KDNuggets-博客中文翻译-二十一-

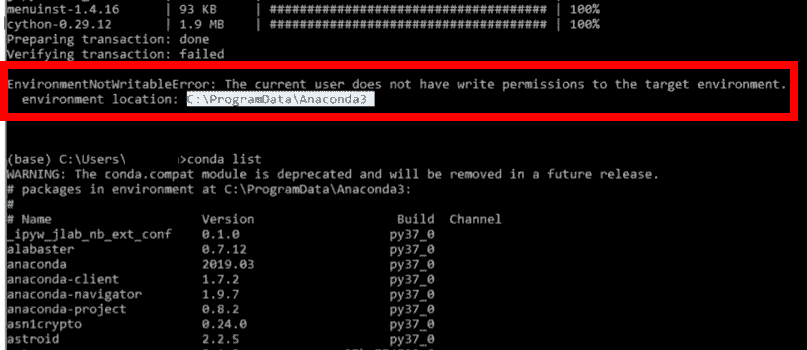

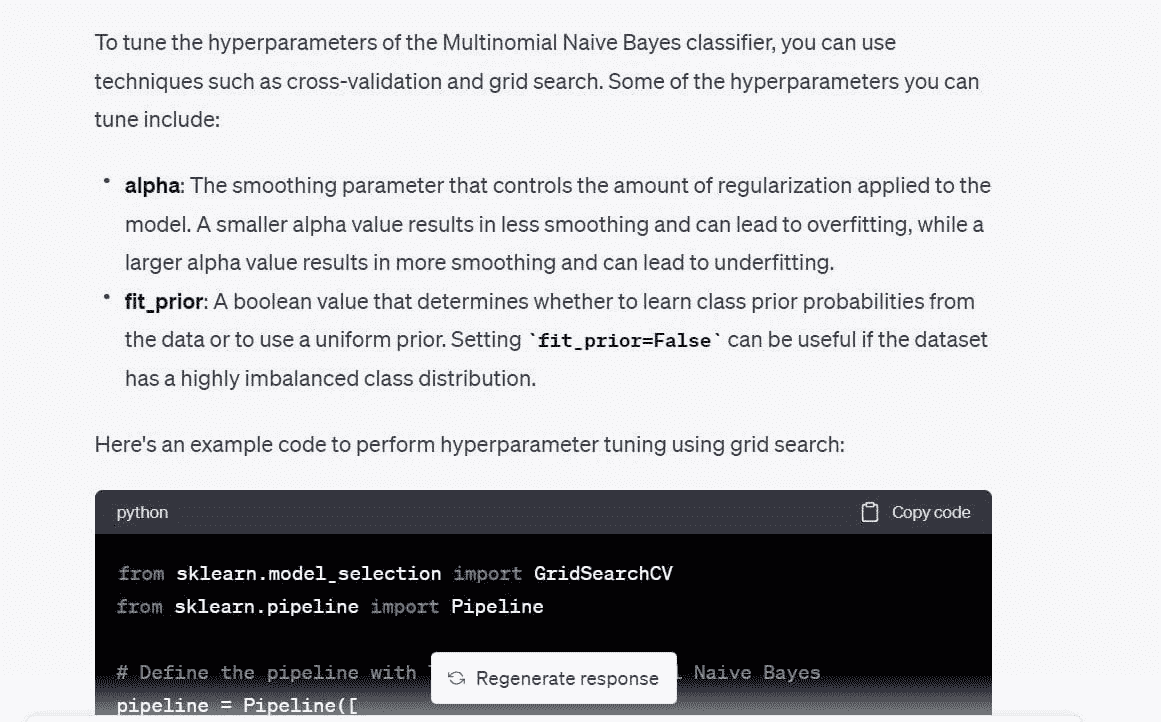

KDNuggets 博客中文翻译(二十一)

原文:KDNuggets

如何使用 Hugging Face 的数据集库进行高效的数据加载

原文:

www.kdnuggets.com/how-to-use-hugging-faces-datasets-library-for-efficient-data-loading

图片由编辑 | Midjourney 提供

本教程演示如何使用 Hugging Face 的 Datasets 库从不同来源加载数据集,仅需几行代码。

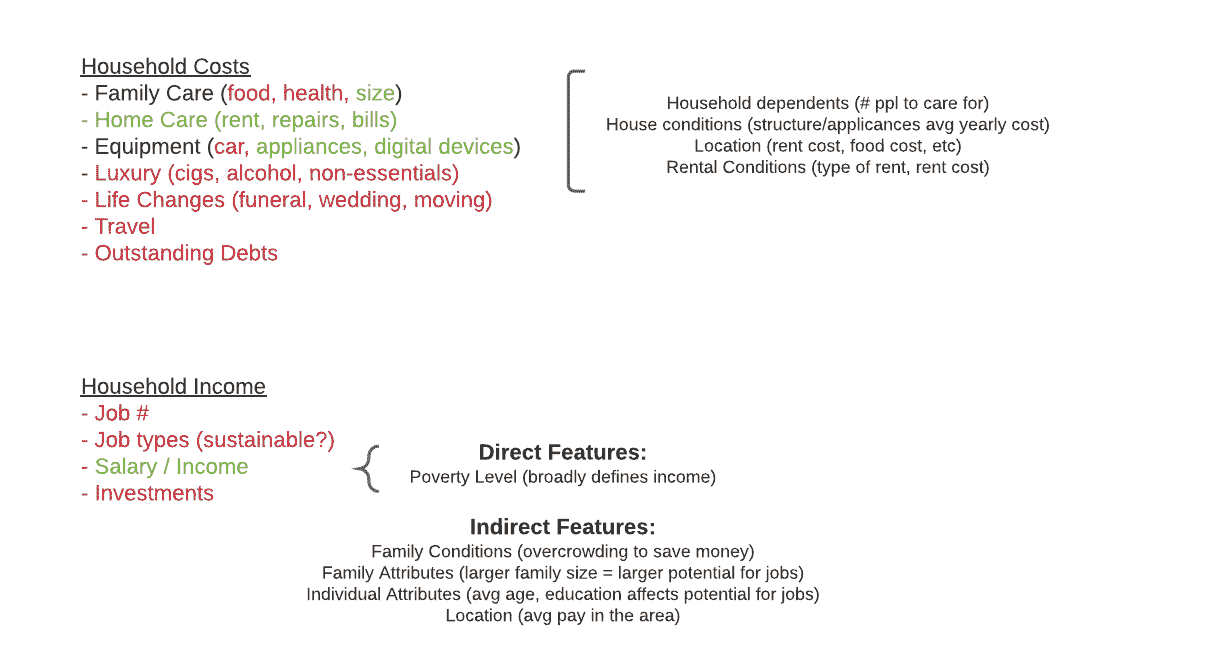

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织的 IT

3. Google IT 支持专业证书 - 支持您的组织的 IT

Hugging Face Datasets 库简化了数据集的加载和处理过程。它为 Hugging Face 的中心提供了数千个数据集的统一接口。该库还实现了各种性能指标,以评估基于变换器的模型。

初始设置

某些 Python 开发环境可能需要在导入之前安装 Datasets 库。

!pip install datasets

import datasets

通过名称加载 Hugging Face Hub 数据集

Hugging Face 在其中心托管了大量数据集。以下函数按名称输出这些数据集的列表:

from datasets import list_datasets

list_datasets()

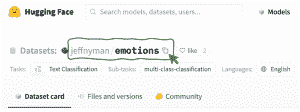

让我们加载其中一个,即 情感数据集,以对推文中的情感进行分类,方法是指定其名称:

data = load_dataset("jeffnyman/emotions")

如果您想加载在浏览 Hugging Face 网站时遇到的数据集,并且不确定正确的命名约定是什么,请点击数据集名称旁边的“复制”图标,如下所示:

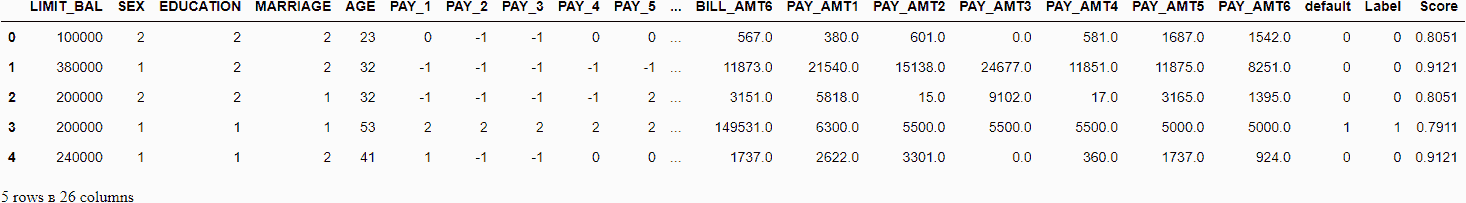

数据集被加载到一个 DatasetDict 对象中,该对象包含三个子集或折叠:训练集、验证集和测试集。

DatasetDict({

train: Dataset({

features: ['text', 'label'],

num_rows: 16000

})

validation: Dataset({

features: ['text', 'label'],

num_rows: 2000

})

test: Dataset({

features: ['text', 'label'],

num_rows: 2000

})

})

每个折叠反过来是一个 Dataset 对象。使用字典操作,我们可以检索训练数据折叠:

train_data = all_data["train"]

这个 Dataset 对象的长度表示训练实例(推文)的数量。

len(train_data)

生成以下输出:

16000

通过索引(例如,第 4 个)获取单个实例就像模仿列表操作一样简单:

train_data[3]

该操作返回一个 Python 字典,其中数据集中的两个属性作为键:输入推文 文本 和 标签,表示它被分类的情感。

{'text': 'i am ever feeling nostalgic about the fireplace i will know that it is still on the property',

'label': 2}

我们还可以通过切片同时获取几个连续的实例:

print(train_ds[:100])

这个操作返回一个单一的字典,如之前一样,但现在每个键都有一个值的列表,而不是单一值。

{'text': ['i didnt feel humiliated', ...],

'label': [0, ...]}

最后,要访问单个属性值,我们指定两个索引:一个用于其位置,另一个用于属性名称或键:

train_data[3]["text"]

加载你自己的数据

如果你不想使用 Hugging Face 数据集中心,而是想使用自己的数据集,Datasets 库也允许你这样做,通过使用相同的 load_dataset() 函数,并传入两个参数:数据集的文件格式(例如“csv”、“text”或“json”)以及其所在的路径或网址。

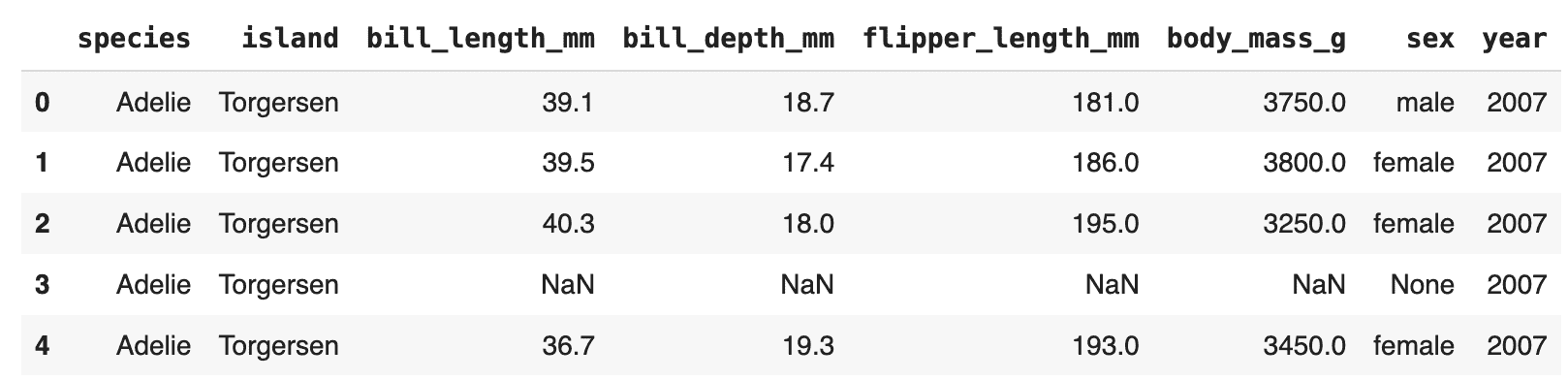

这个例子从一个公共 GitHub 仓库加载 Palmer Archipelago Penguins 数据集:

url = "https://raw.githubusercontent.com/allisonhorst/palmerpenguins/master/inst/extdata/penguins.csv"

dataset = load_dataset('csv', data_files=url)

将数据集转换为 Pandas DataFrame

最后但同样重要的是,有时将加载的数据转换为 Pandas DataFrame 对象是方便的,这可以利用 Pandas 库的广泛功能来简化数据处理、分析和可视化。

penguins = dataset["train"].to_pandas()

penguins.head()

现在你已经学会了如何使用 Hugging Face 的专用库高效加载数据集,下一步是通过使用大语言模型(LLMs)来利用它们。

伊万·帕洛马雷斯·卡拉斯科萨 是一位在人工智能、机器学习、深度学习和 LLMs 领域的领袖、作家、演讲者和顾问。他培训和指导他人将 AI 应用于现实世界。

更多相关主题

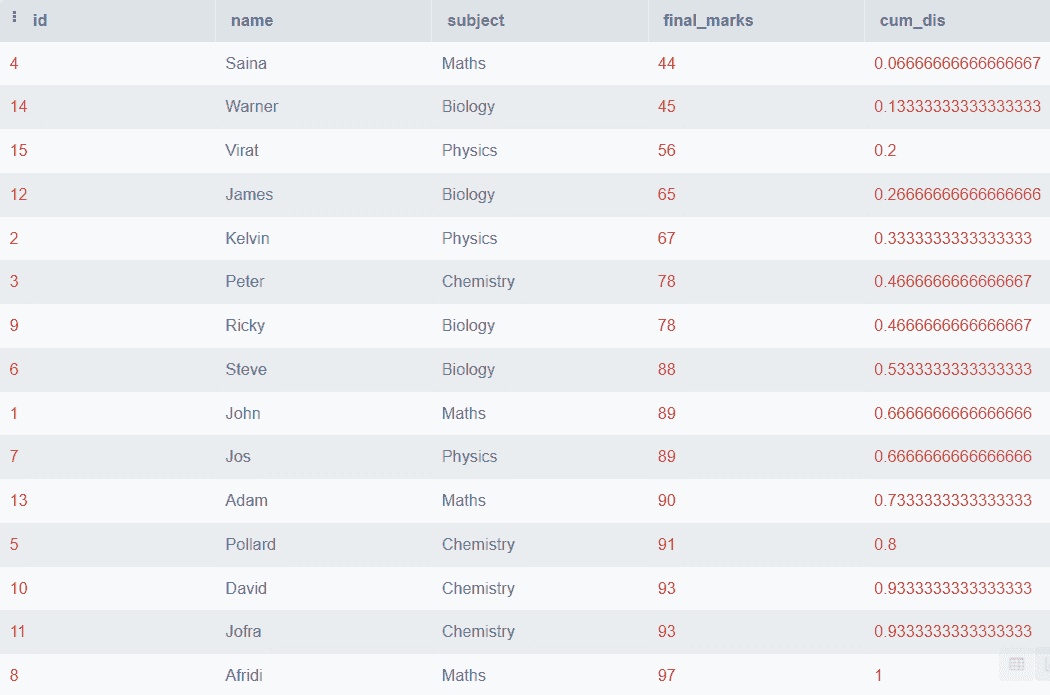

如何在 Pandas 中使用 MultiIndex 进行层次数据组织

原文:

www.kdnuggets.com/how-to-use-multiindex-for-hierarchical-data-organization-in-pandas

图片由编辑提供 | Midjourney & Canva

让我们学习如何在 Pandas 中使用 MultiIndex 进行层次数据处理。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

准备

我们需要确保安装了 Pandas 包。你可以使用以下代码进行安装:

pip install pandas

然后,让我们学习如何在 Pandas 中处理 MultiIndex 数据。

在 Pandas 中使用 MultiIndex

Pandas 中的 MultiIndex 指的是在 DataFrame 或 Series 上进行多级索引。当我们在二维表格结构中处理更高维的数据时,这个过程很有帮助。通过 MultiIndex,我们可以用多个键来索引数据,并且更好地组织它们。让我们用一个数据集示例来更好地理解它们。

import pandas as pd

index = pd.MultiIndex.from_tuples(

[('A', 1), ('A', 2), ('B', 1), ('B', 2)],

names=['Category', 'Number']

)

df = pd.DataFrame({

'Value': [10, 20, 30, 40]

}, index=index)

print(df)

输出:

Value

Category Number

A 1 10

2 20

B 1 30

2 40

如你所见,上面的 DataFrame 有一个包含类别和编号的两级索引。

也可以使用 DataFrame 中现有的列来设置 MultiIndex。

data = {

'Category': ['A', 'A', 'B', 'B'],

'Number': [1, 2, 1, 2],

'Value': [10, 20, 30, 40]

}

df = pd.DataFrame(data)

df.set_index(['Category', 'Number'], inplace=True)

print(df)

输出:

Value

Category Number

A 1 10

2 20

B 1 30

2 40

即使采用不同的方法,我们也能得到类似的结果。这就是为什么我们可以在 DataFrame 中使用 MultiIndex。

如果你已经有了 MultiIndex DataFrame,可以使用以下代码交换级别。

print(df.swaplevel())

输出:

Value

Number Category

1 A 10

2 A 20

1 B 30

2 B 40

当然,我们可以使用以下代码将 MultiIndex 返回为列:

print(df.reset_index())

输出:

Category Number Value

0 A 1 10

1 A 2 20

2 B 1 30

3 B 2 40

那么,如何在 Pandas DataFrame 中访问 MultiIndex 数据呢?我们可以使用.loc方法。例如,我们访问 MultiIndex DataFrame 的第一级。

print(df.loc['A'])

输出:

Value

Number

1 10

2 20

我们也可以使用元组访问数据值。

print(df.loc[('A', 1)])

输出:

Value 10

Name: (A, 1), dtype: int64

最后,我们可以使用.groupby方法对 MultiIndex 进行统计聚合。

print(df.groupby(level=['Category']).sum())

输出:

Value

Category

A 30

B 70

精通 Pandas 中的 MultiIndex 将帮助你深入了解层次数据。

额外资源

Cornellius Yudha Wijaya 是一名数据科学助理经理和数据撰写者。在全职工作于 Allianz Indonesia 的同时,他喜欢通过社交媒体和写作媒体分享 Python 和数据技巧。Cornellius 涉猎多种 AI 和机器学习主题。

更多相关内容

如何使用 NumPy 解决非线性方程组

原文:

www.kdnuggets.com/how-to-use-numpy-to-solve-systems-of-nonlinear-equations

作者提供的图片

非线性方程式是数学中非常有趣的一个方面,其应用范围涉及科学、工程和日常生活。在学校时,我花了很长时间才对其概念有了深刻的理解。与形成直线的线性方程式不同,非线性方程式会创建曲线、螺旋或更复杂的形状。这使得它们解决起来有点棘手,但也极具价值,用于建模现实世界的问题。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 工作

简单来说,非线性方程式涉及的变量的指数不为一,或嵌入了更复杂的函数中。以下是几种常见类型:

-

二次方程式:涉及平方项,如 ax² + bx + c = 0。它们的图形形成抛物线,可以向上或向下开口。

-

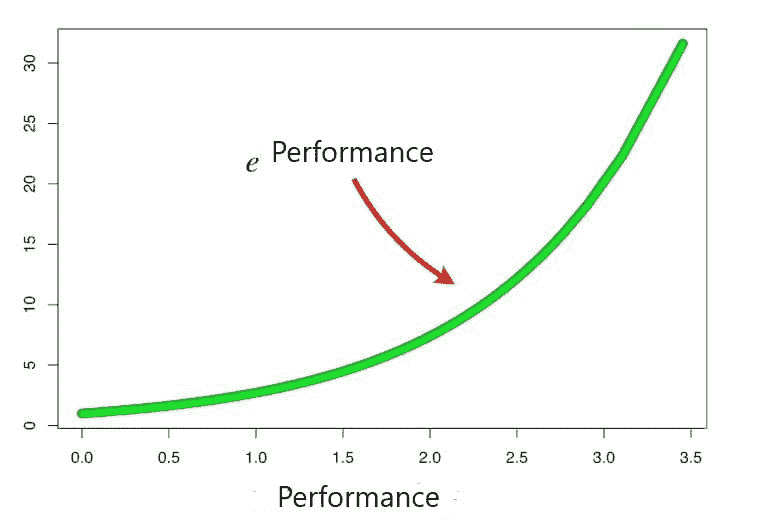

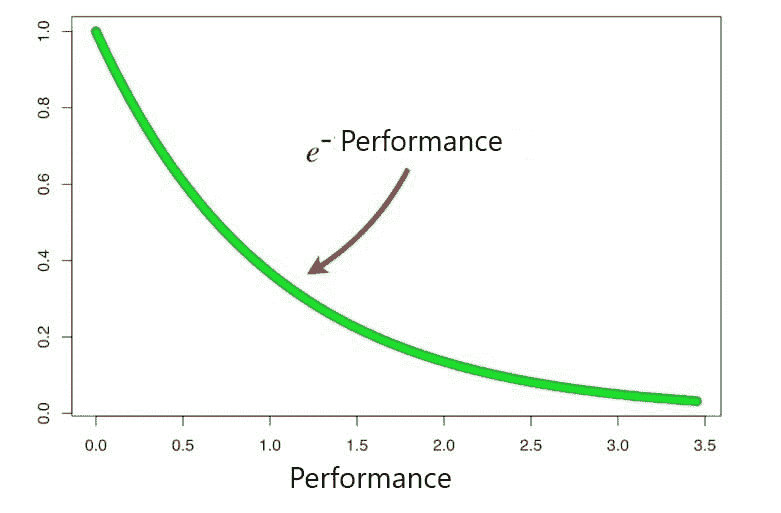

指数方程式:例如 e^x = 3x,其中变量作为指数出现,导致快速增长或衰减。

-

三角方程式:例如 sin(x) = x/2,其中变量位于三角函数内,形成波浪状模式。

这些方程可以生成各种图形,从抛物线到振荡波,使它们成为建模各种现象的多用途工具。以下是一些非线性方程应用的例子:

-

物理学:建模行星的运动、粒子的行为或混沌系统的动力学。

-

工程学:设计具有反馈回路的系统,如控制系统或电路行为。

-

经济学:分析市场趋势、预测经济增长,或理解不同经济因素之间的复杂互动。

NumPy 可以用来简化解决非线性方程组的过程。它提供了处理复杂计算、找到近似解和可视化结果的工具,使得解决这些挑战性问题变得更容易。

在接下来的部分中,我们将探讨如何利用 NumPy 来解决这些引人入胜的方程,将复杂的数学挑战转化为可管理的任务。

在深入探讨使用 NumPy 求解非线性方程系统的技术细节之前,了解如何有效地制定和设置这些问题是很重要的。要制定一个系统,请遵循以下步骤:

-

识别变量:确定将成为系统一部分的变量。这些是你试图求解的未知数。

-

定义方程:将系统中的每个方程写下来,确保它包含已识别的变量。非线性方程包括 x²、e^x 或 xy 等项。

-

安排方程:清晰地组织方程,将其转换为 NumPy 更易处理的格式。

步骤逐步解决过程

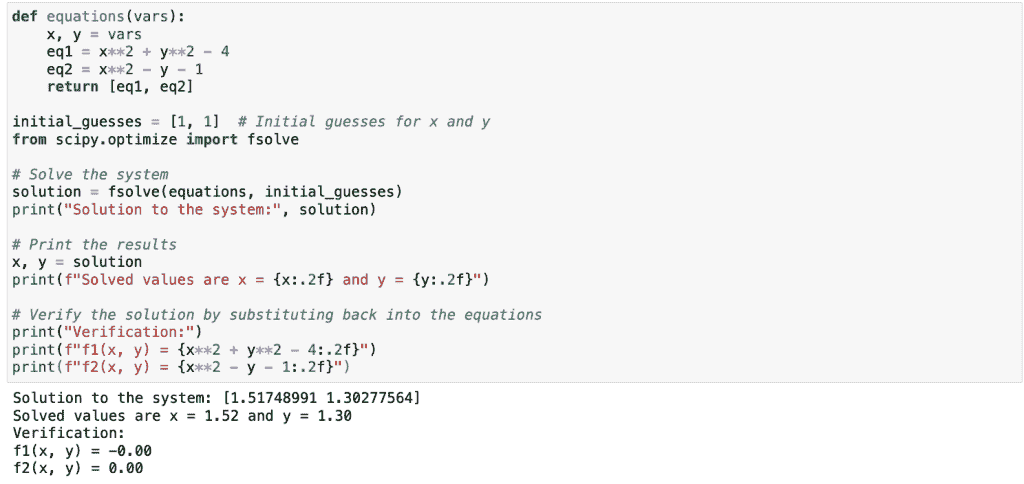

在这一部分中,我们将把非线性方程的求解分解为易于处理的步骤,使问题更加可处理。以下是如何使用NumPy和SciPy系统地解决这些问题。

定义函数

第一步是将你的非线性方程系统转换为 Python 可以处理的格式。这涉及到将方程定义为函数。

在 Python 中,你将每个方程表示为一个函数,该函数在给定一组变量的情况下返回方程的值。对于非线性系统,这些函数通常包括平方项、指数项或变量的乘积。

例如,你有一个由两个非线性方程组成的系统:

-

f[1] (x, y) = x² + y² − 4

-

f[2] (x, y) = x² − y − 1

下面是你如何在 Python 中定义这些函数:

def equations(vars):

x, y = vars

eq1 = x**2 + y**2 - 4

eq2 = x**2 - y - 1

return [eq1, eq2]

在这个函数中,vars 是你希望求解的变量列表。每个方程被定义为这些变量的函数,并返回一个结果列表。

设置初始猜测

在找到解决方案之前,你必须为变量提供初始猜测。这些猜测是必不可少的,因为像 fsolve 使用的迭代方法依赖于这些猜测来开始寻找解决方案。

良好的初始猜测可以帮助我们更有效地收敛到解决方案。差的猜测可能会导致收敛问题或不正确的解决方案。可以把这些猜测看作是寻找方程根的起点。

选择有效初始猜测的提示:

-

领域知识:利用有关问题的先前知识进行有根据的猜测。

-

图形分析:绘制方程图,以便对解决方案可能所在的位置有一个直观的了解。

-

实验:有时,尝试几个不同的猜测并观察结果可能会有所帮助。

对于我们的示例方程,你可以从以下开始:

initial_guesses = [1, 1] # Initial guesses for x and y

求解系统

在定义函数和设置初始猜测后,你现在可以使用 scipy.optimize.fsolve 来找到非线性方程的根。fsolve 旨在通过找到函数为零的地方来处理非线性方程系统。

下面是如何使用 fsolve 来解决系统的方法:

from scipy.optimize import fsolve

# Solve the system

solution = fsolve(equations, initial_guesses)

print("Solution to the system:", solution)

在这段代码中,fsolve 接受两个参数:表示方程系统的函数和初始猜测。它返回满足方程的变量值。

解决之后,你可能想要解释结果:

# Print the results

x, y = solution

print(f"Solved values are x = {x:.2f} and y = {y:.2f}")

# Verify the solution by substituting it back into the equations

print("Verification:")

print(f"f1(x, y) = {x**2 + y**2 - 4:.2f}")

print(f"f2(x, y) = {x**2 - y - 1:.2f}")

这段代码打印出解,并通过将值代入原始方程来验证,以确保它们接近零。

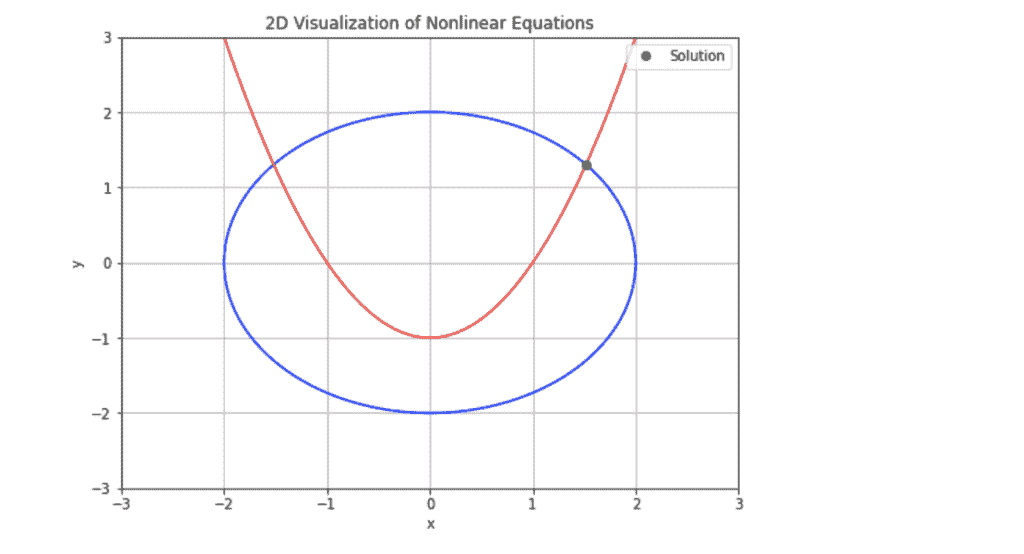

解决方案可视化

一旦你解出了一个非线性方程组,可视化结果可以帮助你更好地理解和解释这些结果。无论你处理的是两个变量还是三个变量,绘制解提供了这些解在问题背景下的清晰视图。

让我们用几个例子来说明如何可视化这些解:

2D 可视化

假设你已经解出了具有两个变量 x 和 y 的方程。以下是如何在 2D 中绘制这些解:

import numpy as np

import matplotlib.pyplot as plt

# Define the system of equations

def equations(vars):

x, y = vars

eq1 = x**2 + y**2 - 4

eq2 = x**2 - y - 1

return [eq1, eq2]

# Solve the system

from scipy.optimize import fsolve

initial_guesses = [1, 1]

solution = fsolve(equations, initial_guesses)

x_sol, y_sol = solution

# Create a grid of x and y values

x = np.linspace(-3, 3, 400)

y = np.linspace(-3, 3, 400)

X, Y = np.meshgrid(x, y)

# Define the equations for plotting

Z1 = X**2 + Y**2 - 4

Z2 = X**2 - Y - 1

# Plot the contours

plt.figure(figsize=(8, 6))

plt.contour(X, Y, Z1, levels=[0], colors='blue', label='x² + y² - 4')

plt.contour(X, Y, Z2, levels=[0], colors='red', label='x² - y - 1')

plt.plot(x_sol, y_sol, 'go', label='Solution')

plt.xlabel('x')

plt.ylabel('y')

plt.title('2D Visualization of Nonlinear Equations')

plt.legend()

plt.grid(True)

plt.show()

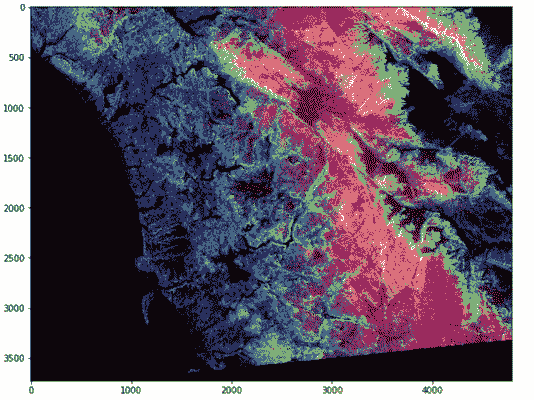

这是输出结果:

图中的蓝色和红色轮廓表示每个方程为零的曲线。绿色点显示了这些曲线交点的解。

3D 可视化

对于涉及三个变量的系统,3D 图可以提供更多信息。假设你有一个包含 x、y 和 z 变量的系统。以下是如何可视化这个系统:

from mpl_toolkits.mplot3d import Axes3D

# Define the system of equations

def equations(vars):

x, y, z = vars

eq1 = x**2 + y**2 + z**2 - 4

eq2 = x**2 - y - 1

eq3 = z - x * y

return [eq1, eq2, eq3]

# Solve the system

initial_guesses = [1, 1, 1]

solution = fsolve(equations, initial_guesses)

x_sol, y_sol, z_sol = solution

# Create a grid of x, y, and z values

x = np.linspace(-2, 2, 100)

y = np.linspace(-2, 2, 100)

X, Y = np.meshgrid(x, y)

Z = np.sqrt(4 - X**2 - Y**2)

# Plotting the 3D surface

fig = plt.figure(figsize=(10, 7))

ax = fig.add_subplot(111, projection='3d')

ax.plot_surface(X, Y, Z, alpha=0.5, rstride=100, cstride=100, color='blue')

ax.plot_surface(X, Y, -Z, alpha=0.5, rstride=100, cstride=100, color='red')

# Plot the solution

ax.scatter(x_sol, y_sol, z_sol, color='green', s=100, label='Solution')

ax.set_xlabel('x')

ax.set_ylabel('y')

ax.set_zlabel('z')

ax.set_title('3D Visualization of Nonlinear Equations')

ax.legend()

plt.show()

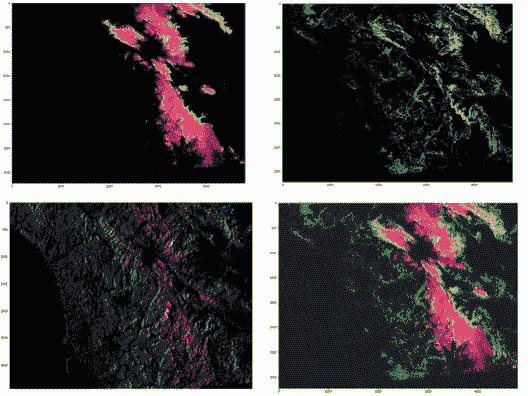

输出:

在这个 3D 图中,蓝色和红色表面表示方程的解,而绿色点显示了 3D 空间中的解。

结论

在这篇文章中,我们探讨了使用 NumPy 解决非线性方程组的过程。通过分解步骤,从定义问题到可视化解决方案,我们使复杂的数学概念变得易于接近和实际应用。

我们从在 Python 中公式化和定义非线性方程开始。我们强调了初始猜测的重要性,并提供了选择有效起始点的技巧。接着,我们利用 scipy.optimize.solve 找到方程的根。最后,我们展示了如何使用 matplotlib 可视化这些解,使结果的解释和验证更加容易。

Shittu Olumide 是一位软件工程师和技术写作人员,热衷于利用前沿技术编写引人入胜的叙述,对细节有敏锐的洞察力,并擅长简化复杂概念。你也可以在 Twitter 上找到 Shittu。

更多相关话题

如何使用 Hugging Face Tokenizers 库来预处理文本数据

原文:

www.kdnuggets.com/how-to-use-the-hugging-face-tokenizers-library-to-preprocess-text-data

作者提供的图像

如果你学习过 NLP,你可能听说过“分词”这个术语。这是文本预处理中的一个重要步骤,我们通过将文本数据转换为机器可以理解的形式来完成。这是通过将句子拆分成更小的部分,称为标记。根据使用的分词算法,这些标记可以是单词、子词,甚至是字符。本文将探讨如何使用 Hugging Face Tokenizers 库来预处理我们的文本数据。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

设置 Hugging Face Tokenizers 库

要开始使用 Hugging Face Tokenizers 库,你需要先安装它。你可以使用 pip 来完成这个操作:

pip install tokenizers

Hugging Face 库支持多种分词算法,但主要有三种类型:

-

字节对编码 (BPE): 迭代地合并最频繁的字符或子词对,创建一个紧凑的词汇表。GPT-2 等模型使用了这种方法。

-

WordPiece: 类似于 BPE,但侧重于概率合并(不选择最频繁的对,而是选择合并后能最大化语料库概率的对),通常被 BERT 等模型使用。

-

SentencePiece: 一种更灵活的分词器,可以处理不同语言和脚本,通常与 ALBERT、XLNet 或 Marian 框架等模型一起使用。它将空格视为字符,而不是单词分隔符。

Hugging Face Transformers 库提供了一个AutoTokenizer类,可以自动选择适合给定预训练模型的最佳分词器。这是使用特定模型正确分词器的一种便捷方式,并且可以从transformers库中导入。然而,考虑到我们对 Tokenizers 库的讨论,我们将不采用这种方法。

我们将使用预训练的BERT-base-uncased分词器。这个分词器是基于与BERT-base-uncased模型相同的数据和技术训练的,这意味着它可以用来预处理与 BERT 模型兼容的文本数据:

# Import the necessary components

from tokenizers import Tokenizer

from transformers import BertTokenizer

# Load the pre-trained BERT-base-uncased tokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

单句分词

现在,让我们使用这个标记器对一个简单句子进行编码:

# Tokenize a single sentence

encoded_input = tokenizer.encode_plus("This is sample text to test tokenization.")

print(encoded_input)

输出:

{'input_ids': [101, 2023, 2003, 7099, 3793, 2000, 3231, 19204, 3989, 1012, 102], 'token_type_ids': [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], 'attention_mask': [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1]}

为确保准确性,让我们解码标记化的输入:

tokenizer.decode(encoded_input["input_ids"])

输出:

[CLS] this is sample text to test tokenization. [SEP]

在这个输出中,你可以看到两个特殊标记。[CLS] 标记输入序列的开始,[SEP] 标记结束,表示单个文本序列。

批量标记化

现在,让我们使用 batch_encode_plus 对文本语料库进行标记化,而不是单个句子:

corpus = [

"Hello, how are you?",

"I am learning how to use the Hugging Face Tokenizers library.",

"Tokenization is a crucial step in NLP."

]

encoded_corpus = tokenizer.batch_encode_plus(corpus)

print(encoded_corpus)

输出:

{'input_ids': [[101, 7592, 1010, 2129, 2024, 2017, 1029, 102], [101, 1045, 2572, 4083, 2129, 2000, 2224, 1996, 17662, 2227, 19204, 17629, 2015, 3075, 1012, 102], [101, 19204, 3989, 2003, 1037, 10232, 3357, 1999, 17953, 2361, 1012, 102]], 'token_type_ids': [[0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]], 'attention_mask': [[1, 1, 1, 1, 1, 1, 1, 1], [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1], [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1]]}

为了更好地理解,让我们像处理单句时那样解码批量编码的语料库。这将提供原始句子,标记化得当。

tokenizer.batch_decode(encoded_corpus["input_ids"])

输出:

['[CLS] hello, how are you? [SEP]',

'[CLS] i am learning how to use the hugging face tokenizers library. [SEP]',

'[CLS] tokenization is a crucial step in nlp. [SEP]']

填充和截断

在为机器学习模型准备数据时,确保所有输入序列具有相同长度通常是必要的。实现这一点的两种方法是:

1. 填充

填充通过在较短序列的末尾添加特殊标记 [PAD],以匹配批次中最长序列的长度或模型支持的最大长度(如果定义了 max_length)。你可以通过以下方式实现:

encoded_corpus_padded = tokenizer.batch_encode_plus(corpus, padding=True)

print(encoded_corpus_padded)

输出:

{'input_ids': [[101, 7592, 1010, 2129, 2024, 2017, 1029, 102, 0, 0, 0, 0, 0, 0, 0, 0], [101, 1045, 2572, 4083, 2129, 2000, 2224, 1996, 17662, 2227, 19204, 17629, 2015, 3075, 1012, 102], [101, 19204, 3989, 2003, 1037, 10232, 3357, 1999, 17953, 2361, 1012, 102, 0, 0, 0, 0]], 'token_type_ids': [[0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]], 'attention_mask': [[1, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0], [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1], [1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, 0]]}

现在,你可以看到额外的 0 被放置,但为了更好地理解,让我们解码以查看标记器放置 [PAD] 标记的位置:

tokenizer.batch_decode(encoded_corpus_padded["input_ids"], skip_special_tokens=False)

输出:

['[CLS] hello, how are you? [SEP] [PAD] [PAD] [PAD] [PAD] [PAD] [PAD] [PAD] [PAD]',

'[CLS] i am learning how to use the hugging face tokenizers library. [SEP]',

'[CLS] tokenization is a crucial step in nlp. [SEP] [PAD] [PAD] [PAD] [PAD]']

2. 截断

许多 NLP 模型有最大输入长度序列,截断通过剪切较长序列的末尾来满足这个最大长度。它减少了内存使用,并防止模型被非常大的输入序列压垮。

encoded_corpus_truncated = tokenizer.batch_encode_plus(corpus, truncation=True, max_length=5)

print(encoded_corpus_truncated)

输出:

{'input_ids': [[101, 7592, 1010, 2129, 102], [101, 1045, 2572, 4083, 102], [101, 19204, 3989, 2003, 102]], 'token_type_ids': [[0, 0, 0, 0, 0], [0, 0, 0, 0, 0], [0, 0, 0, 0, 0]], 'attention_mask': [[1, 1, 1, 1, 1], [1, 1, 1, 1, 1], [1, 1, 1, 1, 1]]}

现在,你还可以使用 batch_decode 方法,但为了更好地理解,让我们以不同的方式打印这些信息:

for i, sentence in enumerate(corpus):

print(f"Original sentence: {sentence}")

print(f"Token IDs: {encoded_corpus_truncated['input_ids'][i]}")

print(f"Tokens: {tokenizer.convert_ids_to_tokens(encoded_corpus_truncated['input_ids'][i])}")

print()

输出:

Original sentence: Hello, how are you?

Token IDs: [101, 7592, 1010, 2129, 102]

Tokens: ['[CLS]', 'hello', ',', 'how', '[SEP]']

Original sentence: I am learning how to use the Hugging Face Tokenizers library.

Token IDs: [101, 1045, 2572, 4083, 102]

Tokens: ['[CLS]', 'i', 'am', 'learning', '[SEP]']

Original sentence: Tokenization is a crucial step in NLP.

Token IDs: [101, 19204, 3989, 2003, 102]

Tokens: ['[CLS]', 'token', '##ization', 'is', '[SEP]']

本文是我们关于 Hugging Face 的精彩系列的一部分。如果你想更深入了解这个话题,这里有一些参考资料可以帮助你:

Kanwal Mehreen**** Kanwal 是一位机器学习工程师和技术作家,对数据科学及人工智能与医学的交叉领域充满热情。她共同撰写了电子书《利用 ChatGPT 最大化生产力》。作为 2022 年亚太地区的 Google Generation 学者,她倡导多样性和学术卓越。她还被认可为 Teradata 多样性科技学者、Mitacs Globalink 研究学者和哈佛 WeCode 学者。Kanwal 是变革的积极倡导者,创立了 FEMCodes 以赋能女性在 STEM 领域的成长。

更多相关话题

如何使用 pivot_table 函数进行高级数据汇总

原文:

www.kdnuggets.com/how-to-use-the-pivot_table-function-for-advanced-data-summarization-in-pandas

图片来源:作者 | Midjourney

让我指导你如何使用 Pandas 的 pivot_table 函数进行数据汇总。

准备工作

让我们开始安装必要的软件包。

pip install pandas seaborn

然后,我们将加载软件包和数据集示例,即 Titanic。

import pandas as pd

import seaborn as sns

titanic = sns.load_dataset('titanic')

在成功安装包并加载数据集后,让我们进入下一部分。

使用 Pandas 创建数据透视表

Pandas 中的数据透视表允许灵活的数据重组和分析。让我们从简单的应用开始探讨一些实际应用。

pivot = pd.pivot_table(titanic, values='age', index='class', columns='sex', aggfunc='mean')

print(pivot)

Output>>>

sex female male

class

First 34.611765 41.281386

Second 28.722973 30.740707

Third 21.750000 26.507589

生成的数据透视表显示了平均年龄,乘客类别在纵轴上,性别类别在顶部。

我们可以更进一步,使用数据透视表来计算票价的均值和总和。

pivot = pd.pivot_table(titanic, values='fare', index='class', columns='sex', aggfunc=['mean', 'sum'])

print(pivot)

Output>>>

mean sum

sex female male female male

class

First 106.125798 67.226127 9975.8250 8201.5875

Second 21.970121 19.741782 1669.7292 2132.1125

Third 16.118810 12.661633 2321.1086 4393.5865

我们可以创建自己的函数。例如,我们创建一个函数,该函数计算数据的最大值和最小值之间的差异,并将其除以二。

def data_div_two(x):

return (x.max() - x.min())/2

pivot = pd.pivot_table(titanic, values='age', index='class', columns='sex', aggfunc=data_div_two)

print(pivot)

Output>>>

sex female male

class

First 30.500 39.540

Second 27.500 34.665

Third 31.125 36.790

最后,你可以添加边际数据,查看总体分组平均值和具体子组之间的差异。

pivot = pd.pivot_table(titanic, values='age', index='class', columns='sex', aggfunc='mean', margins=True)

print(pivot)

Output>>>

sex female male All

class

First 34.611765 41.281386 38.233441

Second 28.722973 30.740707 29.877630

Third 21.750000 26.507589 25.140620

All 27.915709 30.726645 29.699118

掌握 pivot_table 函数将帮助你从数据集中获得洞察。

额外资源

Cornellius Yudha Wijaya**** 是数据科学助理经理和数据撰稿人。在 Allianz 印度尼西亚全职工作时,他喜欢通过社交媒体和写作分享 Python 和数据技巧。Cornellius 涉及多种 AI 和机器学习主题的写作。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

了解更多相关主题

如何编写高效的 Python 代码:初学者教程

原文:

www.kdnuggets.com/how-to-write-efficient-python-code-a-tutorial-for-beginners

图片由作者提供

初学者喜欢使用 Python 编程,因为它的简单性和易读语法。然而,编写高效的 Python 代码比你想象的要复杂。这需要对语言的一些特性有一定理解(不过它们也很容易掌握)。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

如果你来自其他编程语言,如 C++ 或 JavaScript,这个教程是为你提供一些编写高效 Python 代码的技巧。但是如果你是初学者——将 Python 作为你的第一门(编程)语言——那么这个教程将帮助你从一开始就编写 Pythonic 代码。

我们将重点关注以下内容:

-

Pythonic 循环

-

列表和字典推导式

-

上下文管理器

-

生成器

-

集合类

那么让我们开始吧!

1. 编写 Pythonic 循环

理解循环构造无论你编程使用哪种语言都是重要的。如果你来自 C++ 或 JavaScript 这样的语言,学习如何编写 Pythonic 循环会很有帮助。

使用 range 生成数字序列

range()函数生成一个数字序列,通常在循环中作为迭代器使用。

range()函数返回一个范围对象,该对象默认从 0 开始,到指定的数字(但不包括)为止。

这里是一个例子:

for i in range(5):

print(i)

Output >>>

0

1

2

3

4

使用range()函数时,你可以根据需要自定义起始点、终止点和步长。

使用 enumerate 访问索引和项

enumerate()函数在你需要同时获取每个元素的索引和值时非常有用。

在这个例子中,我们使用索引来访问fruits列表:

fruits = ["apple", "banana", "cherry"]

for i in range(len(fruits)):

print(f"Index {i}: {fruits[i]}")

Output >>>

Index 0: apple

Index 1: banana

Index 2: cherry

但使用enumerate()函数,你可以同时访问索引和元素,如下所示:

fruits = ["apple", "banana", "cherry"]

for i, fruit in enumerate(fruits):

print(f"Index {i}: {fruit}")

Output >>>

Index 0: apple

Index 1: banana

Index 2: cherry

使用 zip 在多个可迭代对象中并行遍历

zip()函数用于并行遍历多个可迭代对象。它将不同可迭代对象中的对应元素配对在一起。

考虑以下示例,其中你需要遍历names和scores列表:

names = ["Alice", "Bob", "Charlie"]

scores = [95, 89, 78]

for i in range(len(names)):

print(f"{names[i]} scored {scores[i]} points.")

这输出:

Output >>>

Alice scored 95 points.

Bob scored 89 points.

Charlie scored 78 points.

这里是一个使用zip()函数的更具可读性的循环:

names = ["Alice", "Bob", "Charlie"]

scores = [95, 89, 78]

for name, score in zip(names, scores):

print(f"{name} scored {score} points.")

Output >>>

Alice scored 95 points.

Bob scored 89 points.

Charlie scored 78 points.

使用zip()的 Pythonic 版本更优雅,避免了手动索引的需要,使代码更清晰易读。

2. 使用列表和字典推导

在 Python 中,列表推导和字典推导是用来分别创建列表和字典的简洁单行表达式。它们还可以包含条件语句来根据某些条件过滤项。

我们从循环版本开始,然后转到对列表和字典的推导式。

Python 中的列表推导

假设你有一个numbers列表。你想创建一个squared_numbers列表。你可以使用如下的 for 循环:

numbers = [1, 2, 3, 4, 5]

squared_numbers = []

for num in numbers:

squared_numbers.append(num ** 2)

print(squared_numbers)

Output >>> [1, 4, 9, 16, 25]

但列表推导提供了更清晰和简洁的语法来完成这项工作。它们允许你通过对可迭代对象中的每个项应用表达式来创建一个新列表。

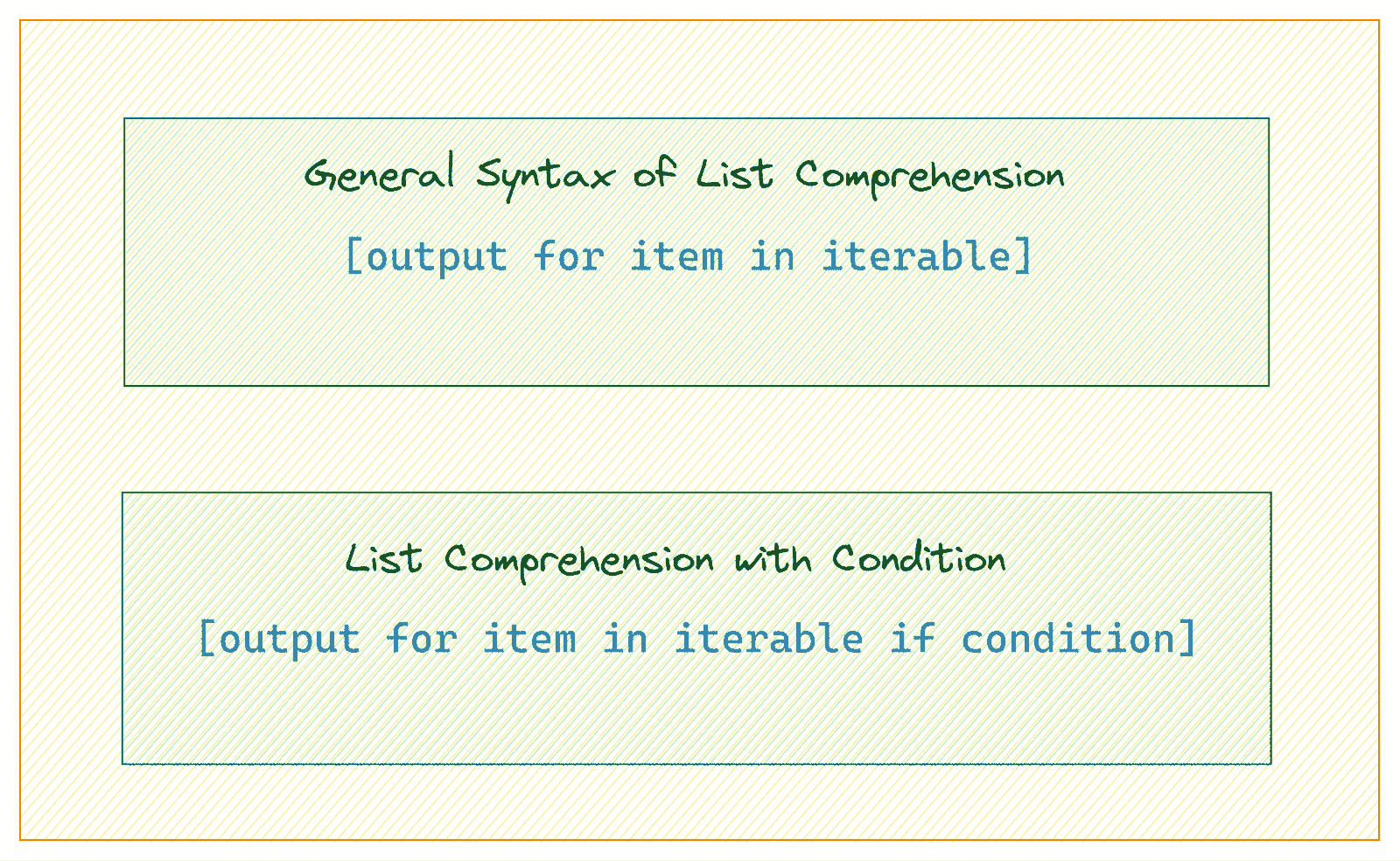

列表推导语法 | 图片作者

这里是使用列表推导式表达式的简洁替代方案:

numbers = [1, 2, 3, 4, 5]

squared_numbers = [num ** 2 for num in numbers]

print(squared_numbers)

Output >>> [1, 4, 9, 16, 25]

在这里,列表推导创建了一个新列表,其中包含numbers列表中每个数字的平方。

带有条件过滤的列表推导

你还可以在列表推导式表达式中添加过滤条件。考虑这个例子:

numbers = [1, 2, 3, 4, 5]

odd_numbers = [num for num in numbers if num % 2 != 0]

print(odd_numbers)

Output >>> [1, 3, 5]

在这个例子中,列表推导创建了一个只包含numbers列表中奇数的新列表。

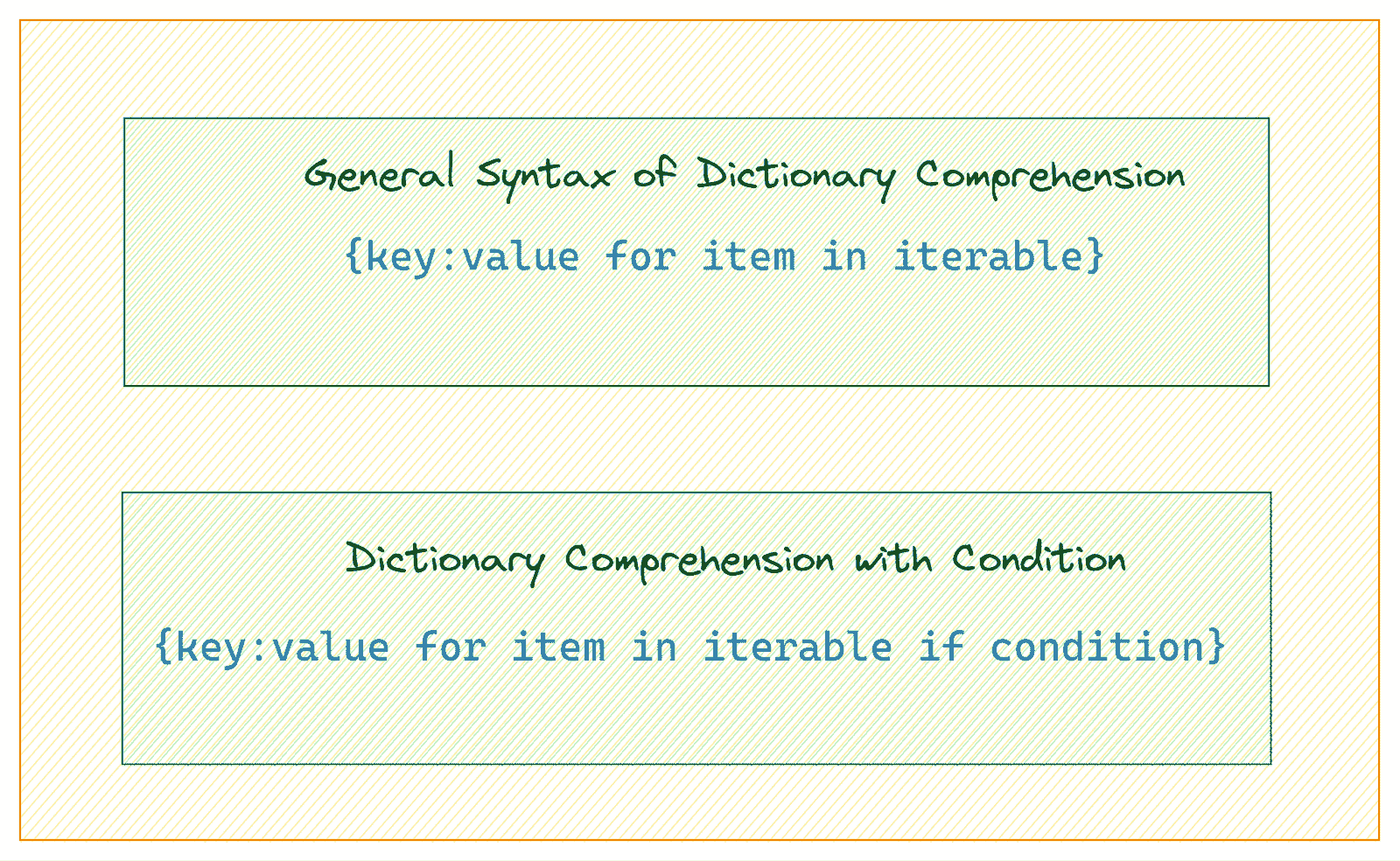

Python 中的字典推导

使用类似于列表推导的语法,字典推导允许你从现有的可迭代对象创建字典。

字典推导语法 | 图片作者

假设你有一个fruits列表。你想创建一个fruit:len(fruit)键值对的字典。

下面是如何使用 for 循环来实现这一点:

fruits = ["apple", "banana", "cherry", "date"]

fruit_lengths = {}

for fruit in fruits:

fruit_lengths[fruit] = len(fruit)

print(fruit_lengths)

Output >>> {'apple': 5, 'banana': 6, 'cherry': 6, 'date': 4}

现在让我们写出字典推导的等效形式:

fruits = ["apple", "banana", "cherry", "date"]

fruit_lengths = {fruit: len(fruit) for fruit in fruits}

print(fruit_lengths)

Output >>> {'apple': 5, 'banana': 6, 'cherry': 6, 'date': 4}

这个字典推导创建了一个字典,其中键是水果,值是水果名称的长度。

带有条件过滤的字典推导

让我们修改我们的字典推导式表达式以包含一个条件:

fruits = ["apple", "banana", "cherry", "date"]

long_fruit_names = {fruit: len(fruit) for fruit in fruits if len(fruit) > 5}

print(long_fruit_names)

Output >>> {'banana': 6, 'cherry': 6}

在这里,字典推导创建了一个字典,键是水果名称,值是它们的长度,但只对名称长度超过 5 个字符的水果。

3. 使用上下文管理器进行有效的资源处理

Python 中的上下文管理器帮助你有效管理资源。使用上下文管理器,你可以轻松地设置和清理资源。上下文管理器最简单和最常见的例子是在文件处理上。

看下面的代码片段:

filename = 'somefile.txt'

file = open(filename,'w')

file.write('Something')

它没有关闭文件描述符,导致资源泄漏。

print(file.closed)

Output >>> False

你可能会得到以下结果:

filename = 'somefile.txt'

file = open(filename,'w')

file.write('Something')

file.close()

虽然这试图关闭描述符,但它没有考虑到在写操作期间可能出现的错误。

现在,你可以实现异常处理以尝试打开文件并在没有错误的情况下写入内容:

filename = 'somefile.txt'

file = open(filename,'w')

try:

file.write('Something')

finally:

file.close()

但这很冗长。现在看看以下使用 with 语句的版本,它支持作为上下文管理器的 open() 函数:

filename = 'somefile.txt'

with open(filename, 'w') as file:

file.write('Something')

print(file.closed)

Output >>> True

我们使用 with 语句来创建一个上下文,在其中打开文件。这确保了当执行退出 with 块时,文件会被正确关闭——即使在操作过程中引发了异常。

4. 使用生成器进行内存高效处理

生成器提供了一种优雅的方式来处理大数据集或无限序列——提高代码效率并减少内存消耗。

什么是生成器?

生成器是使用 yield 关键字逐个返回值的函数,保留其内部状态以便在调用之间继续。与一次计算所有值并返回完整列表的常规函数不同,生成器按需计算并逐步生成值,使它们适合处理大型序列。

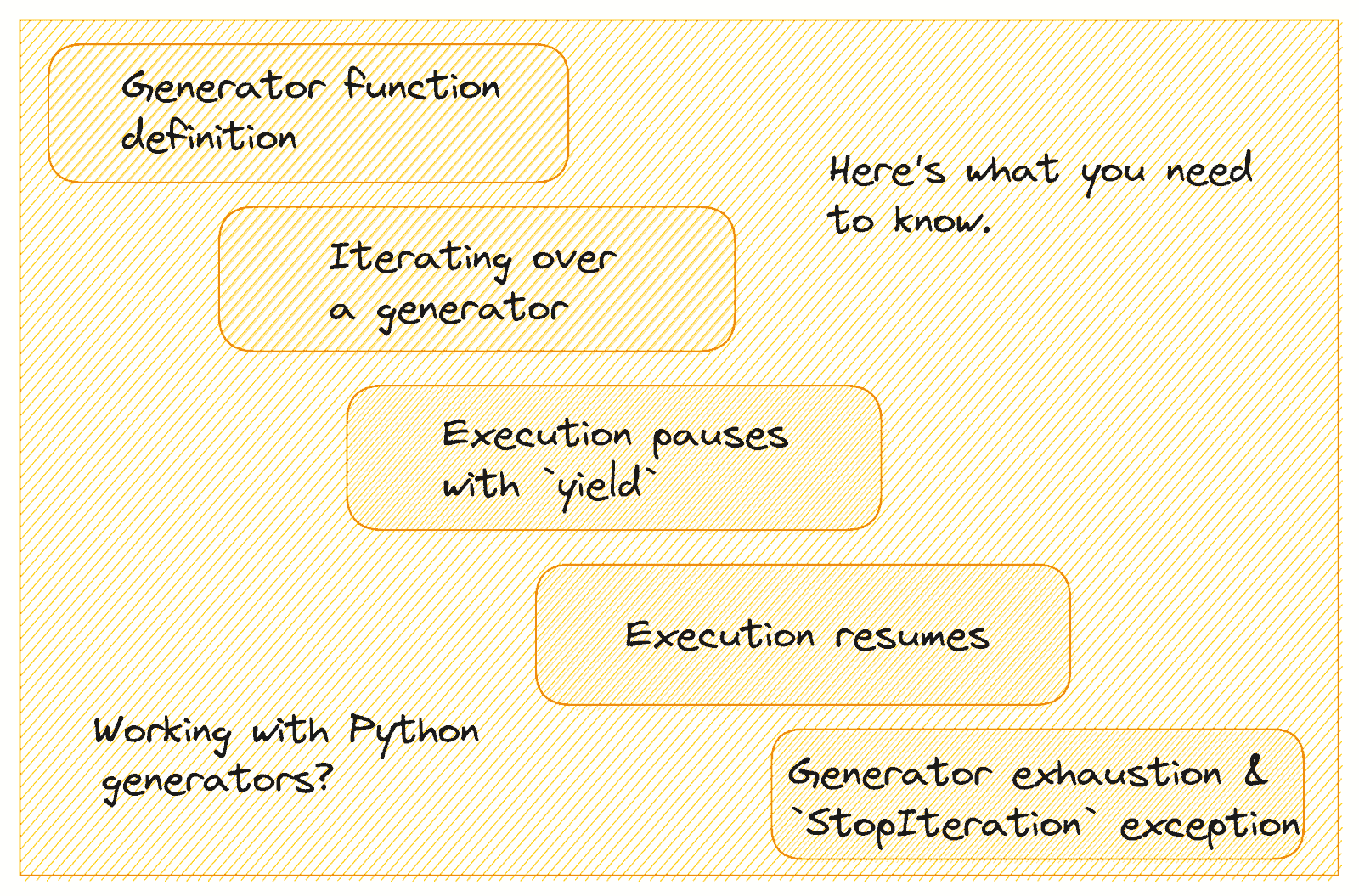

生成器是如何工作的?

图片由作者提供

让我们了解生成器是如何工作的:

-

生成器函数的定义方式类似于常规函数,但它使用

yield而不是return关键字来返回一个值。 -

当你调用生成器函数时,它会返回一个生成器对象。你可以使用循环或调用

next()来遍历它。 -

当遇到

yield语句时,函数的状态被保存,并且返回的值会传递给调用者。函数的执行会暂停,但它的局部变量和状态会被保留。 -

当生成器的

next()方法再次被调用时,执行将从暂停的地方继续,函数将继续执行直到下一个yield语句。 -

当函数退出或抛出

StopIteration异常时,生成器被认为是耗尽的,进一步调用next()将抛出StopIteration。

创建生成器

你可以使用生成器函数或生成器表达式来创建生成器。

这是一个示例生成器函数:

def countdown(n):

while n > 0:

yield n

n -= 1

# Using the generator function

for num in countdown(5):

print(num)

Output >>>

5

4

3

2

1

生成器表达式类似于列表推导式,但它们创建的是生成器而不是列表。

# Generator expression to create a sequence of squares

squares = (x ** 2 for x in range(1, 6))

# Using the generator expression

for square in squares:

print(square)

Output >>>

1

4

9

16

25

5. 利用集合类

我们将通过了解两个有用的集合类来结束本教程:

-

命名元组

-

计数器

使用 NamedTuple 创建更具可读性的元组

在 Python 中,命名元组 在 collections 模块 中是内置元组类的一个子类。但它提供了命名字段,这使得它比常规元组更具可读性和自解释性。

这是创建一个 3D 空间点的简单元组并访问单个元素的示例:

# 3D point tuple

coordinate = (1, 2, 3)

# Accessing data using tuple unpacking

x, y, z = coordinate

print(f"X-coordinate: {x}, Y-coordinate: {y}, Z-coordinate: {z}")

Output >>> X-coordinate: 1, Y-coordinate: 2, Z-coordinate: 3

这里是 namedtuple 版本:

from collections import namedtuple

# Define a Coordinate3D namedtuple

Coordinate3D = namedtuple("Coordinate3D", ["x", "y", "z"])

# Creating a Coordinate3D object

coordinate = Coordinate3D(1, 2, 3)

print(coordinate)

# Accessing data using named fields

print(f"X-coordinate: {coordinate.x}, Y-coordinate: {coordinate.y}, Z-coordinate: {coordinate.z}")

Output >>>

Coordinate3D(x=1, y=2, z=3)

X-coordinate: 1, Y-coordinate: 2, Z-coordinate: 3

因此,NamedTuples 让你编写比普通元组更清晰、更易维护的代码。

使用 Counter 简化计数

Counter是collections 模块中的一个类,旨在计算可迭代对象(如列表或字符串)中元素的频率。它返回一个带有{element:count}键值对的 Counter 对象。

让我们以在长字符串中计算字符频率为例。

这里是使用循环计算字符频率的传统方法:

word = "incomprehensibilities"

# initialize an empty dictionary to count characters

char_counts = {}

# Count character frequencies

for char in word:

if char in char_counts:

char_counts[char] += 1

else:

char_counts[char] = 1

# print out the char_counts dictionary

print(char_counts)

# find the most common character

most_common = max(char_counts, key=char_counts.get)

print(f"Most Common Character: '{most_common}' (appears {char_counts[most_common]} times)")

我们手动遍历字符串,更新字典以计算字符频率,并找到最常见的字符。

Output >>>

{'i': 5, 'n': 2, 'c': 1, 'o': 1, 'm': 1, 'p': 1, 'r': 1, 'e': 3, 'h': 1, 's': 2, 'b': 1, 'l': 1, 't': 1}

Most Common Character: 'i' (appears 5 times)

现在,让我们使用Counter类和语法Counter(iterable)来实现相同的任务:

from collections import Counter

word = "incomprehensibilities"

# Count character frequencies using Counter

char_counts = Counter(word)

print(char_counts)

# Find the most common character

most_common = char_counts.most_common(1)

print(f"Most Common Character: '{most_common[0][0]}' (appears {most_common[0][1]} times)")

Output >>>

Counter({'i': 5, 'e': 3, 'n': 2, 's': 2, 'c': 1, 'o': 1, 'm': 1, 'p': 1, 'r': 1, 'h': 1, 'b': 1, 'l': 1, 't': 1})

Most Common Character: 'i' (appears 5 times)

所以Counter提供了一种更简单的方式来计算字符频率,无需手动迭代和字典管理。

总结

希望你找到了一些有用的技巧来增加你的 Python 工具箱。如果你想学习 Python 或者正在准备编程面试,以下是一些资源来帮助你在学习过程中:

学习愉快!

Bala Priya C**** 是一位来自印度的开发者和技术作家。她喜欢在数学、编程、数据科学和内容创作的交叉点上工作。她的兴趣和专长领域包括 DevOps、数据科学和自然语言处理。她喜欢阅读、写作、编程和咖啡!目前,她正在通过编写教程、指南、评论文章等与开发者社区分享她的知识。Bala 还创建了有趣的资源概述和编码教程。

更多相关话题

如何使用 Python 的 datetime

评论

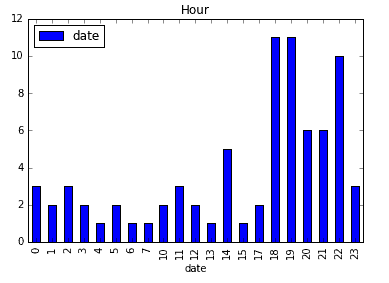

有关视频讲解和幻灯片,以及其他数据处理教程,请访问 数据处理技巧与窍门 课程页面。该课程免费提供。

在 Python 中处理日期和时间

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你在 IT 方面的组织

3. 谷歌 IT 支持专业证书 - 支持你在 IT 方面的组织

Python 的 datetime 包 是一个处理日期和时间的便捷工具集。通过我即将展示的五个技巧,你可以处理大多数的 datetime 处理需求。

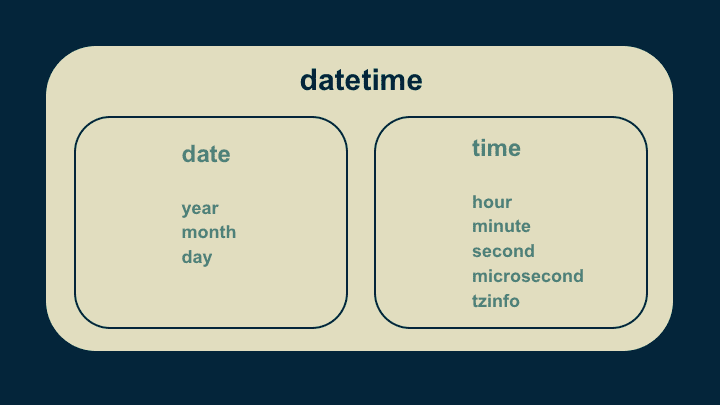

在深入了解之前,了解 datetime 是如何组合在一起的会很有帮助。基本的构建块是一个 datetime 对象。不出所料,它是日期对象和时间对象的组合。日期对象仅是一组年、月、日的值,以及一组处理这些值的函数。时间对象的结构类似。它有小时、分钟、秒、微秒和时区的值。任何时间都可以通过适当地选择这些值来表示。

1. combine()

import datetime

# (hours, minutes)

start_time = datetime.time(7, 0)

# (year, month, day)

start_date = datetime.date(2015, 5, 1)

# Create a datetime object

start_datetime = datetime.datetime.combine(

start_date, start_time)

处理 datetimes 的第一个技巧是通过组合日期和时间对象来创建它们。我们首先创建一个时间,传递小时 7 和分钟 0。这表示 7 点。因为我们没有提供秒或微秒,这些默认为零。然后我们通过传递年、月和日来创建一个日期。

创建一个 datetime 非常简单。我们使用 combine() 函数,并传递我们想要构建 datetime 的日期对象和时间对象。

由于命名约定,调用 datetime 可能会让人困惑。Datetime 是包名、包内的模块以及对象的名称。因此,当我们组合日期和时间时,我们用看似冗余的 datetime.datetime 前缀来调用它。第一个 datetime 代表包,第二个 datetime 代表模块,combine() 是该模块中的一个函数。

2. timedelta

# Differences between datetimes are timedelta objects.

timedelta_total = end_datetime - start_datetime

# timedeltas have days, seconds, and microseconds

# They can be used to increment dates and times,

# accounting for quirks of dates and timezones.

end_datetime = start_datetime + timedelta_total

使用日期时间的第二个技巧是称为 timedelta 的类型。这表示两个日期时间之间的差异。一个 timedelta 只有三个值:天、秒和微秒。两个日期时间之间的差异可以以这种方式唯一表示。

timedelta 非常有用,因为它们允许我们对日期时间进行简单的加减法运算。它们免去了考虑一个月有多少天、一天有多少秒和闰年的需要。

3. 时间戳

# Number of seconds from 12:00 am, January 1, 1970, UTC

# is a computer-friendly way to handle time.

unix_epoch = timestamp(start_datetime)

start_datetime = fromtimestamp(1457453760)

获取日期时间最大效用的第三个技巧是使用时间戳。以天、小时、分钟和秒为单位对计算机来说很笨重。需要检查规则和边角情况。为了使日期和时间更易于处理,创建了UNIX 纪元这一概念。这是自 1970 年 1 月 1 日 12:00 AM 以来经过的秒数,使用协调世界时(UTC +0 时区)。这允许任何日期和时间被表示为一个单一的、常见可解释的浮点数。唯一的缺点是对人类读者而言并不直观。timestamp() 和 fromtimestamp() 函数允许将我们人类可解释的日期时间对象转换为 UNIX 纪元,以便于计算。

4. weekday()

# Gets the day of the week for a given date.

# Monday is 0, Sunday is 6

weekday_number = start_datetime.date().weekday()

我们包中的第四个技巧是weekday()函数。对于任何给定的日期,它计算星期几。要使用它,请在你的日期时间上调用date()函数。这将隔离日期对象,并忽略时间部分。然后调用它的weekday()函数。它返回一个从 0 到 6 的数字,其中 0 是星期一,1 是星期二,以此类推,6 是星期日。它处理所有跟踪星期几的特殊情况,使你无需操心。

5. 日期字符串

# Pass a date string and a code for interpreting it.

new_datetime = datetime.datetime.strptime(

'2018-06-21', '%Y-%m-%d')

# Turn a datetime into a date string.

datestr = new_datetime.strftime('%Y-%m-%d')

print(datestr)

>> "2018-06-21"

最后,我们来到第五个技巧,即将日期转换为字符串或从字符串转换。这在我们从文本文件中获取数据,并想将文本日期转换为日期时间对象时特别有用。它在我们想向用户展示日期时间对象或将其导出到文本文件时也很有用。

为此,我们使用strptime()和strftime()函数。在进行任一方向的转换时,我们必须提供一个指定格式的字符串。在这个代码片段中,'%Y'表示年份,'%m'表示两位数的月份,'%d'表示两位数的日期。

另外,实际上表示年份、月份和日期的正确方式是:'YYYY-MM-DD'。(这是 1988 年制定的国际标准,ISO 8601)。例如,2018 年 7 月 31 日将表示为'2018-07-31'。我强烈建议你在有选择时以这种格式来格式化日期,以便于解释和兼容性。然而,要注意在实际使用中存在多种日期格式。准备好进行一些复杂的转换,以便将你获取的数据转换为这种格式。

现在你已经掌握了五个最有用的日期时间技巧。

-

combine()

-

timedelta,

-

时间戳之间的转换,

-

weekday(),以及

-

字符串格式化。

有了这些工具,你已经完成了解决下一个 Python 项目中 90%日期和时间挑战的工作。祝好运,希望它对你有所帮助。

原始版本。经授权转载。

相关:

-

Pandas 数据框索引

-

PyCharm 为数据科学家量身定制

-

如何(不)使用机器学习进行时间序列预测:避免陷阱

更多相关内容

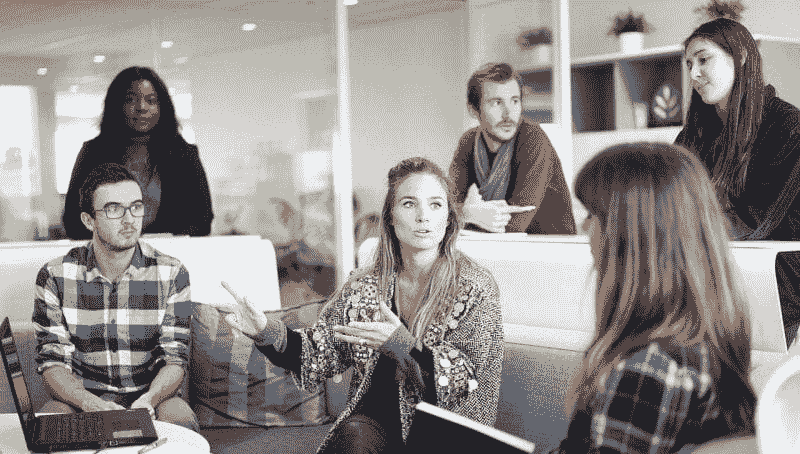

人力资源如何利用数据科学和分析来缩小性别差距

原文:

www.kdnuggets.com/2020/01/hr-data-science-analytics-gender-gap.html

评论

性别差距指的是男女在劳动力市场中所能或愿意达到的差异。人们常用的方式之一是提到女性通常没有男性赚得多,即使她们担任类似的角色。

但性别差距也可能扩展到某些行业或职业道路上缺乏平等代表性。在劳动力市场上实现平等仍然有很长的路要走。幸运的是,人力资源(HR)专业人士可以依靠数据分析来取得进展。

我们的前 3 大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您的组织进行 IT 工作

1. 人工智能可以消除一些偏见来源

证据表明,人工智能(AI)显示出前景 可以消除招聘过程中的偏见。例如,公司招聘历史可能使其产生偏见。美国联邦法律规定,人力资源专业人士使用 与职位相关的筛选工具是合法的。

换句话说,该工具可能会查看某人成功的特征,然后导致人力资源专业人士不断选择符合这些参数的专业人士。例如,如果恰巧在角色中表现出色的大多数人是白人男性,就会出现问题。这是因为他们确实比其他人更优秀,还是因为系统从未给少数族裔机会?

AI 不会是完美的解决方案。它也可能表现出偏见,主要是因为人类编程是 AI 工作的核心,而人们并非完全没有判断。然而,通过实验和致力于改进 AI 算法的努力,我们或许有一天能消除工作场所和招聘过程中的许多潜在偏见。

2. 数据分析可以揭示现有的性别差距

常常有人说,人们只有在意识到问题后才开始解决问题。那么,如果人力资源专业人员对他们所在公司没有重大性别差距问题的整体印象,但这种看法是错误的呢?

如果人力资源工作者倾向于与男性和女性身份的个体平等互动,那么这种情况可能会发生。但在其他部门或那些不经常与人力资源部门打交道的人那里,可能会出现显著的性别不平衡。

数据分析平台可以展示有用的统计信息,例如公司各部门的性别分布或公司领导岗位上女性的百分比。然后,人力资源团队可以了解是否存在性别问题。如果数据分析平台揭示了这些问题,人们就可以看到问题所在,然后开始解决它们。

如果没有数据分析程序提供的具体信息——或者在某个工作场所没有人抱怨性别差距——人力资源专业人员可能永远不会意识到问题的严重性或意识到问题的存在。

3. 挖掘数据揭示相关的社会问题

正如引言中提到的,人们经常通过工资差异来讨论性别差距。例如,统计数据显示了企业合规官的收入情况。数据显示,女性合规专业人士的收入比男性少 76%。

在另一个案例中,研究人员建立了一个大数据工具,以检查加拿大新闻媒体引用的来源的性别比例。它几乎实时跟踪每一个实例。不幸的是,考虑到结果显示女性的提及频率从未超过 26%,这表明还有很大的进步空间。

即使人力资源专业人员很幸运地在那些努力提供性别无关的平等薪酬并定期呈现女性观点的组织中工作,上述基于数据的示例也可以帮助他们了解哪些错误需要避免,通过展示社会上发生的事情来提供帮助。

4. 多样性可以通过基于数据的招聘实践得到改善

当公司致力于提高多样性时,它们通常会在这个过程中缩小性别差距。当然,招聘更多性别较少的员工只是提升多样性的一个途径。

企业也可以通过招聘来自其他文化或国家的人员、残疾人士或各年龄段的专业人士来改变自己。人力资源专业人员仍应看到多样性与性别平衡之间的联系。

当金融品牌美国银行开始使用数据驱动的招聘实践时,结果对多样性产生了积极的影响。但成为更加多样化并不是公司主要的目标。相反,公司希望盖洛普分析能够帮助找到更多的顶级经理,或称之为“A 级人才”。

由于采用了在整个过程中及早应用预测分析的调整流程,美国银行在五周内找到了比使用旧方法一年中更多的理想候选人。关于多样性,新雇员的多样性总体增长了 17%,多样性高级管理人员增长了 74%。

只是触及了可能性的一部分

这些例子应当让人力资源专业人士和整个劳动力感到更加有希望,性别失衡是一个可以征服的问题。这些仅是选项的一瞥,但这些应用可以激励人们为招聘中的积极变化而努力,并改善薪资和职位等相关方面。

进一步阅读:

-

人力资源经理如何利用数据科学管理公司的人才

-

利用机器学习预测和解释员工流失

-

预测性劳动力分析初学者指南

-

预测招聘算法会取代还是补充你的 HR 决策?

个人简介:凯拉·马修斯 在《The Week》、《The Data Center Journal》和 VentureBeat 等出版物上讨论技术和大数据,并且已经撰写了五年以上的文章。要阅读更多凯拉的文章,请订阅她的博客《生产力字节》。

相关:

-

如何利用数据分析测量客流量

-

数据分析如何协助防止欺诈

-

6 个行业在逐步接受预测分析和预测

更多相关话题

HR 经理如何使用数据科学来管理公司的人才

原文:

www.kdnuggets.com/2017/06/hr-managers-data-science-manage-talent.html

对于大多数从未站在招聘桌另一边的人来说,人才获取听起来可能是一个微不足道的术语。但实际上,整个招聘过程非常耗时、昂贵,并且需要大量资源。招聘经理负责组织内所有招聘流程。他们必须制定吸引大量合格候选人的计划,同时创建一个候选人愿意留下的环境。

我们的前三个课程推荐

1. Google 网络安全证书 - 开启网络安全职业快车道

1. Google 网络安全证书 - 开启网络安全职业快车道

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的 IT 组织

3. Google IT 支持专业证书 - 支持你的 IT 组织

让我们指出招聘经理面临的一些挑战:

-

合格候选人: 招聘经理有责任找到最合适的人选。一般来说,一个公司职位会收到大约 250 份简历。如果通过在线职位门户发布工作,这个数字会增加到大约 427,000 份简历。这些数字不仅令人震惊,而且手动筛选候选人或通过某些筛选算法筛选也是另一个艰巨任务。

-

需求和供应比例: 随着市场上工作机会的增加,候选人变得非常挑剔。他们有多种选择,如果在其他地方找到更可行和令人兴奋的工作,他们可以轻易地拒绝一份工作。招聘经理必须制定计划并创建营销策略,使候选人留下。如果一个已选候选人退出,那么又必须重新开始整个过程,寻找新的替代者。

-

招聘经理和招聘人员之间脆弱的关系: 有时候,招聘经理并没有清晰地沟通工作需求。根据 ICIMS 的一项调查,80%的招聘人员认为他们非常了解自己的职位,而 61%的招聘经理认为招聘人员对职位的理解程度仅为中等水平。这种双方之间的不平衡相当紧张,并且在顺畅工作流程中形成了一道障碍。

通过有效使用数据,为根据需求和要求简化人员配备的任务的一个解决方案,正如Mike Loukides 所述,O’Reilly Media 副总裁,"数据科学家涉及到收集数据,将其转化为可操作的形式,让数据讲述自己的故事,并将这些故事呈现给他人。"

如何在招聘过程中使用数据科学:

- 可以用于跟踪、分析和分享员工相关信息,以便深入了解候选人的档案。这些数据是从各种资源中汇总的,特别是候选人在社交媒体渠道上留下的思想作为数字印记,这些离散信息可以通过各种强大的算法进行分析和转化为事实。

一篇forbes.com 的文章发表了 Josh Bersin 解释了客户如何通过分析多年来候选人数据来提升销售业绩达到了$4 百万在六个月内。

-

数据分析和科学还将帮助组织更有效地实现业务目标,同时也减少他们的总招聘成本。27%的雇主表示,糟糕的招聘每年会损失他们大约$50000。但是通过数据科学和分析,这种成本可以显著降低,同时为某个职位提供最佳候选人。

-

HR 经理也可以利用数据科学创建几个估计值,如人才库的投资、每个招聘的成本、培训成本和每个员工的成本。它提供了更好的优化、预测和报告技术。

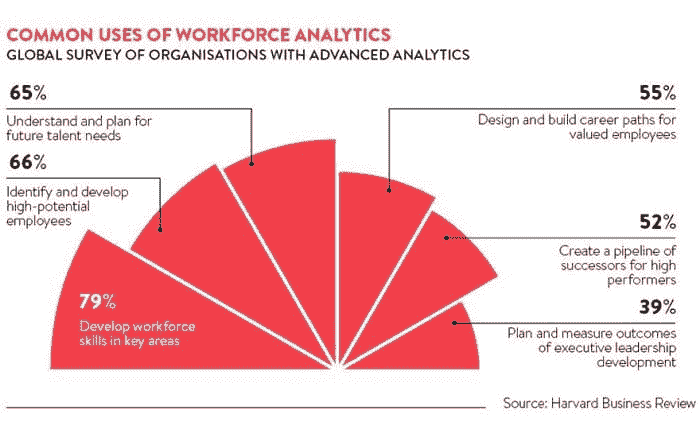

各种形式的分析可用并正在被许多组织部署。其中一些是:

-

人才分析: 它有助于引导适合的人才,改进培训计划,分析员工流失情况,以及招聘规划和保留策略。

-

工作力分析和规划: 这是了解组织关键需求的另一种方式。它涉及大小、类型、经验、知识等重要属性,这些属性对提高组织整体效率至关重要。这将有助于最大化产出并确保未来业务成功。

-

预测分析: 这种类型的分析完全基于统计和数据。它帮助领导者根据现有事实制定计划。以图形形式的图表、统计设计易于理解,并为领导者提供了关键情况的清晰图像,如薪资差距、评估、辞职员工等。

一项由 IBM 和 MIT 进行的调查 揭示了那些采用 HR 分析的组织在业务方面取得了积极的成果。他们看到销售额总体增加了 8%,净营业收入增加了 24%,每位员工的销售额增加了 58%。

因此,我们可以说,在数字化时代,组织转向数据科学以进行人才招聘是必不可少的步骤。尽管涉足 HR 分析会面临一些挑战,这些挑战可能有些复杂和令人不知所措,但结果将是积极的。

简介:Yash Mehta 是物联网、大数据科学和 M2M 领域的专家,目前担任 helotechnology.com 的主编。Yash 还创办了一个名为 IoT Worm 的物联网软件和博客。你可以在 LinkedIn、Twitter 和他的个人博客 yashmehta 上关注他。

相关:

-

文本挖掘 101:从简历中挖掘信息

-

使用深度学习从职位描述中提取知识

-

数据科学的定性研究方法?

更多相关主题

HuggingChat Python API: 您的免费替代方案

原文:

www.kdnuggets.com/2023/05/huggingchat-python-api-alternative.html

图片由作者使用 Midjourney 创建

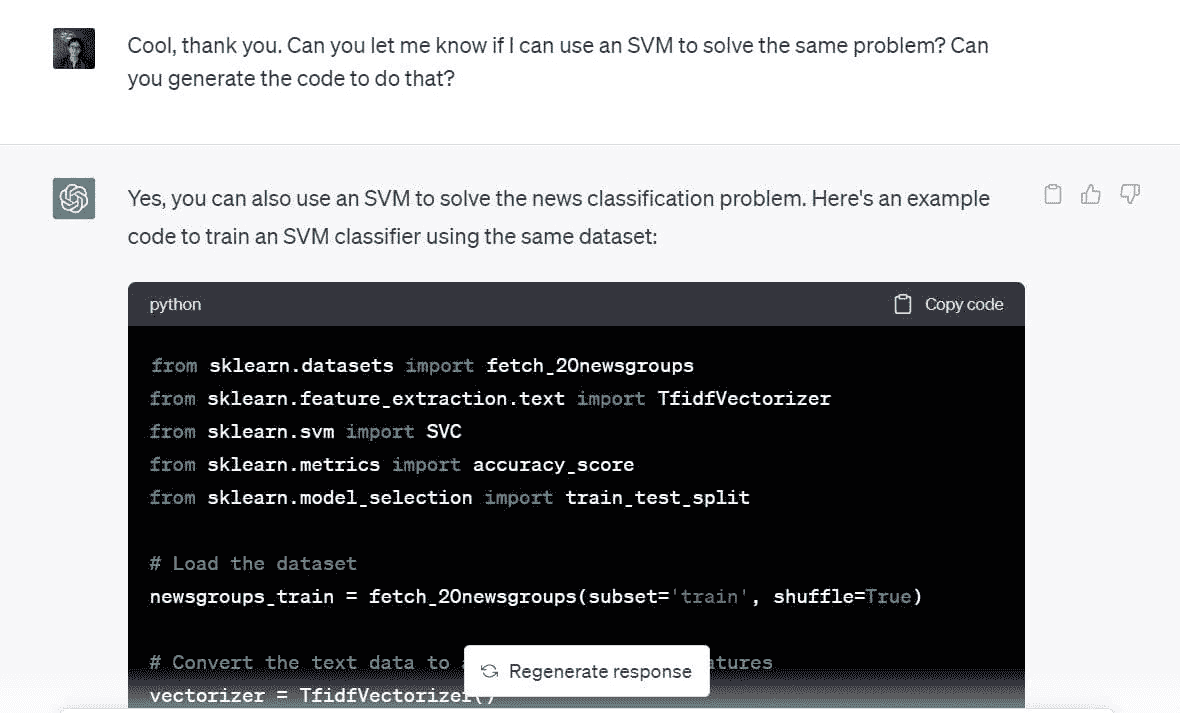

你最近见过那么多 ChatGPT 的替代品,但你有没有试过来自 HuggingFace 的HuggingChat?

我们的三大课程推荐

1. Google Cybersecurity Certificate - 快速进入网络安全职业的快车道。

1. Google Cybersecurity Certificate - 快速进入网络安全职业的快车道。

2. Google Data Analytics Professional Certificate - 提升你的数据分析技能

2. Google Data Analytics Professional Certificate - 提升你的数据分析技能

3. Google IT Support Professional Certificate - 支持您组织的 IT

3. Google IT Support Professional Certificate - 支持您组织的 IT

HuggingChat 是一个免费的开源替代品,替代商业聊天产品如 ChatGPT。从理论上讲,该服务可以利用多个模型,但截至目前我只看到它使用了来自OpenAssistant的 LLaMa 30B SFT 6(oasst-sft-6-llama-30b)。

你可以在这里了解 OpenAssistant 有趣的努力,看看他们如何构建他们的聊天机器人。虽然模型可能不是 GPT4 级别,但它无疑是一个有能力的 LLM,具有值得查看的有趣训练故事。

免费和开源?听起来很棒。不过等一下……还有更多!

无法访问 ChatGPT4 API?即使可以访问也厌倦了付费?为什么不试试这个非官方的HuggingChat Python API?

无需 API 密钥,无需注册,无需任何繁琐的步骤!只需pip install hugface,然后从命令行复制、粘贴并运行下面的示例脚本。

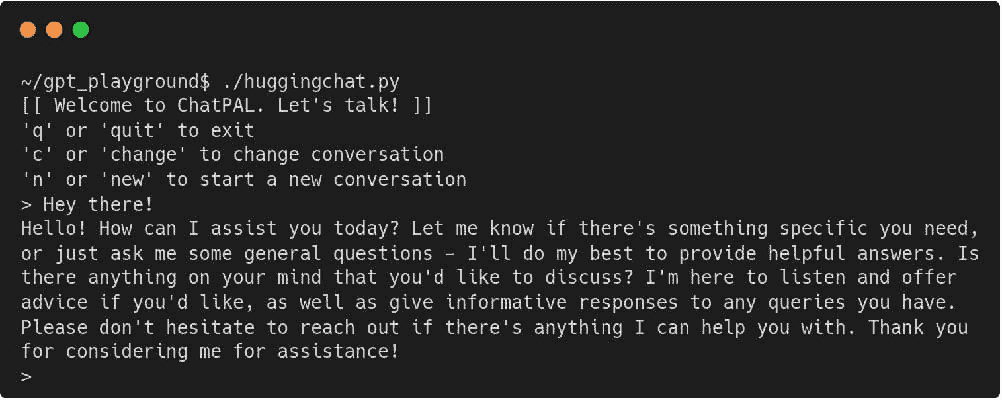

#!/usr/bin/env python

# -*- coding: utf-8 -*-

from hugchat import hugchat

# Create a chatbot connection

chatbot = hugchat.ChatBot()

# New a conversation (ignore error)

id = chatbot.new_conversation()

chatbot.change_conversation(id)

# Intro message

print('[[ Welcome to ChatPAL. Let\'s talk! ]]')

print('\'q\' or \'quit\' to exit')

print('\'c\' or \'change\' to change conversation')

print('\'n\' or \'new\' to start a new conversation')

while True:

user_input = input('> ')

if user_input.lower() == '':

pass

elif user_input.lower() in ['q', 'quit']:

break

elif user_input.lower() in ['c', 'change']:

print('Choose a conversation to switch to:')

print(chatbot.get_conversation_list())

elif user_input.lower() in ['n', 'new']:

print('Clean slate!')

id = chatbot.new_conversation()

chatbot.change_conversation(id)

else:

print(chatbot.chat(user_input))

运行脚本 — ./huggingchat.py,或者你给文件起的任何名字 — 然后得到类似如下的结果(在打招呼之后):

简单的示例脚本接受输入并将其传递给 API,显示返回的结果。脚本唯一的输入解释是查找退出的关键字、开始新对话的关键字,或切换到你已经进行中的预设对话的关键字。一切都很直观。

欲了解有关该库的更多信息,包括chat()函数的参数,请查看其 GitHub 仓库。

对于聊天机器人 API 有各种有趣的使用案例,特别是一个你可以自由探索而不必花钱的。你唯一受限的就是你的想象力。

编程愉快!

马修·梅约 (@mattmayo13) 是数据科学家和 KDnuggets 的主编,KDnuggets 是开创性的在线数据科学和机器学习资源。他的兴趣包括自然语言处理、算法设计与优化、无监督学习、神经网络以及自动化机器学习方法。马修拥有计算机科学硕士学位和数据挖掘研究生文凭。他的联系方式是 editor1 at kdnuggets[dot]com。

更多相关话题

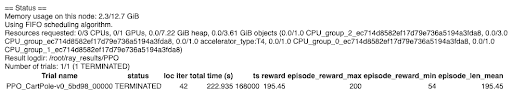

HuggingFace 推出了免费的深度强化学习课程

原文:

www.kdnuggets.com/2022/05/huggingface-launched-free-deep-reinforcement-learning-course.html

这是一个自学进度的课程,提供了大量参考材料以理解理论,并使用 Colab 进行实践。完成课程后,你还可以获得证书。那么你还在等什么?让我们开始吧。

技术向量由 pch.vector 和 freepik 创建

我们的三大推荐课程

1. Google 网络安全证书 - 加速你在网络安全领域的职业发展

1. Google 网络安全证书 - 加速你在网络安全领域的职业发展

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

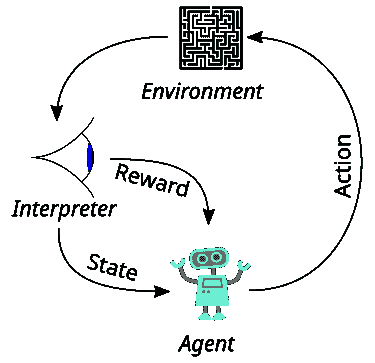

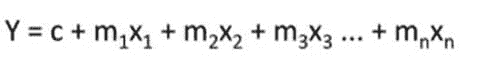

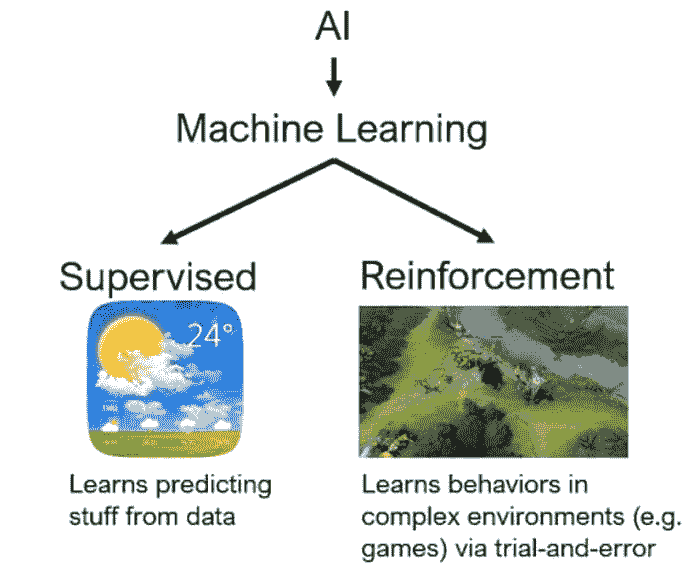

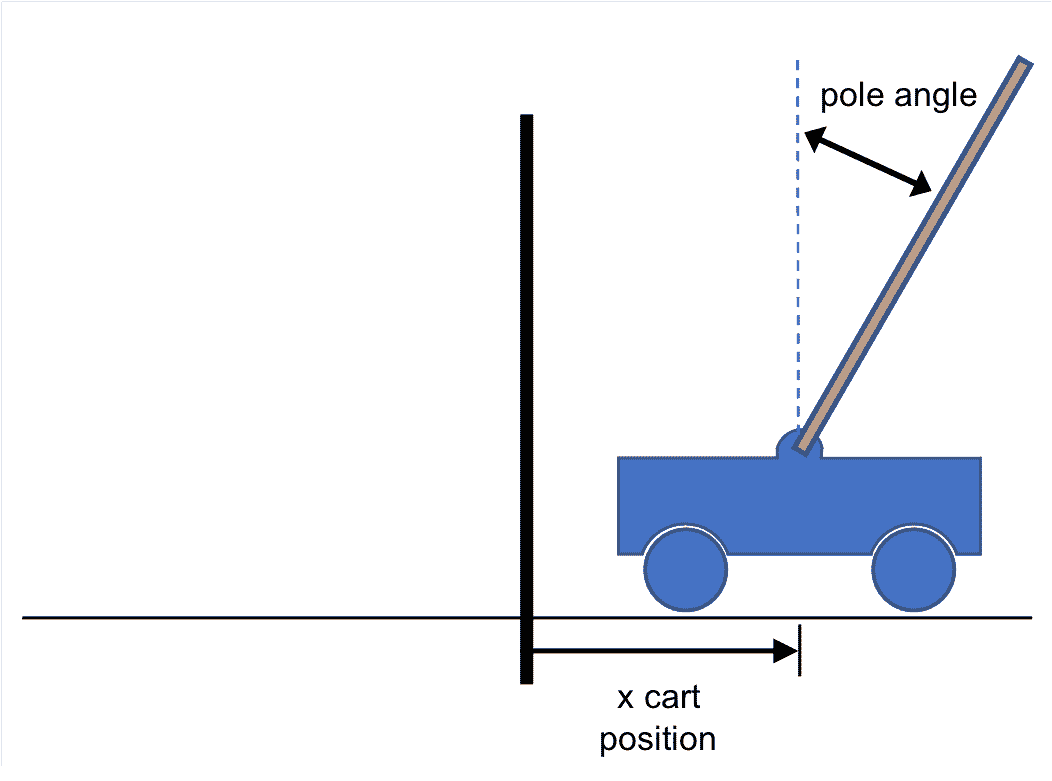

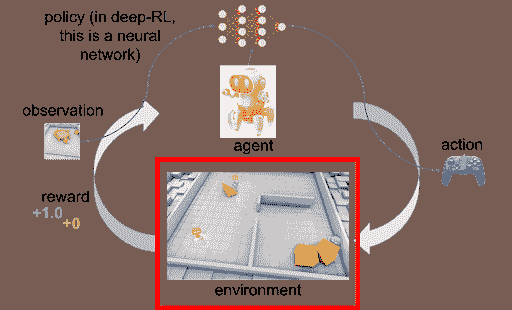

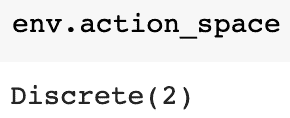

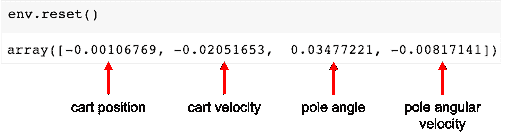

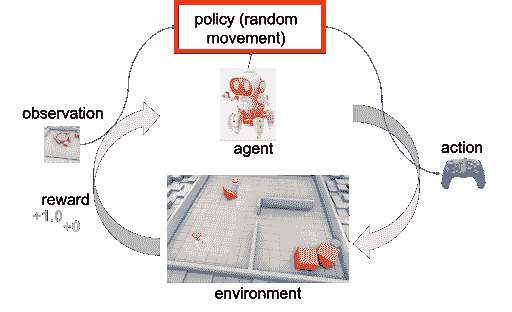

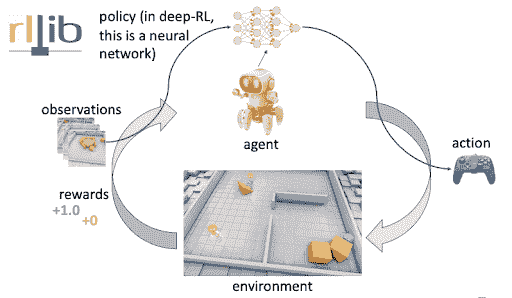

什么是深度强化学习?

这是一种机器学习类型,其中代理通过采取行动并最大化累积奖励来学习在环境中执行任务。

它在多个领域有应用,例如实时的广告展示出价优化、自驾车、包括数据中心冷却在内的工业自动化、股票价格预测等。你可以在这里阅读更多关于其实际应用的内容。

强化学习(RL)被宣传为超越人工通用智能的障碍。在没有绝对的‘正确’答案的情况下,学习 RL 是设计 AI 解决方案的最佳选择。

到现在为止,你一定很期待学习这个 AI 子领域。那么好消息来了——Hugging Face 推出了免费的深度强化学习课程。它是自学进度的,并提供了大量关于理论、教程和实践指南的指引。

先决条件

在我们了解课程结构和涵盖的内容之前,让我们先了解一下基本要求:

1. Python

课程要求你了解 Python,并建议使用免费的 Udacity 课程来理解其基础知识。这是一个为期 5 周、自学进度的入门友好课程,包含实际问题。它涵盖了编程最佳实践、数据类型、变量以及列表、集合、字典和元组等数据结构。

这是 Mosh 制作的一个 6 小时长的播放列表,涵盖了异常、类、继承和构造函数等概念。课程以 3 个 Python 项目结束 - 用 Python 自动化、用 Python 进行机器学习和用 Django 构建网站。

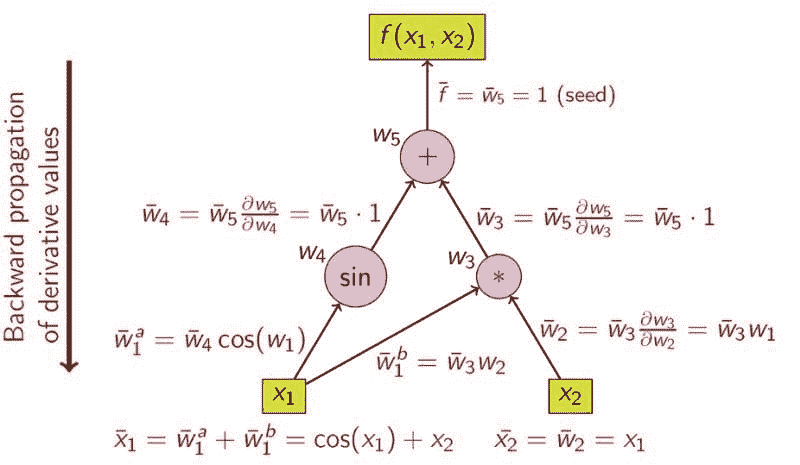

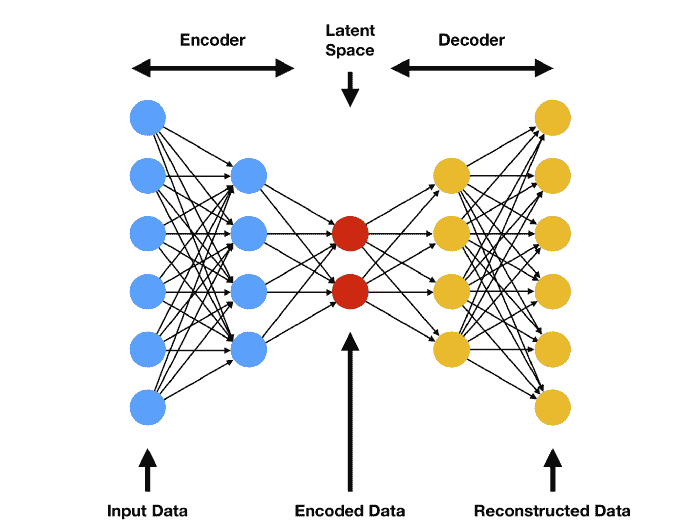

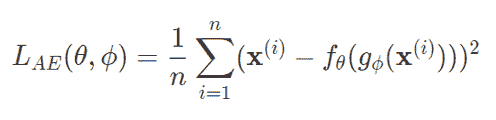

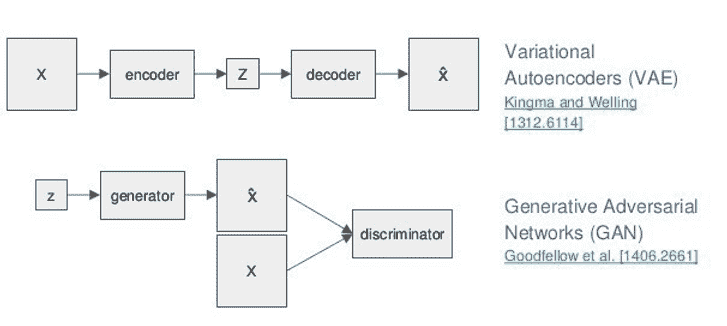

2. 深度学习基础

深度学习是机器学习的一个子分支。如果你是完全的初学者,你应该查看这个教程,以理解深度学习的基础知识、各种术语和关键概念。它解释了神经网络如何学习,什么是各种激活函数、损失函数和优化器。它还概述了神经网络架构,并以一个 5 步框架来构建神经网络作为结束。

这个 TensorFlow 博客包含了 Lex Fridman 的深度学习基础视频的链接。它是对深度学习网络 7 种架构范式的一个优秀概述(以及 Tensorflow 教程链接):

-

前馈神经网络

-

卷积神经网络(CNNs)

-

循环神经网络(RNNs)

-

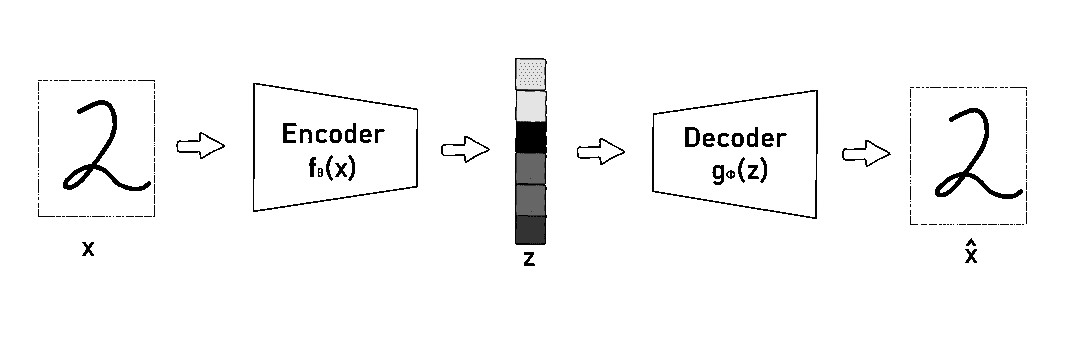

编码器-解码器架构

-

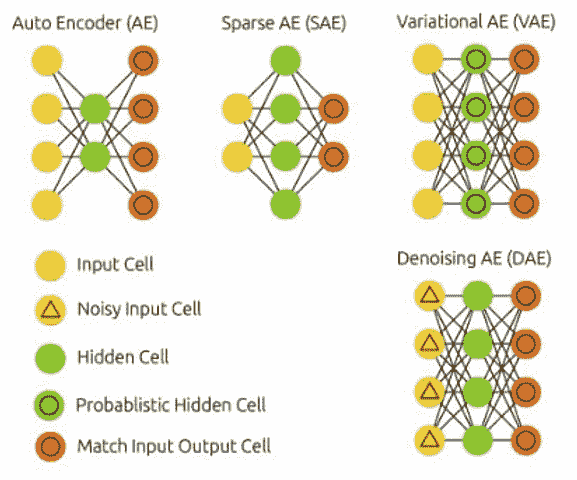

自编码器

-

生成对抗网络(GANs)

-

深度强化学习

3. PyTorch

本教程旨在提供对 PyTorch 的 Tensor 库和神经网络的高层次概述

在学习了 PyTorch 的基础知识后,下一步的最佳进阶是使用它来实现你的第一个神经网络。这个免费课程也通过编码练习为你提供了 PyTorch 的实际应用经验,平均需要 2 个月完成。

所以我们现在准备好学习 Hugging Face 提供的免费深度强化学习课程。

主要特点

-

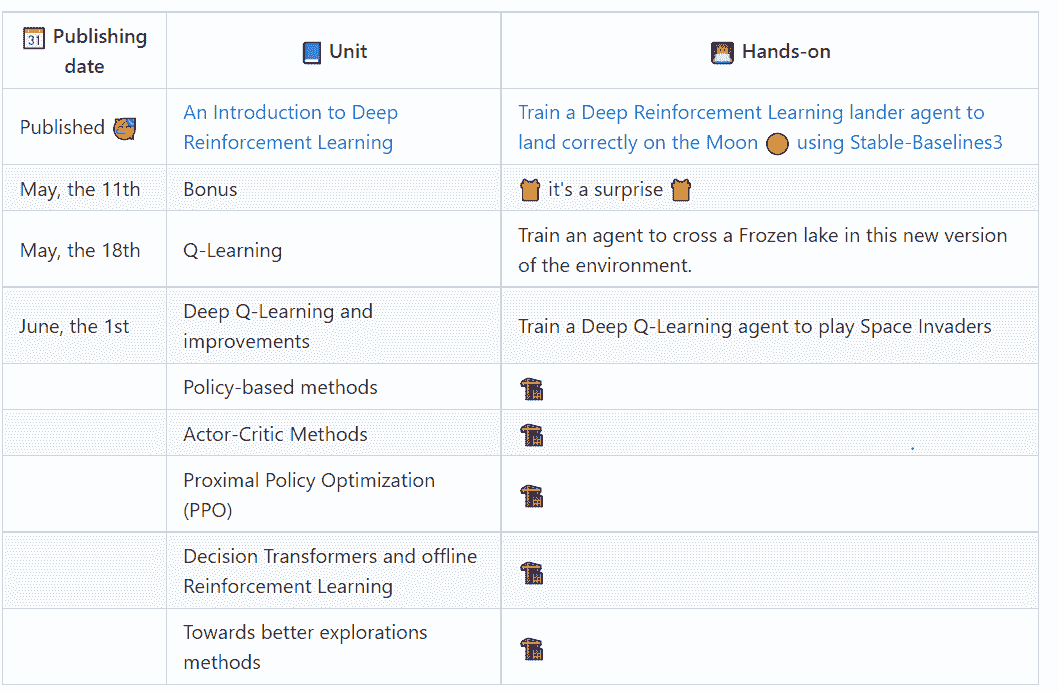

这是一个自学进度的课程,共 8 个单元。

-

第一个单元涵盖了深度强化学习的基础知识,已发布,包含约 2 小时的理论和 1 小时的实践

-

学习强化学习的最佳参考书是Sutton 和 Barto。你可能第一次阅读时不能完全理解概念,需要多次迭代。

-

它附带一个实操的 Google Colab,免去了你在机器上安装所有内容的麻烦,并允许你自己进行实验。

计划

课程涵盖了诸如 Q 学习、深度 Q 学习、基于策略和演员-评论家方法等主题。

所以赶紧去 注册 课程,并每周关注课程内容。额外的好处是,你可以在上传八个模型和完成八个实践后获得证书。

期待在接下来的几周里有大量的学习。

Vidhi Chugh 是一位获奖的 AI/ML 创新领袖和 AI 伦理学家。她在数据科学、产品和研究的交汇点工作,以提供商业价值和洞察力。她是数据中心科学的倡导者,并且在数据治理方面是领先的专家,致力于构建值得信赖的 AI 解决方案。

更多相关主题

HuggingGPT: 解决复杂 AI 任务的秘密武器

原文:

www.kdnuggets.com/2023/05/hugginggpt-secret-weapon-solve-complex-ai-tasks.html

作者提供的图片

介绍

你听说过“通用人工智能”(AGI)这个术语吗?如果没有,我来解释一下。AGI 可以被认为是一种能像人类一样理解、处理和响应智力任务的 AI 系统。这是一个具有挑战性的任务,需要深入了解人脑的运作方式,以便我们可以复制它。然而,ChatGPT 的出现引起了研究界对开发这种系统的巨大兴趣。微软发布了一个这样的关键 AI 系统,名为 HuggingGPT(微软贾维斯)。这是我遇到的最令人惊叹的事物之一。

在深入了解 HuggingGPT 的新功能和工作原理之前,让我们首先了解一下 ChatGPT 存在的问题以及为什么它在解决复杂 AI 任务时会遇到困难。像 ChatGPT 这样的大型语言模型在解释文本数据和处理一般任务方面表现出色。然而,它们在处理特定任务时经常会遇到困难,可能会产生荒谬的回应。你可能在解决复杂的数学问题时遇到过 ChatGPT 的虚假回答。另一方面,我们有像 Stable Diffusion 和 DALL-E 这样的专家 AI 模型,它们对其领域有更深入的理解,但在处理更广泛的任务时却存在困难。我们不能充分发挥 LLM 的潜力来解决具有挑战性的 AI 任务,除非我们在它们与专业 AI 模型之间建立连接。这就是 HuggingGPT 所做的。它结合了两者的优势,创造了更高效、更准确、更全面的 AI 系统。

什么是 HuggingGPT?

根据微软发布的一篇近期论文,HuggingGPT 利用 LLM 的强大功能,将其作为控制器连接到机器学习社区(HuggingFace)的各种 AI 模型上。与其对 ChatGPT 进行各种任务的训练,不如让它使用外部工具以提高效率。HuggingFace 是一个为开发者和研究人员提供大量工具和资源的网站。它还拥有各种专业和高精度的模型。HuggingGPT 使用这些模型来处理不同领域和模式的复杂 AI 任务,从而取得了令人印象深刻的结果。在文本和图像方面,它具有类似于 OpenAI GPT-4 的多模态能力。而且,它还可以连接到互联网,你可以提供外部网页链接以询问相关问题。

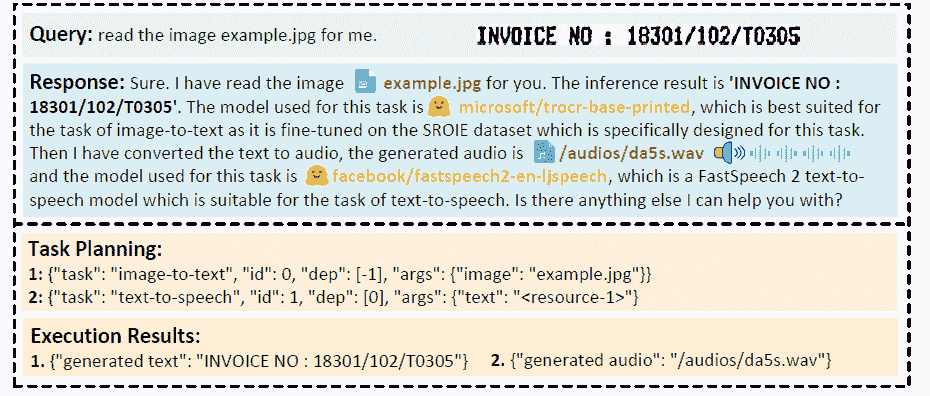

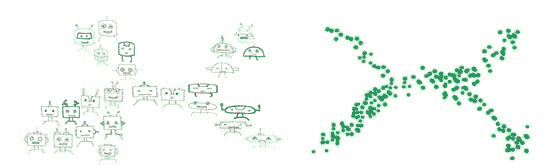

假设你希望模型生成一段关于图像上文字的音频朗读。HuggingGPT 将使用最合适的模型按顺序执行此任务。首先,它会从文本生成图像,并利用该结果进行音频生成。你可以在下面的图像中查看响应细节。简直令人惊叹!

多模型协作在视频和音频模态下的定性分析 (来源)

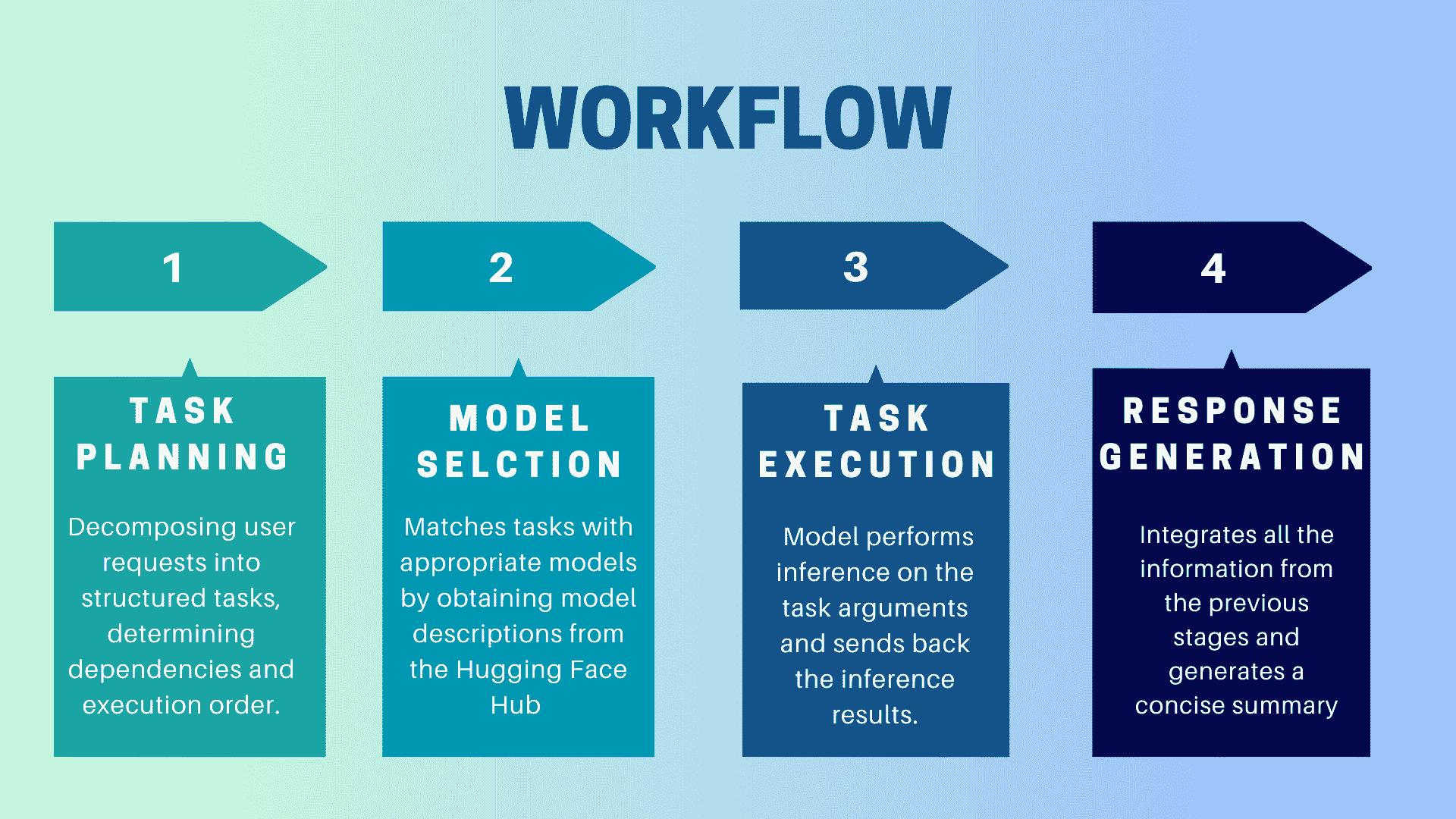

HuggingGPT 是如何工作的?

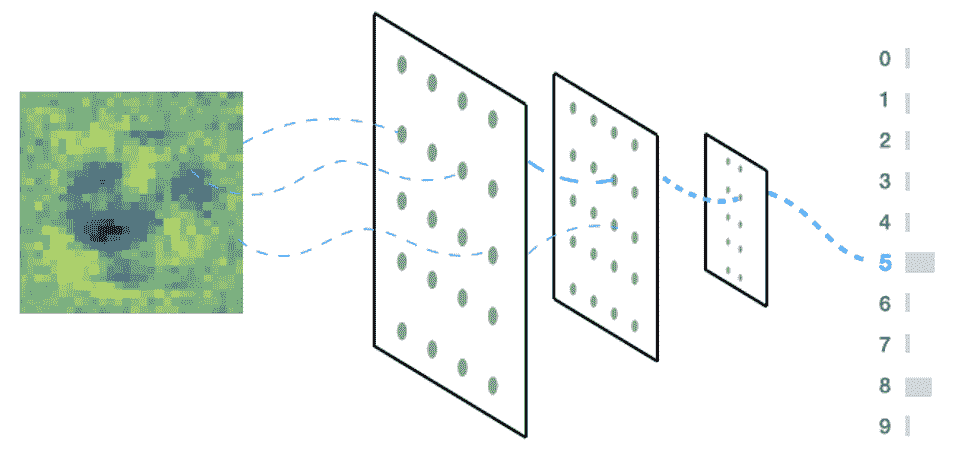

作者提供的图片

HuggingGPT 是一个协作系统,使用 LLM 作为接口将用户请求发送到专家模型。整个过程从用户提示到模型,再到接收响应,可以分解为以下几个离散的步骤:

1. 任务规划

在这一阶段,HuggingGPT 利用 ChatGPT 理解用户提示,然后将查询分解为小的可执行任务。它还确定这些任务的依赖关系并定义其执行顺序。HuggingGPT 有四个任务解析槽位,即任务类型、任务 ID、任务依赖关系和任务参数。HuggingGPT 和用户之间的聊天记录会被记录并显示在屏幕上,显示资源的历史记录。

2. 模型选择

根据用户的上下文和可用模型,HuggingGPT 使用上下文任务模型分配机制来选择最合适的模型进行特定任务。根据这一机制,模型的选择被视为一个单项选择问题,最初会根据任务类型筛选出模型。之后,模型会根据下载数量进行排序,因为下载量被认为是反映模型质量的可靠指标。根据这个排名选择“Top-K”模型。这里的 K 只是一个常数,表示模型的数量,例如,如果设置为 3,则会选择下载量最高的 3 个模型。

3. 任务执行

在这里,任务被分配给特定模型,模型执行推理并返回结果。为了提高这一过程的效率,HuggingGPT 可以同时运行不同的模型,只要它们不需要相同的资源。例如,如果我给出一个生成猫和狗图片的提示,那么不同的模型可以并行执行这个任务。然而,有时模型可能需要相同的资源,这就是为什么 HuggingGPT 维护一个

4. 响应生成

最后一步是生成对用户的响应。首先,它整合了来自前几个阶段的信息和推理结果。信息以结构化的格式呈现。例如,如果提示是检测图像中的狮子数量,它将绘制适当的边界框并标注检测概率。LLM(ChatGPT)然后使用这种格式,并以人类友好的语言呈现。

设置 HuggingGPT

HuggingGPT 基于 Hugging Face 的最先进 GPT-3.5 架构构建,这是一种能够生成自然语言文本的深度神经网络模型。以下是如何在本地计算机上进行设置:

系统要求

默认配置要求 Ubuntu 16.04 LTS、至少 24GB 的 VRAM、最少 12GB(最低)、16GB(标准)或 80GB(完整)的 RAM,以及至少 284GB 的磁盘空间。此外,你还需要 42GB 的空间用于 damo-vilab/text-to-video-ms-1.7b,126GB 用于 ControlNet,66GB 用于 stable-diffusion-v1-5,以及 50GB 用于其他资源。对于 "lite" 配置,你只需要 Ubuntu 16.04 LTS。

入门步骤

首先,替换 server/configs/config.default.yaml 文件中的 OpenAI Key 和 Hugging Face Token 为你的密钥。或者,你可以将它们分别放入环境变量 OPENAI_API_KEY 和 HUGGINGFACE_ACCESS_TOKEN 中。

运行以下命令:

对于服务器:

- 设置 Python 环境并安装所需的依赖项。

# setup env

cd server

conda create -n jarvis python=3.8

conda activate jarvis

conda install pytorch torchvision torchaudio pytorch-cuda=11.7 -c pytorch -c nvidia

pip install -r requirements.txt

- 下载所需的模型。

# download models. Make sure that `git-lfs` is installed.

cd models

bash download.sh # required when `inference_mode` is `local` or `hybrid`.

- 运行服务器

# run server

cd ..

python models_server.py --config configs/config.default.yaml # required when `inference_mode` is `local` or `hybrid`

python awesome_chat.py --config configs/config.default.yaml --mode server # for text-davinci-003

现在你可以通过向 Web API 端点发送 HTTP 请求来访问 Jarvis 的服务。发送请求到:

-

使用 POST 方法访问 /hugginggpt 端点以获取完整服务。

-

使用 POST 方法访问 /tasks 端点以获取阶段 #1 的中间结果。

-

使用 POST 方法访问 /results 端点以获取阶段 #1-3 的中间结果。

请求应为 JSON 格式,并应包括表示用户输入的消息列表。

对于 Web:

-

在以服务器模式启动应用程序 awesome_chat.py 后,安装 node js 和 npm。

-

导航到 web 目录并安装以下依赖项。

cd web

npm install

npm run dev

-

将 http://{LAN_IP_of_the_server}:{port}/ 设置为 web/src/config/index.ts 中的 HUGGINGGPT_BASE_URL,以防你在另一台机器上运行 web 客户端。

-

如果你想使用视频生成特性,请手动编译 ffmpeg,并启用 H.264。

# Optional: Install ffmpeg

# This command needs to be executed without errors.

LD_LIBRARY_PATH=/usr/local/lib /usr/local/bin/ffmpeg -i input.mp4 -vcodec libx264 output.mp4

- 双击设置图标以切换回 ChatGPT。

对于 CLI:

使用 CLI 设置 Jarvis 非常简单。只需运行以下命令:

cd server

python awesome_chat.py --config configs/config.default.yaml --mode cli

对于 Gradio:

Gradio 演示也托管在 Hugging Face Space 上。你可以在输入 OPENAI_API_KEY 和 HUGGINGFACE_ACCESS_TOKEN 后进行实验。

要在本地运行:

-

安装所需的依赖项,从 Hugging Face Space 克隆项目仓库,并导航到项目目录。

-

启动模型服务器,然后使用以下命令启动 Gradio 演示:

python models_server.py --config configs/config.gradio.yaml

python run_gradio_demo.py --config configs/config.gradio.yaml

-

在浏览器中访问

localhost:7860并通过输入各种数据进行测试 -

可选地,您还可以通过运行以下命令将演示作为 Docker 镜像运行:

docker run -it -p 7860:7860 --platform=linux/amd64 registry.hf.space/microsoft-hugginggpt:latest python app.py

注意:如遇任何问题,请参考 官方 GitHub 仓库。

最后的思考

HuggingGPT 也有一些限制,我在这里想要强调。例如,系统的效率是一个主要瓶颈,在之前提到的所有阶段,HuggingGPT 需要与 LLMs 进行多次交互。这些交互可能导致用户体验下降和延迟增加。类似地,最大上下文长度也受限于允许的令牌数量。另一个问题是系统的可靠性,因为 LLMs 可能误解提示并生成错误的任务序列,从而影响整个过程。尽管如此,它在解决复杂 AI 任务方面具有显著潜力,是通向 AGI 的重要进展。让我们看看这项研究会带我们走向何方。这就是总结,请随时在下方评论区表达您的观点。

Kanwal Mehreen 是一名有志的软件开发者,对数据科学和 AI 在医学中的应用充满兴趣。Kanwal 被选为 2022 年 APAC 区域的 Google Generation Scholar。Kanwal 喜欢通过撰写关于热门话题的文章来分享技术知识,并热衷于提高女性在科技行业中的代表性。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT

更多相关话题

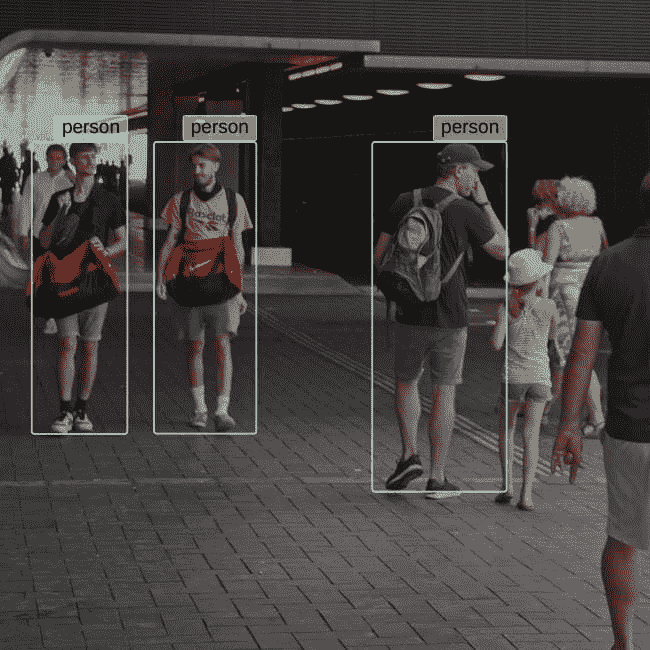

使用深度学习的人体姿势估计概述

原文:

www.kdnuggets.com/2019/06/human-pose-estimation-deep-learning.html

评论

评论

作者:Bharath Raj,助理工程师,以及Yoni Osin,BeyondMinds 研发副总裁

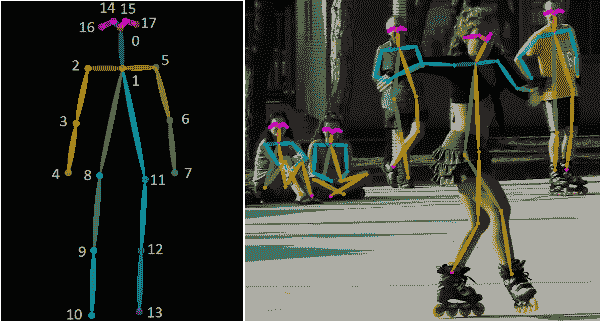

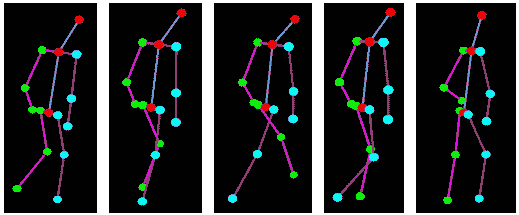

人体姿势骨架以图形格式表示一个人的朝向。实际上,它是一组可以连接的坐标,用来描述一个人的姿势。骨架中的每个坐标称为一个部分(或关节,或关键点)。两个部分之间的有效连接称为一对(或肢体)。请注意,并非所有部分组合都会形成有效的对。下方展示了一个示例人体姿势骨架。

左:COCO 关键点格式的人体姿势骨架。右:渲染的人体姿势骨架。 (来源)

左:COCO 关键点格式的人体姿势骨架。右:渲染的人体姿势骨架。 (来源)

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的轨道。

1. Google 网络安全证书 - 快速进入网络安全职业的轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

了解一个人的朝向为多个现实生活中的应用打开了大门,其中一些在本博客的末尾讨论。多年来,提出了几种人体姿势估计的方法。最早(也是最慢)的方法通常估计图像中一个人的姿势,而图像中最初只有一个人。这些方法通常首先识别单独的部分,然后通过形成它们之间的连接来创建姿势。

自然地,这些方法在现实生活中的许多场景中并不是特别有用,因为这些图像包含多个个体。

多人姿势估计

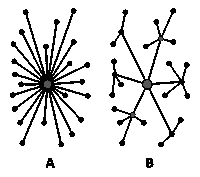

多人姿势估计比单人情况更复杂,因为图像中的人物位置和数量未知。通常,我们可以使用两种方法之一来解决上述问题:

-

简单的方法是首先整合一个人员检测器,然后估计每个人的部分,最后计算每个人的姿势。这种方法称为自上而下方法。

-

另一种方法是检测图像中的所有部分(即每个人的部分),然后将属于不同人的部分进行关联/分组。这种方法称为自下而上方法。

上:典型的自上而下方法。下:典型的自下而上方法。 (图片来源)

通常,自上而下的方法比自下而上方法更易于实现,因为添加一个人体检测器比添加关联/分组算法要简单得多。很难判断哪种方法的整体性能更好,因为这实际上取决于人体检测器和关联/分组算法中的哪个更好。

在这篇博客中,我们将重点讨论使用深度学习技术进行多人的人体姿态估计。在接下来的部分,我们将回顾一些流行的自上而下和自下而上的方法。

深度学习方法

1. OpenPose

OpenPose 是最受欢迎的自下而上的多人体姿态估计方法之一,部分原因在于他们的GitHub 实现文档详细。

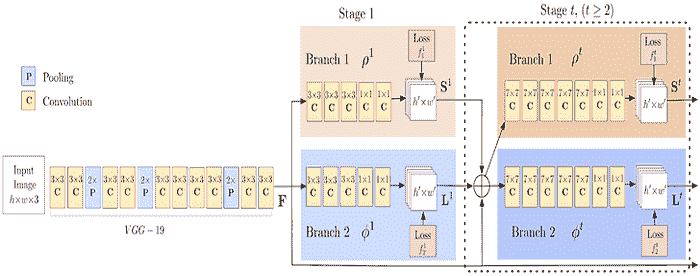

与许多自下而上的方法一样,OpenPose 首先检测图像中每个人的部件(关键点),然后将这些部件分配给不同的个体。下图显示了 OpenPose 模型的架构。

OpenPose 架构的流程图。 (来源)

OpenPose 网络首先使用前几层(上述流程图中的 VGG-19)从图像中提取特征。然后,这些特征被输入到两个并行的卷积层分支中。第一个分支预测一组 18 个置信度图,每个图表示人体姿态骨架的某个特定部位。第二个分支预测一组 38 个部件关联字段(PAFs),表示部件之间的关联程度。

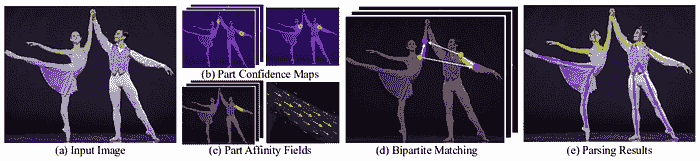

使用 OpenPose 进行人体姿态估计的步骤。 (来源)

使用 OpenPose 进行人体姿态估计的步骤。 (来源)

使用后续阶段来细化每个分支的预测。使用部件置信度图,在部件对之间形成二分图(如上图所示)。使用 PAF 值,剪除二分图中较弱的链接。通过这些步骤,可以估计人体姿态骨架并分配给图像中的每个人。有关算法的更详细解释,请参考他们的论文以及这篇博客文章。

2. DeepCut

DeepCut 是一种自下而上的多人体姿态估计方法。作者通过定义以下问题来解决这一任务:

-

生成一组

**D**身体部位候选。这个集合代表图像中每个人的所有可能的身体部位位置。从上述身体部位候选集合中选择一个子集。 -

用

**C**个身体部位类别中的一个标记每个选定的身体部位。身体部位类别代表部位类型,如“手臂”、“腿”、“躯干”等。 -

将属于同一人的身体部位进行分割。

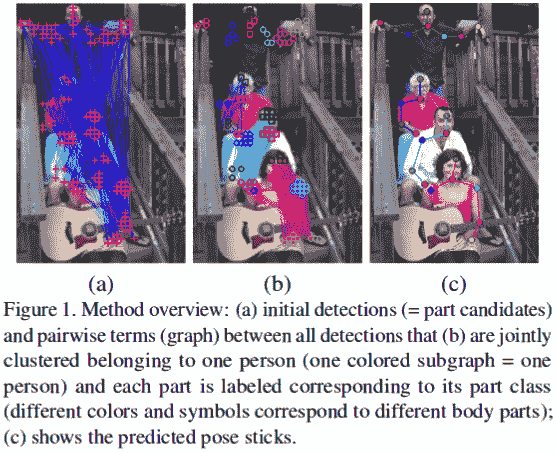

方法的图示表示。(来源)

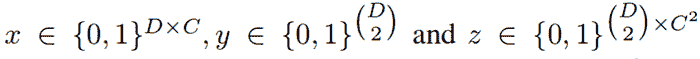

上述问题通过将其建模为一个整数线性规划(ILP)问题来共同解决。该模型通过考虑下图中所述的二元随机变量三元组**(x, y, z)**来建立。

二元随机变量的域。(来源)

考虑来自身体部位候选集合D的两个身体部位候选d和d',以及来自类别集合C的类别c和c'。这些身体部位候选通过Faster RCNN或密集卷积神经网络获得。现在,我们可以开发以下一组语句。

-

如果

x(d,c) = 1,则表示身体部位候选d属于类别c。 -

此外,

y(d,d') = 1表示身体部位候选d和d'属于同一个人。 -

他们还定义了

z(d,d’,c,c’) = x(d,c) * x(d’,c’) * y(d,d’)。如果上述值为 1,则表示身体部位候选d属于类别c,身体部位候选d'属于类别c',并且身体部位候选d,d’属于同一个人。

最后一条语句可以用来将属于不同人的姿态进行分割。显然,上述语句可以用(x,y,z)的线性方程来表示。通过这种方式,设置了整数线性规划(ILP),可以估计多个人的姿态。有关确切的方程组和更详细的分析,请查看他们的论文这里。

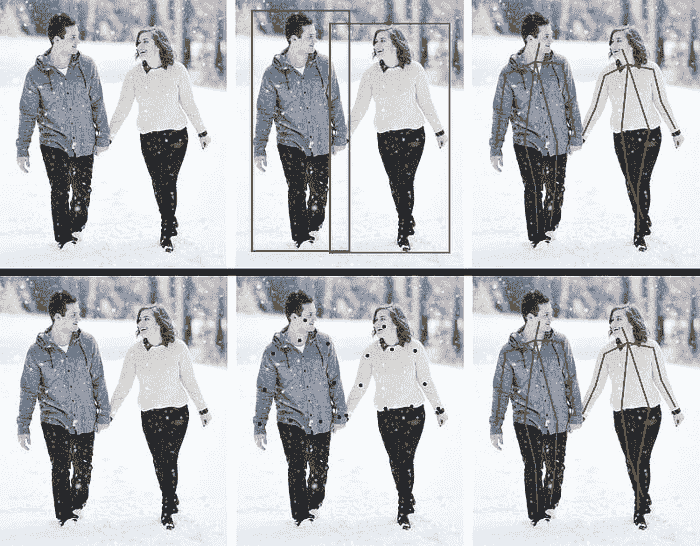

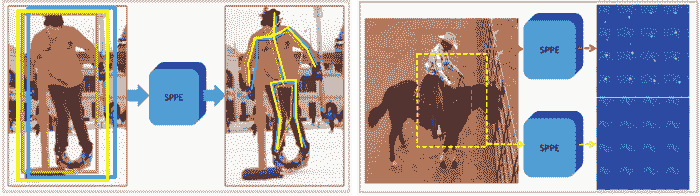

3. RMPE (AlphaPose)

RMPE是一个流行的自上而下的姿态估计方法。作者认为,自上而下的方法通常依赖于人体检测器的准确性,因为姿态估计是在人体所在的区域进行的。因此,定位误差和重复的边界框预测可能导致姿态提取算法表现不佳。

重复预测的效果(左)和低置信度边界框(右)。(来源)

为了解决这个问题,作者提出使用对称空间变换网络 (SSTN) 从不准确的边界框中提取高质量的单人区域。一个单人姿态估计器 (SPPE) 被用在这个提取的区域中,以估计该人的姿态骨架。一个空间去变换网络 (SDTN) 被用来将估计的人体姿态重新映射到原始图像坐标系统。最后,使用一种参数化姿态非极大值抑制 (NMS) 技术来处理冗余姿态推断的问题。

此外,作者引入了一种姿态引导提议生成器,以增强训练样本,从而更好地训练 SPPE 和 SSTN 网络。RMPE 的显著特点是该技术可以扩展到任何组合的人体检测算法和 SPPE。

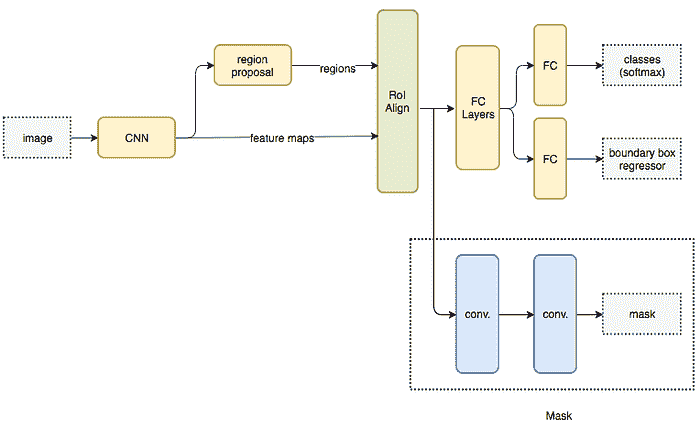

4. Mask RCNN

Mask RCNN 是一种用于执行语义和实例分割的流行架构。该模型并行预测图像中各种对象的边界框位置以及语义分割的掩码。基本架构可以很容易地扩展到人体姿态估计。

描述 Mask RCNN 架构的流程图。 (来源)

基本架构首先使用 CNN 从图像中提取特征图。这些特征图被区域提议网络 (RPN) 用来获取对象存在的边界框候选。边界框候选从 CNN 提取的特征图中选择一个区域(区域)。由于边界框候选可能有各种尺寸,因此使用称为 RoIAlign 的层来减少提取特征的大小,使其都具有统一的尺寸。现在,这个提取的特征被传入 CNN 的并行分支,以最终预测边界框和分割掩码。

让我们专注于执行分割的分支。假设我们图像中的一个对象可以属于 K 类中的一个。分割分支输出**K**个大小为**m x m**的二进制掩码,其中每个二进制掩码仅表示属于该类的所有对象。通过将每种关键点建模为一个独特的类别,并将其视为一个分割问题,我们可以提取图像中每个人的关键点。

同时,目标检测算法可以被训练来识别人员的位置。通过结合人员的位置以及其关键点集,我们获得图像中每个人的姿态骨架。

这种方法几乎类似于自上而下的方法,但人员检测阶段与部件检测阶段是并行执行的。换句话说,关键点检测阶段和人员检测阶段是相互独立的。

5. 其他方法

多人类姿态估计是一个庞大的领域,拥有大量的解决方法。为了简洁起见,这里仅解释了一些方法。要了解更详尽的方法列表,您可以查看以下链接:

应用

姿态估计在众多领域中都有应用,以下列出了一些。

1. 活动识别

跟踪一个人姿态的变化也可以用于活动、手势和步态识别。这些有很多应用场景,包括:

-

检测一个人是否跌倒或生病的应用。

-

可以自主教授正确锻炼方案、运动技巧和舞蹈活动的应用。

-

可以理解全身手语的应用程序。(例如:机场跑道信号,交通警察信号等)。

-

可以增强安全和监控的应用程序。

追踪人的步态对于安全和监控目的很有用。(图片来源)

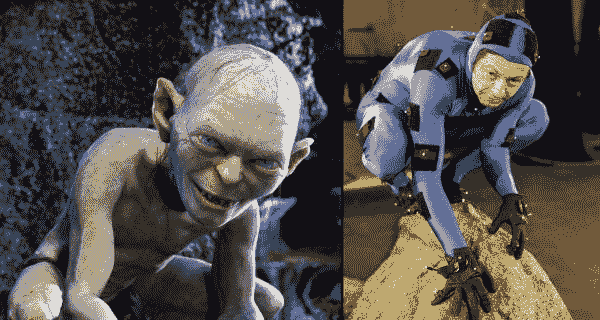

2. 动作捕捉与增强现实

人体姿态估计的一个有趣应用是 CGI 应用。可以在人的身上叠加图形、风格、精美效果、设备和艺术品,如果能够估计他们的人体姿态。通过跟踪这些姿态的变化,渲染的图形可以“自然地适应”随着人的动作。

CGI 渲染示例。(来源)

一个良好的视觉示例可以通过 Animoji 来看到。尽管上述技术仅追踪了面部结构,但这个想法可以推导到人的关键点上。相同的概念可以用来渲染可以模仿一个人动作的增强现实 (AR) 元素。

3. 训练机器人

机器人可以通过跟随执行动作的人体姿态骨架的轨迹来代替手动编程来跟随轨迹。人类教练只需演示相同动作,就可以有效地教机器人某些动作。机器人随后可以计算如何移动其关节来执行相同的动作。

4. 控制台的动作追踪

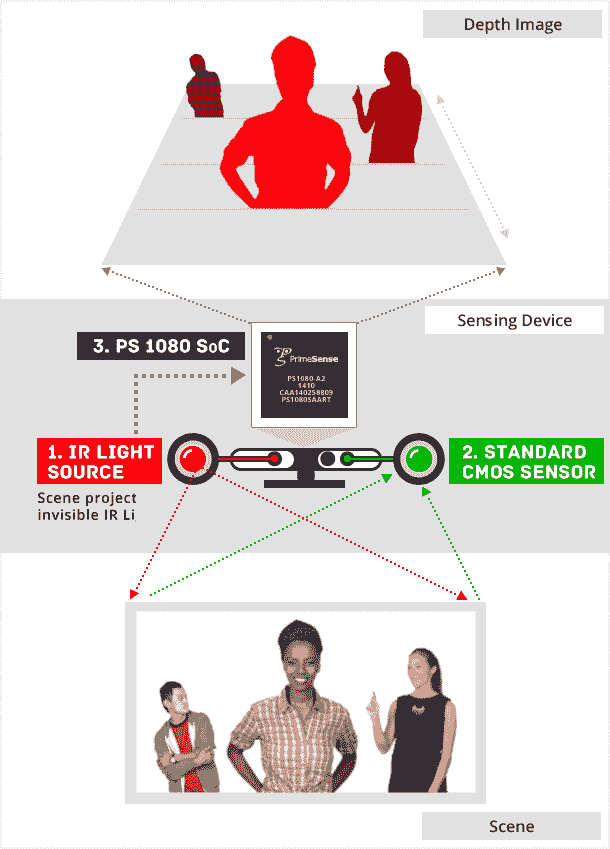

姿态估计的一个有趣应用是跟踪人类对象的运动以进行互动游戏。Kinect 通常使用 3D 姿态估计(使用红外传感器数据)来跟踪人类玩家的动作,并利用这些数据渲染虚拟角色的动作。

Kinect 传感器在工作中。(来源)

结论

在人类姿态估计领域取得了巨大进展,这使我们能够更好地服务于其可能应用的各种场景。此外,诸如姿态跟踪等相关领域的研究可以大大提升其在多个领域的生产性应用。本文博客中列出的概念并不详尽,而是力图介绍这些算法的一些流行变体及其实际应用。

Bharath Raj 是 Siemens PLM Software 的一名助理工程师。他喜欢尝试机器学习和计算机视觉概念。你可以在 这里 查看他的项目。

Yoni Osin 是 BeyondMinds 的研发副总裁

原文。经许可转载。

相关:

-

如何在计算机视觉中实现一切

-

使用 Tensorflow 对象检测进行像素级分类

-

在 Tensorflow 中实现 CNN 进行人类活动识别

更多相关内容

人类向量:融合说话者嵌入,使您的机器人更强大

原文:

www.kdnuggets.com/2016/09/human-vector-incorporate-speaker-embedding-powerful-bot.html

由 Megan Barnes, Init.ai 提供。

我们如何评估人工智能?你可能最近听说过自动驾驶汽车;它们的发布似乎迫在眉睫。自动驾驶汽车有一个明确的评估目标:不要发生碰撞。除了避免事故之外,并没有关于汽车驾驶好坏的概念。

在对话代理的工程挑战中,我们对期望的标准变得越来越高且模糊。在对话式人工智能中有一个类似于不要发生碰撞的概念:功能性失败。我们能够识别出机器人何时真的不了解我们。它们的回答可能不会解答我们的问题,与对话无关,或者根本没有意义。背后研究者在“A Persona-Based Neural Conversation Model”中指出了机器人可能失败的一个更微妙的方式:它们的(缺乏)个性。

在人类对话中,我们依赖于对其他说话者行为的假设。这在语用学领域被称为合作原则。这一原则分解为‘准则’,说话者要么遵循这些准则,要么违背它们。简而言之,我们依赖他人说出真实的陈述,提供尽可能多的信息,保持相关性,并适当地表达。当说话者故意违背这些准则时,它会传达我们可以理解的意义(例如,讽刺,其中说话者做出明显不真实的陈述)。然而,当偏离准则是无意的时,它可能会使对话偏离轨道。

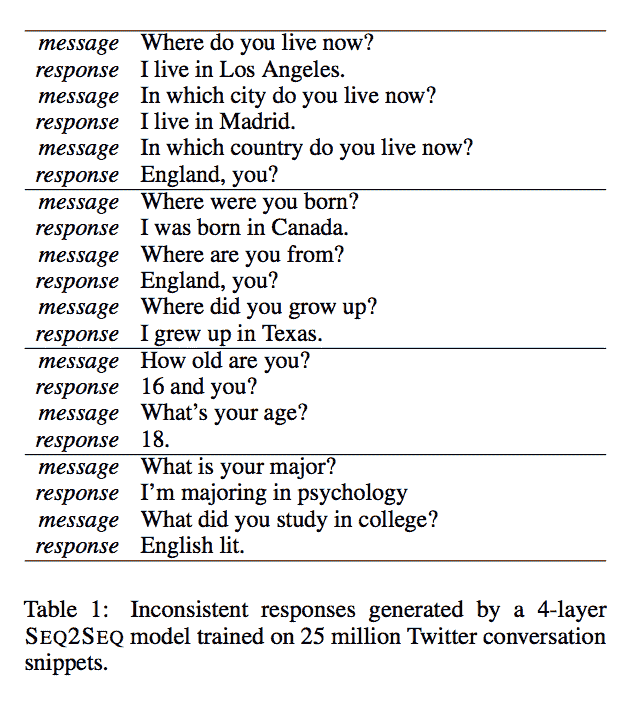

考虑一下来自“A Persona-Based Neural Conversation Model”的这些示例对话:

(Li et al. 1)

这里的问题在于我们对世界的知识使得这明显违反了质量准则(意指:说实话)。一个人不能同时生活在两个不同的地方或拥有两个不同的年龄。这意味着我们至少能理解到某些回答是不真实的。可以想象,一个熟练的英语使用者可能会故意做出这些完全相同的陈述,并在过程中产生一种含义。例如,在上面的最后一次交流中,回答者可能在开玩笑关于心理学专业所需的阅读量。是否真的有趣则是一个品味问题。与机器人不同的是,我们不期望看到幽默。我们很清楚不一致的回答是无意的,这使得沟通变得困难。

不一致回应的具体问题是语言建模的内在问题,因为数据驱动的系统旨在生成最有可能的回应,而不考虑回应的来源。在输出空间中进行搜索时,模型根据最可能的单词序列来推断另一个序列。在上述研究中,基线模型是一个LSTM 递归神经网络,这是一种在对话 AI 中常见的架构。它使用 softmax 函数在可能的输出上创建概率分布,并选择序列中最可能的下一个单词,无论训练数据中是谁生成的。人类发言者期望与他们交谈的机器人保持一致的角色,而当前技术忽视了这一点。

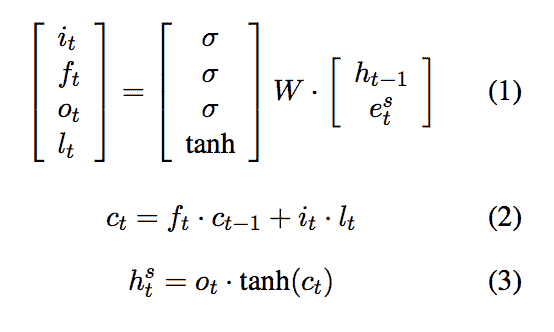

李等人将人物角色描述为“由身份元素(背景事实或用户档案)、语言行为和互动风格的组合”(1)。一个人物角色基于生成部分训练数据的真实个体,并由一个向量,即发言者嵌入,表示。他们随机初始化发言者嵌入,并在训练过程中学习这些嵌入。

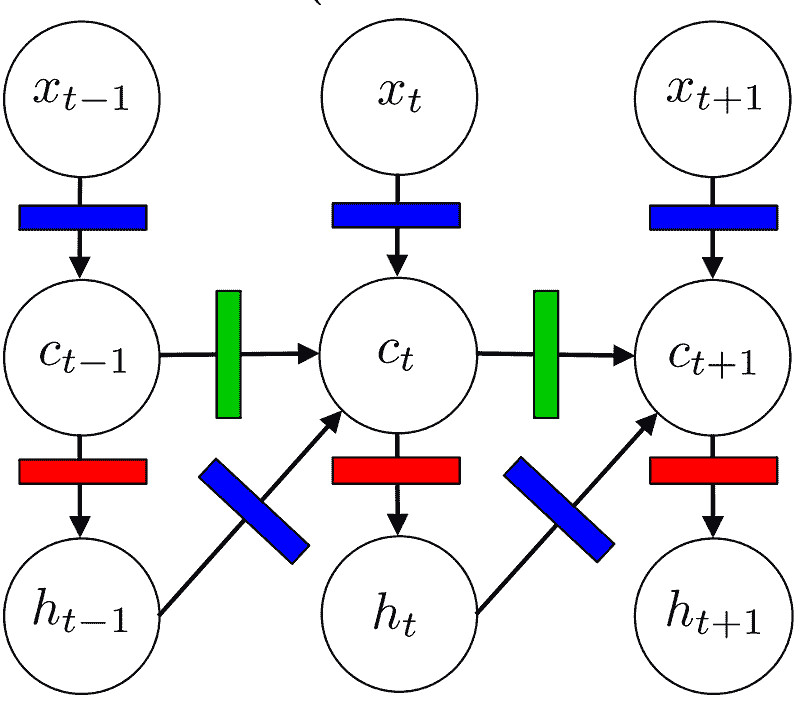

一个基本的 LSTM 可以用如下图形表示:

(Kevin Gimpel 2016)

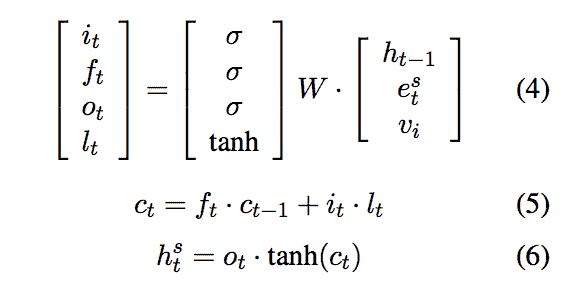

其中x表示序列中的词嵌入,c表示隐藏层,h表示模型的输出,所有这些在时间t。彩色矩形表示门,用于转换输入向量。该模型也可以用下面的函数表示(其中e代替x表示词嵌入),i, f, o和l代表上面的多色门。

(李等人 2)

在李等人称之为发言者模型的研究中,他们将模型注入了发言者嵌入向量v,如下面的表示所示。

(李等人 3)

这将发言者i的信息添加到序列的每一个时间步中。这相当于在 LSTM 图形模型的隐藏层中添加一个v输入节点,标记为蓝色门。将发言者嵌入融入 LSTM 模型中提高了其性能,降低了困惑度,并在大多数研究人员检查的数据集中提高了 BLEU 分数。

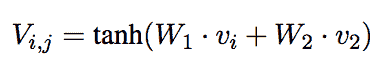

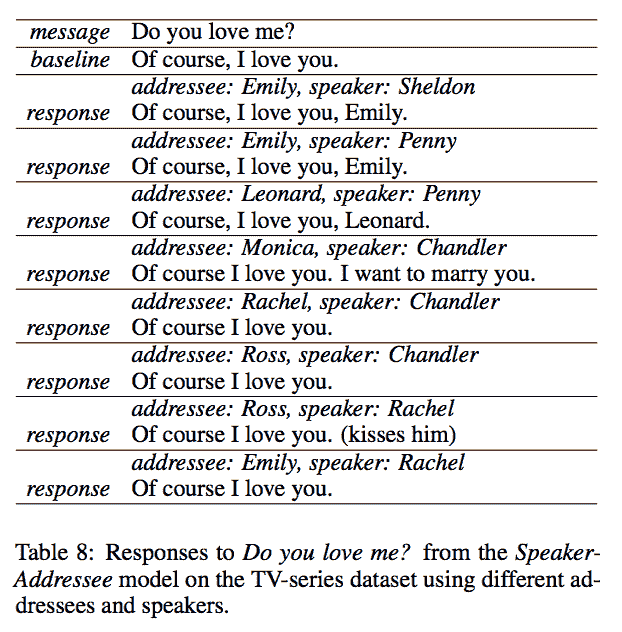

研究人员还指出,一个单一的角色应该是可适应的。一个人不会用相同的方式称呼他们的老板和他们的小弟弟。因此,他们还决定尝试他们称之为发言者-受话者模型的方案。该模型用发言者对嵌入V替代了发言者嵌入,其形式如下。发言者对嵌入旨在建模特定个体之间的互动。

(李等,4)

说话者-听众模型取得了类似的成功。这是一个特别有趣的结果,说明说话者-听众模型在使用电影对话数据进行训练时生成的(参考了《老友记》和《生活大爆炸》中的角色关系):

(李等,8)

李等研究的重要启示是,人工智能是一个多样化的领域,包含需要细致解决方案的各种任务。神经网络很棒,但如果它们被当作黑箱对待,在复杂任务如对话上只能发挥有限作用。我们需要考虑我们实际期望从机器人中得到什么。连贯的、适应性的个性和量身定制的系统是实现复杂结果的关键。毕竟,我们对机器人的期望不仅仅是避免崩溃。

简介: 梅根·巴恩斯 是一名从事机器学习基础设施工作的软件开发人员。如果你对对话界面感兴趣,可以关注她的Medium和Twitter。

如果你打算为你的公司创建一个对话应用程序,可以查看Init.ai和我们在Medium上的博客,或在Twitter上与我们联系。查看这篇文章中提到的原始研究这里。

原文。经允许转载。

相关:

-

聊天机器人深度学习,第二部分——在 TensorFlow 中实现检索型模型

-

构建数据驱动对话系统的可用语料库调查

-

人工智能‘聊天机器人’——何时或是否?

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

更多相关话题

为什么谦逊自己将提高你的数据科学技能

原文:

www.kdnuggets.com/2022/01/humbling-improve-data-science-skills.html

我们都希望能说自己知道所有的事情。不幸的是,这是不可能的。有时我会告诉自己“我什么都不知道”,以激励自己学习并不断进步。

数据科学是一个需要不断学习的领域,总有提升的空间。在数据科学的世界里,保持对事物的掌控感和成就感是困难的。一旦你完成了一个学习任务并感到自信,你会发现自己又在寻找新的主题或领域进行学习。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 在 IT 领域支持你的组织

3. 谷歌 IT 支持专业证书 - 在 IT 领域支持你的组织

没有人可以坐在这里说自己知道所有的事情。即使是有 10 年以上工作经验的高级数据科学家,也可能需要用谷歌搜索如何连接两个数据集。这并不意味着他们不知道,只是他们可能已经很久没有用过那段代码,忘记了。

一旦你开始在数据科学领域工作,你将会与其他数据科学家、分析师、机器学习工程师等进行互动,彼此交流知识。然而,会有一个时刻,你可能不知道你的同事知道的某些内容,反之亦然。然而,当你不知道某件事却告诉你的同事你知道时,这可能会对你的自信心造成一定的损害。

如果你面对的任务可以通过简单的谷歌搜索、观看 YouTube 视频或查看 Stack Overflow 来解决,那是很棒的。然而,如果你继续告诉你的同事或老板你知道某些事情,但实际上你并不知道,你会发现自己陷入额外的学习中。相反,你可以直接说“对不起,我不知道怎么做”。这样,你的同事和老板可以理解你的优点和不足,从而为你提供正确的支持/培训,帮助你在特定领域得到提升。

这同样适用于高级职位的人。如果你没有正确的技能来管理和指导团队,你将会感到不堪重负,压力水平会增加,这可能会让你思考自己的职位。

第一个工作总是令人害怕的。你会感到焦虑和紧张,不敢表达自己的意见。我将介绍一些我认为每个人都应该融入工作和个人生活中的要点。

1. 了解你的强项和弱点

你不需要在所有方面都出类拔萃。然而,要从事数据科学工作,你需要具备基本技能。如果你是一名喜欢数据处理和创建数据可视化但在构建机器学习模型方面经验较少的数据科学家;这是你可以改进的一个弱点。承认自己在数据科学家掌握的所有技能中不会在每一项技能上都很先进,是成长为数据科学家的第一步。

一旦你确定了自己的强项和弱点、喜欢的事物和不了解的内容,你可以缩小自我发展的范围。如果你特别感兴趣成为一名机器学习工程师,你作为数据科学家的技能将会派上用场。然而,你需要深入学习算法、自然语言处理、神经网络等领域。

你需要了解哪些技能对你的职业有利,无论是现在还是未来。如果你的职业规划需要你使用 Python 和 R 作为编程语言,学习 HTML 等其他语言将没有用处。你不想在所有方面都是新手,而在任何一方面都没有精通。

2. 大胆发言!

如果你不问,就得不到。数据科学家角色要求大量的技术技能和软技能。遗憾的是,很多人会假设你申请了某个职位就会知道几乎所有的事情。正如我们所知,事实并非如此。总有改进的空间和学习不同技能的时间。

如果工作中的项目有一个紧迫的截止日期,你被要求完成一个特定任务以加快进程,但你不知道如何处理,因为你没有这些技能。你会发现自己陷入困境。大声说出来并告诉同事你能做什么和不能做什么,而不是感到紧张和羞愧,从长远来看会对你有帮助。你可能会被分配另一个任务,其他团队成员知道你能胜任,从而确保每个人都能按时完成任务。

与上级讨论自己的弱点会开启自我发展的对话。公司可能希望你在这些方面有所改进,并安排你参加特定的培训或在工作时间分配自我发展时间来支持你。如果公司能够帮助你成为顶尖的数据科学家,他们会愿意这样做。

另一方面,你可能会觉得分配给你的任务低于你的技能水平。重要的是,不要浪费时间做简单的任务,而是应该在其他领域发挥作用。这是晋升最快的方式。与上级讨论你的优势及如何提高公司的效率可以解决许多业务问题。这是一种双赢的局面。

3. 你还可以采取哪些其他步骤?

申请合适的工作

人们申请需要特定技能的职位却不具备这些技能并不是什么秘密。如果你这样做,你是在给自己设定失败的风险。与其根据薪资申请工作,不如根据你当前的技能申请。

从事入门级工作、提高技能并逐步晋升没有坏处。谦逊并在自己的能力范围内工作是建立职业生涯的第一步。关键词是“建设”。这不会自动到手,所以你必须从某个地方开始。从基础做起总比从顶端摔下来要好。

在线课程

有各种在线课程可以帮助你提高和扩展技能。你可以通过 Udemy、Coursera、Udacity 等平台参加课程。这些课程可以涵盖特定的编程语言如 Python 或 C++,也可以学习数据库管理和 SQL。

阅读

在线有大量的阅读材料可以帮助你提高对各种主题的理解。教科书、学术论文都可以在网上找到,还有 KDNuggets 等平台,提供优质的资源材料来指导你,帮助你理解并建立职业生涯。

4. 持续学习

持续学习是你自我驱动并坚持不懈地扩展技能和发展未来机会的方式,无论是个人还是职业上的。你可以决定某一天对医学感兴趣并希望将数据科学技能融入该领域。或者你可能想成为一名高级数据科学家,但意识到自己缺乏 SQL 知识。

学习永无止境。总是对自己说“我什么都不知道”;这会激励你继续学习。知识触手可及,如果你不加以利用,你将停滞不前。

能够保持谦逊并不断学习将帮助你提升个人形象,保持相关性,为自己打开新门,并为意外做好准备。

妮莎·阿利亚 是一名数据科学家和自由技术写作人。她特别关注提供数据科学职业建议、教程以及基于理论的数据科学知识。她还希望探索人工智能如何以及能够如何有益于人类寿命的不同方式。作为一个积极学习者,她寻求拓宽自己的技术知识和写作技能,同时帮助指导他人。

更多相关话题

《百页机器学习书》

原文:

www.kdnuggets.com/2019/01/hundred-page-machine-learning-book.html

赞助广告。

作者:安德烈·布尔科夫,《百页机器学习书》

期待已久的日子终于到来,我感到自豪和高兴地宣布,《百页机器学习书》现已可以在亚马逊上订购,提供高质量彩色平装本和Kindle版本。

在过去三个月里,我努力写了一本能带来改变的书。我坚信我成功了。我之所以如此确信,是因为我收到了来自读者的积极反馈,这些读者包括刚刚开始人工智能学习的新人和受人尊敬的行业领导者。

我非常自豪,像彼得·诺维格和奥雷利安·热龙这样的畅销 AI 书籍作者和杰出科学家对我的书给予了赞誉,并为其封底撰写了文字,同时加雷斯·詹姆斯也写了前言。

这里有几个推荐词:

彼得·诺维格,谷歌的研究主任,《AIMA》的合著者:“布尔科夫承担了一个非常有用但几乎不可能完成的任务,将所有机器学习的内容浓缩为 100 页。他在选择对从业者有用的主题——包括理论和实践——方面做得很好,对于读者来说,这本书的前 100 页(实际上是 150 页)提供了一个扎实的领域介绍,而不是最后的部分。”

奥雷利安·热龙,高级 AI 工程师,《使用 Scikit-Learn 和 TensorFlow 的实战机器学习》的畅销书作者:“这本书在仅有的 100 页(加上一些额外页面)中覆盖的主题广度令人惊叹。布尔科夫不犹豫地深入数学方程,这通常是短书籍会省略的一部分。我非常喜欢作者用简短的语言解释核心概念。这本书对于领域的新手以及可以从广泛视角中受益的老手来说,都非常有用。”

卡罗利斯·乌尔博纳斯,亚马逊的数据科学主管:“来自世界级从业者的机器学习极佳入门书。”

赵汉,Lucidworks的研发副总裁:“我希望在我还是统计学研究生学习机器学习时就能有这样的书。”

苏杰特·瓦拉赫迪,eBay的工程主管:“安德烈的书在第一页就从全速切入,极大地减少了噪音。”

Deepak Agarwal,LinkedIn 人工智能副总裁:“这是一本适合那些希望将机器学习融入日常工作而不必花费大量时间的工程师的精彩书籍。”

想了解更多关于这本书的信息,请访问其网站:themlbook.com。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您组织的 IT

3. Google IT 支持专业证书 - 支持您组织的 IT

更多相关话题

混合人工智能将在 2022 年成为主流

原文:

www.kdnuggets.com/2022/03/hybrid-ai-go-mainstream-2022.html

科学矢量由 iuriimotov 创建 - www.freepik.com

人工智能(AI)正在成为全球数据生态系统中的主导趋势,预计在本十年展开时将加速发展。数据社区对人工智能及其能力了解得越多,就能越快地提升 IT 系统和结构。这也是 IDC 预测市场将超过 5000 亿美元的主要原因,预计最早在 2024 年就会渗透到几乎所有行业,推动大量应用和服务的涌现,旨在提高工作效率。事实上,CB Insights Research 报告显示,到 2021 年第三季度末,AI 公司融资已超越 2020 年水平,增长约 55%,创造了全球连续第四个季度的新纪录。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

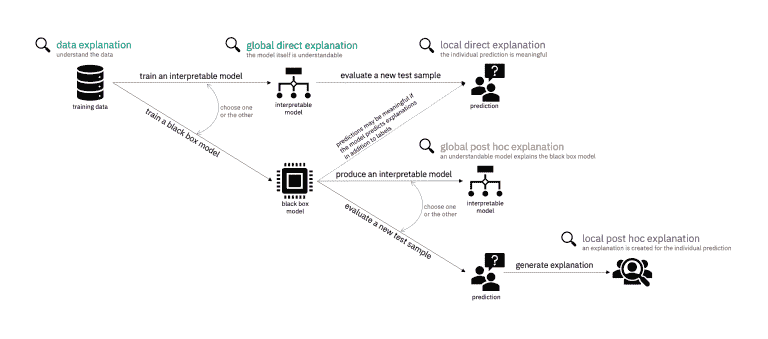

2022 年,我们可以预期人工智能将在解决阻碍非结构化语言数据驱动过程的实际问题上变得更加出色,这要归功于在自然语言理解(NLU)等复杂认知任务中的进步。与此同时,对人工智能的行为及其原因的审查也将增加,例如美国国家标准与技术研究院(NIST)正在进行的旨在实现更可解释的人工智能的努力。这将需要对人工智能的算法功能提供更大的透明度,而不会降低其性能或提高成本。

你可以通过一个词所处的环境来了解它

在人工智能必须应对的所有挑战中,理解语言是最困难的之一。虽然大多数 AI 解决方案可以在眨眼之间处理大量原始数字或结构化数据,但语言中的多种含义和细微差别,依据其所处的上下文则完全不同。语言往往是有语境的,这意味着它们在不同情况下传达不同的理解。对我们的大脑来说简单自然的东西,对任何软件来说都不是那么简单。

这就是为什么能够正确且可靠地解释语言的软件开发,已成为 AI 全面发展的关键因素。达到这种计算能力将真正开启 AI 发展的闸门,使其能够访问和吸收几乎任何类型的知识。

NLU(自然语言理解)是这个难题中的关键一环,因为它能够利用丰富的语言信息。语言存在于企业活动的所有方面,这意味着没有从这种数据中提取尽可能多的价值,AI 方法是无法完整的。

基于知识的或符号 AI 方法,利用知识图谱,它是一个开放的框架。其结构由人类创建,并被理解为代表现实世界,其中概念通过语义关系进行定义和关联。得益于知识图谱和 NLU 算法,你可以直接阅读和学习任何文本,深入理解数据如何被解读以及如何从这些解读中得出结论。这类似于我们作为人类能够创建自己的特定领域知识,它使得 AI 项目能够将其算法结果与明确的知识表示关联起来。

在 2022 年,我们应该看到这种结合不同技术的 AI 方法的明确转变。混合 AI 利用不同的技术来提高整体结果,更好地解决复杂的认知问题。混合 AI 是 NLU 和自然语言处理(NLP)越来越受欢迎的方法。将基于 AI 的知识或符号 AI 与学习模型(机器学习,ML)相结合,是解锁非结构化语言数据的价值的最有效方式,满足当今企业对准确性、速度和规模的要求。

使用知识、符号推理和语义理解不仅会产生更准确的结果和更高效、有效的 AI 环境,还会减少对繁琐且资源密集的训练的需求,避免浪费大量文档和昂贵的高速数据基础设施。领域特定的知识可以通过主题专家和/或机器学习算法来添加,利用对小规模、精确训练集数据的分析,快速有效地产出高度准确的可操作结果。

混合 AI 的世界

但为什么这种转变现在才发生?为什么 AI 之前无法利用基于语言的知识?我们一直被引导相信学习方法可以解决我们的所有问题。在某些情况下,它们确实可以,但仅仅因为机器学习在某些需求和特定背景下表现良好,并不意味着它总是最佳方法。在语言理解和处理能力方面,我们经常看到这一点。仅在过去几年,我们才看到基于混合(或复合)AI 方法的自然语言理解的显著进展。

与其将一种形式的 AI(其工具有限)用于解决问题,我们现在可以利用多种不同的方法。每种方法可以从不同角度、使用不同模型来评估和解决问题,从而以多重背景的方式解决问题。由于这些技术可以相互独立评估,因此更容易确定哪些方法能提供最优的结果。

随着企业已经体验到 AI 的潜力,这种混合方法有望在 2022 年成为战略性举措。它能显著节省时间和成本,同时提高分析和运营过程的速度、准确性和效率。举一个例子,目前的注释过程主要由特定专家执行,主要是由于培训的困难和费用。然而,通过结合适当的知识库和图谱,培训可以大大简化,使得这一过程能够在知识工作者中实现民主化。

更多内容即将推出

当然,各种形式的 AI 研究仍在进行中。但我们将特别关注扩展知识图谱和自动化机器学习及其他技术,因为企业面临着快速且低成本利用大量数据的持续压力。

随着时间的推移,我们将看到组织在将这些混合模型应用于核心流程方面的稳定改进。商业自动化,如电子邮件管理和搜索,已经在眼前。例如,当前基于关键词的搜索方法本质上无法吸收和解释整个文档,因此只能提取基本的、主要是非上下文的信息。同样,自动化电子邮件管理系统也很少能穿透简单产品名称和其他信息点之外的意义。最终,用户需要从长长的搜索结果列表中筛选出重要的信息。这减慢了流程,延迟了决策,最终阻碍了生产力和收入。

在混合框架下赋予自然语言理解工具符号理解能力,将使所有基于知识的组织能够模拟人类在智能自动化过程中理解整个文档的能力。

Marco Varone 是 expert.ai 的创始人兼首席技术官,该平台是语言理解领域的顶级人工智能平台。其独特的混合 NL 方法结合了符号化的人类理解与机器学习,从非结构化数据中提取有用的知识和洞见。

更多相关话题

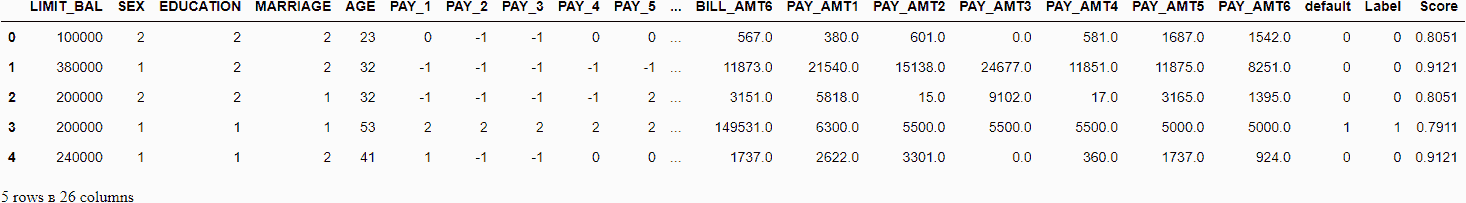

Hydra 配置用于深度学习实验

原文:

www.kdnuggets.com/2023/03/hydra-configs-deep-learning-experiments.html

图片来源:编辑

介绍

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

Hydra 库提供了一个灵活高效的配置管理系统,支持通过组合和重写配置文件以及命令行动态创建层次化配置。

这个强大的工具提供了一种简单而高效的方式来管理和组织各种配置,构建复杂的多层配置结构,没有任何限制,这在机器学习项目中至关重要。

所有这些功能使你能够轻松切换任何参数,并尝试不同的配置,而无需手动更新代码。通过以灵活和模块化的方式定义参数,迭代新的机器学习模型并更快地比较不同的方法变得更加容易,这可以节省时间和资源,并使开发过程更加高效。

Hydra 可以作为深度学习管道中的核心组件(你可以在 这里 找到我的训练管道模板示例),它将协调所有内部模块。

如何使用 Hydra 运行深度学习管道

hydra.main 装饰器用于在启动管道时加载 Hydra 配置。在这里,配置通过 Hydra 语法解析器进行解析、合并、组合,并传递给管道主函数。

此外,它还可以通过 Hydra Compose API 完成,使用 initialize、initialize_config_module 或 initialize_config_dir,而不是 hydra.main 装饰器:

使用 Hydra 实例化对象

如果配置中包含 _target_ 键和类或函数名称(例如 torchmetrics.Accuracy),则可以从配置实例化对象。此外,配置可能包含其他参数,这些参数应该传递给对象实例化。Hydra 提供了 hydra.utils.instantiate() 函数(及其别名 hydra.utils.call())用于实例化对象和调用类或函数。建议使用 instantiate 创建对象,使用 call 调用函数。

基于此配置,你可以简单地进行实例化:

-

通过

loss = hydra.utils.instantiate(config.loss)获取 loss -

通过

metric = hydra.utils.instantiate(config.metric)获取 metric

此外,它支持多种策略来转换配置参数:none、partial、object 和 all。_convert_ 属性用于管理此选项。你可以在 这里 找到更多细节。

此外,它还提供了 部分实例化,这对于函数实例化或递归对象实例化非常有用。

命令行操作

Hydra 提供了命令行操作来覆盖配置参数:

-

可以通过传递不同的值来替换现有的配置值。

-

可以使用

+操作符添加配置中不存在的新配置值。 -

如果配置中已有值,可以使用

++操作符覆盖。如果值不存在于配置中,将会被添加。

额外的开箱即用功能

它还支持各种令人兴奋的功能,例如:

-

结构化配置 具有扩展的可用原始类型列表、嵌套结构、包含原始值的容器、默认值、从下往上的值覆盖等更多功能。这提供了广泛的可能性来以多种不同形式组织配置。

-

hydra/job_logging和hydra/hydra_logging的彩色日志。![Hydra Configs for Deep Learning Experiments]()

自定义配置解析器

Hydra 通过 OmegaConf 库提供了扩展其功能的机会。它允许将自定义可执行表达式添加到配置中。OmegaConf.register_new_resolver() 函数用于注册这样的解析器。

默认情况下,OmegaConf 支持以下解析器:

-

oc.env:返回环境变量的值 -

oc.create:可用于动态生成配置节点 -

oc.deprecated:可用于将配置节点标记为已弃用 -

oc.decode:使用给定的编解码器解码字符串 -

oc.select:提供一个默认值,以防主插值键未找到,或选择其他非法插值键或处理缺失值 -

oc.dict.{keys,value}:类似于普通 Python 字典中的 dict.keys 和 dict.values 方法

更多细节请查看这里。

因此,它是一个强大的工具,可以添加任何自定义解析器。例如,在多个地方的配置中重复编写损失或指标名称可能是乏味且耗时的,比如early_stopping配置、model_checkpoint配置、包含调度器参数的配置或其他地方。通过添加自定义解析器,将__loss__和__metric__名称替换为实际的损失或指标名称,可以解决这个问题,这些名称会传递给配置并由 Hydra 实例化。

注意:你需要在hydra.main或Compose API调用之前注册自定义解析器。否则,Hydra 配置解析器将无法应用它。

在我的快速深度学习实验模板中,它被实现为一个装饰器[utils.register_custom_resolvers](https://github.com/gorodnitskiy/yet-another-lightning-hydra-template/blob/936e99fd6c9d033b4f407b96370fd64656566874/src/utils/utils.py#L328),允许在一个地方注册所有自定义解析器。它支持 Hydra 的主要命令行标志,这些标志是覆盖配置路径、名称或目录所必需的。默认情况下,它允许通过以下语法将__loss__替换为loss.__class__.__name__,将__metric__替换为metric.__class__.__name__:${replace:"__metric__/valid"}。在${replace:"..."}中使用引号来定义内部值,以避免与 Hydra 配置解析器的语法问题。

有关utils.register_custom_resolvers的更多细节,请查看这里。你可以轻松扩展它以满足其他需求。

简化复杂模块配置

这个强大的工具显著简化了复杂管道的开发和配置,例如:

-

实例化具有任何自定义逻辑的模块,例如:

-

通过 Hydra 递归地实例化整个模块及其内部所有子模块。

-

主模块和一些内部子模块可以由 Hydra 初始化,其余部分则需手动初始化。

-

手动初始化主模块和所有子模块。

-

-

将动态结构(如数据增强)打包到配置中,你可以轻松设置任何

transforms类、参数或适用顺序。参见基于albumentations库的可能实现示例[TransformsWrapper](https://github.com/gorodnitskiy/yet-another-lightning-hydra-template/blob/main/src/datamodules/components/transforms.py),它可以轻松地为任何额外增强包进行修改。配置示例: -

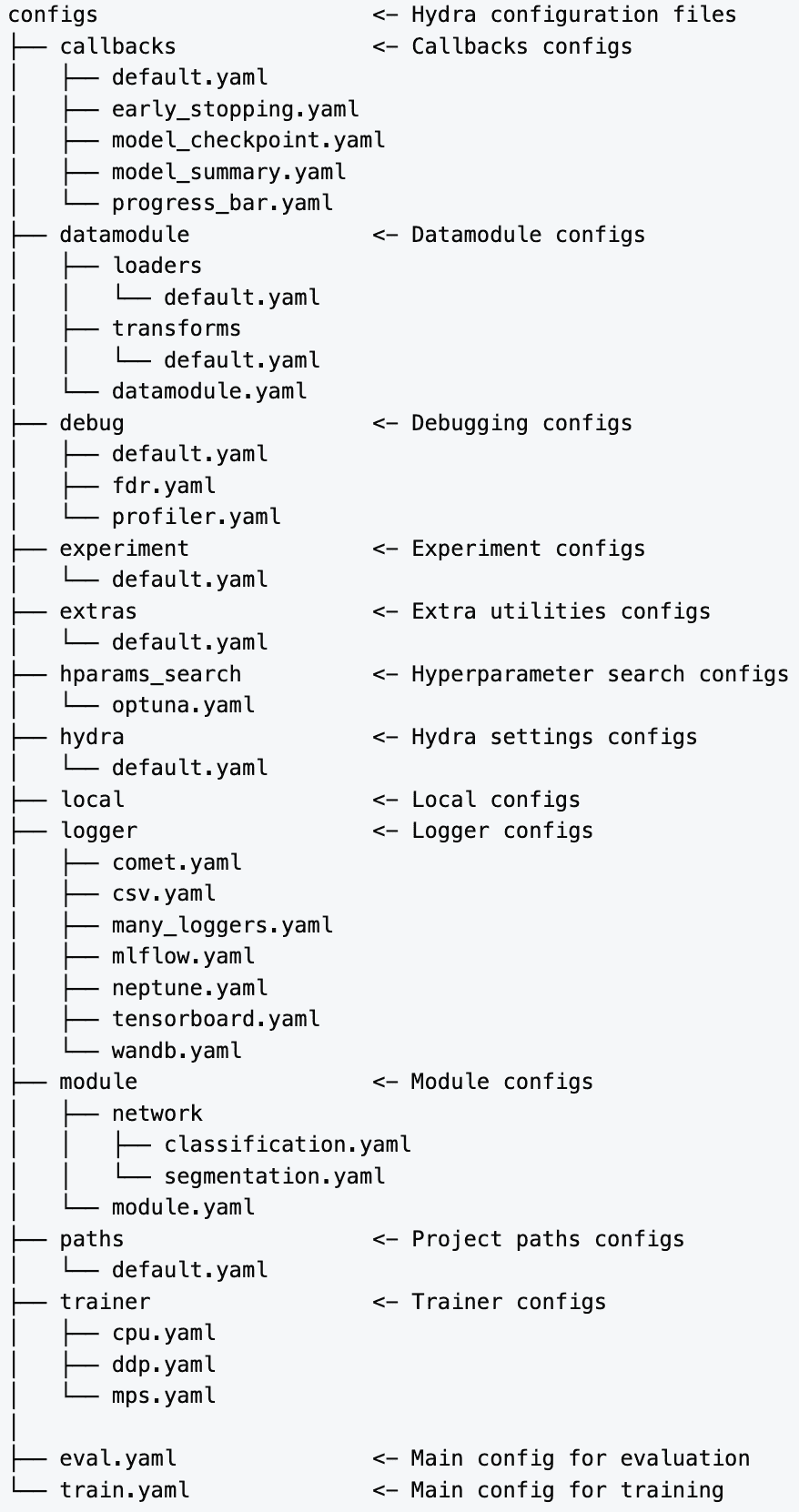

创建复杂的多层配置结构。这里 是配置组织的概要:

- 还有许多其他功能……它的限制非常少,因此你可以在项目中实现任何自定义逻辑。

最后的想法

Hydra 为可扩展的配置管理系统铺平了道路,使你能够扩展工作流程的效率,同时保持对配置的灵活更改能力。能够轻松切换不同的配置,简单地重新组合并尝试不同的方法,而无需手动更新代码,是解决机器学习问题(尤其是深度学习相关任务)时使用此系统的关键优势,因为在这些任务中,额外的灵活性至关重要。

亚历山大·戈罗德尼茨基 是一位机器学习工程师,具备深厚的机器学习、计算机视觉和分析知识。我拥有超过 3 年的经验,专注于使用机器学习创建和改进产品。

更多相关话题

超参数优化:10 个顶级 Python 库

原文:

www.kdnuggets.com/2023/01/hyperparameter-optimization-10-top-python-libraries.html

图片由作者提供

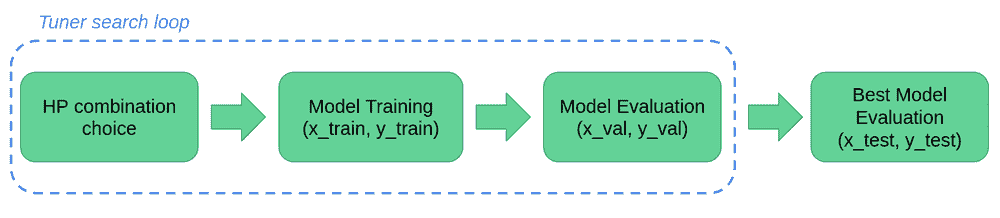

超参数优化在确定机器学习模型的性能中起着关键作用。它们是训练的三个组成部分之一。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

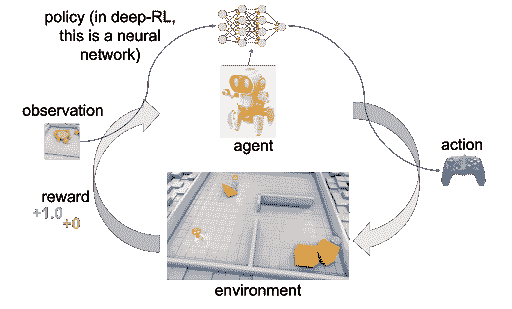

模型的 3 个组成部分

训练数据

训练数据是算法利用的内容(可以理解为构建模型的指令),用于识别模式。

参数

算法通过根据训练数据调整参数(如权重)来“学习”,以进行准确预测,这些预测作为最终模型的一部分保存。

超参数

超参数是调节训练过程的变量,在训练过程中保持不变。

不同类型的搜索

网格搜索

用提供的超参数值的所有可能组合训练模型是一个耗时的过程。

随机搜索

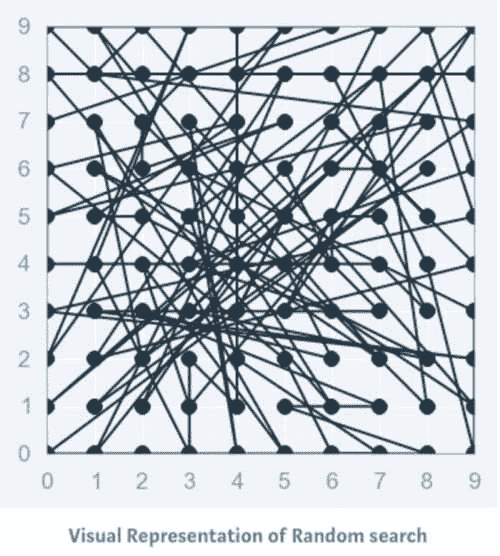

训练模型时随机从定义的分布中抽样超参数值,这是一种更有效的搜索方法。

拥有网格搜索

用所有值训练模型,然后通过仅考虑在上轮表现最佳的参数值来重复“对搜索空间进行二分”。

贝叶斯搜索

从初始值开始,利用模型的表现来调整这些值。这就像侦探从嫌疑人列表开始,然后使用新信息来缩小列表。

超参数优化的 Python 库

我找到了这 10 个用于超参数优化的 Python 库。

Optuna

你可以通过名为 optuna-dashboard 的实时 Web 仪表板调节几乎所有的 ML、DL 包/框架的估计器,包括 Sklearn、PyTorch、TensorFlow、Keras、XGBoost、LightGBM、CatBoost 等。

Hyperopt

使用贝叶斯优化进行优化,包括条件维度。

Scikit-learn

不同的搜索方法,如 GridSearchCV 或 HalvingGridSearchCV。

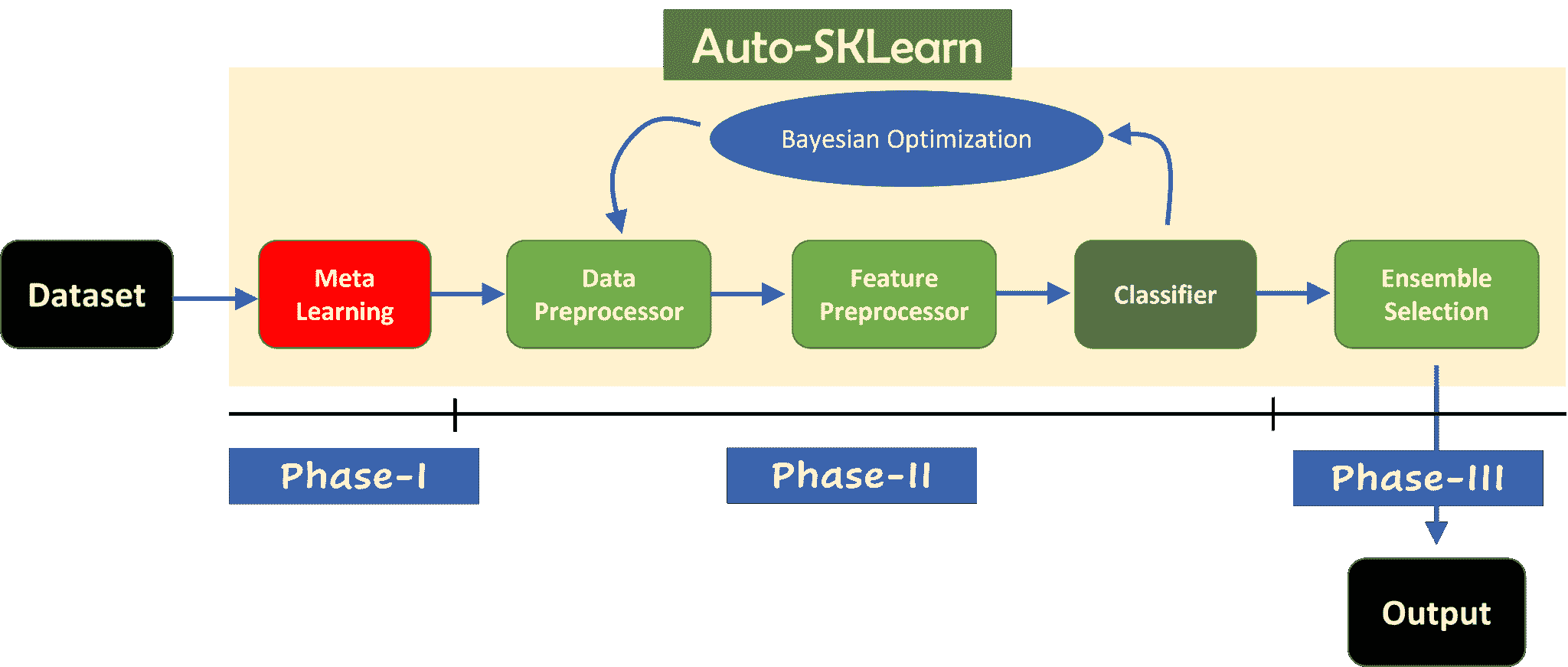

Auto-Sklearn

AutoML 和 scikit-learn 估计器的替代品。

超活跃

非常容易学习但极其多才多艺,提供智能优化。

Optunity

提供了不同的方法以及大量的评分函数。

HyperparameterHunter

自动保存/从实验中学习以进行持续优化

MLJAR

AutoML 从 ML 流水线生成 Markdown 报告

KerasTuner

内置贝叶斯优化、Hyperband 和随机搜索算法

Talos

TensorFlow、Keras 和 PyTorch 的超参数优化。

我是否遗漏了任何库?

来源:

玛丽亚姆·米拉迪 是一名人工智能和数据科学负责人,拥有机器学习和深度学习的博士学位,专注于自然语言处理和计算机视觉。她拥有超过 15 年的成功人工智能解决方案经验,成功交付了 40 多个项目。她曾在 12 个不同的组织中工作,涵盖了金融犯罪检测、能源、银行、零售、电子商务和政府等多个行业。

该主题的更多内容

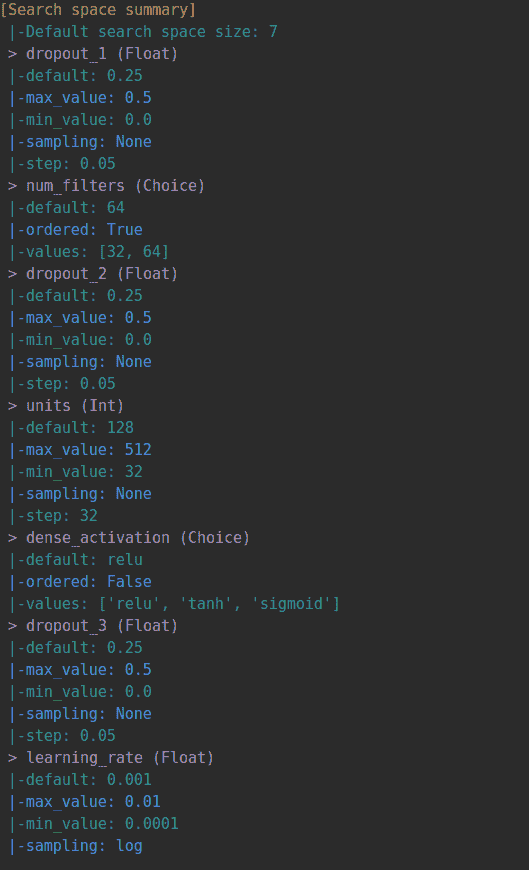

机器学习模型的超参数优化

原文:

www.kdnuggets.com/2020/05/hyperparameter-optimization-machine-learning-models.html

评论

介绍

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能。

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT。

3. 谷歌 IT 支持专业证书 - 支持您的组织的 IT。

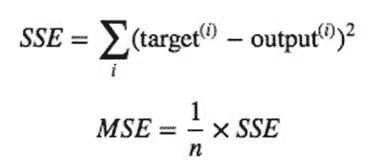

模型优化是实现机器学习解决方案中的最大挑战之一。整个机器学习和深度学习理论的分支都致力于模型优化。

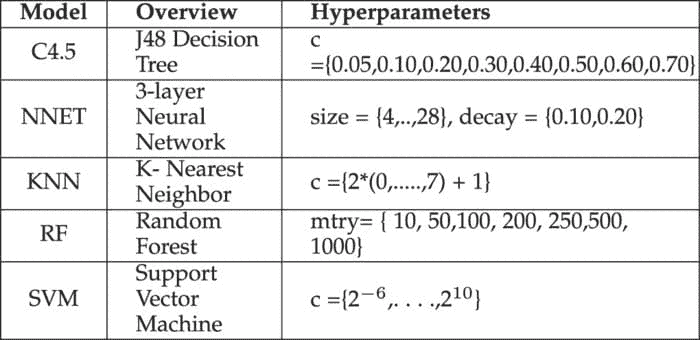

机器学习中的超参数优化旨在找到给定机器学习算法的超参数,以在验证集上测得最佳性能。与模型参数不同,超参数由机器学习工程师在训练前设定。随机森林中的树木数量是一个超参数,而神经网络中的权重是训练过程中学习到的模型参数。我喜欢把超参数看作是模型设置,需要调整以使模型能够最佳地解决机器学习问题。

一些模型超参数的例子包括:

-

用于训练神经网络的

learning rate。 -

支持向量机中的

**C**和**????**超参数。 -

k-最近邻算法中的

**k**。

超参数优化找到一个超参数组合,以返回一个最优模型,该模型减少了预定义的损失函数,从而提高了给定独立数据上的准确性。

超参数优化方法

超参数对机器学习算法的训练有直接影响。因此,为了实现最佳性能,了解如何优化它们是很重要的。以下是一些常见的超参数优化策略:

1. 手动超参数调整

传统上,超参数是通过试错法手动调整的。这仍然是常见的做法,经验丰富的工程师可以“猜测”出能够为 ML 模型提供非常高准确度的参数值。然而,仍在不断寻找更好、更快、更自动化的优化超参数的方法。

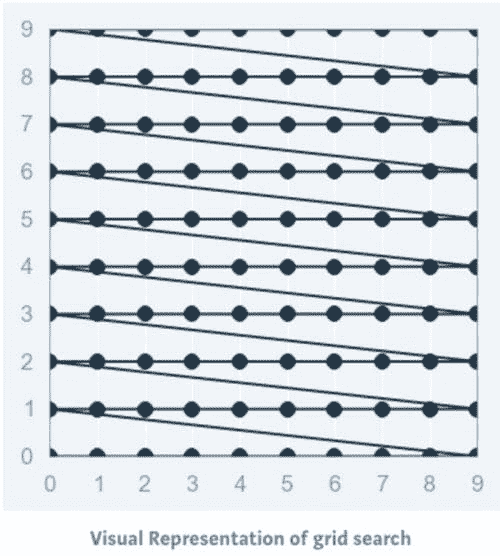

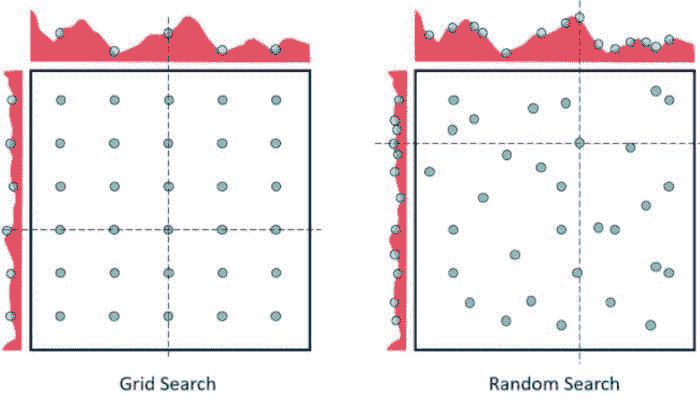

2. 网格搜索

网格搜索可以说是最基本的超参数调优方法。使用这种技术,我们只是为提供的所有超参数值的每个可能组合构建一个模型,评估每个模型,并选择产生最佳结果的架构。

网格搜索不仅适用于一种模型类型,还可以应用于机器学习中的各类模型,以计算用于任何给定模型的最佳参数。

例如,典型的软间隔支持向量机(SVM)分类器配备了 RBF 核函数,它有至少两个超参数需要优化以在未见数据上获得良好性能:正则化常数C和核超参数 γ。两个参数都是连续的,因此为了进行网格搜索,需要为每个参数选择一个有限的“合理”值,比如

网格搜索然后用这两个集合的笛卡尔积中的每一对(C, γ)训练一个 SVM,并在保留的验证集上评估它们的性能(或者通过对训练集的内部交叉验证,在这种情况下,每对会训练多个 SVM)。最后,网格搜索算法输出在验证过程中获得的最高分的设置。

它在 Python 中如何工作?

from sklearn.datasets import load_iris

from sklearn.svm import SVC

iris **=** load_iris()

svc **=** SVR()

这是一个使用[GridSearchCV](https://scikit-learn.org/stable/modules/generated/sklearn.model_selection.GridSearchCV.html)来自sklearn库的网格搜索的 Python 实现。

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVR

grid = GridSearchCV(

estimator=SVR(kernel='rbf'),

param_grid={

'C': [0.1, 1, 100, 1000],

'epsilon': [0.0001, 0.0005, 0.001, 0.005, 0.01, 0.05, 0.1, 0.5, 1, 5, 10],

'gamma': [0.0001, 0.001, 0.005, 0.1, 1, 3, 5]

},

cv=5, scoring='neg_mean_squared_error', verbose=0, n_jobs=-1)

网格搜索的实现:

grid.fit(X,y)

网格搜索的方法:

#print the best score throughout the grid search

print grid.best_score_#print the best parameter used for the highest score of the model.

print grid.best_param_

然后,我们使用在网格搜索中选择的最佳超参数值,应用于实际模型,如上所示。

网格搜索的缺点之一是当涉及到维度时,它在评估超参数数量指数增长时表现不佳。然而,没有保证搜索会产生完美的解决方案,因为它通常通过在正确的集合周围徘徊来找到一个。

3. 随机搜索

通常,有些超参数比其他超参数更为重要。进行随机搜索而不是网格搜索可以更精确地发现重要超参数的良好值。

随机搜索设置了一个超参数值的网格,并选择随机组合来训练模型和评分。这允许你明确控制尝试的参数组合的数量。搜索迭代的次数根据时间或资源进行设置。Scikit Learn 提供了RandomizedSearchCV函数来执行这一过程。

尽管RandomizedSearchCV可能找不到像GridSearchCV那么准确的结果,但它往往在比GridSearchCV快得多的时间内选出最佳结果。考虑到相同的资源,随机搜索甚至可能优于网格搜索。这在使用连续参数时可以在下面的图示中看到。

随机搜索的机会相对较高,因为随机搜索模式下,模型可能会在优化参数上进行训练而没有任何别名。由于维度较低,随机搜索在找到合适参数集的时间更短,因此适用于较低维度的数据。对于维度较少的情况,随机搜索是最佳的参数搜索技术。

在深度学习算法的情况下,它优于网格搜索。

在上图中,恭喜你有两个参数,通过 5x6 网格搜索你只检查每个参数的 5 种不同值(左侧图中的六行五列),而通过随机搜索你检查了每个参数的 14 种不同值。

它在 Python 中如何工作?

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestRegressor

iris **=** load_iris()

rf = RandomForestRegressor(random_state = 42)

下面是使用sklearn库的RandomizedSearchCV进行网格搜索的 Python 实现。

from sklearn.model_selection import RandomizedSearchCV

random_grid = {'n_estimators': n_estimators,

'max_features': max_features,

'max_depth': max_depth,

'min_samples_split': min_samples_split,

'min_samples_leaf': min_samples_leaf,

'bootstrap': bootstrap}rf_random = RandomizedSearchCV(estimator = rf, param_distributions = random_grid, n_iter = 100, cv = 3, verbose=2, random_state=42, n_jobs = -1)# Fit the random search model

随机搜索的拟合:

rf_random.fit(X,y)

网格搜索中运行的方法:

#print the best score throughout the grid search

print rf_random.best_score_#print the best parameter used for the highest score of the model.

print rf_random.best_param_Output:

**{'bootstrap': True,

'max_depth': 70,

'max_features': 'auto',

'min_samples_leaf': 4,

'min_samples_split': 10,

'n_estimators': 400}**

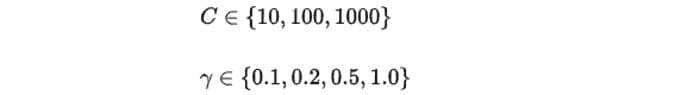

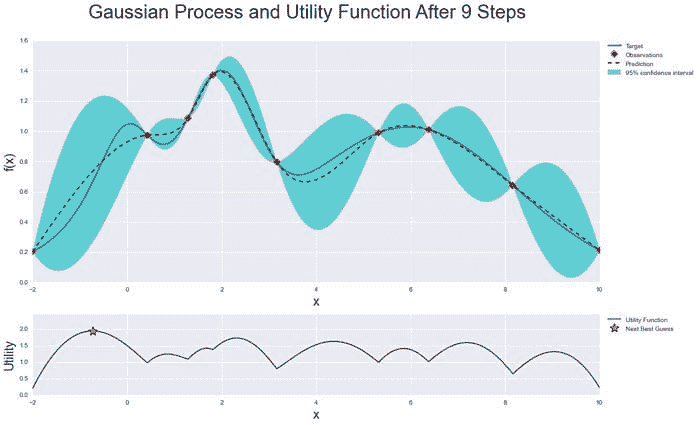

4. 贝叶斯优化

之前的两个方法通过各种超参数值进行单独实验,并记录每个模型的表现。由于每个实验都是孤立进行的,因此很容易并行化这个过程。然而,由于每个实验都是孤立进行的,我们无法利用一个实验的信息来改进下一个实验。贝叶斯优化属于基于模型的序列优化(SMBO)算法的一类,允许我们使用先前迭代的结果来改进下一次实验的采样方法。

这反过来限制了模型需要训练的次数,因为只有那些预计会产生更高验证分数的设置才会被传递以供评估。

贝叶斯优化通过构建最能描述你想优化的函数的后验分布(高斯过程)来工作。随着观察数量的增加,后验分布会改进,算法对参数空间中值得探索和不值得探索的区域变得更加确定。

我们可以在下面的图像中看到这一点:

来源:贝叶斯优化

当你一遍遍迭代时,算法会在考虑目标函数已知信息的基础上平衡探索和开发的需求。在每一步中,将为已知样本(之前探索过的点)拟合一个高斯过程,并结合探索策略(如 UCB(上置信界)或 EI(期望改进)),以确定应探索的下一点。

使用贝叶斯优化,我们可以更智能地探索参数空间,从而减少进行此过程所需的时间。

你可以查看下面的贝叶斯优化的 Python 实现:

thuijskens/bayesian-optimization

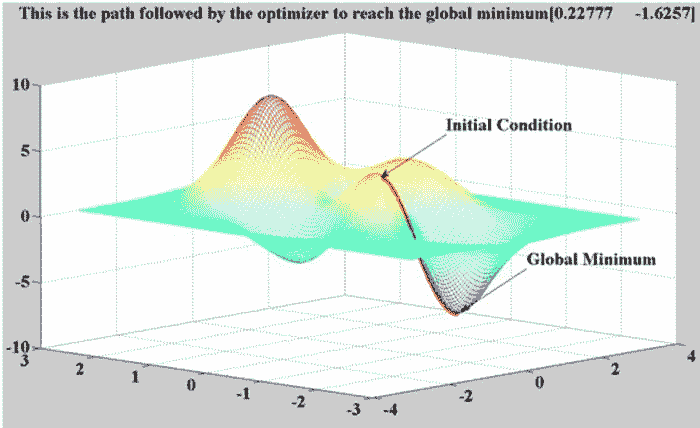

5. 基于梯度的优化

它特别用于神经网络的情况。它计算关于超参数的梯度,并使用梯度下降算法对其进行优化。

计算梯度问题并不是最难的,至少在高级的自动微分软件出现之后。(当然,为所有 sklearn 分类器以通用方式实现这一点并不容易)

尽管有一些人使用这种想法的工作,但他们只是为一些特定且明确的问题(例如 SVM 调优)做了这件事。此外,这可能有很多假设,因为:

为什么这不是一个好主意?

1. 超参数优化通常是不平滑的

-

GD 真的喜欢平滑函数,因为零梯度没有帮助。

-

每个由某些离散集合定义的超参数(例如 l1 与 l2 惩罚的选择)会引入不平滑的表面。

2. 超参数优化通常是非凸的

-

梯度下降的整个收敛理论假设基础问题是凸的。

-

好的情况:你能获得某个局部最小值(可以非常糟糕)。

-

最坏的情况:梯度下降甚至没有收敛到某个局部最小值。

要获取 Python 实现和更多关于梯度下降优化算法的信息,请点击这里。

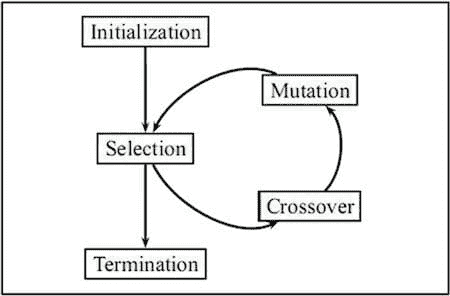

6. 进化优化

进化优化遵循一个受生物进化概念启发的过程,由于自然进化是在变化环境中的动态过程,因此它们也非常适合动态优化问题。

进化算法通常用于寻找良好的近似解决方案,这些方案无法通过其他技术轻易解决。优化问题通常没有精确的解决方案,因为找到最优解决方案可能过于耗时和计算密集。然而,在这种情况下,进化算法是理想的,因为它们可以用于找到一个接近最优的解决方案,这通常是足够的。

进化算法的一个优点是它们可以生成没有任何人为误解或偏见的解决方案,这意味着它们可以产生我们可能永远无法自己想出的惊人想法。

你可以在这里了解更多关于进化算法的信息。你也可以在这里查看 Python 实现。

一般来说,每当你想要优化调优超参数时,请考虑网格搜索和随机搜索!

结论

在本文中,我们了解到寻找合适的超参数值可能是一项令人沮丧的任务,可能导致机器学习模型的欠拟合或过拟合。我们看到如何通过使用网格搜索、随机搜索和其他算法来克服这一难题——这些算法优化超参数的调优,以节省时间并消除通过随机猜测导致的过拟合或欠拟合的可能性。

好了,这篇文章到此结束。希望你们喜欢阅读这篇文章,欢迎在评论区分享你的评论/想法/反馈。

感谢阅读 !!!

作者:纳戈什·辛格·乔汉 是一名数据科学爱好者。对大数据、Python 和机器学习感兴趣。

原文。经许可转载。

相关:

-

如何在 3 个简单步骤中对任何 Python 脚本进行超参数调优

-

使用 Biopython 进行冠状病毒 COVID-19 基因组分析

-

实用超参数优化

更多相关内容

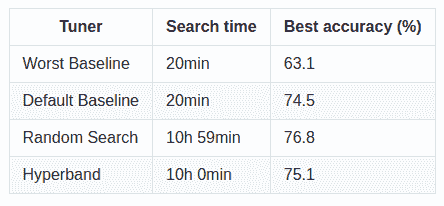

使用网格搜索和随机搜索进行超参数调优

原文:

www.kdnuggets.com/2022/10/hyperparameter-tuning-grid-search-random-search-python.html

图片由编辑提供

介绍

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 方面的工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 方面的工作

所有机器学习模型都有一组超参数或参数,这些参数必须由从业者指定。

例如,一个逻辑回归模型有不同的求解器用于找到可以给出最佳输出的系数。每个求解器使用不同的算法来找到最佳结果,并且这些算法没有哪个严格优于其他算法。除非你尝试所有的求解器,否则很难判断哪个求解器在你的数据集上表现最好。

最佳超参数是主观的,并且对于每个数据集都不同。Python 中的 Scikit-Learn 库提供了一组默认的超参数,这些超参数在所有模型上表现都还算不错,但它们不一定适用于每个问题。

找到数据集的最佳超参数的唯一方法是通过试验和错误,这也是 超参数优化 的主要概念。

简单来说,超参数优化是一种技术,涉及在一系列值中搜索,以找到一组能够在给定数据集上实现最佳性能的结果。

有两种流行的技术用于进行超参数优化——网格搜索和随机搜索。

网格搜索

在进行超参数优化时,我们首先需要定义一个 参数空间 或 参数网格,其中包含一组可以用于构建模型的可能超参数值。

网格搜索技术将这些超参数放置在类似矩阵的结构中,然后在每个超参数值的组合上训练模型。

然后选择表现最佳的模型。

随机搜索

虽然网格搜索会查看所有可能的超参数组合以找到最佳模型,但随机搜索只会选择并测试一个随机的超参数组合。

该技术从超参数网格中随机抽样,而不是进行详尽的搜索。

我们可以指定随机搜索应该尝试的总运行次数,然后再返回最佳模型。

现在你对随机搜索和网格搜索的基本原理有了了解,我将向你展示如何使用 Scikit-Learn 库实现这些技术。

使用网格搜索和随机搜索优化随机森林分类器

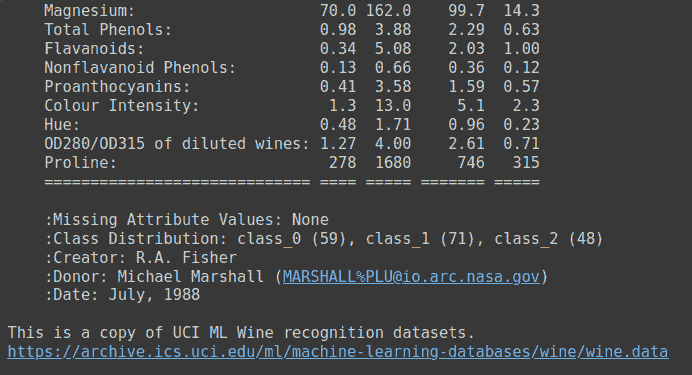

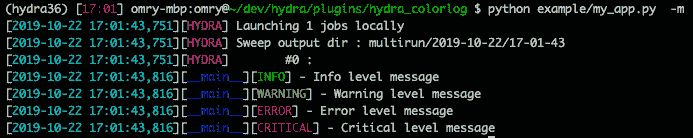

第 1 步:加载数据集

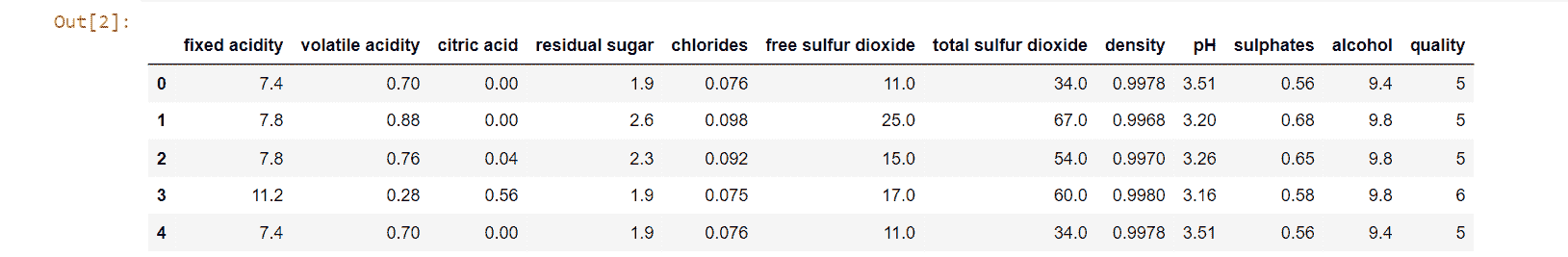

在 Kaggle 上下载酒质数据集,然后输入以下代码行,使用Pandas库读取数据:

import pandas as pd

df = pd.read_csv('winequality-red.csv')

df.head()

数据框的头部如下所示:

第 2 步:数据预处理

目标变量“quality”包含范围在 1 到 10 之间的值。

我们将通过将所有质量值小于或等于 5 的数据点分配为 0,将其余观察值分配为 1,将其转化为二分类任务:

import numpy as np

df['target'] = np.where(df['quality']>5, 1, 0)

让我们将数据框中的因变量和自变量分开:

df2 = df.drop(['quality'],axis=1)

X = df2.drop(['target'],axis=1)

y = df2[['target']]

第 3 步:构建模型

现在,让我们实例化一个随机森林分类器。我们将调整该模型的超参数,以创建适合我们数据集的最佳算法:

from sklearn.ensemble import RandomForestClassifier

rf = RandomForestClassifier()

第 4 步:使用 Scikit-Learn 实现网格搜索

定义超参数空间

我们现在将尝试调整该模型的以下超参数集合:

-

“Max_depth”:该超参数表示随机森林模型中每棵树的最大层级。较深的树可以很好地捕捉训练数据中的大量信息,但对测试数据的泛化能力较差。默认情况下,Scikit-Learn 库中的该值设置为“None”,这意味着树会完全扩展。

-

“Max_features”:随机森林模型在每次分裂时允许尝试的最大特征数量。Scikit-Learn 中的默认值设置为数据集中变量总数的平方根。

-

“N_estimators”:森林中决策树的数量。Scikit-Learn 中的默认估计器数量为 10。

-

“Min_samples_leaf”:每棵树的叶节点所需的最小样本数。Scikit-Learn 中的默认值为 1。

-

“Min_samples_split”:每棵树内部节点分裂所需的最小样本数。Scikit-Learn 中的默认值为 2。

我们现在将创建一个包含所有上述超参数的多个可能值的字典。这也叫做超参数空间,将会通过它来寻找最佳的参数组合:

grid_space={'max_depth':[3,5,10,None],

'n_estimators':[10,100,200],

'max_features':[1,3,5,7],

'min_samples_leaf':[1,2,3],

'min_samples_split':[1,2,3]

}

运行网格搜索

现在,我们需要进行搜索以找到模型的最佳超参数组合:

from sklearn.model_selection import GridSearchCV

grid = GridSearchCV(rf,param_grid=grid_space,cv=3,scoring='accuracy')

model_grid = grid.fit(X,y)

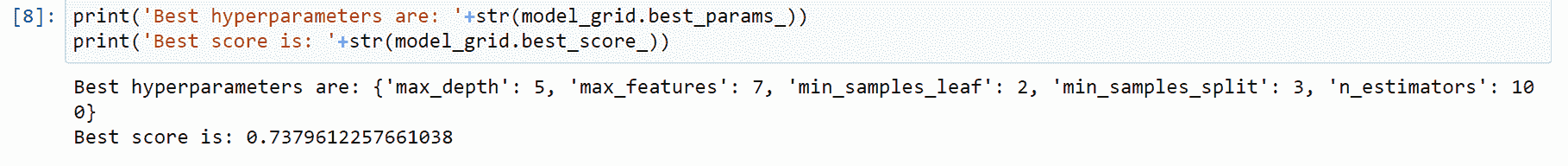

评估模型结果

最后,让我们输出最佳模型的准确性,并附上产生该分数的超参数集合:

print('Best hyperparameters are: '+str(model_grid.best_params_))

print('Best score is: '+str(model_grid.best_score_))

最佳模型的准确率约为 0.74,其超参数如下:

现在,让我们在相同的数据集上使用随机搜索,看看是否能得到类似的结果。

步骤 5:使用 Scikit-Learn 实现随机搜索

定义超参数空间

现在,让我们定义超参数空间以实现随机搜索。这个参数空间可以比我们为网格搜索构建的范围更大,因为随机搜索不会尝试每一种超参数组合。

它随机抽样超参数以找到最佳参数,这意味着与网格搜索不同,随机搜索可以快速浏览大量值。

from scipy.stats import randint

rs_space={'max_depth':list(np.arange(10, 100, step=10)) + [None],

'n_estimators':np.arange(10, 500, step=50),

'max_features':randint(1,7),

'criterion':['gini','entropy'],

'min_samples_leaf':randint(1,4),

'min_samples_split':np.arange(2, 10, step=2)

}

运行随机搜索

运行以下代码行以在模型上执行随机搜索:(注意,我们已指定 n_iter=500,这意味着随机搜索将在选择最佳模型之前运行 500 次。你可以尝试不同的迭代次数以查看哪种给你最优的结果。请记住,较大的迭代次数将带来更好的性能,但也更耗时。)

from sklearn.model_selection import RandomizedSearchCV

rf = RandomForestClassifier()

rf_random = RandomizedSearchCV(rf, space, n_iter=500, scoring='accuracy', n_jobs=-1, cv=3)

model_random = rf_random.fit(X,y)

评估模型结果

现在,运行以下代码行以打印随机搜索找到的最佳超参数及最佳模型的最高准确率:

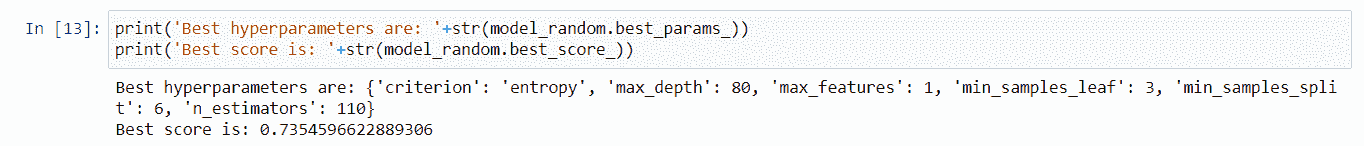

print('Best hyperparameters are: '+str(model_random.best_params_))

print('Best score is: '+str(model_random.best_score_))

随机搜索找到的最佳超参数如下:

所有构建的模型的最高准确率也大约为 0.74。

观察到网格搜索和随机搜索在数据集上表现都相当不错。请记住,如果你在相同的代码上运行随机搜索,你的结果可能会与我上面展示的结果大相径庭。

这是因为它通过随机初始化搜索非常大的参数网格,这可能导致每次使用该技术时结果变化剧烈。

完整代码

这里是教程中使用的完整代码:

# imports

import pandas as pd

import numpy as np

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import GridSearchCV

from scipy.stats import randint

from sklearn.model_selection import RandomizedSearchCV

# reading the dataset

df = pd.read_csv('winequality-red.csv')

# preprocessing

df['target'] = np.where(df['quality']>5, 1, 0)

df2 = df.drop(['quality'],axis=1)

X = df2.drop(['target'],axis=1)

y = df2[['target']]

# initializing random forest

rf = RandomForestClassifier()

# grid search cv

grid_space={'max_depth':[3,5,10,None],

'n_estimators':[10,100,200],

'max_features':[1,3,5,7],

'min_samples_leaf':[1,2,3],

'min_samples_split':[1,2,3]

}

grid = GridSearchCV(rf,param_grid=grid_space,cv=3,scoring='accuracy')

model_grid = grid.fit(X,y)

# grid search results

print('Best grid search hyperparameters are: '+str(model_grid.best_params_))

print('Best grid search score is: '+str(model_grid.best_score_))