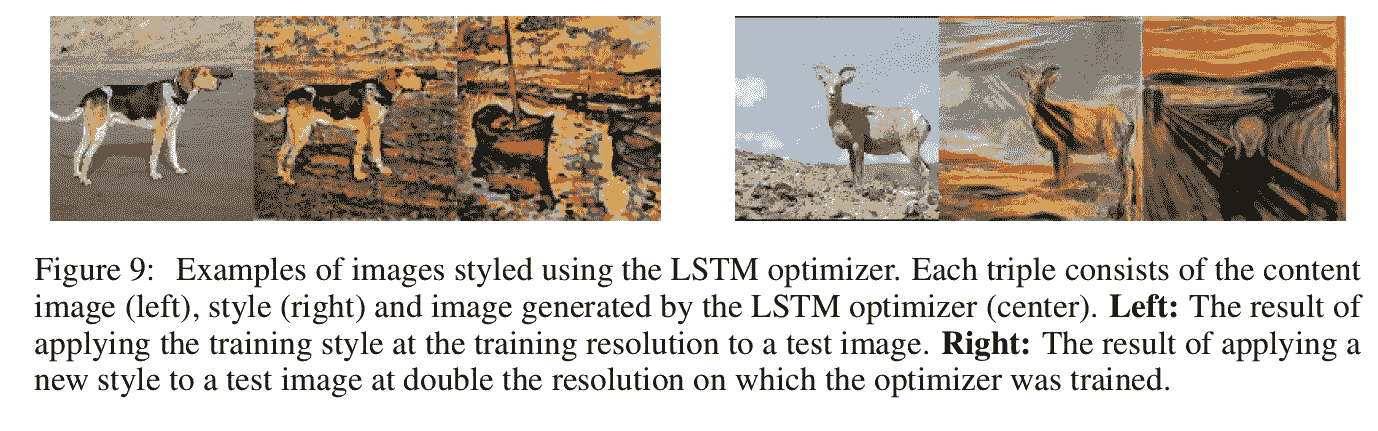

KDNuggets-博客中文翻译-二十三-

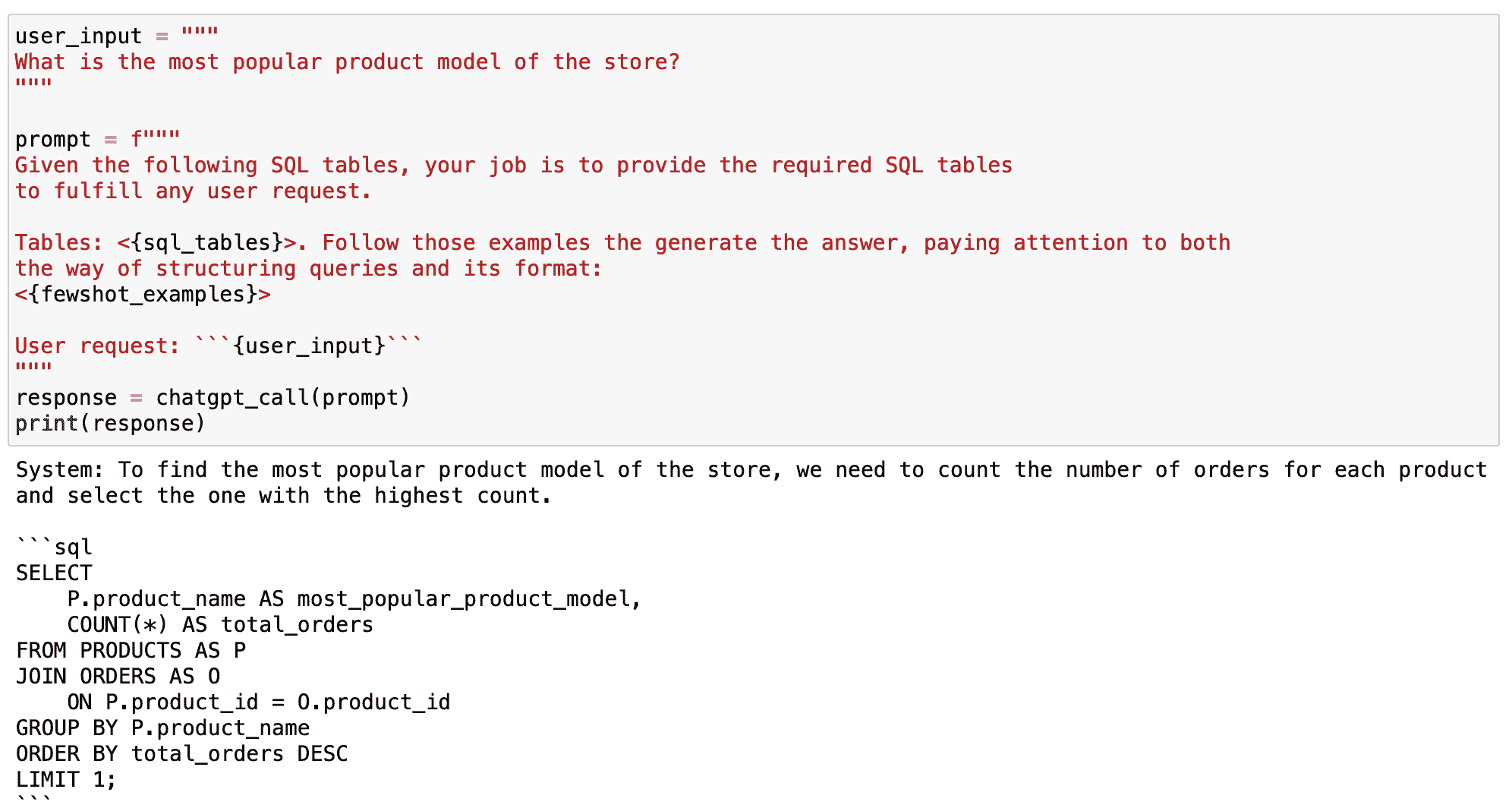

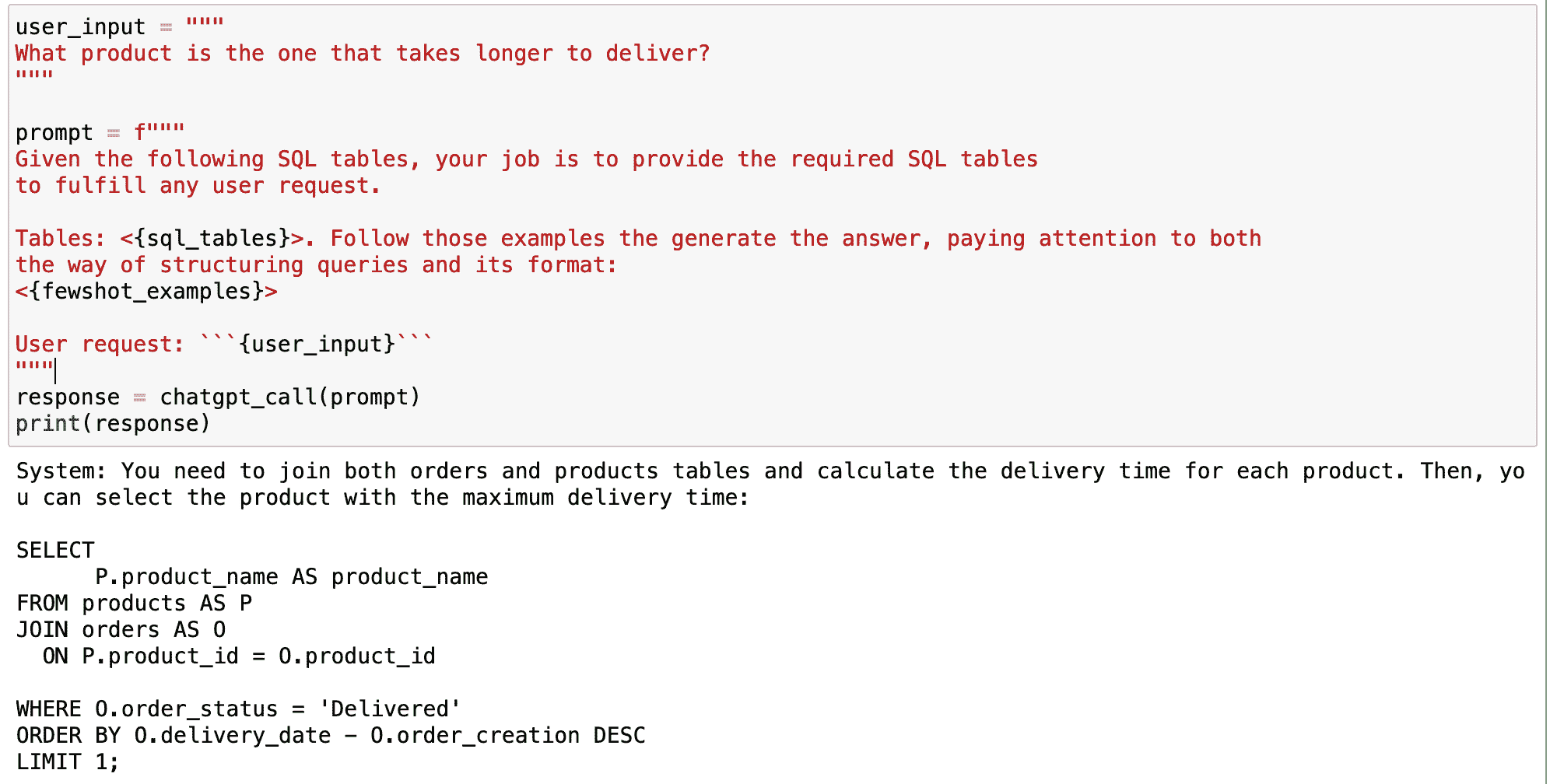

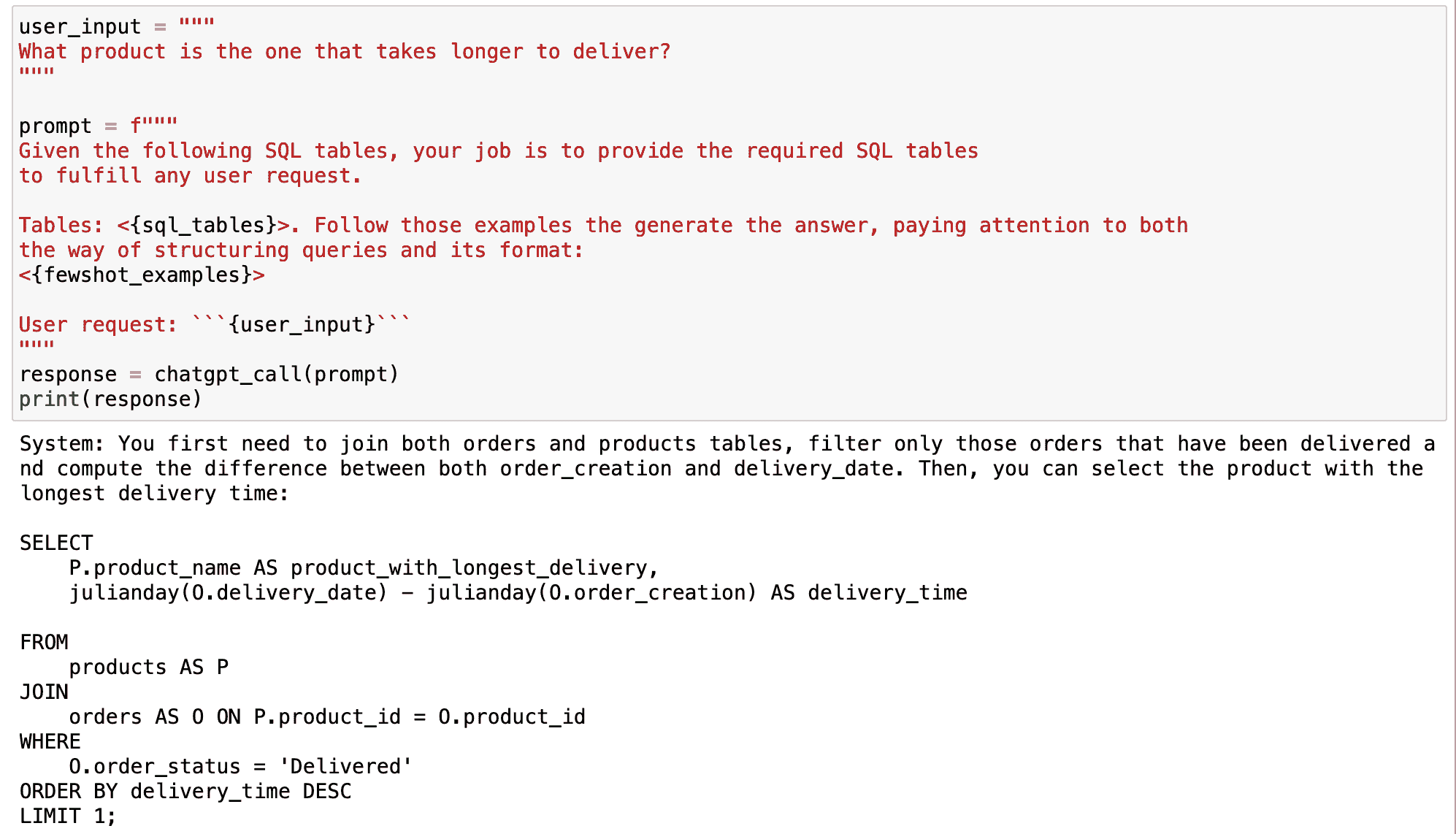

KDNuggets 博客中文翻译(二十三)

原文:KDNuggets

LangChain 101: 构建你自己的 GPT 驱动应用程序

原文:

www.kdnuggets.com/2023/04/langchain-101-build-gptpowered-applications.html

图片来源:作者

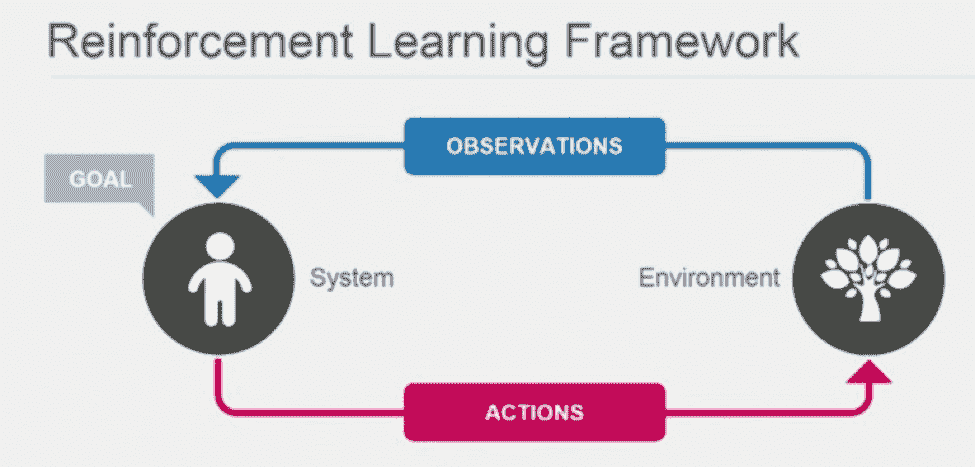

ChatGPT 和 GPT-4 的成功展示了经过强化训练的大型语言模型如何产生可扩展且强大的 NLP 应用程序。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速通道进入网络安全职业。

1. Google 网络安全证书 - 快速通道进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

然而,响应的有用性依赖于提示,这导致用户探索提示工程领域。此外,大多数实际的 NLP 用例需要比单次 ChatGPT 会话更复杂的解决方案。而这正是像 LangChain 这样的库可以提供帮助的地方!

LangChain 是一个 Python 库,帮助你利用大型语言模型构建自定义的 NLP 应用程序。

在本指南中,我们将探讨 LangChain 是什么以及你可以用它构建什么。我们还将通过构建一个简单的问答应用程序来入门 LangChain。

让我们开始吧!

LangChain 是什么?

LangChain 由 Harrison Chase 创建,是一个 Python 库,提供开箱即用的支持,用于使用 LLM 构建 NLP 应用程序。你可以连接各种数据和计算源,构建在特定领域数据源、私人库等上执行 NLP 任务的应用程序。

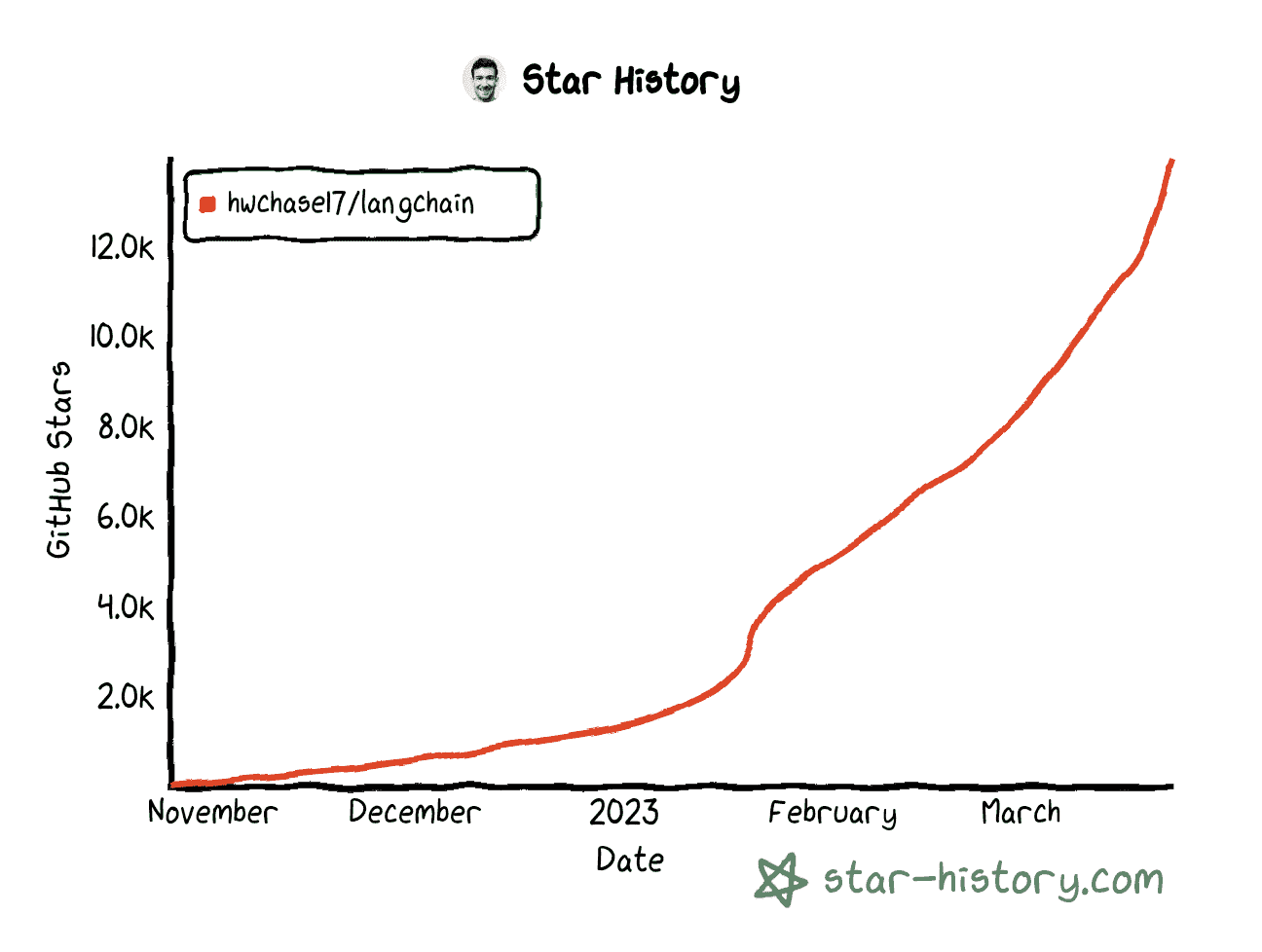

截至本文撰写时(2023 年 3 月),LangChain GitHub 仓库已有超过 14,000 个星标,来自世界各地的 270 多位贡献者。

LangChain Github 星标历史 | 生成于 star-history.com

使用 LangChain 可以构建的有趣应用程序包括(但不限于):

-

聊天机器人

-

针对特定领域的总结和问答

-

查询数据库以获取信息然后处理的应用程序

-

解决特定问题的代理,例如数学和推理难题

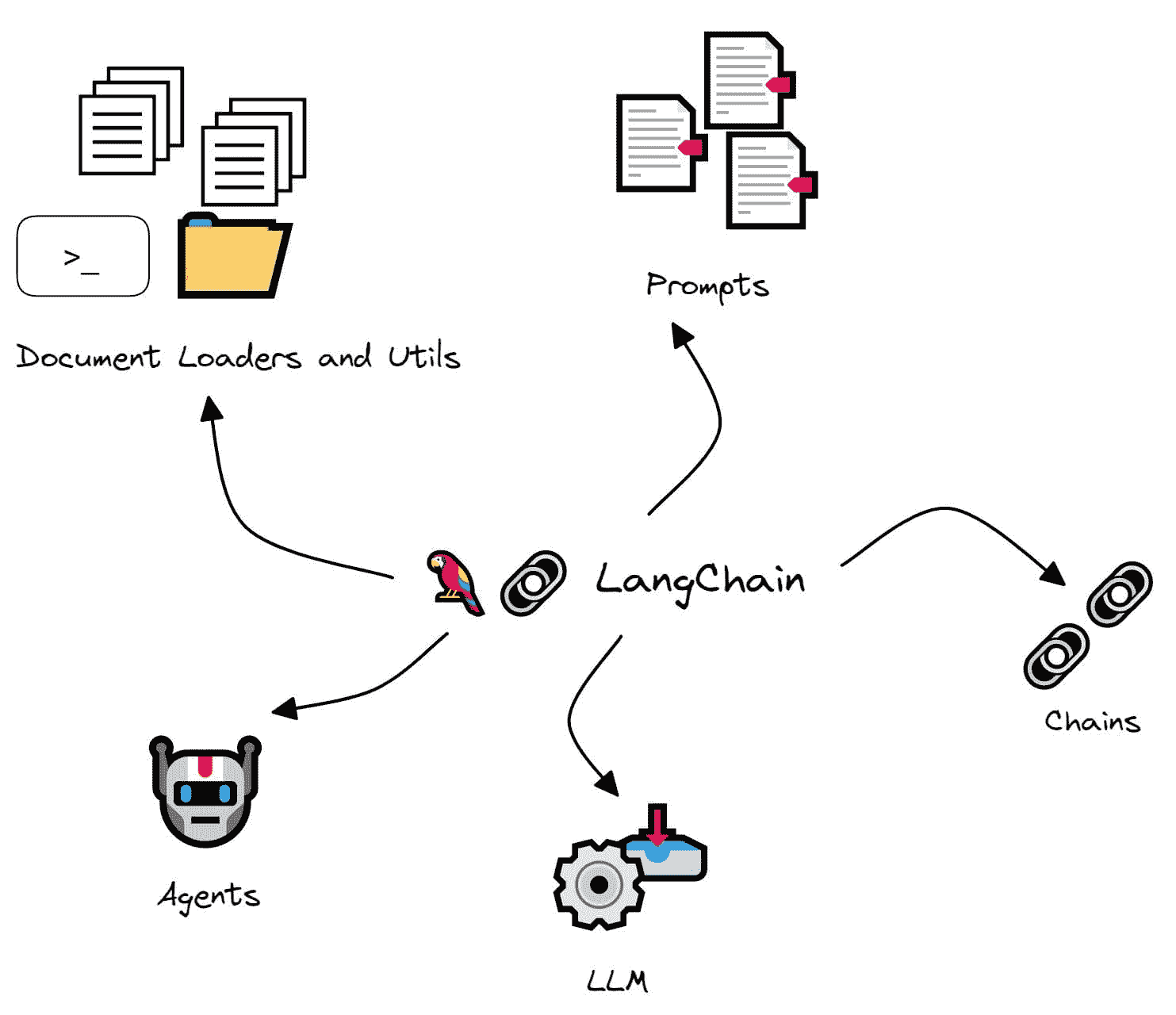

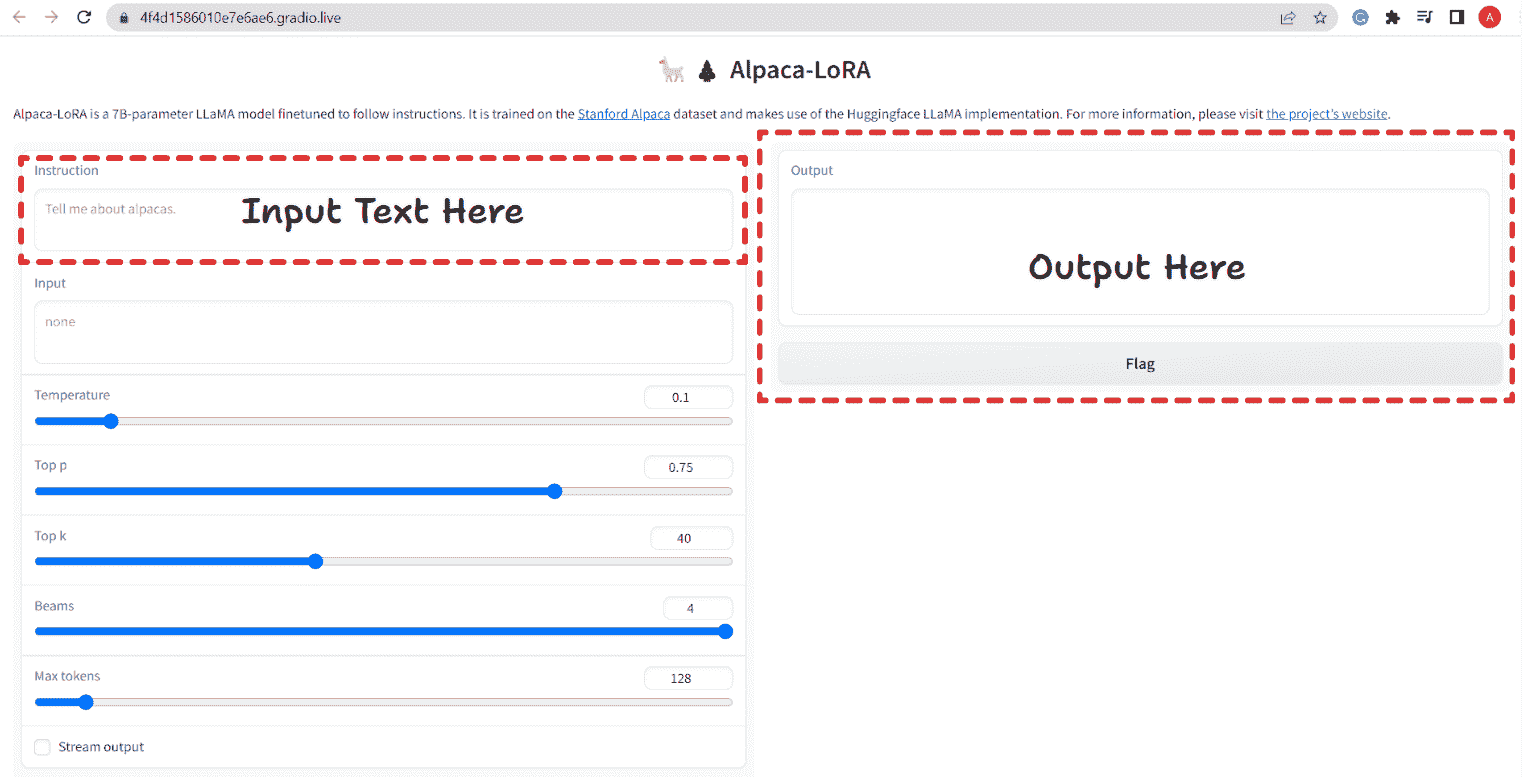

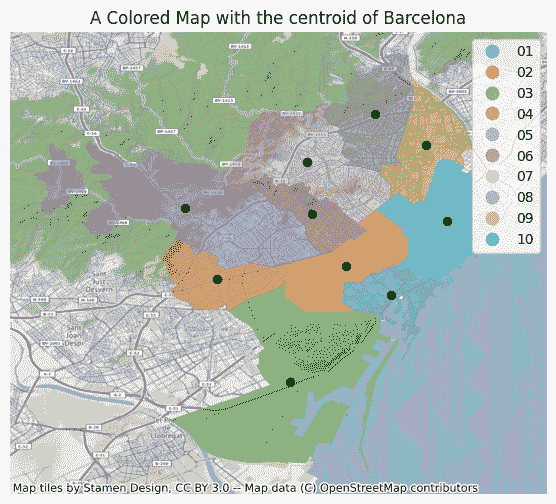

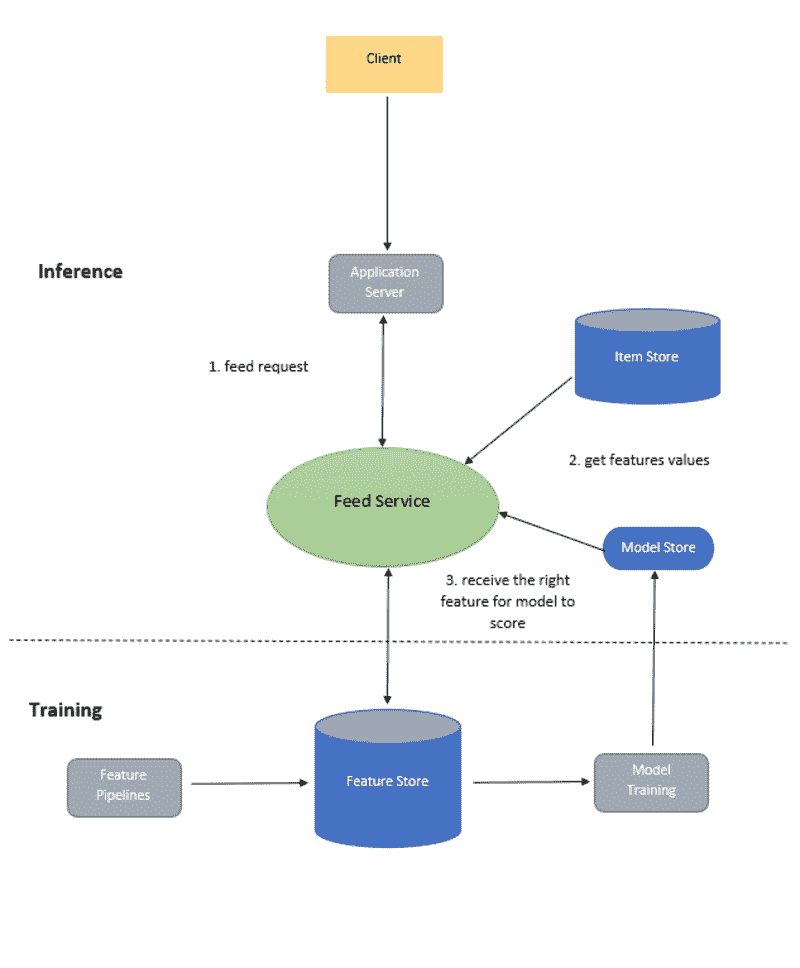

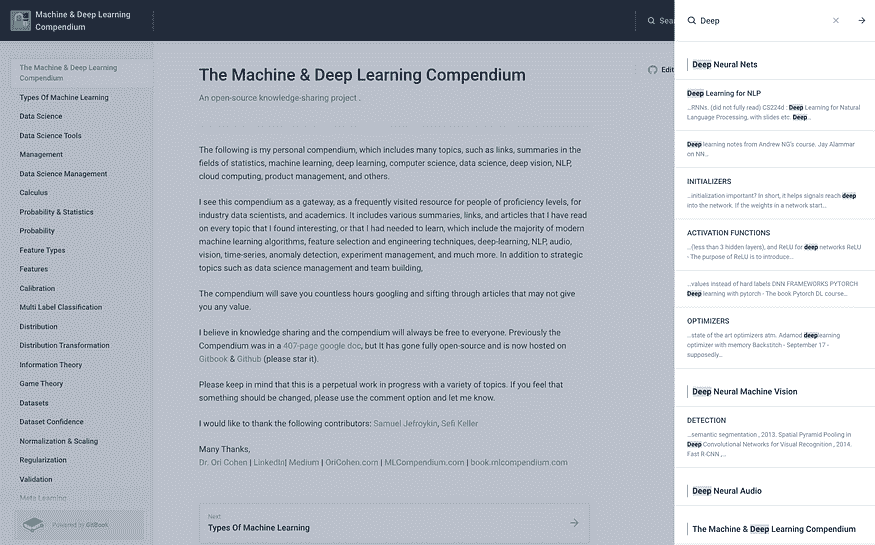

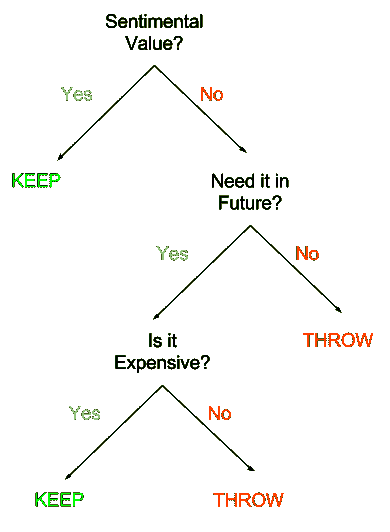

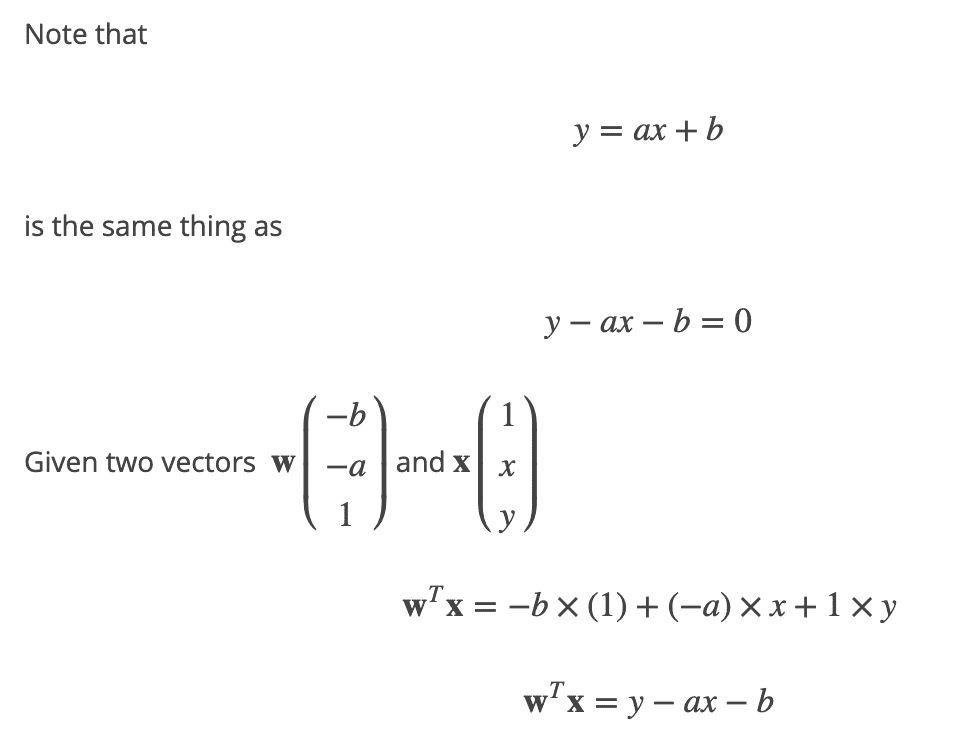

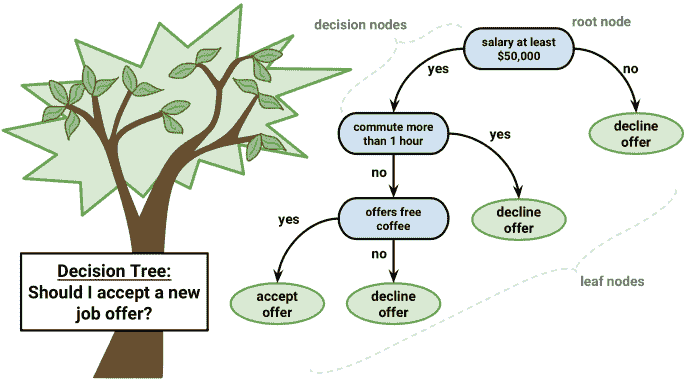

LangChain 模块概览

接下来让我们看看 LangChain 的一些模块:

图片来源:作者

LLM

LLM 是 LangChain 的基本组件。它本质上是一个围绕大型语言模型的封装器,帮助使用特定大型语言模型的功能和能力。

链条

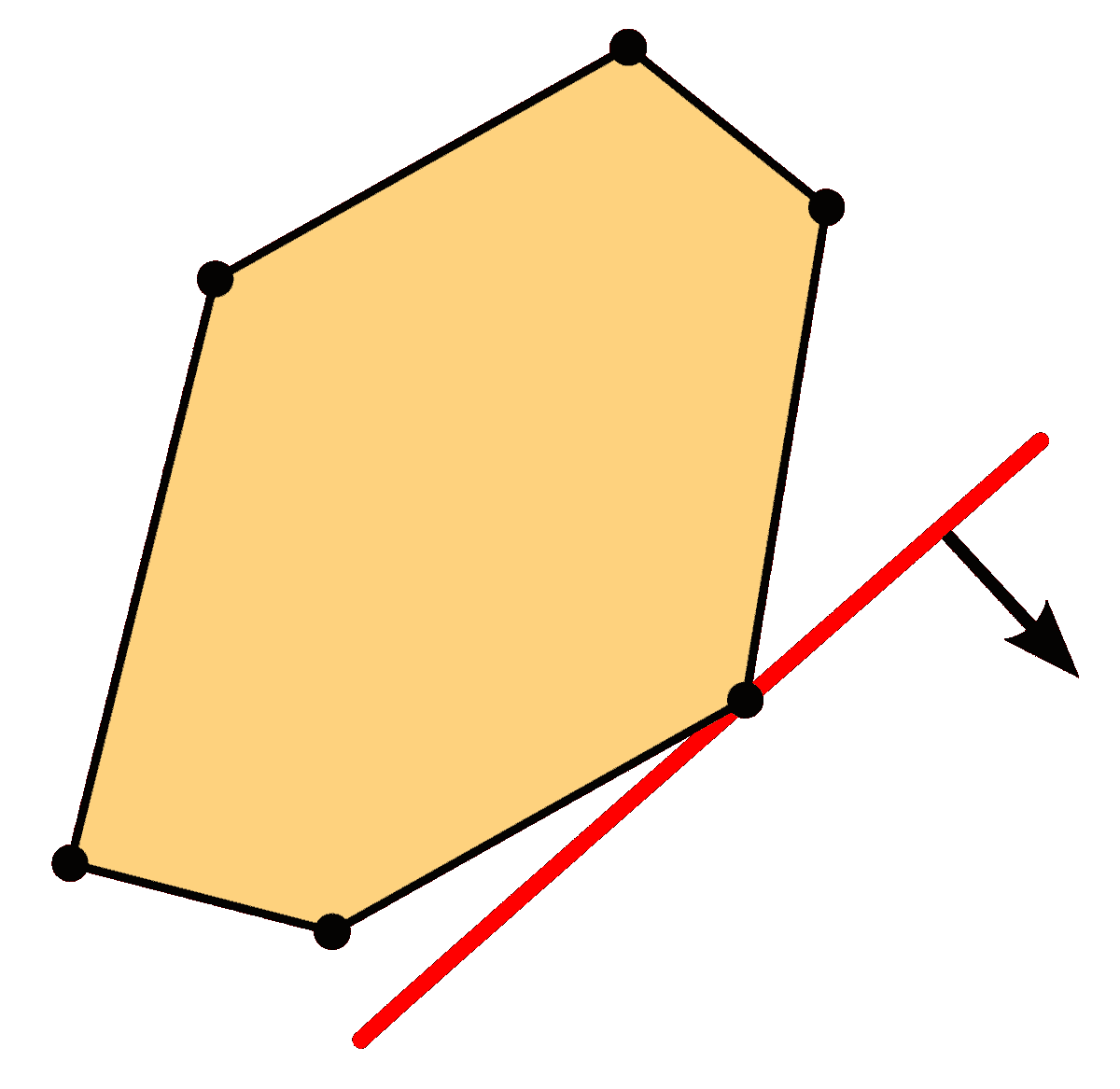

如前所述,LLM 是 LangChain 中的基本单元。然而,正如 LangChain 这个名字所暗示的,你可以根据特定任务将 LLM 调用链接在一起。

例如,你可能需要从特定的 URL 获取数据,汇总返回的文本,并使用生成的摘要回答问题。

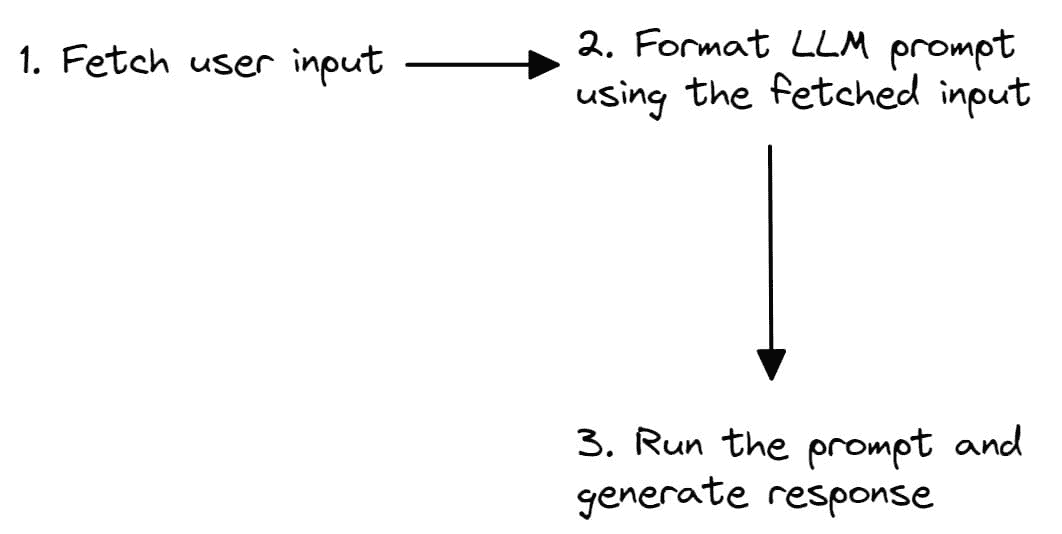

链条也可以很简单。你可能需要读取用户输入,然后用这些输入构造提示。提示可以用于生成响应。

图片由作者提供

提示

提示是任何 NLP 应用程序的核心。即使在 ChatGPT 会话中,答案也只是与提示相关的。为此,LangChain 提供了可以用于格式化输入的提示模板以及许多其他实用工具。

文档加载器和工具

LangChain 的 文档加载器 和 工具 模块分别有助于连接数据源和计算。

假设你有一大批关于经济学的文本,你希望在此基础上构建一个 NLP 应用程序。你的文本库可能是文本文件、PDF 文档、HTML 网页、图像等的混合。目前,文档加载器利用 Python 库 Unstructured 将这些原始数据源转换为可以处理的文本。

工具模块提供了 Bash 和 Python 解释器会话等。这些适用于需要直接与底层系统交互的应用程序,或当我们需要代码片段来计算特定的数学量或解决问题时,而不是一次性计算答案。

代理

我们提到过,“链条”可以帮助将一系列 LLM 调用连接在一起。然而,在某些任务中,这些调用的顺序往往不是确定的。下一步可能依赖于用户输入和前一步的响应。

对于这类应用程序,LangChain 库提供了可以根据输入在过程中采取行动的“代理”,而不是一个硬编码的确定性序列。

除了上述功能,LangChain 还提供了与向量数据库的集成,并具备在 LLM 调用之间维护状态的内存功能,以及更多功能。

使用 LangChain 构建问答应用程序

现在我们已经对 LangChain 有了了解,让我们按照五个简单的步骤使用 LangChain 构建一个问答应用程序:

第一步 – 设置开发环境

在我们开始编码之前,让我们设置开发环境。我假设你已经在工作环境中安装了 Python。

你现在可以使用 pip 安装 LangChain 库:

pip install langchain

由于我们将使用 OpenAI 的语言模型,我们还需要安装 OpenAI SDK:

pip install openai

第二步 – 将 OPENAI_API_KEY 设置为环境变量

接下来,登录你的 OpenAI 账户。导航到账户设置 > 查看 API 密钥。生成一个密钥并复制它。

在你的 Python 脚本中,使用os模块并访问环境变量字典os.environ。将“OPENAI_API_KEY”设置为你刚刚复制的秘密 API 密钥:

import os

os.environ["OPENAI_API_KEY"] = "your-api-key-here"

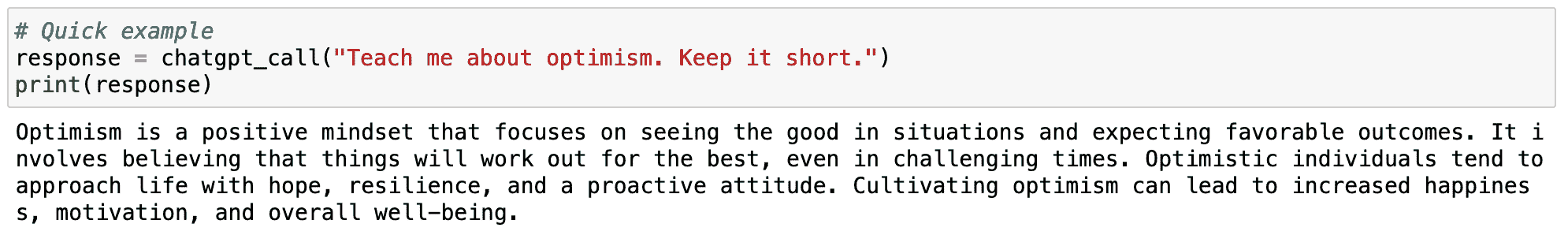

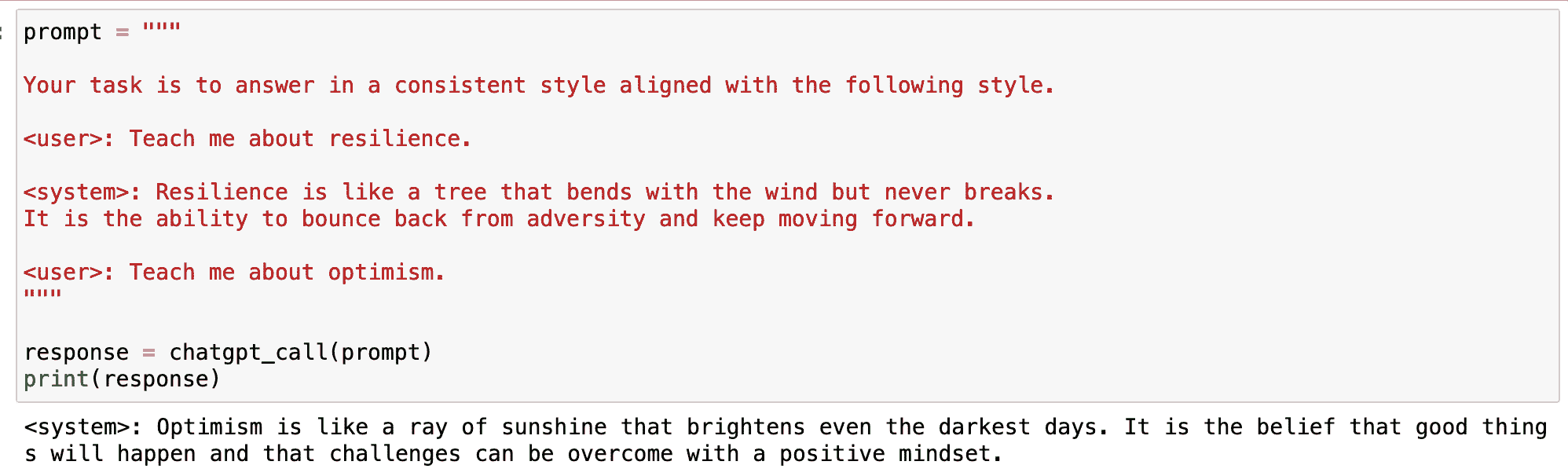

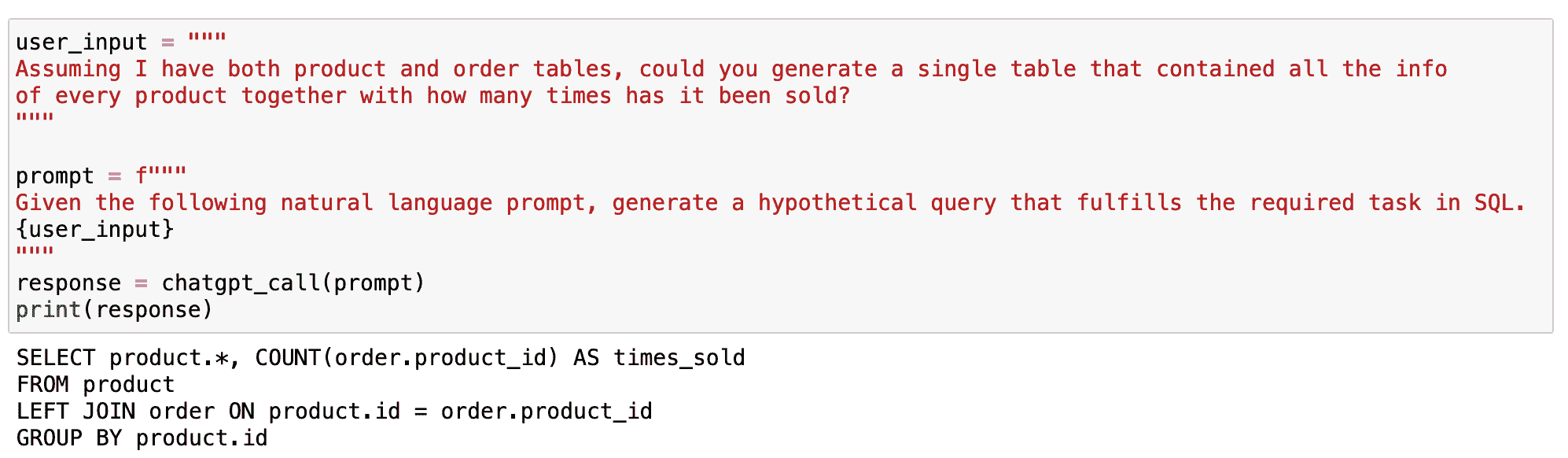

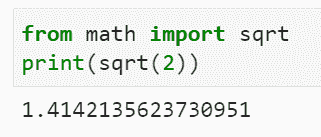

步骤 3 – 使用 LangChain 进行简单的 LLM 调用

现在我们已经安装了所需的库,让我们看看如何使用 LangChain 进行一个简单的 LLM 调用。

为此,让我们导入 OpenAI 包装器。在这个示例中,我们将使用 text-davinci-003 模型:

from langchain.llms import OpenAI

llm = OpenAI(model_name="text-davinci-003")

“text-davinci-003: 相比于 curie、babbage 或 ada 模型,可以更好地完成任何语言任务,提供更长的输出和一致的指令跟随。还支持在文本中插入补全。” – OpenAI 文档

让我们定义一个问题字符串并生成一个响应:

question = "Which is the best programming language to learn in 2023?"

print(llm(question))

Output >>

It is difficult to predict which programming language will be the most popular in 2023\. However, the most popular programming languages today are JavaScript, Python, Java, C++, and C#, so these are likely to remain popular for the foreseeable future. Additionally, newer languages such as Rust, Go, and TypeScript are gaining traction and could become popular choices in the future.

步骤 4 – 创建一个提示模板

让我们问另一个问题,关于学习一种新的编程语言,比如 Golang:

question = "What are the top 4 resources to learn Golang in 2023?"

print(llm(question))

Output >>

1\. The Go Programming Language by Alan A. A. Donovan and Brian W. Kernighan

2\. Go in Action by William Kennedy, Brian Ketelsen and Erik St. Martin

3\. Learn Go Programming by John Hoover

4\. Introducing Go: Build Reliable, Scalable Programs by Caleb Doxsey

虽然这对初学者来说效果不错,但当我们试图整理一份学习编程语言和技术栈的资源列表时,它很快变得重复。

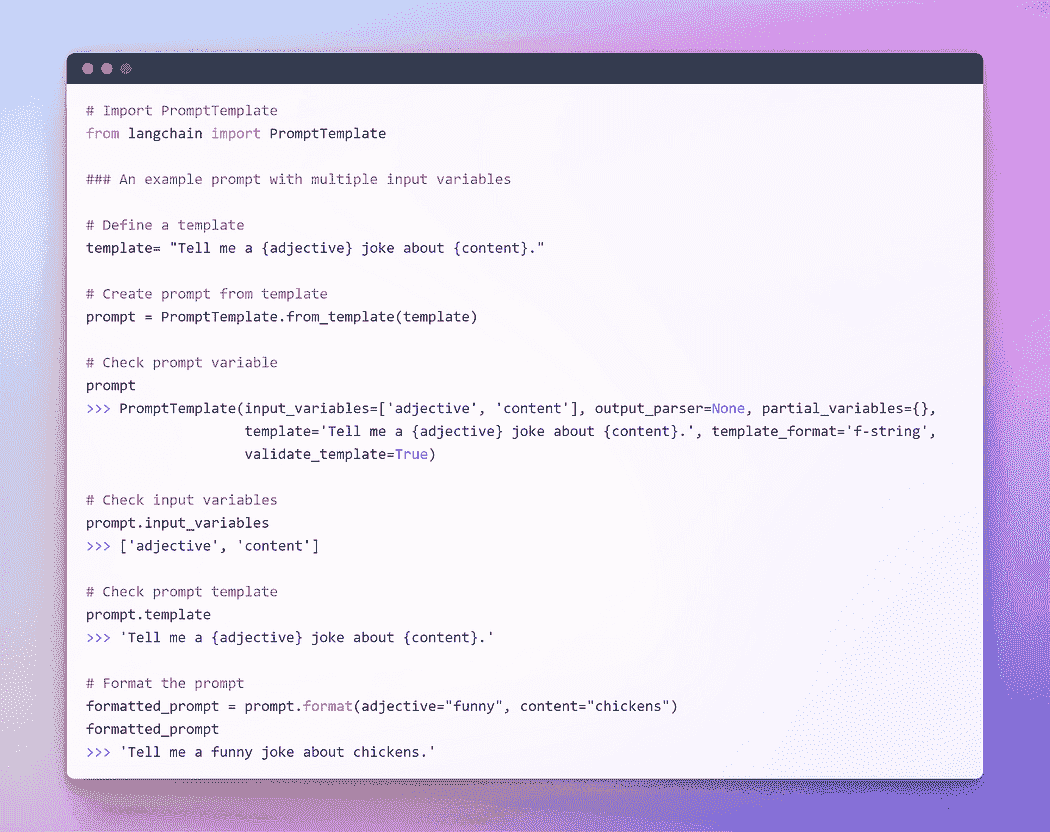

这就是提示模板的用武之地。你可以创建一个可以使用一个或多个输入变量格式化的模板。

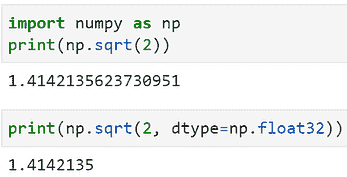

我们可以创建一个简单的模板,以获取学习任何技术栈的前 k 个资源。在这里,我们使用k和this作为input_variables:

from langchain import PromptTemplate

template = "What are the top {k} resources to learn {this} in 2023?"

prompt = PromptTemplate(template=template,input_variables=['k','this'])

步骤 5 – 运行我们的第一个 LLM 链

我们现在有了一个 LLM 和一个可以在多个 LLM 调用中重用的提示模板。

llm = OpenAI(model_name="text-davinci-003")

prompt = PromptTemplate(template=template,input_variables=['k','this'])

让我们继续创建一个 LLMChain:

from langchain import LLMChain

chain = LLMChain(llm=llm,prompt=prompt)

你现在可以将输入作为字典传入,并按如下所示运行 LLM 链:

input = {'k':3,'this':'Rust'}

print(chain.run(input))

Output >>

1\. Rust By Example - Rust By Example is a great resource for learning Rust as it provides a series of interactive exercises that teach you how to use the language and its features.

2\. Rust Book - The official Rust Book is a comprehensive guide to the language, from the basics to the more advanced topics.

3\. Rustlings - Rustlings is a great way to learn Rust quickly, as it provides a series of small exercises that help you learn the language step-by-step.

总结

就这样!你知道如何使用 LangChain 构建一个简单的问答应用程序。我希望你对 LangChain 的功能有了初步的了解。作为下一步,尝试探索 LangChain 来构建更有趣的应用程序。编程愉快!

参考资料及进一步学习

-

Chase, H. (2022). LangChain [计算机软件]. https://github.com/hwchase17/langchain

Bala Priya C 是一位技术作家,喜欢创建长篇内容。她的兴趣领域包括数学、编程和数据科学。她通过撰写教程、操作指南等向开发者社区分享她的学习成果。

更多相关话题

LangChain 备忘单

不要成为弱链

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 需求

人工智能领域持续快速发展,不断出现新的框架和工具,使 AI 更加易于获取。最近 LLM 爆炸性发展的一个特别令人兴奋的进展是 LangChain,这是一个开源 Python 库,简化了使用大型语言模型构建 AI 应用程序的过程。

LangChain 提供了一个直观的接口,用于连接最先进的模型,如 GPT-4,并优化它们以适应定制应用程序。它支持结合多个模型的链条和模块化提示工程,实现更有影响力的互动。该库还包括通过文档加载器、相似性搜索的向量存储等工具,为你的应用程序提供外部知识。

使用 LangChain,开发者可以构建强大的基于语言的 AI 应用程序,无需重新发明轮子。其可组合结构使得轻松混合和匹配组件,如 LLMs、提示模板、外部工具和记忆。这加快了原型制作,并允许随着时间的推移无缝集成新功能。无论你是想创建聊天机器人、问答机器人还是多步骤推理代理,LangChain 都提供了快速组装先进 AI 的构建模块。

欲了解更多关于开始使用 LangChain 的信息,请查看我们的最新备忘单。

LangChain 通过可重用组件和预构建的链条简化了与语言模型的应用构建。它使模型具备数据感知和智能代理功能,从而实现更动态的互动。其模块化架构支持快速开发和定制。

对于那些刚接触对话式人工智能和大语言模型(LLMs)的人,LangChain 提供了易于理解的抽象层,简化了大型模型的使用。文档和社区支持帮助新手快速上手。更有经验的用户将欣赏到自定义和扩展提供的模块的灵活性。LangChain 使所有级别的用户都能释放大语言模型的潜力。

我们最新的备忘单 提供了 LangChain 关键功能的有用概述以及简单的代码片段以便快速入门。对于任何有兴趣使用大语言模型的人来说,LangChain 是一个必备工具,这份资源是立即上手的关键。

立即查看,并请稍后回来查看更多内容。

更多相关内容

LangChain + Streamlit + Llama:将对话 AI 带到你的本地机器

原文:

www.kdnuggets.com/2023/08/langchain-streamlit-llama-bringing-conversational-ai-local-machine.html

图片来源:作者

在过去几个月里,大型语言模型(LLMs)受到了广泛关注,吸引了全球开发者的兴趣。这些模型创造了令人兴奋的前景,特别是对于从事聊天机器人、个人助手和内容创作的开发者。LLMs 带来的可能性在开发者 | AI | NLP 社区中引发了一波热情。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT

3. 谷歌 IT 支持专业证书 - 支持组织的 IT

什么是 LLM?

大型语言模型(LLMs)是指能够生成类似人类语言的文本并以自然方式理解提示的机器学习模型。这些模型通过使用包含书籍、文章、网站和其他来源的大型数据集进行训练。通过分析数据中的统计模式,LLMs 预测最可能跟随给定输入的词或短语。

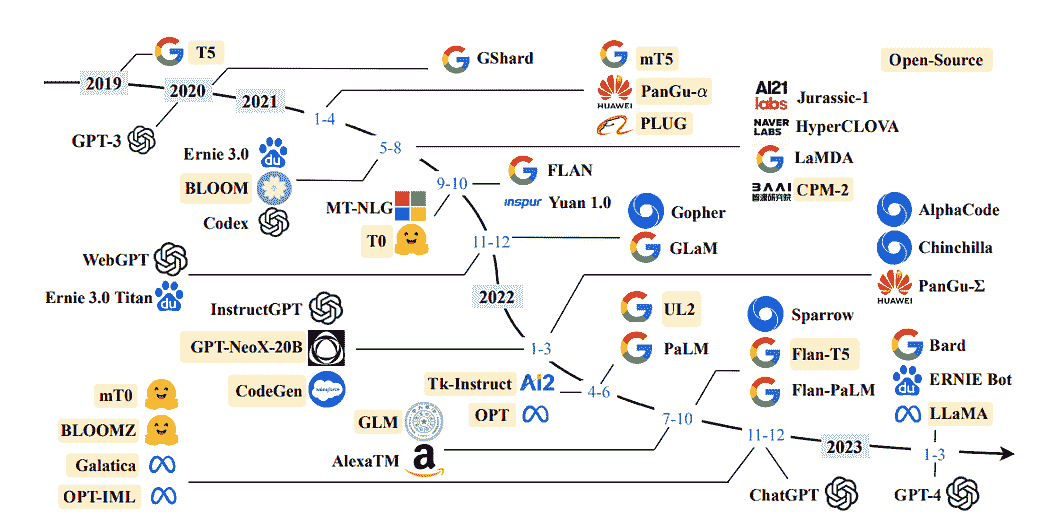

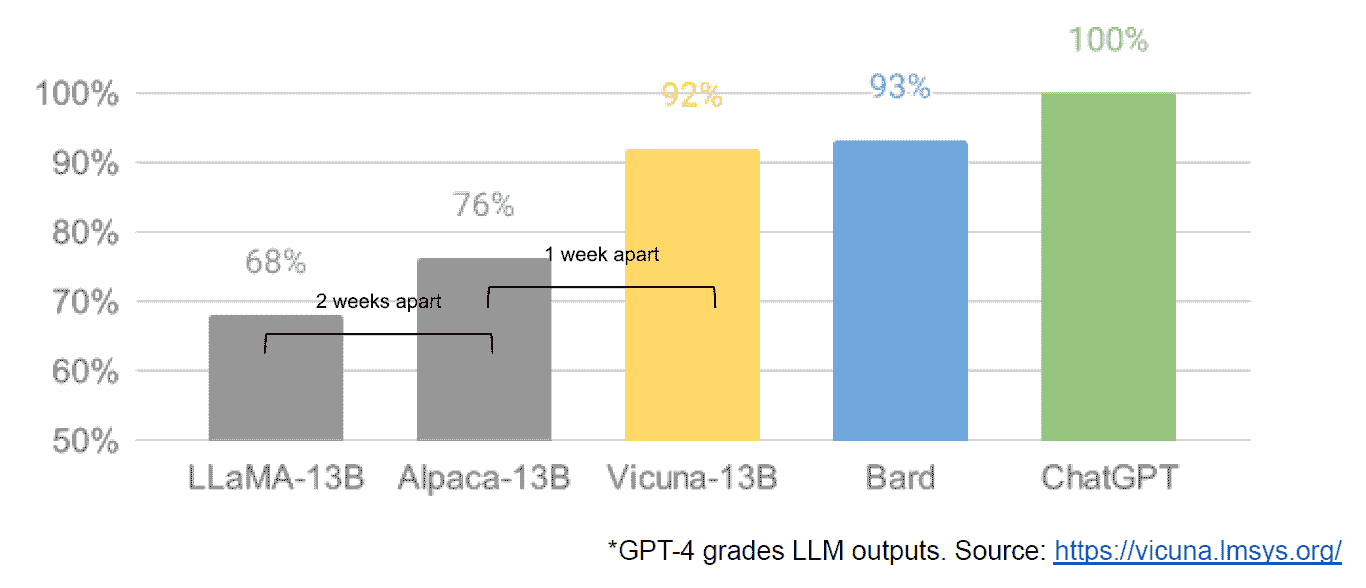

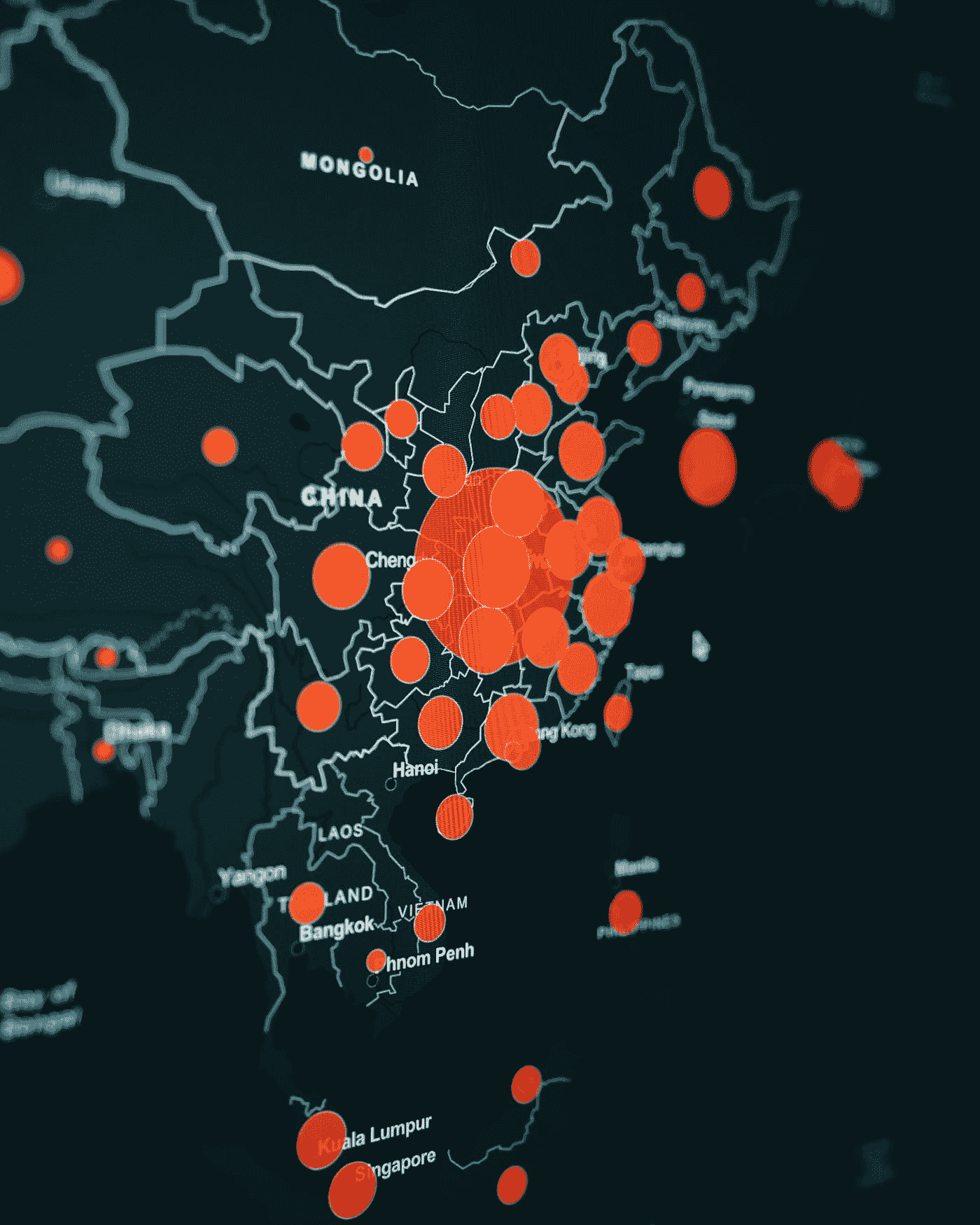

近几年 LLM 的时间轴:大型语言模型的调研

通过利用大型语言模型(LLMs),我们可以整合特定领域的数据以有效回答查询。这在处理模型初次训练时未能访问的信息时尤为有利,例如公司的内部文档或知识库。

为此目的采用的架构被称为 检索增强生成,或较少见的 生成性问答。

什么是 LangChain

LangChain 是一个令人印象深刻且免费提供的框架,精心设计用于帮助开发者创建以语言模型,特别是大型语言模型(LLMs)的强大功能为基础的应用程序。

LangChain 彻底改变了各种应用程序的开发过程,包括聊天机器人、生成式问答(GQA)和总结。通过无缝地串联来自多个模块的组件,LangChain 实现了围绕 LLMs 的强大功能创建出色的应用程序。

了解更多:官方文档

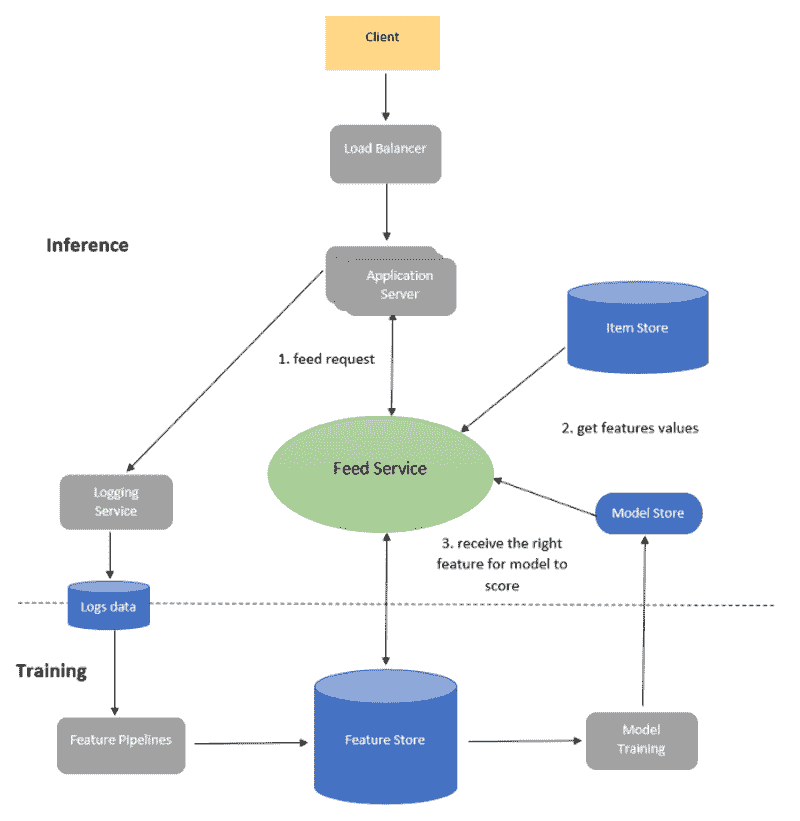

动机?

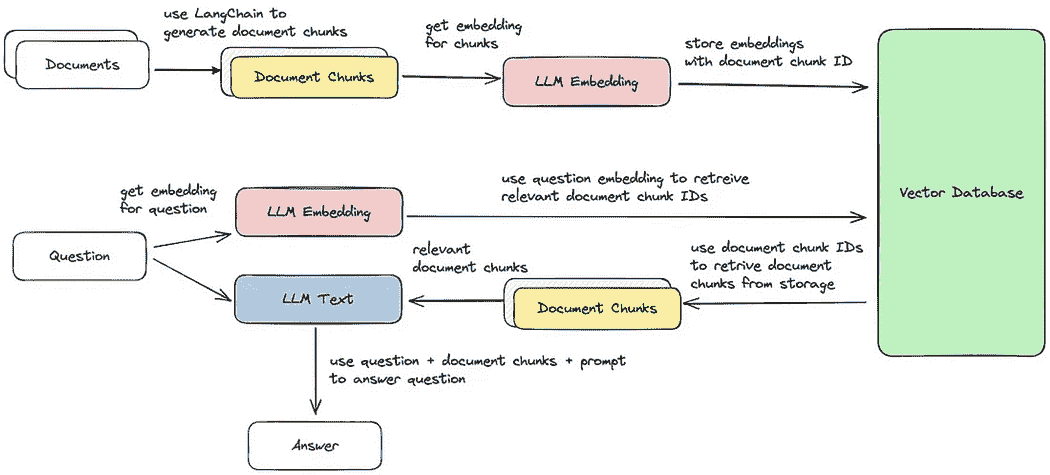

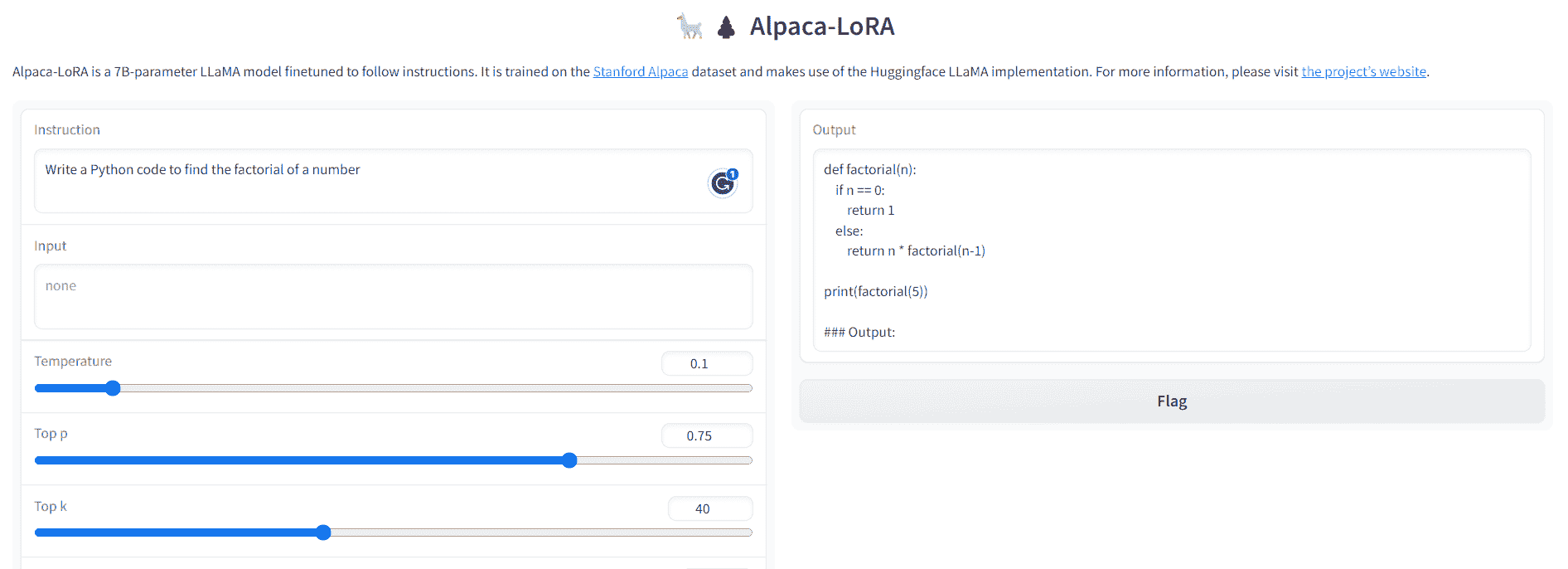

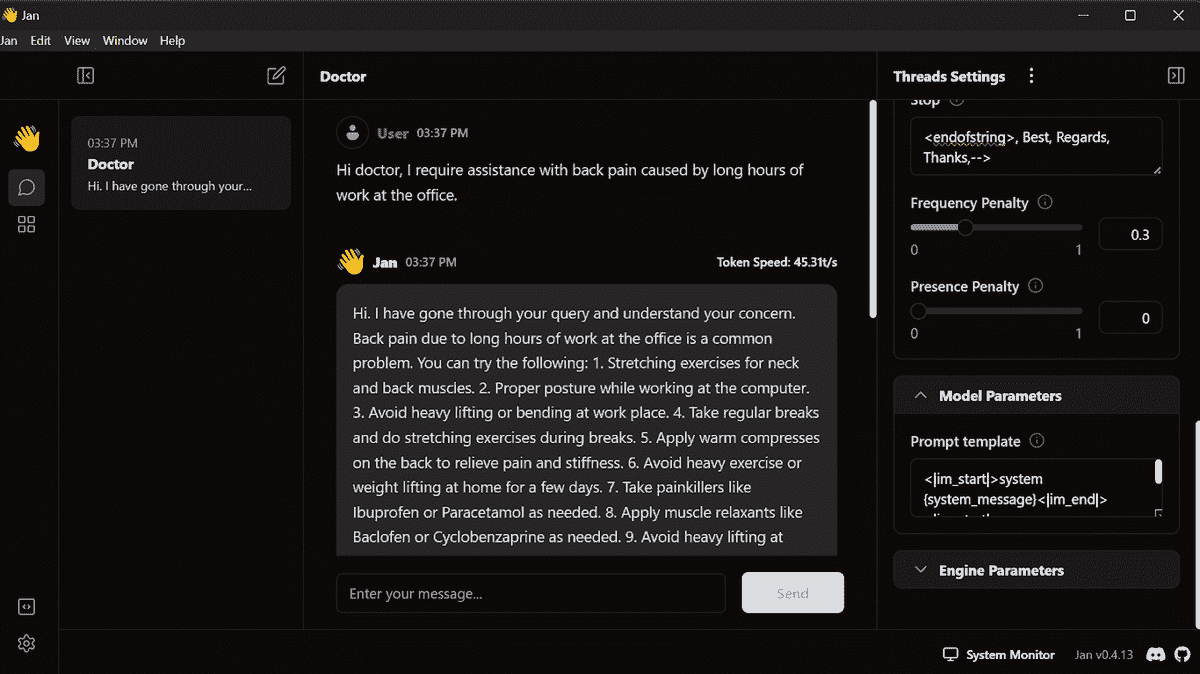

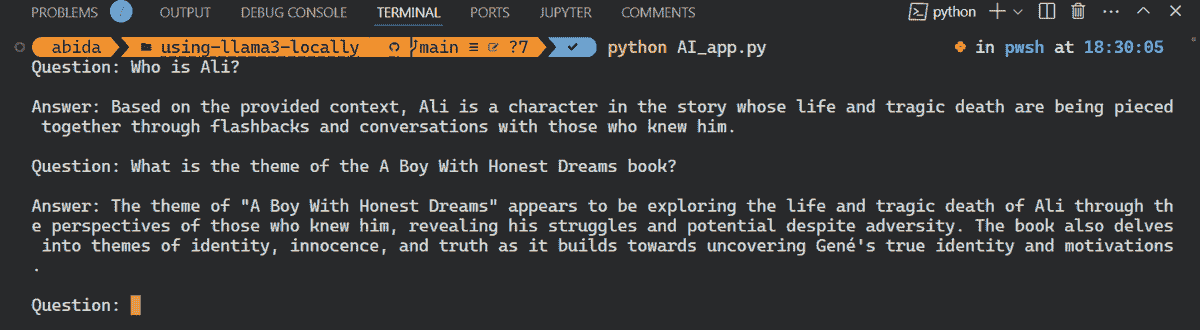

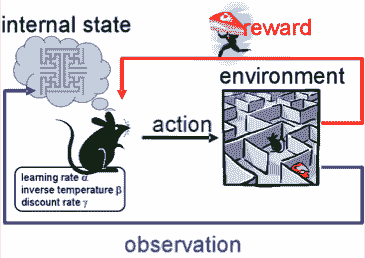

作者提供的图片

在这篇文章中,我将演示从头开始创建自己的文档助手的过程,利用 LLaMA 7b 和 Langchain,这是一个专为与 LLMs 无缝集成而开发的开源库。

下面是博客结构的概述,概述了将详细说明过程的特定部分:

-

**设置虚拟环境和创建文件结构** -

**将 LLM 安装到本地机器上** -

**将 LLM 与 LangChain 集成并自定义 PromptTemplate** -

**文档检索和回答生成** -

**使用 Streamlit 构建应用程序**

第一部分:设置虚拟环境和创建文件结构

设置虚拟环境提供了一个受控且隔离的环境来运行应用程序,确保其依赖项与其他系统范围的包分开。这种方法简化了依赖项的管理,并有助于在不同环境中保持一致性。

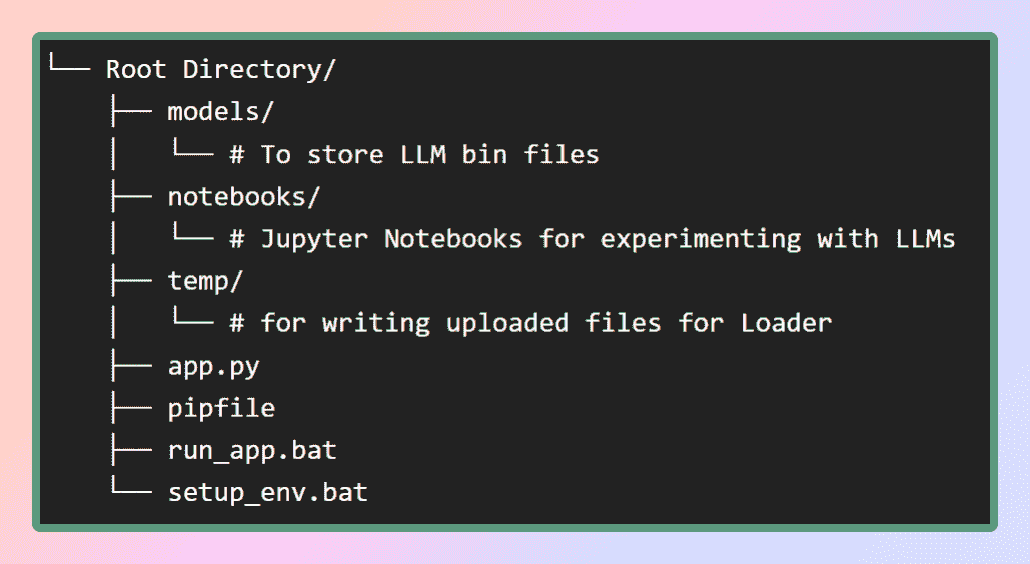

为了设置这个应用程序的虚拟环境,我将在我的 GitHub 仓库中提供 pip 文件。首先,让我们创建图中所示的必要文件结构。或者,你也可以直接克隆仓库以获取所需文件。

作者提供的图片:文件结构

在模型文件夹中,我们将存储下载的 LLMs,而 pip 文件将位于根目录中。

为了创建虚拟环境并安装其中的所有依赖项,我们可以使用 **pipenv install**命令,或者直接运行**setup_env.bat**批处理文件,它将从 **pipfile**中安装所有依赖项。这将确保在虚拟环境中安装所有必要的软件包和库。一旦依赖项成功安装,我们可以继续进行下一步,即下载所需的模型。这里是仓库。

第二部分:在本地机器上获取 LLaMA

什么是 LLaMA?

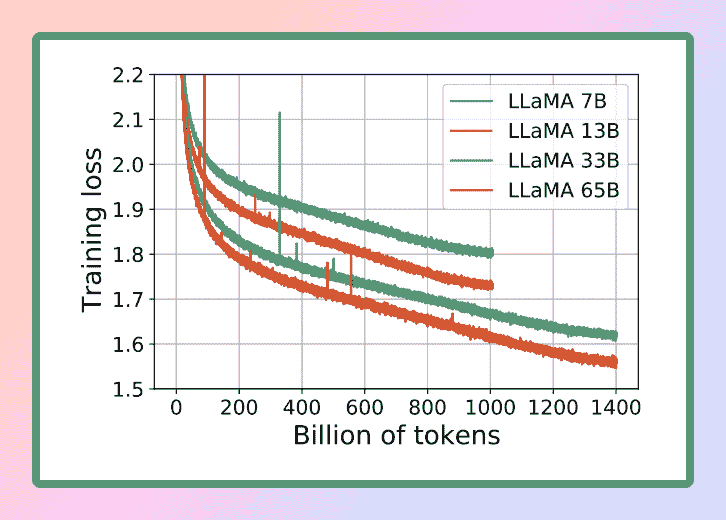

LLaMA 是 Meta AI 设计的新型大型语言模型,Meta 是 Facebook 的母公司。LLaMA 拥有从 70 亿到 650 亿参数的多种模型,是现有的最全面的语言模型之一。2023 年 2 月 24 日,Meta 将 LLaMA 模型公开发布,展示了其对开放科学的承诺。

图片来源: LLaMA

考虑到 LLaMA 的卓越能力,我们选择使用这个强大的语言模型来满足我们的需求。具体来说,我们将使用 LLaMA 的最小版本,即 LLaMA 7B。即便在这个较小的规模下,LLaMA 7B 仍提供显著的语言处理能力,使我们能够高效且有效地实现所需的结果。

**官方研究论文 : **

[**LLaMA: 开放且高效的基础语言模型**](https://research.facebook.com/publications/llama-open-and-efficient-foundation-language-models/)

要在本地 CPU 上运行 LLM,我们需要一个 GGML 格式的本地模型。有几种方法可以实现这一点,但最简单的方法是直接从Hugging Face 模型库下载 bin 文件。在我们的案例中,我们将下载 Llama 7B 模型。这些模型是开源的,可以自由下载。

如果你想节省时间和精力,不用担心——我已经为你准备好了。这里是直接下载模型的链接?。只需下载任何一个版本,然后将文件移动到我们根目录中的 models 目录下。这样,你就能方便地使用这个模型。

什么是 GGML?为什么选择 GGML?如何使用 GGML?LLaMA CPP

GGML 是一个用于机器学习的 Tensor 库,它只是一个 C++库,允许你在 CPU 或 CPU+GPU 上运行 LLMs。它定义了一种用于分发大型语言模型(LLMs)的二进制格式。GGML 利用了一种叫做量化的技术,使大型语言模型可以在消费者硬件上运行。

那么,什么是量化?

LLM 的权重是浮点(十进制)数字。就像表示一个大整数(例如 1000)比表示一个小整数(例如 1)需要更多空间一样,表示一个高精度浮点数(例如 0.0001)也比表示一个低精度浮点数(例如 0.1)需要更多空间。对大型语言模型进行量化的过程涉及减少权重表示的精度,以减少使用模型所需的资源。GGML 支持多种量化策略(例如 4-bit、5-bit 和 8-bit 量化),每种策略在效率和性能之间提供了不同的权衡。

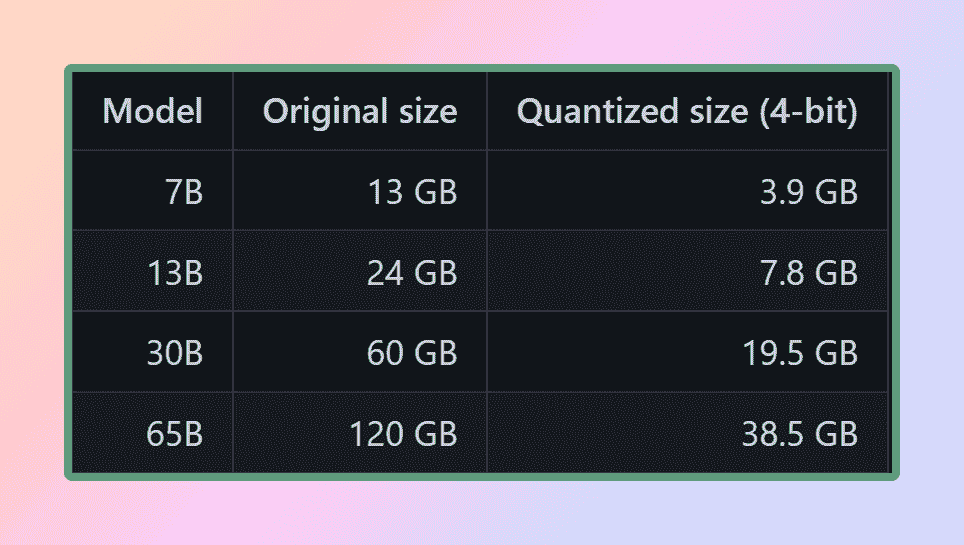

Llama 的量化大小

为了有效使用模型,考虑内存和磁盘需求是至关重要的。由于模型当前完全加载到内存中,你需要足够的磁盘空间来存储它们,以及足够的 RAM 在执行期间加载它们。对于 65B 模型,即使经过量化,建议至少拥有 40 GB 的 RAM。值得注意的是,目前的内存和磁盘要求是相等的。

量化在管理这些资源需求中起着关键作用。除非你有非常强大的计算资源

通过减少模型参数的精度和优化内存使用,量化使得模型可以在更低配置的硬件上使用。这确保了在更广泛的设置中运行模型仍然可行和高效。

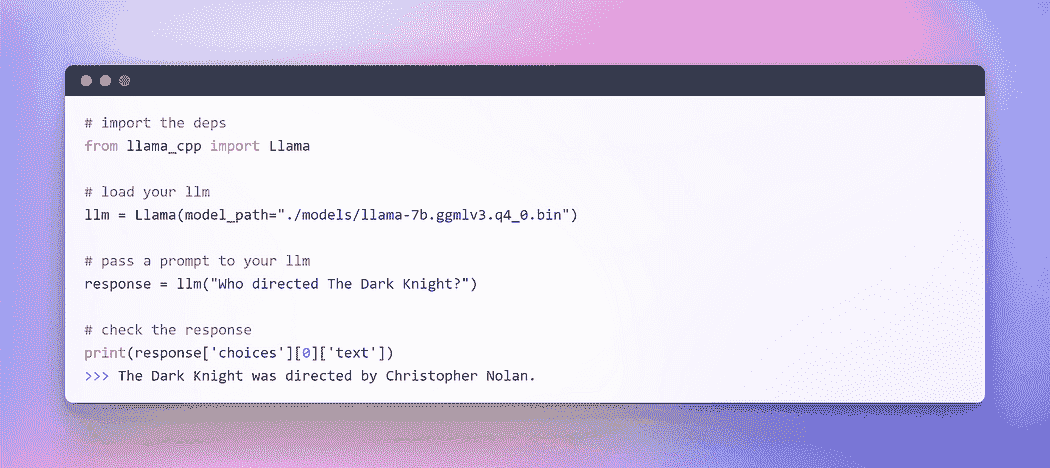

如果这是一个 C++ 库,我们如何在 Python 中使用它?

这时 Python 绑定就派上用场了。绑定指的是为我们 Python 和 C++ 之间创建桥梁或接口的过程。我们将使用 **llama-cpp-python**,这是 **llama.cpp** 的 Python 绑定,充当 LLaMA 模型在纯 C/C++ 中的推理。**llama.cpp** 的主要目标是使用 4 位整数量化运行 LLaMA 模型。这种集成允许我们有效地利用 LLaMA 模型,结合 C/C++ 实现的优势和 4 位整数量化的好处。

llama.cpp 支持的模型: 来源

准备好 GGML 模型并且所有依赖项到位(感谢 pipfile)之后,是时候开始我们的 LangChain 之旅了。但在深入 LangChain 的精彩世界之前,让我们先从惯例 “Hello World” 仪式开始 — 这是我们每次探索新语言或框架时遵循的传统,毕竟 LLM 也是一种语言模型。

作者提供的图片:在 CPU 上与 LLM 互动

瞧!!!我们已经成功在 CPU 上执行了第一个 LLM,完全离线并以完全随机的方式(你可以调整超参数 temperature)。

随着这个激动人心的里程碑的完成,我们现在准备开始我们的主要目标:使用 LangChain 框架对自定义文本进行问答。

第三部分:开始使用 LLM — LangChain 集成

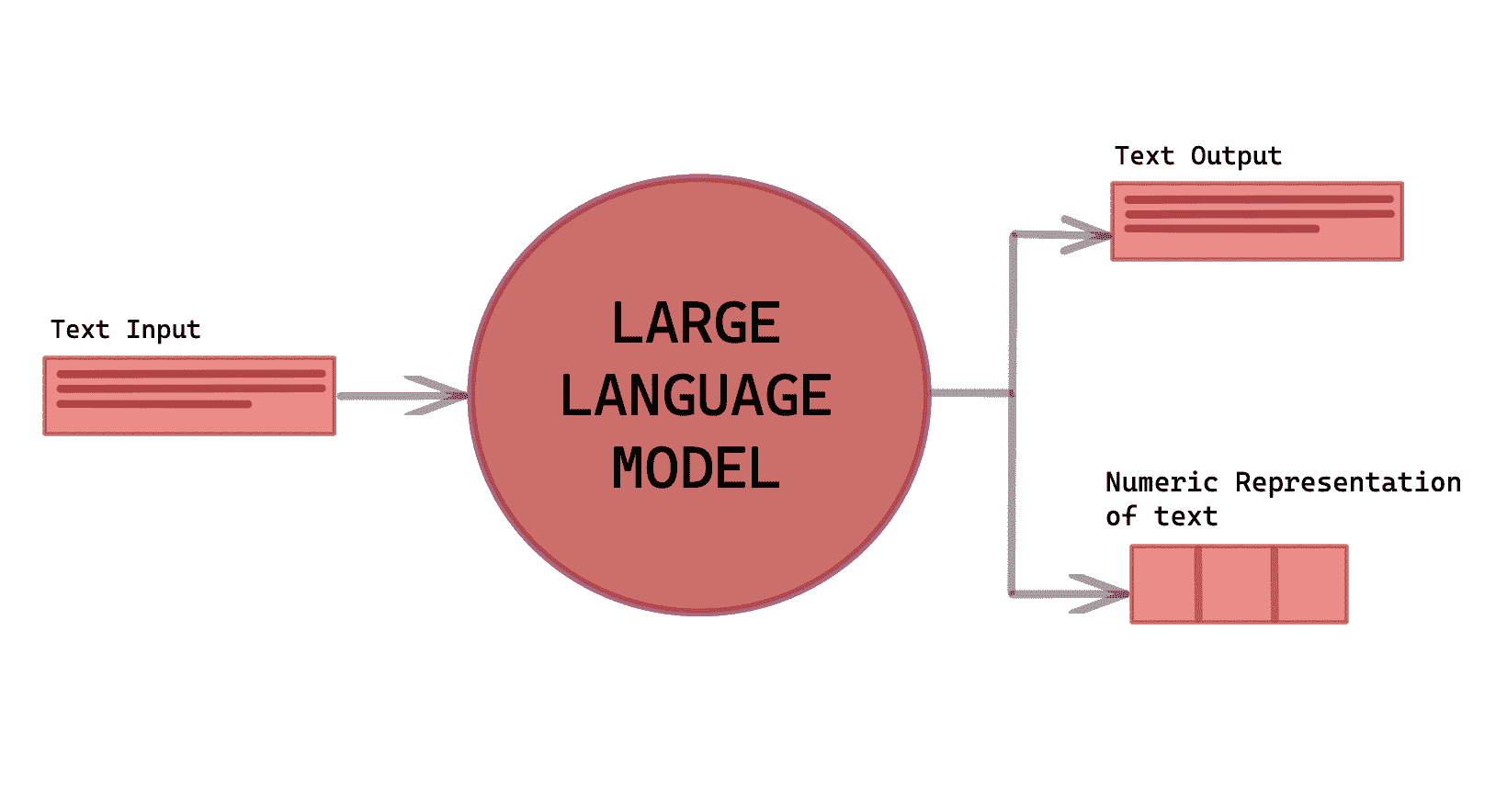

在上一节中,我们使用 llama cpp 初始化了 LLM。现在,让我们利用 LangChain 框架来开发基于 LLM 的应用程序。你与它们互动的主要接口是通过文本。简而言之,许多模型是文本输入,文本输出。因此,LangChain 中的许多接口都是围绕文本展开的。

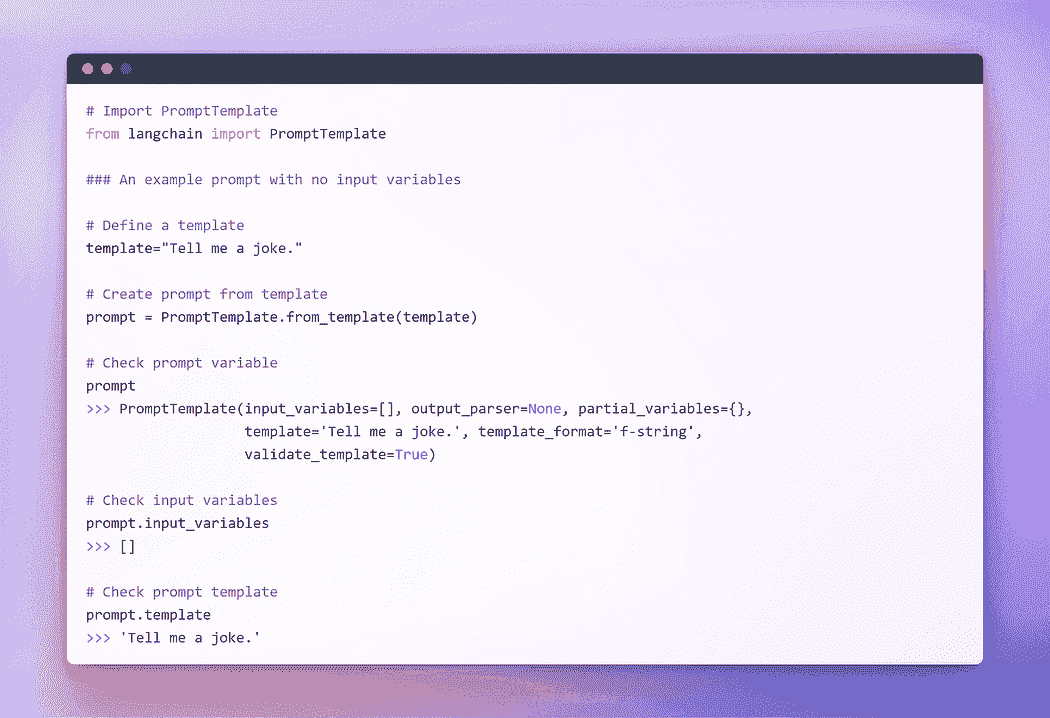

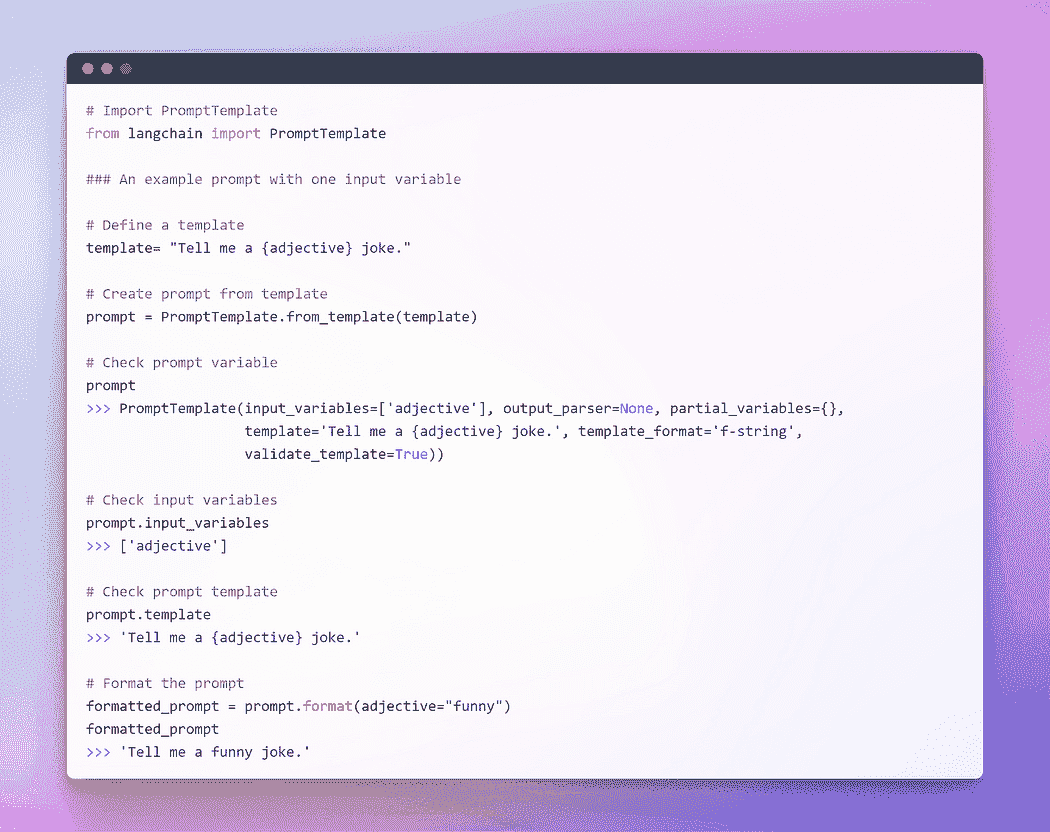

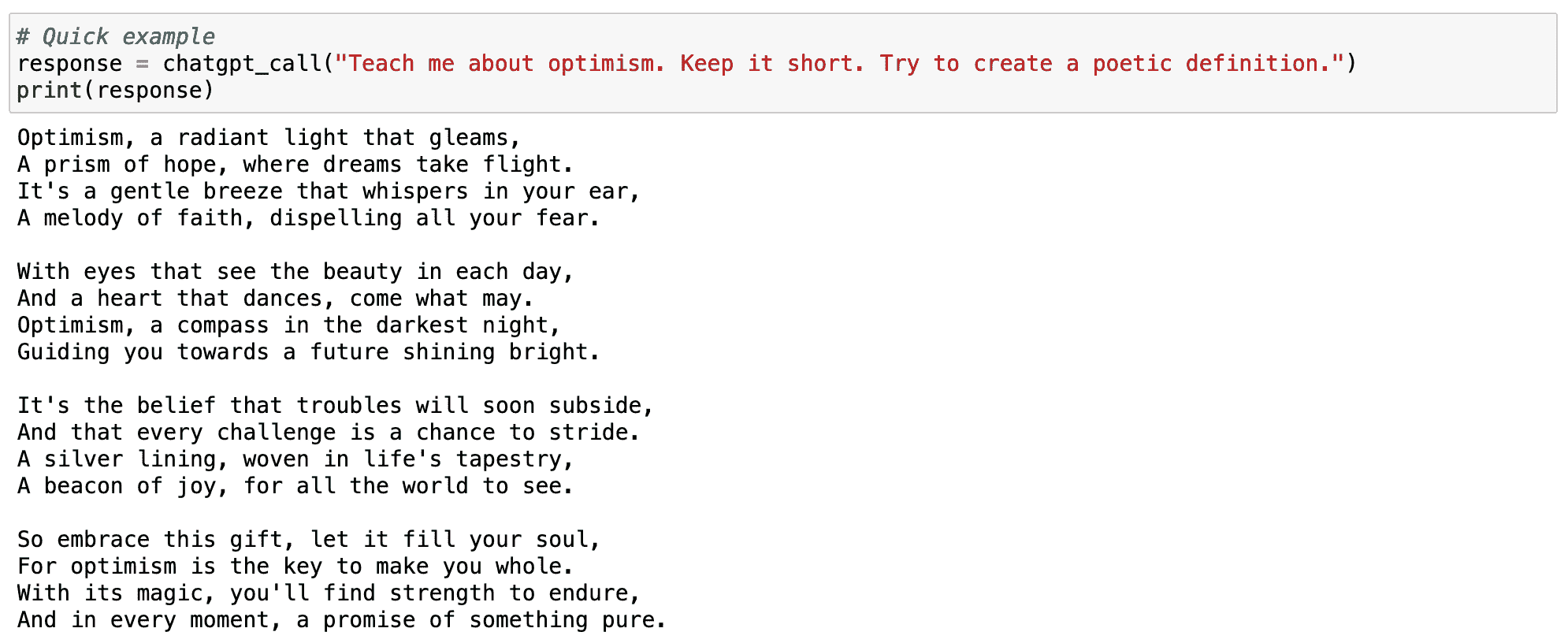

提示工程的兴起

在不断发展的编程领域中,一个引人入胜的范式已经出现:提示。提示涉及向语言模型提供特定输入以引出期望的回应。这种创新的方法允许我们根据提供的输入来塑造模型的输出。

我们措辞方式中的细微差别对模型回应的性质和内容产生显著影响,这一点非常值得注意。结果可能会根据措辞的不同而发生根本性的变化,这突显了在制定提示时需要仔细考虑的的重要性。

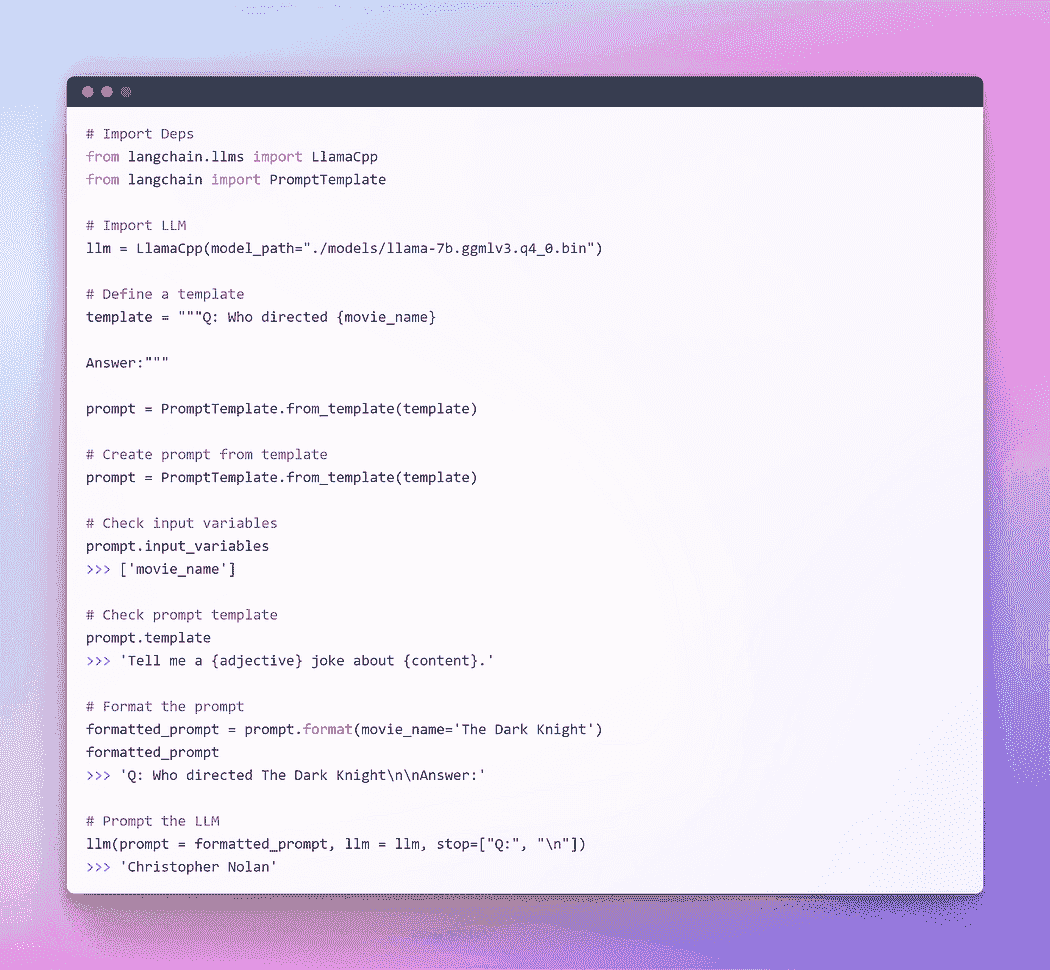

为了与 LLM 提供无缝互动,LangChain 提供了多个类和函数,通过使用提示模板,使构造和处理提示变得简单。这是一种可重复的生成提示的方式。它包含一个文本字符串模板,可以接收来自最终用户的一组参数并生成提示。让我们看几个例子。

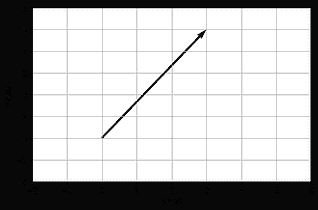

作者提供的图片:没有输入变量的提示

作者提供的图片:使用单一输入变量的提示

作者提供的图片:使用多个输入变量的提示

我希望之前的解释已经让你对提示的概念有了更清晰的理解。现在,让我们继续对 LLM 进行提示。

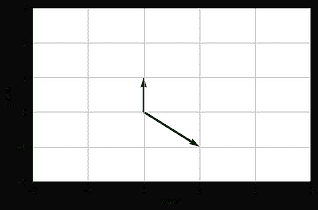

作者提供的图片:通过 Langchain LLM 进行提示

这种方法运行得很好,但这不是 LangChain 的最佳利用方式。到目前为止,我们使用了单独的组件。我们取了提示模板,格式化它,然后取了 llm,然后将这些参数传递给 llm 以生成答案。单独使用 LLM 对于简单应用程序来说是可以的,但更复杂的应用程序需要将 LLM 链接起来——无论是彼此之间,还是与其他组件之间。

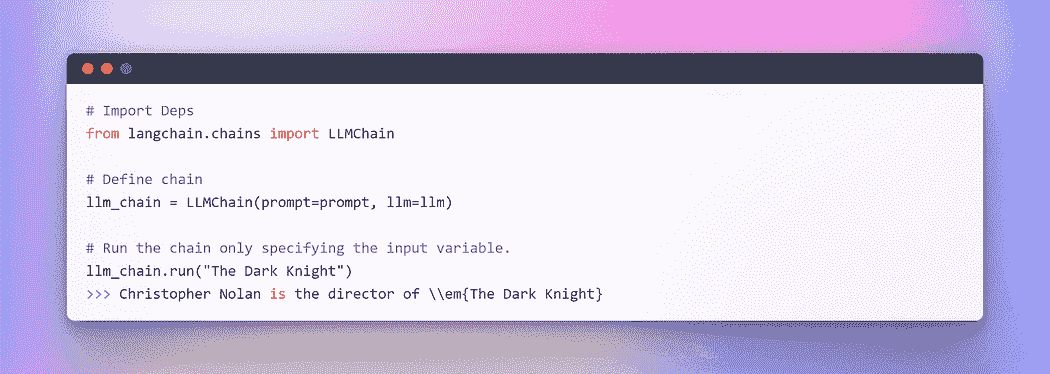

LangChain 提供了 Chain 接口用于此类链式应用。我们非常泛泛地定义 Chain 为一系列对组件的调用,这些组件可以包括其他链。链允许我们将多个组件组合在一起以创建一个单一的、连贯的应用。例如,我们可以创建一个链,它接受用户输入,用提示模板格式化输入,然后将格式化后的响应传递给 LLM。我们可以通过将多个链组合在一起,或将链与其他组件组合来构建更复杂的链。

为了理解其中一个,让我们创建一个非常简单的链,它将接受用户输入,用它格式化提示,然后使用我们已经创建的上述单独组件将其发送给 LLM。

作者提供的图像:LangChain 中的链式操作

在处理多个变量时,你可以选择通过使用字典来集体输入它们。到此为止,这一部分结束了。现在,让我们深入到主要部分,我们将结合外部文本作为检索器来进行问答。

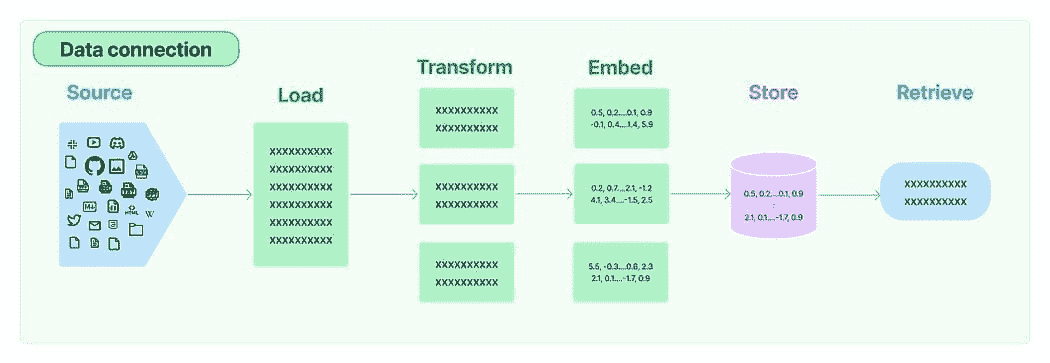

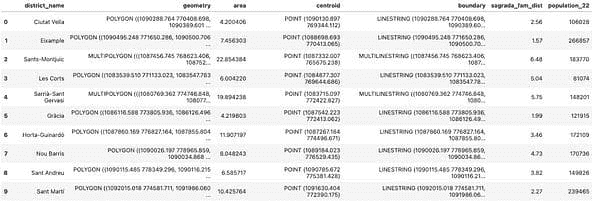

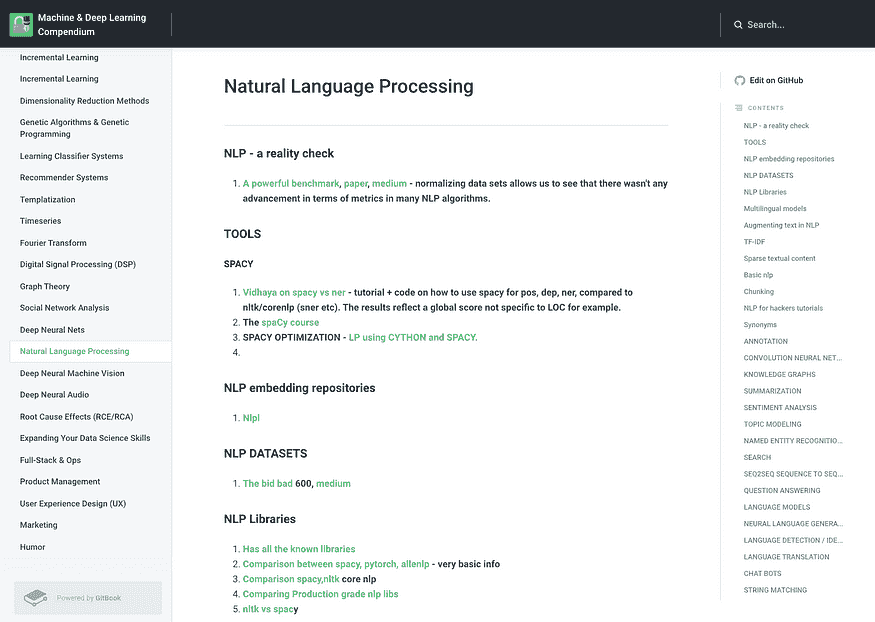

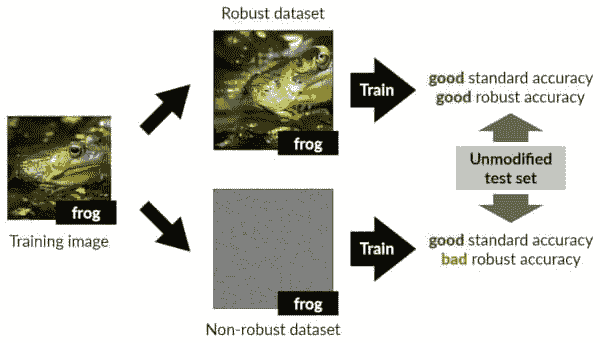

第四节:为问答生成嵌入和向量存储

在众多 LLM 应用中,需要用户特定的数据,这些数据未包含在模型的训练集中。LangChain 为你提供了加载、转换、存储和查询数据的基本组件。

LangChain 中的数据连接:来源

五个阶段是:

-

文档加载器: 用于将数据加载为文档。

-

文档转换器: 它将文档拆分为较小的块。

-

嵌入: 它将块转换为向量表示,即嵌入。

-

向量存储: 用于在向量数据库中存储上述块向量。

-

检索器: 它用于检索与查询最相似的一组/组向量,这些向量以与查询嵌入在同一潜在空间中的向量形式存在。

文档检索/问答循环

现在,我们将逐步进行五个步骤,以检索与查询最相似的文档块。随后,我们可以基于检索到的向量块生成答案,如所提供的图像所示。

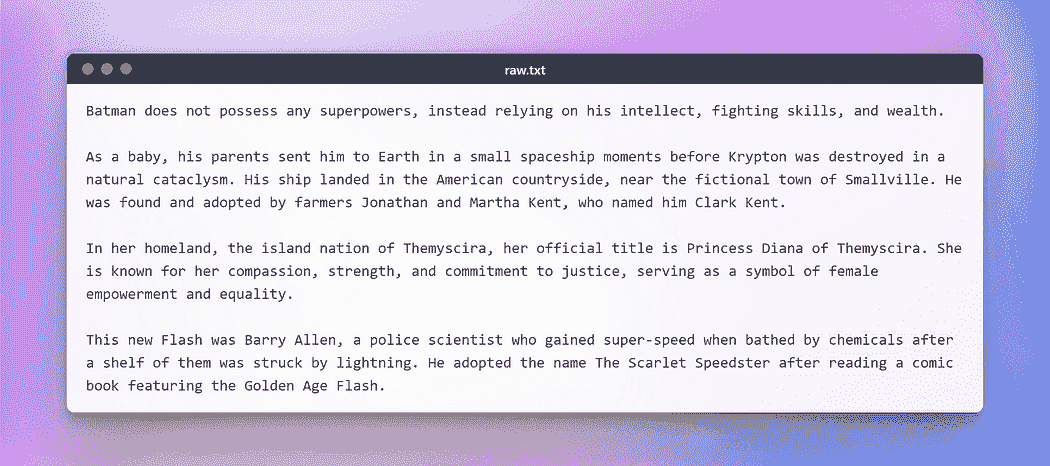

然而,在进一步进行之前,我们需要准备一个文本以执行上述任务。为了这个虚构的测试,我从维基百科复制了一段关于一些受欢迎的 DC 超级英雄的文本。以下是文本:

作者提供的图像:用于测试的原始文本

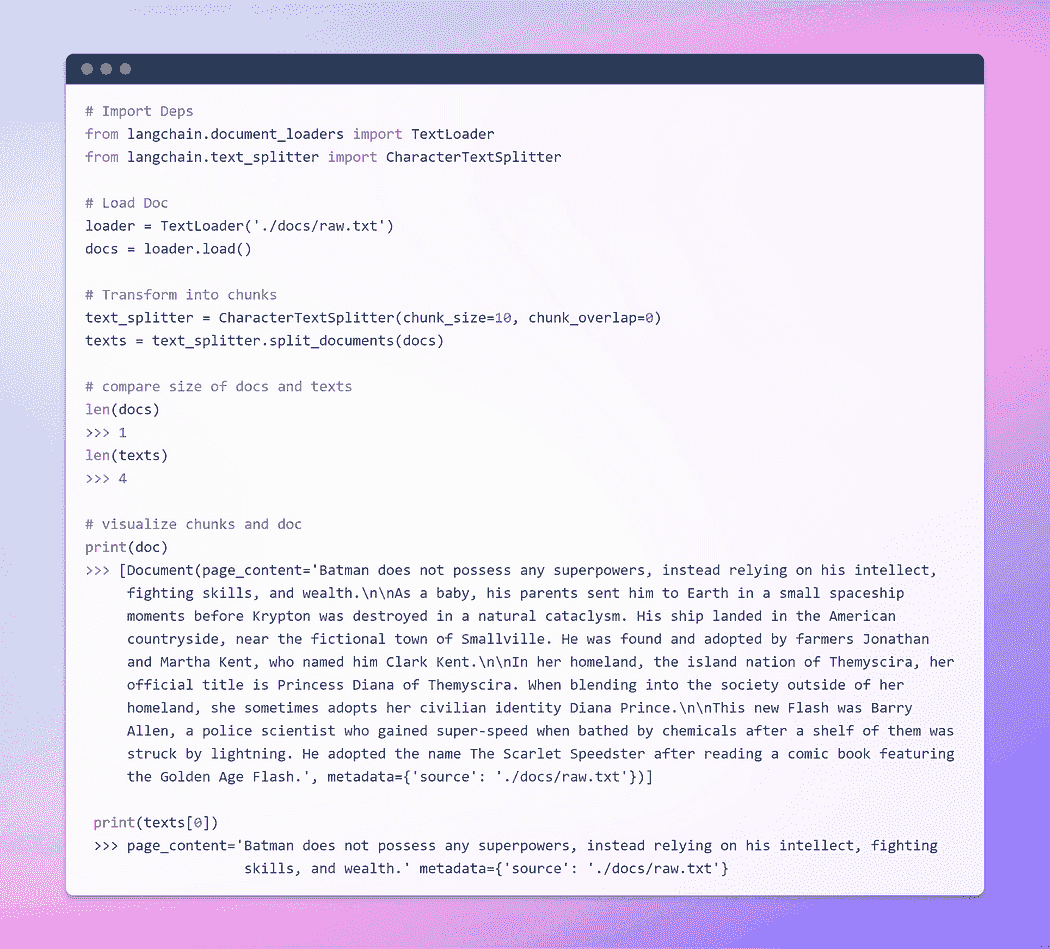

加载与转换文档

首先,让我们创建一个文档对象。在这个示例中,我们将使用文本加载器。然而,LangChain 支持多种文档,因此根据你的具体文档,你可以使用不同的加载器。接下来,我们将使用**load**方法从预配置的源中检索数据并将其加载为文档。

一旦文档被加载,我们可以通过将其分成较小的块来继续转换过程。为此,我们将使用 TextSplitter。默认情况下,分割器在‘\n\n’分隔符处分隔文档。然而,如果你将分隔符设置为 null 并定义特定的块大小,每个块将具有指定的长度。因此,结果列表的长度将等于文档的长度除以块大小。总之,它将类似于**list length = length of doc / chunk size**。让我们实践一下。

作者提供的图像:加载和转换文档

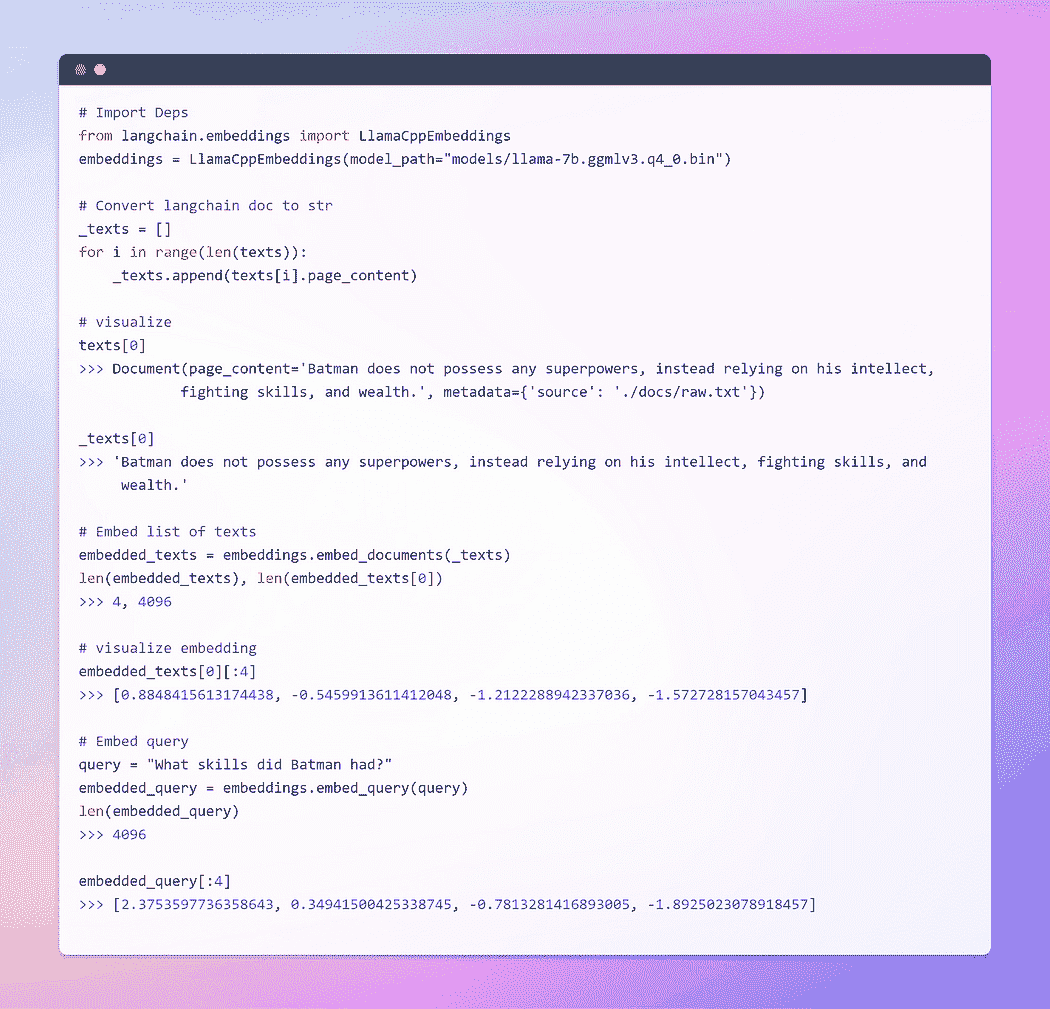

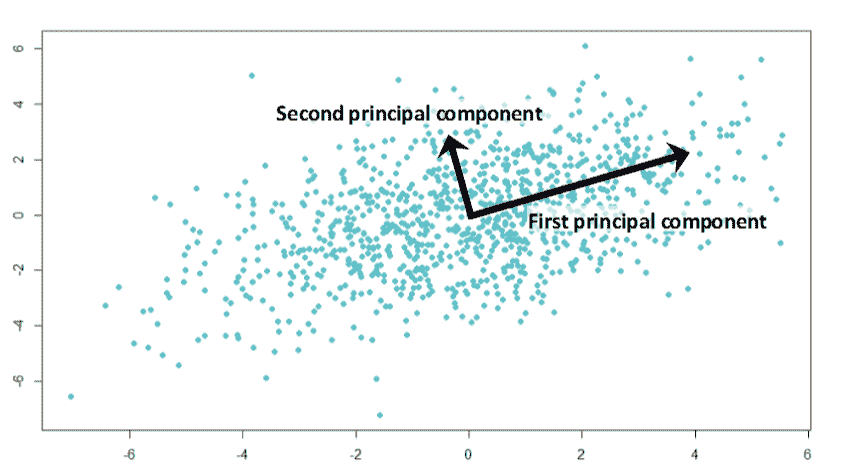

旅程的一部分就是嵌入 !!!

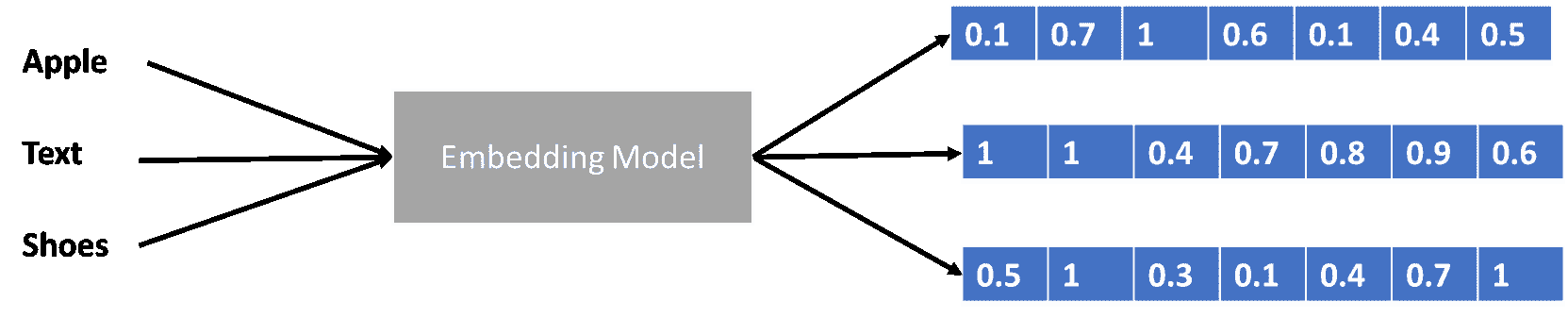

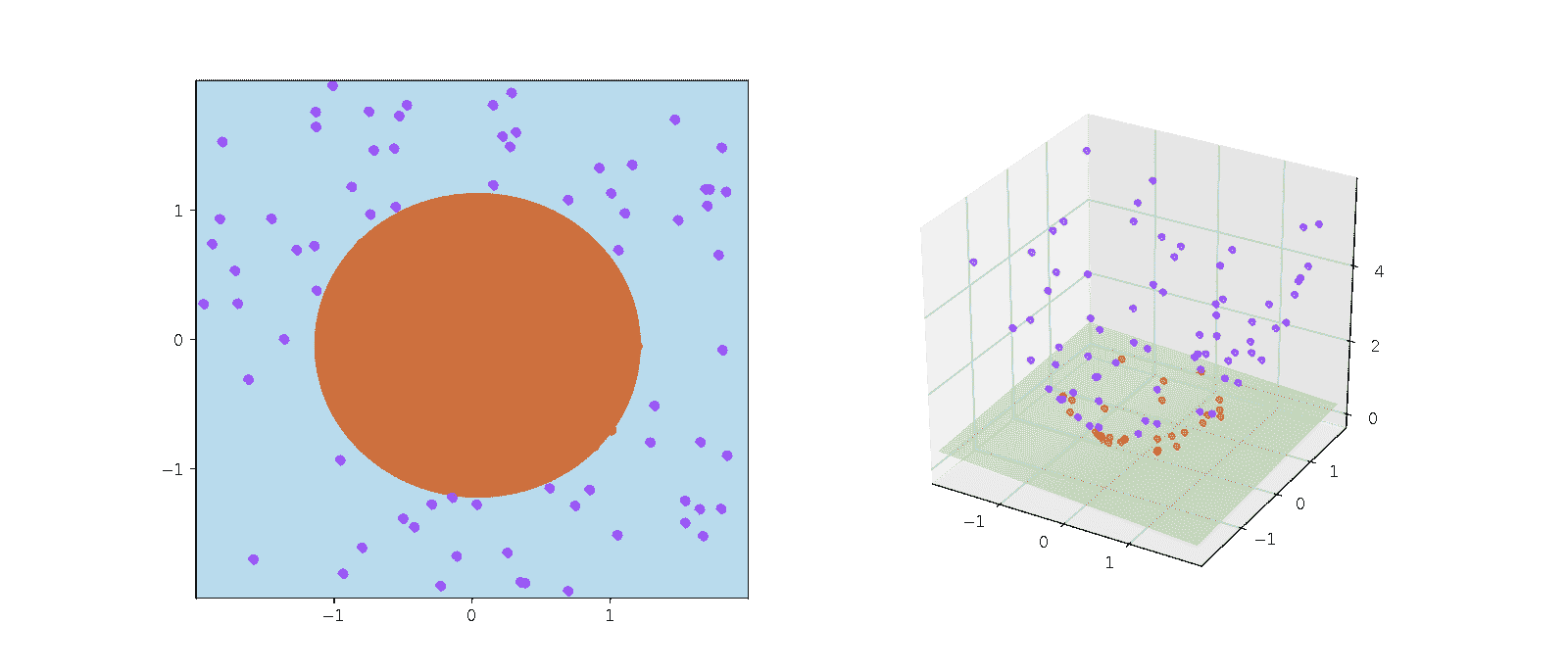

这是最重要的一步。嵌入生成了文本内容的向量化表现。这具有实际意义,因为它允许我们在向量空间中概念化文本。

词嵌入只是单词的向量表示,向量包含实数。由于语言通常包含至少数万词汇,简单的二进制词向量由于维度过高可能变得不切实际。词嵌入通过在低维向量空间中提供密集的词表示来解决这个问题。

当我们谈论检索时,我们指的是检索与查询最相似的一组向量,这些向量以嵌入在相同潜在空间中的形式存在。

LangChain 中的基础嵌入类暴露了两个方法:一个用于嵌入文档,另一个用于嵌入查询。前者接受多个文本作为输入,而后者接受单个文本。

作者提供的图像:嵌入

为了全面理解嵌入,我强烈建议深入了解基础知识,因为它们构成了神经网络处理文本数据的核心。我在我的一篇博客中广泛讨论了这个主题,使用了 TensorFlow。这里是链接。

词嵌入——神经网络的文本表示

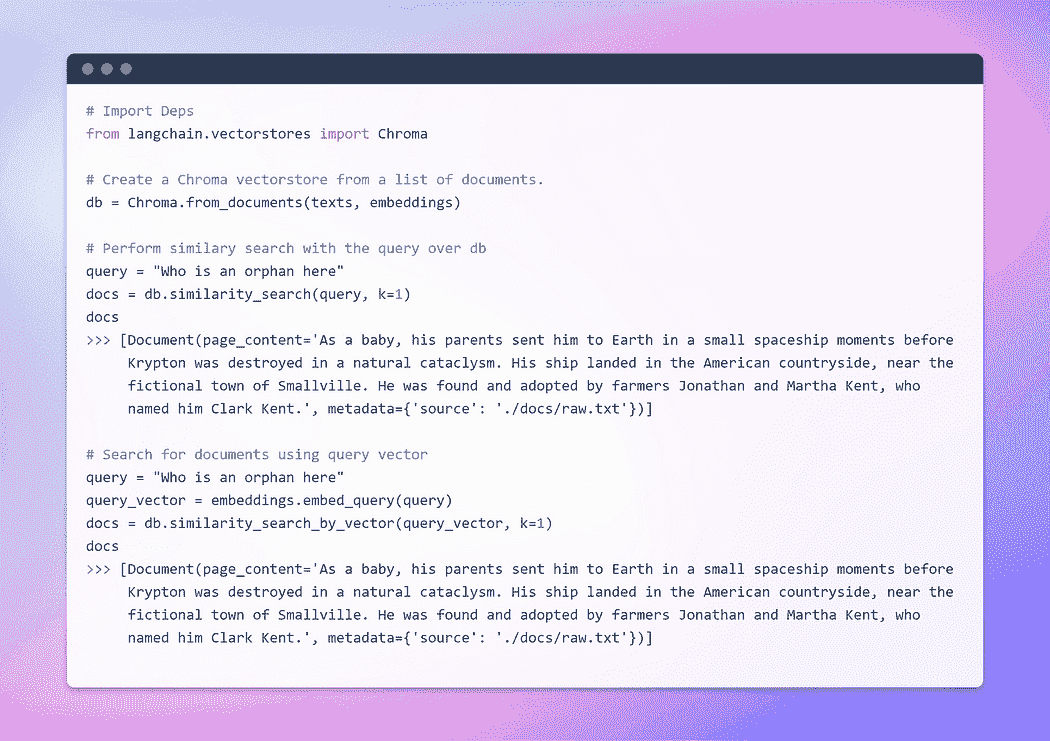

创建向量存储和检索文档

向量存储高效地管理嵌入数据的存储,并代表你执行向量搜索操作。嵌入和存储生成的嵌入向量是一种存储和搜索非结构化数据的常见方法。在查询时,非结构化查询也会被嵌入,并检索出与嵌入查询具有最高相似度的嵌入向量。这种方法能够有效地从向量存储中检索相关信息。

在这里,我们将使用 Chroma,一个专门为简化 AI 应用程序开发而设计的嵌入数据库和向量存储。它提供了一整套内置工具和功能来简化你的初始设置,所有这些都可以通过执行简单的**pip install chromadb**命令方便地安装在本地机器上。

图片由作者提供:创建向量存储

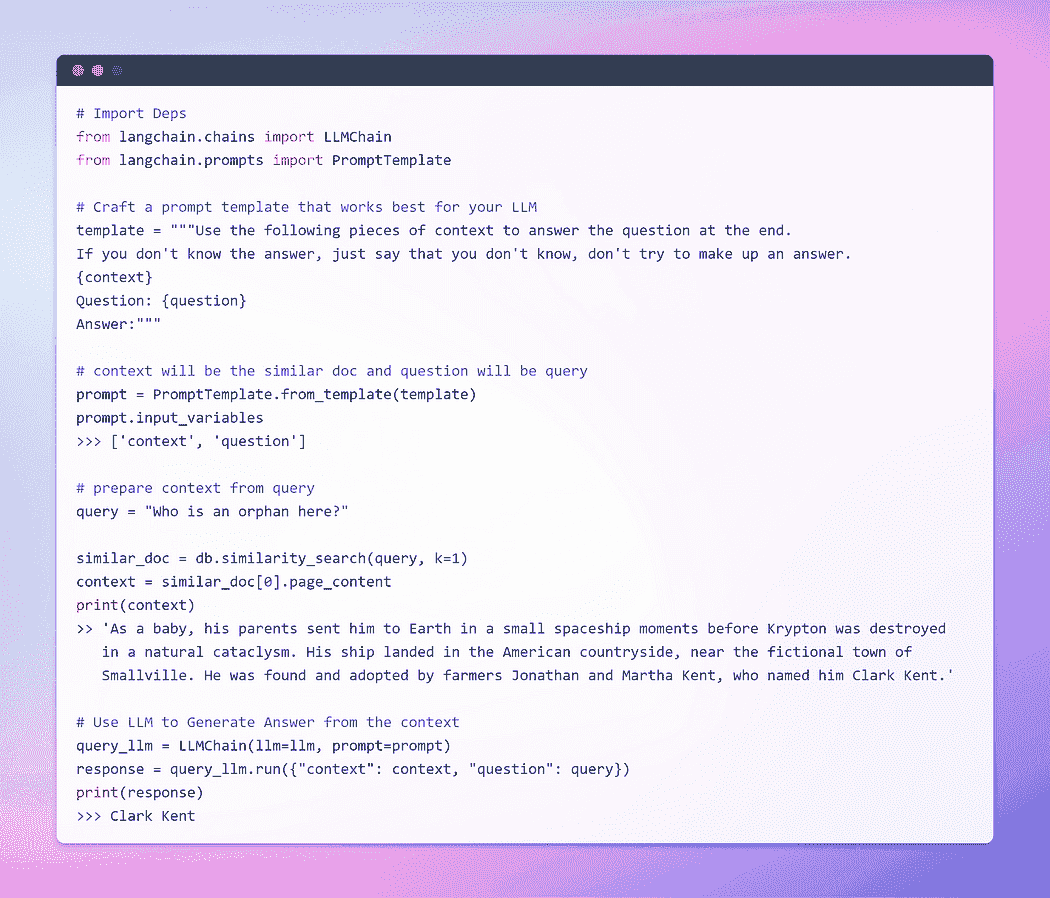

到目前为止,我们已经见证了嵌入和向量存储在从大量文档集合中检索相关片段方面的显著能力。现在,时机已到,我们将把这个检索到的片段与查询一起作为上下文呈现给 LLM。挥动它的魔法棒,我们将请求 LLM 基于我们提供的信息生成答案。关键在于提示结构。

然而,必须强调结构良好的提示的重要性。通过制定精心设计的提示,我们可以减轻 LLM 在面对不确定性时可能出现的幻觉——即它可能发明事实。

在不再拖延的情况下,让我们进入最后阶段,看看我们的 LLM 是否能够生成引人注目的答案。时刻来临,见证我们的努力成果并揭示结果吧。我们出发了?

图片由作者提供:与文档的问答

这是我们一直期待的时刻!我们成功了!我们刚刚构建了我们自己的问答机器人,利用本地运行的 LLM。

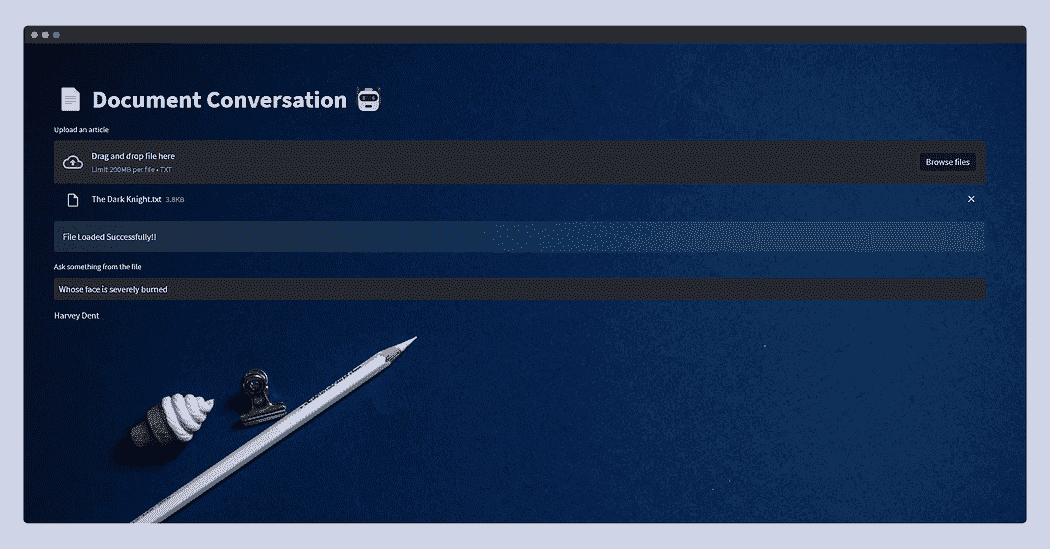

第五部分:使用 Streamlit 链式操作

这一部分完全是可选的,因为它并不是 Streamlit 的全面指南。我不会深入探讨这一部分;相反,我会展示一个基本应用,允许用户上传任何文本文件。然后,他们可以通过文本输入提问。幕后功能将与我们在上一部分中讨论的保持一致。

然而,在 Streamlit 中处理文件上传时有一个警告。为了防止潜在的内存不足错误,特别是考虑到 LLM 的内存密集型特性,我将简单地读取文档并将其写入我们文件结构中的临时文件夹,命名为**raw.txt.**。这样,无论文档的原始名称是什么,Textloader 将在未来无缝处理它。

目前,该应用程序设计用于文本文件,但你可以将其适应于 PDF、CSV 或其他格式。基本概念保持不变,因为 LLM 主要用于文本输入和输出。此外,你可以尝试不同的由 Llama C++ 绑定支持的 LLM。

不再深入复杂的细节,我提供了应用程序的代码。随意自定义以适应你的特定用例。

这是 streamlit 应用程序的外观。

这次我提供了从 Wiki 复制的《黑暗骑士》的情节,并仅仅问了“谁的脸被严重烧伤?”,LLM 回复了——哈维·丹特。

好了,好了,好了!至此,我们博客的内容就结束了。

希望你喜欢这篇文章!并觉得它既有信息量又有趣。你可以关注我Afaque Umer以获得更多此类文章。

我将尝试引入更多机器学习/数据科学概念,并尝试将复杂的术语和概念拆解成更简单的形式。

Afaque Umer 是一位充满激情的机器学习工程师。他喜欢利用最新技术解决新挑战,寻找高效的解决方案。让我们一起推动 AI 的边界!

原文。已获授权转载。

更多相关话题

大型语言模型在三个难度级别中的解释

原文:

www.kdnuggets.com/large-language-models-explained-in-3-levels-of-difficulty

我们生活在一个机器学习模型处于巅峰的时代。与几十年前相比,大多数人可能从未听说过 ChatGPT 或人工智能。然而,这些正是人们不断讨论的话题。为什么?因为它们所带来的价值与投入的努力相比是如此显著。

近年来,人工智能的突破可以归因于许多因素,但其中之一就是大型语言模型(LLM)。许多文本生成 AI 都依赖于 LLM 模型;例如,ChatGPT 使用的是他们的 GPT 模型。由于 LLM 是一个重要的话题,我们应该了解它。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

本文将讨论大型语言模型(LLM)的三个难度级别,但我们只会触及 LLM 的一些方面。我们将以一种使每位读者都能理解 LLM 是什么的方式进行讨论。考虑到这一点,我们开始吧。

第 1 级:LLM 初学者级别

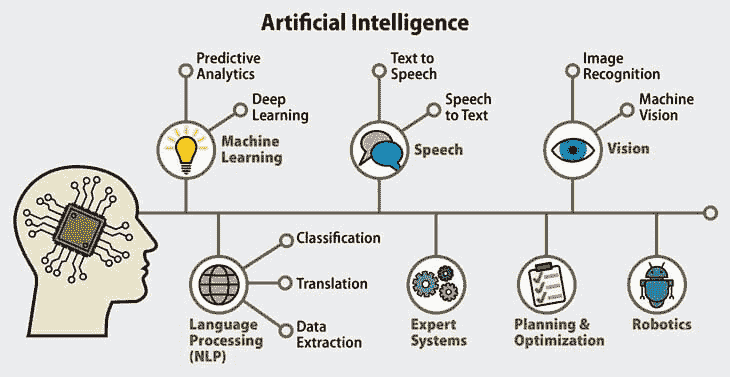

在第一个级别,我们假设读者对 LLM 不了解,并可能对数据科学/机器学习领域有所了解。因此,我将简要介绍人工智能和机器学习,然后再转到 LLM。

人工智能是开发智能计算机程序的科学。它旨在使程序能够执行人类可以做的智能任务,但不受人类生物需求的限制。机器学习是人工智能的一个领域,专注于利用统计算法进行数据泛化研究。从某种意义上说,机器学习通过数据研究来实现人工智能,使程序能够在没有指令的情况下执行智能任务。

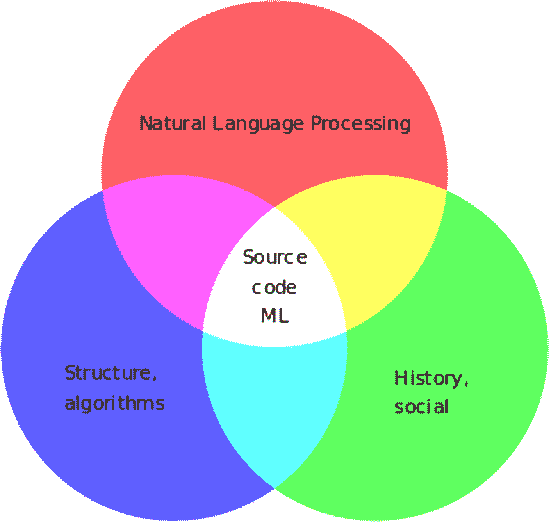

历史上,计算机科学和语言学交叉的领域称为自然语言处理领域。该领域主要涉及机器对人类文本(如文本文件)的处理活动。之前,该领域仅限于基于规则的系统,但随着先进的半监督和无监督算法的引入,该领域得到了扩展,使模型能够在没有任何指导的情况下学习。其中一个先进模型是语言模型。

语言模型是一个概率性 NLP 模型,用于执行许多类似翻译、语法纠正和文本生成的人类任务。旧形式的语言模型使用纯统计方法,如 n-gram 方法,其中假设下一个词的概率仅依赖于前一个词的固定大小数据。

然而,神经网络的引入已经取代了以前的方法。人工神经网络,或称 NN,是一种模拟人脑神经结构的计算机程序。神经网络方法之所以好用,是因为它可以处理复杂的模式识别和文本数据的序列数据。这就是为什么当前的语言模型通常基于 NN。

大型语言模型,或 LLMs,是通过从大量数据文档中学习来执行通用语言生成的机器学习模型。它们仍然是语言模型,但 NN 学到的大量参数使它们被认为是大型的。通俗来说,该模型通过从给定的输入词预测下一个词来非常好地模拟人类的写作方式。

LLM 任务的例子包括语言翻译、机器聊天机器人、问答等。从任何数据输入序列中,模型可以识别单词之间的关系,并生成符合指令的输出。

几乎所有声称使用文本生成的生成式 AI 产品都由 LLMs 驱动。像 ChatGPT、Google 的 Bard 等大型产品都以 LLMs 为基础。

第二级:LLM 中级水平

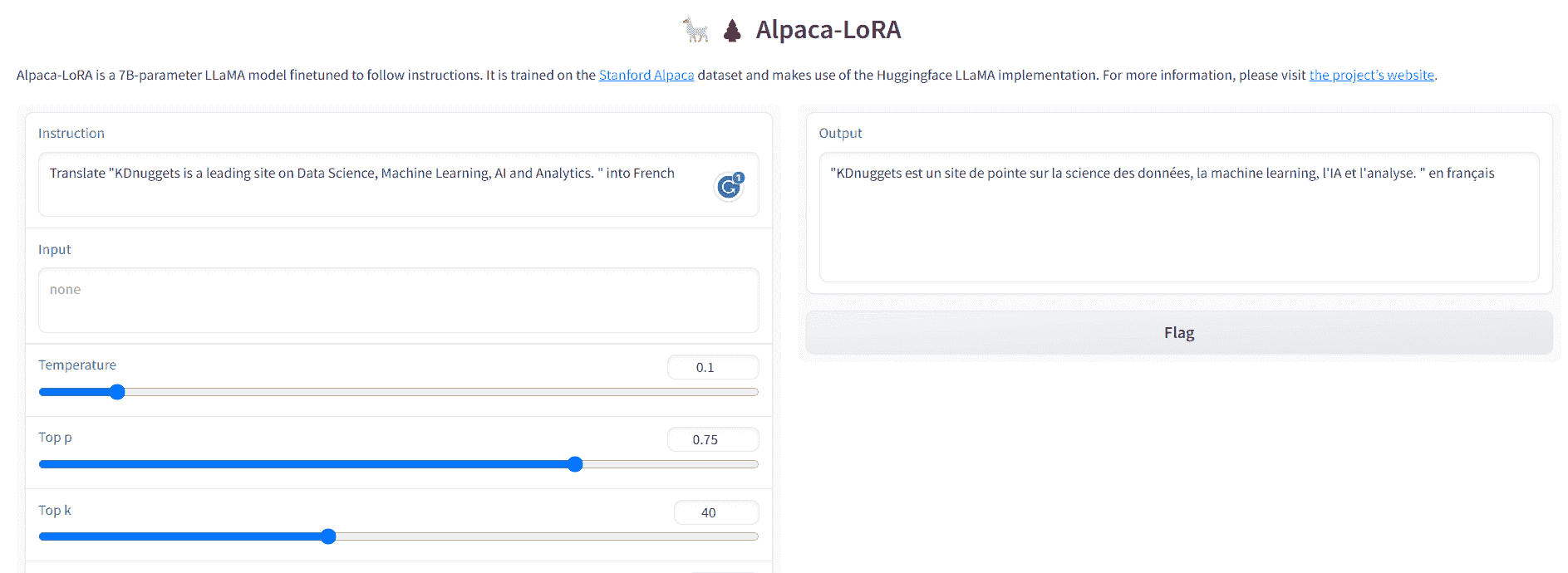

读者具有数据科学知识,但需要在此级别上进一步了解 LLM。至少,读者能够理解数据领域中使用的术语。在这个层面上,我们将更深入地探讨基础架构。

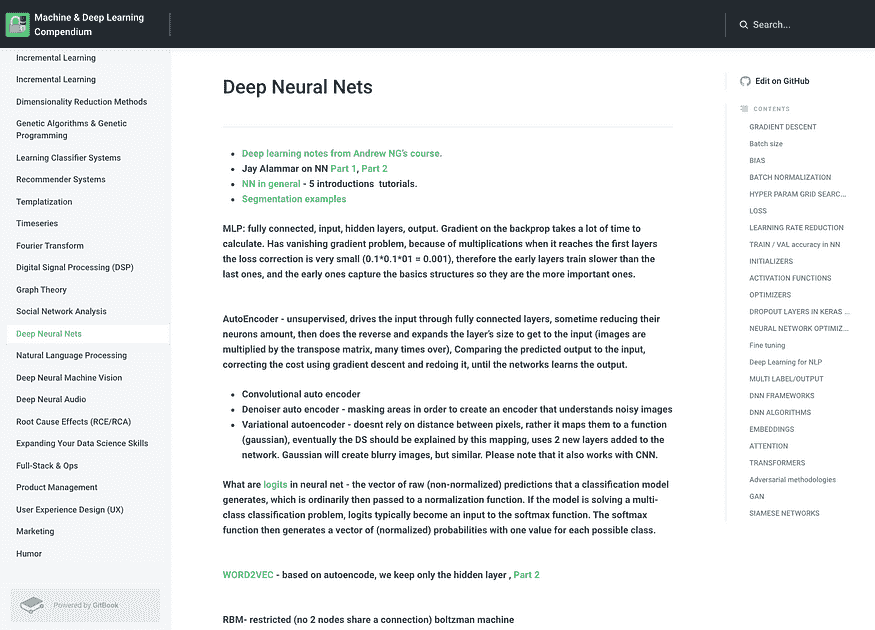

如前所述,LLM 是一个在大量文本数据上训练的神经网络模型。要进一步理解这一概念,了解神经网络和深度学习的工作原理将是有益的。

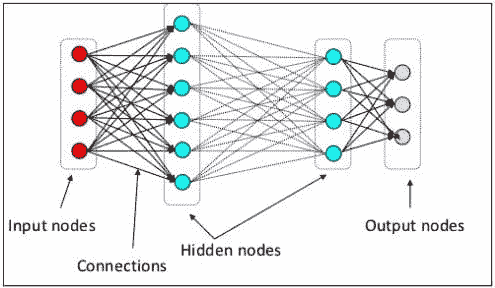

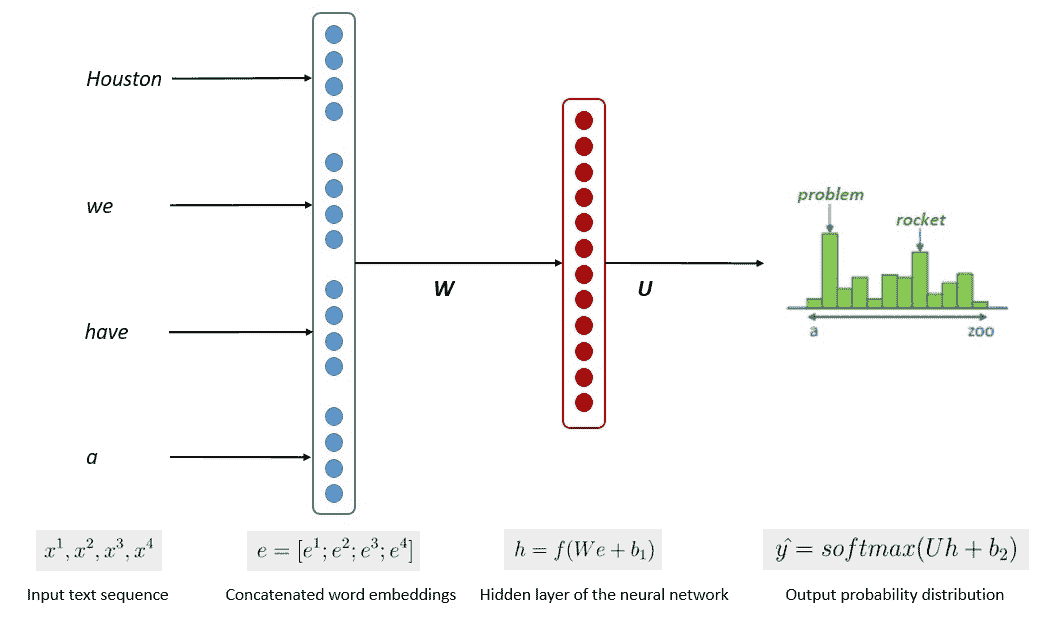

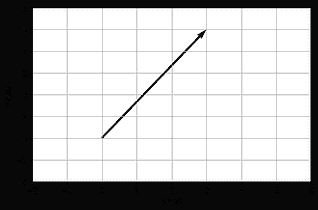

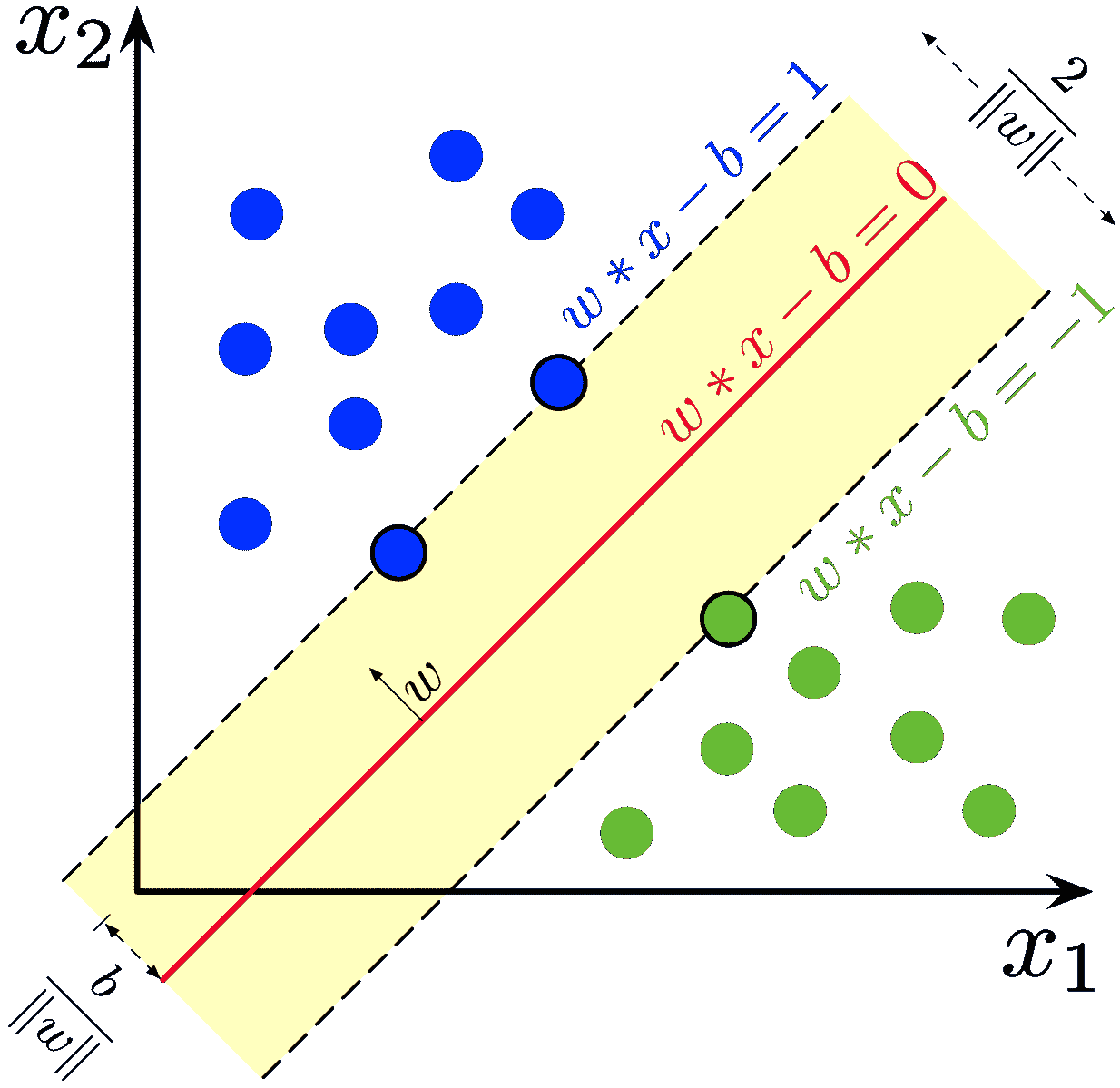

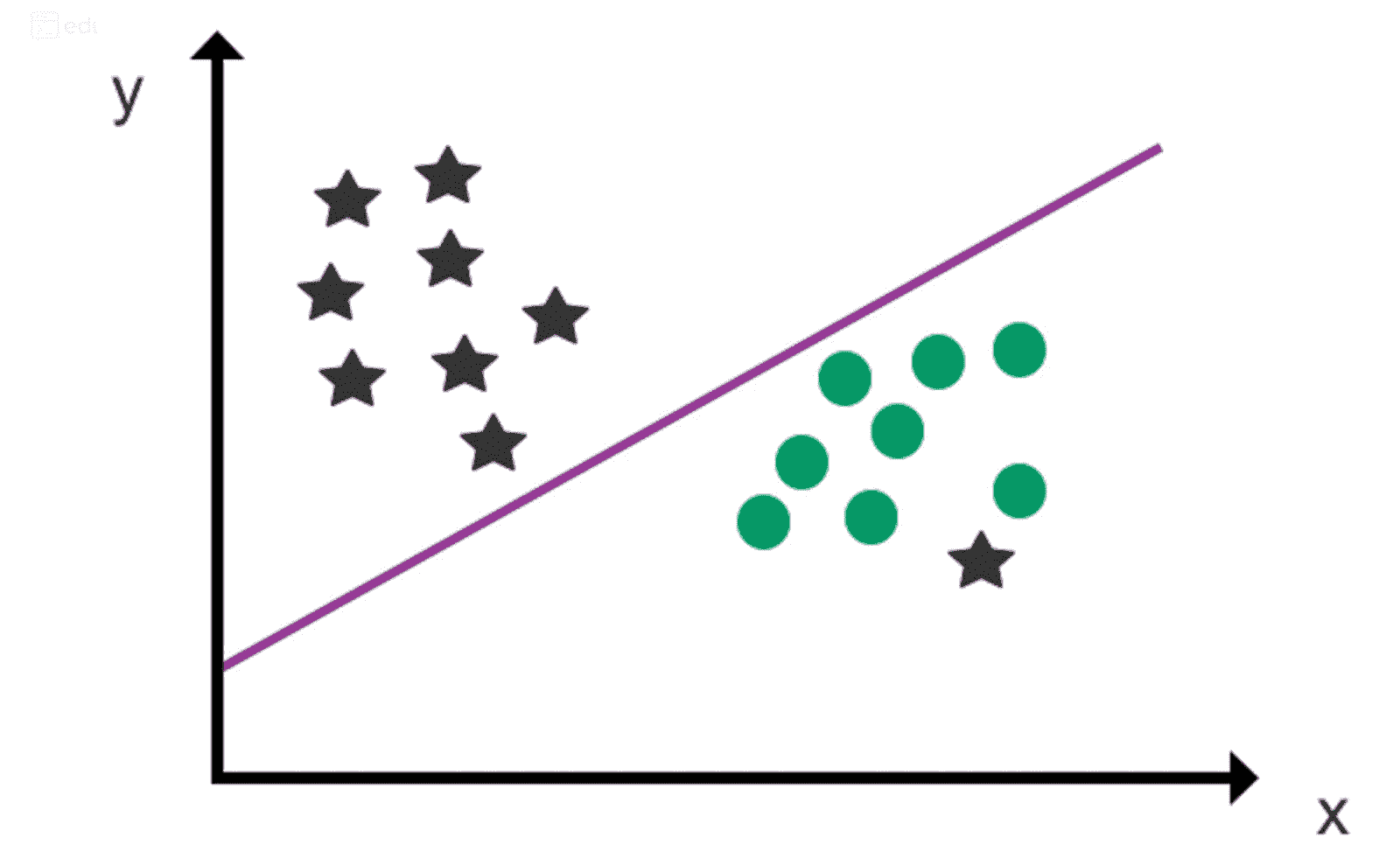

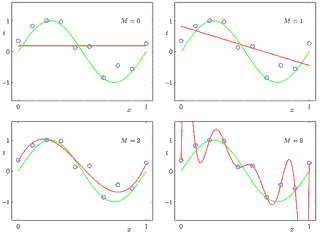

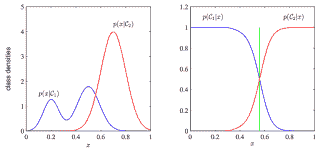

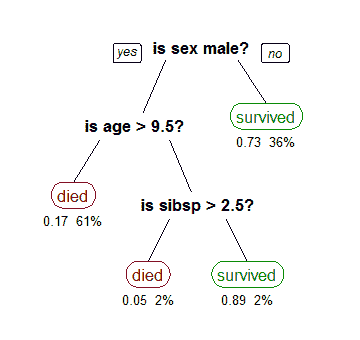

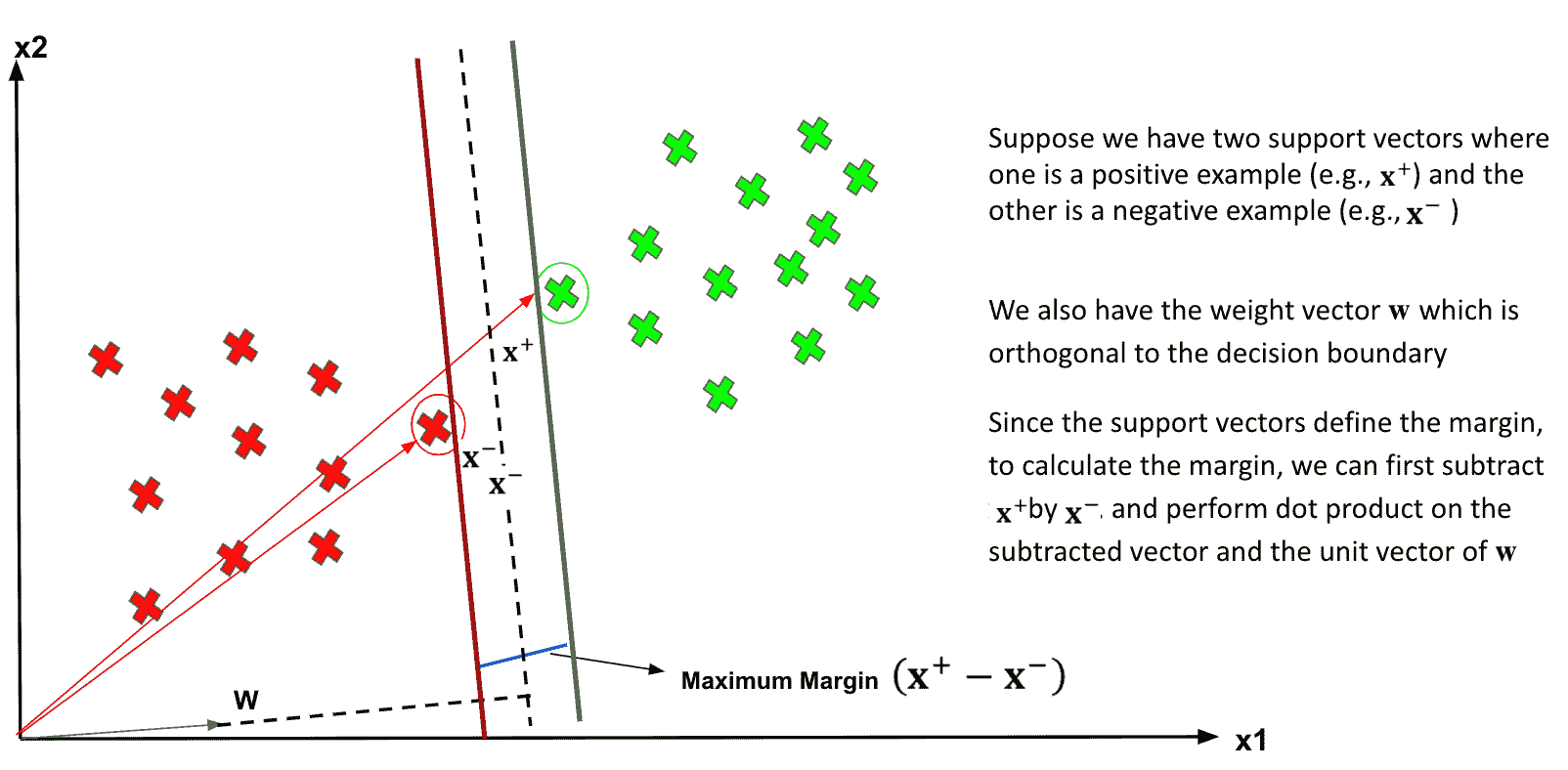

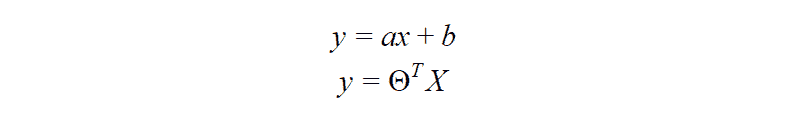

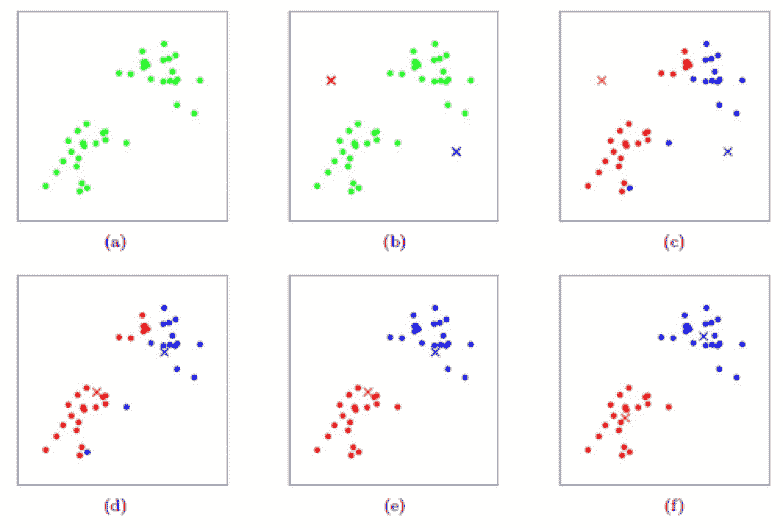

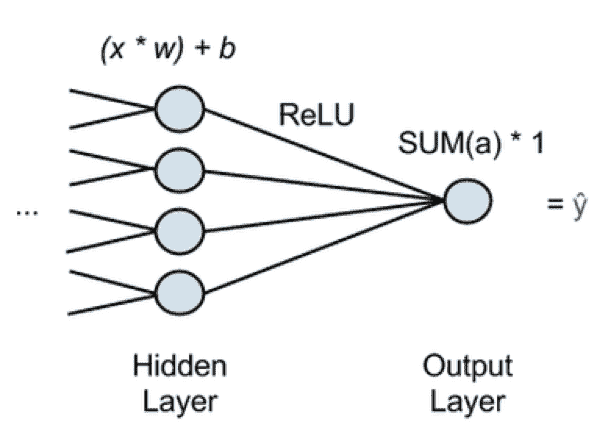

在前一层中,我们解释了神经元是模仿人脑神经结构的模型。神经网络的主要元素是神经元,通常称为节点。为了更好地解释这一概念,请参见下面图像中的典型神经网络架构。

神经网络架构(图片来源:KDnuggets)

如上图所示,神经网络由三层组成:

-

输入层接收信息并将其传输到下一层的其他节点。

-

隐藏节点层是所有计算发生的地方。

-

输出节点层是计算结果所在的地方。

当我们用两个或更多隐藏层训练神经网络模型时,这称为深度学习。之所以叫深度,是因为它使用了许多层。深度学习模型的优势在于它们能够自动学习和提取数据中的特征,而传统的机器学习模型则无法做到这一点。

在大语言模型中,深度学习非常重要,因为该模型建立在深度神经网络架构之上。那么,为什么它叫 LLM 呢?因为数十亿层在大量文本数据上进行训练。这些层会产生模型参数,帮助模型学习语言中的复杂模式,包括语法、写作风格等等。

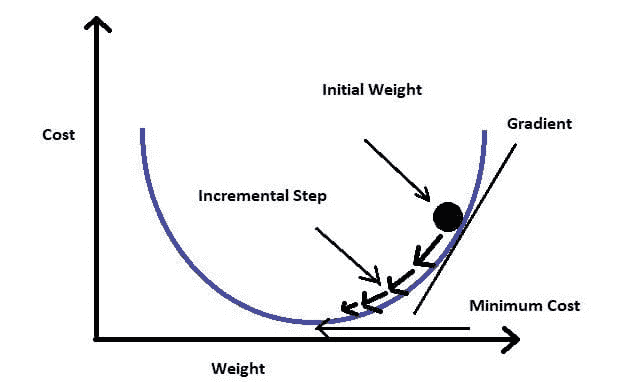

模型训练的简化过程如下面的图像所示。

图片来源:Kumar Chandrakant(来源:Baeldung.com)

过程显示模型可以根据输入数据中每个单词或句子的可能性生成相关文本。在 LLM 中,先进的方法使用 自监督学习 和 半监督学习 来实现通用能力。

自监督学习是一种技术,其中我们没有标签,而是训练数据提供了训练反馈。它在 LLM 训练过程中被使用,因为数据通常缺乏标签。在 LLM 中,可以利用周围的上下文作为线索来预测下一个单词。相比之下,半监督学习将监督学习和无监督学习概念结合起来,使用少量标记数据为大量未标记数据生成新标签。半监督学习通常用于具有特定上下文或领域需求的 LLM。

第 3 层:LLM 高级

在第三层,我们将更深入地讨论 LLM,特别是探讨 LLM 结构以及它如何实现类似人类的生成能力。

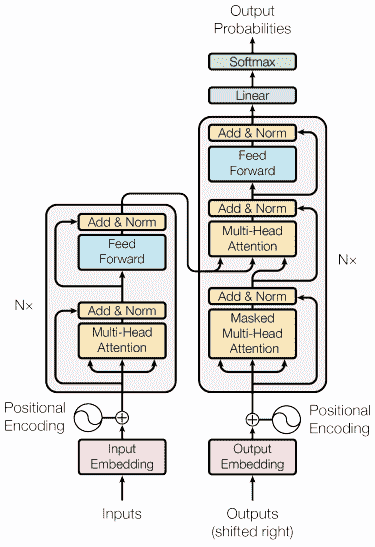

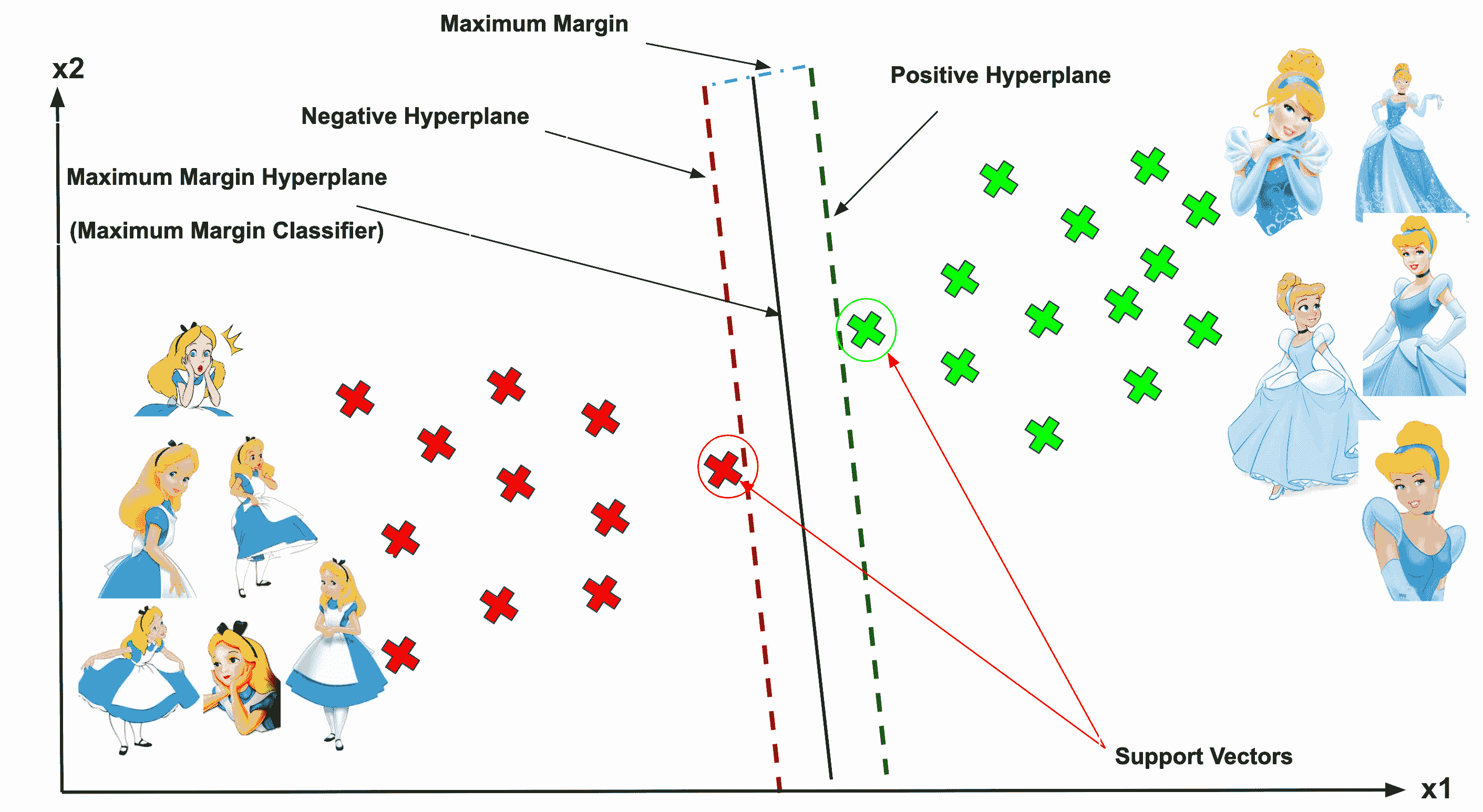

我们已经讨论了 LLM 基于深度学习技术的神经网络模型。近年来,LLM 通常基于 变压器 架构构建。变压器基于 Vaswani et al. (2017) 引入的多头注意力机制,并已被许多 LLM 使用。

变压器是一种模型架构,旨在解决 RNN 和 LSTM 之前遇到的序列任务。语言模型的旧方法是使用 RNN 和 LSTM 顺序处理数据,模型会使用每个词输出并将其回环,以免遗忘。然而,一旦引入变压器,这些方法在长序列数据上会出现问题。

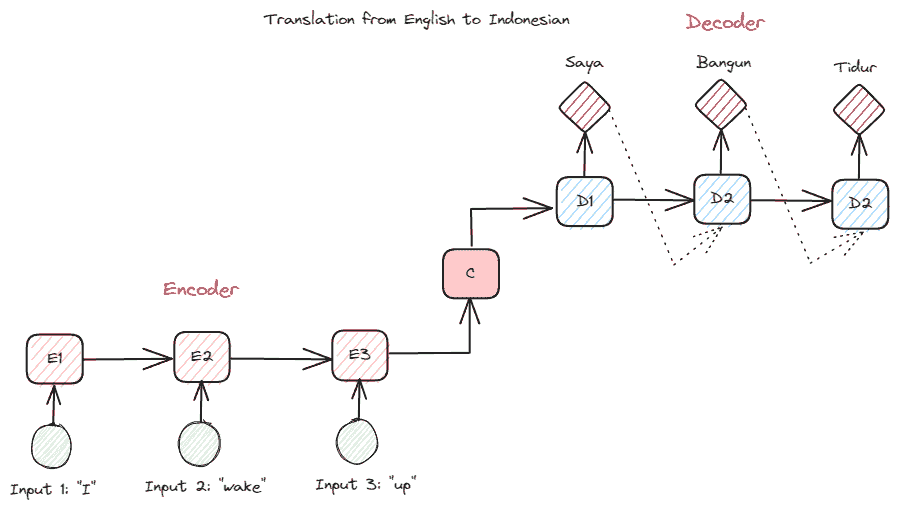

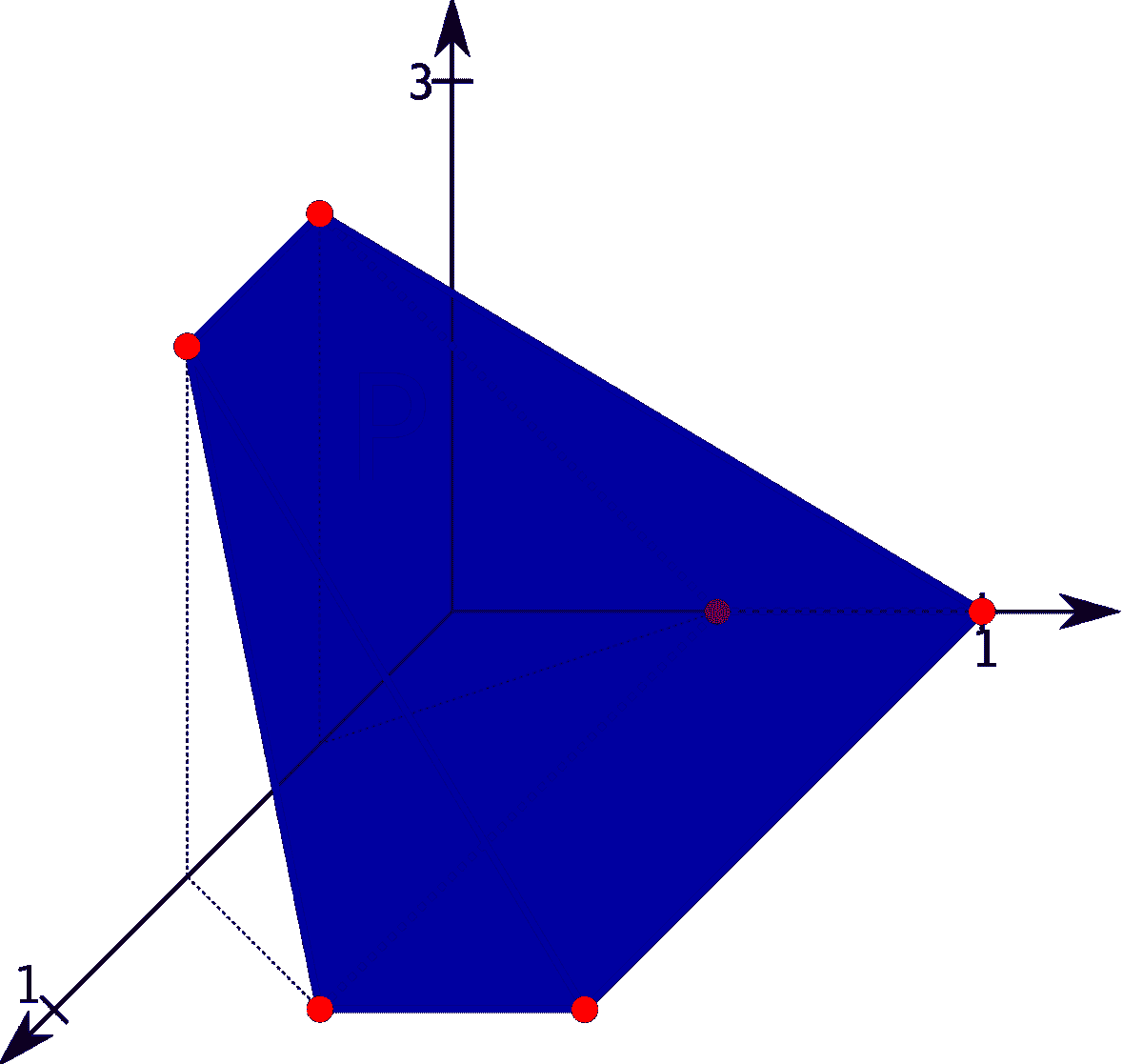

在深入了解变压器之前,我想介绍一下以前在 RNN 中使用的编码器-解码器概念。编码器-解码器结构允许输入和输出文本长度不同。一个示例用例是语言翻译,它通常具有不同的序列大小。

该结构可以分为两部分。第一部分称为编码器,它接收数据序列并基于它创建新的表示。该表示将在模型的第二部分,即解码器中使用。

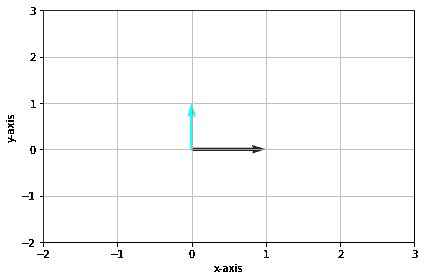

图片由作者提供

RNN 的问题在于,即使在上述编码器-解码器结构下,模型可能仍难以记住较长的序列。这时,注意力机制可以帮助解决这个问题,它是一种能够解决长输入问题的层。注意力机制在 Bahdanau et al. (2014) 的论文中被引入,用于通过关注模型输入的重要部分来解决编码器-解码器类型的 RNN 问题,同时进行输出预测。

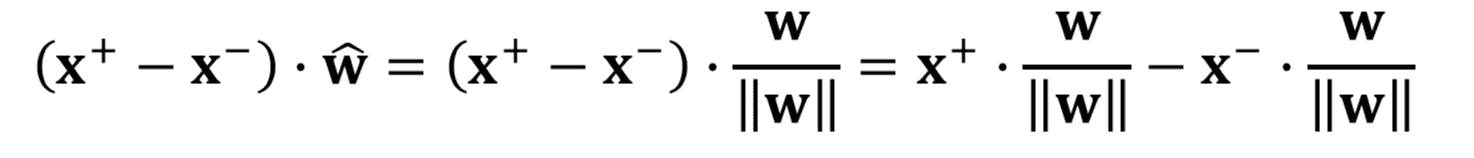

变压器的结构受编码器-解码器类型的启发,并采用注意力机制技术构建,因此无需按顺序处理数据。整体变压器模型的结构如下面的图像所示。

变压器架构(Vaswani et al. (2017))

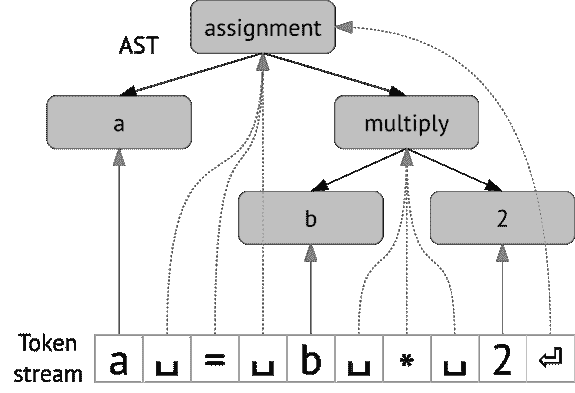

在上述结构中,变压器将数据向量序列编码为词嵌入,同时使用解码将数据转换为原始形式。编码可以利用注意力机制为输入分配一定的重要性。

我们稍微谈了一下变换器如何编码数据向量,但什么是数据向量呢?让我们来讨论一下。在机器学习模型中,我们不能将原始自然语言数据输入模型,因此我们需要将其转化为数字形式。这一转换过程称为词嵌入,其中每个输入单词都通过词嵌入模型处理以获取数据向量。我们可以使用许多初始词嵌入,如 Word2vec 或 GloVe,但许多高级用户尝试使用他们自己的词汇来精细调整它们。在基本形式下,词嵌入过程可以在下图中展示。

作者提供的图片

变换器可以接受输入,并通过以数字形式呈现单词来提供更相关的上下文,如上面的数据向量。在大语言模型(LLMs)中,词嵌入通常是依赖上下文的,通常会根据使用案例和预期输出进行精细调整。

结论

我们以三个难度级别讨论了大型语言模型,从初学者到高级用户。从 LLM 的一般使用到其结构,你可以找到更详细解释这个概念的说明。

Cornellius Yudha Wijaya**** 是一名数据科学助理经理和数据撰稿人。在全职工作于 Allianz Indonesia 的同时,他喜欢通过社交媒体和写作媒体分享 Python 和数据技巧。Cornellius 撰写了各种人工智能和机器学习主题的文章。

更多相关话题

大型语言模型是什么,它们是如何工作的?

原文:

www.kdnuggets.com/2023/05/large-language-models-work.html

编辑提供的图像

大型语言模型是什么?

我们的前三个课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业之路。

1. Google 网络安全证书 - 快速开启网络安全职业之路。

2. Google 数据分析专业证书 - 提升您的数据分析能力

2. Google 数据分析专业证书 - 提升您的数据分析能力

3. Google IT 支持专业证书 - 支持您的组织的 IT

3. Google IT 支持专业证书 - 支持您的组织的 IT

大型语言模型是一种人工智能(AI)模型,旨在理解、生成和处理自然语言。这些模型在大量文本数据上进行训练,以学习人类语言的模式、语法和语义。它们利用深度学习技术,如神经网络,来处理和分析文本信息。

大型语言模型的主要目的是执行各种自然语言处理(NLP)任务,如文本分类、情感分析、机器翻译、摘要生成、问答和内容生成。一些知名的大型语言模型包括 OpenAI 的 GPT(生成预训练变换器)系列,其中 GPT-4 是最著名的之一,Google 的 BERT(双向编码器表示变换器),以及 Transformer 架构的一般应用。

大型语言模型的工作原理

大型语言模型通过使用深度学习技术分析和学习大量文本数据,使其能够理解、生成和处理人类语言,以执行各种自然语言处理任务。

A. 预训练、微调和基于提示的学习

在大规模文本语料库上进行预训练:大型语言模型(LLMs)在庞大的文本数据集上进行预训练,这些数据集通常涵盖了互联网的显著部分。通过从各种来源学习,LLMs 捕捉语言中的结构、模式和关系,使其能够理解上下文并生成连贯的文本。这一预训练阶段帮助 LLMs 建立一个强大的知识基础,作为各种自然语言处理任务的基础。

在任务特定的标记数据上进行微调:在预训练之后,LLM 会使用针对特定任务和领域(如情感分析、机器翻译或问答)的较小标记数据集进行微调。这一微调过程使模型能够将其一般语言理解适应目标任务的细微差别,从而提高性能和准确性。

基于提示的学习与传统的 LLM 训练方法有所不同,例如 GPT-3 和 BERT 的训练方法,这些方法需要在未标记的数据上进行预训练,然后用标记数据进行任务特定的微调。而基于提示的学习模型则可以通过使用提示整合领域知识,自主调整以适应各种任务。

基于提示的模型生成的输出的成功严重依赖于提示的质量。精心设计的提示可以引导模型生成精确且相关的输出。相反,设计不当的提示可能会产生不合逻辑或无关的输出。设计有效提示的技巧被称为提示工程。

B. Transformer 架构

自注意力机制:支撑许多大型语言模型(LLM)的 Transformer 架构引入了一种自注意力机制,这一机制彻底改变了语言模型处理和生成文本的方式。自注意力机制使模型能够在给定的上下文中权衡不同单词的重要性,从而在生成文本或进行预测时选择性地关注相关信息。该机制计算效率高,并提供了一种灵活的方式来建模复杂的语言模式和长距离依赖。

位置编码和嵌入:在 Transformer 架构中,输入文本首先被转换为嵌入,这些嵌入是连续的向量表示,用于捕捉单词的语义含义。然后,将位置编码添加到这些嵌入中,以提供有关句子中单词相对位置的信息。这种嵌入和位置编码的结合使 Transformer 能够以上下文感知的方式处理和生成文本,从而理解和生成连贯的语言。

C. 分词方法和技术

分词是将原始文本转换为一系列较小单位(称为标记)的过程,这些单位可以是单词、子词或字符。分词是 LLM 管道中的一个重要步骤,因为它使模型能够以结构化格式处理和分析文本。LLM 中使用了几种分词方法和技术:

基于单词的分词:这种方法将文本拆分成单独的单词,将每个单词视为一个独立的标记。虽然简单直观,但基于单词的分词在处理词汇表外的词时可能会遇到困难,并且可能无法有效处理具有复杂形态的语言。

基于子词的分词:子词方法,如字节对编码(BPE)和 WordPiece,将文本拆分为可以组合成完整单词的较小单元。这种方法使 LLMs 能够处理词汇表外的单词,并更好地捕捉不同语言的结构。例如,BPE 通过合并最常出现的字符对来创建子词单元,而 WordPiece 则采用数据驱动的方法将单词分割成子词标记。

基于字符的分词:这种方法将单个字符视为标记。虽然它可以处理任何输入文本,但基于字符的分词通常需要更大的模型和更多的计算资源,因为它需要处理更长的标记序列。

大型语言模型的应用

A. 文本生成与完成

LLMs 可以生成连贯流畅的文本,紧密模拟人类语言,使其成为创意写作、聊天机器人和虚拟助手等应用的理想选择。它们还可以根据给定的提示完成句子或段落,展示了出色的语言理解和上下文意识。

B. 情感分析

LLMs 在sentiment analysis任务中表现出色,在这些任务中,它们根据情感将文本分类为正面、负面或中性。这种能力广泛应用于客户反馈分析、社交媒体监测和市场研究等领域。

C. 机器翻译

LLMs 还可以用于机器翻译,允许用户在不同语言之间翻译文本。像 Google Translate 和 DeepL 这样的 LLMs 已经展示了令人印象深刻的准确性和流畅性,使其成为跨语言障碍沟通的宝贵工具。

D. 问答系统

LLMs 可以通过处理自然语言输入并根据其知识库提供相关答案来回答问题。这一能力已被应用于各种场景,从客户支持到教育和研究辅助。

E. 文本摘要

LLMs 可以生成长文档或文章的简明摘要,使用户能够更快地掌握主要观点。文本摘要在新闻聚合、内容策划和研究辅助等方面具有广泛的应用。

结论

大型语言模型代表了自然语言处理领域的重大进展,改变了我们与语言技术互动的方式。它们在大量数据上进行预训练,并在特定任务数据集上进行微调,从而提高了在各种语言任务上的准确性和性能。从文本生成与完成到情感分析、机器翻译、问答系统和文本摘要,LLMs 展示了非凡的能力,并已在众多领域得到应用。

然而,这些模型也面临挑战和限制。计算资源、偏见与公平性、模型可解释性以及控制生成内容是需要进一步研究和关注的领域。尽管如此,大语言模型对 NLP 研究和应用的潜在影响巨大,它们的持续发展可能会塑造 AI 和基于语言的技术的未来。

如果你想构建自己的大语言模型,可以在 Saturn Cloud 注册,开始使用免费的云计算和资源。

Saturn Cloud 是一个数据科学和机器学习平台,灵活支持 Python、R 等多种语言。可以扩展、协作并利用内置管理功能来帮助你运行代码。可以创建一个具有 4TB RAM 的笔记本,添加 GPU,连接到分布式工作节点等。Saturn 还自动化了 DevOps 和 ML 基础设施工程,使你的团队可以专注于分析。

原始文章。经许可转载。

相关主题

你所需的最后一本 SQL 数据分析指南

原文:

www.kdnuggets.com/2019/10/last-sql-guide-data-analysis-ever-need.html

评论

由 Muhsin Warfa,系统开发员/技术写作人

照片由 Tobias Fischer 提供,来自 Unsplash

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 工作

到 2020 年,预计每秒将为地球上的每个人创造 1.7 MB 的数据。真是荒谬!数据将成为我们数字时代的新石油。数据的增长带来了从中提取意义的需求。这催生了许多职业,这些职业管理和分析数据以做出更明智的商业决策。许多这些职业要求你熟练管理数据库中的数据。

介绍

管理数据的一种常见方式是使用关系型数据库管理系统。关系型数据库以表格形式存储数据,由行和列组成。这些数据库通常包括数据和元数据。数据是存储在表中的信息,而元数据是描述数据库中数据结构或数据类型的数据。

为了能直接与这些数据库沟通,我们使用 SQL,它是结构化查询语言(Structured Query Language)的缩写。SQL 用于执行如创建、读取、更新和删除数据库中的表等任务。

SQL 是一种声明式且特定领域的语言,主要由商业分析师、软件工程师、数据分析师以及许多其他利用数据的职业使用。你不需要成为程序员或了解如 Python 等编程语言才能掌握 SQL。SQL 的语法类似于英语。只需记住一些简单的语法,你就能舒适地使用数据库系统。

“声明式编程是你说出你想要的结果,而无需说明如何做到这一点。与过程式编程相比,你必须指定获得结果的确切步骤。” — Stack Overflow

我在这篇文章中的目标是让你熟悉 SQL,并逐一介绍 SQL 概念,同时提出处理数据库的查询。

数据库设置

在本教程中,我们不会使用关系数据库管理系统(RDBMS),而是使用测试数据库来编写我们自己的查询。我们将使用 W3school 的 SQL 编辑器编辑测试数据库,链接见这里。它无需安装,因此我们可以专注于编写查询。

备忘单

由于 SQL 是一种声明性语言,记住 SQL 语句将大有帮助。随时保持一份参考指南,将有助于快速掌握查询表格时使用的关键字。这里是我创建的关键字电子表格,供参考。记住,掌握这只 SQL 猛兽的一半战斗就是记住/了解关键字。

数据定义语言(DDL)

我们的大多数查询将涉及对表格执行某种形式的操作。操作分为四类:创建、插入、更新和删除表格。

创建表格

当我们想在数据库中创建表格时,使用CREATE TABLE语句。将以下代码输入编辑器:

CREATE TABLE Countries(

Country_id int,

Country_name varchar(255),

Continent varchar(255),

Population int

);

这将创建一个名为countries的表格,其中包含四列。创建 SQL 表格的最低要求是指定列名、数据类型和长度。当然,你还可以拥有更多特性,如Not Null,意味着表格中不会输入空值,但这些是可选属性。

与表格一起工作

插入表格

创建表格后,我们可以使用INSERT INTO方法语句插入行。输入以下代码:

INSERT INTO countries(Country_id,Country_name, Continent,Population)

VALUES (1,'Somalia','Africa',14000000);

该语句将Somali作为新国家添加到countries表格中。在插入行时,指定列名和值是一个好习惯。

读取表格

当我们想查找存储在数据库中的数据时,使用Select语句。

Select * from Countries;

该语句返回一个表格,显示我们刚刚使用插入语句插入的行。*通配符表示“显示表格中的所有行”。如果你只想显示Population列,可以去掉星号,替换为其列名。

Select Population from Countries;

更新表格

如果我们想修改表格中的现有记录,可以使用UPDATE语句来做到这一点。

UPDATE Countries

SET Country_name ='Kenya'

WHERE Country_id=1;

该语句将country_id为1的行中的country_name列更新为Kenya。我们必须指定国家 ID,因为我们只想更改那一行。如果我们去掉WHERE语句,SQL 会认为我们想更新表格中的所有行。

删除表格中的记录

如果我们想删除表格中的所有行,则使用DELETE FROM语句。

DELETE FROM Countries;

如果你想删除表格而不是所有记录,可以使用DROP TABLE语句。

DROP TABLE Countries;

注意: 这会从数据库中删除整个表格,可能导致数据丢失!

过滤器

如果我们只对表格中的部分数据感兴趣,我们可以筛选表格。我们有多个语句可以用来筛选表格。过滤器基本上选择符合某些标准的行,并将结果作为过滤后的数据集返回。筛选表格不会更改原始表格。

WHERE

WHERE 子句用于筛选记录。在我们的编辑器中有一个名为 Customers 的表。如果我们想筛选来自 “USA” 的客户,我们使用 WHERE 语句。

SELECT * from Customers WHERE country = "USA";

AND, OR 和 NOT

在我们之前的例子中,只有一个条件,即“国家是美国”。我们还可以使用 AND、OR 和 NOT 组合多个条件。例如,如果你想要来自美国或巴西的客户,你可以使用 OR 语句。

SELECT * from Customers WHERE country = "USA" OR country = "Brazil";

ORDER BY

大多数时候,当我们筛选表格时,返回的数据集是未排序的。我们可以使用 ORDER BY 语句对这个筛选后的未排序数据集进行排序。

SELECT * from Customers WHERE country = "USA" OR country = "Brazil"

ORDER BY CustomerName ASC;

这将按字母顺序对筛选结果进行排序。如果我们想要降序排序,可以将 ASC 替换为 DESC。

BETWEEN

有时我们希望选择值满足特定范围的行。我们使用 BETWEEN 语句来选择并定义范围。

SELECT * from Products

WHERE Price BETWEEN 10 AND 20;

上述语句筛选了价格在 10 到 20 之间的产品。

注意: 在 BETWEEN 操作中,下限和上限都是包含在内的。

LIKE

有时我们想根据特定模式筛选表格。为此,我们使用 LIKE 语句。

SELECT * from Customers

WHERE CustomerName LIKE 'A%';

上述 SQL 语句筛选了表格,只显示名字以字母 A 开头的客户。如果你将百分号向前移动,它会筛选名字以字母 A 结尾的客户。

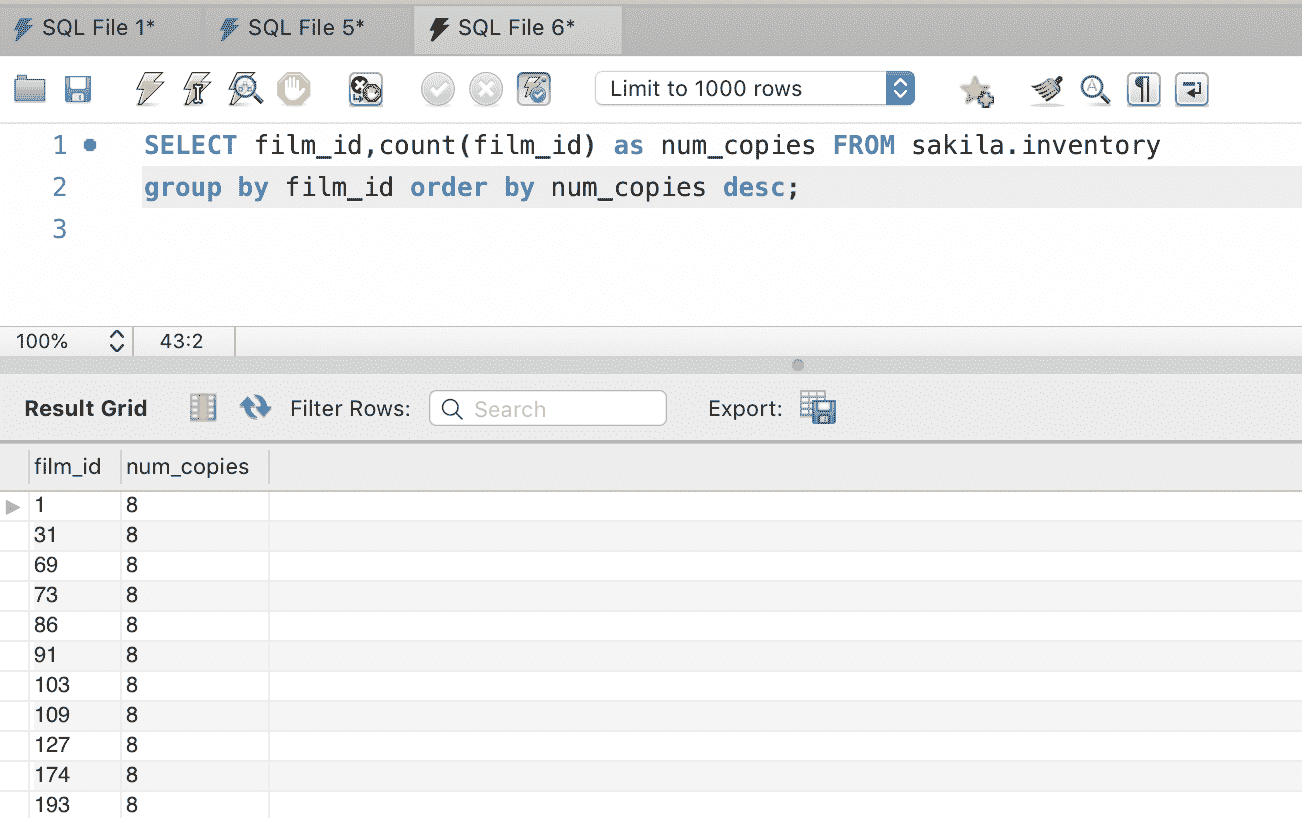

GROUP BY

GROUP BY 将筛选后的结果集分组。可以将其视为每列数据集的汇总组。

SELECT COUNT(CustomerID), Country

FROM Customers

GROUP BY Country;

该语句统计了每个国家的客户数量,然后按国家分组。GROUP BY 通常与聚合函数一起使用,后者我们将在文章的后面详细讨论。

HAVING

HAVING 的引入是因为 WHERE 语句不能与聚合函数一起使用,它只处理数据库中的直接值。

SELECT COUNT(CustomerID), Country

FROM Customers

GROUP BY Country

HAVING COUNT(CustomerID) > 3;

这个语句与上一个例子做的事情一样。唯一的区别是我们只包括客户数量超过三人的国家。

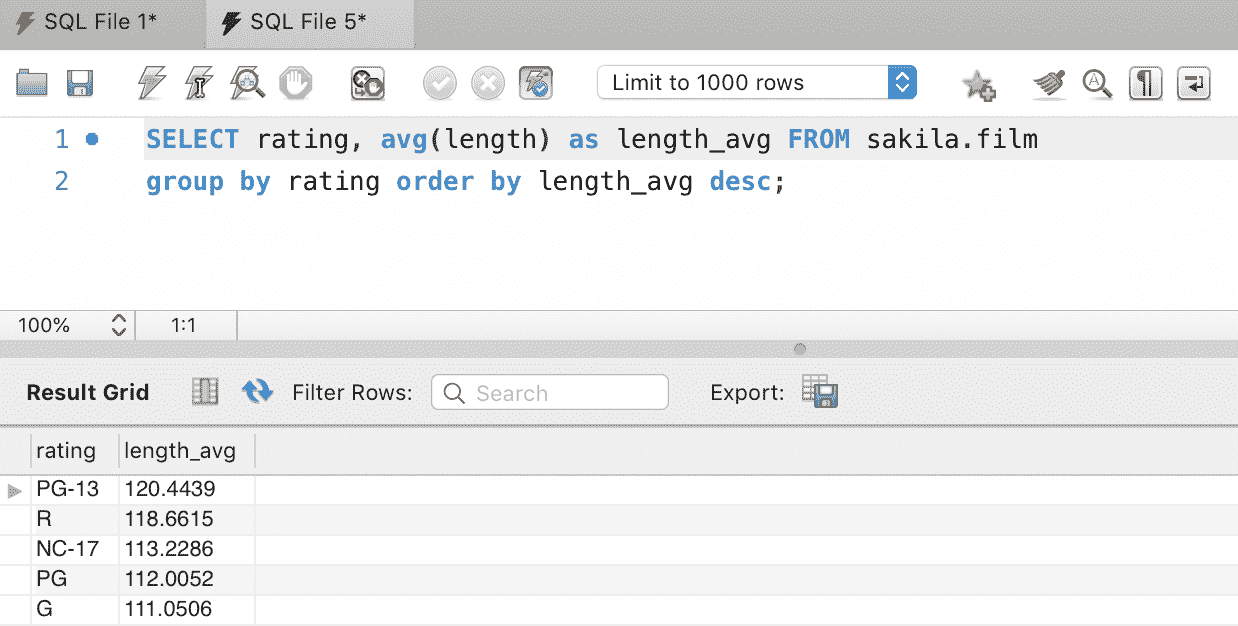

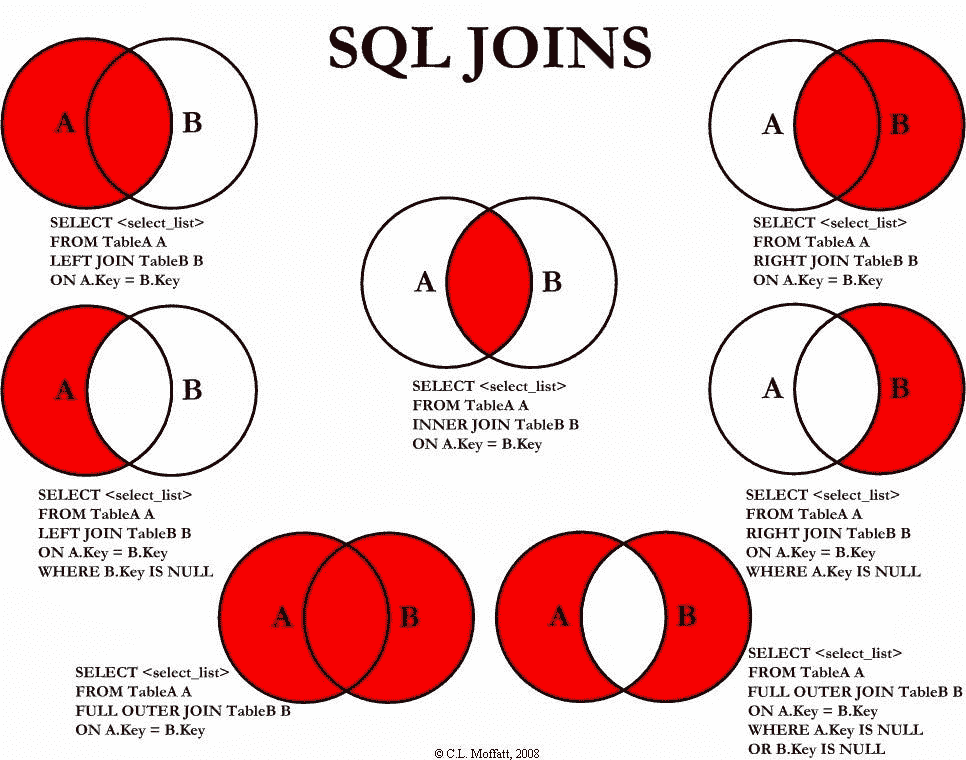

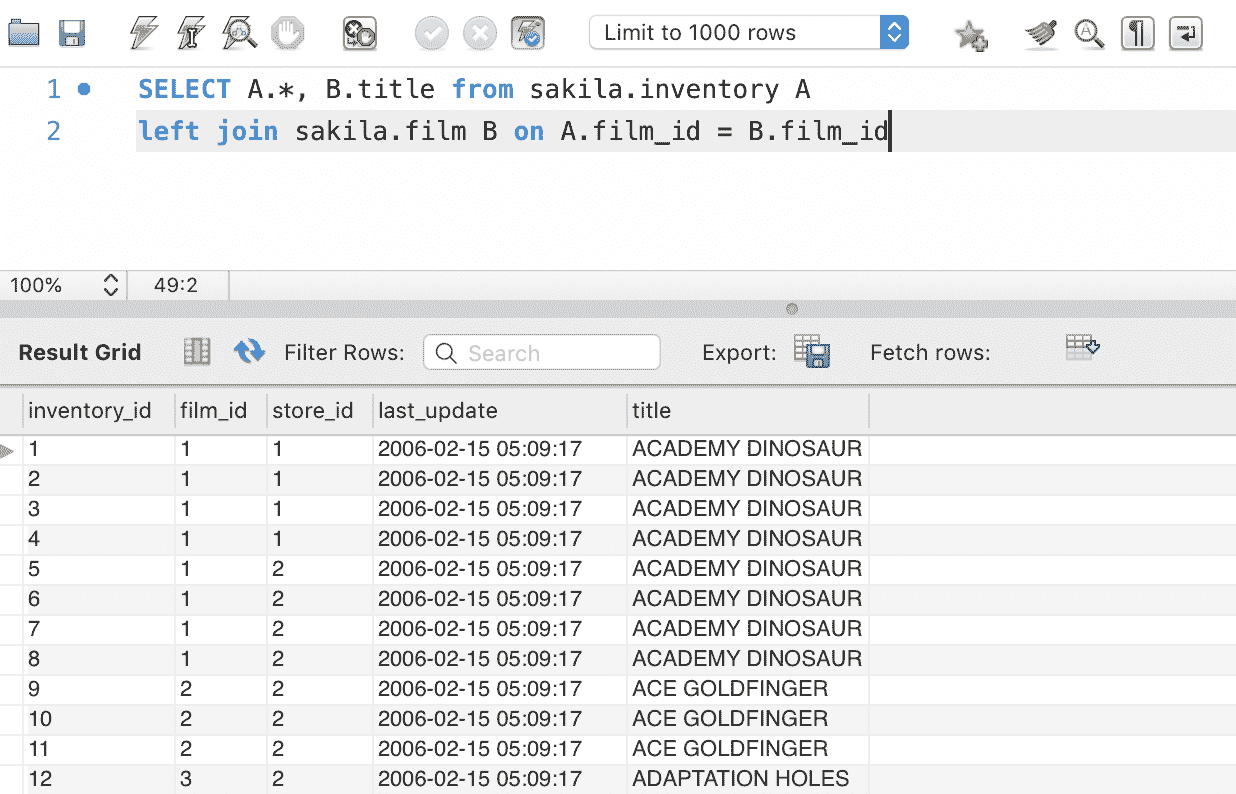

连接

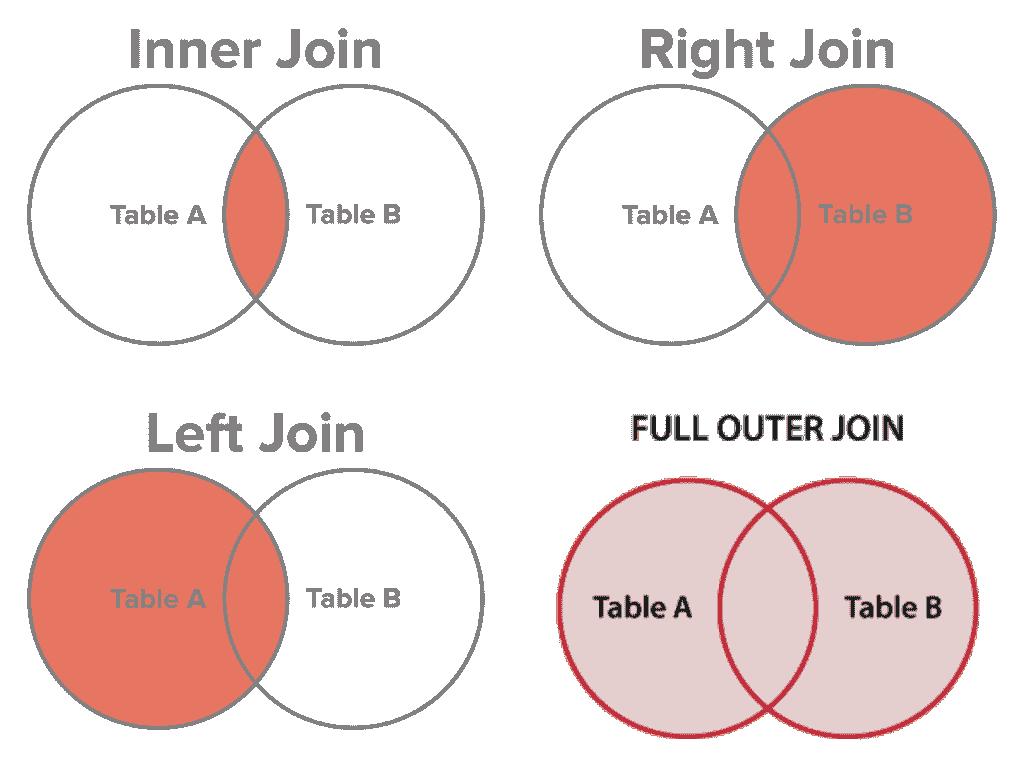

想象一下你想知道哪个客户订购了哪些产品。如果数据库遵循正确的数据库规范化技术,那么产品、客户和订单将被存储在不同的表中。如果我们想查看哪个客户订购了哪些产品,我们需要在订单表中查找客户 ID,然后去客户表查看产品购买情况,再使用产品 ID 查找产品表。正如你所看到的,如果需要重复多次,这将是一个巨大的麻烦。为了更轻松地完成这个操作,SQL 提供了一个名为 JOIN 的语句。这个子句用于基于共享的相关列将两个或更多的表行合并。

内连接

INNER JOIN,通常简称为 "JOIN",用于在共享列上将相关表合并成一个表。

SELECT Orders.OrderID, Customers.CustomerName

FROM Orders

INNER JOIN Customers ON Orders.CustomerID = Customers.CustomerID;

上述语句返回列的订单 ID 和客户姓名。我们将订单表(左)和客户表(右)连接,但仅包括那些具有匹配客户 ID 的行。在查看内连接的维恩图时重新阅读这句话,希望这样更容易理解。

左连接

SELECT Customers.CustomerName, Orders.OrderID

FROM Customers

LEFT JOIN Orders ON Customers.CustomerID = Orders.CustomerID

ORDER BY Customers.CustomerName;

LEFT JOIN 语句用于将左表(客户表)和右表(订单表)连接,返回左表中的所有行以及右表中匹配的记录。

右连接

SELECT Orders.OrderID, Employees.LastName, Employees.FirstName

FROM Orders

RIGHT JOIN Employees ON Orders.EmployeeID = Employees.EmployeeID

ORDER BY Orders.OrderID;

RIGHT JOIN 返回右表中的所有行以及左表中匹配的记录。这将返回所有员工及他们可能下的任何订单。

外连接

SELECT Customers.CustomerName, Orders.OrderID

FROM Customers

FULL OUTER JOIN Orders ON Customers.CustomerID=Orders.CustomerID

ORDER BY Customers.CustomerName;

也被称为 FULL OUTER JOIN,用于将一个或多个表中的所有行合并。没有行会被遗漏,所有行都将包含在连接后的表中。

SQL 聚合函数

函数是一组接受输入并输出结果的过程。SQL 函数基本上是一组 SQL 语句,它接受输入,对输入执行 SQL 操作,然后将结果作为输出返回。

SQL 中有两种类型的函数:集合函数 和 值函数。任何操作表中数据行并返回单个值的函数称为集合函数。程序员通常称它们为聚合函数,因为它们将表中的行汇总成一个信息聚合。

最小值

SELECT MIN(Price) AS LeastPricy

FROM Products;

这个 SQL 函数返回产品表中所有产品的最低价格。

最大值

SELECT MAX(Price) AS MostExpensive

FROM Products;

这个 SQL 函数返回产品表中所有产品的最高价格。

平均值

SELECT AVG(Price) AS AveragePrice

FROM Products;

这个 SQL 函数返回产品表中所有产品的平均价格。

计数

SELECT COUNT(ProductID)

FROM Products;

这返回产品表中产品的数量。

总和

SELECT SUM(Quantity)

FROM OrderDetails;

这返回订单详情表中所有订单的总和。

索引

到目前为止,我们所看过的查询都是基本查询。实际上,我们在日常生活中执行的查询通常由多个 SQL 语句或函数的组合构成。当操作复杂时,这将减少查询的执行时间。

幸运的是,SQL 有一种叫做 索引 的功能,可以加快查找速度。索引是一种数据结构,它指向表中的数据。如果没有索引,搜索表中的数据将是 线性的,意味着会逐行扫描。索引非常适合表格数据。

创建索引

CREATE INDEX idx_lastname

ON Persons (LastName);

这将创建一个索引以便快速查找列中的数据。需要注意的是,索引不存储在表中,对肉眼不可见。我们通常在有大量数据检索时使用索引。

数据库事务

事务 是一系列必须执行的 SQL 语句,以确保操作成功。事务是“全有或全无”的操作。如果所有操作中只有一个失败,我们认为整个事务失败了。

事务的一个常见示例是将资金从一个账户转到另一个账户。为了使转账成功,必须从账户 A 中扣除资金并添加到账户 B 中。否则,我们将回滚事务以重新开始。当事务完成时,我们称之为 提交。这确保了数据库维护数据的完整性和一致性。

如果你想深入了解数据库事务,我建议你查看 this 这段关于数据库事务的优秀视频讲解。

数据库触发器

并非所有 SQL 查询都是单独的和孤立的。有时我们希望在另一表 B 上发生不同事件时,对表 A 执行某个操作。这就是我们使用 数据库触发器 的地方。

数据库触发器是一组在数据库内发生特定操作时执行的 SQL 语句。触发器被定义为在对表数据进行更改时运行,主要是在 DELETE、UPDATE 和 CREATE 等操作之前或之后。数据库触发器的最常见用例是验证输入数据。

提示

-

所有 SQL 保留字均为大写。其他所有内容(表、列等)均为小写。

-

将查询分成多行,而不是在单行中编写一个长语句。

-

你不能在表中添加特定位置的列,所以在设计表时要小心。

-

使用

AS别名语句时请注意;列名并没有在表中被重命名。别名仅在数据集结果中出现。 -

SQL 按以下顺序评估这些子句:

FROM、WHERE、GROUP BY、HAVING,最后是SELECT。因此,每个子句都接收前一个筛选器的过滤结果。它的样子是这样的:

SELECT(HAVING(GROUP BY(WHERE(FROM...))))

结论

你可以从我们在本文中看到的 SQL 语句的无尽排列中生成强大的查询。记住,巩固概念并提高 SQL 水平的最佳方式是通过练习和解决 SQL 问题。上面的部分示例灵感来源于W3School。你可以在像hackerrank和LeetCode这样的互动网站上找到更多练习,它们有吸引人的用户界面,帮助你更长时间地学习。

你练习得越多,你会变得越好,你训练越严格,他们就会看到你更大的潜力。* — Alcurtis Turner*

祝愿你平安和繁荣!

简介:穆欣·沃尔法 为您的组织需求构建和设计全栈网络软件应用程序。作为软件产品开发者,他参与了多个项目,从商业应用到学生课程应用,涵盖了从概念化和构思到测试和部署的所有开发生命周期。如果你喜欢这篇文章,请随时在 LinkedIn 上联系和保持联系,并关注更多文章/帖子。

原文。已获许可转载。

相关:

-

数据科学家的顶级实用 SQL 功能

-

2019 版掌握数据科学 SQL 的 7 个步骤

-

数据科学家需要 SQL 吗?

更多相关主题

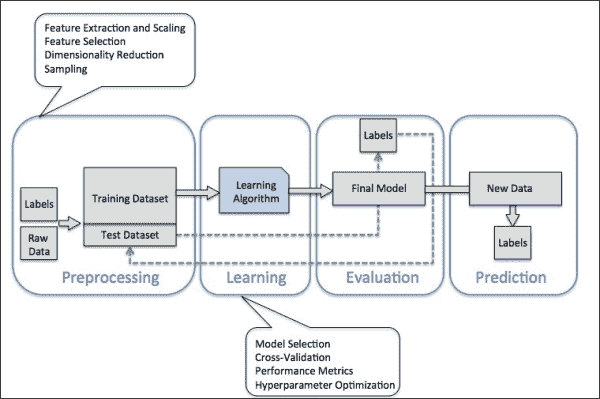

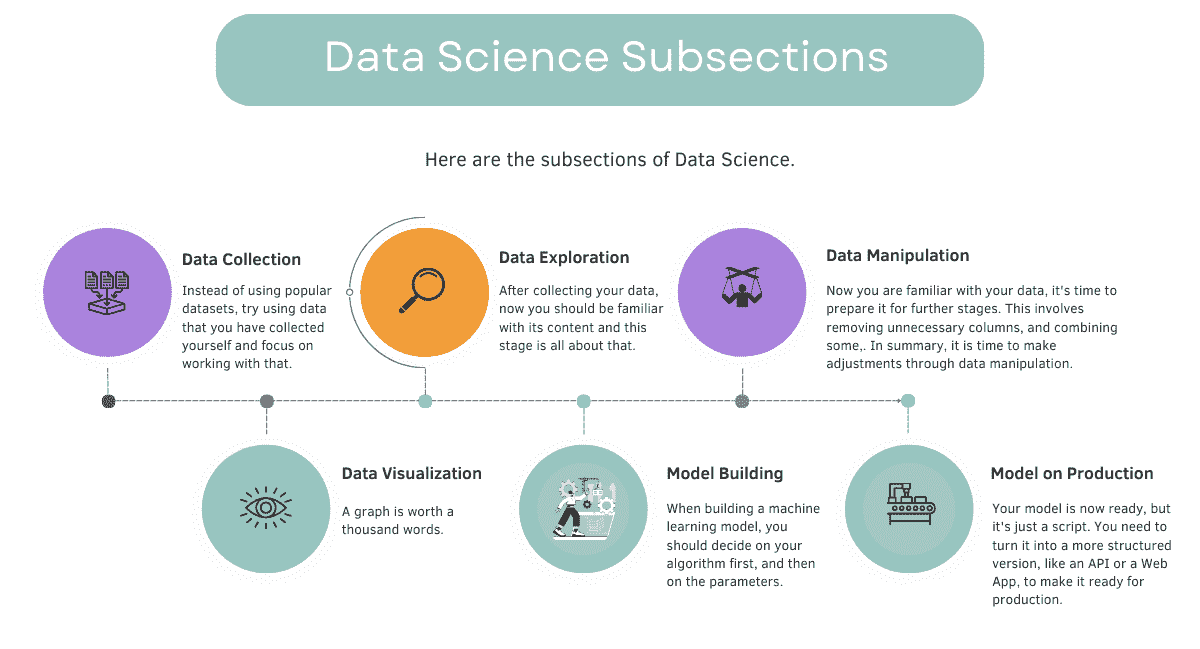

数据科学的外行指南。第三部分:数据科学工作流程

原文:

www.kdnuggets.com/2020/07/laymans-guide-data-science-workflow.html

评论

由 Sciforce。

注意:这是第一部分:如何成为一名(优秀的)数据科学家 – 初学者指南 和

第二部分:数据科学的外行指南。如何构建数据项目

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业

1. 谷歌网络安全证书 - 快速进入网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

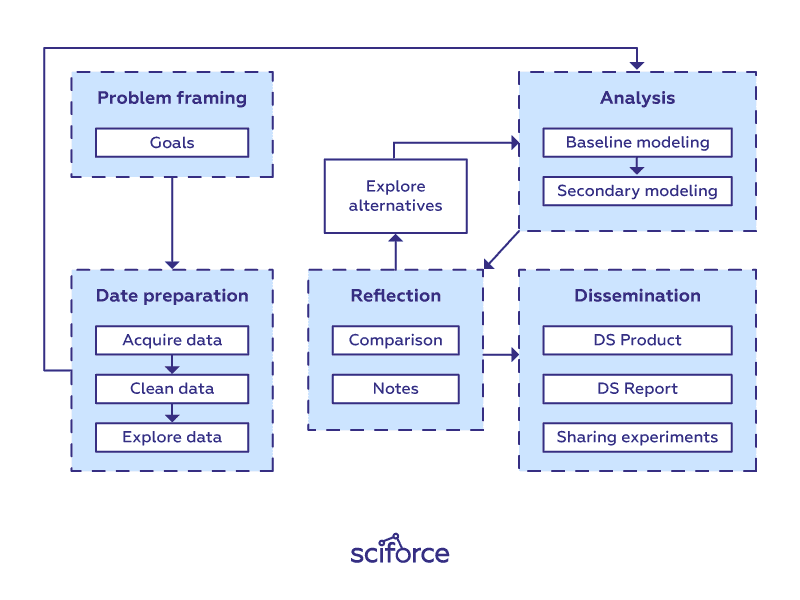

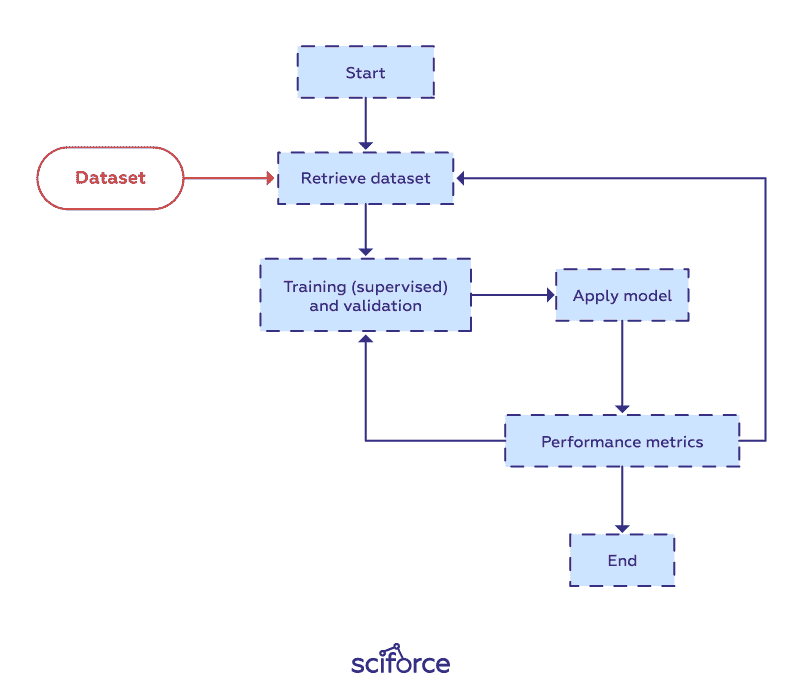

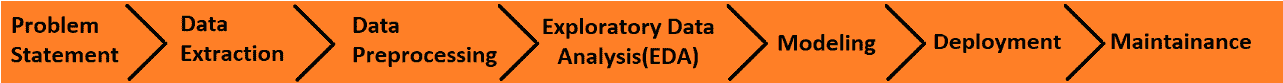

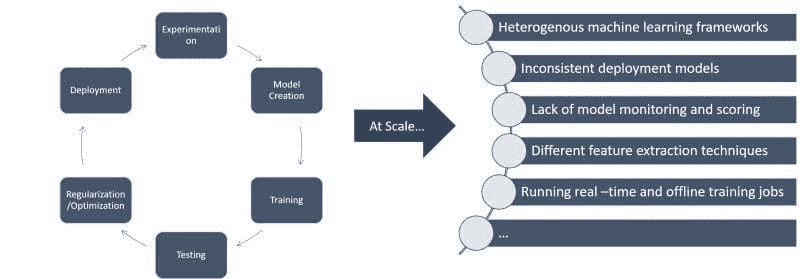

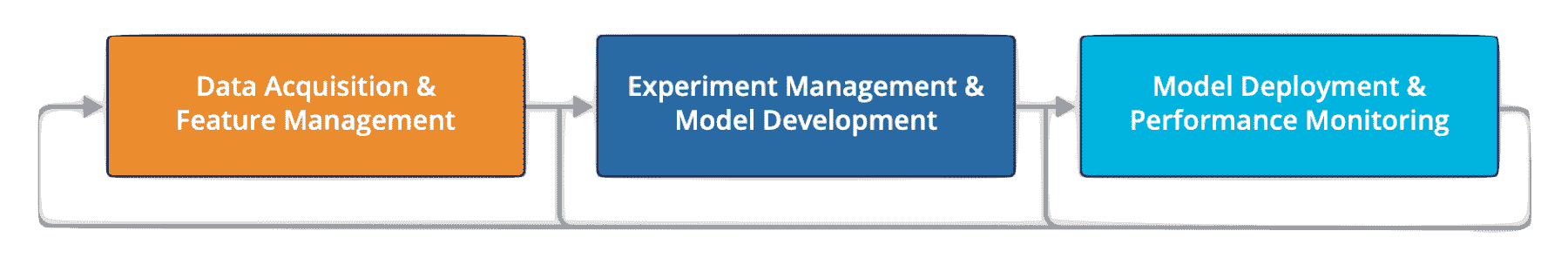

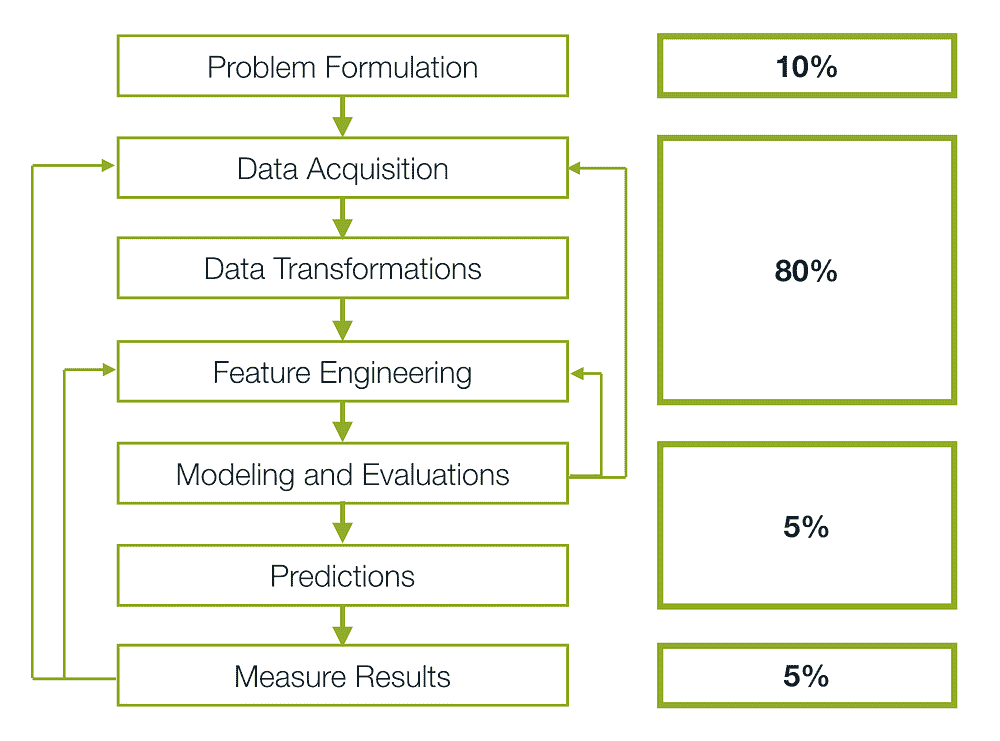

数据科学工作流程。

到目前为止,你已经获得了足够的数据科学知识和技能和完成了你的第一个(或甚至是第二个和第三个)项目。此时,是时候改进你的工作流程,以便进一步发展过程。

解决任何数据科学问题没有特定的模板(否则你会在你遇到的第一本教科书中看到它)。每个新的数据集和每个新的问题都会导致不同的路线图。然而,许多不同项目中有类似的高层步骤。

在这篇文章中,我们提供了一个可以作为数据科学项目基础的清晰工作流程。它的每个阶段和步骤当然可以单独处理,甚至可以由更大规模项目中的不同专家实施。

确定问题和目标

正如你已经知道的,在起始点,你会提出问题并尝试掌握你需要什么数据。因此,考虑你想解决的问题。你想了解更多什么?现在,忘记建模、评估指标和数据科学相关的事物。明确陈述问题和定义目标是提供良好解决方案的第一步。没有这些,你可能会在数据科学的森林中迷失方向。

数据准备阶段

在任何数据科学项目中,获取正确的数据是关键。在进行任何分析之前,你必须获取相关数据,将其重新格式化为适合计算的形式,并进行清理。

获取数据

任何数据科学工作流的第一步是获取要分析的数据。数据可以来自各种来源:

-

从本地计算机的 CSV 文件中导入;

-

从 SQL 服务器中查询;

-

从在线存储库中剥离,如公共网站;

-

通过 API 从在线源按需流式传输;

-

由物理设备自动生成,如连接到计算机的科学实验室设备;

-

由计算机软件生成,如来自网络服务器的日志。

在许多情况下,收集数据可能会变得混乱,特别是当数据不是以有组织的方式收集时。你需要处理不同的来源,并应用各种工具和方法来收集数据集。

收集数据时有几个关键点需要记住:

数据来源:准确追踪数据来源,即每一条数据来自何处以及是否仍然是最新的非常重要,因为数据常常需要重新获取以进行新的实验。重新获取数据是有帮助的,特别是当原始数据源更新时,或者研究人员想要测试替代假设时。此外,我们可以利用数据来源追溯下游分析错误到原始数据源。

数据管理:为了避免数据重复和不同版本之间的混淆,必须为创建或下载的数据文件分配适当的名称,然后将这些文件组织到目录中。当创建这些文件的新版本时,所有版本应分配相应的名称,以便能够跟踪它们之间的差异。例如,科学实验室设备可以生成数百或数千个数据文件,科学家们必须在对其进行计算分析之前对这些文件进行命名和组织。

数据存储:随着现代数据访问几乎没有限制,常常出现数据量如此庞大的情况,以至于无法放入硬盘中,因此必须存储在远程服务器上。尽管云服务越来越受欢迎,但大量的数据分析仍然是在桌面计算机上进行的,数据集可以适应现代硬盘(即少于一太字节)。

重新格式化和清理数据

原始数据通常不以便于分析的格式出现,因为这些数据是由其他人格式化的,而没有考虑到分析的需求。此外,原始数据通常包含语义错误、缺失条目或格式不一致,因此在分析之前需要“清理”。

数据整理(munging)是清理数据的过程,将所有内容放入一个工作空间,并确保数据没有缺陷。可以通过手动或编写脚本来重新格式化和清理数据。将所有值转换为正确的格式可能涉及从字符串中剥离字符、将整数转换为浮点数等许多操作。之后,需要处理缺失值和稀疏矩阵中常见的空值。处理这些数据的过程称为缺失数据插补,即用替代数据替换缺失的数据。

数据集成是一个相关的挑战,因为所有来源的数据需要整合到一个中心 MySQL 关系数据库中,该数据库作为分析的主数据源。

通常,这需要大量时间,无法完全自动化,但同时它可以提供有关数据结构和质量以及可能应用的模型和分析的洞察。

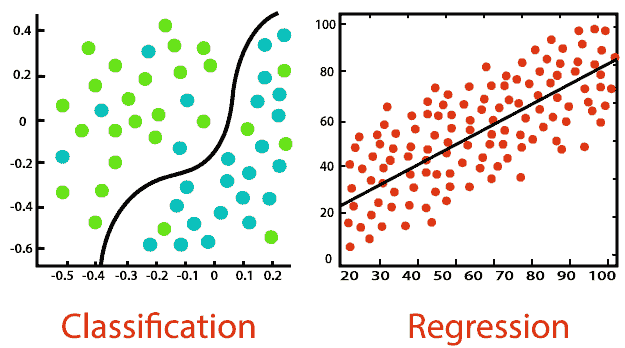

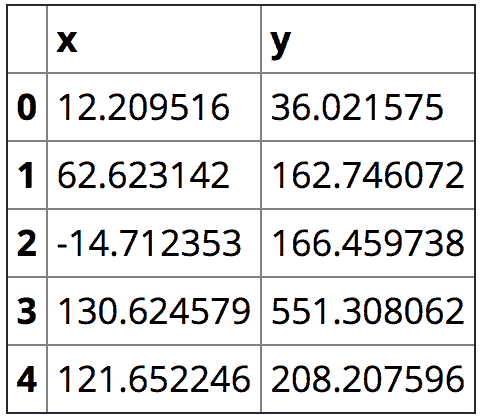

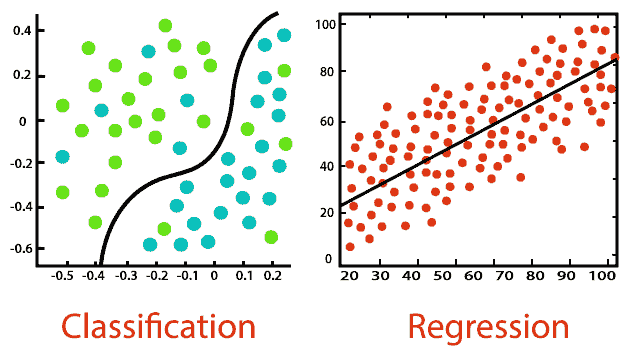

探索数据

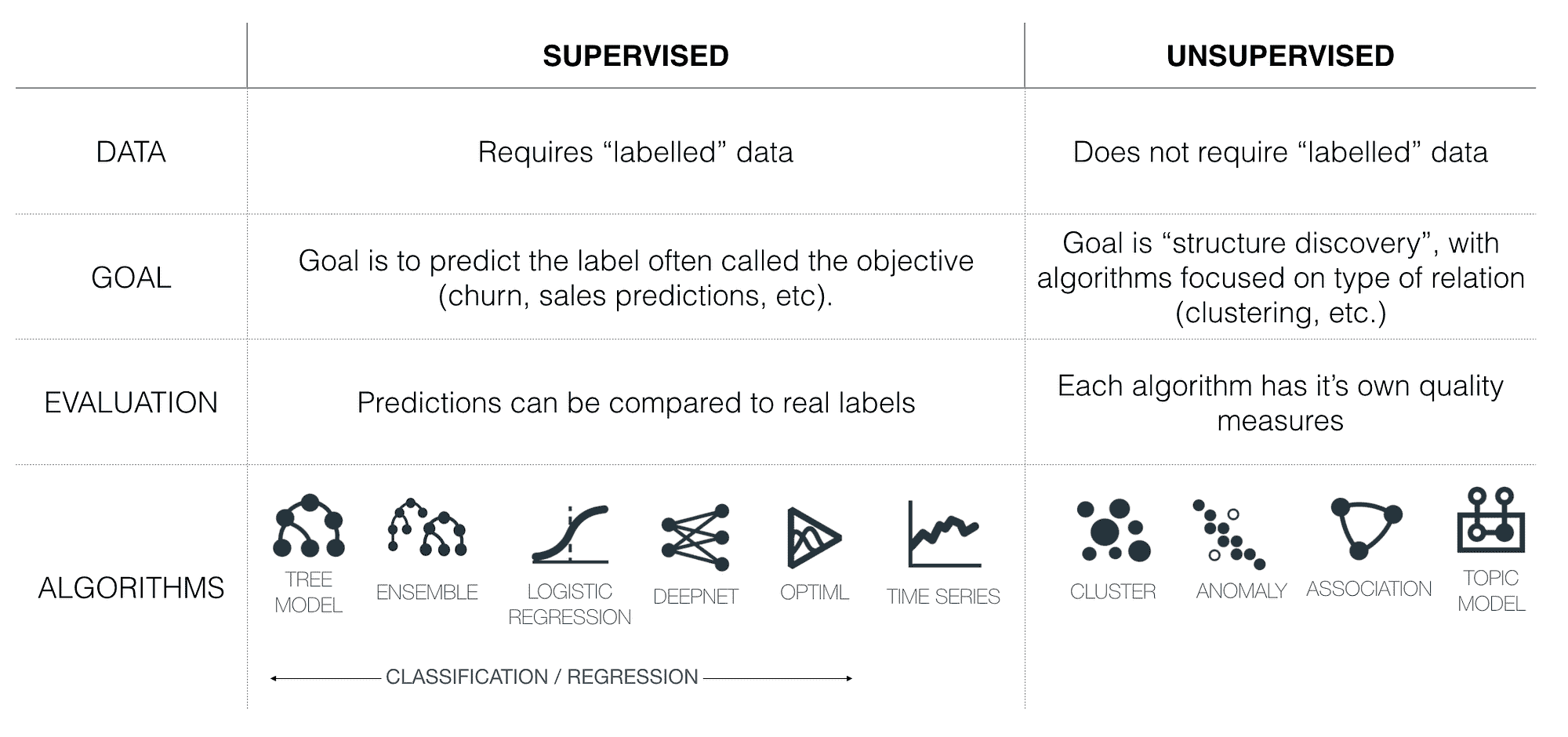

在这里,你将开始获取关于你所查看内容的概要级洞察,并提取大的趋势。在这一步,有三个维度需要探索:数据是否暗示监督学习还是无监督学习?这是分类问题,还是回归问题?这是预测问题还是推断问题?这三组问题在解决数据科学问题时可以提供很多指导。

有许多工具可以帮助你快速理解数据。你可以从检查数据框的前几行开始,获得数据组织的初步印象。集成在多个库中的自动工具,如 Pandas 的.describe(),可以快速提供均值、计数、标准差,你可能已经会发现值得深入研究的内容。有了这些信息,你将能够确定哪个变量是目标,哪些特征是重要的。

分析阶段

分析是数据科学的核心阶段,包括编写、执行和完善计算机程序,以从前一阶段准备的数据中分析并获取洞察。尽管有许多编程语言用于数据科学项目,从解释型的“脚本”语言如 Python、Perl、R 和 MATLAB 到编译型的语言如 Java、C、C++或甚至 Fortran,但编写分析软件的工作流程在不同语言中是类似的。

如你所见,分析是一个重复的迭代循环,涉及编辑脚本或程序、执行以生成输出文件、检查输出文件以获取洞察和发现错误、调试以及重新编辑。

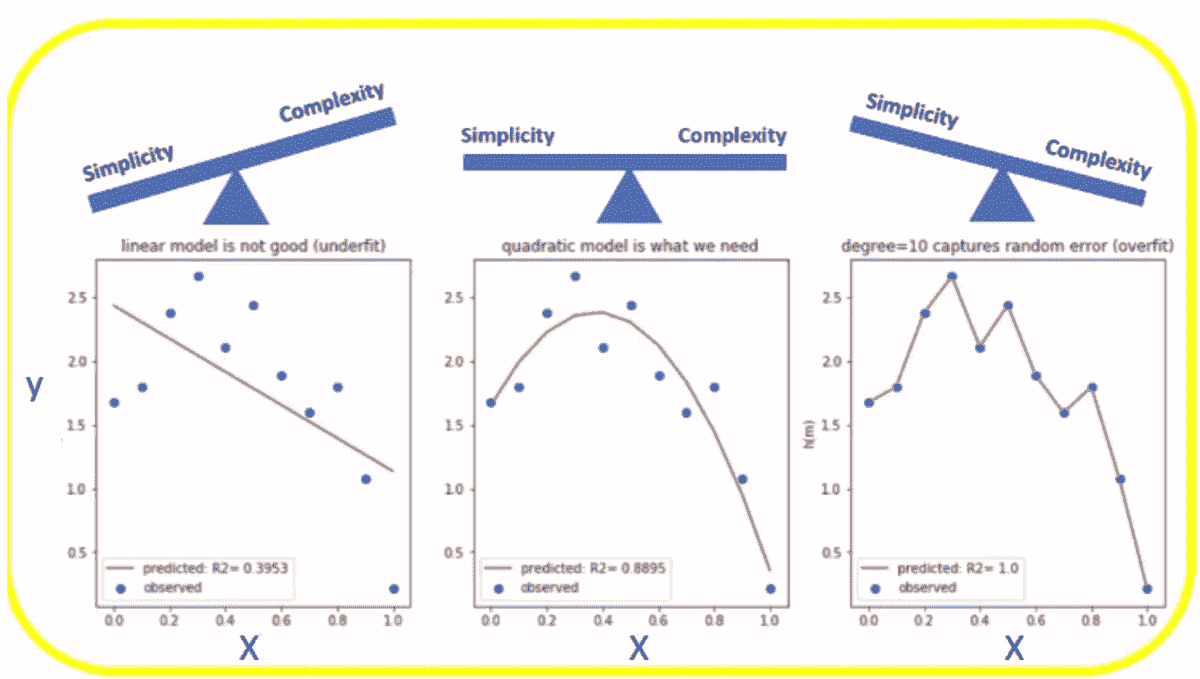

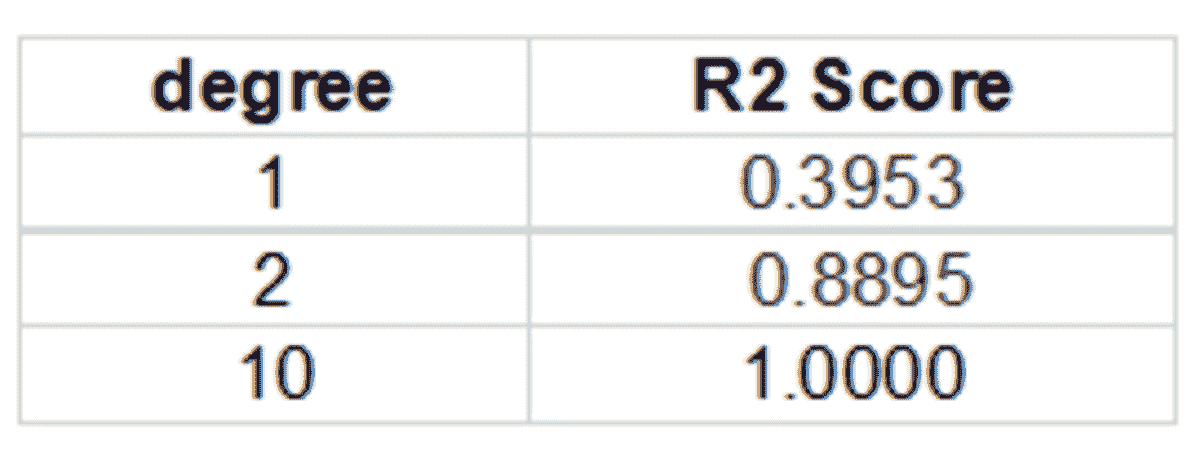

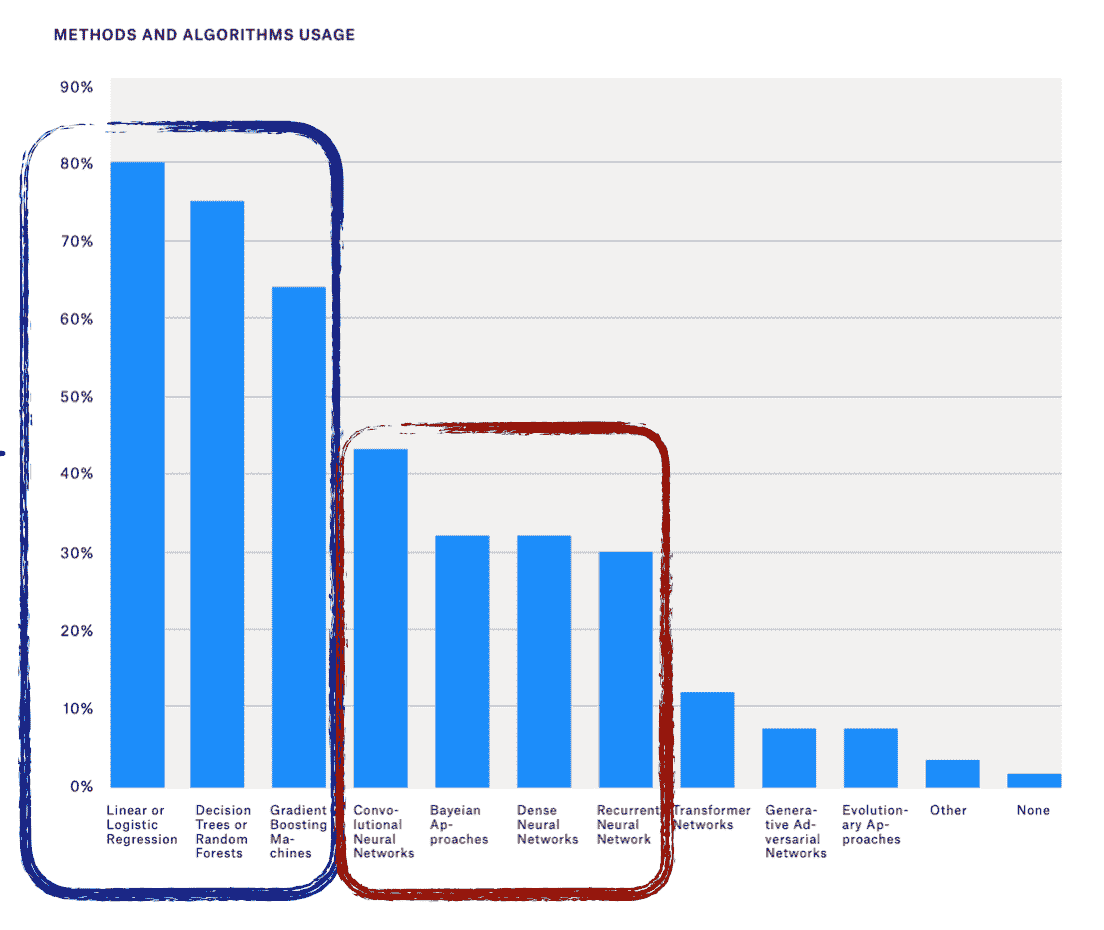

基线建模

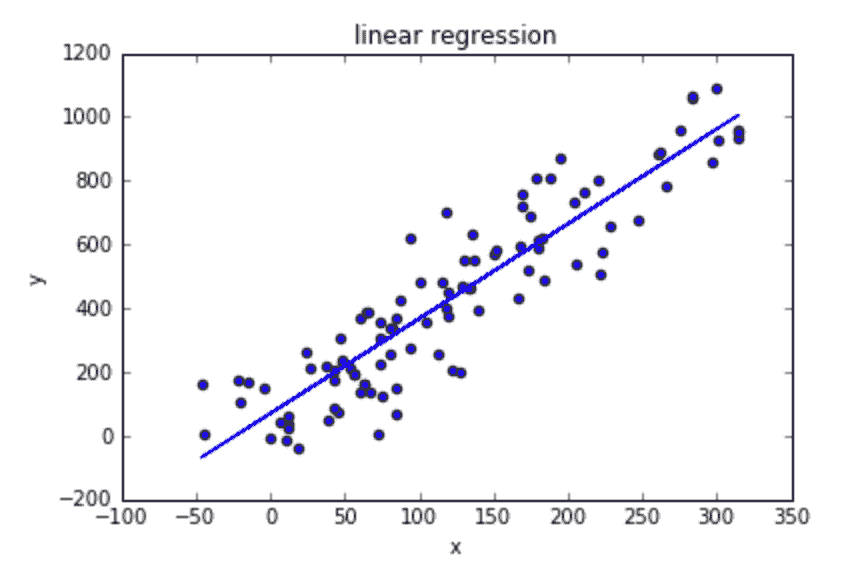

作为数据科学家,你将构建许多使用不同算法的模型来执行不同任务。在处理任务的初期,值得避免使用复杂的高级模型,而是坚持使用更简单、更传统的线性回归用于回归问题,逻辑回归用于分类问题作为基线,从而进行改进。

在模型预处理阶段,你可以将特征与依赖变量分开,缩放数据,并使用训练-测试拆分或交叉验证来防止模型过拟合——过拟合是指模型过于紧密地跟踪训练数据,并且在新数据上表现不佳的问题。

模型准备好后,可以在训练数据上进行拟合,并通过预测X_test数据的y值来进行测试。最后,使用适合任务的评估指标来评估模型,如回归问题的R 平方和分类任务的准确率或ROC-AUC分数。

次级建模

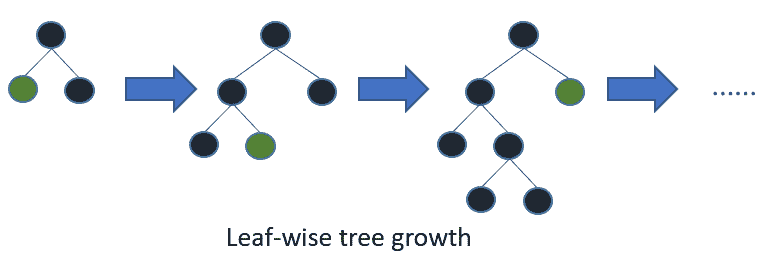

现在是进行更深入分析的时候,如果需要,可以使用更高级的模型,如神经网络、XGBoost或随机森林。重要的是要记住,这些模型可能因为数据集较小无法提供足够的数据或特征之间存在共线性问题而最初表现得比简单易懂的模型差。

因此,次级建模步骤的关键任务是参数调优。每种算法都有一组可以优化的参数。参数是机器学习技术用于调整数据的变量。超参数是管理训练过程本身的变量,如神经网络中的节点数或隐藏层数,通过运行整个训练过程、查看整体准确性并进行调整来进行调优。

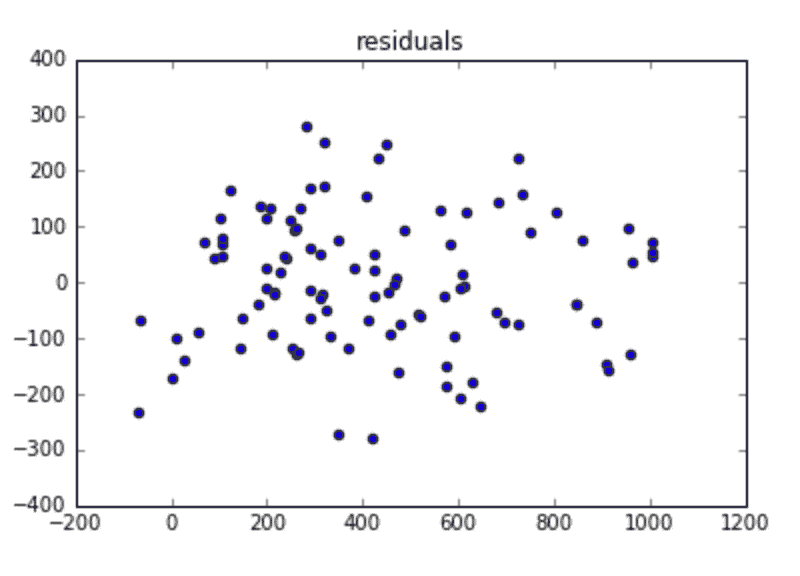

反思阶段

数据科学家经常在分析和反思阶段之间交替进行:分析阶段专注于编程,而反思阶段涉及对分析结果的思考和沟通。在检查一组输出文件后,数据科学家或数据科学家团队可以比较输出变体,通过调整脚本代码和/或执行参数来探索替代路径。数据分析过程中的许多部分是试错的:科学家运行测试,绘制输出图形,然后重新运行测试,重新绘制图形,依此类推。因此,图形是主要的比较工具,可以并排显示在显示器上以便直观地比较和对比它们的特征。补充工具包括记笔记,既有纸质的也有数字的,以跟踪思路和实验过程。

交流阶段

数据科学的最终阶段是传播结果,这些结果可以是数据科学产品的形式,也可以是书面报告,例如内部备忘录、幻灯片演示、业务/政策白皮书或学术研究出版物。

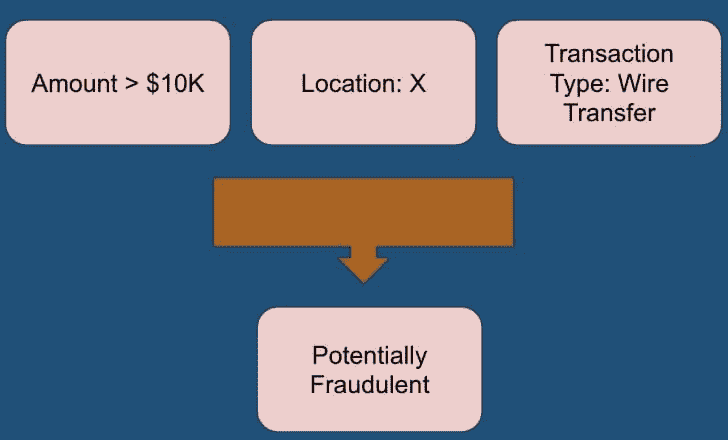

数据科学产品意味着将你的模型投入生产。在大多数公司中,数据科学家将与软件工程团队合作编写生产代码。该软件既可以用于重现实验或测试原型系统,也可以作为独立解决方案来应对市场上的已知问题,例如评估金融欺诈的风险。

另外,你还可以创建数据科学报告。你可以通过演示展示你的结果,并提供过程的技术概述。记住要考虑你的观众:如果是向数据科学同行展示,可以详细说明;如果是向销售团队或高管汇报,则应关注发现。如果公司允许发布结果,这也是获得其他专家反馈的好机会。此外,你还可以写博客文章,并将代码推送到 GitHub,以便数据科学社区可以从你的成功中学习。沟通结果是科学过程的重要部分,因此这一阶段不应被忽视。

原文。已获授权转载。

简介: SciForce 是一家总部位于乌克兰的 IT 公司,专注于基于科学驱动的信息技术的软件解决方案开发。我们在许多关键 AI 技术方面拥有广泛的专业知识,包括数据挖掘、数字信号处理、自然语言处理、机器学习、图像处理和计算机视觉。

相关:

更多相关话题

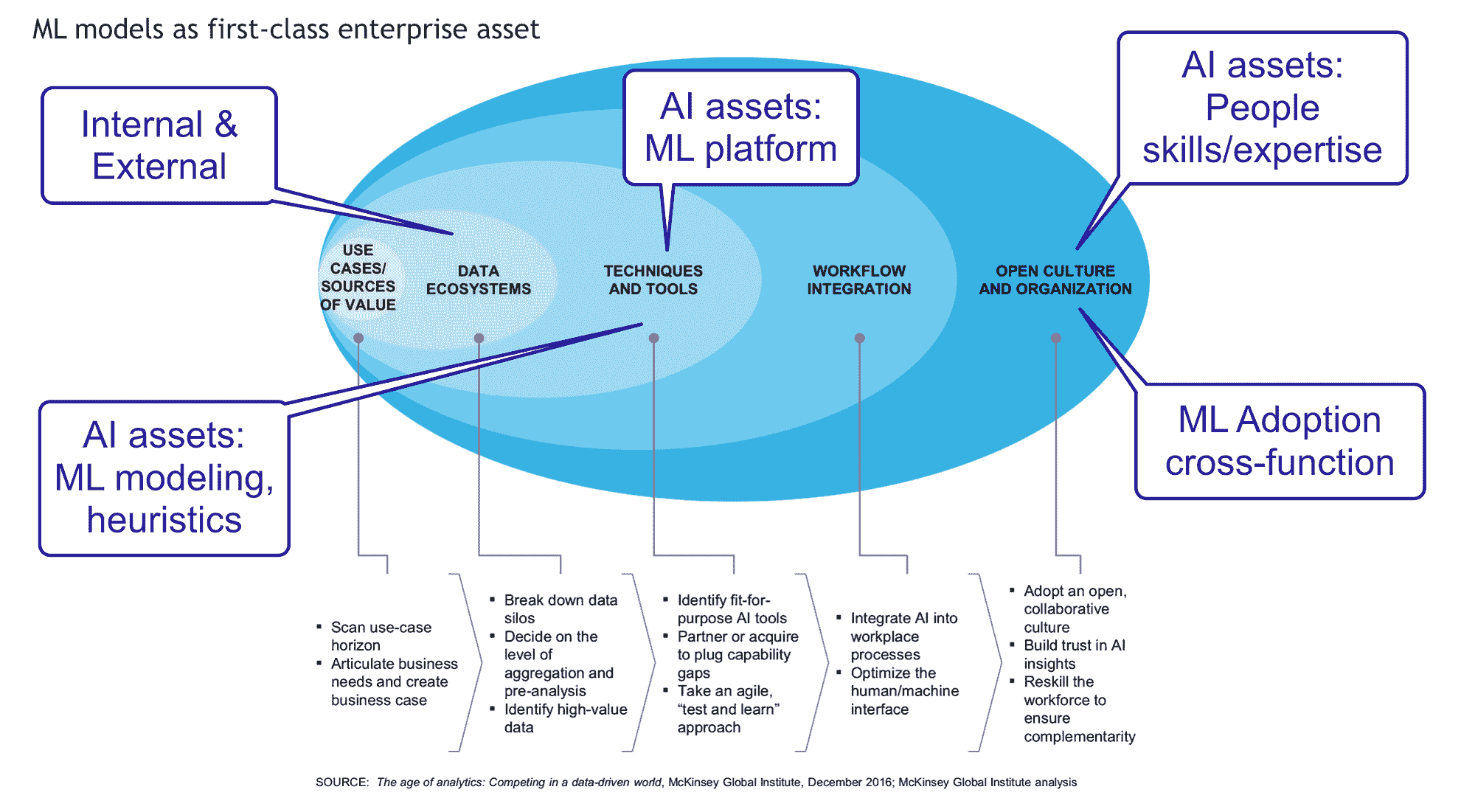

精益六西格玛如何帮助机器学习?

原文:

www.kdnuggets.com/2016/11/lean-sigma-six-help-machine-learning.html

评论

评论

作者:Joseph Chen,高级管理人员及 BI、数据仓库、六西格玛和运筹学领域的架构师。

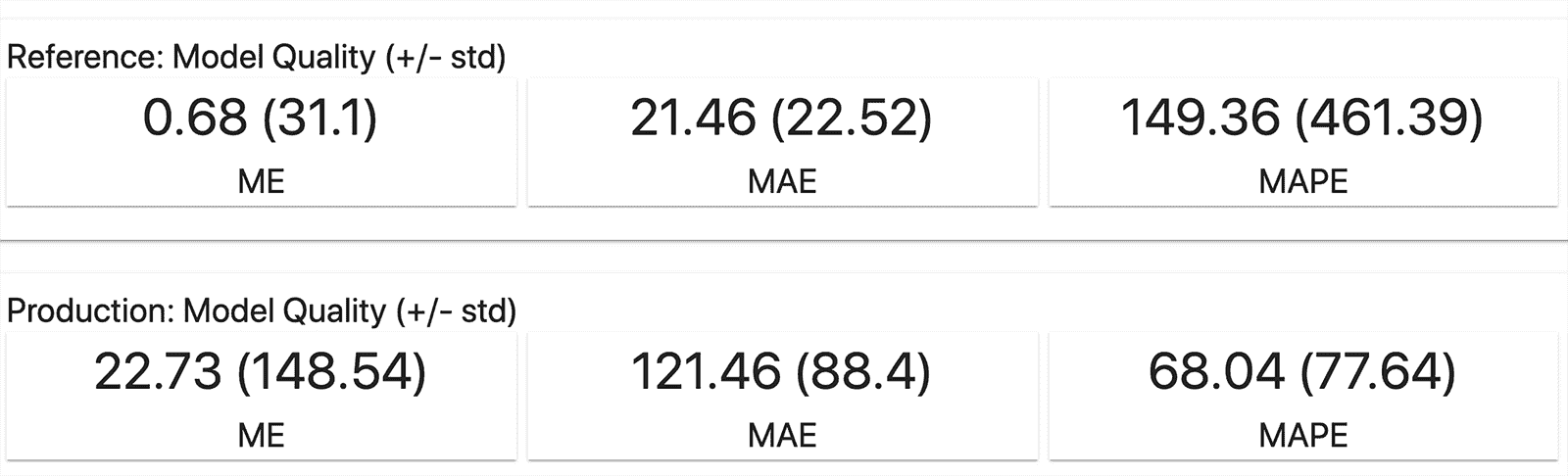

引言

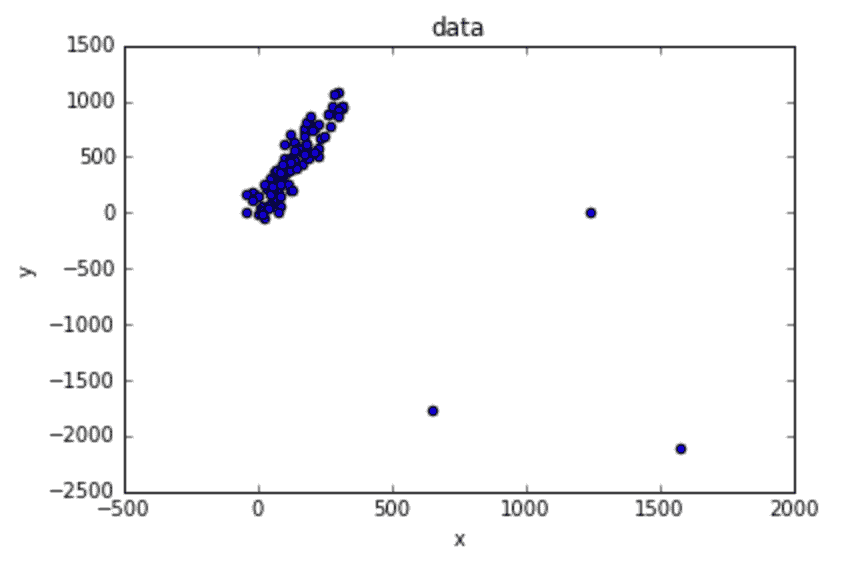

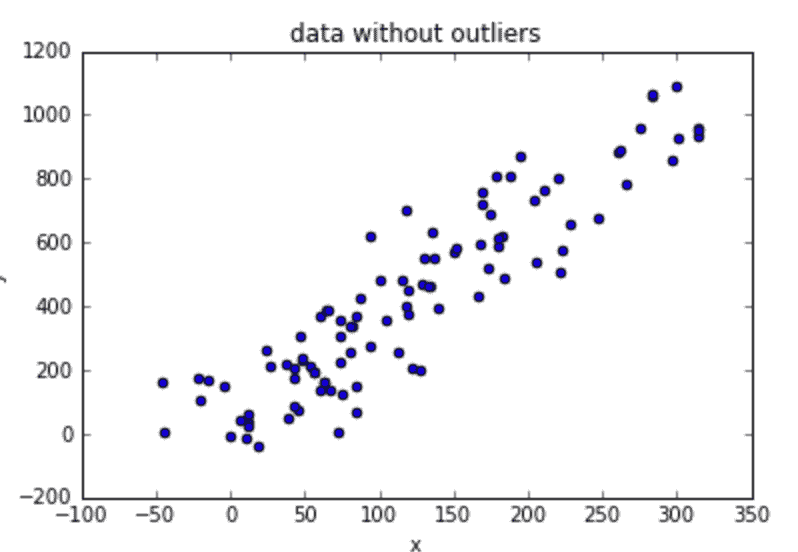

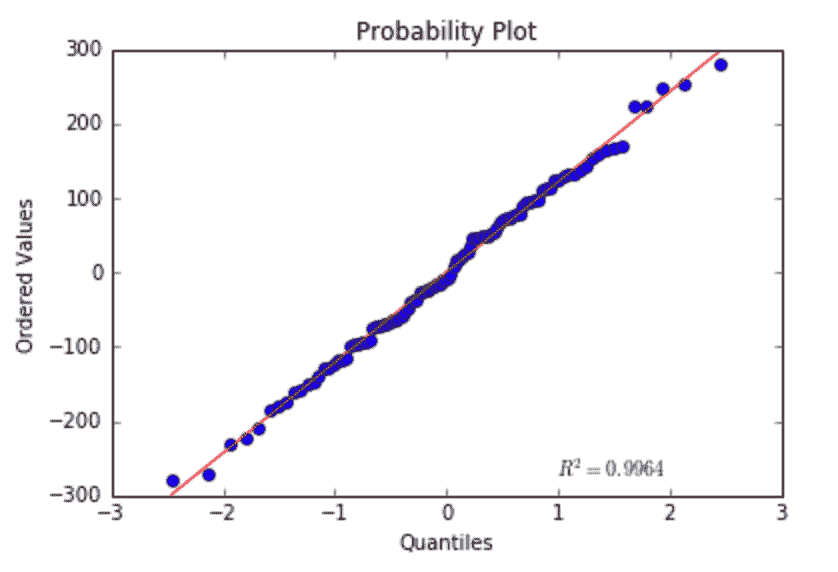

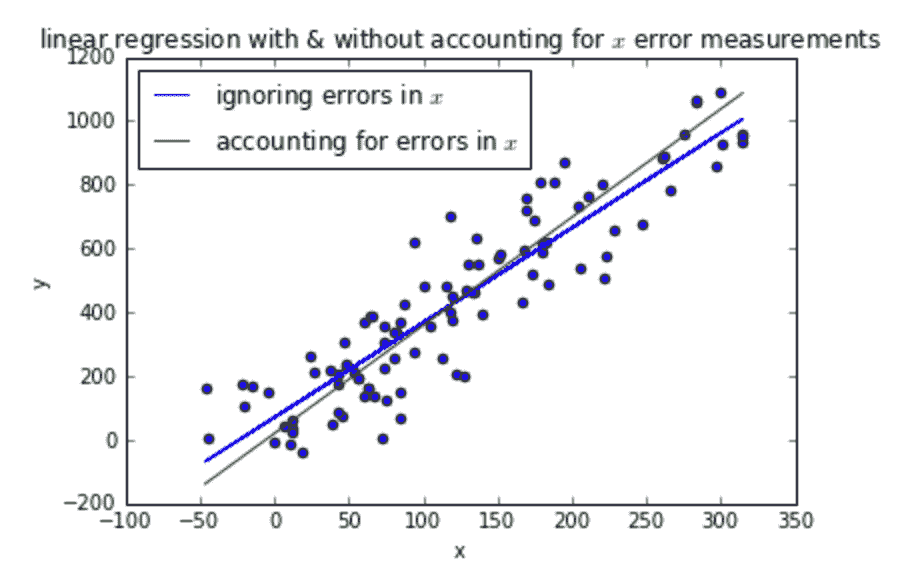

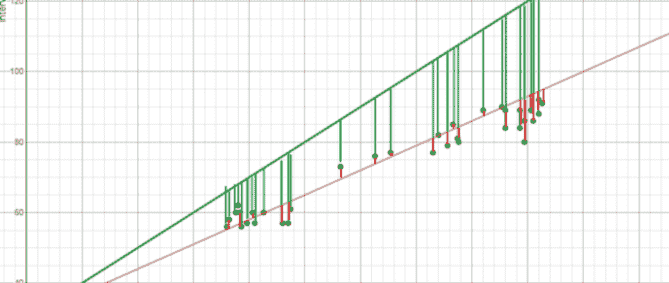

在过去 10 多年中,我一直在使用精益六西格玛(LSS)来改进业务流程,对其效果非常满意。最近,我与一家咨询公司和一位软件供应商合作,实施了一个机器学习(ML)模型,以预测服务部件的剩余使用寿命(RUL)。让我感到最沮丧的是模型的准确性较低。如下面所示,如果人们将偏差测量为实际部件寿命与预测寿命之间的绝对差异,所得到的模型对选定的 3 个部件的平均偏差分别为 127 天、60 天和 36 天。我无法理解为什么机器学习的偏差如此之大。

在与顾问和数据科学家合作后,他们似乎只能通过数据清理将偏差改善 10%。这让我感到非常困惑。对我来说,即便在 10%的改善之后,这种偏差仍然使得预测对业务负责人来说毫无用处。这迫使我问自己以下问题:

-

机器学习真的适合作为预测工具吗?

-

人们对机器学习了解不足的是什么?

-

机器学习中缺少了什么?精益六西格玛能填补这个空缺吗?

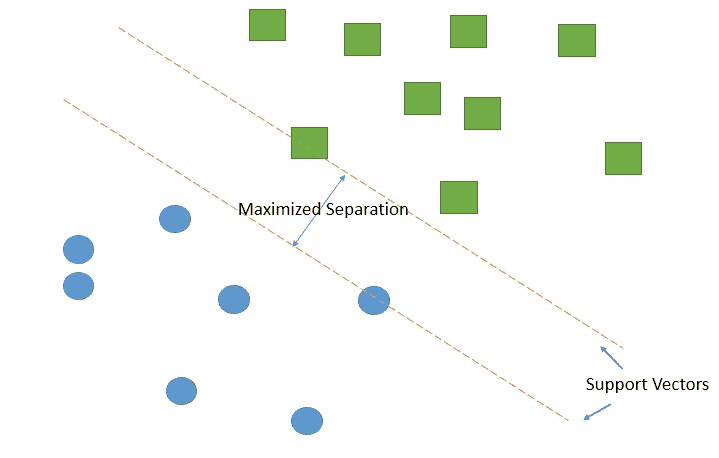

精益六西格玛

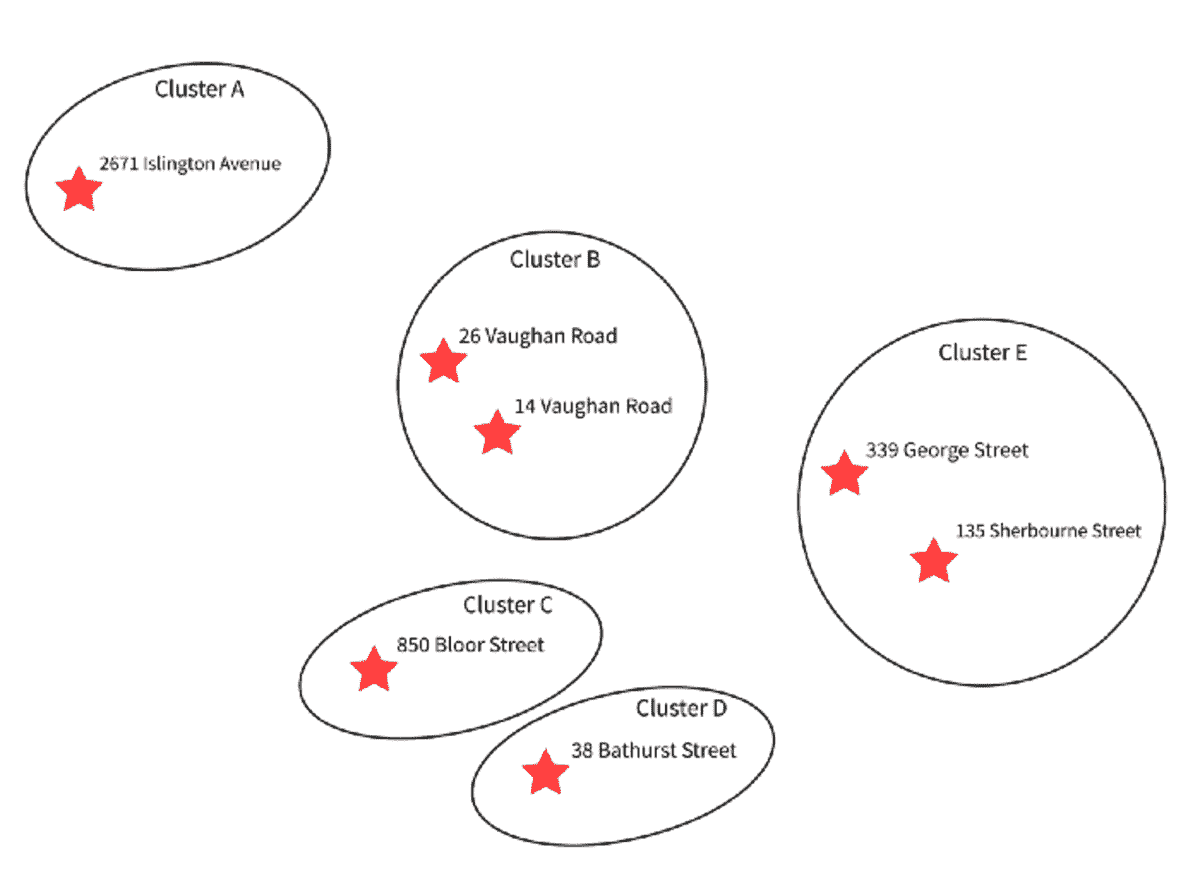

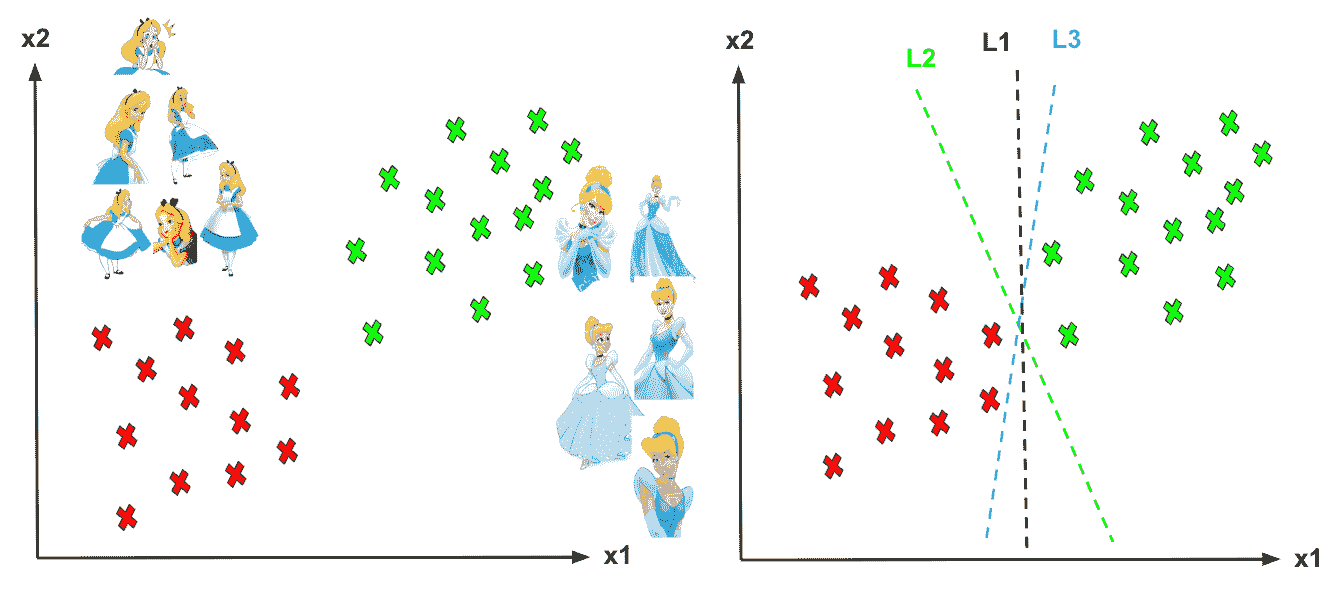

精益六西格玛(LSS)的目标是通过减少过程的方差来提高过程性能。方差定义为 LSS 实际值与预测值之间的平方差和。LSS 的结果本质上是一个统计函数(模型),它在一组输入/自变量和输出/因变量之间建立关系,如下图所示。

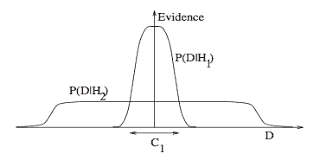

通过识别输入变量与输出变量之间的相关性,LSS 模型告诉我们如何控制输入变量,以使输出变量达到我们的目标值。最重要的是,LSS 还要求被监控的过程是“稳定”的,即通过减少输入变量的方差来最小化输出变量的方差,从而达到所谓的“突破”状态。

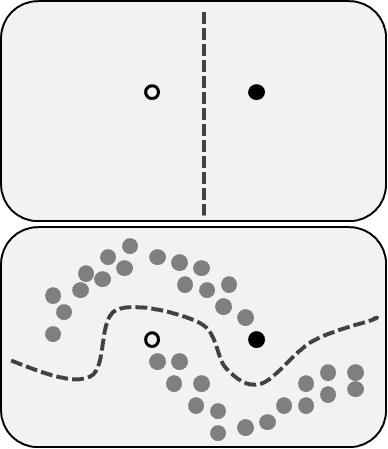

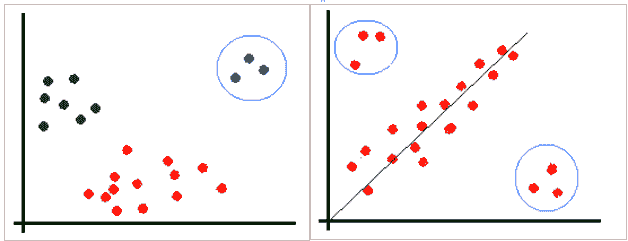

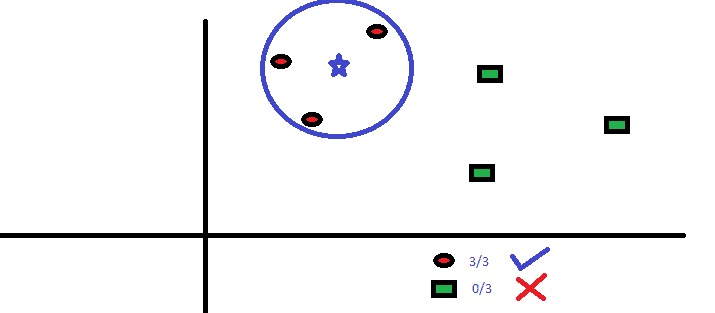

如下图所示,如果你在没有方差控制的情况下(左图中目标周围的分布)独自达到目标(中心),就无法保证你达到了目标;如果在没有达到目标的情况下减少方差(右图),则会错过目标。只有通过保持方差小且集中,LSS 才能确保过程目标以精确的精度和可持续的最佳过程性能达成。这是 LSS 的主要贡献。

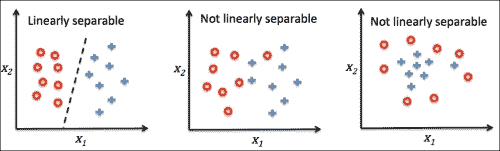

机器学习(ML)

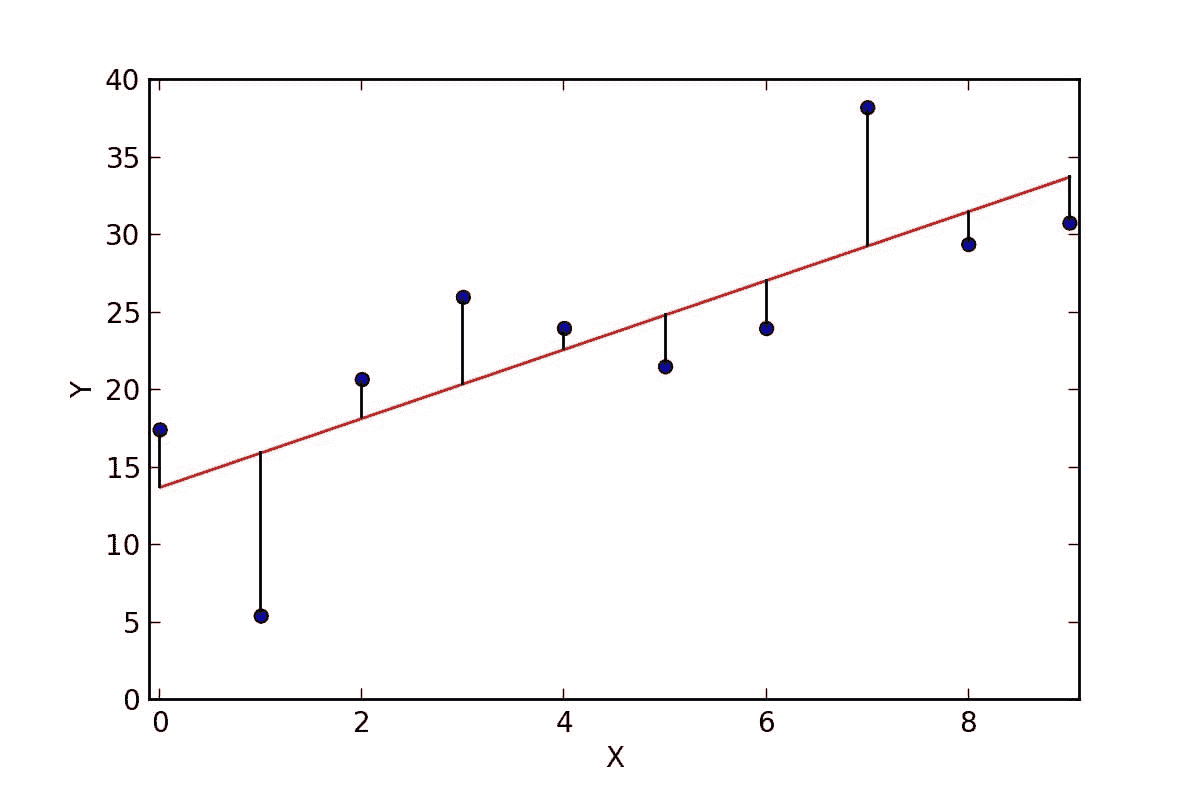

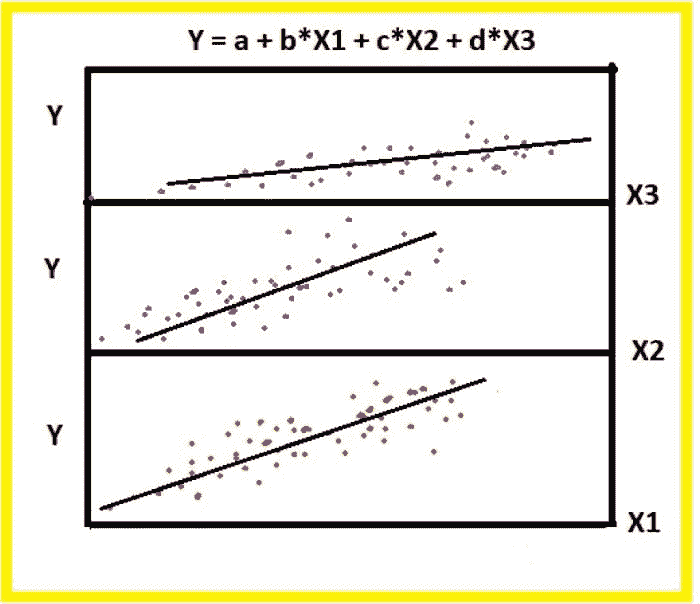

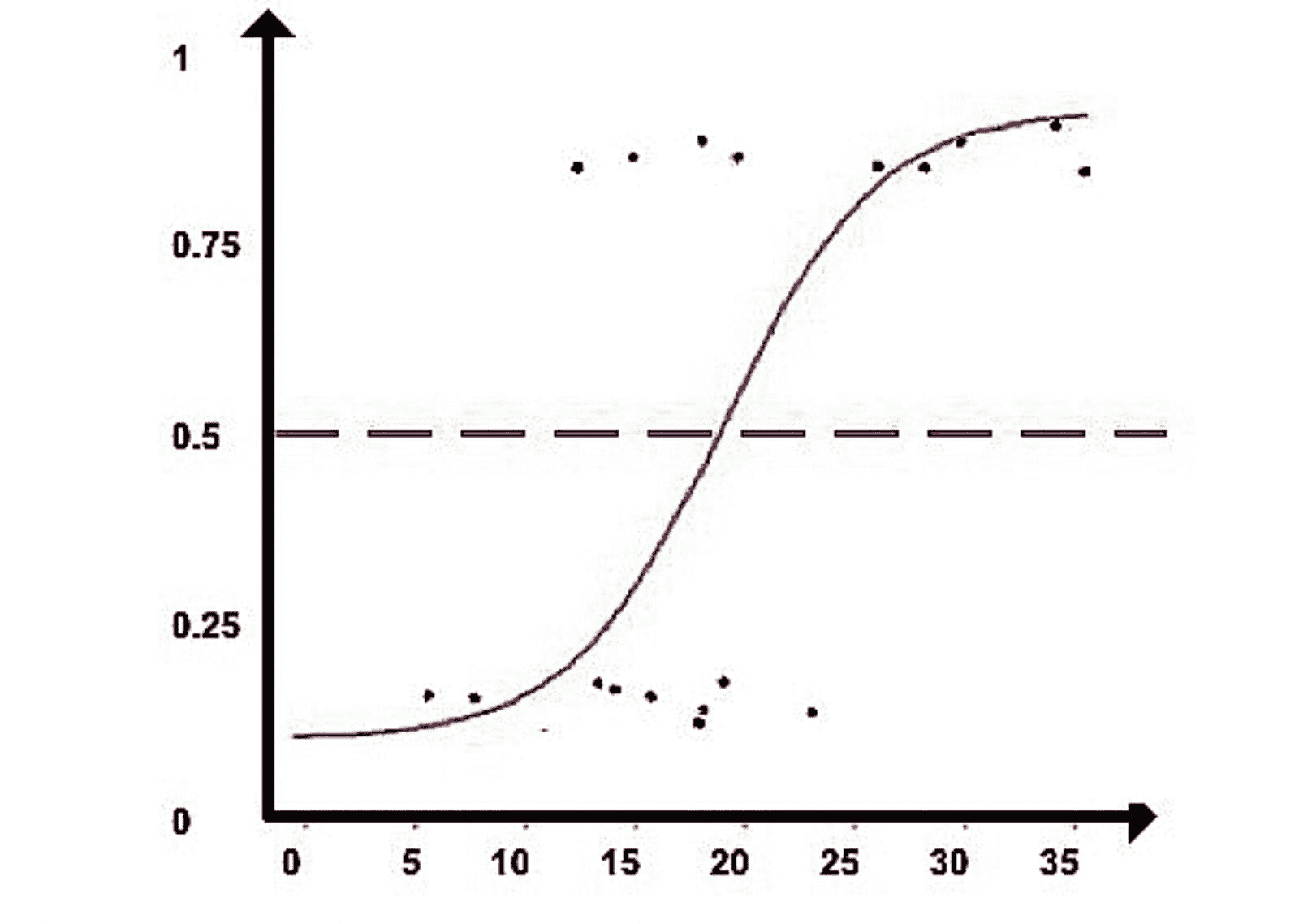

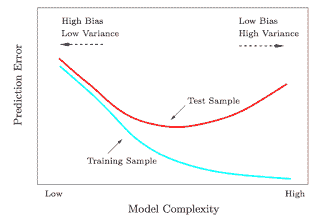

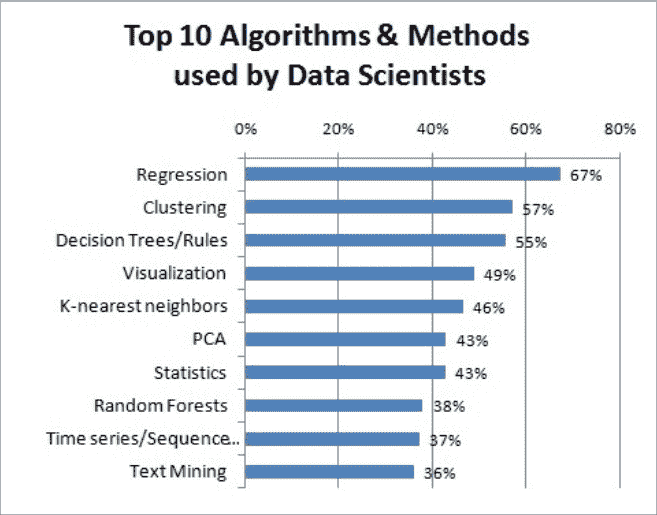

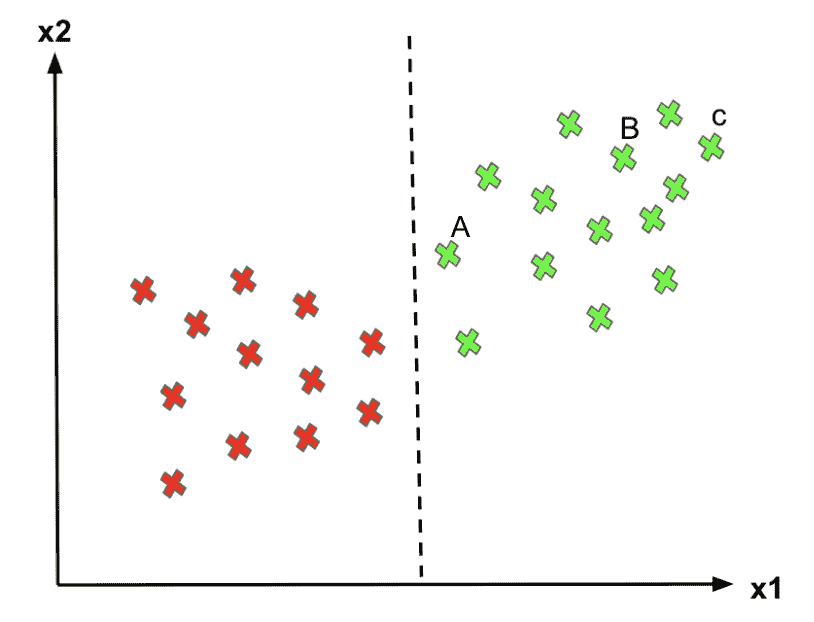

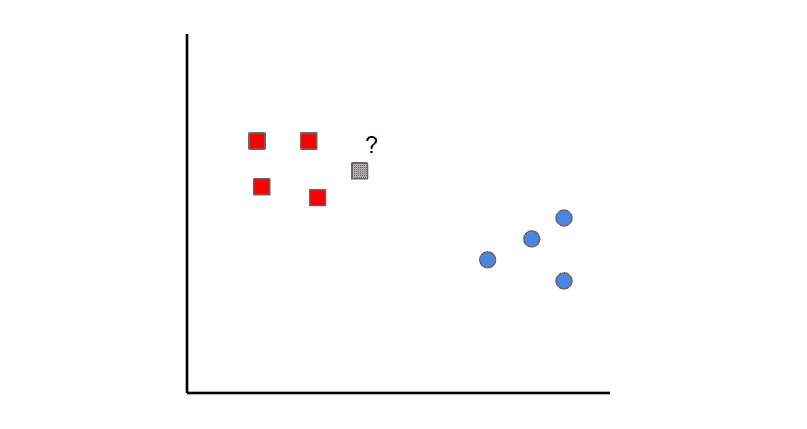

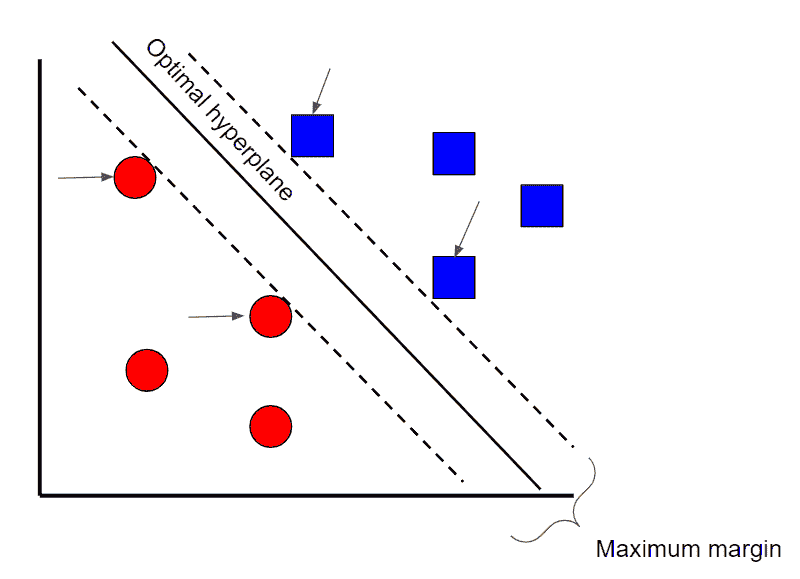

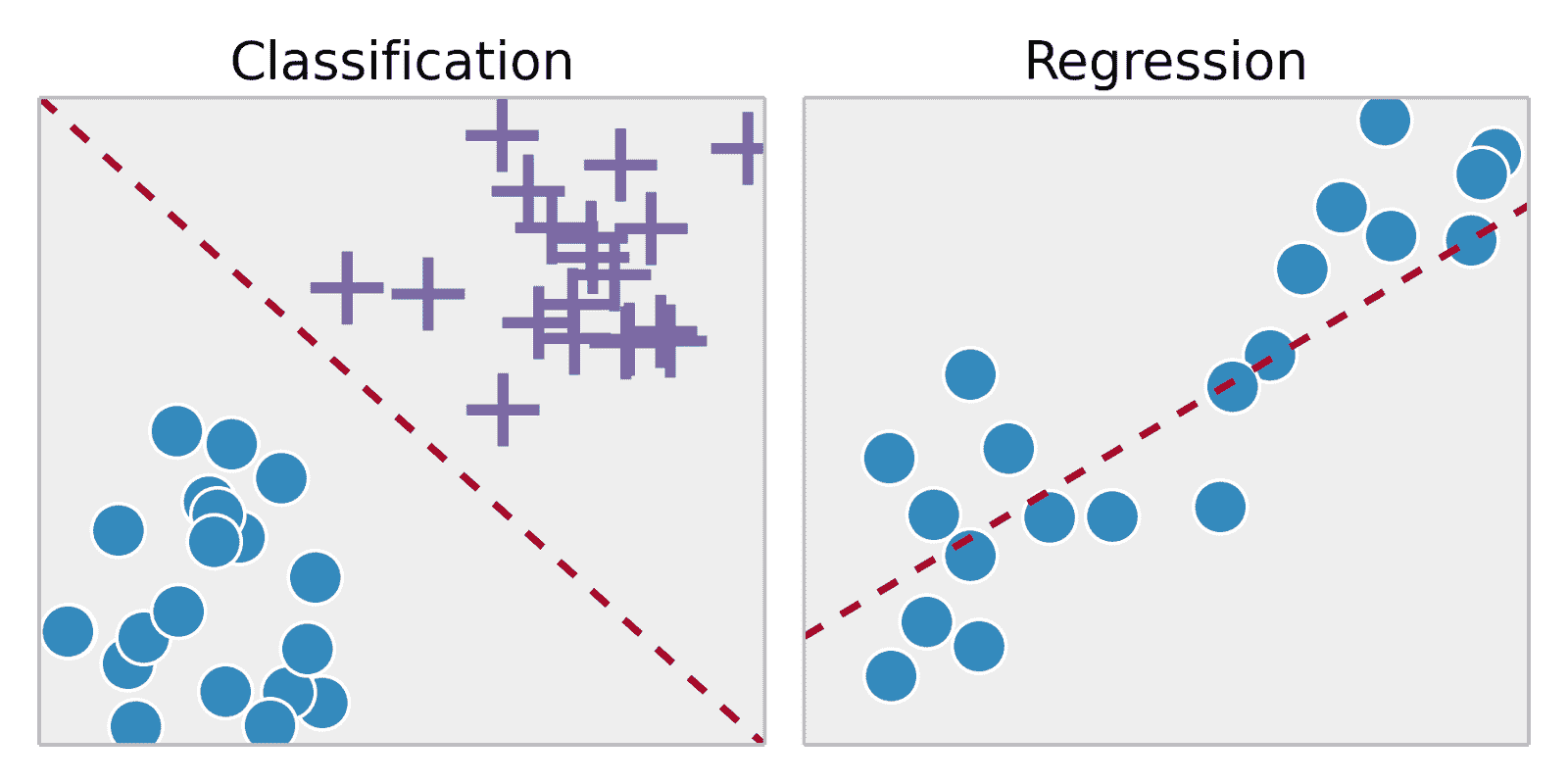

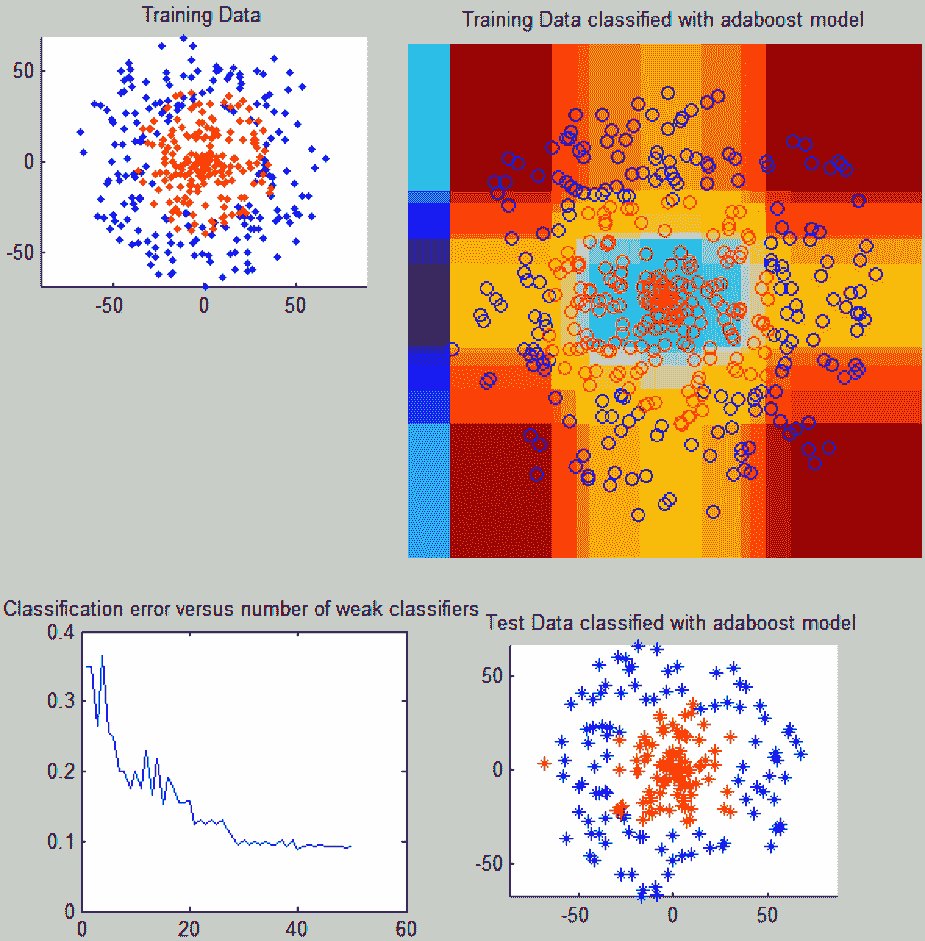

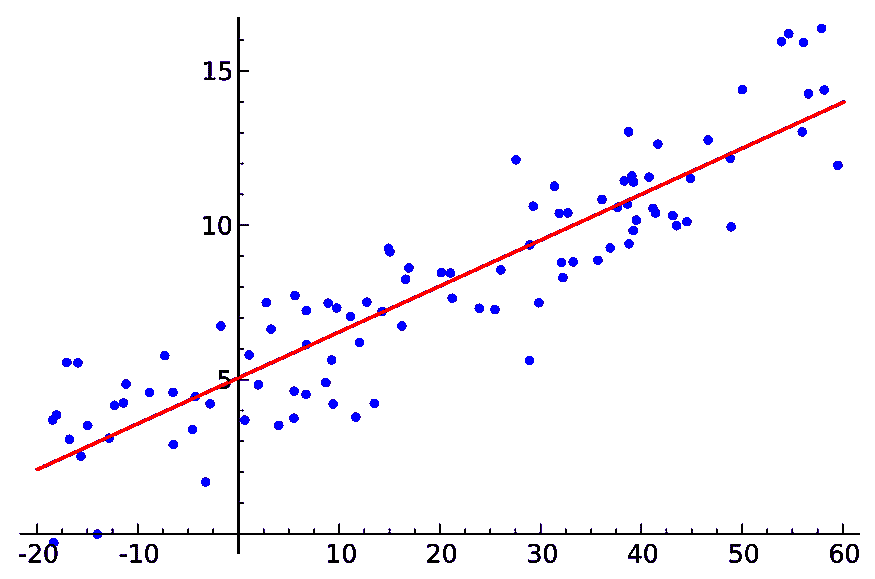

对于有监督机器学习,它关注输入变量集与输出变量之间的函数,以得出“近似”理想函数,如下图中的绿色曲线所示。

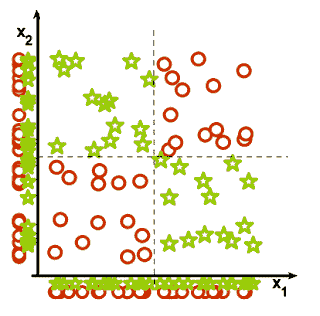

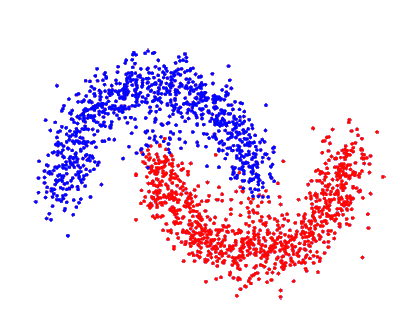

同样,对于无监督机器学习,它寻找能够最好地区分一组簇的函数。

LSS 与 ML 的比较

众所周知,由于偏差和正常随机性,过程本质上是随机的;即,过程具有方差。因此,经典统计学和 LSS 都表明,如果输入变量具有较大方差,我们会预期输出变量也会有较大的方差。

如果 Y=a[1]x[1]+a[2]x[2]+...+a[n]x[n],则 Var(Y)=a[1]²Var(x[1])+a[2]²Var(x[2])+...+a[n]²Var(x[n])。

这强烈暗示了当输入变量具有较大方差时,机器学习模型的不准确性。这就是为什么我认为我最近的机器学习项目在预测中有如此大的不准确性,以及数据清洗只能提高准确性最多 10%的原因。

人们可能会争论数据清洗是否能提高预测质量。问题在于,机器学习(ML)中的数据清洗与最小二乘法(LSS)的方差减少不同。在 LSS 中,人们会回顾业务过程以寻找输入变量的方差源,以消除偏差或减少这些输入变量(因素)的方差;而在 ML 中,人们不会回顾业务过程;相反,ML 中的人们只是尝试纠正数据错误或消除无意义的数据。因此,这种数据清洗方法实际上并不会减少方差;实际上,它可能不会改变输入方差。因此,如果人们不了解方差的作用,ML 模型可能不会很好地工作。

例如,如果下图左侧的图表代表数据清洗后的数据点,我们会得到红色曲线作为最优 ML。但是,如果下图右侧的图表代表方差减少后的数据点,得到的 ML 模型会更加准确。

总结来说,我认为当前机器学习模型的数据清洗需要包含 LSS 的方差减少技术,以便为监督学习和无监督学习提供准确、可靠和有效的模型。人们需要花费精力审查潜在的业务流程,以减少输入方差,使其更好地解决现实世界的问题。

软件供应商和数据科学咨询公司应在机器学习的数据清洗阶段采用方差减少技术,以提供机器学习的实际价值。

简历:Joseph Chen 是一名六西格玛黑带,以及数据科学、商业智能和数据仓库的首席架构师。他拥有运筹学、信息科学和工业工程的学位,具有超过 18 年的高级分析、商业智能、数据仓库、精益六西格玛、流程优化、运营分析等领域的工作经验。

相关:

-

伟大的算法教程汇总

-

数据科学基础:数据挖掘与统计学

-

数据准备技巧、窍门和工具:与业内专家的访谈

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

更多相关话题

免费学习普林斯顿大学的计算机科学!

原文:

www.kdnuggets.com/learn-computer-science-with-princeton-university-for-free

图片来源:作者

当你考虑转行时,首先想到的就是选择哪个课程,是否回到大学,如何开始?不妨从免费的课程开始!!

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业

1. Google 网络安全证书 - 快速进入网络安全职业

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

技术世界不断发展,越来越多的组织正在寻找快速实现数字化的新方法!因此,他们需要计算机科学家、数据科学家、软件工程师等的帮助。这些不同类型的技术专业人员的共同点是他们的计算机科学知识。

计算机科学是他们技能的核心,不容错过!

在这篇博客中,我将介绍 6 个课程,这些课程将为你提供发展计算机科学职业所需的知识和技能。

计算机科学:有目的的编程

链接:计算机科学:有目的的编程

级别:初级

经验要求:无需先前经验

时长:88 小时完成或每周 29 小时,共 3 周

进度:灵活的时间安排

模块数:10

在这个课程中,你将学习基本的编程元素,如变量、条件语句、循环、数组和输入/输出,然后学习函数,介绍关键概念,如递归、模块化编程和代码重用。你还将接触到面向对象的编程。

该课程使用 Java 编程语言,教授解决计算问题的基本技能,这些技能适用于许多现代计算环境。目标是掌握 Java 的基础概念,重点不是 Java 本身。

计算机科学:算法、理论与机器

级别:中级

经验要求:计算机科学:推荐《有目的的编程》(见上文)

时长:20 小时完成或每周 6 小时,共 3 周

进度:灵活的时间安排

模块数:11

在本课程中,你将学习经典算法以及评估性能的科学技术,结合现代应用进行介绍。接下来,你将进入经典理论模型的学习,这些模型帮助我们解决关于计算的基本问题,如可计算性、普遍性和难解性。

你将学习机器体系结构(包括机器语言编程及其与 Java 编码的关系)和逻辑设计(包括从零开始构建的完整 CPU 设计)。

本课程强调应用编程、计算理论、真实计算机以及该领域的历史和发展之间的关系,包括布尔、香农、图灵、冯·诺依曼等人的贡献性质。

算法,第 I 部分

链接:算法,第 I 部分

级别:中级

经验:推荐具备计算机科学:算法、理论和机器(见上文)

时长:54 小时完成或 3 周,每周 18 小时

进度:灵活安排

模块:13

在本课程中,你将深入探讨算法和数据结构,重点是应用和 Java 实现的科学性能分析。第 I 部分涵盖了基本数据结构、排序和搜索算法。你对算法的理解必须清晰透明。随着你在计算机科学领域的发展,你将频繁参考算法,因此对算法的知识至关重要。

算法,第 II 部分

链接:算法,第 II 部分

级别:中级

经验:推荐完成算法第 I 部分(见上文)

时长:62 小时完成或 3 周,每周 20 小时

进度:灵活安排

模块:14

本课程是算法部分的第 II 部分,重点关注图和字符串处理算法。例如,你将学习无向图/有向图、最小生成树、正则表达式、数据压缩等。

算法分析

链接:算法分析

级别:高级

经验:推荐完成算法第 I 部分和第 II 部分(见上文)

时长:20 小时完成或 3 周,每周 6 小时

进度:灵活安排

模块:9

本课程将涵盖生成函数和实际渐进分析。你还将学习符号方法在算法分析中的应用,并涵盖基本结构,如排列、树、字符串、词语和映射。

计算机体系结构

链接:计算机体系结构

级别:高级

时长:49 小时完成或 3 周,每周 16 小时

进度:灵活安排

模块:21

如果你想超越基础,全面了解计算机科学的各个方面,我推荐这门计算机体系结构课程。在这门课程中,你将学习设计复杂现代微处理器的计算机体系结构。你将学习到流水线审核、缓存、超标量、内存保护、并行编程等内容。

总结

在开始新的过渡时,充分利用免费资源应该是你的首选!在这篇文章中,我为你提供了一条启动计算机科学学习之旅的路线图,而无需花费一分钱。

尼莎·阿雅 是一名数据科学家、自由技术写作人员,同时也是 KDnuggets 的编辑和社区经理。她特别关注提供数据科学职业建议或教程以及基于理论的数据科学知识。尼莎涵盖了广泛的主题,并希望探索人工智能如何有利于人类寿命的不同方式。作为一名热衷学习者,尼莎致力于拓宽她的技术知识和写作技能,同时帮助指导他人。

更多相关内容

学习 Julia 数据分析

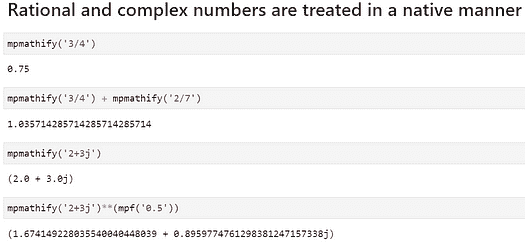

图片作者

Julia 是另一种编程语言,类似于 Python 和 R。它结合了 C 语言的速度和 Python 的简洁性。Julia 在数据科学领域越来越受欢迎,所以如果你想扩展你的技能并学习一种新语言,你来对地方了。

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

在本教程中,我们将学习如何为数据科学设置 Julia,加载数据,进行数据分析,然后进行可视化。这个教程非常简单,以至于任何人,包括学生,都可以在 5 分钟内开始使用 Julia 进行数据分析。

1. 设置你的环境

-

下载 Julia 并通过访问 (julialang.org) 安装包。

-

现在我们需要为 Jupyter Notebook 设置 Julia。启动一个终端(PowerShell),输入

julia启动 Julia REPL,然后输入以下命令。

using Pkg

Pkg.add("IJulia")

-

启动 Jupyter Notebook,并以 Julia 作为内核开始新的笔记本。

-

创建新的代码单元,并输入以下命令以安装必要的数据科学包。

using Pkg

Pkg.add("DataFrames")

Pkg.add("CSV")

Pkg.add("Plots")

Pkg.add("Chain")

2. 加载数据

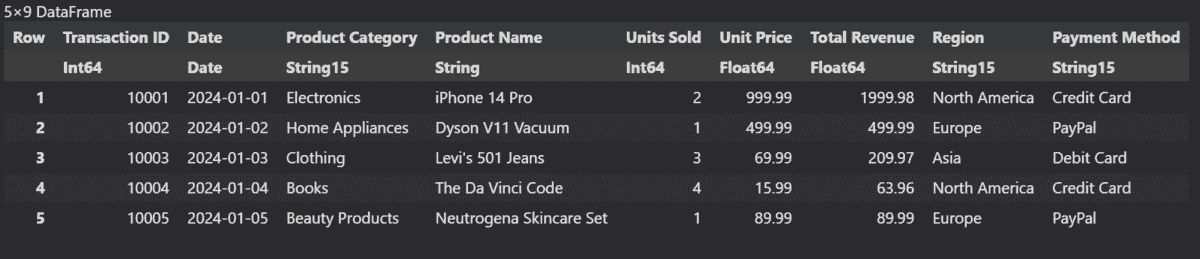

对于这个示例,我们使用来自 Kaggle 的 在线销售数据集。它包含了不同产品类别的在线销售交易数据。

我们将加载 CSV 文件并将其转换为 DataFrames,这类似于 Pandas DataFrames。

using CSV

using DataFrames

# Load the CSV file into a DataFrame

data = CSV.read("Online Sales Data.csv", DataFrame)

3. 探索数据

我们将使用 'first' 函数,而不是 head 来查看 DataFrame 的前 5 行。

first(data, 5)

要生成数据摘要,我们将使用 describe 函数。

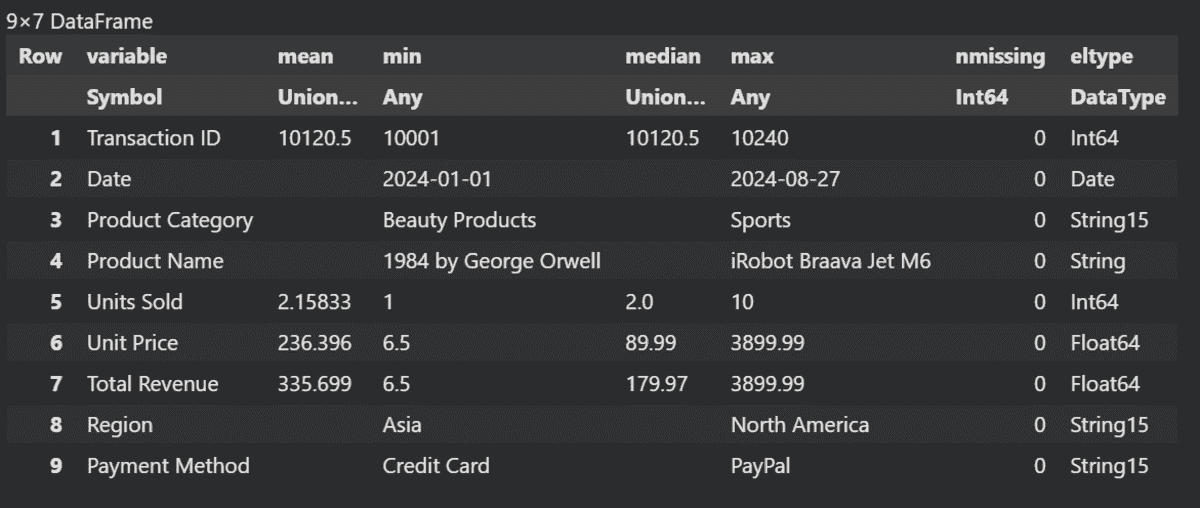

describe(data)

类似于 Pandas DataFrame,我们可以通过提供行号和列名来查看特定值。

data[3,"Product Name"]

输出:

"Levi's 501 Jeans"

4. 数据操作

我们将使用 filter 函数根据特定值过滤数据。它需要列名、条件、值和 DataFrame。

filtered_data = filter(row -> row[:"Unit Price"] > 230, data)

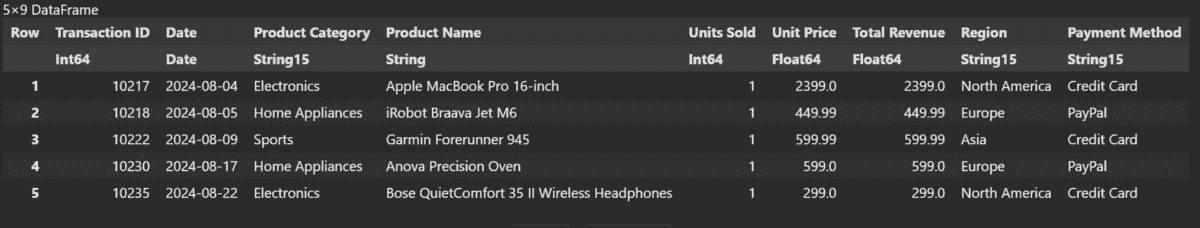

last(filtered_data, 5)

我们也可以创建一个类似于 Pandas 的新列。这么简单。

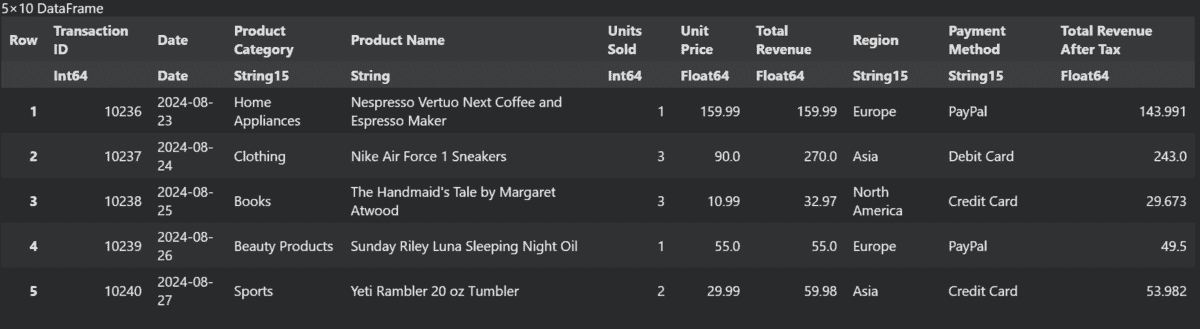

data[!, :"Total Revenue After Tax"] = data[!, :"Total Revenue"] .* 0.9

last(data, 5)

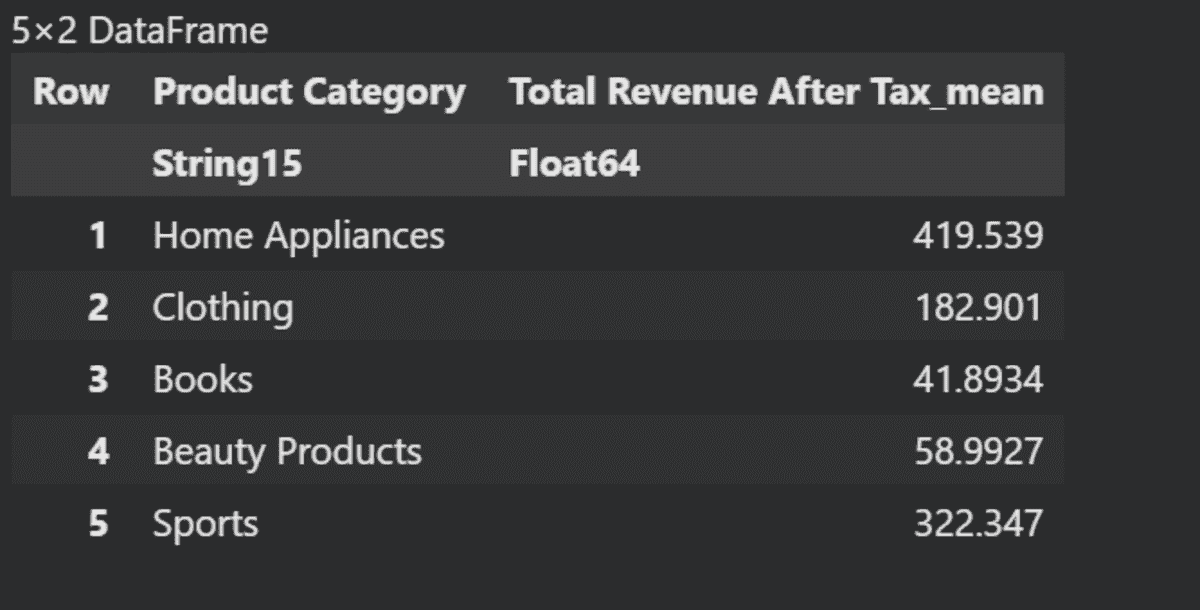

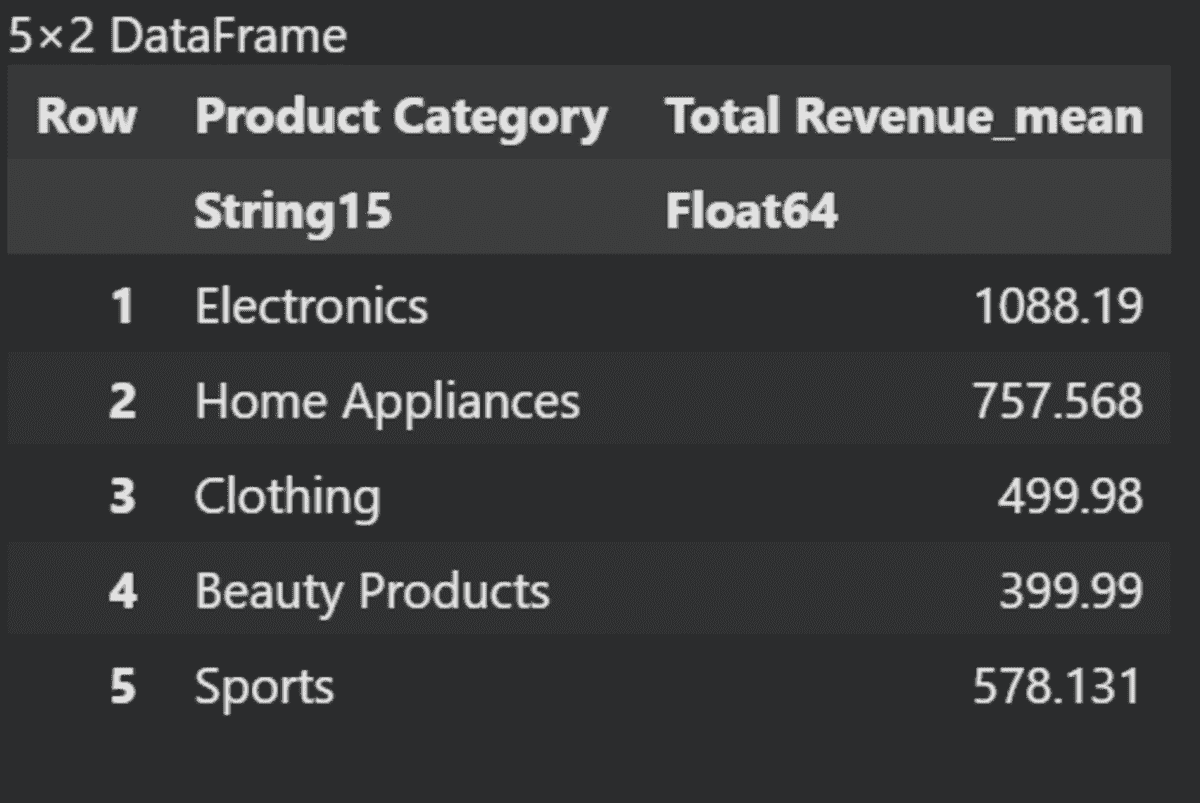

现在,我们将基于不同的“产品类别”计算“税后总收入”的均值。

using Statistics

grouped_data = groupby(data, :"Product Category")

aggregated_data = combine(grouped_data, :"Total Revenue After Tax" .=> mean)

last(aggregated_data, 5)

5. 可视化

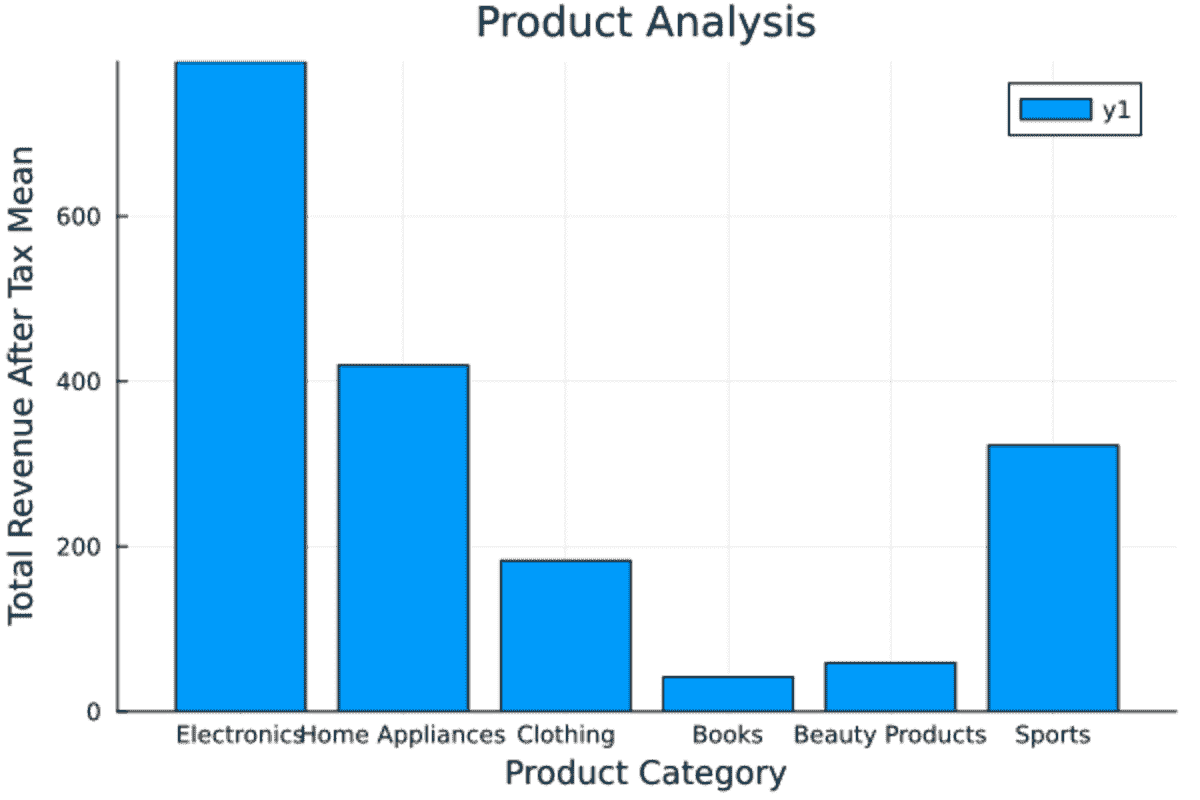

可视化类似于 Seaborn。在我们的案例中,我们正在可视化最近创建的汇总数据的条形图。我们将提供 X 和 Y 列,然后是标题和标签。

using Plots

# Basic plot

bar(aggregated_data[!, :"Product Category"], aggregated_data[!, :"Total Revenue After Tax_mean"], title="Product Analysis", xlabel="Product Category", ylabel="Total Revenue After Tax Mean")

总均收入的大部分是通过电子产品产生的。可视化效果完美且清晰。

要生成直方图,我们只需提供 X 列和标签数据。我们希望可视化销售商品的频率。

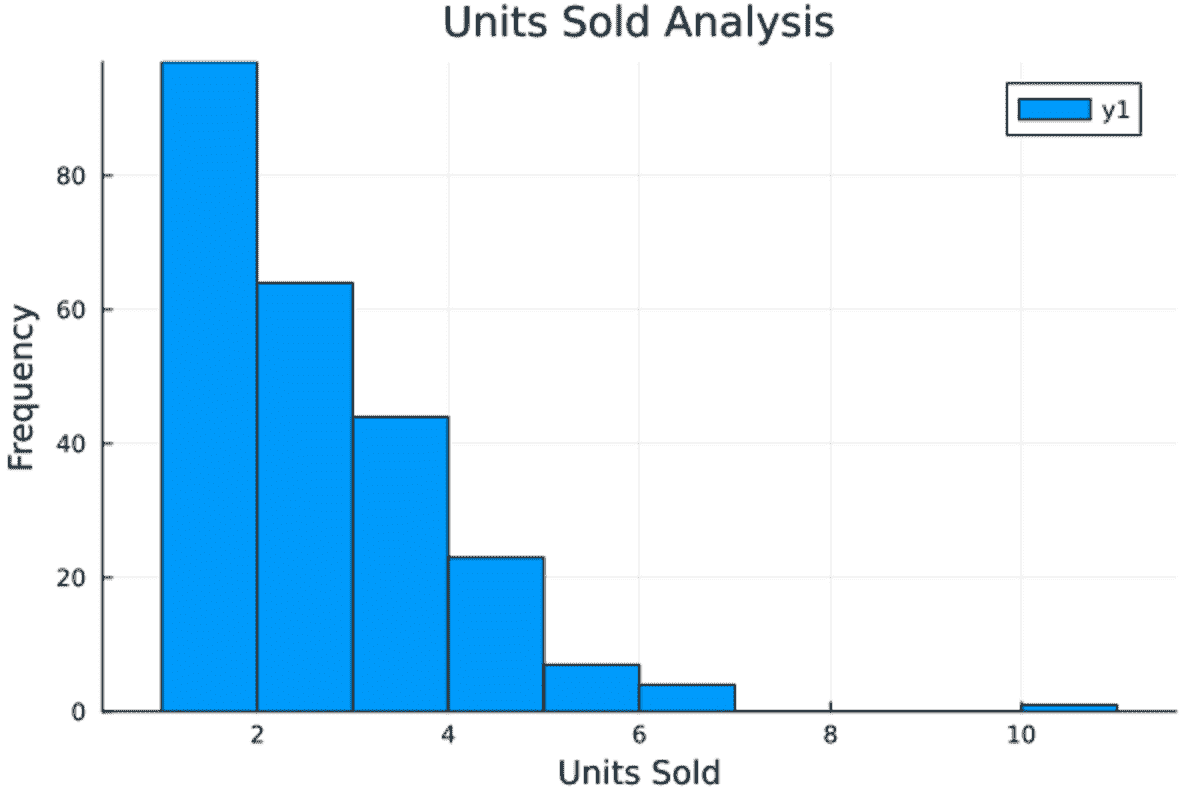

histogram(data[!, :"Units Sold"], title="Units Sold Analysis", xlabel="Units Sold", ylabel="Frequency")

看起来大多数人购买了一到两件商品。

为了保存可视化效果,我们将使用savefig函数。

savefig("hist.png")

6. 创建数据处理管道

创建一个合适的数据管道是自动化数据处理工作流程、确保数据一致性,以及实现可扩展和高效的数据分析的必要条件。

我们将使用Chain库来创建之前用来基于不同产品类别计算总均收入的各种函数链。

using Chain

# Example of a simple data processing pipeline

processed_data = @chain data begin

filter(row -> row[:"Unit Price"] > 230, _)

groupby(_, :"Product Category")

combine(_, :"Total Revenue" => mean)

end

first(processed_data, 5)

为了将处理后的 DataFrame 保存为 CSV 文件,我们将使用CSV.write函数。

CSV.write("output.csv", processed_data)

结论

在我看来,Julia 比 Python 更简单、更快。我习惯的许多语法和函数在 Julia 中也可用,如 Pandas、Seaborn 和 Scikit-Learn。那么,为什么不学习一门新语言,并开始做得比你的同事更好呢?此外,这也将帮助你获得与研究相关的工作,因为大多数临床研究人员更倾向于使用 Julia 而不是 Python。

在本教程中,我们学习了如何设置 Julia 环境、加载数据集、进行强大的数据分析和可视化,并构建用于可重复性和可靠性的数据管道。如果你有兴趣了解更多关于 Julia 的数据科学知识,请告诉我,这样我可以为你们编写更多简单的教程。

Abid Ali Awan (@1abidaliawan)是一位认证的数据科学专业人士,他喜欢构建机器学习模型。目前,他专注于内容创作,并撰写关于机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络构建一款 AI 产品,帮助那些遭遇心理健康问题的学生。

更多信息

通过这本免费电子书学习数据清理和预处理

原文:

www.kdnuggets.com/2023/08/learn-data-cleaning-preprocessing-data-science-free-ebook.html

Data Science Horizons 最近发布了一本有见地的新电子书,标题为数据科学初学者的数据清理和预处理,为数据科学流程的关键早期阶段提供了全面的介绍。在本指南中,读者将了解为什么正确清理和预处理数据对于构建有效的预测模型和从分析中得出可靠结论如此重要。电子书涵盖了数据收集、清理、集成、转换和减少以准备分析的一般工作流程。它还探讨了数据清理和预处理的迭代特性,使这一过程既是一门艺术,也是一门科学。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业。

1. Google 网络安全证书 - 快速进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

3. Google IT 支持专业证书 - 支持你所在组织的 IT 工作

为什么需要这样的书?

本质上,数据是杂乱的。现实世界中的数据,即公司和组织每天收集的数据,充满了不准确、不一致和缺失的条目。正如谚语所说,“垃圾进,垃圾出。”如果我们用肮脏、不准确的数据来喂养我们的预测模型,我们的模型性能和准确性将会受到影响。

这本电子书的一个主要亮点是对用于数据处理、可视化、机器学习和处理缺失值的关键 Python 库的实际演示。读者将熟悉 Pandas、NumPy、Matplotlib、Seaborn、Scikit-learn 和 Missingno 等必备工具。本指南最后通过一个案例研究,使读者能够应用前面章节中涵盖的所有概念和技能。

数据清洗与预处理提供了处理常见数据质量问题的全面指南。它探讨了处理缺失值、检测异常值、数据标准化与缩放、特征选择、变量编码和均衡不平衡数据集的技术。读者将学习评估数据完整性的最佳实践、合并数据集、处理偏斜分布和非线性关系。通过 Python 代码示例,读者将获得实际经验,识别数据异常、填补缺失数据、提取特征,并将混乱的数据集预处理成可分析的形式。案例研究将所有主要概念结合成一个端到端的数据清洗与预处理工作流。

数据科学家工具包的核心是识别常见数据质量问题的能力。

数据清洗与预处理入门指南是任何渴望进入数据科学领域但仍需要掌握处理现实世界数据的人的绝佳起点。此指南真正带你深入了解如何将原始数据处理到最佳状态,以便你能实际使用它。到达最后,你将掌握清洗和预处理数据的所有技巧,使之变得得心应手。不再因数据中的错误而陷入困境!凭借这本电子书赋予你的技能,你将能将最棘手的数据集驯服并像专家一样提取有意义的见解。

无论你是新手还是想提升技能,数据清洗与预处理入门指南都是你数据科学书单中不可或缺的一部分。

Matthew Mayo (@mattmayo13) 是数据科学家和 KDnuggets 的主编,KDnuggets 是数据科学和机器学习的开创性在线资源。他的兴趣包括自然语言处理、算法设计与优化、无监督学习、神经网络以及机器学习的自动化方法。Matthew 拥有计算机科学硕士学位和数据挖掘研究生文凭。你可以通过 editor1 at kdnuggets[dot]com 与他联系。

更多相关内容

从这些 GitHub 仓库中学习数据工程

原文:

www.kdnuggets.com/2023/02/learn-data-engineering-github-repositories.html

作者提供的图片

如果你希望进入数据领域,特别是数据工程 - 那么这个博客可以为你的学习提供有价值的资源。首先,让我们简要区分数据科学家和数据工程师之间的区别。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

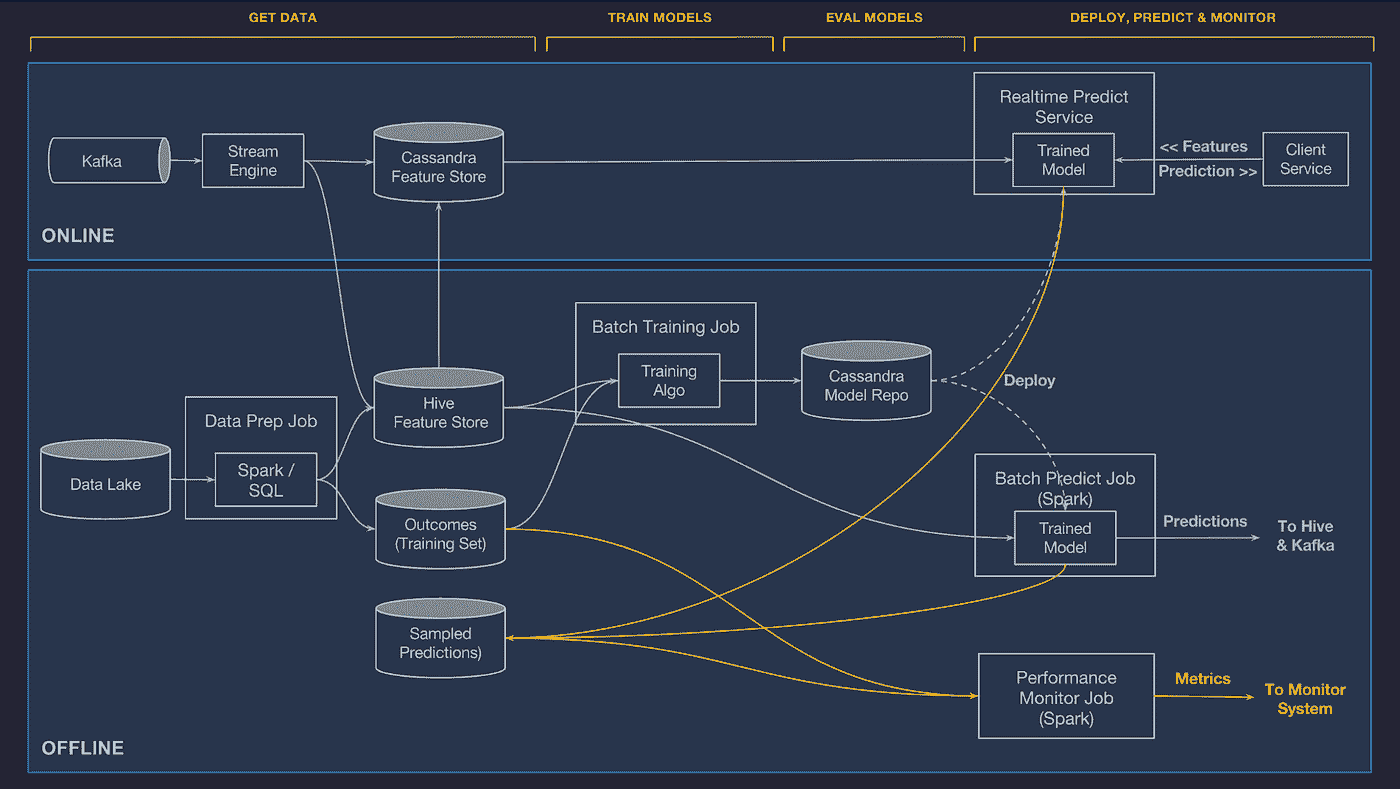

数据科学家的主要工作是探索数据、构建模型以及实施机器学习算法。数据工程师的主要工作是确保构建的算法在生产环境中有效运行,并创建数据管道。

数据工程师负责组织数据基础设施的所有相关工作。这些基础设施将存储业务的关键信息,从小型数据库到大规模系统。目标是确保数据的基础稳固且安全,以便进行关键分析和生成报告。

如果你仍然渴望学习数据工程,这里有一些有价值的 GitHub 仓库可以帮助你。

DataTalks.Club - data-engineering-zoomcamp

仓库链接:data-engineering-zoomcamp

正如名字所示,DataTalksClub 是一个全球数据爱好者的在线社区,讨论关于数据的所有话题。他们有一个 9 周的课程表来帮助你学习数据工程。每周的内容如下:

你可以加入下一个班次,但你也可以在自己的时间内完成。所有课程材料都是免费的,DataTalks.Club 提供了一个逐周的建议大纲来帮助你。

食谱

仓库链接: 食谱

《数据工程食谱》的作者安德雷亚斯·克雷茨在 GitHub 上发布了这本书。他的目标是为数据工程领域的新手提供一个起点,帮助你识别成为成功的数据工程师所需学习的重要主题。

这本书重点介绍了五种不同类型的内容,帮助你了解数据工程:作者发布的文章、他们播客节目的链接(视频和音频)、他推荐的 200 多个有用网站链接、数据工程面试问题和案例研究。

数据工程指南

仓库链接: 数据工程指南

如果你需要关于成为数据工程师所需学习的不同主题的指导,数据工程指南为你提供了一份不同资源的清单,让你可以获得有用的数据工程知识。

该仓库从数据工程的基本概念开始,例如需求层次、初学者指南等。还有关于讲座、算法与数据结构、SQL、编程、数据库、分布式系统、书籍、课程、博客、工具、云平台等的资源。

优秀的数据工程

仓库链接: 优秀的数据工程

如果你对数据工程的基础知识有良好的基础,或者需要更好地关注工具,这个 GitHub 仓库为你提供了一个精心策划的数据工程工具清单,涵盖了你可能遇到的工具类型。

要成为一名成功的数据工程师,你需要对工具有信心。这个仓库涵盖了所有类型的工具,包括:

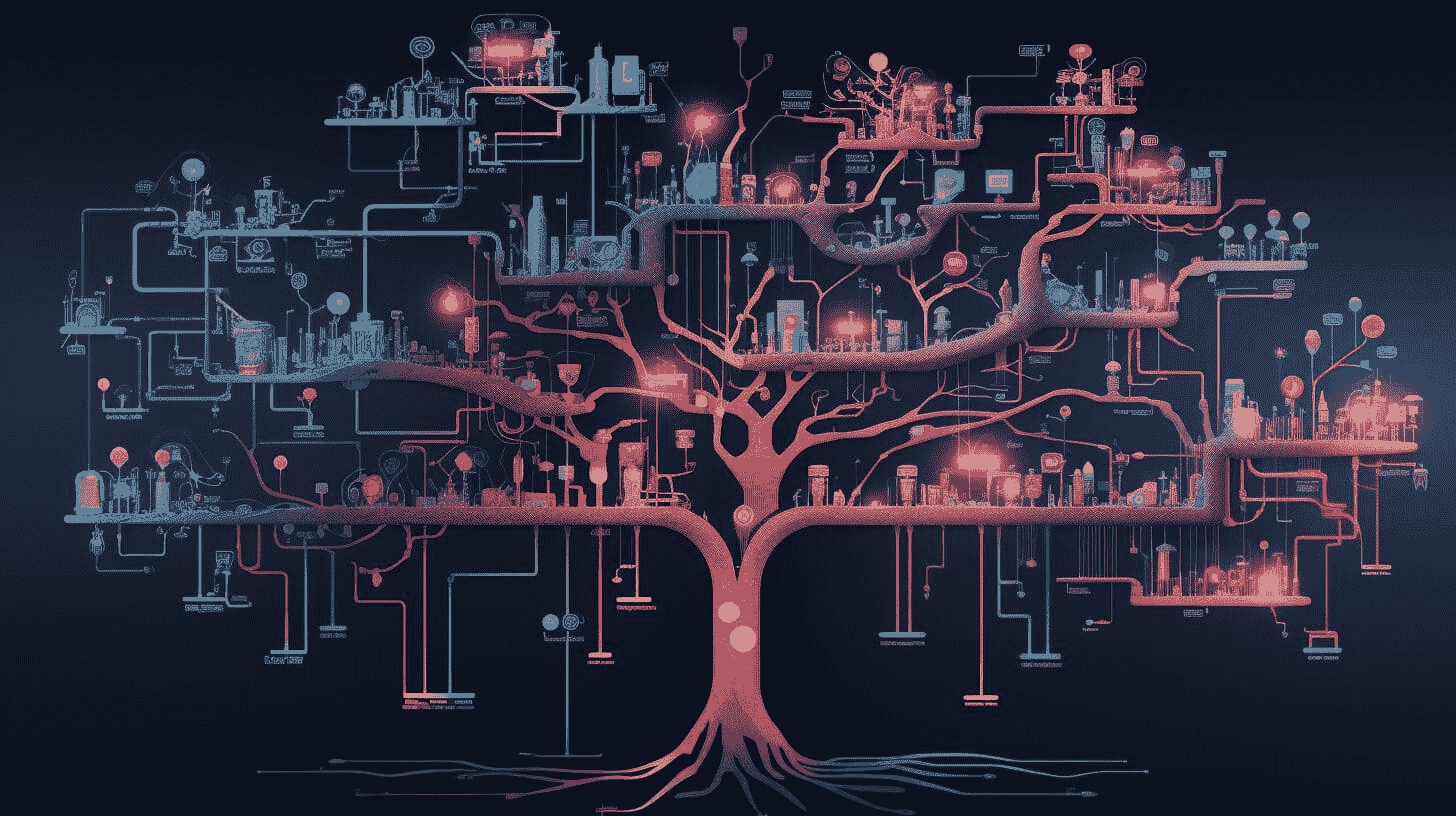

数据工程师路线图

仓库链接: data-engineer-roadmap

如果你是一个视觉型学习者,需要帮助来确定成为成功数据工程师的路线——这个库适合你。它提供了现代数据工程领域的完整可视化,并作为学习指南。

仓库的作者表示:

“初学者不必对这里列出的众多工具和框架感到不知所措。一个典型的数据工程师会在几年的时间内掌握这些工具的一个子集,这取决于他的公司和职业选择。”

总体而言,这个路线图可视化是一个有效的学习大纲,适用于有志于成为数据工程师的人。

开始数据工程

仓库链接: Start Data Engineering

如果你对自己的数据工程技能感到自信并希望开始测试它们。Joseph Machado 讲述了有关数据工程、数据建模、软件工程和系统设计的内容。

他为你提供了一步步的指南,帮助你开始项目,这对于你的数据工程学习以及作为你申请工作的作品集都是有用的。

数据工程项目

仓库链接: Data-Engineering-Projects

如果你在寻找更多应用于数据工程原则的项目,这个 GitHub 库提供了以下 7 种不同类型的项目:

-

Postgres ETL

-

Cassandra ETL

-

使用 Scrapy 进行网页抓取,MongoDB ETL

-

使用 AWS Redshift 进行数据仓库处理

-

使用 Spark 和 AWS S3 的数据湖

-

使用 Airflow 进行数据管道处理

-

关键项目

数据工程面试问题

仓库链接: data-engineering-interview-questions

假设你对自己的数据工程技能感到自信,已经进行过实践,现在准备申请你一直努力争取的工作。你需要为可能在面试中出现的问题做好准备。

这个 GitHub 库包含了 2000 多个问题,帮助你准备数据工程师面试。它们还提供了答案,让你了解你在数据工程中的强项和弱项。

结论

上述 GitHub 资源将帮助你迅速成为成功的数据工程师。如果你需要学习路线图,可以阅读 完整的数据工程学习路线图。它为你提供了一个主题、领域和资源的清单,帮助你在数据工程的旅程中前进。

Nisha Arya 是一名数据科学家和自由撰稿人。她特别关注提供数据科学职业建议或教程以及数据科学理论知识。她还希望探索人工智能如何有助于延长人类寿命。作为一个渴望学习的者,她希望拓宽技术知识和写作技能,同时帮助指导他人。

更多相关话题

以 8 个(简单的)步骤学习数据科学

原文:

www.kdnuggets.com/2016/10/learn-data-science-8-steps.html/2

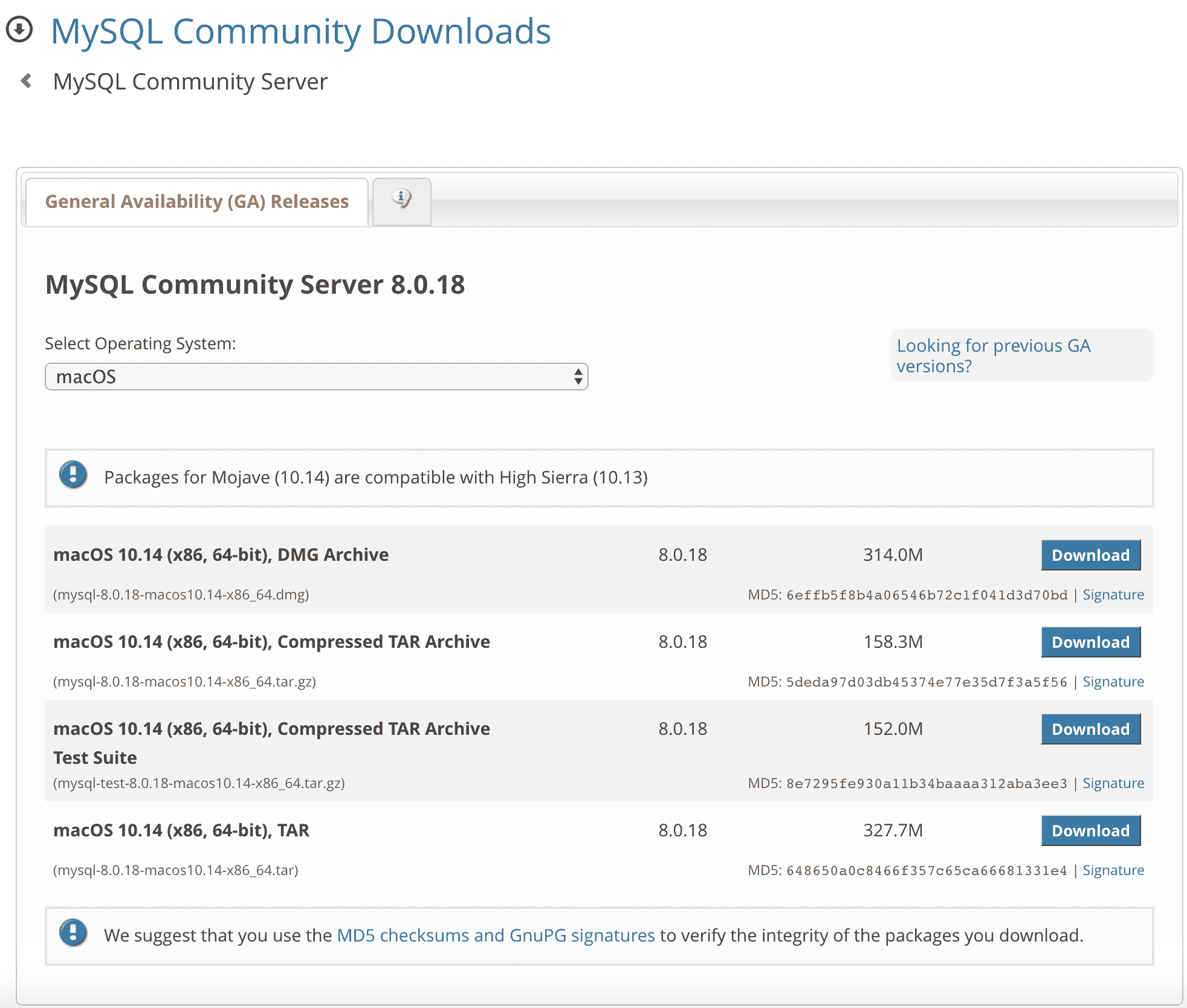

第 3 步. 理解数据库

当你开始学习数据科学时,你会发现很多教程专注于从平面文件中提取数据。然而,当你开始工作或接触到行业本身时,你会发现大部分工作是通过与一个或多个数据库的连接来完成的。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

3. Google IT 支持专业证书 - 支持你的组织进行 IT 工作

而且,市场上有很多数据库。公司可能会使用像 Oracle 这样的商业数据库,也可能会选择开源替代品。这里的关键是理解数据库的工作原理。了解数据库的原理和方法,之后你会掌握相关的内容。你应该掌握的概念包括关系数据库管理系统(RDBMS)和数据仓库。这意味着关系建模与维度建模应该不会对你造成困扰,SQL 或抽取-转换-加载过程(ETL)也不应让你感到意外。

如果你想学习如何理解数据库的工作原理,你应该查看 Mongo DB 大学、斯坦福在线 的 “数据库简介” 课程以及 DataStax 和 TutorialsPoint 的教程。

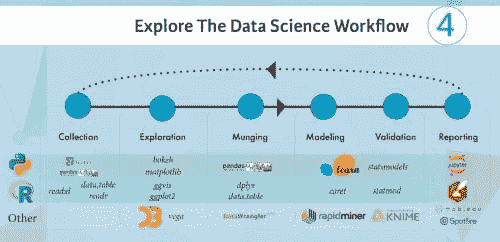

第 4 步. 探索数据科学工作流程

学习过程的下一阶段是探索数据科学工作流程。许多教程或课程仅关注其中的一两个方面,但失去了作为数据科学家或数据科学团队成员时需要经历的整体流程。至关重要的是不要忽视数据科学的迭代过程。

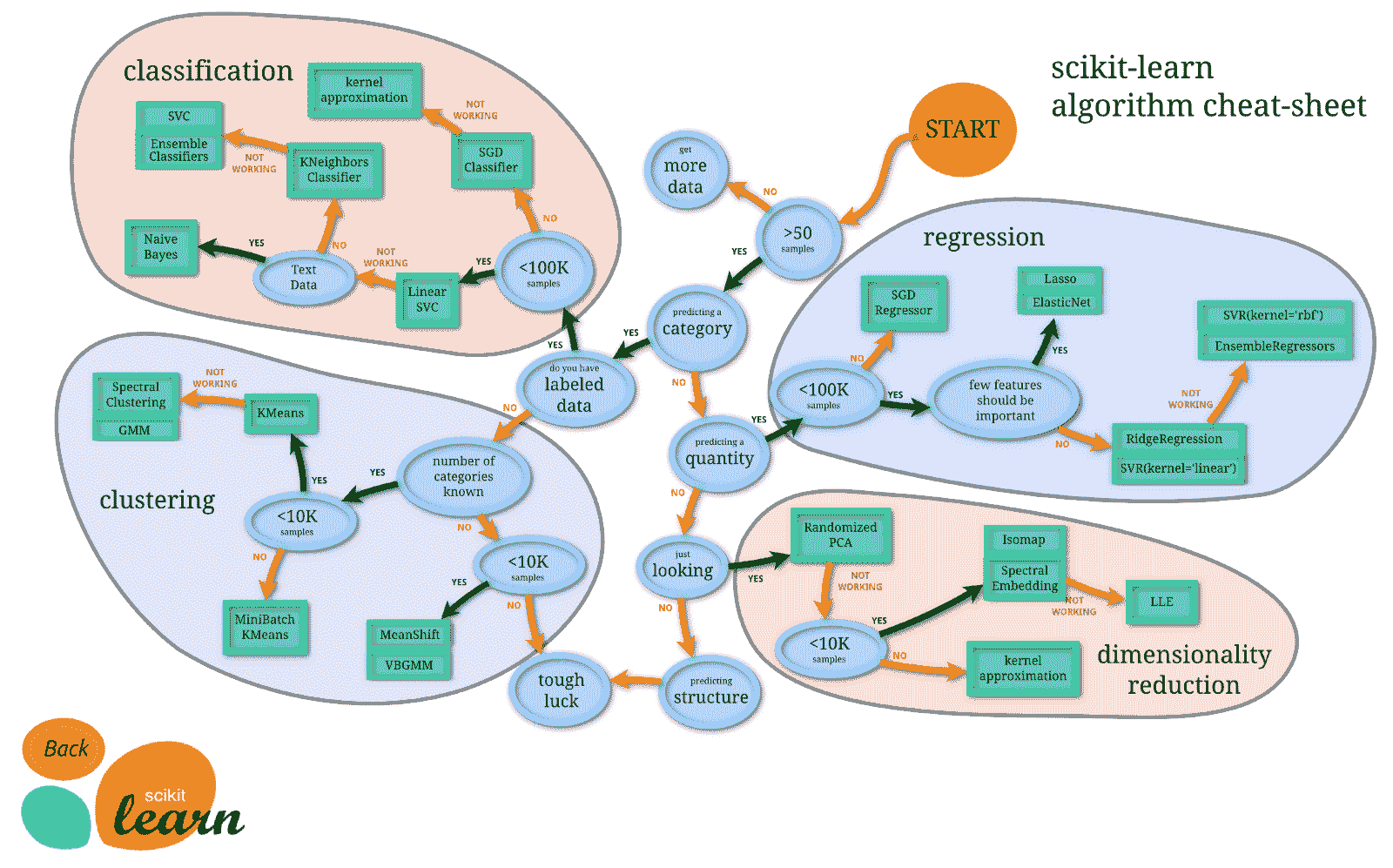

对于那些会编程的数据科学初学者来说,了解数据科学工作流程的最简单方法是通过练习你的编程技能:可以从 R 或 Python 开始你的学习之旅。这里有几个包和库,旨在让你的编码生活更轻松。请查看下面的信息图片段:

对于那些仍然觉得自己黑客技能不足的初学者来说,值得查看一些不需要你编写所有代码的开源替代方案。这些工具将允许你在数据科学工作流程中同时完成多个步骤。例如,RapidMiner允许你导入或收集数据,对其进行一些操作以清理数据,建模和评估。请注意,了解如何使用这些工具很重要,但你仍然应该继续提高你的编码技能!

步骤 5. 利用大数据提升水平

许多学习者过于关注他们所谓的数据科学“基础”,以至于忽略了更大的图景。字面上讲。你在之前的章节中得到了一些关于这一点的提示,但存在差异。就像你在许多教程中使用的平面文件与行业中使用的数据库之间的差异一样,数据的速度、多样性和规模也是如此。这是一个你不能也不应错过的现实。

大数据可能曾经是一个炒作的话题,但它确实存在,理解其涵盖的内容是非常重要的。了解大数据的三件事是:

-

了解为什么大数据需要不同的数据处理方法。最好的方法可能是查看大数据的实际应用案例。你可以在这里阅读一些。

-

熟悉一下Hadoop框架:它广泛用于分布式数据存储和处理。

-

不要忘记Spark。掌握结合 Python 或 Scala 使用 Spark 的方法是关键。而且,更好的是,你一举两得:你既能练习编码技能,又能拓宽对数据科学的视野。

步骤 6. 成长、连接和学习

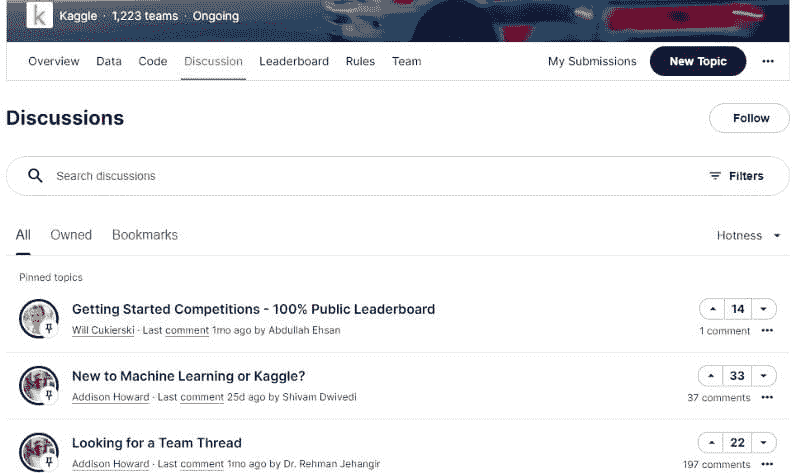

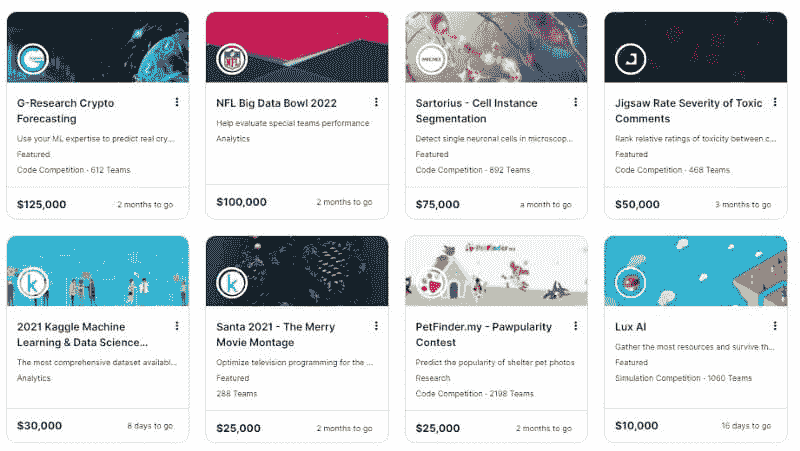

成长。一旦你掌握了基础知识,就该开始成长了:通过参与数据科学挑战(比如在Kaggle或DrivenData上找到的那些)尽可能多地进行实践。它们将挑战你将理论付诸实践。此外,你还应该让你的直觉成长。

连接。作为数据科学学习者,你可能会陷入只关注自己的学习和其他学习者的学习的陷阱,但与那些在这个领域已有更多经验的人建立联系同样重要。这样,你可以建立一个可以在有问题、需要建议或提示时依靠的网络。这些人将激励你保持良好的学习状态,并挑战你更进一步。

学习。持续学习和数据科学几乎可以算是同义词。上述提到的Kaggle和DrivenData挑战将教会你一些关于数据科学实践的知识。除了这些相对较小的练习外,你还可以考虑启动一个个人项目,并更深入地探索一些内容。

第 7 步:彻底沉浸自己

就像语言沉浸一样,你需要一个数据科学的沉浸。根据你已经拥有的技能和知识,你可以考虑参加训练营、实习或找一份工作。训练营是启动或提升你数据科学学习的绝佳方式。作为额外的好处,你将遇到很多人,并有机会建立或扩展你的网络。如果你在寻找训练营时遇到困难,可以查看Galvanize和Metis,但也不要忘记你的Meetup小组可能也会为社区组织训练营和研讨会!

其次,当你已经掌握了数据科学的基础知识后,你应该考虑寻找一个实习机会。许多大公司如Facebook、Quora和Amazon之前都曾招募实习生,所以这是一个很好的开始寻找的地方。此外,你可以利用你的社交渠道或人脉网络来获取有关实习职位的第一手信息。最后,也可以关注初创公司:这些较小的公司愿意让你在工作中学习,只要你能快速学习。AngelList值得查看以获取初创公司职位的信息。

最后的沉浸选项是大多数学习者经历瓶颈的地方,正如最近在“数据科学面试”中的搜索趋势所证实的那样。即使你可能对数据科学家的职位非常热情,但在寻找工作时必须牢记几点:

-

职位发布并不总是准确的。他们可能会发布一个“数据科学家”职位,但实际上他们可能在寻找数据工程师或业务分析师。查看 DataCamp 的数据行业:谁做什么信息图,了解公司在发布职位时的要求。

-

调整你的期望:如果你没有真实的数据科学工作流程、数据库或端到端开发经验,那么直接从数据科学家或分析师职位入手是不现实的。确保在申请时你有相关的经验可供展示。

如果你不能立即找到工作,不要灰心。相反,尽量确保你保持忙碌,积累经验,并关注那些之前发布过数据科学职位的公司,比如Google、Microsoft和Twitter。

第 8 步:与社区互动

最后一步有时会被忽视。即使你在数据科学领域或者作为数据科学家有了工作,你仍然需要记住,数据科学等同于持续学习。时刻有新的进展,保持对周围发生的事情的关注和好奇是关键。因此,不要犹豫参与社交媒体讨论,订阅新闻通讯,关注数据科学行业的关键人物,收听播客……任何可以让你与社区互动的方式!

为了跟上最新的动态,你可以注册以下新闻通讯:双月刊 KD Nuggets 新闻通讯和Data Elixir或Data Science Weekly新闻通讯。接着,在Twitter上关注一些数据科学行业的关键人物。这也会帮助你跟上最新动态。一些可能会引起你兴趣的人物包括DJ Patil、Andrew Ng和Ben Lorica。

加入一些在线社区。LinkedIn、Facebook、Reddit……这些平台都提供了与同行联系的机会。你应该抓住机会成为这些小组中的一员:

-

在LinkedIn上,务必查看“Big Data, Analytics, Business Intelligence”、“Big Data Analytics”、“Data Scientists”或“Data Mining, Statistics, Big Data, Data Visualization, and Data Science”这些小组。

-

在Facebook上,"Beginning Data Science, Analytics, Machine Learning, Data Mining, R, Python"和"Learn Python"这些小组可能会引起你的兴趣。

-

你可以关注的Subreddits包括“/r/datascience”、“/r/rstats”和“/r/python”,还有很多其他的!

这个列表只是一个指引,并不是详尽无遗的!如果你想查看更多资源的概述,可以点击这里。

最后,别忘了为你加入的社区做出贡献!

在 DataCamp 上

DataCamp 是一个在线互动教育平台,专注于为数据科学提供最佳学习体验。我们的课程涉及R、Python 和 数据科学等主题,结合视频讲解和浏览器内编程挑战,使你能够通过实践学习。你可以随时随地免费开始每门课程。

简介:Karlijn Willems 是一名数据科学记者,专注于数据科学教育、最新新闻和热门趋势,并为DataCamp 社区撰写文章。她拥有文学与语言学及信息管理方面的学位。

相关:

-

团队的 4 个在线数据科学培训选项

-

数据分析与数据科学 Python 学习综合指南

-

最佳数据科学在线课程

相关主题

如何在破产时学习数据科学

评论

评论

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

在过去的一年里,我自学了数据科学。我从数百个在线资源中学习,每天学习 6 到 8 小时。同时,我还在一家日托中心以最低工资工作。

我的目标是开始一份我热爱的职业,尽管资金不足。

正因为这个选择,我在过去几个月里取得了很多成就。我发布了自己的 网站,被一家主要的在线数据科学 出版物 刊登,并获得了竞争激烈的计算机科学研究生 项目的奖学金。

在以下文章中,我提供了指南和建议,以便你可以制定自己的数据科学课程。我希望能为他人提供工具,以开始他们自己的教育旅程,从而开始朝着更具激情的数据科学职业发展。

快速说明

当我说“数据科学”时,我指的是将数据转化为实际行动的工具集合。这些包括机器学习、数据库技术、统计学、编程和领域特定的技术。

一些资源来开始你的旅程。

互联网是一个混乱的局面。从中学习往往感觉像是从消防水龙头的喷射端喝水。

有一些更简单的替代方案可以为你整理混乱的局面。

像 Dataquest、 DataCamp 和 Udacity 这样的站点都提供数据科学技能的学习机会。每个网站都创建了一个教育程序,引导你从一个主题到另一个主题。每个都需要你花费很少的课程规划时间。

问题是什么?它们成本太高,它们不教你如何在工作环境中应用概念,而且它们阻止你探索自己的兴趣和激情。

有一些免费的替代方案,比如edX和coursera,它们提供深入特定主题的一次性课程。如果你从视频或课堂环境中学得比较好,这些都是学习数据科学的极佳途径。

免费在线教育平台,查看这个网站以获取可用的数据科学课程列表。你还可以使用一些免费的课程大纲。看看David Venturi的文章,或者开放源代码数据科学硕士(一个更传统的教育计划)。

如果你通过阅读学习得比较好,可以看看从零开始的数据科学这本书。这本教科书是一个完整的学习计划,可以通过在线资源进行补充。你可以在pdf格式(免费)找到整本书,或者从亚马逊($27)获得一本实体书。

这些只是提供详细数据科学学习路径的一些免费资源,还有很多其他的。

为了更好地理解你在教育旅程中需要获得的技能,在下一部分我将详细介绍一个更广泛的课程指南。这旨在提供高层次的指导,而不仅仅是课程或书籍的列表。

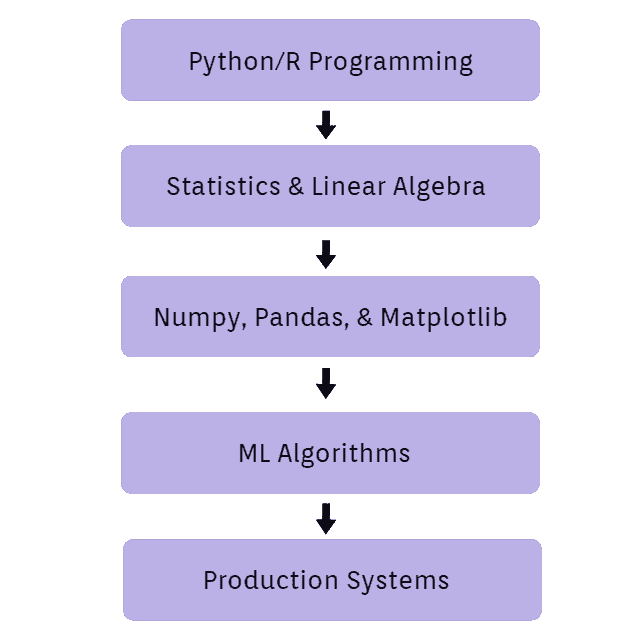

课程指南

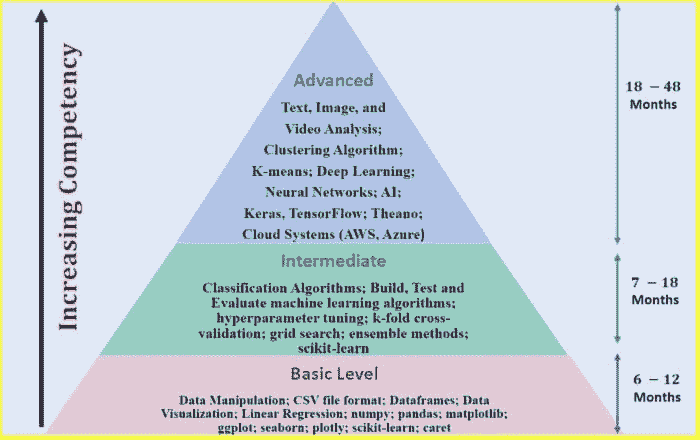

数据科学课程指南

Python 编程

编程是数据科学家的基本技能。熟练掌握 Python 的语法。了解如何以多种不同方式运行 Python 程序。(Jupyter notebook vs. 命令行 vs IDE)

我花了大约一个月的时间复习Python 文档、Python 指南以及在CodeSignal上的编码挑战。

提示:留意程序员使用的常见问题解决技巧。(发音为“算法”)

统计学和线性代数

机器学习和数据分析的前提条件。如果你已经对这些有扎实的理解,花一两周时间复习关键概念。

特别关注描述性统计。能够理解数据集是一项非常宝贵的技能。

Numpy, Pandas, 和 Matplotlib

学习如何加载、操作和可视化数据。掌握这些库对你的个人项目至关重要。

小提示:不要觉得你必须记住每个方法或函数名,这需要实践。如果忘记了,可以用 Google 搜索。

查看Pandas 文档、Numpy 文档和Matplotlib 教程。虽然还有更好的资源,但这些是我使用过的。

记住,你唯一能够学习这些库的方法就是使用它们!

机器学习

学习机器学习算法的理论和应用。然后将你学到的概念应用到你关心的真实数据上。

大多数初学者从使用UCI ML 数据库中的玩具数据集开始。玩弄这些数据,并通过指导性机器学习教程进行学习。

Scikit-learn文档提供了关于常用算法应用的优秀教程。我还发现这个podcast是一个很棒(且免费的)机器学习理论教育资源。你可以在通勤或锻炼时收听它。

生产系统

找到工作意味着能够将真实数据转化为行动。

为了做到这一点,你需要学习如何使用商业计算资源来获取、转换和处理数据。

亚马逊 Web 服务、谷歌云、微软 Azure 这是数据科学课程中最少教授的部分。主要是因为你使用的具体工具取决于你进入的行业。

然而,数据库操作是一个必要的技能。 你可以在ModeAnalytics或Codecademy上学习如何使用代码操作数据库。你也可以在DigitalOcean上便宜地实现自己的数据库。

另一个(通常)需要的技能是版本控制。 你可以通过创建一个GitHub账户并使用命令行每天提交代码,轻松掌握这个技能。

在考虑学习其他技术时,重要的是要考虑你的兴趣和热情。例如,如果你对网页开发感兴趣,那么了解一下该行业公司使用的工具。

执行课程的建议。

1. 概念会比你学习的速度更快地出现。

事实上,有成千上万的网页和论坛解释常用数据科学工具的使用。因此,在网上学习时很容易被分散注意力。

当你开始研究一个主题时,你需要牢记你的目标。如果不这样做,你可能会被吸引到任何引起你注意的有趣链接上。

解决方案是获取一个好的存储系统来保存有趣的网络资源。这样你可以将资料保存以备后用,专注于当前对你有用的主题。

我当前的 Chrome 书签栏 如果你做对了,你可以创建一个有序的学习路径,展示你应该专注的内容。你还会学得更快,避免被分心。

警告,你的阅读列表会很快增长到数百项,因为你会探索新的感兴趣的主题。别担心,这引出了我的第二条建议。

2. 不要焦虑。这是一场马拉松,而不是短跑。

自我驱动的教育常常感觉像是在阅读一个永无止境的知识库。

如果你想在数据科学领域获得成功,你需要把你的教育视为一个终身的过程。

只要记住,学习的过程本身就是一种回报。

在你的教育旅程中,你将探索自己的兴趣,并发现更多驱动你的东西。你对自己的了解越多,你从学习中获得的乐趣也会越多。

3. 学习 -> 应用 -> 重复

不要满足于仅仅学习一个概念然后转到下一个东西。学习的过程不会停止,直到你能够将一个概念应用到现实世界中。

by Allef Vinicius on Unsplash 不是每个概念都需要在你的作品集中有一个专门的项目。但重要的是要保持脚踏实地,记住你在学习是为了在世界上产生影响。

4. 建立一个作品集,它向他人展示他们可以信任你。

归根结底,怀疑是你在学习数据科学时将面临的最大困境之一。

这可能来自他人,也可能来自你自己。

你的作品集是你向世界展示你自己能力和自信的方式。

因此,建立一个作品集是你在学习数据科学期间最重要的事情。一个好的作品集可以帮你找到工作,并让你成为一个更自信的数据科学家。

把你引以为傲的项目填充到你的作品集中。

你是否从零开始构建了自己的网页应用程序?你是否创建了自己的 IMDB 数据库?你是否写过一篇有趣的医疗数据分析?

把它放入你的作品集中。

只需确保撰写的内容易于阅读,代码有良好的文档,并且作品集本身看起来不错。

harrisonjansma.com/archive 这是我的作品集。一个更简单的发布作品集的方法是创建一个包含出色的 ReadMe(摘要页面)以及相关项目文件的 GitHub 仓库。

这是一个美观却简单的GitHub 作品集。对于更高级的作品集,可以考虑使用 GitHub-IO 来托管你自己的免费网站。(示例)

5. 数据科学 + _______ = 激情事业

填空。

数据科学是一套旨在改变世界的工具。一些数据科学家建立计算机视觉系统来诊断医学影像,另一些则遍历数十亿的数据条目以找出网站用户偏好的模式。

数据科学的应用是无限的,这也是为什么找到让你兴奋的应用是很重要的。

如果你发现你热衷的主题,你会更愿意投入工作以做出一个出色的项目。这引出了我在这篇文章中最喜欢的建议。

在学习时,要时刻留意那些让你兴奋的项目或创意。

Stefan Steinbauer在Unsplash上。花时间学习后,尝试连接点滴。找到让你着迷的项目之间的相似性。然后花一些时间研究那些类型项目的行业。

一旦你找到一个你充满热情的行业,将其作为你的目标,获取该行业所需的技能和技术专长。

如果你能做到这一点,你将有能力将你的努力和对学习的热情转化为一份充满激情和成功的事业。

结论

如果你喜欢发现世界的奥秘。如果你对人工智能着迷。那么,无论你的情况如何,你都可以进入数据科学行业。

这不会很容易。

要激励你自己的教育,你需要毅力和纪律。但是如果你是那种能自我推动以提高自己的人,你完全有能力独立掌握这些技能。

毕竟,这就是数据科学家的全部意义。好奇心、自我驱动,以及对寻找答案的热情。

如果你想要更多高质量的数据科学文章,请关注我。 ????

原文。经许可转载。

个人简介:Harrison Jansma 是一位自学成才的数据科学家。在过去的 9 个月里,Harrison 离开了他的工作,开始全职学习机器学习,并报名攻读计算机科学硕士课程。Harrison 之所以这样做,是因为他的热情和目标是将机器学习应用于现实世界。这意味着对预测建模和生产环境有深入的理解。

相关:

更多相关主题

学习数据科学和商业分析以推动创新和增长

原文:

www.kdnuggets.com/2023/08/learn-data-science-business-analytics-drive-innovation-growth.html

你想知道任何企业如何能够长期生存吗?答案很简单——那就是增长。公司的增长对业务表现和利润至关重要。它还促进资产获取、投资融资和人才吸引。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

商业分析和数据科学对推动创新和业务增长至关重要。数据科学可以被企业利用来缓解不利趋势。例如,零售和金融服务公司可以利用数据科学来应对如破产、裁员或即将关闭等挑战。通过应用数据驱动的洞察和分析,这些公司可以做出明智的决策,并采取主动措施来解决这些问题。

此外,数据可以引导你的公司走向成功,你只需正确使用它。换句话说,数据是你业务分析的基础,以及你可以用它做的事情。为了启动你的业务并装备自己,以在竞争激烈的环境中脱颖而出,探索像 Great Learning 提供的最佳数据科学课程可能会带来终极变化。这些课程提供了全面和实践的数据分析、机器学习和人工智能培训,使你具备利用数据驱动洞察力的专业知识。

此外,在今天快速发展的商业环境中,投资于持续学习和技能提升变得至关重要。其他一些在线平台和教育机构也提供有价值的课程和资源,旨在提升业务增长和数据驱动决策。例如,Coursera提供了来自知名大学和行业专家的各种数据科学和商业分析课程,使学习者能够跟上前沿的方法论。

此外,对于寻求更专业技能的从业人员,像Udacity这样的平台提供数据科学、人工智能和高级分析的纳米学位项目。这些纳米学位项目提供基于项目的学习、指导和行业聚焦的课程,帮助个人获得实践经验并将其知识应用于现实世界的业务挑战。

什么是数据科学和商业分析?

使用机器学习算法,数据科学为你的业务增长创建预测模型。这些用于分析的信息对于你的业务非常关键。而且,这些信息来自广泛的来源。

商业界非常喜欢数据科学。他们将其与分析结合使用,以理解消费者行为并支持即时决策。

在商业分析中,数据分析、统计模型和其他定量技术被用于推动业务增长。

用于分析的信息用于决策制定。成功的商业分析依赖于高质量数据、对行业和相关技术有深入了解的能力强的分析师,以及坚定的承诺利用数据揭示有价值的洞察,以指导战略业务决策。

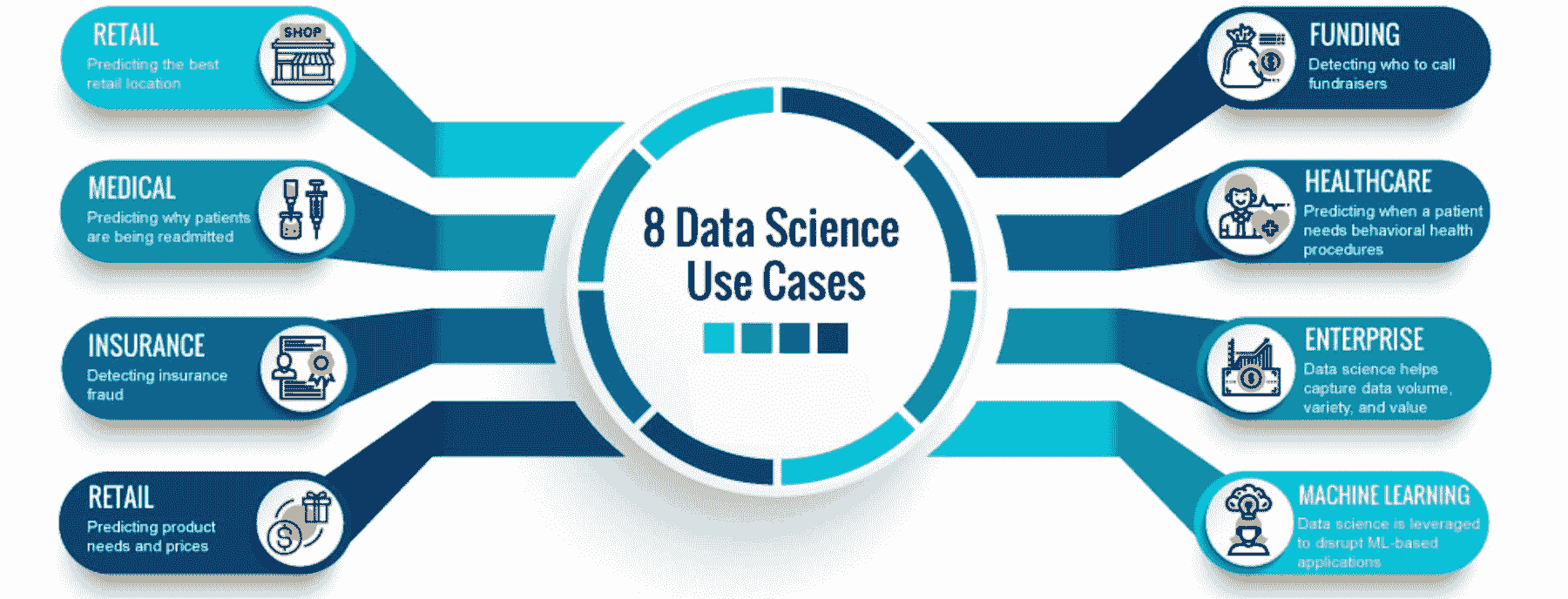

数据科学和商业分析的用途

数据科学允许从看似无序或无关的数据中提取有意义的洞察和预测。另一方面,商业分析使得分析所有可用的数据成为可能。通过利用商业分析,公司可以全面审视和解读他们的数据,获得宝贵的洞察,以推动明智的决策制定并优化业务流程。

科技公司收集的数据可以通过采用方法转化为有价值或盈利的信息。

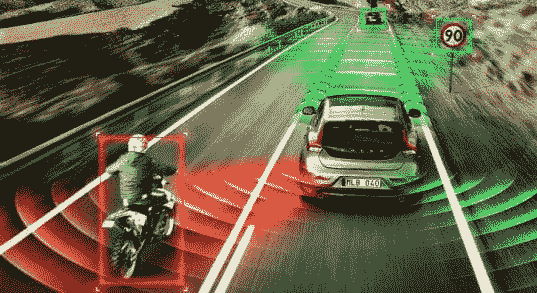

数据科学也帮助了运输行业。使用自动驾驶车辆简化了减少碰撞次数的任务。

利用商业分析,你可以使用现代分析和统计方法揭示数据集中的隐藏模式。通过交互式仪表板和数据驱动的报告向利益相关者传达信息。根据新事实调整和维护决策。监控关键绩效指标(KPI),并迅速应对变化的模式。

如果你的公司希望实现一个或多个目标,分析就是一个好的选择。下一步是选择适合你公司需求的最佳商业分析解决方案。

让我们了解数据科学和商业分析在业务增长中的好处。

图片来源:blog.athenagt.com/wp-content/uploads/2018/09/Blog-info_1074698057-1.png

考虑两个具有说服力的案例研究,这些研究反映了数据科学和商业分析对业务增长的影响。

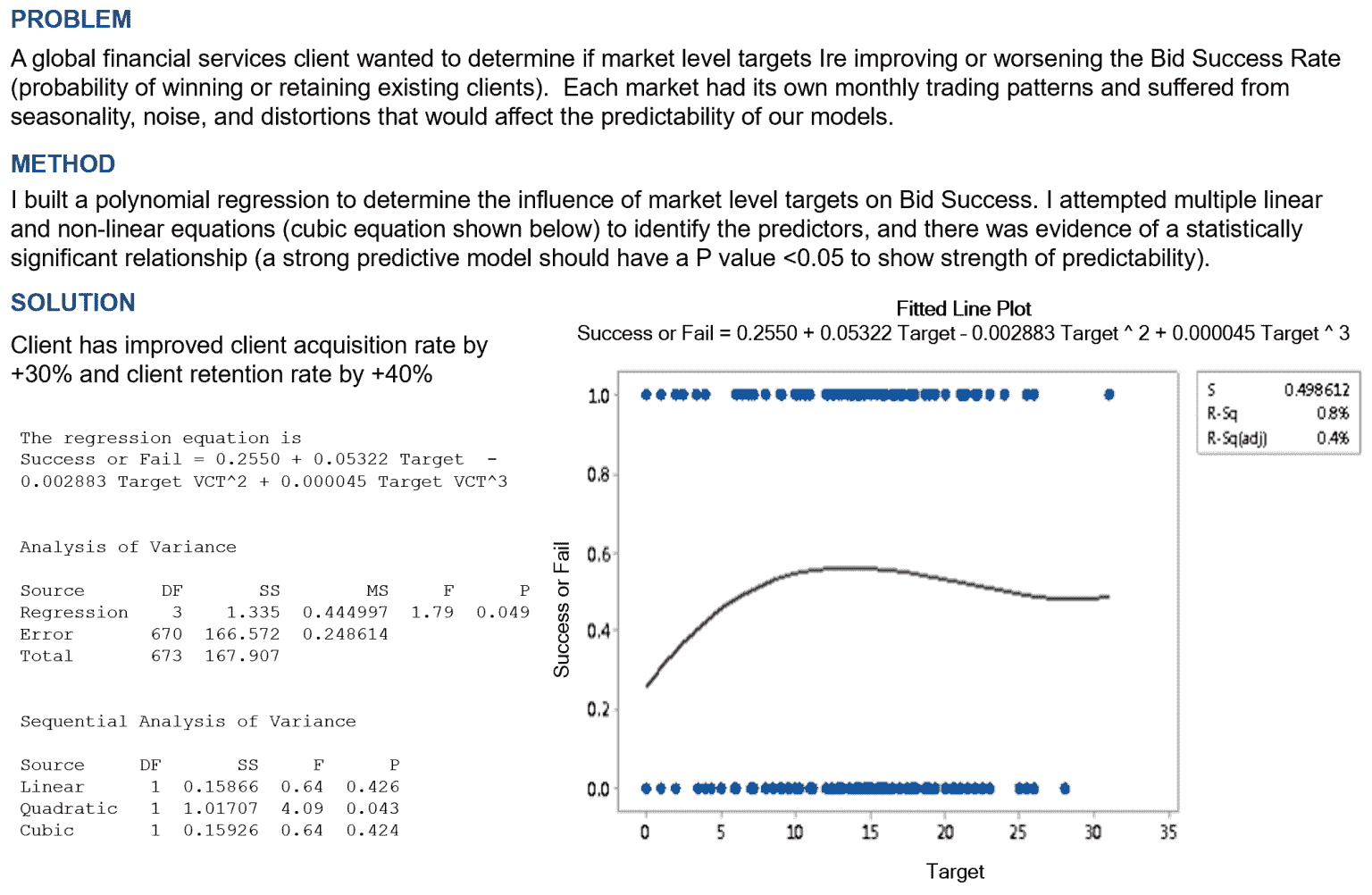

- 在案例研究 1中,采用的策略是构建一个多项式回归模型,以确定市场水平目标对竞标成功的影响。通过使用线性和非线性方程,识别出显著影响赢得或保留现有客户概率的预测变量。这个模型证明了成功,因为它使客户获取率提高了 30%,客户保留率提高了 40%。

这种方法可以应用于各种行业或企业,调整因素和变量以满足具体需求。这意味着通过识别和正确利用关键市场指标或预测因素,企业可以显著提高其客户获取和保留率。

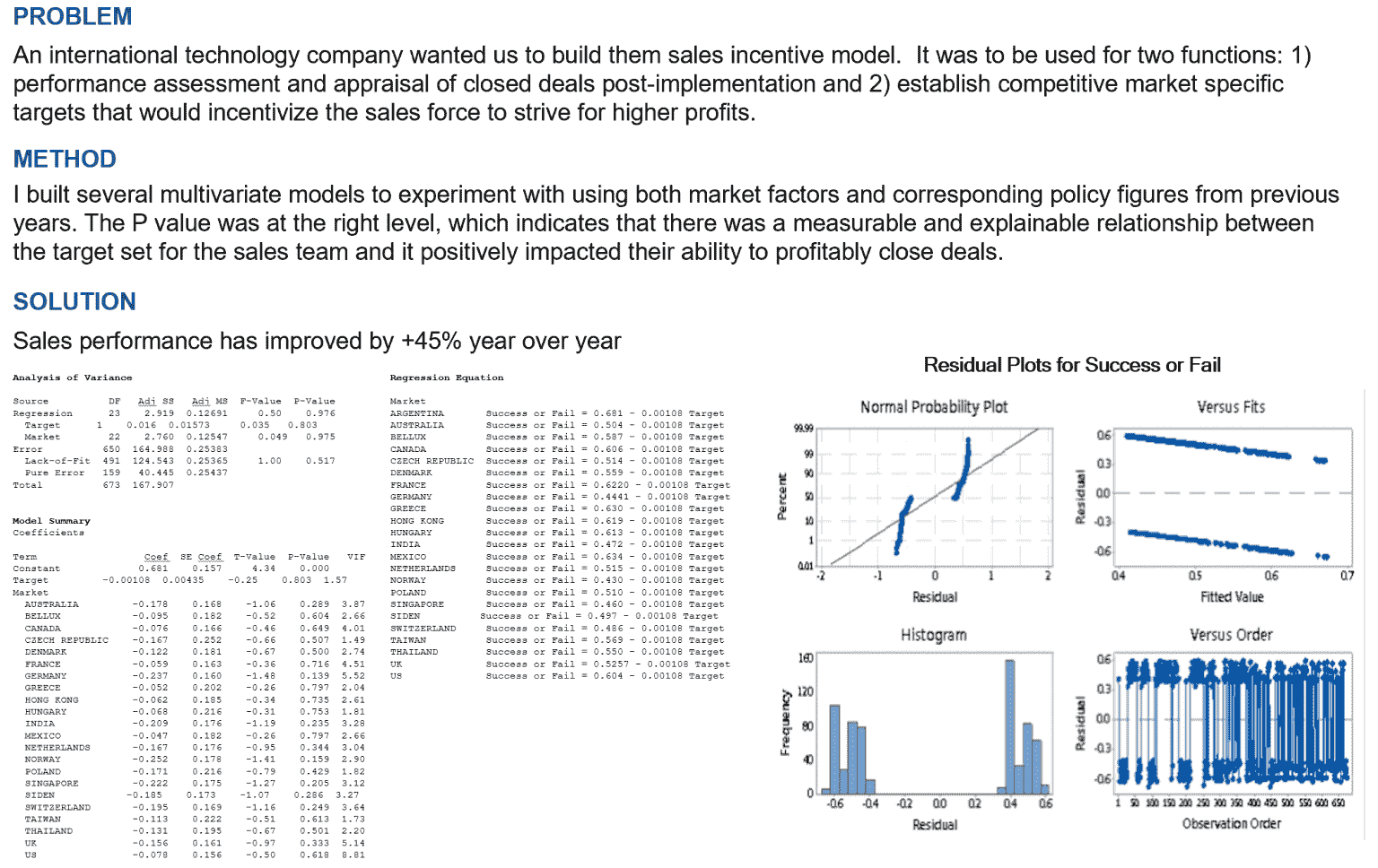

- 在案例研究 2中,创建了一个销售激励模型以提高销售业绩。这个模型是通过多变量模型构建的,输入包括市场因素和前几年对应的政策数据。研究发现,设定的销售团队目标与其盈利完成交易的能力之间存在正相关。这一模型使销售业绩实现了 45%的年增长。

该策略强调了适当地激励销售团队和设定具有竞争力的市场特定目标以提升销售业绩的重要性。通过正确理解激励结构与销售业绩之间的关系,公司可以更好地激励销售团队并优化销售结果。

为什么选择数据科学和商业分析来服务业务?

数据科学在当前商业环境中的重要性已广为人知。这是因为企业必须基于数据做出决策,如果想要保持竞争力并继续扩展。由于它为公司提供了更有效使用数据的方法,近年来数据科学在商业领域越来越受到欢迎。今天,包括医院、银行和学院在内的企业都在利用数据科学来支持各种活动。

商业组织在不久的将来才会真正关注数据科学在商业中的重要性,因为数据几乎被应用于我们生活的每一个方面。如果他们成功了,他们有很大的机会在不失手的情况下击败竞争对手。因此,小型企业通过数据科学能够超越需要更多数据知识和经验的大型企业或更大规模的公司。

商业分析的好处

商业分析提供可操作的洞察。企业通过数据可视化对未来进行预测,这些见解支持未来的规划和决策。商业分析促进了增长并衡量了表现。了解了这些之后,现在是了解商业分析的时间,让我们看看它与商业智能的区别。

数据科学证书

要成为数据科学家,通常需要数据科学或计算机相关领域的学士学位,对于某些职位,可能还需要硕士学位。因此,在追求这一职业之前,验证所有的教育要求至关重要。

此外,各种认证,如项目模型认证、实习认证和资格证书等,对于提升你的资格和市场竞争力也很重要。如果你拥有其他学科的学位,你还可以在线攻读学位。你可以立即开始参加各种快速的在线数据科学课程。

商业分析证书

商业分析证书使你能够让雇主相信你具备使业务成功的技能。你可以说服他们你拥有推动战略决策以及收集和分析数据的必要技能。它赋予你作为商业分析师所需的能力,这些分析师利用数据来提升、扩展和优化企业流程。

数据科学能给你的业务带来什么?

智能策略始终是商业改善所需的。你可以通过以下方式在业务中使用数据科学:

-

数据挖掘与分析: 数据挖掘通过对大型数据集进行排序,揭示可以在数据分析中使用的模式和关系,以帮助解决商业问题。利用数据挖掘技术和方法,企业可以预测未来趋势,并做出更好的商业决策。

-

最终决策选择: 应从分析选项中挑选最佳和最有效的决策。企业的成功将取决于这一终极决策。

-

信息管理: 数据科学家通过实际选择有用数据,保持公司的数据银行准确和最新。公司在需要时使用这些数据银行。

商业分析和数据科学的范围

商业分析有许多不同的应用。对于那些希望在职业生涯中取得进步并获得良好薪水的人来说,商业分析在过去十年中已成为顶尖的就业选择之一。

对于拥有适当技能的人来说,印度广阔的数据科学领域提供了多个机会。通过正确的培训,企业可以从数据科学家的服务中受益,做出更好的决策,更好地了解消费者,并自动化任务。

结论

商业分析通过深入洞察帮助了许多企业实现增长。企业可以通过使用商业分析技术来个性化与客户的互动,这些技术可以通过商业分析课程学习。它们甚至可以将客户反馈纳入开发更有利可图的产品中。在可预见的未来,数据将继续是任何公司运营不可或缺的部分。数据代表了可操作的知识,能显著影响公司成功与失败的差异。正如俗话所说,知识就是力量。

通过整合数据科学工具,企业现在可以利用数据的力量来预测未来增长,主动识别潜在问题,并制定有效的成功计划。拥抱数据驱动的方法使企业能够做出明智的决策,并在当今竞争激烈的环境中保持领先。

在可预见的未来,数据将继续是任何公司运营不可或缺的部分。数据代表了可操作的知识,能显著影响公司成功与失败的差异。正如俗话所说,知识就是力量。

Erika Balla 是一位来自罗马尼亚的匈牙利内容写作专家,专注于 AI 和数据科学主题。她的目标是帮助企业简化复杂信息,让数据科学更广泛地为受众所用,凭借她在写作和先进技术知识方面的专长。

更多相关话题

通过实际操作来学习数据科学的绝佳方式

原文:

www.kdnuggets.com/2015/09/learn-data-science-by-doing.html

由 Sumendar Karupakala 提供。

“对于我们必须在做之前学习的事情,我们通过实际操作来学习它们” ~ 亚里士多德

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

由于数据科学的综合性质,它融合了数学、统计学、经济学、计算机科学以及领域经验、黑客思维和业务影响技能,我们找不到一个地方可以一次性学习所有内容,但有很多出色的在线资源可以单独选择并学习,以成为数据科学领域的专家。如果我们想在这一领域精通,就从各种在线资源中获得这些课程吧。

挑战在于我们如何聪明地选择和使用这些教程,注册这些课程并观看视频不仅是做的一个方法,我们还应该在不同的练习中持续实践这些技巧,这些技巧由平台上的贡献者提供。大多数互动平台提供在线练习内容,如测验、问题集和可免费下载的免费数据集。

不仅要集中于技术方面,我们还必须持续关注与不同工业视角相关的大数据分析方法,因为大多数公司都在寻找对行业知识掌握得很好的商业精英。此外,如今的大数据正在推进和革新每个领域。

我列出了一些最佳的在线平台和相关课程,你可以在这些平台上学习和实践这些主题,成为数据科学专家。这些课程的独特之处在于免费注册,且大多数提供者与合作伙伴关联,提供完成证书。

Edx:

-

分析优势

-

使用 R 进行生命科学统计

-

使用 Transact-SQL 查询

-

线性代数 – 基础到前沿

-

知识管理与商业中的大数据

-

使用 Python 进行计算机科学和编程入门

-

使用 R 探索统计学

-

矩阵代数和线性模型

-

商业统计

-

我爱统计学:学习热爱统计

-

计算思维和数据科学简介

链接: www.edx.org/course/subject/data-analysis-statistics

www.edx.org/course/subject/computer-science

Coursera:

Udacity:

-

推断统计学

-

Hadoop 和 MapReduce 入门

-

使用 R 的数据分析

-

描述性统计入门

-

数据科学入门

-

数据可视化和 D3.js

链接: www.udacity.com/courses/data-science

**DataCamp: **

**Dataquest: **

**BigDataUniversity: **

-

使用 R 的数据分析简介

-

Hadoop 基础

-

SQL 对 Hadoop 的访问

链接: bigdatauniversity.com/wpcourses/?cat=334

bigdatauniversity.com/wpcourses/?cat=19

bigdatauniversity.com/wpcourses/?cat=132

bigdatauniversity.com/wpcourses/?cat=108\

bigdatauniversity.com/wpcourses/?cat=133

CodeSchool:

-

尝试 SQL

-

尝试 R

-

SQL 的续集

链接: www.codeschool.com/courses/try-sql

www.codeschool.com/courses/try-r

www.codeschool.com/courses/the-sequel-to-sql

KhanAcademy:

-

SQL 入门:查询和管理数据库

-

线性代数、概率与统计

链接: www.khanacademy.org/computing/computer-programming/sql

www.khanacademy.org/math/probability

**Stanford online lagunita: **

-

StatLearning 统计学习

-

CS101 计算机科学 101

链接: lagunita.stanford.edu/courses/HumanitiesandScience/StatLearning/

lagunita.stanford.edu/courses/Engineering/CS101/Summer2014/about

**Futurelearn: **

-

大数据:测量和预测人类行为

-

从数据到洞察: 数据分析简介

-

学习数据分析编程

链接: www.futurelearn.com/courses/big-data

www.futurelearn.com/courses/data-to-insight

www.futurelearn.com/courses/learn-to-code

Educast.Emc :

- 大数据湖

链接: educast.emc.com/learn/data-lakes-for-big-data-may-june

Udemy:

-

从零基础学习 Python 编程

-

R 编程语言

-

大数据与 Hadoop 基础

-

数据抓取和挖掘

-

数据分析师的 T-SQL

-

使用 Hadoop 生态系统进行数据分析

链接: www.udemy.com/courses/Business/Data-and-Analytics/

www.udemy.com/courses/Development/Databases/

www.udemy.com/courses/Development/Programming-Languages/

Alison:

Open2study:

Pluralsight:

简介: Sumendar Karupakala 是一位认证的大数据分析师,拥有多个分析领域的经验。他热爱使用分析工具、大数据和数据科学中的算法与技术,以便做出更聪明的决策。

相关:

-

前 20 大数据科学 MOOC 课程

-

在线教育:分析、大数据、数据挖掘和数据科学

-

商业分析与商业智能在线证书及学位

-

如何免费成为数据科学家

更多相关话题

从这些 GitHub 仓库学习数据科学

原文:

www.kdnuggets.com/2022/12/learn-data-science-github-repositories.html

图片由编辑提供

如果你想开始数据科学的职业生涯,你可能会想知道应该选择哪条学习路径。你可能看到过数据科学的训练营、Udemy 课程、学位等。面对如此众多的选择,确实很难决定走哪条路。

我们的前三推荐课程

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

3. Google IT 支持专业证书 - 支持你的组织在 IT 方面

哪里学习比 GitHub 仓库更好呢?如果你不知道,GitHub 是一个用于版本控制和协作的代码托管平台。谁使用 GitHub?你会看到个体专业人士、公司、大学和训练营学生、教师等使用这个平台进行协作和代码跟踪。

虽然 GitHub 不是唯一的平台,但由于以下原因,它非常受欢迎:易于使用,支持公共和私人仓库,并且对于小规模项目是免费的。GitHub 还有一个社区,帮助支持所有在 GitHub 上的用户解答问题、解决问题以及他们的整体学习之旅。多年来,人们对 GitHub 的看法各异,有些人主要将其视为协作工具,而其他人则将其视为学习门户或获取灵感的地方。

现在我们对 GitHub 有了一些了解,接下来看看你如何通过 GitHub 仓库学习数据科学。

freeCodeCamp

仓库链接:freeCodeCamp

如果你对学习数据科学的资源做过一些研究,你可能会遇到 freeCodeCamp。他们的资源非常受欢迎,最大吸引力是它们是免费的。凭借有358k人关注这个仓库,你肯定需要成为这群人中的一员。

你还可以在以下课程中获得认证:

数据科学入门

资源库链接: 数据科学入门

这是我遇到的最好的 GitHub 仓库之一!这个由微软 Azure 云倡导者提供的仓库提供了一个为期 10 周、20 节课的课程,帮助你进入数据科学领域。课程包括一个前导课程,之后是一个课后测验,写有完成课程的说明、解决方案和作业。

这个课程涵盖了数据科学的基础,旨在帮助初学者。你将学习数据科学伦理、统计与概率介绍、关系可视化等方面的内容。

开源数据科学硕士课程

资源库链接: 开源数据科学硕士课程

这个 GitHub 仓库为你提供了一个课程大纲以及相关资源。大多数资源来自大学和在职数据科学家,专注于数据科学的理论以及实际应用技能。

许多资源是免费的,唯一的费用是如果你选择购买推荐的书籍。当你完成课程后,你将被鼓励选择一个项目或数据集来展示你所学到的知识。他们还提供了一份课外学习材料清单,可以提高你的知识基础和技能。

免费数据科学书籍

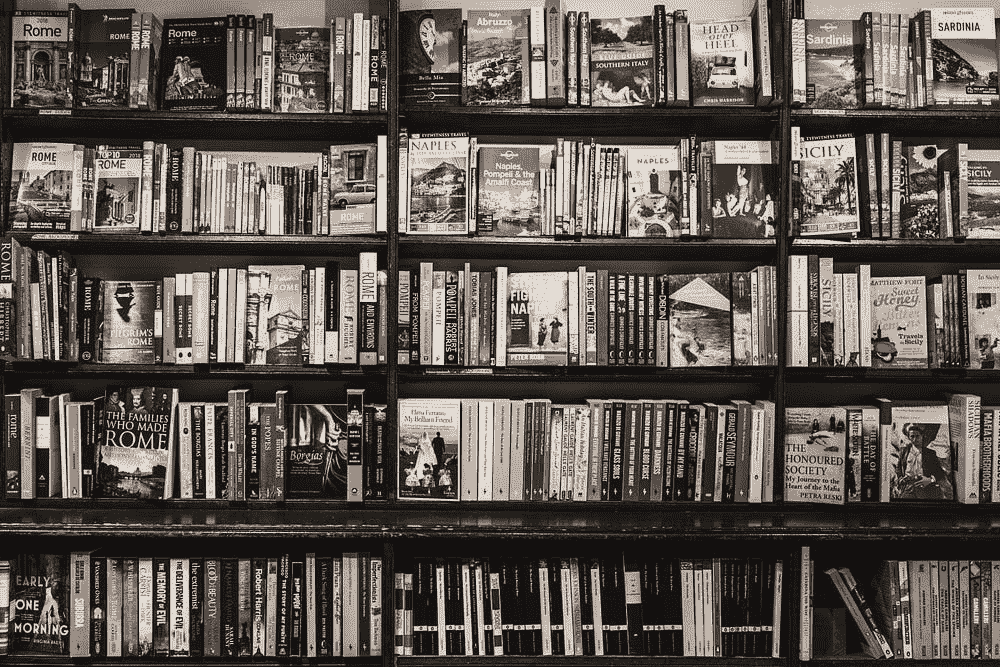

资源库链接: 免费数据科学书籍

如果你是一个书迷,学习的最佳方式是翻阅书页——这个 GitHub 仓库将拯救你。它不仅提供了一个按照课程安排的书单,而且是免费的!

这些书籍将标注其难度级别,包括初学者、中级或高级。涵盖的主题包括数据科学介绍、数据处理、数据分析、数据科学应用、数据可视化、未分类和关于数据科学的 MOOCs。

数据科学课程

资源库链接: 数据科学课程

当你开始你的数据科学之路时,可能很难知道从哪里开始。这是我曾经面临的问题,也是很多我认识的人所遇到的问题。遵循课程可以帮助你有效管理时间,确保涵盖所有数据科学方面,并识别你的弱点,以便加以改进。

这个由开源社会大学提供的数据科学课程清单,列出了成为数据科学家所需的课程。虽然它们可能没有免费的材料,但拥有一个学习计划会让你的生活变得更加轻松。

超棒的数据科学

资源链接: 超棒的数据科学

类似于课程,这个超棒的数据科学 GitHub 涵盖了数据科学的各个方面。如果你需要了解成为数据科学家所需的主题,但又希望自己进行研究,那么这个 GitHub 仓库就是为你准备的。它是数据科学的工具箱。

它为你提供了有关数据科学的所有必要书籍、博客文章、网页等信息。它们还提供了关于免费课程、密集课程和可以启动你数据科学职业生涯的学院的更多信息。

数据科学全能备忘单

资源链接: 数据科学全能备忘单

备忘单是学习新知识的好方法。它们提供了基本信息,并允许你进一步研究。拥有者将这些备忘单汇集在一起,旨在帮助学生获得提供清晰内容的全面资料。

你可以找到广泛的领域提供备忘单,如统计学、Matlab、机器学习、数据仓库、深度学习等。

最佳的 ML 与 Python

资源链接: 最佳的 ML 与 Python

成为成功的数据科学家的关键方面是确保你能应用你的技能,而唯一的方式就是通过做项目。招聘者希望看到你的代码、你的思路过程以及你如何得出最终结果。

这个最佳的 ML 与 Python GitHub 仓库提供了 910 个开源项目,分为 34 个类别。这些项目根据项目质量评分进行排名,因此你可以看到哪些项目受欢迎,并了解项目的描述。你可以找到数据加载与提取、模型解释性、医学数据等类别。

数据科学面试资源 - 面试问题

资源链接: 数据科学面试资源

一旦你掌握了作为数据科学家所需的所有知识并将其应用于项目中,下一步就是申请工作并为面试做好准备。这是最棘手的部分——但这就是你一直等待的时刻。

在数据科学面试中你将被问到的硬技能问题通常会分为两个类别:理论和技术。这些 GitHub 仓库涵盖了这两方面内容,并帮助你测试自己的知识,以便为面试做好准备。它们还提供了有关如何构建简历/CV 的技巧,这是赢得招聘官青睐的重要方面。

总结

学习数据科学不会容易,但在当今这个资源丰富的时代,它绝对是可以实现的。如果你知道其他能帮助他人的优秀 GitHub 仓库,请在下方评论中分享。

Nisha Arya 是一名数据科学家和自由撰稿人。她特别关注提供数据科学职业建议或教程以及数据科学的理论知识。她还希望探索人工智能如何能够/将如何促进人类生命的长久。作为一个热衷的学习者,她寻求拓宽技术知识和写作技能,同时帮助指导他人。

更多相关主题

数据科学和机器学习的学习:路线图后的第一步

原文:

www.kdnuggets.com/2021/08/learn-data-science-machine-learning.html

评论

来源: www.wiplane.com/p/foundations-for-data-science-ml

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

1. 谷歌网络安全证书 - 快速进入网络安全职业道路

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

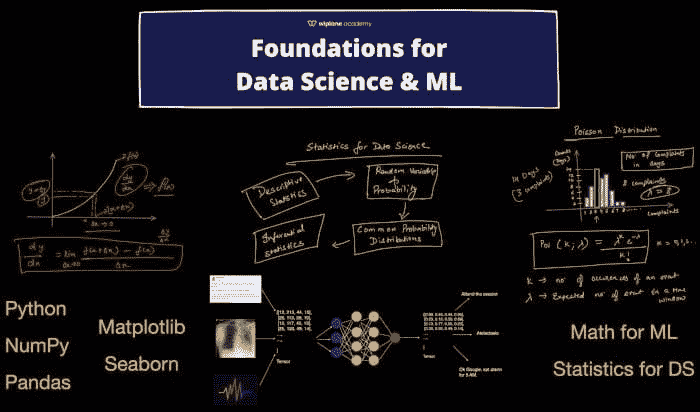

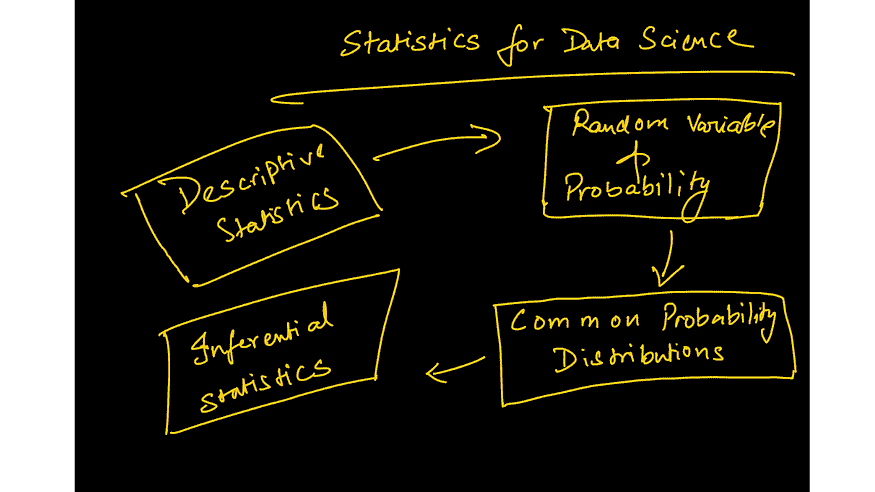

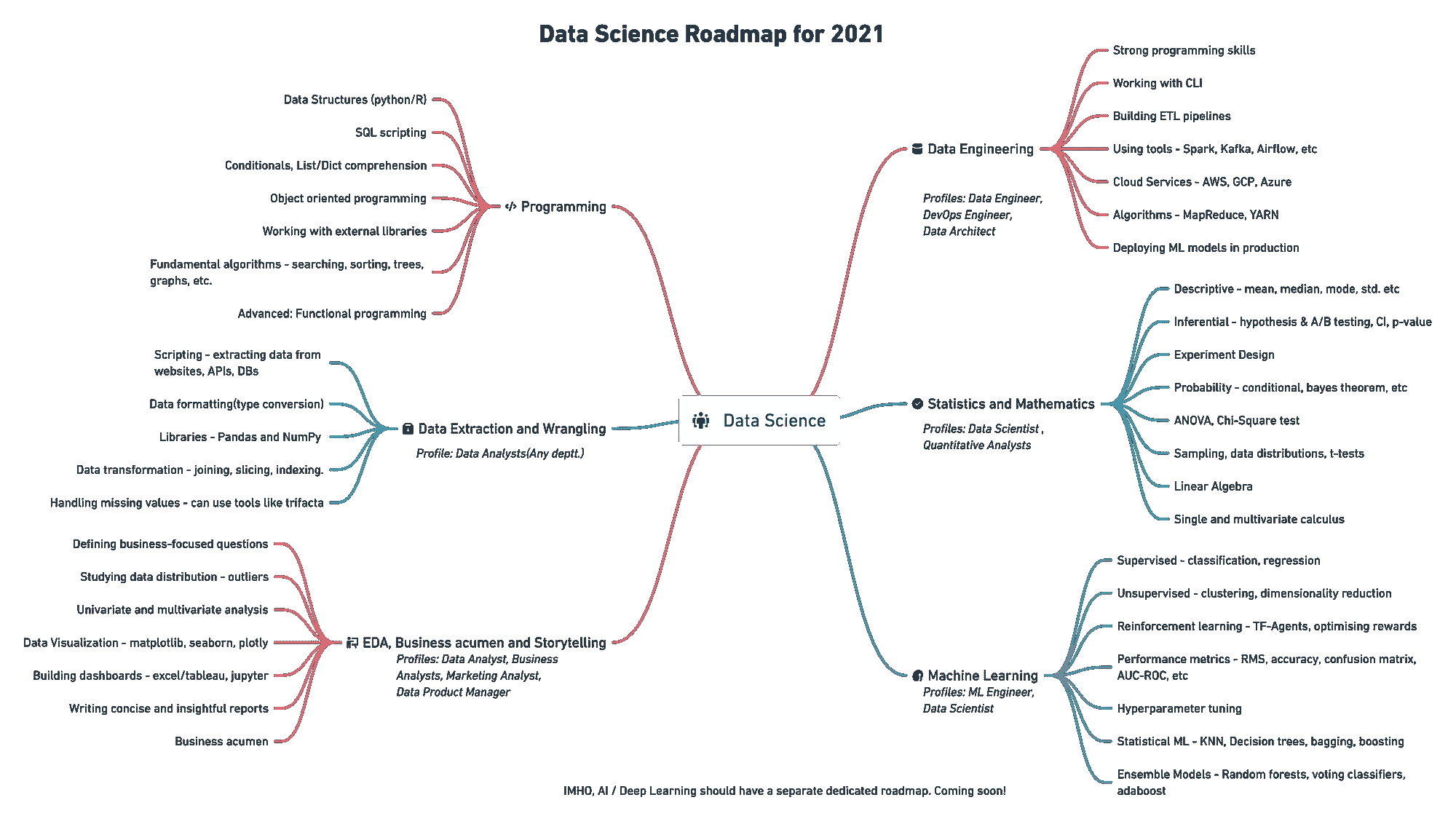

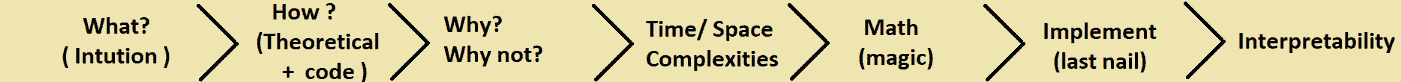

在今年年初,我发布了一份关于数据科学学习路线图(见下文)的思维导图。这份路线图得到了广泛认可,文章被翻译成了多种语言,许多人感谢我发布了这份图谱。

一切都很好,直到一些有抱负的学员指出,资源太多且许多资源很贵。Python 编程是唯一一个有许多非常好的课程的领域,但对于初学者来说,它仅止步于此。

一些关于基础数据科学的重要问题让我深思:

-

学会编程后应该做什么?是否有帮助你巩固数据科学基础的主题?

-

我讨厌数学,但有些教程要么非常基础,要么对我来说过于深入。你能推荐一个紧凑而全面的数学和统计学课程吗?

-

学习机器学习算法需要多少数学基础才够?

-

开始数据分析或数据科学时,有哪些关键的统计学主题?

很多这些问题的答案可以在《深度学习》一书中找到,作者是 Ian Goodfellow 和 Yoshua Bengio。然而,对于许多人来说,这本书有点过于技术化和数学化。

这篇文章的精髓就是,学习数据科学或机器学习的第一步。

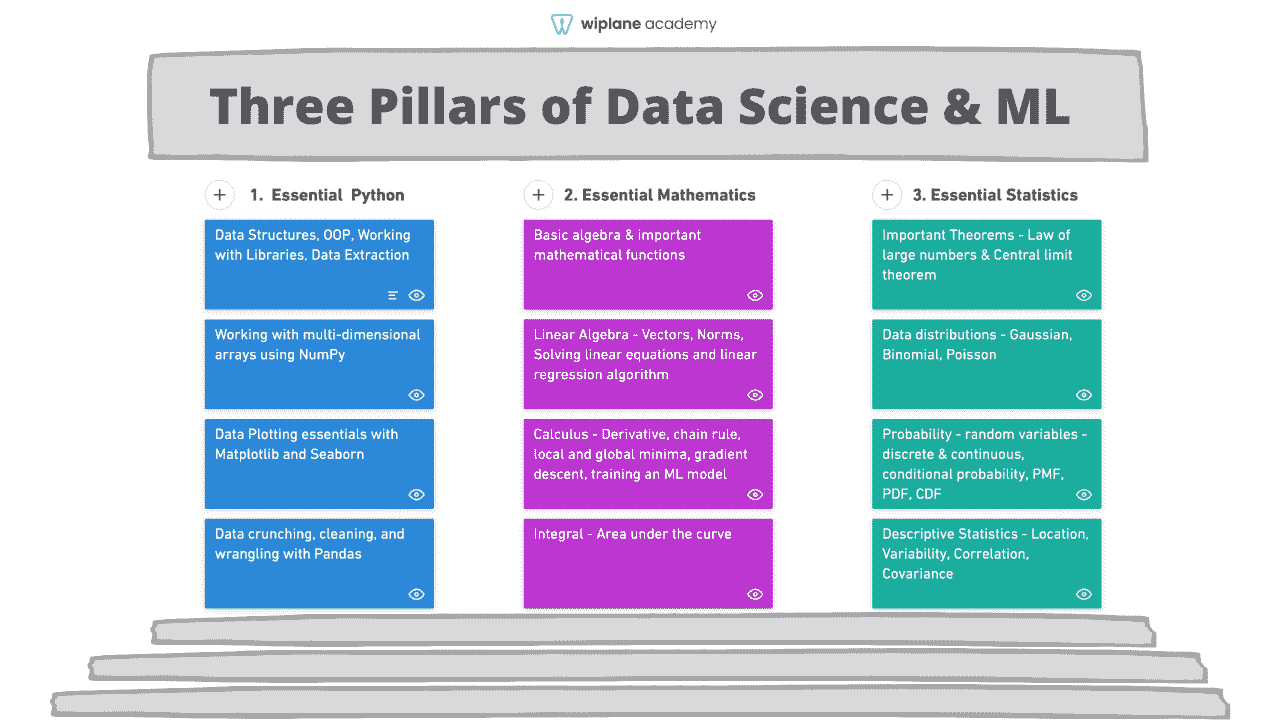

数据科学与机器学习的三大支柱

来源: wiplane.com

如果你查看任何机器学习/数据科学课程的前提条件或预习内容,你会发现它们通常结合了编程、数学和统计学。

先暂时不谈其他内容,这里是谷歌推荐的你在学习机器学习课程之前应该做的事:

developers.google.com/machine-learning/crash-course/prereqs-and-prework (CC BY 4.0)

1. 基本编程

大多数数据职位都是以编程为基础的,除了像商业智能、市场分析、产品分析师等少数职位。

我将专注于那些需要至少掌握一种编程语言的技术数据工作。我个人更喜欢 Python,因为它的多功能性和易学性——无疑是开发端到端项目的好选择。

必须掌握的数据科学主题/库的一瞥:

-

常见的数据结构(数据类型、列表、字典、集合、元组)、编写函数、逻辑、控制流、搜索和排序算法、面向对象编程以及使用外部库。

-

编写 Python 脚本以提取、格式化和存储数据到文件或回到数据库。

-

使用 NumPy 处理多维数组、索引、切片、转置、广播和伪随机数生成。

-

使用科学计算库如 NumPy 执行矢量化操作。

-

使用 Pandas 操作数据——系列、数据框、数据框中的索引、比较操作符、合并数据框、映射和应用函数。

-

使用 Pandas 处理数据——检查空值、填补空值、分组数据、描述数据、进行探索性分析等。

-

使用 Matplotlib 进行数据可视化——API 层次结构、向图形添加样式、颜色和标记、了解各种图形及其使用时机、折线图、条形图、散点图、直方图、箱线图,以及 seaborn 进行更高级的绘图。

2. 基本数学

有实际原因说明数学为何重要 对于那些想要从事机器学习实践者、数据科学家或深度学习工程师职业的人来说。

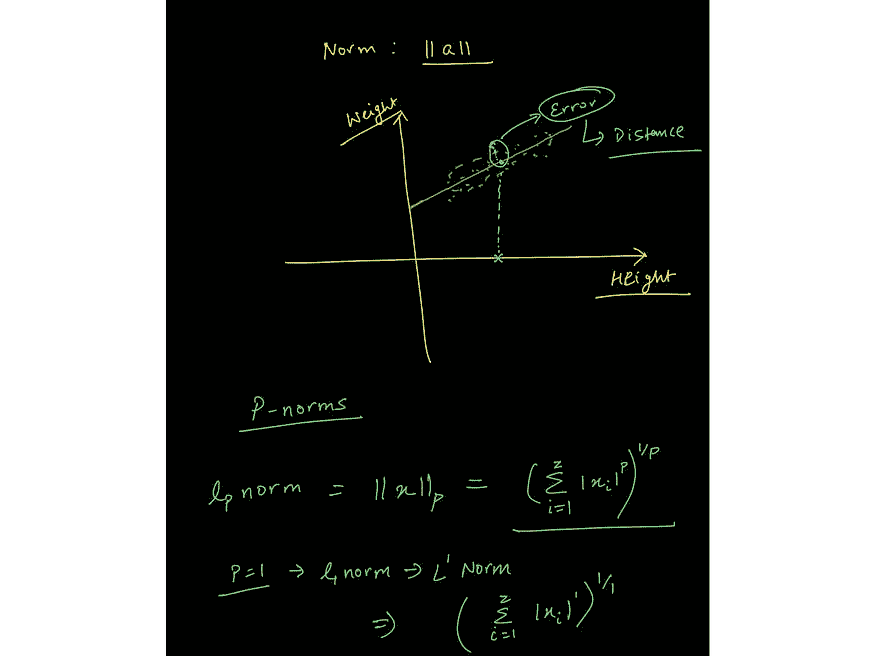

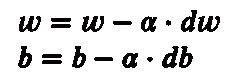

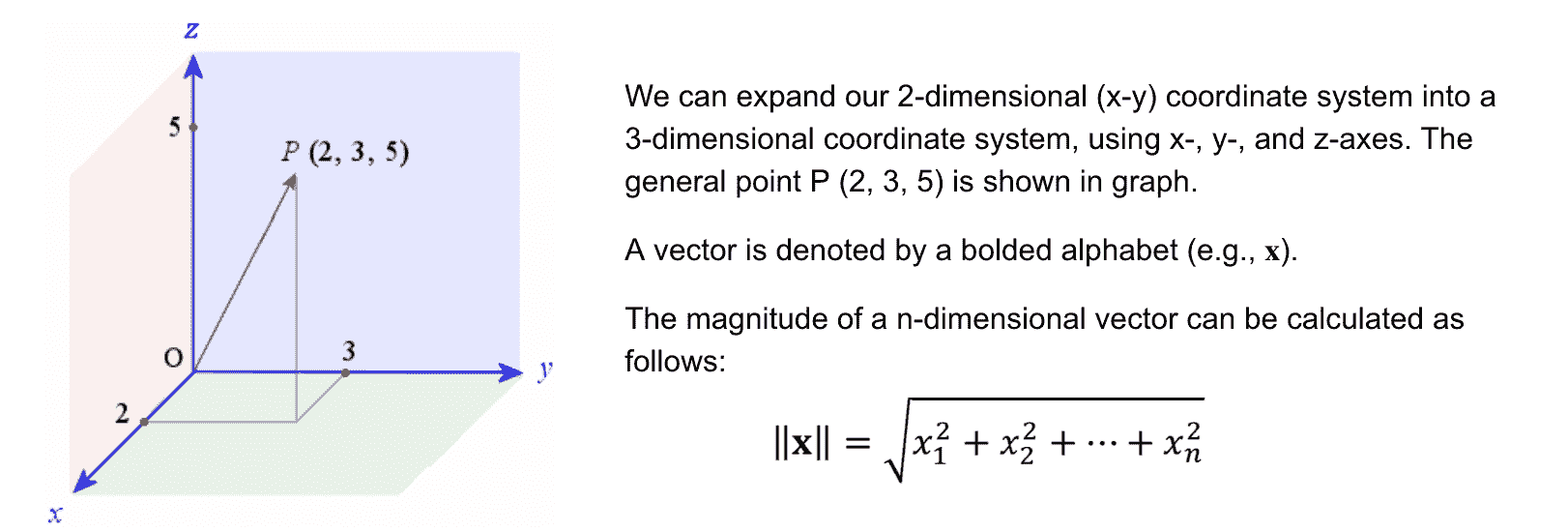

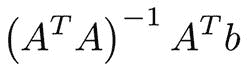

#1 线性代数用于表示数据

来自课程中关于向量范数的讲座的图像: www.wiplane.com/p/foundations-for-data-science-ml

机器学习本质上是数据驱动的,因为数据是机器学习的核心。我们可以将数据视为向量——一个遵循算术规则的对象。这使我们能够理解线性代数的规则如何作用于数据数组。

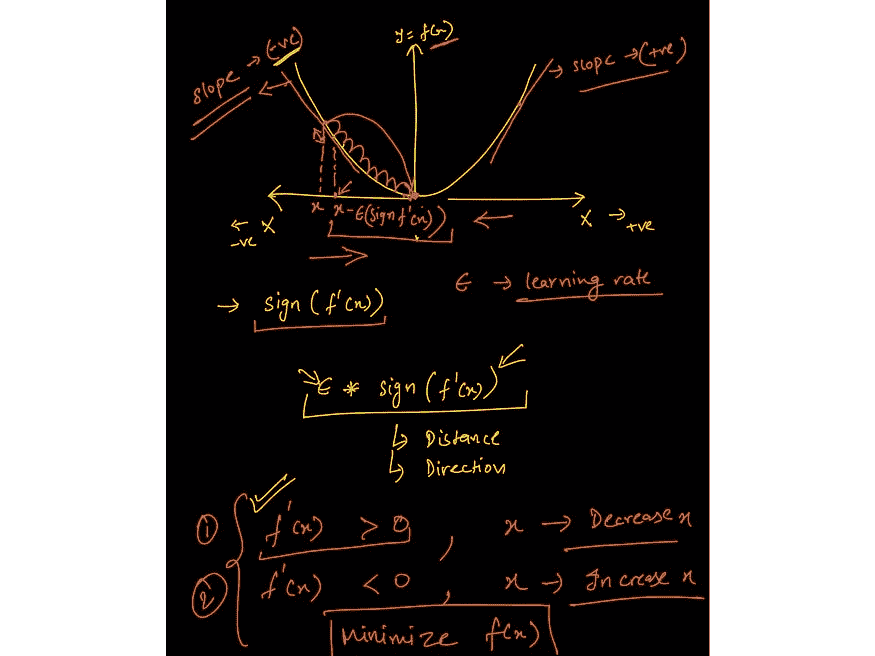

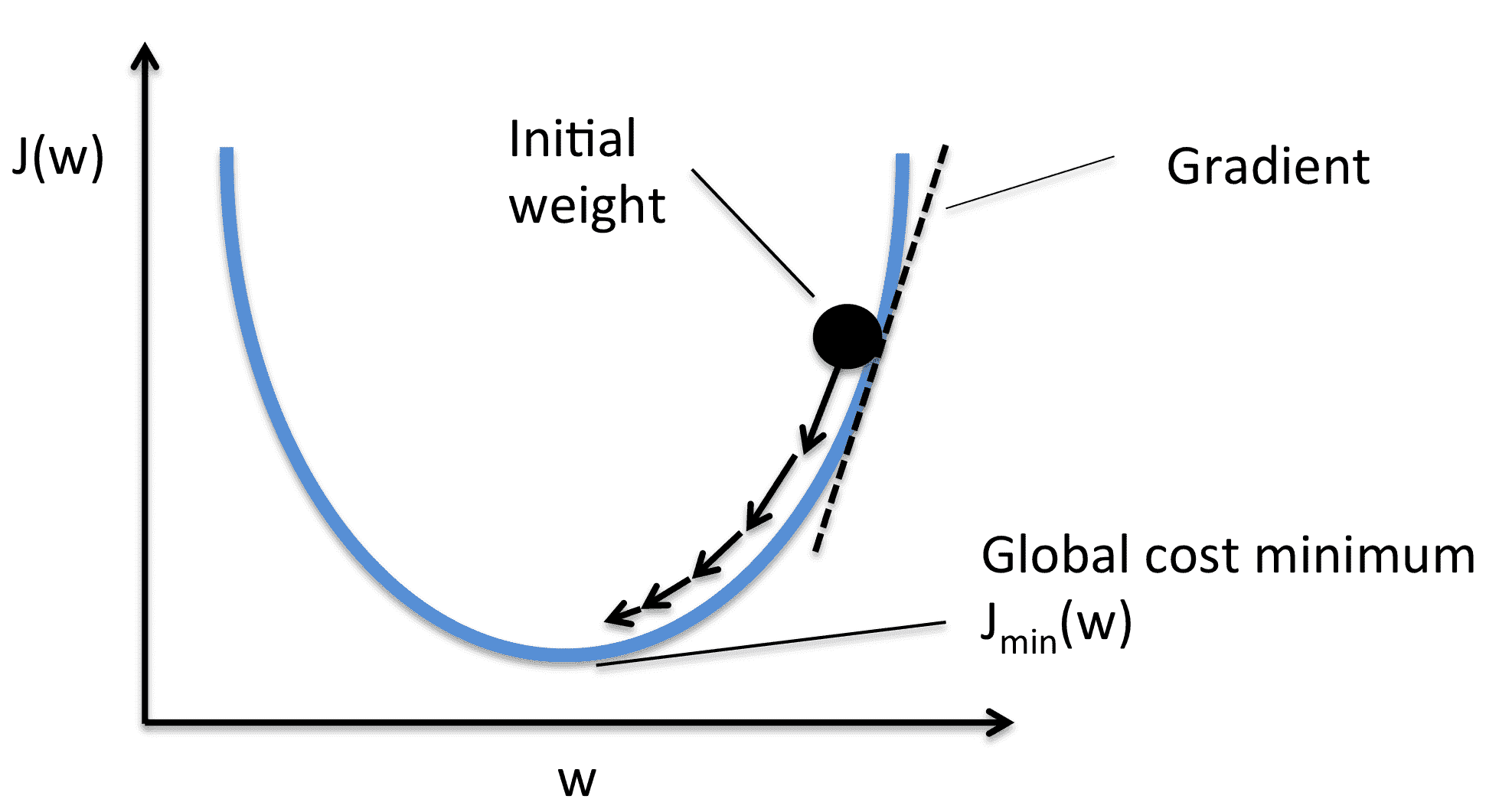

#2 微积分用于训练机器学习模型

来自课程中关于梯度下降的讲座的图像: www.wiplane.com/p/foundations-for-data-science-ml

如果你以为模型训练是“自动进行”的,那么你就错了。微积分是推动大多数机器学习(ML)和深度学习(DL)算法学习的核心。

最常用的优化算法之一——梯度下降法——是偏导数的应用。

模型是某些信念和假设的数学表示。它被认为是学习(近似)数据提供过程(线性、多项式等)的过程,然后基于这个学习到的过程进行预测。

重要主题包括:

-

基础代数 — 变量、系数、方程式以及线性、指数、对数函数等。

-

线性代数 — 标量、向量、张量、范数(L1 和 L2)、点积、矩阵类型、线性变换、矩阵表示线性方程、利用向量和矩阵解决线性回归问题。

-

微积分 — 导数和极限、导数规则、链式法则(用于反向传播算法)、偏导数(计算梯度)、函数的凸性、局部/全局极小值、回归模型背后的数学、从头开始训练模型的应用数学。

#3 基本统计学

现在的每个组织都在努力实现数据驱动。为了实现这一目标,分析师和科学家需要以不同的方式利用数据,以推动决策制定。

描述数据 — 从数据到洞察

数据总是原始且难看。初步探索告诉你缺少什么,数据如何分布,以及清理数据以实现最终目标的最佳方式是什么。

为了回答定义的问题,描述统计使你能够将数据中的每一个观察转化为有意义的洞察。

量化不确定性

此外,量化不确定性的能力是任何数据公司高度重视的最有价值的技能。了解任何实验/决策的成功几率对所有业务至关重要。

这里是一些统计学的主要基础,构成了最低要求:

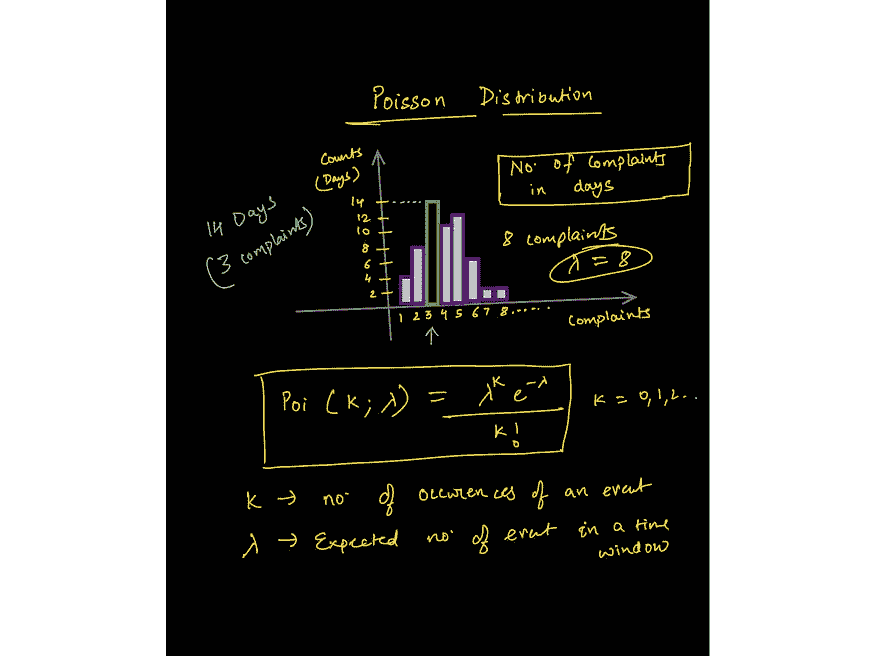

来自关于泊松分布讲座的图像 — www.wiplane.com/p/foundations-for-data-science-ml

-

位置的估计 — 均值、中位数以及这些的其他变体。

-

变异性的估计

-

相关性和协方差

-

随机变量 — 离散和连续

-

数据分布 — PMF、PDF、CDF

-

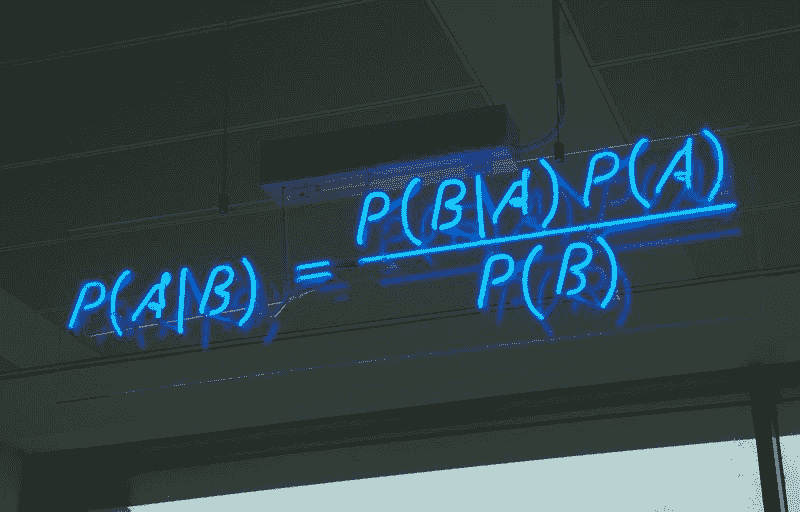

条件概率 — 贝叶斯统计

-

常用的统计分布 — 高斯分布、二项分布、泊松分布、指数分布

-

重要定理 — 大数法则和中心极限定理。

来自关于泊松分布讲座的图像 — www.wiplane.com/p/foundations-for-data-science-ml

-

推断统计 — 一种更实际和高级的统计学分支,有助于设计假设检验实验,推动我们深入理解指标的含义,同时帮助我们量化结果的显著性。

-

重要的测试 — 学生 t 检验、卡方检验、ANOVA 检验等。

每个初学者级别的数据科学爱好者在深入任何核心数据科学或核心机器学习课程之前都应关注这三个支柱

学习上述内容的资源 — 寻找一个紧凑、全面且价格实惠的课程

www.freecodecamp.org/news/data-science-learning-roadmap/

我的学习路线图也告诉你该学习什么,并且也充满了可以注册的资源、课程和项目。

但推荐的资源和我制定的路线图中存在一些不一致之处。

数据科学或机器学习课程的问题

-

我在这里列出的每个数据科学课程都要求学生对编程、数学或统计学有一定的理解。例如,Andrew Ng 最著名的机器学习课程也严重依赖于对向量代数和微积分的理解。

-

大多数涵盖数据科学的数学和统计学的课程,只是列出所需的概念清单,却没有解释这些概念如何应用及如何在机器中编程。

-

有很多优秀的资源可以深入学习数学,但大多数人并不适合,而且学习数据科学并不需要成为金牌得主。

底线: 缺乏一种只涵盖足够应用数学、统计学或编程基础以便入门数据科学或机器学习的资源。

Wiplane Academy — wiplane.com

所以,我决定自己动手做所有的事情。我花了过去 3 个月的时间开发一个课程,以为你的职业生涯奠定坚实的基础……

-

数据分析师

-

数据科学家

-

或者一位机器学习从业者/工程师

在这里,我向你展示 数据科学或机器学习的基础** — **学习数据科学和机器学习的第一步

这就是我决定启动时的样子!

一个全面但紧凑且价格实惠的课程,不仅涵盖所有的基本要素、前提条件和预备工作,还解释了每个概念如何在计算和编程中(Python)使用。

而且这还不是全部。我会根据你的反馈每月更新课程内容。了解更多 这里。

早鸟优惠!

我很兴奋地宣布这门课程的预售,因为我目前正在录制和编辑 2-3 个模块的最终部分,这些模块也将在九月的第一周上线。

抓住早鸟优惠,优惠仅有效至 2021 年 8 月 30 日。

原文。经许可转载。

简介: Harshit Tyagi 是一位具有融合经验的工程师,擅长网页技术和数据科学(即全栈数据科学),曾指导过 1000 多名 AI/Web/数据科学志愿者,同时设计数据科学和机器学习工程学习路径。此前,Harshit 与耶鲁大学、麻省理工学院和加州大学洛杉矶分校的研究科学家一起开发数据处理算法。

相关:

更多相关主题

预算内学习数据科学

图片由 DALLE 提供

找到合适的平台或课程从来不是一件容易的事。这需要很多试错,最糟糕的是当你为这些课程付费时。你会觉得自己一直在寻找最佳课程来提升职业生涯,但最后却回到起点 - 你的钱包也受到了伤害(有时一点,有时很多)。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT 工作

这就是为什么我决定撰写这篇文章,让你可以从我的错误中学习,并以预算内的方式获得所有的数据科学知识!

理解数据科学

链接:理解数据科学

让我们从 DataCamp 开始 - 这是一个提供各种课程的在线学习平台。他们的《理解数据科学》课程专为希望涉足数据科学世界的初学者设计。而且你也不用担心是否有编程经验 - 因为不需要!

这是一个 2 小时的课程,包括 15 个学习视频和 48 个练习题!分为 4 个部分,第一部分“数据科学简介”是免费的,其余 3 个部分需要你获取会员资格。会员价格合理,通过它你可以访问 DataCamp 的完整内容库,方便你在学习额外课程时使用。

从零开始的数据科学

链接:从零开始的数据科学

这是针对那些喜欢用书本作为学习方法的书虫们。在《从零开始的数据科学》这本书中,你将学习数据科学的学科内容,例如库、框架、模块和工具包。还会了解算法的工作原理以及如何从头开始实现它们。

如果你正在寻找 Python 的速成课程,想要学习数据科学的基础,深入了解机器学习的基本原理,并进一步探索 - 这本书就是为你准备的。

概率论简介

链接:概率论简介

一门为期 10 周的免费课程来自哈佛!虽然有很多在线训练营课程,但概率有时会被忽略。然而,它对于理解数据科学基础至关重要。学习概率可以让你从‘良好的’数据科学家成长为‘专家’数据科学家。

在这门课程中,你将学习不确定性和随机性、做出准确预测、常见概率分布等内容。课程是免费的,但你可以为 209 美元添加一个认证证书。

Python in a Nutshell

Python 已经被评为最受欢迎的编程语言之一——这有其原因。它简单的语法使得人们能够轻松过渡到数据科学的世界。对数据专业人士的需求很大,Python 语言无疑开辟了道路。

这本第四版《Python in a Nutshell》书包含了 26 章内容,可以带你从 Python 完全新手成为绝对专家!从在 Python 中表示数据到调试——这本书应有尽有!

数据分析与 Python

链接:数据分析与 Python

Freecodecamp.org 最初是一个希望让学习对每个人都可及的组织——这就是它名字的由来。如果你在寻找一门全面的课程,那么这门数据分析与 Python 课程强烈推荐。数据科学世界发生了很多变化,尤其是 Python、SQL 等等。

在这门课程中,你将学习成为数据科学家的绝对基础,从读取自己的数据到使用库分析数据和创建数据可视化。

总结

通过这 5 门课程/平台,你将能够从对数据科学一无所知到完善简历,申请你的第一份数据科学职位。数据科学仍然是一个非常受欢迎的角色,现在开始再好不过了!

Nisha Arya 是一名数据科学家、自由撰稿人、编辑及 KDnuggets 的社区经理。她特别关注提供数据科学职业建议、教程以及基于理论的数据科学知识。Nisha 涵盖了广泛的话题,并希望探索人工智能如何能促进人类寿命的不同方式。作为一个热衷学习者,Nisha 旨在拓宽自己的技术知识和写作技能,同时帮助他人。

更多相关主题

学习深度学习的地方 – 课程、教程、软件

原文:

www.kdnuggets.com/2014/05/learn-deep-learning-courses-tutorials-overviews.html

评论 Gregory Piatetsky,@kdnuggets,2014 年 5 月 26 日。

评论 Gregory Piatetsky,@kdnuggets,2014 年 5 月 26 日。

深度学习是机器学习研究的一个热门领域,取得了许多显著的成功,例如在面部识别中达到 97.5%的准确率、几乎完美的德国交通标志识别,甚至在狗与猫图像识别中达到 98.9%的准确率。最近许多 Kaggle 数据科学竞赛的获胜作品都使用了深度学习。

“深度学习”一词指的是训练多层神经网络的方法,并在 Geoffrey Hinton 及其合作者发表的论文之后变得流行,这些论文展示了一种快速训练这些网络的方法。

Yann LeCun,Geoff Hinton 的学生,还开发了一种非常有效的深度学习算法,称为,该算法在 80 年代末和 90 年代初成功用于自动读取支票上的金额。

在我的独家与 Yann LeCun 的采访中,了解更多关于卷积网络和推动深度学习成功的因素。

2014 年 5 月,中国搜索巨头百度聘请了 Andrew Ng,一位领先的机器学习和深度学习专家(也是 Coursera 的联合创始人),来领导他们在硅谷的新 AI 实验室,与谷歌(聘请了 Geoff Hinton)和 Facebook(聘请了 Yann LeCun 来领导 Facebook AI 实验室)展开 AI 和深度学习的竞赛。

这里有一些有用且免费的 (!) 深度学习资源:

-

DeepLearning.net,专注于深度学习的网站

-

深度学习维基百科 页面

-

NYU 深度学习课程材料 由 Yann LeCun 提供

-

Yann LeCun 关于深度学习的概述 与 Marc'Aurelio Ranzato

-

Geoff Hinton Coursera 课程 关于神经网络

-

深度学习:方法与应用书籍(134 页)来自微软语音组

-

CMU 阅读列表,包括学生笔记

-

观看:John Kaufhold 的深度学习教程,2014 年华盛顿特区数据科学聚会

-

深度学习课程在哪里?,由数据科学家兼深度学习分析的管理合伙人 John Kaufhold 撰写的博客。

-

深度学习将如何改变我们的世界,Jeremy Howard 在墨尔本数据科学会议上的总结。

支持深度学习的包包括

-

Torch7,是 LuaJIT 语言的扩展,包括一个面向深度学习和计算机视觉的面向对象包。Torch7 的主要优势是 LuaJIT 非常快且灵活。

-

Theano + Pylearn2,具有使用 Python(广泛使用)的优势,但也有使用 Python(处理大数据时较慢)的劣势。

-

cuda-convnet,基于 Yann LeCun 工作的高性能 C++/CUDA 卷积神经网络实现。

相关内容:

-

KDnuggets 独家:对深度学习专家 Yann LeCun 的采访,Facebook AI Lab 的主任

-

KDnuggets 独家:对 Yann LeCun 的采访第二部分

-

深度学习如何模拟人脑

-

深度学习在 Kaggle 的“狗与猫”竞赛中获胜

更多相关内容

使用R学习广义线性模型(GLM)

原文:https://www.kdnuggets.com/2017/10/learn-generalized-linear-models-glm-r.html/2

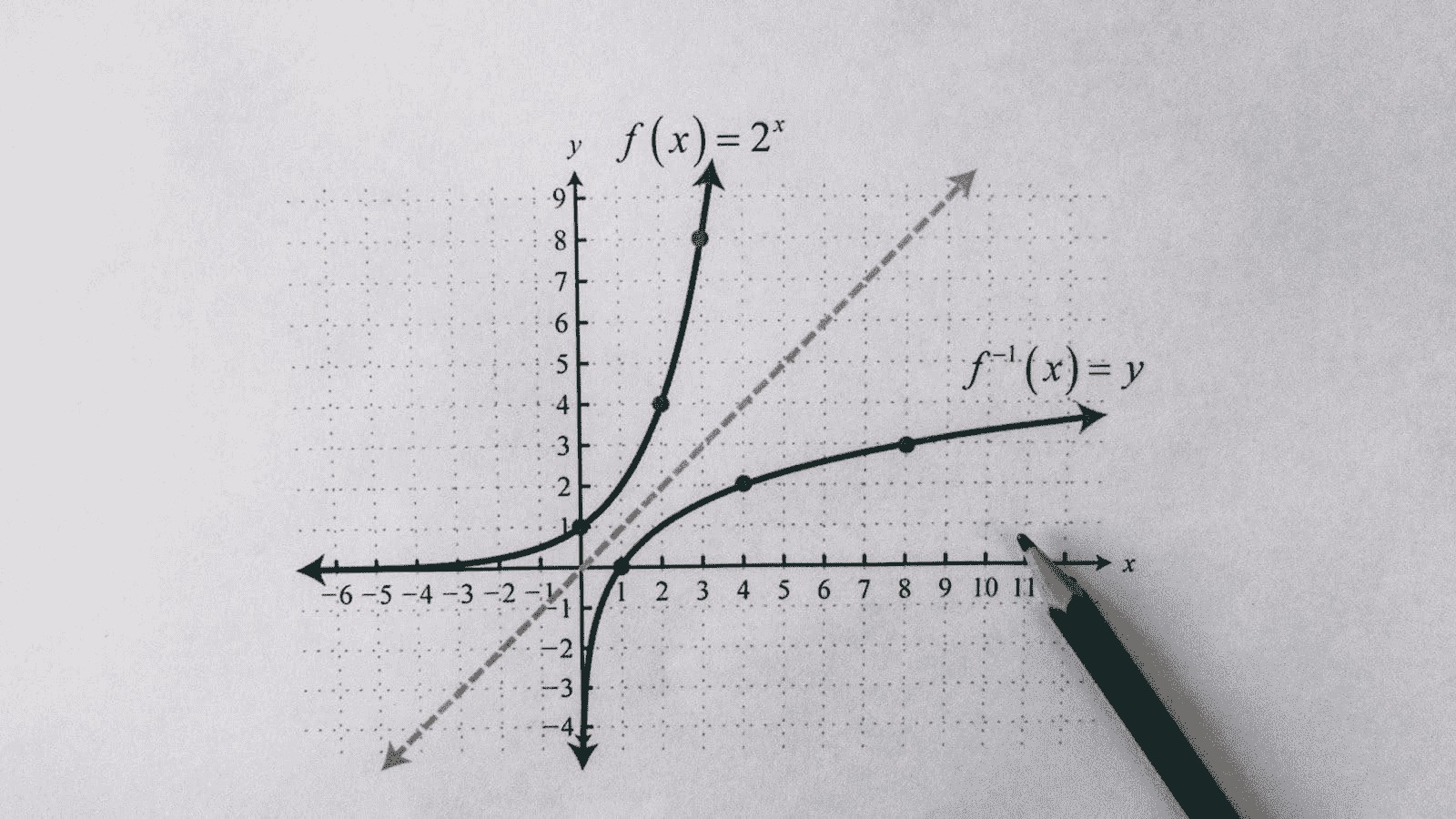

解释对数变换

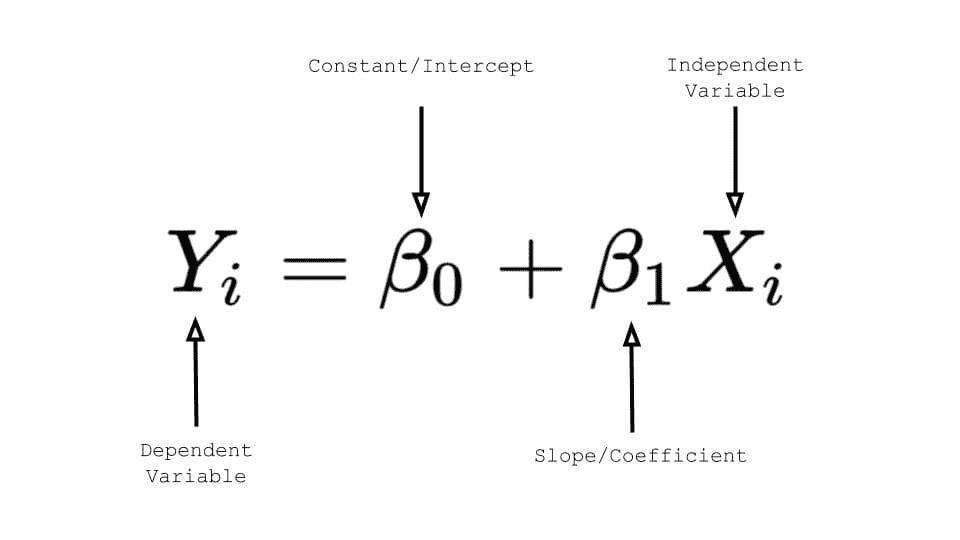

对依赖数据和独立数据进行对数变换是一种处理非线性关系的简单方法。这种变换有助于使用线性模型分析非线性关系。我们已经讨论了对数线性回归。还有两个变体 – a) 线性–对数回归 –独立变量进行对数变换,b) 对数–对数回归 –依赖变量和独立变量都进行变换。下表显示了每个模型的方程和解释。

我们的前3个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织的IT需求

3. Google IT 支持专业证书 - 支持你的组织的IT需求

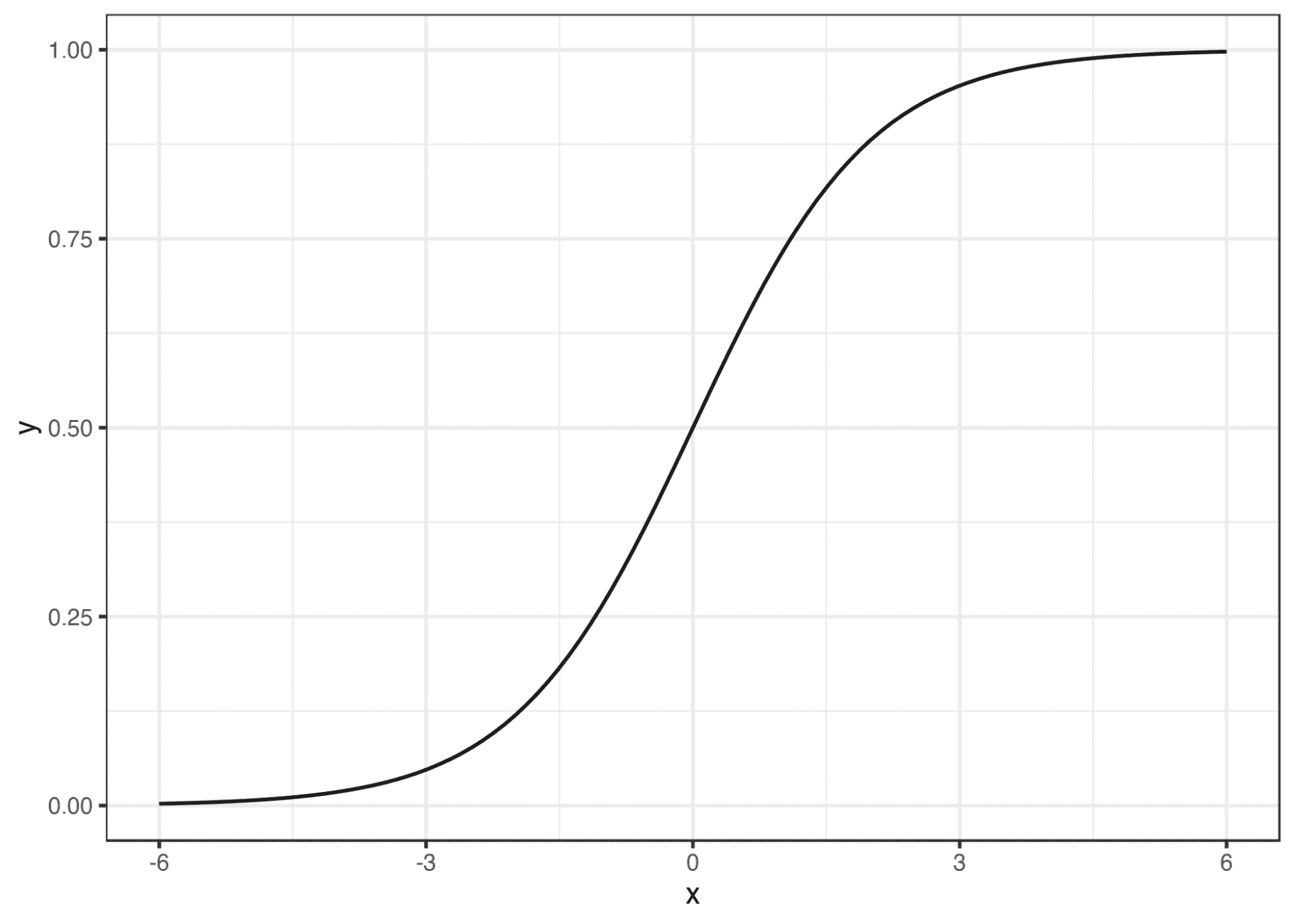

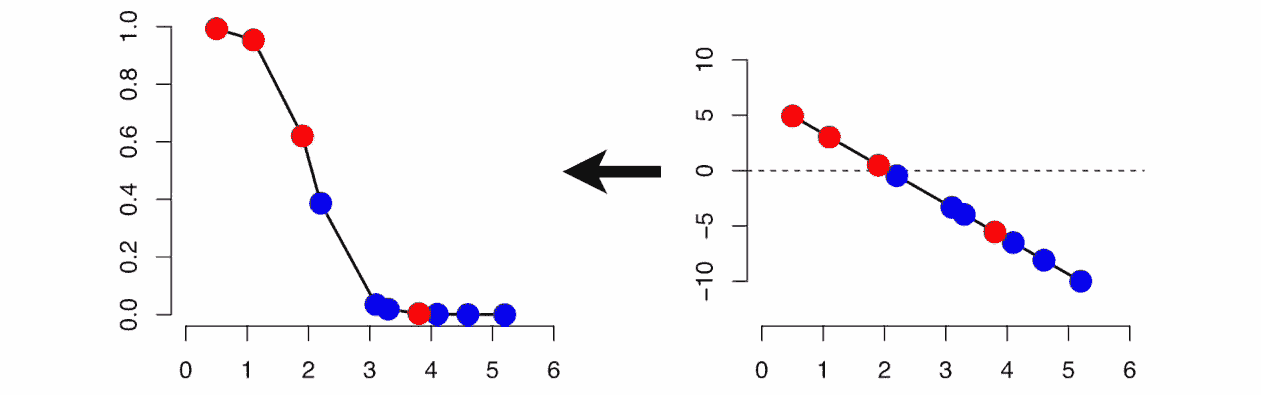

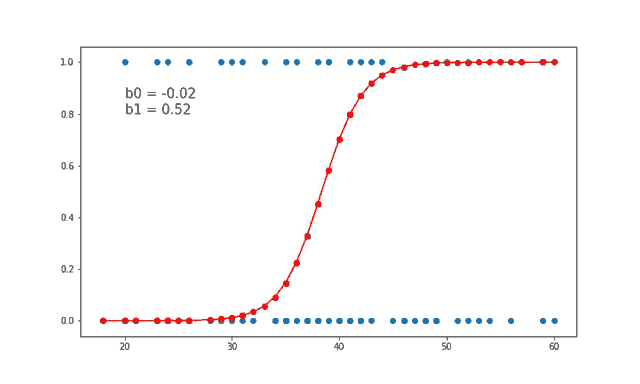

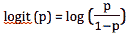

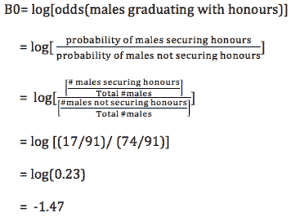

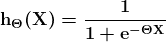

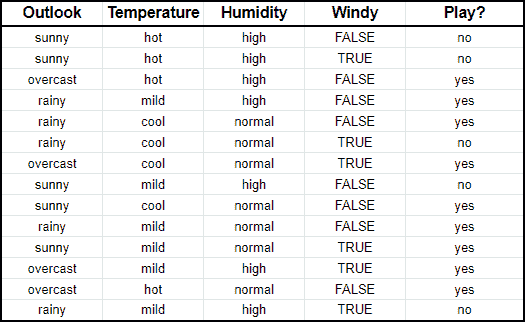

表2 二项逻辑回归的样本数据

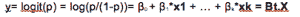

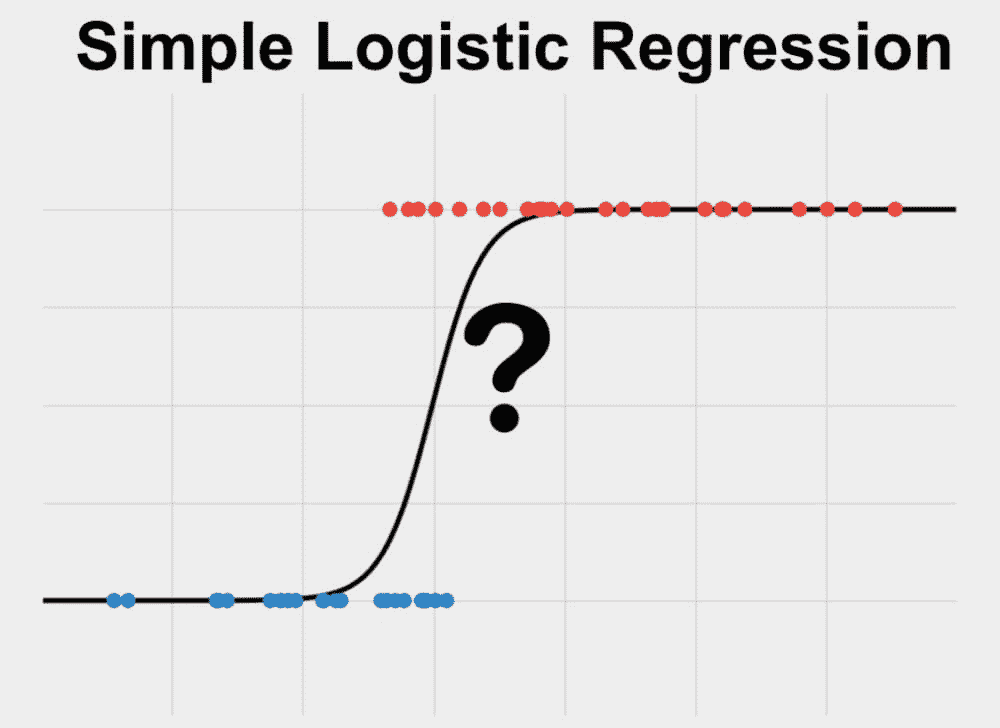

二项逻辑回归

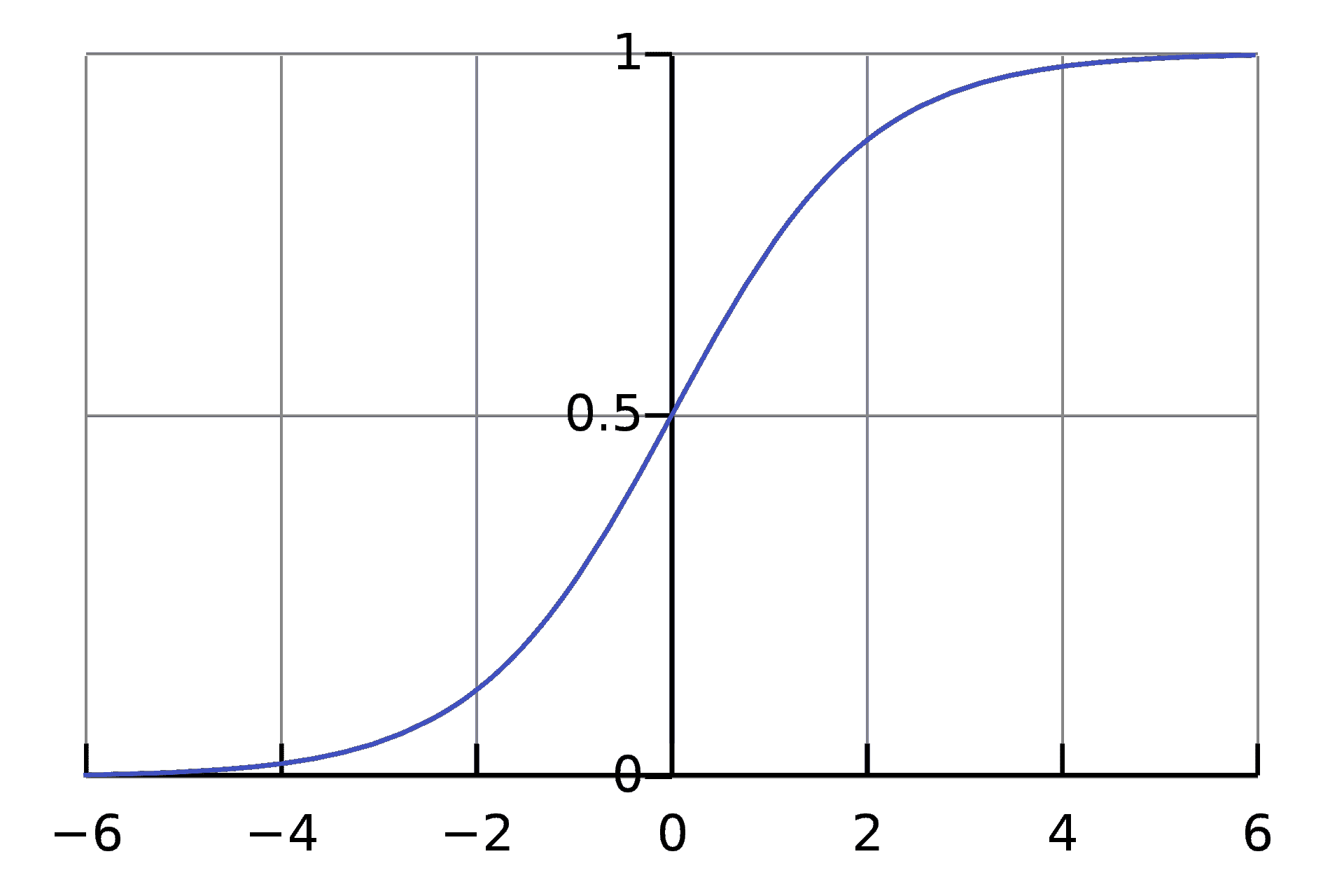

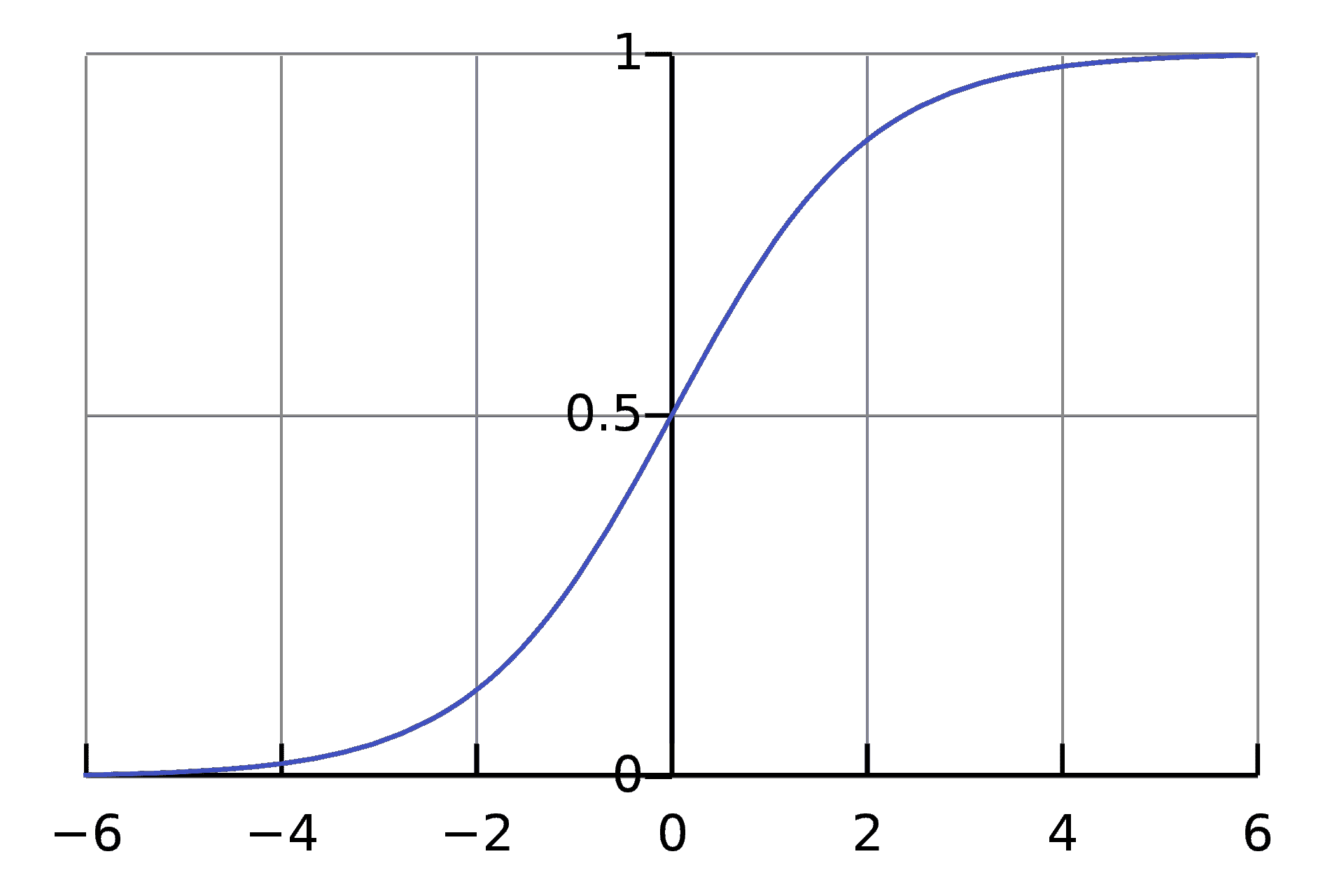

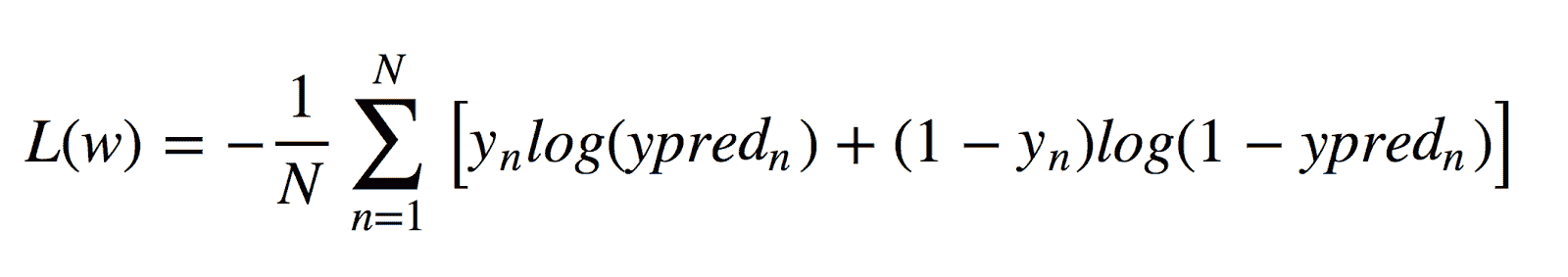

当依赖变量是类别型且取值为0和1时,使用二项逻辑回归。与简单线性回归中依赖变量的条件分布为正态分布不同,逻辑回归中的条件分布为伯努利分布。在伯努利分布中,变量只能取两个值 – 0和1,具有一定的概率。

让我们通过一个例子来理解。假设在足球中,将罚球转换为进球的能力取决于射门者的练习小时数。我们可以用1表示成功罚球,用0表示未成功罚球。数据如下:

表2 二项逻辑回归的样本数据

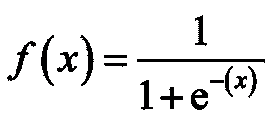

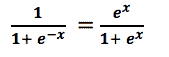

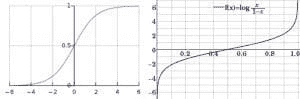

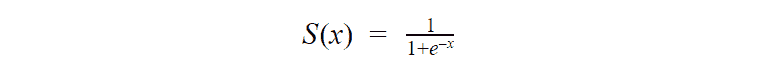

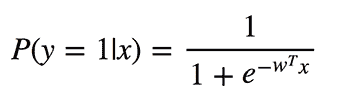

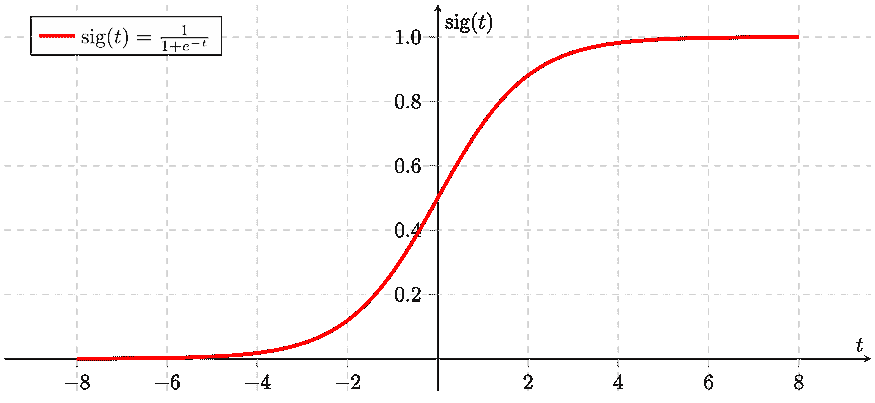

二项逻辑回归模型将根据练习小时数输出成功罚球的概率。逻辑回归使用逻辑函数来建模关系。逻辑函数允许将关系建模为概率,因为它的值在0和1之间。其表示如下:

[4]

[4]

β1 的正值(负值)表示当 X 增加时 Y=1 的概率增加(减少)。逻辑回归是广泛使用的类别预测模型之一。多项式逻辑回归将二分类模型扩展到处理涉及多个类别的问题。例如,一个人是否会兑换优惠券 A、优惠券 B 或优惠券 C。现在我们将在 R 中实现逻辑回归模型。样本数据包括两个变量——点球成功/失败表示为 1/0 和练习小时。请点击这里下载。R 代码如下:

## Prepare scatter plot

#Read data from .csv file

data1 = read.csv("Penalty.csv", header = T)

head(data1)

#Scatter Plot

plot(data1, main = "Scatter Plot")

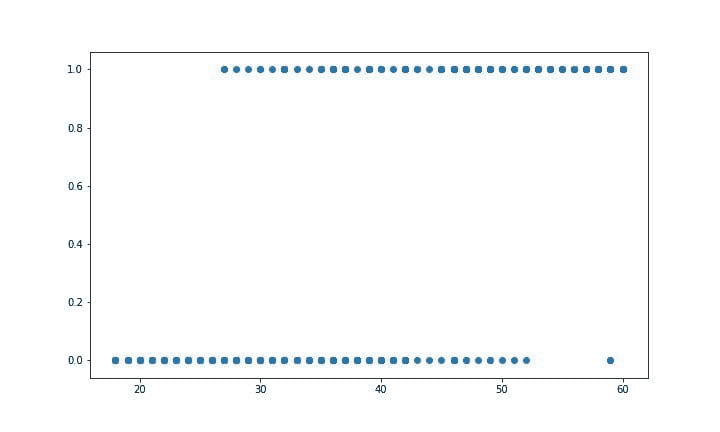

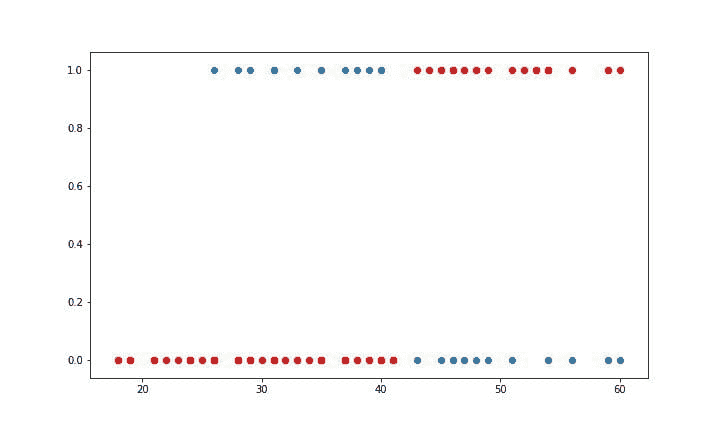

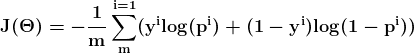

图 4 类别数据的散点图

我们可以观察到,因变量仅能取两个值——1和0。当练习时间增加时,玩家的效率也提高。现在我们将使用逻辑回归准备一个模型来预测基于练习时间的成功或失败的概率。R 代码如下:

## Fitting Logistic regression model

fit = glm(Outcome ~ Practice, family = binomial(link = "logit"), data = data1)

#Plot probabilities

plot(data1, main ="Scatter Plot")

curve(predict(fit,data.frame(Practice = x), type = "resp"), add = TRUE)

points(data1$Practice,fitted(fit),pch=20)

图 5 显示了从逻辑回归中获得的概率值。我们可以看到模型表现良好。随着练习时间的增加,成功的概率也增加。该模型在方程 [5] 中表示。可以通过插入练习小时数来获得概率值。

[5]

[5]

图 5 使用逻辑回归的概率图

结论

在这篇文章中,我们学习了广义线性模型(GLM)。简单线性回归是 GLM 的最基本形式。GLM 的高级形式有助于以简单的方式处理非正态分布和非线性关系。我们重点介绍了对数线性回归和二元逻辑回归。当因变量与自变量之间的关系是非线性时,对数线性回归非常有用。当因变量遵循对数正态分布或泊松分布时,它也提供了快速的解决方案。

此外,我们讨论了二元逻辑回归的基本概念。当因变量遵循伯努利分布,即只能取 0 和 1 的值时,二元逻辑回归非常有用。我们还提供了各种对数变换的方程和解释,这些变换与回归模型一起使用。

除了理论解释,我们还分享了 R 代码,以便你可以在 R 中实现该模型。为了更好地理解,我们展示了结果和代码。

我们希望你觉得这篇文章有用。

个人简介: Chaitanya Sagar 是 Perceptive Analytics 的创始人兼首席执行官。Perceptive Analytics 被《Analytics India Magazine》评选为值得关注的十大分析公司之一。该公司致力于为电子商务、零售和制药公司提供市场分析服务。

相关内容:

相关主题

-

线性回归与逻辑回归:简明解释

在我们将探讨对数线性模型的解释。log(a) 是常数项,log(b) 是 Y 随 X 单位变化而增长的增长率。log(b) 的负值表明 Y 会因为 X 的单位增加而以一定百分比减少。接下来,我们将使用可口可乐销售数据在 R 中实现该模型。R 代码如下。

## Fitting Log-linear model

# Transform the dependent variable

data$LCola = log(data$Cola, base = exp(1))

#Scatter Plot

plot(LCola ~ Temperature, data = data , main = "Scatter Plot")

#Fit the best line in log-linear model

model1 = lm(LCola ~ Temperature, data)

abline(model1)

#Calculate RMSE

PredCola1 = predict(model1, data)

RMSE = rmse(PredCola1, data$LCola)

图 3 对数线性回归给出的最佳拟合线

图 3 显示了使用对数线性回归的最佳拟合线。我们可以将其视为一个两步过程,即对数据进行变换(对两边取对数),然后对变换后的数据进行简单线性回归。计算出的模型如下:

[3]

[3]

可乐销售量可以通过将温度值代入方程[3]来预测。我们观察到与简单线性回归相比,拟合效果有了很大改善。变换后的模型的RMSE仅为0.24。请注意,日志线性回归也解决了可乐销售量出现荒谬负值的问题。对于任何温度值,我们都不会得到负的可乐销售量。简单的对数变换帮助我们处理了这种荒谬情况。在下一部分,我们将讨论其他在各种情况下非常有用的对数变换。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力。

3. 谷歌IT支持专业证书 - 支持你的组织IT需求。

3. 谷歌IT支持专业证书 - 支持你的组织IT需求。

更多相关话题

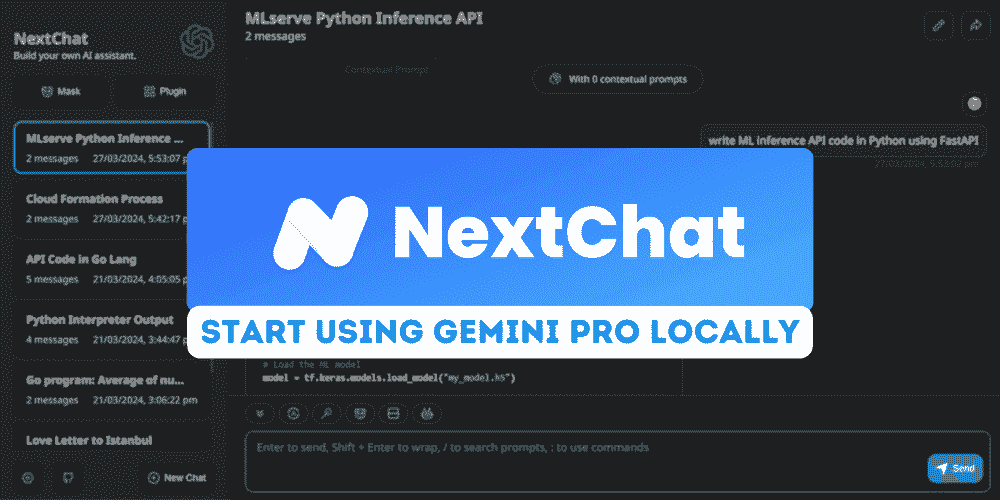

学习如何免费使用 ChatGPT Next Web (NextChat)

原文:

www.kdnuggets.com/learn-how-to-use-chatgpt-next-web-nextchat-for-free

作者提供的图片

ChatGPT Next Web,现在称为 NextChat,是一个聊天机器人应用,允许用户访问来自 OpenAI 和 Google AI 的先进 AI 模型。该应用程序轻量且功能丰富,提升了用户体验。

我们的前 3 个课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

1. Google 网络安全证书 - 快速开启网络安全职业生涯。

2. Google 数据分析专业证书 - 提升您的数据分析技能

2. Google 数据分析专业证书 - 提升您的数据分析技能

3. Google IT 支持专业证书 - 支持您的组织 IT 工作

3. Google IT 支持专业证书 - 支持您的组织 IT 工作

在本教程中,我们将学习如何免费获取 Google AI API,并使用 ChatGPT Next Web 生成响应。此外,我们还将学习如何在 Windows 11 上本地使用它。最后,我们将在不到一分钟的时间内将自己的网页应用部署到 Vercel。

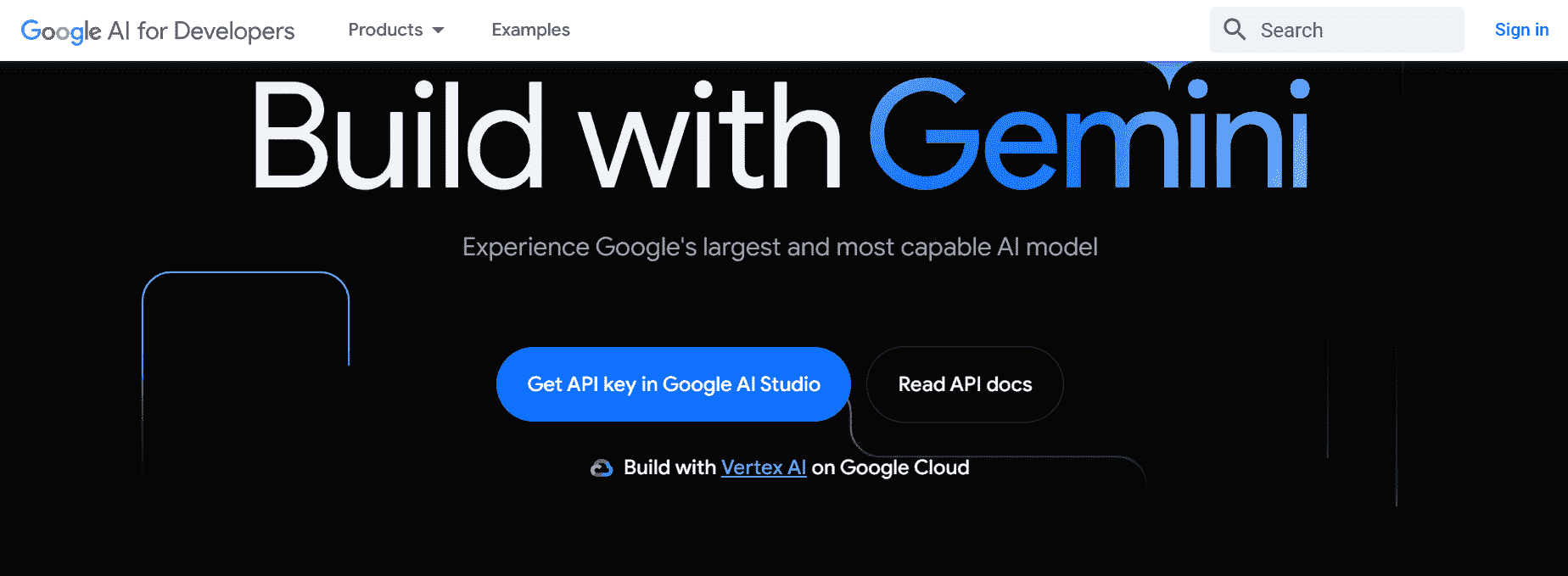

1. 获取免费的 Google AI API

要获取 Google AI API 密钥,我们需要访问 ai.google.dev/ 然后点击蓝色按钮“获取 API 密钥 Google AI Studio”。

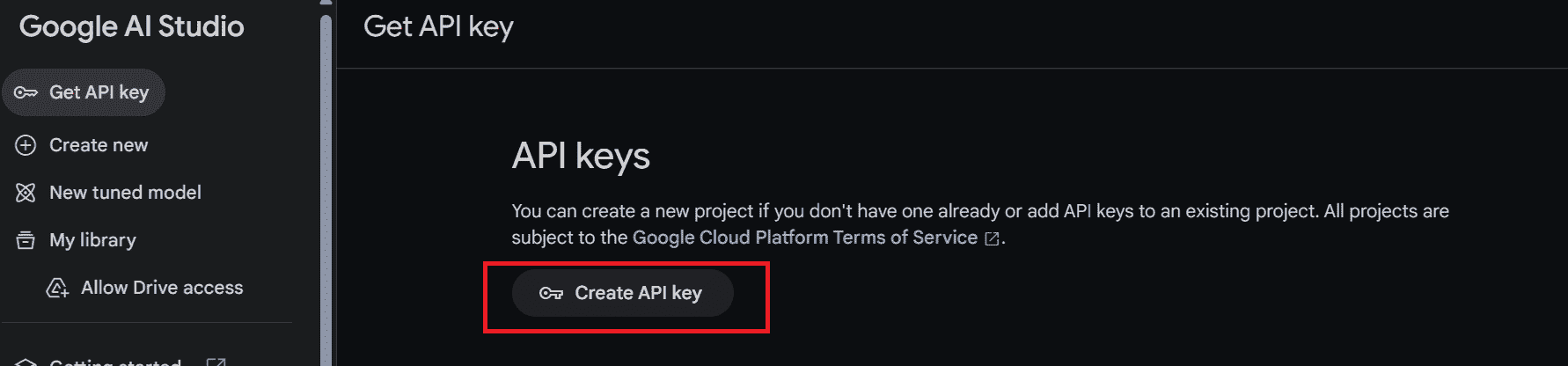

如果您已登录 Google 帐户,将会被引导至 Google AI Studio。在那里,点击左侧面板上的“获取 API 密钥”按钮,然后选择“创建 API 密钥”以生成 API 密钥。

此密钥将用于在官方网页应用、本地以及我们部署的应用中生成响应。

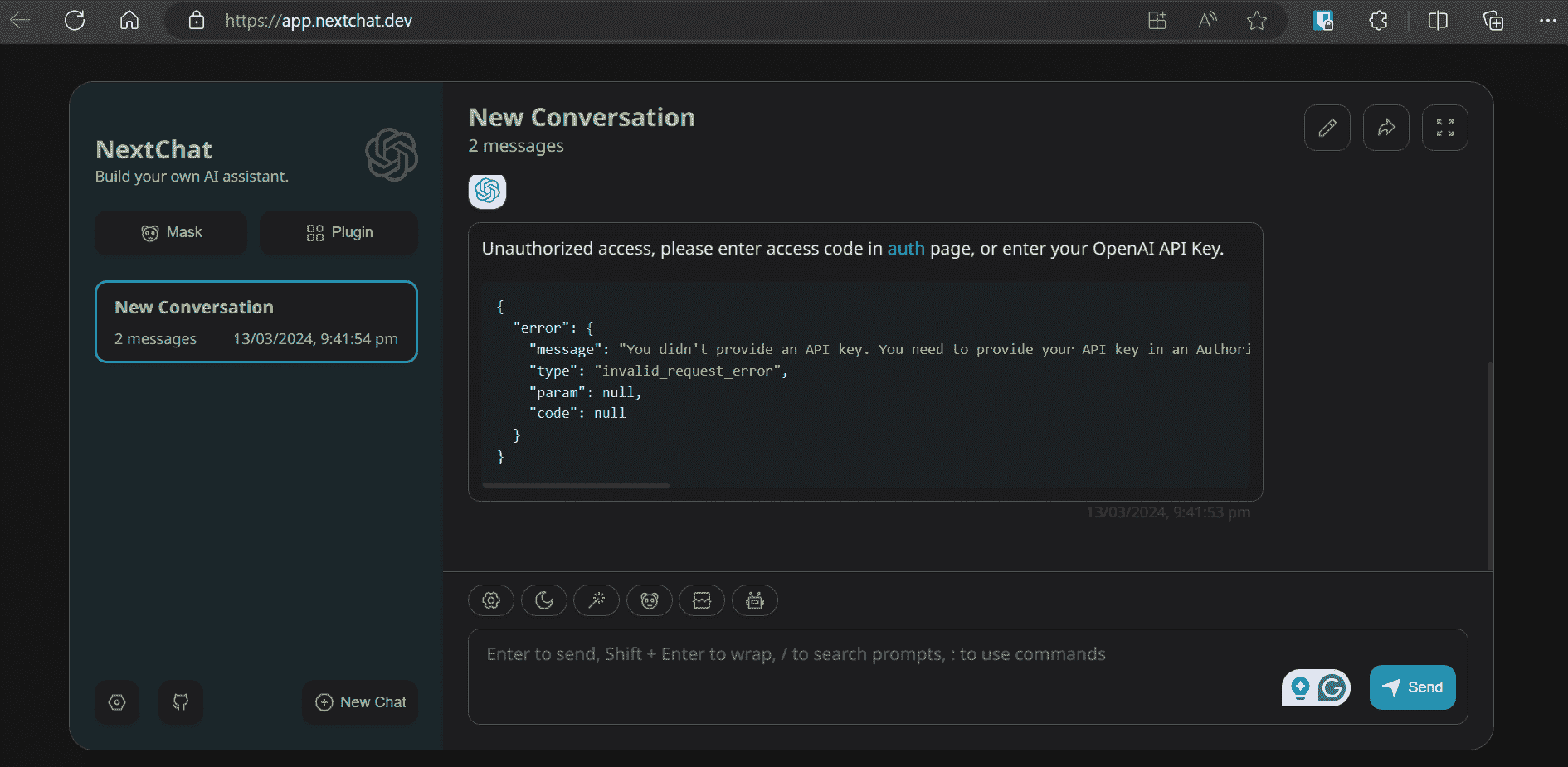

2. 官方网页应用

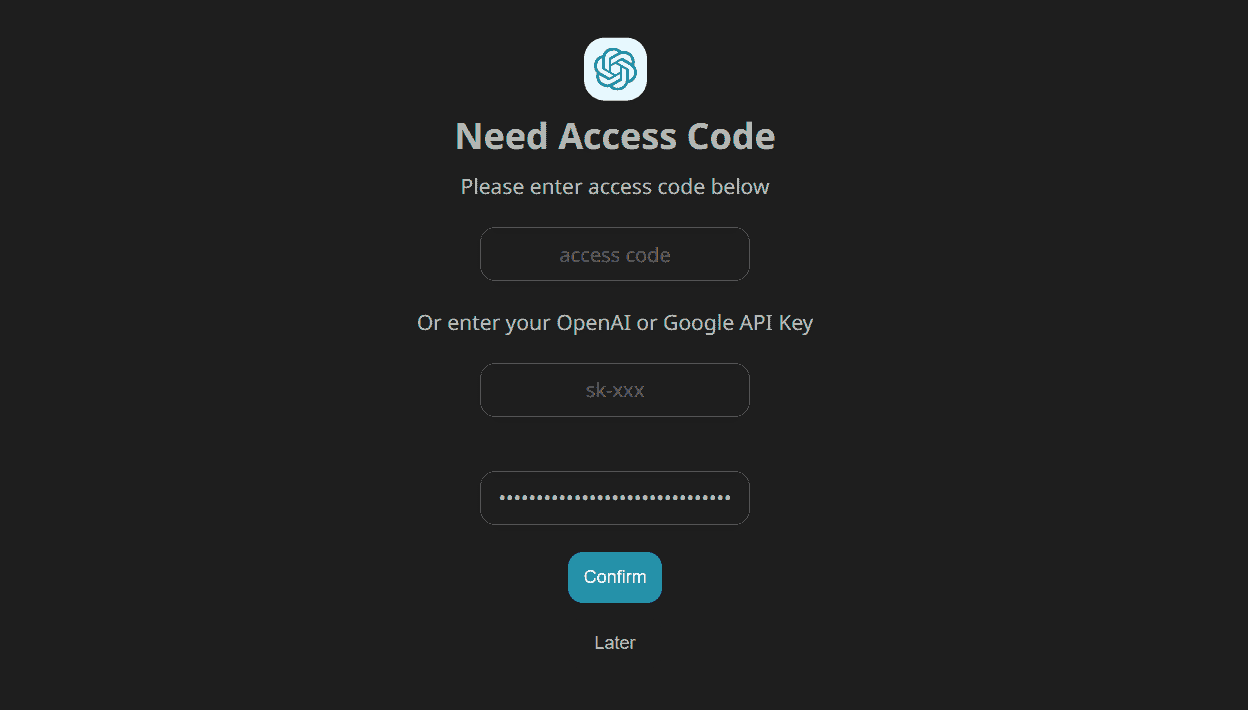

要访问官方 ChatGPT Next Web,请访问 app.nextchat.dev/。它会要求我们提供 API 密钥,通过访问身份验证页面完成。

访问身份验证页面,地址为 app.nextchat.dev/#/auth,在第三个文本框中输入新创建的 Google AI API 密钥,然后点击“确认”按钮。

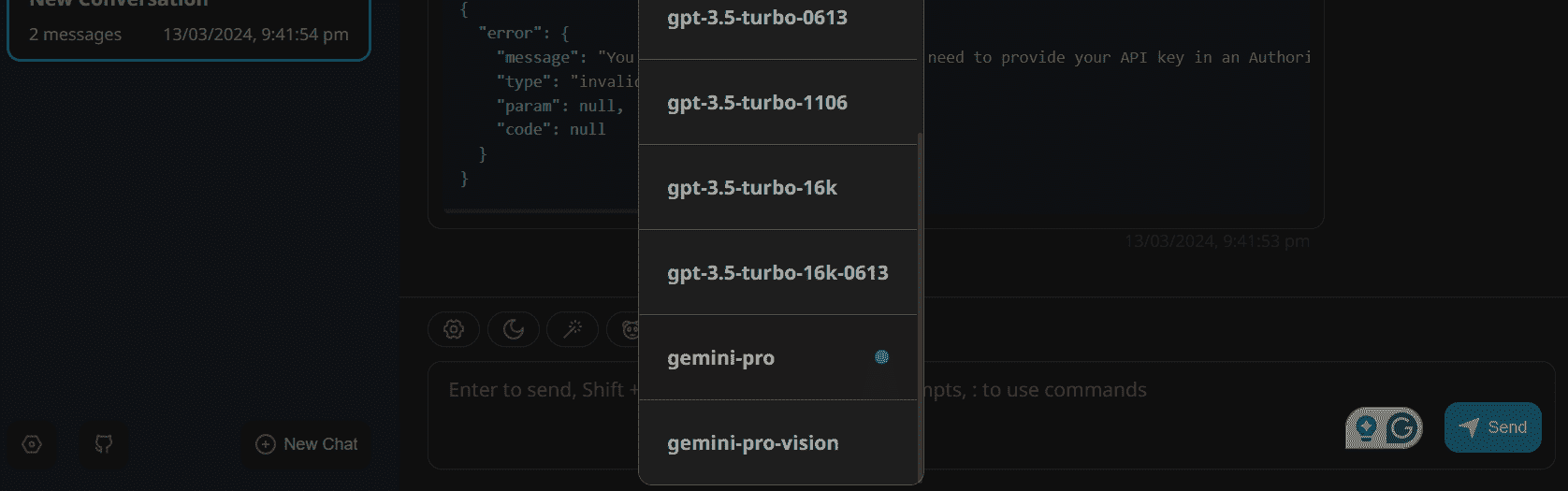

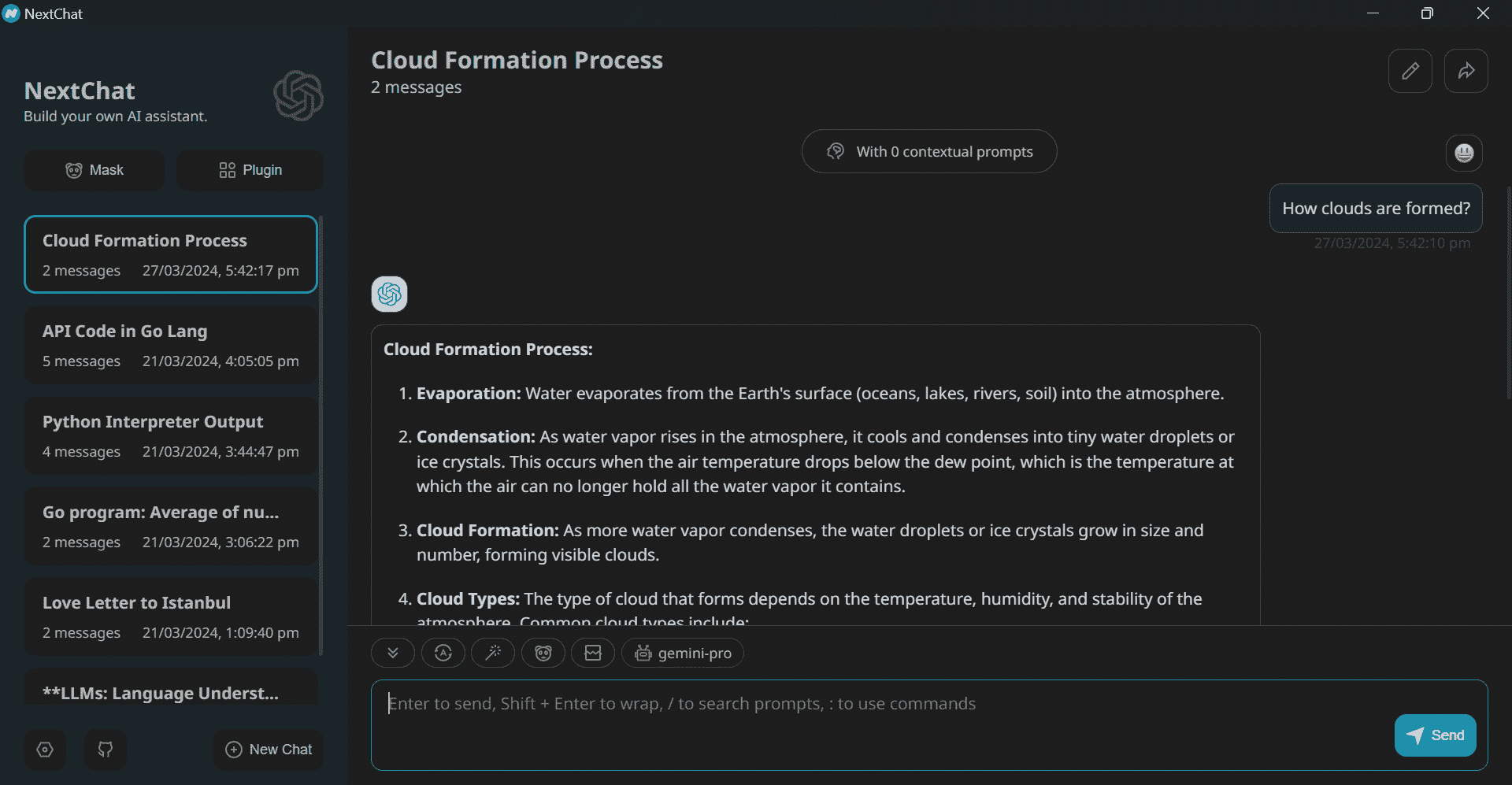

点击消息框上方的机器人(🤖),选择“gemini-pro”模型。

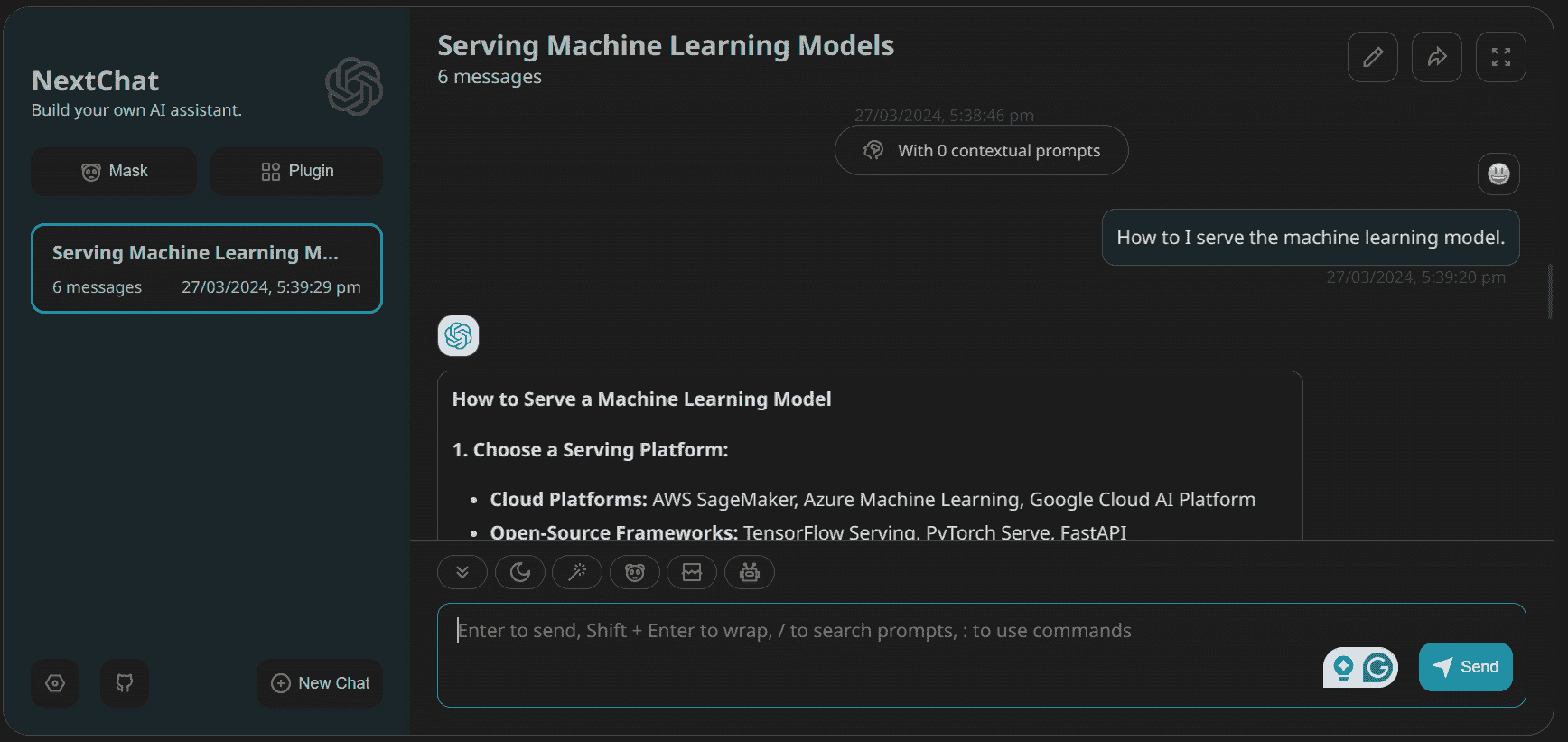

在消息框中输入提示,几秒钟内它将开始生成响应。使用起来既快速又有趣。

3. 本地 Windows 应用程序

让我们继续在你的笔记本电脑上安装 ChatGPT Next Web。这款应用程序兼容 Linux、Windows 和 MacOS。

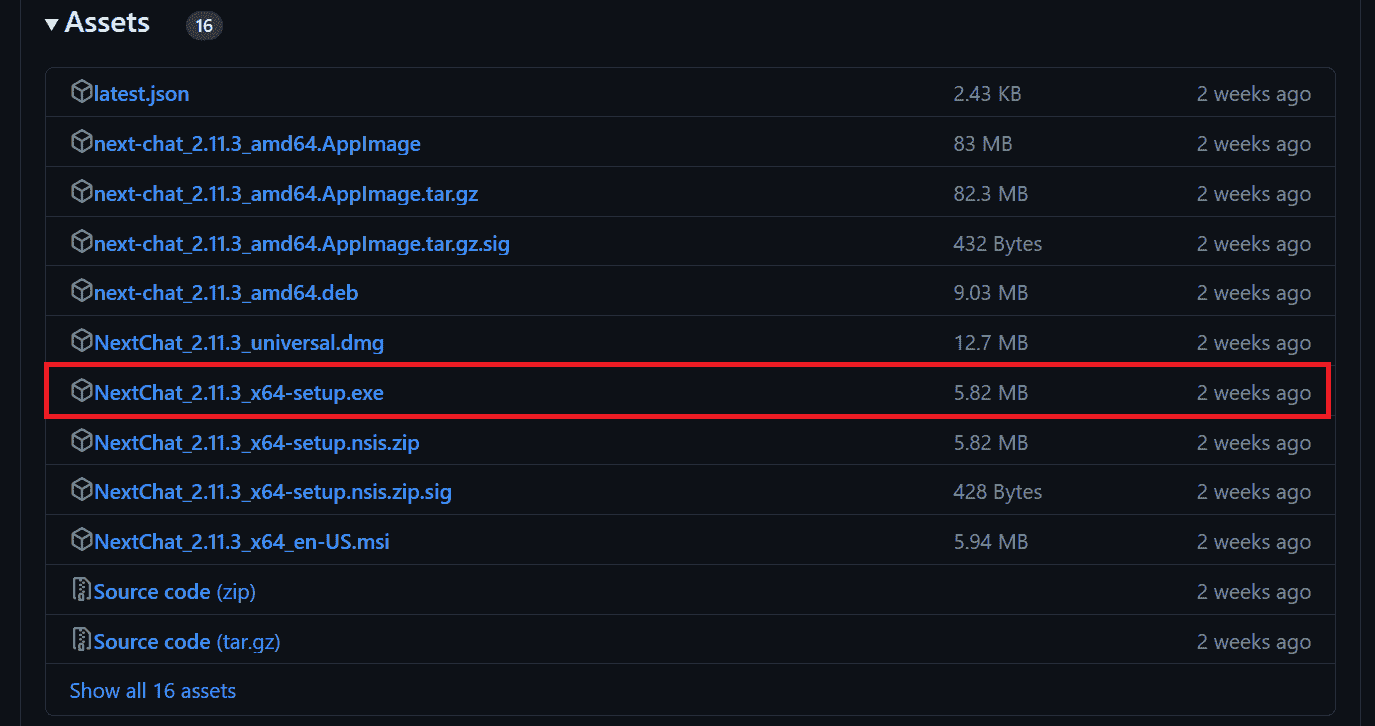

在我们的例子中,我们将访问以下链接:github.com/ChatGPTNextWeb/ChatGPT-Next-Web/releases,点击 .exe 文件。这将下载应用程序安装文件。下载完成后,使用默认设置安装应用程序并启动它。

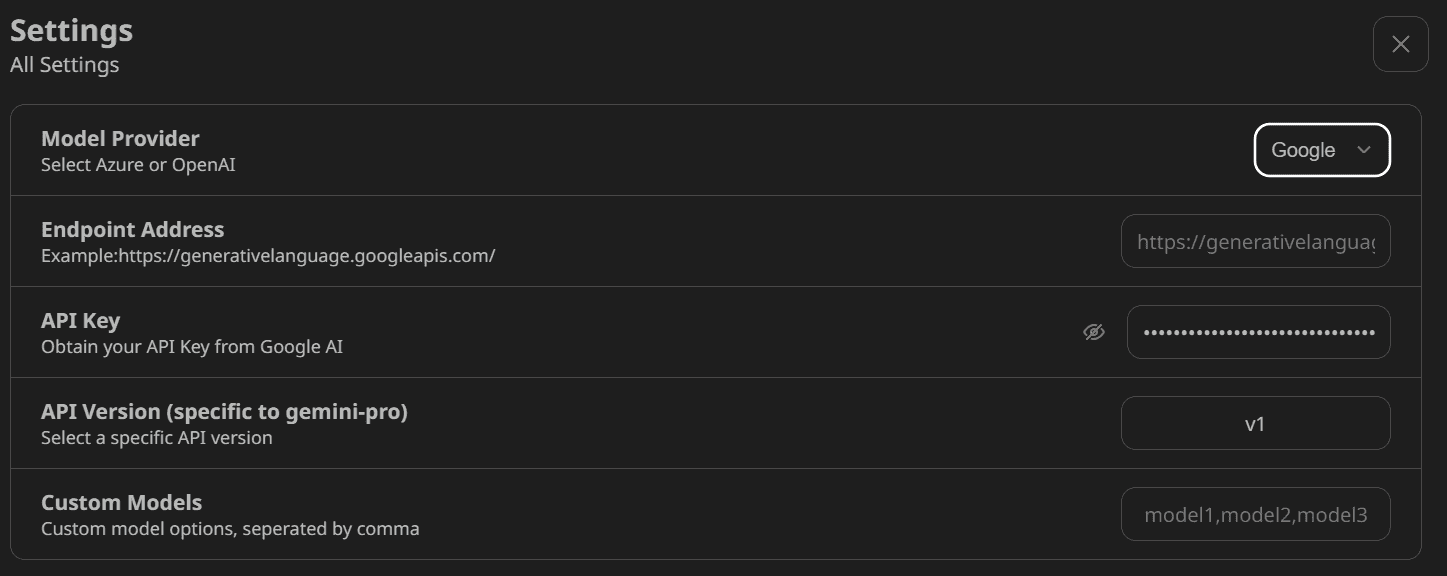

Windows 应用程序没有身份验证页面。因此,要设置 Google AI API,我们需要进入设置并向下滚动找到“模型提供者”部分。从那里,我们应该选择正确的模型提供者并提供 API 密钥,如下所示。

之后,选择“gemini-pro”模型并开始使用应用程序。

4. 一键部署你的网页应用程序

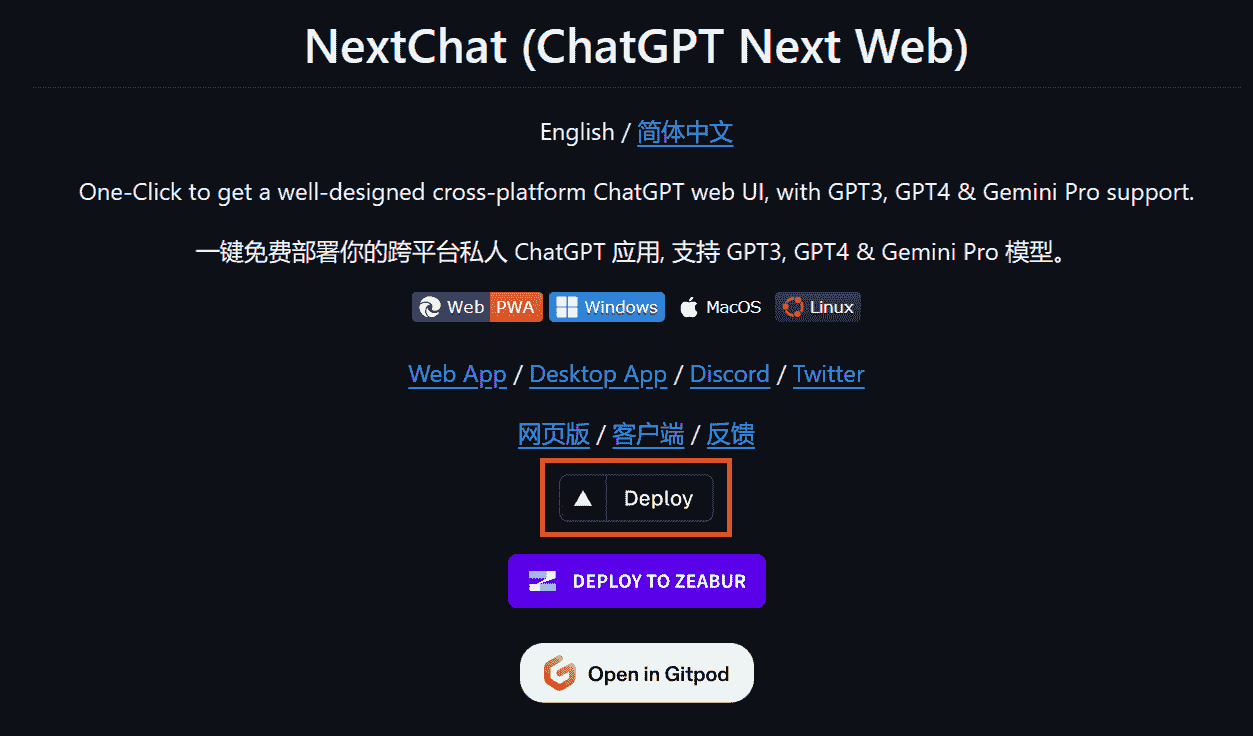

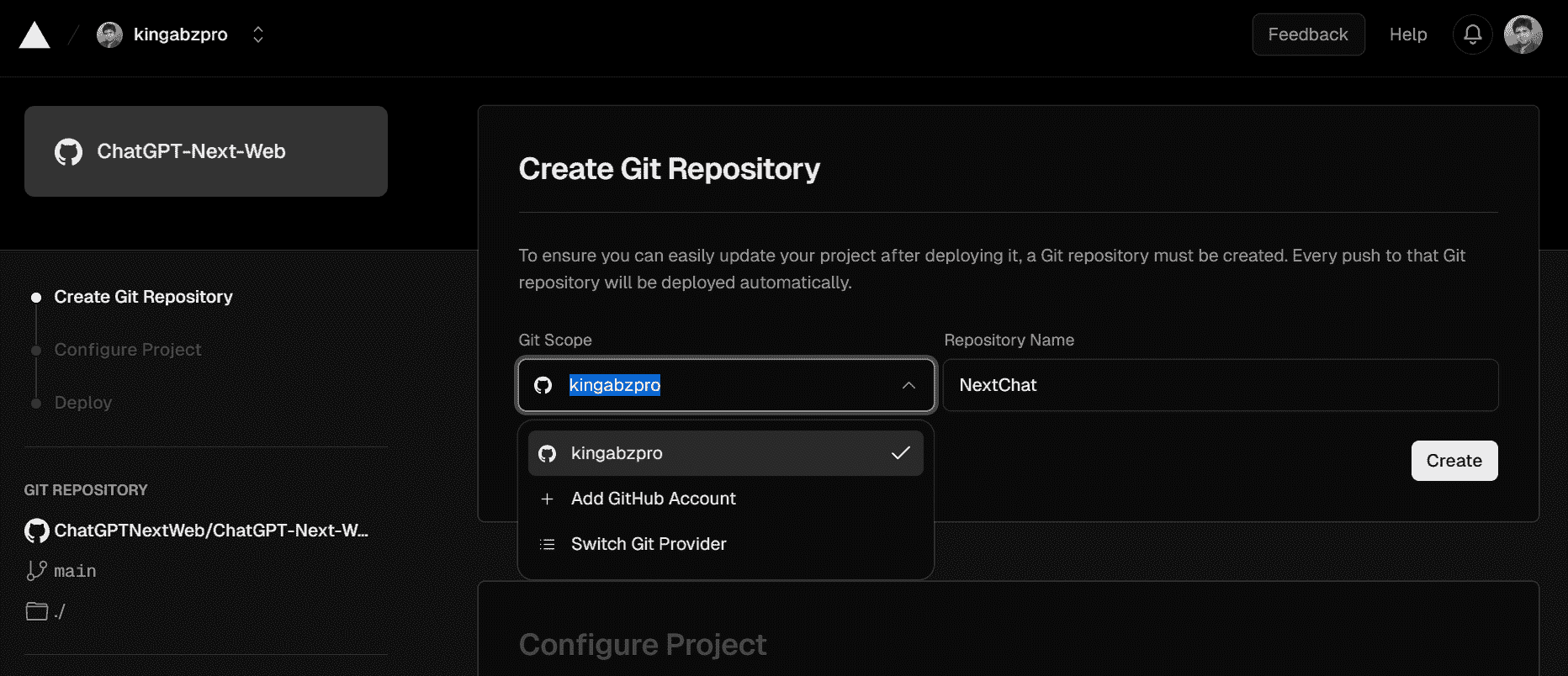

在最后一部分,我们将学习如何在 Vercel 上部署我们自己的网页应用程序。为此,我们需要访问官方 GitHub 仓库,ChatGPTNextWeb/ChatGPT-Next-Web,并点击“部署”按钮。

点击链接后,你将被导向一个新标签页。在这里,你需要注册 Vercel 并登录你的 GitHub 账户以创建一个新的仓库。按照简单的指示操作,点击部署按钮,然后等待过程完成。

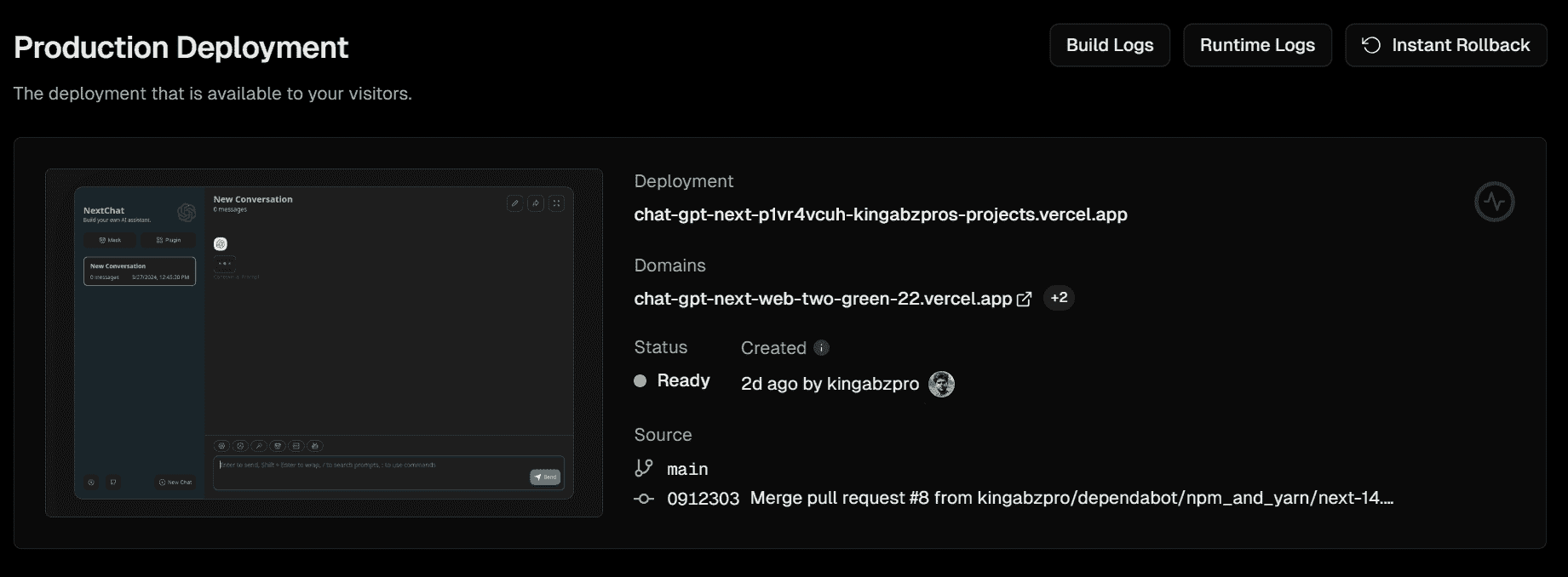

几分钟后,部署将完成,你将收到你网页应用程序的 URL。

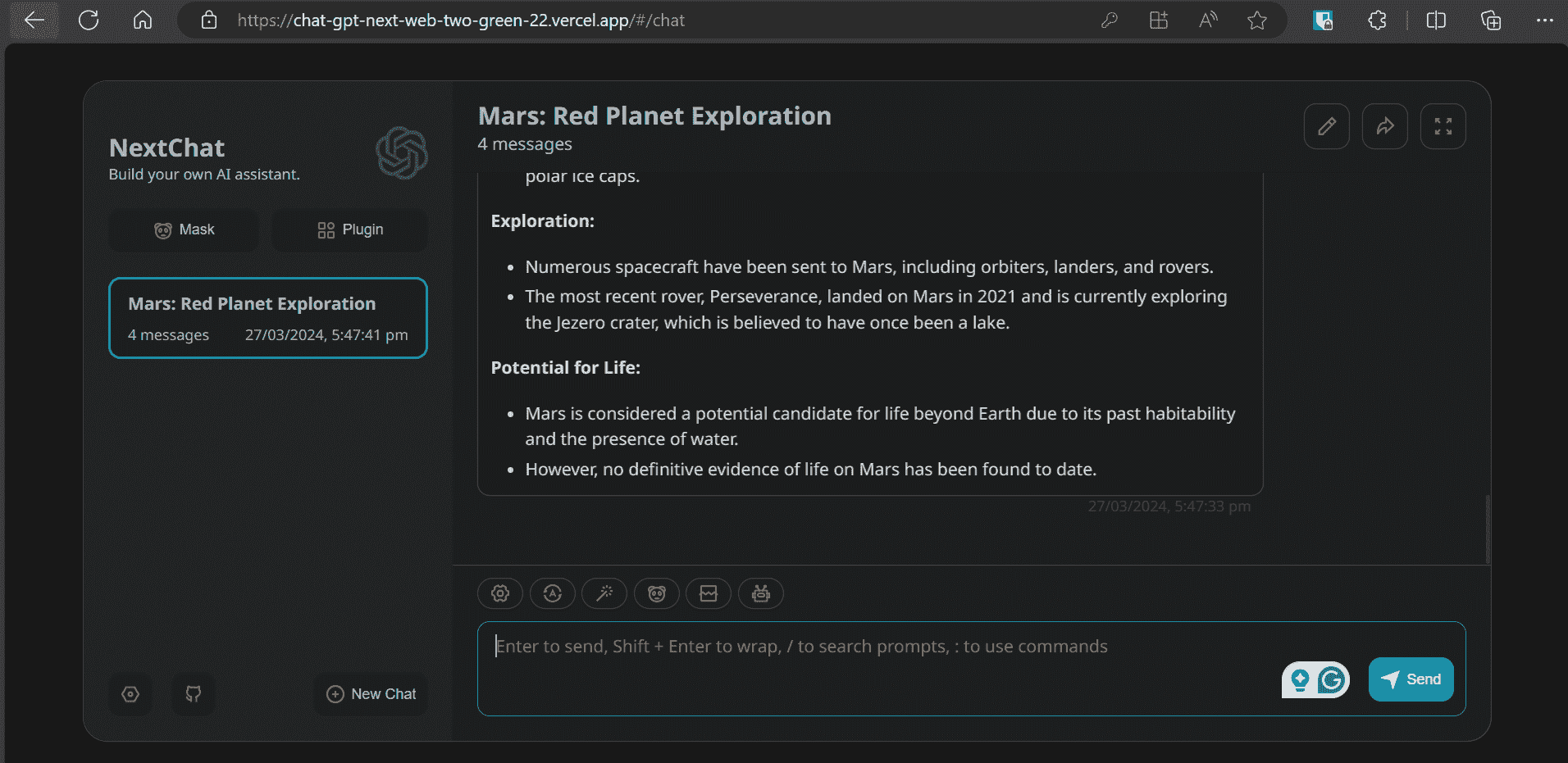

要访问 Vercel 部署的网络应用程序,请访问 chat-gpt-next-web-two-green-22.vercel.app/。我发现 NextChat 比 Bard 或 ChatGPT 更加流畅。

最终想法

我已经使用 ChatGPT Next Web 一段时间了,配有 OpenAI API 密钥。虽然这是一个付费 API,但我的月使用费用仅为约 $0.3。与其花 $20 购买 ChatGPT Pro,我可以以更低的成本访问顶级模型,并且用户界面更好。如果你使用 Gemini Pro,效果更佳,因为它对所有人都是免费的。

如果你仍然对使用这个应用程序感到不确定,跟随我的指南,使用一周时间探索其各种功能。我相信你会像我一样改变看法。

Abid Ali Awan (@1abidaliawan) 是一位认证的数据科学专业人士,热衷于构建机器学习模型。目前,他专注于内容创作,撰写关于机器学习和数据科学技术的技术博客。Abid 拥有技术管理硕士学位和电信工程学士学位。他的愿景是利用图神经网络为面临心理问题的学生构建一款 AI 产品。

主题更多内容

了解大型语言模型

原文:

www.kdnuggets.com/2023/03/learn-large-language-models.html

作者提供的图片

随着 ChatGPT 和 Google Bard 的发布,越来越多的人开始谈论大型语言模型。这是新的趋势,大家都想了解更多。

我们的前 3 名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

语言是我们日常生活中的重要元素。它是我们学习世界、成功职业、塑造未来的方式。它存在于新闻、网页、法律、消息服务等各个方面。它是我们与人连接和沟通的方式。

现在,随着技术的快速发展,越来越多的公司正在寻找新的方法来提升计算机学习和处理语言的能力。这得益于人工智能(AI)在语言处理技术方面的最新突破。

这些语言处理技术使公司能够构建对语言有更好理解的智能系统。这些技术基于大型预训练的 Transformer 语言模型或大型语言模型——它们具有更广泛的能力和对语言的理解,以及这些模型处理文本的需求。

什么是大型语言模型?

查看 AI 应用程序,如 ChatGPT 和 Google Bard——它们能够总结文章、帮助你写故事/漫画,并进行长时间类似人类的对话。它们能够做很多事情,这都归功于内嵌的大型语言模型。

大型语言模型(LLM)是一种深度学习算法,能够读取、识别、总结、翻译、预测以及生成文本。它们的预测未来单词和构造句子的能力使它们能够学习人类的说话和写作方式,并进行对话——就像人类一样!