KDNuggets-博客中文翻译-二十六-

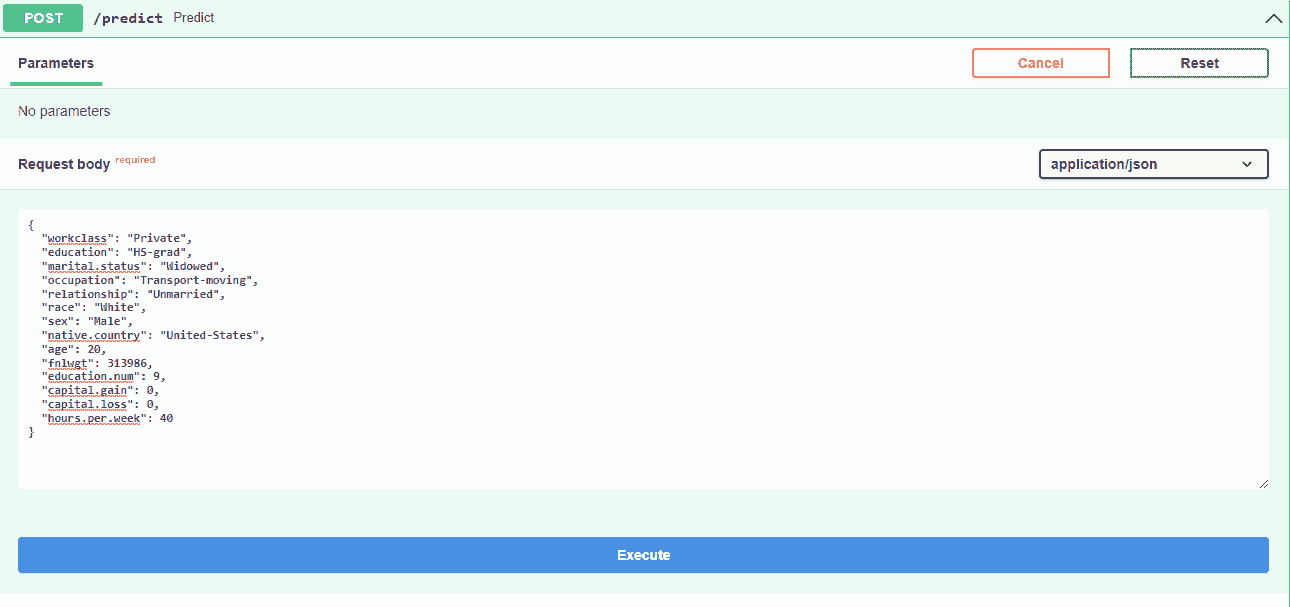

KDNuggets 博客中文翻译(二十六)

原文:KDNuggets

朴素贝叶斯算法:您需要了解的一切

原文:

www.kdnuggets.com/2020/06/naive-bayes-algorithm-everything.html

朴素贝叶斯算法简介

最简单的解决方案通常是最有效的,朴素贝叶斯就是一个很好的例子。尽管*年来机器学习取得了进展,但它不仅简单,而且快速、准确和可靠。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析水*

2. 谷歌数据分析专业证书 - 提升您的数据分析水*

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

它已经成功用于许多目的,但在自然语言处理(NLP)问题上特别有效。

朴素贝叶斯是一种基于贝叶斯定理的概率机器学习算法,广泛应用于各种分类任务。在本文中,我们将深入理解朴素贝叶斯算法及其所有基本概念,以便彻底理解。

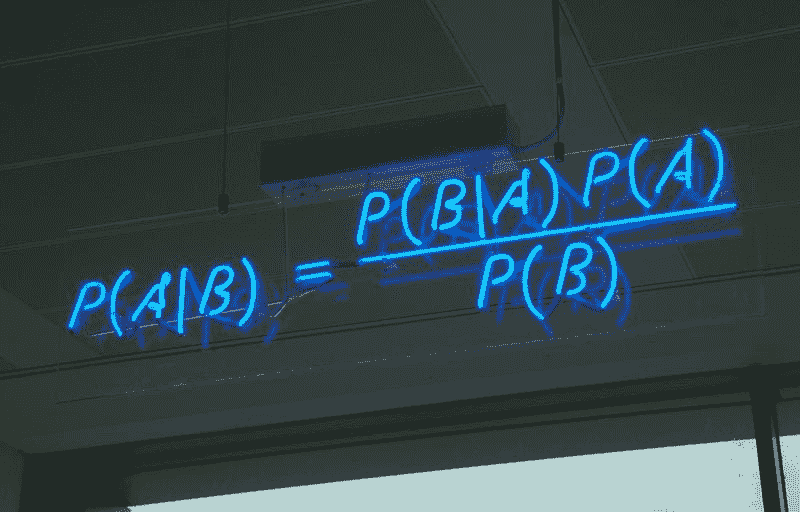

贝叶斯定理

贝叶斯定理是用于计算条件概率的简单数学公式。

条件概率是指在另一个事件(通过假设、推测、断言或证据)发生的情况下,事件发生的概率的度量。

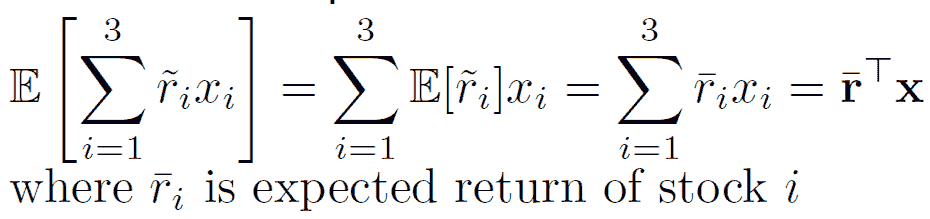

公式是:—

这告诉我们:P(A|B),即在B 发生的情况下,A 发生的概率,也称为后验概率。当我们知道A 发生的情况下B 发生的概率,写作P(B|A),以及A单独发生的概率P(A)和B单独发生的概率P(B)。

简单来说,贝叶斯定理是一种在知道某些其他概率的情况下找出概率的方法。

朴素贝叶斯所做的假设

朴素贝叶斯的基本假设是每个特征都做出一个:

-

独立

-

相等

对结果的贡献。

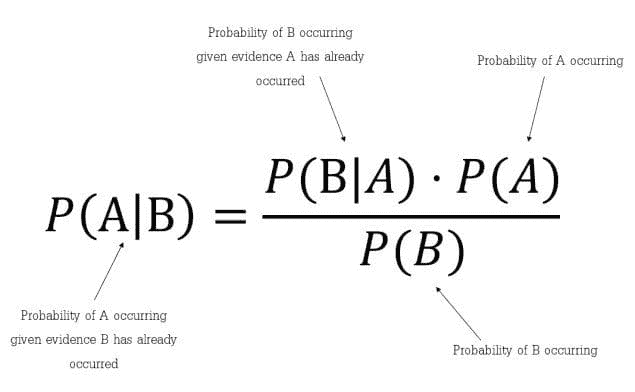

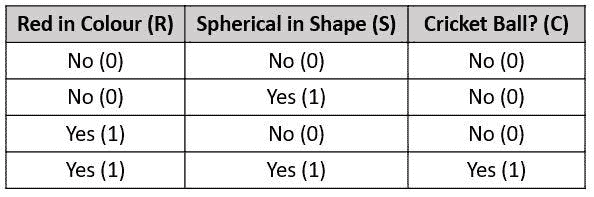

让我们通过一个例子来获得更好的直观理解。考虑一个具有属性颜色、类型、来源的汽车盗窃问题,目标“被盗”可以是“是”或“否”。

朴素贝叶斯示例

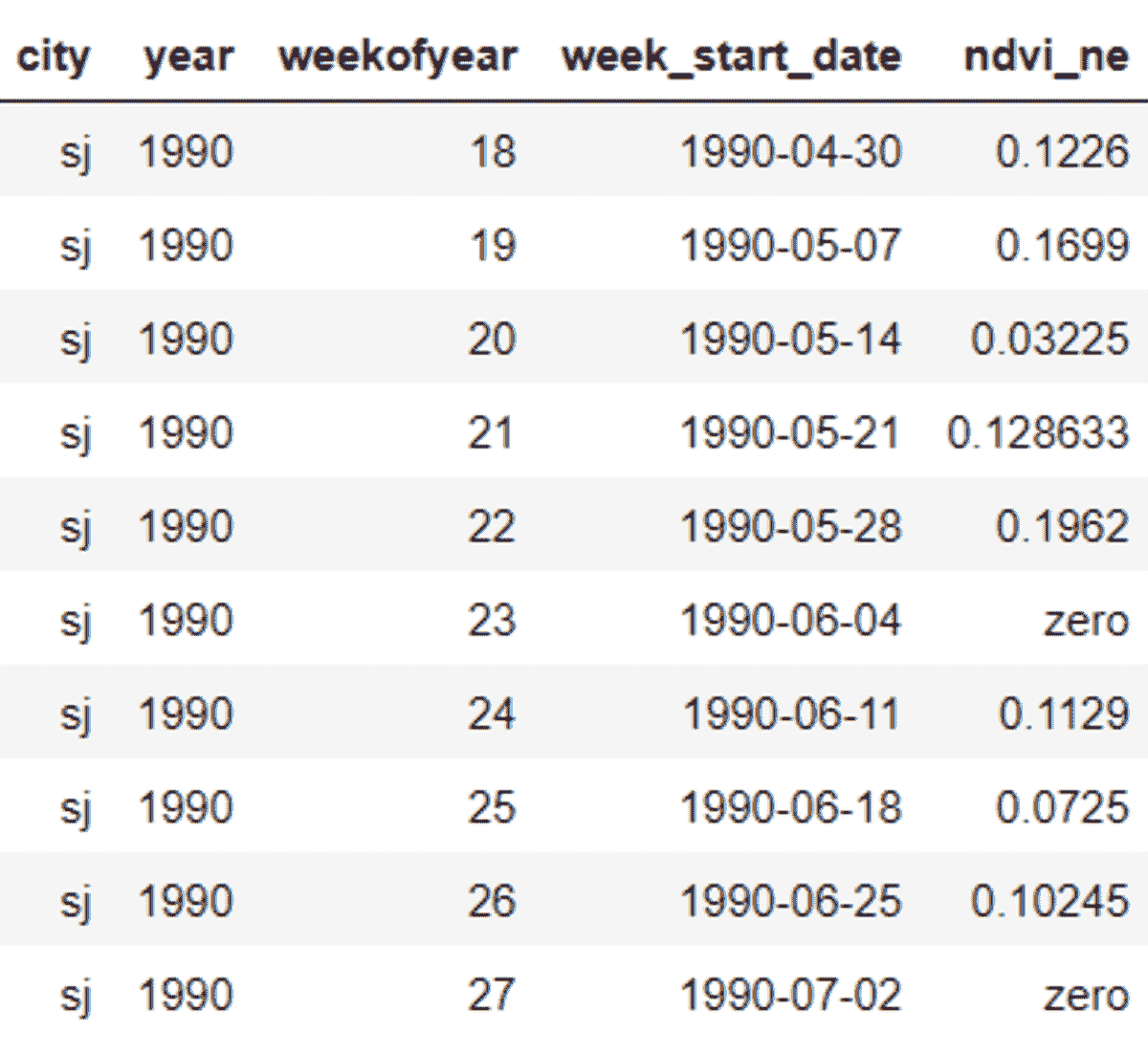

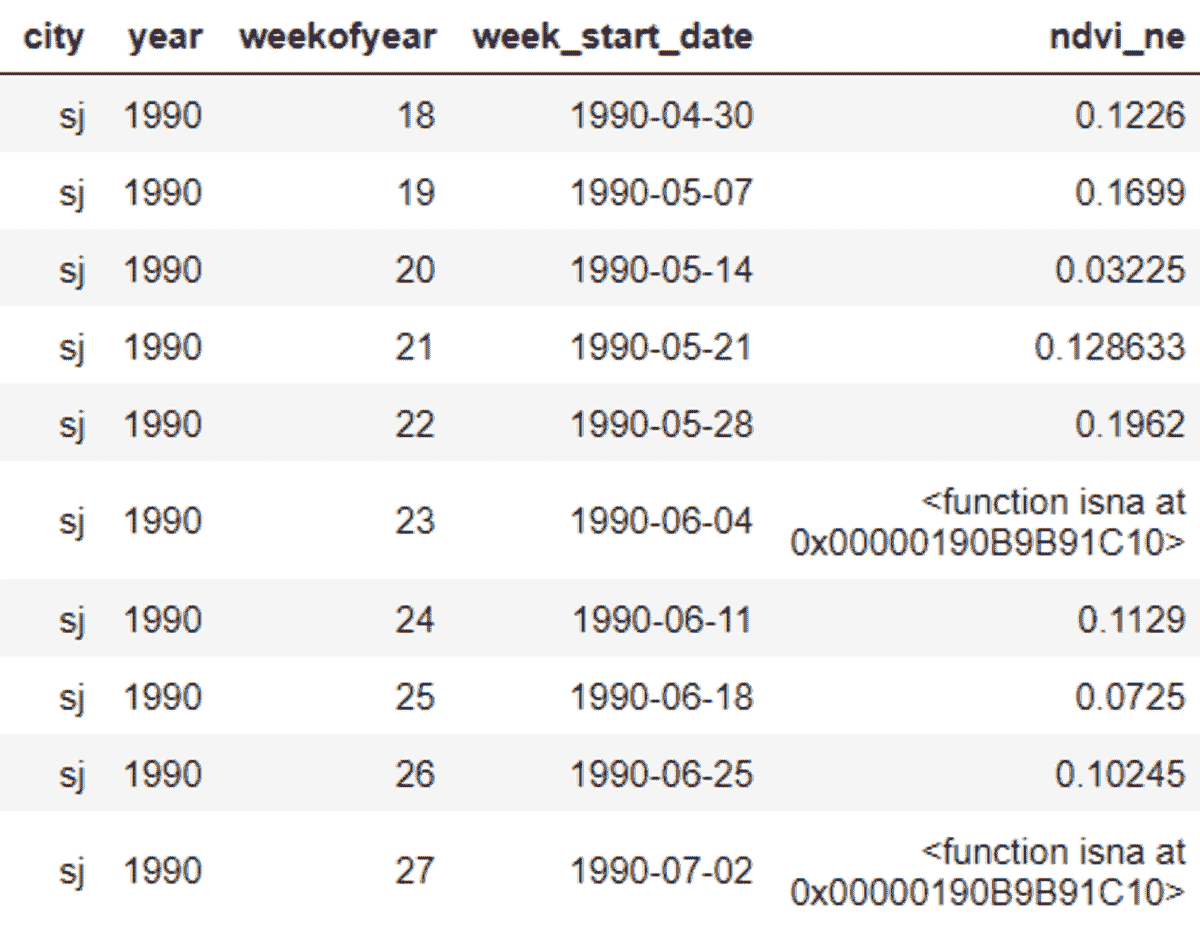

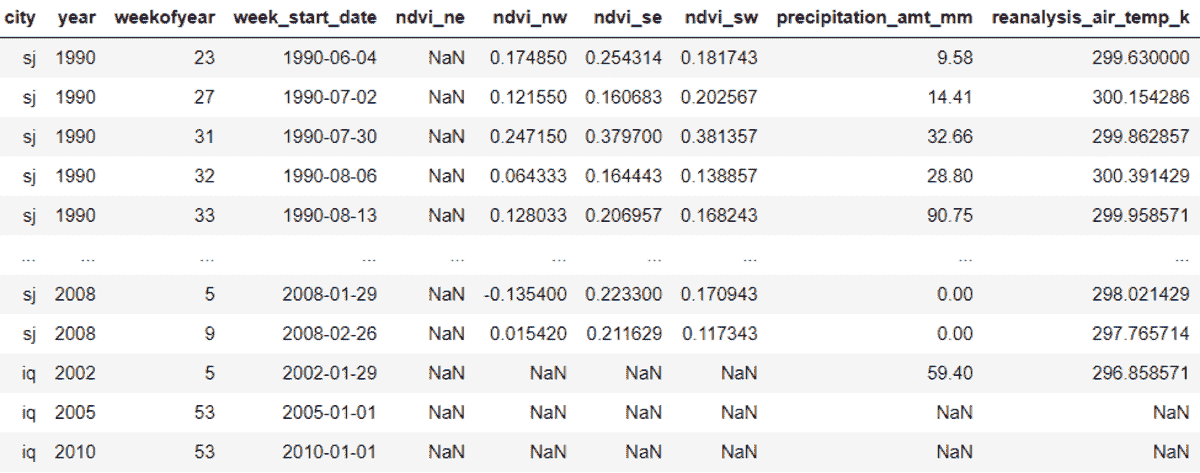

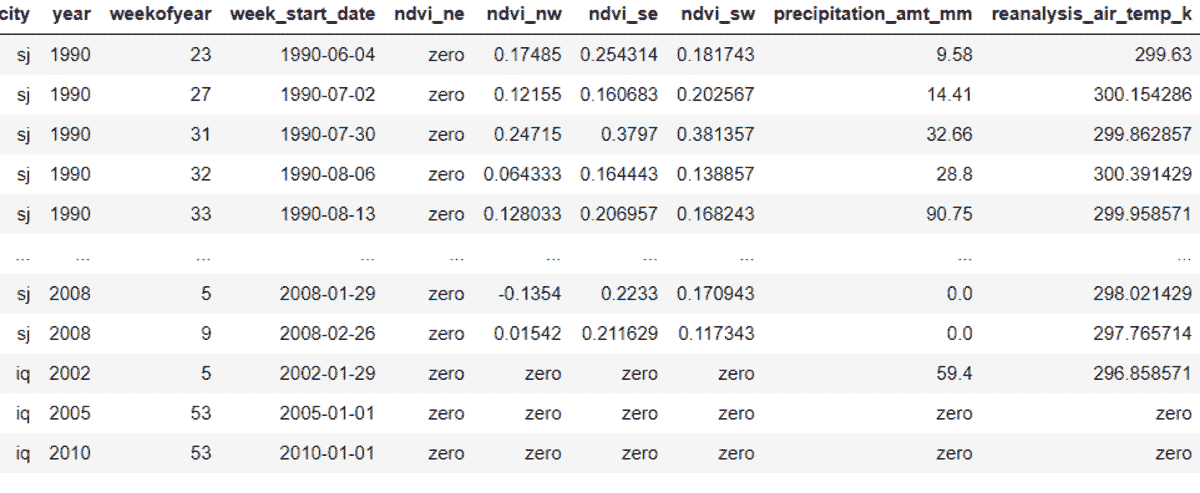

数据集表示如下。

关于我们的数据集,算法所做的假设的概念可以理解为:

-

我们假设没有一对特征是相关的。例如,颜色为‘红色’与汽车的类型或来源无关。因此,特征被假设为独立的。

-

其次,每个特征被赋予相同的影响(或重要性)。例如,仅知道颜色和类型无法完美预测结果。因此,没有任何属性是不相关的,假设它们对结果的贡献是相等的。

注意: Naïve Bayes 进行的假设在实际情况中通常不正确。独立假设从未正确,但在实践中往往有效。因此称为‘Naïve’。

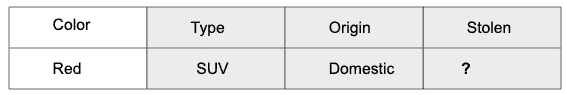

在我们的数据集中,我们需要根据汽车的特征来分类汽车是否被盗。列表示这些特征,而行表示单独的条目。如果我们取数据集的第一行,可以观察到,如果颜色是红色,类型是运动型,来源是国内的,则汽车被盗。因此,我们要分类一个红色的国内 SUV 是否被盗。请注意,我们的数据集中没有红色国内 SUV 的示例。

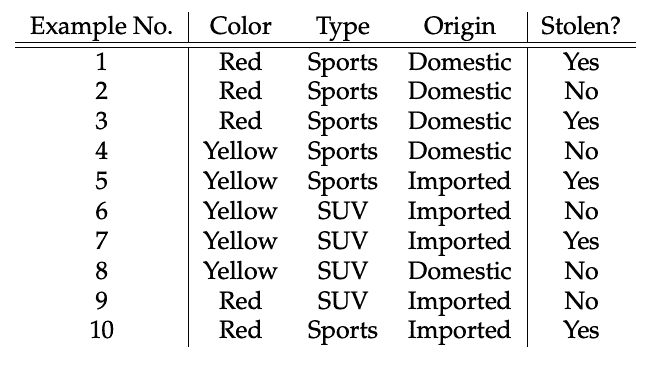

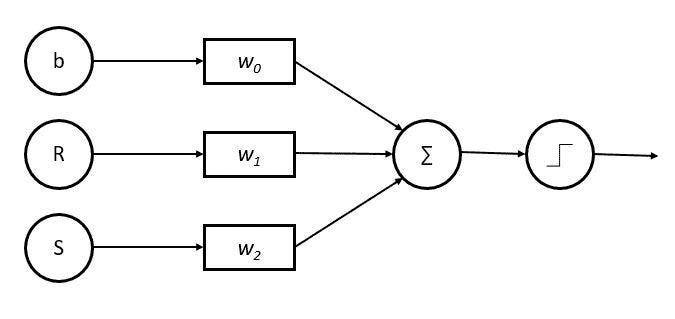

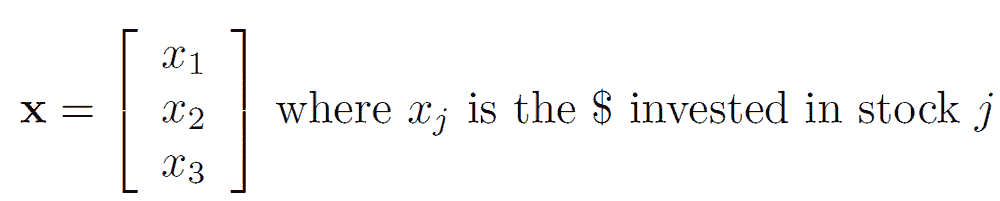

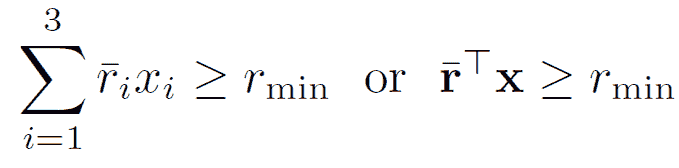

根据此示例,贝叶斯定理可以重写为:

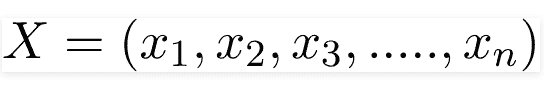

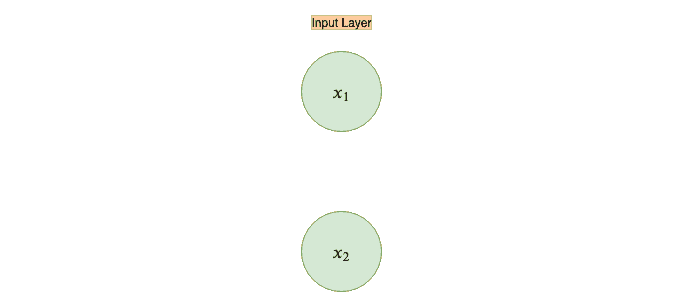

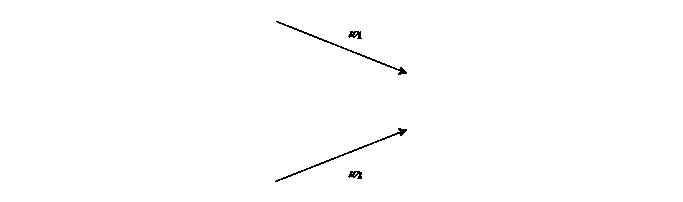

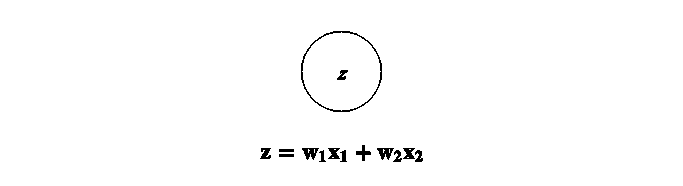

变量 y 是类变量(被盗?),表示在给定条件下汽车是否被盗。变量 X 表示参数/特征。

X 给出如下,

这里 x1, x2…, xn 表示特征,即它们可以映射到颜色、类型和来源。通过替代 X 并使用链式法则展开,我们得到,

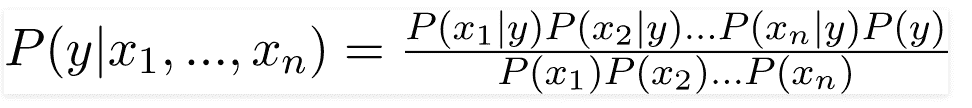

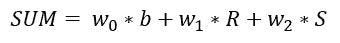

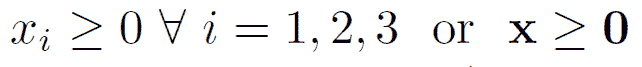

现在,你可以通过查看数据集来获得每个值并将其代入方程中。对于数据集中的所有条目,分母不变,它保持静态。因此,可以去掉分母,并引入比例。

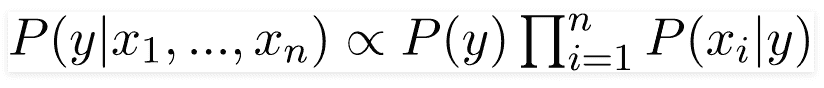

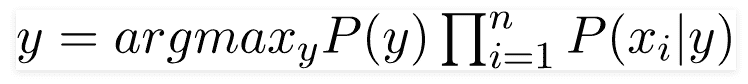

在我们的案例中,类变量(y)只有两个结果,即是或否。可能有多变量分类的情况。因此,我们需要找到具有最大概率的类变量(y)。

使用上述函数,我们可以在给定预测变量/特征的情况下获得类别。

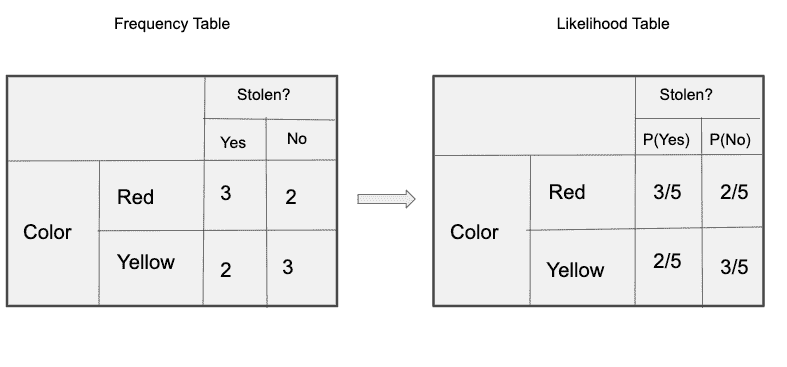

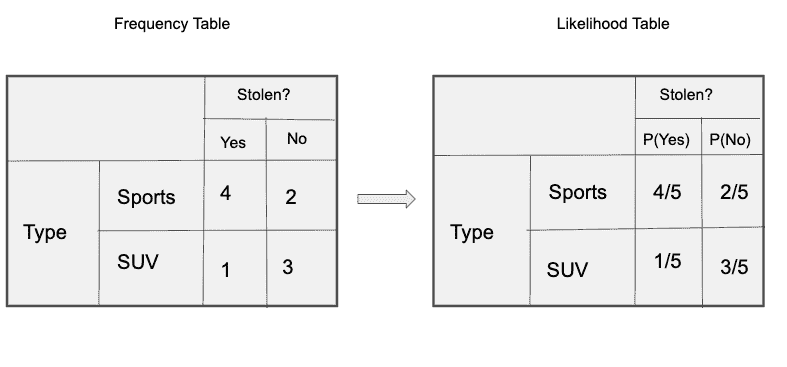

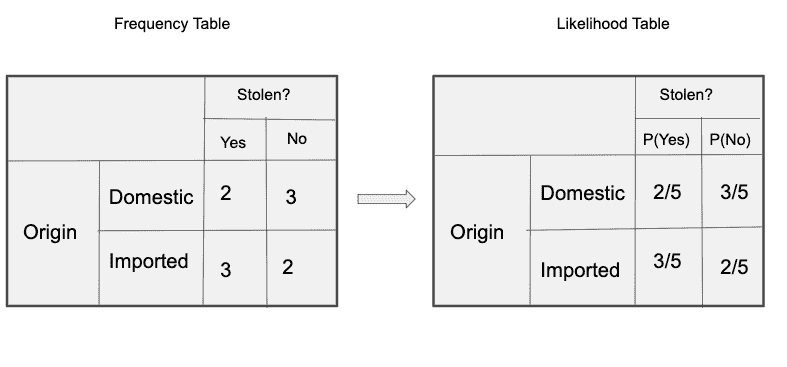

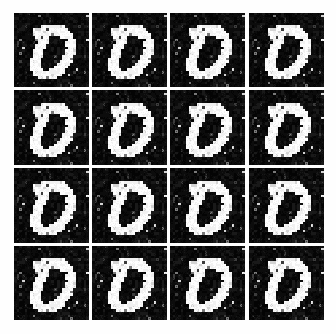

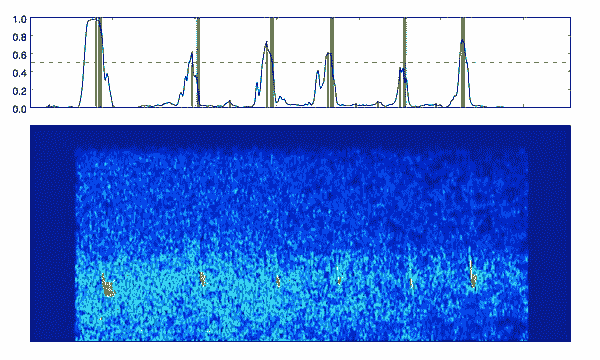

后验概率 P(y|X) 可以通过首先为每个属性创建一个频率表来计算。然后,将频率表转换为可能性表,最后使用 Naïve Bayesian 方程计算每个类别的后验概率。具有最高后验概率的类别是预测的结果。以下是所有三个预测变量的频率和可能性表。

“颜色”的频率和可能性表

‘类型’的频率和可能性表

‘来源’的频率和可能性表

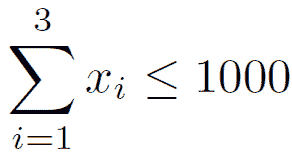

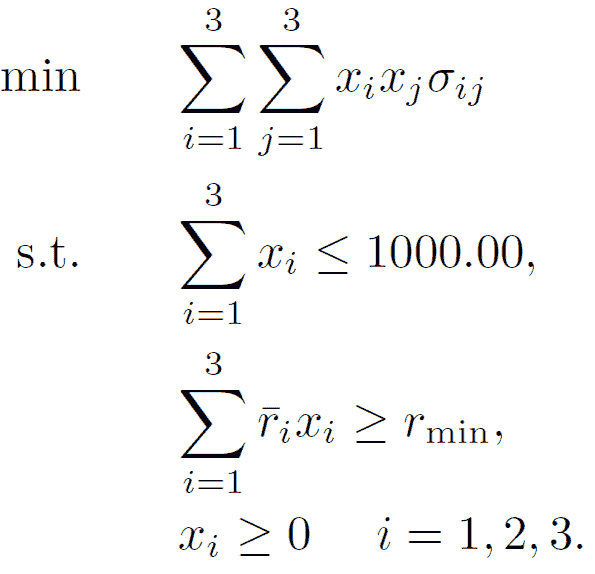

所以在我们的例子中,我们有 3 个预测变量X。

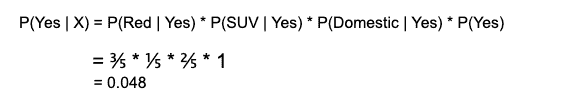

根据上述讨论的方程,我们可以计算后验概率 P(Yes | X)为:

和,P( No | X ):

由于 0.144 > 0.048,这意味着给定特征 RED SUV 和 Domestic,我们的例子被分类为“NO”,即车辆未被盗。

零频率问题

朴素贝叶斯的一个缺点是,如果一个类别标签和某个属性值一起没有出现,那么基于频率的概率估计将为零。当所有概率相乘时,这将得到零。

在贝叶斯环境中克服‘零频率问题’的一种方法是,当一个属性值未与每个类别值一起出现时,将每个属性值-类别组合的计数加一。

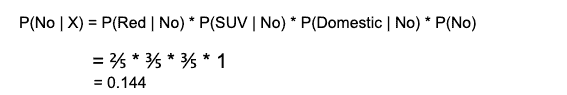

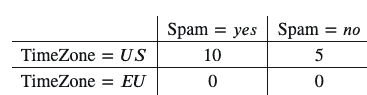

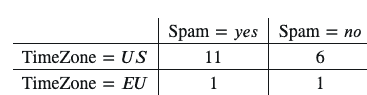

例如,假设你的训练数据如下:

????(TimeZone=????????|Spam=????????????)=10/10=1

????(TimeZone=????????|Spam=????????????)=0/10=0

然后,在使用这个表计算概率时,你应该对每个值加一:

????(TimeZone=????????|Spam=????????????)=11/12

????(TimeZone=????????|Spam=????????????)=1/12

这就是我们如何避免得到零概率的方法。

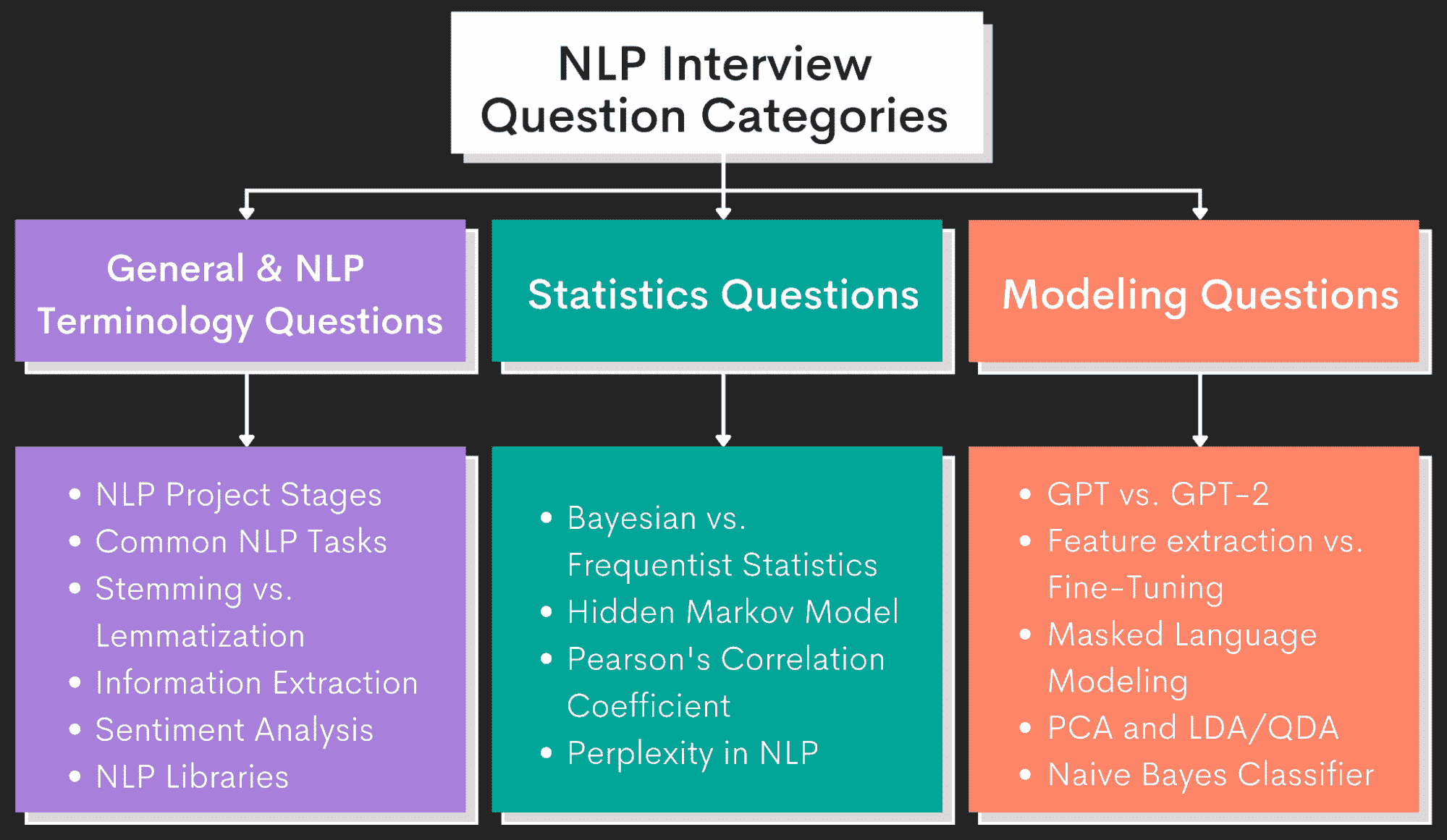

朴素贝叶斯分类器的类型

1. 多项式朴素贝叶斯分类器

特征向量表示某些事件由多项分布生成的频率。这是通常用于文档分类的事件模型。

2. 伯努利朴素贝叶斯分类器:

在多变量伯努利事件模型中,特征是独立的布尔值(离散变量)描述输入。与多项式模型类似,这个模型在文档分类任务中很受欢迎,其中使用的是二元术语出现(即一个词是否出现在文档中)特征,而不是术语频率(即词在文档中的频率)。

3. 高斯朴素贝叶斯分类器:

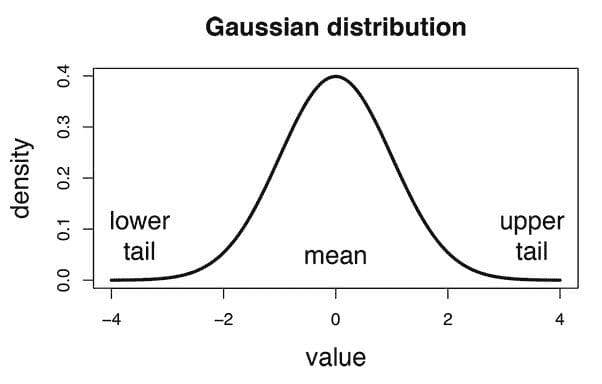

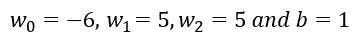

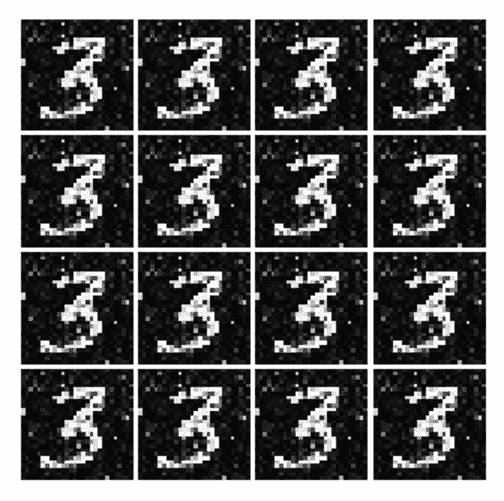

在高斯朴素贝叶斯中,与每个特征相关的连续值假设符合高斯分布 (正态分布)。当绘制时,它给出一个钟形曲线,该曲线关于特征值的均值对称,如下所示:

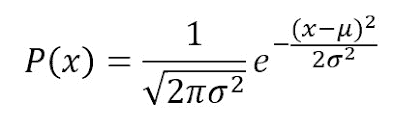

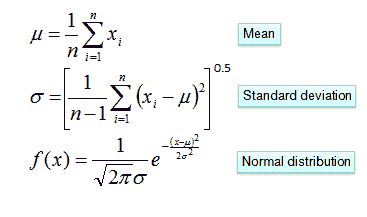

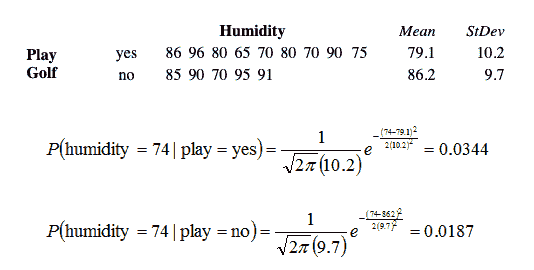

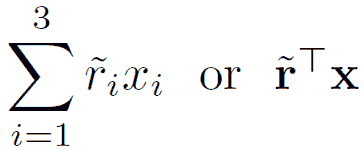

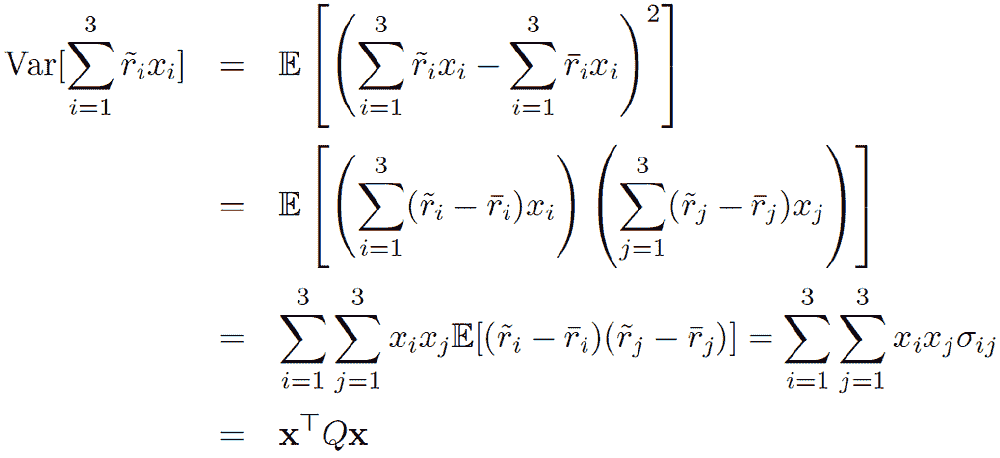

特征的可能性假设为高斯分布,因此,条件概率由下式给出:

现在,如果某些特征包含数值而不是类别,即高斯分布,会怎样呢?

一种选择是在创建频率表之前将数值转换为其分类对应项。另一种选择,如上所示,可以使用数值变量的分布来很好地估计频率。例如,一种常见的方法是假设数值变量服从正态或高斯分布。

正态分布的概率密度函数由两个参数(均值和标准差)定义。

考虑高尔夫球的问题,这里唯一的预测变量是湿度,是否打高尔夫?是目标。使用上述公式,如果我们知道均值和标准差,就可以计算后验概率。

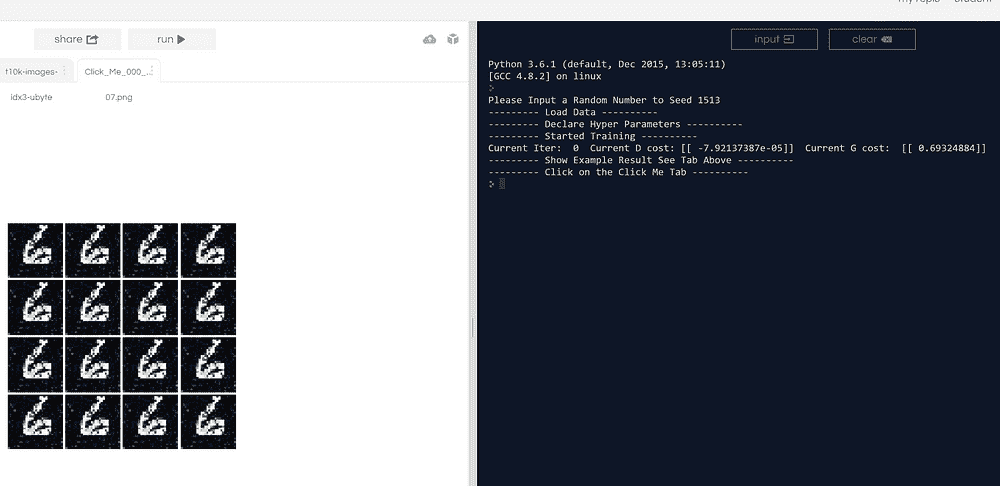

案例研究:从头开始使用 Python 构建朴素贝叶斯分类器

当前任何主要网站面临的一个问题是如何处理恶意和分裂性内容。Quora 希望解决这个问题,使其*台成为用户可以安全分享知识的地方。

Quora 是一个使人们可以相互学习的*台。在 Quora 上,人们可以提问,并与其他提供独特见解和高质量回答的人联系。一个关键挑战是筛除虚伪的问题——那些建立在虚假前提上的问题,或者那些意图陈述观点而不是寻求有用回答的问题。

目标是开发一个朴素贝叶斯分类模型,以识别和标记虚伪的问题。

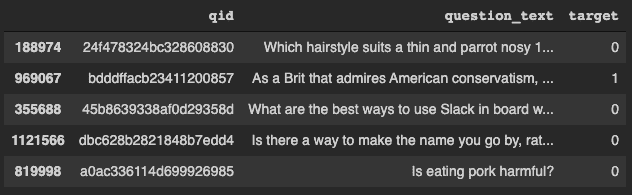

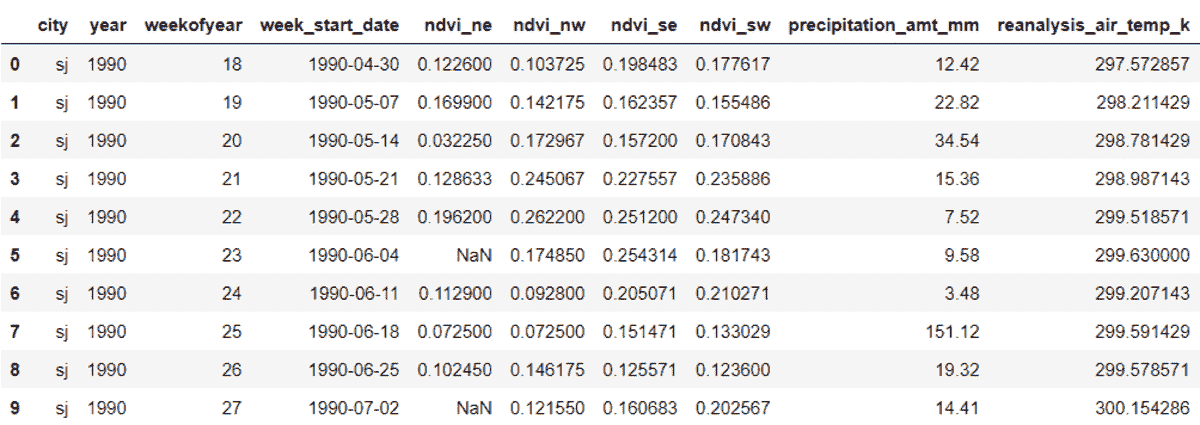

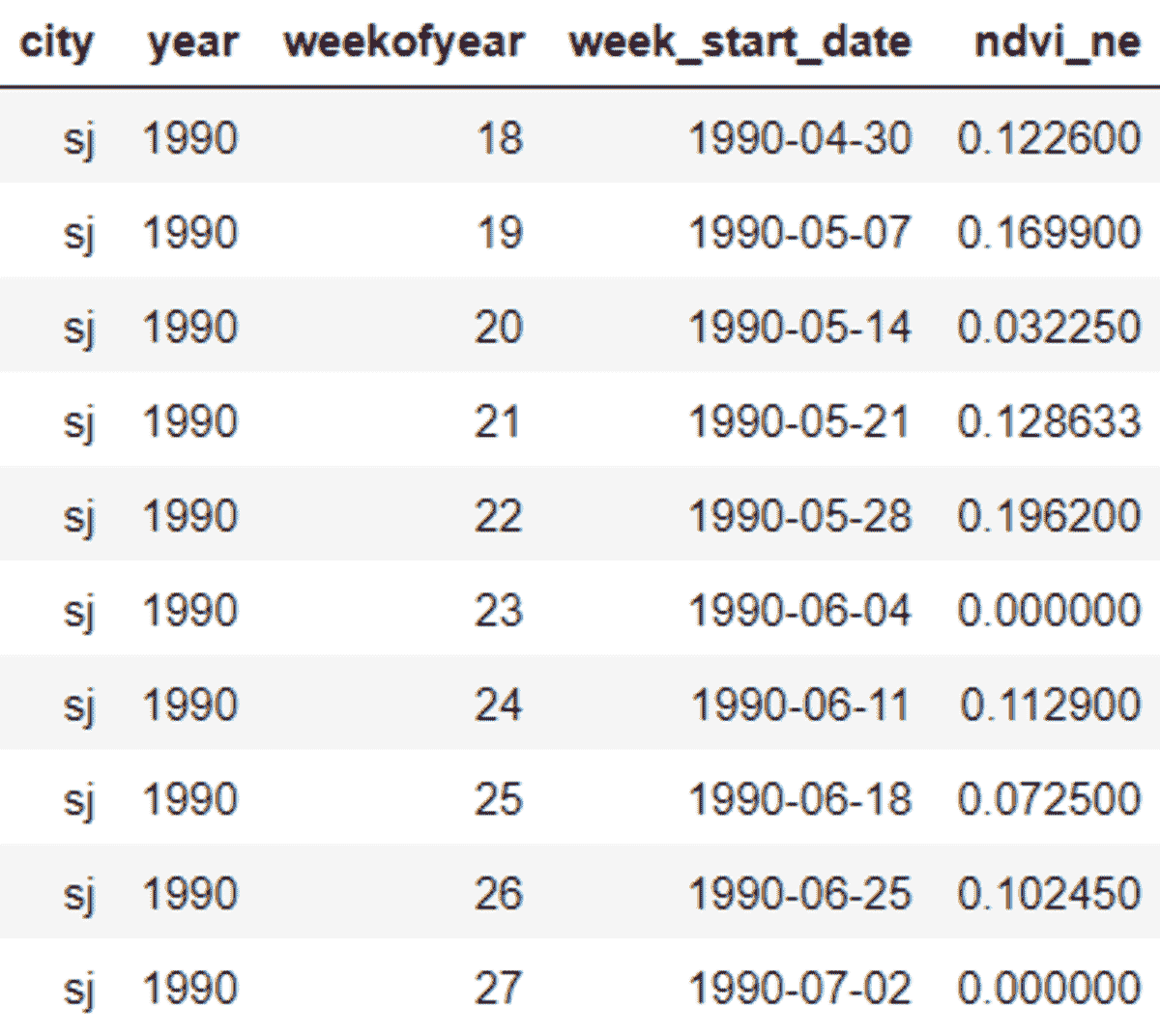

数据集可以从这里下载。下载训练和测试数据后,加载并检查它。

**import** numpy **as** np

**import** pandas **as** pd

**import** os

train **=** pd.read_csv('./drive/My Drive/train.csv')

print(train.head())test **=** pd.read_csv('./drive/My Drive/test.csv')

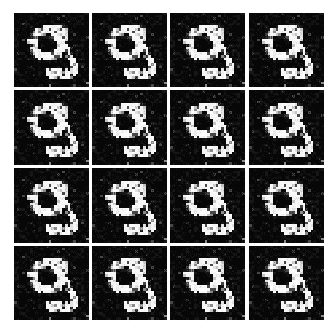

训练数据集

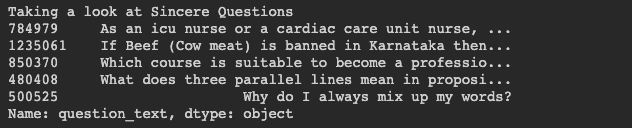

让我们看看真实的问题是什么样的。

真实问题

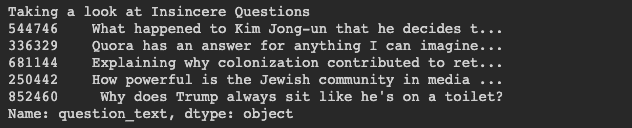

我们来看看虚伪的问题是什么样的。

虚伪问题

文本预处理

下一步是对文本进行预处理,然后将数据集拆分为训练集和测试集。预处理步骤包括:移除数字、移除字符串中的标点符号、移除停用词、词干提取和词形还原。

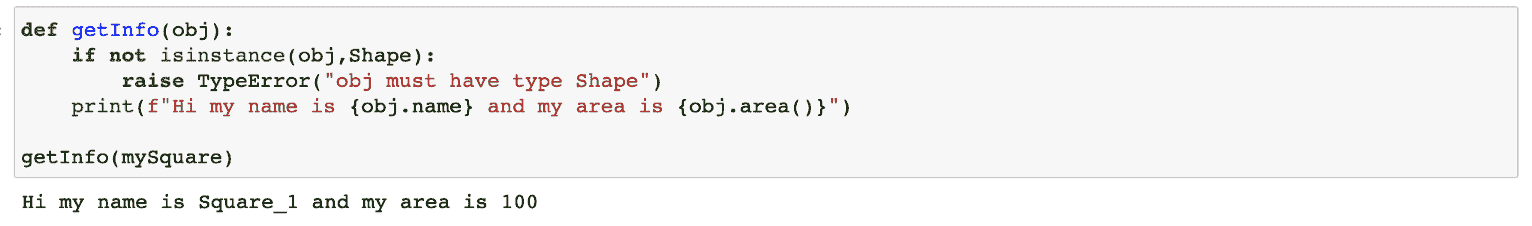

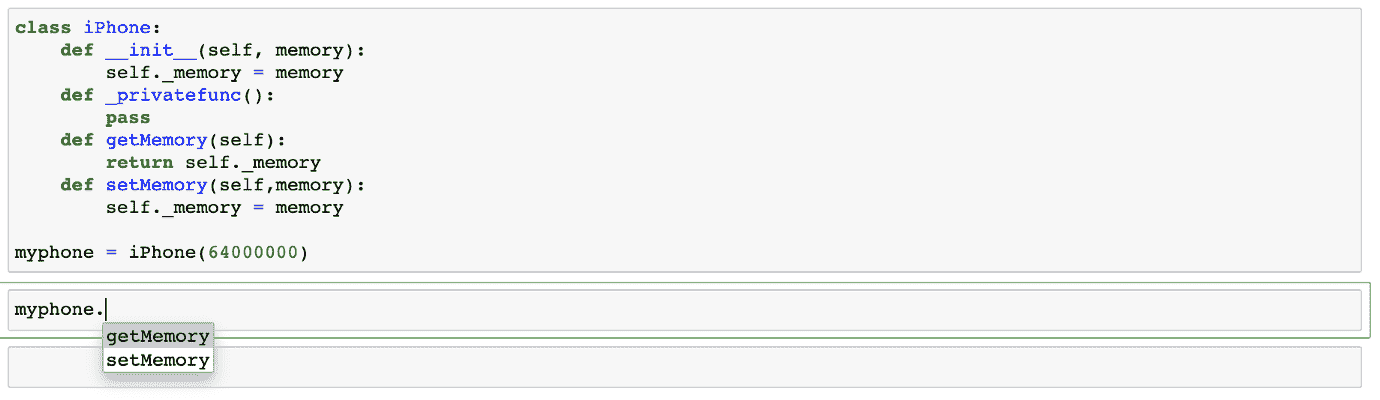

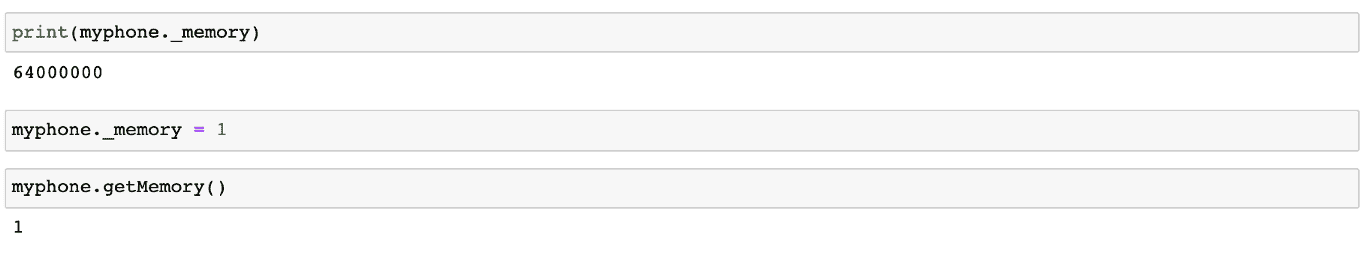

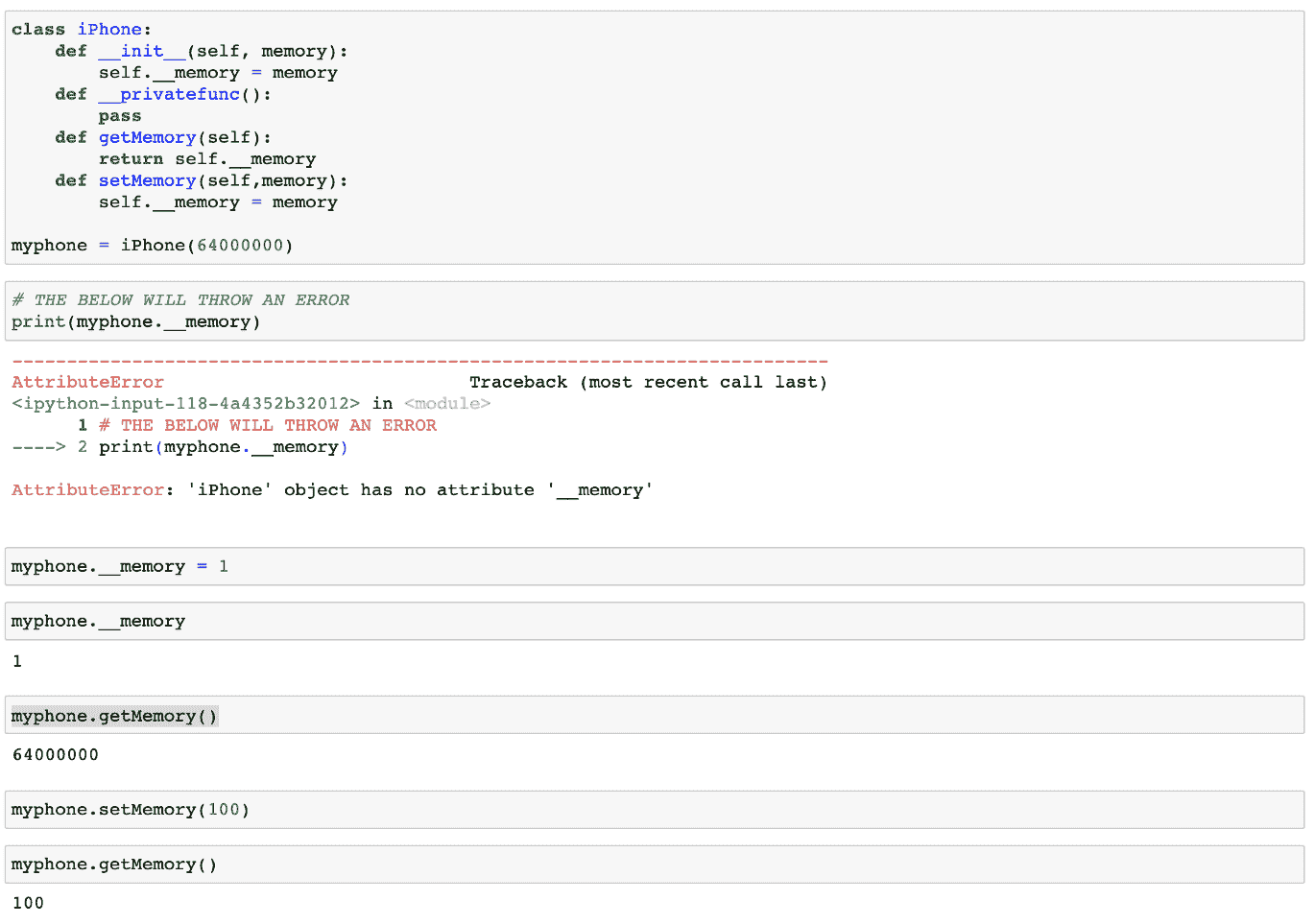

构建朴素贝叶斯分类器

结合所有预处理技术,并创建一个包含训练数据中每个词及其计数的字典。

-

计算文本中每个词的概率,并过滤掉概率低于阈值概率的词。概率低于阈值的词是不相关的。

-

然后对字典中的每个词,计算该词出现在不诚实问题中的概率以及它在不诚实问题中的概率。接着计算条件概率以用于朴素贝叶斯分类器。

-

使用条件概率进行预测。

结论

朴素贝叶斯算法通常用于情感分析、垃圾邮件过滤、推荐系统等。它们实现起来快速简便,但最大缺点是要求预测变量必须独立。

感谢阅读!

Nagesh Singh Chauhan 是 CirrusLabs 的一名大数据开发工程师。他在电信、分析、销售、数据科学等多个领域有超过 4 年的工作经验,专注于多个大数据组件。

原文。经授权转载。

更多相关主题

朴素贝叶斯:机器学习分类性能的基准模型

多项式朴素贝叶斯

首先,需要对分类变量进行编码。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析水*

2. Google 数据分析专业证书 - 提升你的数据分析水*

3. Google IT 支持专业证书 - 支持组织的 IT 需求

3. Google IT 支持专业证书 - 支持组织的 IT 需求

o = {'sunny': 1, 'overcast': 2, 'rainy': 3}

data.outlook = [o[item] for item in data.outlook.astype(str)]

t = {'hot': 1, 'mild': 2, 'cool': 3}

data.temp = [t[item] for item in data.temp.astype(str)]

h = {'high': 1, 'normal': 2}

data.humidity = [h[item] for item in data.humidity.astype(str)]

w = {'True': 1, 'False': 2}

data.windy = [w[item] for item in data.windy.astype(str)]

然后我们可以创建训练集和测试集

x = tennis.iloc[:,0:-1] # X is the features in our dataset

y = tennis.iloc[:,-1] # y is the Labels in our dataset

X_train, X_test, y_train, y_test = train_test_split(x, y, test_size=0.33, random_state=42)

接下来,我们可以继续拟合模型并进行预测

modelM = MultinomialNB().fit(X_train, y_train)

predM = model.predict(X_test)

predM

array(['yes', 'yes', 'yes', 'yes', 'yes'], dtype='<U3')

似乎所有的预测结果都返回了‘是’。这在评估模型时会有影响,如你所见。

让我们用 pandas 制作混淆矩阵,因为我个人不喜欢 Scikit-learn 的混淆矩阵。

pd.crosstab(y_test, predy, rownames=['Actual'], colnames=['Predicted'], margins=True)

Predicted yes All

Actual

no 2 2

yes 3 3

All 5 5

accuracy_score = accuracy_score(y_test, predy)

print('The accuracy of the Multinomial model is ', accuracy_score)

The accuracy of the Multinomial model is 0.6

多项式模型给出了 60% 的准确率

由于没有 false negatives,因为没有预测出‘0’类,因此模型的召回率(真正率)为 100%。召回率通过 [真正例/(真正例+假负例)] 计算。 不幸的是,这在现实情况下是不接受的,因为 100% 的召回率在实际中难以实现。这只是数学计算,需要人为解释以评估其适用性。

高斯朴素贝叶斯

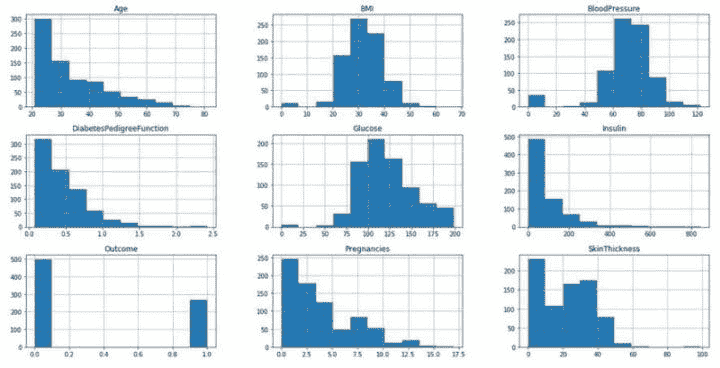

由于高斯朴素贝叶斯更偏好连续数据,我们将使用Pima 印第安人糖尿病数据集

diabetes = pd.read_csv('diabetes.csv')

diabetes.dtypes

Pregnancies int64

Glucose int64

BloodPressure int64

SkinThickness int64

Insulin int64

BMI float64

DiabetesPedigreeFunction float64

Age int64

Outcome int64

dtype: object

我们可以看到所有特征都是连续的。

现在让我们测试特征是否符合高斯分布(正态分布),因为这是高斯朴素贝叶斯模型的一个必要假设(尽管如果数据不符合正态分布,模型仍然可以使用)

循环将告诉我们数据是否符合正态分布,使用著名的 Shapiro-Wilkes 检验。

for i in range(0,9):

stat,p = shapiro(diabetes[diabetes.columns[i]])

print(diabetes.columns[i], 'Test-Statistic=%.3f, p-value=%.3f' % (stat, p));

alpha = 0.05

if p > alpha:

print(diabetes.columns[i], 'looks Gaussian (fail to reject H0)')

print('---------------------------------------')

else:

print(diabetes.columns[i],'does not look Gaussian (reject H0)')

print('---------------------------------------')

Pregnancies Test-Statistic=0.904, p-value=0.000

Pregnancies does not look Gaussian (reject H0)

---------------------------------------

Glucose Test-Statistic=0.970, p-value=0.000

Glucose does not look Gaussian (reject H0)

---------------------------------------

BloodPressure Test-Statistic=0.819, p-value=0.000

BloodPressure does not look Gaussian (reject H0)

---------------------------------------

SkinThickness Test-Statistic=0.905, p-value=0.000

SkinThickness does not look Gaussian (reject H0)

---------------------------------------

Insulin Test-Statistic=0.722, p-value=0.000

Insulin does not look Gaussian (reject H0)

---------------------------------------

BMI Test-Statistic=0.950, p-value=0.000

BMI does not look Gaussian (reject H0)

---------------------------------------

DiabetesPedigreeFunction Test-Statistic=0.837, p-value=0.000

DiabetesPedigreeFunction does not look Gaussian (reject H0)

---------------------------------------

Age Test-Statistic=0.875, p-value=0.000

Age does not look Gaussian (reject H0)

---------------------------------------

Outcome Test-Statistic=0.603, p-value=0.000

Outcome does not look Gaussian (reject H0)

---------------------------------------

所有特征似乎都不符合正态分布。

让我们更进一步,来可视化它们的分布情况

diabetes.hist(figsize=(20, 10));

Pima 糖尿病特征的直方图

通过视觉检查,BMI 和血压似乎符合正态分布,但两侧的离群值和假设检验会让我们认为情况并非如此。尽管假设

如果不符合,我们仍然可以继续前进以适应模型。

xG = diabetes.iloc[:,0:-1] # X is the features in our dataset

yG = diabetes.iloc[:,-1] # y is the Labels in our dataset

X_trainG, X_testG, y_trainG, y_testG = train_test_split(xG, yG, test_size=0.33, random_state=42)

modelG = GaussianNB().fit(X_trainG, y_trainG)

predG = modelG.predict(X_testG)

pd.crosstab(y_testG, predG, rownames=['Actual'], colnames=['Predicted'], margins=True)

Predicted 0 1 All

Actual

0 136 32 168

1 33 53 86

All 169 85 254

这次我们可以计算召回率(真正率),因为现在两个类别都已被预测。

recall = recall_score(y_testG, predG, average='binary')

print('The Recall of the Gaussian model is', recall)

The Recall of the Gaussian model is 0.6162790697674418

我使用average='binary'因为我们的目标变量是二元目标(0 和 1)。

模型给出了 62%的真正率(召回率)。

我在获取模型的准确率时遇到困难,所以我们可以手动计算:

tn, fn, fp, tp = confusion_matrix(y_testG, predG).ravel()

accuracy = (tp + tn) /(tp+fp+tn+fn)

print('The accuracy of the Gaussian model is', accuracy)

The accuracy of the Gaussian model is 0.7440944881889764

高斯模型给出了 74%的准确率。

朴素贝叶斯的优点

-

可以处理缺失值。

- 在准备模型时会忽略缺失值,并在计算类别值的概率时也会被忽略。

-

可以处理小样本量。

- 朴素贝叶斯不需要大量的训练数据。它只需要足够的数据来理解每个特征与目标变量之间的概率关系。如果仅有少量训练数据,朴素贝叶斯通常会比其他模型表现更好。

-

尽管违反了独立性假设,模型仍然表现良好。

- 尽管独立性在现实世界数据中很少成立,但模型仍会像往常一样表现。

-

易于解释,相较而言预测速度较快。

- 朴素贝叶斯不是一种黑箱算法,最终结果可以很容易地向观众解释。

-

可以处理数值型和分类数据。

- 朴素贝叶斯是分类器,因此在处理分类数据时表现更好。尽管数值数据也可以使用,但它假设所有数值数据都是正态分布的,而现实数据中这一点不太可能成立。

朴素贝叶斯的缺点

-

朴素假设

- 朴素贝叶斯假设所有特征彼此独立。在现实生活中,几乎不可能获得一组完全独立的预测变量。

-

无法结合特征之间的交互作用。

-

模型的性能将对数据偏斜高度敏感。

- 当训练集不能代表总体人口的类别分布时,先验估计将会不准确。

-

零频率问题

-

在测试数据中存在但在训练数据中没有的类别的分类变量将被分配为零(0)概率,从而无法进行预测。

-

作为解决方案,必须对类别应用*滑技术。其中一种最简单且最著名的技术是拉普拉斯*滑技术。Python 的 Sklearn 默认实现了拉普拉斯*滑。

-

-

数据集中的相关特征必须被移除,否则在模型中会被投票两次,从而过度夸大该特征的重要性。

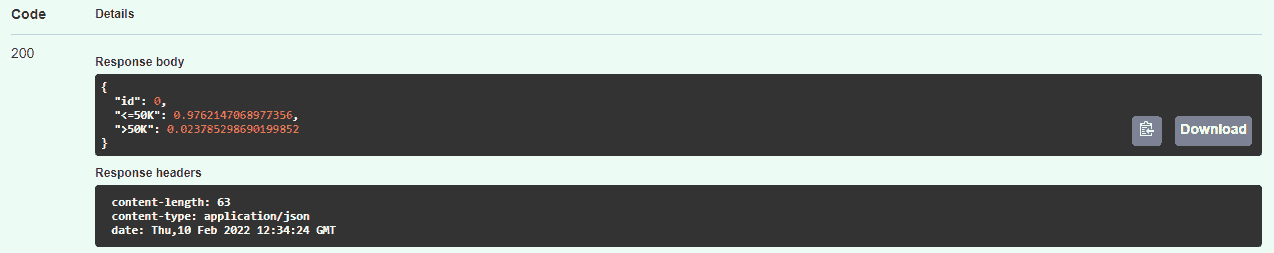

为什么使用朴素贝叶斯作为性能基准分类器?

我认为朴素贝叶斯应该作为第一个模型进行创建和比较,原因是:

-

它在预测中高度依赖先验目标类概率。不准确或不现实的先验可能导致误导性结果。由于朴素贝叶斯是基于概率的机器学习技术,目标的概率将极大地影响最终预测。

-

由于无需去除缺失值,你无需冒着丢失原始数据的风险。

-

独立性假设实际上几乎从未得到满足,因此由于其最基本的假设存在缺陷,结果不太可靠。

-

模型中未考虑特征之间的交互作用。然而,现实世界中的特征几乎总是存在交互作用的。

-

没有错误或方差需要最小化,而只是要在给定预测因子的情况下寻求更高的类概率。

以上所有都可以作为其他分类器应当超越朴素贝叶斯模型的有效点。虽然朴素贝叶斯在垃圾邮件过滤和推荐系统方面表现优异,但在大多数其他应用中可能并不理想。

结论

总体而言,朴素贝叶斯模型快速、强大且易于解释。然而,对目标变量的先验概率的过度依赖可能会产生非常误导和不准确的结果。分类器如决策树、逻辑回归、随机森林和集成方法应当能够超越朴素贝叶斯,成为真正有用的工具。这并不意味着朴素贝叶斯不再是一个强大的分类器。独立性假设、无法处理交互作用以及高斯分布假设使其成为一个非常难以完全信赖的算法,因为这些模型必须不断更新。

相关内容:

-

仅使用 Python 实现的朴素贝叶斯 – 无需复杂框架

-

机器学习以 88% 的准确率发现“假新闻”

-

从零开始展开朴素贝叶斯

更多相关话题

仅使用Python从零开始的朴素贝叶斯 – 无需华丽的框架

原文:https://www.kdnuggets.com/2018/10/naive-bayes-from-scratch-python.html

作者 Aisha Javed。

**从零开始展开朴素贝叶斯! 第2部分 **????

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌IT支持专业证书 - 支持你的组织的IT

3. 谷歌IT支持专业证书 - 支持你的组织的IT

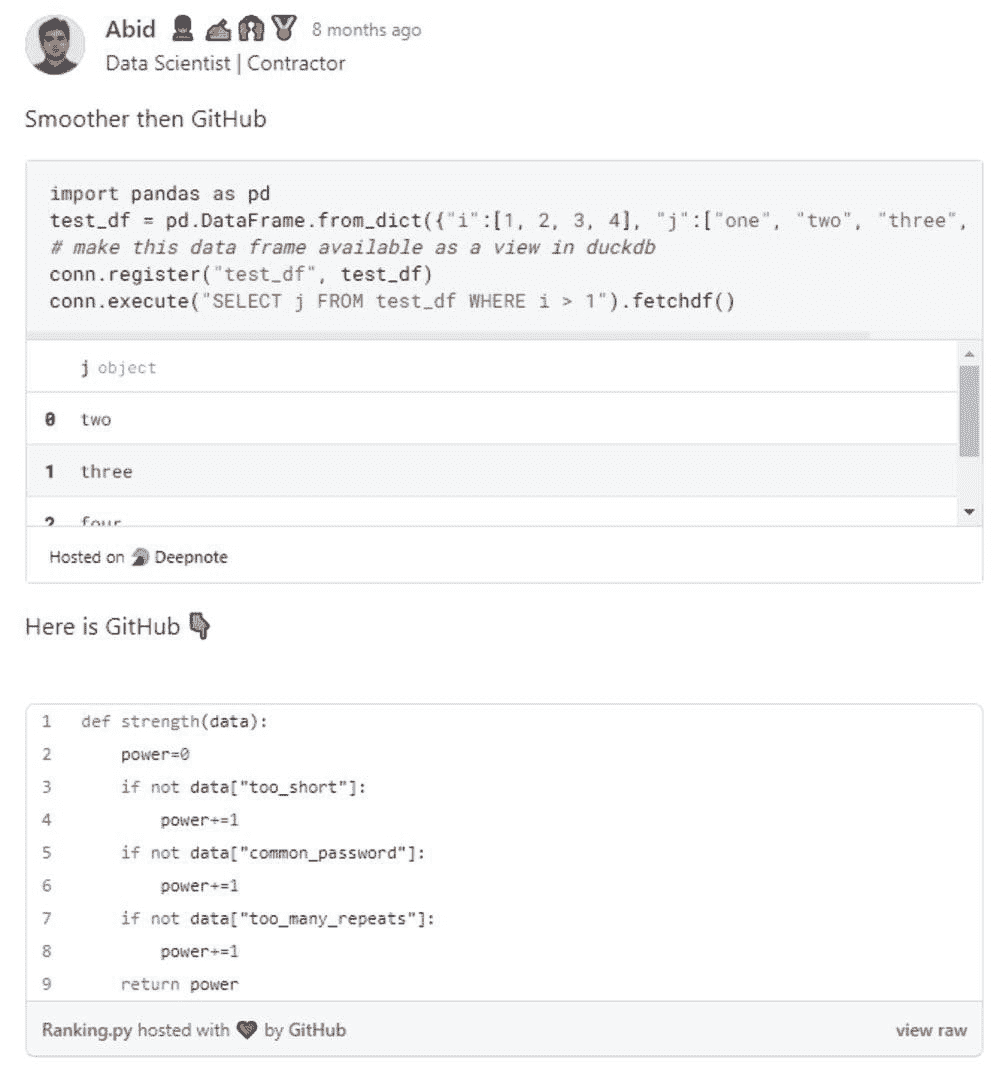

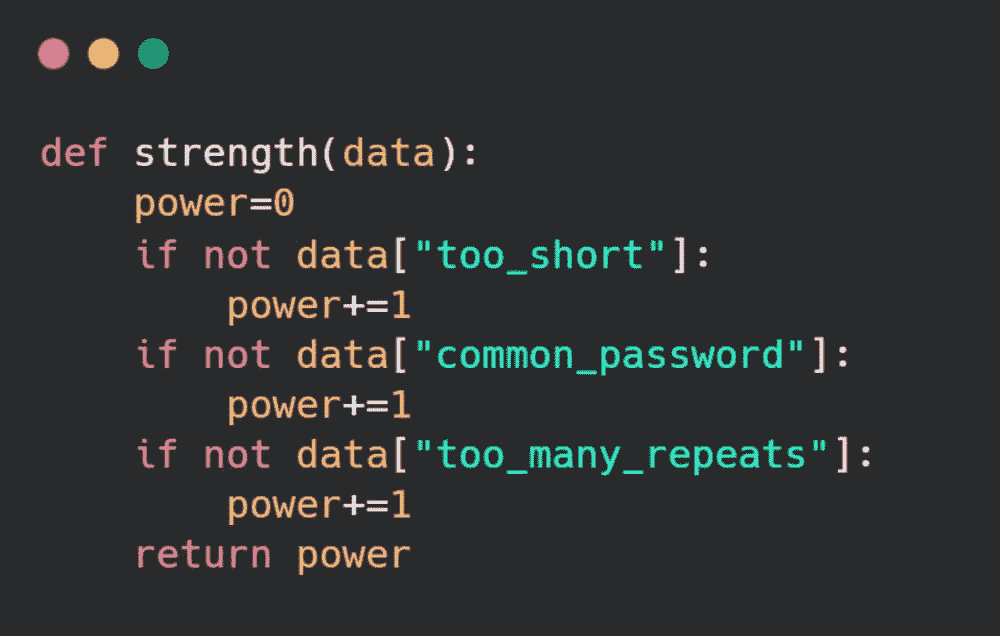

所以在我之前的博客文章从零开始展开朴素贝叶斯! 第1部分????中,我试图解码朴素贝叶斯(NB)机器学习算法的工作原理,通过它的算法洞察,你也一定会发现这个算法相当简单。在这篇博客中,我们将详细讲解其完整的逐步Python实现(仅使用基础Python),并且会非常明显从零开始编码NB有多么简单,而且NB在分类上并不那么天真!

目标受众是谁? ???? ???? ???? 机器学习初学者 ???? ????????

由于我一直想为绝对初学者解读机器学习,而且有人说如果你不能解释清楚,那你可能没真正理解它,所以这篇博客也特别针对寻找深入但没有那些可怕的希腊数学公式的机器学习初学者(老实说,那些吓人的数学对我来说也没什么意义!)

本教程的成果 — 朴素贝叶斯的实用Python实现

如我刚刚提到的,完整的朴素贝叶斯Python实现讲解

一旦你阅读完这篇博客文章,你将完全掌握90%的朴素贝叶斯理解和实现,剩下的10%则是从应用角度掌握它!

机器学习小鸟从零到英雄!!!

定义路线图….. ????

**里程碑 # 1: **数据预处理函数

里程碑 # 2:实现 NaiveBayes 类——定义训练和测试函数

里程碑 # 3:在训练数据集上训练 NB 模型

里程碑 # 4:使用训练好的 NB 模型进行测试

里程碑 # 5:证明 NaiveBayes 类的代码绝对通用!

在我们开始编写 Naive Bayes 的 Python 代码之前,我假设你已经熟悉:

-

Python 列表

-

Numpy 以及一点向量化代码

-

字典

-

正则表达式

让我们开始 Pythonic 的实现吧!

定义数据预处理函数

让我们从几个在实现 Naive Bayes 时需要的导入开始

里程碑 # 1 达成 🤩

实现 NaiveBayes 类——定义训练和测试函数

附加部分:我们将为 NB 分类器编写一个完全通用的代码!无论训练数据集中有多少类,以及给定什么文本数据集——它仍然能够训练一个完全有效的模型 🤔 🤔 🤔

NaiveBayes 的代码只是 稍微复杂——但我们只需要花费最多 10-15 分钟就能掌握它!之后,你绝对可以自称为“NB 大师” 🤓

这段代码在做什么?🤔

NaiveBayes 类中总共定义了四个函数:

1\. def addToBow(self,example,dict_index)

2\. def train(self,dataset,labels)

3\. def getExampleProb(self,test_example)

4\. def test(self,test_set)

代码被分为两个主要函数,即训练和测试函数。一旦你理解了这两个函数内部定义的语句,你将确切了解代码的实际作用以及其他两个函数的调用顺序。

1\. Training function that trains NB Model :

def train(self,dataset,labels)

2\. Testing function that is used to predict class labels

for the given test examples :

def test(self,test_set)

另外两个函数是为了补充这两个主要函数而定义的

1\. BoW function that supplements training function

It is called by the train function.

It simply splits the given example using space as a tokenizer

and adds every tokenized word to its corresponding BoW :

def addToBow(self,example,dict_index)

2\. Probability function that supplements test function.

It is called by the test function.

It estimates probability of the given test example so that

it can be classified for a class label :

def getExampleProb(self,test_example)

你也可以在这个 Jupyter Notebook 中查看上述代码

如果我们定义一个 NB 类,而不是使用传统的结构化编程方法,组织和重用代码会容易得多。这就是定义一个 NB 类及其相关函数的原因。

我们不仅仅想编写代码,更希望编写美观、整洁、实用且可重用的代码。没错,我们希望拥有一个优秀数据科学家可能具备的所有特质!

你知道吗?每当我们处理一个文本分类问题并打算使用NB解决时,我们只需实例化其对象,通过相同的编程接口,就可以训练一个NB分类器。而且,根据面向对象编程的一般原则,我们只在类内部定义与该类相关的函数,因此所有与NB类无关的函数将会被单独定义。

里程碑 # 2 达成 🎉 🎉

相关话题

-

Chip Huyen 分享实施ML系统的框架和案例研究

了实施 ML 系统的框架和案例研究](https://www.kdnuggets.com/2023/02/sphere-chip-huyen-shares-frameworks-case-studies-implementing-ml-systems.html)

自然语言界面到数据表

原文:

www.kdnuggets.com/2019/06/natural-language-interface-datatable.html

评论

评论

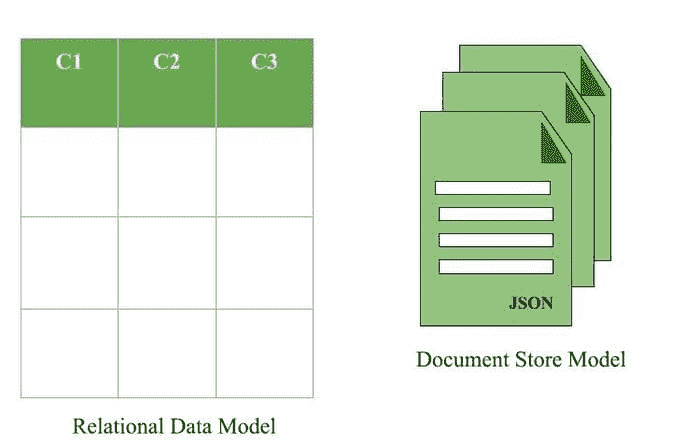

由 Yogesh Kulkarni, Yati.io

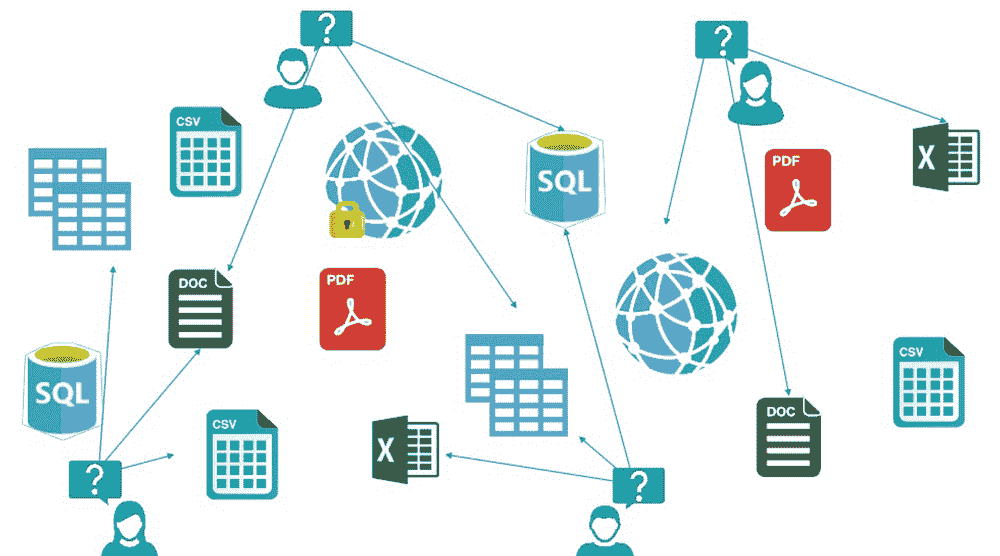

大量结构化数据以关系数据库中的表格形式存储。以一个表格作为简化的例子,即使要访问各个单元格中的值,也需要编写逻辑或在电子表格软件中打开并手动查找。如果可以仅通过自然语言(如英语)查询字段,岂不是更好吗?

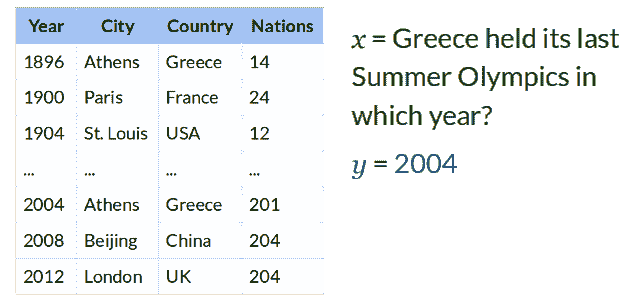

例如,如果你有一个像图 1中那样的表格,那么在聊天机器人中发送一个“2008 年哪个城市举办了奥运会?”的查询会更好,你会得到“北京”这样的答案。这比编写程序或手动搜索一个庞大的表格要用户友好得多。

图 1:维基表格问题(来源:斯坦福 NLP 组研究博客)

上述例子确实是为数据集或数据库提供自然语言界面的巨大可能性的非常简单版本。自然语言理解(NLU)是关键技术,它会解析自然语言查询(如英语),‘理解’它,然后发出数据格式特定的查询以获取所需的答案。本文演示了如何使用 Rasa NLU 框架实现这一点。

Rasa 是一个开源聊天机器人框架。它分为两个部分,‘NLU’用于理解用户文本中的意图和实体,而‘Core’则用于对话管理。Rasa 框架的一个显著特点是其功能基于机器/深度学习,并且是在本地训练的。无需将你的数据(即用户文本)发送到某些托管服务进行 NLU 或对话管理。

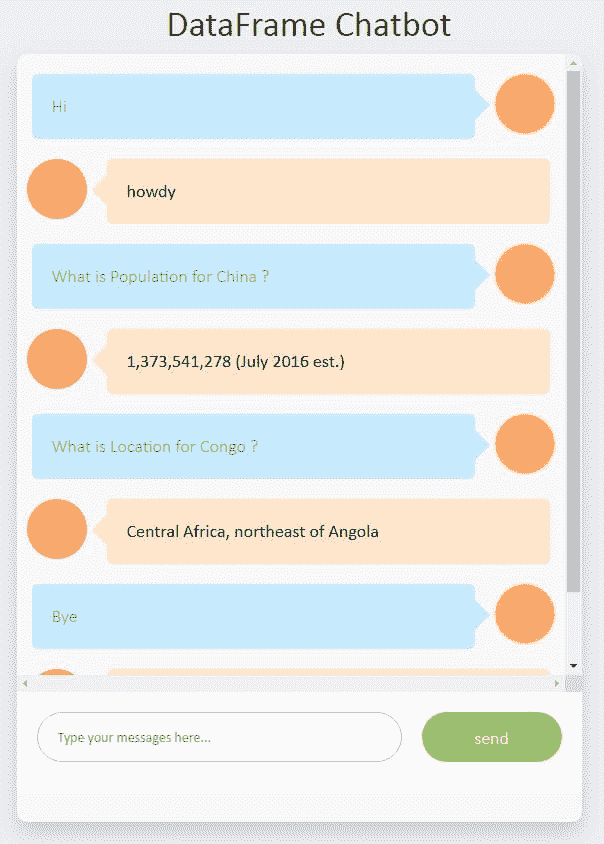

示例聊天机器人

比如,你希望构建一个通用知识聊天机器人,用于查询世界各国的信息。查询如“中华人民共和国的总人口是多少?”,“印度的面积是多少?”等。

世界概况手册 是一个关于各国数据的极好来源。信息以国家网页的形式排列,包含“地理”、“经济”等部分。要查找中国的人口,首先需要在下拉列表中滚动到中国,找到“人民与社会”部分,然后你会看到中国的人口为“1,384,688,986(2018 年 7 月估计)”。在这种情况下,聊天机器人会更有效。

数据收集

首要步骤是将分散在各种网页上的数据整合到一个表格中。这个文章很好地解释了网络抓取的过程。输出是一个以国家为行、以各个字段为列的表格。

现在我们需要构建一个自然语言接口来访问这个表的字段或单元格。对于像“China 的总人口是多少?”这样的查询,我们需要获取位于“Country==China”行和名为“Population”的列交叉处的单元格中的值。简单来说,从自然语言查询中,我们需要提取两个实体,“Population 作为列”和“China 作为行”(在“Country”列中)。这里使用 Rasa NLU 进行实体提取。

实体提取

实体提取是一个在句子中找到映射到预定义实体类型的单词/标记的过程。命名实体识别(NER)是提取实体的监督方法,使用如条件随机场(CRF)等算法。

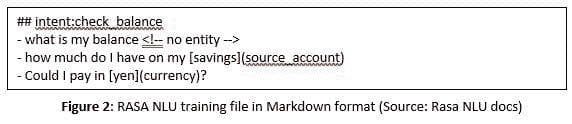

要训练 RASA NLU 的 NER,我们需要提供带有注释实体的样本句子的训练数据。图 2中展示了样本训练文件。

这里“savings”和“yen”分别是“source account”和“currency”实体类型的实际值。

为给定的表构建这种训练数据,将再次是一个手动的、繁琐的过程。通过对表的行和列进行迭代,注释过程可以自动化。不需要提供所有列或行的示例,因为学到的是抽象模式,而不是单元格中的硬编码实际值。

生成训练文件的代码示例如下:

n_sample_countries = 5

n_sample_columns = 5

self.all_columns = [col for col in list(self.df.columns) if col != self.primarycolumnname]

sample_sentences = []

for c in self.primary_key_values_list[:n_sample_countries]:

for col in self.all_columns[:n_sample_columns]:

sentenceformat1 = "What is " + col + " for " + c + " ?"

sentenceformat2 = "For " + c + ", what is the " + col + " ?"

sample_sentences.append(sentenceformat1)

sample_sentences.append(sentenceformat2)

尽管上述仅显示了两种句子格式,但可以添加更多变体。自动生成的 NLU 训练文件如下:

## intent:query

- What is Area for Afghanistan ?

- For Afghanistan, what is the Area ?

- What is Background for Akrotiri ?

- For Akrotiri, what is the Background ?

- What is Location for Akrotiri ?

- For Akrotiri, what is the Location ?

- What is Map references for Akrotiri ?

- For Akrotiri, what is the Map references ?

:

:

使用训练数据训练 NER 模型。当用户查询出现时,模型能够提取“行”和“列”名称。有了这两个信息,就可以在给定的表中定位值。值返回给用户。

以下是样本对话工作流:

聊天机器人的源代码可以在“DataFrame Chatbot”找到。

聊天机器人的源代码可以在“DataFrame Chatbot”找到。

限制与未来展望

展示的聊天机器人示例非常简化。它可以通过以下功能进一步增强:

-

跨多个表的查询。

-

查询带有聚合和关系的,例如“哪些国家人口超过 1 亿且人均 GDP 低于$1000?”。

-

部分/完整 SQL 支持,即将自然语言查询转换为等效的 SQL 查询。

结论

本文演示了如何构建一个聊天机器人,以用户友好的方式与数据表进行交互。它在那些提供这种表格数据的领域有多种应用。

简介:Yogesh Kulkarni 是 Yati.io 的数据科学讲师兼研究员。

相关内容:

-

使用 Python 和 NLTK 构建你的第一个聊天机器人

-

TNLP – 构建一个问答模型

-

使用深度学习从职位描述中提取知识

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持组织的 IT 工作

更多相关话题

自然语言处理:将人类沟通与人工智能连接起来

原文:

www.kdnuggets.com/natural-language-processing-bridging-human-communication-with-ai

摄影作品由 ROMAN ODINTSOV 提供

想象一个机器能够理解你所说的话和你的感受的世界;你可以和计算机交谈,它会做出回应;科技能够筛选文本并为你总结。等一下。你不需要想象任何东西——这已经成为现实,得益于 NLP 的应用。

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

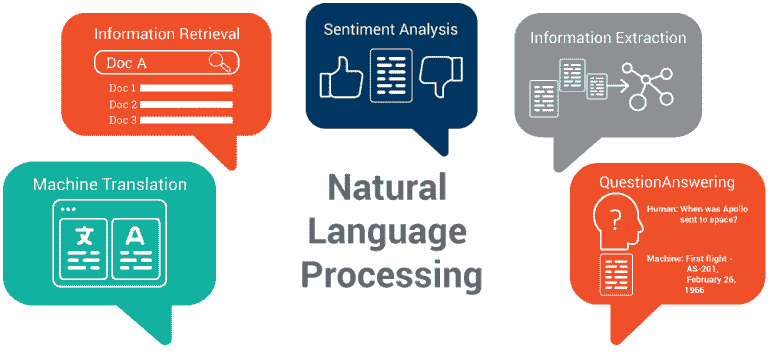

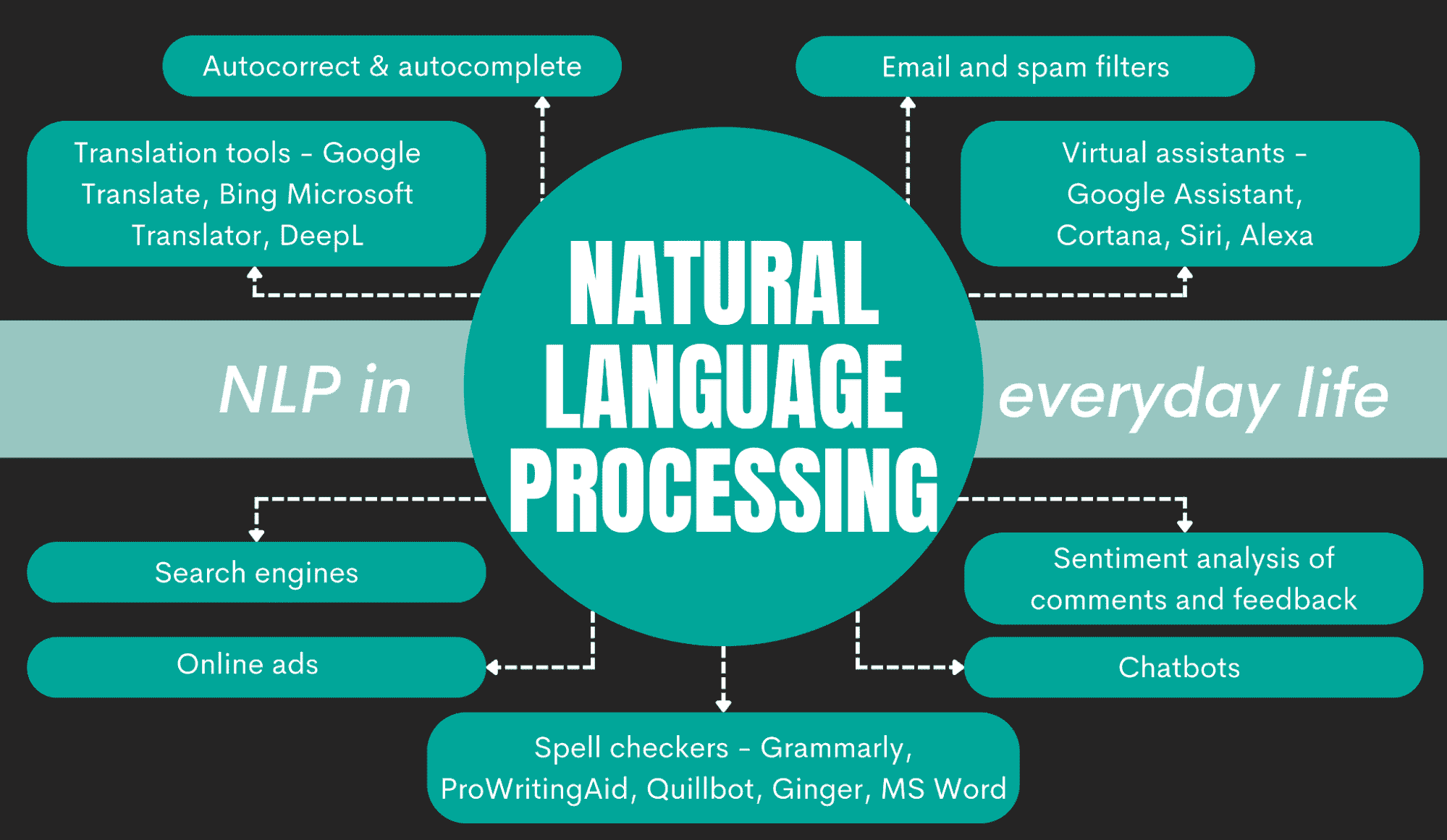

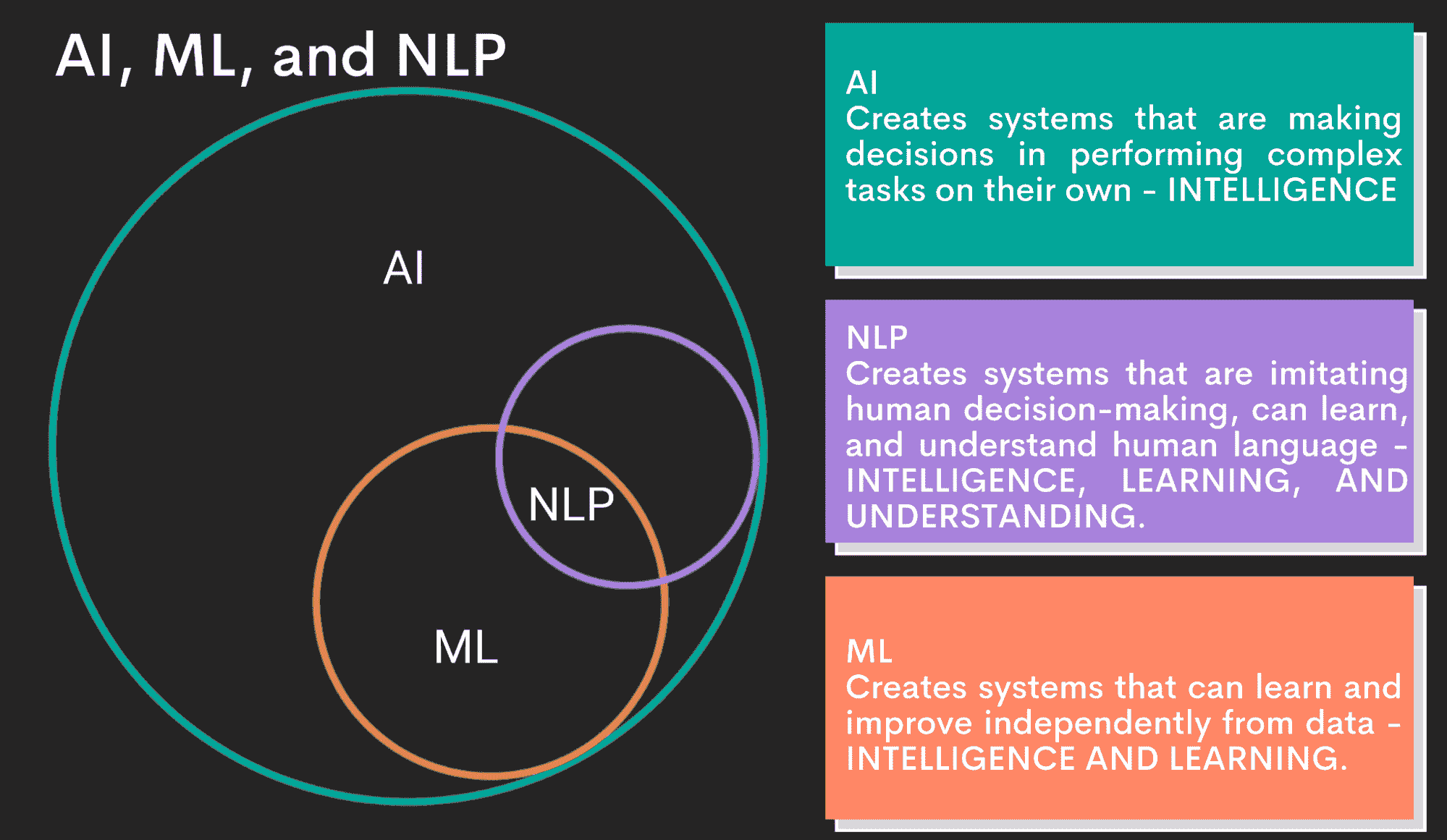

作为人工智能的一个子领域,自然语言处理(NLP)已成为技术突破,使计算机能够使用人类语言进行沟通。其 市场规模 在 2023 年被评估为 189 亿美元,并预计到 2028 年将增长到 680 亿美元。考虑到 NLP 在现代世界的多种应用,从聊天机器人到机器翻译再到文档分析,这并不令人惊讶。

在这篇文章中,我们讨论了自然语言处理对商业的变革性影响,它的应用案例以及各行业的实际例子。我们还简要介绍了自然语言处理的好处、挑战以及它带来的未来机会。

理解自然语言处理的本质

自然语言处理(NLP)是一种结合了语言学、统计学和机器学习(ML)技术的方法,能够处理海量数据。这使计算机能够理解人类语言中的细微差别,理解上下文,并以有意义的方式做出回应。换句话说,NLP 算法旨在将人类沟通与人工智能连接起来。

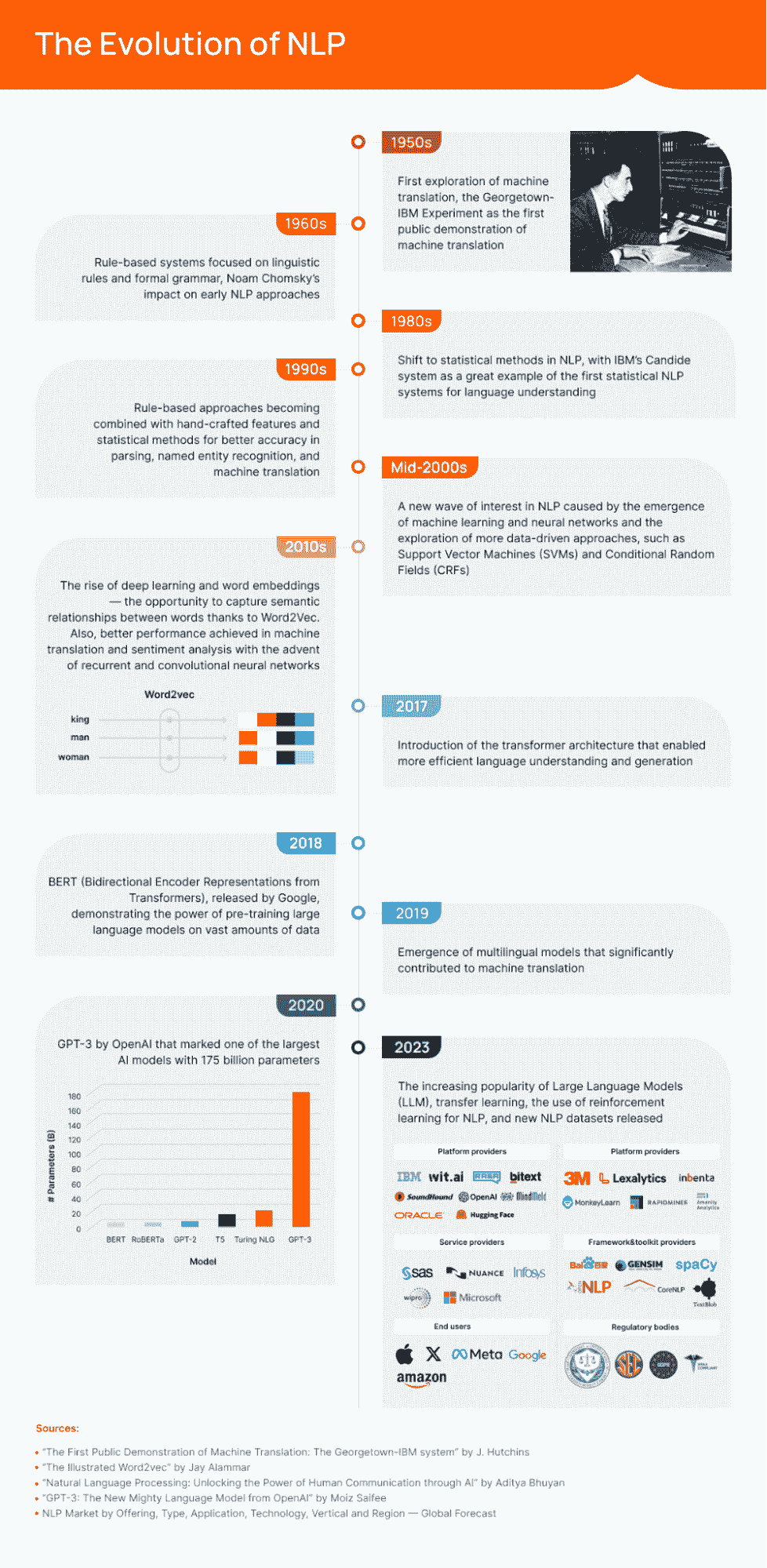

但情况并非一直如此。下面的图表展示了 NLP 随时间演变的过程,直到达到今天的潜力。NLP 采用的关键驱动因素包括计算能力的提升、AI 和机器学习的进步以及数据的可用性。后者主要是因为云计算提供了更好的可扩展性和更低的存储及处理成本。

NLP 的演变

自然语言处理(NLP)的演变也经历了从基于规则的系统到机器学习算法的过渡,后者可以“理解”语言。在基于规则的方法中,专家手动编码每个规则在 NLP 中。这也是为什么这些系统相比机器学习更静态且不可适应。

NLP 的基本目标

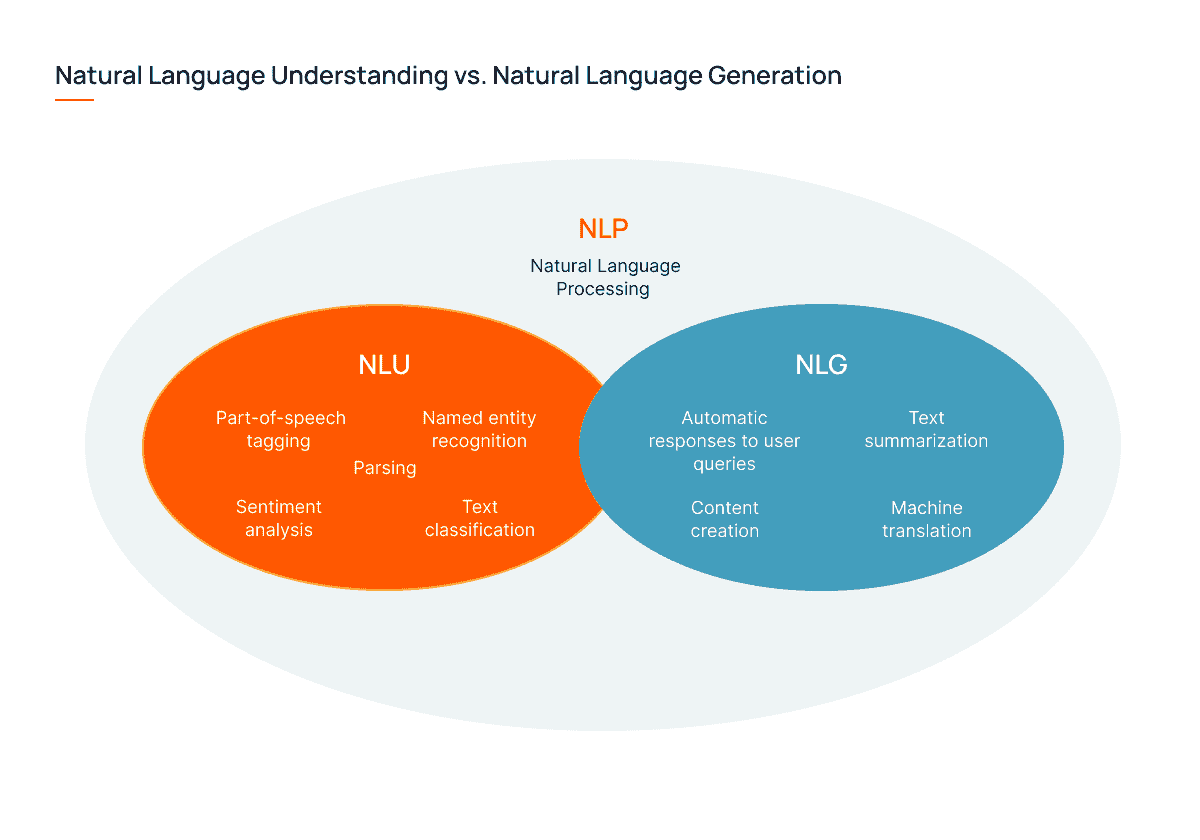

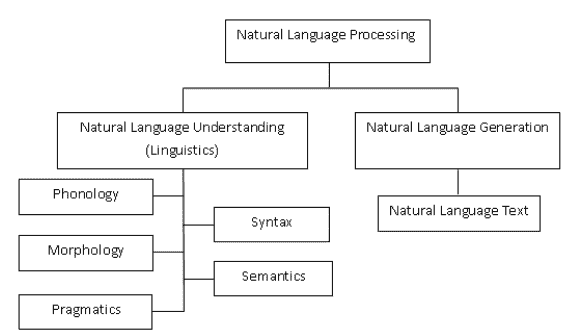

深入探索 NLP 的本质时,我们应该提到其基本目标是理解和与人类语言互动。因此,我们区分以下内容:

-

自然语言理解(NLU),关注于意义的提取。它帮助理解书面和口头语言的复杂性和细微差别,处理歧义和上下文变化。例如,NLU 对区分口音或理解俚语非常有用。

-

自然语言生成(NLG),涉及从数据中生成类似人类的回应。利用统计方法和语言模型分析大量数据,NLG 帮助以对话的方式“回应”用户查询。它还处理文本摘要、机器翻译和内容创作。

自然语言理解与自然语言生成

现在我们可以概述 NLP 的工作原理。基本上,有 2 个步骤:

-

将文本转换成机器可以理解的形式。

-

分析文本以实际理解上下文和语言,并提取意义。

与此同时,自然语言处理系统的内部发生了许多工作,以使机器能够执行这两项操作。让我们快速了解一下关键的 NLP 组件,以便更好地理解其工作原理:

-

分词:将文本分解为较小的单元,如单词或短语(标记),以便在更小、可管理的块中处理它们。

-

句法分析:解析语法结构,以正确理解句子的句法关系。

-

词性标注:为句子中的单词分配语法标签(例如,名词、动词等),以增加句法分析的深度。

-

语义分析:捕捉单词、短语和句子的含义和上下文。

-

情感分析:确定文本中表达的情感或情绪,如积极、消极或中性。

-

命名实体识别(NER):识别和分类实体,即名称、组织、地点等。

-

统计和机器学习模型:处理和分析大量数据。监督学习算法最适用于文本分类和情感分析等任务,而无监督算法则适用于聚类和主题建模。

-

语言模型:用于预测上下文中词序列的概率。这种技术广泛用于自动补全和语言生成任务。

-

语言翻译模型:用于将文本从一种语言转换为另一种语言。先进的模型,如神经机器翻译,能显著提高翻译的准确性。

-

语言生成技术:基于数据或给定上下文生成类似人类的回应。这种方法用于聊天机器人、文本摘要等。

这些组件的结合与整合使数据科学家能够构建强大的 NLP 系统,并有助于改善 AI 沟通结果。

通过 NLP 转变人类沟通

自然语言处理在各行各业中正获得越来越多的关注,每年都有新的应用出现。以下是我们对 NLP 最常见用例的回顾,以发现 NLP 在业务沟通转型中的潜力。

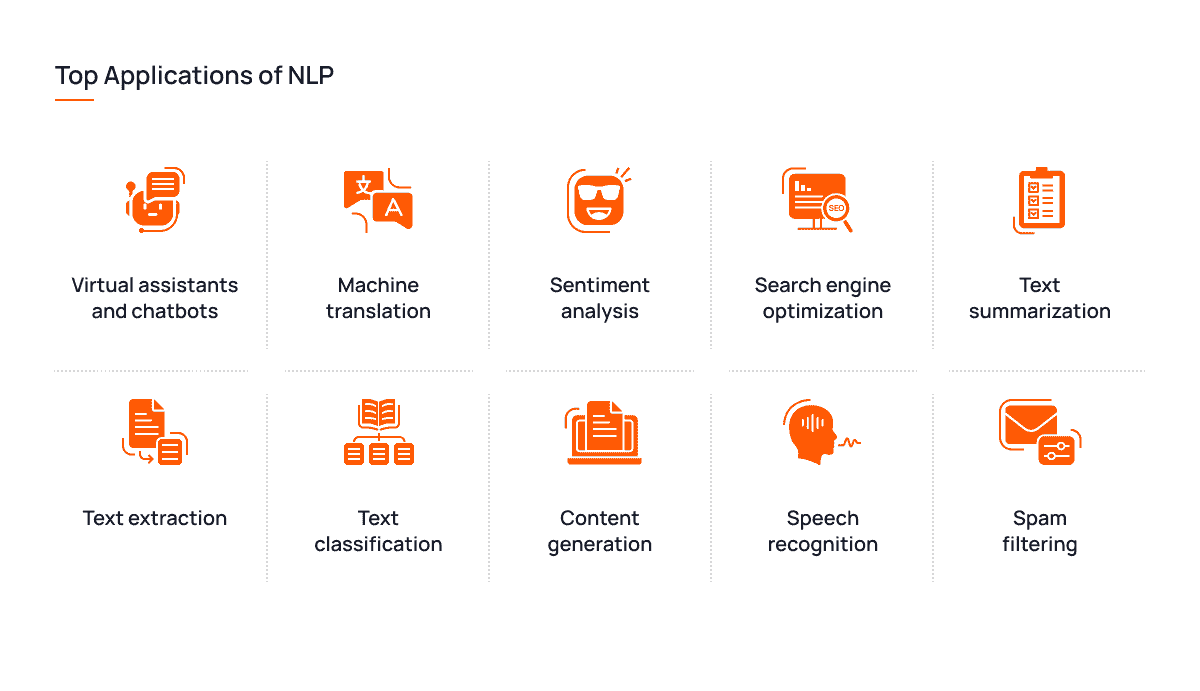

NLP 的主要应用

对话 AI 和聊天机器人

当想到 NLP 时,智能虚拟助手和聊天机器人是最先想到的。今天的 NLP 对话 AI 系统足够复杂,可以与用户进行真实且上下文适当的对话。

像 Siri 或 Alexa 这样的虚拟助手已经成为我们日常生活的一部分,处理像设置提醒、拨打和接听电话、寻找停车位等小任务。基于 NLP 的聊天机器人通过扩展支持服务和提高个性化来为企业做出贡献。

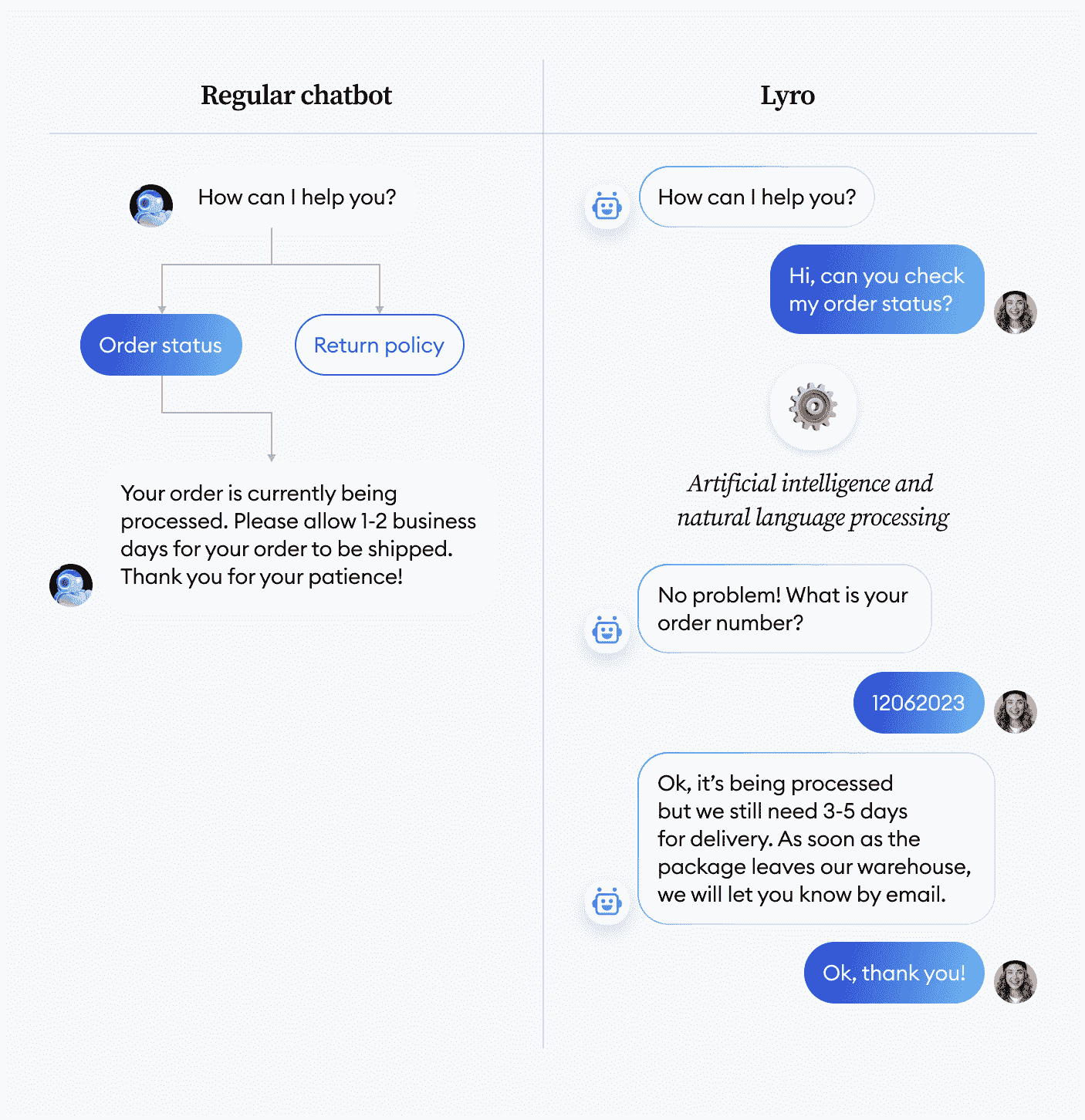

看一下下面由 Tidio 开发的 Lyro 聊天机器人。与普通聊天机器人不同,Lyro 不需要支持人员的训练——公司激活它后,它便开始立即响应用户的查询。

图片来自 Tidio

机器翻译

机器翻译是 NLP 的第二大突出应用。学生、语言翻译者、游客以及许多人今天都离不开 Google Translate。尽管机器翻译早在 NLP 之前就存在,但它通过以下方式将其提升到了一个新水*:

-

利用变换器增加准确性和流畅性

-

促进和简化实时语言翻译

-

实现上下文感知翻译,告别传统的逐字翻译方法

-

帮助内容本地化,以考虑文化偏好和地方方言

为了更具说明性,这里有 DeepL,一个不如 Google Translate 知名的竞争者。该工具支持 26 种语言翻译,帮助用户打破语言障碍。它还具备应用集成和网站翻译插件。

图片来源于 Deepl

文档管理

NLP 还有独特的语音转文本功能,有助于提高文档的准确性和效率。除了像口述文本这样的简单应用,NLP 还可以实现以下功能:

-

文本摘要:AI 提供的自动摘要在需要快速消化大量信息时非常有用。NLP 不仅仅是总结冗长的文本——关键词提取和句子排名使 NLP 能够以连贯的方式总结文本,捕捉关键点。

-

信息提取:在 NLP 的其他方法中,NER 在自动信息检索和知识发现方面特别高效。这极大地节省了研究人员在大量信息中筛选的时间和精力。

-

文本分类:当面对大量文本数据时,NLP 可以帮助对其进行分类。这样,公司的数据会更有条理,同时也能提高信息的可访问性。

内容生成

由于其捕捉事件和数据本质的能力,NLP 可以根据给定的信息生成内容。也许大家都听说过 ChatGPT 以及它如何通过正确的提示创建独特、有意义的内容。这些模型可以通过帮助内容创作者撰写产品说明、社交媒体帖子、文章、电子邮件等,来让他们的生活变得更轻松。

考虑一个比 GPT 更冷门的 AI 内容创作工具。OwlyWriter AI 可以节省营销人员大量时间。该工具帮助社交媒体专业人员克服写作障碍,提高工作效率,从创建帖子的标题到生成内容创意再到撰写帖子。

图片来源于 Hootsuite

语音识别

NLP 的另一个伟大应用是语音识别,它允许机器将口语转换为书面文本。同样,像 Siri 或 Google Assistant 这样的语音助手在这方面是最具代表性的例子。

语音识别还有许多其他应用场景,比如转录服务或语音控制设备。记得那种允许驾驶员安全免提控制汽车的功能。此外,智能家居设备都是基于 NLP 开发的。

情感分析

情感分析作为 NLP 技术之一,最适合分析客户评论和社交媒体情感,以获取对产品或服务的公众意见或跟踪趋势。

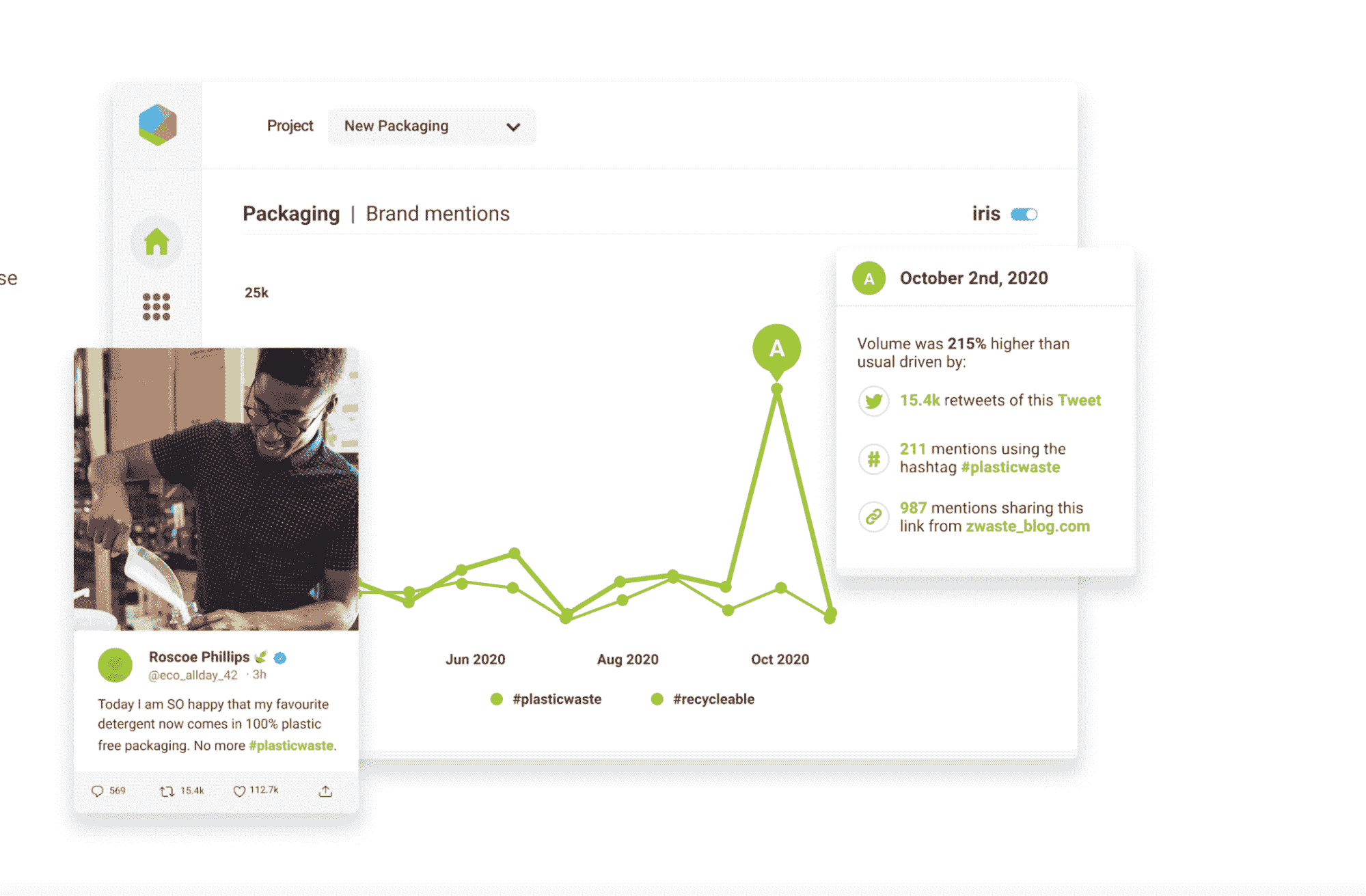

例如,NLP 可以帮助企业分析关于*期产品发布的客户反馈,以便做出更明智的客户满意度决策。它还支持社交媒体监控应用程序,如 Brandwatch。这些应用程序监控公司在社交网络上的内容,以了解公众对品牌的看法和感受,追踪趋势,管理在线声誉。

图片来源: Brandwatch

搜索引擎优化

像 Google 这样的搜索引擎使用 NLP 来提高搜索结果的准确性。这种方法有助于更好地理解用户查询背后的意图,并将其与最相关的搜索结果匹配。

垃圾邮件过滤

自然语言处理(NLP)革命化的另一个领域包括垃圾邮件过滤。在这里,我们不仅谈论电子邮件,还包括其他应用。例如, YouTube 使用 NLP 来过滤其视频评论区的垃圾数据。它使用一个名为 TubeSpam 的工具,该工具通过朴素贝叶斯分类器进行训练,以过滤垃圾邮件。

NLP 的应用列表要长得多。我们讨论了最大的用例,但遗漏了像自动更正和自动完成、欺诈检测等较小的用例。为了使我们的研究更全面,让我们谈谈 NLP 如何在现实生活中转变各个行业的例子。

NLP 在实际中的应用实例

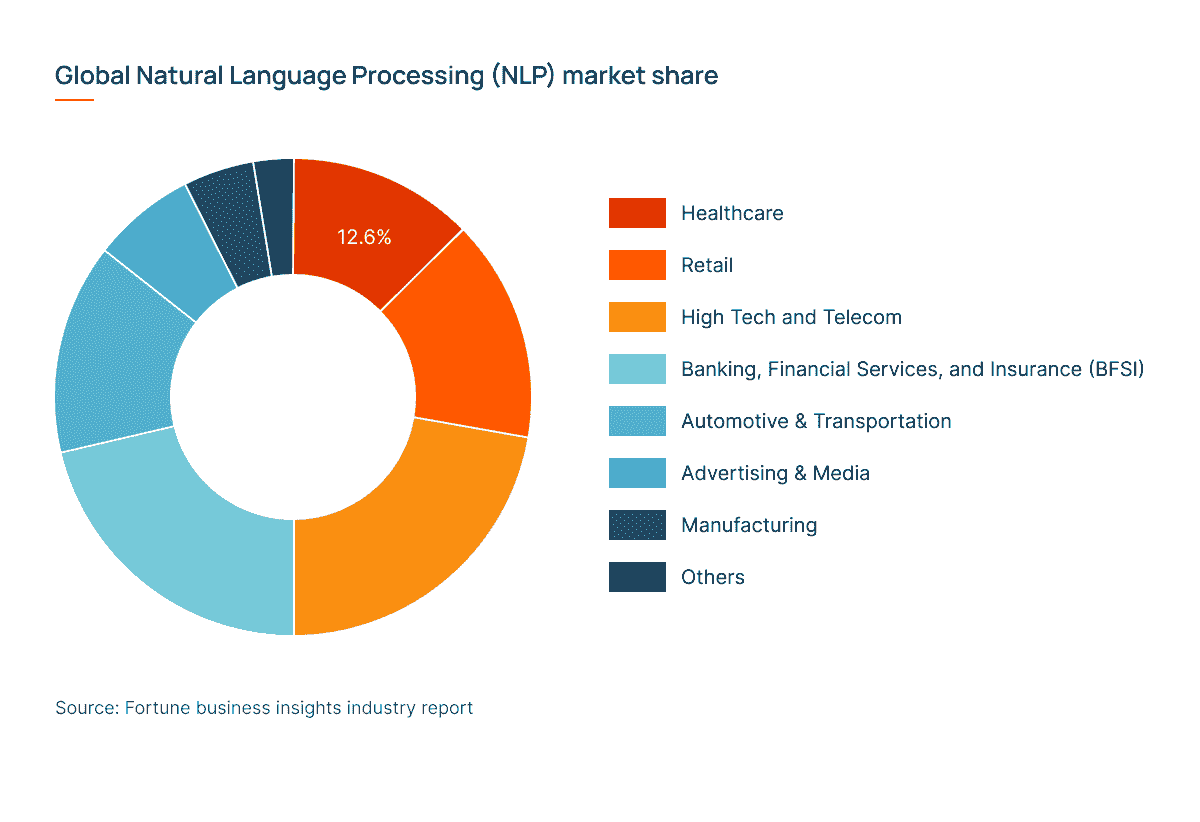

尽管 NLP 在各个行业中得到了成功应用,但其最大的市场份额集中在科技、医疗保健、零售、金融服务、保险和市场营销领域。请详细了解这些领域的情况。

全球 NLP 市场份额按行业划分

客户服务

基于 NLP 的聊天机器人和虚拟助手彻底改变了客户服务。现在,客户可以获得全天候支持,而代理则从减少的工作负担中受益。由美国银行创建的聊天机器人 Erica 提供财务支持和指导,并帮助用户进行在线银行操作。NLP 使 Erica 能够学习用户的偏好和需求,并提供个性化建议。

让我们看看 NLP 在客户服务中的具体应用例子:

-

基于 NLP 的语音助手可以理解用户的请求并将其转发给合适的人工客服

-

用于简单任务的自动化聊天机器人,如回答问题、检查信息、安排预约等

-

使用虚拟助手进行免提设备和服务交互

-

客户反馈分析和情感分析——例如,聊天机器人可以在处理沮丧的客户时先进行道歉

电商和零售

目前,大多数知名电商网站如 Amazon、eBay 或 Walmart 使用 NLP 驱动的语义搜索,这提高了产品的可见性和搜索体验。与匹配关键字相比,语义搜索更具直观性,旨在理解用户查询背后的意图。

除了语义搜索,NLP 在零售领域还有其他应用:

-

客户情感分析,以更好地了解品牌忠诚度,并最终增强品牌实力

-

与语音助手的对话式商务

-

个性化产品推荐

教育

在教育领域,NLP 有着最具创意的应用。一个很好的例子是 Coursera 的课程推荐系统,它帮助用户根据兴趣找到最佳课程。也想想大家都喜欢的 Grammarly,这是一种基于 NLP 的解决方案,可以使你的写作清晰无误。

NLP 在教育中的其他例子包括但不限于:

-

智能辅导系统

-

基于教科书或其他培训材料生成考试题目

-

自动评分和反馈分析

-

抄袭检测软件

-

适应性学习和个性化指导及反馈

金融和银行业务

你是否曾接到过银行打来的电话,询问账户上的可疑活动?这些电话通常是由 NLP 触发的。欺诈检测是 NLP 在金融领域中的最大应用之一。曾经,Mastercard 决策智能系统专门用于指示欺诈活动,帮助公司减少了 50%的欺诈行为。亲自检查解决方案的潜力:

mastercard-a.akamaihd.net/global-risk/videos/DecisionIntelligenceExternalVideoGLOBALJul19.mp4

曝光标签:Mastercard 决策智能

自然语言处理在金融领域的其他两种应用包括:

-

对各种文本数据进行情感分析,如财务报告、社交媒体帖子和新闻文章,以预测股票价格和市场波动,从而帮助交易者和投资者做出更明智的决策

-

从财务报告和文件中提取数据,以及总结财务新闻以便快速更新

医疗保健

NLP 技术对医疗服务提供者非常有帮助,可以总结和分类临床记录和患者信息。通过这种方式,他们可以更快地访问数据并保持文档的组织性。电子健康记录的实现主要得益于自然语言处理。

此外,自然语言处理还可以协助转录,允许医生进行口述记录,减少手动数据输入。临床 NLP 系统可以帮助诊断、制定治疗计划和个性化的治疗建议。例如,Merative L.P.使用 NLP 算法为其患者开发癌症治疗计划。

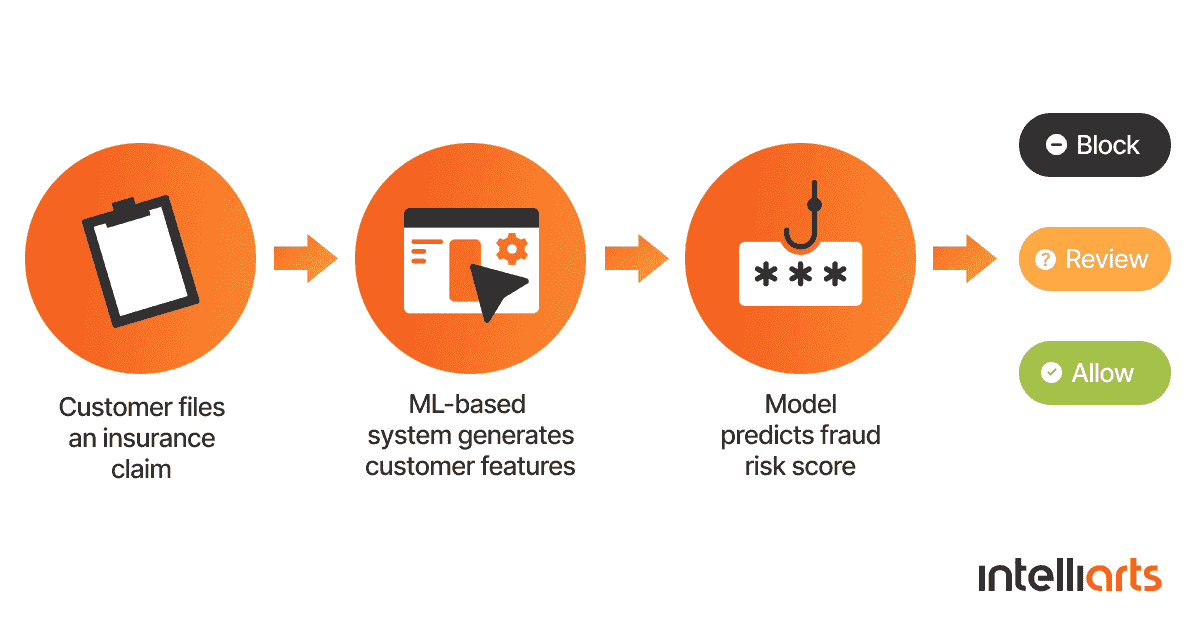

保险

如同在金融领域中,保险领域也利用自然语言处理(NLP)来识别欺诈性索赔。通过分析不同类型的数据,如客户档案、沟通记录和社交网络,NLP 可以检测到欺诈的指标,并将这些索赔发送进行进一步检查。 土耳其保险公司 在切换到基于机器学习的欺诈检测系统后,投资回报率提高了 210%。

机器学习欺诈检测系统的工作原理

保险公司也可以通过文本挖掘和市场情报来监测行业趋势,从而受益于 NLP。通过这种方式,公司可以了解竞争对手的表现,并做出更多数据驱动的决策。

法律

在法律领域,自然语言处理在处理文档时最为有用。法律专业人士可以在合同审查与分析、文本总结、案件结果分析等方面使用该技术。NLP 算法帮助律师扫描大量法律文本,以找到特定的日期、术语或条款。

Luminance 利用自然语言处理(NLP)提高尽职调查和合同审查的效率。与更通用的 GPT 模型相比,该模型在 1.5 亿份法律文件上进行了训练,并由行业专家验证。公司承诺通过自动化合同处理为用户节省高达 90%的时间。

此外,法律专业人士在监管合规监控、审讯记录分析和法律研究中应用自然语言处理(NLP)。

制造业和供应链

在制造业和供应链中,自然语言处理(NLP)同样有效地保持数据组织和简化沟通。例如,它可以帮助分析和筛选大量的货运文件,解决物流挑战。

聊天机器人可以用于更快速地响应客户或供应商的查询。特斯拉早在很久之前就引入了聊天机器人,以提供卓越的客户体验。这些机器人安排试驾并回答有关特斯拉汽车的简单问题。

通过将聊天机器人与制造商的 ERP 或其他遗留系统集成,聊天机器人还可以帮助将信息集中在一个地方,改善部门间的协作。

市场营销

如前所述,情感分析在市场营销中广泛应用,以了解客户对品牌的看法。这有助于向客户推荐个性化的产品或服务,并增强决策能力。例如,麦当劳利用自然语言处理(NLP)来监控社交媒体上的客户投诉,并培训员工正确回应这些投诉。

在命名实体识别(NER)的帮助下,自然语言处理(NLP)还被用来识别热门话题和客户洞察,以便进一步在销售材料或产品设计改进中使用。

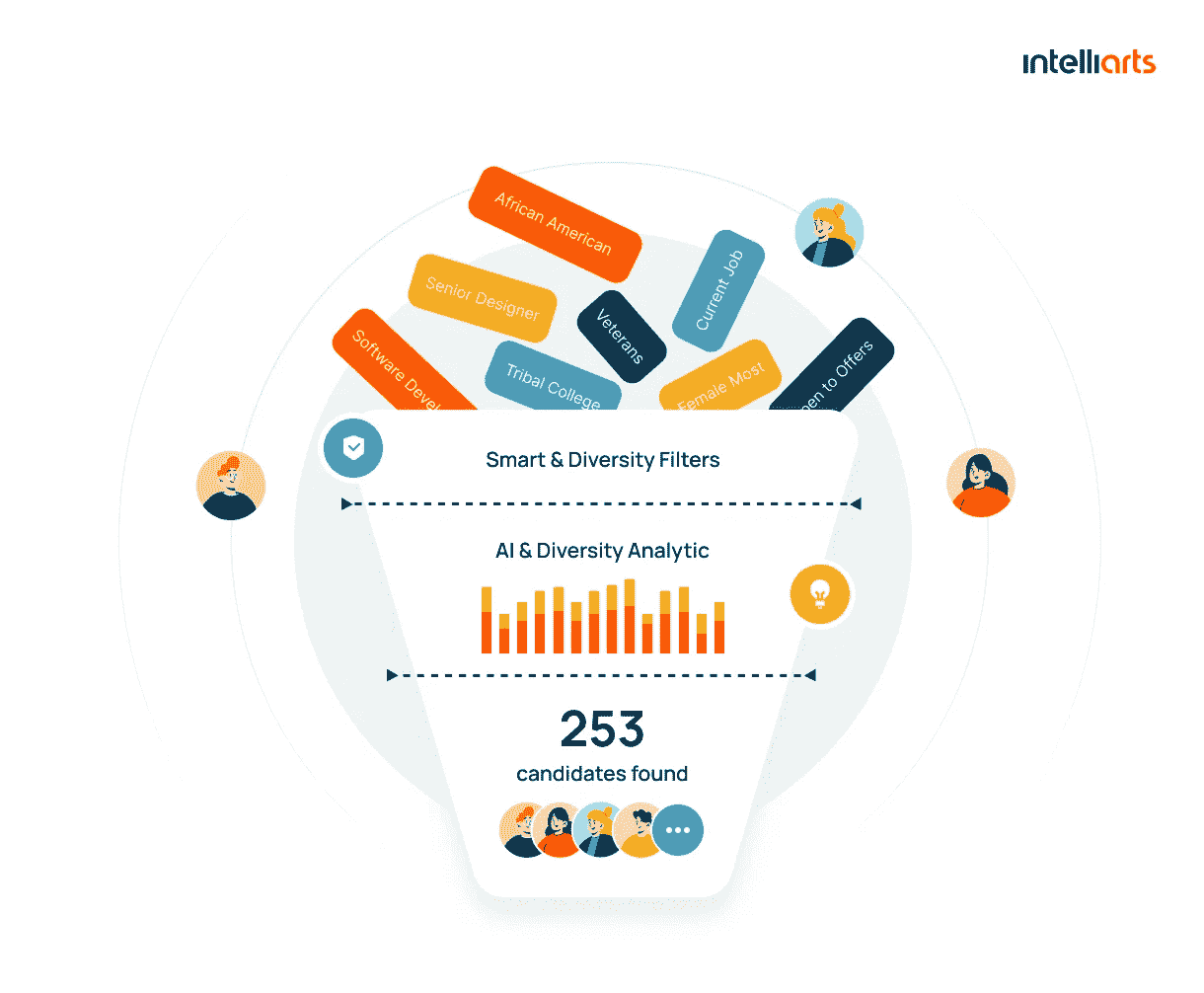

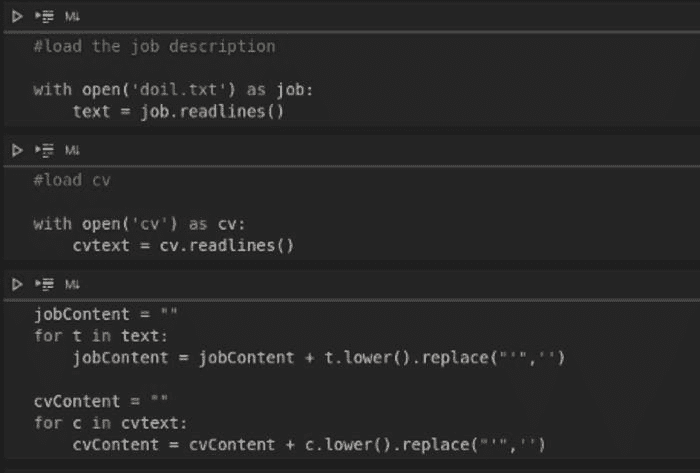

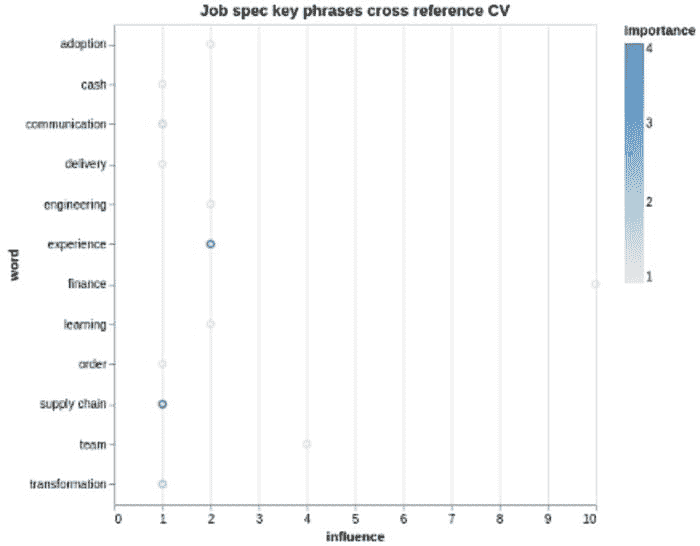

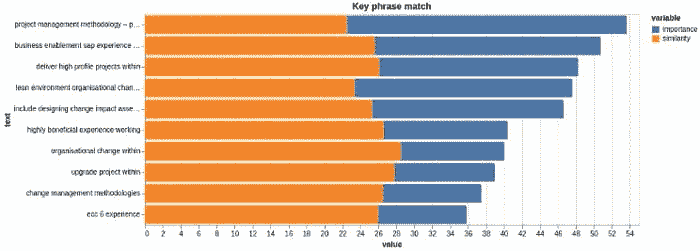

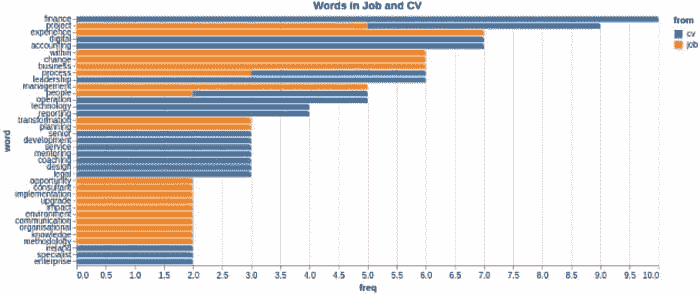

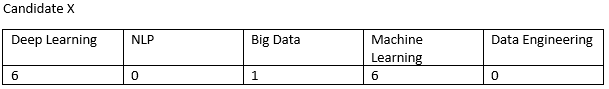

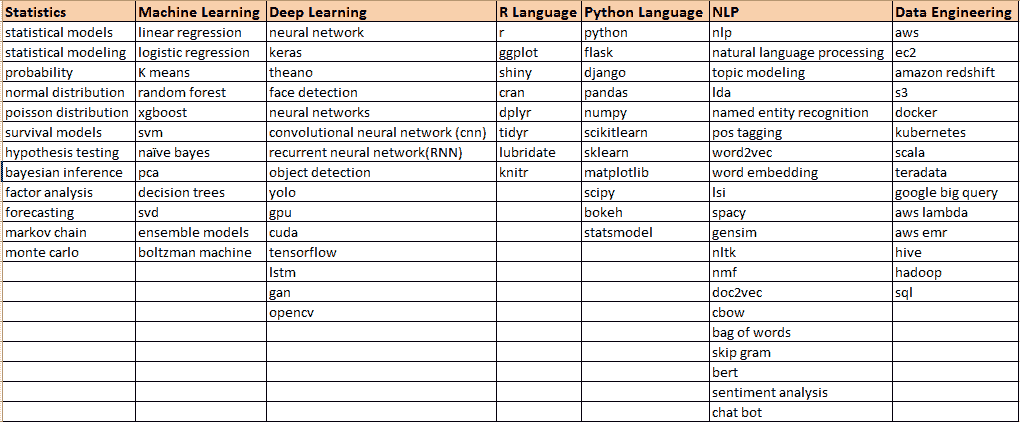

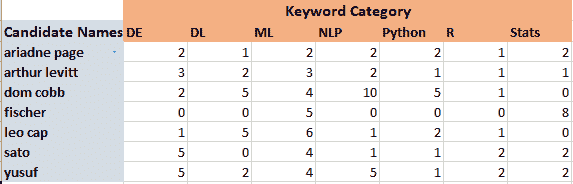

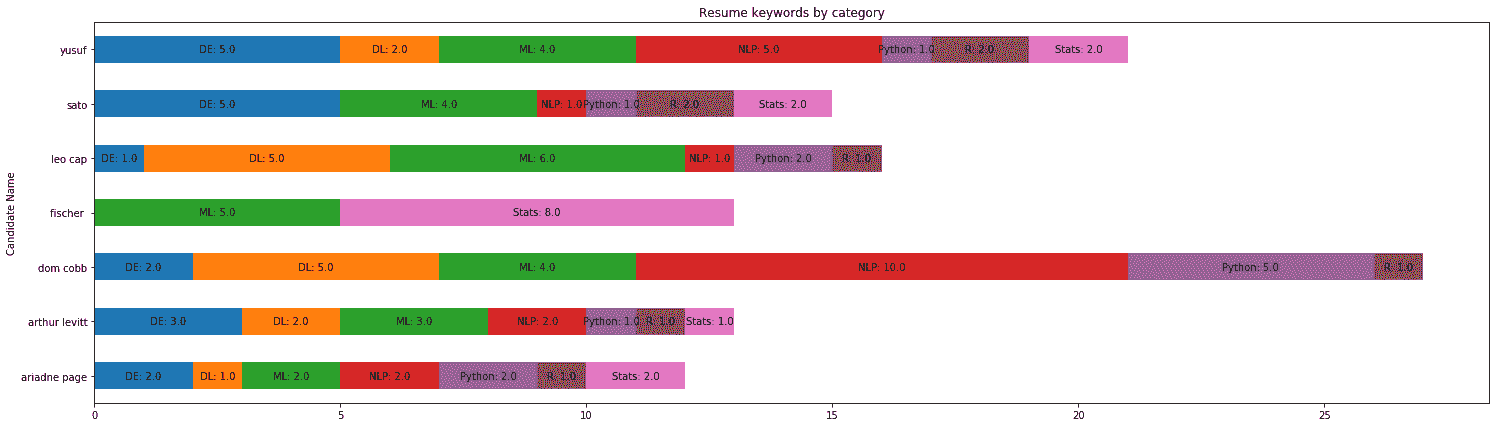

招聘

在招聘中,自然语言处理(NLP)被用于求职候选人筛选,以提高准确性和速度。例如,Intelliarts 开发的 B2B 招聘*台可以将求职者的个人资料与职位描述进行匹配,并涉及 LinkedIn 等社交媒体网站。此外,该解决方案遵循多样性、公*性和包容性(DEI)原则。客户得到的是简化的候选人筛选,同时满足 DEI 要求。

B2B 招聘*台

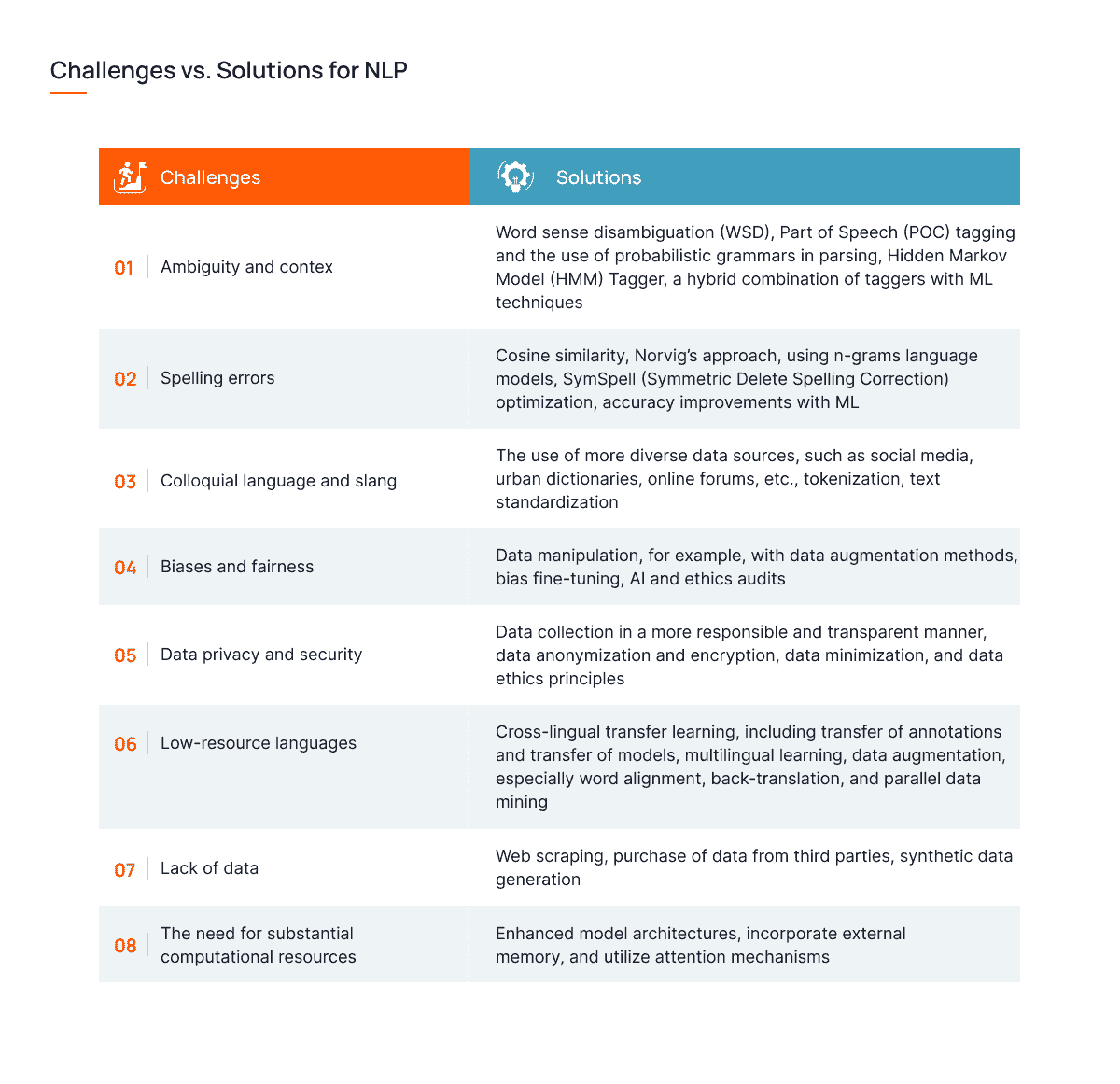

自然语言处理的核心挑战:*衡问题

尽管自然语言处理(NLP)在各个行业中的受欢迎程度和技术进步不断提高,但在融入现有系统的过程中仍存在一些挑战。以下是这些挑战及其潜在解决方案:

挑战与解决方案:自然语言处理

人工智能下的人类沟通未来

NLP 继续发展,新的解决方案不断涌现,以应对上述挑战。同时,NLP 研究中出现了新的应用和趋势。让我们来看看 NLP 的最新进展,以及这些进展如何进一步革新人机交互:

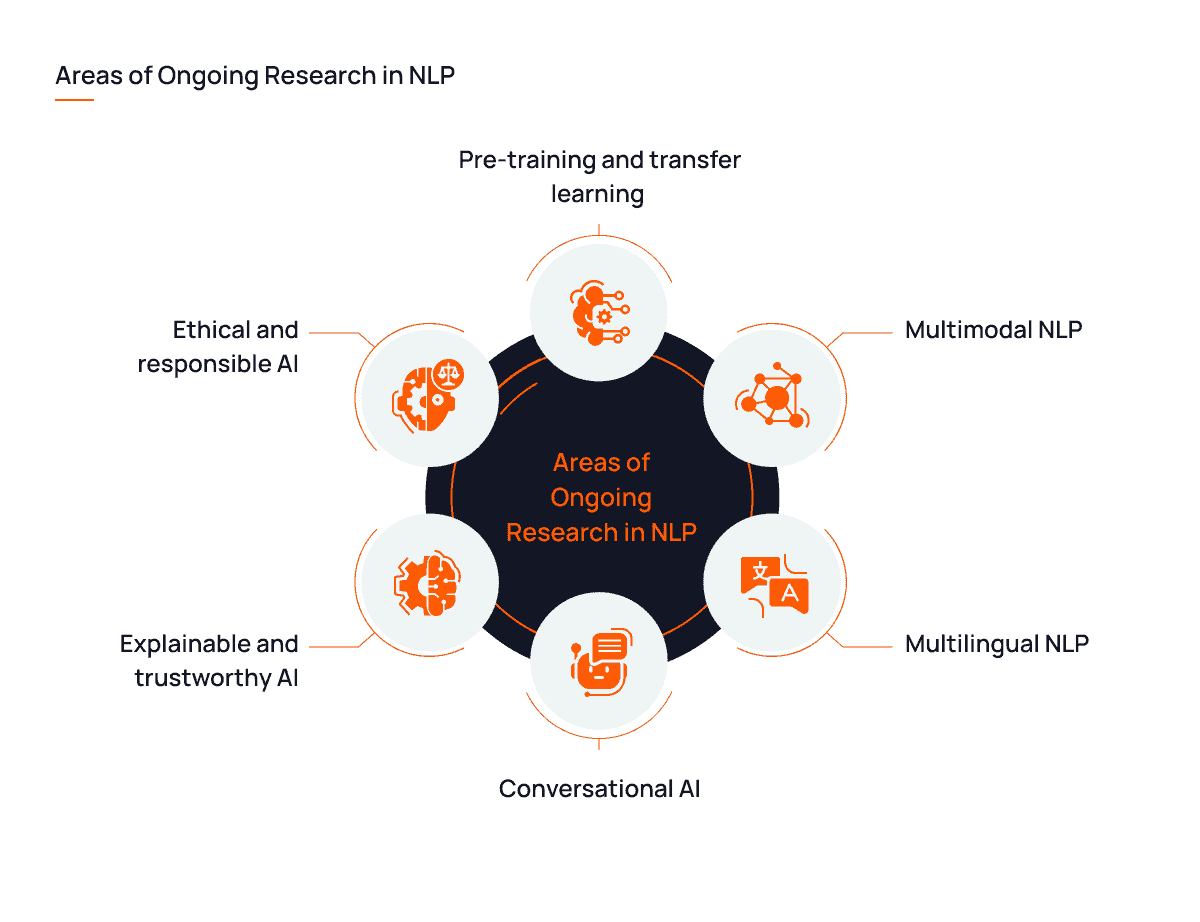

-

预训练和迁移学习:像 GPT-3 或 T5 这样的预训练模型是当今 NLP 领域最重要的进展之一。这一趋势肯定会持续,因为它不仅能带来高效的结果,还提供了迁移学习的机会,可以将从一个任务中学到的知识应用到其他任务和领域中。

-

多模态 NLP:NLP 终于超越了文本,研究人员尝试其在语音、视频和图像中的能力。多模态性在各个领域中找到了应用,从视频字幕生成到自动驾驶汽车,再到更准确的情感分析。

-

对话式 AI:NLP 的多模态性还体现在对话式 AI 的进步上,该技术旨在使人机互动更加自然和直观。智能家居的语音助手现在可能是研究人员最感兴趣的领域。

-

多语言 NLP:多语言和跨语言 NLP 引起了研究人员的兴趣,因为它能够提升全球沟通、增加信息获取和文化多样性。

-

可解释和可信赖的 AI:对可解释和可信赖的 AI 的需求涉及到在 NLP 中增强用户信任、问责和责任感。这在医疗、教育和法律等敏感领域尤为重要。

-

伦理和负责任的 AI:研究人员还旨在解决 NLP 中的偏见、公*性和伦理问题,以创造更负责任的 AI 应用。一个很好的例子是深度伪造检测,用于识别和标记 AI 操控的视频和音频信息。

NLP 领域的持续研究

总结

NLP 的概念彻底改变了人机交互,重塑了信息获取和沟通的方式。通过将 AI 与深度学习相结合,计算机获得了阅读文本、解读语音、分析对话、判断情感等能力,证明了 NLP 在从数据中提取有价值见解方面的力量。

我们现在看到 NLP 的无限可能性,从聊天机器人和虚拟助手到情感分析和语言翻译。这些已经改变了许多行业,提高了用户体验。但 NLP 的持续研究和发展预示着更加光明的未来,标志着更多的进步和趋势。这有可能使沟通变得比以往更加无缝和包容。

Olena Zherebetska** 是 Intelliarts 的内容作者,撰写关于数据科学和机器学习的最新新闻和创新。她拥有 7 年的写作经验,喜欢在研究技术主题时深入探讨。

主题更多内容

自然语言处理如何改变数据分析

原文:

www.kdnuggets.com/2020/08/natural-language-processing-changing-data-analytics.html

评论

作者:Malcom Ridgers,BairesDev

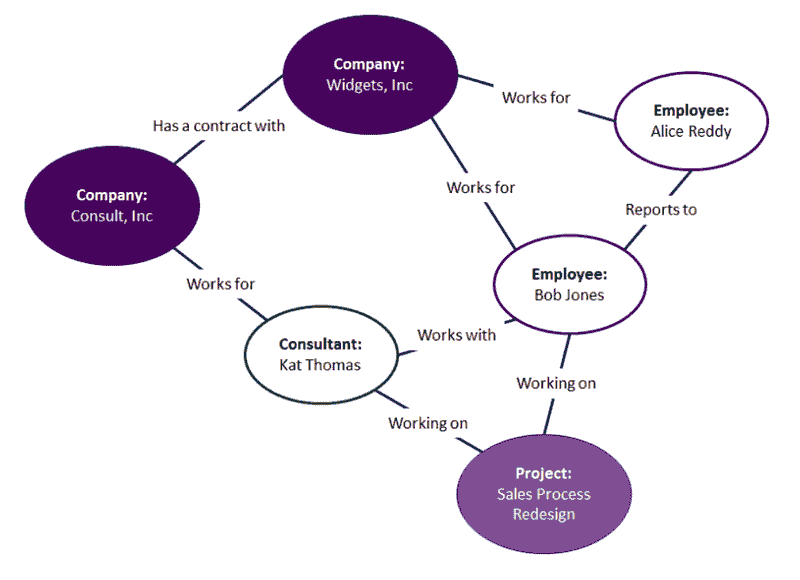

来源:2017 年值得关注的前 5 大语义技术趋势(ontotext)。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持您组织的 IT 需求

自然语言处理(NLP)是计算机理解和处理自然人类语言的过程。如果你使用 Google 搜索、Alex、Siri 或 Google 助手,你已经见证了它的应用。NLP 的优势在于它允许用户在不必将查询内容转换成“计算机语言”的情况下进行提问。

NLP 有潜力使商业和消费者应用程序更易于使用。软件开发者已经在更多应用程序中融入了它,包括机器翻译、语音识别、情感分析、聊天机器人、市场情报、文本分类和拼写检查。

这一技术在数据分析中尤其有用,数据分析帮助商业领袖、研究人员和其他人获得洞察,从而做出有效的决策。正如我们下面将看到的,NLP 可以通过多种方式支持数据分析工作,例如解决重大全球问题,并帮助更多人,甚至那些没有数据处理训练的人,使用这些系统。

管理大数据

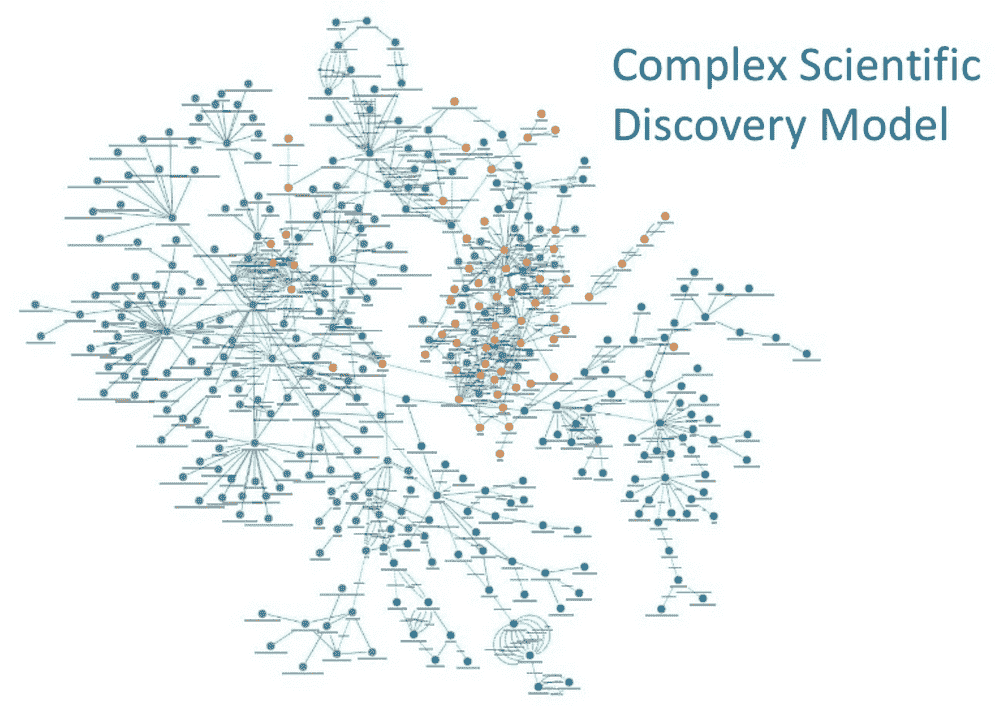

借助 NLP,用户可以分析比以往更多的数据,包括关键过程如医学研究。这项技术现在尤其重要,因为研究人员试图找到 COVID-19 的疫苗。

在一篇最*的文章中,世界经济论坛(WEF)指出,NLP 可以帮助研究人员应对 COVID-19,通过处理大量人类无法分析的数据。“机器可以查找、评估和总结数以万计的新冠病毒研究论文,每周都有成千上万的论文新增……。”此外,这项技术还可以通过检测新爆发来帮助追踪病毒传播。

根据 WEF 的文章,NLP 可以在数据分析师 “[训练] 机器分析完整句子的用户问题,然后阅读数据库中的数万篇学术文章,对其进行排名,并生成答案片段和摘要。”例如,研究人员可能会使用问题:“COVID-19 是季节性的吗?”系统会审核数据并返回相关响应。

解决问题

除了紧迫的健康问题外,NLP 与人工智能(AI)结合使用,可以帮助专业人士解决其他全球挑战,如清洁能源、全球饥饿、改善教育和自然灾害。例如,根据 福布斯 上的 Council Post,“像谷歌这样的巨大公司正致力于洪水预防,利用 AI 预测风险区域并通知受影响区域的人员。”

使更多专业人士能够发挥作用

根据 InformationWeek 的一篇文章,“有了自然语言搜索功能,用户不必了解 SQL 或布尔搜索,因此搜索操作变得更容易。”由于洞察的质量取决于知道如何“提出正确的问题”,这种技能可能很快成为商业运营商、经理和行政人员的必备技能。

例如,公司内的任何人都可以使用 NLP 查询 BI 系统,提问如:“与去年相比,本财年的库存周转率是多少?”系统会将每个短语转换为数字信息,搜索所需的数据,并以自然语言格式返回结果。这种查询使得任何部门的员工都能够获得关键洞察,帮助他们做出明智的决策。

创建数据驱动的文化

过去,依赖数据分析的商业智能(BI)需要经过培训的数据专业人员来正确输入查询并理解结果。但自然语言处理(NLP)正在改变这种动态,导致一些专家称之为“数据民主化”:使更多人能够访问以前仅限于具有高级技能的人员的数据集。

公司内掌握如何基于数据获取洞察的人越多,该公司就能从数据驱动的文化中受益越多,这种文化依赖于确凿的证据而非猜测、观察或理论来做决策。这种文化可以在任何行业中培养,包括医疗保健、制造业、金融、零售或物流。

例如,一位零售市场经理可能希望确定每次购买消费最多的客户的 demographics,并针对这些客户提供特别优惠或忠诚奖励。一位制造业班组长可能希望在其操作中测试不同的方法,以确定哪种方法能提供最大的效率。通过 NLP,获取这些信息所需的命令可以由业务中的任何人执行。

总结

NLP 尚未普及。根据 InformationWeek 的文章,“一些 BI 和分析供应商提供 NLP 功能,但目前它们仍属少数。更多供应商可能很快会进入市场以保持竞争力。”

随着自然语言处理的普及,人类将能够以之前无法实现的方式与计算机互动。这种新的合作模式将允许在各种人类活动中,包括商业、慈善、健康和沟通方面,取得进展。

随着计算机学习识别上下文甚至非语言的人类线索如肢体语言和面部表情,这些进展将变得更加有用。换句话说,与计算机的对话可能会变得越来越像人类对话。

马尔科姆·瑞德杰斯是一位技术专家,专注于软件外包行业。他获取最新市场新闻,并对创新及技术业务的未来有敏锐的洞察力。

相关:

-

5 本极好的自然语言处理书籍

-

数据分析中的 5 大趋势

-

数据科学家自然语言处理入门指南及 7 种常用技术

更多相关信息

自然语言处理关键术语,解释如下

原文:

www.kdnuggets.com/2017/02/natural-language-processing-key-terms-explained.html

照片由 Towfiqu barbhuiya 提供,来自 Unsplash

在计算语言学和人工智能的交汇处,我们找到了自然语言处理。广义上,自然语言处理(NLP)是一个研究人类语言以及说这些语言的人如何与技术互动的学科。NLP 是一个跨学科的话题,历史上一直是人工智能研究人员和语言学家*等的领域;显然,那些从语言学方面接*这个学科的人必须了解技术,而那些从技术领域进入这个学科的人需要学习语言学概念。

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 需求

本文旨在为第二组术语提供入门级的介绍,我们将以不含废话的方式来定义一些关键的 NLP 术语。虽然阅读完本文后你不会成为语言学专家,但我们希望你能够更好地理解一些 NLP 相关的讨论,并对如何进一步学习这些话题获得一些视角。

下面是 18 个精选的自然语言处理术语,简明定义。

1. 自然语言处理(NLP)

自然语言处理(NLP)关注自然人类语言与计算设备之间的互动。NLP 是计算语言学的一个主要方面,也涉及计算机科学和人工智能的领域。

2. 分词

分词,通常是 NLP 过程中的早期步骤,这一步骤将较长的文本字符串拆分成更小的部分或标记。较大的文本块可以被分词成句子,句子可以被分词成单词,等等。文本在适当分词后,通常会进行进一步处理。

3. 标准化

在进一步处理之前,文本需要规范化。规范化通常指一系列相关任务,旨在使所有文本处于相同的水*:将所有文本转换为相同的大小写(大写或小写),删除标点符号,扩展缩写,将数字转换为其单词等。规范化使所有单词处于*等基础上,并允许处理过程均匀进行。

4. 词干提取

词干提取是去除单词中词缀(后缀、前缀、插入词缀、环绕词缀)的过程,以获取单词词干。

running → run

5. 词形还原

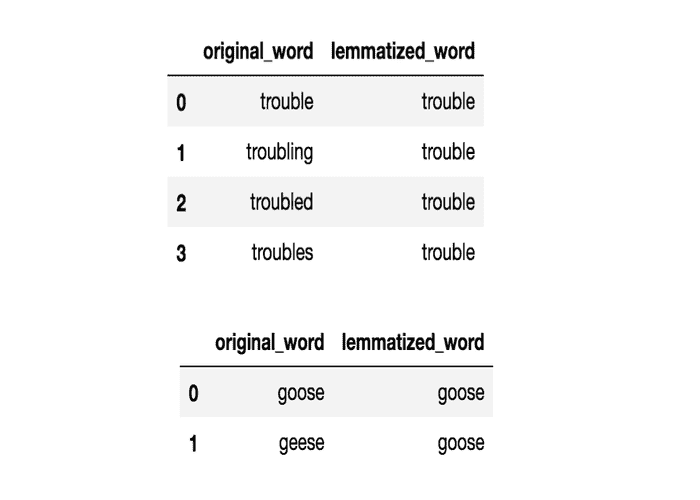

词形还原与词干提取相关,但不同之处在于词形还原能够基于单词的词元捕捉规范形式。

例如,将单词“better”进行词干提取会失败,无法返回其引文形式(词元的另一种说法);然而,词形还原则会得到如下结果:

better → good

应该很容易理解,为什么实现词干提取器的难度会比实现词形还原要小。

6. 语料库

在语言学和自然语言处理(NLP)中,语料库(字面上是拉丁语中的身体)指的是文本集合。这些集合可以由单一语言的文本组成,也可以跨越多种语言——多语言语料库(语料库的复数形式)可能有多种用途。语料库也可以由主题文本(历史的、圣经的等)组成。语料库通常仅用于统计语言分析和假设检验。

7. 停用词

停用词是那些在进一步处理文本之前被过滤掉的单词,因为这些单词对整体意义贡献很小,通常它们是语言中最常见的单词。例如,“the”、“and”和“a”虽然在特定段落中都是必需的单词,但通常对理解内容的贡献不大。作为一个简单的例子,如果去掉停用词,以下全字母句依然容易辨识:

The 快速的棕色狐狸跳过了the 懒狗。

8. 词性标注(POS)

词性标注包括为句子的分词部分分配类别标签。最常见的词性标注是识别单词作为名词、动词、形容词等。

9. 统计语言建模

统计语言建模是构建统计语言模型的过程,旨在提供自然语言的估计。对于一系列输入单词,模型会为整个序列分配一个概率,这有助于估计各种可能序列的可能性。这对于生成文本的 NLP 应用特别有用。

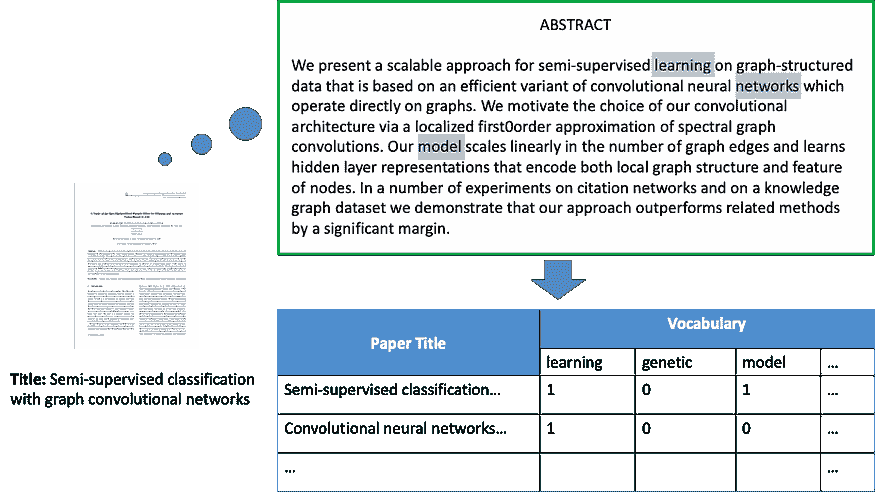

10. 词袋模型

词袋模型是一种特定的表示模型,用于简化文本选择的内容。词袋模型省略了语法和词序,但关注于文本中词的出现次数。文本选择的最终表示为词袋 (bag 指的是多重集的集合论概念,与简单集合不同)。

词袋表示的实际存储机制可以有所不同,但以下是使用字典的简单示例以便直观理解。示例文本:

“哦,好,好,”约翰说。

“那里,那里,”詹姆斯说。“那里,那里。”

生成的词袋表示为字典:

{

'well': 3,

'said': 2,

'john': 1,

'there': 4,

'james': 1

}

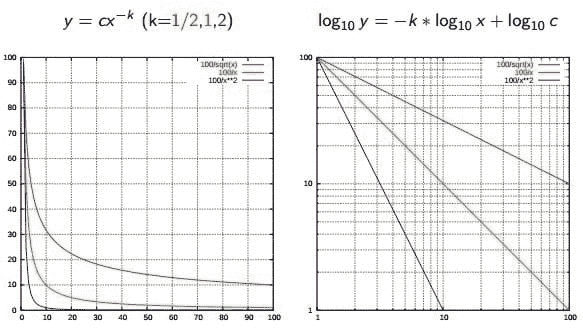

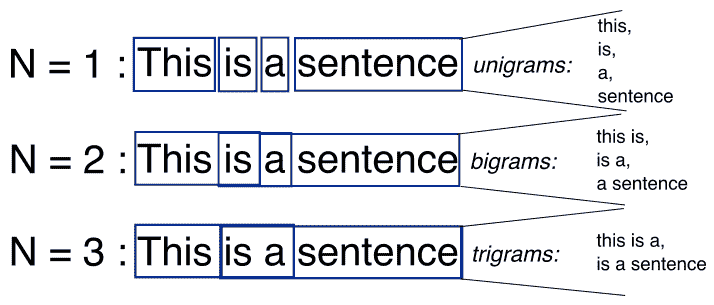

11. n-grams

n-grams 是另一种用于简化文本选择内容的表示模型。与无序的词袋模型不同,n-grams 模型关注于保留文本选择中的连续 N 项序列。

上述示例的第二句话(“那里,那里,”詹姆斯说。“那里,那里。”)的三元组(3-gram)模型示例如下所示:

[

"there there said",

"there said james",

"said james there",

"james there there",

]

12. 正则表达式

正则表达式,通常缩写为 regexp 或 regex,是一种简洁描述文本模式的可靠方法。正则表达式本身表示为一个特殊的文本字符串,用于在文本选择上开发搜索模式。正则表达式可以看作是扩展的规则集合,超出了 ? 和 ***** 的通配符字符。尽管经常被认为学习起来令人沮丧,正则表达式却是非常强大的文本搜索工具。

13. Zipf 定律

Zipf 定律用于描述文档集合中词频之间的关系。如果按频率排序文档集合中的词,并且用 y 描述第 x 个词出现的次数,Zipf 的观察可以简洁地表示为 y = cx^(-1/2)(项频率与项排名成反比)。更一般地,维基百科说:

Zipf 定律表明,给定一些自然语言的语料库,任何词的频率与其在频率表中的排名成反比。因此,最频繁的词出现的频率大约是第二频繁词的两倍,第三频繁词的三倍,等等。

来源:维基百科

14. 相似性度量

有许多相似性度量可以应用于 NLP。我们在测量什么的相似性?通常是字符串。

-

莱文斯坦 - 使一对字符串相等所需删除、插入或替换的字符数

-

贾卡德 - 2 个集合之间重叠的度量;在 NLP 的情况下,通常文档是词的集合

-

史密斯-沃特曼 - 类似于 Levenshtein,但对替换、插入和删除分配了成本。

15. 语法分析

也被称为语法分析,语法分析的任务是将字符串视为符号,并确保它们符合既定的语法规则。这一步必须在任何进一步尝试从文本中提取洞见的分析之前进行——无论是语义分析、情感分析等——将其视为超越符号的东西。

16. 语义分析

也称为意义生成,语义分析关注于确定文本选择的含义(无论是字符还是词序列)。在读取和解析(语法分析)输入的文本选择后,可以对该文本选择进行意义解释。简单来说,语法分析关注的是文本选择由哪些词组成,而语义分析想知道这些词集合实际意味着什么。语义分析的主题既广泛又深奥,研究人员可以使用各种工具和技术。

17. 情感分析

情感分析是评估和确定文本选择中捕捉到的情感的过程,其中情感定义为感觉或情绪。这种情感可以是简单的积极(快乐)、消极(悲伤或愤怒)或中立,或者可以是沿着某个尺度的更精确的测量,其中中立在中间,积极和消极在两个方向上递增。

18. 信息检索

信息检索是基于特定查询,从文本中访问和检索最相关信息的过程,使用基于上下文的索引或元数据。最著名的信息检索实例之一是 Google 搜索。

Matthew Mayo (@mattmayo13) 是一名数据科学家和 KDnuggets 的主编,这是一个开创性的在线数据科学和机器学习资源。他的兴趣包括自然语言处理、算法设计与优化、无监督学习、神经网络以及机器学习的自动化方法。Matthew 拥有计算机科学硕士学位和数据挖掘研究生文凭。你可以通过 editor1 at kdnuggets[dot]com 联系他。

了解更多相关内容

Apache Spark 的自然语言处理库 – 免费使用

原文:

www.kdnuggets.com/2017/11/natural-language-processing-library-apache-spark.html

评论

评论

由 David Talby,Usermind 首席技术官。

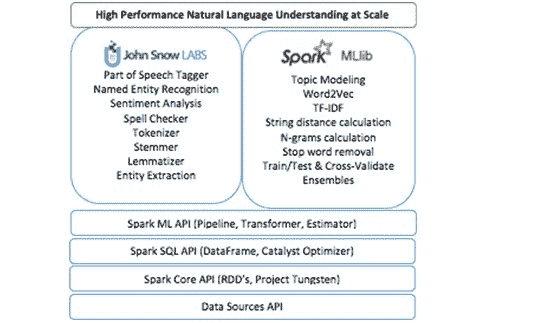

Apache Spark 是一个通用集群计算框架,原生支持分布式 SQL、流处理、图处理和机器学习。现在,Spark 生态系统还拥有一个 Spark 自然语言处理库。

John Snow Labs NLP 库遵循 Apache 2.0 许可,使用 Scala 编写,不依赖其他 NLP 或 ML 库。它本地扩展了 Spark ML Pipeline API。你将受益于:

-

无与伦比的运行时性能,因为处理直接在 Spark DataFrames 上完成,无需任何复制,并充分利用 Spark 的缓存、执行计划和优化的二进制数据格式。

-

无摩擦地重用现有的 Spark 库,包括分布式主题建模、词嵌入、n-gram 计算、字符串距离计算等。

-

通过在数据科学管道的自然语言理解、机器学习和深度学习部分使用统一的 API 提高生产力。

“通过 John Snow Labs NLP,我们兑现了使客户能够利用最新开源技术和数据科学中的学术突破的承诺,所有这些都在高性能的企业级代码库中。”,创始团队表示。此外,“John Snow Labs NLP 包含了一系列高效的自然语言理解工具,用于文本挖掘、问答、聊天机器人、事实提取、主题建模或搜索,运行规模和性能在现有技术中尚未出现。”

框架提供了标注器的概念,并且开箱即用:

-

分词器

-

归一化器

-

词干提取器

-

词形还原器

-

实体提取器

-

日期提取器

-

词性标注器

-

命名实体识别

-

句子边界检测

-

情感分析

-

拼写检查器

此外,考虑到与 Spark ML 的紧密集成,在构建 NLP 管道时你可以立即使用更多功能。这包括词嵌入、主题建模、停用词移除、各种特征工程函数(tf-idf、n-grams、相似度度量等)以及将 NLP 注释作为机器学习工作流中的特征。如果你不熟悉这些术语,这个 理解 NLP 任务的指南 是一个好的起点。

我们的虚拟团队已经在构建严重依赖自然语言理解的商业软件多年。因此,我们对 spaCy、 CoreNLP、 OpenNLP、 Mallet、 GATE、 Weka、 UIMA、 nltk、 gensim、 Negex、 word2vec、 GloVe 和一些其他工具有实际的经验。

我们是这些库的大粉丝,我们模仿它们的许多地方旨在表达我们诚挚的赞美之情。然而,当我们需要交付可扩展、高性能、高准确度的实际生产软件时,我们也多次撞上了它们的限制。

性能

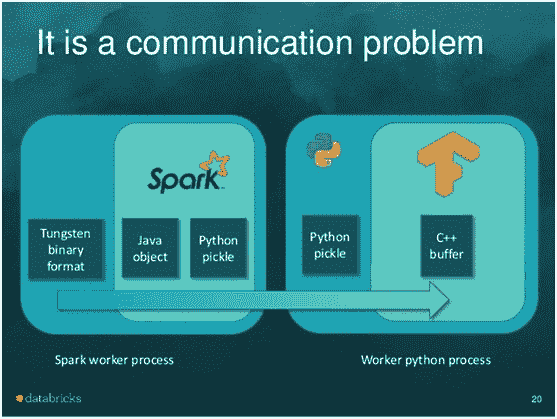

我们解决的三个顶级需求中的第一个是运行时性能。你会认为随着 spaCy 及其公共基准 的出现,这个问题已经基本解决,它们反映了一个经过深思熟虑和精心实现的权衡集合。然而,在其基础上构建 Spark 应用程序时,你仍会遇到不合理的低吞吐量。

要理解原因,可以考虑 NLP 管道总是数据处理管道的一部分:例如,问题回答涉及加载训练数据、转换数据、应用 NLP 注释器、构建特征、训练价值提取模型、评估结果(训练/测试拆分或交叉验证)和超参数估计。

将数据处理框架(Spark)与 NLP 框架分开意味着你大部分的处理时间都会花在序列化和复制字符串上。

一个很好的类比是 TensorFrames——它显著提高了在 Spark 数据框上运行 TensorFlow 工作流的性能。此图像归功于 Tim Hunter 的优秀 TensorFrames 概述:

Spark 和 TensorFlow 都在性能和规模上进行了极致优化。然而,由于 DataFrames 存在于 JVM 中,而 TensorFlow 运行在 Python 进程中,因此两个框架之间的任何集成都意味着每个对象都必须序列化,经过双向的进程间通信 (!) 并在内存中至少复制两次。TensorFrames 的公开基准报告显示,仅通过在 JVM 进程中复制数据就能获得 4 倍的加速(使用 GPU 时效果更显著)。

当将 spaCy 与 Spark 一起使用时,我们遇到相同的问题:Spark 在加载和转换数据方面高度优化,但运行 NLP 管道需要将所有数据从 Tungsten 优化格式外部复制,序列化,推送到 Python 进程中,运行 NLP 管道(这一部分非常快速),然后将结果重新序列化回 JVM 进程。这自然会消耗你从 Spark 的缓存或执行计划中获得的任何性能收益,需要至少两倍的内存,并且在扩展时没有改善。使用 CoreNLP 消除了复制到另一个进程的需求,但仍然需要将所有文本从数据框中复制并将结果重新复制回来。

所以我们首先的任务是直接对优化后的数据框进行分析,就像 Spark ML 已经做的那样(来源:Databricks 的 ML Pipelines 介绍文章):

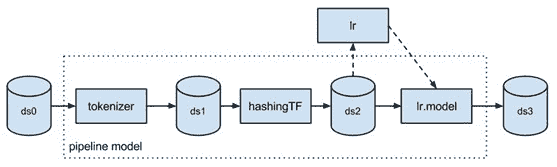

生态系统

我们的第二个核心要求是无摩擦地重用现有的 Spark 库。其中一部分是我们自己的痛点——为什么所有的 NLP 库都必须构建自己的主题建模和词嵌入实现?另一部分是务实的——我们是一个小团队,时间紧迫,需要充分利用现有资源。

当我们开始考虑一个 Spark NLP 库时,我们首先询问了 Databricks,指引我们找出已经在构建这个库的人。当得到的回答是没有这样一个库时,我们的下一个要求是帮助我们确保这个库的设计和 API 完全符合 Spark ML 的 API 指南。这次合作的结果是这个库无缝扩展了 Spark ML,例如你可以构建这种管道:

val pipeline = new mllib.Pipeline().setStages(

Array(docAssembler,tokenizer,stemmer,stopWordRemover,hasher,idf,dtree,labelDeIndex))

在这段代码中,文档汇编器、分词器和词干提取器来自 Spark NLP 库——com.jsl.nlp.* 包。TF 哈希器、IDF 和 labelDeIndex 都来自 MLlib 的 org.apache.spark.ml.feature.* 包。dtree 阶段是 spark.ml.classification.DecisionTreeClassifier。

所有这些阶段都在一个管道内运行,该管道是可配置的、可序列化的和可测试的,并且以完全相同的方式进行。它们还在数据框上运行,而无需复制数据(与 spark-corenlp 不同),享受 Spark 的标志性内存优化、并行性和分布式扩展。

这意味着 John Snow Labs NLP 库附带了完全分布式、经过严格测试和优化的 主题建模、词嵌入、n-gram 生成和余弦相似度功能。我们不需要自己构建这些功能——它们是与 Spark 一起提供的。

最重要的是,这意味着你的 NLP 和 ML 管道现在是统一的。上述代码示例是典型的,因为它不仅仅是一个 NLP 管道——NLP 用于生成特征,然后用这些特征训练决策树。这在问答任务中很常见。一个更复杂的例子还会应用命名实体识别,按 POS 标签和共指解析过滤;训练随机森林,考虑 NLP 基于的特征和其他来源的结构化特征;并使用网格搜索进行超参数优化。能够使用统一的 API 在需要测试、重现、序列化或发布这样的管道时非常有利——甚至超出了性能和重用的好处。

企业级

我们的第三个核心要求是提供一个任务关键型、企业级的 NLP 库。我们的工作是构建生产软件。许多当前最受欢迎的 NLP 包具有学术背景——这在设计权衡中表现出来,例如优先考虑原型设计的简便性而非运行时性能,选项的广度而非简单的简约 API,以及对可扩展性、错误处理、节省内存和代码重用的轻视。

John Snow Labs NLP 库是用 Scala 编写的。它包括用于 Spark 的 Scala 和 Python API。它不依赖于任何其他 NLP 或 ML 库。对于每种类型的注释器,我们会进行学术文献综述以找出最先进的技术,进行团队讨论并决定要实现哪些算法。实现根据三个标准进行评估:

-

准确性 – 如果框架有低于标准的算法或模型,那么再好的框架也没有意义。

-

性能 – 运行时应该与任何公共基准相当或更好。没有人应该因为注释器的速度不够快以处理流式用例,或在集群设置中扩展性不好而牺牲准确性。

-

可训练性或可配置性 – NLP 是一个固有的领域特定问题。社交媒体帖子、学术论文、SEC 文件、电子病历和报纸文章使用了不同的语法和词汇。

该库已经在企业项目中使用,这意味着第一层次的错误、重构、意外瓶颈和序列化问题已得到解决。单元测试覆盖率和 参考文档 已经达到让我们放心将代码开源的水*。

John Snow Labs 是领导和资助 Spark NLP 库开发的公司。该公司为该库提供商业支持、赔偿和咨询服务。这为库提供了长期的财务支持、资助的活跃开发团队以及不断增长的现实世界项目流,推动了库的稳定性和路线图优先级。

参与方式

如果你需要 NLP 用于当前项目,请访问 John Snow Labs NLP for Apache Spark 主页 或快速入门指南进行尝试。提供预构建的 maven central (Scala) 和 pip 安装 (Python) 版本。通过 nlp@johnsnowlabs.com 或 Twitter、LinkedIn 或 Facebook 发送问题或反馈。

告诉我们 你下一步需要什么功能。

以下是我们收到的一些请求,我们期待更多反馈以设计和优先考虑:

-

提供一个 SparkR 客户端

-

提供“无 Spark”版本的 Java 和 Scala

-

添加最先进的共指消解标注器

-

添加最先进的极性检测标注器

-

添加最先进的时间推理标注器

-

发布适用于常见用例的示例应用程序,如问答、文本摘要或信息检索

-

为新领域或语言训练和发布模型

-

发布可重复、同行评审的准确性和性能基准

如果你想扩展或贡献于该库,可以从克隆 John Snow Labs NLP for Spark GitHub 仓库开始。我们使用拉取请求和 GitHub 的问题跟踪器来管理代码更改、错误和功能。该库仍处于初期阶段,我们非常欢迎各种形式的贡献和反馈。

简历: David Talby 是 Usermind 的首席技术顾问,专注于在医疗保健领域应用大数据和数据科学。

相关

我们的前三名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 支持

3. Google IT 支持专业证书 - 支持你的组织进行 IT 支持

相关话题

自然语言处理管道,详细解释

原文:

www.kdnuggets.com/2021/03/natural-language-processing-pipelines-explained.html

评论

由 Ram Tavva,高级数据科学家,ExcelR Solutions 董事

介绍

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

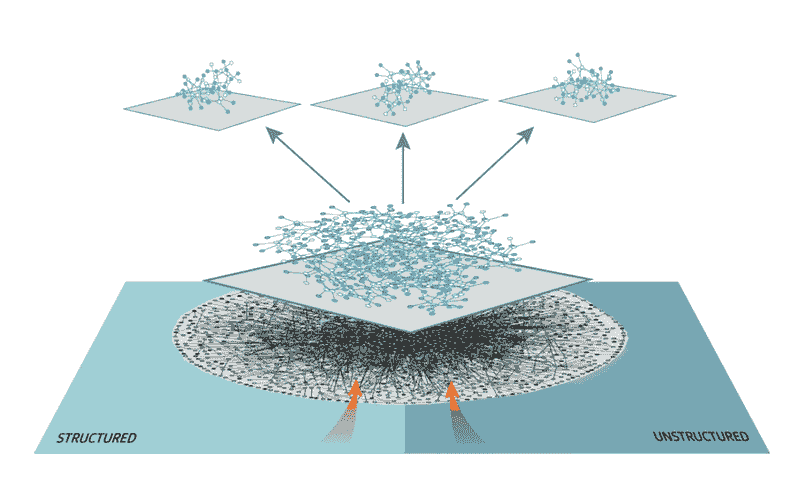

计算机最擅长处理结构化数据集,如电子表格和数据库表格。但我们人类几乎不会以这种方式进行沟通,我们的大多数沟通都是以未结构化的格式——句子、单词、语音等,这些对计算机来说是无关的。

这很不幸,数据库中存在大量未结构化的数据。但你是否曾考虑过计算机如何处理这些未结构化数据?

是的,虽然有许多解决方案,但 NLP 始终是改变游戏规则的技术。

让我们详细了解 NLP…

什么是 NLP?

NLP 代表自然语言处理,它自动操作自然语言,例如应用程序和软件中的语音和文本。

语音可以是算法接收的任何文本,算法测量准确性,运行自我和半监督模型,然后在输入数据后以语音或文本的形式给我们期望的输出。

NLP 是最受欢迎的技术之一,它使人与计算机之间的沟通变得更加容易。如果你使用 Windows 系统,可以使用微软 Cortana;如果你使用 macOS 系统,Siri 就是你的虚拟助手。

最棒的是,即使是搜索引擎也配备了虚拟助手。例如:谷歌搜索引擎。

使用 NLP,你可以输入任何你想搜索的内容,或者点击麦克风选项说出来,你就能获得想要的结果。看看 NLP 如何使人与计算机之间的沟通变得更容易。当你看到这一点时,难道不是很惊奇吗?

无论你是想了解天气情况还是互联网的最新消息,或是周末目的地的路线,NLP 都能满足你的所有需求。

自然语言处理管道(NLP 管道)

当你在文本或语音上调用 NLP 时,它将整个数据转换成字符串,然后主字符串经过多个步骤(称为处理管道的过程)。它使用训练好的管道来监督你的输入数据,并根据语音语调或句子长度重构整个字符串。

对于每个管道,组件返回到主字符串,然后传递给下一个组件。功能和效率依赖于组件、它们的模型和训练。

NLP 如何使人与计算机之间的沟通变得简单

NLP 使用语言处理管道来读取、解码和理解人类语言。这些管道由六个主要过程组成。这些过程将整个语音或文本拆分成小块,重构、分析并处理,以从搜索引擎结果页面中获取最相关的数据。

这是帮助计算机理解人类语言的 6 个 NLP 管道内部步骤

句子分割

当你有段落需要处理时,最佳的方式是逐句进行。这降低了复杂性,简化了过程,甚至能获得最准确的结果。计算机不会像人类那样理解语言,但如果你以正确的方式对待它们,它们总能做很多事情。

例如,考虑上面的段落。然后,你的下一步是将段落拆分成单个句子。

-

当你有段落需要处理时,最佳的方式是逐句进行。

-

这降低了复杂性,简化了过程,甚至能获得最准确的结果。

-

计算机不会像人类那样理解语言,但如果你以正确的方式对待它们,它们总能做很多事情。

# Import the nltk library for NLP processes

import nltk

# Variable that stores the whole paragraph

text = "..."

# Tokenize paragraph into sentences

sentences = nltk.sent_tokenize(text)

# Print out sentences

for sentence in sentences:

print(sentence)

当你有段落需要处理时,最佳的方式是逐句进行。

这降低了复杂性,简化了过程,甚至能获得最准确的结果。

计算机不会像人类那样理解语言,但如果你以正确的方式对待它们,它们总能做很多事情。

单词标记化

标记化是将短语、句子、段落或整个文档拆分成最小单元(如单独的单词或术语)的过程。每个小单元称为标记。

这些标记可以是单词、数字或标点符号。基于单词的边界——单词的结束点,或下一个单词的开始。这也是词干提取和词形还原的第一步。

这个过程至关重要,因为通过分析文本中的单词,词义容易被解释。

让我们来看一个例子:

那只狗是一只哈士奇犬。

当你标记化整个句子时,你得到的答案是[‘That’, ‘dog’, ‘is’, ‘a’, ‘husky’, ‘breed’]。

你可以用多种方式做到这一点,但我们可以使用这种标记化的形式来:

-

计算句子中的单词数。

-

你还可以测量重复单词的频率。

自然语言工具包(NLTK)是一个用于符号和统计 NLP 的 Python 库。

import nltk

sentence_data = "That dog is a husky breed. They are intelligent and independent."

nltk_tokens = nltk.sent_tokenize(sentence_data)

print (nltk_tokens)

输出:

[‘那只狗是哈士奇品种。’, ‘它们既聪明又独立。’]

每个标记的词性预测

在词性分析中,我们必须考虑每个标记。然后,尝试弄清楚不同的词性——标记是否属于名词、代词、动词、形容词等等。

所有这些都有助于了解我们在谈论哪个句子。

让我们快速了解一些词汇:

语料库: 单数形式的文本主体。其复数形式为 corpora。

词汇表: 词汇及其含义。

标记: 基于规则分割后的每个“实体”。

import nltk

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize, sent_tokenize

stop_words = set(stopwords.words('english'))

// Dummy text

txt = Everything is all about money.\

# sent_tokenize is one of the instances of

# PunktSentenceTokenizer from the nltk.tokenize.punkt module

tokenized = sent_tokenize(txt)

for i in tokenized:

# Word tokenizers is used to find the words

# and punctuation in a string

wordsList = nltk.word_tokenize(i)

# removing stop words from wordList

wordsList = [w for w in wordsList if not w in stop_words]

# Using a Tagger. Which is part-of-speech

# tagger or POS-tagger.

tagged = nltk.pos_tag(wordsList)

print(tagged)

输出:

[('一切', 'NN'), ('是', 'VBZ'), ('所有', 'DT'),('关于', 'IN'), ('钱', 'NN'), ('.', '.')]

文本词形还原

英语也是一种可以使用各种基本词形式的语言。当在计算机上工作时,它能够理解这些词用于相同概念,即使句子中存在多个具有相同基本词的词汇。这一过程就是我们在 NLP 中称之为词形还原。

这一步骤会进入词汇的根本层面,找出所有可用词汇的基本形式。它们有普通的规则来处理这些词汇,而大多数人对此并不知晓。

识别停用词

当你完成词形还原后,下一步是识别句子中的每个词。英语中有很多填充词,它们没有实际意义,但会削弱句子的效果。通常最好省略这些词,因为它们在句子中出现的频率较高。

大多数数据科学家在进行进一步分析之前会删除这些词汇。基本算法通过检查已知的停用词列表来识别停用词,因为没有标准的停用词规则。

一个有助于你更好地理解识别停用词的例子是:

# importing NLTK library stopwords

import nltk

from nltk.corpus import stopwords

nltk.download('stopwords')

nltk.download('punkt')

from nltk.tokenize import word_tokenize

## print(stopwords.words('english'))

# random sentence with lot of stop words

sample_text = "Oh man, this is pretty cool. We will do more such things."

text_tokens = word_tokenize(sample_text)

tokens_without_sw = [word for word in text_tokens if not word in stopwords.words('english')]

print(text_tokens)

print(tokens_without_sw)

输出:

带停用词的文本分词:

[‘哦’, ‘人’, ’,’ ‘这’, ‘是’, ‘挺’, ‘酷’, ‘.’, ‘我们’, ‘将’, ‘做’, ‘更多’, ‘这样的’, ’事情’, ‘.’]

不带停用词的文本分词:

[‘哦’, ‘人’, ’,’ ‘挺’, ‘酷’, ‘.’, ‘我们’, ’事情’, ‘.’]

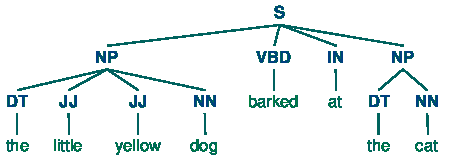

依存句法分析

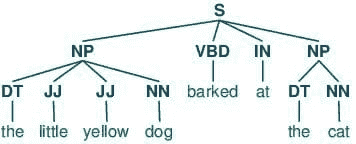

解析进一步分为三个主要类别。每一类都不同于其他类别。它们是词性标注、依存句法分析和构成短语。

词性标注(POS)主要用于分配不同的标签。这就是我们所说的 POS 标签。这些标签指示了句子中词汇的词性。而在依存短语的情况下:分析句子的语法结构。基于句子中词汇的依赖关系。

而在构成分析中:句子被拆分为子短语。这些子短语属于特定的类别,如名词短语(NP)和动词短语(VP)。

结论

在这个博客中,你简要了解了 NLP 流水线如何通过各种 NLP 过程帮助计算机理解人类语言。

从自然语言处理开始,语言处理流程是什么?自然语言处理如何使人类之间的沟通更轻松?以及 NLP 流程中的六个内幕。

自然语言处理流程涉及的六个步骤是 - 句子分割、词汇标记、每个标记的词性。文本词形还原、识别停用词和依赖解析。

简介: Ram Tavva 是 ExcelR Solutions 的高级数据科学家和总监。

相关:

-

每个数据科学家都应该知道的 6 种 NLP 技术

-

使用 NLP 改进你的简历

-

Hugging Face Transformers 包 – 这是什么以及如何使用它

相关主题

使用 Python 的自然语言处理:免费电子书

原文:

www.kdnuggets.com/2020/06/natural-language-processing-python-free-ebook.html

评论

说到自然语言处理领域,实际上涉及了很多相关的概念、技术和方法。词向量、依存解析、文本分类、正则表达式、语言模型、语音翻译;这些都可以归入 NLP 的范畴,尽管它们是非常不同的任务和技术。

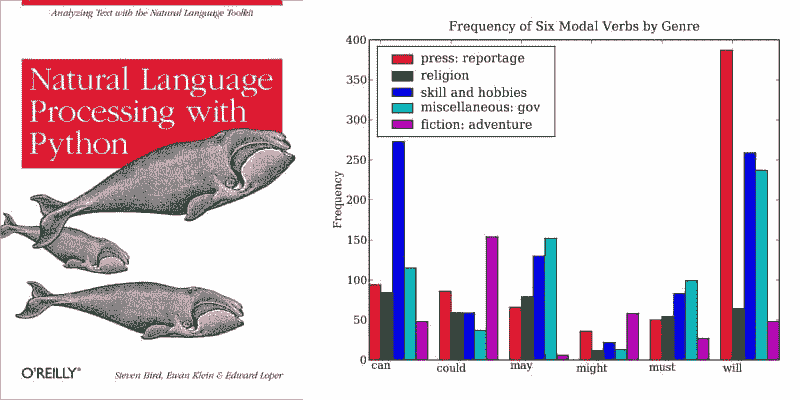

鉴于这一领域的广泛性和迅速发展,建立扎实的基础概念,并以实用的方式进行学习,应被视为高度重要。本周推荐的免费电子书,使用 Python 的自然语言处理,是帮助建立这种扎实基础的绝佳方式。

我们的前三名课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析水*

2. Google 数据分析专业证书 - 提升你的数据分析水*

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

自然语言工具包 (NLTK) 是一个通用的 NLP 库,虽然通常不被视为生产系统的选择,但非常适合用于教学和学习如何实现一些 NLP 的基本概念。这本配套书专门设计用于指导读者完成这一学习过程。

从书籍的前言:

本书提供了一个高度易于理解的自然语言处理领域介绍。它可以用于个人学习,也可以作为自然语言处理或计算语言学课程的教材,或作为人工智能、文本挖掘或语料库语言学课程的补充。书中内容非常实用,包含了数百个完整的例子和分级练习。

[...]

本书面向各种希望学习如何编写分析书面语言的程序的人群,无论其之前是否有编程经验。

如上所述,本书确实具有实用性质。尽管你在阅读过程中会遇到解释概念,但毫无疑问,这本书是为那些希望立即开始使用 Python 实施自然语言处理解决方案的人量身打造的,并且要做到现在。

值得注意的是,这版免费的在线书籍已经更新了 Python 3 的代码,因为原版书籍已*十年,使用的是 Python 2。同时,本书不提供 PDF 下载,而是以 HTML 格式在其网站上免费提供。

本书的章节如下:

-

语言处理与 Python

-

访问文本语料库和词汇资源

-

处理原始文本

-

编写结构化程序

-

词汇的分类和标记

-

学习文本分类

-

从文本中提取信息

-

分析句子结构

-

构建基于特征的语法

-

分析句子的含义

-

管理语言数据

-

后记:面对语言挑战

本书的前言还指出了这些具体的学习成果:

- 如何利用简单程序来操作和分析语言数据,以及如何编写这些程序

- 如何将 NLP 和语言学中的关键概念用于描述和分析语言

- 数据结构和算法如何在 NLP 中使用

- 语言数据如何以标准格式存储,以及如何利用这些数据来评估 NLP 技术的表现

样本块解析器输出可视化。来自《Python 自然语言处理》第七章。

本书开始时内容较慢——描述 NLP、如何使用 Python 执行一些 NLP 编程任务、如何访问自然语言内容进行处理——然后转向更大的概念,既包括概念上的(NLP),也包括编程上的(Python)。不久后,它将涉及分类、文本分类、信息提取以及其他更多被认为是经典 NLP 的话题。在掌握了这本书中的 NLP 基础后,你可以通过一些斯坦福大学的免费 课程继续学习更现代和前沿的技术。

祝所有踏入自然语言处理领域的朋友好运。这是一本很好的入门书籍,因其篇幅较短,可以相对快速地吸收,从而能够迅速进入更高级的主题。

相关:

-

深度学习与 fastai 和 PyTorch:免费电子书

-

Python 面向所有人:免费电子书

-

自动化机器学习:免费电子书

相关主题

自然语言处理配方:最佳实践和示例

原文:

www.kdnuggets.com/2020/05/natural-language-processing-recipes-best-practices-examples.html

评论

我们 KDnuggets 最*尽力突显一些优质的自然语言处理(NLP)资源,最显著的包括 The Big Bad NLP Database 和 The Super Duper NLP Repo,这是 Quantum Stat 管理的两个项目。其中第一个是围绕任务精心组织的 NLP 数据集的策划仓库,而第二个是演示这些任务实现的 Google Colab notebooks 集合。

在这种背景下,我们发现微软的Natural Language Processing Best Practices & Examples仓库是这一集合中另一个值得添加的资源。该仓库描述了其用处如下:

该仓库包含构建 NLP 系统的示例和最佳实践,以 Jupyter notebooks 和实用功能的形式提供。该仓库的重点是最先进的方法和在处理文本和语言问题的研究人员和从业者中流行的常见场景。

这些笔记本和它描述的实用功能更像是对 NLP 任务的指导,而非端到端解决方案,以确保你在实现系统时考虑到最佳实践。

这个仓库的目标是构建一整套全面的工具和示例,利用最*在 NLP 算法、神经网络架构和分布式机器学习系统方面的进展。[...] 我们希望这些工具能够显著缩短“上市时间”,通过从定义业务问题到解决方案开发的过程大幅简化体验。此外,示例笔记本将作为指导,并展示工具在各种语言中的最佳实践和使用方法。

强调Emily Bender的多语言原则,该仓库还阐明 NLP“并不等同于英语”,并确保项目的目标是“提供尽可能多语言的端到端示例”,鼓励社区贡献以促进实现。

该仓库包含一系列的Jupyter notebooks,这些笔记本实现了表格中额外描述的以下 NLP 场景。

而且这些指南并不是单一维度的;例如,文本分类笔记本中有几种不同的笔记本,使用了不同的数据集、自然语言、环境(本地或 Azure 云端)、语言模型和任务焦点的组合。

这些笔记本还依赖于utils_nlp模块中的脚本,以帮助减轻一些“从数据加载、数据集理解、模型开发、模型评估到将训练好的 NLP 模型投入生产”的繁琐任务。务必查看微软研究开发的这些工具,旨在节省时间并加速一些与自然语言处理相关的繁重任务。

我对几乎所有 NLP 的内容情有独钟,从学习资源到示例笔记本,再到框架和库、语言模型、数据集集合等等。如果你也是如此,我建议你查看微软的这个最佳实践导向的仓库。

相关内容:

-

超级 NLP 仓库:100 个即用的 Colab 笔记本

-

大型 NLP 数据库:访问* 300 个数据集

-

使用 TensorFlow 和 Keras 进行分词和文本数据准备

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

1. 谷歌网络安全证书 - 快速进入网络安全职业轨道。

2. 谷歌数据分析专业证书 - 提升你的数据分析水*

2. 谷歌数据分析专业证书 - 提升你的数据分析水*

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作

更多相关话题

使用 spaCy 进行自然语言处理

原文:

www.kdnuggets.com/2023/01/natural-language-processing-spacy.html

图片由编辑提供

数据科学是许多子领域的总称;自然语言处理(NLP)是最著名和最重要的领域之一。自然语言处理是使计算机能够理解人类自然语言的领域。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

3. Google IT 支持专业证书 - 支持你的组织的 IT 需求

NLP 是一个非常有价值的领域,它连接了人类和计算机,并使我们能够利用技术改善生活。由于 NLP 的普及,你可以通过多种方式来构建 NLP 项目。其中一种方式是使用 Python 和 spaCy 库。

spaCy 是一个用于高级 NLP 的开源库,用 Python 和 Cython 编写。spaCy 使你能够轻松构建现实世界中的 NLP 应用程序。如果你是 NLP 的新手,这篇 Analytics Vidhya 上的优秀文章以非常直接的方式讲解了 NLP 的基础知识。他们还提供了一个很棒的指南,帮助你在 NLP 领域中找到方向。

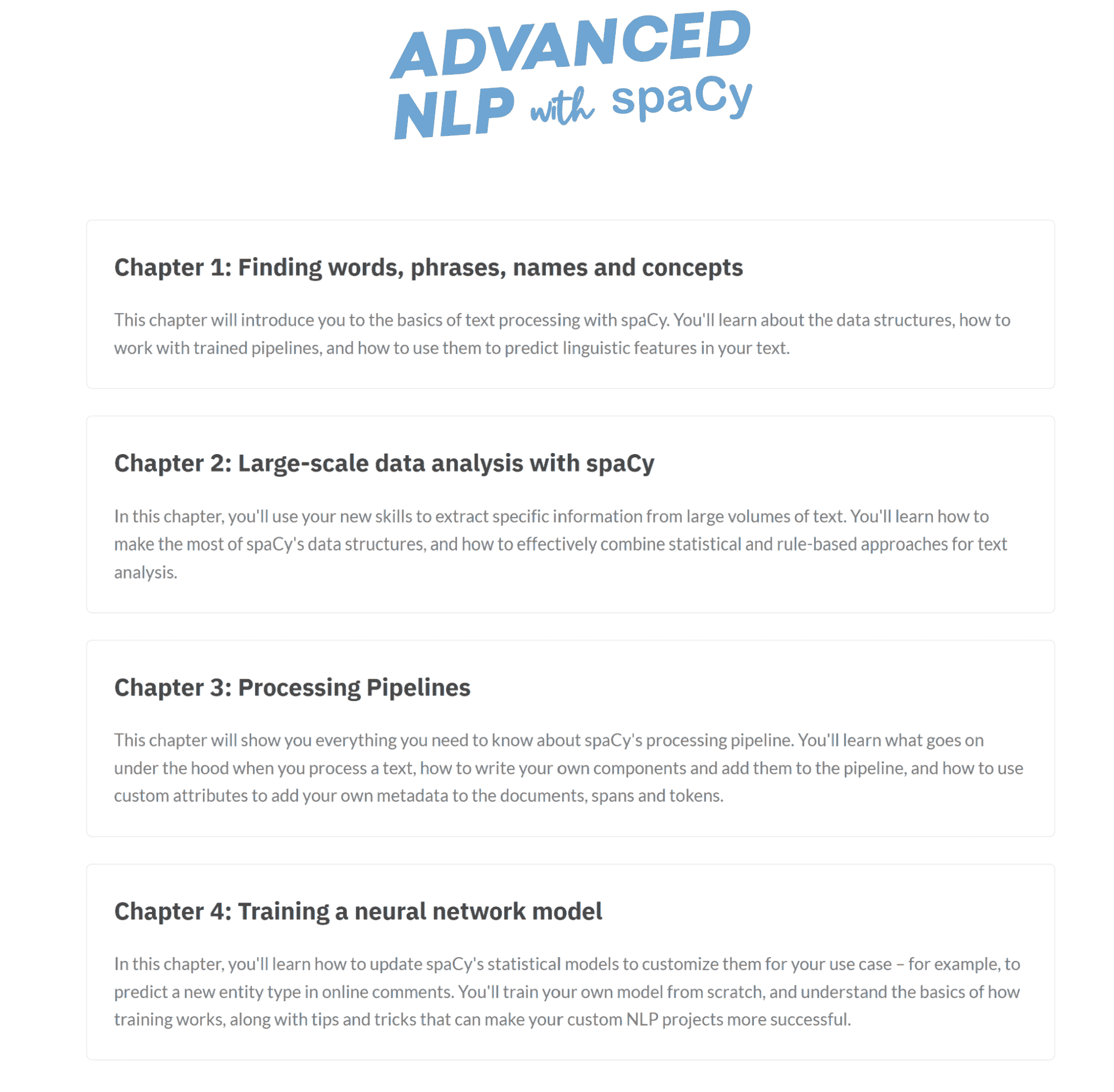

一旦掌握了基础知识,你可以使用 spaCy 创建高级 NLP 应用程序。每当我遇到新的软件包库时,我都会先访问官方网站获取材料,然后再扩展到其他资源。spaCy 的官方网站提供了一门简短且实用的4 章课程,帮助你从入门到精通使用这个包。

图片来源:course.spacy

这门课程是开始学习 spaCy 和自然语言处理(NLP)的绝佳方式。另一个很棒的资源是由freeCodeCamp提供的 3 小时课程,它将带你了解 NLP 和 spaCy 的基础知识。课程涵盖了不同的主题:

-

如何安装 spaCy。

-

spaCy 容器。

-

语言学注释。

-

词向量。

-

正则表达式(基础和多词令牌)。

以及更多内容。

课程链接: www.youtube.com/watch?v=dIUTsFT2MeQ

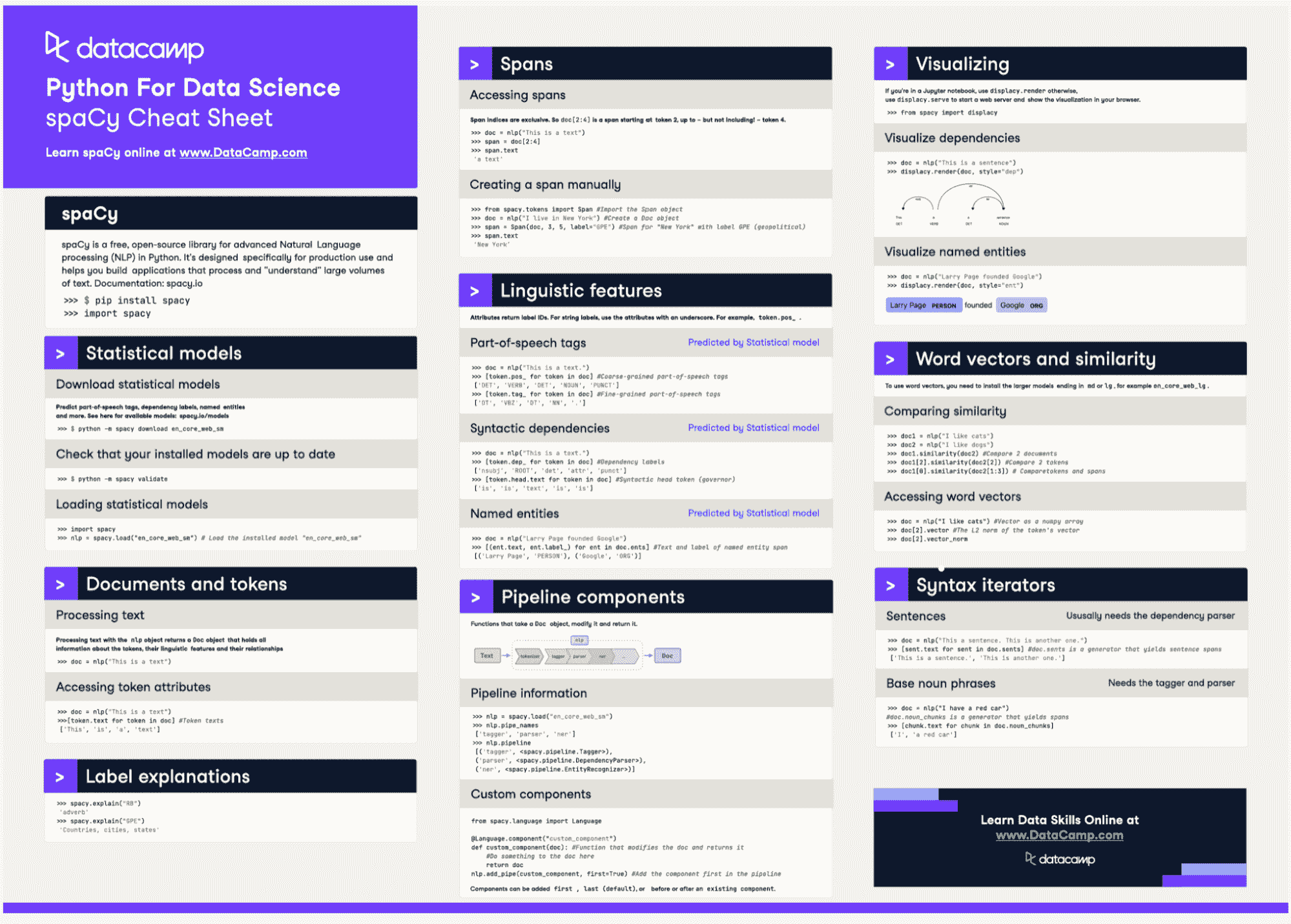

尽管这些资源足以让你踏上成为 NLP 大师的道路,但我总是喜欢总结和备忘单,以备不时之需。幸运的是,DataCamp 提供了一个很棒的 spaCy 备忘单,你可以将其保存为最常用函数的指南。

图片来源: DataCamp

自然语言处理使计算机能够理解和使用我们的语言。今天,我们可以在日常生活中利用自然语言处理的力量。

由于自然语言处理是今天的热门话题,你可以采用不同的方法来设计、构建和开发自然语言处理应用程序。构建高级自然语言处理项目的最强大工具之一是 spaCy。今天我们向你展示了免费的资源,帮助你开始使用 spaCy,然后利用这些知识构建更大、更真实的应用程序。

Sara Metwalli 是庆应大学的博士候选人,研究如何测试和调试量子电路。我是 IBM 的研究实习生和 Qiskit 倡导者,致力于构建更量子的未来。我还是 Medium、Built-in、She Can Code 和 KDN 的作者,撰写有关编程、数据科学和技术主题的文章。我也是“Woman Who Code Python”国际分会的负责人,一个火车爱好者、旅行者和摄影爱好者。

更多相关主题

使用 spaCy 的 Python 自然语言:简介

原文:

www.kdnuggets.com/2019/09/natural-language-python-using-spacy-introduction.html

评论

作者:Paco Nathan

本文提供了使用 spaCy 和 Python 相关库的自然语言简要介绍。补充的 Domino 项目也可以查看。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持组织的 IT

3. 谷歌 IT 支持专业证书 - 支持组织的 IT

简介

本文和配套的 Domino 项目 提供了使用 自然语言(有时称为“文本分析”)的 Python 简要介绍,使用的工具包括 spaCy 和相关库。工业界的数据科学团队必须处理大量文本,这是机器学习中使用的四大数据类别之一。通常是人类生成的文本,但并非总是如此。

想一想:商业的“操作系统”是如何工作的?通常,包括合同(销售合同、工作协议、合作伙伴关系)、发票、保险单、规章制度及其他法律等。所有这些都以文本形式存在。

你可能会遇到一些缩略语:自然语言处理(NLP)、自然语言理解(NLU)、自然语言生成(NLG)——它们分别大致表示“读取文本”、“理解意义”、“编写文本”。这些任务的重叠越来越多,因此很难对任何特定功能进行分类。

spaCy 框架——以及越来越多的插件和其他集成——提供了广泛的自然语言任务功能。它已成为 Python 中工业应用最广泛使用的自然语言库之一,并拥有相当大的社区——因此,对研究进展的商业化支持也较多,随着该领域的快速发展,支持也在不断增加。

入门

我们已经在 Domino 中配置了默认计算环境,以包含本教程所需的所有软件包、库、模型和数据。查看 Domino 项目以运行代码。

如果你对 Domino’s 计算环境如何工作感兴趣,可以查看 支持页面。

现在让我们加载 spaCy 并运行一些代码:

import spacy

nlp = spacy.load("en_core_web_sm")

现在,nlp 变量是你接触所有 spaCy 相关内容的入口,并加载了用于英语的 en_core_web_sm 小型模型。接下来,让我们通过自然语言解析器运行一个小的“文档”:

text = "The rain in Spain falls mainly on the plain."

doc = nlp(text)

for token in doc:

print(token.text, token.lemma_, token.pos_, token.is_stop)

The the DET True

rain rain NOUN False

in in ADP True

Spain Spain PROPN False

falls fall VERB False

mainly mainly ADV False

on on ADP True

the the DET True

plain plain NOUN False

. . PUNCT False

首先,我们从文本中创建了一个 doc,它是一个容器,包含了文档及其所有注释。然后我们遍历了文档,以查看 spaCy 解析了什么。

很好,但信息量很大,阅读起来有点困难。让我们将 spaCy 解析的句子重新格式化为一个 pandas 数据框:

import pandas as pd

cols = ("text", "lemma", "POS", "explain", "stopword")

rows = []

for t in doc:

row = [t.text, t.lemma_, t.pos_, spacy.explain(t.pos_), t.is_stop]

rows.append(row)

df = pd.DataFrame(rows, columns=cols)

df

可读性提高了!在这个简单的例子中,整个文档只是一个简短的句子。在那个句子中的每个词,spaCy 都创建了一个标记,我们访问了每个标记中的字段来显示:

-

原始文本

-

[词元](https://en.wikipedia.org/wiki/Lemma_(morphology) - 词的根形式

-

一个标记是否是 停用词 的标志——即,可能被过滤掉的常见词

接下来,让我们使用 displaCy 库来可视化该句子的解析树:

from spacy import displacy

displacy.render(doc, style="dep")

这是否让你想起了小学的回忆?坦白说,对于那些来自计算语言学背景的人来说,这个图示确实带来快乐。

但我们稍微退一步。你如何处理多个句子?

有用于 句子边界检测(SBD)—也称为 句子分割—的功能,基于内置/默认的 sentencizer:

text = "We were all out at the zoo one day, I was doing some acting, walking on the railing of the gorilla exhibit. I fell in. Everyone screamed and Tommy jumped in after me, forgetting that he had blueberries in his front pocket. The gorillas just went wild."

doc = nlp(text)

for sent in doc.sents:

print(">", sent)

> We were all out at the zoo one day, I was doing some acting, walking on the railing of the gorilla exhibit.

> I fell in.

> Everyone screamed and Tommy jumped in after me, forgetting that he had blueberries in his front pocket.

> The gorillas just went wild.

当 spaCy 创建文档时,它使用了一种 非破坏性分词 原则,意味着标记、句子等只是长数组中的索引。换句话说,它们不会将文本流切割成小块。因此,每个句子都是一个 span,具有 start 和 end 索引到文档数组:

for sent in doc.sents:

print(">", sent.start, sent.end)

> 0 25

> 25 29

> 29 48

> 48 54

我们可以在文档数组中索引,以提取一个句子的标记:

doc[48:54]

The gorillas just went wild.

或简单地索引到一个特定的标记,例如最后一个句子中的动词 went:

token = doc[51]

print(token.text, token.lemma_, token.pos_)

went go VERB

到目前为止,我们可以解析文档,将文档分割成句子,然后查看每个句子中标记的注释。这是一个良好的开端。

获取文本

现在我们可以解析文本了,那我们从哪里获取文本呢?一个快速的来源是利用网络。当然,当我们下载网页时,我们会得到 HTML,然后需要从中提取文本。Beautiful Soup 是一个流行的包来实现这一点。

首先,进行一些基础操作:

import sys

import warnings

warnings.filterwarnings("ignore")

在以下函数get_text()中,我们将解析 HTML 以查找所有的<p/>标签,然后提取这些标签的文本:

from bs4 import BeautifulSoup

import requests

import traceback

def get_text (url):

buf = []

try:

soup = BeautifulSoup(requests.get(url).text, "html.parser")

for p in soup.find_all("p"):

buf.append(p.get_text())

return "\n".join(buf)

except:

print(traceback.format_exc())

sys.exit(-1)

现在让我们从在线来源抓取一些文本。我们可以比较Open Source Initiative网站上托管的开源许可证:

lic = {}

lic["mit"] = nlp(get_text("https://opensource.org/licenses/MIT"))

lic["asl"] = nlp(get_text("https://opensource.org/licenses/Apache-2.0"))

lic["bsd"] = nlp(get_text("https://opensource.org/licenses/BSD-3-Clause"))

for sent in lic["bsd"].sents:

print(">", sent)

> SPDX short identifier: BSD-3-Clause

> Note: This license has also been called the "New BSD License" or "Modified BSD License"

> See also the 2-clause BSD License.

…

自然语言工作中的一个常见用例是比较文本。例如,通过这些开源许可证,我们可以下载它们的文本,解析,然后比较similarity度量:

pairs = [

["mit", "asl"],

["asl", "bsd"],

["bsd", "mit"]

]

for a, b in pairs:

print(a, b, lic[a].similarity(lic[b]))

mit asl 0.9482039305669306

asl bsd 0.9391555350757145

bsd mit 0.9895838089575453

这很有趣,因为BSD和MIT许可证似乎是最相似的文档。事实上,它们密切相关。

坦率地说,由于 OSI 免责声明在页脚中包含了一些额外的文本——但这为比较许可证提供了一个合理的*似。

自然语言理解

现在让我们深入探讨一些spaCy的自然语言理解(NLU)功能。鉴于我们有一个文档的解析,从纯语法的角度来看,我们可以提取noun chunks,即每个名词短语:

text = "Steve Jobs and Steve Wozniak incorporated Apple Computer on January 3, 1977, in Cupertino, California."

doc = nlp(text)

for chunk in doc.noun_chunks:

print(chunk.text)

Steve Jobs

Steve Wozniak

Apple Computer

January

Cupertino

California

不错。句子中的名词短语通常提供更多的信息内容——作为一种简单的过滤器,用于将长文档减少到更“精炼”的表示形式。

我们可以进一步采用这种方法,并识别文本中的named entities,即专有名词:

for ent in doc.ents:

print(ent.text, ent.label_)

Steve Jobs PERSON

Steve Wozniak PERSON

Apple Computer ORG

January 3, 1977 DATE

Cupertino GPE

California GPE

displaCy库提供了一种出色的可视化命名实体的方式:

displacy.render(doc, style="ent")

如果你正在处理knowledge graph应用程序和其他linked data,你的挑战是构建文档中的命名实体与其他相关信息之间的链接,这称为entity linking。识别文档中的命名实体是这种特定类型的 AI 工作中的第一步。例如,给定上述文本,可以将Steve Wozniak命名实体链接到lookup in DBpedia。

更一般来说,还可以将lemmas链接到描述其含义的资源。例如,在早期部分,我们解析了句子The gorillas just went wild,并能够显示单词went的词元是动词go。此时我们可以使用一个叫做WordNet的古老项目,它提供了一个英语的词汇数据库——换句话说,它是一个可计算的词典。

有一个名为spacy-wordnet的spaCy与 WordNet 的集成,由自然语言和知识图谱工作的专家Daniel Vila Suero提供。

然后我们将通过 NLTK 加载 WordNet 数据(这些事情会发生):

import nltk

nltk.download("wordnet")

[nltk_data] Downloading package wordnet to /home/ceteri/nltk_data...

[nltk_data] Package wordnet is already up-to-date!

True

注意到spaCy作为一个“管道”运行,并允许自定义管道中的部分内容。这对于支持数据科学工作中的非常有趣的工作流集成非常有用。在这里,我们将从spacy-wordnet项目中添加WordnetAnnotator:

from spacy_wordnet.wordnet_annotator import WordnetAnnotator

print("before", nlp.pipe_names)

if "WordnetAnnotator" not in nlp.pipe_names:

nlp.add_pipe(WordnetAnnotator(nlp.lang), after="tagger")

print("after", nlp.pipe_names)

before ['tagger', 'parser', 'ner']

after ['tagger', 'WordnetAnnotator', 'parser', 'ner']

在英语中,一些词因具有多种可能的含义而臭名昭著。例如,通过WordNet搜索结果来查找与withdraw一词相关的含义。

现在让我们使用spaCy来自动执行该查找:

token = nlp("withdraw")[0]

token._.wordnet.synsets()

[Synset('withdraw.v.01'),

Synset('retire.v.02'),

Synset('disengage.v.01'),

Synset('recall.v.07'),

Synset('swallow.v.05'),

Synset('seclude.v.01'),

Synset('adjourn.v.02'),

Synset('bow_out.v.02'),

Synset('withdraw.v.09'),

Synset('retire.v.08'),

Synset('retreat.v.04'),

Synset('remove.v.01')]

token._.wordnet.lemmas()

[Lemma('withdraw.v.01.withdraw'),

Lemma('withdraw.v.01.retreat'),

Lemma('withdraw.v.01.pull_away'),

Lemma('withdraw.v.01.draw_back'),

Lemma('withdraw.v.01.recede'),

Lemma('withdraw.v.01.pull_back'),

Lemma('withdraw.v.01.retire'),

…

token._.wordnet.wordnet_domains()

['astronomy',

'school',

'telegraphy',

'industry',

'psychology',

'ethnology',

'ethnology',

'administration',

'school',

'finance',

'economy',

'exchange',

'banking',

'commerce',

'medicine',

'ethnology',

'university',

…

同样,如果你正在处理知识图谱,那些来自WordNet的“词义”链接可以与图算法一起使用,以帮助识别特定词的含义。这也可以用于通过一种叫做总结的技术开发较大文本部分的摘要。这超出了本教程的范围,但在自然语言处理领域中这是一个有趣的应用。

反过来,如果你知道a priori一份文档是关于特定领域或主题集合的,那么你可以限制从WordNet返回的含义。在以下示例中,我们希望考虑金融和银行领域的 NLU 结果:

domains = ["finance", "banking"]

sentence = nlp("I want to withdraw 5,000 euros.")

enriched_sent = []

for token in sentence:

# get synsets within the desired domains

synsets = token._.wordnet.wordnet_synsets_for_domain(domains)

if synsets:

lemmas_for_synset = []

for s in synsets:

# get synset variants and add to the enriched sentence

lemmas_for_synset.extend(s.lemma_names())

enriched_sent.append("({})".format("|".join(set(lemmas_for_synset))))

else:

enriched_sent.append(token.text)

print(" ".join(enriched_sent))

I (require|want|need) to (draw_off|withdraw|draw|take_out) 5,000 euros .

这个示例看起来很简单,但如果你玩一下domains列表,你会发现结果在没有合理约束的情况下会出现一种组合爆炸的情况。想象一下拥有一个包含数百万个元素的知识图谱:你会想尽可能地限制搜索,以避免每个查询都需要数天/周/月/年来计算。

有时,试图理解文本——或者更好地说,理解一个corpus(一个包含许多相关文本的数据集)——时遇到的问题变得如此复杂,以至于你需要先可视化它。这是一个用于理解文本的交互式可视化工具:scattertext,这是Jason Kessler的天才作品。

让我们分析 2012 年美国总统选举期间的党派大会的文本数据。注意:这个单元可能需要几分钟才能运行,但经过所有这些数字运算后,结果是值得等待的。

import scattertext as st

if "merge_entities" not in nlp.pipe_names:

nlp.add_pipe(nlp.create_pipe("merge_entities"))

if "merge_noun_chunks" not in nlp.pipe_names:

nlp.add_pipe(nlp.create_pipe("merge_noun_chunks"))

convention_df = st.SampleCorpora.ConventionData2012.get_data()

corpus = st.CorpusFromPandas(convention_df,

category_col="party",

text_col="text",

nlp=nlp).build()

一旦你准备好了corpus,生成一个 HTML 中的交互式可视化:

html = st.produce_scattertext_explorer(

corpus,

category="democrat",

category_name="Democratic",

not_category_name="Republican",

width_in_pixels=1000,

metadata=convention_df["speaker"]

)

from IPython.display import IFrame

file_name = "foo.html"

with open(file_name, "wb") as f:

f.write(html.encode("utf-8"))

IFrame(src=file_name, width = 1200, height=700)

现在我们将渲染 HTML——请稍等一两分钟,它值得等待:

想象一下,如果你有过去三年中针对特定产品的客户支持文本。假设你的团队需要了解客户如何谈论该产品?这个scattertext库可能会非常有用!你可以对NPS 评分(一个客户评估指标)进行聚类(k=2),然后用聚类中的前两个组件替换民主党/共和党的维度。

概要

五年前,如果你询问有关 Python 中自然语言的开源工具,许多数据科学工作者的默认答案可能是NLTK。该项目包括几乎所有内容,但组件相对学术。另一个受欢迎的自然语言项目是斯坦福大学的CoreNLP,虽然也相当学术,但功能强大,不过 CoreNLP 在生产环境中与其他软件集成可能会有挑战。

几年前,这个自然语言领域的一切开始发生变化。spaCy的两位主要作者,Matthew Honnibal和Ines Montani,于 2015 年推出了该项目,行业采纳迅速。他们专注于一种主观性的方法(做必要的事,做到最好,不多也不少),这使得在 Python 中的数据科学工作流程中能够简单、快速地集成,并且执行速度更快、准确性更高。基于这些优先级,spaCy变成了NLTK的反面。自 2015 年以来,spaCy始终专注于作为一个开源项目(即依赖其社区进行方向指导、集成等)以及商业级软件(而非学术研究)。尽管如此,spaCy迅速纳入了机器学习的 SOTA 进展,实际上成为了将研究成果转化为行业应用的桥梁。

值得注意的是,自 2000 年代中期谷歌开始赢得国际语言翻译竞赛后,自然语言的机器学习得到了极大的提升。另一个重大变化发生在 2017-2018 年,当时,随着深度学习的诸多成功,这些方法开始超越之前的机器学习模型。例如,请参见ELMo对语言嵌入的工作,由 Allen AI 主导,接着是Google 的 BERT,以及最*的百度的 ERNIE——换句话说,全球的搜索引擎巨头们为我们提供了基于深度学习的开源嵌入语言模型的《芝麻街》剧目,这些模型现在是最先进的(SOTA)。说到这一点,为了跟踪自然语言的 SOTA,可以关注NLP-Progress和Papers with Code。

过去两年自然语言的应用场景发生了剧烈变化,深度学习技术的出现使得这些变化加速。大约在 2014 年,一个 Python 自然语言教程可能会展示词频统计、关键词搜索或情感检测,当时的目标用例相对较为*淡。而到了 2019 年,我们谈论的则是分析成千上万的文档以优化工业supply chain…或分析数亿份文档用于保险公司保单持有人,或无数份关于财务披露的文档。更现代的自然语言处理工作倾向于自然语言理解(NLU),通常用于支持知识图谱的构建,并且越来越多地应用于自然语言生成(NLG),在这里,大量类似文档可以在人工规模下进行总结。

spaCy Universe 是检查特定用例深度探讨以及了解这一领域如何发展的好地方。从这个“宇宙”中选择的一些项目包括:

-

Blackstone – 解析非结构化法律文本

-

Kindred – 从生物医学文本(例如,制药领域)中提取实体

-

mordecai – 解析地理信息

-

Prodigy – 人工干预标注数据集

-

spacy-raspberry – Raspberry PI 镜像,用于在边缘设备上运行 spaCy 和深度学习

-

Rasa NLU – Rasa 集成用于聊天应用

另外,还有几个超级新的项目值得一提:

-

spacy-pytorch-transformers 用于微调(即,使用迁移学习)Sesame Street 的角色和朋友:BERT、GPT-2、XLNet 等。

-

spaCy IRL 2019 会议 – 查看演讲视频!

我们可以用spaCy做更多的事情——希望这个教程能够提供一个入门介绍。祝你在自然语言处理工作中一切顺利。

原始。经许可转载。

相关:

-

自然语言处理中的迁移学习现状

-

Reddit 帖子分类

-

2018 年数据科学和 AI 的顶级 7 个 Python 库

相关话题

导航数据科学职位标题:数据分析师 vs. 数据科学家 vs. 数据工程师

原文:

www.kdnuggets.com/navigating-data-science-job-titles-data-analyst-vs-data-scientist-vs-data-engineer

“导航”似乎是合适的词汇。数据科学有时可能像一片狂野的海洋,每隔几分钟就会出现一个新的职位名称或专业化方向。谢谢你,数据科学。我们感激你充满活力和狂野,但我们该如何应对呢?

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业之路。

1. 谷歌网络安全证书 - 快速开启网络安全职业之路。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

首先,让我们先搞清楚基础。当我说数据科学职位时,我指的是更广泛的数据科学,包括所有的数据相关职位。对我来说,所有这些都是数据科学职位标题。

其次,数据分析师、数据科学家和数据工程师不再是新兴职位了。但它们仍然会引起一些关于谁做什么的困惑。这些职位之间有一些轻微的重叠,这并没有帮助。

许多公司在只有一个数据团队成员时甚至会让情况更糟。是的,初创公司,我在看着你们呢!

不,数据分析师、数据科学家和数据工程师并不是相同的工作!谁会想到呢?

虽然这些职位有不同的专业领域和重点,但它们都朝着同一个目标努力,作为公司内部数据团队的一部分。

为什么数据角色至关重要

每家公司都看到数据的价值,并利用数据团队来提取这些价值。通常,大多数公司都尝试实现五个常见的目标。

1. 明智决策

数据使公司不再盲目决策,依赖决策者的商业直觉(即:运气)。随着技术的进步,数据的多样性和使用可能性增加了。

数据科学利用数据提供洞见,以指导战略和决策。

2. 改善客户体验

公司必须以客户为导向,因为这就是它们的资金来源。数据科学使公司能够分析客户行为和反馈。这使企业能够根据客户的需求量身定制其产品和服务,并预测客户的需求。

3. 操作效率

虽然他们希望从客户那里赚取尽可能多的钱,但企业也希望以最有效的方式做到这一点。阅读:以最低成本完成。数据科学可以帮助实现这一目标。它可以自动化和加速任务,优化它们,并发现瓶颈。简而言之,就是处理业务的成本问题。

4. 创新与竞争力

数据科学通过识别和预测客户需求、行业趋势、经济变化等来推动创新。这里的创新可以指现有或新产品、市场营销和销售策略以及制造过程,但不限于此。

5. 风险管理

商业是一项有风险的,呃,业务。数据科学帮助识别、评估和管理公司的潜在风险。

数据科学职位名称

除非我们对每个职位有清晰的定义,否则无法分析职位名称之间的差异。让我们从这里开始,然后再讨论它们的职责、技能、使用的工具和职业发展路径。

数据分析师

角色总结: 数据分析师显而易见地分析数据。他们这样做是为了识别模式并提出可行的洞察。这些模式和洞察会以报告和仪表盘的形式呈现,使决策者能够做出明智的决策。

数据分析师主要负责描述性(发生了什么?)和诊断性(为什么发生?)的数据分析。

主要职责:

-

数据清洗: 通过标准化数据、改变数据格式以及处理重复项、缺失值和数据不一致性,使数据准备好进行分析。

-

数据分析: 使用统计方法来理解数据中的趋势、模式和洞察。

-

数据可视化和报告: 通过报告、数据可视化和仪表盘传达数据分析结果。

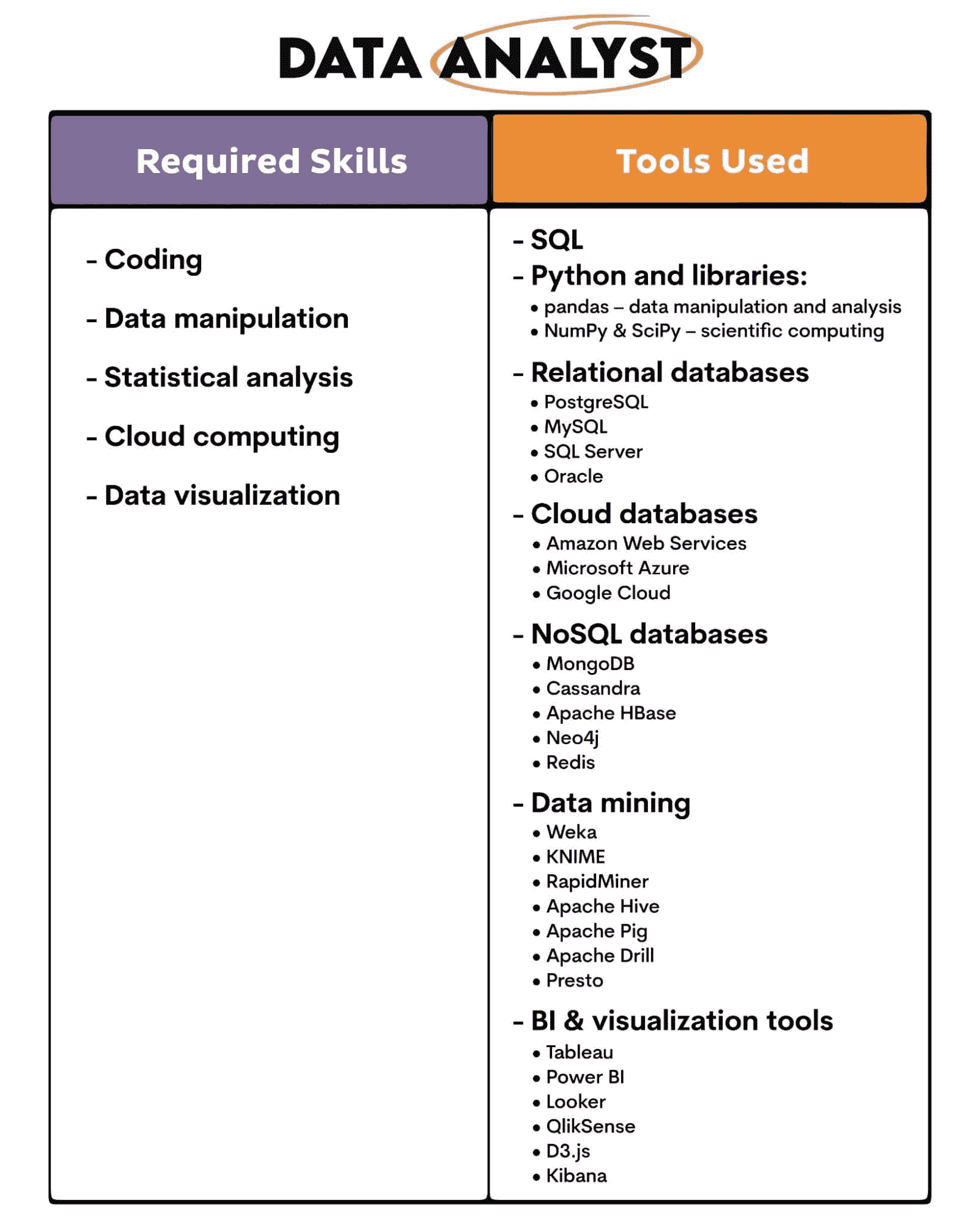

关键技能和工具: 主要技能和工具可以从角色描述中得出。

职业发展路径: 数据分析师可以晋升到更高级的分析师角色。随着经验的增加和额外教育的完成,他们可以转型为专业角色,如统计师、业务分析师,甚至数据科学家。

数据科学家

角色总结: 数据科学家也分析数据,但在更高级的层面。他们使用统计模型和机器学习算法来确定未来事件的可能性。这告诉我们,他们与数据分析师不同,关注预测性(会发生什么?)和规范性(应该做什么?)数据分析。

主要职责:

-

高级分析: 使用先进的统计技术从数据中提取洞见。

-

机器学习: 实施机器学习算法,从现有数据中学习。

-

预测建模: 构建和部署模型以预测实际和新数据中的未来事件。

这些主要职责建立在数据分析师所做的相同工作基础上。数据科学家也不能离开数据清理和数据可视化。

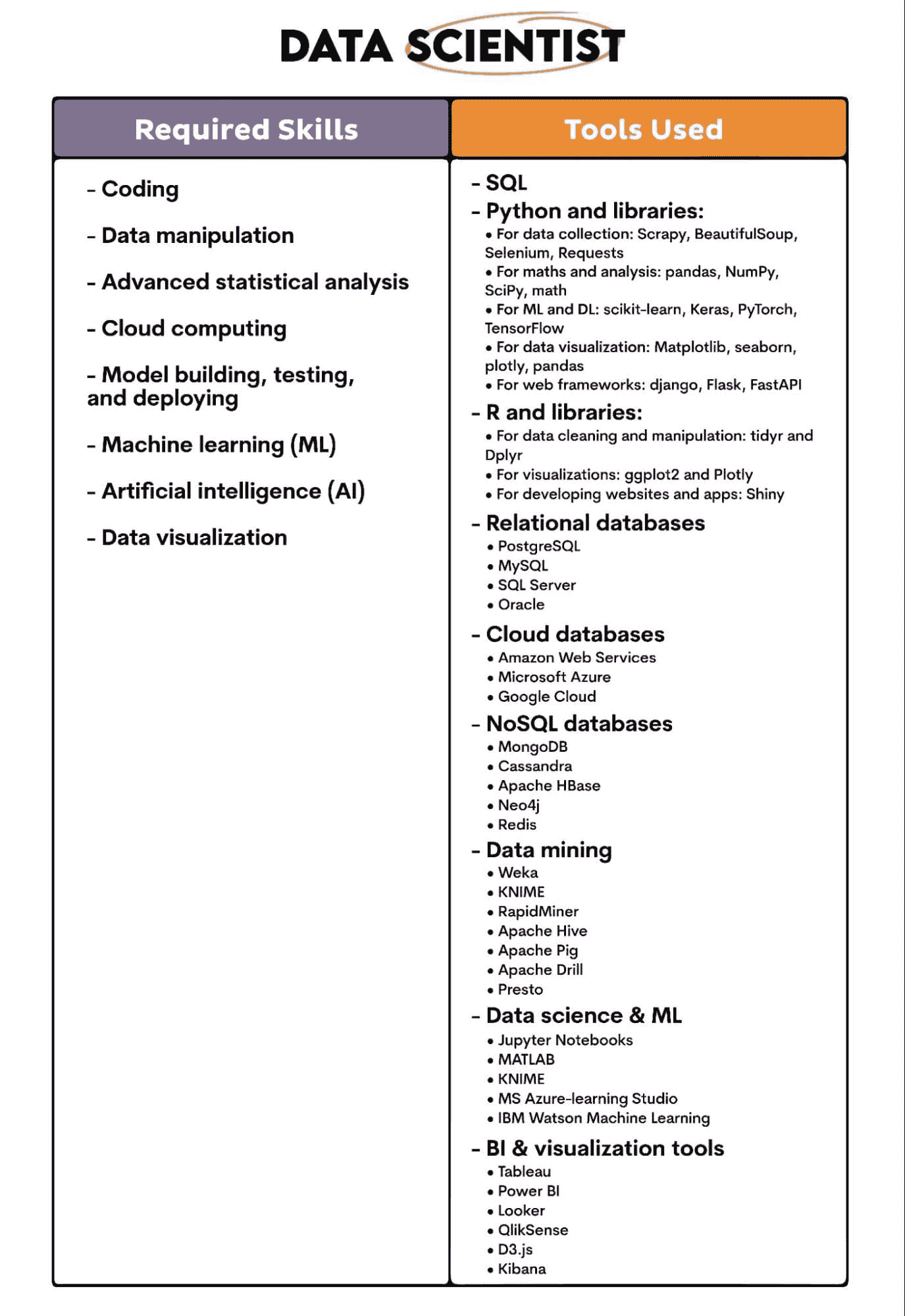

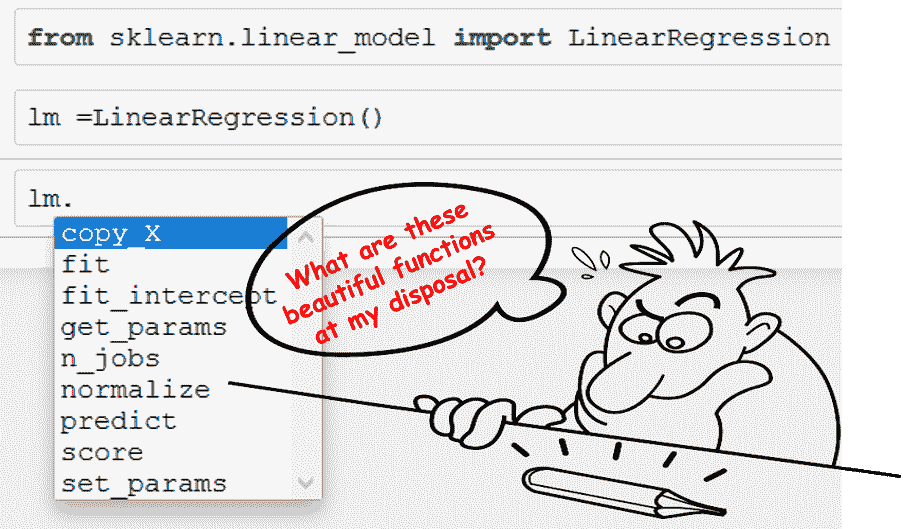

关键技能和工具: 以下是成为数据科学家所需的技能和工具。你会看到它们与数据分析师有一些重叠。

职业发展路径: 数据科学家从初级数据科学家开始,可以晋升为高级数据科学家、首席数据科学家和数据科学总监。他们还可以朝其他方向发展,如成为人工智能专家、机器学习工程师或计算机与信息研究科学家。

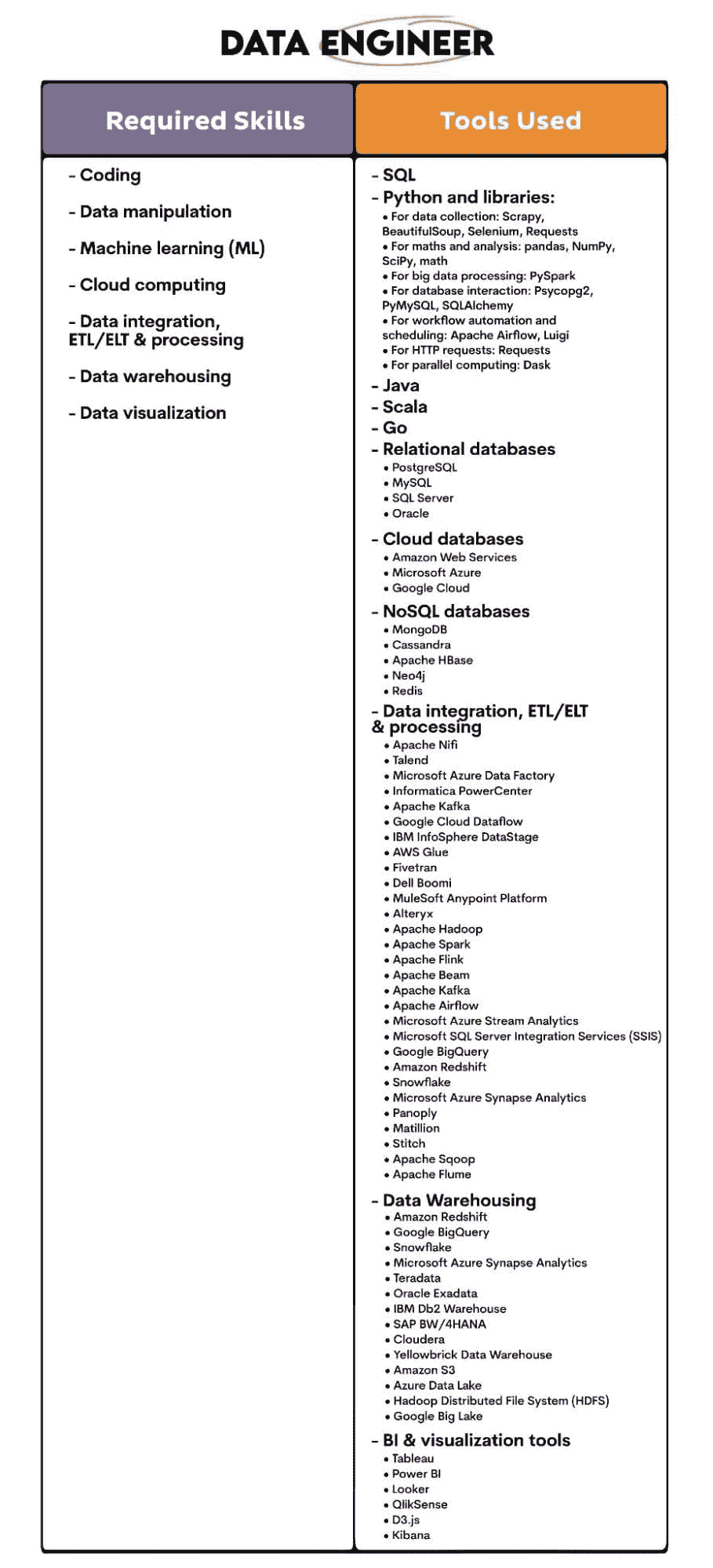

数据工程师

角色概述: 数据工程师构建数据系统,以便收集、存储和传输数据。他们确保数据的可用性、质量和可分析性(这是个词吗?)对所有数据用户而言。

主要职责:

-

数据架构: 根据数据架构师设想的设计构建数据系统。

-

数据管道: 构建系统,使数据能够从多个数据源流向数据库、数据仓库和数据湖,并为其他数据用户使用做好准备。

-

确保数据质量: 识别数据中的错误和不一致,删除它们,并提高数据的准确性和可靠性。

是的,数据工程师专注于这些任务。但他们也无法避免数据清理和数据可视化。

关键技能和工具: 这是数据工程师所使用的技能和工具。

职业发展路径: 数据工程师的职业可以晋升为高级数据工程师或数据架构师。他们也可以专注于大数据、机器学习或商业智能等领域。

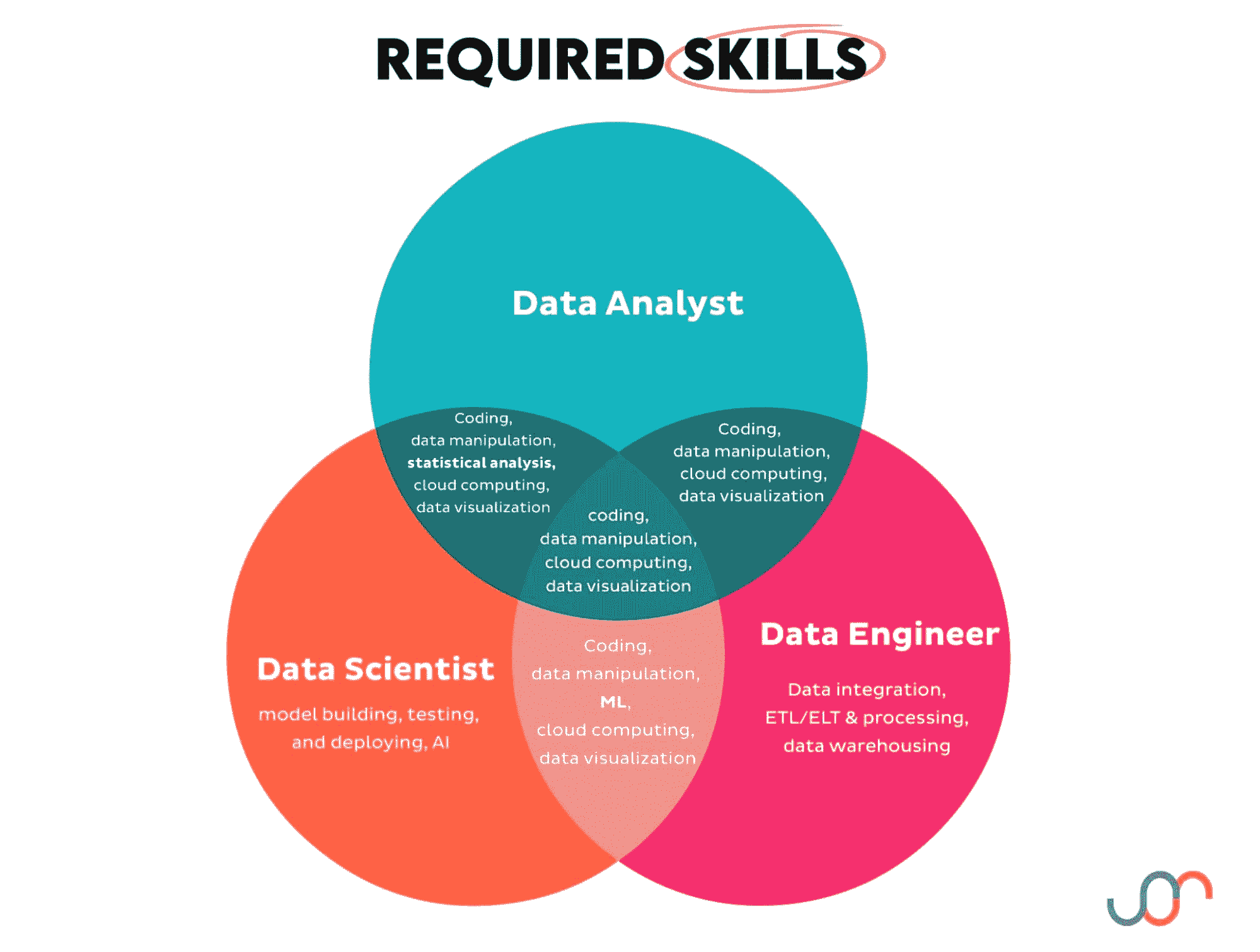

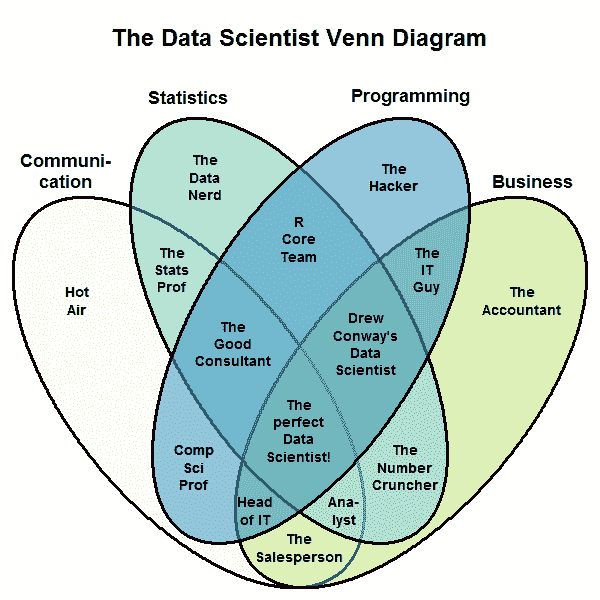

数据分析师、数据科学家和数据工程师的维恩图

我们已经看到了这三个职位之间的区别。在这个过程中,我们还注意到这些职位之间在所需技能方面有一些重叠。

为了快速了解,这些可以通过维恩图进行展示。

你可以看到这三个职位共享的技能有:

-

编程

-

数据处理

-

云计算

-

数据可视化

额外的技能在两个职位之间共享,并加以突出显示。

数据分析师没有任何独特的技能;其他职位在某种程度上也需要这些技能。

数据科学家独有的技能有:

-

模型构建、测试和部署

-

AI

数据工程师特有的技能有:

-

数据集成、ETL/ELT 和处理

-

数据仓储

现在让我们使用相同的可视化工具展示这些职位使用的工具。

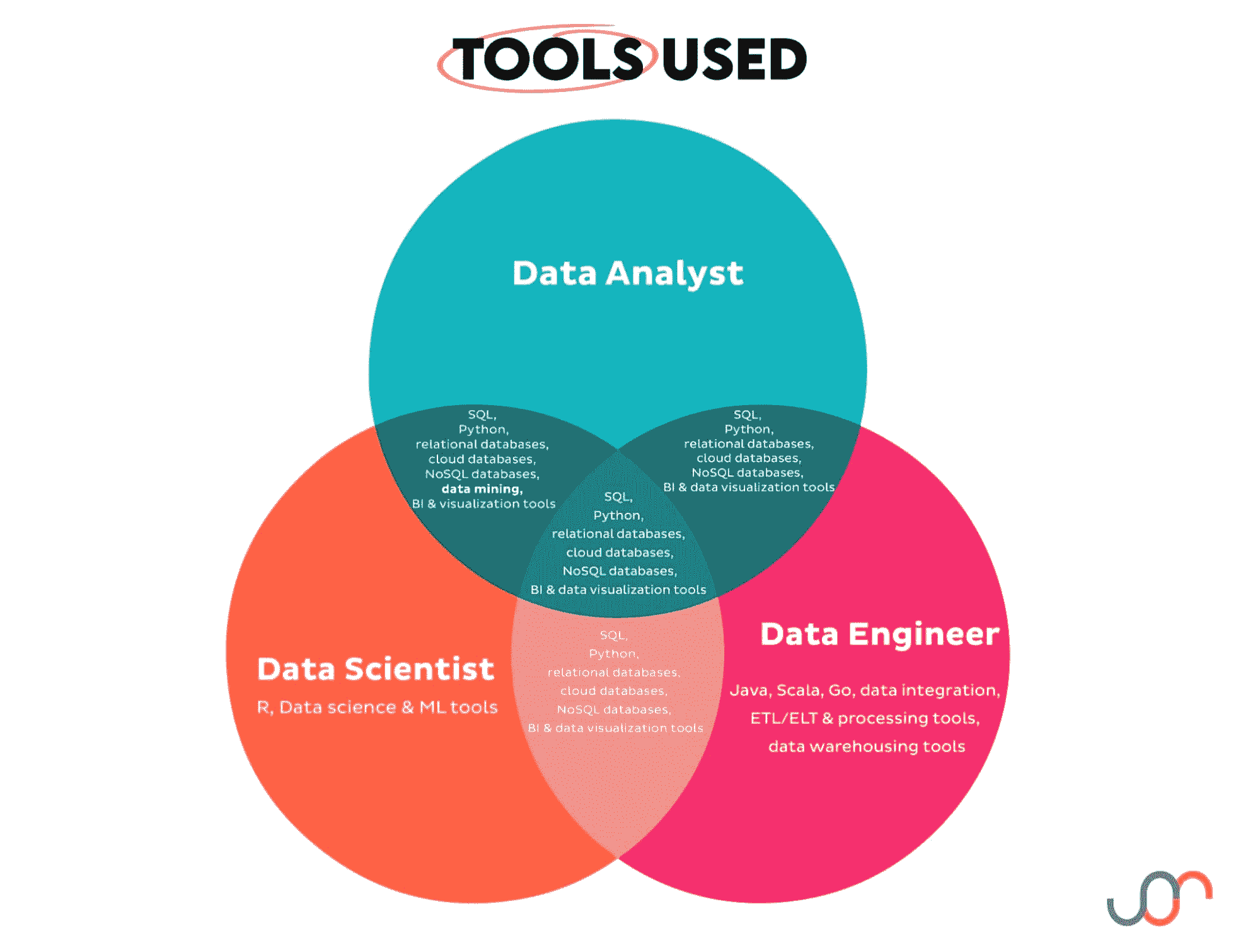

图像显示所有三个职位共享这些工具:

-

SQL

-

Python

-

关系数据库

-

云数据库

-

NoSQL 数据库

-

BI 和数据可视化工具

除此之外,两个职位之间共享的附加工具已被突出显示。

数据分析师使用的工具类型至少被另一个职位使用。虽然职位可能共享相同的工具类型,但工具的使用程度可能不同,或者同一类别中的具体工具可能有所不同。

数据科学家特有的工具有:

-

R

-

数据科学和机器学习工具

数据工程师特有的工具有:

-

Java

-

Scala

-

Go

-

数据集成、ETL/ELT 和处理工具

-

数据仓储工具

弥合差距:合作是关键

我们看到每个角色都有其独特的职责和使用的工具。三者之间也有一些重叠。这表明这些职位并不是完全不同的世界,数据分析师、数据科学家和数据工程师在数据团队中的合作至关重要。

数据分析师和数据科学家都依赖于基础设施和高质量的干净、组织良好的数据。另一方面,数据工程师在构建数据架构和提供数据时必须与数据分析师和数据科学家合作——因为他们是数据用户。

数据科学家通常需要与数据分析师合作,以更好地理解业务背景。

结论:选择你的路径

数据分析师、数据科学家和数据工程师之间的差异和相似性现在应该更加清晰。

总结:

-

如果你喜欢从数据中获取见解并传达它们,数据分析可能是你的路径。

-

如果构建预测模型和使用机器学习算法让你兴奋,考虑数据科学。

-

如果你觉得构建数据架构和确保数据流的规律性会让你感到愉悦,那么数据工程可能是正确的选择。

如果你想了解更多,请参考有关数据工程师和数据科学家以及数据分析师和数据科学家的更多细节。

内特·罗西迪是一名数据科学家,专注于产品战略。他还是一名兼职教授,教授分析课程,并且是 StrataScratch 的创始人,这是一个帮助数据科学家通过真实的面试问题准备面试的*台。内特撰写有关职业市场的最新趋势,提供面试建议,分享数据科学项目,并覆盖所有 SQL 相关内容。

更多相关内容

数据革命的导航:探索数据科学和机器学习中的蓬勃趋势

图片由 DALLE-3 生成

在不断发展的技术领域,数据革命作为一种强大的力量,重新塑造了行业、经济和社会规范。数据科学和机器学习是这一变革浪潮的核心,作为创新的关键催化剂。它们推动我们进入一个问题解决超越单纯人类认知的时代,成为人类智慧与智能机器之间的协作舞蹈。本文将进行全面的探索,深入挖掘数据科学和机器学习中的新兴趋势,揭示那些引领我们走向数据驱动未来的关键发展。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

AI 驱动的自动化:用智能系统改造行业

数据科学和机器学习中的一个重要趋势是将人工智能(AI)融入自动化。各行各业都在利用机器学习算法来简化日常任务、优化流程并提高效率。无论是在制造业、医疗保健、金融还是物流行业,AI 驱动的自动化浪潮正在根本改变企业的运营格局。这一转变降低了成本,提高了整体生产力,标志着企业在日常运作中迈出了革命性的一步。

使用案例

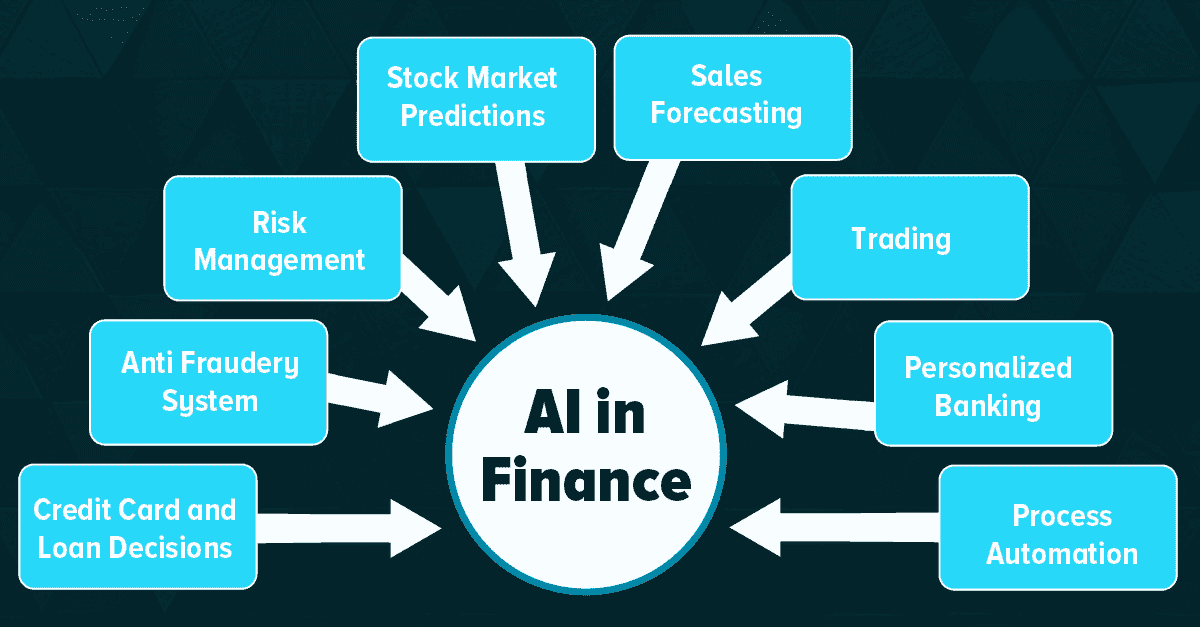

- 金融:

在金融领域,自动交易系统已成为中心,利用机器学习的力量来分析市场趋势并实时执行交易。这是将技术深度融合到动态的金融市场中,开启了一个效率和数据驱动决策的新纪元。

图片来自 AISmartz

- 医疗保健:

在医疗保健领域,机器学习算法的惊人能力正逐步进入关键角色。这些算法在诊断中提供帮助,提供关于患者结果的预测分析见解,甚至有助于机器人手术的精准度。这是技术与医学的卓越融合,正在重新塑造患者护理的格局。

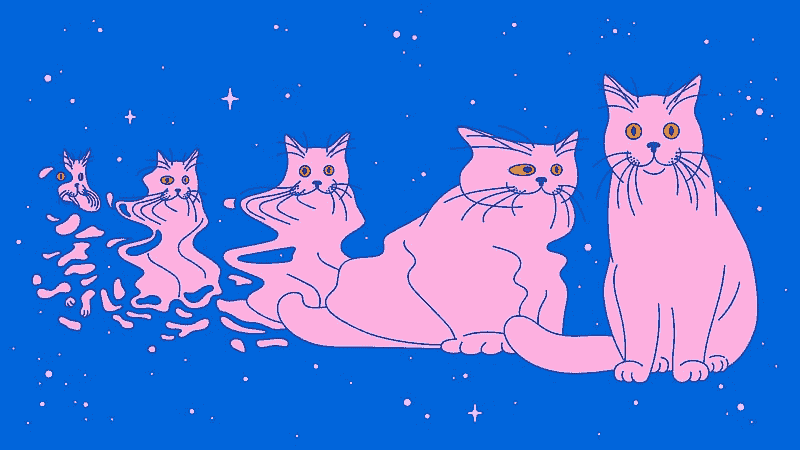

自然语言处理(NLP)的指数增长

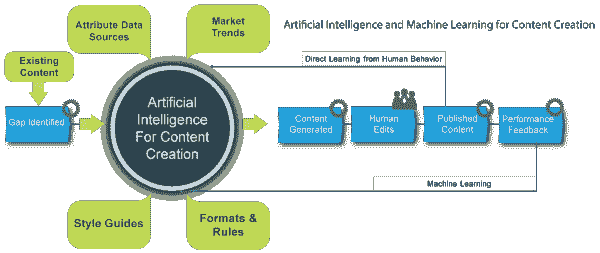

自然语言处理(NLP)在机器学习的广阔领域中占据了中心位置。得益于深度学习模型如 GPT-3 的进步,机器正在快速进化,展现出解码和生成模仿人类表达的语言的非凡能力。这一变革趋势正在重新塑造我们与技术的互动方式,从聊天机器人和虚拟助手的直观回应,到语言翻译和内容创作的无缝复杂性。机器理解和响应自然语言的新能力不仅重新定义了我们的沟通格局,还开辟了各种领域的全新通道,以提升可及性。

用例

- 内容生成:

像 GPT-3 这样的模型通过生成类似人类语言的文本,改变了内容创作和写作行业的格局。他们的影响力显著,引领了人工智能与作者合作,共同创作引人入胜且连贯的内容的新时代。

图片来自 AnalyticsVidhya

- 聊天机器人和虚拟助手:

自然语言处理(NLP)在 Siri 和虚拟助手如 Alexa 的功能中扮演了关键角色。这是它们理解和响应我们日常语言查询的神奇之处,使互动更加人性化和直观。

- 语言翻译:

在语言翻译中,Google 翻译依赖于自然语言处理(NLP)的精妙之处,以提供准确无误的多语言翻译。这种高超的技术应用使跨语言沟通成为可能。

伦理 AI 和负责任的数据科学实践

在不断发展的决策制定领域中,数据的关键作用不容低估。越来越受到关注的是人工智能和数据科学中的伦理考量需求。在机器学习模型的开发和部署阶段,伦理原则作为核心要素的认识显著上升。诸如偏见、公*、透明度和问责制等问题已成为讨论的重点,塑造了负责任的数据科学实践的叙述。组织正在积极拥抱这一伦理转变,采纳寻求在创新与伦理考量之间取得微妙*衡的框架和指南,引导数据世界迈向一个更具良知的时代。

使用案例

- 面部识别:

与面部识别技术相关的伦理环境十分复杂,主要因为系统中潜在的偏见。这促使了对负责任和谨慎部署的迫切需求,因为偏见面部识别的后果可能对隐私、安全和社会公正产生深远影响。

- 信用评分:

在信用评分中运用机器学习需要细致考虑,因为所涉及的模型必须精心构建,以减少任何潜在的歧视性做法。这种审慎的做法对于确保贷款实践中的公*和公正至关重要,认识到这些模型对个人财务机会的重大影响。

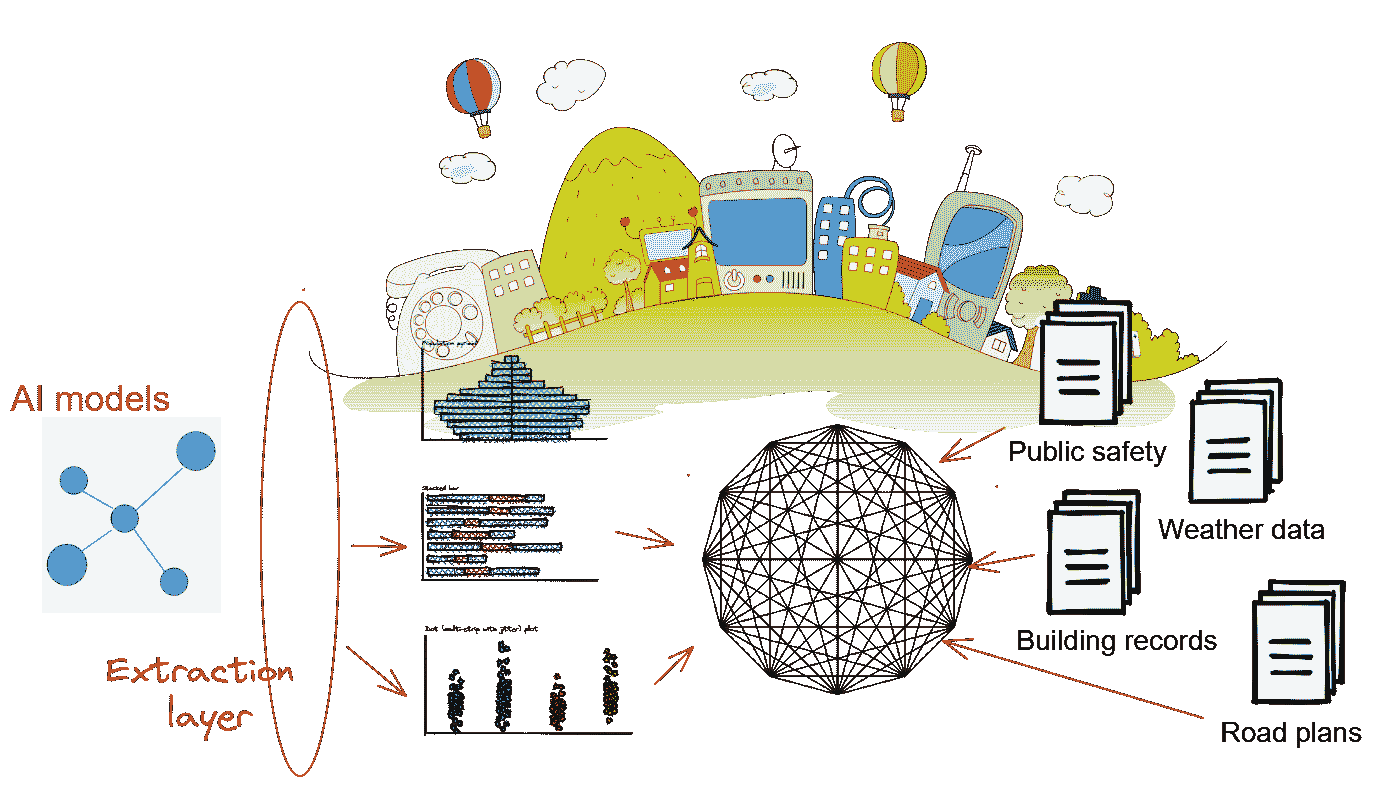

边缘计算和去中心化机器学习

物联网(IoT)设备的广泛采用引发了网络边缘数据生成的显著增长。一种获得显著关注的趋势是将边缘计算与去中心化机器学习相结合,旨在处理靠*数据源的数据。这一战略举措有望减少延迟并优化带宽使用。其相关性在自动驾驶汽车、智慧城市和工业物联网等领域尤为突出,这些领域中瞬间决策至关重要。将机器学习模型集成到边缘设备中对于推动智能且高度响应实时需求的系统具有重要意义。

使用案例

- 自动驾驶汽车:

在自动驾驶汽车领域,边缘计算已被证明具有变革性。通过直接处理来自传感器的数据,使这些车辆能够快速做出决策,增强了它们在道路上灵活导航的能力,并确保了对其安全和高效操作至关重要的响应水*。

- 智慧城市:

将去中心化的机器学习融入智慧城市应用标志着一个重要的进步。这一创新通过来自各种传感器的实时数据分析,提供及时的洞察,帮助城市提高整体效率,优化决策和资源分配。这展示了技术无缝集成以创建更智能、更响应的城市环境。

图片来源于TowardsDataScience

跨学科合作与混合技能组合

数据科学和机器学习的领域正在超越传统界限,发展成为一个跨学科的领域。专家们来自不同背景,能够无缝合作,解决复杂问题的趋势越来越明显。对混合技能组合的需求不断增加,这些技能组合融合了数据科学的能力、领域特定知识和有效沟通。在这个互联的数据生态系统中,能够弥合技术复杂性与非技术利益相关者之间差距的专业人士正变得越来越宝贵。

用例

- 医疗分析:

在复杂的医疗领域,数据科学家与医疗专业人士之间展开了动态合作。他们共同筛选大量的患者数据,运用综合专业知识获得宝贵的洞察,提升治疗效果,迎来个性化和有效医疗解决方案的新纪元。

- 金融和数据分析:

在金融与数据科学的交汇点,具有双重专业知识的专业人士联合合作。他们将自己的知识应用于构建预测模型,深入分析市场趋势的复杂图景,体现了金融敏锐性与数据驱动洞察的和谐融合。

总结

在数据科学和机器学习的推动下,正在进行的数据革命从根本上重塑我们的日常生活和职业领域。无论是人工智能驱动的自动化的出现,还是对伦理考量的日益重视,或是跨学科方法的协作,这些趋势都为这些领域动态而不断发展的本质提供了细致的视角。成功应对这场革命需要坚守不变的承诺,跟上发展步伐,拥抱负责任的实践,并培养持续学习的文化。展望未来,数据科学与机器学习的融合有望揭示新的可能性,持续推动各行各业的创新。

Aryan Garg 是一名 B.Tech.电气工程学生,目前处于本科最后一年。他的兴趣在于网页开发和机器学习。他已经追随这一兴趣,并渴望在这些方向上进一步发展。

相关阅读

探索你的数据科学职业生涯:从学习到收入

原文:

www.kdnuggets.com/navigating-your-data-science-career-from-learning-to-earning

图片来源于作者

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在的组织进行 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在的组织进行 IT 工作

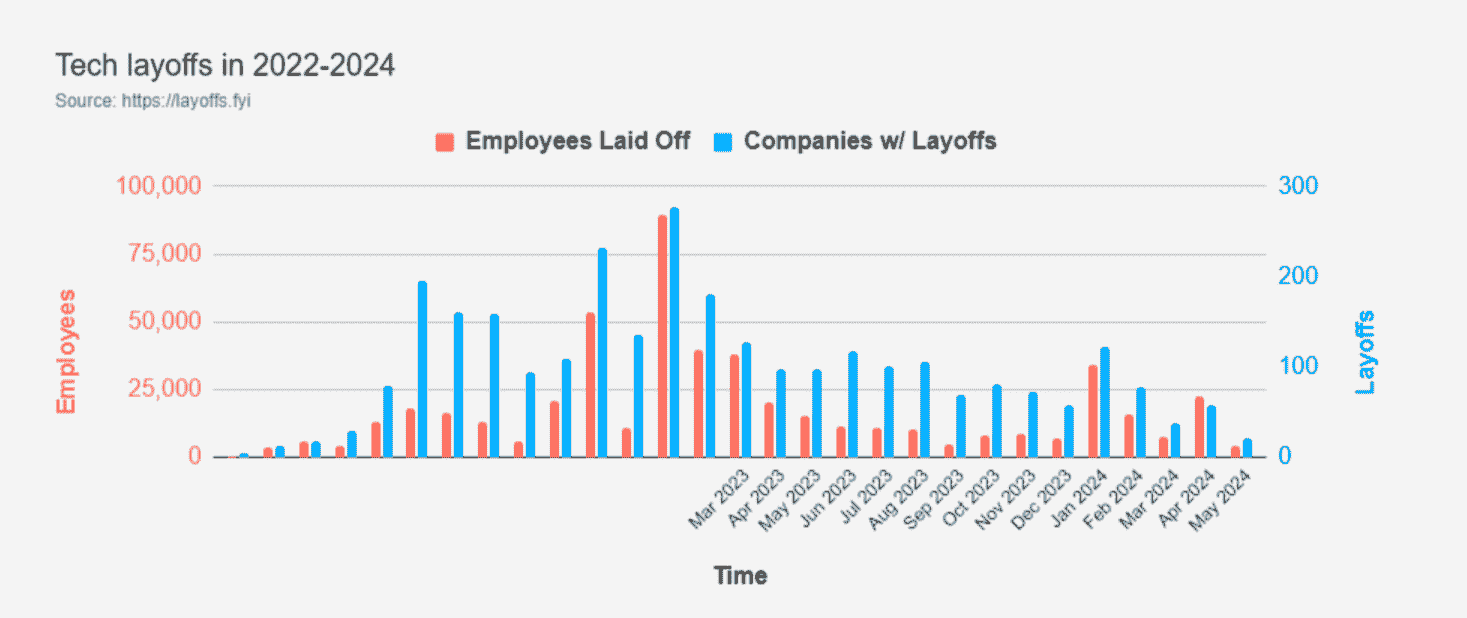

随着 281 家科技公司裁员 80,628 人,你为什么会对开始一个数据科学职业感兴趣呢?

现在可能看起来不是一个好时机,尤其是在公司裁员的情况下。是的,有裁员,但下图显示最*的裁员与 2022 年底和 2023 年初相比并不算严重。所以,情况并没有那么糟糕!

来源: layoffs.fyi

从另一个角度来看情况更为积极:公司仍在招聘数据科学家。实际上,在过去一个月内,美国在 Glassdoor 上几乎有5,500 个招聘广告。

数据科学家有一个相当活跃的就业市场。只是现在公司要求更高。他们更倾向于寻找数据科学专家而不是通才。此外,现在数据科学家需要掌握 AI 工具。以下是你如何应对这些挑战并在就业市场上脱颖而出的方式。

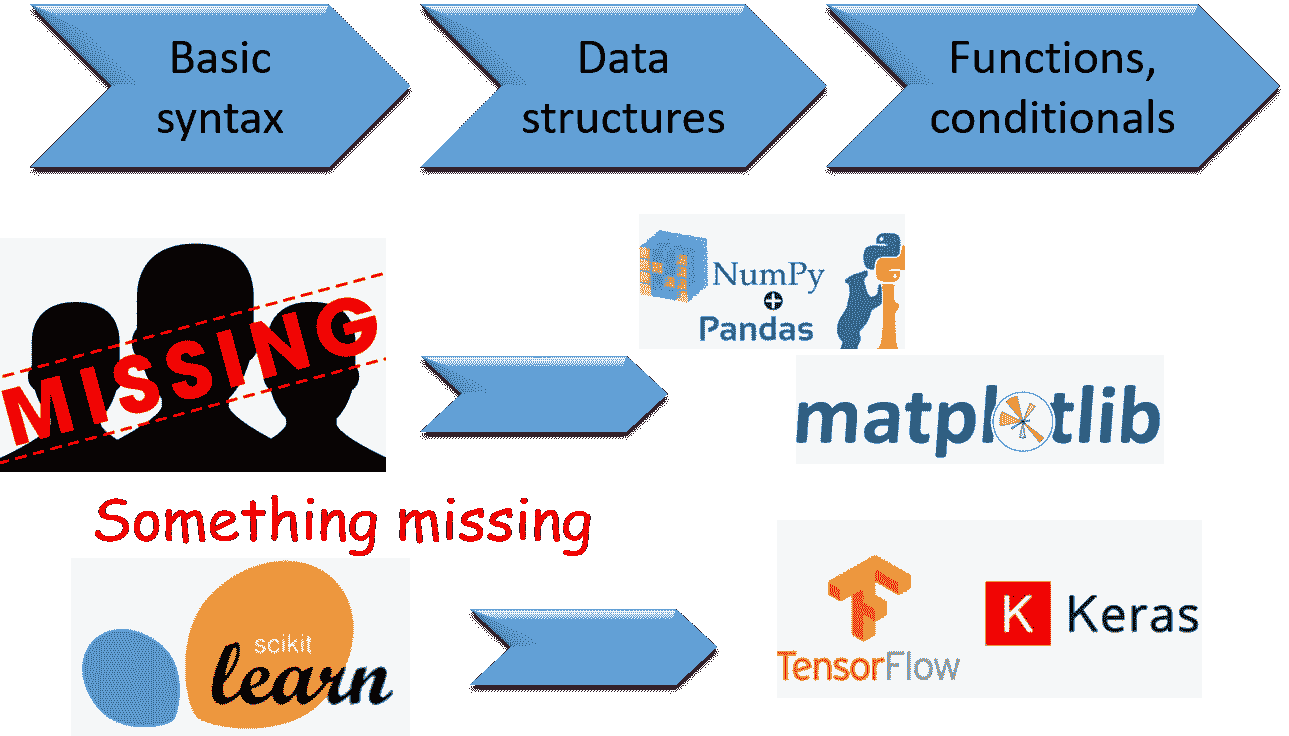

1. 教育路径

学习数据科学时总有两种不同的方法:

-

学术教育

-

自学

理想情况下,你应该结合这两者。

学术教育

成为数据科学家并不一定需要学术教育,但它确实提供了广泛而结构化的知识。比起从零开始成为数据科学家,后续在此基础上构建知识要容易得多。

数据科学家通常拥有计算机科学、统计学、数学甚至经济学等定量领域的学士学位。

拥有硕士学位是提升就业机会的一个好主意。通过它,你可以专注于某些领域。一些专业化的例子包括机器学习、数据分析、商业智能等。

追求博士学位通常是不必要的,除非你对公司或学术界的研究导向角色感兴趣。

自学

你可以通过为自己制定课程来成为数据科学家。这可以包括以下(非详尽)列表中的任何内容:

-

认证

-

在线课程

-

训练营

-

YT 视频

-

书籍

-

博客文章

-

社区论坛

如果时间和财务条件允许,我建议你专注于认证、在线课程和训练营。然后,辅以其他资源。

我建议的一些认证、课程和训练营包括:

-

认证分析师专业证书 (CAP) – 一个中立于供应商和技术的数据科学技能认证

-

Google 专业数据工程师认证 – 使用 Google Cloud 认证你的数据工程知识

-

IBM 机器学习专业证书 – 显然是 IBM 的机器学习认证

-

Microsoft Azure 数据工程师助理 (DP-203) 专业证书 – 微软 Azure 数据工程的证书

-

助理大数据分析师 – 大数据分析的中立认证

-

Coursera 上的数据科学专业化 – 约翰斯·霍普金斯大学的 10 门课程数据科学专业化

-

edX 上的统计学与数据科学微硕士项目 – 麻省理工学院的数据科学教育

-

Coursera 上的机器学习专业化 – 斯坦福大学和 DeepLearning.AI 提供的机器学习专业化,由 Andrew Ng 授课

-

数据科学训练营 – Springboard 提供的训练营,配有一对一辅导和就业保障(怎么样!)

-

Python 中的机器学习与深度学习训练营 – 学习 Keras 和 TensorFlow 中的机器学习和深度学习

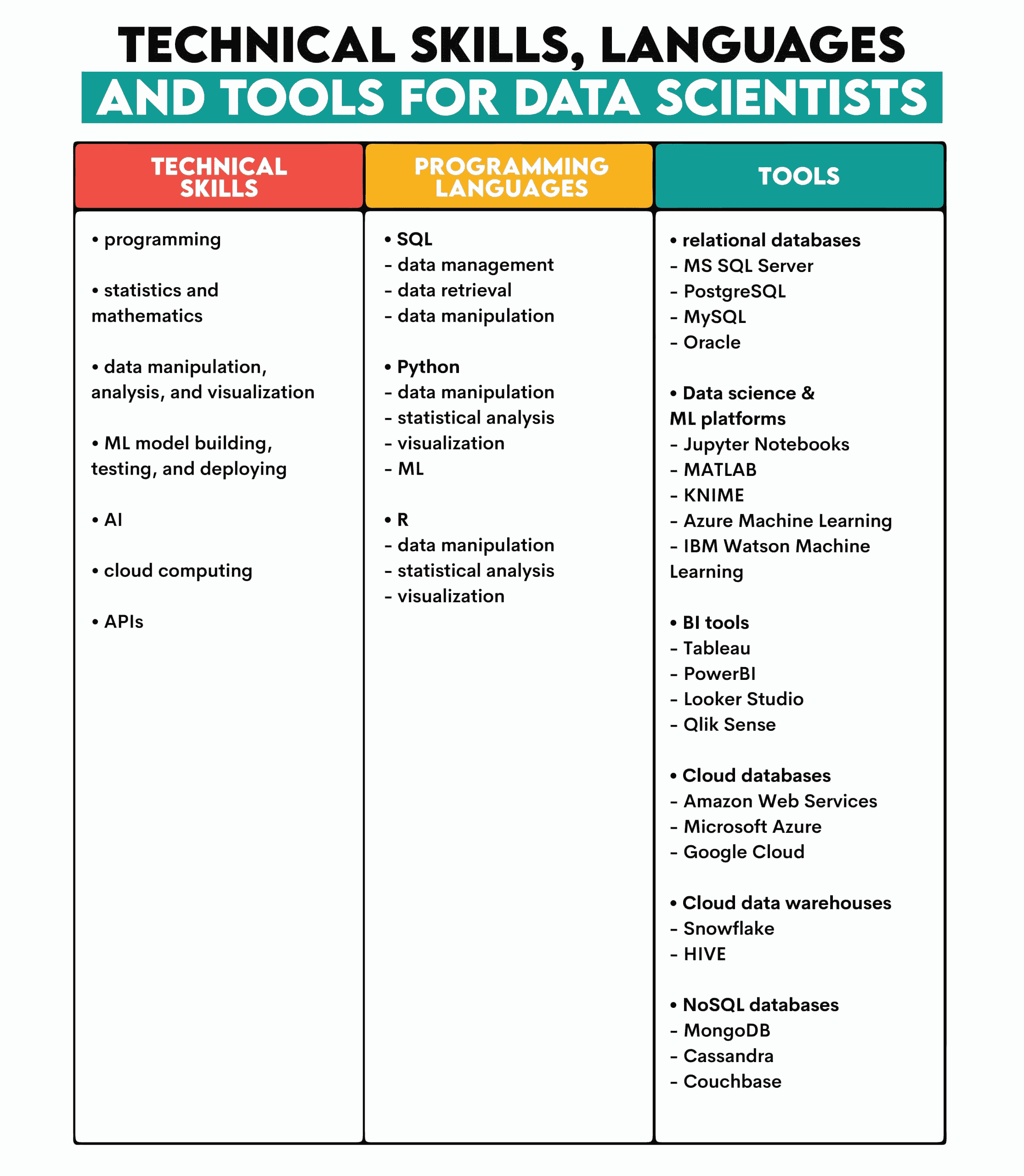

2. 技能

数据科学家的技能可以分为技术技能和软技能。

技术技能

这些任务来源于首席数据科学家的工作:提取和处理数据,构建、测试和部署机器学习模型。

数据科学家必须使用各种编程语言和工具将所有这些知识付诸实践。

下面是一个概述。

这应该是你进一步专业化的起点。例如,你可以专注于 BI 工具或数据工程工具,如Apache Kafka、Apache Spark、Talend、Airflow等。

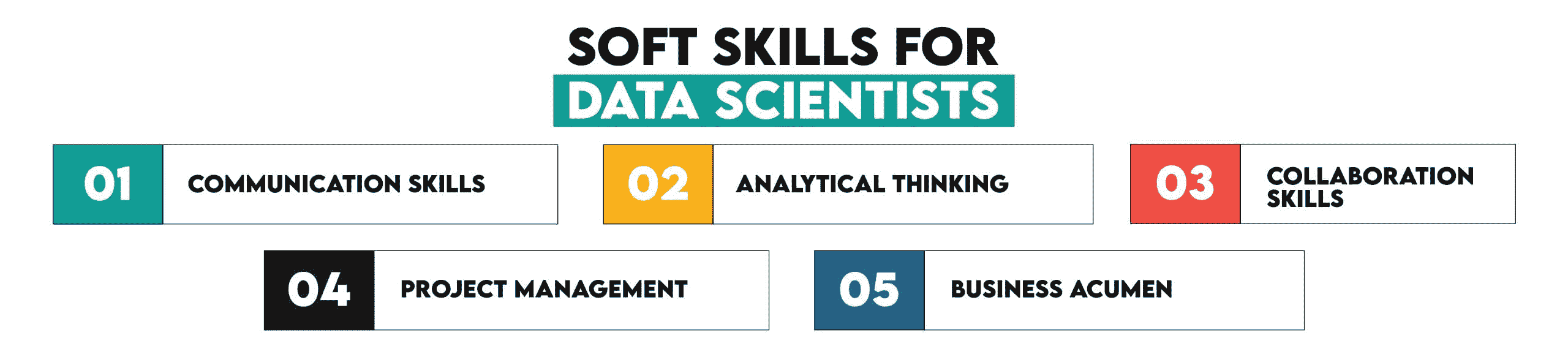

软技能

技术技能需要以下软技能的补充。

沟通技能

这些技能包括既倾听他人的想法也传达自己的想法。

作为数据科学家的工作始于倾听他人的问题。你是那种通过数据帮助他人解决问题的心理治疗师。数据治疗师?通过理解商业问题,你可以将你的技术解决方案塑造成用户的需求。

数据科学家还必须能够将其工作的技术复杂性转化为非技术受众能够理解的内容。他们借助于可视化工具,即有效地可视化和展示你的工作是强制性的。

分析思维

你需要解决的商业问题通常会以非常非技术性的方式向你解释:“天啊,我们的客户留存率直线下降!救命啊!你,数据科学家,想办法解决这个问题。”

这需要将问题分解成逻辑块并系统性地解决。同时,需要创意,因为许多问题需要找到新颖的解决方案。

协作技能

数据科学家的理想工作日是被独自留在一旁,专注于自己的模型,并低声对其讲话(用咕噜的声音): 这是我的,我告诉你。我的。我的珍宝。是的,我的珍宝。

不幸的是,数据科学家常常需要与数据团队的其他同事合作。项目还包括跨部门团队。

适应性和灵活性,创造良好的工作氛围,有效且尊重地解决冲突?是的,我的珍宝!

项目管理

从事数据科学项目需要项目管理能力,包括任务优先级排序、协调项目团队以及跟踪项目进度和截止日期。

加上指导初级员工和在多个项目之间转换,这项技能变得至关重要。

商业敏锐性

所有数据项目的设计都是为了解决商业问题。要做到这一点,你需要对公司业务和行业有扎实的理解。这使得理解商业问题并设计考虑到可能未明确提及的依赖关系的解决方案变得更容易。

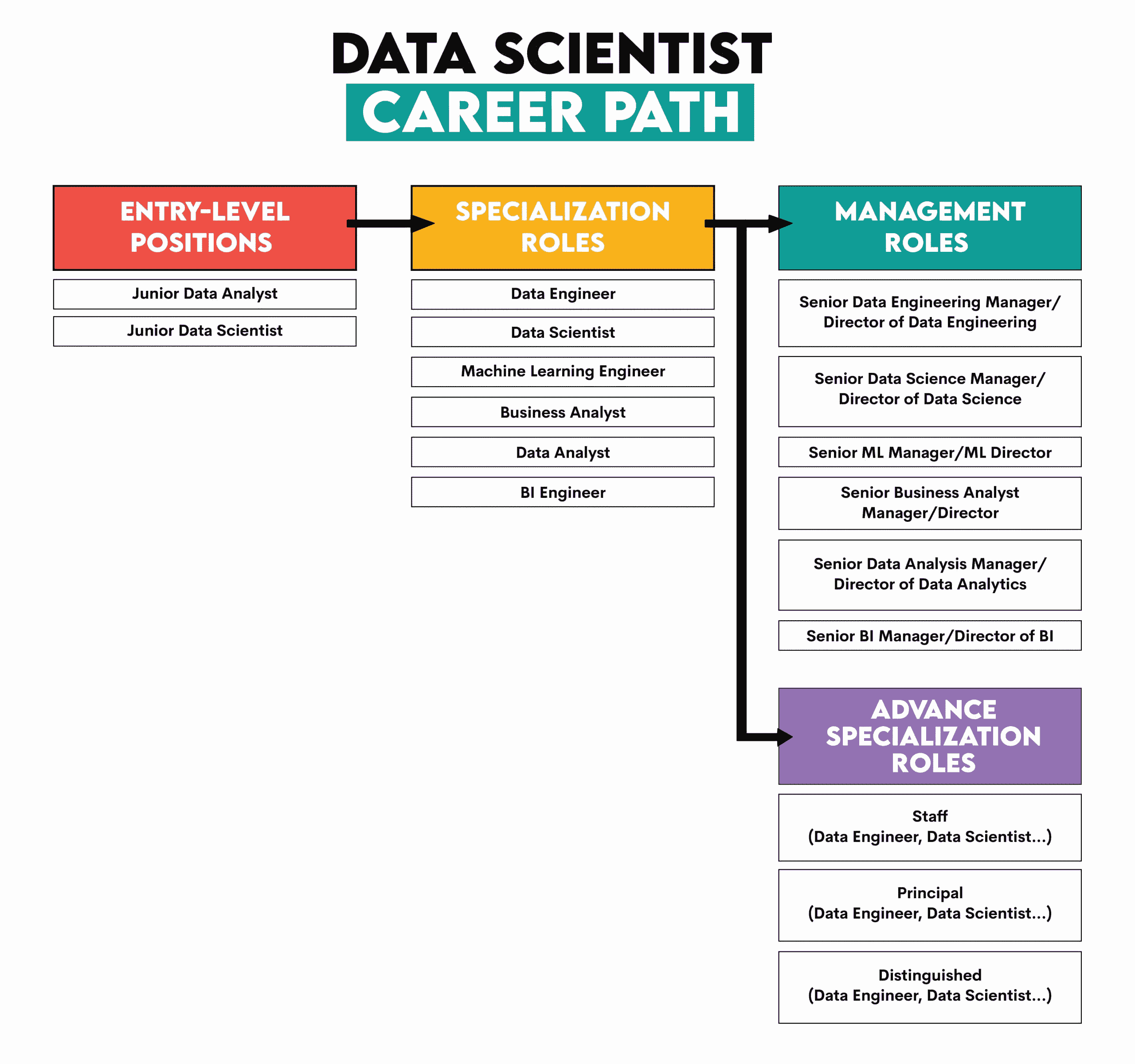

3. 职业路径和薪资

数据科学职业通常以获得初级数据分析师或初级数据科学家职位开始。

从这里,我建议你进入专业角色之一。一些例子包括数据工程师、机器学习工程师、业务分析师、数据分析师或 BI 工程师。如今的数据科学家职位也越来越成为一个专业角色——更多关注于数据探索和初步模型开发中的统计应用,而不是做端到端的项目。

根据你在特定专业职位上的年限和兴趣,你可以走两个不同的方向:管理角色或高级专业角色。

例如,管理角色可能包括之前提到的任何领域的高级经理或总监。这条路径会让你远离技术工作,管理人员和部门将成为你的核心工作。

另一种选择是继续作为个人贡献者,进一步深入你的专业领域。这些是高级专业角色。对于提到的任何专业领域,职位通常是员工、首席、杰出和研究员。

4. 薪资

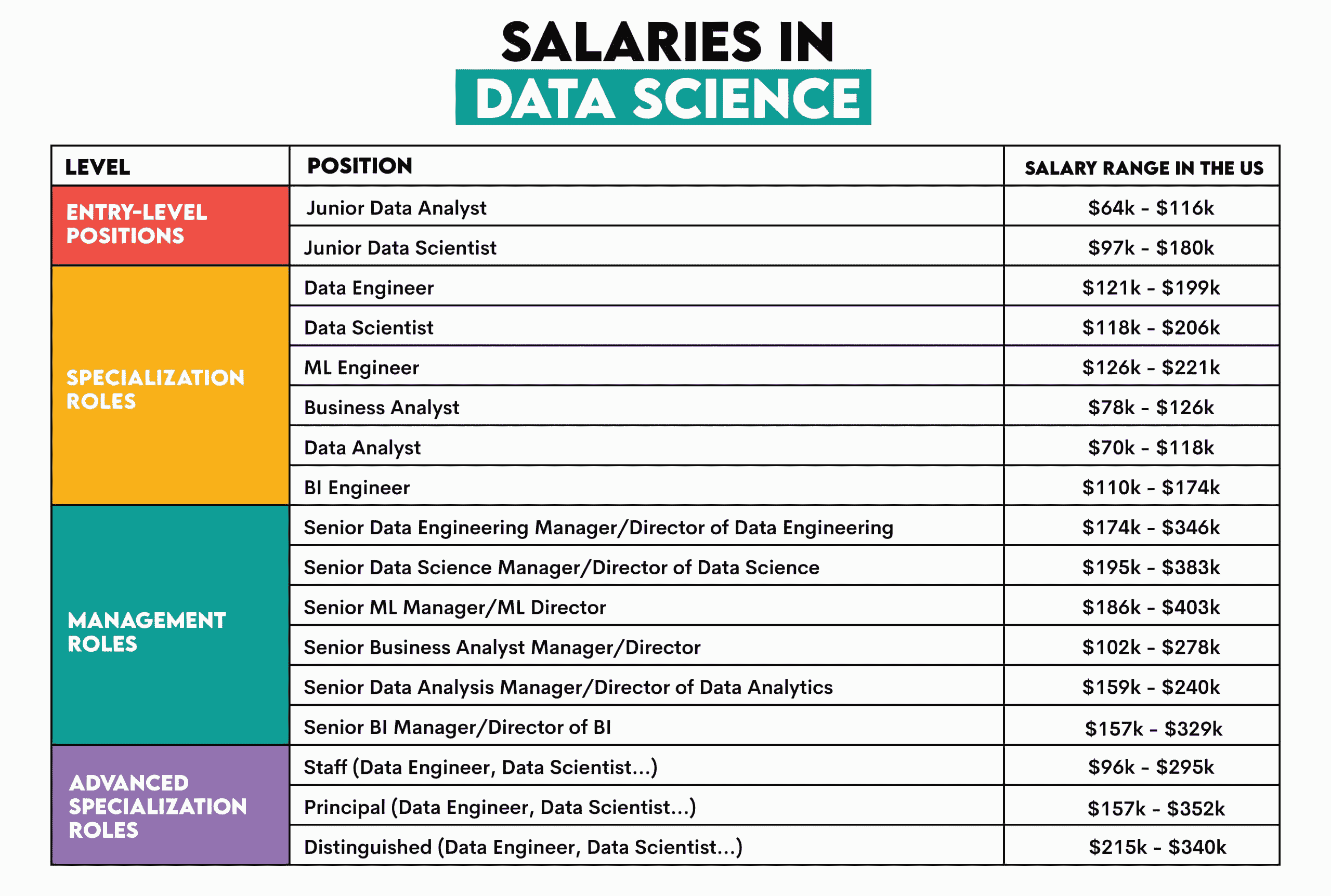

数据科学仍然是一个薪资非常高的职业。在选择职业道路时,不应忽视这一点。以下是之前提到的角色的薪资概览。

作者提供的图像,薪资数据来源: Glassdoor

5. 找工作

现在的问题是如何从学习数据科学过渡到赚取这些钱,也就是找工作。

我如果说:“找到你喜欢的职位广告,申请,面试表现出色,找到工作。”这并不会说什么新话。就这样,别客气!

然而,有两件事可以让你与其他申请者区别开来:

-

一个出色的作品集

-

面试经验

一个出色的作品集意味着拥有大量与工作相关的数据项目。数据项目是全面构建和展示你数据科学技能的最佳方式,因为完成这些项目需要高度的各项技能。当然,你也可以做一些专注于特定技能的专业项目,例如机器学习、数据工程等。

面试经验可以通过两种方式获得。第一种是面试失败很多次之后才找到工作。这是我们很多人经历过的正当方式。我不是开玩笑;获得经验让你更习惯面试过程、方法、测试主题,尤其是在时间压力下的编码。

然而,还有一种不那么痛苦的方式可以实现同样的目标:在提供实际编码和其他技术面试问题的*台上解决这些问题。

结论

虽然现在看起来可能不太明显,但现在正是进入数据科学领域的最佳时机。有两个原因。首先,如果你正在考虑开始数据科学教育,那么就去做吧。这需要一些时间。等你完成时,数据科学可能会再次蓬勃发展。

其次,如果你已经具备所有要求,尽管裁员频繁,也要申请那些职位,因为有很多这样的职位。

尽管经历了许多动荡,让我们记住数据科学仍然是最有吸引力的工作之一。

内特·罗西迪是一位数据科学家和产品策略专家。他还是一位兼职教授,教授分析学,并且是 StrataScratch 的创始人,该*台帮助数据科学家通过来自顶尖公司的真实面试题准备面试。内特撰写有关职业市场最新趋势的文章,提供面试建议,分享数据科学项目,并涵盖所有关于 SQL 的内容。

更多相关主题

分类的最*邻

原文:

www.kdnuggets.com/2022/04/nearest-neighbors-classification.html

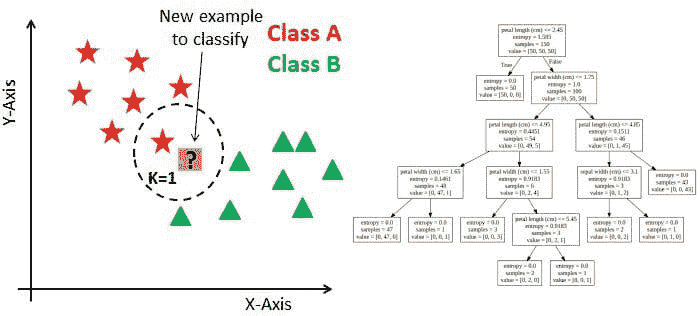

K-最*邻

K-最*邻(KNN)是一种监督学习机器学习算法,用于回归和分类任务。

我们的前 3 个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

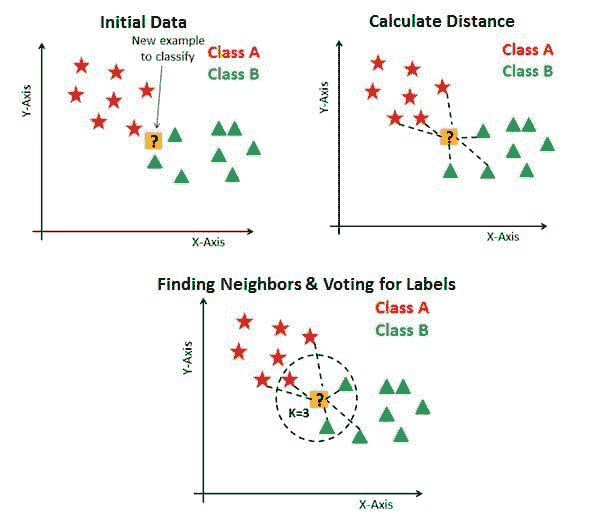

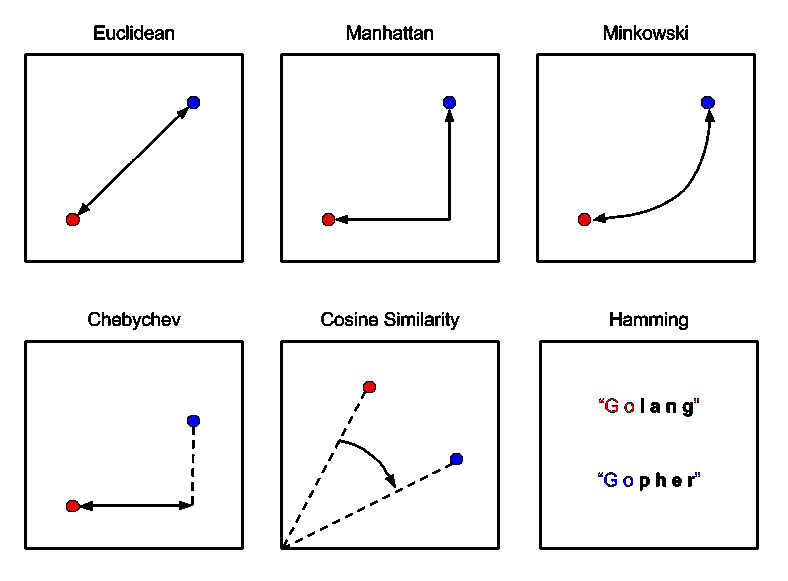

KNN 用于基于当前训练数据点的特征对测试数据集进行预测。这是通过计算测试数据与训练数据之间的距离来完成的,假设相似的事物在较*的距离内存在。

该算法将存储学习到的数据,使其在预测和分类新数据点时更为有效。当输入一个新数据点时,KNN 算法将学习其特征。然后,它会将新数据点放置在与具有相同特征或特征的当前训练数据点更接*的位置。

KNN 中的 ‘k’ 是什么?

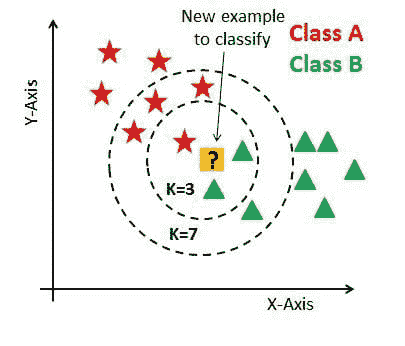

KNN 中的 ‘K’ 是一个参数,表示最*邻居的数量。K 是一个正整数,通常值较小,建议为奇数。

通俗地说,K 值为数据点创建了一个环境。这使得分配数据点所属的类别变得更加容易。

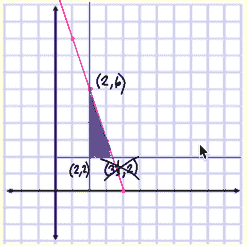

以下示例显示了 3 个图表。第一个图表,“初始数据”是一个将数据点绘制并分类到各个类别中的图表,并且有一个新的示例需要分类。在“计算距离”图表中,计算了新示例数据点到最*训练数据点的距离。然而,这仍然不能对新示例数据点进行分类。因此,使用 k 值,本质上创建了一个邻域,我们可以在其中对新示例数据点进行分类。

我们会说 k=3,新数据点将属于 B 类,因为与 A 类相比,更多的训练过的 B 类数据点具有与新数据点相似的特征。

来源:datacamp.com

如果我们将 k 值增加到 7,我们将看到新数据点将属于 A 类,因为与 B 类相比,更多的训练过的 A 类数据点具有与新数据点相似的特征。

来源: datacamp.com

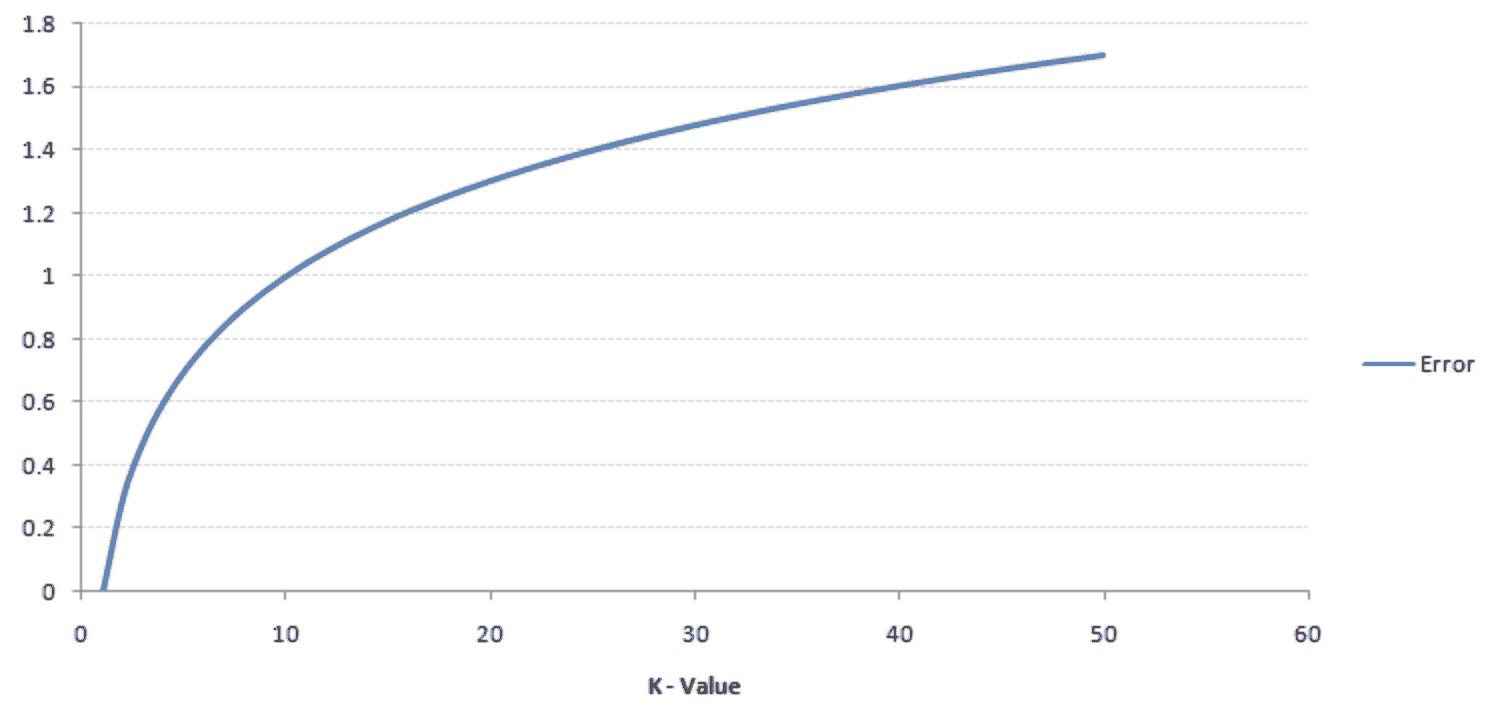

k 值通常是一个较小的数字,因为随着 k 值的增加,误差率也会增加。下图展示了这一点:

来源: analyticsvidhya

然而,如果 k 值较小,则会导致低偏差但高方差,导致模型过拟合。

还建议 k 值是奇数。这是因为如果我们尝试对一个新数据点进行分类,而类别/类的数量只有偶数(例如,A 类和 B 类),可能会产生不准确的结果。因此,强烈建议选择一个奇数的 K 值以避免*局。

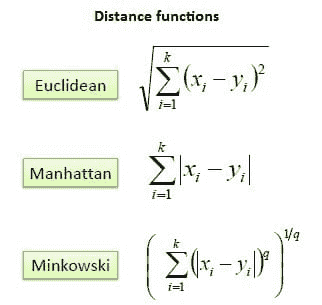

计算距离

KNN 通过计算数据点之间的距离来对新数据点进行分类。在 KNN 中,计算这种距离的最常见方法是欧几里得距离、曼哈顿距离和闵可夫斯基距离。

欧几里得距离是使用两点之间的线段长度来表示的距离。欧几里得距离的公式是新数据点(x)与现有已训练数据点(y)之间差异*方和的*方根。

曼哈顿距离是两点之间的距离,是它们的笛卡尔坐标的绝对差值的总和。曼哈顿距离的公式是新数据点(x)与现有已训练数据点(y)之间的长度总和,使用坐标轴上的线段。

闵可夫斯基距离是规范化向量空间中两点之间的距离,是欧几里得距离和曼哈顿距离的一般化。在闵可夫斯基距离的公式中,当 p=2 时,我们得到欧几里得距离,也称为 L2 距离。当 p=1 时,我们得到曼哈顿距离,也称为 L1 距离、城市街区距离和 LASSO。

下图是公式:

下图解释了三者之间的区别:

来源: Packt 订阅

KNN 算法如何工作?

以下是 KNN 算法工作的步骤:

-

加载你的数据集

-

选择一个 k 值。建议选择奇数以避免*局。

-

计算新数据点与邻*的已训练数据点之间的距离。

-

找到与新数据点最*的 K 个邻居

以下是一个概述这些步骤的图像:

来源: kdnuggets.com

KNN 算法分类实现

我将通过一个使用鸢尾花数据集进行分类任务的 KNN 算法示例来演示。

导入库

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

载入鸢尾花数据集

url = "https://archive.ics.uci.edu/ml/machine-learning-databases/iris/iris.data"

# Assign the column namesnames = ['sepal-length', 'sepal-width', 'petal-length', 'petal-width', 'Class']

# Read the dataset in

dataset = pd.read_csv(url, names=names)

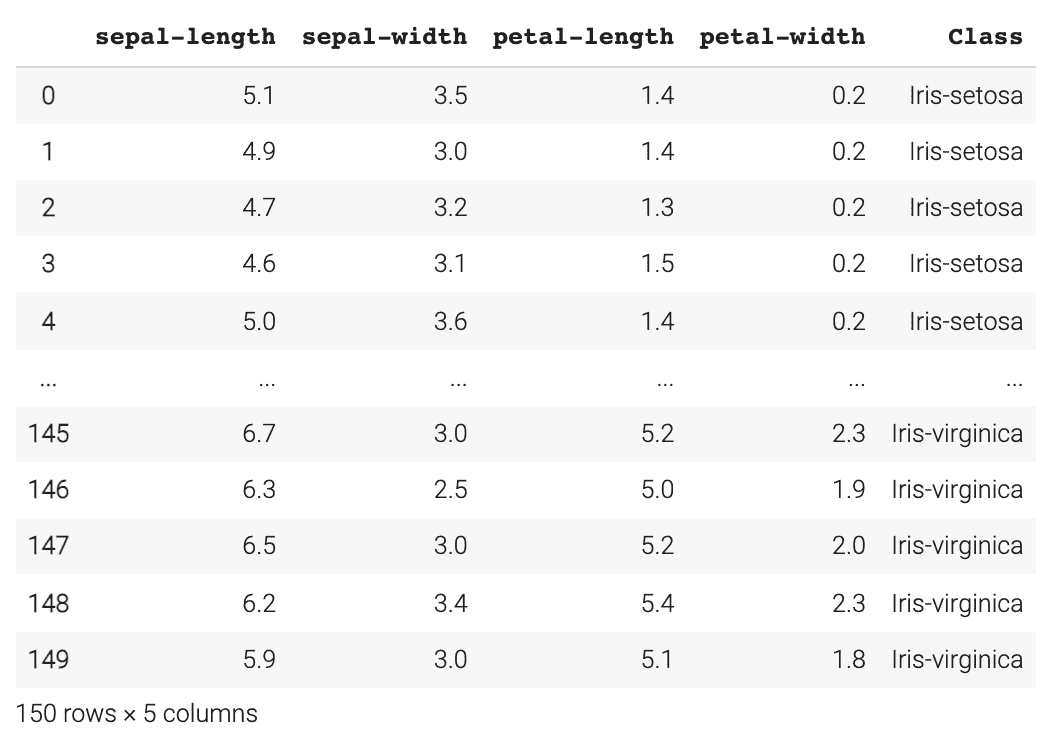

dataset

数据预处理

我们需要将数据集分成属性和标签。变量 X 将包含数据集的前四列,我们称之为属性;变量 y 将包含最后一列,我们称之为标签。

X = dataset.iloc[:, :-1].values

y = dataset.iloc[:, 4].values

训练测试分离

在这一步中,我们将数据集分为训练集和测试集。这让我们了解算法在训练数据上的学习效果以及在测试数据上的表现。

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.20)

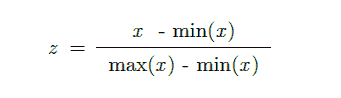

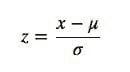

特征缩放

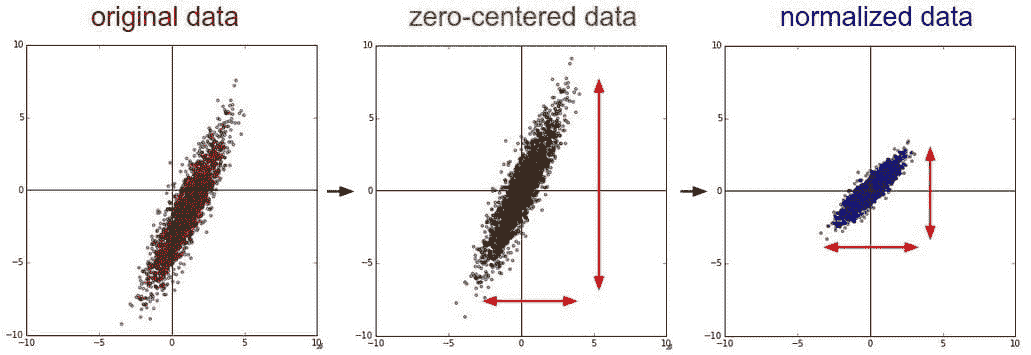

特征缩放是在进行预测之前对数据进行预处理的重要步骤。这种方法用于归一化数据的特征范围。

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

scaler.fit(X_train)

X_train = scaler.transform(X_train)

X_test = scaler.transform(X_test)

使用 KNN 进行预测

首先,我们需要从 sklearn.neighbors 库中导入 KNeighborsClassifier 类。然后选择我们的 k 值,在这个例子中,我选择了 7。请记住,强烈建议选择一个奇数值以避免出现*局。

from sklearn.neighbors import KNeighborsClassifier

classifier = KNeighborsClassifier(n_neighbors=7)

classifier.fit(X_train, y_train)

然后我们开始对测试数据集进行预测。

y_pred = classifier.predict(X_test)

算法的准确率

使用 sklearn.metrics,我们可以使用 classification_report 评估算法的准确性,查看精确率、召回率和 F1 分数。

from sklearn.metrics import classification_report

print(classification_report(y_test, y_pred))

这是输出的样子:

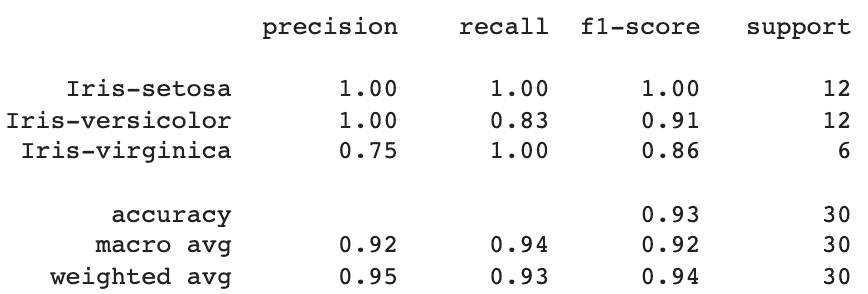

从这里我们可以看到 KNN 算法对 30 个数据点进行了分类,精确率*均达到了 95%,召回率为 93%,F1 分数为 94%。

寻找合适的 k 值

在这个例子中,我选择了 k 值为 7。然而,如果我们想要检查最佳的 k 值是多少,我们可以生成一个显示不同 k 值和其产生的误差率的图表。

我将查看 k 值在 1 到 30 之间的情况。在每次迭代中,计算*均误差并将其添加到误差列表中。

error = []

# Calculating the error rate for K-values between 1 and 30

for i in range(1, 30):

knn = KNeighborsClassifier(n_neighbors=i)

knn.fit(X_train, y_train)

pred_i = knn.predict(X_test)

error.append(np.mean(pred_i != y_test))

绘制 k 值与错误率图:

plt.figure(figsize=(12, 5))

plt.plot(range(1, 30), error, color='red', marker='o',

markerfacecolor='yellow', markersize=10)

plt.title('Error Rate K Value')

plt.xlabel('K Value')

plt.ylabel('Mean Error')

图的输出:

来源:作者图片

从这个图表中,我们可以看到产生*均误差为 0 的 k 值主要在 k 值为 13 到 23 之间。

摘要

KNN 是一个简单易用的算法,可用于回归和分类任务。K 值是一个参数,表示最*邻的数量。建议选择一个奇数作为 k 值。有不同的距离度量标准可用,但最常见的是欧氏距离、曼哈顿距离和闵可夫斯基距离。

尼莎·阿利亚 是一位数据科学家和自由职业技术作家。她特别感兴趣于提供数据科学职业建议或教程,以及围绕数据科学的理论知识。她还希望探索人工智能在延长人类寿命方面的不同方式。作为一个热衷学习者,她寻求拓宽自己的技术知识和写作技能,同时帮助引导他人。

相关话题

我们是否需要*衡采样?

作者:朱炳(四川大学)、巴特·贝森斯(鲁汶大学)& 塞佩·范登·布鲁克(鲁汶大学)。

在许多实际分类任务中,如流失预测和欺诈检测,我们经常遇到类别不*衡问题,即一个类别的样本显著少于另一个类别。类别不*衡问题给标准分类学习算法带来了很大的挑战。大多数算法在不*衡数据集上往往更容易将少数类样本误分类为多数类样本。例如,当模型在一个少数类样本占比 1%的数据集上训练时,通过将所有样本都分类为多数类,可以简单地实现 99%的准确率。确实,学习不*衡数据集的问题被认为是数据挖掘研究中的十大挑战性问题之一。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业道路。

1. Google 网络安全证书 - 快速进入网络安全职业道路。

2. Google 数据分析专业证书 - 提升你的数据分析技能。

2. Google 数据分析专业证书 - 提升你的数据分析技能。

3. Google IT 支持专业证书 - 为你的组织提供 IT 支持。

3. Google IT 支持专业证书 - 为你的组织提供 IT 支持。

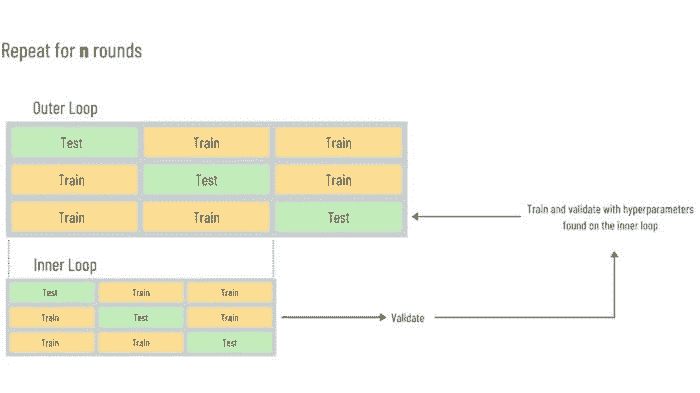

为了解决从不*衡数据集中学习的问题,*年来提出了许多解决方案。重采样方法试图通过重采样数据来解决问题,并作为预处理阶段。它们的使用假设与分类器无关,并且可以应用于任何学习算法。因此,重采样解决方案在实际应用中非常受欢迎。使用重采样时,一个重要的问题是我们是否真的需要一个完全*衡的数据集。我们的流失预测研究表明,*衡采样并非必要。

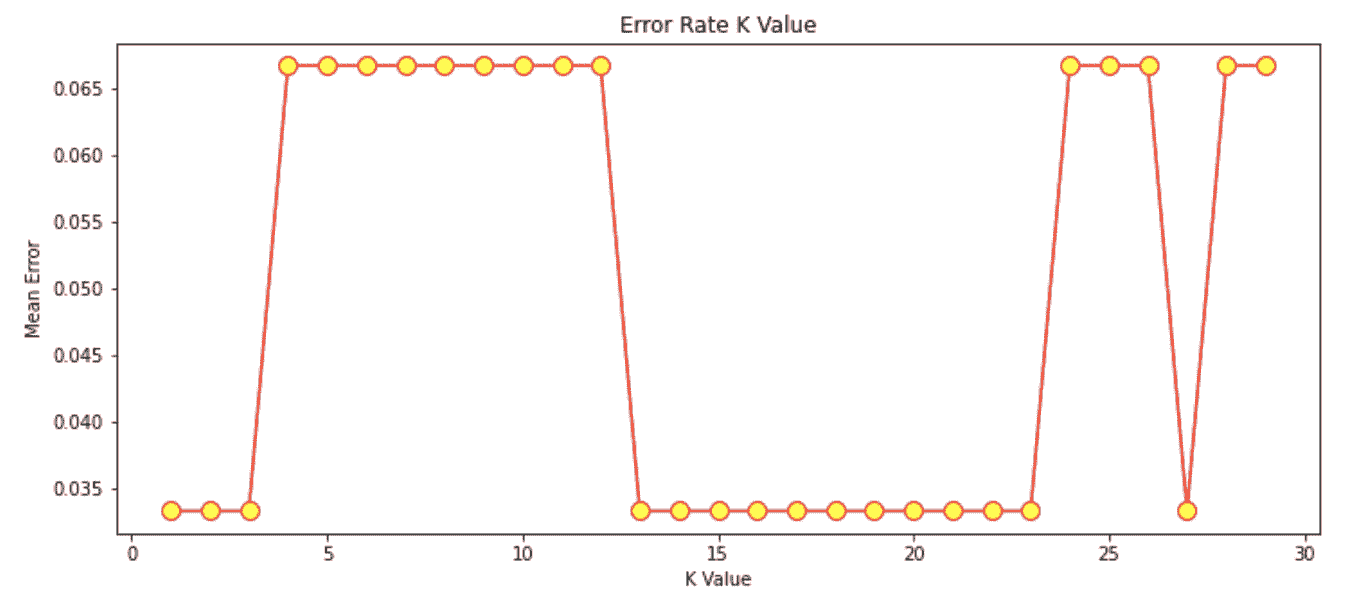

我们在实验中使用了来自电信行业的 11 个真实数据集。考虑了七种采样方法,包括随机过采样、随机欠采样、SMOTE 采样等。我们考虑了三种不同的类别比例设置:1:3、2:3 和 1:1(少数类与多数类)。实验中使用了四种基准分类器:逻辑回归、C4.5 决策树、支持向量机(SVM)和随机森林(RF),这些在流失预测中被广泛使用。下表显示了部分结果,使用了 5 × 2 交叉验证实验设置,其中每个条目表示不同分类器和采样方法下每个采样比例的*均性能。除了 AUC 衡量标准外,我们还考虑了最大利润衡量标准,它测量了保留活动产生的利润(Verbraken et al., 2013)。

表 1:来自电信行业的不*衡数据集的实验结果

正如表格所示,在两个数据集上,1:3 的比例效果最好,而 2:3 的比例在两个数据集上排名第一。*衡类别比例从未达到最佳位置。结果明确显示,采样后没有必要生成*衡的数据集,推荐使用不太*衡的策略(1:3),因为它的表现相对较好。完整的结果和更多讨论可以在我们最*发表的论文《不*衡学习中采样技术的基准测试》中找到,该论文发表于 JORS。

参考文献:

-

H. He, E. Garcia, “从不*衡数据中学习”,《IEEE 知识与数据工程学报》,2009,21(9):1263-1284。

-

W. Verbeke, K. Dejaeger, D. Martens, J. Hur, B. Baesens, “电信行业流失预测的新见解:一种以利润驱动的数据挖掘方法”,《欧洲运筹学杂志》,2012,218(1):211-229。

-

T. Verbraken, W. Verbeke, B. Baesens, “一种新颖的利润最大化度量用于衡量客户流失预测模型的分类性能”,《IEEE 知识与数据工程学报》,2013,25(5),961-973,2013。

-

B. Zhu, B. Baesens, A. Backiel, S. vanden Broucke,“流失预测中不*衡学习的采样技术基准测试”,《运筹学学会杂志》,2017。

朱冰 是中国四川大学商学院的副教授。他的主要研究兴趣包括流失预测和欺诈检测。

巴特·贝森斯 是比利时鲁汶大学(KU Leuven)的大数据与分析学教授。他在大数据和分析方面进行了广泛的研究。他的研究成果已发表在知名国际期刊上,并在国际顶级会议上进行过展示。

塞佩·范登·布鲁克 现任比利时鲁汶大学(KU Leuven)决策科学与信息管理系助理教授。塞佩的研究兴趣包括商业数据挖掘与分析、机器学习、过程管理和过程挖掘。

相关文章:

-

构建预测流失模型的挑战

-

初学者指南:客户分群

-

在 CRISP-DM 中修复部署和迭代问题

更多关于此主题的内容

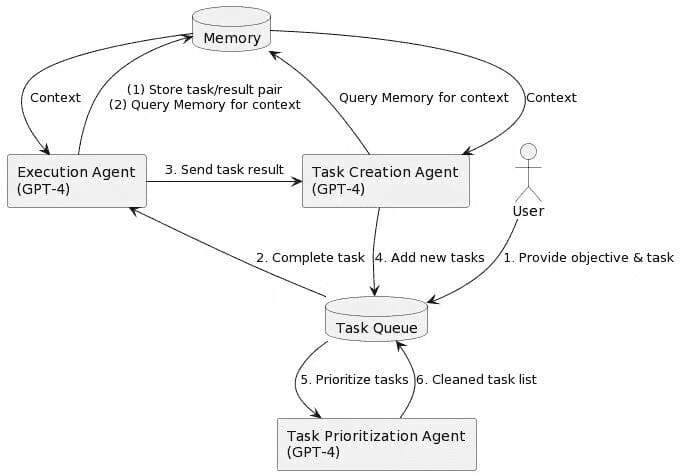

为什么你需要了解自主 AI 代理

原文:

www.kdnuggets.com/2023/06/need-know-autonomous-ai-agents.html

图片由 Bing 图像生成器提供

让我们从显而易见的开始——AI。人工智能是计算机使用数据、机器学习等来执行通常由人类完成的任务的能力。你可以使用 AI 创建内容、回答问题和生成逼真的艺术作品。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT 工作