KDNuggets-博客中文翻译-二十-

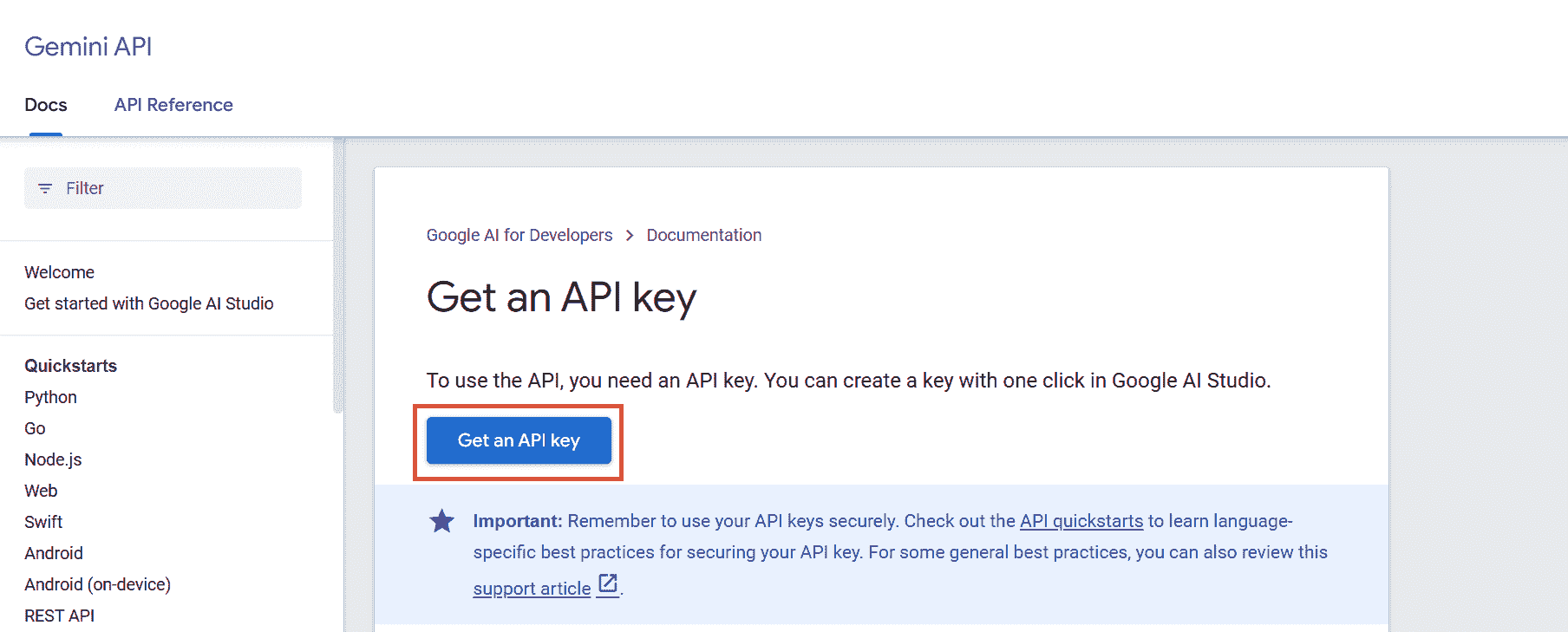

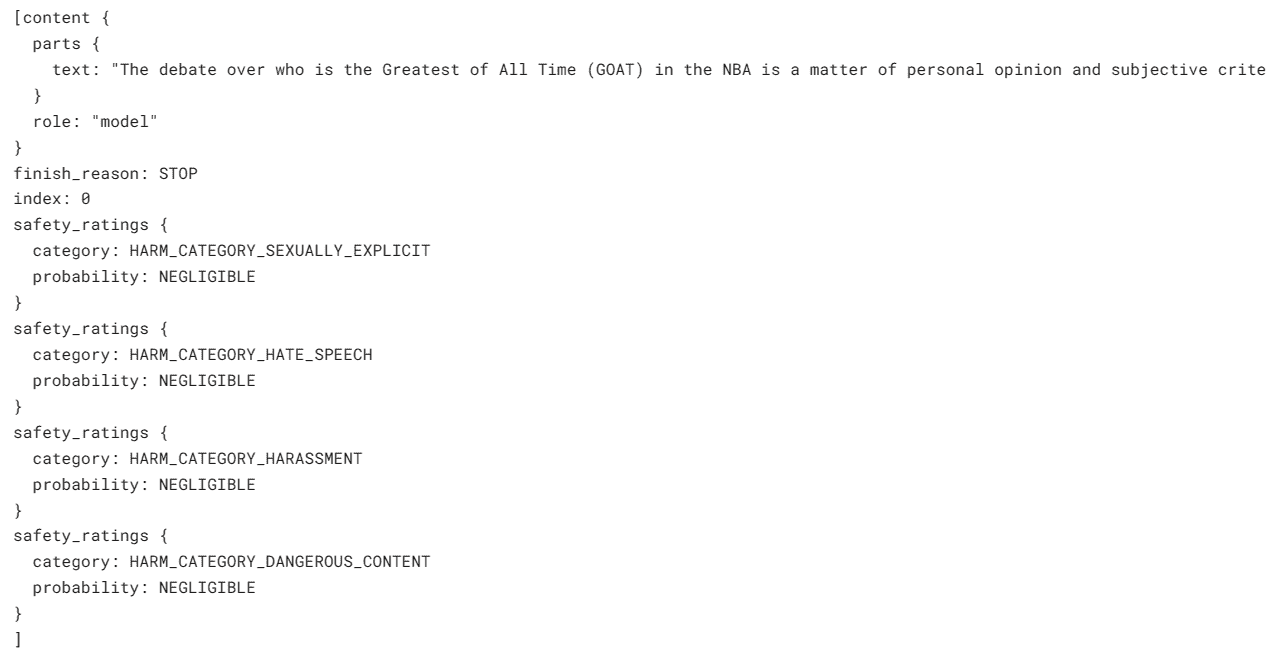

KDNuggets 博客中文翻译(二十)

原文:KDNuggets

《自然语言生成综合指南》

原文:

www.kdnuggets.com/2020/01/guide-natural-language-generation.html

评论

由 Sciforce 提供。

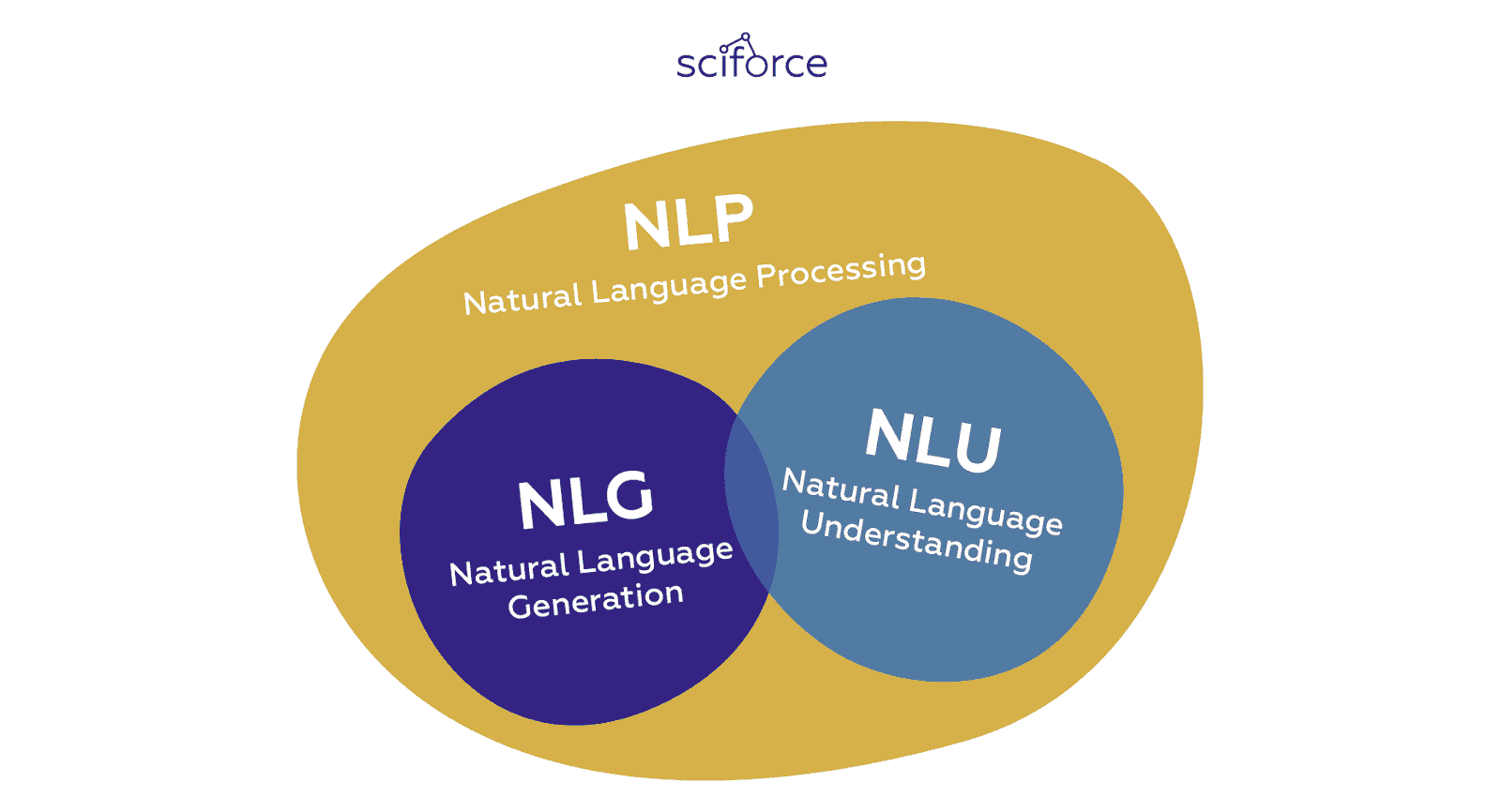

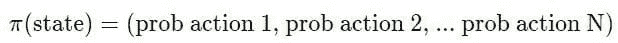

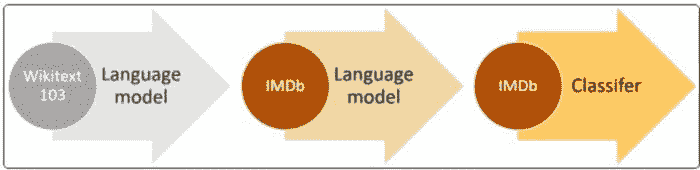

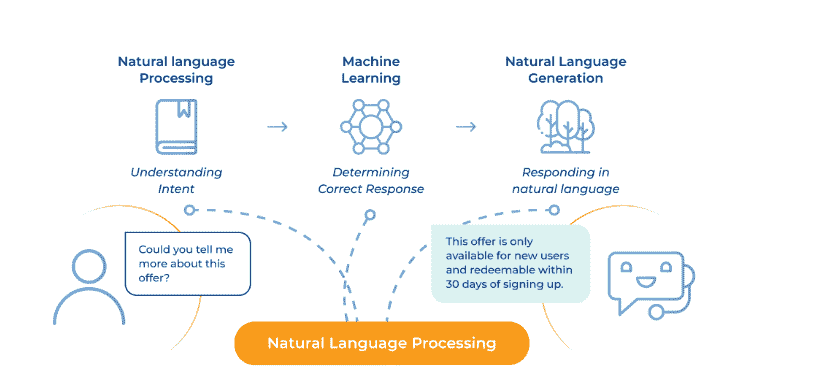

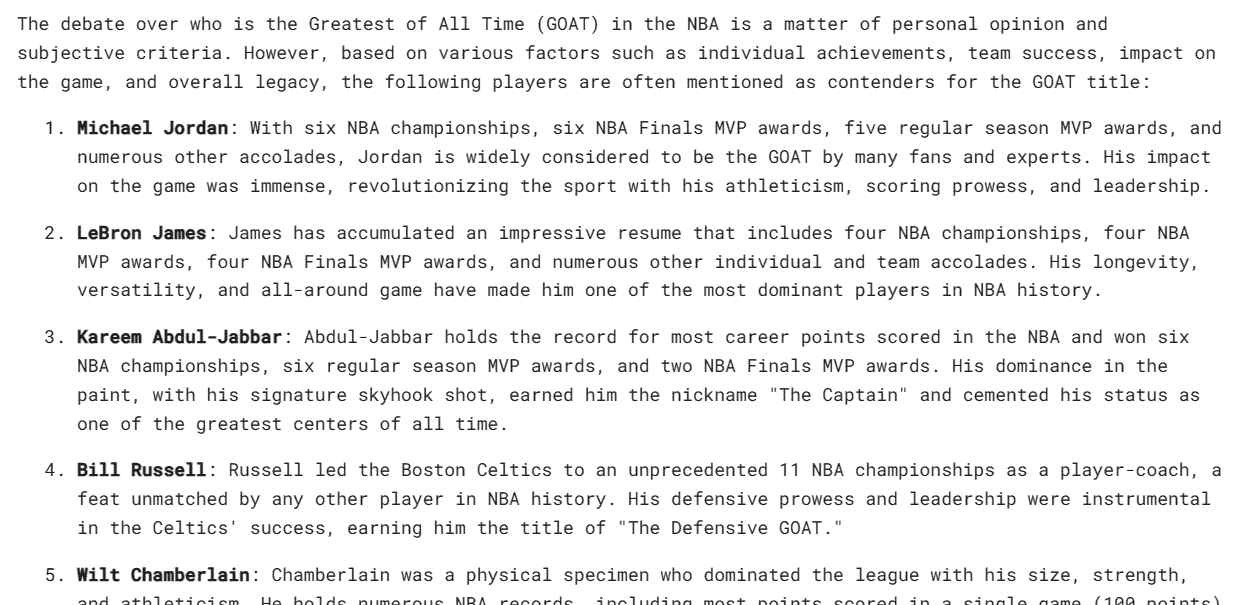

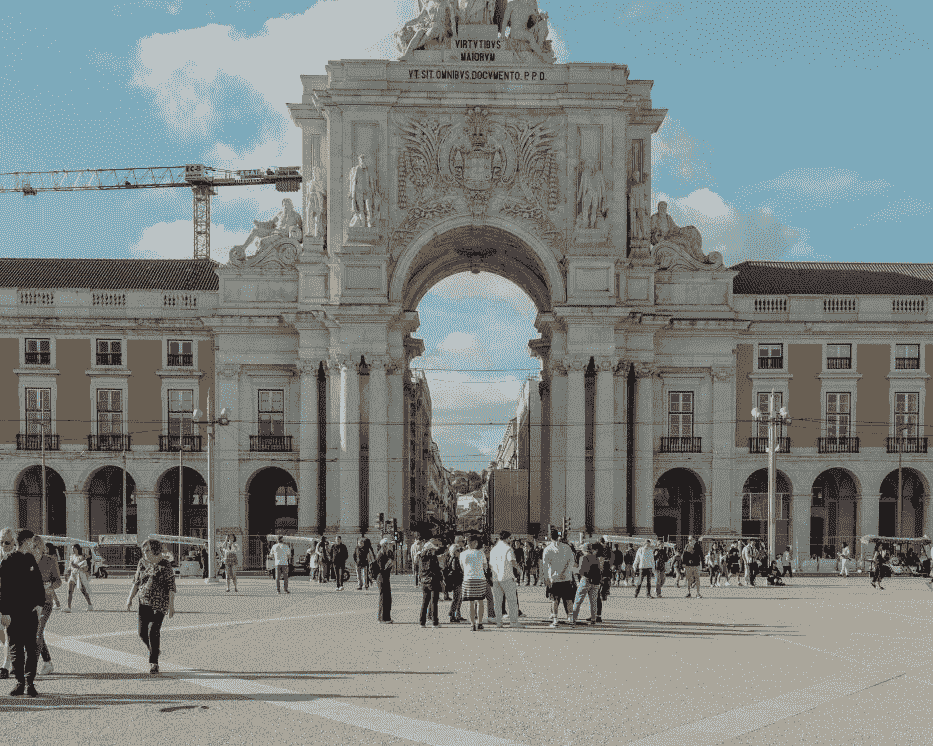

只要人工智能帮助我们从自然语言中获得更多信息,我们就会看到更多在 AI 和语言学交集处出现的任务和领域。在我们之前的一篇文章中,我们讨论了Natural Language Processing 和 Natural Language Understanding 的区别。然而,这两个领域都有自然语言作为输入。同时,与计算机建立双向通信的需求导致了处理生成(准)自然语言的任务的一个独立子类别的出现。这个子类别被称为自然语言生成,将成为本博客文章的重点。

什么是 NLG?

自然语言生成,如《人工智能:自然语言处理基础》所定义,是“以自然语言形式生成有意义的短语和句子的过程。”本质上,它以每秒数千页的速度自动生成描述、总结或解释输入结构化数据的叙述。

然而,虽然 NLG 软件可以写作,但它不能阅读。阅读自然语言并将其非结构化数据转化为计算机可理解的结构化数据的 NLP 部分被称为自然语言理解。

一般而言,NLG(自然语言生成)和 NLU(自然语言理解)是更广泛的 NLP 领域的子部分,该领域包括所有解释或生成自然语言的软件,无论是口头还是书面形式:

-

NLU 负责基于语法、上下文以及意图和实体的理解数据。

-

NLP 将文本转换为结构化数据。

-

NLG 基于结构化数据生成文本。

NLG 的主要应用

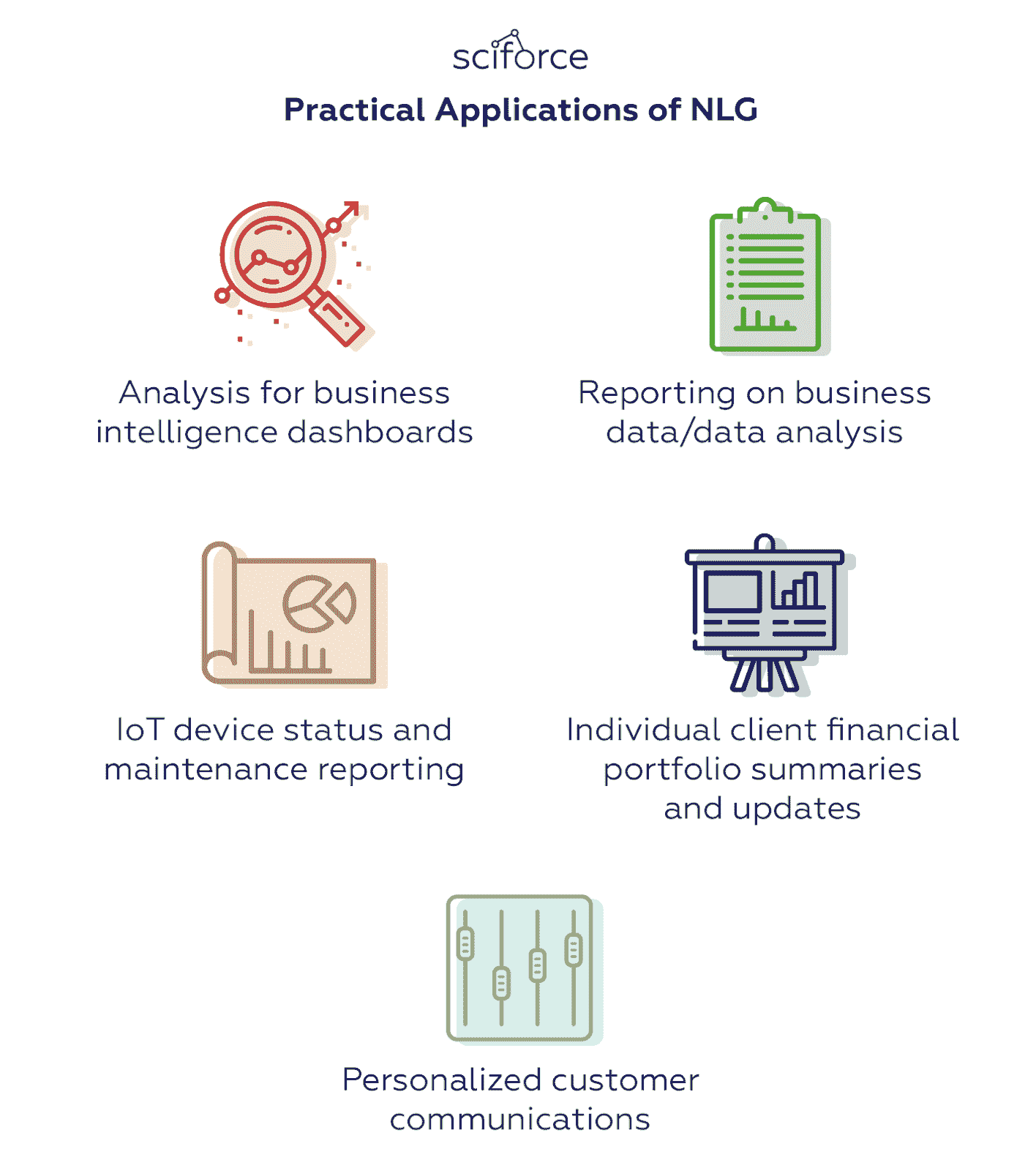

NLG 使数据具有普遍可理解性,使得编写数据驱动的财务报告、产品描述、会议备忘录等变得更加容易和快速。理想情况下,它可以将总结数据的负担从分析师那里转移到自动编写针对受众的报告上。因此,NLG 当前的主要实际应用与写作分析或向客户传达必要信息相关:

NLG 的实际应用。

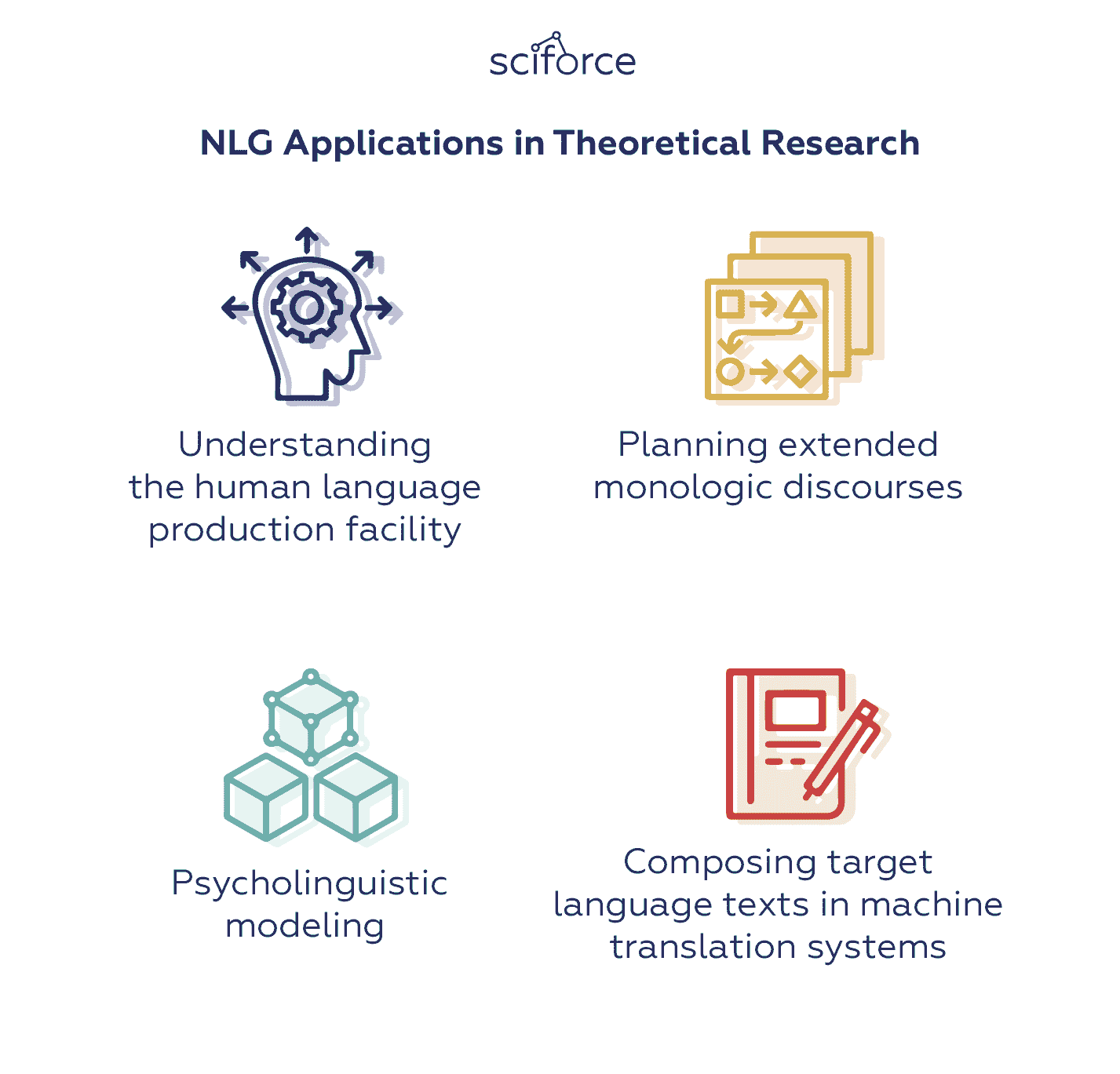

与此同时,NLG 还有更多的理论应用,使其不仅在计算机科学与工程领域,而且在认知科学和心理语言学中成为有价值的工具。这些包括:

NLG 在理论研究中的应用。

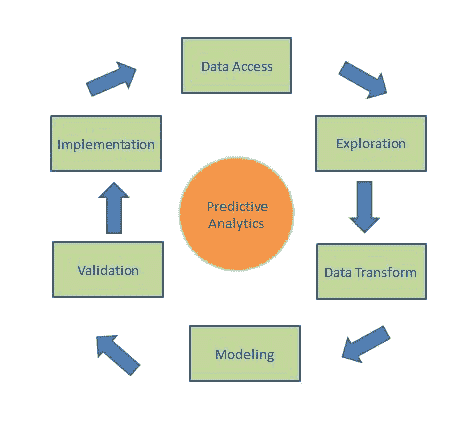

NLG 设计与架构的演变

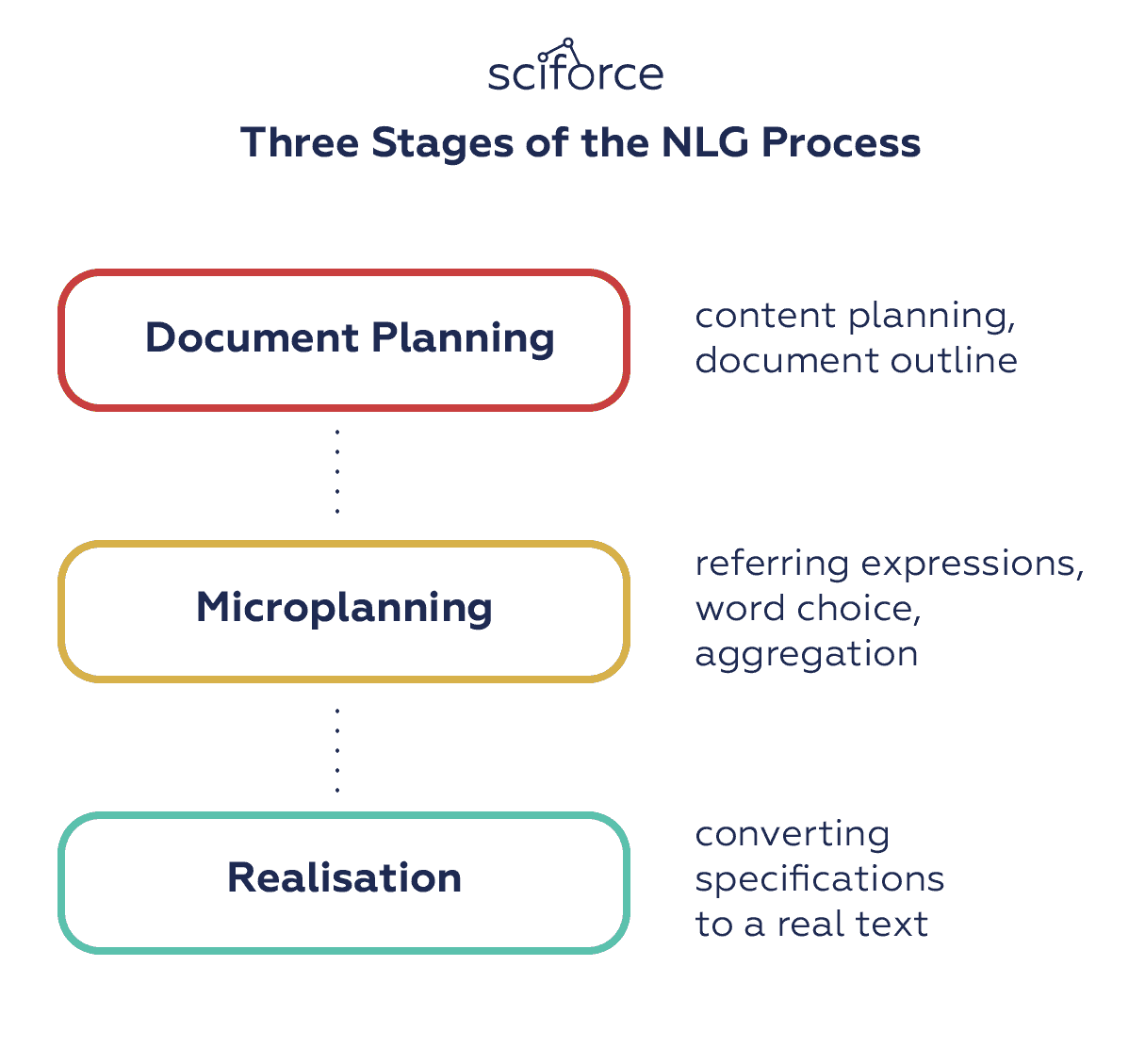

在模仿人类语言的尝试中,NLG 系统使用了不同的方法和技巧来根据观众、背景和叙述目的调整其写作风格、语气和结构。在 2000 年,Reiter 和 Dale 设计了一个 NLG 架构,将 NLG 过程划分为三个阶段:

-

文档规划:决定要表达的内容,并创建一个概述信息结构的抽象文档。

-

微观规划:生成引用表达、词汇选择和聚合,以充实文档规格。

-

实现:将抽象文档规格转换为真实文本,使用有关语法、形态学等的领域知识。

NLG 过程的三个阶段。

这个流程展示了自然语言生成的里程碑。然而,具体步骤和方法,以及所使用的模型,随着技术的发展可能会有显著变化。

语言生成有两种主要方法:使用模板和动态创建文档。虽然只有后者被认为是“真实”的 NLG,但从基础的简单模板到最先进技术的过程中经历了漫长而多阶段的演变,每一种新方法都扩展了功能并增加了语言能力:

简单的填空方法

最古老的方法之一是简单的填空模板系统。在结构预定义且只需少量数据填充的文本中,这种方法可以自动从电子表格行、数据库表条目等中填充这些空白。原则上,你可以变更文本的某些方面:例如,你可以决定是拼写数字还是保留原样,这种方法的使用相当有限,不被认为是“真实”的 NLG。

脚本或规则生成文本

基础的填空系统通过脚本语言或使用业务规则扩展了通用编程构造。脚本方法,如使用网页模板语言,将模板嵌入通用脚本语言中,因此它允许复杂的条件、循环、代码库访问等。业务规则方法,由大多数文档编排工具采用,工作原理类似,但侧重于编写业务规则而非脚本。尽管比简单的填空更强大,这些系统仍然缺乏语言能力,无法可靠地生成复杂、高质量的文本。

词级语法功能

模板系统的逻辑发展是添加词级语法功能,以处理形态学、形态音系学和正字法以及处理可能的例外。这些功能使生成语法正确的文本和编写复杂的模板系统变得更加容易。

动态句子生成

最终,从基于模板的方法转向动态自然语言生成(NLG),这种方法从句子的意义表示或期望的语言结构动态创建句子。动态创建意味着系统能够在不需要开发人员为每个边界情况显式编写代码的情况下,在不寻常的情况下做出合理的处理。它还允许系统在参考、聚合、排序和连接词等方面以多种方式进行语言上的“优化”。

动态文档创建

虽然动态句子生成在某种“微观层面”上工作,但“宏观写作”任务生成与读者相关且有用的文档,并且在叙事上结构良好。如何完成这项任务取决于文本的目标。例如,一篇说服性写作可能基于论证和行为变化的模型,以模仿人类修辞;而一篇总结数据以供商业智能使用的文本可能基于对影响决策的关键因素的分析。

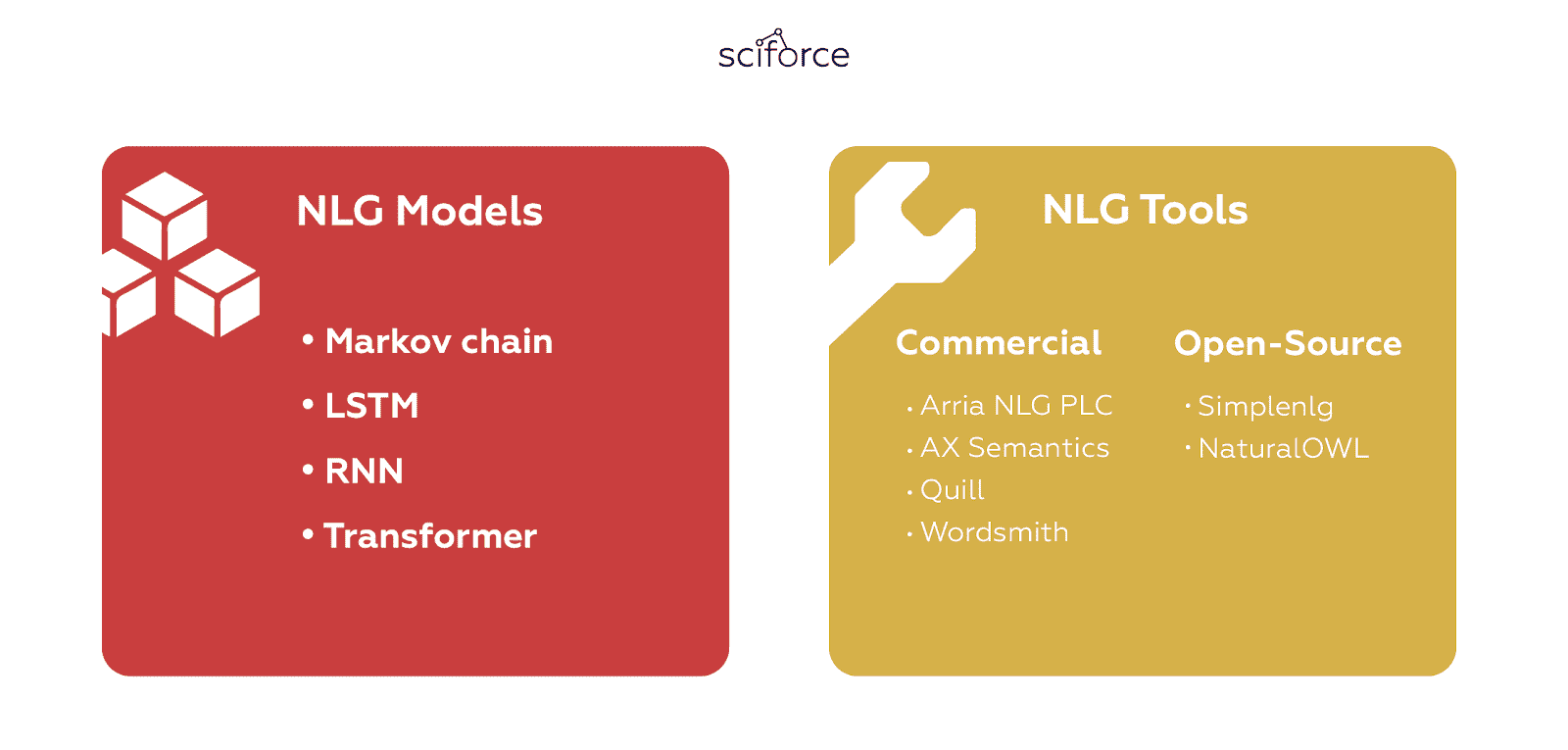

NLG 模型

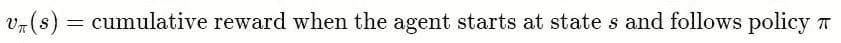

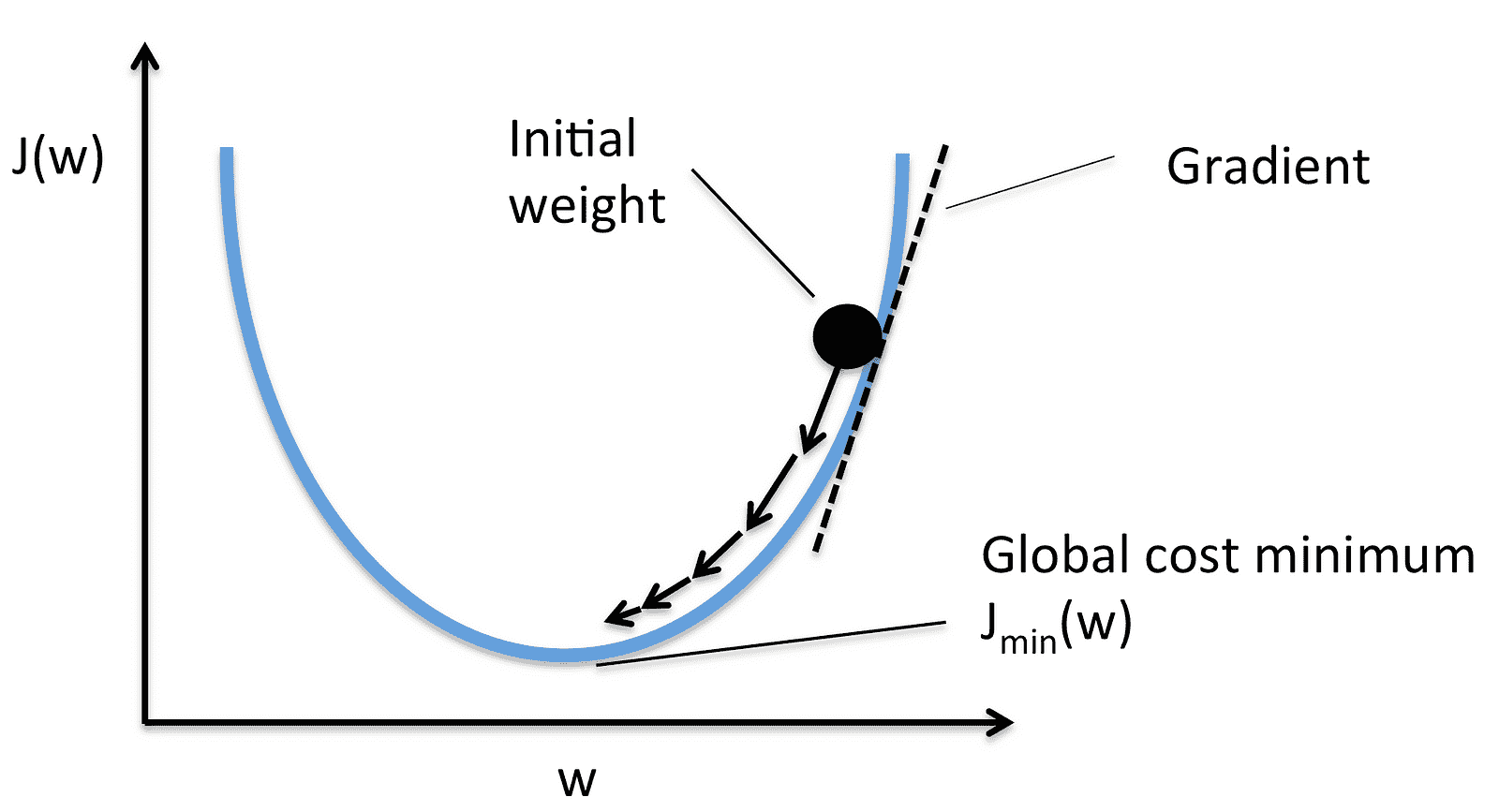

即使在 NLG 从模板转向动态句子生成后,这项技术仍然经历了多年的实验才取得令人满意的结果。作为自然语言处理(NLP)的一部分,更多地说作为人工智能(AI)的一部分,自然语言生成依赖于一系列算法,这些算法解决了生成类人文本的某些问题:

马尔可夫链

马尔可夫链是用于语言生成的第一个算法之一。该模型通过使用当前词并考虑每个独特词之间的关系来预测句子中的下一个词,从而计算下一个词的概率。事实上,你在早期版本的智能手机键盘上见过它们,当时它们用于生成下一个词的建议。

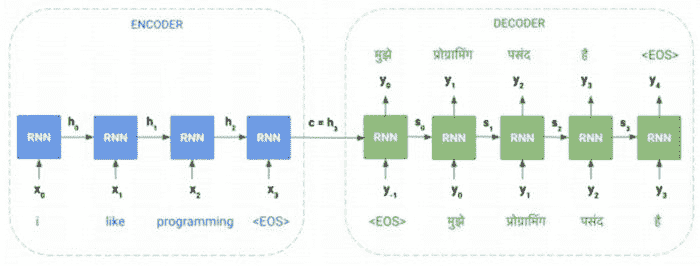

递归神经网络(RNN)

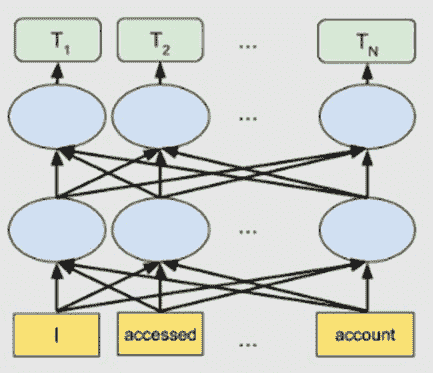

神经网络是尝试模拟人脑运作的模型。RNN 将序列中的每个项通过前馈网络,并使用模型的输出作为下一个序列项的输入,从而允许将前一步的信息存储起来。在每次迭代中,模型将之前遇到的单词存储在其记忆中,并计算下一个单词的概率。对于字典中的每个单词,模型根据前一个单词分配一个概率,选择概率最高的单词并将其存储在记忆中。RNN 的“记忆”使得该模型非常适合语言生成,因为它可以随时记住对话的背景。然而,随着序列长度的增加,RNN 无法存储句子中远处遇到的单词,并且仅根据最近的单词进行预测。由于这一限制,RNN 无法生成连贯的长句子。

LSTM

为了解决长程依赖问题,提出了一种名为长短期记忆(LSTM)的 RNN 变体。虽然与 RNN 相似,但 LSTM 模型包括一个四层神经网络。LSTM 包含四个部分:单元、输入门、输出门和遗忘门。这些允许 RNN 通过调整单元的信息流,在任何时间间隔记住或忘记单词。当遇到一个时期时,遗忘门识别到句子的上下文可能发生变化,可以忽略当前单元状态信息。这使得网络能够有选择地跟踪相关信息,同时最小化梯度消失问题,从而使模型能够在更长的时间内记住信息。

尽管如此,由于 LSTM 的记忆容量受限于前一单元到当前单元的复杂序列路径,因此其容量仅限于几百个单词。这种复杂性也导致了高计算需求,使得 LSTM 难以训练或并行化。

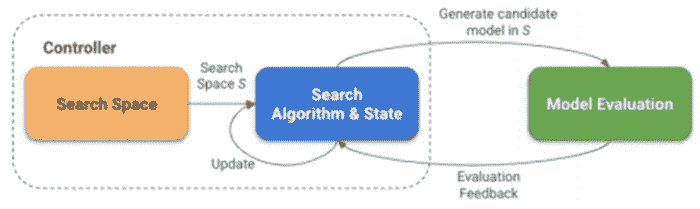

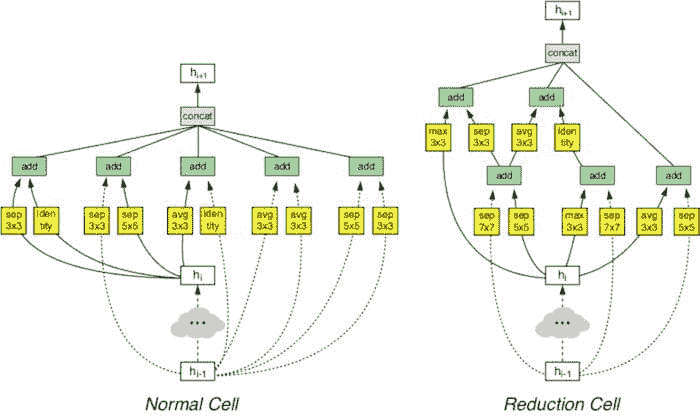

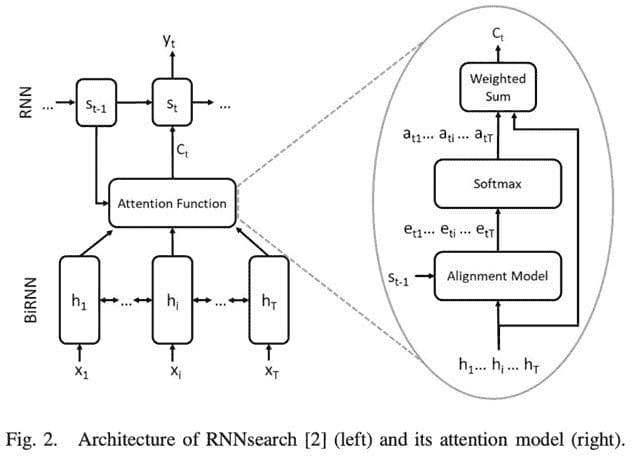

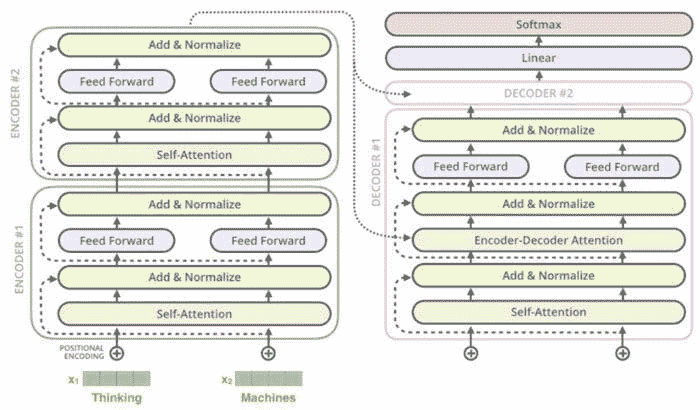

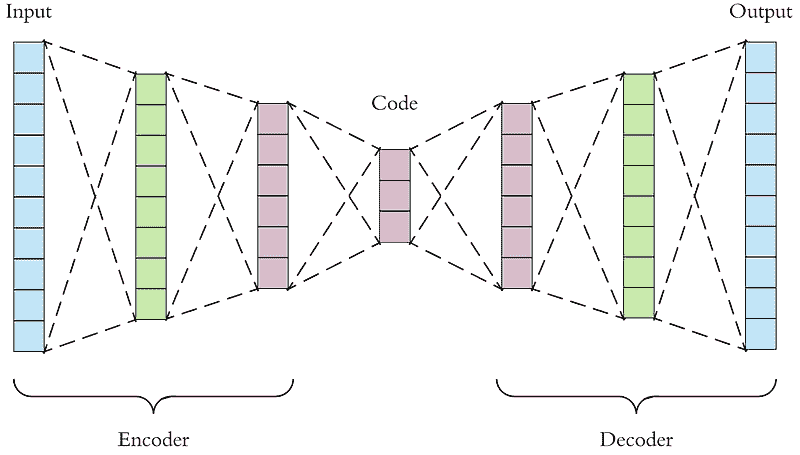

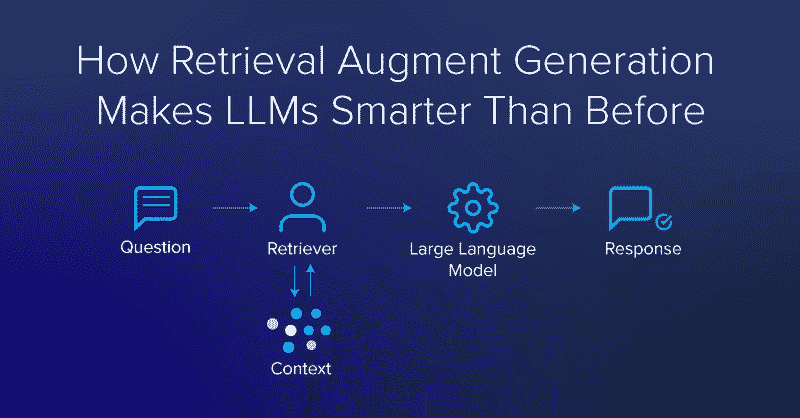

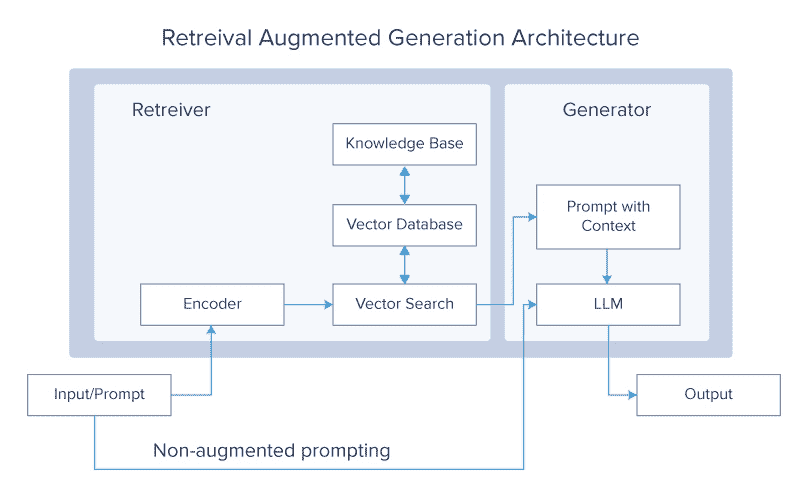

Transformer

一个相对较新的模型在 2017 年的 Google 论文中首次提出 “Attention is all you need”,提出了一种称为“自注意力机制”的新方法。Transformer 由一个处理任意长度输入的编码器堆栈和另一组输出生成句子的解码器组成。与 LSTM 相比,Transformer 仅执行少量、恒定的步骤,同时应用直接模拟句子中所有单词之间关系的自注意力机制。与之前的模型不同,Transformer 使用上下文中所有单词的表示,而不必将所有信息压缩到单个固定长度的表示中,从而使系统能够处理更长的句子,而不会导致计算需求急剧增加。

语言生成的一个著名例子是 OpenAI 的 GPT-2 语言模型。该模型通过关注模型中之前见过的与预测下一个词相关的词来学习预测句子中的下一个词。谷歌的最新升级版 Transformers 双向编码器表示(BERT)为各种 NLP 任务提供了最先进的结果。

NLG 工具

你可以看到,自然语言生成是一个复杂的任务,需要考虑语言的多个方面,包括结构、语法、词汇使用和感知。幸运的是,你可能不会从头开始构建整个 NLG 系统,因为市场上提供了多种现成的工具,包括商业和开源的。

商业 NLG 工具

Arria NLG PLC 被认为是全球 NLG 技术和工具的领导者之一,拥有最先进的 NLG 引擎和由 NLG 叙述生成的报告。该公司拥有可通过 Arria NLG 平台使用的专利 NLG 技术。

AX Semantics: 为超过 100 种语言提供电子商务、新闻和数据报告(例如 BI 或财务报告)的 NLG 服务。它是一个开发者友好的产品,利用 AI 和机器学习来训练平台的 NLP 引擎。

Yseop 以其在移动、在线或面对面等平台上的智能客户体验而闻名。从 NLG 角度来看,它提供了可以在本地、云端或作为服务消费的 Compose,并且还提供了用于 Excel 和其他分析平台的插件 Savvy。

Quill 由 Narrative Science 提供,是一个由先进 NLG 技术驱动的 NLG 平台。Quill 通过开发故事、分析并提取所需数据,将数据转换为具有智能的人类叙述。

Wordsmith 由 Automated Insights 提供,是一个主要在高级模板化方法领域工作的 NLG 引擎。它允许用户将数据转换为任何格式或规模的文本。Wordsmith 还提供了丰富的语言选项用于数据转换。

开源 NLG 工具

Simplenlg 可能是最广泛使用的开源实现工具,特别是被系统构建者使用。它是由 Arria 创始人编写的开源 Java API。它功能最少,但使用最简单且文档最完善。

NaturalOWL 是一个开源工具包,用于生成 OWL 类和个体的描述,以将 NLG 框架配置到特定需求,而无需进行大量编程。

结论

NLG 功能已成为分析平台试图实现数据分析民主化的事实选择,并帮助任何人理解他们的数据。 接近人类叙述的自然语言自动解释了那些可能在表格、图表和图形中丢失的见解,并在数据发现过程中充当助手。此外,NLG 与 NLP 结合是聊天机器人和其他自动化聊天及助手的核心,提供日常支持。

随着自然语言生成(NLG)的不断发展,它将变得更加多样化,并在我们与计算机之间提供自然的有效沟通,这是许多科幻作家在他们的书中梦想的。

原文。经许可转载。

简介: SciForce 是一家总部位于乌克兰的 IT 公司,专注于基于科学驱动的信息技术的软件解决方案开发。我们在许多关键的 AI 技术领域拥有广泛的专业知识,包括数据挖掘、数字信号处理、自然语言处理、机器学习、图像处理和计算机视觉。

相关:

更多相关主题

你在自然语言处理(NLP)方面的指南

原文:

www.kdnuggets.com/2019/05/guide-natural-language-processing-nlp.html

评论

评论

由Diego Lopez Yse,穆迪 LATAM 运营。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

我们表达的每一件事(无论是口头的还是书面的)都携带大量的信息。我们选择的话题、语气、词汇选择,一切都增加了一些可以被解释并从中提取价值的信息。从理论上讲,我们可以利用这些信息来理解甚至预测人类行为。

但有一个问题:一个人可能在声明中生成数百或数千个单词,每句话都有其对应的复杂性。如果你想在特定地理区域内扩展并分析数百、数千或数百万人或声明,那么情况就会变得难以管理。

从对话、声明甚至推文中生成的数据是非结构化数据的例子。非结构化数据不适合传统的关系数据库中的行列结构,代表了现实世界中绝大多数的数据。它是杂乱的,难以操作。然而,得益于机器学习等学科的进步,这个话题正经历一场巨大的革命。如今,不再是尝试基于关键词(传统的机械方式)来解释文本或语音,而是理解这些词汇背后的含义(认知方式)。这样可以检测到修辞手法,如讽刺,甚至进行情感分析。

自然语言处理或 NLP 是人工智能的一个领域,它赋予机器阅读、理解和推断人类语言含义的能力。

这是一个专注于数据科学与人类语言之间互动的学科,并且正在扩展到许多行业。如今,由于对数据获取的巨大改进和计算能力的提升,NLP 正在蓬勃发展,这使得从业者能够在医疗保健、媒体、金融和人力资源等领域取得有意义的成果。

NLP 的使用案例

简单来说,NLP 代表了对自然人类语言(如语音或文本)的自动处理,虽然这个概念本身很迷人,但这种技术的真正价值来自于它的实际应用场景。

NLP 可以帮助您完成许多任务,其应用领域似乎每天都在增加。让我们举一些例子:

-

NLP 使得基于电子健康记录和患者自身语音的疾病识别和预测成为可能。这项能力正在被探索用于从心血管疾病到抑郁症甚至精神分裂症的健康状况。例如,Amazon Comprehend Medical 是一项利用 NLP 来提取疾病状况、药物和治疗结果的服务,从患者笔记、临床试验报告和其他电子健康记录中提取信息。

-

组织可以通过识别和提取社交媒体等来源的信息来确定客户对服务或产品的评价。这种情感分析可以提供关于客户选择及其决策驱动因素的大量信息。

-

IBM 的一位发明家开发了一种认知助手,它像个个性化搜索引擎,通过了解您的所有信息,然后在您需要时提醒您一个名字、一首歌或任何您记不起来的东西。

-

像 Yahoo 和 Google 这样的公司通过分析流经其服务器的电子邮件文本来过滤和分类您的邮件,并阻止垃圾邮件,即使在它们到达您的收件箱之前。

-

为了帮助识别虚假新闻,麻省理工学院的 NLP 小组开发了一种新系统,用于判断信息源是否准确或具有政治偏见,检测新闻源是否值得信赖。

-

亚马逊的 Alexa 和苹果的 Siri 是语音驱动接口的例子,它们使用 NLP 来响应语音提示,并完成所有任务,如查找特定商店、告诉我们天气预报、建议最佳路线或打开家里的灯。

-

了解发生了什么以及人们在谈论什么对金融交易员来说非常宝贵。NLP(自然语言处理)被用来追踪新闻、报告、关于公司可能合并的评论,一切都可以被纳入交易算法中以产生巨额利润。记住:买入谣言,卖出新闻。

-

NLP 也被应用于人才招聘的搜索和筛选阶段,识别潜在雇员的技能,并在他们进入就业市场之前发现有潜力的候选人。

-

由 IBM Watson NLP 技术支持,LegalMation开发了一个平台,自动化日常诉讼任务,帮助法律团队节省时间,降低成本,并转移战略重点。

NLP 在医疗行业特别蓬勃发展。这项技术改善了护理服务、疾病诊断,并降低了成本,同时医疗机构在电子健康记录的采用上也在不断增长。临床文档的改进意味着患者可以通过更好的医疗得到更好的理解和利益。目标应是优化他们的体验,许多组织已经在这方面进行工作。

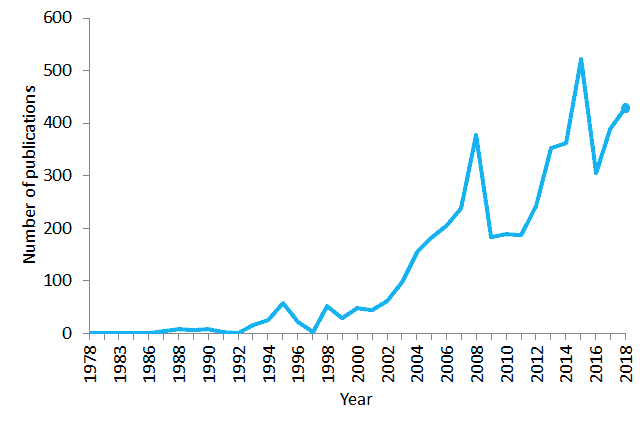

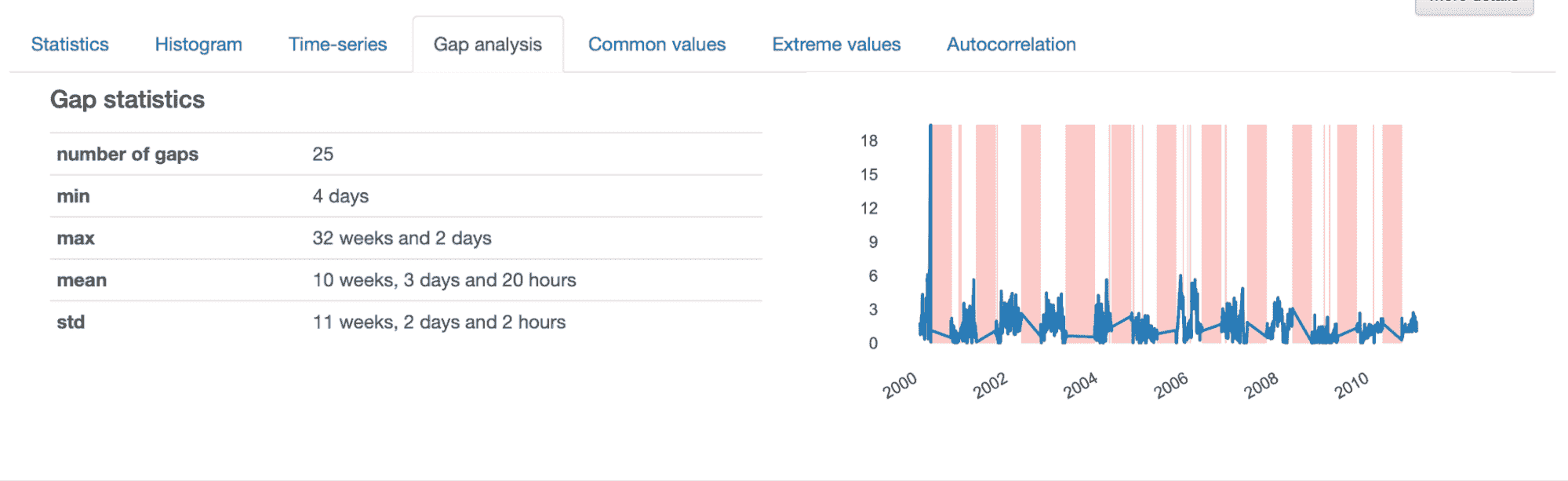

PubMed 在 1978–2018 年期间包含“自然语言处理”这句话的出版物数量。到 2018 年,PubMed 包含了超过 2900 万条生物医学文献引用。

像Winterlight Labs这样的公司,通过语音监测认知障碍在阿尔茨海默病治疗方面取得了巨大进展,他们还可以支持各种中枢神经系统疾病的临床试验和研究。采用类似的方法,斯坦福大学开发了Woebot,一个聊天机器人治疗师,旨在帮助有焦虑和其他障碍的人。

但围绕这一主题存在严重的争议。几年前,微软演示了通过分析大量搜索引擎查询样本,他们可以识别出正在遭受胰腺癌的互联网用户,即使在他们收到疾病诊断之前。用户对这种诊断会有何反应?如果你被错误地标记为阳性(即使你没有该疾病)会发生什么?这让人想起 Google Flu Trends,在 2009 年宣布能够预测流感,但由于准确性低和未能达到预期而消失。

NLP 可能是未来有效临床支持的关键,但短期内仍面临许多挑战。

基础 NLP 技术让你的非 NLP 朋友刮目相看

当前我们面临的主要缺点与自然语言处理(NLP)相关,语言本身非常复杂。理解和处理语言的过程极其复杂,因此通常需要使用不同的技术来应对不同的挑战,然后再将一切结合起来。像 Python 或 R 这样的编程语言被广泛用于执行这些技术,但在深入代码行之前(这将是另一篇文章的主题),理解其背后的概念非常重要。让我们总结并解释一些在定义术语词汇表时最常用的 NLP 算法:

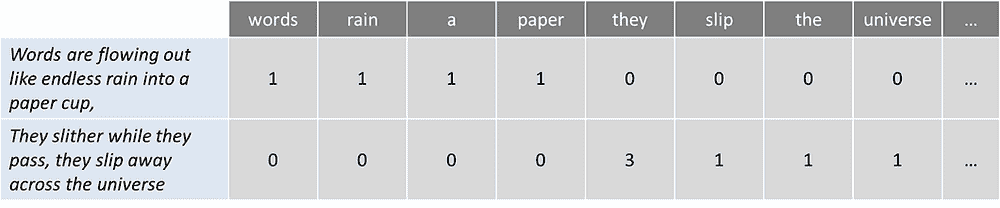

词袋模型

是一种常用模型,允许你计算一段文本中的所有词汇。基本上,它为句子或文档创建一个发生矩阵,忽略语法和词序。这些词汇的频率或出现次数随后被用作训练分类器的特征。

为了举一个简单的例子,我取了披头士乐队歌曲《Across the Universe》的第一句:

词汇像无尽的雨水流入纸杯,

他们滑过时,他们滑离宇宙

现在让我们计算一下词汇数量:

这种方法可能会反映出一些缺点,比如缺乏语义意义和上下文,停用词(如“the”或“a”)会给分析带来噪声,有些词的权重也不相应(“universe” 的权重低于“they”)。

为了解决这个问题,一种方法是通过词汇在所有文本中出现的频率(不仅仅是我们正在分析的文本)来重新调整词频,以使像“the”这样的频繁词汇在其他文本中也很常见,得到惩罚。这种评分方法称为“词频—逆文档频率”(TFIDF),它通过权重改进了词袋模型。通过 TFIDF,文本中的频繁词汇(如我们的例子中的“they”)会得到“奖励”,但如果这些词汇在其他文本中也很频繁,它们也会被“惩罚”。相反,这种方法突出了并“奖励”独特或稀有的术语,考虑了所有文本。然而,这种方法仍然没有上下文或语义。

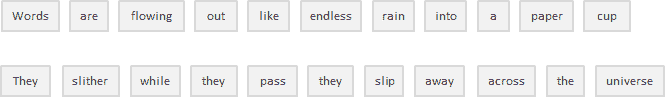

分词

是将连续文本划分为句子和单词的过程。实质上,这就是将文本切割成称为tokens的片段,同时丢弃某些字符,如标点符号。以我们的例子为例,分词的结果是:

很简单,对吧?虽然在这种情况下以及像英语这样通过空格分隔单词的语言(称为分段语言)中,这可能看起来相当基础,但并非所有语言都是如此。如果你仔细考虑一下,仅靠空格在英语中也不足以进行准确的分词。基于空格的分割可能会将本应视为一个标记的内容拆开,例如某些名字(如旧金山或纽约)或借用的外语短语(如 laissez faire)。

分词也可以去除标点符号,这有助于进行准确的单词分割,但也可能引发一些问题。例如,在缩写(如 dr.)后的句点,句点应视为同一标记的一部分,而不是被去除。

在处理包含大量连字符、括号和其他标点符号的生物医学文本领域时,分词过程可能特别棘手。

有关分词的更详细信息,你可以在 这篇文章中找到很好的解释。

停用词删除

包括去除常见的语言文章、代词和介词,如英语中的“and”、“the”或“to”。在此过程中,一些非常常见的单词,因为对自然语言处理目标几乎没有价值,被过滤并排除在处理文本之外,从而去除那些广泛且频繁但没有信息量的词。

通过查阅预定义的关键词列表,可以安全地忽略停用词,从而节省数据库空间并提高处理速度。

没有通用的停用词列表。这些可以是预先选择的,也可以从头开始建立。一种潜在的方法是从采用预定义的停用词开始,然后逐步添加新的词。然而,似乎最近的总体趋势是从使用大型标准停用词列表转向不使用任何列表。

问题在于,停用词的删除可能会抹去相关信息并改变句子的上下文。例如,如果我们在进行情感分析时删除像“not”这样的停用词,可能会让我们的算法偏离方向。在这种情况下,你可能需要选择一个最小的停用词列表,并根据具体目标添加额外的术语。

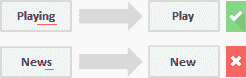

词干提取

指的是通过切割单词的前部或后部来去除词缀(词根的附加部分)。

附加在单词开头的词缀称为前缀(例如单词“astrobiology”中的“astro”),而附加在单词结尾的词缀称为后缀(例如单词“helpful”中的“ful”)。

问题是词缀可以创造或扩展相同词的新形式(称为屈折词缀),甚至创造新的词(称为派生词缀)。在英语中,前缀总是派生性的(词缀创造了一个新词,例如“ecosystem”中的前缀“eco”),但后缀可以是派生性的(词缀创造了一个新词,例如“guitarist”中的后缀“ist”)或屈折性的(词缀创造了一个新形式的词,例如“faster”中的后缀“er”)。

那么,我们如何区分并剪切正确的部分呢?

一种可能的方法是考虑一个常见词缀和规则的列表(Python 和 R 语言有不同的库包含词缀和方法),并根据这些进行词干提取,但这种方法显然也存在局限性。由于词干提取器使用算法方法,词干提取过程的结果可能不是一个实际的词,甚至可能改变词(和句子)的含义。为了抵消这种效果,你可以通过添加或删除词缀和规则来编辑这些预定义的方法,但你必须考虑你可能会在一个领域提高性能,同时在另一个领域产生退化。始终考虑整体情况并测试模型的性能。

如果词干提取有严重的局限性,那我们为什么还要使用它呢?首先,它可以用来纠正词汇中的拼写错误。词干提取器使用简单且运行非常快速(它们对字符串进行简单操作),如果在 NLP 模型中速度和性能很重要,那么词干提取无疑是合适的选择。记住,我们使用它的目的是提高性能,而不是作为语法练习。

词形还原

其目的是将一个词简化为其基本形式,并将同一词的不同形式归为一类。例如,过去时动词被转化为现在时(例如,“went”被转化为“go”),同义词被统一(例如,“best”被转化为“good”),从而将具有相似意义的词标准化为其词根。尽管它似乎与词干提取过程密切相关,但词形还原使用不同的方法来达到词根形式。

词形还原将单词解析为其词典形式(称为词元),这需要详细的词典,算法可以查阅并将单词链接到其对应的词元。

例如,“running”,“runs” 和 “ran” 都是“run”的不同形式,因此“run”是所有这些词的词元。

词形还原也考虑了词的上下文,以解决其他问题,如歧义消解,这意味着它可以区分在特定上下文中具有不同含义的相同词汇。想想“bat”一词(可以指动物或用于棒球的金属/木制球棒)或“bank”一词(可以指金融机构或水体旁的土地)。通过为词提供词性参数(例如名词、动词等),可以定义该词在句子中的角色,从而消除歧义。

正如你可能已经想象的那样,词形还原是一个比词干提取过程更为资源密集的任务。同时,由于它比词干提取方法需要更多的语言结构知识,它需要更多的计算能力,而不是设置或调整词干提取算法。

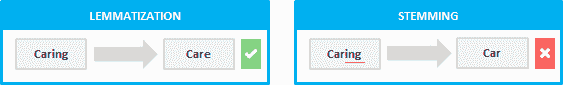

话题建模

作为一种揭示文本或文档中隐藏结构的方法,本质上,它将文本聚类以发现基于其内容的潜在话题,处理单个词并根据其分布分配值。这项技术基于每个文档由一组话题混合组成,每个话题由一组词组成的假设,这意味着如果我们能够识别这些隐藏的话题,就能解锁文本的意义。

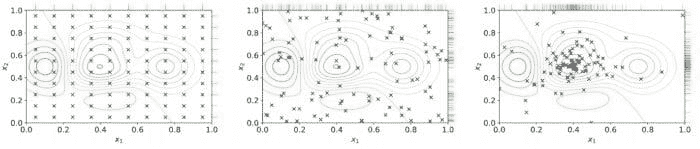

在话题建模技术的宇宙中,潜在狄利克雷分配(LDA)可能是最常用的。这种相对较新的算法(发明不到 20 年)作为一种无监督学习方法,发现文档集合中的不同话题。在无监督学习方法中,没有输出变量来引导学习过程,数据由算法探索以发现模式。更具体地说,LDA 通过以下方式找到相关词的组:

-

将每个词分配给一个随机话题,用户定义希望揭示的话题数量。你不需要定义具体的话题(只定义话题数量),算法会将所有文档映射到这些虚拟话题上,以便每个文档中的词大多数都被这些虚拟话题所捕捉。

-

算法逐词迭代,重新分配词到某个话题,考虑到该词属于某话题的概率,以及文档由某话题生成的概率。这些概率会被多次计算,直到算法收敛。

与其他执行硬聚类(主题之间互不重叠)的聚类算法如K-means不同,LDA 将每个文档分配给一个或多个主题的混合,这意味着每个文档可以由一个或多个主题来描述(例如,文档 1 由 70%的主题 A、20%的主题 B 和 10%的主题 C 来描述),从而反映出更现实的结果。

主题建模对于分类文本、构建推荐系统(例如,根据过去的阅读推荐书籍)或甚至检测在线出版物中的趋势非常有用。

未来看起来怎么样?

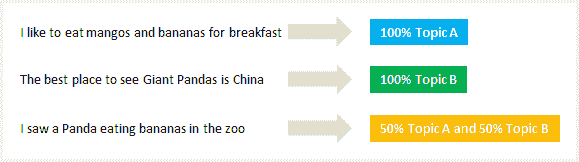

目前,NLP 正在努力检测语言意义的细微差别,无论是由于缺乏上下文、拼写错误还是方言差异。

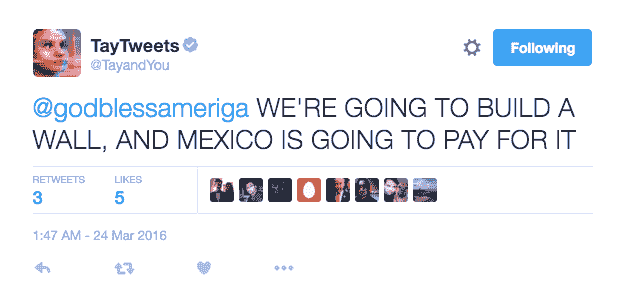

2016 年 3 月,微软推出了Tay,这是一个作为 NLP 实验在 Twitter 上发布的人工智能(AI)聊天机器人。其想法是,随着更多用户与 Tay 对话,它会变得更聪明。结果是,经过 16 小时后,Tay 因其种族主义和辱骂性评论而被移除:

微软从自身经验中吸取了教训,并在几个月后发布了Zo,这是其第二代英语语言聊天机器人,不会再犯与其前身相同的错误。Zo 使用了一系列创新的方法来识别和生成对话,其他公司也在探索能够记住特定个人对话细节的机器人。

尽管未来对 NLP 看起来极具挑战性且充满威胁,但这一学科正在以前所未有的速度发展,我们很可能在未来几年达到一种使复杂应用看起来可行的进步水平。

原文。经授权转载。

简介:Diego Lopez Yse是一位经验丰富的专业人士,拥有在不同领域(生物技术、软件、咨询、政府、农业)获得的扎实国际背景。

资源:

相关:

了解更多相关话题

傻瓜指南:精确度、召回率和混淆矩阵

原文:

www.kdnuggets.com/2020/01/guide-precision-recall-confusion-matrix.html

评估机器学习模型

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

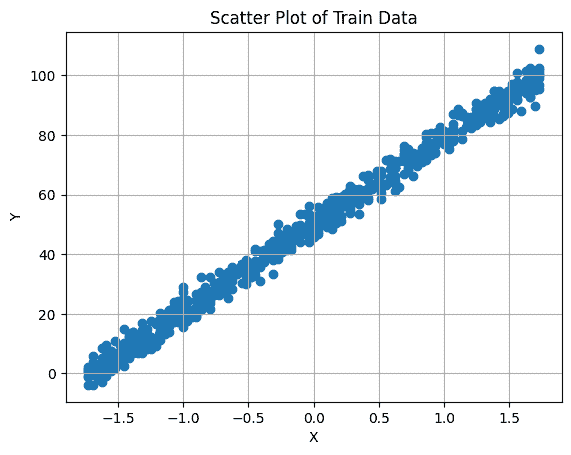

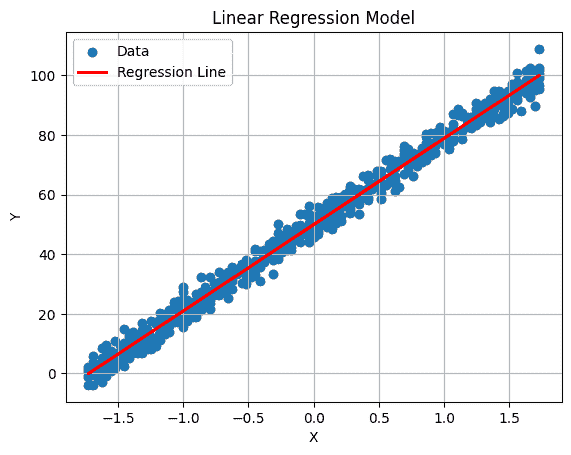

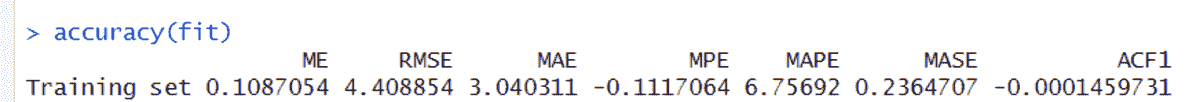

回归模型

RMSE 是评估machine learning模型表现的一个好指标。

如果测试集的 RMSE 显著高于训练集——模型很可能是过拟合了。(确保训练集和测试集来自相同/类似分布)

分类模型怎么样?

说出来你可能不信,评估分类模型并不像看起来那么简单

但是为什么呢?

你一定在想‘难道我们不能把准确率作为终极指标吗?’

准确率非常重要,但可能并不是总是最好的指标。让我们通过一个例子来看看为什么——

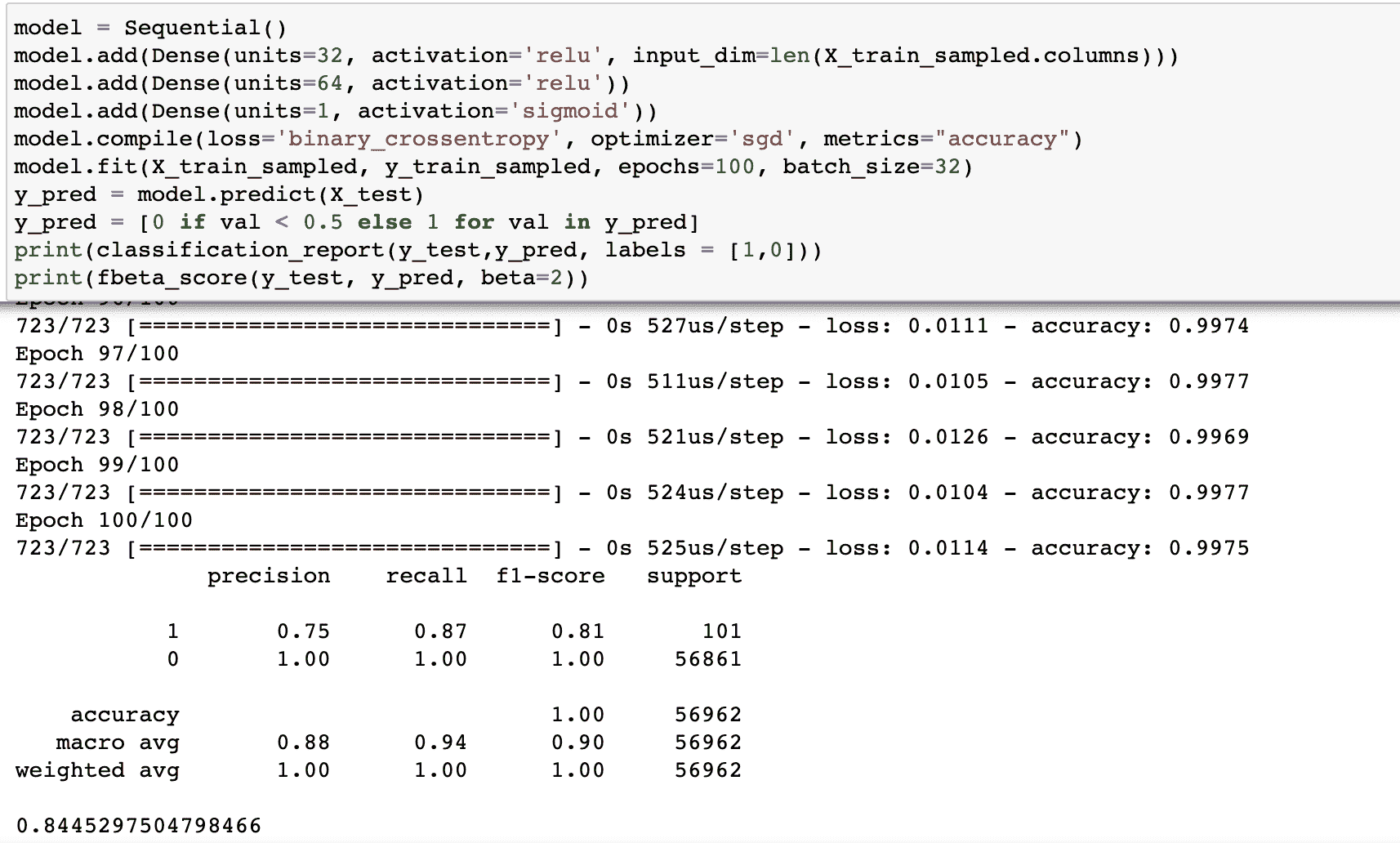

假设我们正在构建一个预测银行贷款是否会违约的模型

(S&P/Experian 消费者信贷违约综合指数报告的违约率为 0.91%)

让我们有一个虚拟模型,它总是预测贷款不会违约。你猜这个模型的准确率是多少?

===> 99.10%

印象深刻,对吧?不过,银行购买这个模型的概率绝对是零。????

虽然我们的模型有惊人的准确率,但这是一个准确率绝对不是合适指标的恰当例子。

如果不是准确率,还有什么呢?

除了准确率,还有许多其他方法来评估分类模型的性能

-

混淆matrix,

-

精确度、召回率

-

ROC 和 AUC

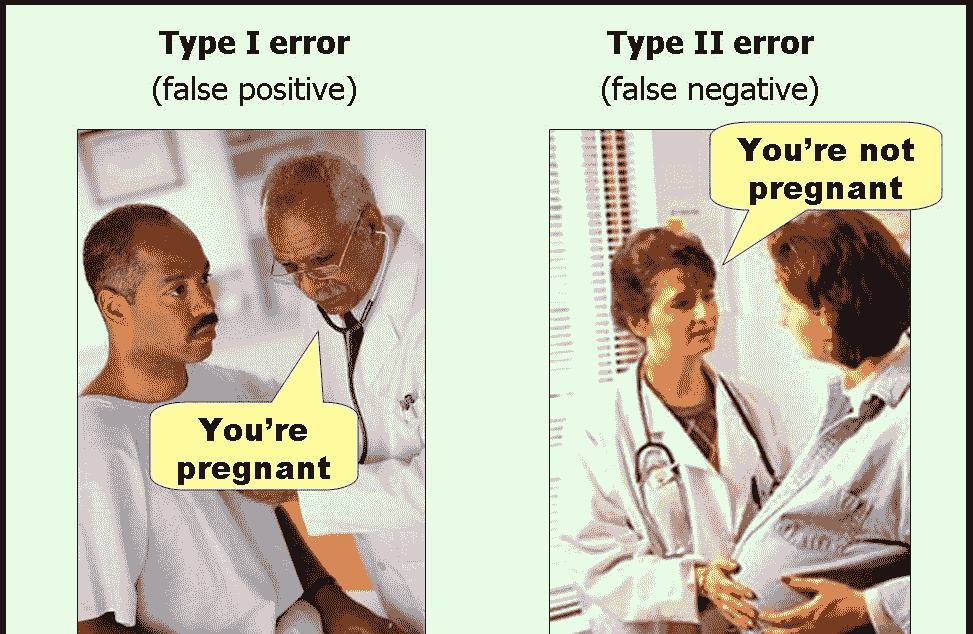

在继续之前,我们将了解一些常见的术语,如果没有清晰理解,可能会让整个事情变成一个难以理解的迷宫。

简单吧?

看完这些后感觉完全不同????

但正如他们所说——每朵乌云都有银边

让我们逐一了解,从基本术语开始。

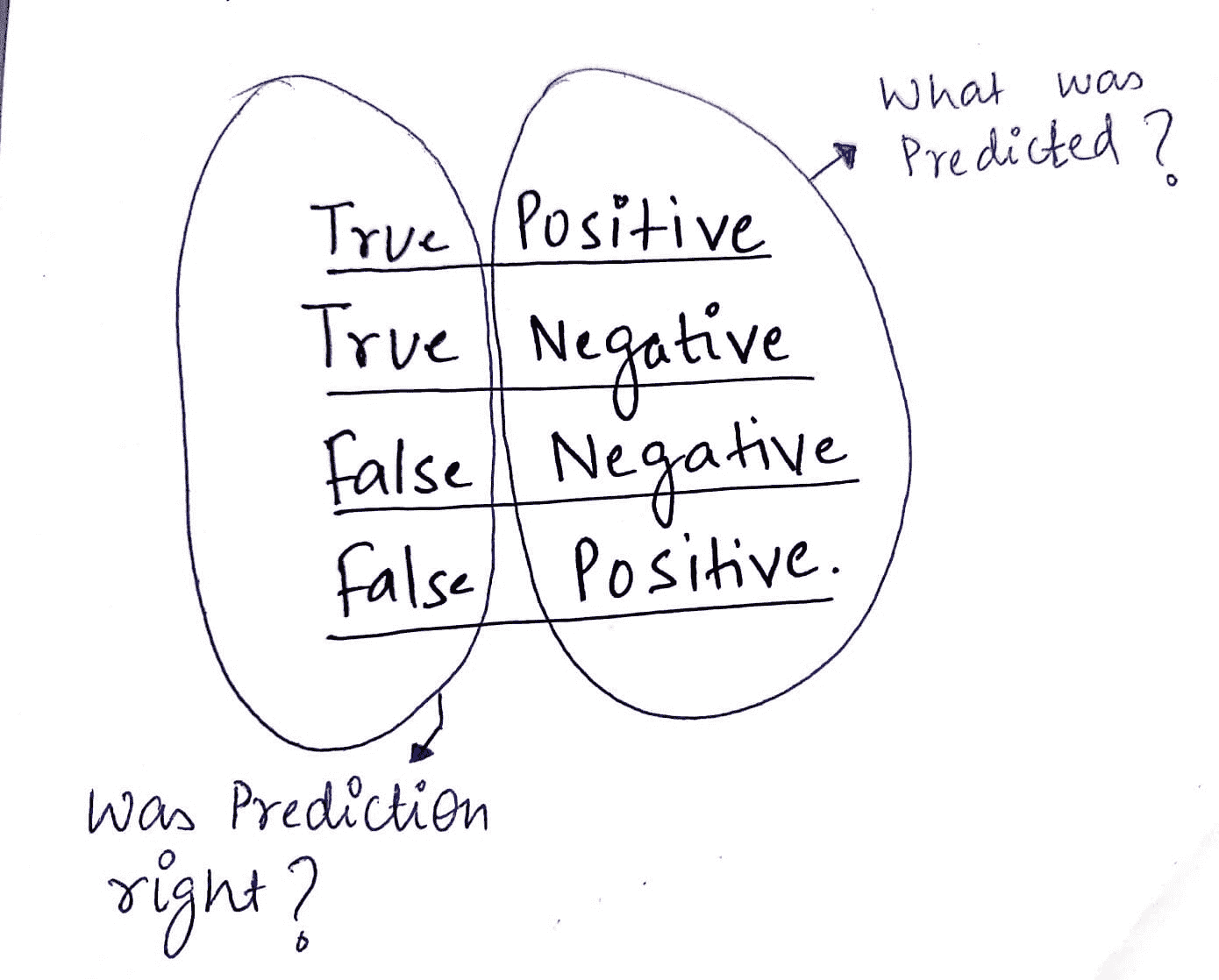

积极和消极——TP、TN、FP、FN

我用这个技巧来正确记住每个术语的含义。

(二分类问题。例如——预测银行贷款是否会违约)

那么真正的负类是什么意思呢?

真负例:我们在预测贷款不会违约时是正确的。

假阳性:我们错误地预测贷款会违约。

让我们巩固所学知识

另一张让我印象深刻的图片。

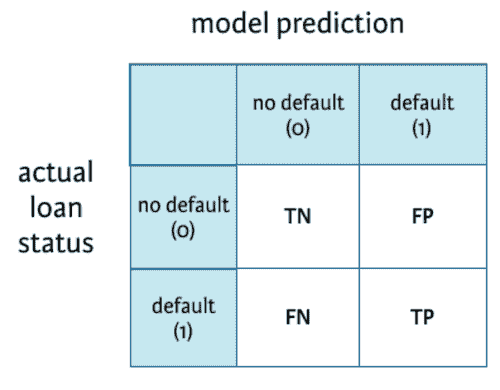

混淆矩阵

既然我们已经熟悉了 TP、TN、FP、FN——那么理解混淆矩阵将变得非常简单。

这是一个总结表,显示了我们模型在预测各种类别样本时的表现。这里的坐标轴是预测标签与实际标签。

用于分类模型预测贷款是否会违约的混淆矩阵。

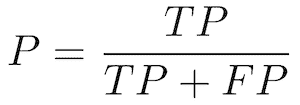

精确率和召回率

精确率——也称为正预测值

正确预测的正例比例与所有预测为正例的总比例。

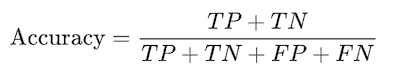

召回率——也称为敏感性、检测概率、真正例率

正确预测的正例比例与所有正例样本的总比例。

理解

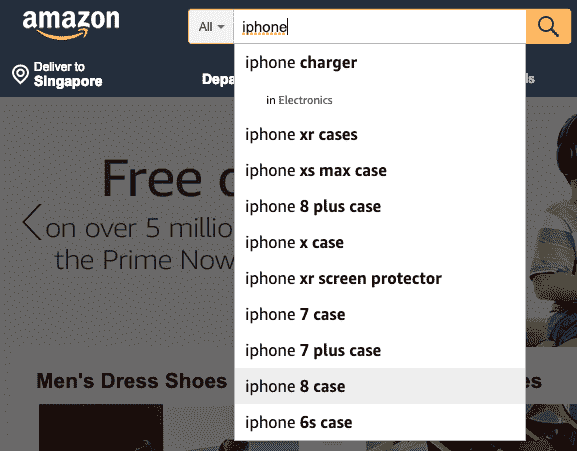

为了理解精确率和召回率,让我们以搜索为例。想想亚马逊主页上的搜索框。

“精确率”是所有返回搜索结果中相关结果的比例。召回率是搜索引擎返回的相关结果与本应返回的相关结果总数的比率。

在我们预测贷款是否违约的情况下——拥有较高的召回率会更好,因为银行不想亏损,即使有轻微的违约疑虑,提醒银行也是一个好主意。

在这种情况下,低精确率可能是可以接受的。

注意:通常,我们必须在精确率和召回率之间做出选择。几乎不可能同时拥有高精确率和高召回率。

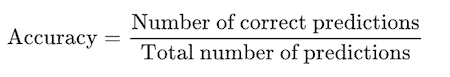

准确率

说到准确率,我们最喜欢的指标!

准确率定义为正确预测样本与总样本的比例。

就混淆矩阵而言,它的计算方法是:

记住,当所有类别同样重要时,准确率是一个非常有用的指标。但如果我们在预测病人是否有癌症时,这可能不适用。在这种情况下,我们可能能容忍假阳性,但不能容忍假阴性。

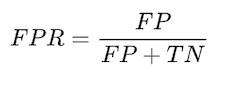

ROC 曲线

ROC 曲线(接收器操作特征曲线)图显示了分类模型在所有分类阈值下的表现。

(使用阈值:例如,如果你想计算 TPR 和 FPR,对于阈值 0.7,你需要将模型应用于每个样本,得到分数,如果分数大于或等于 0.7,则预测为正类;否则,预测为负类)

它绘制了 2 个参数:

- 真正例率(召回率)

- 假阳性率

表示未违约的人中,有多少百分比被识别为违约者。

预测与总预测正例的比例。

典型的 ROC 曲线。

降低分类阈值会将更多项目分类为正例,从而增加假阳性和真阳性的数量。

AUC

AUC代表ROC 曲线下面积。它提供了所有可能分类阈值下性能的综合测量。

ROC 曲线下面积(AUC)越高,分类器的表现越好。一个完美的分类器 AUC 为 1。通常,如果你的模型表现良好,你可以通过选择使 TPR 接近 1 而 FPR 接近 0 的阈值来获得一个好的分类器。

总结

在这篇文章中,我们了解了如何有效评估分类模型,特别是在单独查看准确率不足的情况下。我们理解了 TP、TN、FP、FN、精确度、召回率、混淆矩阵、ROC 和 AUC 等概念。希望这能让事情更清楚!

原文。经许可转载。

Vipul Jain是一位数据科学家,专注于机器学习,拥有从构思到生产的端到端数据产品开发经验。

更多相关话题

为 Android 准备 OpenCV 的指南

原文:

www.kdnuggets.com/2020/10/guide-preparing-opencv-android.html

评论

本教程指导 Android 开发人员为使用流行的 OpenCV(开源计算机视觉)库做准备。通过逐步指南,将该库导入 Android Studio(Android 的官方 IDE)。

安装和设置完成后,可以使用 OpenCV 执行其支持的任何操作,例如目标检测、分割、跟踪等。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯

1. Google 网络安全证书 - 快速进入网络安全职业生涯

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织的 IT

3. Google IT 支持专业证书 - 支持你的组织的 IT

在本教程的最后,将使用 OpenCV 对图像应用 Canny 滤镜。与此相关的 Android Studio 项目可以在 GitHub 上找到:

使用 OpenCV 在 Android 设备上。通过在 GitHub 上创建一个帐户来贡献 ahmedfgad/OpenCVAndroid 的开发。

OpenCV 概述

OpenCV 是一个用于对图像执行复杂实时操作的视觉库。它是一个免费、开源的库,最初用 C++ 编写。它包括与 Python、Java 和 MATLAB 的接口。无需编写大量代码即可构建操作,OpenCV 已经支持使用简单的接口构建这样的操作,用户只需编写几行代码。

在讨论如何将 OpenCV 导入 Android 项目之前,首先从构建一个 Android 项目开始,确保 Android 开发环境按预期工作。

本教程将涵盖的要点如下:

-

构建一个 Android Studio 项目

-

运行项目

-

编辑项目以显示 Toast 消息

-

下载 OpenCV

-

在 Android Studio 中导入 OpenCV

-

修复可能的 Gradle 同步错误

-

将 OpenCV 作为依赖项添加

-

添加本地库

-

使用 OpenCV 进行图像滤波

-

概述

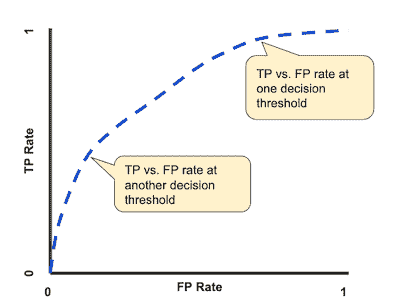

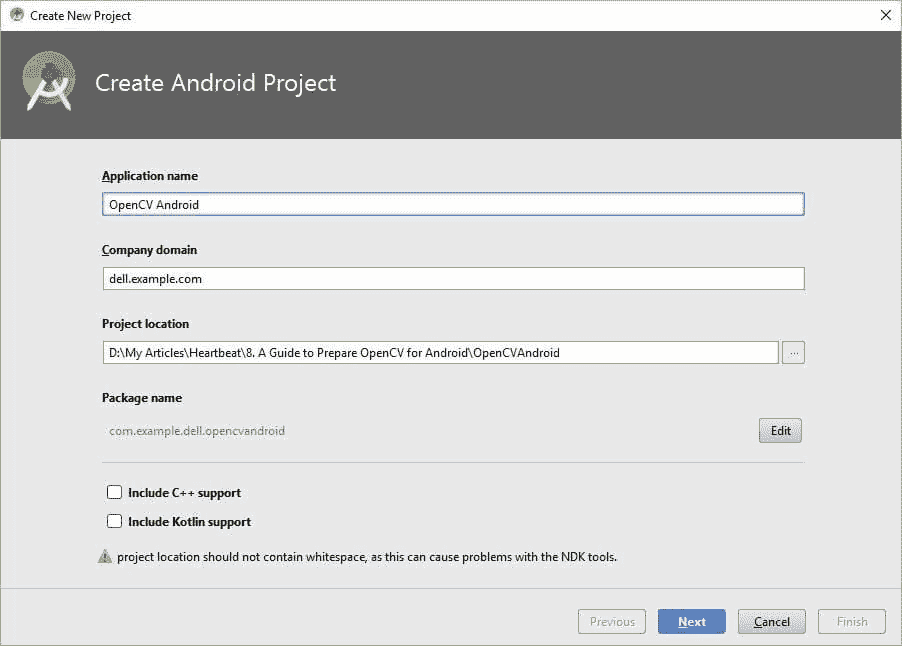

构建一个 Android Studio 项目

让我们来看看构建一个新的 Android Studio 项目的步骤。第一步是从文件菜单中创建一个新项目,如下图所示。

通过选择“新建项目”菜单项,将出现一个新窗口,要求输入一些细节(例如应用名称和项目目录)。本教程中将使用的应用名称是OpenCVAndroid。

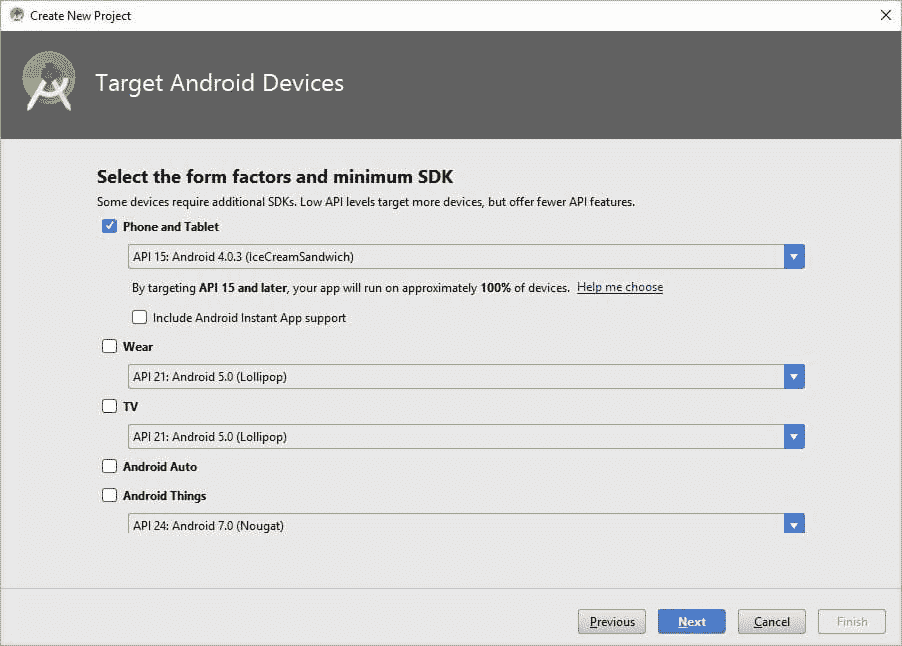

点击下一步按钮后,会出现另一个窗口询问目标设备和最低 SDK。你可以选择环境中可用的一个 SDK。如果你想支持更多设备,可以降低最低 SDK。

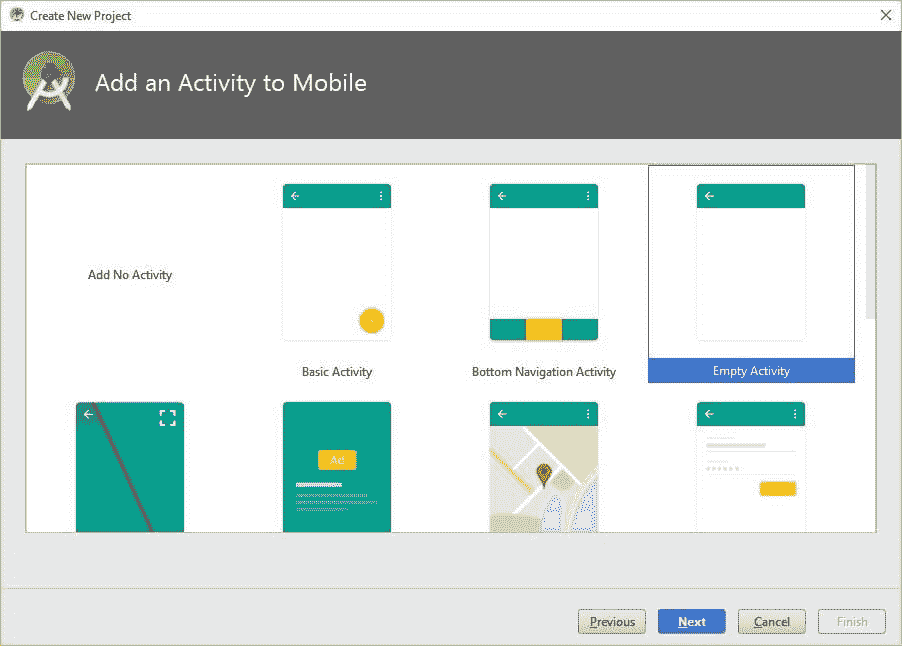

点击下一步,会出现另一个窗口询问是否在项目中创建一个默认活动。有几个不同的选项。如果不创建任何活动,你可以选择左上角的选项“添加无活动”。

因为我们要构建一个 Android 应用程序,所以必须有一个 Activity,即使是空的。因此,我选择了“空活动”选项。请注意,这个活动并非完全空白,因为它包含一个覆盖整个屏幕的 TextView,稍后运行应用程序时我们会看到。

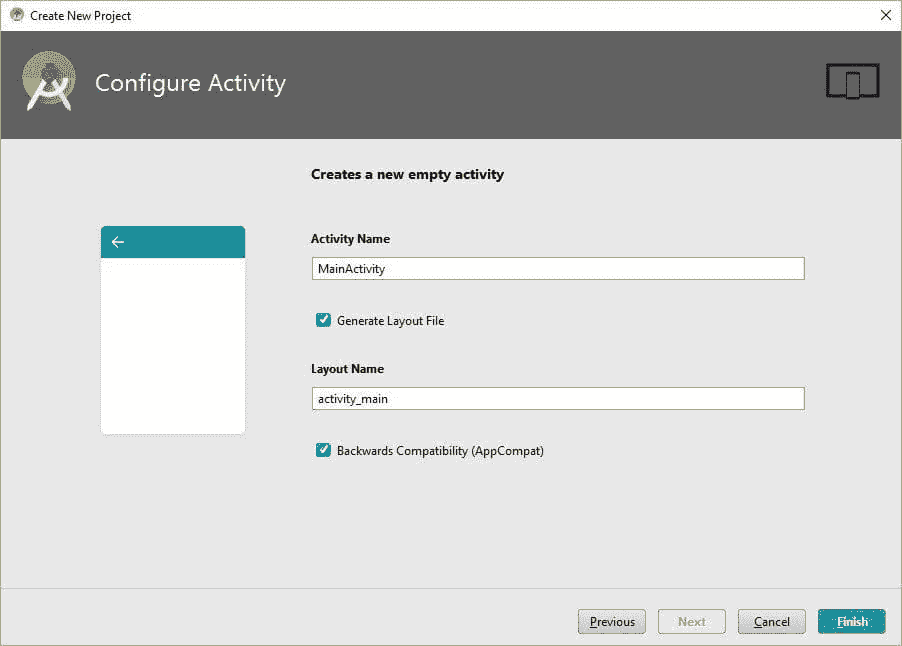

指定应用程序包含一个活动后,会出现另一个窗口询问活动名称。此名称被视为与该活动相关联的 Java 文件的类名。指定适当的名称后,点击完成以创建项目。

请注意,你可以勾选“生成布局文件”复选框来为活动创建一个布局。你可以选择勾选或取消勾选“向后兼容性”复选框。

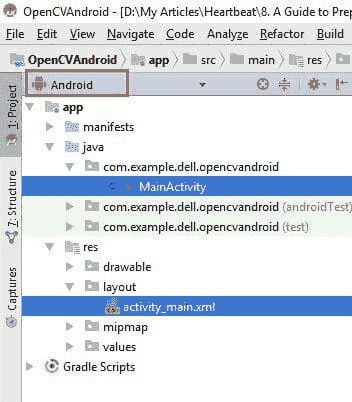

项目创建完成后,你可以选择 Android 项目视图,并会找到一个名为MainActivity的 Java 文件。这是一个 .java 扩展名的 Java 文件,但不仅仅在 Android 项目视图中显示。还有一个名为activity_main.xml的 XML 布局文件,如下图所示。

运行项目

在不讨论这些文件的实现的情况下,让我们运行项目以确保一切正常。要运行 Android Studio 项目,你需要一个模拟器(虚拟设备)或通过 USB 电缆连接的真实设备。

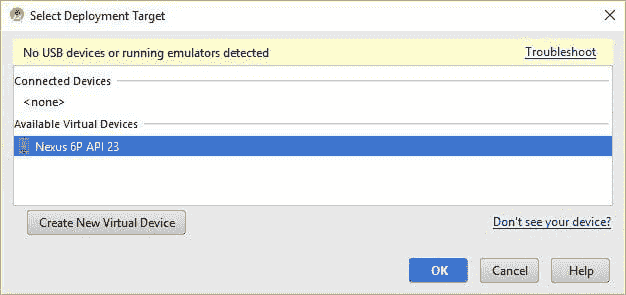

要运行项目,请从运行菜单中选择运行 'app'选项。会出现一个窗口询问是否使用模拟器或 USB 设备。我目前没有连接任何 USB 设备,因此选择了可用的模拟器。

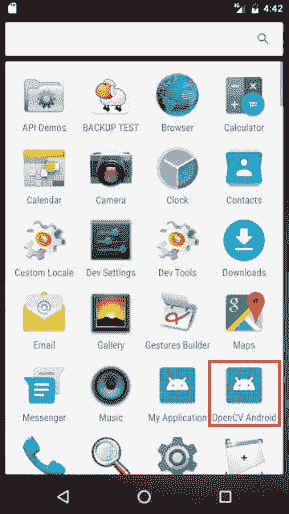

模拟器启动后,应用程序将自动安装并出现在应用程序列表中,如下所示。请注意,应用程序名称“OpenCV Android”是我们之前输入的。

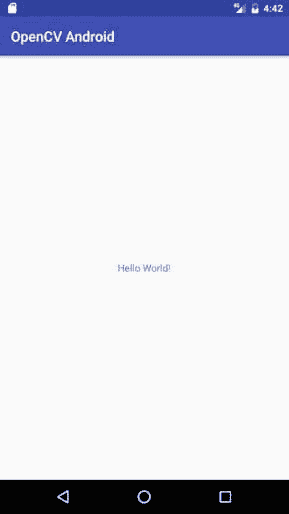

项目运行后,应用程序不仅会安装,还会自动启动。应用程序的界面如下所示。如前所述,活动布局仅包含一个显示“Hello World!”的 TextView。

运行项目后,我们知道开发环境工作正常。在项目中导入 OpenCV 之前,最好先熟悉一下项目。因此,我们来查看 MainActivity.java 和 activity_main.xml 文件的内容,并进行一个简单的编辑。

想为你的应用带来新的突破吗?机器学习可以实现强大而高度个性化的移动体验。 订阅 Fritz AI 新闻通讯以了解更多信息。

编辑项目以显示 Toast 消息

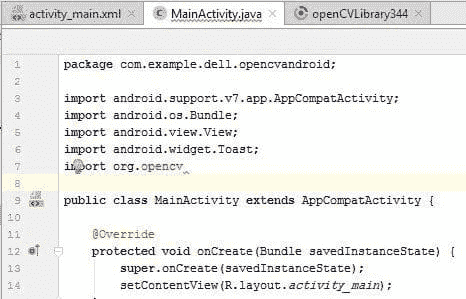

MainActivity.java 文件的内容如下所示。活动名称为 MainActivity,继承自 AppCompatActivity 类。众所周知,Android 活动继承自 Activity 类,但在本项目中,它实际上继承自 AppCompatActivity,因为我们在创建项目时选择了“向后兼容性”选项。

该活动仅有 onCreate() 方法,它在活动创建时被调用。它只使用 setContentView() 方法来设置活动的 XML 布局,该方法在启动时呈现活动的 UI。

XML 布局的内容如下所示。它简单地创建了一个 ConstraintLayout 类型的布局,宽度和高度覆盖设备屏幕。它只有一个子视图,即在构建项目时指定的 TextView。TextView 的文本设置为“Hello World!”。

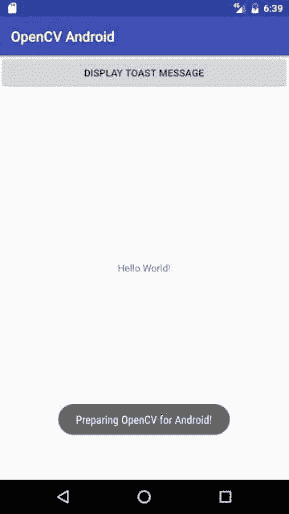

为了熟悉项目,我们来做一个简单的编辑,通过添加一个新的按钮视图,该视图在点击时显示 Toast 消息。添加按钮视图的编辑后的布局 XML 文件如下所示。按钮的文本设置为“显示 Toast 消息”。点击时,将调用一个名为 displayToast() 的回调方法。

displayToast() 方法在编辑过的活动 Java 文件中实现,如下所示。它使用 Toast 类来显示 Toast 消息。

再次运行项目并点击按钮时,消息将如下一图所示显示。通过这个步骤,我们确保项目运行正常,同时对主活动及其布局有了一些了解。现在,让我们开始导入 OpenCV 库。

下载 OpenCV

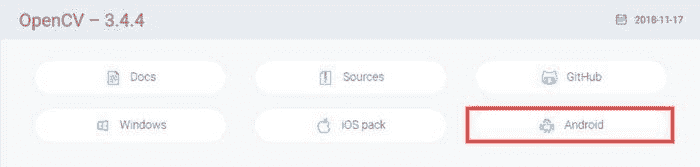

下载 OpenCV 时,你可以使用这个链接 opencv.org/releases,它列出了 OpenCV 的各个版本。在页面向下滚动,你可以找到本教程中使用的 OpenCV 3.4.4。如果最新的 4.1.0 版本对你来说是更好的选择,也可以下载。记得下载库的 Android 版本。

你将下载一个 ZIP 文件,需要将其解压。

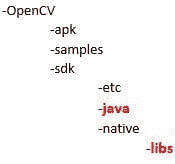

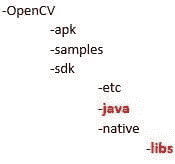

解压缩文件夹的目录结构见下图。我们将使用的两个重要文件夹是 java 和 libs。这两个文件夹都是 sdk 文件夹的子文件夹。

java 文件夹包含 OpenCV 的 Java 文件。因为并非所有文件都是用 Java 编写的,有些是用 C++ 编写的,并且仍需要在 Java 中使用,所以还有一个名为 libs 的文件夹来存放这些文件。

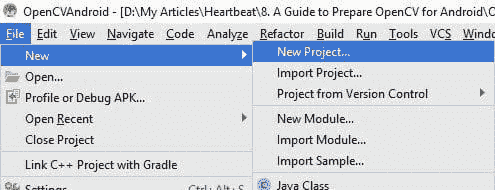

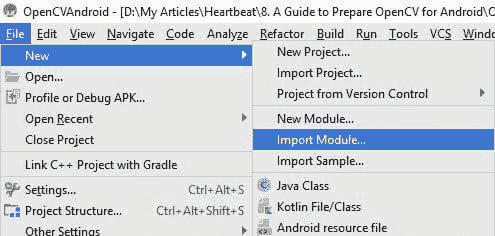

在 Android Studio 中导入 OpenCV

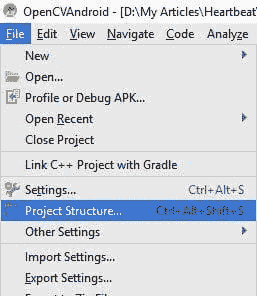

要在 Android Studio 中导入库,进入 File 菜单并选择“Import Module”,如下图所示。

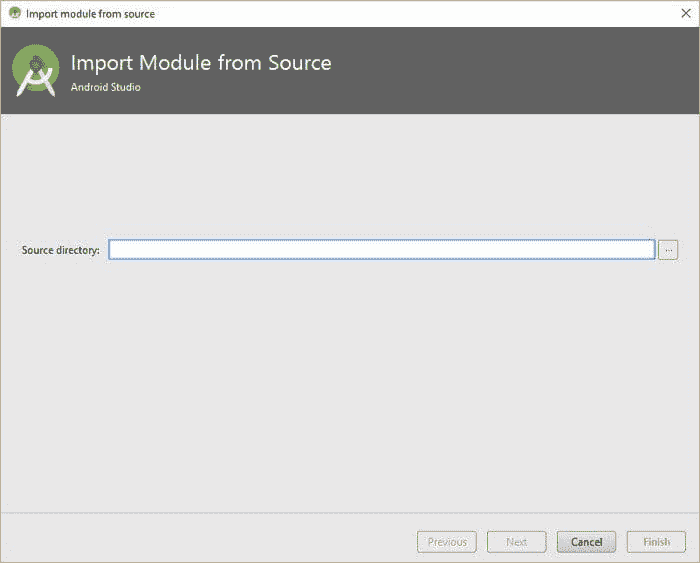

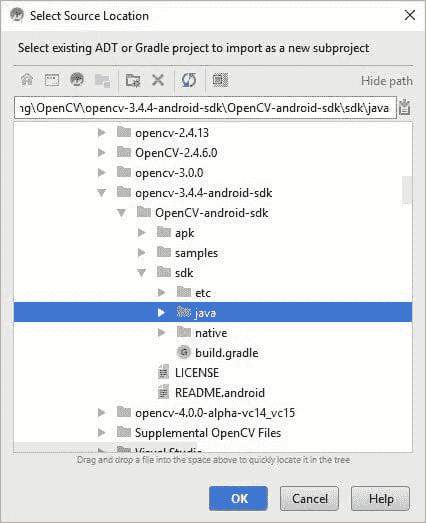

选择后,会出现一个新窗口,询问要导入的模块的路径,如下所示。

点击右侧“Source Directory”旁边的三个点,然后导航到下载的 OpenCV for Android 中 sdk 文件夹所在的路径。

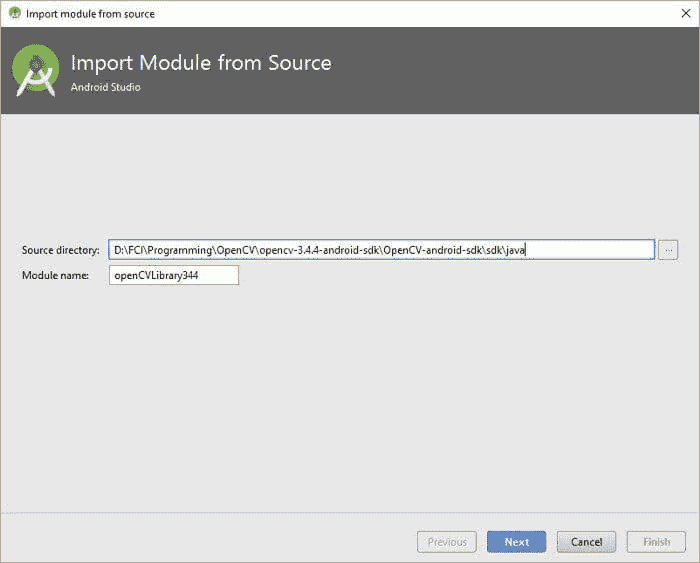

点击 OK 后,之前菜单中的“Source Directory”将根据选择的路径进行更改,如下图所示。模块名称将更改以反映 Android Studio 检测到 OpenCV。

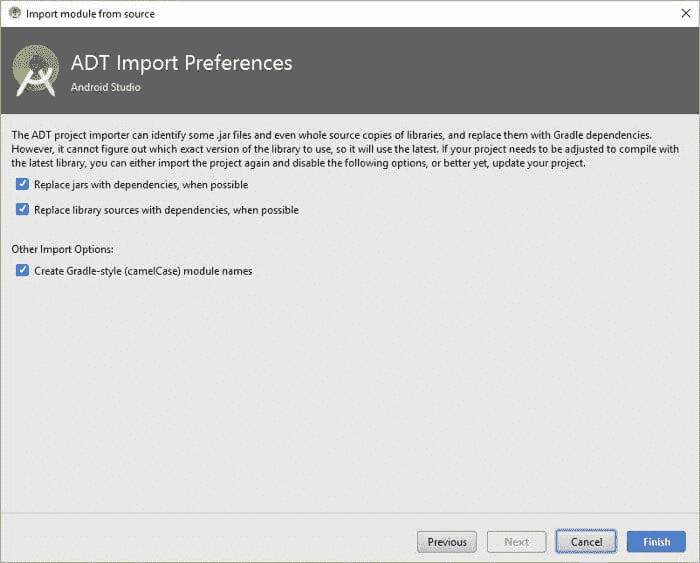

点击 Next 进入下一个窗口,在那里你只需点击 Finish 以导入库。点击 Finish 后,你需要等待 Gradle Sync 完成。

修复可能的 Gradle Sync 错误

在使用 Gradle 构建项目时,可能会出现多个错误。这里我们将讨论其中的 3 个。

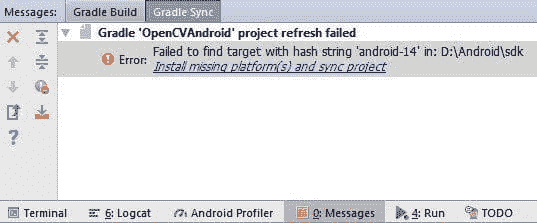

首先,你可能会遇到 Gradle Sync 错误,如下所示。问题在于 OpenCV 使用的 SDK 在环境中未安装。

我们可以通过两种方式解决这个问题。第一种是安装 OpenCV 使用的 SDK。第二种方法,在本教程中使用,是将 OpenCV 使用的 SDK 版本更改为已存在的 SDK 之一。

要更改 OpenCV 使用的 SDK,请将项目视图更改为 Project,然后转到导入的 OpenCV 下的 build.gradle 文件。不要忘记打开 OpenCV 库下的 build.gradle 文件,而不是应用下的。

此文件的内容如下所示。根据 compileSdkVersion 字段,它反映了 OpenCV 使用的 SDK 版本为 14 并且尚未安装。如果 SDK 14 已安装,则此错误可能不会出现。

如果没有安装 SDK 14,你可以更改为其他可用的 SDK。我将使用 SDK 21。下面列出了编辑后的 OpenCV 库 build.gradle 文件。你可以在进行此编辑后尝试重新同步项目,预期一切会在那之后成功运行。

第二个问题是 OpenCV 库的 build.gradle 文件中的第一行可能如下所示。这指的是导入的 OpenCV 是一个应用程序而不是库。我发现这一行存在于 OpenCV 4.1.0 中。

apply **plugin: 'com.android.application'**

使用这一行会在构建项目时返回错误。错误信息是:

无法解析‘**:app@debugUnitTest/compileClasspath’ 的依赖项:无法解析项目 :openCVLibrary433.**

因为 OpenCV 是作为库导入的,第一行必须是以下内容:

apply **plugin: 'com.android.library'**

将第一行更改为上面提到的内容可能还不够。这是因为如果 OpenCV 的 build.gradle 文件中的第一行是 apply plugin: ‘com.android.application’,则期望找到 applicationId 设置为 org.opencv。在作为库导入的项目中有这样的字段是一个问题。因此,你需要使用 // 将其格式化为注释,或者直接删除它。

添加 OpenCV 作为依赖

尽管在 Android Studio 内部导入了 OpenCV,但在 activity Java 文件中没有检测到 OpenCV。项目不知道 org.opencv 是什么。这是因为我们还需要在项目中将库添加为依赖。

为此,从文件菜单中选择“项目结构”菜单项,如下所示。

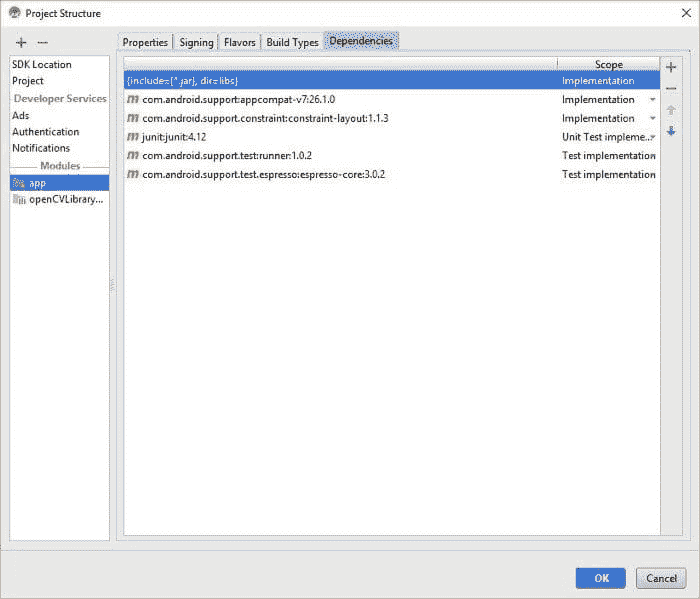

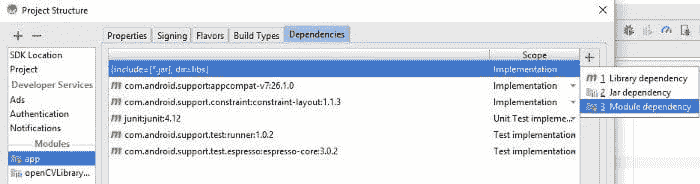

这会打开另一个窗口。在左侧的 模块 部分,点击 app,然后转到 依赖。这会打开依赖窗口。

为了添加新的依赖,点击屏幕右侧的绿色 + 图标,如下所示。会出现一个菜单,我们从中选择“模块依赖”选项。

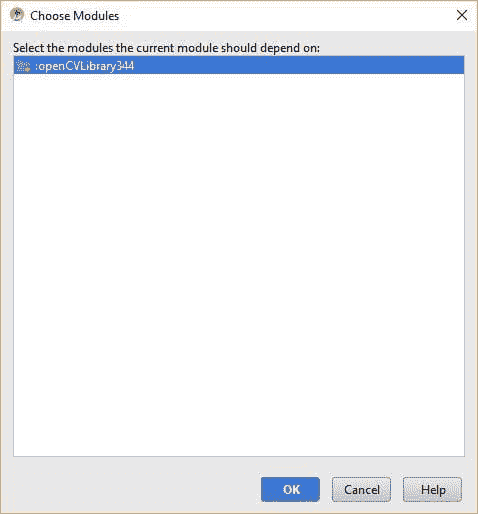

一个新窗口会打开,显示一个模块列表以供选择作为依赖项。我们只有一个 OpenCV 模块,因此只有一个项目可用。选择它并点击 OK。

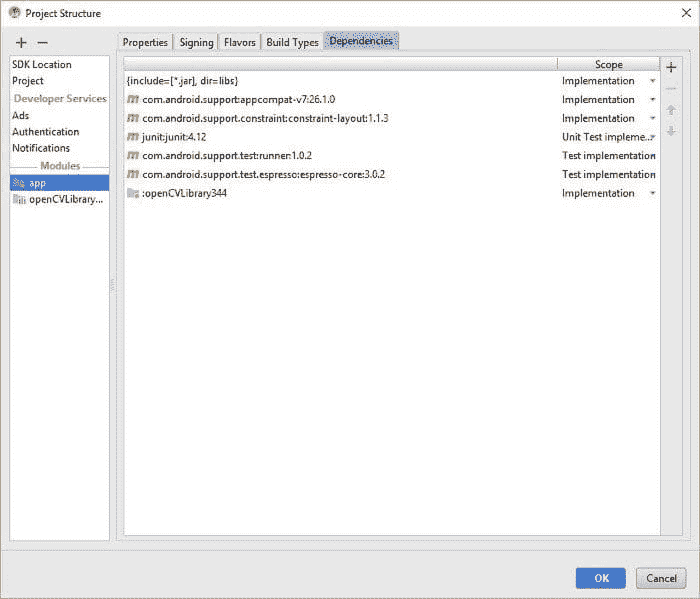

这会带你回到依赖窗口,但 OpenCV 已作为依赖之一添加。点击 OK 确认添加 OpenCV 作为依赖。

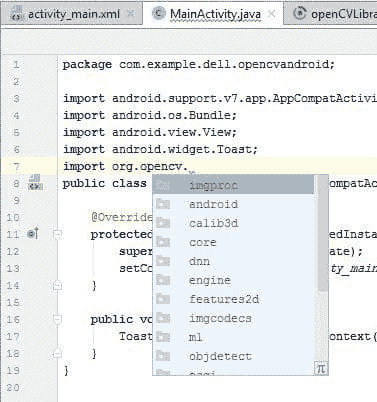

完成后,你会发现 OpenCV 库在 Java 代码中被检测到了。

添加本地库

OpenCV 中的一些文件是本地的。这意味着它们不是用 Java 编写的,而是用 C++ 编写的。这些文件可以在libs文件夹中找到。下载的 OpenCV 文件的文件夹结构如下,以便你重新记起libs文件夹的位置,即OpenCV/sdk/native/libs。

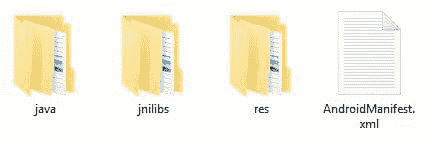

这个文件夹需要复制到项目中的这个目录:OpenCVAndroid/app/src/main/。非常重要的是将复制的文件夹重命名为jnilibs。完成后,项目的主文件夹内容如下图所示。完成这些步骤后,OpenCV 库就可以使用了。

使用 OpenCV 进行图像滤镜处理

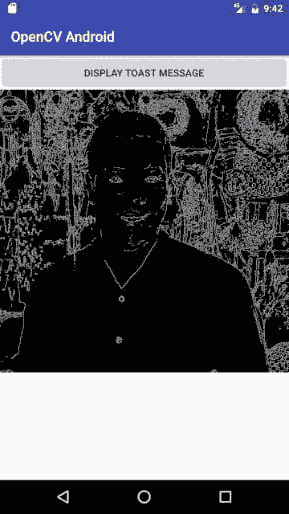

成功在 Android Studio 中导入 OpenCV 后,本教程的这一部分使用 OpenCV 对图像应用滤镜。GitHub 项目包含了已经导入 OpenCV 的 Android Studio 项目,并在点击按钮后对图像应用了 Canny 滤镜。

之前的应用布局将被修改以添加一个 ImageView,具体如下。这不是唯一的更改,因为所使用的布局被更改为LinearLayout。该布局的方向为垂直。此外,TextView 不再需要,因此被移除。

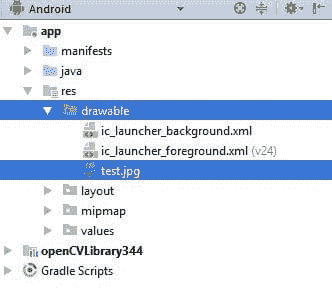

显示在 ImageView 上的图像是名为test的资源图像。为了将资源图像添加到项目中,只需使用 Android 项目视图,将图像文件拖放到drawable文件夹中,如下所示。图像文件名为test.jpg。该图像的资源名称test来源于文件名。

运行修改后的应用程序后的屏幕如下面所示。接下来,我们编写 Java 代码来读取在 ImageView 中显示的资源图像,使用 OpenCV 处理它,然后再次在 ImageView 中显示处理后的图像。

之前,按钮视图在点击时会显示一个 toast 消息。这一次,它将对图像应用 Canny 滤镜。修改后的 Java 代码如下。你只需创建一个名为test的 drawable 资源。

点击按钮后,资源图像会被读取为名为 img 的 OpenCV Mat。然后,使用 Canny() 方法对 Mat 进行滤镜处理,并将处理后的图像存储到 img_result Mat 中。

然后,这个 Mat 会使用 matToBitmap() 方法转换为位图图像。最后,使用 setImageBitmap() 方法将转换后的位图图像设置为 ImageView 上显示的图像。图像过滤后的结果如下图所示。

就这些!

总结

本教程讨论了在 Android Studio 中使用 OpenCV 的详细步骤。创建了一个 Android Studio 项目,并在确保其正常工作的情况下,开始准备 OpenCV。

为此,我们首先从官方网站下载了 OpenCV。之后,将 OpenCV 作为模块导入 Android Studio 项目,并将其添加为依赖项。接着,我们将libs文件夹(在 Android Studio 中)复制到项目中,并将其重命名为jnilibs。作为准备 OpenCV 用于 Android Studio 的最终步骤,我们使用OpenCVLoader初始化了onCreate()方法。

最后,我们确保了 OpenCV 在项目中的正常工作,并用它构建了一个简单的应用程序,在该程序中,通过 Canny 进行图像滤波。

联系作者

-

E-mail: ahmed.f.gad@gmail.com

-

LinkedIn:

linkedin.com/in/ahmedfgad -

Heartbeat:

heartbeat.fritz.ai/@ahmedfgad -

KDnuggets:

www.kdnuggets.com/author/ahmed-gad -

TowardsDataScience:

towardsdatascience.com/@ahmedfgad -

GitHub:

github.com/ahmedfgad

简历: Ahmed Gad 获得了埃及梅诺菲亚大学计算机与信息学院信息技术学士学位,并以优异成绩毕业。由于在学院排名第一,他在 2015 年被推荐到埃及的一所机构担任教学助理,随后在 2016 年继续担任教学助理及研究员。他当前的研究兴趣包括深度学习、机器学习、人工智能、数字信号处理和计算机视觉。

原文。转载经许可。

相关内容:

-

加速计算机视觉:来自亚马逊的免费课程

-

计算机视觉食谱:最佳实践和示例

-

联邦学习简介

更多相关内容

预测性维护机器学习技术指南

原文:

www.kdnuggets.com/2021/10/guide-right-predictive-maintenance-machine-learning-techniques.html

评论

由 Maruti Techlabs 提供

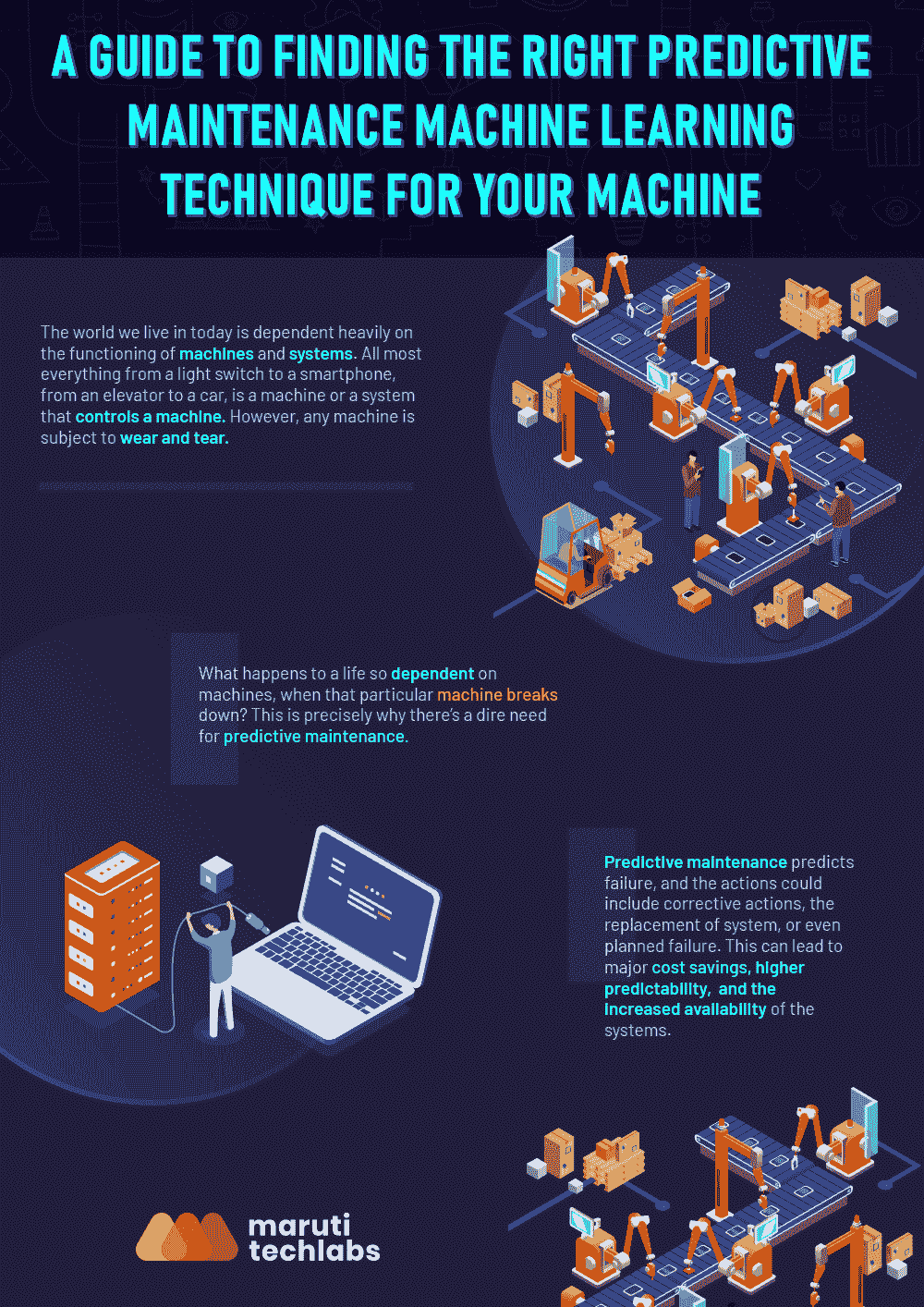

仔细考虑的话,你会发现我们今天生活的世界在很大程度上依赖于机器和系统的运行。从电灯开关到智能手机,从电梯到汽车,几乎所有东西都是机器或控制机器的系统。然而,任何机器都会出现磨损。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

3. 谷歌 IT 支持专业证书 - 支持你所在组织的 IT 工作

当一个生命如此依赖于机器时,如果那台特定的机器出现故障,会发生什么?这正是为何迫切需要通过机器学习进行预测性维护。

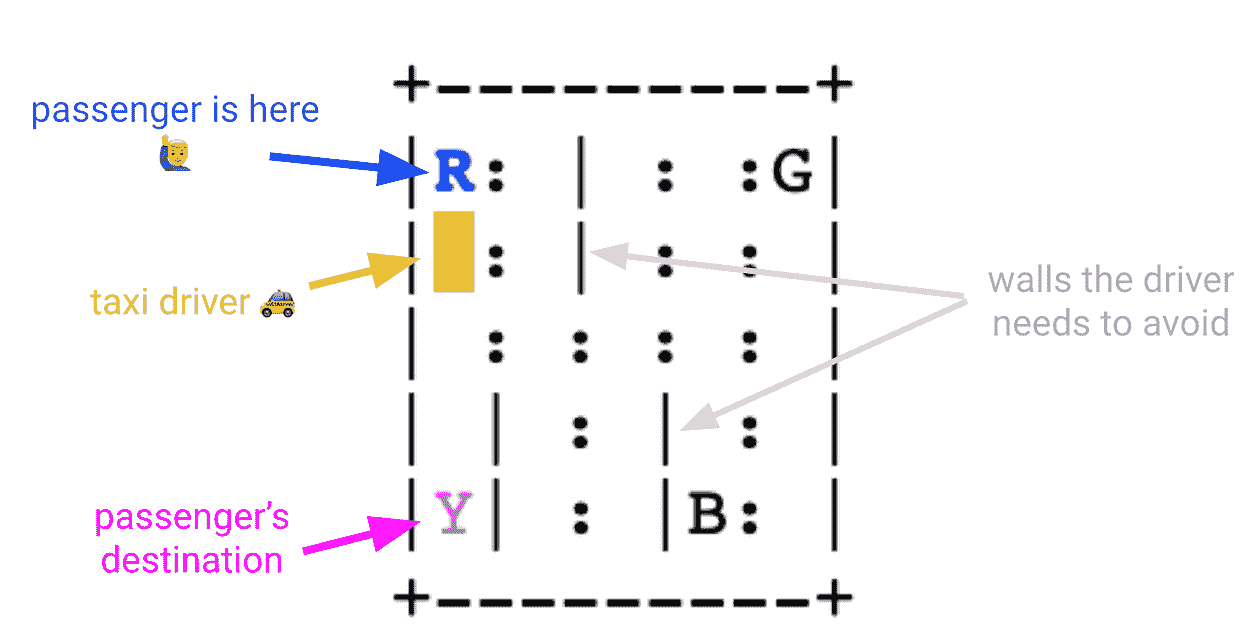

我们以出租车公司为例来理解这一点。如果你希望汽车按时运行,并在高峰工作时段不会出现故障,你需要确保所有移动部件得到适当维护。通常,有两种思维方式来消除故障或失败。

你可以选择保守一点,安排定期维护。在这种情况下,你不太可能完全了解机器的生命周期和实际导致故障的因素。由于这个过程不专注于在安排维护之前从机器中提取最大价值,因此成本可能会更高。例如,你可能会在轮胎完全使用之前更换它们,并在发动机油尚未充分使用之前更换它。结果,你将会在维护上花费更多。

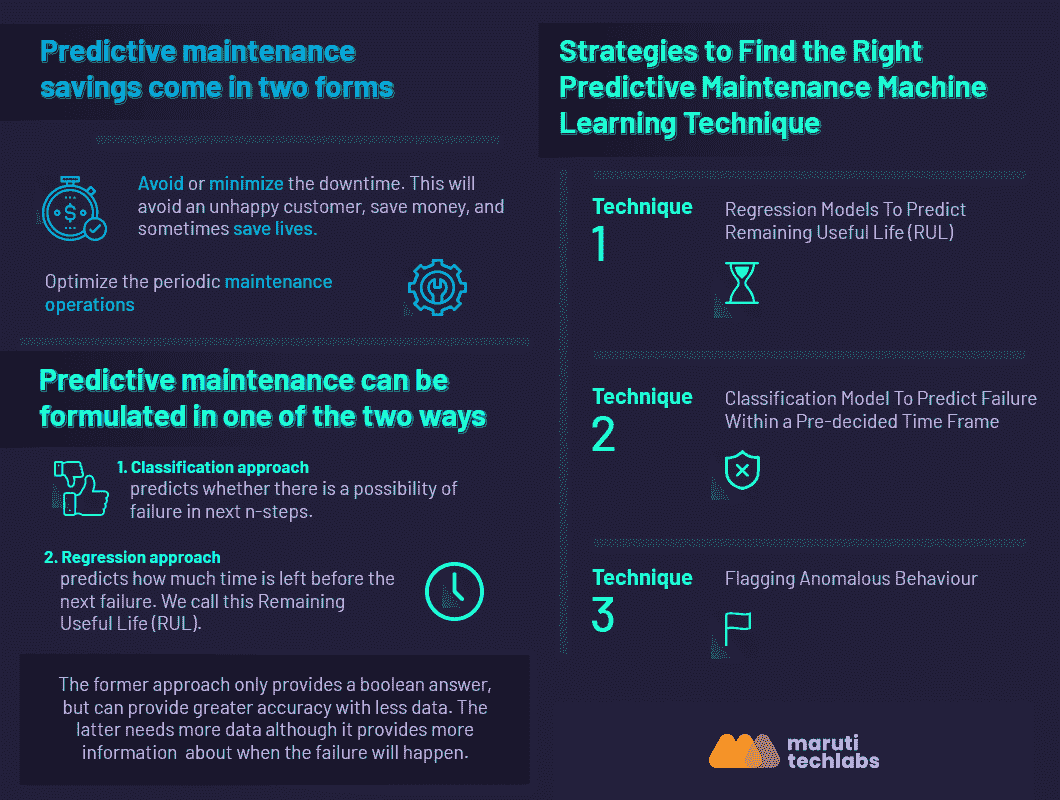

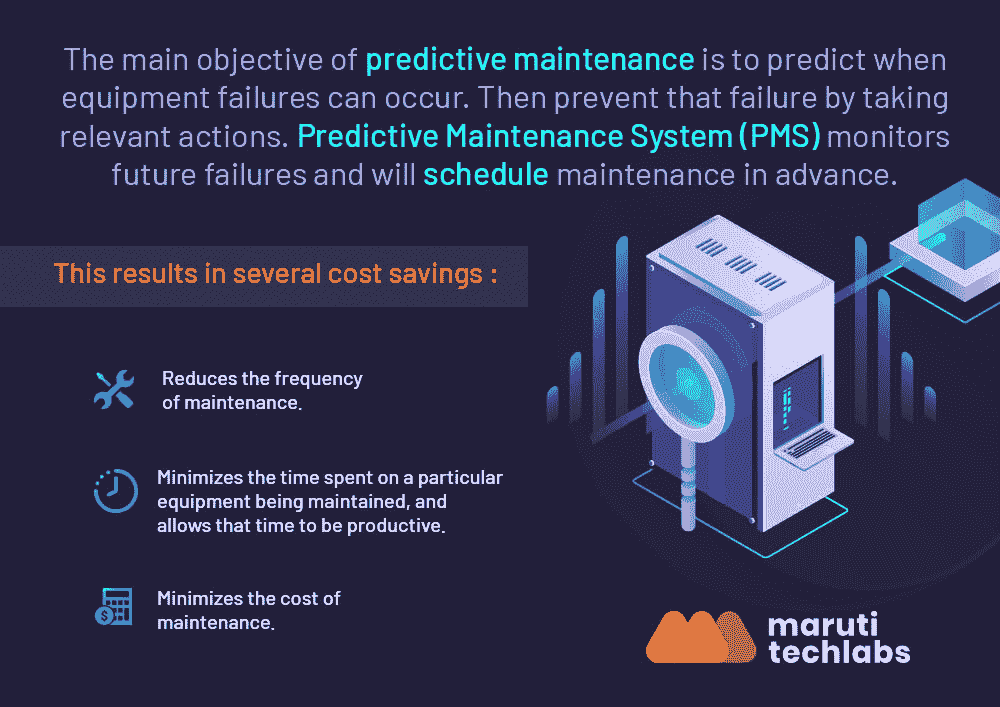

第二种思考方式是进行计算并基于预测数据分析做出决策。预测性维护使用机器学习从历史数据中学习,并利用实时数据分析故障模式。由于保守的方法会导致资源浪费,使用机器学习的预测性维护寻求资源的最佳利用,并在故障发生之前进行预测。因此,预测性维护避免了两种极端情况,力求找到完美的中间点。

但是你如何找到完美的中间点?你使用哪种机器学习技术?在这篇文章中,我们将探讨如何找到合适的技术,以成功进行基于机器学习的预测性维护。

收集数据

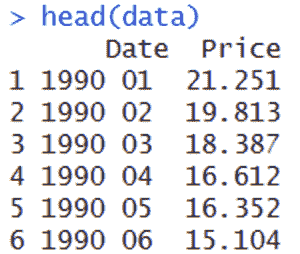

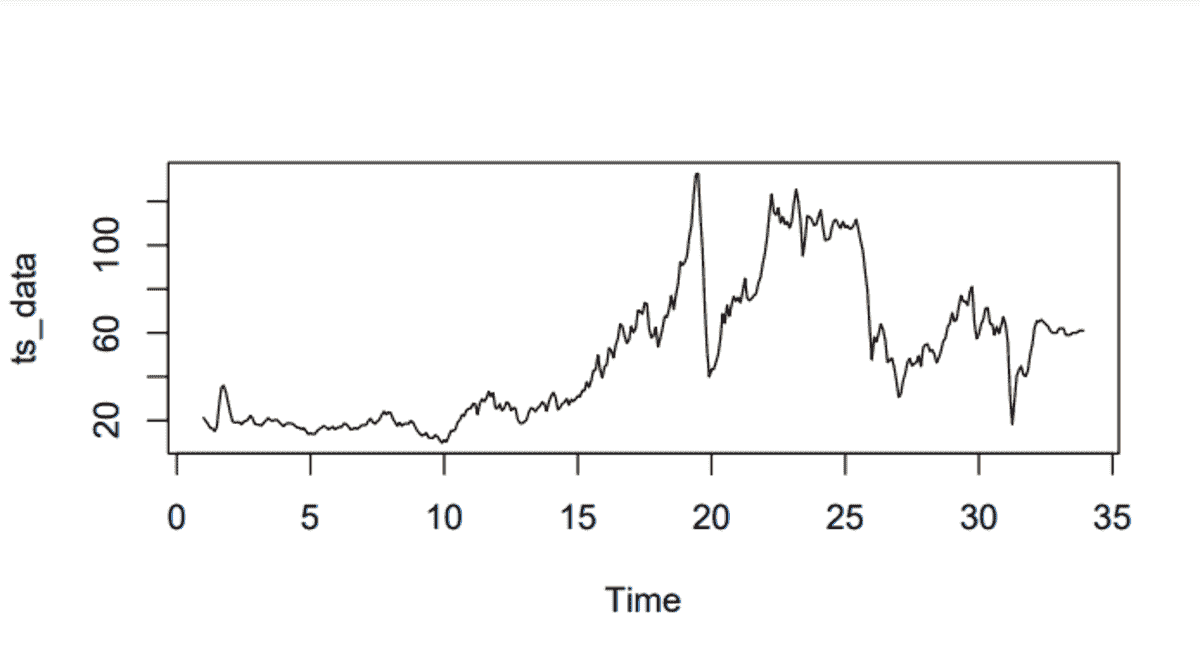

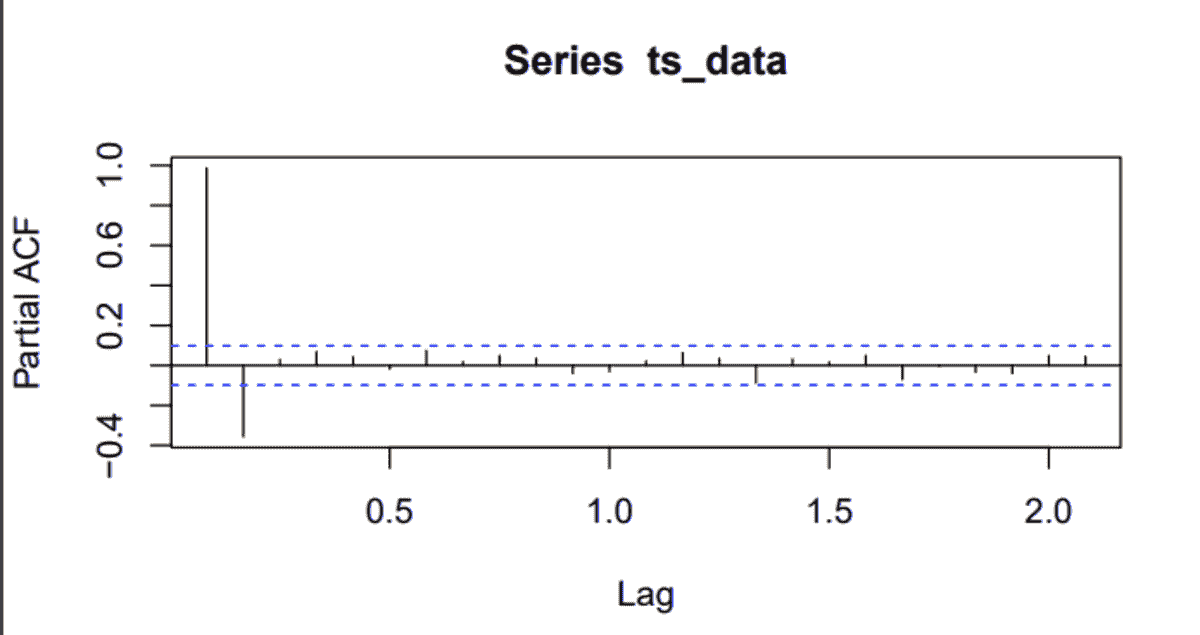

第一步应该是收集数据。需要随时监控需要预测故障的机器或系统。监控系统生成的数据需要被分类,以理解影响机器的各种条件和因素。例如,为了了解汽车发动机故障,传感器应记录温度、湿度、油位、油密度等。这些信息将为跟踪和预测故障模式及原因提供动力。预测性维护的数据是时间序列数据。

在设置传感器监控系统时,数据需要解决以下一些问题:

-

我们需要识别通常发生的故障类型。因此,第一步应该是识别这些故障,然后找到需要预测的故障。

-

接下来,我们需要对故障过程进行特征描述。故障过程是逐渐发生的,例如刹车片的磨损,还是急性问题,例如发动机进水?

-

在下一步中,我们需要确定哪些部件或过程与每种类型的故障相关。需要决定哪些不同的参数可以揭示过程的信息。因此,需要建立监测机制来测量和跟踪每个参数以及相关的部件/过程。

-

通常,机器的使用寿命是以多年为单位。因此,监控数据需要在较长时间内收集,以便正确记录退化过程。

-

通常,建议数据科学家和领域专家共同收集数据。领域专家对于了解机器及相应创建数据收集方案至关重要。同样,数据科学家需要确保收集的数据有用,并尽可能减少数据清理工作。

然而,在现实生活中,这种情况几乎不会发生。大多数组织自行跟踪数据。因此,当数据科学家到达时,已经收集了大量数据,重新开始数据收集过程可能会显著拖延整个过程。

因此,与其基于预先确定的模型收集数据,不如制定一个模型以最佳适应现有数据。

预测性维护机器学习技术

为了制定预测性维护模型,需要考虑一些必要的信息。

-

首要考虑应该是确定模型应该提供什么样的输出。

-

接下来,机器是否拥有足够的历史数据,或者我们是否依赖于静态数据?

-

每个事件都需要被记录、标记和登录。这将有助于快速识别标记,并允许数据科学家在短时间内筛选数据。这些数据将用于了解机器正常运作的指标以及故障的迹象。

-

同样,事件数量与故障之间是否存在直接相关性?是否存在只在过程故障前发生的特定事件?作为提前警告所需的最短时间是多少?

现在我们有了所需的信息,我们将决定哪种建模技术最适合数据集。在决定建模技术时,还会考虑期望的输出和可用条件。可以考虑三种主要的机器学习技术。然后,根据适配情况,可以做出最终决定。

技术 1 – 回归模型预测剩余使用寿命 (RUL)

所需数据类型——这种模型需要静态数据和历史数据。每个事件都需要被标记和登录。数据集中包含了每种故障类型的众多事件。这些数据集随后被用于训练模型,以预测可能的故障。

前提条件——假设静态特性可以用来预测故障。

-

这意味着需要同时使用历史数据和静态数据,并且退化过程是渐进的,而不是急性的。

-

模型将专注于一种类型的故障。如果模型要考虑不同类型的故障,则行为将会发生变化。

-

因此,成功率可能会有所不同。因此,最好采用线性方法,并对每种故障类型使用一种模型。每个事件都被标记和登录。

结果——该模型提供的输出是故障事件发生之前剩余的天数。这也被称为剩余使用寿命 (RUL)。

技术 2 – 分类模型预测预定时间框架内的故障

创建一个可以准确预测机器寿命的模型可能极具挑战性。然而,实际上,这样的模型并不必要。维护团队只需知道机器是否会在短期内故障。为此,我们可以使用classification model预测在接下来的'N'天或周期内的故障(其中 N = 任何数字)。

需要的数据类型 - 该模型还需要历史数据和静态数据。它还将依赖于标记和标签事件。因此,数据特征与技术 1 相同。

先决条件 - 先决条件与技术 1 非常相似。然而,存在以下列出的具体差异:

-

由于我们不是预测确切时间,而是寻找一个时间范围,因此模型不需要假设逐渐退化。

-

与回归模型不同,分类模型可以同时处理多种故障类型。唯一的要求是模型被框定为多类问题。

-

需要有标记的数据,但此外,还需要有足够的每种故障事件(和正常事件)实例来训练模型。

技术 3 – 标记异常行为

在前述的两种技术中,使用了历史数据和静态数据来训练模型。这有助于理解正常时间特征与故障事件特征之间的关系。然而,公司愿意消化多少故障事件以收集数据?在关键任务系统的情况下,故障案例是有限的。因此,需要采用不同的策略。

需要的数据类型 - 静态数据和历史数据都可用,但事件没有被标记和记录,或者数据不可用。

先决条件 - 假设可以从数据集中识别正常行为,并且可以区分正常事件与故障事件之间的差异。

结论

本质上,这里没有一种通用策略。每个项目都需要根据实际情况进行处理。第一步应是了解系统、问题、机器/系统周围的条件,然后根据所需结果制定模型。

在Maruti Techlabs,我们在高级预测建模和部署大规模大数据管道方面拥有丰富的经验。凭借一支经验丰富的数据科学和机器学习专业团队,我们为客户设计、实施和工业化机器学习及 AI 解决方案,覆盖众多行业。我们将技术技能与商业建议相结合,帮助企业建立数据驱动的能力。对我们的服务感兴趣?请随时联系或发送邮件至 hello@marutitech.com

简介: Maruti Techlabs 旨在通过数字化转型重新定义企业,并成为全球尊敬的企业,推动传统商业解决方案的边界。

原始。经授权转载。

相关:

-

在生产环境中服务 ML 模型:常见模式

-

20 个机器学习项目,让你找到工作

-

构建和运作机器学习模型:成功的三条建议

相关主题更多内容

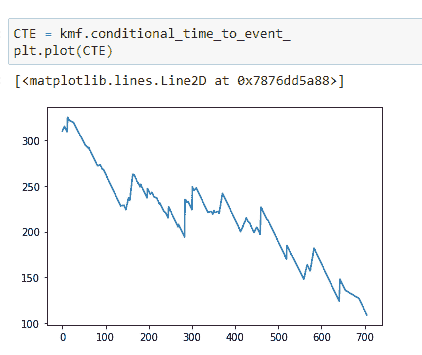

生存分析在 Python 中的完整指南,第二部分

原文:

www.kdnuggets.com/2020/07/guide-survival-analysis-python-part-2.html

评论

由 Pratik Shukla,有志的机器学习工程师。

在 这一三部分系列的第一篇文章中,我们了解了 Kaplan-Meier 估计器的基础知识。现在,是时候实现我们在第一部分讨论的理论了。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速入门网络安全职业。

1. 谷歌网络安全证书 - 快速入门网络安全职业。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你组织的 IT

示例 1:Kaplan-Meier 估计器(没有任何分组)

让我们编写代码:

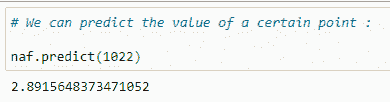

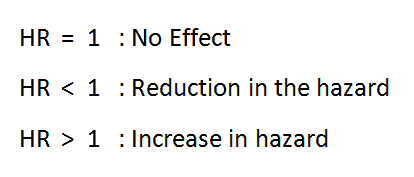

(1) 导入所需的库:

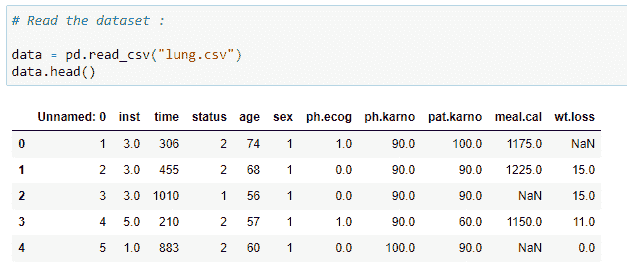

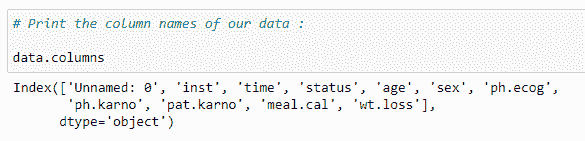

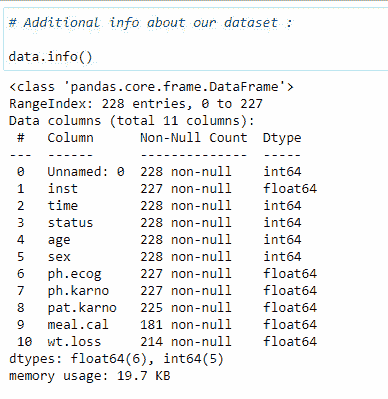

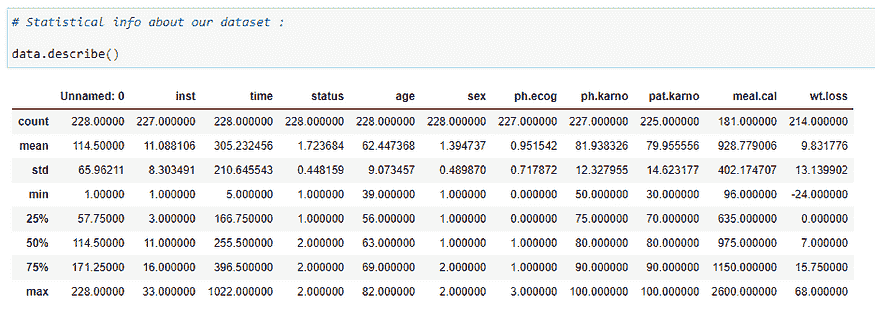

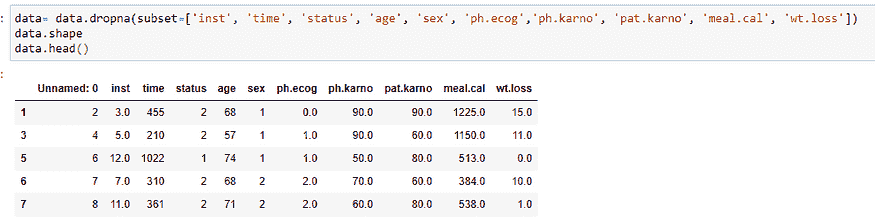

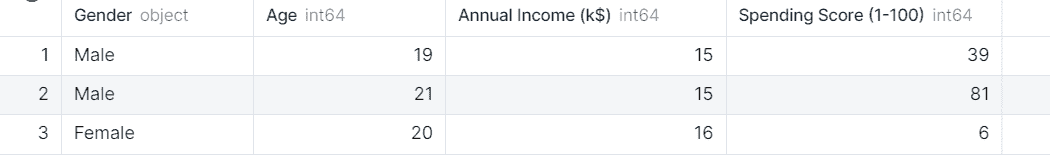

(2) 读取数据集:

(3) 数据集的列:

(4) 数据集的附加信息:

这提供了有关数据类型和每列中具有空值的行数的信息。对于生存分析中的某些方法,去除具有空值的行非常重要。

(5) 数据集的统计信息:

这提供了一些统计信息,如总行数、均值、标准差、最小值、第 25 百分位数、第 50 百分位数、第 75 百分位数和每列的最大值。

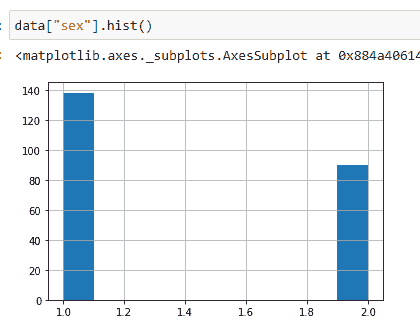

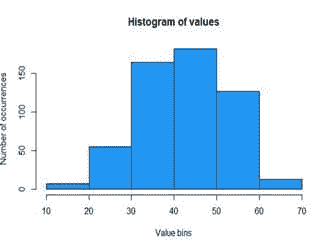

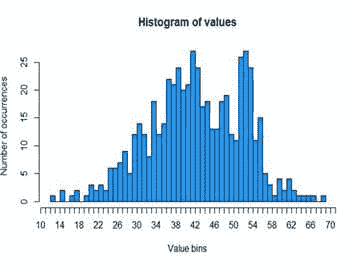

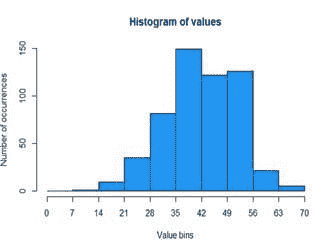

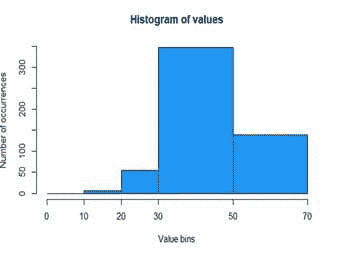

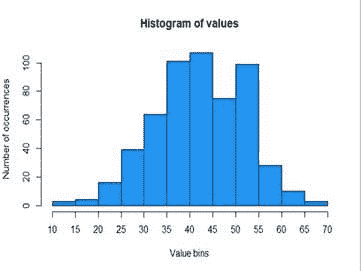

(6) 使用直方图查看性别分布:

这让我们对数据的分布有一个总体了解。在下面的图表中,你可以看到大约有 139 个值的状态为 1,大约 90 个值的状态为 2。这意味着在我们的数据集中,有 139 名男性和约 90 名女性。

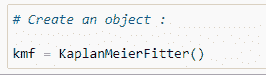

(7) 为 KaplanMeierFitter 创建对象:

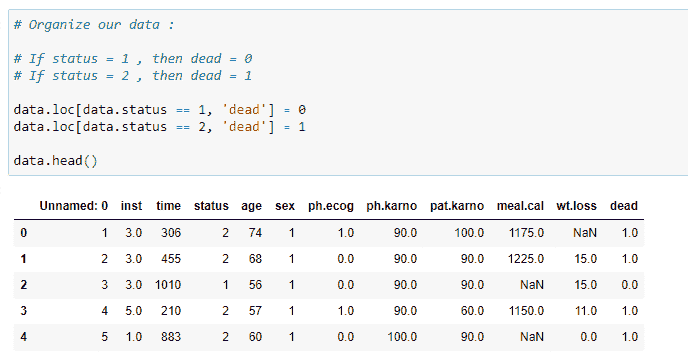

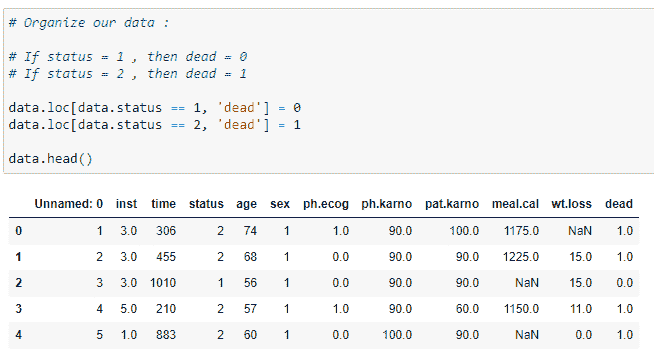

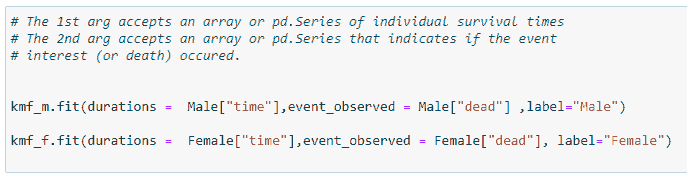

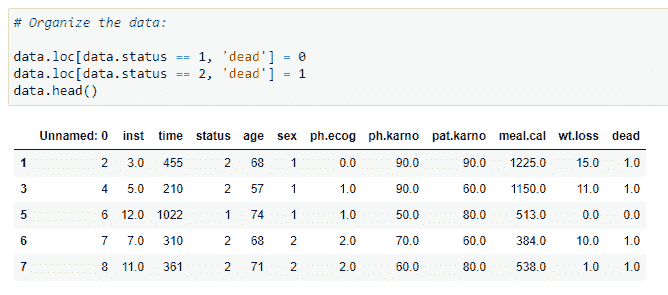

(8) 组织数据:

现在我们需要组织数据。我们将在数据集中添加一个名为“dead”的新列。它存储有关实验中人员是否生存的数据(基于状态值)。如果我们的状态值为 1,则该人活着;如果状态值为 2,则该人已死。这是我们在下一步需要做的非常关键的一步。因为我们将把数据存储在名为 censored 和 observed 的列中。观察数据存储特定时间线中死者的值,而 censored 数据存储活人或我们在该时间点不会调查的人的值。

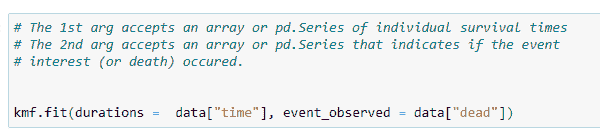

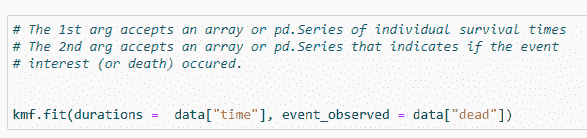

(9) 将数据拟合到对象中:

我们的目标是找到患者在死亡前存活的天数。因此,我们感兴趣的事件将是“死亡”,它存储在“dead”列中。它接受的第一个参数是我们实验的时间线。

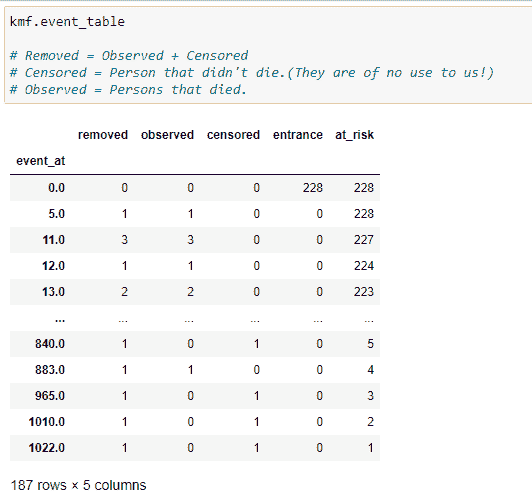

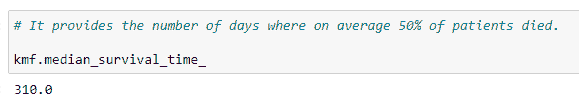

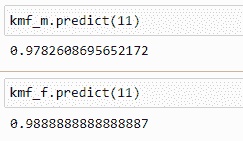

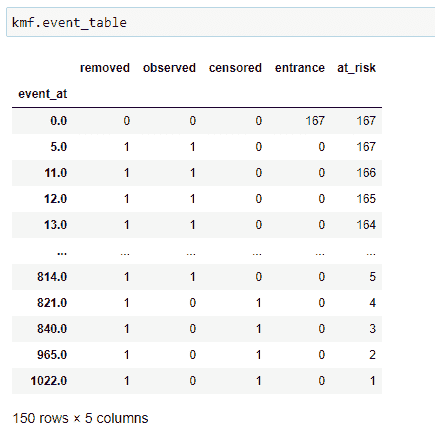

(10) 事件表:

kmf对象的一个最重要的方法是“event_table”。它为我们提供了适配数据的各种信息。让我们逐列查看。

(1) 事件时间: 存储数据集中时间线的值,即患者在实验中被观察到的时间或实验进行的时间。可以是分钟、天、月、年等。在我们的案例中,它将是天数。它基本上存储患者的生存天数。

(2) 风险中: 存储当前患者的数量。一开始,它将是我们在实验中要观察的总患者数。如果在某个时间点新增患者,我们需要相应地增加它的值。基本上,我们可以这样说:

at_risk = 当前患者 at_risk + 入口 — 移除

(3) 入口: 存储特定时间线中新患者的值。在我们有其他患者时,也可能有一些新患者被诊断出癌症。因此我们将其添加在这里。

(4) 审查: 我们的终极目标是找到患者的生存概率。如果在特定时间线上,实验中的人仍然活着,则该人进入审查类别。如果我们没有关于患者死亡时间的信息,则将其添加到审查数据中。其他可能性是如果患者选择搬到另一个无法进行实验的城镇,我们将该患者添加到审查类别中。

(5) 观察到: 实验期间死亡的患者数量。

(6) 移除: 存储不再参与实验的患者的值。如果一个人死亡或被审查,则他们属于这一类别。简而言之,

移除 = 观察 + 审查

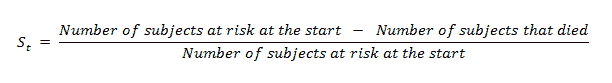

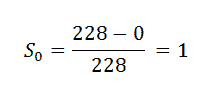

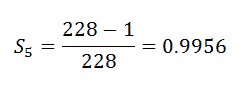

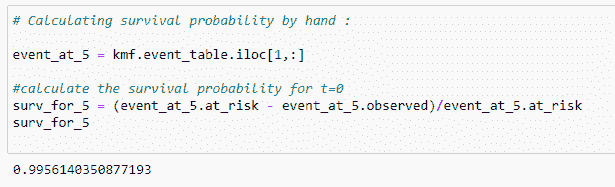

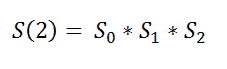

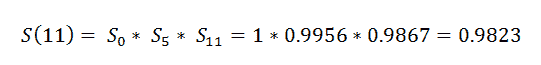

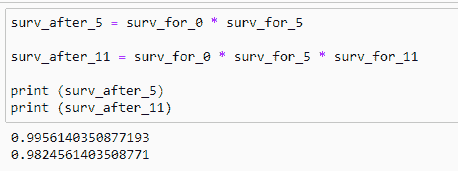

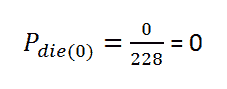

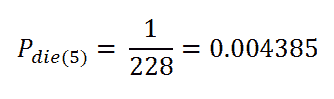

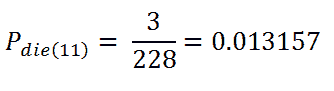

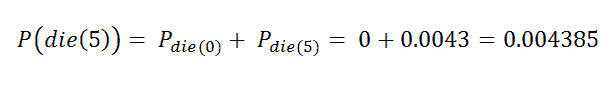

(11) 计算单个时间线的生存概率:

我们将使用以下公式手动计算:

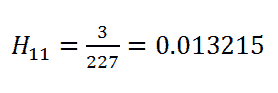

(12) Event_At_5:

(13) Event_At_11:

现在我们在这里找到的是某一特定时间段的概率。我们想要的是患者在整个时间段内的概率,即患者在所有实验回合中存活的概率。

这似乎很令人困惑,对吗?

让我们用一个非常简单的例子来理解条件概率的概念。

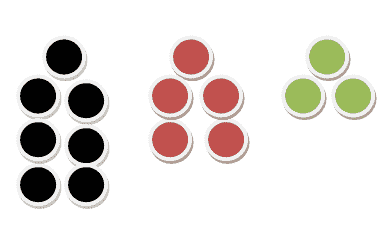

假设我们在一个不透明的盒子里总共有 15 个球。在这 15 个球中,有 7 个黑球、5 个红球和 3 个绿球。这是一个图示视图。

现在让我们找出一些概率吧!

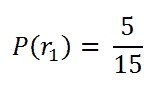

选择红球的概率:

注意,我们总共有 15 个球中的 5 个是红球。

选择第二个红球的概率:

由于我们已经移除了一个红球,因此我们剩下的红球总数是 4,总球数是 14。

现在我的意思是:如果我们想找出两个选中的球都是红色的概率。这就是我们的情况。比如我们想找出一个患者在第一次时间区间存活的情况下,第二次时间区间存活的概率。我的意思是我们不仅仅想找出第二个时间区间的概率,我们想要的是他们在这个时间段内存活的总概率。

在这种情况下,我们想找出选中的两个球都是红色的概率是多少?

两个红球的概率。

在这里,我们的目标是找出这个人整个时间线上的概率。比如他们在第一次、第二次和第三次时间线中存活,那么他们的生存概率将是:

回到我们的主要示例:

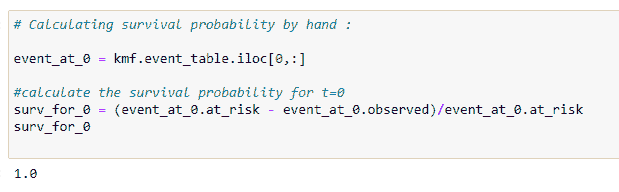

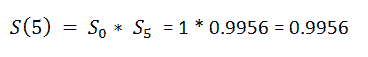

(14) Surv_After_probability:

我们想找出一个患者到目前为止存活的概率。现在我们需要找出患者的实际生存概率。

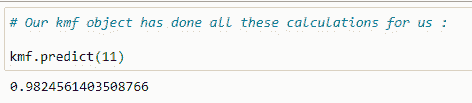

(15) Predict function:

现在,kmf对象的预测函数会为我们完成所有这些工作。但了解其背后的逻辑总是好的。

(16) Finding survival probability for an array of the timeline:

我们可以找到一系列时间的概率。

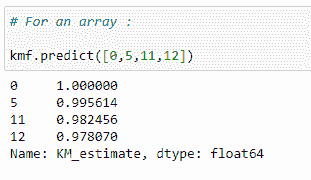

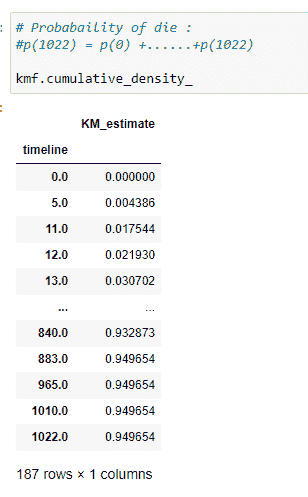

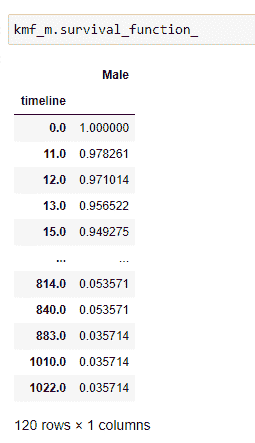

(17)获取整个时间线的生存概率:

kmf 对象的 survival_function_ 提供了我们时间线的完整数据。

解释:

在时间线 0 时,患者的生存概率为 1。如果你仔细考虑,就会明白在诊断后的第 1 天一个人死亡的概率几乎为 0。因此,我们可以说生存概率尽可能高。随着时间线的增加,患者的生存概率会降低。

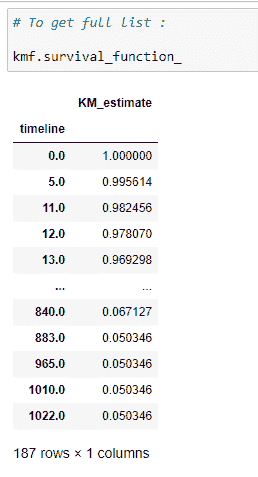

(18)中位数:

它提供了在平均情况下,50% 的患者存活的天数。

从上述代码中,我们可以说,平均来说,一个人在诊断后的 310 天后生存。

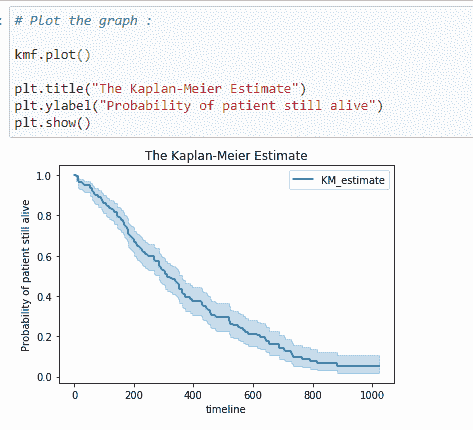

(19)绘制图表:

在这里,我们可以绘制生存概率的图表。

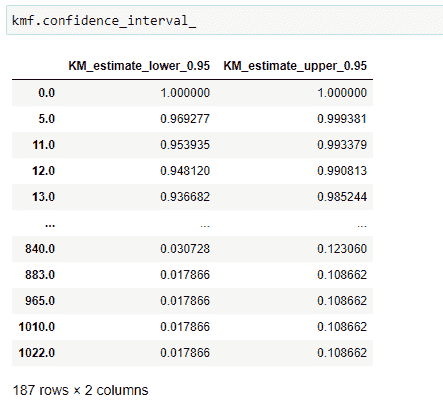

(20)置信区间:

置信区间给出了我们较为确定的真实值所在的范围。你可以在上面的图表中看到,浅蓝色阴影表示生存的置信区间。从中我们可以说该时间线上的概率确实位于该置信区间之间。

现在我们掌握的所有信息都是关于一个人的生存。现在我们将查看某个时间线上的人死亡的概率。在这里要注意,高生存概率对一个人来说是好的,但更高的累积分布密度(死亡概率)则不那么好!

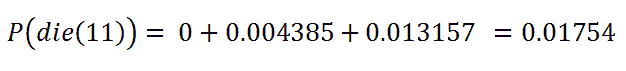

(21)一个人死亡的概率:

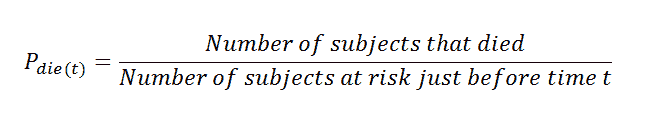

在这里注意到,分母值是时间 (t) 之前的风险对象。简单来说,我们可以说前一行的对象 at_risk。

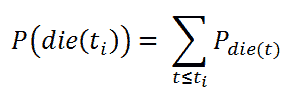

累积分布密度的公式:

累积分布密度。

手动计算概率:

t = 0

t = 5

t = 11

查找累积分布密度:

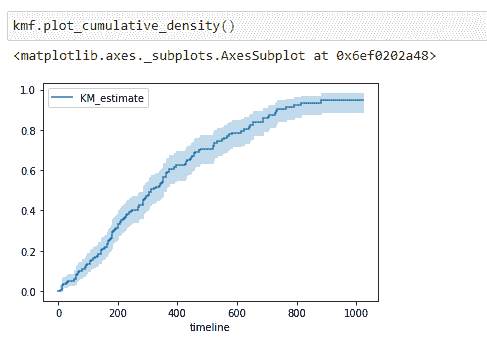

(22)绘制图表:

注意到,随着生存天数的增加,死亡概率也增加。

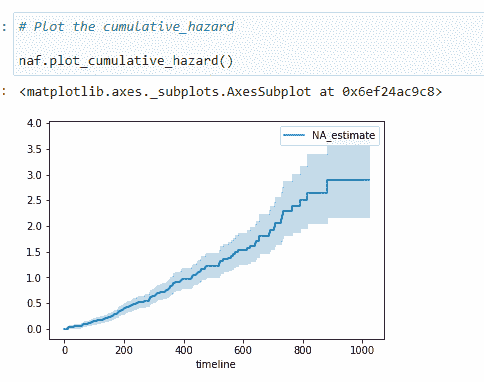

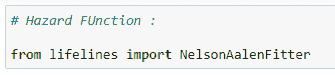

示例 2:使用 Nelson-Aalen 估计风险率

风险函数:

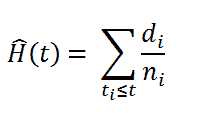

生存函数是总结和可视化生存数据集的好方法。然而,这并不是唯一的方法。如果我们对一个人群的危险函数 h(t) 感到好奇,不幸的是,我们不能转化 Kaplan-Meier 估计。为此,我们使用 Nelson-Aalen 危险函数:

危险函数

其中,

di = 时间 ti 的死亡人数

ni = 开始时的患者数量。

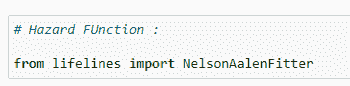

(23) 导入库:

(24) 拟合数据:

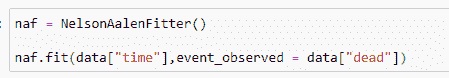

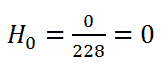

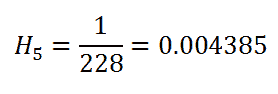

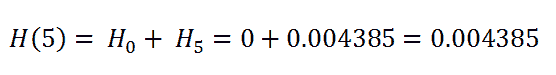

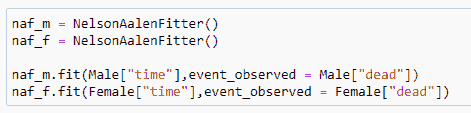

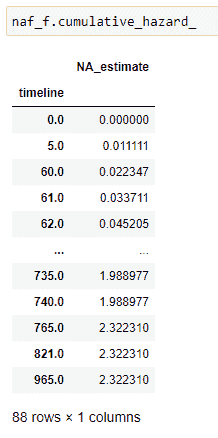

(25) 累积危险度:

请记住我们考虑当前行的 at_risk:

(26) 绘制数据:

累积危险度不如生存函数那么直观易懂,但危险函数是更高级生存分析技术的基础。

(27) 预测一个值:

综合起来:

在下一篇文章中,我们将讨论对数秩检验和 Cox 回归,并提供示例。

原始。已获许可转载。

简介: Pratik Shukla 是一位有抱负的机器学习工程师,喜欢将复杂理论以简单的方式呈现。Pratik 在计算机科学专业完成了本科,并正在南加州大学攻读计算机科学硕士学位。 “向月亮射击。即使错过,你也会落在星星之间。 -- Les Brown”

相关:

更多相关信息

《Python 生存分析完整指南》第三部分

原文:

www.kdnuggets.com/2020/07/guide-survival-analysis-python-part-3.html

评论

由Pratik Shukla,有志于成为机器学习工程师。

系列索引

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT 工作

3. Google IT 支持专业证书 - 支持你的组织 IT 工作

第一部分:

(1) 生存分析基础。

第二部分:

(2) Kaplan-Meier 拟合器理论与示例。

(3) Nelson-Aalen 拟合器理论与示例。

第三部分:

(4) 基于不同组的 Kaplan-Meier 拟合器。

(5) 带示例的 Log-Rank 检验。

(6) 带示例的 Cox 回归。

在上一篇文章中,我们讨论了如何分析患者的生存概率。但我们还需要知道哪个因素对生存的影响最大。因此,在这篇文章中,我们将讨论基于不同组的 Kaplan-Meier 估计器。

示例 3:带组的 Kaplan-Meier 估计器

让我们将数据分为 2 组:男性和女性。我们的目标是检查如果我们按性别划分数据集,生存率是否存在显著差异。

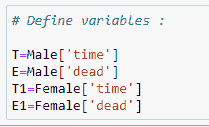

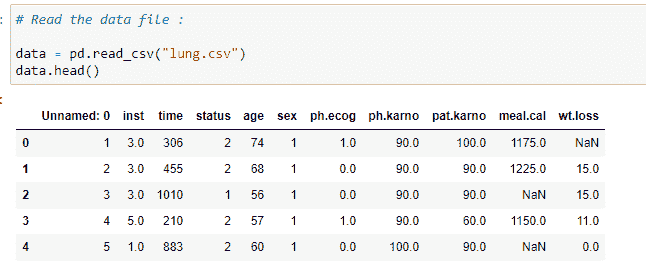

(1) 导入所需的库:

(2) 读取数据集:

(3) 组织我们的数据:

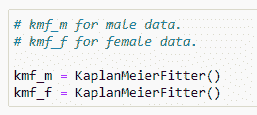

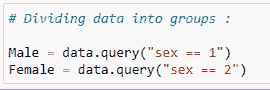

(4) 创建两个 KaplanMeierFitter()对象:

kmf_m 用于男性数据集。

kmf_f 用于女性数据集。

(5) 将数据划分为组:

(6) 将数据拟合到我们的对象中:

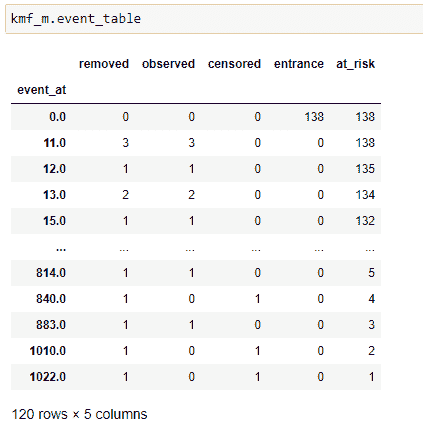

(7) 生成事件表:

男性事件表。

女性事件表。

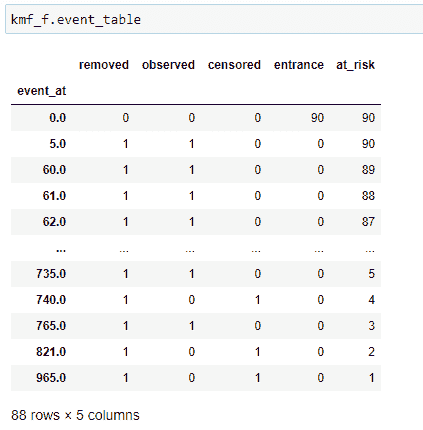

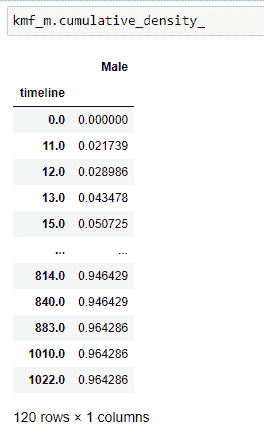

(7) 预测生存概率:

现在我们可以预测两个组的生存概率。

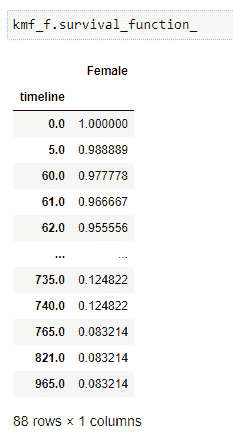

(8) 获取生存概率的完整列表:

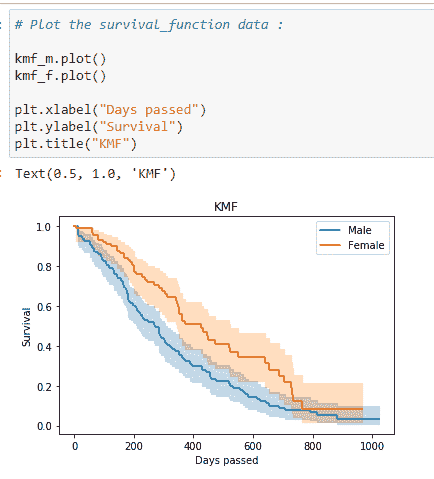

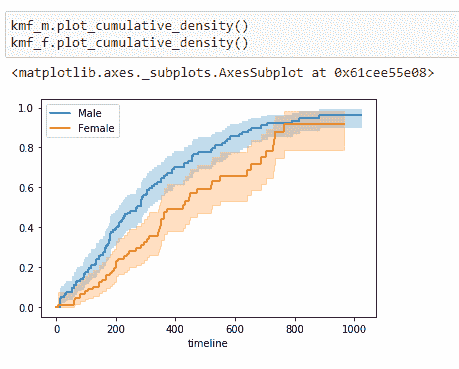

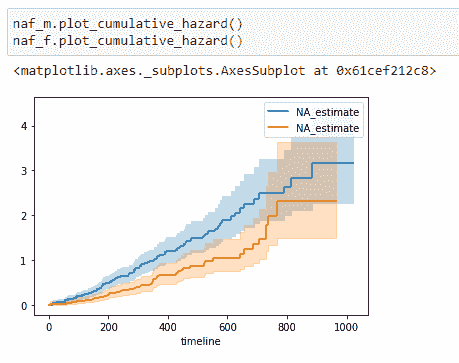

(9) 绘制图表:

注意到女性存活于肺癌的概率高于男性。因此,从这些数据中,我们可以说医学研究人员应更多关注导致男性患者存活率较低的因素。

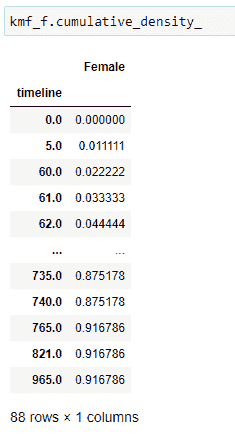

(10)累积分布:

它给出了一个人在某一时间点死亡的概率。

(11)绘制数据:

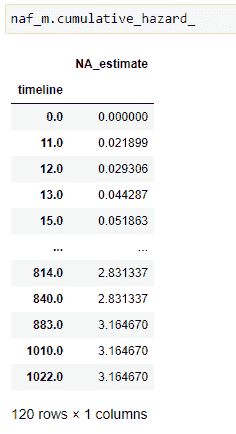

(12)风险函数:

(13)数据拟合:

(14)累积风险:

(15)绘制数据:

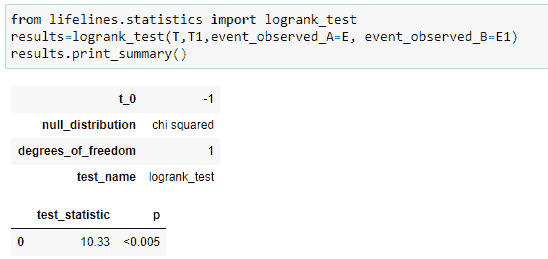

对数秩检验

目标:在这里,我们的目标是查看被比较组之间是否存在显著差异。

原假设:原假设表明所研究的组之间没有显著差异。如果这些组之间存在显著差异,则必须拒绝我们的原假设。

我们如何说存在显著差异?

统计显著性由一个介于 0 和 1 之间的 p 值表示。p 值越小,所研究组之间的统计差异越大。请注意,我们的目标是找出我们比较的组之间是否存在差异。如果存在,我们可以基于各种信息如饮食、生活方式等进一步研究为何某个组的存活机会较低。

小于(5% = 0.05)P-值表示我们比较的组之间存在显著差异。我们可以根据性别、年龄、种族、治疗方法等对组进行划分。

这是一种找出 P 值的方法。

在这里,我们将通过著名的对数秩检验方法比较两个不同组的生存分布。请注意,对于我们的组,检验统计量为 10.33,P 值显示为(<0.005),这是统计上显著的,表示我们必须拒绝原假设,并承认两个组的生存函数存在显著差异。P 值为“性别”与生存天数相关提供了有力证据。简而言之,我们可以说在我们的示例中,“性别”对生存天数有主要贡献。

汇总起来:

示例 4:Cox 比例风险模型

Cox 比例风险模型基本上是一个回归模型,通常由医学研究人员用来找出受试者的生存时间与一个或多个预测变量之间的关系。简而言之,我们想了解年龄、性别、体重、身高等不同参数如何影响受试者的生存时间。

在前一节中,我们了解了 Kaplan-Meier、Nelson-Aalen 和 Log-Rank 检验。但在那些方法中,我们只能逐个考虑变量。而且需要注意的是,我们只对性别、状态等分类变量进行操作,这些变量通常不用于像年龄、体重等非分类数据。作为解决方案,我们使用 Cox 比例风险回归分析,它适用于定量预测(非分类)变量和分类变量。

为什么我们需要它?

在医学研究中,通常我们考虑多个因素来诊断一个人的健康状况或生存时间,即我们通常使用性别、年龄、血压和血糖等因素,以找出不同组之间是否有显著差异。例如,如果我们根据一个人的年龄对数据进行分组,那么我们的目标是找出哪个年龄组的生存机会更高。是儿童组、成人组,还是老年组?现在我们需要找出我们如何分组。为此,我们使用 Cox 回归分析,找出不同参数的系数。让我们看看它是如何工作的!

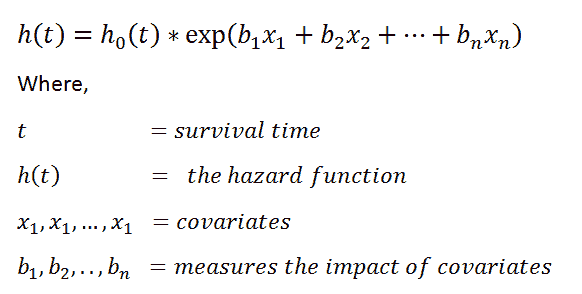

Cox 比例风险方法的基础:

Cox 比例风险方法的最终目的是观察数据集中不同因素对感兴趣事件的影响。

风险函数:

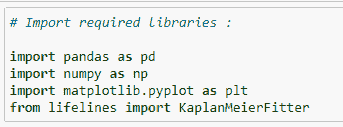

exp(bi)的值称为风险比(HR)。HR 大于 1 表示,当第 i 个协变量的值增加时,事件风险增加,从而生存期减少。

总结一下,

让我们编写代码:

(1) 导入所需库:

(2) 读取 CSV 文件:

(3) 删除包含空值的行:

在这里,我们需要删除包含空值的行。我们的模型无法处理含有空值的行。如果不对数据进行预处理,我们可能会遇到错误。

(4) 创建 KapanMeierFitter 对象:

(5) 组织数据:

(6) 拟合值:

(7) 事件表:

(8) 导入 Cox 回归库:

(9)在拟合我们的模型时需要考虑的参数:

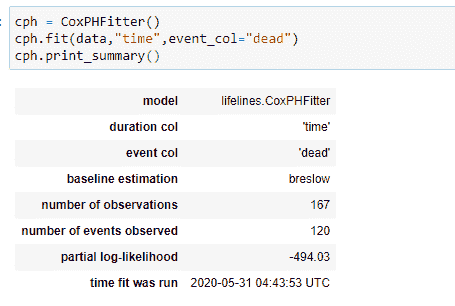

(10)拟合数据并打印摘要:

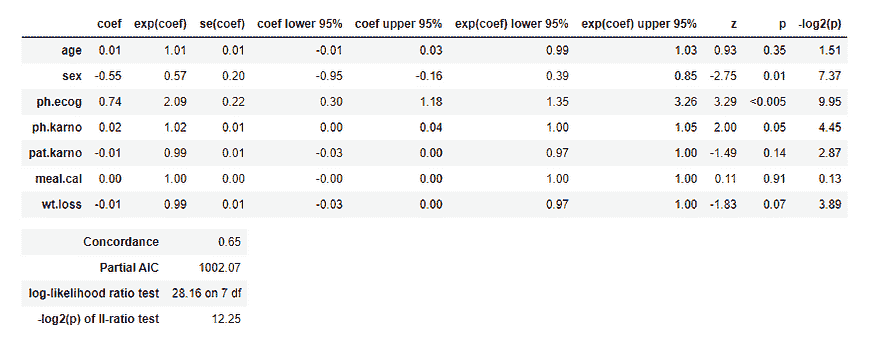

我们的模型将考虑所有参数,以找到相应的系数值。

注意不同参数的 p 值,我们知道 p 值(<0.05)被认为是显著的。你可以看到 sex 和 ph.ecog 的 p 值都 <0.05。因此,我们可以根据这些参数对数据进行分组。

HR(风险比) = exp(bi)

性别的 p 值为 0.01,HR(风险比)为 0.57,表明患者性别与死亡风险降低之间存在很强的关系。例如,在其他协变量保持不变的情况下,女性(性别=2)将风险降低了 0.58 倍,即 42%。 这意味着女性的生存几率更高。注意,我们使用前一部分的图表得出了这个结论。

ph.ecog 的 p 值为 <0.005,HR 为 2.09,表明 ph.ecog 值与死亡风险增加之间有很强的关系。在其他协变量保持不变的情况下,较高的 ph.ecog 值与较差的生存有关。这里 ph.ecog 值较高的人有 109% 更高的死亡风险。 所以,简而言之,我们可以说医生试图通过提供相关药物来降低 ph.ecog 的值。

现在注意到年龄的 HR 是 1.01,这表明年龄较大组的风险仅增加 1%。所以我们可以说不同年龄组之间没有显著差异。

简而言之,

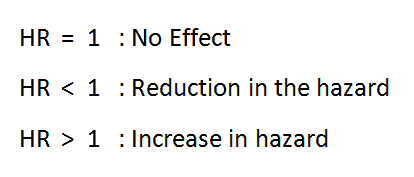

(11)检查图表中哪个因素影响最大:

你可以清楚地看到 ph.ecog 和性别变量有显著差异。

(12)绘制图表:

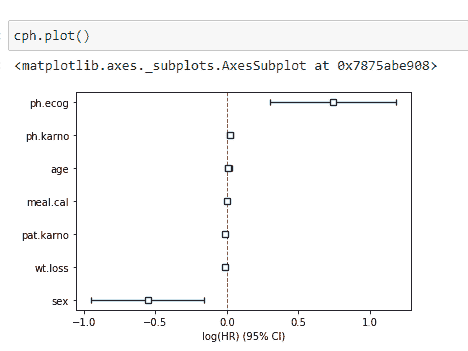

在这里,我绘制了我们数据集中不同个体的生存概率图。注意,person-1 的生存几率最高,而 person-3 的生存几率最低。如果你查看主要数据,你会发现 person-3 的 ph.ecog 值较高。

注意,即使 person-5 仍然活着,由于其较高的 ph.ecog 值,他/她的生存概率较低。

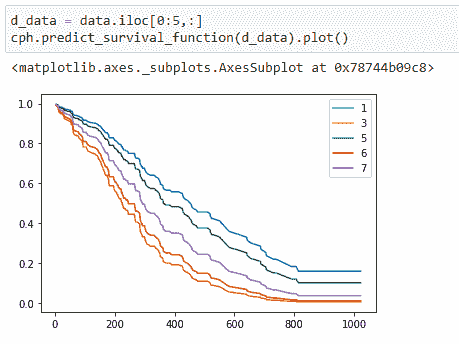

(13)找出时间线的中位事件时间:

注意,随着时间的推移,中位生存时间在减少。

将所有内容整合在一起:

原文。已获得许可转载。

个人简介:Pratik Shukla是一名有抱负的机器学习工程师,喜欢将复杂的理论简化表达。Pratik 完成了计算机科学的本科学业,并计划在南加州大学攻读计算机科学硕士学位。“瞄准月球。即使错过了,你也会落在星星之间。-- 莱斯·布朗”

相关内容:

更多主题

数据科学备忘单指南

原文:

www.kdnuggets.com/2014/05/guide-to-data-science-cheat-sheets.html

评论由 Ajay Ohri,2014 年 5 月。

评论由 Ajay Ohri,2014 年 5 月。

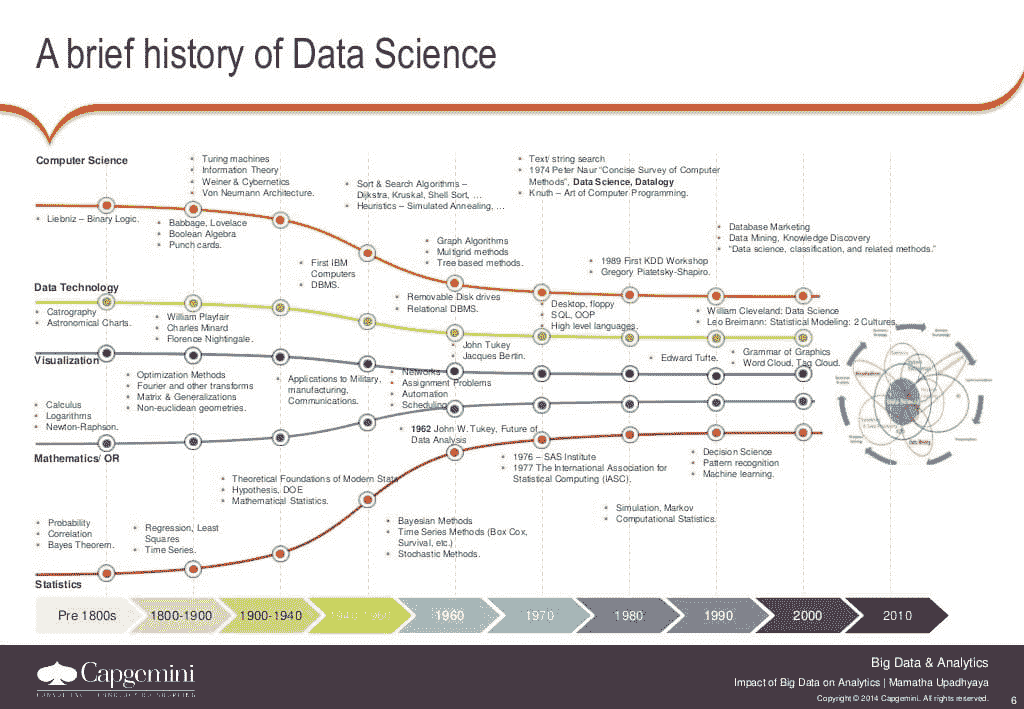

近年来,随着数据科学家的需求和热度持续增长,人们渴望了解如何加入、学习、进步并在这个看似有利可图的职业中蓬勃发展。作为一个从事分析写作并偶尔教授这门课程的人,我经常被问到——我如何成为一名数据科学家?

我回答的复杂性增加了,因为数据科学似乎是一个多学科领域,而统计学、计算机科学和管理学的大学部门在处理数据时方式各异。

但抛开营销创造的术语不谈,数据科学家只是一个能够用几种语言(主要是 R、Python 和 SQL)编写代码进行数据查询、操作、聚合和可视化的人,并运用足够的统计知识为业务提供可操作的见解,以便做出决策。

由于这种数据科学家的实际定义得到“数据科学家”工作网站上附带词汇的支持,因此,这里有一些学习数据科学主要语言——Python、R 和 SQL 的工具。备忘单或参考卡片是一个主要用于帮助你更快学习该语言语法的命令汇编。

包括 SQL 可能会让一些人感到惊讶(这不是 NoSQL 时代吗?),但这是有逻辑原因的。PIG 和 Hive 查询语言与 SQL——原始的结构化查询语言密切相关。此外,R 中的sqldf包(以及 Pythonic 数据科学家较少使用的python-sql或python-sqlparse库)或甚至旧语言 SAS 中的 Proc SQL 命令,也可以完成数据科学家预期完成的大部分任务(至少在数据清洗方面)。

对于 Python 而言,这是一个相当部分的列表,因为 Python 是数据科学家工具包中的通用语言,可以用于许多方面。但对于数据科学家而言,numpy、scipy、pandas和scikit-learn的包似乎是最相关的。

对于 Python 而言,这是一个相当部分的列表,因为 Python 是数据科学家工具包中的通用语言,可以用于许多方面。但对于数据科学家而言,numpy、scipy、pandas和scikit-learn的包似乎是最相关的。

所有成千上万的 R 包对有志于数据科学的人都有用吗?不一定。

因此,我们为你选择了合适的备忘单。请注意,这是一个经过筛选的列表。如果在数据科学领域中可以做出任何假设,那就是零假设是数据科学家足够聪明,可以根据数据及其背景做出自己的决策。三份打印件就足以加快有志数据科学家的学习之旅。

请在下方评论中添加额外的备忘单。

Python 的备忘单

-

Python www.astro.up.pt/~sousasag/Python_For_Astronomers/Python_qr.pdf

-

NumPy, SciPy 和 Pandas s3.amazonaws.com/quandl-static-content/Documents/Quandl+-+Pandas,+SciPy,+NumPy+Cheat+Sheet.pdf

R 的备忘单

-

回归分析的 R 函数 cran.r-project.org/doc/contrib/Ricci-refcard-regression.pdf

-

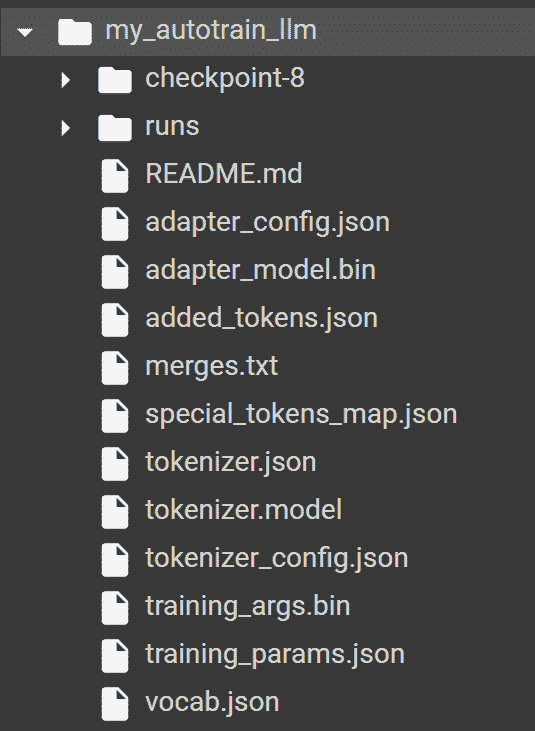

数据挖掘 cran.r-project.org/doc/contrib/YanchangZhao-refcard-data-mining.pdf

![r-data-mining]()

-

Quandl s3.amazonaws.com/quandl-static-content/Documents/Quandl+-+R+Cheat+Sheet.pdf

R、Python(和 Matlab)之间的交叉参考

SQL 备忘单

-

SQL 连接 www.codeproject.com/Articles/33052/Visual-Representation-of-SQL-Joins

-

SQL 和 Hive hortonworks.com/wp-content/uploads/downloads/2013/08/Hortonworks.CheatSheet.SQLtoHive.pdf

附加内容

Ajay Ohri 是一位受欢迎的作者和 博客 写手,专注于分析和数据挖掘,并且是R for Business Analytics一书的作者(Springer, 2012)。

更多相关内容

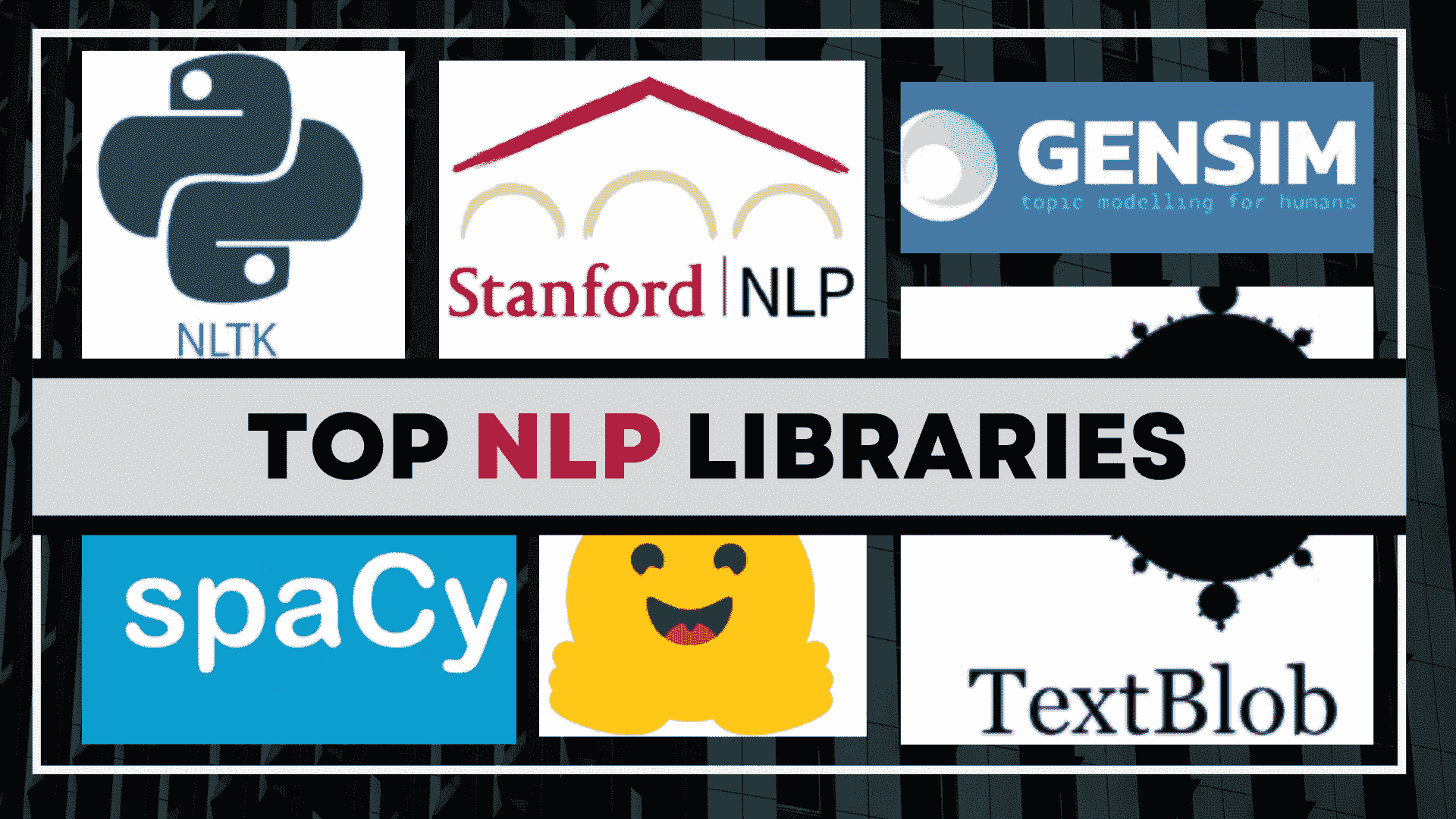

顶级自然语言处理库指南

原文:

www.kdnuggets.com/2023/04/guide-top-natural-language-processing-libraries.html

图片由作者提供

介绍

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织 IT

不同语言用于沟通,但被认为是最复杂的数据形式之一。你是否曾考虑过像 Google 翻译、Alexa 和 Siri 这样的语音助手如何理解、处理和响应人类指令?这是因为自然语言处理。NLP 是数据科学的一个分支,旨在使计算机理解语义并分析文本数据,以提取有意义的见解。自然语言处理的一些典型应用如下:

-

机器翻译

-

文本摘要

-

语音识别

-

推荐系统

-

情感分析

-

市场情报

NLP 库是内置的包,用于将 NLP 解决方案集成到你的应用程序中。这些库非常有用,因为它们使开发者能够专注于项目中真正重要的部分。以下是一些流行的 NLP 库介绍,这些库可以用于构建智能应用程序。

1. NLTK - 自然语言工具包

GitHub 星标 ⭐: 11.8k 链接到 GitHub 仓库: 自然语言工具包

NLTK 是最知名的 Python 库,用于处理人类语言数据。它提供了一个直观的界面,拥有超过 50 个语料库和词汇资源。它是一个多功能的开源库,支持分类、分词、词性标注、停用词去除、词干提取、语义推理等任务。

| 优点 | 缺点 |

|---|---|

| 综合 | 学习曲线陡峭 |

| 大型社区支持 | 可能较慢且内存占用高 |

| 广泛文档 | |

| 可定制 |

有用资源

2. SpaCy

GitHub Stars ⭐: 25.7k GitHub 仓库链接: SpaCy

SpaCy 是一个开源库,旨在用于生产环境。它可以快速处理大量文本,是统计 NLP 的完美选择。它提供了多达 80 个预训练的管道,支持 24 种语言,并且目前支持 70 多种语言的分词。除了支持 POS 标注、依存解析、句子边界检测、命名实体识别、文本分类、基于规则的匹配等任务外,它还提供了多种语言学注释,以帮助你深入了解文本的语法结构。这些功能极大地提高了 NLP 任务的准确性和深度。

| 优点 | 缺点 |

|---|---|

| 快速高效 | 与 NLTK 相比支持的语言有限 |

| 用户友好 | |

| 预训练模型 | 一些预训练模型的大小可能会让计算资源有限的用户感到担忧 |

| 允许模型自定义 |

有用的资源

-

SpaCy 在线文档 - 官方文档

-

SpaCy 在线课程 - 使用 SpaCy 的高级 NLP

-

SpaCy Universe 是一个社区驱动的平台,提供基于 SpaCy 的工具、扩展和插件。它还包含了示例和书籍以供指导 - SpaCy Universe

3. Gensim

GitHub Stars ⭐: 14.2k GitHub 仓库链接: Gensim

Gensim 是一个 Python 库,广泛用于主题建模、文档索引和大语料库的相似性检索。它提供了用于词嵌入的预训练模型,这些模型用于识别两个文档之间的语义相似性。例如,预训练的 word2vec 模型可以识别出“巴黎”和“法国”之间的关系,因为巴黎是法国的首都。识别这种语义关系的能力提供了对数据潜在含义和背景的深刻洞察。能够处理比 RAM 更多的输入使得 Gensim 非常有效。

| 优点 | 缺点 |

|---|---|

| 直观界面 | 预处理能力有限 |

| 高效且可扩展 | |

| 支持分布式计算 | 对深度学习模型的支持有限 |

| 提供广泛的算法 |

有用的资源

4. 斯坦福 CoreNLP

GitHub Stars ⭐: 8.9k GitHub 仓库链接: 斯坦福 CoreNLP

斯坦福 CoreNLP 是一个经过充分测试的自然语言处理工具,使用 Java 编写。它以原始人类语言作为输入,并且能够执行各种操作,如词性标注、命名实体识别、依存关系解析和语义分析,只需几行代码。尽管它最初是为英语设计的,但现在也支持多种语言,包括阿拉伯语、法语、德语、中文等。总体而言,它是一个强大且可靠的开源 NLP 工具。

| 优点 | 缺点 |

|---|---|

| 高精度 | 过时的界面 |

| 广泛的文档 | 有限的扩展性 |

| 综合语言学分析 |

有用资源

5. TextBlob

GitHub Stars ⭐: 8.5k GitHub 仓库链接: TextBlob

TextBlob 是另一个用于处理文本数据的 Python 库。它提供了一个非常友好且易于使用的界面。它提供了一个简单的 API 来执行任务,如名词短语提取、词性标注、情感分析、分词、单词和短语频率、解析、WordNet 集成等。我个人推荐给希望熟悉 NLP 任务的初级程序员。

| 优点 | 缺点 |

|---|---|

| 适合初学者 | 性能较慢 |

| 易于使用的界面 | 功能有限 |

| 与 NLTK 集成 |

有用资源

-

官方 TextBlob 文档: TextBlob

-

Analytics Vidhya TextBlob 教程: 使用 TextBlob 轻松处理 NLP

-

自然语言基础与 TextBlob - 简短 NLP 课程

6. Hugging Face Transformers

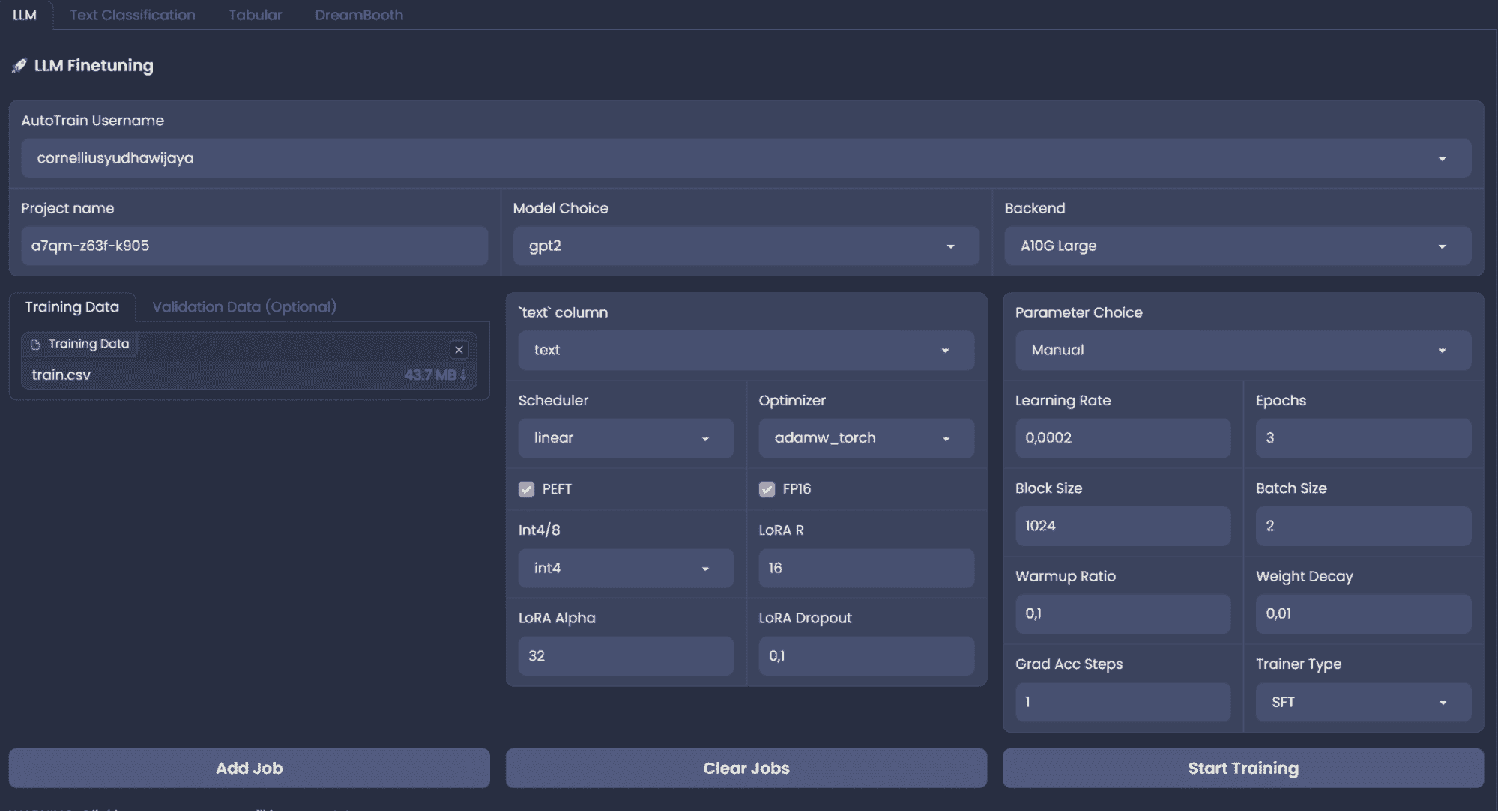

GitHub Stars ⭐: 91.9k GitHub 仓库链接: Hugging Face Transformers

Hugging Face Transformers 是一个强大的 Python NLP 库,拥有数千个预训练模型,可用于执行 NLP 任务。这些模型在大量数据上训练,可以理解文本数据中的潜在模式。使用预训练模型可以节省开发者的时间和资源,相比从头训练自己的模型。Transformer 模型还可以执行诸如表格问答、光学字符识别、从扫描文档中提取信息、视频分类和视觉问答等任务。

| 优点 | 缺点 |

|---|---|

| 易于使用 | 资源消耗大 |

| 大型且活跃的社区 | 昂贵的云服务 |

| 语言支持 | |

| 较低的计算成本 |

有用资源

-

官方文档 - Hugging Face Transformer 文档

-

Hugging Face 社区论坛 - 社区论坛

-

高级介绍 Hugging Face Transformers - Coursera

结论

NLP 库在加速 NLP 研究进展方面发挥了重要作用。这使得机器能够与人类有效沟通。尽管 NLP 任务刚开始可能看起来有些复杂,但凭借合适的工具,你可以很好地处理这些任务。上述列表仅提及当前在 NLP 中使用的顶级库,但还有许多其他的库供你探索。希望你从这篇文章中学到了一些有价值的东西,我鼓励你尝试这些工具,并创造一些有趣的东西。

Kanwal Mehreen 是一位有抱负的软件开发者,对数据科学和人工智能在医学中的应用充满浓厚兴趣。Kanwal 被选为 2022 年 APAC 区域的 Google Generation Scholar。Kanwal 喜欢通过撰写有关热门话题的文章来分享技术知识,并且热衷于提升女性在科技行业中的代表性。

更多相关话题

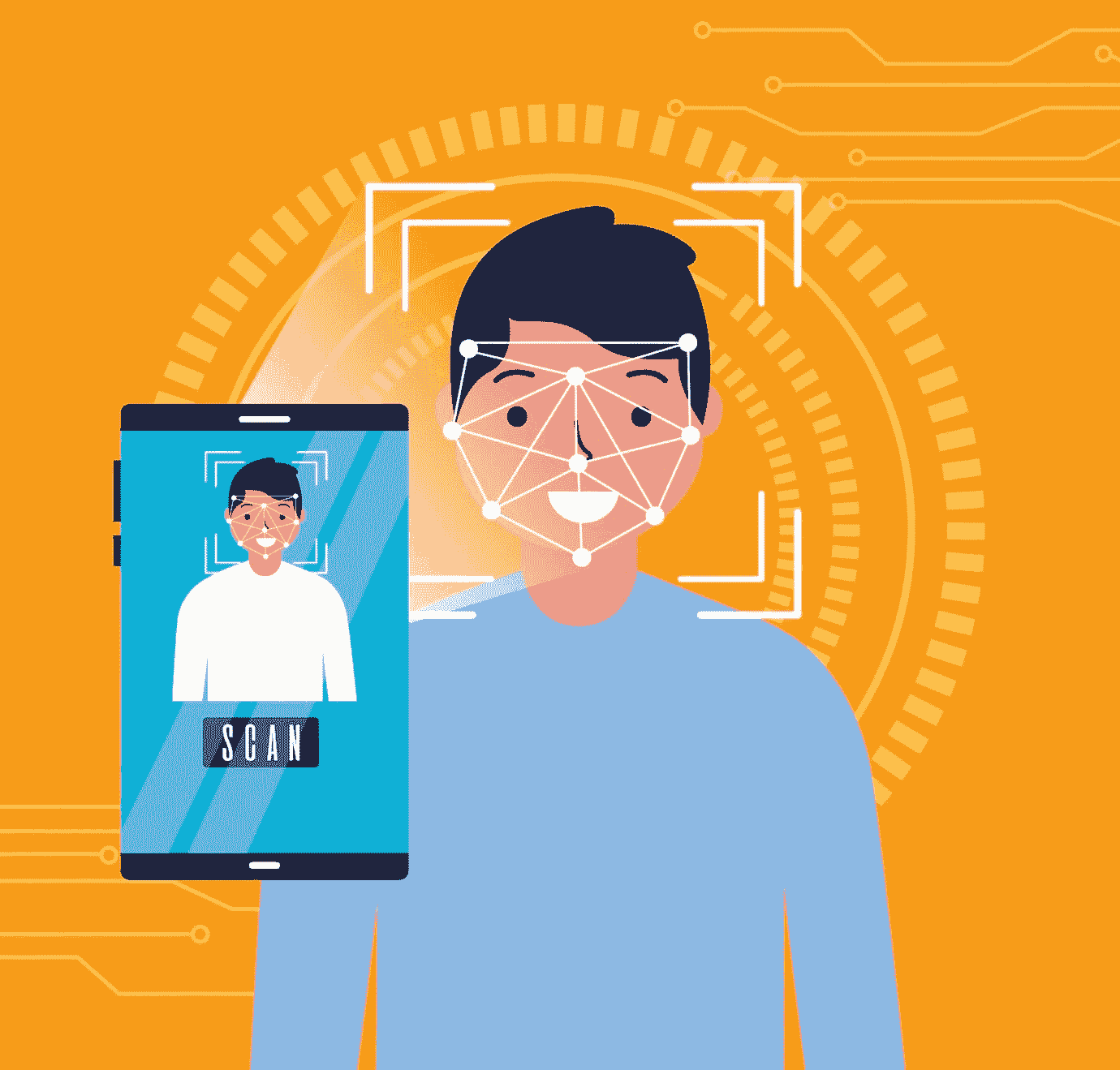

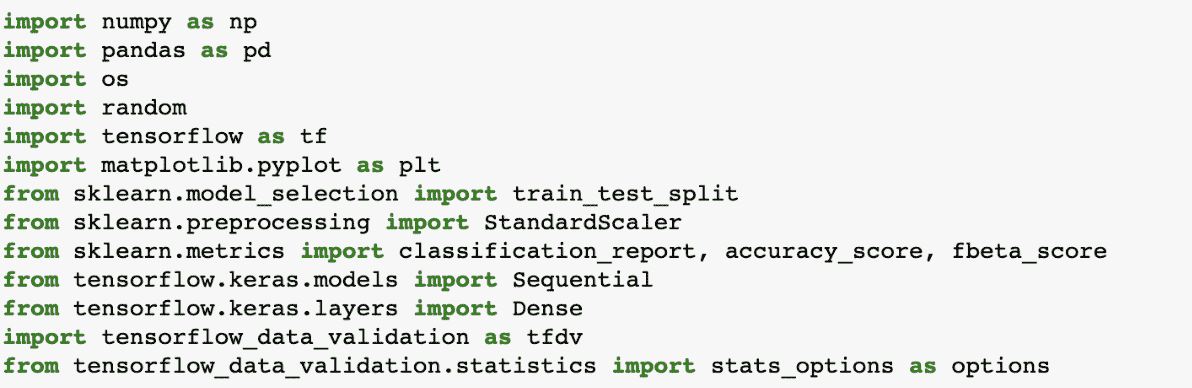

使用 Tensorflow 训练图像分类模型的指南

原文:

www.kdnuggets.com/2022/12/guide-train-image-classification-model-tensorflow.html

人类在很小的时候就学会了识别和标记视觉图像。现在,随着机器学习和深度学习算法的出现,计算机能够大规模且高精度地分类图像。这些先进的算法有许多应用——常见的包括区分健康的肺部扫描、移动设备的人脸识别,或将物体分类为零售商的不同类别。

本文解释了计算机视觉的一个应用,即图像分类,并说明了如何使用 Tensorflow 在小型图像数据集上训练模型。

数据集和目标

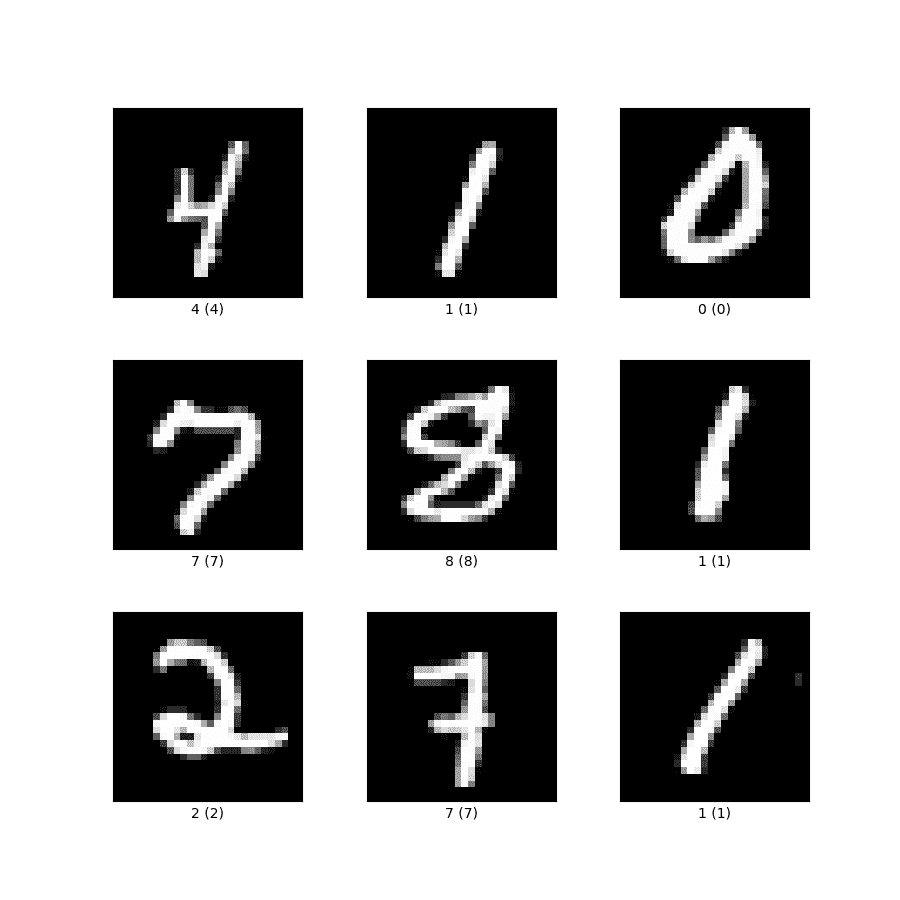

为了演示的目的,我们将使用包含 0 到 9 数字图像的MNIST数据集。样本图像如下所示:

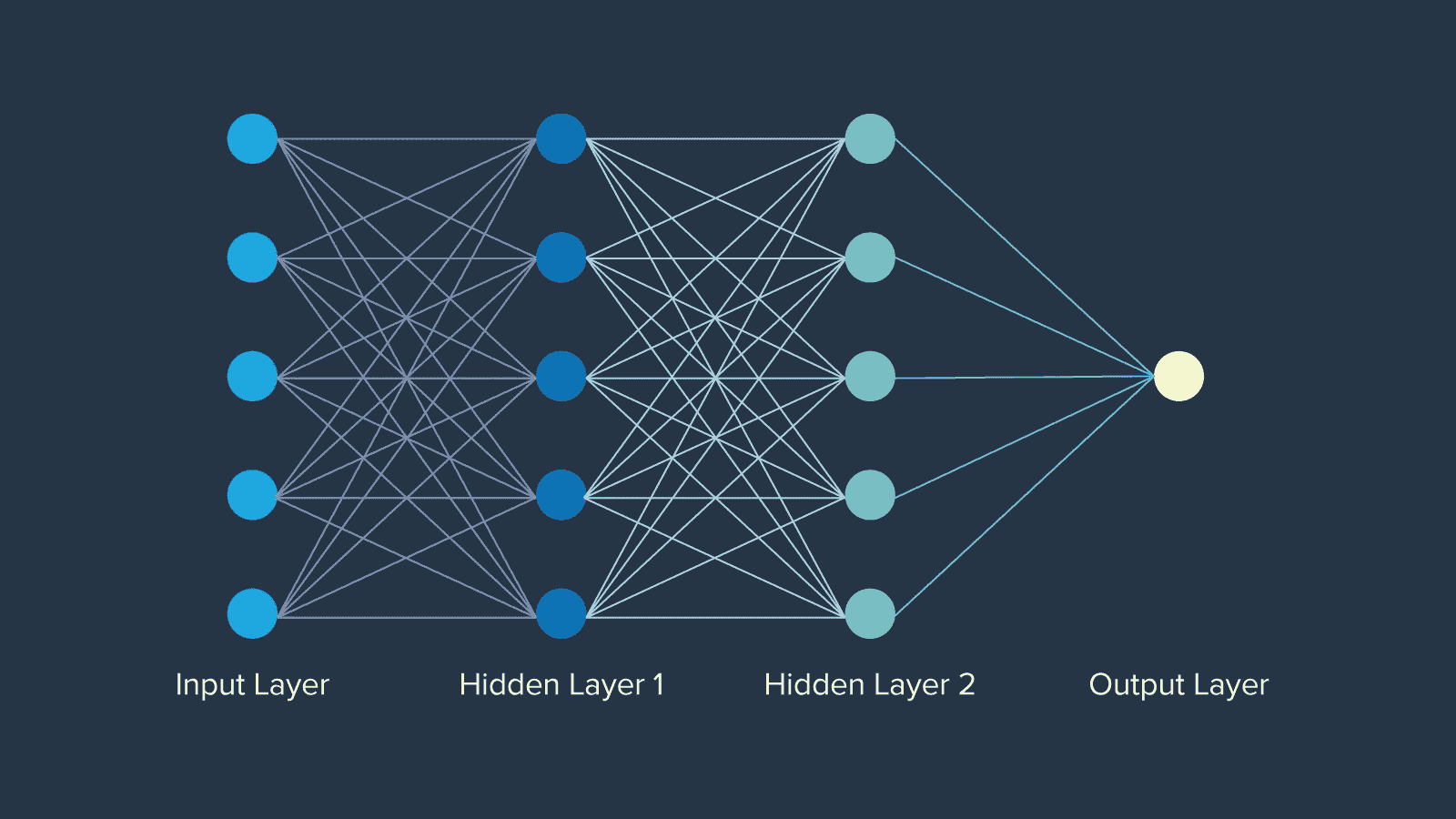

训练这个模型的目的是将图像分类到它们各自的标签,即对应的数字等价物。使用一个输入层、一个输出层、两个隐藏层和一个 Dropout 层的深度神经网络架构来训练模型。CNN 或卷积神经网络是较大图像的首选,因为它能够在减少输入大小的同时捕捉相关信息。

入门指南

首先,导入所有相关的库,包括 TensorFlow、to_categorical(用于将数值类值转换为类别)、Sequential、Flatten、Dense 和 Dropout,用于构建神经网络架构。如果这些库中的一些对你来说是新的,不用担心。它们将在接下来的部分中进行解释。

超参数

以下提示帮助你选择正确的超参数:

-

让我们定义一些超参数作为起点,你可以调整它们以进行不同的实验。我们选择了 128 的迷你批量大小。批量大小可以取任何值,但选择一个 2 的幂作为批量大小在内存使用上更高效,因此是首选。让我们还理解决定适当批量大小的主要原因——过小的批量大小会使收敛过程非常嘈杂,而过大的批量大小可能无法适应你的计算机内存。

-

我们将 epoch 数量设置为 50,以快速训练模型。数据集较小且简单,适合较低的 epoch 数量。

-

接下来,你需要添加隐藏层。我们保留了两个各 128 个神经元的隐藏层——你也可以尝试 64 和 32。对于像 MINST 这样简单的数据集,不推荐使用更高的数字。

-

你可以尝试不同的学习率,如 0.01、0.05 和 0.1。为了演示的目的,保持在 0.01。

-

其他超参数如衰减步数和衰减率分别选择为 2000 和 0.9。它们用于在训练过程中减少学习率。

-

选择 Adamax 作为优化器,尽管你还可以选择其他优化器,如 Adam、RMSProp、SGD 等。你可以阅读更多关于可用优化器列表以及它们的区别,以选择适合你解决方案的优化器。

import tensorflow as tf

from tensorflow.keras.utils import to_categorical

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Flatten, Dense, Dropout

params = {

'dropout': 0.25,

'batch-size': 128,

'epochs': 50,

'layer-1-size': 128,

'layer-2-size': 128,

'initial-lr': 0.01,

'decay-steps': 2000,

'decay-rate': 0.9,

'optimizer': 'adamax'

}

mnist = tf.keras.datasets.mnist

num_class = 10

# split between train and test sets

(x_train, y_train), (x_test, y_test) = mnist.load_data()

# reshape and normalize the data

x_train = x_train.reshape(60000, 784).astype("float32")/255

x_test = x_test.reshape(10000, 784).astype("float32")/255

# convert class vectors to binary class matrices

y_train = to_categorical(y_train, num_class)

y_test = to_categorical(y_test, num_class)

创建训练和测试集

-

TensorFlow 库还包括 MNIST 数据集,你可以通过调用 datasets.mnist,然后在对象上调用 load_data()来分别获取训练(60,000 个样本)和测试(10,000 个样本)数据集。

-

接下来,你需要重新调整和归一化训练和测试图像,其中归一化将图像像素强度限制在 0 到 1 之间。

-

使用之前导入的 to_categorical 方法将训练和测试标签转换为类别。这对于向 TensorFlow 框架传达输出标签即 0 到 9 是类别而不是数值性质至关重要。

设计神经网络架构

理解如何设计神经网络架构的细节非常重要。

-

通过添加 Flatten 来定义 DNN(深度神经网络)结构,将 2D 图像矩阵转换为向量。输入神经元对应于这些向量中的数字。

-

接下来,使用 Dense()方法添加两个隐藏的全连接层,并从之前定义的“params”字典中提取超参数。我们将这些层的激活函数设置为“relu”,即修正线性单元,它是神经网络隐藏层中最常用的激活函数之一。

-

接下来使用 Dropout 方法添加 dropout 层。它用于在训练神经网络时避免过拟合。一个过拟合的模型倾向于准确记住训练集,而无法对未见过的数据集进行泛化。

-

输出层是我们网络中的最后一层,使用 Dense()方法定义。需要注意的是,输出层有 10 个神经元,分别对应于类别(数字)的数量。

# Model Definition

# Get parameters from logged hyperparameters

model = Sequential([

Flatten(input_shape=(784, )),

Dense(params('layer-1-size'), activation='relu'),

Dense(params('layer-2-size'), activation='relu'),

Dropout(params('dropout')),

Dense(10)

])

lr_schedule =

tf.keras.optimizers.schedules.ExponentialDecay(

initial_learning_rate=experiment.get_parameter('initial-lr'),

decay_steps=experiment.get_parameter('decay-steps'),

decay_rate=experiment.get_parameter('decay-rate')

)

loss_fn = tf.keras.losses.CategoricalCrossentropy(from_logits=True)

model.compile(optimizer='adamax',

loss=loss_fn,

metrics=['accuracy'])

model.fit(x_train, y_train,

batch_size=experiment.get_parameter('batch-size'),

epochs=experiment.get_parameter('epochs'),

validation_data=(x_test, y_test),)

score = model.evaluate(x_test, y_test)

# Log Model

model.save('tf-mnist-comet.h5')

训练时间

现在我们已经定义了架构,让我们用给定的训练数据来编译和训练神经网络。

-

定义一个学习率调度器,使用 ExponentialDecay(指数衰减学习率),并以初始学习率、衰减步数和衰减率作为参数。

-

定义损失函数为 CategoricalCrossentropy(用于多类分类)。

-

通过将优化器(adamax)、损失函数和指标(选择准确率,因为所有类别同等重要且均匀分布)作为参数传递来编译模型。

-

通过调用 fit 方法,传入 x_train、y_train、batch_size、epochs 和 validation_data 来拟合模型。

-

调用模型对象上的 evaluate 方法,以获取模型在未见数据集上的表现分数。

-

你可以使用 save 方法将模型对象保存以供生产使用。

这篇文章解释了训练深度神经网络进行图像分类任务的基础知识,并且是熟悉使用神经网络进行图像分类任务的良好起点。它详细阐述了选择正确参数和架构的一般方法和理由。

Vidhi Chugh 是一位 AI 策略师和数字化转型领导者,她在产品、科学和工程的交汇处工作,致力于构建可扩展的机器学习系统。她是获奖的创新领袖、作者和国际演讲者,致力于使机器学习民主化,并让每个人都能参与这一转型。

了解更多关于此主题的信息

转型为数据科学职业的逐步指南 – 第一部分

原文:

www.kdnuggets.com/2019/05/guide-transitioning-career-data-science-part-1.html

评论

如果你想将职业转型为数据科学,最常听到的建议可能是学习 Python 或 R,或通过参加 Coursera 上的 Andrew Ng 的机器学习课程来学习机器学习,或开始学习大数据技术,如 Spark 和 Hadoop。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速通道进入网络安全职业。

1. Google 网络安全证书 - 快速通道进入网络安全职业。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织进行 IT 支持

3. Google IT 支持专业证书 - 支持你的组织进行 IT 支持

我称这是通向数据科学职业的技术导向路线。

如果你是程序员或有博士学位,这种方法完全合理。如果你来自非技术背景,最简单的入门数据科学的方法是采取以领域知识为重点的方法。

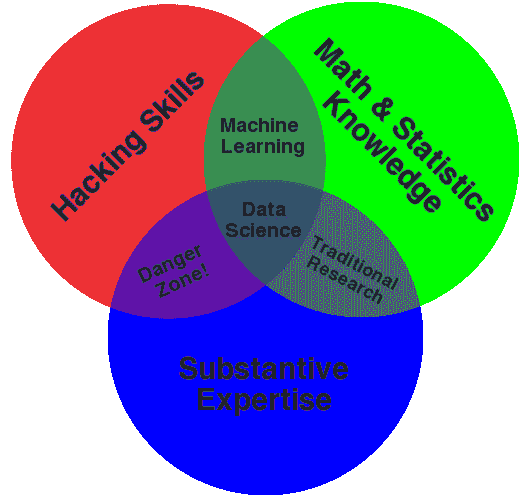

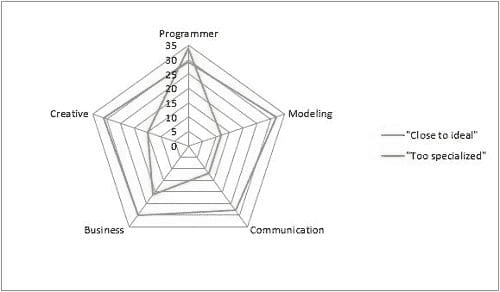

如果你查看 Drew Conway 的维恩图,你会发现数据科学家不仅仅具备技术技能。他们还具备领域专长。

那么,为什么不利用它呢?我一直相信发挥自己的优势。

让我详细解释一下这种方法。

第一步:发现你的理想工作

数据科学在多个领域(如市场营销、金融、人力资源等)中用于解决有趣的商业问题。

你的第一步是选择一个与你领域相关的数据科学职位。

让我通过一个例子来说明这一点。

我将假设自己是一个数字营销人员,想要转型到数据科学。如果我在 Google 上搜索“营销数据科学职位”,我会得到一系列职位发布,标题如下:

-

“高级市场营销数据分析师”

-

“高级数据科学家 - 市场营销”

-

“市场营销分析专员”

然后我会逐一查看每个描述,以了解这些职位标题中哪些最接近我当前的技能(在领域知识方面)。

通过这个练习,我发现“营销数据分析师”角色很适合我。我还排除了高级职位,因为它们需要数据科学的经验——因此,它们不是好的目标。

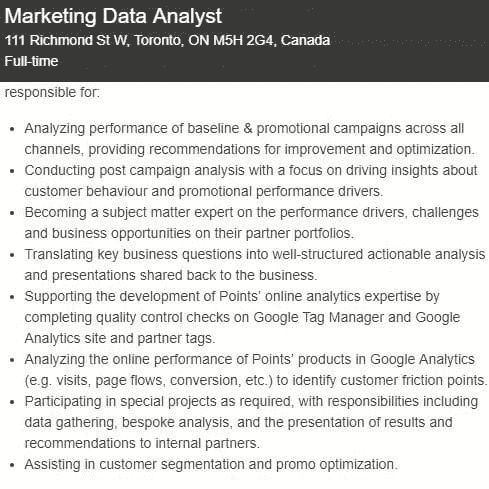

这是一个营销数据分析师职位的描述:

该职位的强有力候选人应具备一定的 Google Analytics 技能,了解在线指标(如访问量、转化率等),并知道如何进行活动分析。如果我是一名具备这些技能的数字营销员,那么我就是这个职位的强有力候选人。

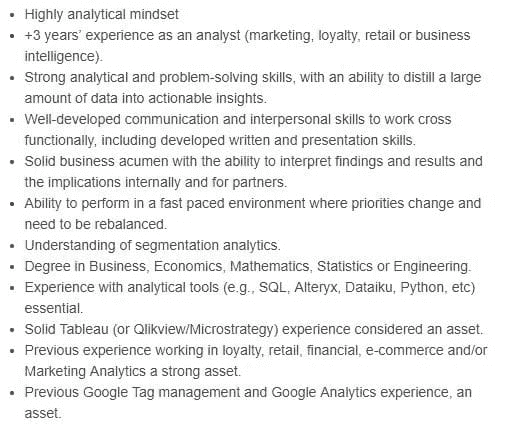

以下是职位描述中列出的技术技能:

在这个阶段,我不打算担心职位描述中列出的技术和分析技能,因为我的重点只在于领域知识。

你可以运用相同的原则来选择你领域内的目标职位。

一旦你确定了目标职位,是时候筛选你的目标公司了。

第 2 步:发现你的梦想公司

你必须根据以下两个标准之一,筛选出 5 家公司作为目标:

-

他们经常发布你目标职位头衔的招聘广告。

-

有很多人拥有你所针对的职位头衔。

我发现,主要招聘数据科学专业人员的公司通常属于以下类别之一:

-

中型科技公司

-

精品数据科学咨询公司

-

大型咨询公司

-

主要金融机构

-

大型零售公司

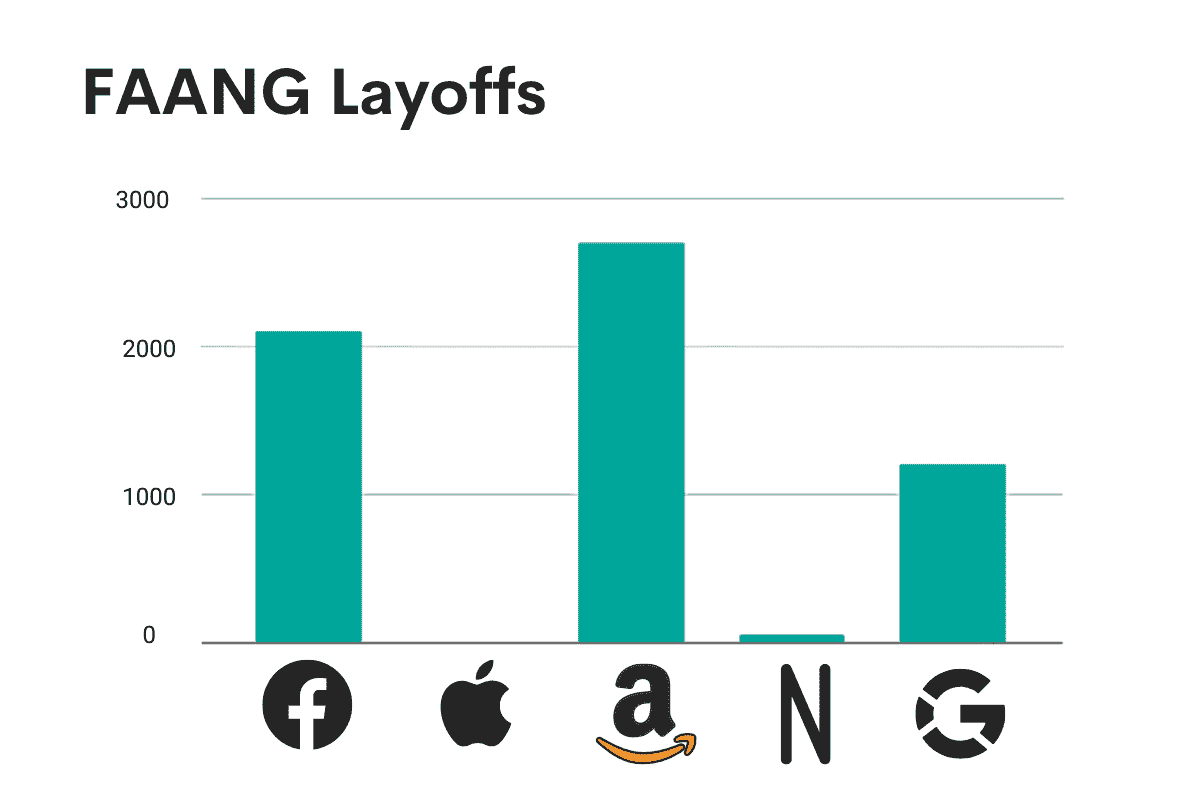

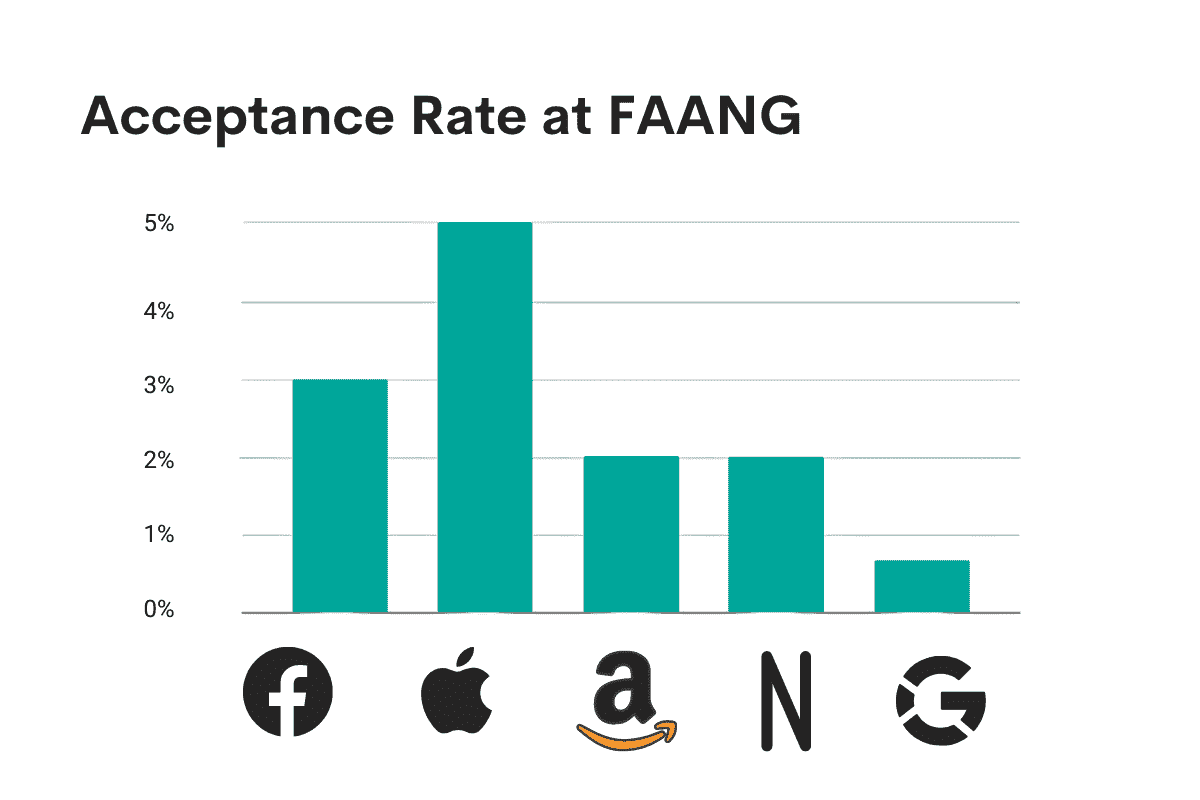

在主要科技公司(如 Facebook、Google 或 Amazon)获得入门级数据科学职位是相当困难的,因此不要以它们为目标。

对于我的“营销数据分析师”职位,我已经筛选出了加拿大前 5 名银行:

-

TD 银行

-

RBC

-

CIBC

-

BMO

-

道明银行

第 3 步:与合适的人建立网络

你已经选定了目标职位和几家公司,做了功课。但从你的房间里,你能做的也有限。

你还有很多问题,例如:

我真的能得到这个工作吗?

下一步我该做什么?

你如何回答这些问题?

通过测试。

除了这次,你将与真实的人交流:那些已经经历过的人。

以下是你可以遵循的步骤:

-

找到你所筛选公司中拥有目标职位头衔的人

-

给他们发电子邮件,安排咖啡会面或电话会议。

-

出席并提出好的问题。

-

跟进并建立真实的关系。

第一步是使用 LinkedIn 找到每个目标公司中至少 2 个已经拥有你目标职位头衔的人。

在我的情况下,我会在 LinkedIn 搜索栏中输入“Marketing Data Analysts TD Bank”以获取 TD 银行的目标人员列表。

如果他们在 LinkedIn 上有 500+个连接,我会通过 LinkedIn 联系他们,否则我会通过电子邮件联系他们。

你可以使用一个名为“Voila Norbert”的工具来获取他们的官方电子邮件地址。你只需在这个工具中输入他们的姓名和他们所在组织的域名即可获取他们的电子邮件地址。

你可以使用一些模板与联系人取得联系:

初始 LinkedIn 请求消息:

我在 LinkedIn 上研究市场数据分析师职位时,注意到你是[公司名称]的市场数据分析师。你的职业道路对我很有启发。我正在寻找理想工作,想向你请教 3-5 个关于你职业道路的问题。

一旦他们接受了你的 LinkedIn 请求:

感谢你接受我的请求。

我的名字是 [名字],和 [关于你的几句话]。

正如我之前所说,我正在寻找我的梦想工作([你的目标职位]),希望向你请教 3-5 个关于你在 [公司名称] 的经验的问题。

你的见解对我会很有帮助。我将在 9 月 14 日(星期五)到 9 月 17 日(星期一)在城里。你是否在 9 月 14 日到 17 日之间的任何时间可以抽空喝杯咖啡聊聊?

你可以将上述 LinkedIn 信息作为你的第一次联系邮件,主题行如下:

有志的数据科学家——寻求最佳建议

如果 3 天后没有收到回复,请发送一封类似的跟进邮件:

我想跟进我之前的信息。*

此时,我已经:*

- 确定我想追求的职位:市场数据分析师 *

- 以及我有兴趣申请的公司列表,也已经彻底研究过。

我确实有一些关于我的方法的问题——这就是我联系像你这样的专家的原因(你已经拥有了我梦寐以求的工作)。

我坚信,你对我数据科学求职市场的指导和反馈将对我有很大帮助。

再次,如果 2 个工作日后没有收到回复,请再发送一封跟进邮件:

嗨 [名字],我想最后一次跟进我之前的信息。如果没有收到回复,我将假设时机不对。你的指导将对我追求梦想工作的旅程帮助很大。

在联系你的任何目标之前,看看你是否认识可以介绍你的人。可以是你的校友或前同事。

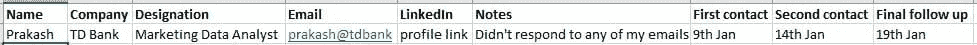

你也可以使用一个简单的 Excel 表格来跟踪整个过程。这是一个示例:

假设你的一个目标联系人同意了,让我们讨论一下实际会议中该做什么。

记住,这些非正式会议是为了测试你的想法并获得新见解。它们不是为了获得工作。在这里绝不要询问工作。你处于研究阶段。现在你只是收集信息。它们也不是为了谈论你自己,所以请友善地倾听。你的任务是学习,而不是谈论自己。

如果你有半小时的会议,应该花大约 25 分钟提问。在最后五分钟,你可以花几分钟谈谈自己。

尝试提出聪明的问题。在实际提问之前,尝试自己回答每一个问题。为每个答案进行情景规划。

你可以问一些问题:

-

我想了解一下你是如何开始你的数据科学职业生涯的。

-

你能告诉我数据科学如何为[公司名称]创造价值吗?最近的一些工作例子?

-

[公司名称] 的团队经常使用哪些软件和机器学习技术?

-

团队的典型背景是什么?

-

[公司名称] 是否雇用没有数据科学经验的人?

-

如果是这样,他们在寻找没有该领域经验的候选人时,会看重哪些重要技能和特征?

-

如果我申请了[公司名称],你认为什么会让我脱颖而出?如果我下周有面试,你会给我什么建议?

会议结束后,当天就发一封感谢邮件。

再次感谢你昨天与我会面——这对我非常有帮助。

我认为我的下一步是[包括你们对话中的一些内容]。

请告诉我是否有什么我可以做的来回报这份恩情!

你应该在目标公司见到至少 2 个人。

到目前为止,你已经进行过十次咖啡会议,并对所有问题都有了答案。你打算如何处理这些答案?如何说服你见过的人你是一个强有力的候选人?

这正是我将在下一个博客文章中讨论的内容。敬请关注。

相关:

-

转型为数据科学家的逐步指南 – 第二部分

-

成为数据科学家

-

转型为数据科学:如何成为数据科学家,以及如何创建数据科学团队

更多相关话题

将职业转型为数据科学的逐步指南 – 第二部分

原文:

www.kdnuggets.com/2019/06/guide-transitioning-career-data-science-part-2.html

评论

评论

这是我关于同一主题的上一篇博客文章的延续。确保你在继续阅读这里之前先阅读了那篇文章。

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业

1. 谷歌网络安全证书 - 快速进入网络安全职业

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

第 5 步:构建你的作品集项目

你的潜在客户已经回答了你所有的问题。现在,你需要分析这些答案并回答这两个问题:

-

“我的潜在客户正在解决什么业务问题?”

-

“他们掌握的主要技术技能是什么?”

就这样,没有更多内容了。

回到我的例子,如果我的大多数潜在客户说他们分析来自 Google Analytics 的网站数据并将这些见解呈现给数字营销总监。他们主要使用 SQL 和 Tableau 进行分析,但很少使用 Python 或 R。如果他们还提到大多数市场数据分析师在工作中学习 R 或 Python。

那么我知道我必须开始学习 SQL 和 Tableau。如果我一开始就开始学习 Python 或 R,我就会浪费时间。

下一步是基于本节中两个问题的答案快速构建一个作品集项目。不要立刻报名参加课程以学习构建项目所需的技术技能。相反,你应该学习足够的技术技能来完成你的作品集项目。我从《The First 20 Hours: How to Learn Anything . . . Fast!》的作者 Josh Kaufman 那里学到了这种方法。

对我而言,我必须分析 Google Analytics 数据,并在 Tableau 中开发一个仪表板来可视化我的分析见解。你的第一步是找到项目的数据源。你可以在 Kaggle 上找到有趣的数据集。你也可以通过“19 个地方找到免费的数据集”来寻找数据集。

对于我的项目,我将使用Kaggle 上的 Google Analytics Customer Revenue数据集。然后在我的笔记本电脑上安装 Microsoft SQL 服务器,并将数据集上传到 SQL 服务器。我这样做是因为根据我的了解,市场数据分析师使用 SQL 来提取数据。所以我想展示我掌握了 SQL。

项目的第一步是了解数据集,并提出 2 到 3 个你可以通过分析回答的有趣的业务问题。你还需要知道数据集中哪些列(或特征)是回答这些问题所需的。这时你的领域知识就派上用场了。

不要试图让这个项目变得复杂,你的目标是构建一个能让你获得工作的项目。我称这个投资组合项目为“最小可行项目”。

对于我的市场数据分析师角色,我必须学习 SQL 和 Tableau。所以,首先我学习 SQL 和 Tableau 的基础知识。你不应该在学习基础知识上花费超过 10 小时。

一旦你学会了基础知识,你的下一步是找到一个导师,他可以帮助你制定一个详细的计划,按照步骤逐步推进你的项目。选择一个在数据科学领域有丰富经验的导师。你可以使用像Clarity或Mentor Cruise这样的服务来寻找经验丰富的数据科学家。安排与数据科学导师的电话会议,询问他们解决问题的最佳方法。详细说明你想解答的业务问题。

在你收到如何回答业务问题的具体计划后,开始你的项目。

如果在进行项目时遇到困境,或在像 Stack Overflow 这样的论坛上找不到技术问题的答案,你可以再次安排与导师的电话会议,寻求他们的帮助。你也可以在CodeMentor上找到专家以获得技术帮助。

完成项目后,再次与导师复审项目并获取反馈。

在做这些事情的同时,你也应该与潜在客户保持联系。只需根据与你之前的对话发送一篇有趣的文章:

在 KDnuggets 上看到这篇文章,想起了你说的市场科学相关的内容!无需回复,只是觉得你可能会觉得有趣。

第 6 步:向招聘经理索取介绍

一旦你的项目完成,将其托管到 Github 上。并撰写一篇深入的博客文章,介绍你是如何开展这个项目的。在写博客时,技术细节要尽量减少,因为你写这篇博客是为了吸引招聘团队中的业务经理。招聘团队将包括技术和业务人员。技术经理会查看你在 Github 上的代码,但业务经理更关心你通过分析想回答哪些业务问题。

将你的项目和博客文章的链接发送给你的前景并请求反馈。如果大多数前景给出某种反馈,那么在你的项目中实施这些建议。现在,你的前景也会说如果有工作机会他们会推荐你。

感谢他们,但不要发送你的简历。相反,要求他们介绍你认识团队中更有经验的人。以下是你可以使用的示例邮件:

谢谢你的反馈。我在我的项目中实施了你的建议。

在我们上次的聊天中,你提到[人名]是谈论[公司名]潜在的市场数据分析师职位的合适人选。我很感兴趣,并且希望与她/他交谈。你是否愿意帮忙联系她/他?我保证尊重她/他的时间。

如果需要,我可以为你发送一封预格式化的介绍邮件,让事情变得非常简单。如果不需要,也没关系——再次感谢你的帮助!

你的目标是联系到他们团队中的高级人员。一个有权聘用你的人。

如果你的前景同意,你就成功了——80-90%的情况下,你会收到招聘经理的会议或电话。你的前景很可能会做出介绍,因为你在根据他们的反馈采取行动,并且你视他们为导师。因此,这更像是一种导师-学员关系。

通过适当的介绍,VIP 几乎每次都会同意与你交谈。

在实际会议中,把它当作一次非正式的会谈——不是推销,而是非正式的对话:提问,与自己的经历相关联,提出你的想法。在谈话中也可以谈论你的项目,但不要炫耀。

最重要的是,先不要要求面试,因为你不知道他们是否有相同的感觉。只需说:“非常感谢您抽出时间与我会面。我会花些时间考虑这些问题。几天后我能否再跟进一下?”他们会说“可以”。然后,发送一封表达你兴趣的邮件,并询问他们推荐的下一步措施。如果他们喜欢你,你几乎可以保证会有面试——而且你已经和招聘经理喝过咖啡了。这是非常重要的。

那么,招聘经理在想什么?

再次,把自己放在招聘经理的角度。他们面临大问题,但找到合适的帮助很困难。如果他们能找到一个“明白情况”的人并能迅速上手就好了。你,聪明且有洞察力的候选人,理解他们的世界。如果有些漏洞也没关系——你显然是一个快速学习者,而且你已经做了功课(你的项目)。他们会想,“哇,他似乎聪明、正常、才华横溢……我们至少应该把他请进来了解更多。”

会后向招聘经理发送感谢邮件。在感谢邮件中你也应提供你项目的链接。同时,让你的前景保持更新。以下是你可以发送给前景的邮件:

嘿,[名字]

只是想让你知道我前几天和[公司名称]的[招聘经理]见了面,效果很好!他邀请我申请市场数据分析师职位,我会在本周晚些时候申请。

无需回应;只是让你了解情况。非常感谢——没有你我做不到!

-[你的名字]

步骤 7:准备你的简历并破解面试

现在是时候准备你的简历和求职信了。你的简历和求职信应该针对你申请的职位。将你潜在雇主和招聘经理的话语融入到你的简历中。这就是为什么在会议中做笔记非常重要。

简历实际上只需要这两个主要部分:

-

经验

-

教育

这是 Quora 数据科学经理 William Chen 的一段精彩视频,讲解如何准备数据科学简历。

在将简历发送给招聘经理后,你需要为面试做好准备。

你在前期投入的所有工作在面试中大有回报,因为你:

-

进行了更深入的研究

-

建立了更好的联系

-

你有一个针对他们需求的项目

你 80%的工作是在面试前完成的。现在是时候完成剩下的 20%工作了。

此时,你的潜在雇主对你充满好奇。你提交了一个令人印象深刻的申请,甚至还有共同联系人的介绍。现在,他们希望你来见见团队,回答一些问题,并聊一会儿。还有,他们也想回到工作中!他们希望你成功——如果你适合这个职位。所以,做好面试准备。

为一些最常见的面试问题准备脚本,例如:

-

“告诉我关于你自己的事。”

-

“你为什么想在这里工作?”

-

“谈谈你以前的工作经验”

-

“谈谈你发送给我们的项目”

破解面试,获得你的第一个梦想数据科学职位。

结论

我理解这个过程比盲目地提交简历要困难得多,但从长远来看回报更丰厚。

如果你有任何问题,请在评论中告诉我!

相关:

-

将你的职业转型为数据科学的逐步指南 – 第一部分

-

雇主希望看到的数据科学项目:如何展示业务影响

-

数据科学作品集中的项目

更多相关内容

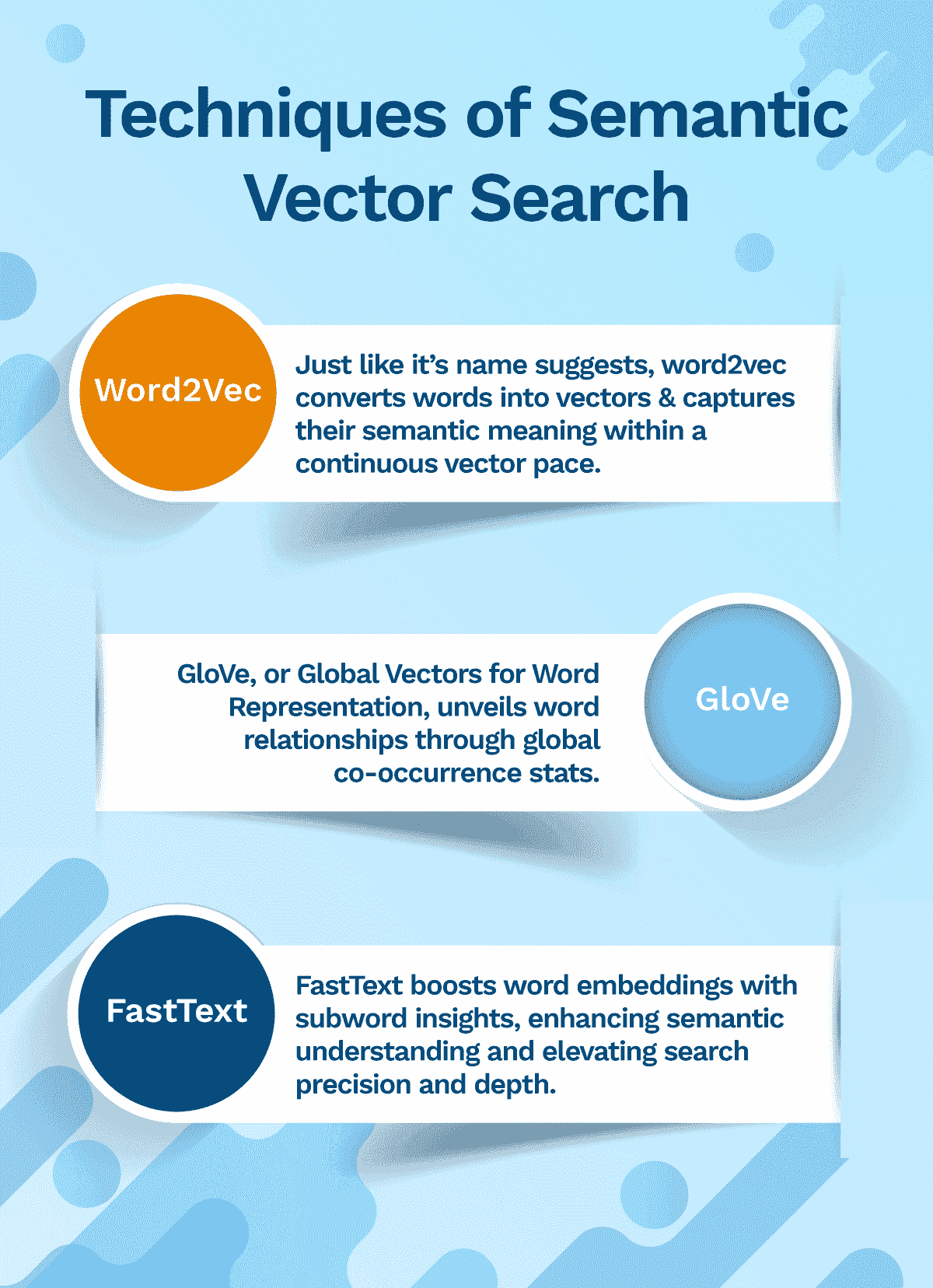

NLP 中不同词嵌入技术的终极指南

原文:

www.kdnuggets.com/2021/11/guide-word-embedding-techniques-nlp.html

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

“你可以通过一个词所处的环境来了解它!”

—约翰·鲁珀特·费斯

如果计算机能开始理解莎士比亚的作品?或者像 J.K. 罗琳那样写小说?这在几年前是不可想象的。近年来,自然语言处理(NLP)和自然语言生成(NLG)的最新进展使计算机在理解基于文本的内容方面的能力大大提升。

为了理解和生成文本,基于 NLP 的系统必须能够识别单词、语法以及大量的语言细微差别。对于计算机来说,这比说起来要困难得多,因为它们只能理解数字。

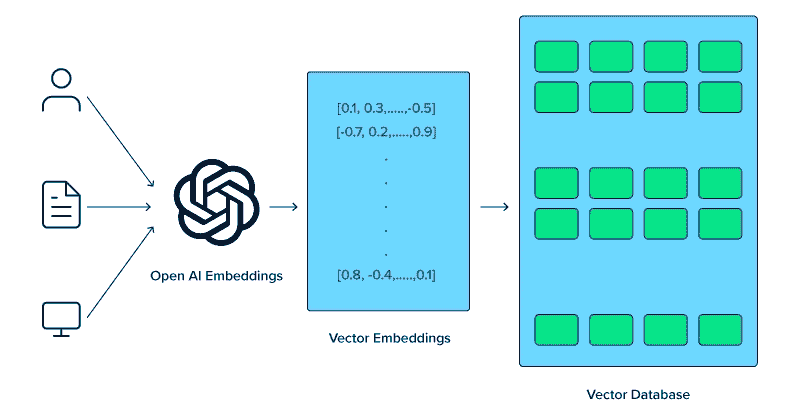

为了弥补这一差距,自然语言处理(NLP)专家开发了一种称为词嵌入的技术,将单词转换为其数值表示。一旦转换完成,自然语言处理算法可以轻松处理这些学习到的表示,以处理文本信息。

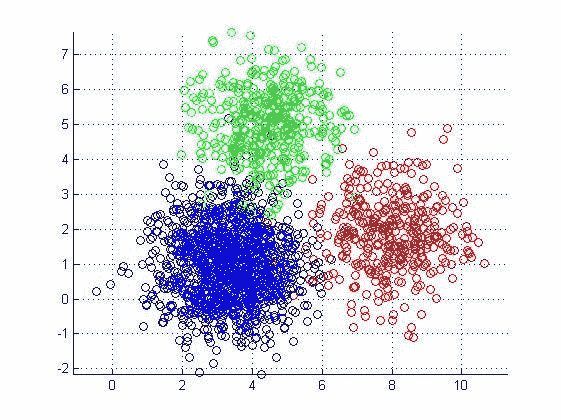

词嵌入将单词映射为实值数值向量。它通过对序列(或句子)中的每个单词进行标记化,并将其转换为向量空间来实现。词嵌入旨在捕捉文本序列中单词的语义意义。它为具有相似含义的单词分配类似的数值表示。

让我们来看看 NLP 中一些最有前景的词嵌入技术。

TF-IDF — 词频-逆文档频率

TF-IDF 是一种基于统计度量的机器学习(ML)算法,用于找出文本中单词的相关性。文本可以是一个文档或多个文档(语料库)。它是两种指标的结合:词频(TF)和逆文档频率(IDF)。

TF 分数是基于文档中单词的频率。通过计算单词在文档中出现的次数来确定 TF。TF 的计算方法是将单词(i)出现的次数除以文档(j)中的总单词数(N)。

TF (i) = log (frequency (i,j)) / log (N (j))

IDF 分数计算词语的稀有性。这一点很重要,因为 TF 会给出现频率较高的词语更多的权重。然而,在语料库中很少使用的词语可能包含重要的信息。IDF 捕捉到这些信息。它可以通过将文档总数(N)除以包含该词语的文档数量(i)来计算。

IDF (i) = log (N (d) / frequency (d,i))

在上述公式中使用 log 来减弱 TF 和 IDF 大分数的影响。最终的 TF-IDF 分数通过将 TF 和 IDF 分数相乘来计算。

TF-IDF 算法用于解决简单的 ML 和 NLP 问题。它更适合用于信息检索、关键词提取、停用词(如 ‘a’,‘the’,‘are’,‘is’)移除以及基本的 文本分析。它无法高效捕捉词语序列的语义意义。

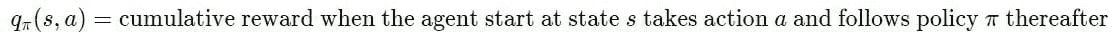

Word2Vec — 捕捉语义信息

由 Tomas Mikolov 和 Google 的其他研究人员于 2013 年开发的 Word2Vec 是一种用于解决高级 NLP 问题的词嵌入技术。它可以遍历大量的文本语料库来学习词语之间的关联或依赖关系。

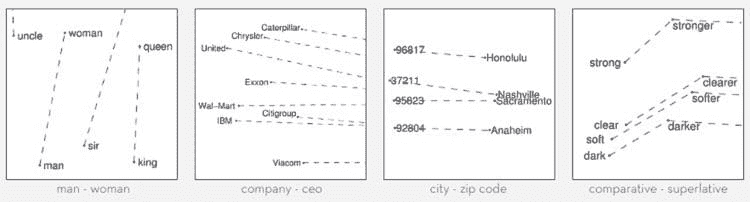

Word2Vec 通过使用 余弦相似度 度量来发现词语之间的相似性。如果余弦角度为 1,意味着词语重叠。如果余弦角度为 90,则意味着词语是独立的或没有上下文相似性。它为相似的词语分配相似的向量表示。

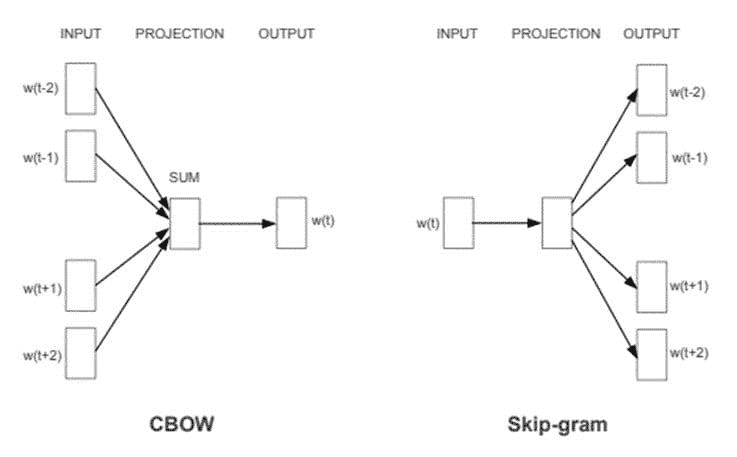

Word2Vec 提供了两种基于 神经网络 的变体:连续词袋模型(CBOW)和 Skip-gram。在 CBOW 中,神经网络模型以各种词语作为输入,预测与输入词语上下文紧密相关的目标词语。另一方面,Skip-gram 架构以一个词语作为输入,预测与之紧密相关的上下文词语。

CBOW 速度较快,并为常见词语找到更好的数值表示,而 Skip Gram 能有效地表示稀有词语。Word2Vec 模型擅长捕捉词语之间的语义关系。例如,国家与其首都之间的关系,如巴黎是法国的首都,柏林是德国的首都。它最适合执行 语义分析,这在推荐系统和知识发现中有应用。

CBOW & Skip-gram 架构。图片来源: Word2Vec 论文。

GloVe — 全局词向量表示

由 Jeffery Pennington 及斯坦福大学的其他研究人员开发的,GloVe扩展了 Word2Vec 的工作,通过计算全球词-词共现矩阵来捕捉文本语料库中的全球上下文信息。

Word2Vec 仅捕捉词汇的局部上下文。在训练过程中,它仅考虑邻近的词来捕捉上下文。GloVe 考虑整个语料库,并创建一个大矩阵,可以捕捉语料库中词汇的共现。

GloVe 结合了两种词向量学习方法的优点:矩阵分解方法,如潜在语义分析(LSA)和局部上下文窗口方法,如 Skip-gram。GloVe 技术具有更简单的最小二乘成本或误差函数,从而降低了模型训练的计算成本。生成的词嵌入在某些方面有所不同且有所改进。

GloVe 在词汇类比和命名实体识别问题上表现显著更好。在某些任务中,它优于 Word2Vec,并在其他任务中与之竞争。然而,两种技术在捕捉语料库中的语义信息方面都表现良好。

GloVe 词向量捕捉到语义相似的词。图片来源:斯坦福 GloVe。

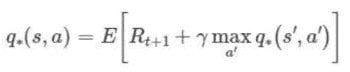

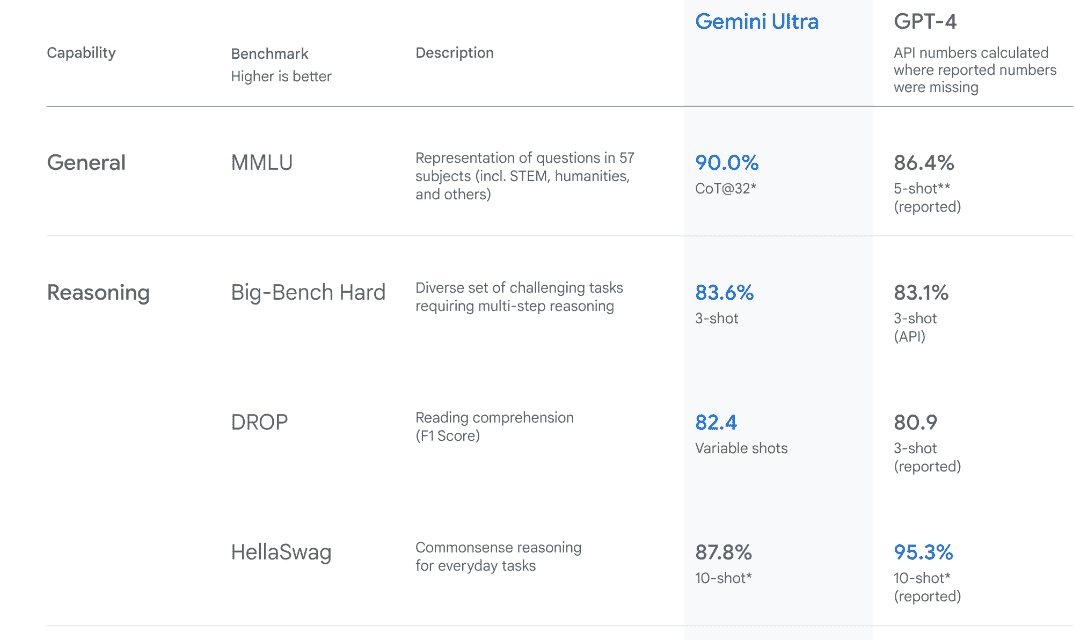

BERT—来自 transformers 的双向编码器表示

由 Google 于 2019 年介绍,BERT属于一种基于 NLP 的语言算法类别,称为transformers。BERT 是一个大规模预训练的深度双向编码器基础的 transformer 模型,有两个变体。BERT-Base 有 1.1 亿个参数,而 BERT-Large 有 3.4 亿个参数。

在生成词嵌入时,BERT 依赖于注意机制。它生成高质量的上下文感知或上下文化的词嵌入。在训练过程中,嵌入通过每一层 BERT 编码器进行细化。对于每个词,注意机制根据左侧和右侧的词捕捉词汇关联。词嵌入也进行位置编码,以跟踪句子中每个词的模式或位置。

BERT 比上述讨论的任何技术都更先进。它通过在大规模词汇语料库和维基百科数据集上进行预训练,生成了更好的词嵌入。BERT 可以通过在任务特定数据集上微调嵌入来进一步提升。

然而,BERT 最适合语言翻译任务。它已经针对许多其他应用和领域进行了优化。

双向 BERT 架构。图片来源:Google AI Blog。

结论

随着自然语言处理(NLP)的进步,词嵌入技术也在不断改进。有许多 NLP 任务并不需要高级的嵌入技术。许多任务使用简单的词嵌入技术同样可以表现良好。选择词嵌入技术必须基于细致的实验和任务特定的需求。微调词嵌入模型可以显著提高准确性。

在本文中,我们对各种词嵌入算法进行了高层次的概述。让我们总结如下:

| 词嵌入技术 | 主要特点 | 应用场景 |

|---|---|---|

| TF-IDF | 统计方法用于捕捉词语相对于文本语料库的相关性。它不捕捉语义词语关联。 | 更适合信息检索和文档中的关键词提取。 |

| Word2Vec | 基于神经网络的 CBOW 和 Skip-gram 架构,更擅长捕捉语义信息。 | 对语义分析任务有用。 |

| GloVe | 基于全局词对共现的矩阵分解方法。它解决了 Word2Vec 的局部上下文限制。 | 在词语类比和命名实体识别任务中表现更好。在一些语义分析任务中与 Word2Vec 的结果相当,而在其他任务中则更优。 |

| BERT | 基于 Transformer 的注意力机制,用于捕捉高质量的上下文信息。 | 语言翻译、问答系统。部署在 Google 搜索引擎中以理解搜索查询。 |

参考文献

-

www.techopedia.com/definition/33012/natural-language-generation-nlg -

www.expert.ai/blog/natural-language-process-semantic-analysis-definition/ -

blog.marketmuse.com/glossary/latent-semantic-analysis-definition/ -

ai.googleblog.com/2018/11/open-sourcing-bert-state-of-art-pre.html -

ai.googleblog.com/2017/08/transformer-novel-neural-network.html -

www.analyticsvidhya.com/blog/2019/11/comprehensive-guide-attention-mechanism-deep-learning/

Neeraj Agarwal 是 Algoscale 的创始人,Algoscale 是一家数据咨询公司,涵盖数据工程、应用 AI、数据科学和产品工程。他在该领域拥有超过 9 年的经验,并帮助了从初创企业到财富 100 强公司等各种组织,处理和存储大量原始数据,以将其转化为可操作的见解,帮助做出更好的决策并加快业务价值的实现。

相关主题更多信息

H2O 机器学习框架

原文:

www.kdnuggets.com/2020/01/h2o-framework-machine-learning.html

评论

由 ActiveWizards 提供

我们的三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

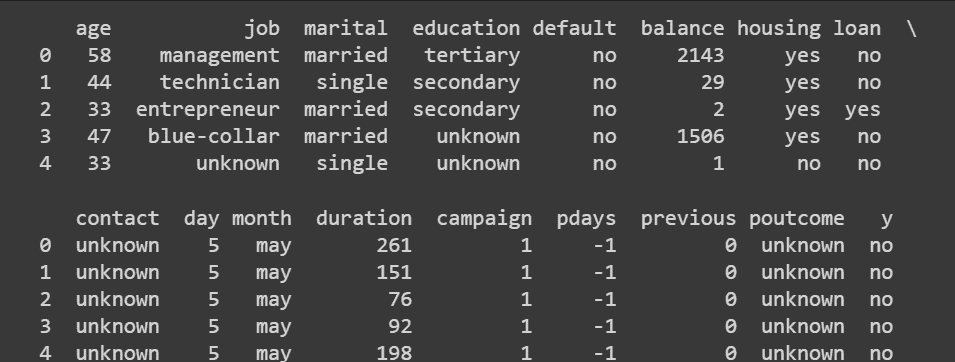

H2O 是一个可扩展且快速的开源机器学习平台。我们将应用它来执行分类任务。我们使用的数据集是 银行营销数据集。在这里,我们需要训练一个模型,该模型能够根据客户的个人特征、营销活动特征和当前的宏观经济条件,预测银行客户是否会开设定期存款。

在模型创建过程中,我们探索了 H2O 工具包中的各种核心组件和功能。你应该明白,虽然本文涵盖了一些 H2O 的基本概念,但如果你需要更详细的信息,应该访问 H2O 网站并阅读 文档。

注意:有关安装说明,请使用 官方网站。

准备工作

我们需要首先导入所需的库:

import pandas as pd

import numpy as np

import h2o

pd.set_option('display.width', 5000)

首先,你应该启动 H2O。你可以运行方法 h2o.init() 来初始化 H2O。可以向 h2o.init() 方法传递许多不同的参数,以根据需要设置 H2O。因此,你可以在这里更改 H2O 的一些全局设置。然而,在大多数情况下,调用该方法时不带任何参数就足够了,正如我们下面所做的那样:

h2o.init()

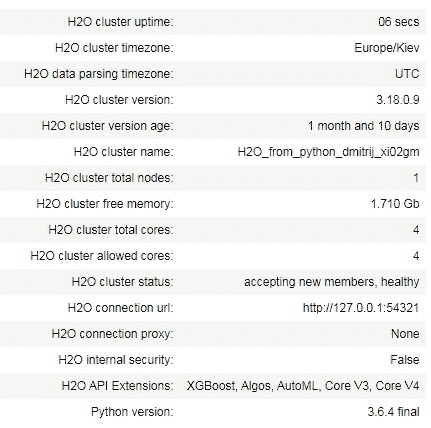

你可以看到,这种方法的输出包含有关 H2O 集群的一些元信息。

下一步我们应该导入将要使用的数据集。这是一个 .csv 文件,H2O 具有 upload_file() 函数,可以将数据集加载到内存中。值得一提的是,H2O 可以处理多种数据源(本地和远程),并支持不同的文件格式。

bank_df = h2o.upload_file("bank-additional-full.csv")

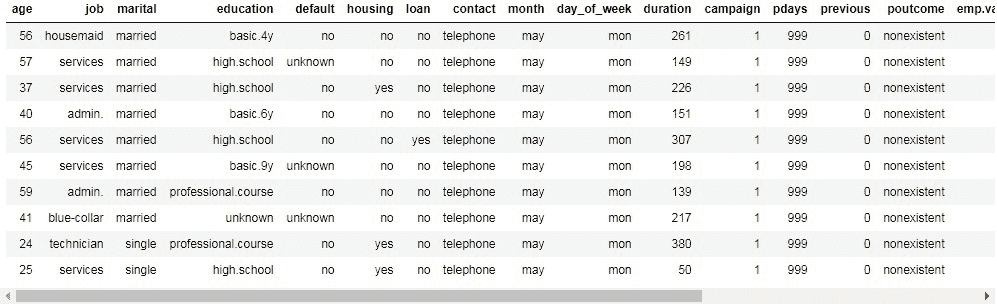

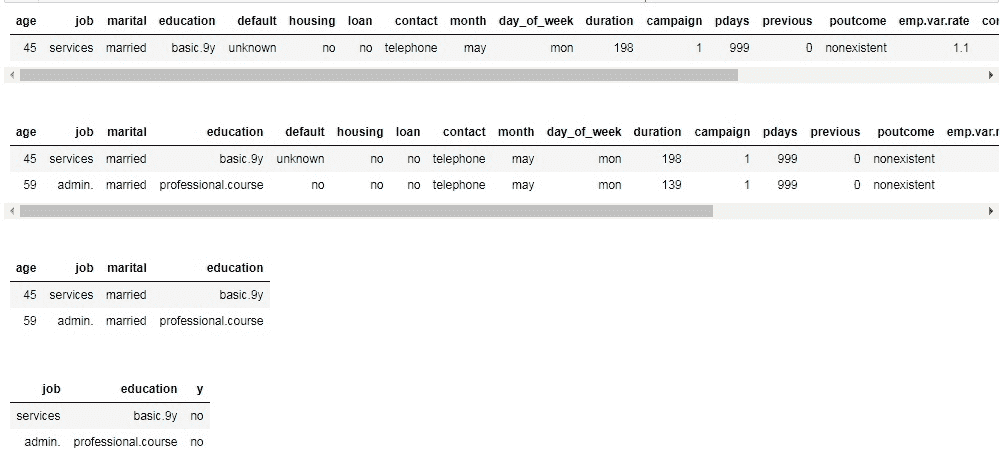

要查看数据集,你可以简单地输入其名称并运行单元格。默认显示前 10 行。

从这个变量的类型来看,我们可以看到类型是 h2o.frame.H2OFrame。因此,这不是 pandas 对象,而是 H2O 的对象。

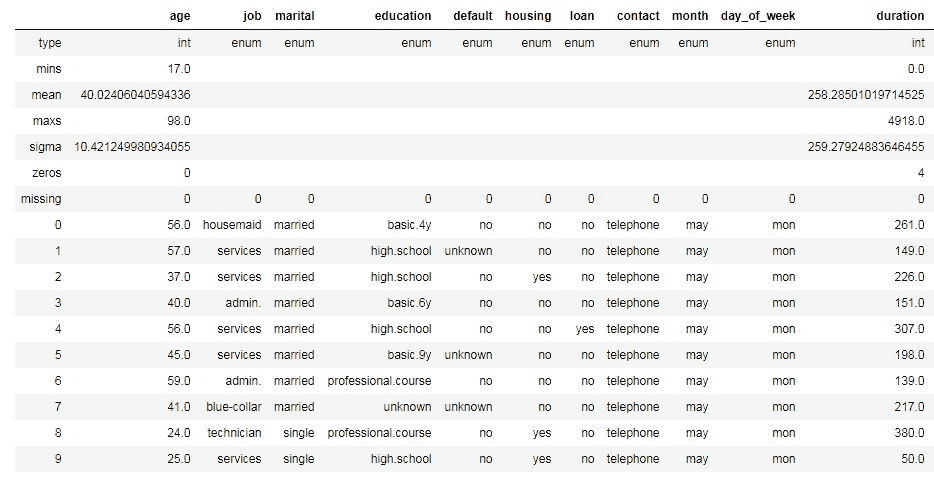

然而,你可以以熟悉的方式对这个 H2OFrame 进行索引和切片:

# show 6th row

print(bank_df[5,:])

# show 6-7 rows

print(bank_df[5:7,:])

# show first 4 columns from 6-7 rows

print(bank_df[5:7,0:4])

# show job,education and y columns from 6-7 rows

print(bank_df[5:7, ['job', 'education', 'y']])

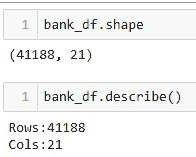

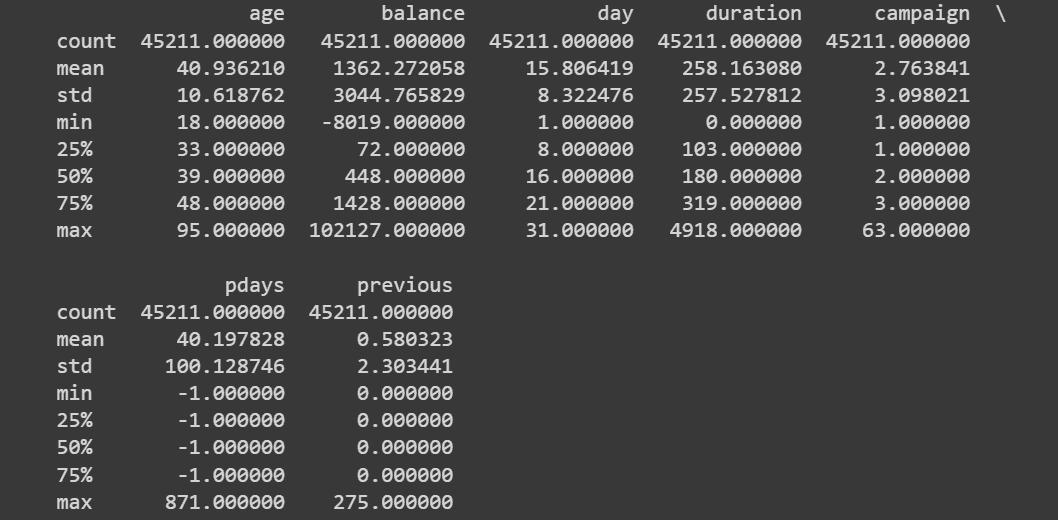

你可以通过访问 .shape 属性来检查 H2OFrame 的形状。此外,一些有用的信息(列类型、最小值、平均值、最大值、标准差、零值数量、缺失值)可以通过 .describe() 方法生成。

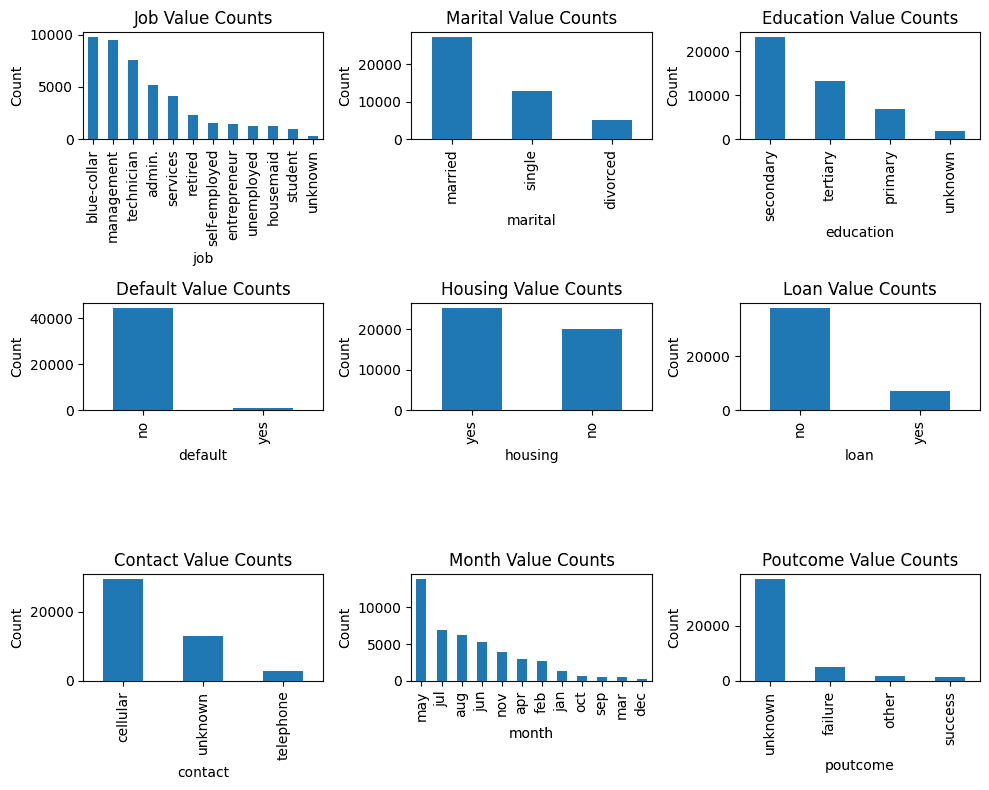

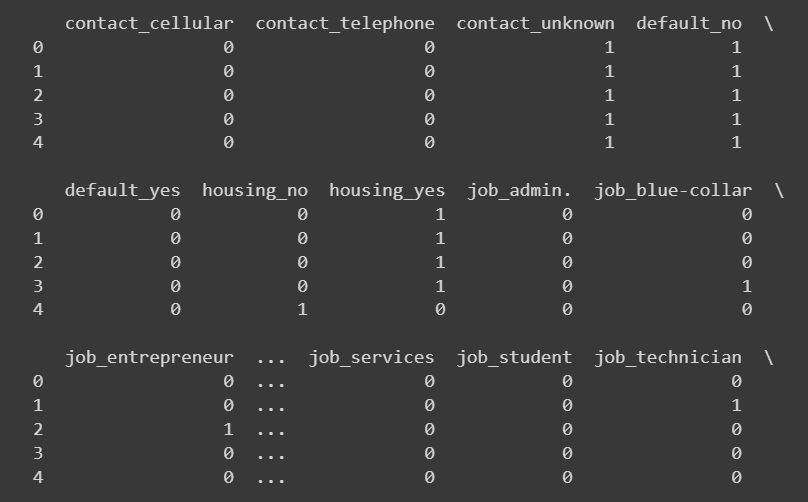

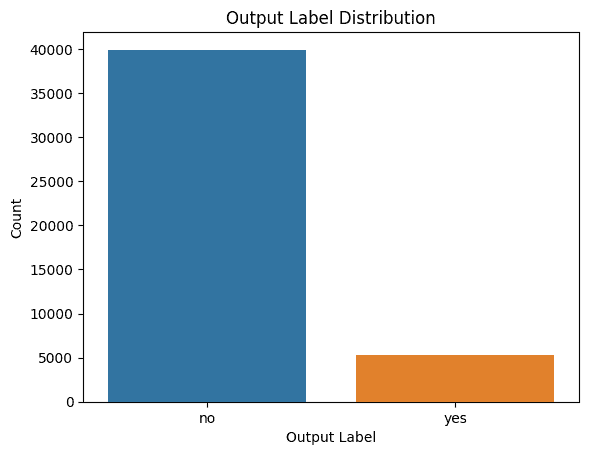

正如我们所见,我们的数据集中没有缺失数据。我们有 20 列不同的分类、整数和实数特征以及 1 列目标变量 (y)。目标变量是二元的,如果客户希望订阅定期存款,则值为 "yes",否则为 "no"。

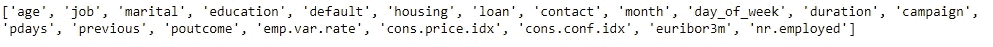

在下一个单元格中,我们将列名提取到变量 x 中。然后,我们从这个列表中移除目标列名 (y)。另外,我们将目标变量的名称写入变量 y 中。

x = bank_df.names

x.remove("y")

print(x)

Y = "y"

第一个模型

现在让我们训练某个模型。首先,我们需要将数据集拆分为训练集和测试集。H2O 允许通过使用函数 split_frame() 来完成。如果你只传递一个元素作为第一个参数(或参数 ratios),这个元素定义了训练数据集的比例。其余部分是测试集。如果你传递两个元素,第一个表示训练集,第二个表示测试集,剩余部分是验证集。这里我们希望将 70% 的样本作为训练集,30% 作为测试集。我们还固定了随机状态以获得可重复的结果。

train, test = bank_df.split_frame([0.7], seed=42)

一开始,我们希望使用随机森林模型来分类数据点。 H2ORandomForestEstimator 可以在模块 h2o.estimators 中找到。

from h2o.estimators import H2ORandomForestEstimator

然后我们创建一个估计器的实例。这里你可以指定许多不同的参数。我们通过将 200 分配给 ntrees 参数来设置树的数量为 200。在此之后,我们在估计器的实例上调用 train 方法。我们应该将特征的列名传递给变量 x,将目标列名传递给变量 y。我们还指定训练和验证样本。在我们运行这个单元格之后,可以看到下面的进度条,反映训练过程的状态。

rf = H2ORandomForestEstimator(ntrees=200)

rf.train(x=x,

y=y,

training_frame=train,

validation_frame=test)

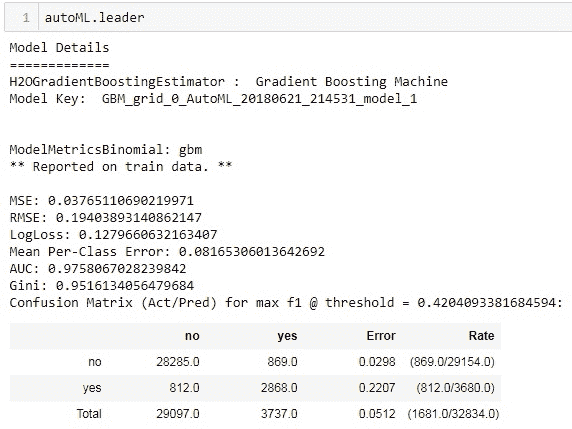

可以通过查看估计器的实例来访问模型详细信息:

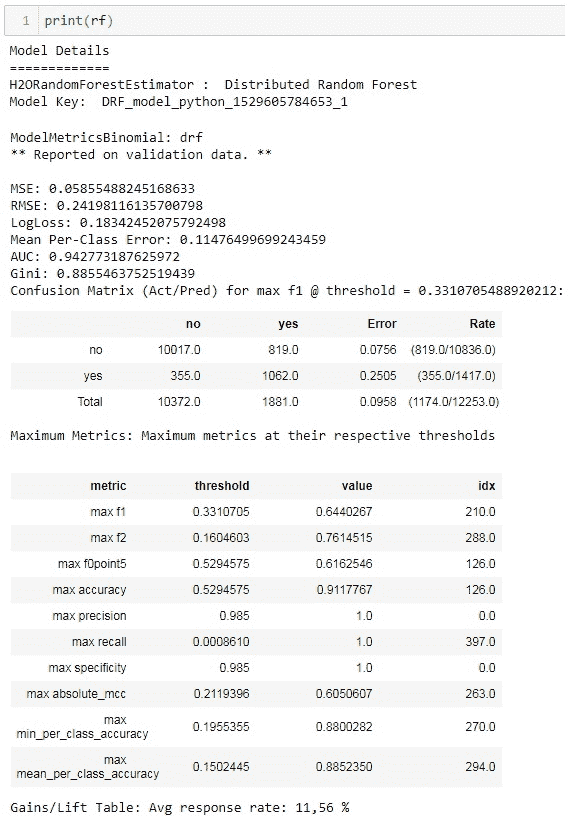

这里有很多有趣和有用的信息。你可以注意到两个信息块。第一个是关于训练集的,第二个是关于测试集的。有不同的模型性能指标(MSE、RMSE、LogLoss、AUC、Gini 等)。混淆矩阵是一个非常有趣的错误分析指标。H2O 允许查看训练集和测试集的混淆矩阵。混淆矩阵中也显示了每个标签的错误总比例。

有趣的表格是关于在各自错误下的最大指标。在二分类中,模型返回实例属于正类的概率。然后这个概率应与某个阈值进行比较,以决定这是正类还是负类。H2O 在这个表格中显示了不同指标的最大值,并指定了在达到这些最大值时使用的阈值。例如,在我们的案例中,通过选择阈值 0.985 可以在测试集上实现完美的精确度。测试集上的最大准确率是 0.911,当你选择 0.5294 作为阈值时可以达到。最高的 F1 分数对应于阈值 0.331。

在实现解决方案中的模型时,你可以选择最适合你需求的阈值。同时,你可以尝试一些更高级的操作,例如通过结合训练集和测试集的不同指标的最大值报告的阈值来选择阈值。

另一个有趣的表格是特征重要性的表格。最具信息量的列是scaled_importance和percentage。你可以看到,duration特征在这个任务和数据集中具有最大的预测能力。这个特征表示与客户通话的持续时间。除了duration之外,排名前五的其他重要特征是宏观经济指标euribor3m和nr.employed,以及客户的age和job。

现在我们想要手动计算测试集上的准确率。

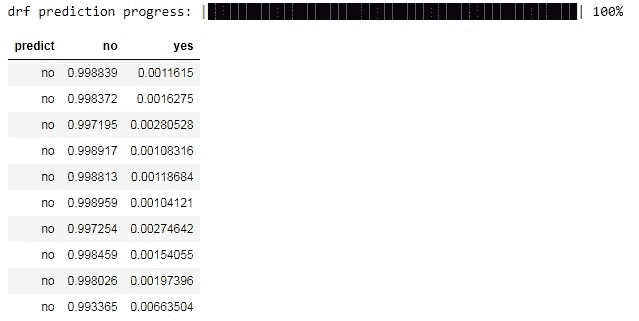

在下一个单元格中,我们进行预测。你可以看到方法predict()返回一个数据框,其中第一列是答案(是或否),接下来的两列是“否”和“是”的概率。

rf = H2ORandomForestEstimator(ntrees=200)

rf.train(x=x,

y=y,

training_frame=train,

validation_frame=test

在下一个单元格中,我们统计预测结果与实际答案相等的案例数量,然后计算均值,这将成为预测的准确性。我们可以看到准确率是 0.9041,或者大约 90.4%。如果你回到混淆矩阵,可以注意到,如果你从 1 中减去测试集的总错误(0.0958),你将得到约 0.9041,这就是我们手动计算得到的准确率。

(predictions["predict"] == test["y"]).mean()

其他算法

H2O 提供了几种不同的训练模型。让我们尝试其中的一些。

我们想要使用神经网络训练的第一个算法。要使用这个模型,我们需要从 h2o.estimators.deeplearning 模块中导入 H2ODeepLearningEstimator。然后,我们需要创建这个估计器的实例。与之前的随机森林示例类似,你可以传递许多不同的参数来控制模型和训练过程。重要的是要设置神经网络的架构。在参数 hidden 中,我们传递一个包含隐藏层神经元数量的列表。因此,这个参数同时控制隐藏层的数量和这些层中的神经元数量。我们设置了 3 个隐藏层,分别有 100、10 和 4 个神经元。同时,我们将激活函数设置为 Tanh。

from h2o.estimators.deeplearning import H2ODeepLearningEstimator

dl = H2ODeepLearningEstimator(hidden=[100, 10, 4],activation='Tanh')

dl.train(x=x, y=y, training_frame=train, validation_frame=test)

predictions_dl = dl.predict(test)

print((predictions_dl["predict"] == test["y"]).mean())

我们可以看到,准确率略低于随机森林。也许我们可以调整模型的参数以获得更好的性能。

在接下来的几个单元格中,我们将训练线性模型。Binomial family 表示我们想要执行逻辑回归分类。 lambda_search 允许搜索最优的正则化参数 lambda。

from h2o.estimators.glm import H2OGeneralizedLinearEstimator

lm = H2OGeneralizedLinearEstimator(family="binomial",

lambda_search=True)

lm.train(x=x,

y=y,

training_frame=train,

validation_frame=test)

predictions_lm = lm.predict(test)

print((predictions_lm["predict"] == test["y"]).mean())

我们在这里想要使用的最后一个模型是梯度提升算法。使用默认参数,它在所有其他算法中可能表现最佳。

from h2o.estimators.gbm import H2OGradientBoostingEstimator

gb = H2OGradientBoostingEstimator()

gb.train(x=x,

y=y,

training_frame=train,

validation_frame=test)

predictions_gb = gb.predict(test)

print((predictions_gb["predict"] == test["y"]).mean())

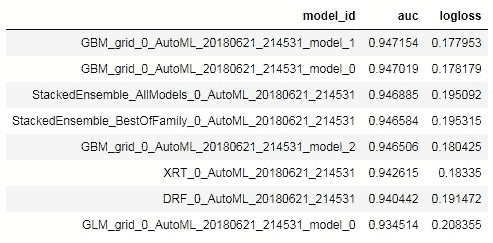

值得一提的是 H2O 平台中 XGBoost 的集成。XGBoost 是实现梯度提升思想的最强大算法之一。你可以单独安装它,但在 H2O 中使用 XGBoost 也非常方便。在下面的单元格中,你可以看到如何创建 H2OXGBoostEstimator 的实例以及如何训练它。你应该理解,XGBoost 使用许多参数,且这些参数的变化常常会非常敏感。

param = {

"ntrees" : 400,

"max_depth" : 4,

"learn_rate" : 0.01,

"sample_rate" : 0.4,

"col_sample_rate_per_tree" : 0.8,

"min_rows" : 5,

"seed": 4241,

"score_tree_interval": 100

}

predictions_xgb = xgb.predict(test)

print((predictions_xgb["predict"] == test["y"]).mean())

H2O 中还提供了其他几种模型。如果你想了解更多,请查看文档。

H2O 中的交叉验证

交叉验证是机器学习中核心技术之一。基本思想是将数据集拆分为几个部分(折叠),然后在除了一个折叠的所有部分上训练模型,该折叠将用于后续的测试。在此,当前迭代完成,下一次迭代开始。在下一次迭代中,测试折叠被纳入训练样本。相反,来自之前训练集的某个折叠将用于测试。

例如,我们将数据集拆分为 3 个折叠。在第一次迭代中,我们使用第 1 和第 2 个折叠进行训练,第 3 个折叠用于测试。在第二次迭代中,使用第 1 和第 3 个折叠进行训练,第 2 个折叠用于测试。在第三次迭代中,第 1 个折叠用于测试,第 2 和第 3 个折叠用于训练。

交叉验证允许以更准确和可靠的方式评估模型的性能。

在 H2O 中进行交叉验证很简单。如果模型支持,有一个可选参数 nfolds 可以在创建模型实例时传递。你应使用此参数指定交叉验证的折数。

H2O 构建了 nfolds + 1 个模型。一个额外的模型是在所有可用数据上训练的。这是你训练结果的主要模型。

让我们训练随机森林并进行 3 折交叉验证。注意我们没有传递验证(测试)集,而是使用整个数据集。

rf_cv = H2ORandomForestEstimator(ntrees=200, nfolds=3)

rf_cv.train(x=x, y=y, training_frame=bank_df)

如果你查看上面的单元格输出,你会注意到一些差异。

第一个是模型不是在验证数据上进行报告,而是在交叉验证数据上进行报告。

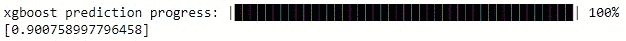

第二点是有一个交叉验证指标总结表。在这里你可以看到许多不同的指标、每个折作为测试折的指标值,这些值的均值以及每个指标的标准偏差。例如,对于第一折我们得到的准确率是 0.9006,第二折是 0.904,第三折是 0.903。这些值的均值是 0.9025,标准偏差是 0.001。你应该理解,拥有“良好”的指标值固然重要,但低标准偏差也很重要。这意味着你的模型在数据集中不同样本上的表现都很好。但交叉验证结果的解释实际上不是本文的目标,因此我们继续下一章节!

使用 GridSearch 调整模型

通常,你需要尝试许多不同的参数及其组合,以找到最佳模型性能的配置。手动完成所有这些工作是困难且有时乏味的。GridSearch 可以自动化这一过程。你只需指定想要尝试的一组超参数,并运行 GridSearch 实例。系统将尝试所有可能的参数组合(为每个组合训练和测试模型)。让我们看看如何在 H2O 中使用这个工具。

首先,你需要导入 GridSearch 对象的实例:

from h2o.grid.grid_search import H2OGridSearch

现在,你需要指定所有可能的参数。我们将搜索之前构建的 XGBoost 模型的最佳参数组合。参数被放置在一个 Python 字典中,其中键是参数的名称,值是这些参数的可能值的列表。

xgb_parameters = {'max_depth': [3, 6],

'sample_rate': [0.4, 0.7],

'col_sample_rate': [0.8, 1.0],

'ntrees': [200, 300]}

下一步是创建 GridSearch 实例。你应该传递一个模型、网格的 ID 和包含超参数的字典。

xgb_grid_search = H2OGridSearch(model=H2OXGBoostEstimator,

grid_id='example_grid',

hyper_params=xgb_parameters)

最终,你可以运行网格搜索。注意我们设置了较高的学习率,因为网格搜索是一个非常耗时的过程。随着超参数数量的增长,训练的模型数量迅速增加。因此,考虑到这只是一个学习示例,我们不想测试太多的超参数。

xgb_grid_search.train(x=x,

y=y,

training_frame=train,

validation_frame=test,

learn_rate=0.3,

seed=42)

我们可以通过使用 GridSearch 实例的 get_grid()方法来获取网格搜索的结果。我们希望按准确率指标的降序对结果进行排序。

grid_results = xgb_grid_search.get_grid(sort_by='accuracy',

decreasing=True)

print(grid_results)

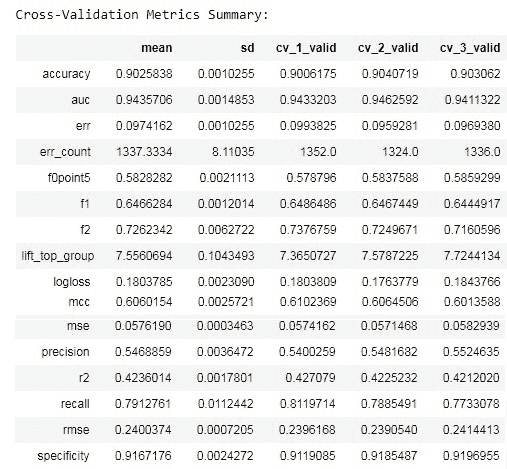

你可以看到,使用 1.0 列样本率、0.4 样本率、200 棵树和每棵树的最大深度为 3 的组合可以获得最高的准确率。

AutoML

H2O 提供了自动化机器学习的能力。这个过程非常简单,面向那些在机器学习方面知识和经验较少的用户。AutoML 将遍历不同的模型和参数,尝试找到最佳方案。需要指定几个参数,但大多数情况下,你只需要设置最大运行时间(以秒为单位)或最大模型数。你可以将 AutoML 视为类似于 GridSearch,但它是在模型层级而不是参数层级上进行的。

from h2o.automl import H2OAutoML

autoML = H2OAutoML(max_runtime_secs=120)

autoML.train(x=x,

y=y,

training_frame=bank_df)

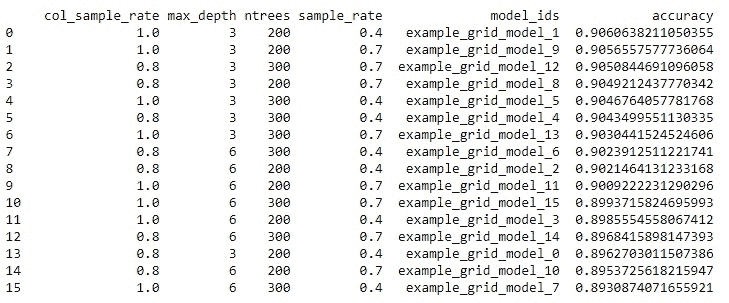

我们可以通过检查 autoML 实例的.leaderboard 属性来查看所有尝试过的模型及其对应的性能。具有 0.94 AUC 指标的 GBM 模型似乎是这里表现最好的模型。

leaderboard = autoML.leaderboard

print(leaderboard)

查看最佳模型:

你可以直接从 autoML 实例上对测试集进行预测。

predictionAML = autoML.predict(test)

结论

这篇文章只是 H2O 功能的简要介绍。这是一个出色的机器学习平台,可以使一些机器学习领域的工程师工作变得更简单。它是一个不断发展的框架。在我们看来,它不能单独使用。相反,与 H2O 一起使用的其他工具可以使机器学习过程更快、更便捷。

在本文中,我们介绍了 H2O 中的一些基本数据操作,查看了 H2O 提供的几种机器学习模型,学习了如何进行交叉验证和网格搜索,并熟悉了 H2O 中的自动化机器学习。

你应该了解 H2O 的一些功能超出了本文的范围。因此,如果你有兴趣了解更多,请阅读官方文档。

ActiveWizards 是一个由数据科学家和工程师组成的团队,专注于数据项目(大数据、数据科学、机器学习、数据可视化)。核心专长领域包括数据科学(研究、机器学习算法、可视化和工程)、数据可视化(d3.js、Tableau 等)、大数据工程(Hadoop、Spark、Kafka、Cassandra、HBase、MongoDB 等)以及数据密集型网页应用开发(RESTful APIs、Flask、Django、Meteor)。

原文。经许可转载。

相关:

-

自动化机器学习:团队如何在 AutoML 项目中协作?

-

自动化机器学习项目实施的复杂性

-

顶级 6 个 Python NLP 库的比较

更多相关话题

对有志数据科学家的黑客马拉松指南

原文:

www.kdnuggets.com/2019/07/hackathon-guide-aspiring-data-scientists.html

评论

评论

由 Jiwon Jeong,数据科学研究员

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业领域。

1. 谷歌网络安全证书 - 快速进入网络安全职业领域。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

3. 谷歌 IT 支持专业证书 - 支持你的组织在 IT 方面

黑客马拉松是一种竞赛,各种人员,包括程序员、开发者和图形设计师,密集合作以在短时间内设计软件项目。黑客马拉松的目标是在活动结束时创建一个功能性产品。

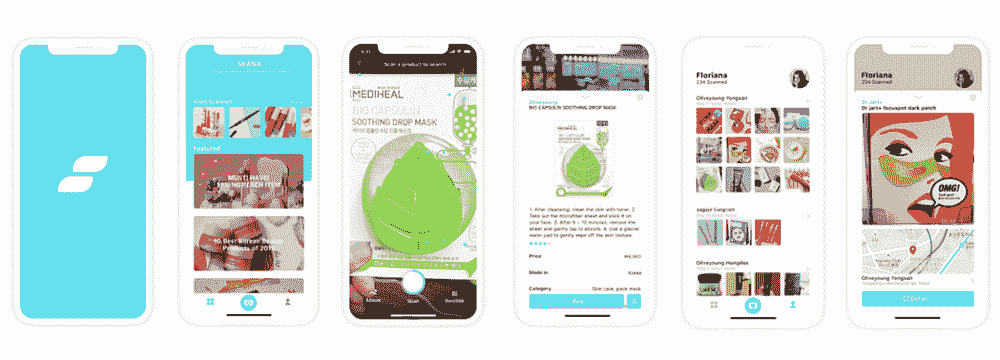

上个月,我有机会参加由 Junction Ltd. 举办的 JunctionX Seoul 黑客马拉松。我们的团队开发了一个 iOS 应用,利用图像搜索引擎为韩国美容产品提供优化的购物服务体验。这个应用可以帮助想要探索韩国美容产品的旅行者,因为他们可能因为明显的语言障碍而不知道尝试什么。用户只需扫描产品即可找到有用的数据,这些信息会被翻译成他们的本地语言。还有一个搜索历史页面,可以用于进一步的定制服务。你可以在 这里 了解更多信息。

这个应用,Skana

然而,我更愿意分享我在过程中学到的东西,而不是我做了什么。所以今天,我将讨论你应该申请黑客马拉松的 4 个理由(特别是如果你是一个有抱负的数据科学家),你应该如何准备以及我的一些小贴士。我希望这篇文章能激励你走出舒适区,像我一样获得深刻的灵感。

1. 为什么参加黑客马拉松

如果你之前从未尝试过黑客马拉松或编程比赛,并问我是否值得尝试,我会毫不犹豫地点头。以下是你应该参加黑客马拉松的 4 个理由。

超越“建模”

我们,数据科学学习者,往往倾向于独自工作或学习。我们往往将大部分时间投入到数据预处理和数据处理上。我们将大部分精力投入到学习机器学习或深度学习算法中。我们的项目通常从导入数据(有时是自己构建数据)开始,以评估预测结果结束。

不幸的是,几乎所有现实世界的项目并不是这样运作的。我们并不孤单工作。我们与其他团队成员合作。从数据库到部署和产品管理,所有过程都应通过协作完成。拥有超越“建模”领域的工具包对有志者来说是一个很大的加分项。(许多文章指出了这一点,你可以在这里找到一篇)现在重要的问题是,我们在哪里可以学习和体验这些?

“与比赛不同,没有人给你两个叫做 train 和 test 的 .csv 文件以及一个写得很好的评估指标。几乎 80% 的努力投入在定义问题和获取及处理数据上。剩下的 20% 努力用于纯建模和部署。” - AnalyticsVidhya

黑客马拉松可以是一个与他人合作并实现实际项目的绝佳机会。尽管有一些限制,你仍然可以学习如何与他人(他们对机器学习的了解不如你)沟通,并理解发布实际产品的整体工作流程。如果你有机会与比你在机器学习方面更了解的人一起工作,我相信这将是推动你极限的绝佳时机。

商业思维比你想象的更为重要

项目的第一步是决定构建什么。我可以告诉你,成功的机会有一半在这里决定。你应该从一开始就走在正确的道路上。实施也是一个关键点,但商业价值扮演着至关重要的角色。如果被忽视,你的工作可能只是展示你在技术上的能力。

“同样,数据科学家被雇佣来创造商业价值,而不仅仅是建立模型。问问自己:我的工作成果将如何影响公司的决策?我需要做些什么来最大化这一影响?怀着这种企业家精神,第三波数据科学家不仅产生可操作的见解,还寻求这些见解带来真正的改变。” - Towards Data Science

你可能已经见过很多人指出商业思维的重要性。发现用户的隐藏需求和观察市场中的问题。利用你的技术知识提出解决方案。开发可以盈利的服务。在黑客马拉松中,你被要求从这个角度深入思考和讨论。

我听说过一个人,他赢得了超过 15 次编程比赛。他在赢得一次 Google 比赛后,退休于他的“奖品猎人”生涯。你知道他的秘密是什么吗?只是商业头脑和一点机智。通过创造一个聪明而有创意的产品,他让人们喊出“精彩!”这无疑给评委留下了深刻的印象。所以,如果你在寻找额外的获胜提示,具备商业价值和一些机智可能是一个很好的加分项。

处理极端压力的绝佳机会

黑客马拉松的目标是在短时间内(通常是 2 或 3 天)创建一个功能产品。你被要求在这些日子里展示你的产品原型或演示。这一切都涉及到有限的时间、资源和精力问题。有时候,你可能会遇到事情出错的情况,你必须立刻找到解决方案。有时候你需要优先处理工作,这意味着什么先做,什么时候停止。你可能会感受到强烈的压力来完成所有任务,而不成为团队的负担。随着时间的推移,彻底疲惫和精疲力竭几乎是不可避免的!(更像是能量耗竭,直到最终“跌入”睡眠。)

如果你像我一样,容易在极端压力时僵住,你甚至会被比赛大厅的空气所压倒。这是我第一次参加黑客马拉松,所以我经历了几次大脑瘫痪。我不得不去呼吸新鲜空气,放松一下以缓解紧张。但这也是一个很好的机会,让我学会如何应对压力。因为在工作中遇到那些意想不到的问题是不可避免的,我们必须管理那些要求很高的时刻。

“Hello, world”的实时

结识新朋友也是一种很大的乐趣,特别是当他们是志同道合的人时。在黑客马拉松中,你可以遇到来自不同地区和具有不同专业但有相同兴趣的各种人。他们可以是网页开发者、应用开发者或设计师,但他们都是愿意花费周末开发一些酷东西的人。

我遇到了从俄罗斯专程来韩国参加这个活动的人。我还遇到了一位在韩国学习计算机科学的乌克兰女士。还有来自丹麦、法国、中国和日本的人。结识新朋友本身就是一种乐趣。但更重要的是,我可以了解他们遇到的痛点以及他们真正热衷的事物。通过与其他参与者聊天,我的编程视野得到了拓展。这也是我认为你应该尝试有宽泛主题的黑客马拉松,而不是过于集中在数据科学领域的原因。

此外,关注其他人的工作也很重要。虽然你会忙得无暇顾及他人,但这将帮助你理解整个过程。毕竟,我们在这里是为了学习新东西!

照片来自JunctionXSeoul和我在进行演讲(右下角)

2. 如何准备

现在,黑客马拉松听起来值得一试吗?如果是的话,你接下来的问题可能是如何准备。实际上,什么都不需要。只管去尝试。无论你具备什么技能,都不要犹豫去申请。黑客马拉松不仅仅是专业人士的舞台。但如果你想在活动前做一些准备,那么我想列出一些我认为有用且适用的技能。

后端和部署

这不是一个从导入数据开始、以一些评估图表结束的项目。你需要收集数据并根据团队项目建立数据库。在你完成数据分析或建模部分后,你需要将模型传递给前端。或者你可能需要自己将工作部署到网站上。因此,拥有数据库和 Flask 在你的工具包中可以是这个活动的巨大资产。

如果你对数据库完全陌生,你可以从理解SQL 和 NoSQL 的区别开始学习。这里有一个紧凑的初学者 SQL 课程,但除了这个,还有大量的数据库教程可以选择。所以,根据你的兴趣去挑选吧。

Flask是一个用 Python 编写的微框架,易于学习,非常适合模型部署。这里有一个关于如何用 Flask 部署 Keras 深度学习模型的优秀教程,由Ben Weber提供。你也可以在这里找到一系列 Flask 视频课程。

API 和云服务

每个黑客松的条件可能不同,但我参与的那个非常依赖于 API 和云服务。比赛中有几个子轨道,参赛者被要求使用特定的 API 来参与给定的轨道。但除了这个条件,你无论如何都需要自己收集数据。你会从哪里获取数据?那训练的计算能力呢?你可能会把你的“超级计算机”留在家里。

因此,最好有从 API 获取数据和处理 JSON 格式数据的经验。如果你对 API 不熟悉, 这篇文章可以向你解释 API 的相关内容。

使用像 AWS 或 Google Cloud GPU 这样的云服务的能力也是必要的。这里是 AWS EC2 的官方指南,此外还有一段友好的视频由 AI 学校提供。你还可以找到一个针对初学者的更详细教程由 Michael Galarnyk提供。

充分充电的自己

充足的睡眠。掌控好你的状态。这不是开玩笑。在比赛期间,我总共睡了 4 小时。虽然少睡觉可能是一个好的策略,但你在进入比赛场地时需要保持良好的状态。此外,颈枕和猫毯对于小憩来说可能和“Flask”或“AWS”一样重要。???????

图片来源于 JunctionXSeoul

3. 我的最后一些小建议

最后,这里有一些我的小建议。

如何组建你的团队

如果你是单独申请者,你需要从头开始组建你的团队。可以通过类似 Slack 这样的社交网络平台从其他申请者那里获取信息,并在活动开始前组建团队。你可能有机会加入一个已经组建好的团队,前提是有一个空缺。

如果你有一个开发的想法,将其分解成几个部分,并寻找能够承担每部分的团队成员。你需要找到那些技能与我们不同的人(例如数据建模)。你需要的常见成员包括后端工程师、网页/应用开发者以及 UI/UX 设计师。

对于你能做的事情要诚实

你可能会觉得自己的能力不足以完成这个任务。所以你可能想隐藏自己的水平或者假装知道得比实际更多。但你真的不需要这样。黑客松对每个人开放。无论你对编程了解多少,总有一些部分只有你能填补!旁边的人比你知道得多?太棒了!你有更多学习的机会。寻求帮助是“帮助”你的团队的更好方式,而不是独自挣扎并浪费宝贵的时间。

尽情享受,尽情享受,再尽情享受!

这不仅仅是关于赢得胜利。虽然你应该在比赛中尽全力,但不要忘记脸上的微笑。享受学习的时光,结识新朋友并与他们一起工作。享受创造的时光,开发一些世界上不存在的新事物。享受面对压力并突破极限的时光。这将极具挑战性。然而,活动结束时,即使你没有赢得奖项,你也会带着新的想法和教训回到家中。你会像我一样期待下一次黑客马拉松。????

这个故事与你产生共鸣了吗?请与我们分享你的见解。我总是愿意交流,所以请随时在下方留言分享你的想法。我还在LinkedIn上分享有趣且有用的资源,欢迎关注并与我联系。我下次会带来另一个有趣的故事。敬请关注!

个人简介: Jiwon Jeong 是一名数据科学研究员,数据迷,书虫和旅行爱好者。

原文。经授权转载。

相关:

-

构建一个 Flask API 来自动提取命名实体,使用 SpaCy

-

将你的 PyTorch 模型部署到生产环境

-

可持续数据科学、机器学习和人工智能产品开发的核心原则:研究作为核心驱动因素

更多相关内容

-

[停止学习数据科学以寻找目标,并寻找目标来...] (https://www.kdnuggets.com/2021/12/stop-learning-data-science-find-purpose.html)

使用机器学习和人工智能解释计算蛋白质工程。

原文:

www.kdnuggets.com/2017/07/hacking-silico-protein-engineering-machine-learning.html

由Kamil Tamiola 创办的 Peptone。

蛋白质

可以安全地说,蛋白质是构建块和定义生命物质的机制。在过去 70 年里,在蛋白质的分离、生产、特征化和最终工程方面取得了巨大的进展。尽管在实验室和工业规模的蛋白质生产方面取得了巨大进步,但蛋白质工程及所有相关步骤仍然是繁琐、昂贵且真正复杂的。

蛋白质是聚合物

蛋白质是由20 种构建块氨基酸组成的复杂生物分子,这些氨基酸按顺序连接成长的非分支链,通常称为多肽链。

多肽链的独特空间排列产生三维分子结构,这些结构定义了蛋白质的功能及其与其他生物分子的相互作用。

尽管蛋白质三维结构形成的基本力已经已知并理解,但多肽折叠的确切性质仍然难以捉摸,并且在过去 50 年中已经进行了广泛的研究。

蛋白质工程是复杂的

我们希望工程化蛋白质以增强其属性。通常,关注点是不同温度、pH或盐度下的稳定性。研究人员通常旨在提高蛋白质酶的催化性能,或向已知蛋白质中添加全新的化学活性。

工程化蛋白质最常见且成熟的方法是通过用替代氨基酸创建其变体,这些变体也称为突变体。随后,使用各种实验技术对新产生的突变体进行特征化,以测量增强的程度;例如,扫描量热法、等电点测定、简单溶解度研究或高级酶活性测定。然而,由于存在20 种标准蛋白质氨基酸,如果你决定探索所有可能的典型蛋白质氨基酸组合,那么 100 残基长的多肽的完全突变将产生20¹⁰⁰种突变组合。

相当可能,只有极少数的突变体会具有期望的属性,因为通常改变蛋白质越多,你就越远离其原始功能。

(这绝不是规则,因为这取决于蛋白质的具体情况。然而,替换蛋白质的主要部分为完全新的氨基酸序列的逻辑后果可能是新的折叠,从而带来新的功能。此外,我故意省略了一个根本性的重要事实——突变可能会显著影响蛋白质的动态,从而影响其功能)。

蛋白质生物技术在很大程度上受到规模和突变分析的复杂性的制约。

机器学习如何加速蛋白质科学的进展?

机器学习的最先进和概率(贝叶斯)变体在很大程度上依赖于输入数据的大小和质量。这一点对于生命科学中的推断和预测技术尤为重要,因为模型的复杂性水平令人困惑或尚不清楚。

通过机器学习方法对蛋白质结构、功能和动态的预测并非例外。然而,即使在相对稀疏(与所有可能的长多肽链中的蛋白质氨基酸组合数量相比)蛋白质数据库的情况下,机器学习也能帮助揭示蛋白质序列与其结构变异性和动态之间复杂的非线性关系。这些关系要么非常难以建模,要么仅仅尚未完全理解。

机器学习方法在预测蛋白质生物物理属性中的最大价值在于它们能够将松散相关的蛋白质特征与可测量的实验数据“等同”起来。因此,利用复杂数值模型进行的预测可以通过提供独立的蛋白质结构和动态的实验代理进一步调整和优化。

蛋白质是动态的,并表现出不同程度的无序。

就像我们自然环境中的其他分子一样,多肽链在从纳秒到分钟的时间尺度上进行分子运动。

已接受的观点是,完全理解蛋白质的功能和活动需要对结构和动态的了解。

结构无序是许多已知且特征化蛋白质的非常特殊的属性。它被归因于蛋白质序列中的特定模式,并对蛋白质的稳定性、对酶解的易感性、蛋白质-蛋白质相互作用以及在许多使人虚弱的 人类病理中发挥决定性作用。

从工业生物技术的角度来看,准确识别工程蛋白质中氨基酸突变的无序效应可以节省大量时间和资源。对任意蛋白质突变体的准确无序预测可以立即报告氨基酸序列的有问题的组合,从而将这些残基排除在进一步的突变分析之外,并大幅减少突变搜索空间。

阅读更多内容,始于单一蛋白质结构模型不够的 Kamil Tamiola 文章。转载了初始部分,已获得许可。

简介:卡米尔·塔米奥拉 是一位企业家和研究人员,拥有广泛的超级计算和蛋白质结构生物物理学的科学背景。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

更多相关内容

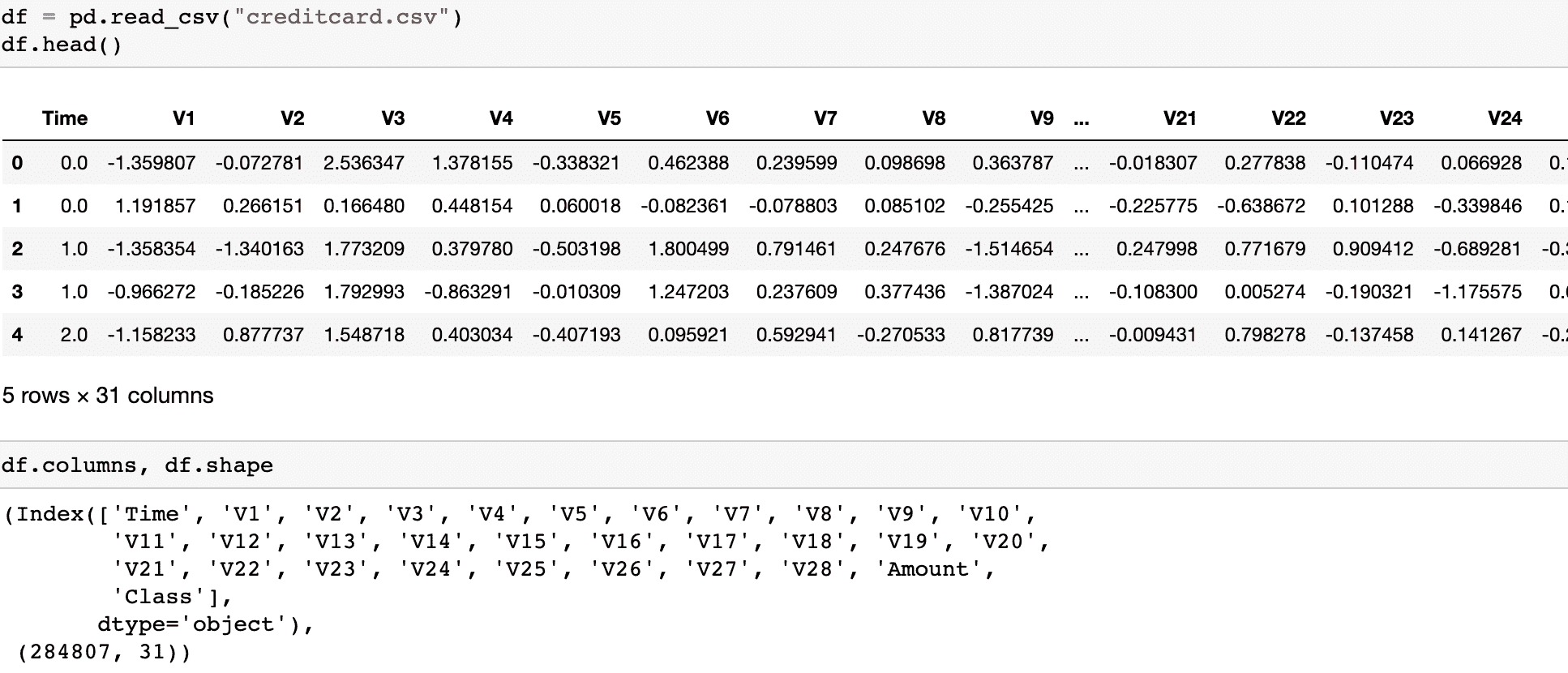

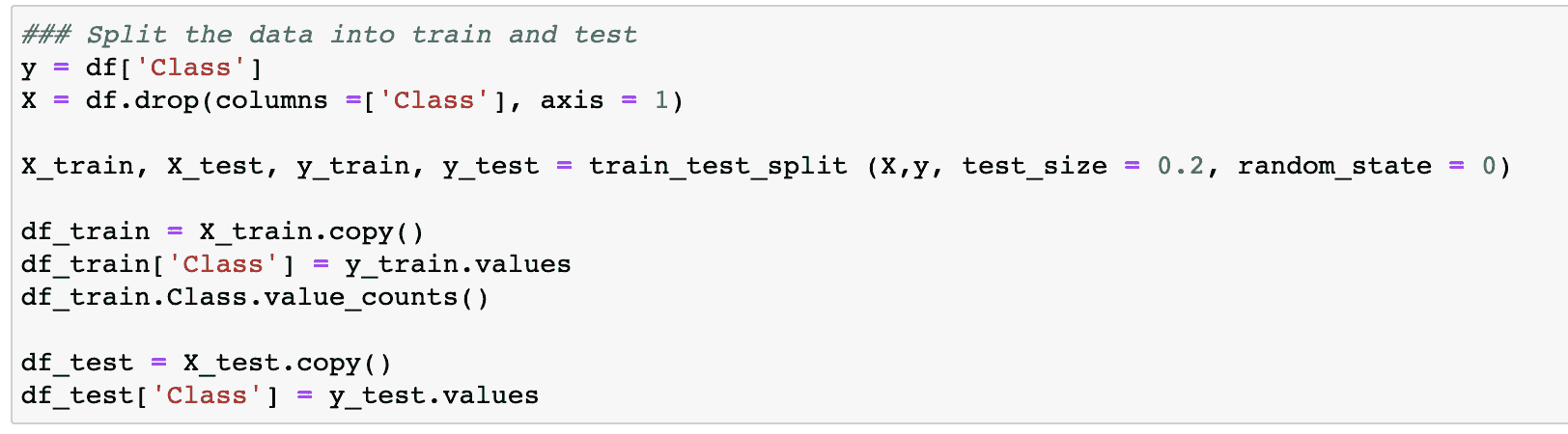

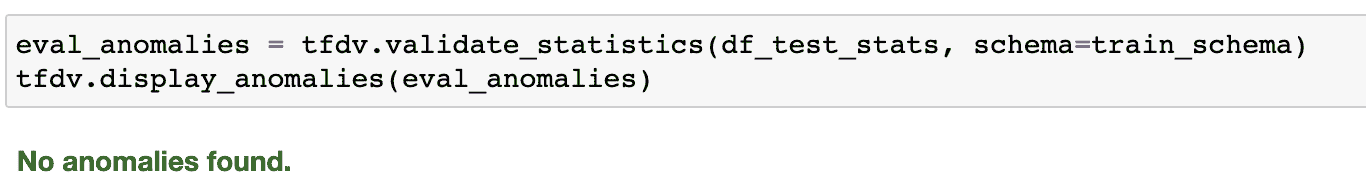

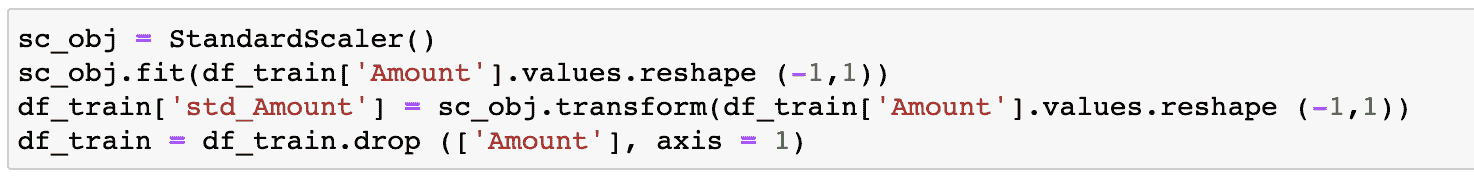

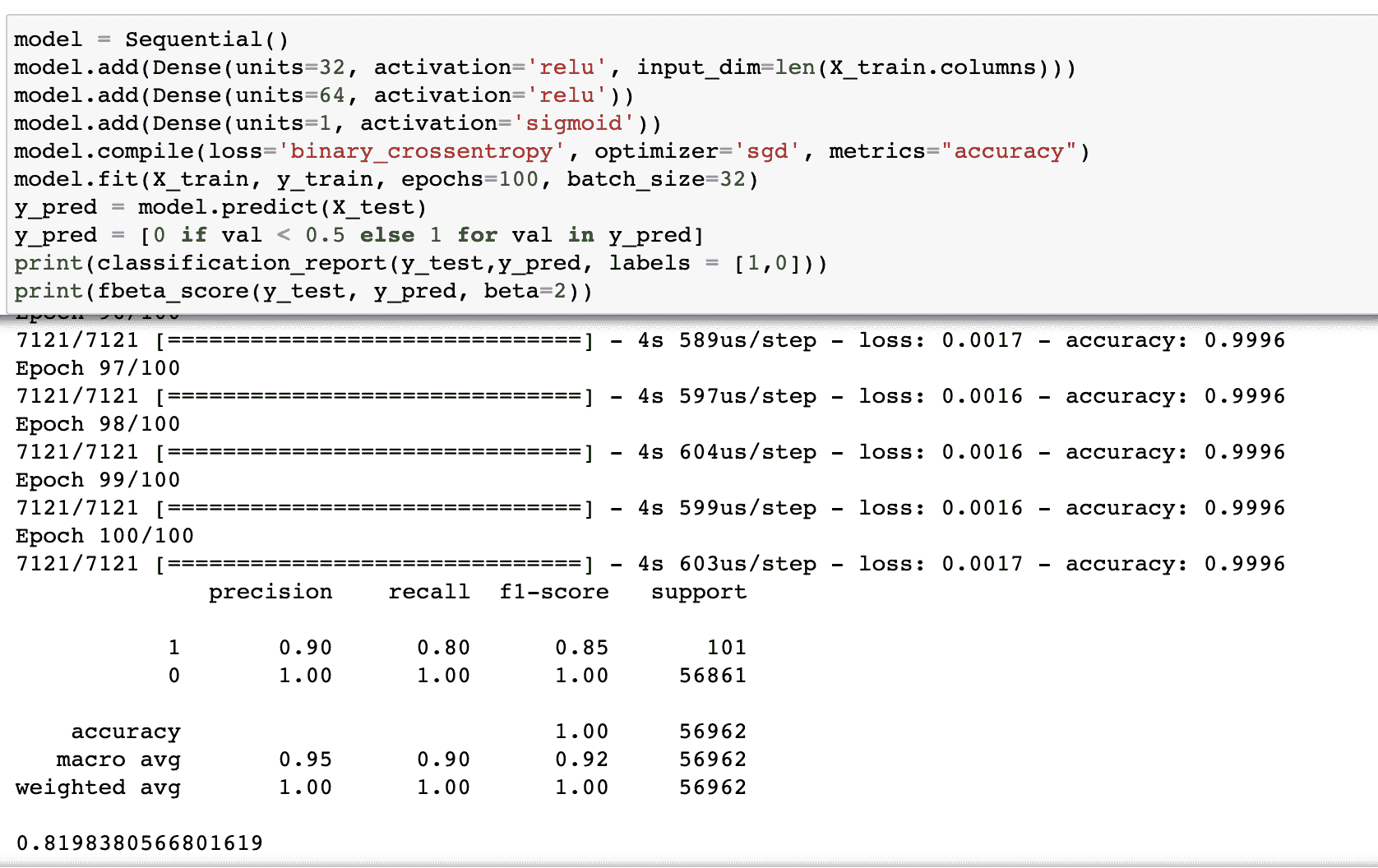

处理深度学习中的不平衡数据集

原文:

www.kdnuggets.com/2018/12/handling-imbalanced-datasets-deep-learning.html

评论

评论

像灭霸一样为你的数据集带来平衡

并不是所有数据都是完美的。实际上,如果你能获得一个完美平衡的现实世界数据集,你将非常幸运。大多数情况下,你的数据会有某种程度的类别不平衡,即每个类别的示例数量不同。

为什么我们希望数据平衡?

在投入时间进行任何可能漫长的深度学习项目之前,理解为什么我们应该这样做是很重要的,以确保这是一个有价值的投资。类别平衡技术只有在我们真正关心少数类时才是必要的。

比如,假设我们要预测是否应该根据市场的当前状况、房子的属性和我们的预算来购买一栋房子。在这种情况下,如果我们决定买房,那么这个决定是否正确是非常重要的,因为这是一个巨大的投资。同时,如果我们的模型说不买而实际上应该买,这也不是大问题。即使错过了某一栋房子,仍然会有其他房子可供选择,但对如此大的资产做出错误投资会很糟糕。

在这个例子中,我们绝对需要我们的少数“买”类别非常准确,而对于“不要买”类别则不是那么重要。然而在实际情况中,由于在数据中购买会比不购买少得多,我们的模型会倾向于非常好地学习“不要买”类别,因为它有最多的数据,并可能在“买”类别上表现不佳。这就需要平衡数据,以便我们可以更重视“买”预测的正确性!

那么如果我们不太关心少数类呢?例如,假设我们正在做图像分类,并且你的类别分布如下:

初看起来,平衡数据似乎有帮助。但也许我们对那些少数类不太感兴趣。也许我们的主要目标是获得最高可能的百分比准确度。在这种情况下,进行任何平衡并没有太大意义,因为我们的百分比准确度大部分来自于训练示例更多的类别。其次,即使数据集不平衡,分类交叉熵损失在追求最高百分比准确度时也往往表现良好。总的来说,我们的少数类对实现主要目标贡献不大,因此平衡并不是必要的。

说到这里,当我们遇到需要平衡数据的情况时,我们可以使用两种技术来帮助我们。

(1) 权重平衡

权重平衡通过调整每个训练样本在计算损失时所承载的权重来平衡我们的数据。通常,我们的损失函数中的每个样本和类别将承担相等的权重,即 1.0。但是有时我们可能希望某些类别或某些训练样本承载更多的权重,如果它们更为重要。再次以我们买房的例子为例,由于“买入”类别的准确性对我们最为重要,因此该类别中的训练样本应该对损失函数有显著影响。

我们可以通过根据类别的不同,将每个样本的损失乘以某个因子来给类别赋权。在 Keras 中,我们可以这样做:

我们创建了一个字典,其中基本上规定了我们的“买入”类别应在损失函数中占据 75%的权重,因为“买入”类别比“不要买”类别更为重要,而“不要买”类别的权重则相应设置为 25%。当然,这些值可以很容易地调整,以找到最适合您应用的设置。如果我们的某个类别的样本显著多于其他类别,我们也可以使用这种权重平衡的方法。与其花费时间和资源去收集更多的少数类样本,不如尝试使用权重平衡,使所有类别对我们的损失函数的贡献相等。

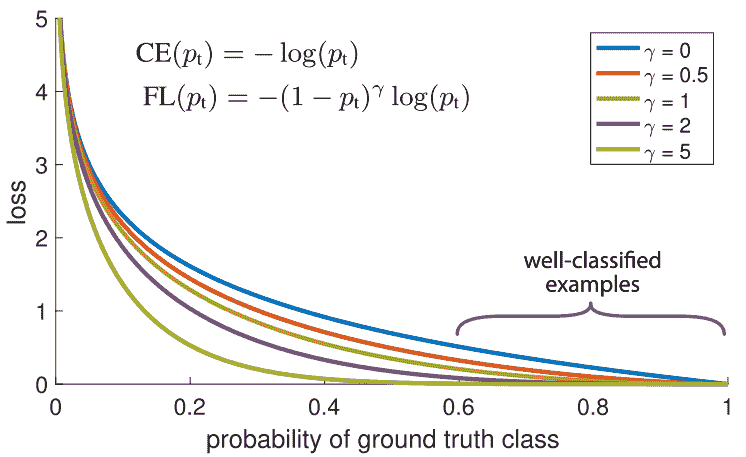

另一种平衡训练样本权重的方法是焦点损失。其主要思想是:在我们的数据集中,某些训练样本自然比其他样本更容易分类。在训练过程中,这些样本将以 99%的准确率被分类,而其他更具挑战性的样本可能仍表现较差。问题在于,那些容易分类的训练样本仍然在贡献损失。为什么我们还要对它们给予相同的权重,而在其他更具挑战性的数据点上,如果正确分类,能对我们的整体准确率贡献更多?!

这正是焦点损失可以解决的问题!焦点损失降低了对已分类样本的权重,而不是对所有训练样本给予相等的权重。这有助于将更多的训练重点放在那些难以分类的数据上!在数据不平衡的实际设置中,由于我们拥有更多的数据,我们的多数类很快就会被良好分类。因此,为了确保我们在少数类上也能实现高准确率,我们可以使用焦点损失在训练过程中给予这些少数类样本更多的相对权重。焦点损失可以很容易地在 Keras 中作为自定义损失函数实现:

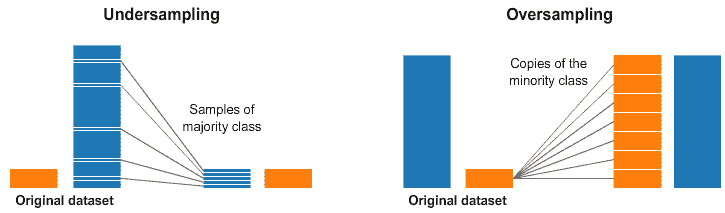

(2) 过采样与欠采样

选择合适的类别权重有时可能会很复杂。简单的逆频率方法可能效果不好。焦点损失可以提供帮助,但即便如此,它也会平等地减少每个类别的所有良好分类示例的权重。因此,平衡数据的另一种方式是通过直接采样。请查看下面的图示。

欠采样和过采样

在上图的左侧和右侧,我们的蓝色类别样本远多于橙色类别。在这种情况下,我们有两个预处理选项可以帮助训练我们的机器学习模型。

欠采样意味着我们只会从多数类中选择一部分数据,只使用与少数类相同数量的样本。这种选择应保持类别的概率分布。这样很简单!我们通过减少样本数量平衡了数据集!

过采样意味着我们会创建副本以使少数类的样本数量与多数类相同。这些副本的生成会保持少数类的分布。我们没有获取更多数据,但依然平衡了数据集!如果发现类别权重难以有效设置,采样可以是平衡类别的一个好替代方案。

想学习更多吗?

关注我的推特,我会发布最新最前沿的 AI、技术和科学内容!

简介: George Seif 是一名认证极客及 AI/机器学习工程师。

原文. 经许可转载。

相关内容:

-

数据科学家必知的 5 种聚类算法

-

三种提高不平衡数据集上机器学习模型性能的技术

-

使用 Python 提升数据预处理速度 2-6 倍

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业。

1. 谷歌网络安全证书 - 快速进入网络安全职业。

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

2. 谷歌数据分析专业证书 - 提升您的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 工作

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT 工作

更多相关内容

使用 SQL 处理时间序列中的缺失值

原文:

www.kdnuggets.com/2022/09/handling-missing-values-timeseries-sql.html

今天早上我阅读了Madison Schott的文章,她在其中强调了这个鲜为人知的 SQL 函数LAST_VALUE的实用性。

这激励我写了一篇关于处理时间序列数据时经常遇到的特定用例的后续文章。

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

示例

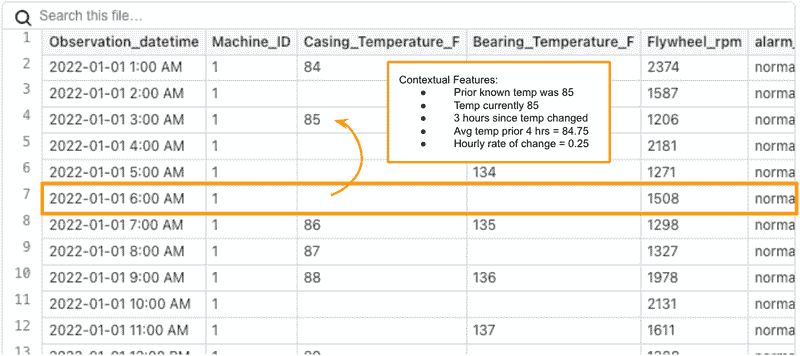

让我们假设你正在使用传感器数据构建一个预测性维护模型。

经过一些整理,你最终得到的每小时数据如下所示:

一些预处理的传感器数据示例

到目前为止,我们已经进行了一些相当重要的数据工程,以在每小时创建这些均匀间隔的观测数据。如何做到这一点是另一个文章的主题。然而,请注意,温度测量中存在一些间隙。这时LAST_VALUE就派上用场了。

缺失值的原因通常是传感器只在值发生变化时报告。这减少了机器需要传输的数据量,但这为我们创建了一个数据问题需要解决。

原因

如果我们直接使用这些数据构建模型,当特定值缺失时,模型的准确性会受到影响,因为没有历史上下文写入到行本身。为了获得尽可能准确的模型,我们应该添加如下一些特征:

-

最后一次温度读取

-

过去 6 小时的平均温度

-

自上次温度读取以来的小时数(温度上升/下降)

-

过去 12 小时的温度变化率

将对预测模型有用的特征类型的说明

我们的第一步应该是用最后一个已知的值替换缺失值。我们选择首先这样做的原因是其他特征会变得更容易创建。

例如,如果我们将其留作缺失并尝试计算滚动平均值,那么平均值将被错误计算(它会忽略缺失值,仅计算非缺失值的平均值)。

过去 4 小时的平均温度(有缺失值)

(null + 85 + null + null) / 1 = 85

过去 4 小时的平均温度(替换后)

(84 + 85 + 85 + 85) / 4 = 84.75

如何修复

在 Python 中,我们会从 前向填充 开始。然而,在 SQL 中这样做意味着我们可以利用我们数据仓库的强大功能。

在 SQL 中,我们使用 LAST_VALUE。有关更多深入解释,请参阅 这篇文章。

这里是语法:

SELECT

MACHINE_ID,

OBSERVATION_DATETIME,

LAST_VALUE(

CASING_TEMPERATURE_F ignore NULLS

) OVER (

PARTITION BY MACHINE_ID

ORDER BY

OBSERVATION_DATETIME ROWS BETWEEN UNBOUNDED PRECEDING

AND CURRENT ROW

) AS LATEST_CASING_TEMPERATURE_F,

LAST_VALUE(

BEARING_TEMPERATURE_F ignore NULLS

) OVER (

PARTITION BY MACHINE_ID

ORDER BY

OBSERVATION_DATETIME ROWS BETWEEN UNBOUNDED PRECEDING

AND CURRENT ROW

) AS LATEST_BEARING_TEMPERATURE_F,

LAST_VALUE(FLYWHEEL_RPM ignore NULLS) OVER (

PARTITION BY MACHINE_ID

ORDER BY

OBSERVATION_DATETIME ROWS BETWEEN UNBOUNDED PRECEDING

AND CURRENT ROW

) AS LATEST_FLYWHEEL_RPM,

--8<-- snip --8<--

FROM

hourly_machine_data

用 LAST_VALUE 替换缺失值后的结果

就这样!

结论

希望我能为 LAST_VALUE 及其表亲 FIRST_VALUE 提供一些启示,它们是较不为人知的 SQL 窗口函数。

Josh Berry (@Twitter) 领导了 Rasgo 的客户数据科学团队,并自 2008 年以来一直从事数据和分析行业。Josh 在 Comcast 工作了 10 年,期间他建立了数据科学团队,并且是内部开发的 Comcast 特征库的关键负责人——这是市场上第一个特征库之一。在 Comcast 之后,Josh 在 DataRobot 构建客户数据科学团队中发挥了关键作用。在业余时间,Josh 对棒球、F1 赛车、住房市场预测等有趣的主题进行复杂分析。

原文。已获许可转载。

更多相关主题

处理数据科学中的树结构算法面试

原文:

www.kdnuggets.com/2020/01/handling-trees-data-science-algorithmic-interview.html

评论

算法和数据结构是数据科学的重要组成部分。虽然我们大多数数据科学家在学习过程中没有修过专门的算法课程,但它们依然至关重要。

许多公司在招聘数据科学家时会将数据结构和算法作为面试的一部分。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯

1. 谷歌网络安全证书 - 快速开启网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

现在许多人会问,为什么要问数据科学家这些问题。我喜欢将其描述为数据结构问题可以被视为编码能力测试。

我们都在生活中的不同阶段做过能力测试,虽然这些测试并不是完美的判断标准,但几乎没有什么是完美的。所以,为什么不使用标准算法测试来评估一个人的编码能力呢?

但不要自欺欺人,它们的难度与数据科学面试的难度相当,因此,你可能需要花些时间来学习算法和数据结构问题。

这篇文章旨在加速学习过程,并为数据科学家解释树结构的概念,以便下次在面试中被问到时能够轻松应对。

但首先,为什么树对数据科学如此重要?

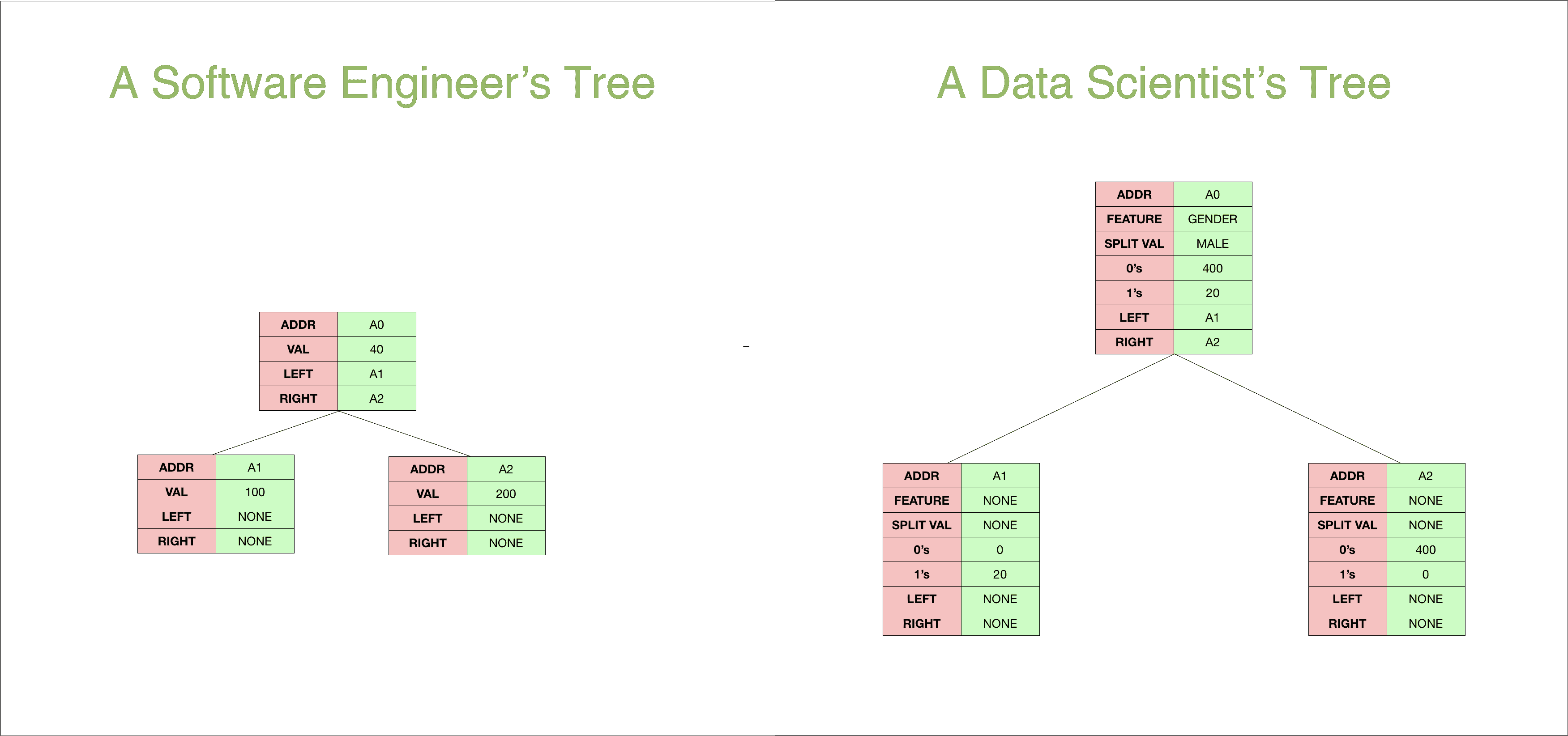

对数据科学家来说,树的意义与对软件工程师来说的不同。

对于软件工程师而言,树只是一个简单的数据结构,用于管理层次关系,而对于数据科学家来说,树是一些最有用的分类和回归算法的基础。

那么这两者在哪里相遇呢?

它们实际上是同一个东西。不要感到惊讶。以下是数据科学家和软件工程师如何看待树结构的。

它们本质上是相同的。

唯一的区别在于,数据科学树节点包含了更多信息,这有助于我们确定如何遍历树。例如,在预测的数据科学树中,我们会查看节点中的特征,并根据分裂值确定我们要沿着哪个方向移动。

如果你想从头开始编写决策树,你可能还需要了解树在软件工程中的工作原理。

树的类型:

在这篇文章中,我将只讨论两种在数据科学面试问题中经常出现的树。二叉树(BT)和二叉树的扩展,称为二叉搜索树(BST)。

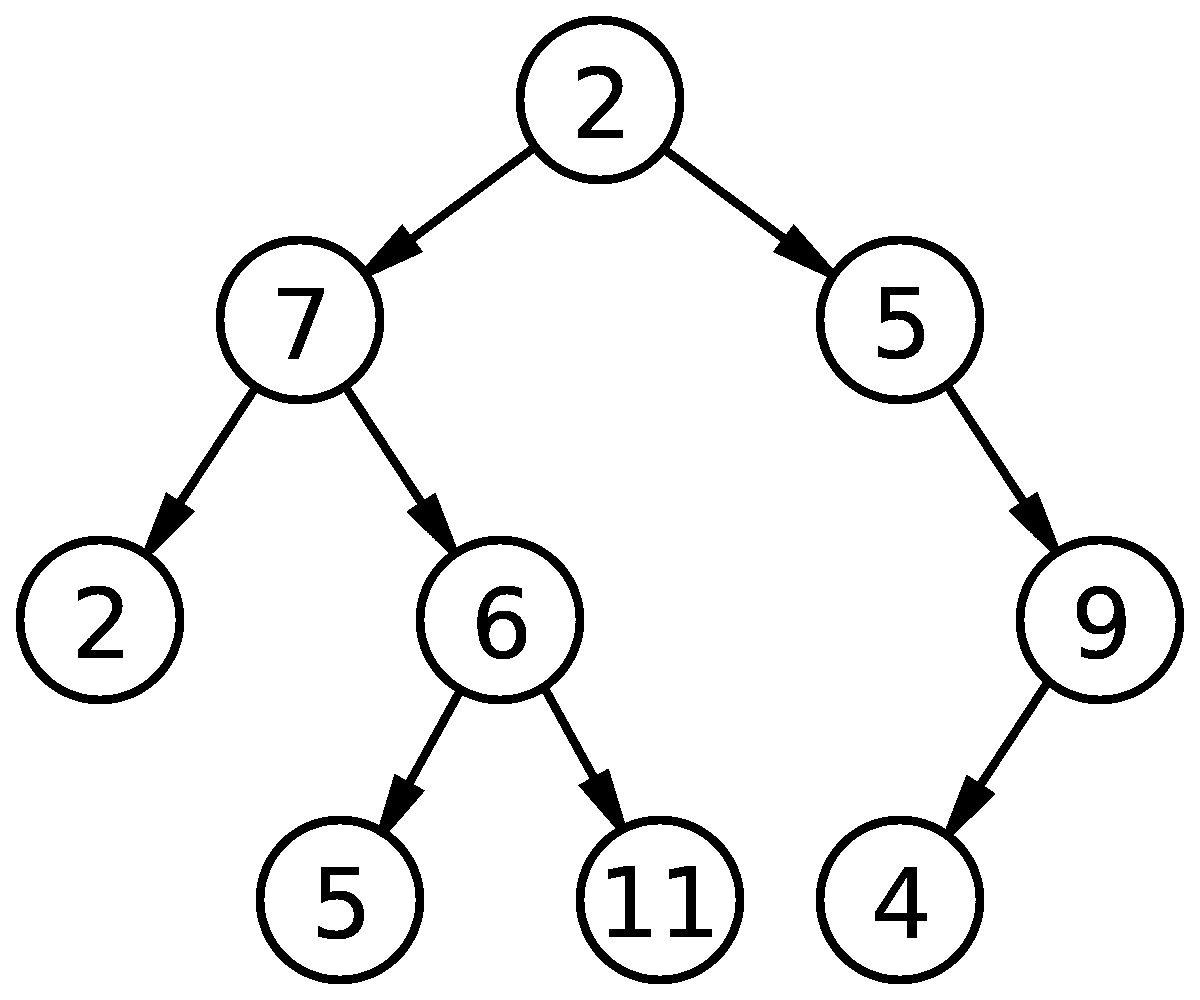

1. 二叉树:

二叉树仅仅是每个节点最多有两个子节点的树。决策树是我们日常生活中看到的一个例子。

二叉树:每个节点最多有 2 个子节点

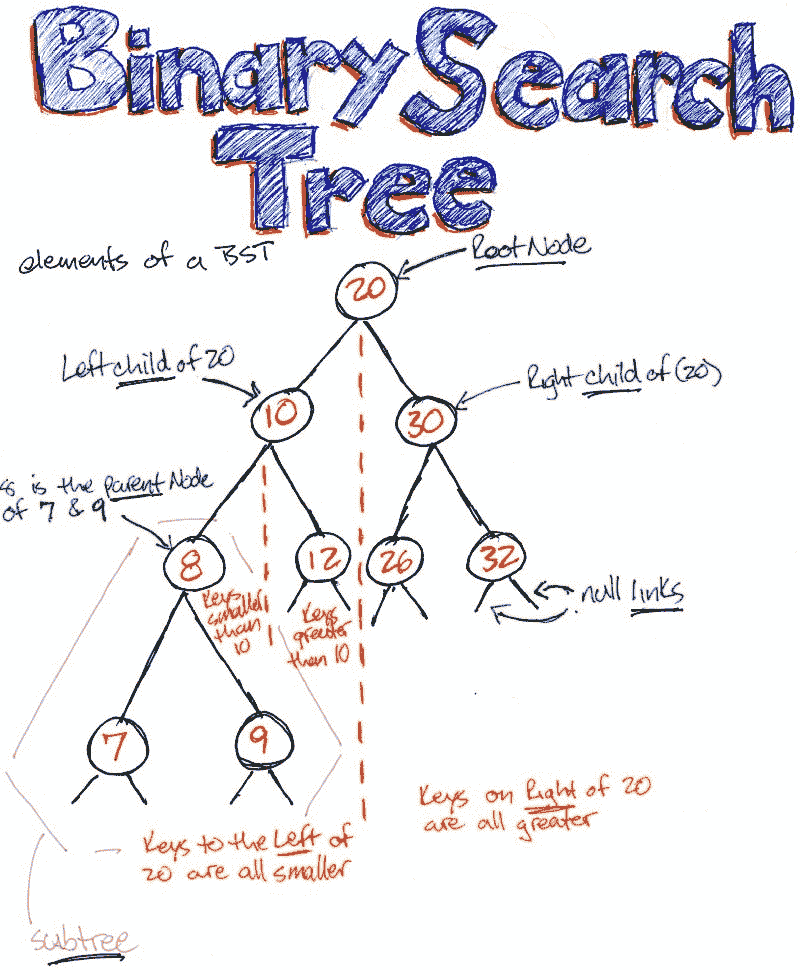

2. 二叉搜索树(BST):

二叉搜索树是二叉树的一种,其中:

-

节点的所有左侧后代都小于或等于该节点,且

-

节点的所有右侧后代都大于该节点。

关于等式,这一定义有一些变体。有时等式出现在右侧或任一侧。有时树中只允许不同的值。

8 大于左子树中的所有元素,并小于右子树中的所有元素。树中的任何节点也可以这样说。

创建一个简单的树:

那么我们如何构造一个简单的树呢?

根据定义,树由节点组成。因此我们从定义node类开始,该类用于创建节点。我们的节点类相当简单,它保存节点的值、左子节点的位置和右子节点的位置。

class node:

def __init__(self,val):

self.val = val

self.left = None

self.right = None

现在我们可以创建一个简单的树,如下:

root = node(1)

root.left = node(2)

root.right = node(3)

现在我注意到,我们没有通过一些实际编程就很难掌握基于树的问题。

那么让我们更深入地探讨一下编码部分,特别是我在处理树时发现的最有趣的一些问题。

中序树遍历:

遍历树有多种方法,但我发现中序遍历是最直观的。