KDNuggets-博客中文翻译-八-

KDNuggets 博客中文翻译(八)

原文:KDNuggets

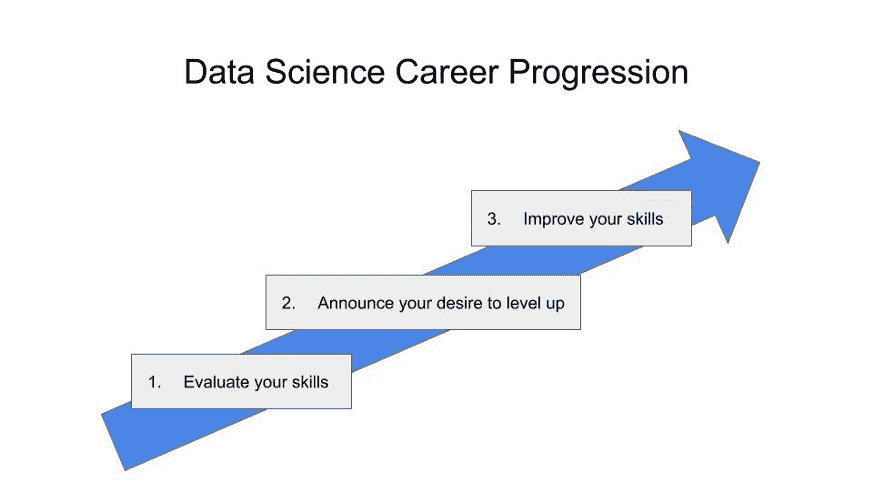

数据科学工作流程中的自动化

原文:

www.kdnuggets.com/2023/03/automation-data-science-workflows.html

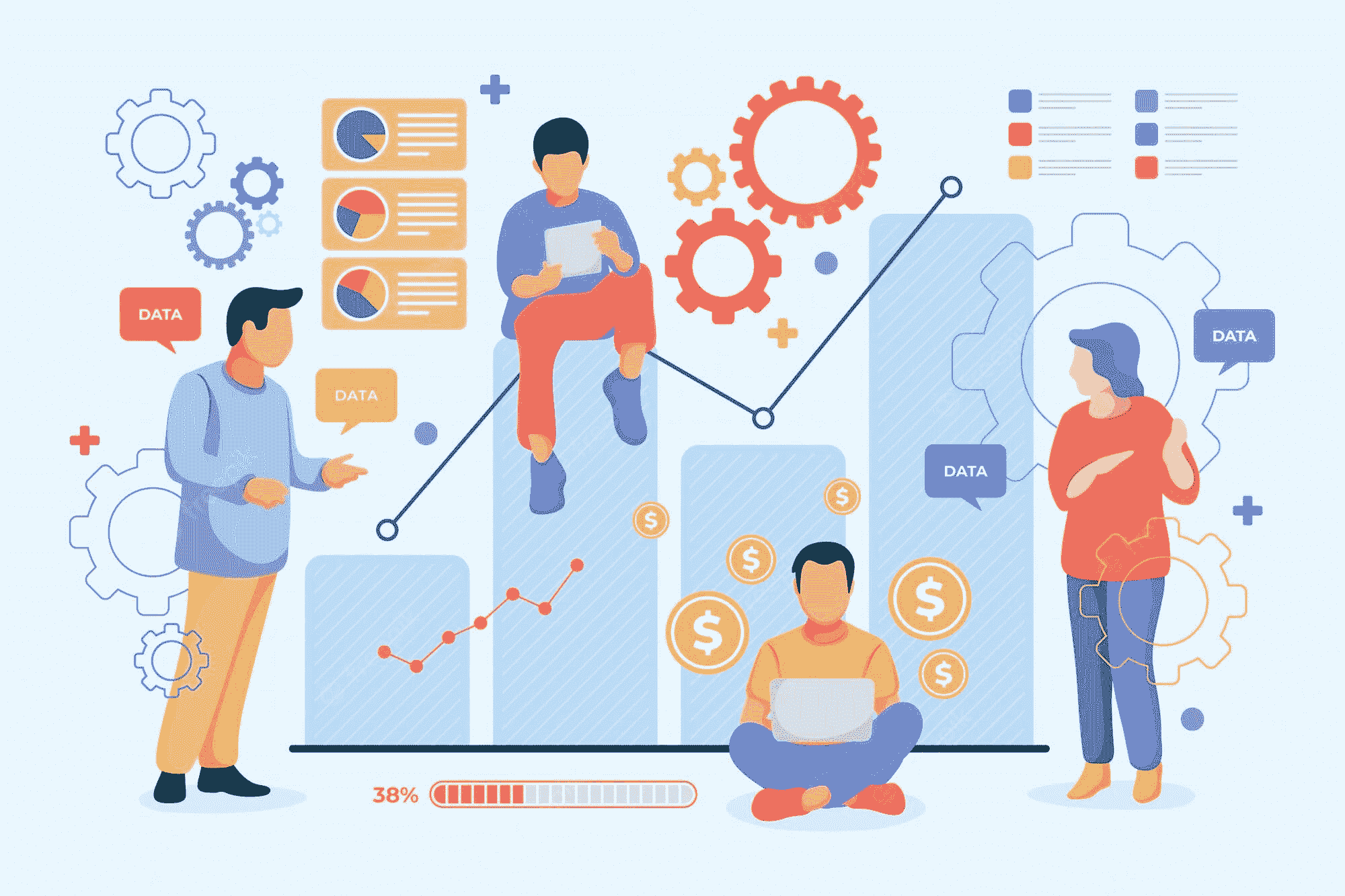

机器学习解决方案已经自动化了世界上大部分的操作方式,并且现在也在处理自身的低效问题。所以,数据科学领域也不例外,正在经历核心机器学习工程过程的自动化,以实现更顺畅、更快速的开发。

图片由 RODNAE Productions 提供

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析水平

2. Google 数据分析专业证书 - 提升你的数据分析水平

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

想象一下以前那些步骤繁琐的过程——从数据集成到模型训练、选择和部署——都是手动完成的。每个步骤都非常严格,需要数据科学家付出大量的努力。无可否认,自动化在帮助数据科学家完成端到端建模和部署过程中变得极为重要。

自动化机器学习(AutoML)显著提高了开发者的生产力,使他们能够专注于需要时间和注意力的关键建模领域。

在评估 AutoML 的优缺点之前,让我们首先了解数据科学世界在机器学习过程自动化之前的运作方式,以更好地理解其价值主张。

自动化胜过人工努力——对组织和数据科学社区的双赢

AutoML 常被视为复制数据科学家的工作,但实际上它是一种加速构建更好模型的工具。数据科学家仍然有许多工作需要手动完成,这给机器学习实施带来了挑战。 dotData 的首席执行官藤卷良平如下解释。

对于组织来说,至关重要的是不要将自动化视为对数据科学家的“替代”,而应将其视为一种工具。我们发现许多企业现在将特征工程过程从数据科学组织中分离出来,交给专注于特征发现的专门团队。无论设置如何,提供使数据科学家工作更轻松的自动化工具和平台应成为重点。

– Ryohei Fujimaki,dotData的首席执行官

机器学习流程中最重要但非常关键且耗时的步骤之一是数据分析和验证数据的良好质量。在这一环节的任何失败或细节偏差都可能代价高昂,因此需要一位熟练的数据分析师来奠定基础。

除了数据分析,数据清洗和特征工程还大大加速了模型学习现象的速度。但问题在于这些技能需要时间来培养。因此,与其等待建立合适的团队和技能来筛选海量数据集中的模式并生成有价值的见解,不如通过自动化机器学习工作流来消除建立模型的障碍。

简而言之,它帮助企业快速扩展其机器学习计划,使非技术专家也能利用这些复杂算法的力量。不仅自动化有助于提高模型准确性,还带来了行业最佳实践,因此没有人需要在已经解决的重复问题上重新发明轮子。

让数据科学家免于花费在可以轻松自动化的无尽琐碎任务上的时间,从而赋予他们用脑力将创新变为现实的能力。

根据微软对 AutoML 的观点,它是通过自动化耗时的迭代任务来构建大规模、高效且富有生产力的机器学习模型的过程,同时保持模型质量。

这需要思维方式的转变,以通过自动化手动任务(如特征工程、特征发现、模型选择等)来改进流程和构建系统。

数据科学过程仍然是一个主要依赖人工的工作。若应用得当,自动化可以大大帮助数据科学家,而不必担心“失业”。当 AutoML 首次流行时,数据科学社区的讨论主要集中在自动化整个数据科学流程生命周期的利弊上。在 dotData,我们发现这种“全有或全无”的方法低估了数据科学流程的复杂性——尤其是在大型组织中。因此,我们认为公司应该更关注提供自动化,以简化数据科学家的工作并提高工作效率。一个这样的领域是特征工程。数据科学家花费大量时间与数据工程师和主题专家合作,发现、开发和优化他们模型的最佳特征。通过自动化大量特征发现过程,数据科学家可以专注于他们真正擅长的任务:构建最佳的机器学习模型。

– Ryohei Fujimaki,dotData的首席执行官

除了提升生产力和效率外,它还减轻了人为错误和偏见的风险,从而增加了模型的可靠性。但正如专家所说,过犹不及。因此,自动化在一定程度的人类监督下最佳,可以结合实时信息和领域专业知识。

自动化的重点领域

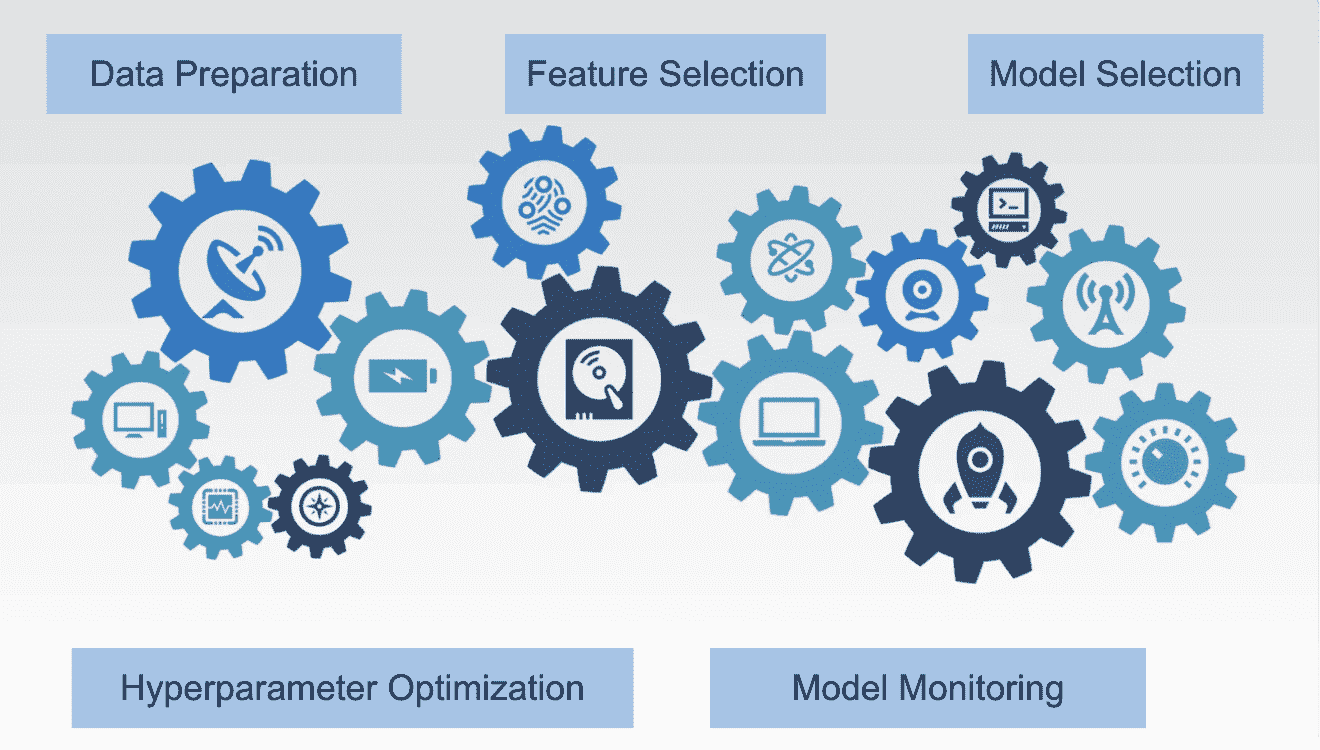

现在我们了解了自动化的好处,让我们重点关注最值得投入时间和精力的具体步骤和流程。以下列出的领域的自动化有可能显著提高效率和准确性:

-

数据准备:来自不同来源的数据使得数据科学家将其准备成适合输入模型训练阶段的格式变得具有挑战性。这涉及诸多步骤,如数据收集、清理和预处理等。

-

特征选择和特征工程:向模型选择和呈现正确的特征是学习正确现象的基础。自动化不仅有助于找到正确的特征,还用于工程化新特征,以加速学习过程。

-

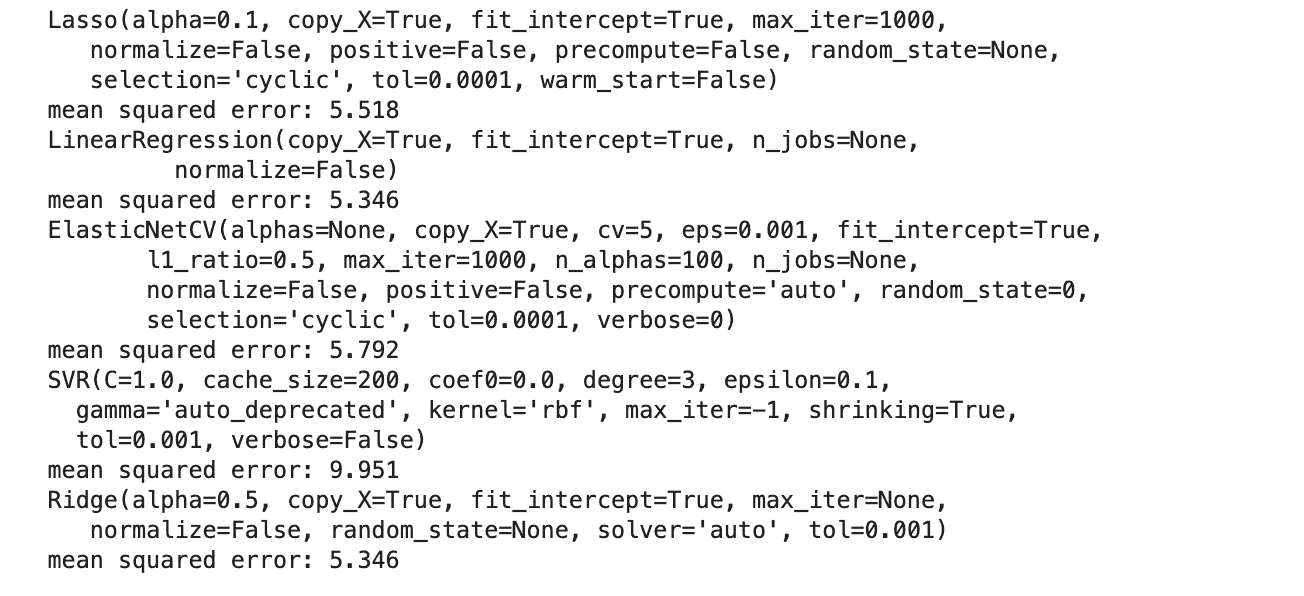

模型选择:这是在候选模型集合中找到最佳表现模型的过程,它决定了模型开发流程的准确性和稳健性。AutoML 在迭代和识别适合特定任务的模型方面非常有用。

-

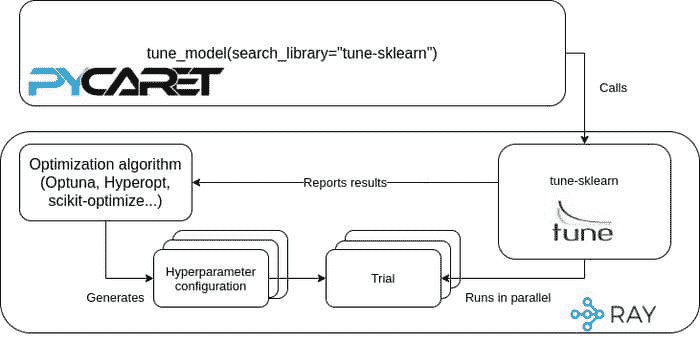

超参数优化:选择正确的模型是不够的,你还需要为给定的机器学习算法找到合适的超参数,如学习率、层数和迭代次数。这些模型设置需要机器学习工程师调整这些参数,以最优地解决机器学习问题。自动化的超参数优化是一个不可或缺的工具,通过评估各种组合来找到最适合你模型的架构。

-

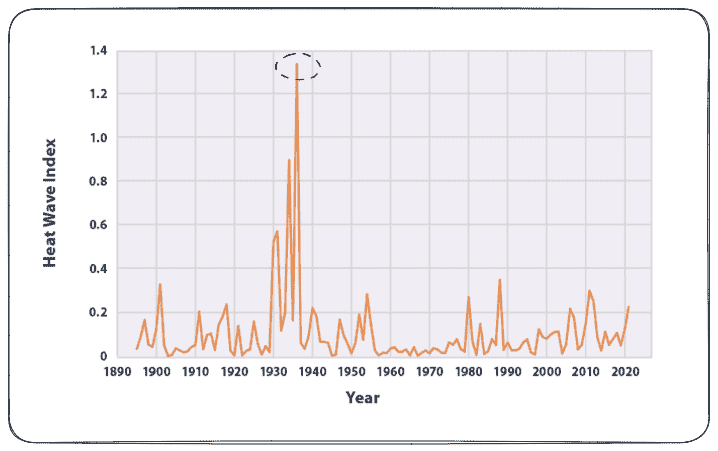

模型监控:没有哪个机器学习模型能够持续提供准确的预测而无需定期重新训练。自动化工具监控并触发模型流程,以便在部署的模型偏离预期性能时采取纠正措施。

图片来自 Canva

结束语

一般来说,自动化被视为“技术抢走工作”,然而,它实质上有助于简化重复和单调的任务。数据科学中的自动化是数据科学家的一大助力,通过减少人工操作,从而实现改进和高效的建模过程。必须用公平的人类专业知识和监督来补充 AutoML,以充分发挥自动化处理数据科学工作流中挑战性部分的好处。

Vidhi Chugh 是一位人工智能战略家和数字化转型领导者,致力于在产品、科学与工程的交汇处构建可扩展的机器学习系统。她是一位获奖的创新领袖、作者和国际演讲者。她的使命是让机器学习民主化,打破术语,使每个人都能参与到这场转型中。

更多相关主题

自动化工具将如何改变数据科学?

评论

评论

作者:藤巻良平博士,dotData 的首席执行官和创始人

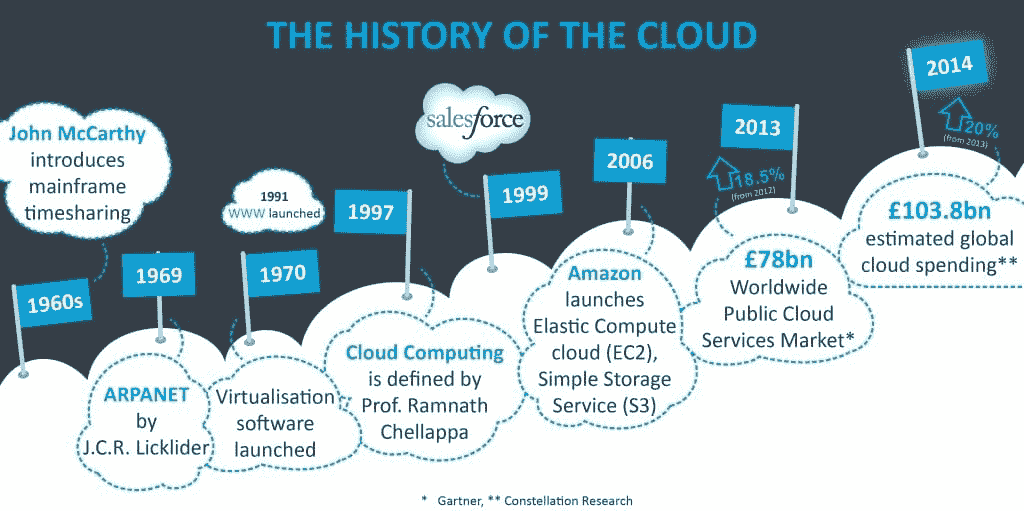

数据科学现在是技术投资的一个主要领域,鉴于其对客户体验、收入、运营、供应链、风险管理以及许多其他业务功能的影响。数据科学使组织能够实现数据驱动的决策过程,加速数字化转型和人工智能计划。根据 Gartner, Inc,只有 4%的首席信息官已经实施了人工智能,只有 46%的人有计划这么做。虽然投资持续增长,但许多企业发现实施和加速数据科学实践越来越具有挑战性。本文概述了机器学习和数据科学自动化工具的最新趋势,并讨论了这些工具将如何改变数据科学。

传统的数据科学过程

我们的前三个课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

3. 谷歌 IT 支持专业证书 - 支持你在 IT 领域的组织

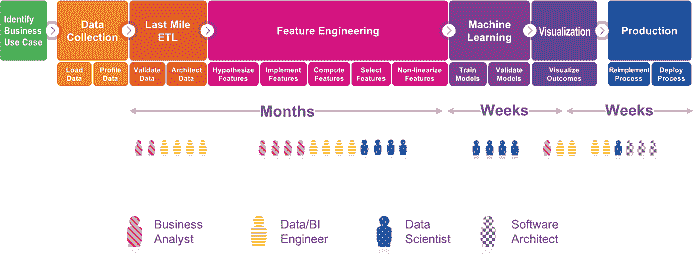

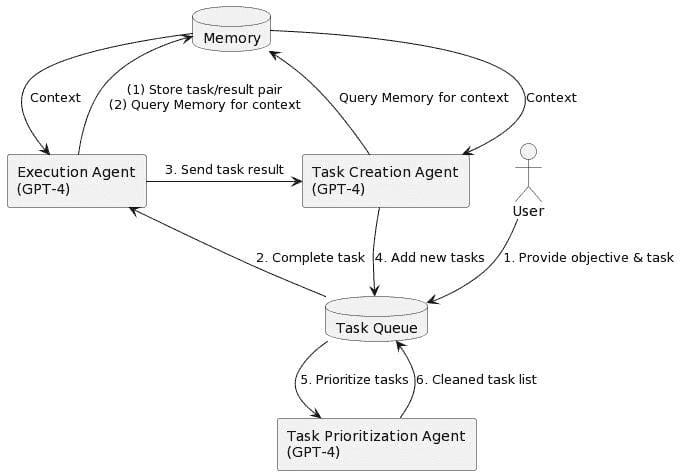

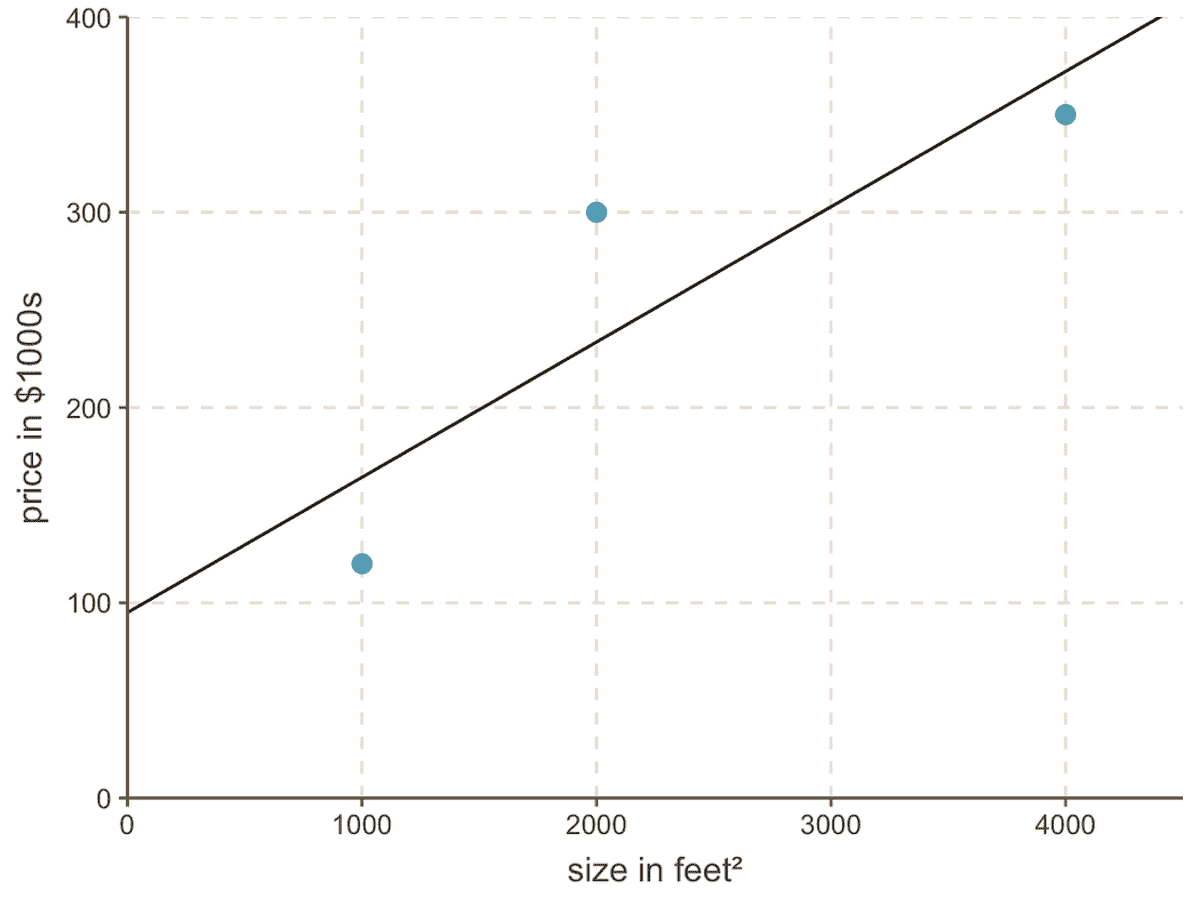

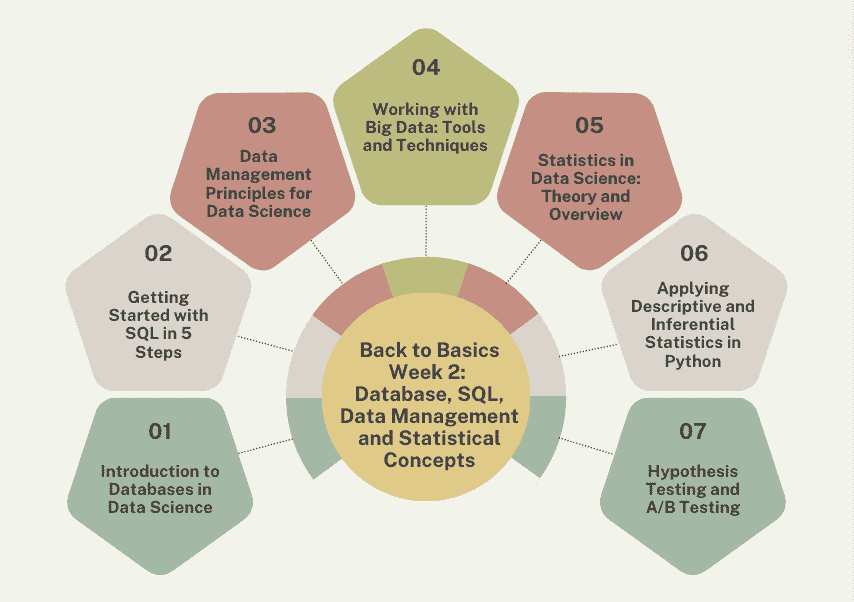

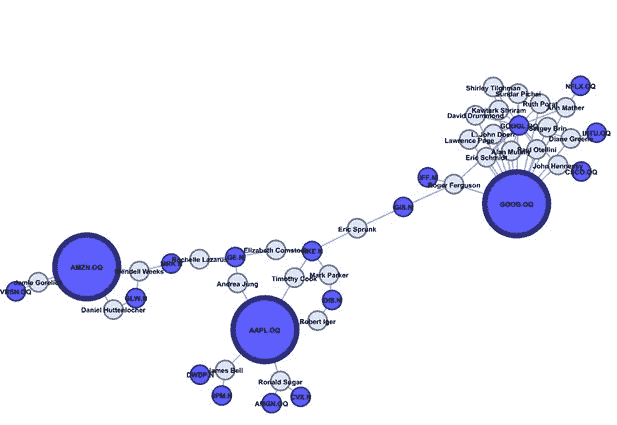

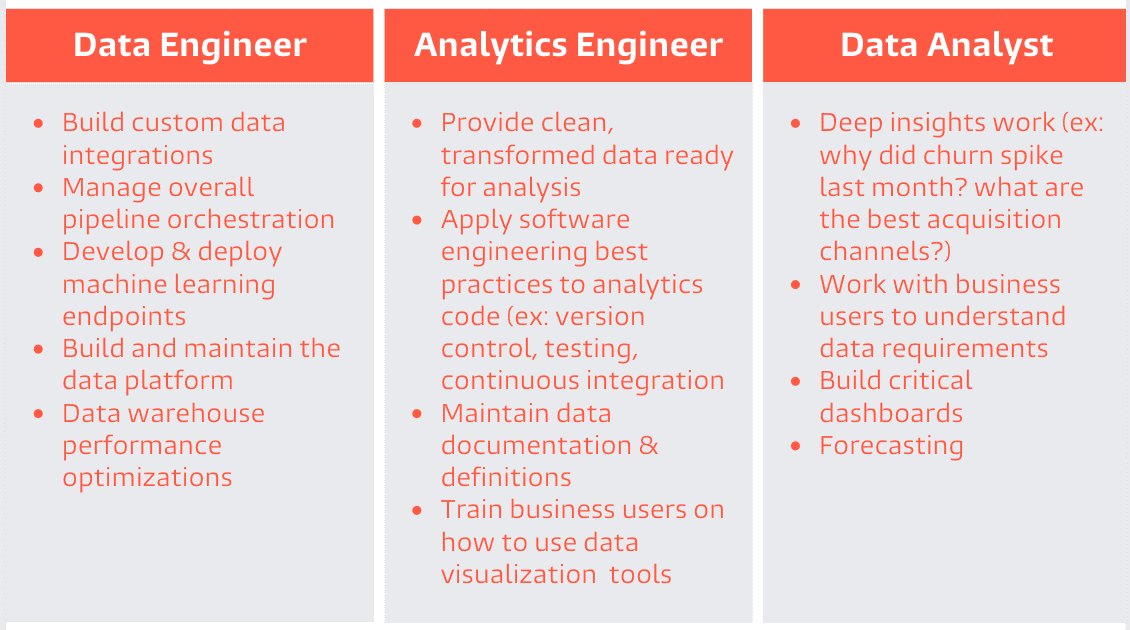

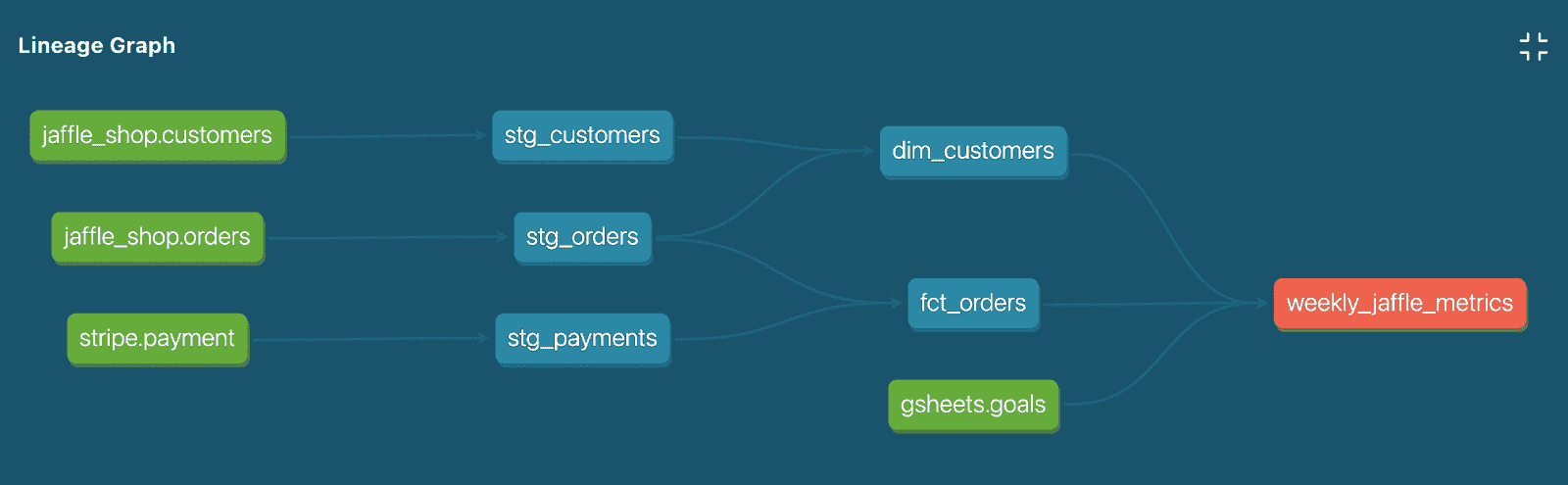

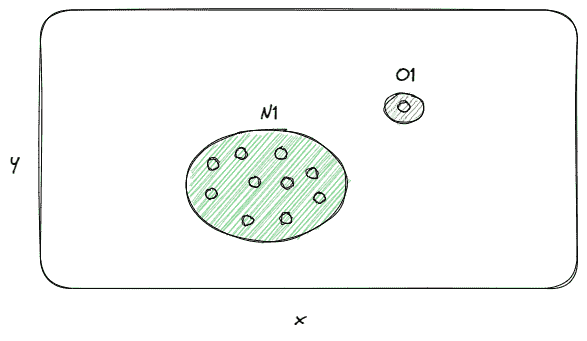

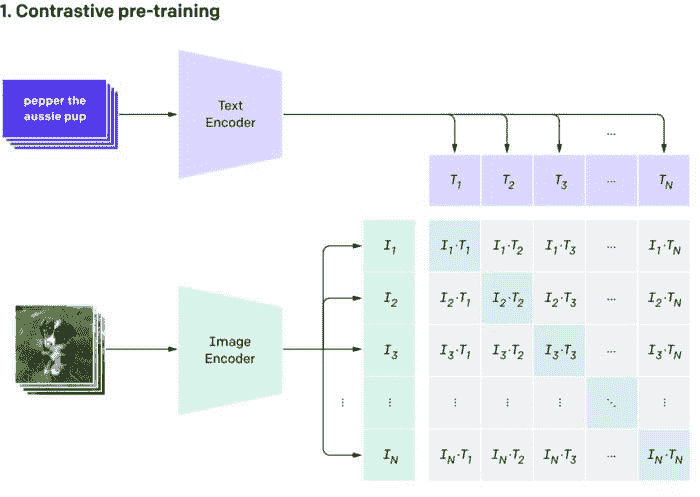

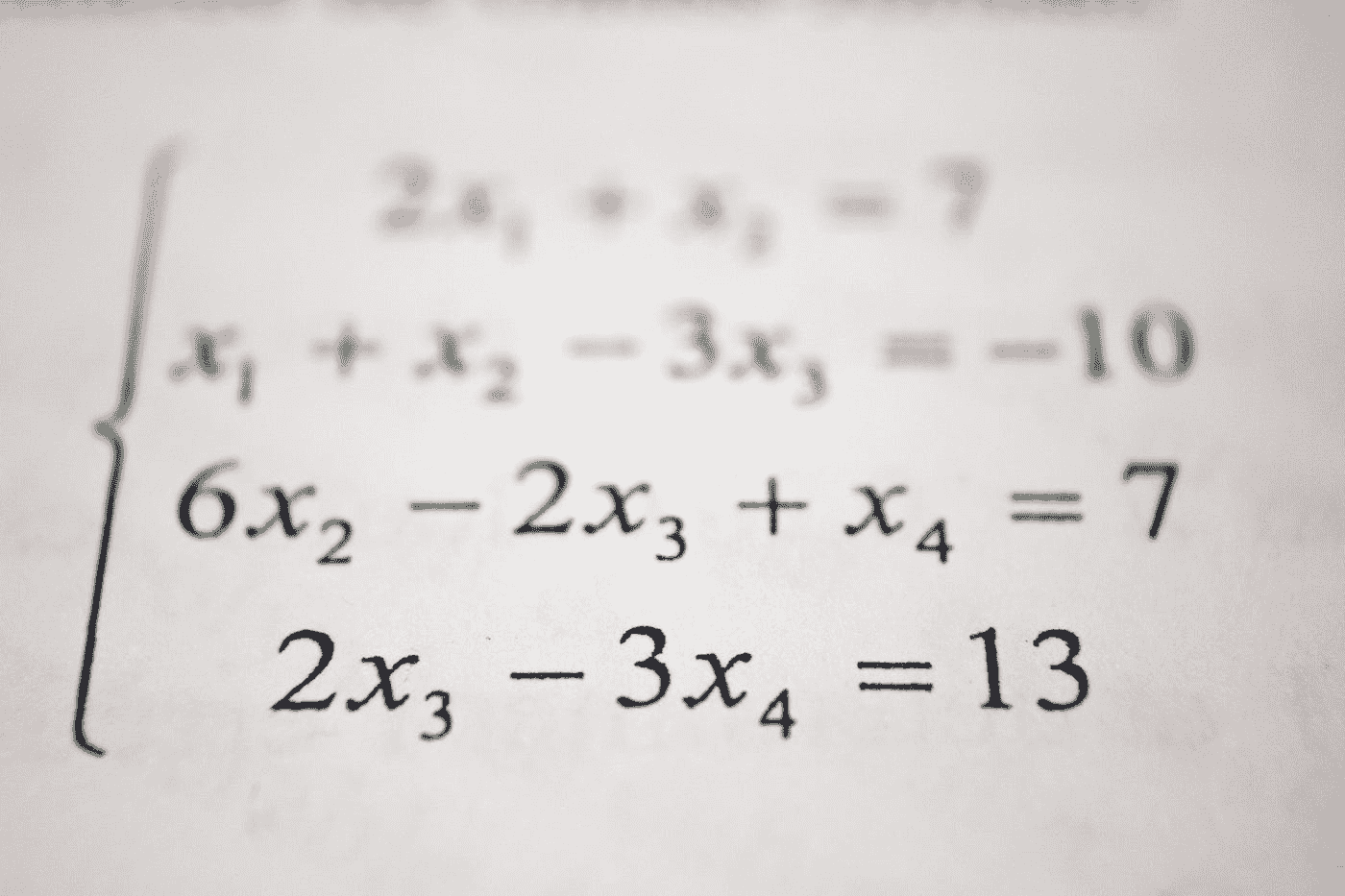

那么,是什么阻碍了企业中数据科学的采用和加速呢?一个典型的企业数据科学项目非常复杂,涉及多个步骤,包括数据收集、最后一公里的 ETL*(数据整理)、特征工程、机器学习、可视化和生产(见下图)。即使对于经验丰富的团队,传统的数据科学项目也需要几个月才能完成。这是一个高度参与和协作的过程,需要各种专业技能,如领域专家、数据工程师、数据科学家、商业智能工程师和软件架构师。此外,大多数企业数据科学项目的结果难以解释,这使得业务用户很难实施这些结果。

传统的数据科学过程

数据科学为什么这么难?

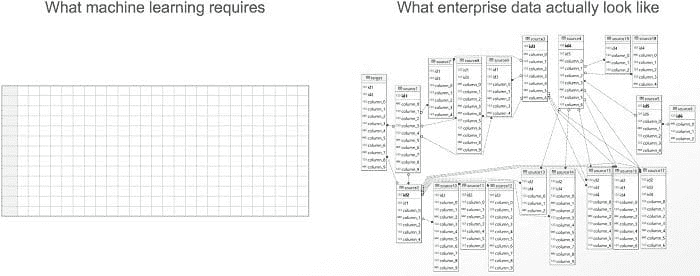

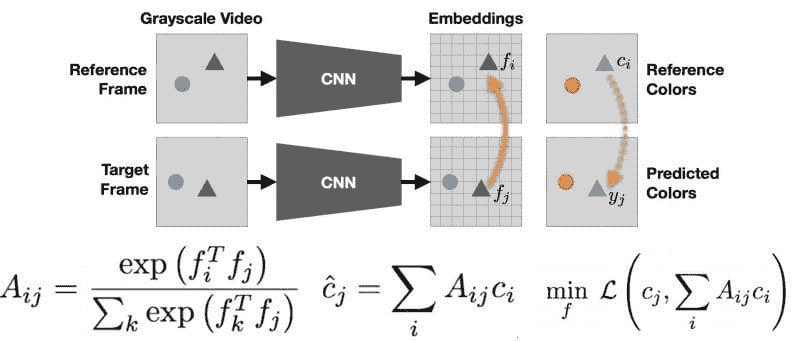

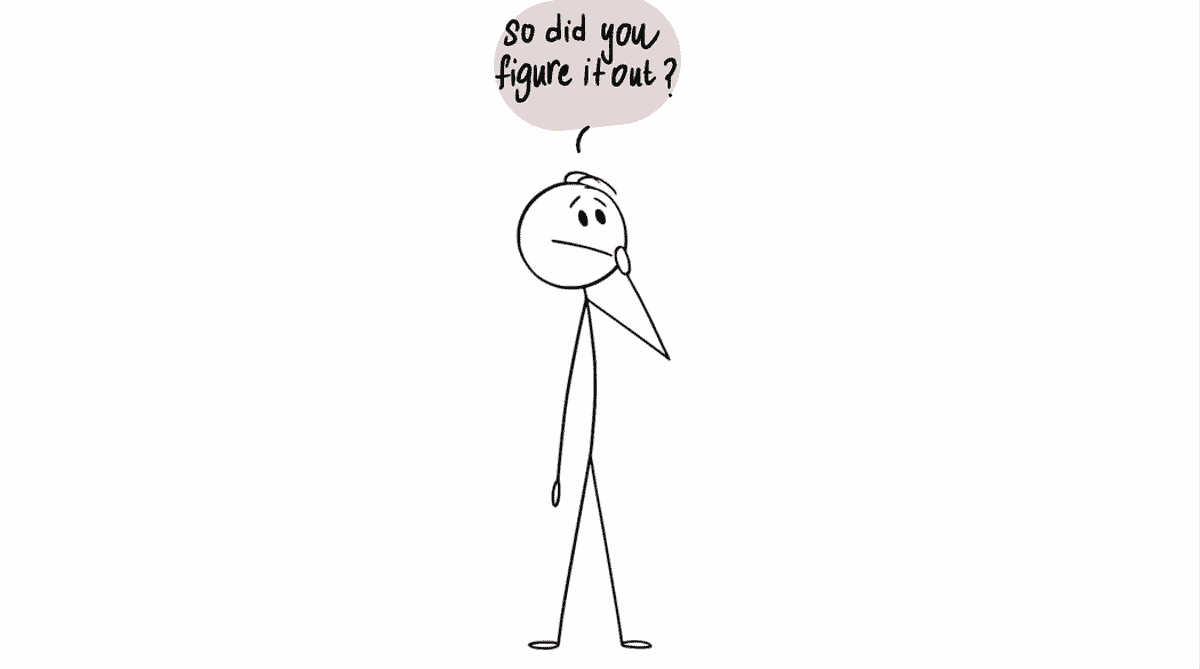

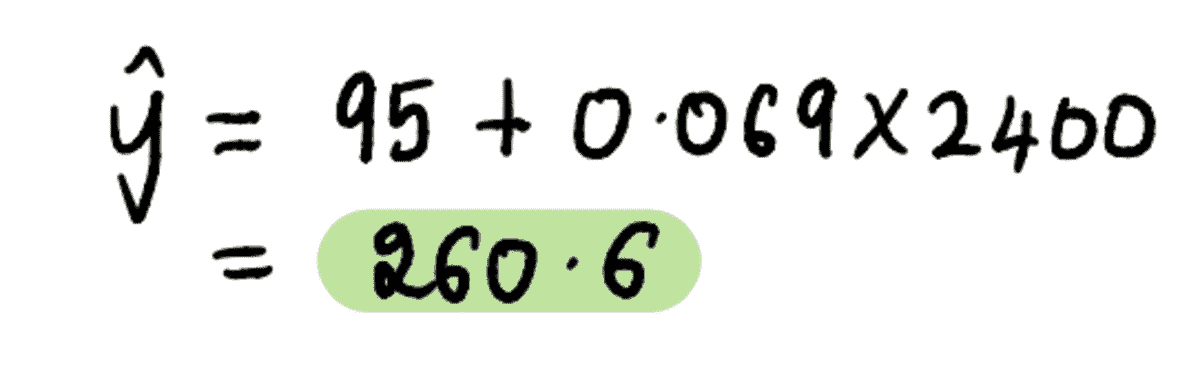

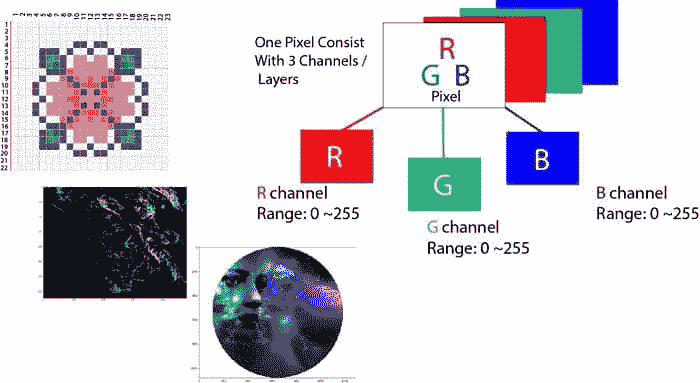

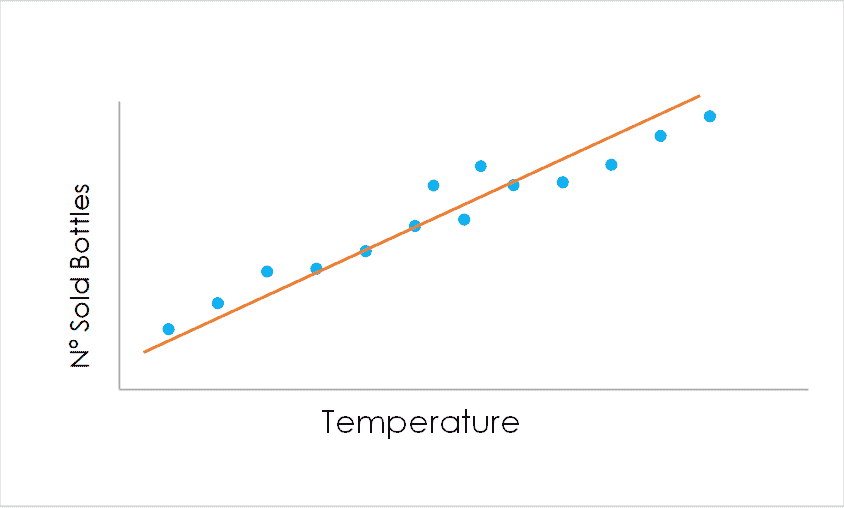

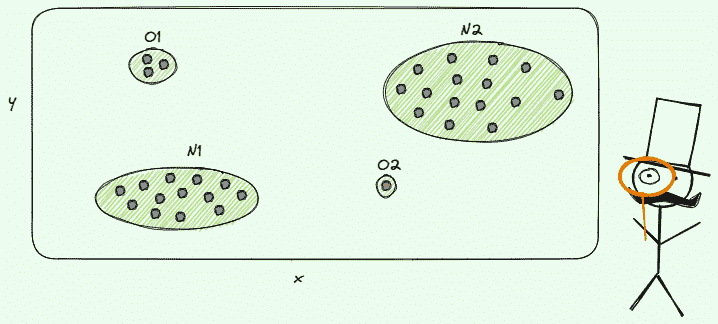

玩转机器学习(ML)模型被认为是有趣的部分,但任何数据科学项目的真正痛点通常是最后一公里的 ETL 和特征工程。如下面所示,机器学习需要一个称为特征表的单一扁平表。给定一个特征表,数据科学家可以使用 ML 算法进行操作。但实际的企业数据从来不是一个单一的扁平表,而是一组具有复杂关系的数据表。

机器学习所需的数据(左)与实际企业源数据(右)

最后一公里的 ETL 和特征工程是将多个表转换为特征表的必要步骤。这些是数据科学项目中最具挑战性和耗时的步骤,需由高技能的数据科学家和领域专家完成——这些资源既昂贵又稀缺。

“……特征工程通常是机器学习项目中大部分努力投入的地方……在这里,直觉、创造力和‘黑艺’与技术内容一样重要……” - Pedro Domingos 博士

数据科学与机器学习自动化工具

自动化机器学习的尝试始于 2010 年代初(例如 2013 年的AutoWEKA),并且变得非常流行。DataRobot和H2O.ai是机器学习自动化领域的领先初创公司。

机器学习自动化的基本理念是使用不同的算法(包括缺失值填充等预处理)和不同的超参数训练评分模型,并验证其准确性以选择最佳模型。最近,像微软这样的公司也开始支持机器学习自动化工具(更多细节可以在这里或这里找到)。这些优秀的工具显著简化了机器学习模型的构建。另一方面,最后一公里的 ETL 和特征工程仍然是一个手动过程,需要领域专家和数据科学家的大量参与。

尽管已有努力自动化特征工程,但大多数关注于给定特征表的非线性转换,这只是特征工程过程中的一个小组成部分,并且依赖于手动创建特征表。dotData发布了一个平台,它不仅自动化了从源数据中生成特征工程,还自动化了机器学习。dotData 称之为“数据科学自动化”。其人工智能驱动的特征工程自动设计和生成重要且可解释的特征,无需领域知识。该平台涵盖了与数据科学过程相关的广泛任务,使构建和实施数据科学项目变得更容易、更快捷。

自动化工具将如何改变数据科学?

数据科学家或领域专家会被自动化工具取代吗?显然不会。没有任何工具可以真正取代熟练的专家。相反,它使他们更高效。自动化将从三个主要方面影响数据科学:

-

敏捷性: 传统的数据科学过程通常遵循“瀑布”方法,这涉及大量前期工作,如数据清洗、ETL 和特征工程,因为每个单独步骤都需要大量的人工和耗时的工作。自动化工具使得尝试想法变得更容易、更快捷,从而使数据科学家能够探索高影响力的用例。

-

民主化: 大型企业中有数百种潜在的分析用例(甚至可能更多)。自动化工具使具有不同技能的人能够执行数据科学任务,并使难以招聘的成熟数据科学团队能够专注于高价值创造的用例。

-

操作化: 如本博客开头所述,大多数企业尚未实施人工智能和数据科学。许多企业级自动化工具,如 dotData,可以自动生成 API 或可执行包,立即在生产中操作。这显著缩短了在企业中实施数据科学的时间和障碍(上图的最后一步)。

随着企业转向数据驱动文化,数据科学变得越来越重要。自动化工具有助于加速数据科学和商业创新。

注释:

- 企业中有两种类型的 ETL(包括数据清洗)。一种是“主数据 ETL”,用于准备组织中通用的数据。有许多出色的工具来支持这个过程,如 informatica。另一方面,即使主数据准备得很好,我们仍然需要针对每个分析用例的定制 ETL 工作,这被称为“最后一公里 ETL”。

ACM 通讯,第 55 卷第 10 期,2012 年 10 月

简介: 藤卷良平博士 是 dotData 的创始人兼首席执行官。在创立 dotData 之前,他曾是 NEC 公司 119 年历史上最年轻的研究员,这一荣誉仅授予了 1000 多名研究人员中的六位。在 NEC 任职期间,良平积极参与开发许多前沿的数据科学解决方案,并在多个高-profile 分析解决方案的成功交付中发挥了重要作用,这些解决方案现在在行业中被广泛使用。

资源:

相关:

更多相关话题

自动化如何改善数据科学家的角色

原文:

www.kdnuggets.com/2020/10/automation-improving-data-scientists.html

评论

来源: 数据科学中的自动化

我们的前三个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持你的组织 IT

3. Google IT 支持专业证书 - 支持你的组织 IT

很多人担心自动化是否会最终取代数据科学家的工作。更可能的结果——而且这种情况已经在发生——是数据自动化将增强科学家们花费时间的方式,并改善他们的成果。以下是五种方式它可以提供帮助。

1. 加速项目完成时间

从数据中获取洞察是决策者最常关注的方面。然而,虽然不那么令人兴奋但却至关重要的任务,比如整理、清理和格式化信息,可能会占据比人们最初意识到的更多项目时间。投资于自动化可以让数据科学团队更高效、更灵活。

举例来说,一家利用数据科学的银行领导发现获取关键洞察所需的时间超过了预期。他们通过自动化补充了工作。在做出这个改变之前,公司每三个月完成一到两个项目。引入自动化让他们在相同的时间框架内完成了十倍的项目。

2. 为有价值的任务提供更多时间

即使数据自动化越来越受欢迎,它也不会取代公司雇佣科学家的需求。相反,自动化工具将提供更多时间用于那些对公司最有价值的职责。

例如,与其将大量工作时间用于将信息整理成正确的格式,数据专业人员可以利用他们的判断分析结果,或专注于创建帮助企业追踪趋势的算法。

最聪明的技术工具不能替代人类的智慧和经验。它们也可能无法检测到可能导致不可靠结果的错误。数据科学自动化在不需要人类知识的重复任务中表现优异。这种方法使人们能够以个人有益的方式运用他们的技能,同时也造福于雇主。

3. 允许数据科学家在任何地方工作

回顾与数据自动化相关的近期历史,可以看到它如何改善了几乎所有使用它的行业。

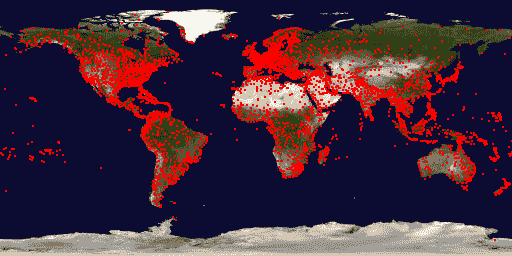

在一个例子中,制药专家探索了一个自动发送全球通知的系统,关于基于某一国家法规的药物安全事件。云计算的兴起也推动了自动化系统在数据处理中的采用。

根据 2016-2022 年全球自动化即服务市场的市场研究报告,该行业将增长到 62.3 亿美元,到期末实现 28.1%的年均增长率。分析师指出,云计算是增长的重要推动因素。例如,如果数据科学家使用自动化即服务工具来减少手动任务,他们可能会通过云完成工作,并在任何地方进行工作。

4. 帮助更多的数据科学项目成功

广泛引用的研究表明大多数数据科学项目失败。这发生的原因多种多样,包括数据孤岛和技能短缺。

然而,自动化可以为专业人士提供他们所需的资源,使即将到来或当前的项目每一个都获得成功的机会。例如,它可以帮助人们更快地测试假设,从而更有效地排除错误的假设。

数据科学自动化还使与信息打交道的专家能够追求持续改进。正如之前提到的,自动化技术有助于加快项目完成速度。

然而,它也可能带来整体更好的结果。当工具处理最重复的任务时,数据科学家可以利用他们的脑力和经验在项目可能失败时采取纠正措施。

5. 促进更准确的结果

在数据领域,一个经常被提到的警告是算法的聪明程度仅仅取决于构建它的人类。

一些人倾向于让自动化工具尽可能多地完成任务,但这种方法往往会导致错误。因此,一些专家提倡所谓的增强智能。它结合了人工智能(AI)与人类知识。

一家公司利用 AI 对成千上万 的客户评论进行分类,用于年度调查。算法的平均准确率为 90%,但在一些类别中降至 60%。公司通过引入人工专业知识来处理置信度较低的分组,从而弥补了这一差距。这种方法提高了准确性,并产生了可信的结果。

数据科学自动化展现潜力

人类的专业知识无疑将数据科学的努力提升到了极致。然而,公司不应忽视数据科学自动化产品如何帮助熟练人员以最有效、最有用的方式处理信息。

个人简介:德文·帕蒂达 是一位大数据和技术作家,同时也是 ReHack.com 的总编辑。

相关内容:

-

AutoML 何时会取代数据科学家?调查结果与分析

-

预测分析在劳动行业中的潜力

-

数据科学家开发出更快速的污染减少和温室气体排放削减方法

相关话题

自动化机器学习项目实施复杂性

原文:

www.kdnuggets.com/2019/11/automl-implementation-complexities.html

评论

图片由 Soroush Zargar 提供,来源于 Unsplash

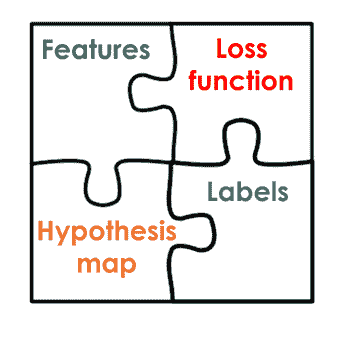

自动化机器学习(AutoML)涵盖了一个相当广泛的任务范围,这些任务可以合理地被认为是机器学习流程的一部分。

一个 AutoML “解决方案”可能包括数据预处理、特征工程、算法选择、算法架构搜索和超参数调整等任务,或者这些任务的某些子集或变体。因此,自动化机器学习现在可以被视为从仅执行单一任务(如自动化特征工程),到完全自动化的流程(从数据预处理、特征工程到算法选择等)的任何事物。

然而,实际的 AutoML 还有一个重要维度,即其实施复杂性。这一维度决定了实现和配置 AutoML 项目所需的配置和工程努力。有些解决方案可以轻松集成到现有的软件 API 中;有些是现有 API 的封装;还有些则进一步远离现有 API,通过命令行或单行代码调用。

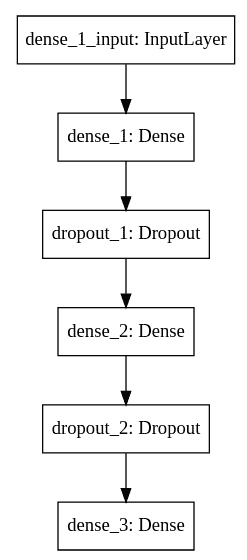

为了展示 AutoML 之路上实施复杂性的差异,让我们看看 3 个具体的软件项目如何处理这样的 AutoML “解决方案”,即 Keras Tuner、AutoKeras 和 automl-gs。我们将看到这些项目在哲学上彼此间的差异,并了解实现这些方法所需或适合的不同级别的机器学习知识。

请注意,这些项目中的前两个直接与 Keras 和 TensorFlow 相关,因此它们特定于神经网络。然而,其他 AutoML 软件在这些相对实施复杂性下并不一定特定于神经网络;这两个工具仅提供了一种在实施复杂性之间进行比较的简便方法。

还需要注意的是,所评估的复杂性是解决方案的实际代码实现复杂性。还有许多其他的 AutoML 相关复杂性会影响其整体复杂性,包括数据集的大小、维度等。

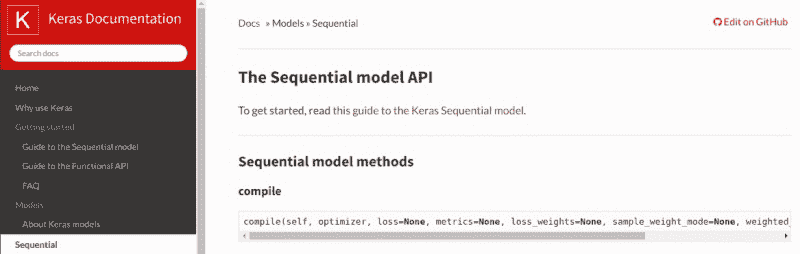

Keras Tuner

让我们从Keras Tuner开始,我将其称为“需要一些组装”的自动化机器学习项目。为了成功实施该项目的解决方案,您需要对神经网络、其架构和使用 Keras 库编写代码有一定了解。因此,这比本文讨论的其他库更为“深入”。

本质上,Keras Tuner 为 Keras 提供自动化的超参数调优。您定义一个 Keras 模型,并注明希望包含在自动化调优中的超参数以及搜索空间,然后 Keras Tuner 执行繁重的工作。这些超参数可以包括条件参数,搜索空间可以限制到您喜欢的程度,但本质上这是一个超参数调优应用程序。

回想一下,本文提到的复杂性不是指特定项目执行的 AutoML 任务数量,而是实现这些任务的代码的复杂性。在这方面,鉴于我们可以称之为底层基础库代码的部分必须编写并与我们的 AutoML 库集成,Keras Tuner 代表了 AutoML 实现复杂性谱系中更复杂的一端。

Keras Tuner 最可能的用户是机器学习工程师或数据科学家。您不太可能发现具有少量或没有编码或机器学习专业知识的特定领域专家直接跳转到 Keras Tuner,而不是下面的其他项目之一。要了解原因,这里是如何实现一些非常基础的 Keras Tuner 代码的快速概述(示例来自Keras Tuner 文档网站)。

首先,您需要一个函数来返回一个编译好的 Keras 模型。它接受一个参数,从中采样超参数:

from tensorflow import keras

from tensorflow.keras import layers

from kerastuner.tuners import RandomSearch

def build_model(hp):

model = keras.Sequential()

model.add(layers.Dense(units=hp.Int('units',

min_value=32,

max_value=512,

step=32),

activation='relu'))

model.add(layers.Dense(10, activation='softmax'))

model.compile(

optimizer=keras.optimizers.Adam(

hp.Choice('learning_rate',

values=[1e-2, 1e-3, 1e-4])),

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

return model

然后,您需要一个调优器,它指定了模型构建函数、优化目标、试验次数等内容。

tuner = RandomSearch(

build_model,

objective='val_accuracy',

max_trials=5,

executions_per_trial=3,

directory='my_dir',

project_name='helloworld')

然后开始搜索最佳超参数配置:

tuner.search(x, y,

epochs=5,

validation_data=(val_x, val_y))

最后,要么检查最佳模型,要么打印结果总结:

# Best model(s)

models = tuner.get_best_models(num_models=2)

# Summary of results

tuner.results_summary()

您可能会犹豫是否将此实现的代码称为极其复杂,但当您与以下项目进行比较时,我希望您改变主意。

要查看上述代码的更多细节、Keras Tuner 的一般过程以及您可以对该项目做的更多工作,请参见其网站。

AutoKeras

接下来是AutoKeras,我将其称为“现成的”解决方案,这是一种预打包的、或多或少已经准备好的解决方案,使用更为限制性的代码模板。AutoKeras 自我描述为:

AutoML 的终极目标是为具有有限数据科学或机器学习背景的领域专家提供易于访问的深度学习工具。

为了实现这一点,AutoKeras 执行了 Keras 神经网络模型的架构搜索和超参数调整。

这是使用 AutoKeras 的基本代码足迹:

import autokeras as ak

clf = ak.ImageClassifier()

clf.fit(x_train, y_train)

results = clf.predict(x_test)

如果你使用过 Scikit-learn,这种语法应该很熟悉。上述代码使用了task API;不过,还有其他更复杂的 API。你可以在项目文档网站上找到这些附加 API 的更多信息和更详细的教程。

显然,上述 AutoKeras 代码的复杂性相比 Keras Tuner 显著降低。然而,当你降低复杂性时,确实会牺牲一些精度,这是明显的权衡。对于具有有限机器学习专业知识的领域专家来说,这可能是一个不错的平衡点。

automl-gs

我们要查看的第三种解决方案是automl-gs,它从 30,000 英尺的高度审视 AutoML 实现。这超越了“现成”实现的复杂性,提供了一种有点类似 Staples 简易按钮的方法。

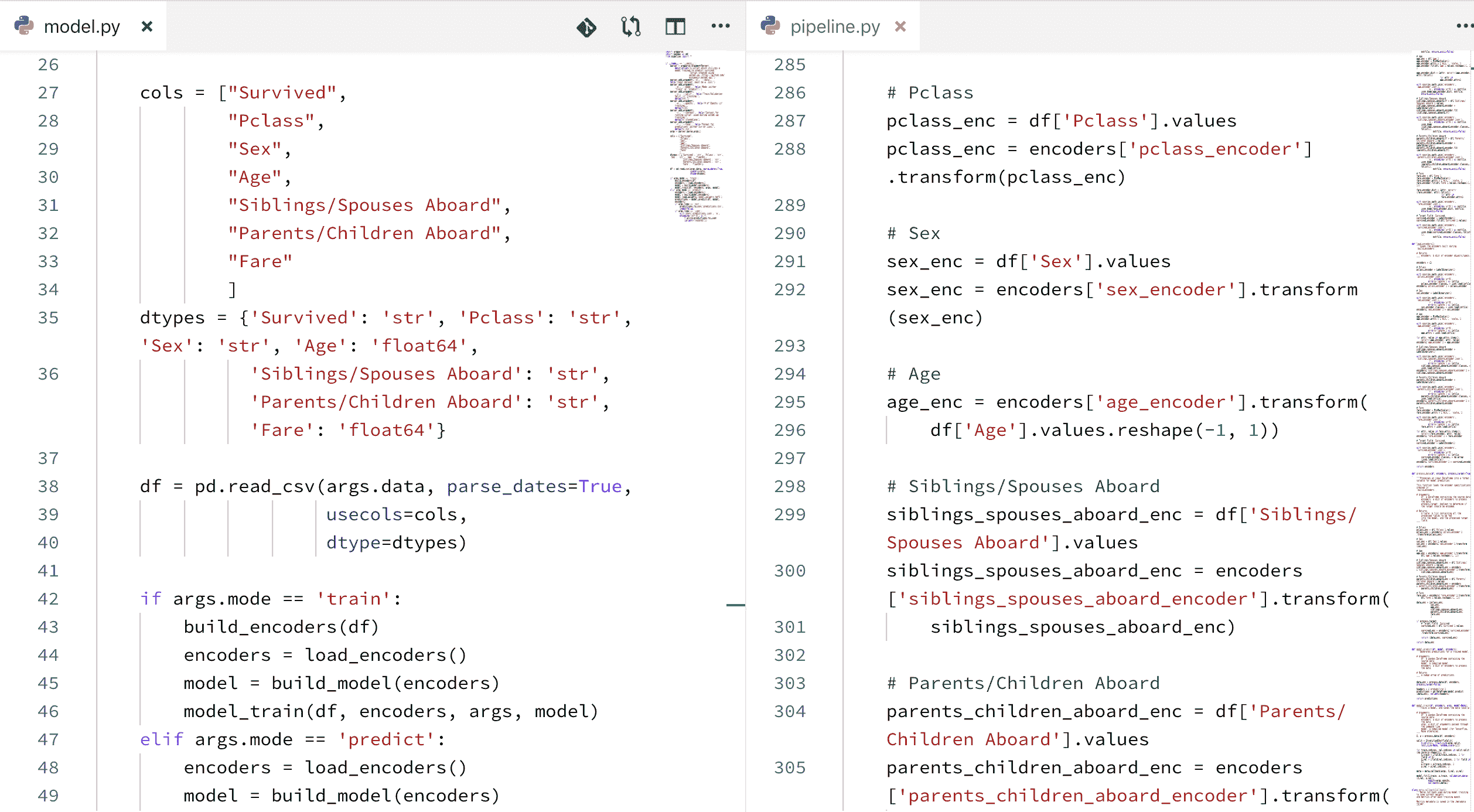

automl-gs 提供了一个“零代码/模型定义接口”。你只需将其指向一个 CSV 文件,确定要预测的目标字段,然后让它自动运行。它生成的 Python 代码可以集成到现有的机器学习工作流中,类似于流行的 AutoML 工具 TPOT的功能。automl-gs 还宣称它不是黑箱,因为你可以看到数据是如何处理的,模型是如何构建的,从而在事后进行调整。

automl-gs 执行数据预处理,并目前使用神经网络(通过 Keras)和 XGBoost 构建模型,同时计划实现 CatBoost 和 LightGBM。

这里是调用 automl-gs 的两种方法的比较,通过命令行和通过一行代码。请注意,你可以在项目网站上找到关于配置选项的更多信息以及检查输出的内容。

命令行:

automl_gs titanic.csv Survived

Python 代码:

from automl_gs import automl_grid_search

automl_grid_search('titanic.csv', 'Survived')

现在应该很容易比较这三种级别的 AutoML 项目复杂性。

automl-gs 可以通过单个命令行命令或单行 Python 代码 API 调用执行。因此,这个项目可能被任何人使用,从寻找项目基准的专业数据科学家,到具有有限编码技能或没有统计知识的业余爱好者,寻求数据科学的入门(在这里插入关于操控你不理解的力量的标准警告)。虽然一个业余项目基于预测做出一些重要决策可能会有问题(在我看来不太可能),但将机器学习和 AutoML 开放给任何想要了解更多的人确实具有价值。

automl-gs 输出代码示例 (来源)

类似于 TPOT,我认为这里的价值在于创建项目基准的潜在低门槛。可以将 automl-gs 指向一个 CSV,让它并行地进行操作,同时手动制作竞争解决方案,并比较结果。这也可以通过其他 AutoML 工具完成,但这种低复杂度工具的绝对简单性依赖于几乎无需设置和考虑的特性,使得它能够非常快速地启动。能够在之后审查模型并进行编辑也很有吸引力,可以作为这种并行 AutoML/手动模型构建过程的另一层添加。

重点内容

机器学习呈现出一系列可以以不同程度自动化的任务,以帮助简化流程并提高成功率。自动化机器学习项目在自动化任务的方式以及对这些任务的配置、执行和后续操作的控制精度上采取不同的方法。希望这里突出介绍的 3 个项目能提供一些关于 AutoML 工具的实际代码复杂度差异的具体示例,以及它们如何以及对谁有用。

相关:

-

GitHub 仓库劫掠者与机器学习的自动化

-

自动化超参数调整您的模型

-

自动化机器学习:究竟多少?

我们的前 3 个课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

1. Google 网络安全证书 - 快速进入网络安全职业轨道。

2. Google 数据分析专业证书 - 提升您的数据分析能力

2. Google 数据分析专业证书 - 提升您的数据分析能力

3. Google IT 支持专业证书 - 支持您的组织 IT

3. Google IT 支持专业证书 - 支持您的组织 IT

更多相关主题

AutoML:使用 Auto-Sklearn 和 Auto-PyTorch 的介绍

原文:

www.kdnuggets.com/2021/10/automl-introduction-auto-sklearn-auto-pytorch.html

评论

让计算机自动完成你想要的任务

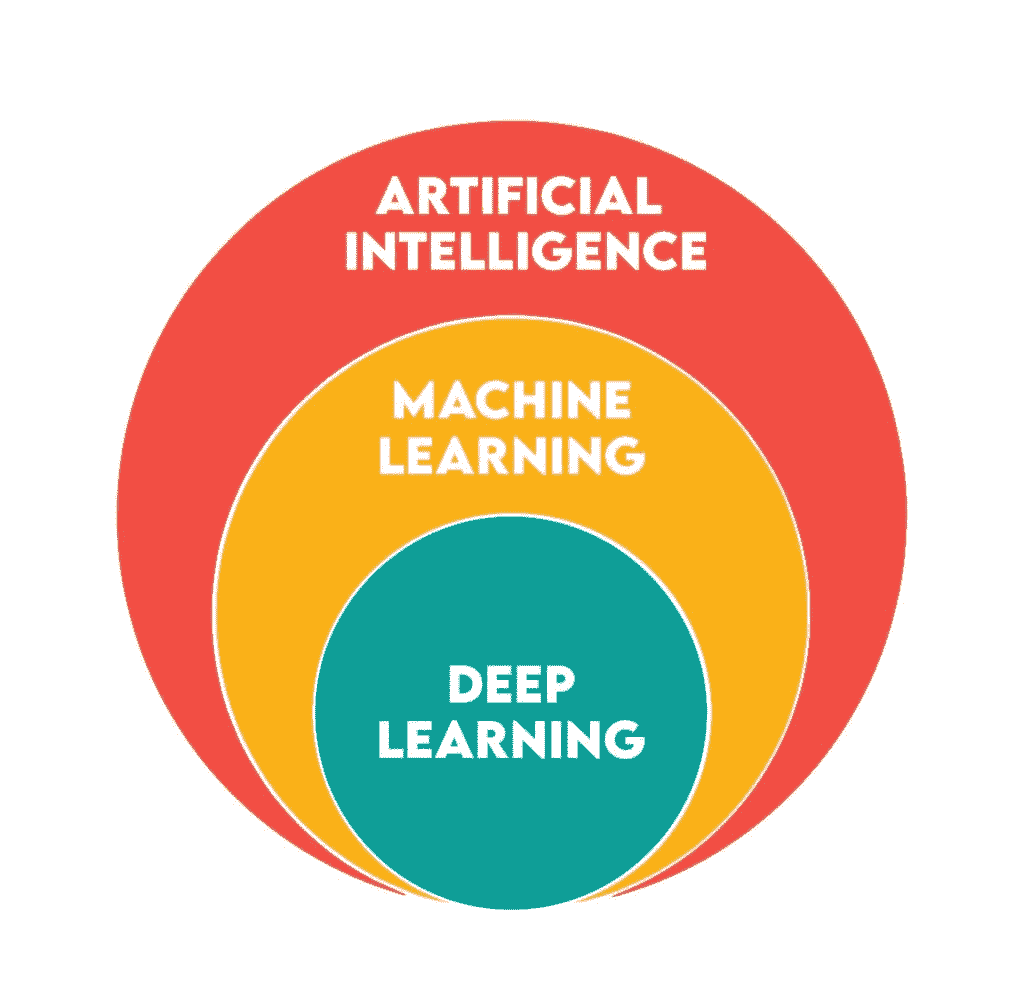

机器学习 (ML)现在影响着广泛的商业、工程和研究领域,以至于很难找到一个完全未涉及机器学习的领域。机器学习的进展伴随着软件和自动化的广泛趋势:只要人类活动依赖于可以以计算机可以处理的方式描述的重复任务,通常编写一个计算机可以遵循的配方(或程序)是很有用的。

现在使用机器学习意味着对于许多有用的任务,已经不再需要手动编写程序,甚至不需要准确知道如何解决问题。相反,我们可以通过定义一个搜索空间和一个学习算法来解决许多问题,然后让机器来解决。

现代机器学习有时被称为“软件 2.0”,这一趋势受到深度学习效果以及随之而来的研究和开发兴趣的推动。显而易见,这种方法非常适合一些应用:例如,拟合统计模型到数据上;但也有一些更深奥和令人印象深刻的例子,在统计学或旧式机器学习时代并不明显。

在过去几年中,我们看到机器学习比其他任何方法更好地预测蛋白质折叠,在围棋、Dota II、星际争霸 II 等游戏中击败了顶级人类玩家,并创造出相对连贯的文本和语音回应(尽管最后的成就有时可能会有偏差)。

尽管如此,这些项目几乎总是需要大量世界级工程和研究人才的应用。这并不完全令人惊讶,因为即使是配备了先进最尖端机器学习算法的计算机程序,要实现全新的目标仍然需要人类的创新。这种情况可能会在未来发生变化,当人工智能研究人员创造出突破人类专家级别的人工智能研究者门槛的新机器学习代理时。

目前,尽管突破性的人工智能科学仍然难以实现自动化,但有越来越多的机器学习应用场景中,不一定需要人工工程师来优化模型以完成特定任务。实际上,在某些任务中,将选择具体模型和调整学习超参数的任务交给人工判断,实际上可能会拖慢进度或导致结果不佳。人类可能在探索超参数空间时表现不佳,可能因为错误的原因偏向自己喜欢的模型类型,或者可能比实际训练模型所需的更频繁地开始和停止训练(这对他们的心理状态也不好)。

相反,一个好的机器学习从业者应该充分利用所有可用的工具,现在这些工具包括开源现成工具和应用机器学习的最佳实践。换句话说,AutoML。

什么是 AutoML?

AutoML 是一个广泛的技术和工具类别,用于将自动化搜索应用于您的自动化搜索,并将学习应用于您的学习。这些技术从对统计学习算法的超参数应用贝叶斯优化,到对深度学习模型进行神经网络结构搜索。

这个领域非常活跃且多样化,拥有健康的竞赛生态系统,其中许多竞赛都在automl.ai上进行了记录。事实上,最著名的 AutoML 包之一,Auto-SciKit-Learn(Auto-Sklearn),起初是 2014 年至 2016 年 ChaLearn AutoML 挑战赛的获胜者。

Auto-Sklearn 由德国著名的AutoML 超级组织中追求自动化机器学习的最著名研究小组之一开发。这个合作组织由弗赖堡大学和汉诺威大学的实验室组成。其他在这一领域有显著贡献的研究者包括Auto-WEKA背后的科学家,Auto-WEKA 是最早的流行 AutoML 工具包之一,以及其继任者 Auto-WEKA 2.0。这些研究人员主要分布在北美,但以加拿大的不列颠哥伦比亚大学为中心。而 Auto-WEKA 与开源 WEKA 软件和 Java 一起工作,Auto-Sklearn 是一个 Python 包,并且旨在紧密遵循 SciKit-Learn 的使用模式(因此得名“Auto-SciKit-Learn”)。

除了 Auto-Sklearn,弗赖堡-汉诺威 AutoML 小组还开发了一个Auto-PyTorch库。我们将在接下来的简单教程中使用这两个库作为我们进入 AutoML 的起点。

AutoML 教程演示

首先,我们将设置所需的包和依赖项。我们使用 Python3 的 virtualenv 来管理项目的虚拟环境,但如果你更喜欢 Anaconda(特别是如果你在 Anaconda 中使用 pip),你会发现类似的说明应该也能奏效。

以下是从基于 Unix 的系统(如 Ubuntu)或类似 Anaconda 提示符的 Windows 系统的命令行设置环境的命令。Auto-Sklearn 文档建议首先从其 requirements.txt 依赖文件安装,但我们发现对于本教程中使用的代码没有必要这样做。

# create and activate a new virtual environment

virtualenv automl --python=python3

source automl/bin/activate

# install auto-sklearn

pip install auto-sklearn

如果你在同一环境中同时使用 AutoML 库,可能会遇到冲突,因此请为 Auto-PyTorch 创建第二个环境。请注意,此环境需要使用版本大于或等于 3.7 的 Python。

deactivate

virtualenv autopt –-python=python3.7

source autopt/bin/activate

# install auto-pytorch from the github repo

git clone https://github.com/automl/Auto-PyTorch.git

cd Auto-PyTorch

pip install -e .

pip install numpy==1.20.0

pip install ipython

请注意,在 pip install -e . 后还有额外的两个安装语句。在我们的操作中,将 NumPy 版本升级到 1.20.0 解决了一个奇怪的错误,下面重现了该错误。

ValueError: numpy.ndarray size changed, may indicate binary incompatibility. Expected 88 from C header, got 80 from PyObject

如果你想为项目做贡献,或只是想查看最新的进行中的代码,请查看开发分支。

# (optional)

git checkout development

# make sure to switch back to the primary branch for the tutorial

git checkout master

本教程的其余代码是 Python 代码,因此请启动你的 Python 提示符、Jupyter notebook 或文本编辑器。

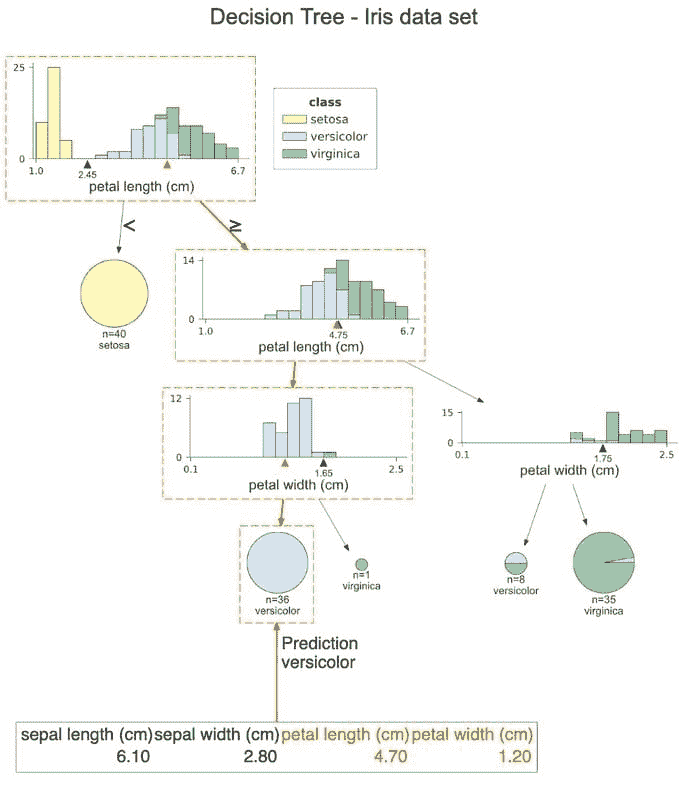

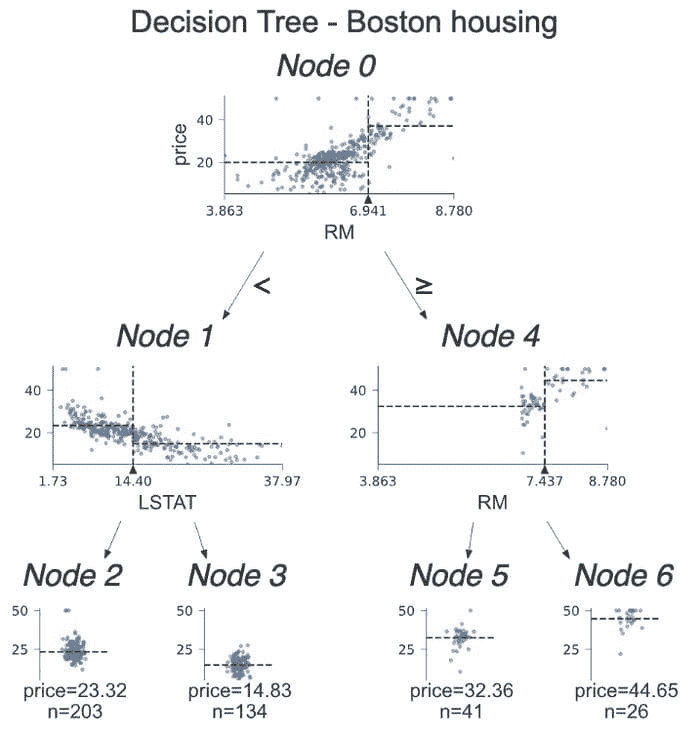

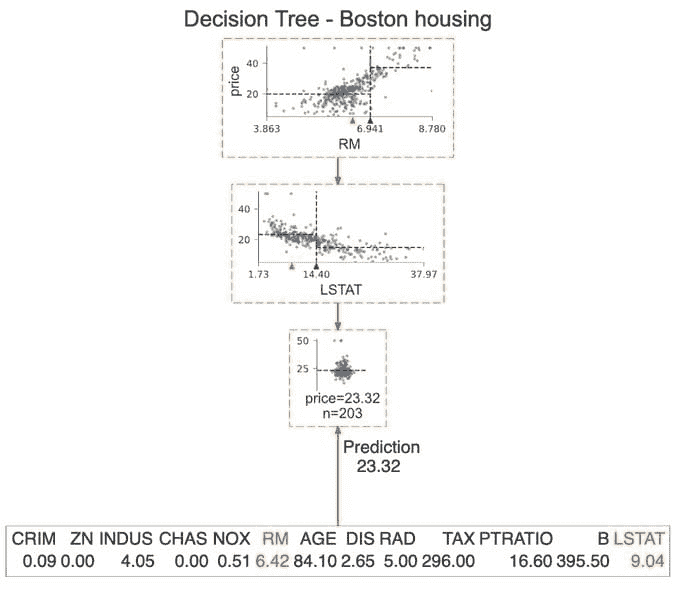

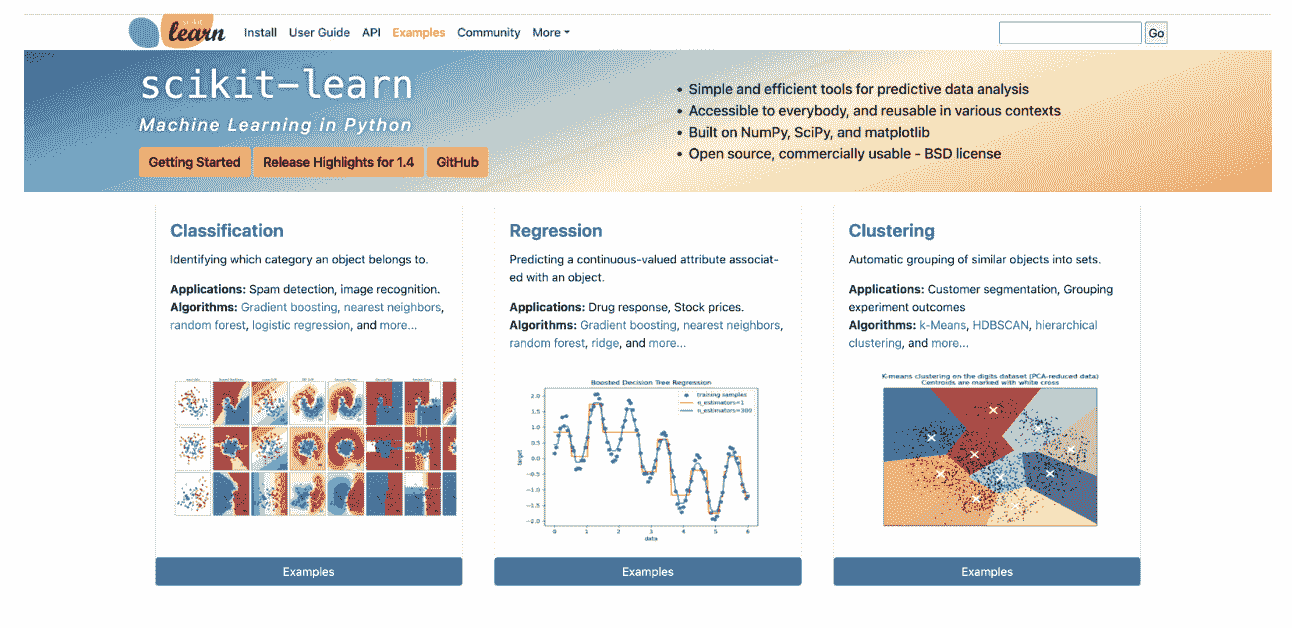

本教程将包含使用标准 SciKit-Learn、Auto-Sklearn 和 Auto-PyTorch 分类器进行分类的最少演示。我们将为每种情况使用 SciKit-Learn 提供的内置数据集,每个演示都共享一些代码以导入公共依赖项、加载和拆分数据集。

import time

import sklearn

import sklearn.datasets

#** load and split data **

data, target = sklearn.datasets.load_iris(return_X_y=True)

# split

n = int(data.shape[0] * 0.8)

train_x = data[:n]

train_y = target[:n]

test_x = data[n:]

test_y = target[n:]

上述设置数据集的代码将用于本教程中的每个演示。

我们使用了小型的“iris”数据集(150 个样本,4 个特征和 3 个标签类别),以节省时间,但在完成示例后,你可能会想尝试更复杂的数据集。

其他可以尝试的 sklearn.datasets 中的分类数据集包括糖尿病 (load_diabetes) 数据集和手写数字数据集 (load_digits)。糖尿病数据集有 569 个样本,每个样本有 30 个特征和 2 个标签类别,而手写数字数据集有 1797 个样本,每个样本有 64 个特征(对应 8x8 的图像)和 10 个标签类别。

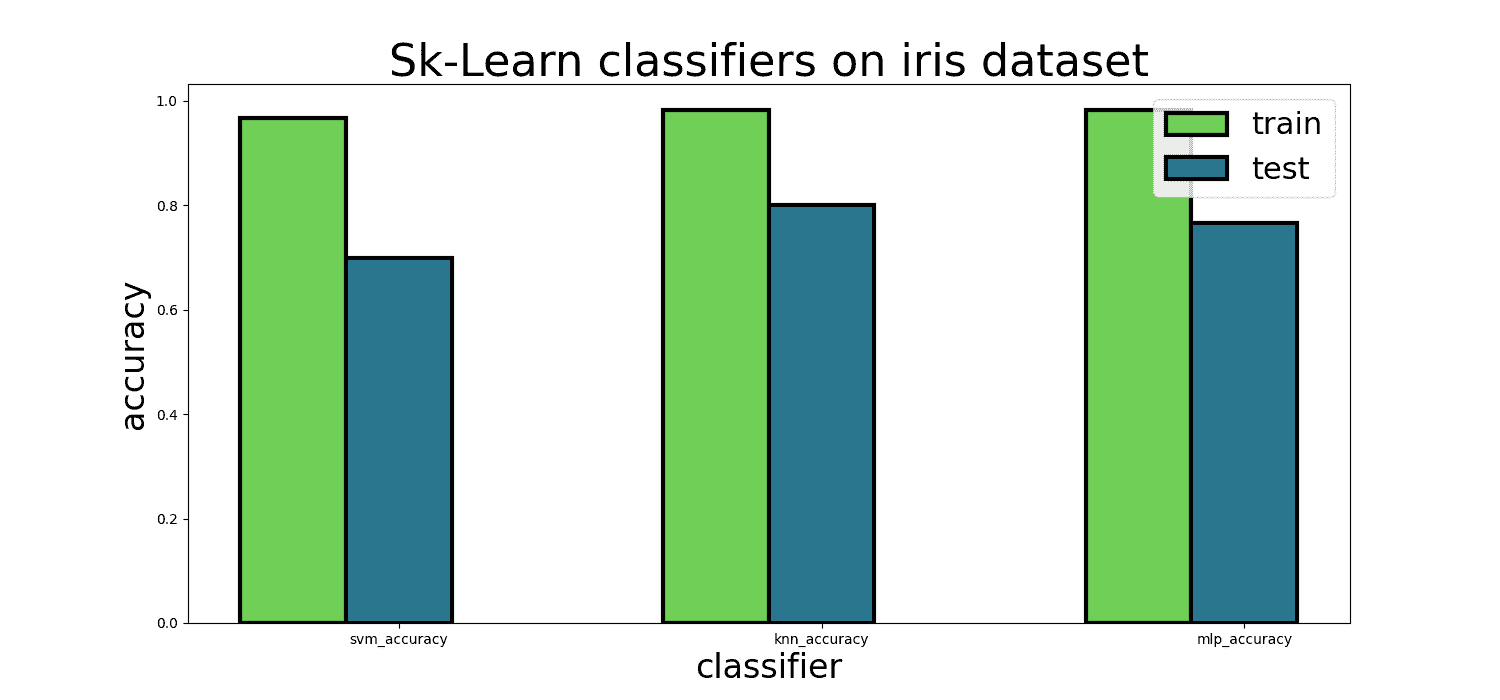

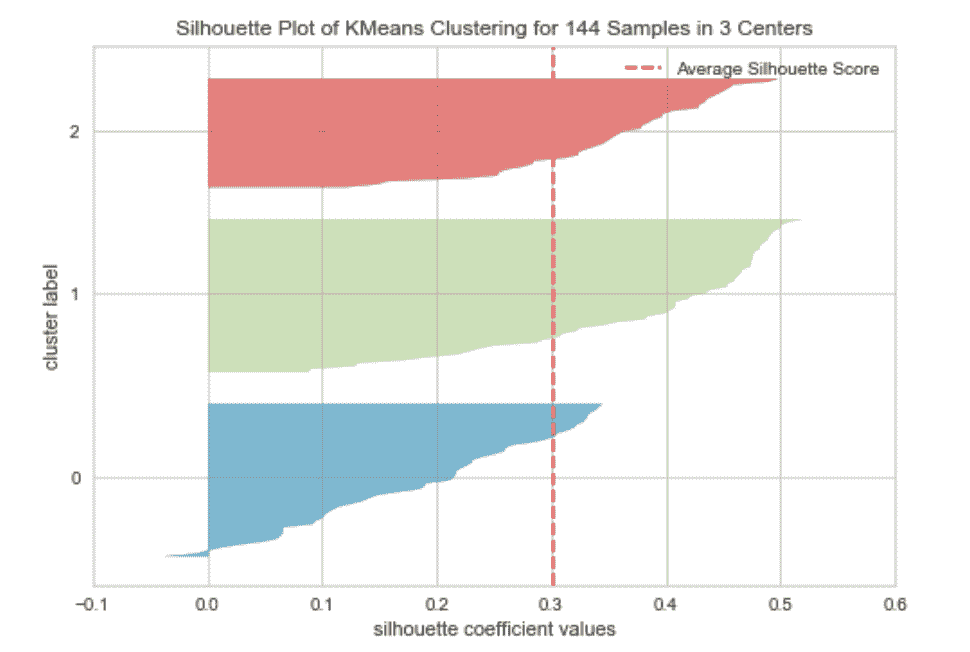

在开始使用 sklearn 的 AutoML 分类器之前,让我们先使用 vanilla sklearn 的默认设置训练几个标准分类器。可以选择很多,但我们将坚持使用 k-最近邻分类器、支持向量机分类器和多层感知器。

# import classifiers

from sklearn.svm import SVC

from sklearn.neural_network import MLPClassifier

from sklearn.neighbors import KNeighborsClassifier

# instantiate with default parameters

knn = KNeighborsClassifier()

mlp = MLPClassifier()

svm = SVC()

SciKit-Learn 使用友好的 fit/predict API,使得训练模型变得非常简单,Auto-Sklearn 和 Auto-PyTorch 也保留了相同的 API。这是易用性的一个重要因素,因为在这三个包中训练模型的体验非常相似。

t0 = time.time()

knn.fit(train_x, train_y)

mlp.fit(train_x, train_y)

svm.fit(train_x, train_y)

t1 = time.time()

同样,评估你的模型也很简单。SciKit-Learn 分类模型有一个 predict 方法,该方法接收输入数据并预测标签,然后可以将结果传递给 sklearn.metrics.accuracy_score 以计算准确率。

以下代码可以用来计算预测和在保留的测试集上的预测准确率,使用的是在上一段代码中训练的 k 最近邻、支持向量机和多层感知器分类器。

knn_predict = knn.predict(test_x)

train_knn_predict = knn.predict(train_x)

svm_predict = svm.predict(test_x)

train_svm_predict = svm.predict(train_x)

mlp_predict = mlp.predict(test_x)

train_mlp_predict = mlp.predict(train_x)

knn_accuracy = sklearn.metrics.accuracy_score(test_y, knn_predict)

train_knn_accuracy = sklearn.metrics.accuracy_score(train_y,train_knn_predict)

svm_accuracy = sklearn.metrics.accuracy_score(test_y, svm_predict)

train_svm_accuracy = sklearn.metrics.accuracy_score(train_y,train_svm_predict)

mlp_accuracy = sklearn.metrics.accuracy_score(test_y, mlp_predict)

train_mlp_accuracy = sklearn.metrics.accuracy_score(train_y,train_mlp_predict)

print(f"svm, knn, mlp test accuracy: {svm_accuracy:.4f}," \

f"{knn_accuracy:.4}, {mlp_accuracy:.4}")

print(f"svm, knn, mlp train accuracy: {train_svm_accuracy:.4f}," \

f"{train_knn_accuracy:.4}, {train_mlp_accuracy:.4}")

print(f"time to fit: {t1-t0}")

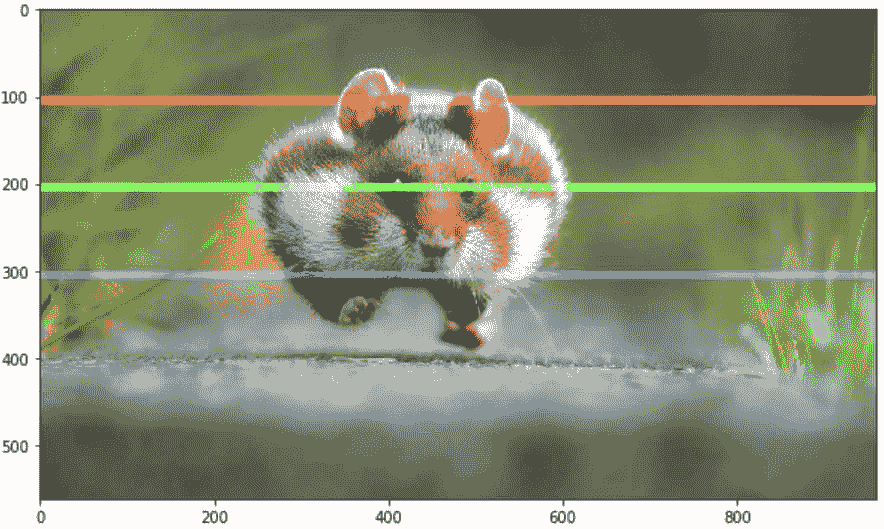

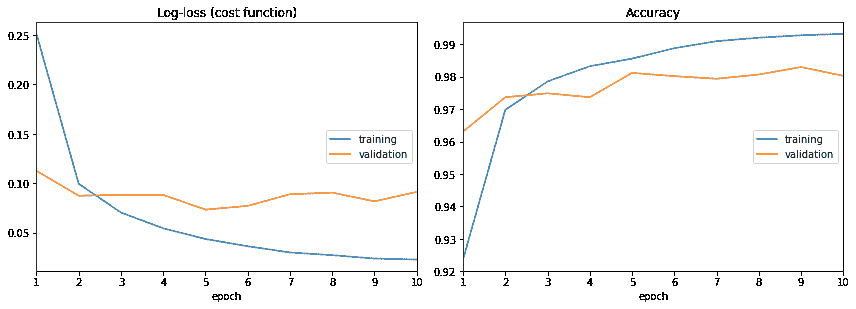

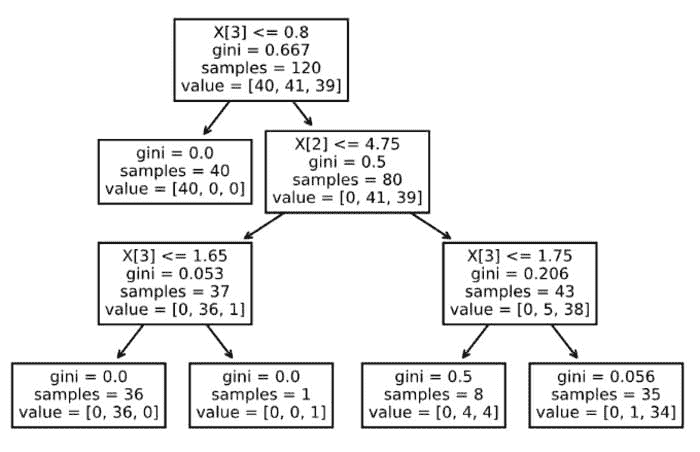

Sklearn 分类器在鸢尾花数据集上的图像

这些模型在鸢尾花训练数据集上相当有效,但训练集和测试集之间存在显著差距。

接下来,让我们使用这个类

AutoSKlearnClassifier

来源于

autosklearn.classification

使用这个基本 AutoML 类的代码看起来和上面示例中训练单个模型的代码完全相同,但实际上它会对多种机器学习模型进行超参数搜索,并保留最佳模型作为集成。

在引入常用库并设置好训练和测试数据集分割后,我们需要导入并实例化 AutoML 分类器。

import autosklearn

from autosklearn.classification import AutoSklearnClassifier as ASC

classifier = ASC()

classifier.time_left_for_this_task = 300

t0 = time.time()

classifier.fit(train_x, train_y)

t1 = time.time()

autosk_predict = classifier.predict(test_x)

train_autosk_predict = classifier.predict(train_x)

autosk_accuracy = sklearn.metrics.accuracy_score( \

test_y, autosk_predict \

)

train_autosk_accuracy = sklearn.metrics.accuracy_score( \

Train_y,train_autosk_predict \

)

print(f"test accuracy {autosk_2_accuracy:.4f}")

print(f"train accuracy {train_autosk_2_accuracy:.4f}")

print(f"time to fit: {t1-t0}")

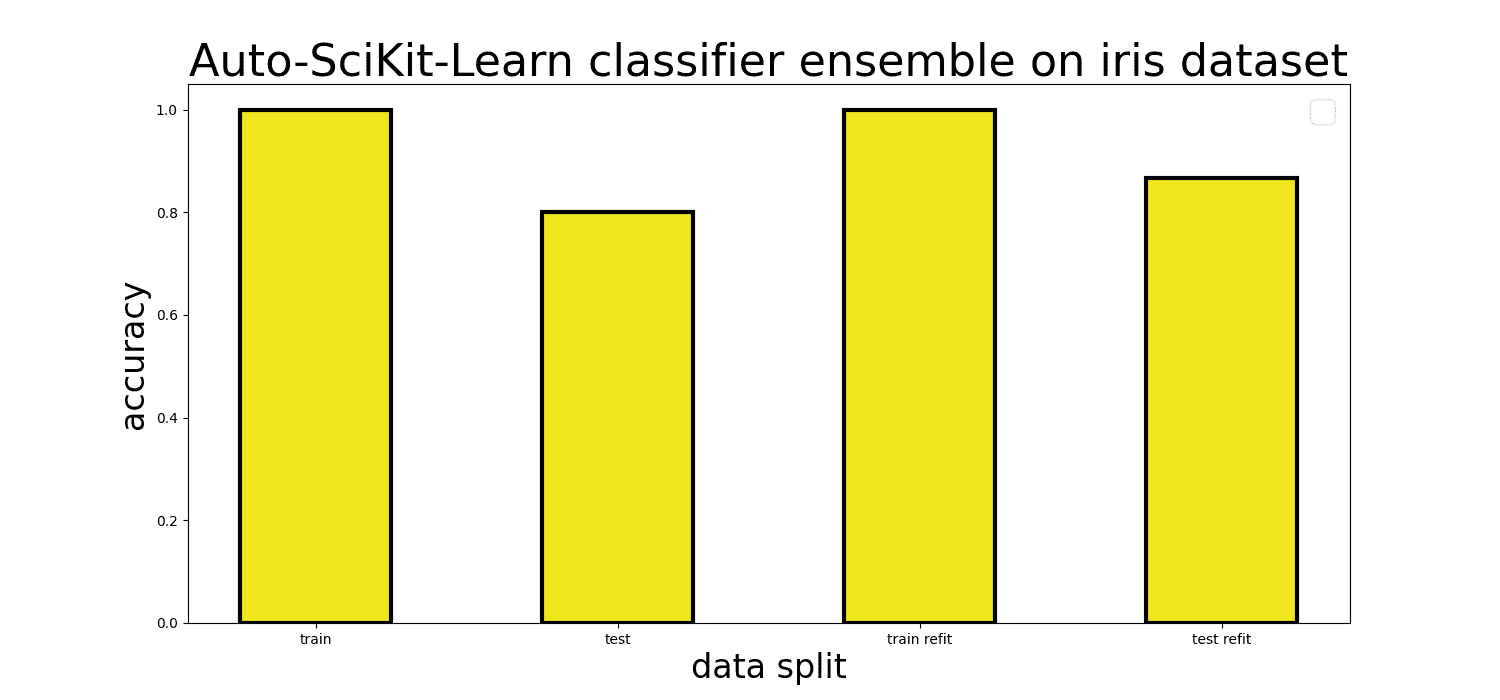

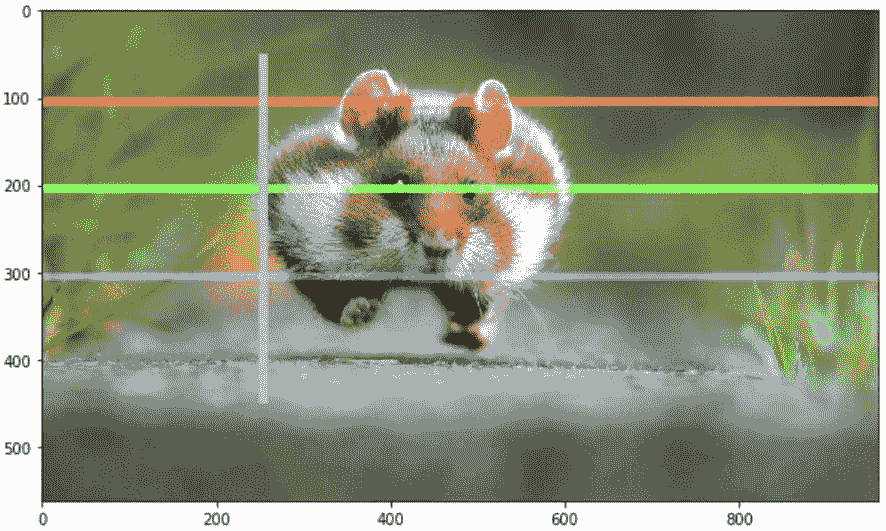

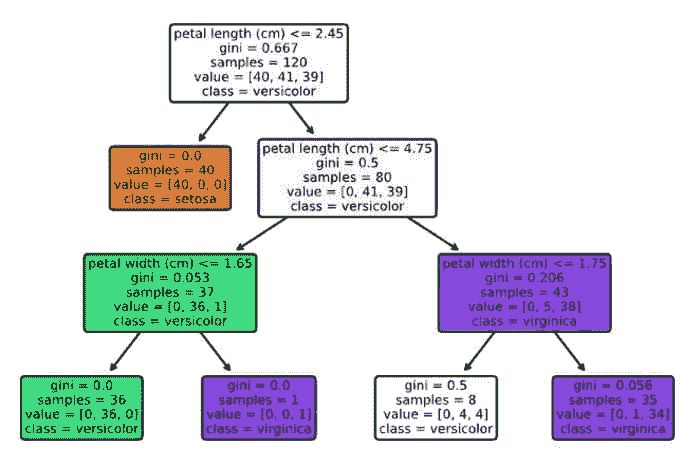

Auto-Sklearn 分类器集成在鸢尾花数据集上的图示

如果你不重置time_left_for_this_task,使用AutoSklearnClassifier运行fit方法将会花费大量时间,因为默认值是 3600 秒(一小时)。对于我们简单的鸢尾花数据集来说,这是过度的。从包文档来看,时间限制应该可以作为初始化分类器对象时的输入参数设置,但在我们的经验(版本 0.13.0)中并非如此。

你还可以尝试启用交叉验证来运行 fit 方法,如果选择这样做,你需要再次使用该方法进行训练。

refit

用最佳模型和超参数训练整个训练数据集。我们发现,当使用交叉验证和重训练相比于默认设置时,测试集准确率从 80%提高到了 86.67%。

请记住,当你在使用predict方法对AutoSklearnClassifier对象进行推断时,你实际上是在利用在 AutoML 超参数搜索过程中找到的最佳模型的集成。

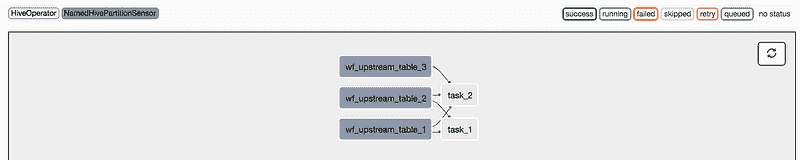

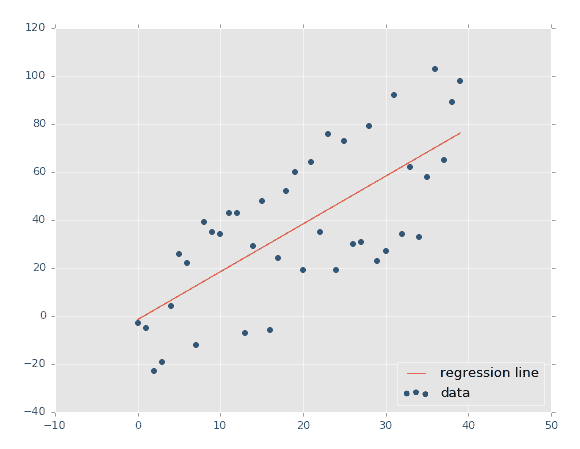

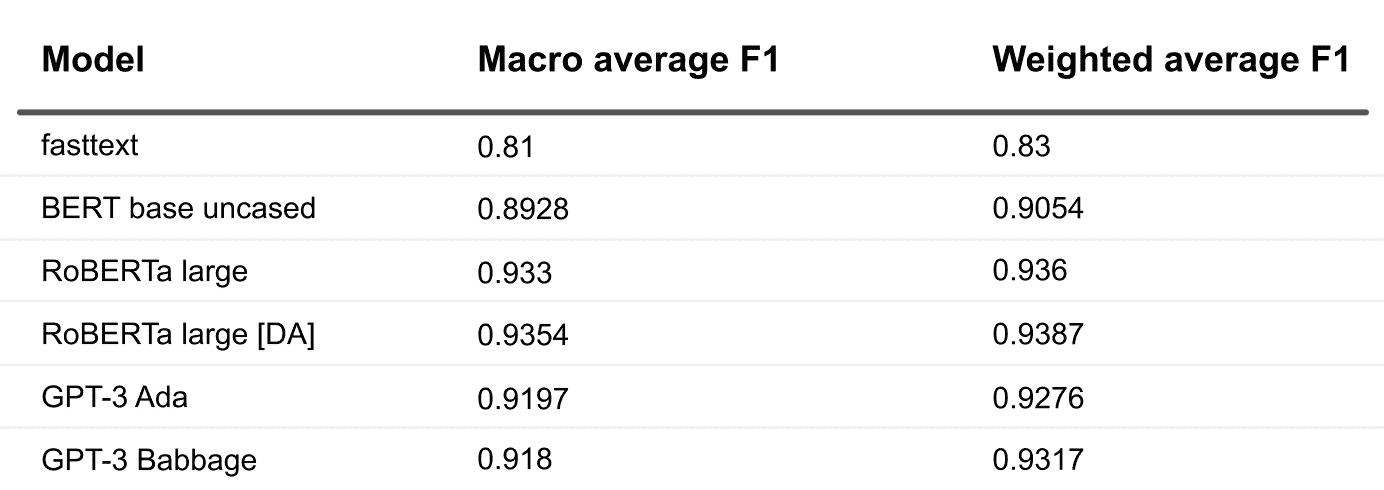

| 方法 | 训练准确率 | 测试准确率 | 运行时间 |

|---|---|---|---|

| 默认 KNN | 0.9833 | 0.8000 | 0.6 ms 总计 |

| 默认 SVM | 0.9667 | 0.7000 | 0.6 ms 总计 |

| 默认 MLP | 0.9833 | 0.7667 | 0.6 ms 总计 |

| Auto-Sklearn | 1.000 | 0.8000 | 291.390 s |

| Auto-Sklearn (含 cv + refit) | 1.000 | 0.8667 | 918.658 s |

| Auto-PyTorch | 0.9917 | 0.9667 | 302.236 s |

最后,让我们尝试一个适合深度学习爱好者的 AutoML 包。

与 Auto-Sklearn 一样,Auto-PyTorch 也旨在极其简单易用。要运行下一段代码,请记得切换到你的 Auto-PyTorch 环境,以确保正确的依赖项可用。在导入常用库并拆分数据之后:

import autoPyTorch

from autoPyTorch import AutoNetClassification as ANC

model = ANC(max_runtime=300, min_budget=30, max_budget=90, cuda=False)

t0 = time.time()

model.fit(train_x, train_y, validation_split=0.1)

t1 = time.time()

auto_predict = model.predict(test_x)

train_auto_predict = model.predict(train_x)

auto_accuracy = sklearn.metrics.accuracy_score(test_y, auto_predict)

train_auto_accuracy = sklearn.metrics.accuracy_score(train_y, train_auto_predict)

print(f"auto-pytorch test accuracy {auto_accuracy:.4}")

print(f"auto-pytorch train accuracy {train_auto_accuracy:.4}")

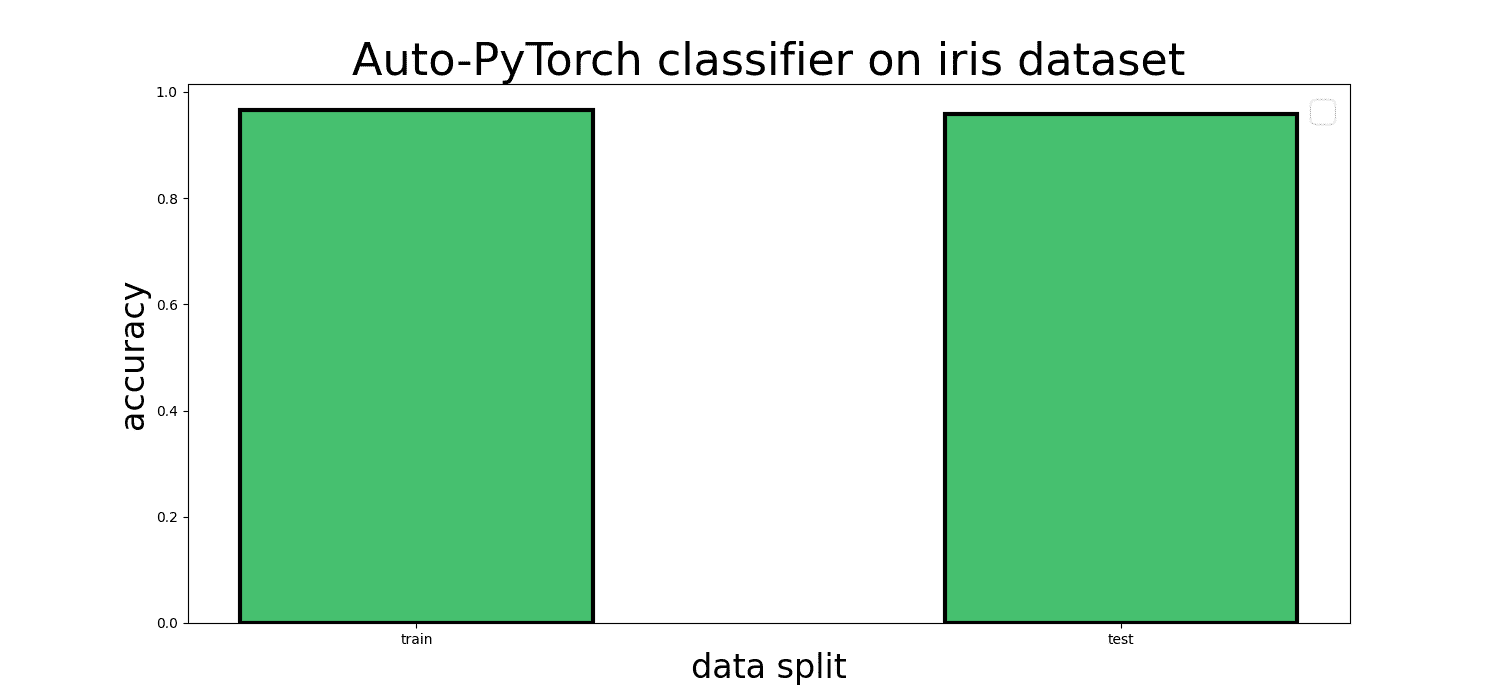

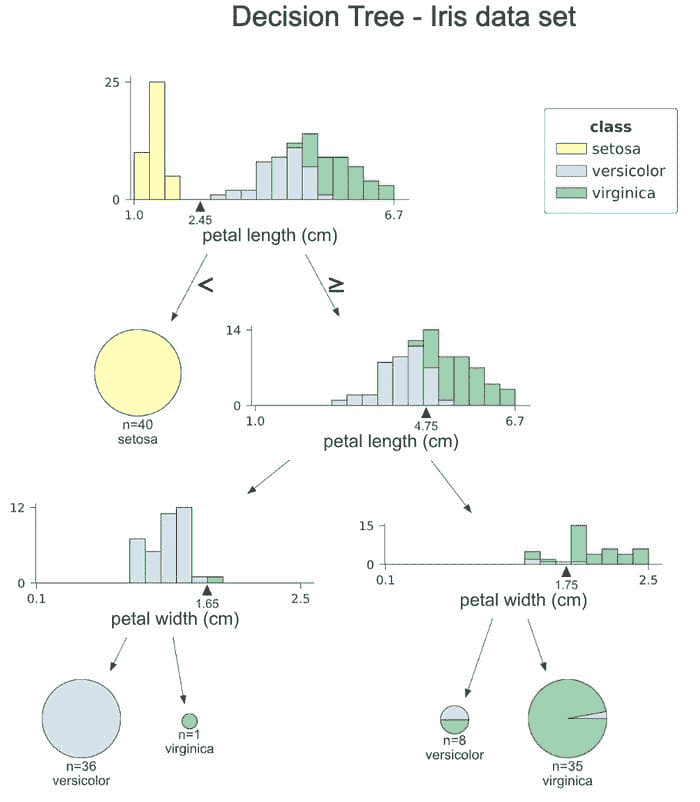

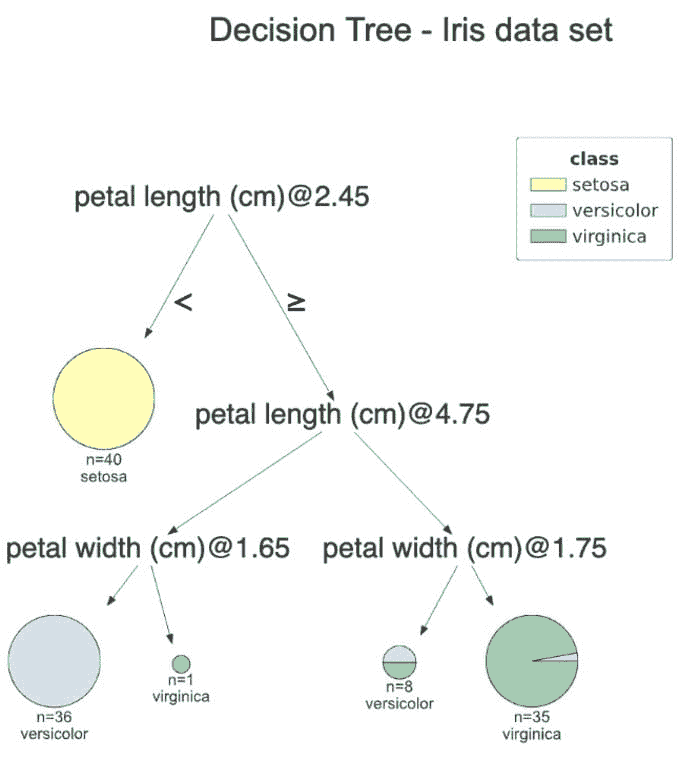

Auto-PyTorch 分类器在鸢尾花数据集上的图示

正如你在结果表中看到的,Auto-PyTorch 在拟合鸢尾花数据集时非常高效和有效,训练和测试准确率达到了 90 多%。这比我们之前训练的自动 SciKit-Learn 分类器稍微好一点,比使用默认参数的标准 sklearn 分类器要好得多。

AutoML 会取代数据科学家吗?

不,未必。AutoML 承诺改善典型数据科学和机器学习工作流的实用性、性能和效率。额外的抽象层和自动化的最佳实践超参数搜索,如果使用得当,确实可以带来显著的不同。对于我们在今天教程中实验的这些软件包,我们将其准备程度描述为正在进行的研究原型。

我们需要进行许多小修小补才能使一切正常工作,例如将 NumPy 升级到 1.20.0 以修复模糊的错误消息,无法将运行时间限制设置为输入参数(如 Auto-Sklearn 文档所建议),以及由于一些模糊的冲突而无法使用单个虚拟环境同时支持两个软件包。此外,AutoML 的价值在于自动化超参数搜索,但自动分类器本身有许多参数,这些参数对最终结果有很大影响,这也让人忍俊不禁。

尽管如此,我们认为 AutoML 是任何机器学习或数据科学从业者工具箱中有价值的补充,无论他们使用 Auto-Sklearn/Auto-PyTorch、Auto-WEKA、其他软件包,还是自行开发解决方案。当 AutoML 工具适合时,它不仅能提升项目的性能,还能减少经济和能源(包括环境)成本,从而避免长时间的超参数和架构搜索。

即使一些工具仍有许多粗糙的地方,这也只是一个很好的理由和动力,让你自己参与到这些项目中。Auto-PyTorch 在 Apache 2.0 许可证下提供,而 Auto-Sklearn 使用 BSD 3-Clause 许可证。

简介:Kevin Vu 负责管理 Exxact Corp 博客,并与许多才华横溢的作者合作,他们撰写有关深度学习不同方面的文章。

原文。经授权转载。

相关内容:

-

自动化机器学习简介

-

如何创建 AutoML 管道优化沙盒

-

使用 TPOT 进行机器学习管道优化

我们的三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

3. Google IT 支持专业证书 - 支持你的组织 IT 需求

更多相关内容

如何创建一个 AutoML 管道优化沙箱

原文:

www.kdnuggets.com/2021/09/automl-pipeline-optimization-sandbox.html

评论

你可能了解自动化机器学习(AutoML)。你很可能听说过开源的 AutoML 工具 TPOT,也就是你的 数据科学助手。你甚至可能看过我最近的文章,介绍了如何使用 TPOT 优化机器学习管道(你可能还没看过,所以这是你去看看它的机会... 我会等你)。

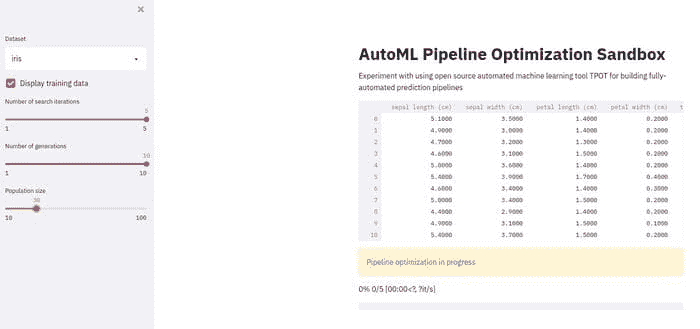

无论如何,当这些调节按钮可见且易于调整时,探索 AutoML 和机器学习优化的各种调节按钮将更具意义。在本文中,我们将实现一个版本的 TPOT 示例,我们在上一篇文章中查看过,将其作为一个 Streamlit 应用程序。

如果你不熟悉 Streamlit,这是 30,000 英尺的概述:

Streamlit 可以在几分钟内将数据脚本转化为可分享的网页应用程序。

全部使用 Python。完全免费。不需要前端经验。

概述

除了本文中使用的内容,我不会进一步详细介绍 Streamlit,但你可以在这里找到这个很棒的介绍,以及 Streamlit 备忘单,基本覆盖了在了解其工作原理后你需要知道的一切,点击这里。

除了快速了解实现 Streamlit 项目外,你还将获得一个沙箱网页应用程序,允许使用一对著名数据集进行管道优化实验。通过一些修改,你还应该能够让沙箱与其他数据集一起运行,并扩展功能以包括更多调节按钮。

我们使用 Streamlit 和 TPOT 构建的“AutoML 管道优化沙箱”网页应用程序

我不会重新讲述原始博客文章(请随意现在阅读),但简而言之,我们正在创建一个脚本来自动化预处理和建模的优化——包括有限数量的预处理转换以及算法选择——用于对鸢尾花和数字数据集的分类任务。确实,数据集比较无聊,但使用知名数据来设置应用程序并不是一个坏主意,正如我上面所说,修改几行代码后,你可以尝试任何其他数据集。

关于这个优化过程的一些注意事项,除了上述内容,还有:

-

用于模型评估的交叉验证

-

对建模进行多次迭代(由于 TPOT 内部使用遗传算法)— 对如此小的数据集可能没有用,但随着进展可能会有帮助

-

比较这些多次迭代的结果管道——它们都是相同的吗?

-

你知道 TPOT 现在在后台使用 PyTorch 来构建神经网络进行预测吗?

最后一点今天我们不考虑,但请记住以备未来使用。

让我们看一下创建这个简单 Streamlit 应用所需的代码。

代码

首先,导入:

import streamlit as st

import timeit

import pandas as pd

import matplotlib.pyplot as plt

from tpot import TPOTClassifier

from sklearn.model_selection import StratifiedKFold

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_digits, load_iris

from sklearn import metrics

from stqdm import stqdm

一切应该都相当直接。最后一个导入,stqdm,是一个 tqdm 风格的进度条,专门为 Streamlit 编写。

接下来,这是数据加载器函数:

@st.cache

def load_data(dataset, train_size, test_size, random_state):

"""Load data"""

ds = ''

if dataset == 'digits':

ds = load_digits()

df = load_digits(as_frame=True)

if dataset == 'iris':

ds = load_iris()

df = load_iris(as_frame=True)

X_train, X_test, y_train, y_test = train_test_split(ds.data, ds.target, train_size=train_size, test_size=test_size, random_state=random_state)

return X_train, X_test, y_train, y_test, df['frame']

我们使用 Scikit-learn 的 load_iris() 和 load_digits() 函数(TPOT 与之紧密集成)来提取相应的数据集。请注意,这里将数据集分为训练集和测试集,训练/测试特征/标签都分别返回,并提供一个完整的数据集数据框以供展示给用户,因为这样看起来更好,尤其是在 Streamlit 上展示时(Streamlit 能够使用其 write() 方法解释和正确显示各种对象)。还有其他方法可以实现,但对于如此小的数据集,这种方式简单而且没有问题。注意 @st.cache 装饰器,它缓存了函数的结果以便未来应用运行时使用,而不是每次都重新加载数据。

现在我们设置一些全局 Streamlit 配置,设置侧边栏,分配一些变量,并使用上述函数加载数据:

# Set title and description

st.title("AutoML Pipeline Optimization Sandbox")

st.write("Experiment with using open source automated machine learning tool TPOT for building fully-automated prediction pipelines")

# Create sidebar

sidebar = st.sidebar

dataset = sidebar.selectbox('Dataset', ['iris','digits'])

train_display = sidebar.checkbox('Display training data', value=True)

search_iters = sidebar.slider('Number of search iterations', min_value=1, max_value=5)

generations = sidebar.slider('Number of generations', min_value=1, max_value=10)

population_size = sidebar.select_slider('Population size', options=[10,20,30,40,50,60,70,80,90,100])

random_state = 42

train_size = 0.75

test_size = 1.0 - train_size

checkpoint_folder = './tpot_checkpoints'

output_folder = './tpot_output'

verbosity = 0

n_jobs = -1

times = []

best_pipes = []

scores = []

# Load (and display?) data

X_train, X_test, y_train, y_test, df = load_data(dataset)

if train_display:

st.write(df)

将上面的代码与先前作为独立脚本实现的文章或 Streamlit 快捷参考进行比较,相关内容应该都相当直接。

注意到设置交互式用户配置变量的简易性,这些变量随后被用于我们的代码中,以及设置侧边栏的简易性。我们可以使用滑块、复选框和下拉框来选择和显示数据集,并设置遗传算法 TPOT 内部用于优化过程的搜索迭代次数、代数和种群大小。应该越来越容易看出,如何在不费太多力气的情况下将其开放给自定义数据集。

接下来,让我们定义评分方法、模型评估方法和实际的搜索方法。之后,显示优化循环,其中包括一些特定于迭代的输出以便用户参考。

# Define scoring metric and model evaluation method

scoring = 'accuracy'

cv = ('stratified k-fold cross-validation',

StratifiedKFold(n_splits=10,

shuffle=True,

random_state=random_state))

# Define search

tpot = TPOTClassifier(cv=cv[1],

scoring=scoring,

verbosity=verbosity,

random_state=random_state,

n_jobs=n_jobs,

generations=generations,

population_size=population_size,

periodic_checkpoint_folder=checkpoint_folder)

# Pipeline optimization iterations

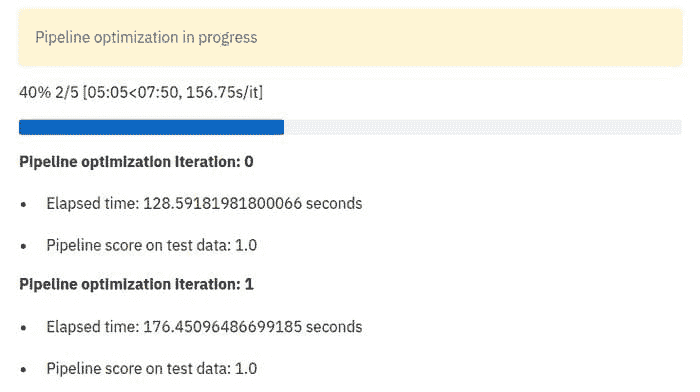

with st.spinner(text='Pipeline optimization in progress'):

for i in stqdm(range(search_iters)):

start_time = timeit.default_timer()

tpot.fit(X_train, y_train)

elapsed = timeit.default_timer() - start_time

score = tpot.score(X_test, y_test)

best_pipes.append(tpot.fitted_pipeline_)

st.write(f'\n__Pipeline optimization iteration: {i}__\n')

st.write(f'* Elapsed time: {elapsed} seconds')

st.write(f'* Pipeline score on test data: {score}')

tpot.export(f'{output_folder}/tpot_{dataset}_pipeline_{i}.py')

此时,你应该将 write()、spinner()、success() 和 Streamlit 快捷参考中的其他显示功能进行比较。

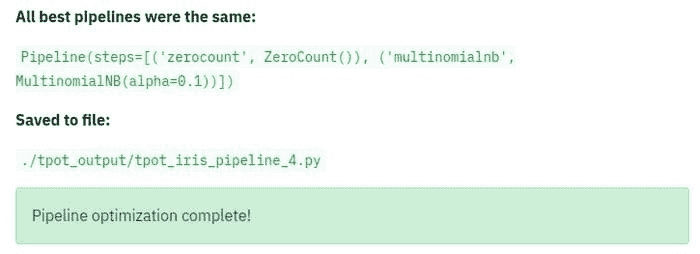

一旦运行,上述优化循环将输出类似以下内容的结果:

最后,我们需要评估我们的结果:

# check if pipelines are the same

result = True

first_pipe = str(best_pipes[0])

for pipe in best_pipes:

if first_pipe != str(pipe):

result = False

if (result):

st.write("\n__All best pipelines were the same:__\n")

st.write(best_pipes[0])

else:

st.write('\nBest pipelines:\n')

st.write(*best_pipes, sep='\n\n')

st.write('__Saved to file:__\n')

st.write(f'```{output_folder}/tpot_{dataset}_pipeline_{i}.py```py')

st.success("Pipeline optimization complete!")

...并输出最佳管道的代码(也保存到文件中):

# Output contents of best pipe file

with open (f'{output_folder}/tpot_{dataset}_pipeline_{i}.py', 'r') as best_file:

code = best_file.read()

st.write(f'```{code}```py')

这是完整的 Streamlit 应用程序代码(请注意,除了这个简短的 Python 脚本之外不需要其他任何东西来完成所有工作):

这就是如何快速构建由 Streamlit 和 TPOT 提供支持的 AutoML 管道优化沙箱,只需使用 Python 代码即可。请注意我们在成功实现这一目标时所需的网络编程技能的缺乏。

非常好。成功!

相关:

-

使用 TPOT 的机器学习管道优化

-

Python 中的简单 AutoML

-

使用 FLAML + Ray Tune 的快速 AutoML

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

1. Google 网络安全证书 - 快速进入网络安全职业生涯。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

更多相关主题

LinkedIn 供稿排名的多目标优化的自动调节

原文:

www.kdnuggets.com/2020/08/autotuning-multi-objective-optimization-linkedin-feed-ranking.html

评论

由 Marco Varela 和 Mavis Li,LinkedIn

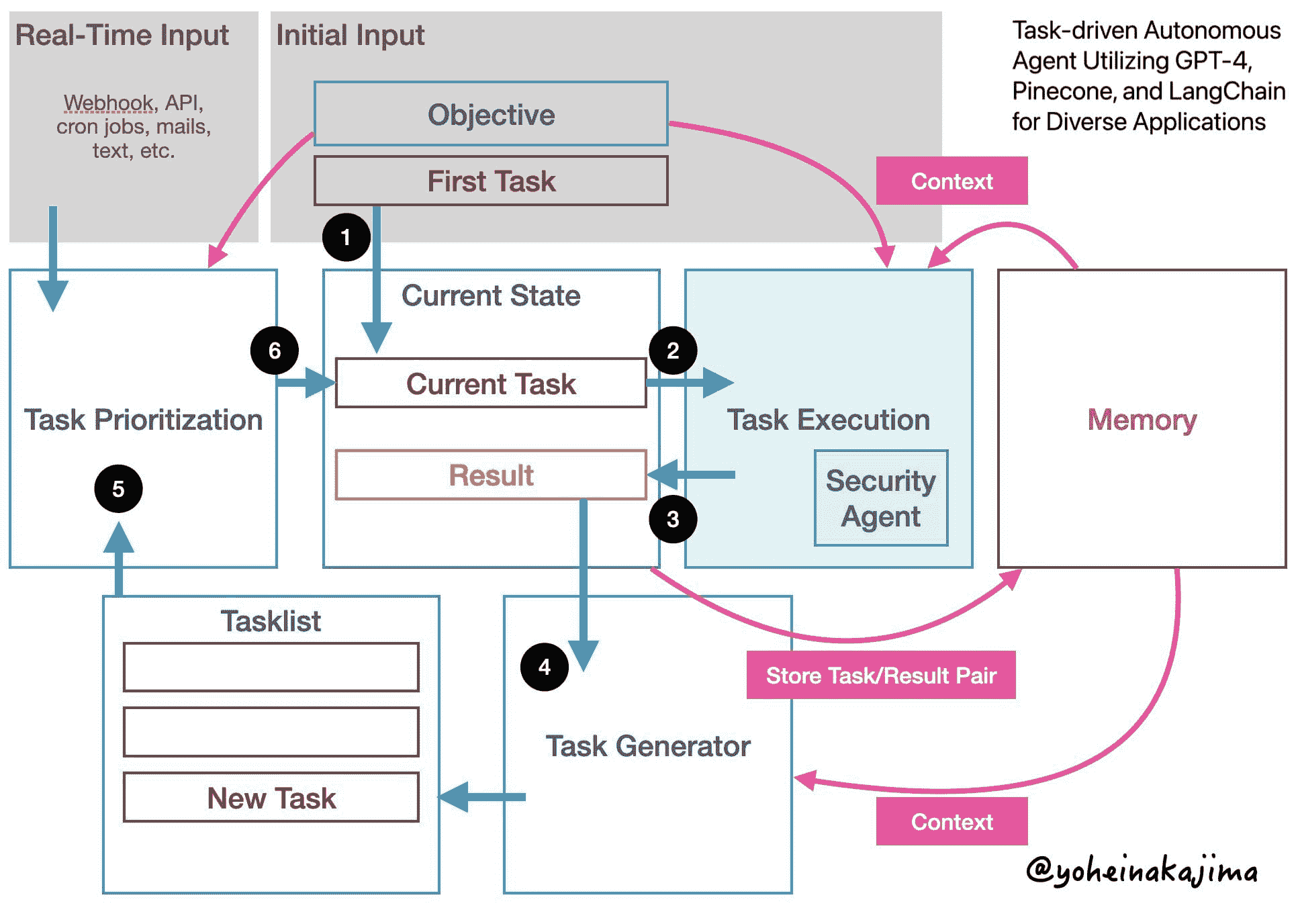

LinkedIn 主页上的供稿使命是使会员能够建立一个积极的专业社区,促进他们的职业发展。为了在供稿上提供最佳体验,我们利用人工智能(AI)向会员展示最相关的内容。这是具有挑战性的,因为我们需要从数百个选项中选择要展示的内容。这些内容类型可以包括其他会员分享的文章、职位推荐、课程推荐等,每种类型以不同的方式丰富我们的生态系统,这些共同的目标是实现 LinkedIn 的使命,即“连接全球专业人士,让他们更高效、更成功”。鉴于我们希望为会员提供多样化且丰富的体验,我们不能仅仅追求点击量的增加。

为了在内容上实现最佳的平衡以优化会员体验,我们采用了 多目标优化 方法。我们有不同的机器学习模型来优化不同的目标,比如反应、评论、行动的下游影响。然而,这些不同目标的平衡是通过机器学习工程师手动调整参数来实现的,这非常低效。

在这篇文章中,我们分享了如何开发一个自动化系统来调整我们机器学习模型中的一个主要参数,该模型推荐 LinkedIn 供稿中的内容,这只是 以社区为中心的架构 的一部分。我们的目标是实现成员指标的适当平衡,同时考虑到工程师的生产力和满足我们生态系统中的约束。有关 LinkedIn 供稿的更多背景信息,请参考 这篇博客文章。

在供稿上管理指标权衡的方法

为了应对我们生态系统中的复杂性和权衡,我们在优化一组度量标准的同时保持另一组标准不变。优化部分来自我们希望最大化会员的“贡献”。我们所说的“贡献”主要指点赞、评论和分享,这些行为更有可能在我们的生态系统中驱动对话,而不是简单的文章点击。贡献通过几种方式推动更多对话:分享会在 Feed 上创建新的帖子,评论使会员能够与帖子作者开始对话,点赞则在会员网络中生成下游更新。这些行为可以被视为“主动”的,因为会员通过为生态系统做出贡献而主动消费内容。

然而,我们也希望为那些不那么以对话为驱动的内容留下空间,这些内容可以被视为更“被动”的内容。特别是,Feed 上的不频繁访客更可能参与被动消费。基于这些原因,我们决定保持“被动”消费不变。

将度量权衡转化为评分函数

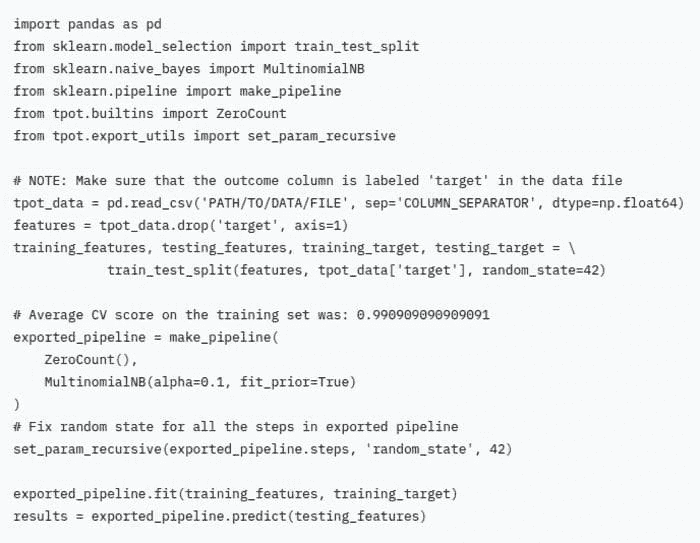

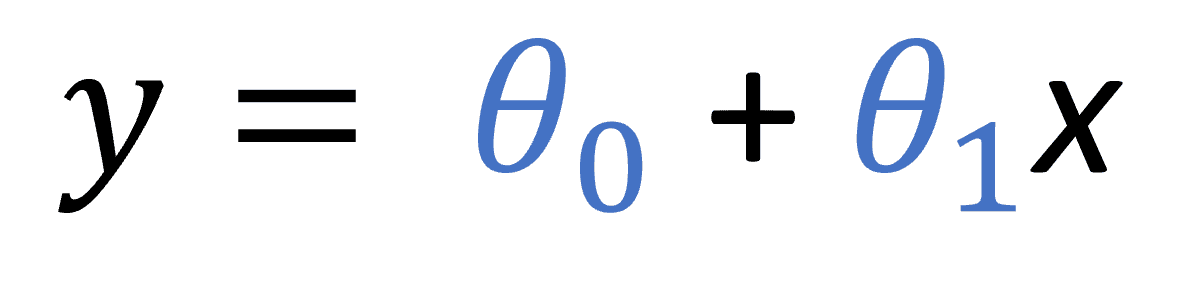

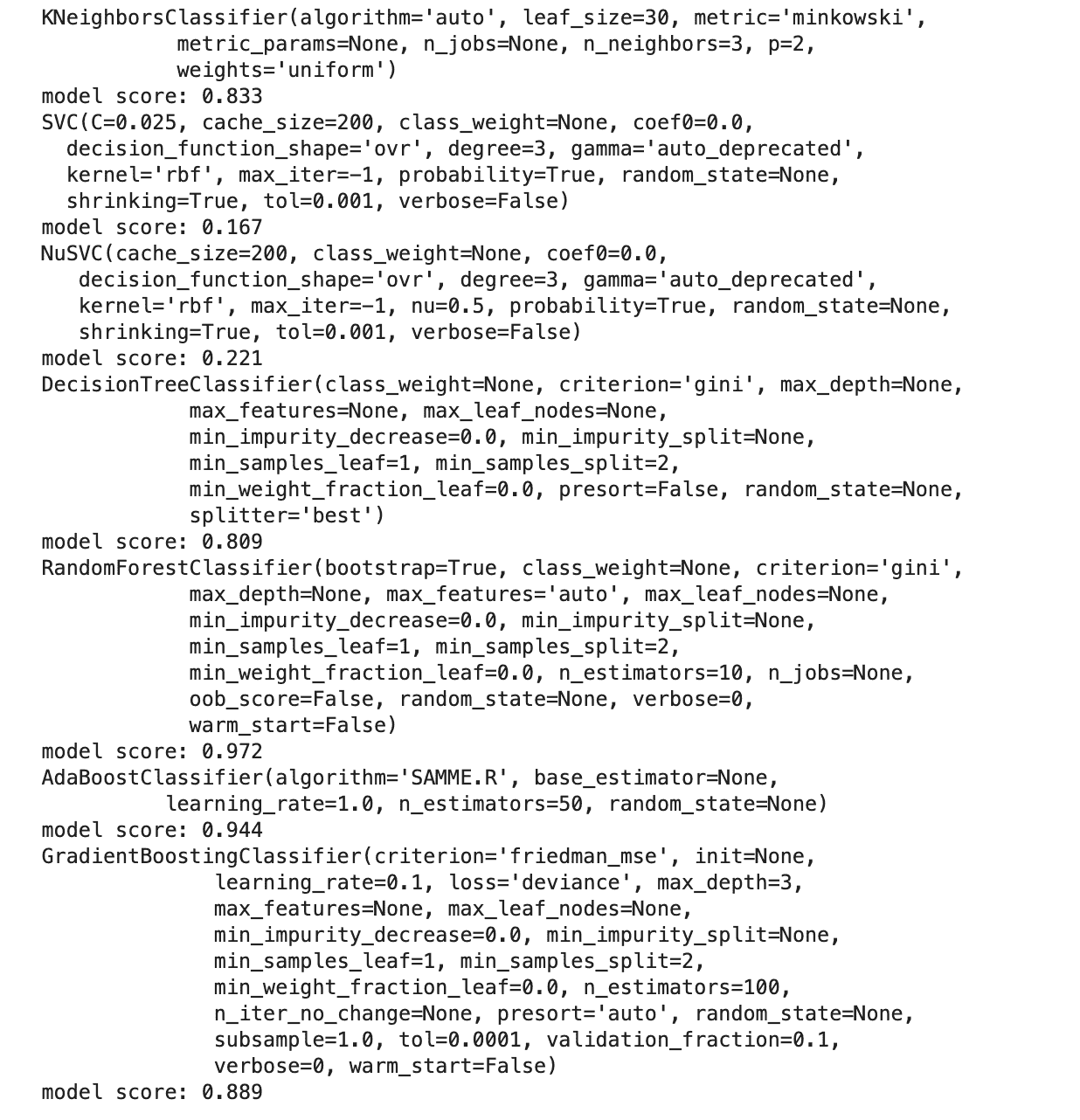

鉴于我们需要在 LinkedIn Feed 上管理内容和目标的多样性,我们决定采用 多目标优化 方法对我们的 Feed 内容进行排序。从高层次来看(略过许多细节),我们用以下方程粗略地对每个更新进行评分:

你可以将每个 P(x) 视为模型对特定目标的概率评分。我们使用一种称为点击权重(????)的杠杆来选择更偏向被动消费的内容(例如,可能会驱动点击的工作或文章推荐)与更偏向社区驱动的内容(例如,可能会鼓励评论的帖子)。不同类型的内容在某些使用场景下表现更佳,因此在被动消费和主动消费之间存在权衡。即使在特定类型的内容中,也可能有鼓励更多被动行为而非主动行为的条目。例如,热门文章可能只会鼓励点击,而来自密切联系人的文章可能会引发讨论。

为什么我们需要不断管理权衡

既然我们已经提供了足够的关于 LinkedIn Feed 的背景信息,我们想分享一些我们在选择合适的 ????(点击权重)以平衡被动消费(即点击)与主动消费(即点赞、评论、分享)过程中的经历。在接下来的内容中,我们将把点赞、评论和分享的动作集合称为“贡献”。

???? 参数决定了主动和被动消费之间的平衡,不能保持静态,原因有几个。我们不断改进我们的机器学习模型,以提供最佳的会员体验,这可能会影响两个指标之间的平衡。例如,我们可能会加入新功能或尝试新的建模方法。这会以多种方式影响平衡。一种方式是某个特定的特征变化(例如,会员对文章帖子的偏好)或模型变化可能在推荐主动消费内容时比被动消费更有效,反之亦然。另一种方式是我们的训练过程中存在随机成分,这可能会在重新训练模型后改变最佳权重。

在多目标环境中维持平衡的挑战

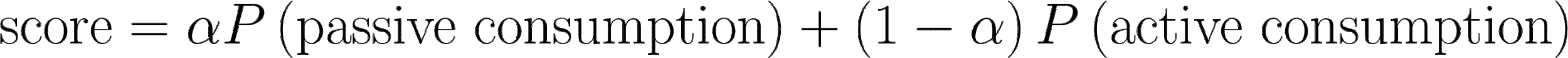

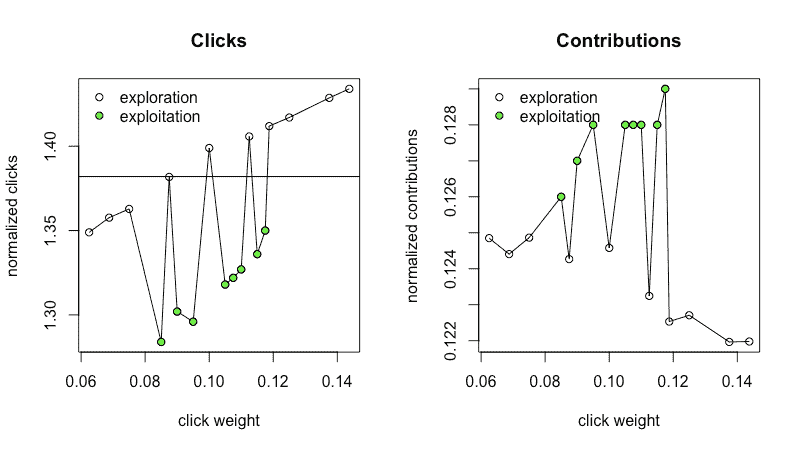

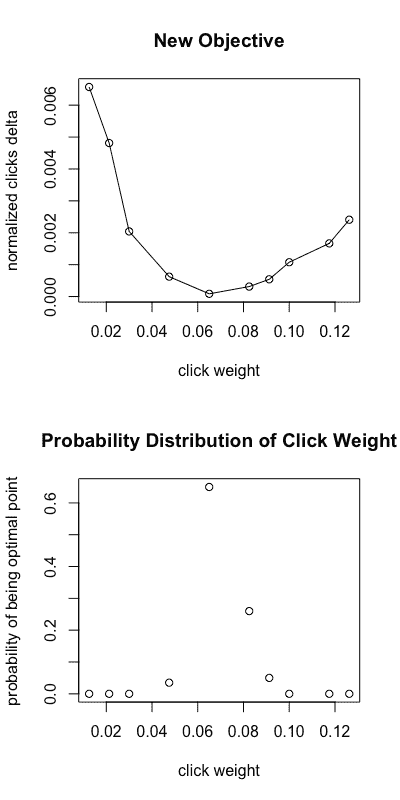

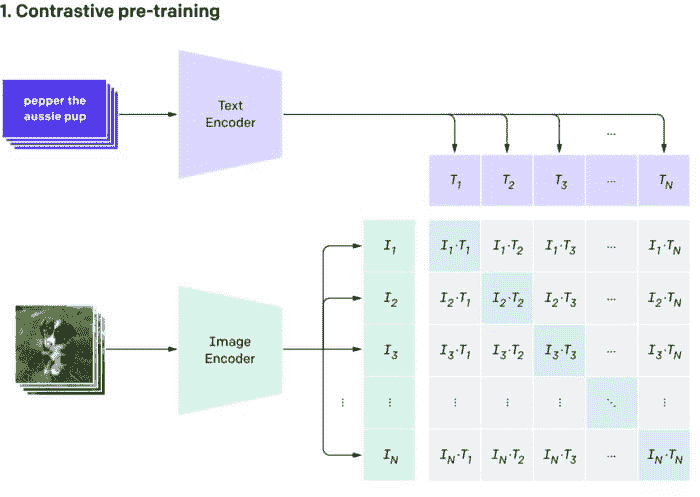

我们最初管理正确平衡的方法是基于历史数据建立离线模拟器,运行我们的模型,然后获取不同 ???? 值的模拟指标。这使我们能够通过查看如下输出图表来感知正确的 ????, 其中每个点表示一个不同的 ????:

图 1:模拟结果(点击率和贡献率的实际值被排除,因为它们与此帖不相关)。对照组是我们会员的标准体验,而处理组是正在评估的标准体验的变体。

然而,这种方法证明还不够。由于几个原因,我们的模拟器方法在预测在线世界中的效果时固有的存在局限性:

-

LinkedIn 生态系统随时间变化。也许会引入影响会员行为的 UI 变化,或者我们可能会向信息流中引入之前没有的新内容,如投票。这些变化很难在离线环境中复制,因为模拟器仅限于历史数据,可能无法完全反映当前的生态系统状态。

-

会员可能采取的行动顺序可能会根据显示的内容而有所不同。例如,如果他们首先看到一篇他们非常喜欢的文章,他们可能更有可能继续与其他更新进行互动。

-

生态系统中有一些 强化学习 组件,在模拟器环境中特别难以体现。

结果,机器学习工程师不得不在线上发布多个版本的模型以测试不同的 ???? 值,这带来了两个主要痛点。首先,对于工程师来说,创建具有不同 ???? 值的模型变体变得耗时,特别是因为这一过程涉及反复试验。其次,由于我们依赖 A/B 实验来评估每个变体,我们会耗尽在线流量,无法进行我们希望进行的实验。

选择权衡的新方法:在线自适应调优

鉴于手动调优????在线上存在的困难,我们决定自动化这个过程,以减少人工工程工作和在线流量负担。我们确定了几个要求,以便我们的团队能够轻松利用该工具,并在尊重在线流量需求的情况下允许同时进行足够多的实验:

-

该工具需要易于使用,因为我们试图减少工程师的人工工作,并且它应该能够被数十名机器学习工程师轻松采用。

-

该工具只需占用总流量的一小部分。例如,如果工具占用 50% 的流量,那就没有用处。

-

该工具应该在相对较短的时间内得出????的最佳值。例如,如果该工具需要一个月才能找到最佳权重,那就没有用处。

需求 2 和 3 是必要的,以确保我们可以最大化同时进行的实验数量。

在线自动调优的实施:初步策略概述

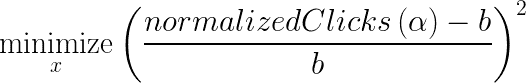

考虑到这些要求,我们决定在 LinkedIn 中利用TALOS(调优所有大规模在线系统)库,该库旨在在线环境中学习参数。我们的目标是自动调整点击权重(????),以最大化贡献的同时保持被动消费水平。正式地,我们的问题可以写成如下:

,

,

其中b是等于基线模型的归一化点击数的常数,????是点击权重。我们根据 Feed 加载的次数以及相关的 alpha(即贡献/加载的 Feed)对贡献和点击进行了归一化。

我们解决这个问题的初步尝试是使用探索-利用策略与 TALOS。探索阶段将成员分配到不同的点击权重桶中,并收集相关指标(即贡献,归一化点击)几天。在利用阶段,算法将聚焦于一个点击权重范围内,收集该范围内更接近解决方案的额外数据。

在线自动调优的实施:指标理解

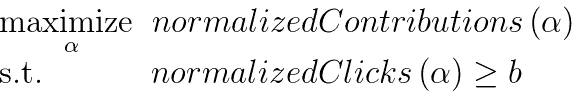

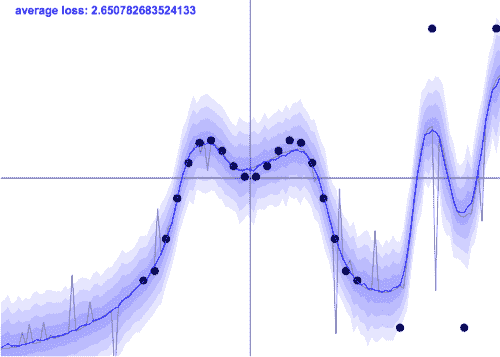

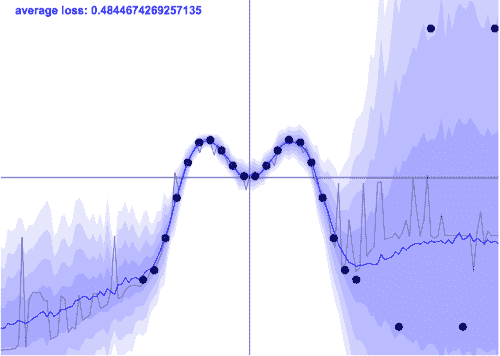

在我们实施解决方案之前,首先集中精力理解我们的指标。这涉及确定探索的网格点和搜索范围。我们根据历史模型迭代中手动选择的点击权重 [0.0, 0.005] 选择了探索的搜索范围。选择网格点数存在权衡。增加点数可以为点击权重提供更多的细粒度,但也使每个点的流量减少,从而增加了指标中的噪声。当我们用 31 个网格点收集指标时,我们在归一化贡献指标中看到主要是噪声,而在归一化点击指标中看到上升趋势。这在图 2a 和 2b 中得到了说明,这些图显示了对桌面(非应用程序)用户的实验结果。

图 2a, 2b: 小搜索范围,31 个点

为了改善这种情况,我们做了两件事:

-

将点数从 31 减少到 15,以在每个点击权重下收集更多数据。

-

扩大了我们的搜索范围,以便更清楚地看到贡献与点击权重之间的关系。

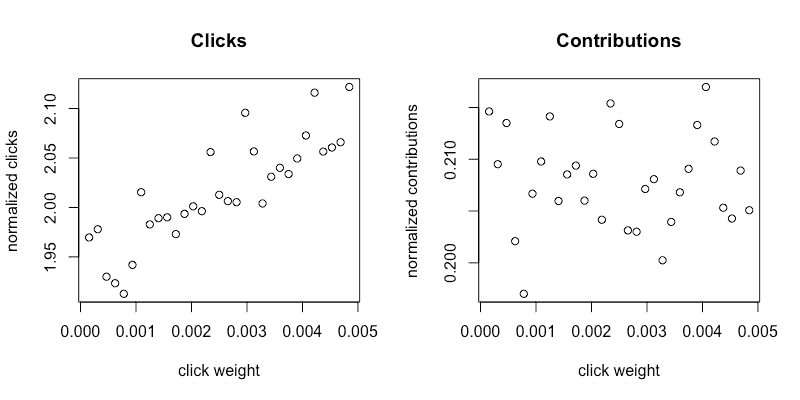

从图 3a 和 3b 中可以看到,经过更改后,点击和贡献都有明显的趋势。

图 3a, 3b: 大搜索范围,15 个点

图 3a 和 3b 是减少点数并增加搜索范围的结果。

在线自动调优的实施:初步策略经验

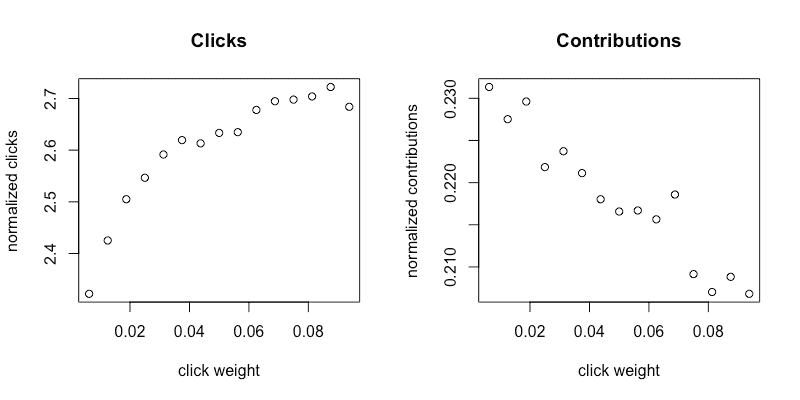

一旦确定了可靠捕捉指标的正确参数,我们进行了利用阶段的实验,如下图所示。由于这一部分示例了不同平台(移动设备)上的不同模型,因此搜索范围不同。

图 4a, 4b: 探索结果

图 4a 和 4b 显示了在探索阶段收集的指标。我们可以在归一化点击指标(4a)中看到明显的正向趋势,而在归一化贡献指标(4b)中看到下降但嘈杂的趋势。黑色水平线表示常数 b,即我们控制模型的归一化点击量。

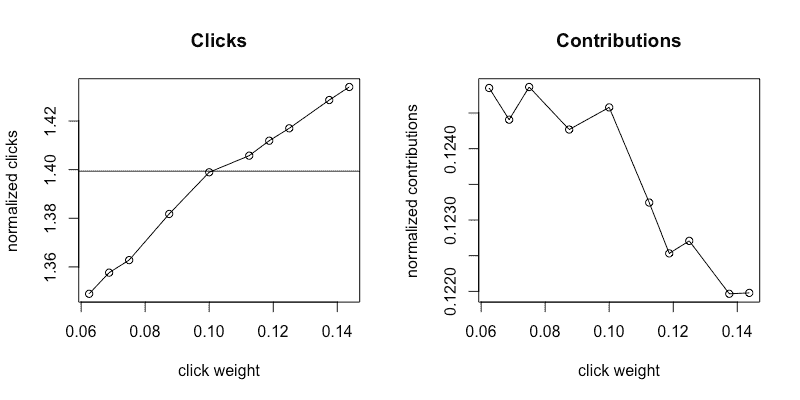

图 5a, 5b: 探索和利用结果

图 5a 和 5b 显示了在探索阶段之后和利用阶段的指标汇总。白色点来自探索阶段(数据与图 4a 和 4b 相同)。探索阶段之后,算法决定解决方案位于缩小的搜索范围内,并选择了新的点(绿色点)以收集利用阶段的指标。

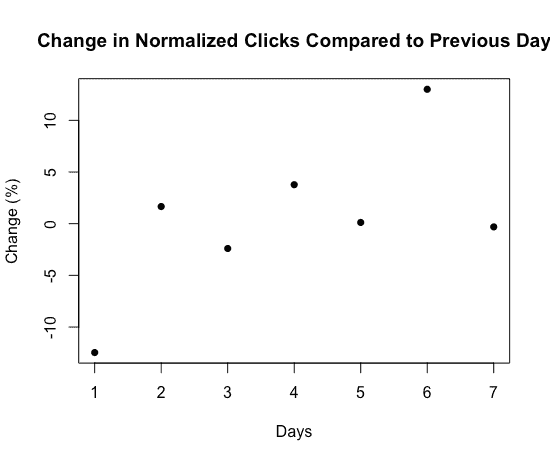

绿色的利用点给我们的指标增加了过多的噪音,使得实际可行的点击权重变得不清晰。这很让人惊讶,因此我们更仔细地查看了我们的指标。我们首先查看了从前一天起标准化点击的变化。如图 6 所示,在某些日子中,变化幅度可以达到 12%。

图 6:标准化点击的日间变化

这表明我们的指标存在显著的日间变化,并解释了为什么我们的利用点与探索相比具有如此不同的趋势,这扰乱了算法,因为我们的指标可能受到点击权重和一天中的时间的类似影响。

LinkedIn 应用的使用在每周的不同日期变化显著(例如,专业人士在星期五和星期三的使用模式不同),因此看到这种变异性并不完全令人惊讶。

这尤其具有挑战性,因为我们的工具期望探索和利用的数据趋势相似;然而,一旦我们将探索和利用数据放在一起(如工具要求的那样),趋势就丢失了。由于这些原因,我们决定跳过利用阶段,以在我们工作所限的时间和提升约束下保持合理的趋势。

在线自调节的实施:优化问题的修订

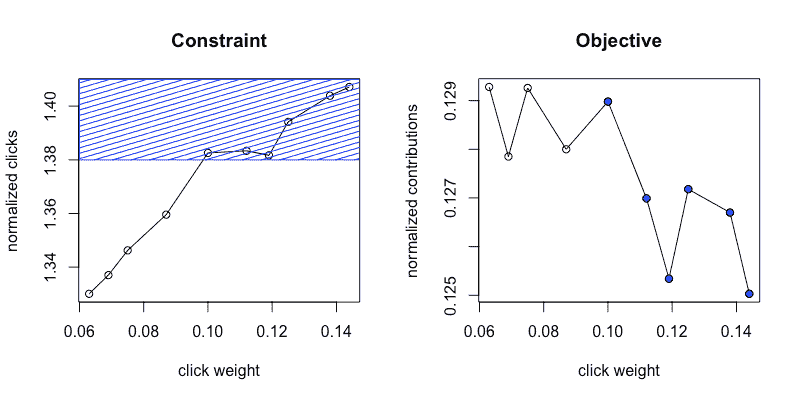

我们随后专注于仅对探索数据应用优化问题,如下所示。我们最初收集了我们在项目开始时设定的两倍在线流量需求的数据(即需求 2),以更好地理解我们的指标。图 7a 和 7b 总结了收集的数据。图 7b 中的蓝色点对应于图 7a 中的蓝色区域,即我们的约束定义的可行区域。

图 7a,7b:带约束的可行区域

我们最大的挑战是弄清楚如何处理贡献指标的噪音问题。正如我们从公共贡献的图表中看到的,即使在所需的提升百分比的两倍下,贡献指标仍然非常嘈杂。由于我们 A/B 实验的流量有限,我们无法信任贡献(????)指标。

为了应对这一挑战,我们更仔细地查看了我们指标的模式。由于贡献指标是????的递减函数,而我们的约束是????的递增函数,因此问题的解决方案在于活动约束集,即 normalizedClicks(????) = b。这是有用的,因为 normalizedClicks(????)是一个更稳定的指标。因此,我们可以将原始问题重新表述为基于原始约束的最小化问题,其中我们仅尝试保持标准化点击与基线相同,避免依赖 normalizedContribuons 指标。

重新表述的问题涉及在没有约束的情况下最小化 normalizedClicksDelta。

在线自动调优的实施:最终策略和结果

在图 6a 中,我们观察了在 5%流量下,经过 2 天的点击权重范围内的新指标。图 6b 显示了点击权重 ????(在 x 轴上显示)成为优化问题中最优点的概率。这个概率是通过首先从后验高斯过程重复抽样函数,然后确定优化(最大化或最小化)这些抽样函数的点来计算的。获得的点的经验分布给出了图 6b。

图 8a, 8b:使用新目标的收敛情况

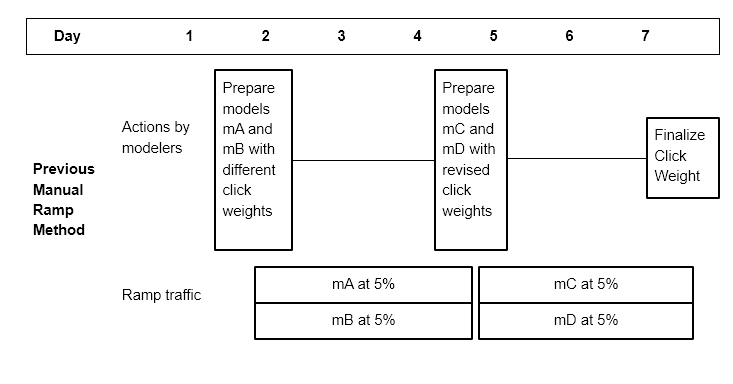

以前,工程师会使用不同的点击权重来测试多个模型,以尝试找到一个调整得当的点击权重模型。如果第一组点击权重中没有理想的点击权重候选项,这可能涉及到几天后重新启动不同的点击权重。实际模型的一个示例时间表可能涉及在 5%流量下收集 4 种不同的点击权重,经过 2 天后选择一个“最优”点击权重。图 9 是引入点击自动调优之前的调试计划示例。图 10 是使用自动调优工具的新调试计划示例。

图 9:自动调优工具之前的调试过程

图 10:自动调优工具后的调试过程

旧的调试时间表可能需要在 5 天内完成 10%流量(4 天收集指标,1 天进行流量变化)。现在,通过自动选择参数 ???? 的过程,我们可以将这个部分的过程减少到在 5%流量下的 2 天。在模型调试到 5%后,工程师可以使用脚本启动点击自动调优,并在 2 天内提供一个单一的收敛点击权重。在这两天内,我们会考虑 10 种不同的点击权重,并选择一个可能位于这些点之间的解决方案。这种新工具通过以下三个方面的成本降低提高了我们的效率:

-

调试时长

-

调试量

-

工程师的人工努力

此外,新工具通过在选择 ???? 时更加精准,帮助我们找到更优的点击权重,相比于以前的人工努力。

经验教训

在这段旅程中,我们学到了一些经验教训。首先,我们发现,在这个特定的优化问题中,将问题公式化为尽可能简单是有益的。在花时间理解我们想要目标的指标以及它们如何与我们特定的机器学习模型相关之后,我们意识到我们可以将问题定义从一个带约束的最大化问题转变为一个最小化问题。这使我们能够只处理在较低 ramp 百分比下更可靠的约束指标,同时仍然满足我们的总体目标,即在模型之间保持被动消费恒定,同时减少工程师所需的手动工作量和在线流量需求。

此外,重要的是要意识到解决方案需要解决的约束条件。在我们的案例中,我们只能允许工具使用有限的 ramp 体积,并在有限的时间内最大化同时进行的实验数量。一旦约束条件定义清晰,就更容易识别适合的解决方案。在我们的案例中,所处理的指标存在显著的日间波动,因此在我们的约束下,我们发现探索-开发算法并不适用,因为这些算法需要更长时间和更大的 ramp 来适应我们的难题。

感谢 Kinjal Basu、Viral Gupta、Yunbo Ouyang 构建参数调整库及提供建议,以及我们的经理 Ying Xuan 和 Zheng Li 的支持。

Marco Varela是 Linkedin 的高级软件工程师,他是 Feed AI 团队的一员,专注于通过自动化和特征新鲜度提高 Feed 更新的排名。

Mavis Li是 Linkedin Feed AI 团队的一个软件工程师,负责 Feed 的个性化和排名。她参与了多个项目,包括将下游模型作为目标、将网络外的群组更新整合到 Feed 中,以及点击权重自动调整。

相关:

-

查看这份全面的模型优化技术指南。

-

自动化机器学习:免费的电子书

-

数据科学家的灭亡 – AutoML 会取代他们吗?

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

2. 谷歌数据分析专业证书 - 提升你的数据分析能力

3. Google IT 支持专业证书 - 支持您的组织的 IT

3. Google IT 支持专业证书 - 支持您的组织的 IT

更多相关内容

如何避免分析兔子洞:避免调查循环及其陷阱

原文:

www.kdnuggets.com/2017/04/avoid-analytic-rabbit-holes-investigation-loops.html

评论

评论

“如果我们添加这些变量会怎样?..”是一个致命的问题类型,可能会毁掉你的分析项目。虽然好奇心是数据科学家的最佳朋友,但随之而来的诅咒也是不可避免的——有些人称之为分析瘫痪,有些人则称之为过度分析,但我称这些情况为“分析兔子洞”。在你开始任何数据科学项目时——无论是深入的统计研究、机器学习模型,还是简单的业务分析——总会涉及某些步骤。有些来源将它们分解得更细致,有些则更为概括,但从实际业务的角度来看,这种观点最为合理。

我们的前三名课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

1. 谷歌网络安全证书 - 快速进入网络安全职业的快车道。

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT

过程如下:数据科学家定义一个假设,然后探索数据,获得帮助解释假设的数据洞察。完成这一步后,循环开始了——新的信息使得假设得到改进,进入“更深入挖掘”的阶段,同时重复数据探索、洞察生成和……再次重新定义假设。这里就是循环的开始,重要的是从一开始就要意识到。如果没有明确一件事——一个有支持的决策——就会陷入分析兔子洞。

如果决定未被明确或不是分析调查的主要目标——项目就会陷入“分析兔子洞”。为什么?因为当数据科学家开始关注假设而不是决策时,就会开始过度分析。虽然这两者看起来非常相似,但实际上它们之间的差异对数据科学项目的成功与否至关重要。我将描述这两种方法以及它们如何导致成功或注定失败。

以假设为中心。 在数据探索的过程中,假设不断被修正,新的见解不断被发现。这个过程的诅咒在于,由于目标是找到完美的答案或假设的解决方案,数据科学家会陷入许多陷阱,比如发现不相关但相关的变量之间的虚假相关性。最终,分析和切分数据的广度开始产生副作用——假设被拆分为子段,每个子段都有一系列的数据点、假设和相互冲突的结论。这个项目的典型结局是一个快乐的数据科学家向一个非技术团队展示这些巨大的发现,而这个团队比数据科学家开始解释第二个要点的速度更快地迷失在细节中。一个能够击垮这一努力的问题是——“我们能对此做点什么吗?”就是这样。几周的工作和一个问题就会使整个努力偏离轨道。

以决策为中心。 探索的重点是寻找影响和改善决策的方法,并尽快测试它是否能有所变化。然后,只有在那时,假设才能被修正。这并没有结束分析的循环,但它确保了数据科学家的重点是发现可以改善基本决策影响的见解。在这种情况下,重点是项目的输出如何影响环境,数据科学家和企业都可以从环境对数据优化行动的响应中学习。没有实际干预的假设测试是分析兔子洞的完美例子。

那又怎样?

尽管这听起来可能非常琐碎,但数据科学家在以假设为中心的项目上浪费的时间非常多。如果这种以假设为中心的理念得不到挑战,可能会毁掉他们的职业生涯,同时也会使其他人对数据科学部门失去信任。相信我——每当你被交付一个非常酷且有趣的假设时,唤醒你内心的极客并陷入分析的兔子洞陷阱是非常诱人的。

数据科学家内心的直觉告诉他们,工作的主要任务是回答复杂问题并获得深刻见解。而实际上,这一切都关乎解决问题——解决问题的唯一方法就是付诸行动。作为数据科学家的目标是通过可操作的数据驱动的建议来支持艰难而复杂的决策。我们是驱动行动的终极内部顾问。有些见解带来的行动总比有全部见解但没有行动要好。因此,永远不要忘记问自己一个问题——“这项分析支持的决策是什么?”这可能会挽救项目,甚至可能挽救你作为数据科学家的职业生涯。

简介: Karolis Urbonas,是亚马逊数据科学部门负责人,是一位充满活力的数据高管,拥有建立高绩效数据科学团队和交付战略分析项目的丰富经验。他在cyborgus.com上博客。

相关:

-

警惕两种数据模糊化策略

-

什么使数据科学家出色?

-

使用 CRISP-DM 时的四个问题及其解决方法

了解更多此主题

避免这五种让你看起来像数据新手的行为

原文:

www.kdnuggets.com/2021/10/avoid-five-behaviors-data-novice.html

评论

由 Tessa Xie,Cruise 高级数据科学家,Medium 撰稿人。

我们的前三大课程推荐

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

1. Google 网络安全证书 - 快速进入网络安全职业的快车道。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在组织的 IT

3. Google IT 支持专业证书 - 支持你所在组织的 IT

照片由 Isaiah Rustad 提供,来自 Unsplash。

随着每天收集的数据越来越多,几乎每家公司都以做出数据驱动的决策为荣,数据已经触手可及。数据科学正变得越来越热门。你之所以阅读这篇文章,可能是因为你对数据充满热情,想在这个领域获得专业知识。如今有许多训练营和在线课程,每个人在几个月甚至几周内都可以感到 像 一个数据专家;但要成为真正有用、受欢迎且可信的“数据伙伴”,不仅仅是对 SQL 和 Python 以及基本统计知识的熟悉。

新手和真正懂得如何处理数据并成为有用数据伙伴的人之间存在明显差异。我观察到一些人表现出的行为无异于在空中挥舞双手并大喊:“我对这完全陌生,我不知道自己在做什么……”我自己在刚开始做数据科学家时也做过大部分这些事情。这些行为会迅速降低你作为数据伙伴的信誉,让人怀疑你对主题的理解。所以,希望我能提供一些避免做这些事的建议,以及应该做些什么,以免你成为那种数据新手。

#1 过度解读结果,试图从虚无中编造故事。

“我们已经推断出 X 和 Y 之间有正相关……基于 30 个数据点,我们相信这是因为……”每当我听到类似上述的陈述时,我都会略感不安。在趋势分析和生成洞察时,样本量始终是首要考虑的因素。除非是一个具有代表性的客户群体的焦点小组(我甚至对焦点小组的调查结果存有疑虑,但那是另一个话题),否则 30 个数据点通常不会给你任何可靠的洞察。

有没有比从极小的数据集中推测“趋势”更尴尬的事情?有的,就是为这些“趋势”出现的原因提出理论。我见过人们提出各种荒谬的理论来解释为什么来自微小数据集的结果是“违反直觉”的;当真正的解释很简单……那就是噪声时,他们会失去可信度以及大部分听众。

试试这个: 与其在样本量小的时候急于进行趋势分析,不如专注于建立结构,以便未来能收集到更多高质量的数据,从而进行这些分析。如果你真的希望从小样本中获得一些洞察,请注明样本量的不足,并在报告的指标中添加置信区间。

#2 未在使用数据/查询之前进行质量检查(QC)。

没有完美的数据集;任何告诉你其他情况的人要么在撒谎,要么是无知。因此,作为数据专家,你应该比仅凭数据质量表面现象更了解。你查询和分析的每一份数据都需要经过质量检查——确保表格实际去重,检查时间戳是否在你认为的时区等等。在使用数据之前不进行质量检查可能会导致意外结果和误导性的洞察,并使人们对你处理复杂数据的能力产生怀疑。

试试这个: 制定一个质量检查框架(即你执行的测试列表),每次处理新数据集时都要遵循。例如,检查(意外的)重复项;如果你预计数据集中每个订单只有一行,写一个快速查询按订单 ID 分组并统计行数——你会惊讶于有多少“订单级”表在某些订单 ID 下有 1,000 条记录。始终,始终,始终检查你的工作,并与利益相关者和主题专家双重检查。

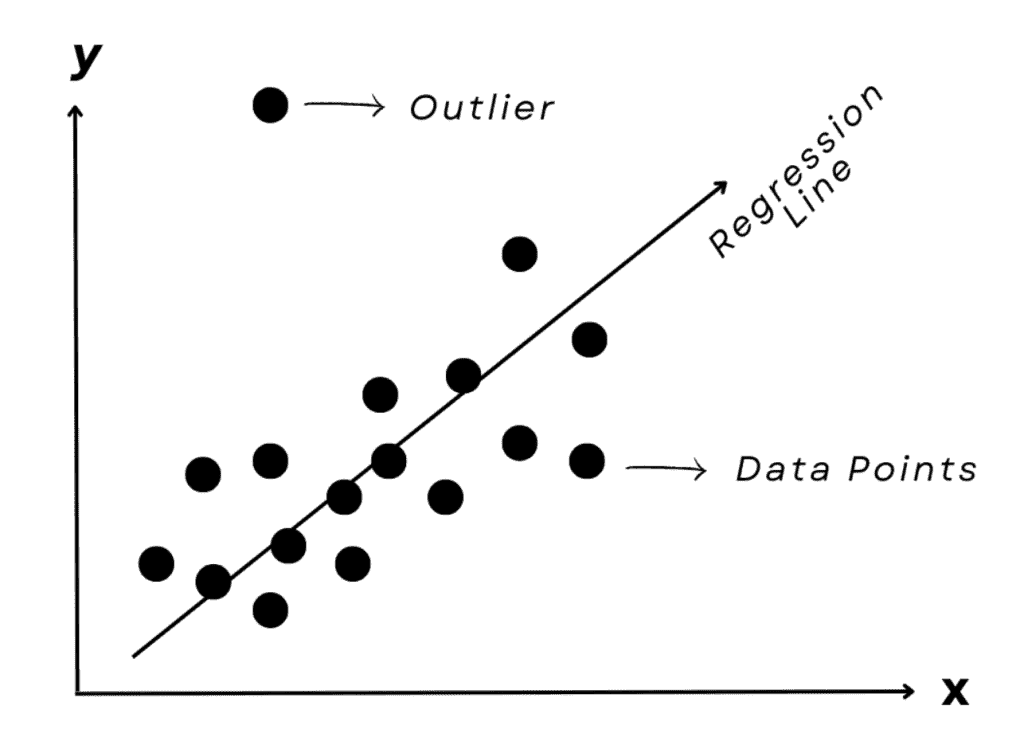

#3. 过度工程化。

我仍然记得当我学到像随机森林或 XGBoost 这样的复杂模型后的兴奋;当你有了锤子,尤其是一个闪亮的酷锤子时,所有东西都像钉子。但实际上,除非你是机器学习工程师,否则你在日常数据工作中很少需要 10 层神经网络。使用复杂的机器学习模型,而简单的线性回归足矣,不仅效率低下,还适得其反。正如我在关于data science lessons I learned from working at McKinsey的文章中提到的,作为行业中的数据科学家,产生商业影响是首要目标,而不是炫耀你掌握了多少机器学习知识。

过度工程化模型和分析是一种让自己成为人们不愿意合作的、效果不佳的数据合作伙伴的可靠方法。

试试这个方法:从简单开始,只有在确实必要时才使用更复杂的方法。对你在分析中使用的方法要做出非常明确的决策,并应用 80/20 原则,以避免那些带来边际效益的、不必要的努力。

#4. 使用流行词汇。

这种情况在刚进入数据领域的人中很常见。类似于因为对新建模技能的兴奋而倾向于过度工程化,很多新的数据从业者喜欢在可能的情况下使用他们学到的所有新概念和新词汇。在沟通时,我们往往用复杂性来弥补对事物的理解不足——一个人谈论机器学习和分析时使用的流行词汇越多,通常他/她的分析知识就越少。一个经验丰富的数据从业者应该能够用简单的英语解释方法论和分析细节;如果某人的数据工作解释难以理解,就像阅读维基百科页面一样,很可能是因为他们也是刚从维基百科上读到的。

试试这个方法:当学习一个新的分析概念时,真正努力理解到你能够用简单的英语轻松地向不懂数据科学的朋友解释它。这样的理解水平也将帮助你决定何时应用复杂的高级方法,何时使用传统的线性回归。

#5. 忽视利益相关者在创建数据产品时的需求。

我偶尔遇到一些新的数据从业者,他们不仅仅遭受上述症状 3 和 4 的困扰,还过度热衷于在工作中创建没人欣赏的“数据宠物项目”。别误会,我认为所有的数据热情都应该受到鼓励,宠物项目对技能发展有帮助……只是在你的日常工作中,商业对你使用数据产品来推动影响有很高的期望。

数据产品(例如,仪表盘)就像任何其他产品一样,其设计的首要规则应该是以用户为中心。它们应该基于需求而生……而不是仅仅基于激情。

试试这个方法:在构建任何数据产品之前,与利益相关者沟通。了解当前阶段业务的需求:如果是初创公司,我敢打赌你的利益相关者不会过于关心你构建的数据可视化的格式和颜色,而是更关注可视化背后的数据准确性及其洞察。同样,真正了解受众和使用场景;例如,如果数据产品是打算由非技术受众定期使用的,你可能会花更多时间在打磨和简化用户界面上。

发展你自己的副项目,也许有一天会派上用场;只要不让它们妨碍你成为一个高效且受欢迎的数据合作伙伴。

关键要点

-

不要把事情搞得过于复杂或过度工程化;这不会让你显得聪明,反而会让你看起来不知道做事的最有效方式。

-

确保对数据进行质量检查并审查你的见解,并在数据质量或样本大小存在疑虑时总是要说明发现结果的局限性。

-

在创建数据产品时要考虑利益相关者的需求。

原文。经授权转载。

简介:Tessa Xie 是一名从事 AV 行业的数据科学家,曾在麦肯锡工作,且是三次顶级中等作家。Tessa 白天是数据领域的先锋,晚上是作家,周末则是画家、潜水员,还有更多身份。

相关:

更多相关话题

避免时间序列预测中的这些错误

原文:

www.kdnuggets.com/2021/12/avoid-mistakes-time-series-forecasting.html

评论

作者:Roman Orac,高级数据科学家

图片来源:Photoholgic 在 Unsplash

时间序列预测是数据科学的一个子领域,涉及预测 COVID 的传播、股票价格、每日电力消费……我们可以继续列举下去。

数据科学是一个广泛的研究领域,几乎没有“全才”

数据科学领域是一个广泛的研究领域。许多数据科学家在整个职业生涯中处理的是非顺序数据(经典分类和回归机器学习),他们在职业生涯中从未训练过时间序列预测模型。

这是可以预期的,因为数据科学领域的快速发展。跟上所有子领域变得越来越困难。

计划转入时间序列领域的数据科学家可以做好迎接有趣挑战的准备,因为处理这种数据需要不同的专业方法。

在本文中,我们将深入探讨几个容易陷入的常见时间序列预测陷阱。我基于金融股票数据进行示例,但这些方法也可以应用于其他时间序列数据。

通过阅读本文,你将学到:

-

如何使用 pandas 下载金融时间序列数据

-

如何在时间序列信号中找到峰值和谷值

-

什么是(以及如何使用)自相关图

-

如何检查时间序列是否具有统计显著信号

全才,什么都懂,精通的却没有

我们只需要收集数据

图片来源:Hans Eiskonen 在 Unsplash

一个谬误(以及从一开始就是注定要失败的项目)是,当软件工程师认为他们可以简单地收集股票市场数据,然后将其放入深度神经网络中找到有利可图的模式时。

深度神经网络会自动找到有利可图的模式,对吗?

别误会我,拥有数据是有用的,但最难的部分在于建模。

有数据服务网站,如 EOD Historical Data,提供各种金融数据,并提供免费计划。首先识别有利可图的模式更有意义,因为你可以通过单个 pandas 命令下载历史数据。

EOD Historical Data 提供各种金融数据,并有一个免费的计划(作者制作的截图)

下载数据的 pandas 命令是什么?

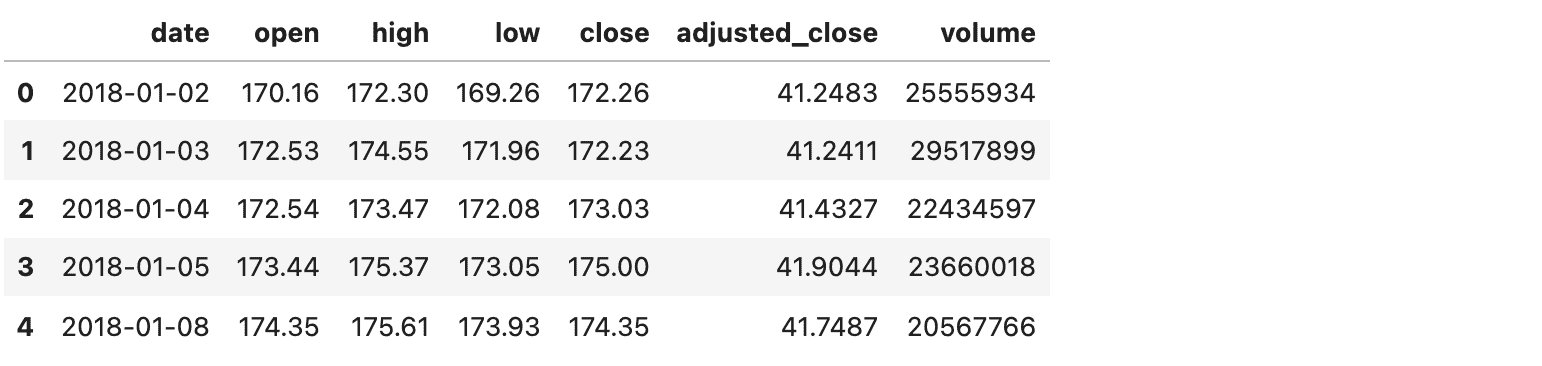

让我们看看下面的例子,我从 2018 年 1 月 1 日起下载了苹果股票的每日价格:

import pandas as pdstock = "AAPL.US"

from_date = "2018-01-01"

to_date = "2021-10-29"

period = "d"eon_url = f"[`eodhistoricaldata.com/api/eod/{stock}?api_token=OeAFFmMliFG5orCUuwAKQ8l4WWFQ67YX&from={from_date}&to={to_date}&period={period}&fmt=json`](https://eodhistoricaldata.com/api/eod/%7Bstock%7D?api_token=OeAFFmMliFG5orCUuwAKQ8l4WWFQ67YX&from={from_date}&to={to_date}&period={period}&fmt=json)"df = pd.read_json(eon_url)

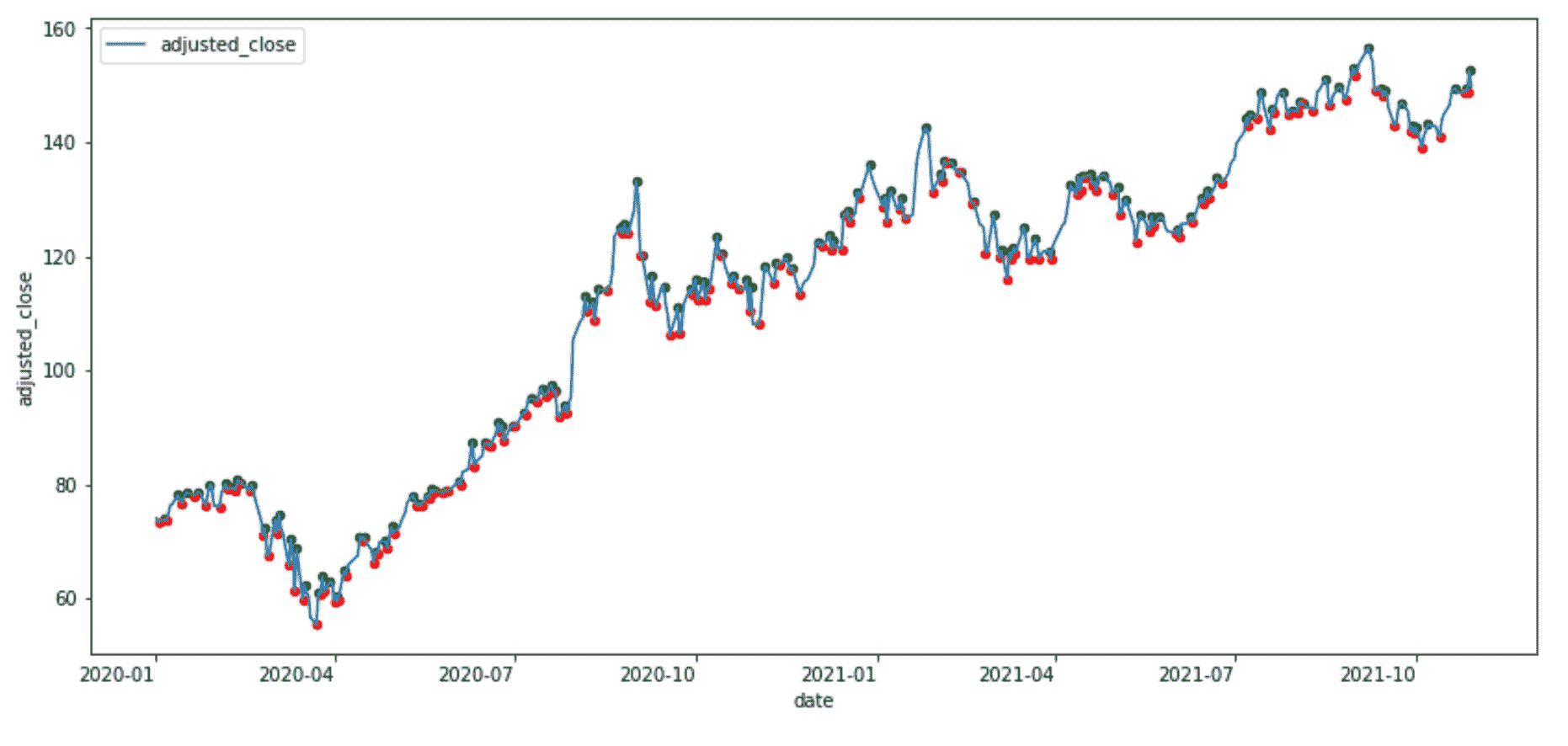

从 2018 年 1 月 1 日起的苹果股票每日价格(作者提供的图片)

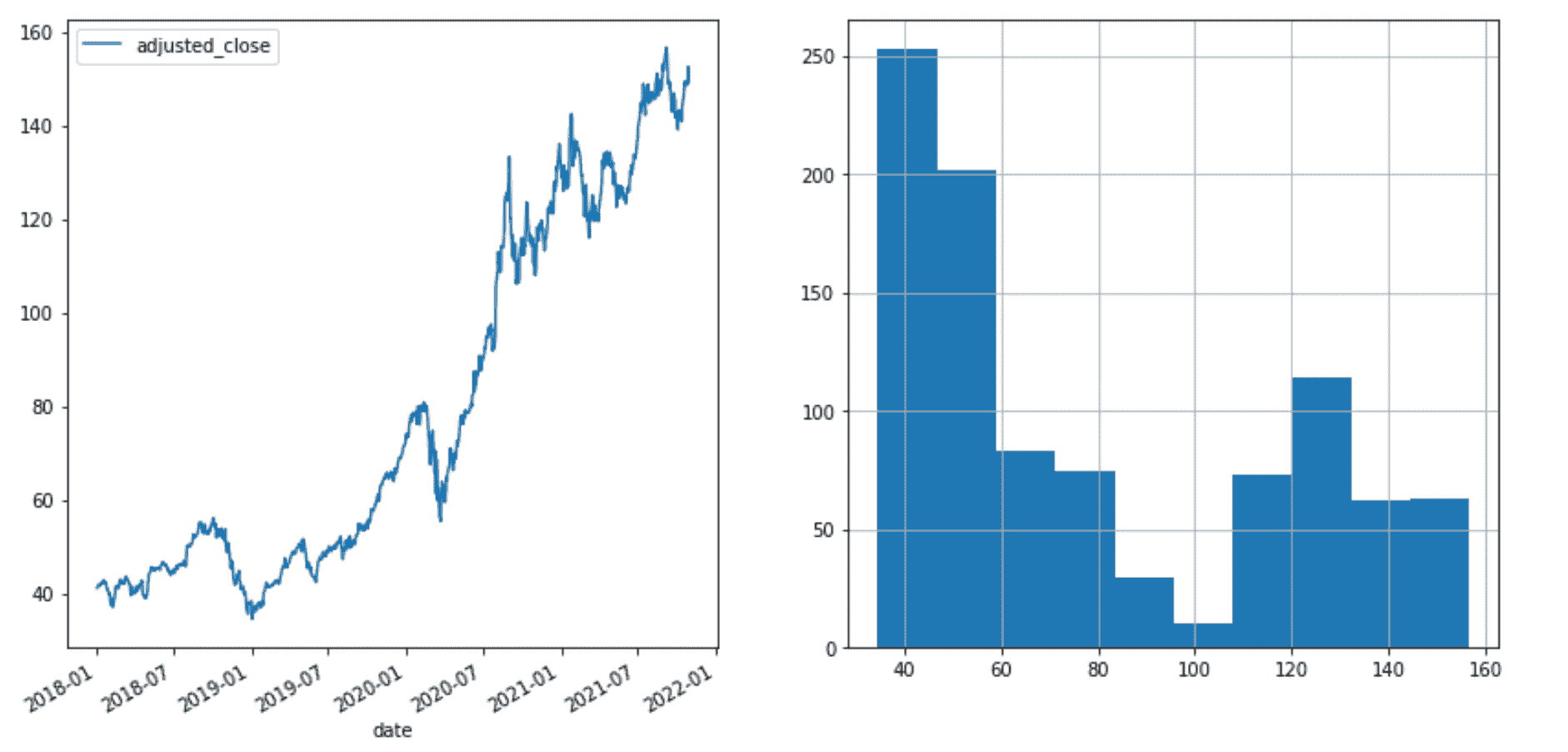

然后我们可以通过以下方式可视化苹果股票的调整收盘价和价格分布:

fig, axes = plt.subplots(nrows=1, ncols=2, figsize=(14, 7))col = "adjusted_close"

df.plot(x="date", y=col, ax=axes[0])

df[col].hist(ax=axes[1])

苹果股票调整收盘价和价格分布(作者提供的图片)

寻找峰值和低谷

图片由 Claudel Rheault 提供,来源于 Unsplash

时间序列预测学习问题的一个常见定义是,在时间序列信号上找到峰值和低谷,这些作为机器学习算法的目标变量。

让我们首先减少数据规模,以便更容易可视化:

df_sub = df[df["date"] > "2020-01-01"].copy().reset_index(drop=True)

然后找到峰值:

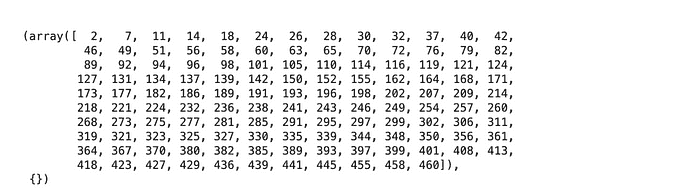

from scipy.signal import find_peakspeaks = find_peaks(df_sub["adjusted_close"])

包含峰值索引的数组(作者提供的图片)

然后找到低谷:

troughs = find_peaks(-df_sub["adjusted_close"])

然后我们可以进行可视化

ax = df_sub.plot(x="date", y="adjusted_close", figsize=(14, 7))df_sub.iloc[peaks[0]].plot.scatter(x="date", y="adjusted_close", ax=ax, color="green")df_sub.iloc[troughs[0]].plot.scatter(x="date", y="adjusted_close", ax=ax, color="red")

苹果股票时间序列的峰值和低谷(作者提供的图片)

现在数据集已经标记了进出信号,我们只需将神经网络拿出来,坐下来放松一下,对吧?

不完全正确!

技术分析师可能会指出上述例子中的前瞻性偏差。

为什么?

因为

find peaks函数一次性处理整个信号。如果我们基于滞后指标在其基础上定义决策逻辑,它将遭受前瞻性偏差。在金融领域,技术分析是一种通过研究过去市场数据,主要是价格和成交量,来预测价格方向的方法。

但这只是一个问题,如果我们依赖于技术分析的话。

让我们回到机器学习。

从机器学习的角度来看,上述定义是可以的,如果我们将信号分为 3 部分。例如:

-

第一部分用于训练(前 60%)

-

第二部分用于验证(第二 10%)

-

最后一部分用于样本外测试(最后 30%)

find peaks函数的输出仅用于目标,并且不会泄露到特征中。

那么这个学习问题定义有什么问题呢?

我们在对数据应用机器学习算法之前需要回答的百万美元问题:

时间序列中是否存在信号,还是只是随机噪声?

时间序列中是否存在信号?

照片由 Clarisse Meyer 提供,来自 Unsplash

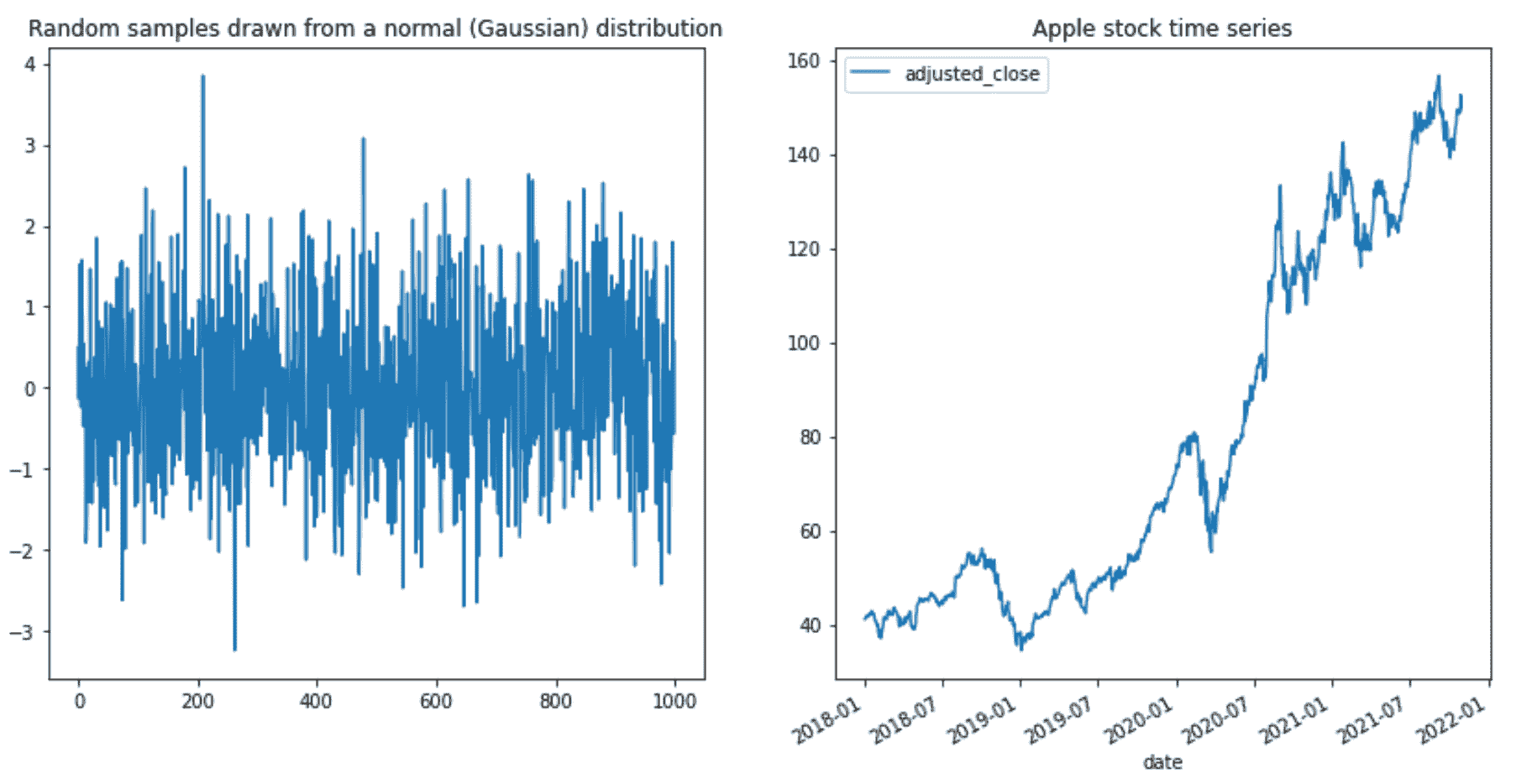

让我们将从高斯分布中生成的随机数与苹果股票时间序列进行比较。

使用下面的命令,我从均值为零、标准差为 1 的高斯分布(也称为正态分布)中生成了 1000 个随机数:

np.random.seed(42)normal_dist = pd.DataFrame(np.random.normal(size=1000), columns=["value"])

从正态分布中提取的随机数(图像由作者提供)

现在,让我们可视化生成的数字并将其与苹果股票时间序列进行比较:

fig, axes = plt.subplots(nrows=1, ncols=2, figsize=(14, 7))normal_dist["value"].plot(

ax=axes[0],

title="Random samples drawn from a normal (Gaussian) distribution",

)df.plot(x="date", y="adjusted_close", ax=axes[1], title="Apple stock time series")

将高斯分布的随机样本与苹果股票时间序列进行比较(图像由作者提供)

你不需要是科学家就能注意到,苹果股票时间序列具有递增的模式,而高斯数值则只是随机上下波动。

苹果股票时间序列真的有一个机器学习算法可以学习的模式吗?

让我带你去进行一次(随机的)游走

照片由 Jonas Weckschmied 提供,来自 Unsplash

随机游走是一种统计工具,它生成-1 和 1 的随机数,下一个数字依赖于前一个状态。这提供了一些一致性,与独立的随机数字不同。随机游走可以帮助我们确定我们的时间序列是否可预测。

让我们看下面的例子。

在第一步中,我们生成了一个包含 1000 个随机选择的-1 和 1 的数字列表。

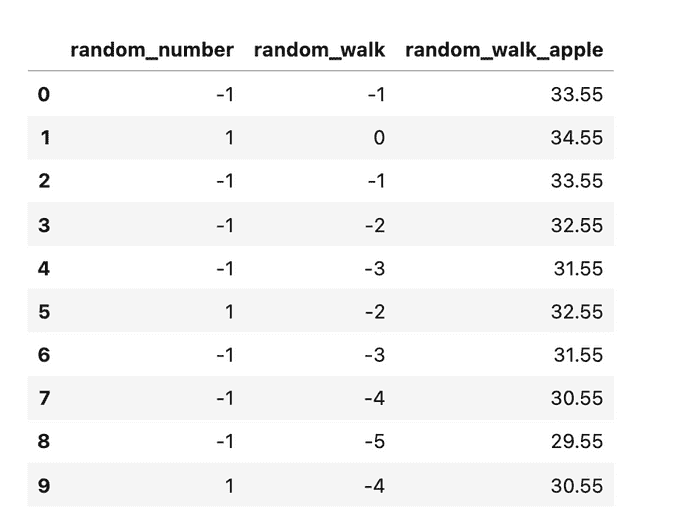

np.random.seed(42)random_walk = pd.DataFrame()

random_walk.loc[:, "random_number"] = np.random.choice([-1, 1], size=1000, replace=True)

然后,我们将生成的随机值累积总结,以增加对前一个状态的依赖:

random_walk.loc[:, "random_walk"] = random_walk["random_number"].cumsum()

苹果股票的初始调整后收盘价为 34.55。让我们将这个数字添加到 random_walk 中,以便我们使用相同的尺度:

random_walk.loc[:, "random_walk_apple"] = random_walk["random_walk"] + 34.55

最终结果是一个包含生成的随机游走的 pandas Dataframe:

生成的随机游走的 Dataframe(图像由作者提供)

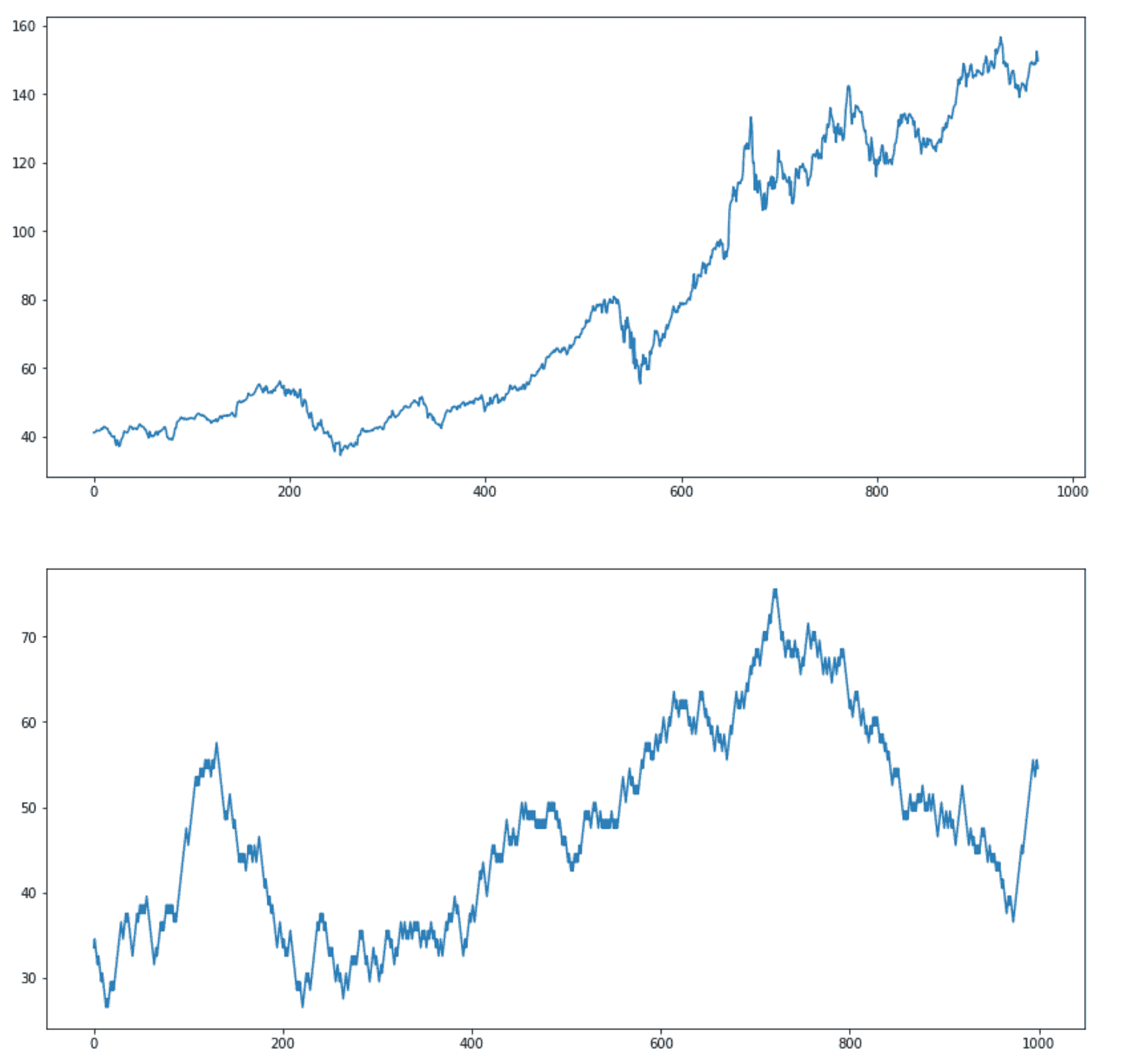

现在,让我们将随机生成的游走与实际的苹果股票时间序列进行比较:

fig, axes = plt.subplots(nrows=2, ncols=1, figsize=(14, 14))df["adjusted_close"].plot(ax=axes[0])

random_walk["random_walk_apple"].plot(ax=axes[1])

苹果股票时间序列和随机游走(图像由作者提供)

我故意没有在上述图表中包含标题。你能告诉我哪个是随机的,哪个是实际的苹果股票时间序列吗?

我们的时间序列是可以预测的吗,还是随机的?

照片由 Universal Eye 提供,来自 Unsplash

为了回答这个问题,我们需要将随机生成的序列的属性与苹果股票时间序列的属性进行比较。

一个有用的工具是自相关图,它展示了每个观察值与前几个时间步的观察值的相关性。

自相关是信号与其延迟副本的相关性,作为延迟的函数。非正式地说,它是观察值之间的相似性,作为它们之间时间滞后的函数。

随机游走的构造方式(当前状态是从前一个状态计算得出的+1 或-1——对前一个状态的高度依赖),我们可以预期在最初的几个时间步中会有很高的自相关性,随着滞后的增加而线性下降。

Pandas 有一个 autocorrelation_plot 函数,它计算自相关并在自相关图上进行可视化。

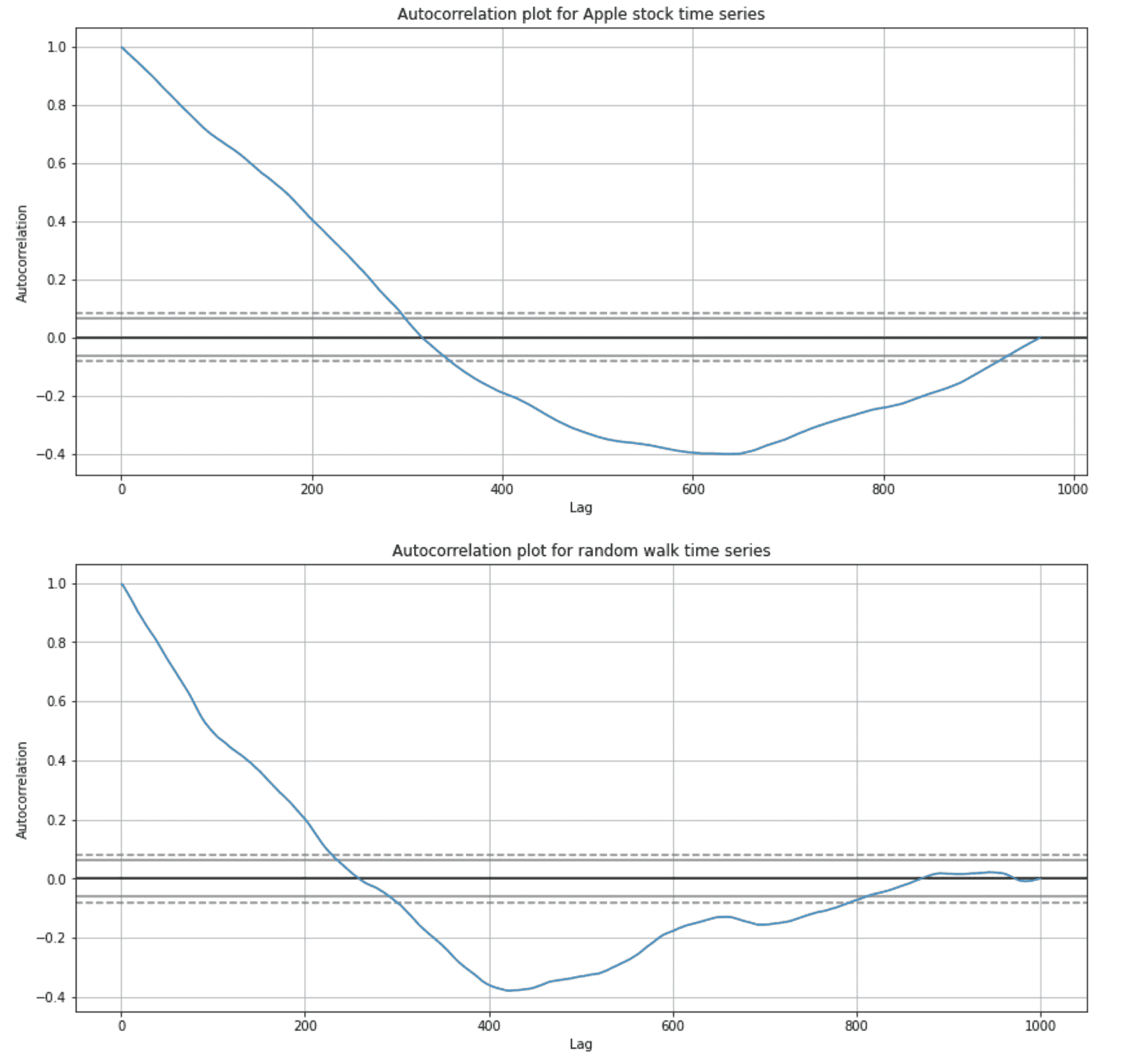

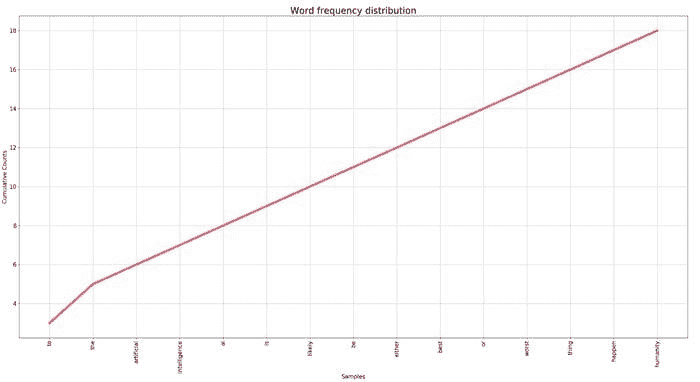

让我们可视化随机游走和苹果股票时间序列的自相关图。

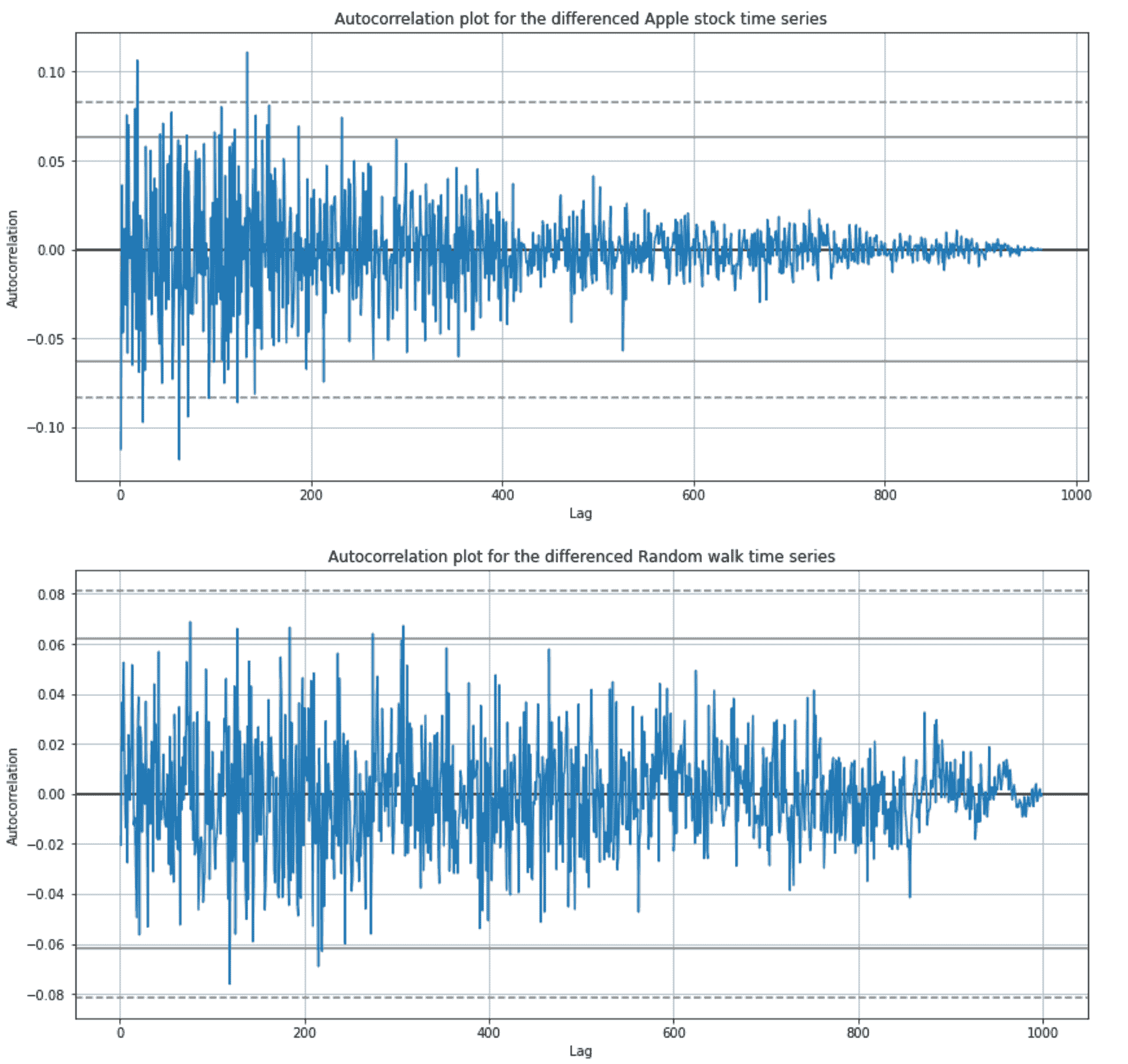

fig, axes = plt.subplots(nrows=2, ncols=1, figsize=(14, 14))axes[0].set_title("Autocorrelation plot for Apple stock time series")

pd.plotting.autocorrelation_plot(df["adjusted_close"], ax=axes[0])axes[1].set_title("Autocorrelation plot for random walk time series")

pd.plotting.autocorrelation_plot(random_walk["random_walk_apple"], ax=axes[1])

随机游走和苹果股票时间序列的自相关图(图像由作者提供)

图中的 x 轴显示自相关,y 轴显示滞后。图中的水平线对应于 95%和 99%置信区间。虚线是 99%置信区间。高于这些线的值在统计上是显著的。

正如我们对随机游走序列的预期一样,前 100 个时间步中有很高的自相关性,随着滞后的增加而线性下降。

令人惊讶的是(或者对一些人来说不惊讶),苹果股票时间序列的自相关性类似于随机游走自相关图。

让深度神经网络回到休眠状态……

图片由 Pierre Bamin 提供,来源于 Unsplash

让我们通过从当前观察值中移除前一个观察值的值来使两个时间序列平稳——差分。通过应用差分操作,我们去除了时间的函数。

以下命令对苹果股票和随机游走时间序列应用差分操作:

# applying differencing operation

# [1:] is used to remove the first value which is nullapple_stationary = df["adjusted_close"].diff()[1:]

random_walk_stationary = random_walk["random_walk_apple"].diff()[1:]

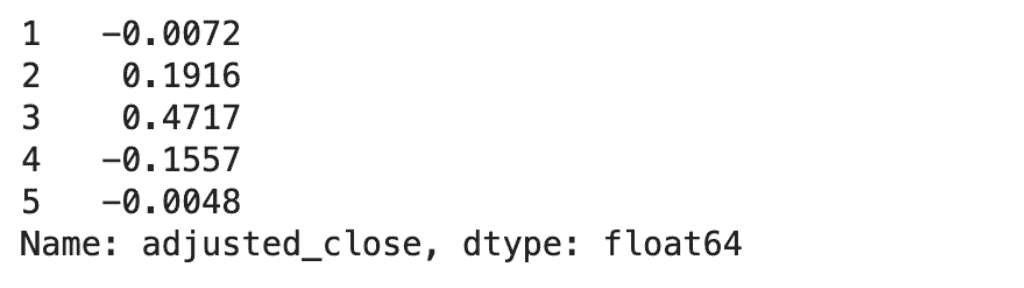

差分的苹果股票时间序列(图像由作者提供)

现在,让我们可视化差分时间序列:

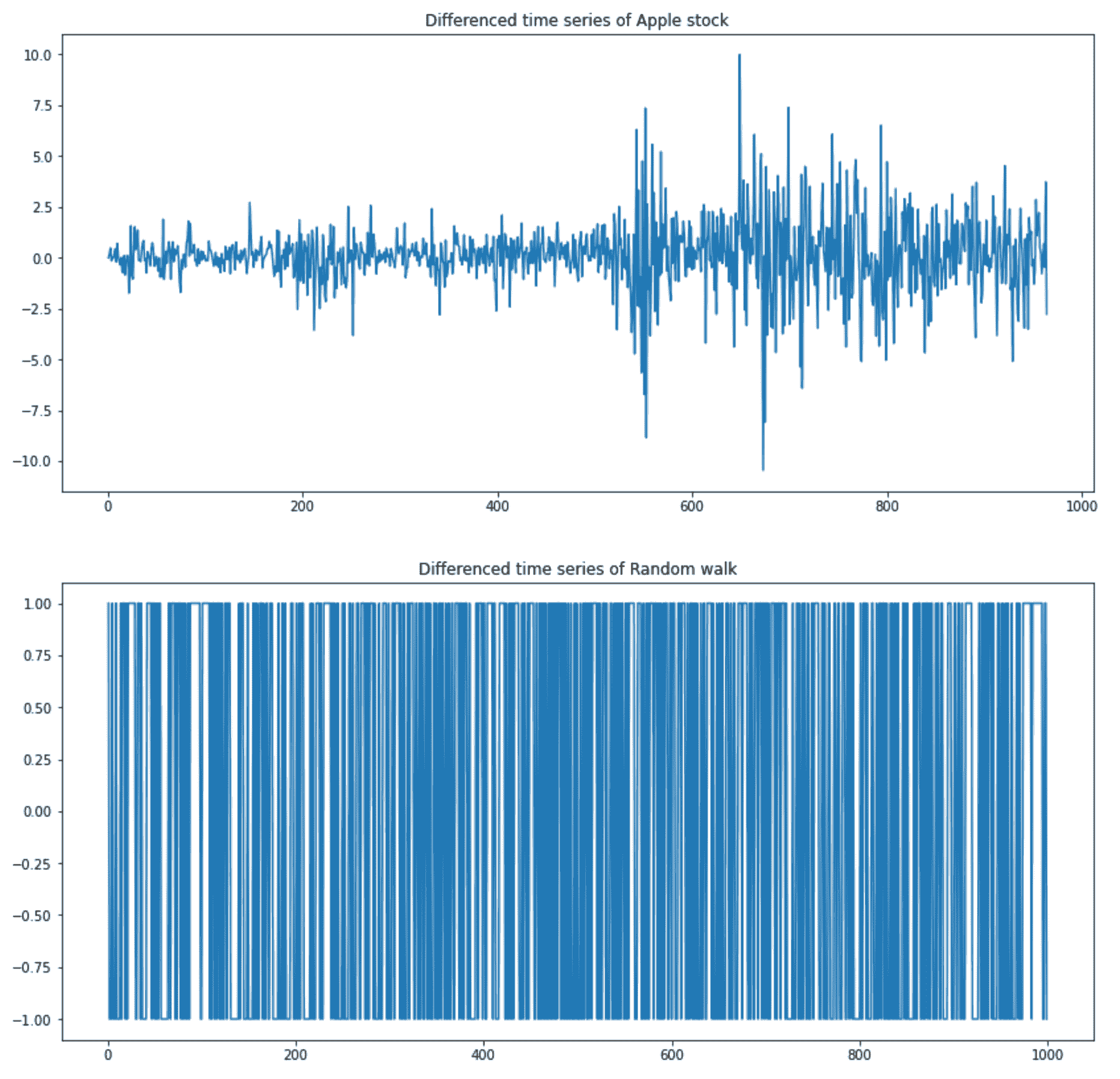

fig, axes = plt.subplots(nrows=2, ncols=1, figsize=(14, 14))apple_stationary.plot(ax=axes[0], title="Differenced time series of Apple stock")random_walk_stationary.plot(ax=axes[1], title="Differenced time series of Random walk")

苹果股票和随机游走的差分时间序列(图像由作者提供)

差分的随机游走时间序列只有-1 和+1,正如预期的那样。差分的苹果股票时间序列有更多的波动,但这些波动是否显著?

我们可以通过差分时间序列上的自相关图来检查这一点:

fig, axes = plt.subplots(nrows=2, ncols=1, figsize=(14, 14))pd.plotting.autocorrelation_plot(apple_stationary, ax=axes[0])

pd.plotting.autocorrelation_plot(random_walk_stationary, ax=axes[1])

差分的随机游走和苹果股票时间序列的自相关图(图像由作者提供)

请记住,超出水平线的自相关值具有统计显著性。

差分后的苹果股票时间序列有几个自相关值超出 99%的置信区间,但差分后的随机游走时间序列也有几个值超出 95%的置信区间,我们知道信号是随机的,因此我们可以将这些归因于统计错误。

结论

图片来源于 Ferdinand Stöhr 在 Unsplash

在文章中,我们对真实世界的时间序列数据进行了几个统计检查,我们确定其信号是随机的。

我对此的看法是什么?

你可能会感到惊讶(就像我一样),我们在苹果股票时间序列中没有发现任何统计显著的信号。

当我们不断听到关于机器学习算法如何在股市上做出自动决策的故事时,这怎么可能呢?

好吧,虽然我确信机器学习算法被用于做出这样的决策——Marcos López de Prado 为此写了一整本书——但我也确信它们使用了更多的数据。我指的不是更多的价格数据,而是一种不同类型的数据,这种数据影响了股票价格的变动。

你可以阅读维基百科上的随机游走假设,该假设认为股市价格按照随机游走演变(即价格变化是随机的),因此无法预测。

对此你有什么想法?请在下方评论中告诉我。

简介: Roman Orac 是一名机器学习工程师,在改进文档分类和项目推荐系统方面取得了显著成功。Roman 拥有管理团队、指导初学者和向非工程师解释复杂概念的经验。

原文。经允许转载。

相关内容:

-

前 5 名时间序列方法

-

对有志成为数据科学家的建议——你最常见的问题解答

-

基于 LSTM 的 RNN 的多变量时间序列分析

我们的前三名课程推荐

1. Google 网络安全证书 - 加入网络安全职业的快速通道。

1. Google 网络安全证书 - 加入网络安全职业的快速通道。

2. Google 数据分析专业证书 - 提升你的数据分析能力

2. Google 数据分析专业证书 - 提升你的数据分析能力

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

3. 谷歌 IT 支持专业证书 - 支持您的组织 IT

更多相关主题

如何避免过拟合

编辑器提供的图片

过拟合是许多数据科学家常犯的一个常规错误。它可能会使你数小时的编码工作付诸东流。你的模型可能会产生不准确的输出,并导致决策过程中的进一步问题。

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

1. 谷歌网络安全证书 - 快速进入网络安全职业生涯

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

2. 谷歌数据分析专业证书 - 提升你的数据分析技能

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

3. 谷歌 IT 支持专业证书 - 支持你的组织的 IT 需求

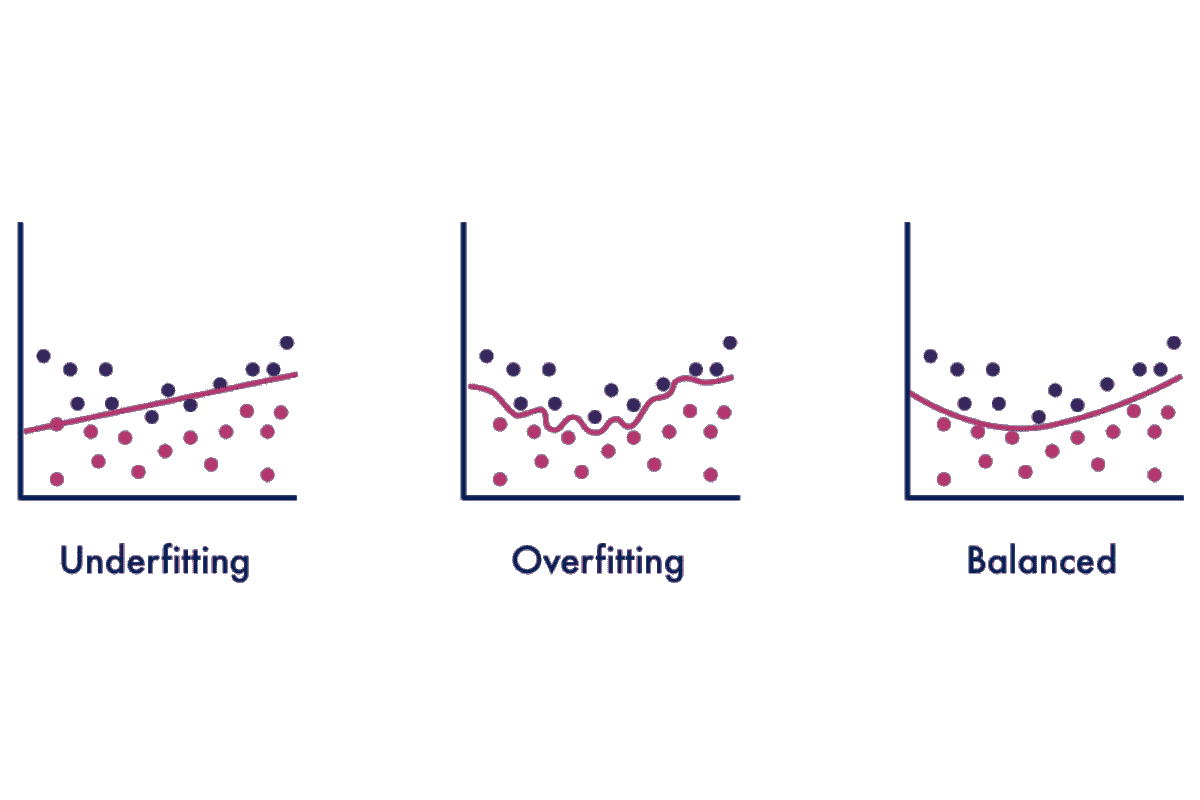

在我们讨论如何避免过拟合之前,先来了解一下什么是过拟合。

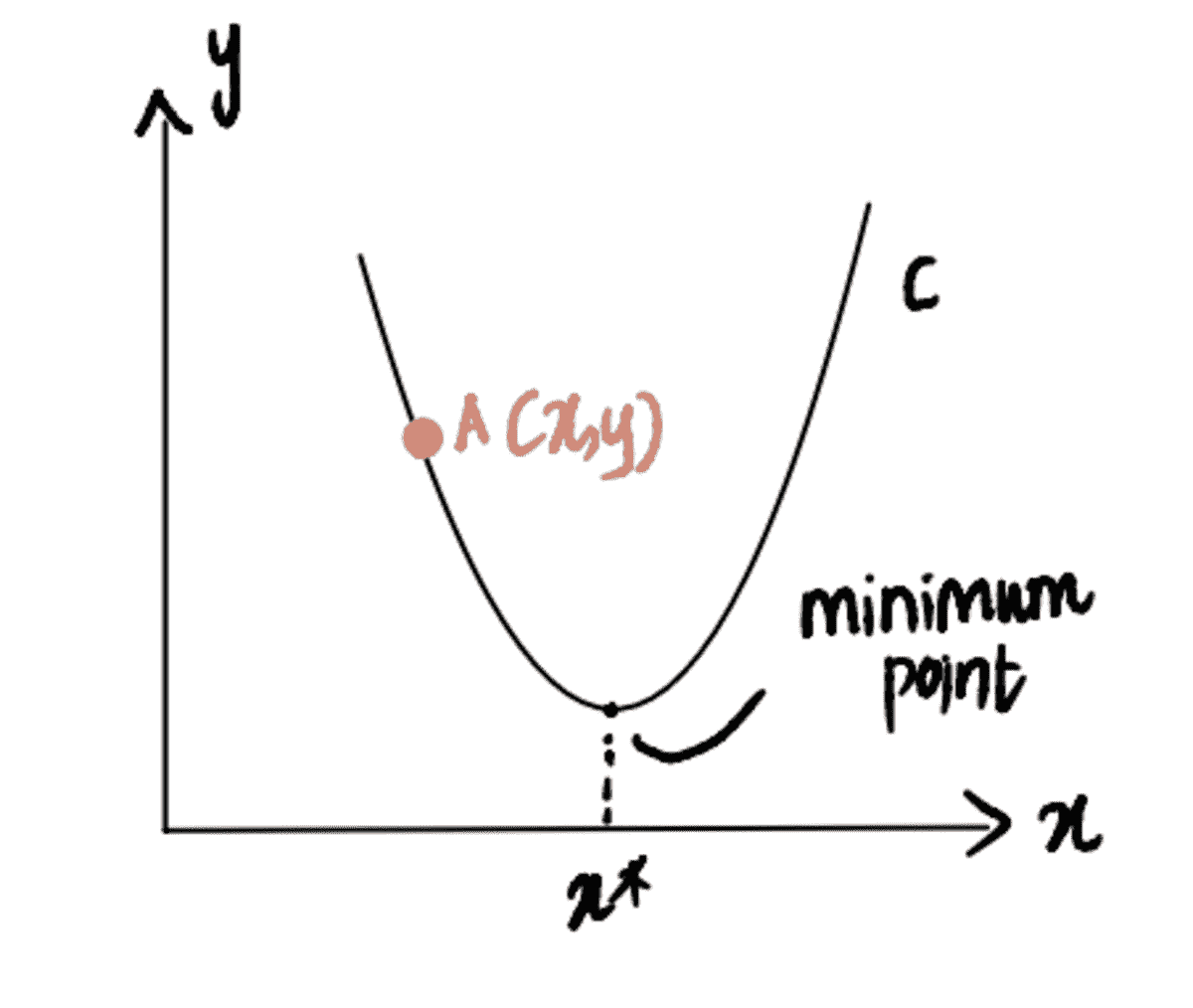

什么是过拟合?

过拟合是指统计模型完全贴合其训练数据。这是一种建模错误,表明你的函数过于紧密地贴合有限的数据点。这是因为模型仅专注于它知道的变量,并自动假设这些预测将适用于测试或未见过的数据。这导致模型无法准确预测未来的观察值。

过拟合发生的原因之一是模型或数据集的复杂性。如果模型过于复杂,或者模型在一个非常大的样本数据集上进行训练——模型开始记住数据集中无关的信息。当信息被记住时,模型对训练集的拟合过于紧密,无法很好地对新数据进行泛化。

尽管在处理训练数据时,这种情况会产生低误差,但在处理测试数据时却变得非常无用,因为它会产生高误差。判断你的模型是否过拟合的一种方法是查看其是否具有低误差率但高方差。

什么是欠拟合?

过拟合的对立面是欠拟合。欠拟合是指模型无法准确识别输入和输出变量之间的关系。这可能是由于模型过于简单,可以通过增加更多输入特征或使用高方差模型如决策树来解决。

欠拟合最糟糕的地方在于它既不能建模训练数据,也不能对新数据进行泛化——在训练集和未见过的数据上都会产生高误差率。

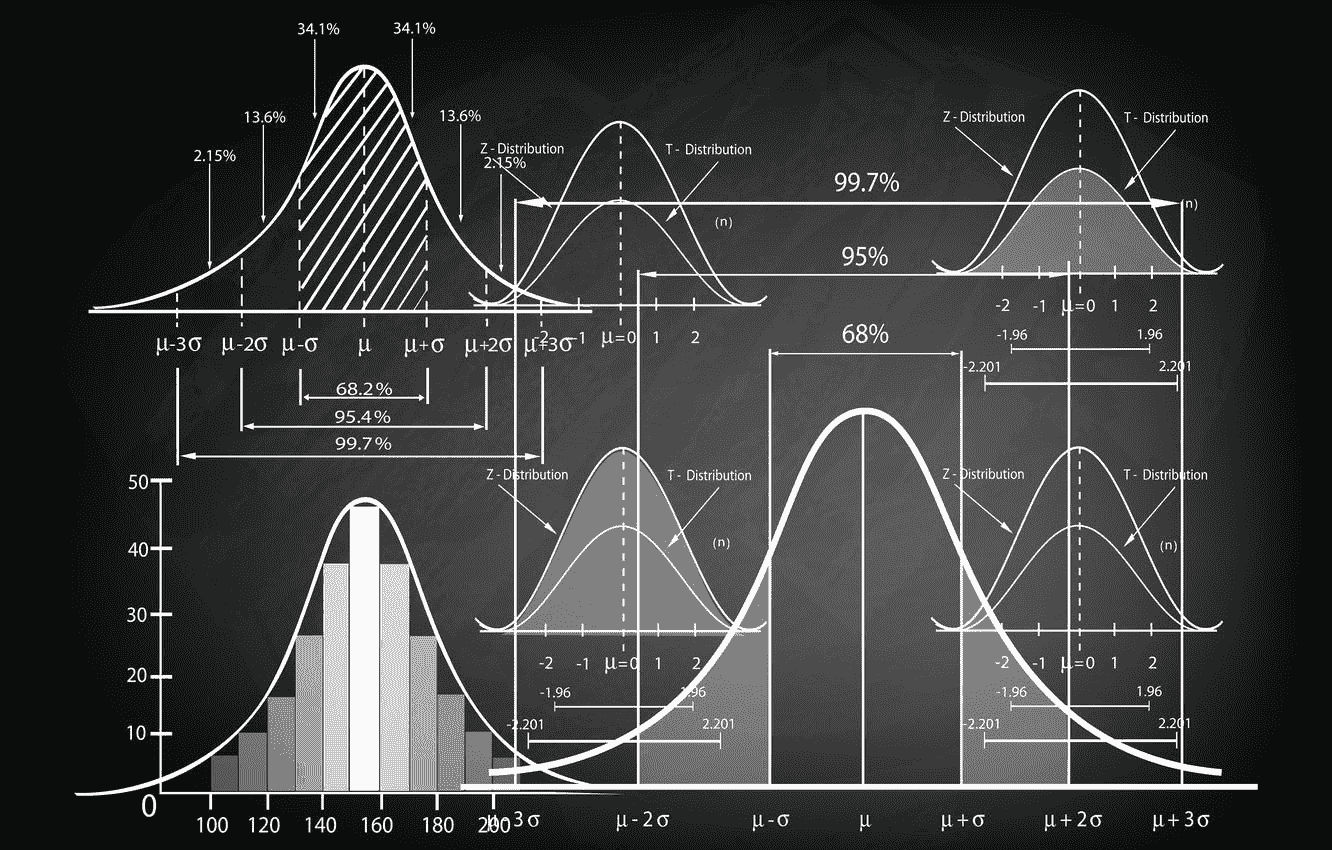

信号和噪声

在我们了解如何避免过拟合之前,我们需要理解信号和噪声。

信号是帮助模型学习数据的真实潜在模式。例如,青少年年龄与身高之间的关系就是一个明确的关系。

噪声是数据集中随机且无关的数据。以信号的示例来说,如果我们采样一所以体育专业闻名的学校——这将导致离群值。由于身体特征,如篮球的身高,学校的学生人数会更高。这将导致模型中的随机性——显示噪声如何干扰信号。

如果你产生一个高效的机器学习模型,能够区分信号和噪声,它将表现良好。

拟合优度是一个统计术语,指的是模型预测值与观察值的匹配程度。当模型学习噪声而不是学习信号时,就会导致过拟合。模型过于复杂或过于简单会提高学习噪声的可能性。

防止过拟合的技术

训练更多数据

我将从你可以使用的最简单技术开始。在训练阶段增加数据量不仅可以提高模型的准确性,还能减少过拟合。这使得你的模型能够识别更多的信号,学习模式并减少错误。

这将帮助模型更好地推广到新数据,因为模型有更多机会理解输入与输出变量之间的关系。然而,你需要确保所使用的额外训练数据是干净的——否则,你可能会做反向操作,增加更多复杂性。

特征选择

减少过拟合的下一个简单技术是特征选择。这是通过仅选择相关特征来减少输入变量数量的过程,从而确保你的模型表现良好。

根据你的任务,有些特征与其他特征没有相关性或关联。因此,这些特征可以被移除,因为它们使你的模型学习不需要的东西。为了找出与任务直接相关的特征,你可以通过在单独的模型上训练不同的特征来测试它们。

你不仅会提高模型性能,还会减少建模的计算成本。

数据增强

数据增强是一组通过从现有数据生成新数据点来人工增加数据量的技术。

虽然增加更多干净数据是一种选择,但这也是一种非常昂贵的选择。数据增强通过使数据看起来更为多样化来降低成本,因为样本数据每次被模型处理时略有不同。每个数据集对模型来说都显得独特——提高了学习速率和性能。

噪声也可以在这个技术中使用,以提高模型的稳定性。向数据中添加噪声使数据更加多样化,而不会降低数据质量。然而,添加噪声的选择应该谨慎进行,以防止过拟合。

提前停止

在训练阶段通过每次迭代测量模型性能是一种有效的防止过拟合的技术。你可以通过在模型开始学习噪声之前暂停训练来实现这一点。然而,需要考虑的是,当使用“提前停止”技术时,有暂停训练过程过早的风险——这可能导致欠拟合。

正则化

正则化是强制你的模型变得更简单,以最小化损失函数并防止过拟合或欠拟合。它不鼓励模型学习非常复杂的东西。

这种技术旨在惩罚系数,这有助于减少过拟合,因为过拟合的模型通常具有膨胀的系数。如果系数膨胀,其效果是成本函数将增加。

正则化也是像交叉验证这样的技术的一个超参数——使得过程更简单。

交叉验证

交叉验证是用于衡量过拟合的最知名技术之一。它用于评估统计分析的结果对未见数据的泛化能力。

交叉验证的过程是从你的训练数据中生成多个训练-测试拆分——这些拆分用于调整你的模型。然后,参数将经历交叉验证,以选择最佳参数并将其反馈到模型中进行再训练。这将提高模型的整体性能和准确性,并帮助模型更好地泛化到未见数据。

交叉验证技术的示例包括 Hold-out、K-folds、Leave-one-out 和 Leave-p-out。

交叉验证的好处在于它简单易懂,易于实现,并且与其他方法相比,通常具有较低的偏差。

如果你想了解更多关于最常用的交叉验证技术 K-fold 的信息,可以阅读这篇文章:为什么使用 k-fold 交叉验证?

集成

我将要讲的最后一种技术是集成。集成方法创建多个模型,然后结合这些模型产生的预测以改善结果。最流行的集成方法包括提升和 Bagging。

Bagging

Bagging 是“Bootstrap Aggregation”的缩写,是一种用于减少预测模型方差的集成方法。Bagging 旨在通过关注“强学习者”来减少过拟合复杂模型的可能性。

它并行训练大量强学习者,然后将这些强学习者组合在一起,以优化和产生准确的预测。决策树,例如分类和回归树(CART),通常以高方差而闻名。

提升算法

提升算法专注于通过提高简单模型的预测灵活性,将“弱学习者”转变为更强的学习者。它通过构建和改进简单模型为强预测模型,从而减少偏差错误。

弱学习者按顺序训练,以便它们能够专注于学习之前的错误。完成这些后,所有的弱学习者将合并成一个强学习者。

如果你想了解更多关于集成技术的信息,可以阅读这篇文章:集成技术何时是一个好的选择?

结论

你已经读到了最后。在这篇文章中,我们已经探讨了:

-

什么是过拟合?

-

什么是欠拟合?

-

信号与噪声

-

防止过拟合的技术

敬请关注更多深入探讨此主题的文章,例如《方差-偏差权衡》等。

Nisha Arya 是一位数据科学家和自由技术写作人。她特别关注提供数据科学职业建议或教程以及围绕数据科学的理论知识。她还希望探索人工智能在延长人类生命方面的不同方式。作为一个热衷学习者,她寻求拓宽自己的技术知识和写作技能,同时帮助指导他人。

更多相关话题

避免这 5 个人工智能新手常犯的错误

原文:

www.kdnuggets.com/avoid-these-5-common-mistakes-every-novice-in-ai-makes

图片由作者提供

我们的前三大课程推荐

1. 谷歌网络安全证书 - 快速迈入网络安全职业生涯。

1. 谷歌网络安全证书 - 快速迈入网络安全职业生涯。

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

2. 谷歌数据分析专业证书 - 提升你的数据分析水平

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

3. 谷歌 IT 支持专业证书 - 支持你的组织进行 IT 管理

你听过爱因斯坦的以下名言吗?

疯狂就是一遍遍地做同样的事情却期待不同的结果。

对于那些刚开始人工智能之旅的人来说,这是一个完美的提醒。作为初学者,面对大量的信息和资源容易感到不知所措。你可能会发现自己犯了许多人之前犯过的相同错误。但为什么要浪费时间和精力重复这些错误,为什么不从他们的经验中学习呢?

作为一个曾与该领域经验丰富的从业者交谈的人,我一直好奇他们的人工智能之旅。我很快发现,他们中的许多人在早期遇到了类似的挑战和陷阱。这就是我写这篇文章的原因——分享新手在人工智能领域常犯的 5 个错误,以便你可以避免它们。

所以,让我们开始吧:

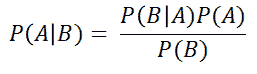

1. 忽视基础知识

作为一个人工智能初学者,容易被炫目的算法和强大的框架所吸引。然而,就像一棵树需要强大的根基才能成长一样,你对人工智能的理解也需要坚实的基础。忽视这些构建块背后的数学可能会阻碍你。框架是为了帮助计算机进行计算,但学习基础概念比仅仅依赖黑箱库和框架更为重要。许多初学者开始使用像 scikit-learn 这样的工具,虽然他们可能会得到结果,但通常会在分析性能或解释发现时遇到困难。这通常是因为他们跳过了理论。要成为成功的人工智能开发者,学习这些核心概念是至关重要的。

确定区分优秀 AI 开发者与新手的技能组合并没有一个简单的“一刀切”答案。这是多个因素的结合。然而,为了讨论基础内容,强调解决问题、数据结构和算法的重要性是必要的。大多数机器学习公司在招聘过程中会评估这些技能,掌握它们将使你成为一个更强的候选人。

2. 万能型人才谬论

你可能见过 LinkedIn 上的个人资料声称在 AI、机器学习、深度学习、计算机视觉、自然语言处理等方面有专长。这就像一长串技能,可能会让人感到头晕。也许是因为社交媒体或“全栈开发者”这一趋势,人们将 AI 与之进行比较。但现实是,生活在幻想世界里并没有帮助。AI 是一个非常广阔的领域。知道所有内容是不现实的,试图做到这一点可能会导致沮丧和倦怠。这样想吧:这就像尝试一口气吃下整个比萨饼——不太实际,对吧?相反,专注于某个特定领域,真正做到精通。通过缩小焦点并将时间投入到掌握 AI 的某个部分,你将能够产生有意义的影响,并在竞争激烈的 AI 领域中脱颖而出。因此,让我们避免分散精力,专注于一次成为一个领域的专家。

3. 陷入教程陷阱

我认为初学者常犯的最大错误就是被大量的在线教程、课程、书籍和文章压倒。学习和参与这些课程并不是负面的事情。然而,我担心的是,他们可能无法在理论和实践之间找到正确的平衡。花太多时间在教程上而不实际应用所学内容,可能会导致被称为“教程地狱”的挫败感。为了避免这种情况,重要的是通过实际项目来检验你的知识,尝试不同的数据集,并不断提高你的结果。此外,你会发现课程中教的一些概念可能并不总是对特定数据集或问题最有效。例如,我最近观看了DeepLearning.ai 的 LLM 对直接偏好优化的对齐讲座,其中 Huggingface 的研究科学家ED Beeching提到,尽管原始的直接偏好优化论文使用了 RMSProp 作为优化器,但他们发现 Adam 在实验中更为有效。你只有通过实际操作和深入实践才能学到这些东西。

4. 数量优于质量的项目

当初学者想展示他们的 AI 技能时,他们常常会被诱惑去创建大量项目以展示他们的专业知识。然而,优先考虑质量而不是数量至关重要。我观察到,在大型科技公司工作的人往往简历上有 2-3 个强有力的项目,而不是像许多人那样有 6-10 个小而平庸的项目。这种方法不仅对求职有利,而且对学习也有帮助。你可以更好地理解主题。与其跟随 YouTube 教程或做一堆普通项目,不如花费一个月左右的时间和精力投入到那些具有长期价值的项目中。这种方法会让你的学习曲线更陡峭,并真正突出你的理解。这也可以让你的简历从其他人中脱颖而出。即使在找到工作后,你也不会在过渡到实际工作时遇到太多困难。

5. 孤狼综合症

我理解不同的人有不同的工作偏好。有些人可能喜欢独自工作,而其他人则寻求支持。对于机器学习的初学者来说,面对这些可能会感到不知所措,孤立工作可能会阻碍你的成长。我强烈推荐你参与 Reddit、Discord、Slack、LinkedIn 和 Facebook 等平台上的 AI 社区。如果你对社区不太舒服,可以考虑找一个 AI 导师进行指导和支持。与他们讨论你的项目,寻求建议,并学习更好的方法。这不仅使学习过程变得愉快,而且节省时间。虽然我不鼓励你在遇到问题时立即发布问题或联系导师,但你应该始终先尝试自己解决。但在某些时候,寻求帮助是可以的。这种方法可以避免倦怠,增强你的学习能力,最终,你会为自己尝试并获得对失败的了解而感到满意。

50 天挑战:敢于接受挑战,提升你的 AI 技能

在本文中,我们讨论了初学者应该避免的 5 个最常见的错误。

我为大家准备了一个令人兴奋的挑战。作为这个社区的负责任成员,我想鼓励你采取行动,将这些技巧应用到自己的 AI 旅程中。以下是“50 天挑战”:

1. 在下方评论区写下“挑战接受”。(如果你无法看到评论区,请刷新页面——可能需要一些时间才能出现。)

2. 在接下来的 50 天里,专注于这 5 个技巧,并将它们应用到你的 AI 学习中。

3. 在 50 天后,返回本文并在评论中分享你的经验。告诉我们这些技巧给你的生活带来了哪些变化,以及它们如何帮助你成长为 AI 从业者。

我迫不及待想听听你的故事,并了解你的进展。此外,如果你有任何建议或额外的提示,可以分享给其他读者,请尽管说出来!让我们互相帮助,共同成长。

Kanwal Mehreen**** Kanwal 是一位机器学习工程师和技术作家,对数据科学以及人工智能与医学的交集充满了深厚的热情。她共同撰写了电子书《利用 ChatGPT 提高生产力》。作为 2022 年亚太地区 Google Generation Scholar,她倡导多样性和学术卓越。她还被认定为 Teradata 多样性科技奖学者、Mitacs Globalink 研究奖学者和哈佛 WeCode 学者。Kanwal 是变革的坚定倡导者,创立了 FEMCodes 以赋能 STEM 领域的女性。

更多相关话题

超棒的 100+ 类别的数据集列表

评论

由 Etienne D. Noumen,高级软件工程师。

我们的前三个课程推荐

1. Google 网络安全证书 - 快速开启网络安全职业之路。

1. Google 网络安全证书 - 快速开启网络安全职业之路。

2. Google 数据分析专业证书 - 提升你的数据分析技能

2. Google 数据分析专业证书 - 提升你的数据分析技能

3. Google IT 支持专业证书 - 支持你所在组织的 IT 部门

3. Google IT 支持专业证书 - 支持你所在组织的 IT 部门

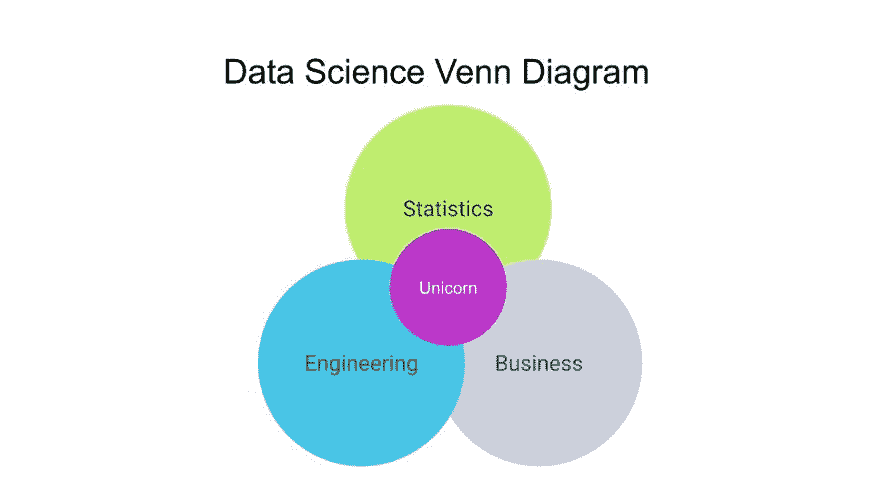

数据科学是一个跨学科领域,它使用科学方法、过程、算法和系统从结构化和非结构化数据中提取知识和洞察,并将这些知识和可操作的洞察应用于广泛的应用领域。

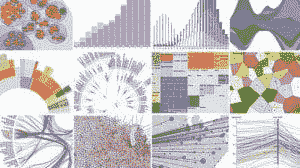

在本博客中,我们提供了流行的开源和公共数据集、数据可视化、数据分析资源和数据湖的链接。

目录

-

最新完整的 Netflix 电影数据集

-

通用爬虫

-

蛋白质价格数据集

-

CPOST 数据集:四十年来的自杀攻击

-

信用卡数据集 – 消费者金融调查 (SCF) 综合提取数据 1989-2019 综合提取数据 1989-2019")

-

带注释的无人机图像用于小物体检测和跟踪数据集

-

NOAA 高分辨率快速刷新 (HRRR) 模型 模型")

-

AWS 上的开放数据注册表

-

教科书问答 (TQA)")

-

协调癌症数据集:基因组数据公共门户

-

癌症基因组图谱

-

治疗性应用研究以生成有效治疗方法 (TARGET)")

-

基因组聚合数据库 (gnomAD)")

-

SQuAD (斯坦福问答数据集)")

-

PubMed 糖尿病数据集

-

药物-靶标互动数据集

-

药物基因组数据集

-

胰腺癌类器官分析

-

非洲土壤信息服务 (AfSIS) 土壤化学 Soil Chemistry")

-

E 环境中的情感状态数据集

-

NatureServe Explorer 数据集

-

美国航班记录

-

全球航班数据

-

2019 年美国犯罪统计数据

-

雅虎问答数据集

-

美洲历史 1400-2021

-

波斯语词汇发音数据集

-

历史空气质量数据集

-

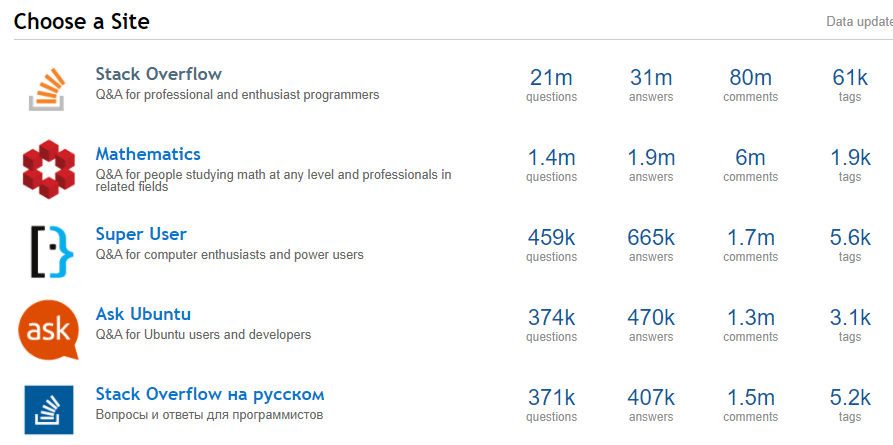

Stack Exchange 数据集

-

精彩公共数据集

-

农业数据集

-

生物数据集

-

气候和天气数据集

-

复杂网络数据集

-

计算机网络数据集

-

网络安全数据集

-

数据挑战数据集

-

地球科学数据集

-

经济数据集

-

教育数据集

-

能源数据集

-

娱乐数据集

-

金融数据集

-

地理信息系统数据集

-

政府数据集

-

医疗数据集

-

图像处理数据集

-

机器学习数据集

-

博物馆数据集

-

自然语言数据集

-

神经科学数据集

-

物理数据集

-

前列腺癌数据集

-

心理学和认知数据集

-

公共领域数据集

-

搜索引擎数据集

-

社交网络数据集

-

社会科学数据集

-

软件数据集

-

体育数据集

-

时间序列数据集

-

交通数据集

-

电子竞技数据集

-

补充集合

-

分类公共数据集列表:Sindre Sorhus /awesome List

-

平台

-

编程语言

-

前端开发

-

后端开发

-

计算机科学

-

大数据

-

理论

-

书籍

-

编辑器

-

游戏

-

开发环境

-

娱乐

-

数据库

-

媒体

-

学习

-

安全

-

内容管理系统

-

硬件

-

商业

-

工作

-

网络

-

去中心化系统

-

高等教育

-

事件

-

测试

-

其他

-

相关

-

美国教育部 CRDC 数据集

-

NASA 数据集:从细菌的空间前后测序数据

-

2015 年至 2021 年所有特朗普的推特侮辱记录 CSV 格式

-

数据是复数

-

全球恐怖主义数据库

-

海豚社交网络

-

20 万笑话的数据集

-

百万歌曲数据集

-

康奈尔大学的 eBird 数据集

-

UFO 报告数据集

-

CDC 的趋势药物数据

-

健康与退休研究:公众调查数据

这是一个庞大的列表,这里有100+个更多的类别

最新完整的 Netflix 电影数据集

从 4 个 API 创建。包含 11K+行和 30+属性的 Netflix 数据(评级、收入、演员、语言、可用性、电影预告片等等)

使用FlixGem.com探索这个数据集(这个数据集驱动了这个 web 应用)

Common Crawl

一个由超过 500 亿个网页组成的网络爬虫数据语料库。Common Crawl 语料库包含自 2008 年以来收集的 PB 级数据。它包含原始网页数据、提取的元数据和文本提取。

AWS CLI 访问(无需 AWS 账户)

aws s3 ls s3://commoncrawl/ --no-sign-request

s3://commoncrawl/crawl-data/

蛋白质价格数据集

关于主要商品价格的数据每月更新,基于 IMF 的主要商品价格系统。

CPOST 数据集:四十年来的自杀攻击

芝加哥大学安全与威胁项目展示了更新和扩展后的自杀攻击数据库(DSAT),该数据库现在链接到乌普萨拉冲突数据计划的武装冲突数据,并包括一个新的数据集,用于衡量与自杀攻击组织相关的武装组织之间的联盟和对立关系。在这里访问

信用卡数据集 – 消费者金融调查(SCF)1989-2019 年合并提取数据

你可以在这里以非常简单的方式进行大量汇总分析。

附带小物体检测和跟踪的无人机图像数据集

11 TB 无人机图像数据集附带小物体检测和跟踪的注释

下载和更多信息请访问这里

数据集许可证:CDLA-Sharing-1.0

访问数据集的辅助脚本:DATASET.md

数据集探索:Colab

NOAA 高分辨率快速更新(HRRR)模型

HRRR 是 NOAA 的实时 3 公里分辨率、每小时更新、云解析、允许对流的气象模型,由 3 公里网格和 3 公里雷达同化初始化。雷达数据每 15 分钟同化到 HRRR 中,持续 1 小时,进一步增加了由 13 公里雷达增强的快速刷新每小时数据同化提供的细节。

AWS 开放数据注册表

本注册表旨在帮助人们发现和共享通过 AWS 资源提供的数据集。了解更多关于在 AWS 上共享数据的信息。

查看来自数字地球非洲、Facebook 数据公益、NASA 空间法案协议、NIH STRIDES、NOAA 大数据计划、空间望远镜科学研究所和亚马逊可持续数据计划的数据集。

教科书问答(TQA)

1,076 节教科书课文,26,260 个问题,6229 张图片

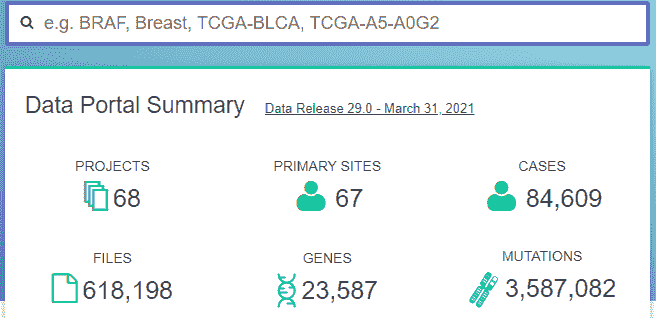

协调癌症数据集:基因组数据公共门户

GDC 数据门户是一个强大的数据驱动平台,允许癌症研究人员和生物信息学家搜索和下载癌症数据进行分析。

基因组数据公共门户

癌症基因组图谱

癌症基因组图谱(TCGA),是国家癌症研究所(NCI)和国家人类基因组研究所(NHGRI)之间的合作,旨在生成主要癌症类型和亚型中关键基因组变化的全面、多维度图谱。

AWS CLI 访问(无需 AWS 账户)

aws s3 ls s3://tcga-2-open/ --no-sign-request

临床应用研究以生成有效治疗(TARGET)

临床应用研究以生成有效治疗(TARGET)计划采用全面的基因组方法来确定驱动儿童癌症的分子变化。该计划的目标是利用数据指导开发有效且毒性较小的治疗方案。TARGET 组织为一个疾病特定项目团队的协作网络。TARGET 项目提供全面的分子表征,以确定驱动儿童癌症起始和进展的遗传变化。数据集包含来自基因组数据公共数据库(GDC)的开放临床补充、样本补充、RNA-Seq 基因表达定量、miRNA-Seq 亚型表达定量、miRNA-Seq miRNA 表达定量数据以及来自 GDC 遗留档案的开放数据。点击这里访问。

基因组聚合数据库(gnomAD)

基因组聚合数据库(gnomAD)是由国际研究人员联盟开发的资源,汇总和协调来自各种大规模人类测序项目的外显子组和基因组数据。这里提供的总结数据为科学界提供便利,无使用限制。下载

SQuAD(斯坦福问题回答数据集)

斯坦福问答数据集(SQuAD)是一个阅读理解数据集,由众包工作者在一组维基百科文章上提出问题,每个问题的答案都是来自相应阅读段落的文本片段或范围,或者问题可能没有答案。在这里访问

PubMed 糖尿病数据集

Pubmed 糖尿病数据集包含 19717 篇来自 PubMed 数据库的关于糖尿病的科学出版物,分类为三类之一。引用网络包含 44338 条链接。数据集中的每篇出版物由一个 TF/IDF 加权词向量描述,该词典由 500 个唯一单词组成。数据集中的 README 文件提供了更多细节。

药物-靶标互动数据集

此数据集包含从 DrugBank、KEGG Drug、DCDB 和 Matador 收集的药物与靶标之间的互动。最初由Perlman 等收集。数据集包含 315 种药物、250 个靶标、1306 个药物-靶标互动、5 种药物-药物相似性和 3 种靶标-靶标相似性。药物-药物相似性包括基于化学的、基于配体的、基于表达的、基于副作用的和基于注释的相似性。靶标-靶标相似性包括基于序列的、基于蛋白质-蛋白质相互作用网络的和基于基因本体论的相似性。数据集的原始任务是基于网络中的不同相似性预测药物和靶标之间的新互动。下载链接

药物基因组学数据集

PharmGKB 数据和知识可供下载。通常在使用这些数据进行大规模项目之前,检查与其策展人联系 feedback@pharmgkb.org 是至关重要的,以确保所提供的文件和数据被正确解释。PharmGKB 通常不需要成为这些分析的共同作者;他们只希望确保在投入大量资源之前对数据有正确的理解。

胰腺癌类器官分析

数据集包含开放的 RNA-Seq 基因表达定量数据以及受控的 WGS/WXS/RNA-Seq 对齐读取、WXS 注释体突变、WXS 原始体突变和 RNA-Seq 剪接位点定量。文档

AWS CLI 访问(无需 AWS 账户)

aws s3 ls s3://gdc-organoid-pancreatic-phs001611-2-open/ --no-sign-request

非洲土壤信息服务(AfSIS)土壤化学

该数据集包含通过非洲土壤信息服务(AfSIS)项目收集的土壤红外光谱数据及配对的土壤性质参考测量,这些样本在 2009 年至 2018 年期间进行了地理参考。文档

AWS CLI 访问(无需 AWS 账户)

aws s3 ls s3://afsis/ --no-sign-request

情感状态数据集(E-Environments)

DAiSEE 是第一个多标签视频分类数据集,包含 9068 个视频片段,捕捉自 112 位用户,用于识别用户的无聊、困惑、参与和挫折等情感状态。数据集包含四个标签级别,即非常低、低、高和非常高,每种情感状态都由人群标注,并与使用专家心理学家团队创建的黄金标准标注相关。 在这里下载

NatureServe Explorer 数据集

NatureServe Explorer 提供了超过 95,000 种植物和动物在美国和加拿大的保护状态、分类学、分布和生活历史信息,以及西半球超过 10,000 种植被群落和生态系统的信息。

通过 NatureServe Explorer 提供的数据代表了在 NatureServe 中央数据库中管理的数据。这些数据库是动态的,通过数百名自然遗产项目科学家和其他合作伙伴的输入不断增强和完善。NatureServe Explorer 从这些中央数据库中更新,以反映新的实地调查、最新的分类处理、其他科学出版物以及新的保护状态评估。在这里探索数据

美国航班记录

航空公司准时表现及航班延误原因 – On_Time 数据。

该数据库包含由认证的美国航空承运人报告的计划和实际出发及到达时间、延误原因,这些承运人占国内计划客运收入的至少 1%。数据由运输统计局(BTS)航空信息办公室收集。

FlightAware.com 有数据,但你需要付费才能获得完整的数据集。

anyflights 包提供了一组函数,用于生成类似于nycflights13的航空旅行数据(和数据包!)。通过用户定义的年份和机场,anyflights函数将抓取以下数据:

-

flights: 指某年某月从特定机场起飞的所有航班 -

weather: 某年某月特定机场的每小时气象数据 -

airports: 机场名称、FAA 代码和位置 -

airlines: 两字母航空公司代码与名称的转换 -

planes: 关于flights中每架飞机的建造信息

美国交通部(DOT)的运输统计局(BTS)跟踪大型航空公司运营的国内航班的准时表现。关于准时、延误、取消和改道航班数量的汇总信息会出现在 DOT 的每月航空旅行消费者报告中,该报告在每月结束后约 30 天发布,并在该网站上发布汇总表。BTS 从 2003 年 6 月开始收集航班延误原因的详细信息。汇总统计数据和原始数据在航空旅行消费者报告发布时公开。在此访问

全球航班数据

开放航班:截至 2017 年 1 月,OpenFlights 机场数据库包含超过 10,000个机场、火车站和渡轮码头,遍布全球

下载: airports.dat(仅机场,高质量)

下载: airports-extended.dat(机场、火车站和渡轮码头,包括用户贡献)

Flightera.net 似乎提供了大量免费的优质数据。它提供了深入的航班数据,并且似乎没有日期限制。不过,我无法评论数据的有效性。

flightradar24.com 拥有大量数据,包括历史数据,他们可能会愿意帮助你以良好的格式获取这些数据。

2019 年美国犯罪统计数据

包含按种族和各州分开的美国逮捕数据集。在这里下载 Excel

Yahoo Answers 数据集

Yahoo 将于 2021 年关闭。这是来自 2015 年的 Yahoo Answers 数据集(300MB gzip),相当广泛,大约有 140 万行。这个数据集包含了最佳的问题答案,我指的是所有的答案,包括最荒谬糟糕的答案和最糟糕的问题。在这里下载。

另一个选项在这里:根据跟踪器,已完成 7700 万,还有 2000 万未完成(?),还有 4000 万待完成:

wiki.archiveteam.org/index.php/Yahoo!_Answers

美国历史 1400-2021

来源:

www.ggdc.net/maddison/oriindex.htm

www.globalfirepower.com/countries-comparison.asp

波斯词汇发音数据集

这是一个包含约 55K 个波斯词汇及其发音的数据集。每个词汇占一行,并通过制表符与其发音分开。

历史空气质量数据集

美国户外监测器收集的空气质量数据。这是一个 BigQuery 数据集。没有下载文件,但可以通过 Kernels 使用 BigQuery API 查询。AQS 数据库包含所有来自 AQS 的信息。它记录了 EPA 通过国家环境空气监测计划收集的每一个测量值,还包括 EPA 计算的相关汇总值(8 小时、每日、年度等)。AQS 数据库是每周制作一次的 AQS 副本,通过基于网络的应用程序向公众开放。数据集的预期用户是监管、学术和健康研究领域的空气质量数据分析师。它旨在为那些需要下载大量详细技术数据的人提供,而不提供任何互动分析工具。它作为几个机构互动工具的后端数据库,这些工具无法完全运作:AirData、AirCompare、The Remote Sensing Information Gateway、地图监测站点 KML 页面等。

Stack Exchange 数据集

精彩公共数据集

这个列表包含了高质量的以主题为中心的公共数据源。它们是从博客、回答和用户回应中收集和整理的。下面列出的多数数据集是免费的,但有些则不是。

农业

生物学

气候和 气候和天气

复杂 复杂网络

计算机网络

网络安全

数据挑战

地球科学数据集

经济学数据集

教育数据集

能源数据集

娱乐数据集

金融数据集

GIS 数据集

政府数据集

-

加拿大安大略省多伦多 [修复]

医疗数据集

图像处理数据集

机器学习数据集

博物馆数据集

自然语言数据集

神经科学数据集

物理学数据集

前列腺癌数据集

心理学与认知数据集

公共领域数据集

-

Infochimps [修正]

-

KDNuggets 数据集合

搜索引擎数据集

社交网络数据集

社会科学数据集

软件数据集

体育数据集

时间序列 Datas****ets

交通运输

电子竞技数据集

补充集合

-

一个不断增长的公共数据集集合: CoolDatasets.

-

DataWrangling: 网上可用的一些数据集

-

Inside-r: 在互联网上寻找数据

-

OpenDataMonitor: 欧洲可用开放数据资源概览

-

Quora: 我可以在哪里找到公开的大型数据集?

-

RS.io: 100+ 有趣的统计数据集

-

StaTrek: 利用开放数据理解城市生活

-

CV Papers: 网络上的计算机视觉数据集

-

CVonline: 图像数据库

分类的公共数据集列表: Sindre Sorhus /awesome 列表

平台

-

Node.js – 基于 Chrome 的 V8 JavaScript 引擎构建的异步非阻塞事件驱动 JavaScript 运行时。

- 跨平台 – 在 Node.js 上编写跨平台代码。

-

iOS – 适用于苹果手机和平板的移动操作系统。

-

Android – 由 Google 开发的移动操作系统。

-

Electron – 使用 JavaScript/HTML/CSS 的跨平台原生桌面应用。

-

Cordova – 用于混合应用的 JavaScript API。

-

React Native – 用于编写 iOS 和 Android 原生渲染移动应用的 JavaScript 框架。

-

Xamarin – 移动应用程序开发集成开发环境(IDE)、测试和分发。

-

-

eBPF – 一个虚拟机,使您能够编写更高效和强大的 Linux 系统跟踪和监控代码。

-

基于 Arch 的项目 – 基于 Arch Linux 的 Linux 发行版和项目。

-

macOS – 苹果 Mac 计算机的操作系统。

-

watchOS – 苹果手表的操作系统。

-

IPFS – 点对点超媒体协议。

-

Fuse – 移动开发工具。

-

Heroku – 云平台即服务。

-

树莓派 – 一种信用卡大小的计算机,旨在教授孩子们编程,但能做更多事情。

-

Qt – 跨平台图形用户界面应用程序框架。

-

WebExtensions – 跨浏览器扩展系统。

-

RubyMotion – 使用 Ruby 为 iOS、Android、macOS、tvOS 和 watchOS 编写跨平台原生应用。

-

智能电视 – 为不同的电视平台创建应用。

-

GNOME – 适用于 Linux 的简洁且无干扰的桌面环境。

-

KDE – 一个致力于创建开放且用户友好的计算体验的自由软件社区。

-

Amazon Alexa – 虚拟家庭助理。

-

DigitalOcean – 专为开发人员设计的云计算平台。

-

Flutter – Google 的移动 SDK,用于从一个用 Dart 编写的代码库构建原生 iOS 和 Android 应用。

-

Home Assistant – 开源家居自动化系统,优先考虑本地控制和隐私。

-

IBM 云 – 面向开发者和公司的云平台。

-

Firebase – 基于 Google Cloud Platform 的应用开发平台。

-

机器人操作系统 2.0 – 一套帮助你构建机器人应用的软件库和工具。

-

Adafruit IO – 可视化和存储来自任何设备的数据。

-

Cloudflare – 为你的站点提供 CDN、DNS、DDoS 保护和安全性。

-

Google Actions – Google Assistant 的开发平台。

-

ESP – 低成本的微控制器,具备 WiFi 和广泛的物联网应用。

-

Deno – 一种安全的 JavaScript 和 TypeScript 运行时,使用 V8,构建于 Rust 上。

-

DOS – 一种用于 x86 个人计算机的操作系统,曾在 1980 年代和 1990 年代初期流行。

-

Nix – 用于 Linux 和其他 Unix 系统的包管理器,使包管理可靠且可重现。

编程语言

-

Swift – 苹果的编译编程语言,安全、现代、对程序员友好且快速。

-

Python – 旨在提高可读性的通用编程语言。

-

Asyncio – Python 3 的异步 I/O。

-

科学音频 – 音频/音乐方面的科学研究。

-

CircuitPython – 为微控制器提供的 Python 版本。

-

数据科学 – 数据分析和机器学习。

-

类型检查 – Python 的可选静态类型检查。

-

MicroPython – 为微控制器提供的精简高效的 Python 3 实现。

-

-

- Scala Native – 基于 LLVM 的 Scala 提前优化编译器。

-

Julia – 高级动态编程语言,旨在满足高性能数值分析和计算科学的需求。

-

C/C++ – 通用语言,偏向系统编程和嵌入式、资源受限的软件。

-

R – 用于统计计算和图形的函数式编程语言和环境。

-

Common Lisp – 强大的动态多范式语言,便于迭代和互动开发。

-

Java – 设计为灵活的流行安全面向对象语言,实现“一次编写,到处运行”。

-

PHP – 服务器端脚本语言。

- Composer – 包管理器。

-

Frege – 用于 JVM 的 Haskell。

-

CMake – 构建、测试和打包软件。

-

ActionScript 3 – 面向 Adobe AIR 的面向对象语言。

-

Eta – JVM 的函数式编程语言。

-

Idris – 一种通用的纯函数式编程语言,具有受 Haskell 和 ML 影响的依赖类型。

-

Ada/SPARK – 现代编程语言,适用于需要可靠性和效率的大型、长期运行的应用程序。

-

Q# – 用于表达量子算法的领域特定编程语言。

-

Imba – 受 Ruby 和 Python 启发的编程语言,编译为高效的 JavaScript。

-

Vala – 设计用来充分利用 GLib 和 GNOME 生态系统的编程语言,同时保留 C 代码的速度。

-

Coq – 用于编程和规范的形式化语言和环境,支持交互式机器检查证明的开发。

-

V – 简单、快速、安全的编译语言,用于开发可维护的软件。

前端开发

-

CSS – 用于指定 HTML 元素在屏幕上显示方式的样式表语言。

-

React – 应用框架。

-

Relay – 用于构建数据驱动的 React 应用的框架。

-

React Hooks – 一项新特性,让你在不编写类的情况下使用状态和其他 React 特性。

-

-

Polymer – 用于开发 Web 组件的 JavaScript 库。

-

Angular – 应用框架。

-

Backbone – 应用框架。

-

HTML5 – 用于网站和 Web 应用的标记语言。

-

SVG – 基于 XML 的矢量图像格式。

-

KnockoutJS – JavaScript 库。

-

Dojo Toolkit – JavaScript 工具包。

-

Ember – 应用框架。

-

D3 – 用于制作动态、交互式数据可视化的库。

-

jQuery – 易于使用的 JavaScript 库,用于 DOM 操作。

-

Cycle.js – 函数式和响应式 JavaScript 框架。

-

Vue.js – 应用框架。

-

Marionette.js – 应用框架。

-

Aurelia – 应用框架。

-

PostCSS – CSS 工具。

-

Draft.js – React 的富文本编辑器框架。

-

choo – 应用框架。

-

Redux – JavaScript 应用的状态容器。

-

webpack – 模块打包器。

-

Browserify – 模块打包器。

-

Sass – CSS 预处理器。

-

Ant Design – 企业级 UI 设计语言。

-

Less – CSS 预处理器。

-

WebGL – 用于渲染 3D 图形的 JavaScript API。

-

Preact – 应用框架。

-

Next.js – 用于服务器渲染的 React 应用的框架。

-

lit-html – 用于 JavaScript 的 HTML 模板库。

-

JAMstack – 基于客户端 JavaScript、可重用的 API 和预构建标记的现代 Web 开发架构。

-

WordPress-Gatsby – 以 WordPress 为后端,Gatsby 为前端的 Web 开发技术栈。

-

Mobile Web Development – 创建出色的移动 Web 体验。

-

Storybook – UI 组件的开发环境。

-

Blazor – 使用 C#/Razor 和 HTML 的 .NET 网络框架,通过 WebAssembly 在浏览器中运行。

-

PageSpeed 指标 – 帮助理解页面速度和用户体验的指标。

-

Tailwind CSS – 以实用程序为先的 CSS 框架,用于快速 UI 开发。

-

Seed – 用于创建运行在 WebAssembly 中的网页应用的 Rust 框架。

-

网页性能预算 – 确保网站性能指标的技术。

-

网页动画 – 浏览器中的动画,使用 JavaScript、CSS、SVG 等。

-

Yew – 受 Elm 和 React 启发的 Rust 框架,用于创建多线程前端网页应用与 WebAssembly。

-

Material-UI – 用于更快更容易网页开发的 Material Design React 组件。

-

构建网页应用的模块 – 独立功能模块,可集成到网页应用中。

-

Svelte – 应用框架。

-

设计系统 – 可重用组件的集合,由规则指导,确保一致性和速度。

后端开发

-

Flask – Python 框架。

-

Vagrant – 自动化虚拟机环境。

-

Pyramid – Python 框架。

-

CakePHP – PHP 框架。

-

Symfony – PHP 框架。

-

Laravel – PHP 框架。

-

TALL Stack – 全栈开发解决方案,包含 Laravel 社区构建的库。

-

Rails – Ruby 的网页应用框架。

- Gems – 软件包。

-

Phalcon – PHP 框架。

-

nginx – 网络服务器。

-

Dropwizard – Java 框架。

-

Kubernetes – 自动化 Linux 容器操作的开源平台。

-

Lumen – PHP 微框架。

-

Serverless Framework – 无服务器计算和无服务器架构。

-

Apache Wicket – Java web 应用框架。

-

Vert.x – 用于在 JVM 上构建响应式应用的工具包。

-

Terraform – 用于构建、修改和版本化基础设施的工具。

-

Vapor – Swift 中的服务器端开发。

-

Dash – Python web 应用框架。

-

FastAPI – Python web 应用框架。

-

CDK – 用于在代码中定义云基础设施的开源软件开发框架。

-

IAM – 用户帐户、身份验证和授权。

-

Chalice – 用于在 AWS Lambda 上开发无服务器应用的 Python 框架。

计算机科学

-

-

ML with Ruby – 使用 Ruby 学习、实施和应用机器学习。

-

Core ML Models – Apple 机器学习框架的模型。

-

H3O – 用 Java 编写的开源分布式机器学习平台,提供 R、Python 和 Scala 的 API。

-

Software Engineering for Machine Learning – 从实验到生产级机器学习。

-

AI in Finance – 使用机器学习解决金融中的问题。

-

JAX – 自动微分和 XLA 编译结合用于高性能机器学习研究。

-

Speech and Natural Language Processing

-

Question Answering – 用机器进行自然语言问答的科学。

-

自然语言生成 – 用于数据到文本、对话代理和叙事生成应用的文本生成。

-

- 论文 – 非密码学家使用密码学的理论基础。

-

深度学习 – 神经网络。

-

TensorFlow – 机器智能库。

-

TensorFlow.js – 用于训练和部署模型的 WebGL 加速机器学习 JavaScript 库。

-

TensorFlow Lite – 优化 TensorFlow 模型以便在设备上进行机器学习的框架。

-

论文 – 被引用最多的深度学习论文。

-

-

经验软件工程 – 基于证据的软件系统研究。

-

信息检索 – 学习开发你自己的搜索引擎。

-

量子计算 – 利用量子力学和量子计算机上的量子比特进行计算。

大数据

-

Hadoop – 用于分布式存储和处理超大数据集的框架。

-

Apache Spark – 大规模数据处理的统一引擎。

-

Qlik – 用于数据可视化、分析和报告应用的商业智能平台。

-

Splunk – 用于实时搜索、监控和分析结构化和非结构化机器生成大数据的平台。

理论

书籍

编辑器

-

Atom – 开源且可黑客化的文本编辑器。

-

Visual Studio Code – 跨平台开源文本编辑器。

游戏

-

Godot – 游戏引擎。

-

Unity – 游戏引擎。

-

LÖVE – 游戏引擎。

-

PICO-8 – 幻想控制台。

-

Construct 2 – 游戏引擎。

-

Gideros – 游戏引擎。

-

Minecraft – 沙盒视频游戏。

-

游戏数据集 – 用于游戏中人工智能的材料和数据集。

-

Haxe 游戏开发 – 一种高层次的强类型编程语言,用于生成跨平台的本地代码。

-

libGDX – Java 游戏框架。

-

PlayCanvas – 游戏引擎。

-

游戏重制 – 积极维护的开源游戏重制版。

-

Flame – 用于 Flutter 的游戏引擎。

-

Discord 社区 – 与朋友和社区聊天。

-

CHIP-8 – 70 年代的虚拟计算机游戏机。

-

编程游戏 – 通过制作游戏来学习编程语言。

开发环境

-

快速查看插件 – 适用于 macOS。

-

Fish – 用户友好的 shell。

-

GitHub – Git 仓库的托管服务。

-

Git 插件 – 增强

gitCLI。 -

Git 钩子 – 用于

git工作流中的任务自动化脚本。 -

Hyper – 基于 Web 技术的跨平台终端应用。

-

PowerShell – 跨平台面向对象的 shell。

-

Alfred 工作流 – 适用于 macOS 的生产力应用。

-

GitHub Actions – 创建任务来自动化工作流,并与 GitHub 上的其他人共享。

娱乐

数据库

-

MongoDB – NoSQL 数据库。

-

TinkerPop – 图计算框架。

-

PostgreSQL – 对象关系型数据库。

-

CouchDB – 面向文档的 NoSQL 数据库。

-

HBase – 分布式、可扩展的大数据存储。

-

NoSQL Guides – 使用非关系型、分布式、开源和水平可扩展数据库的帮助。

-

Contexture – 从不同的数据存储如 ElasticSearch 和 MongoDB 中抽象查询/过滤器和结果/聚合。

-

Database Tools – 使数据库操作更简便的工具。

-

Grakn – 逻辑数据库,用于组织大型复杂的数据网络作为一个知识体系。

媒体

-

Codeface – 文本编辑器字体。

-

GIF – 以动画图像著称的图像格式。

-

Pixel Art – 像素级数字艺术。

-

FFmpeg – 跨平台的音视频录制、转换和流媒体解决方案。

-

Icons – 可下载的 SVG/PNG/字体图标项目。

-

Audiovisual – 专业环境中的灯光、音频和视频。

学习

-

CLI Workshoppers – 互动教程。

-

教育游戏 – 在游戏中学习。

-

CSS 学习 – 主要关于 CSS——语言和模块。

-

产品管理 – 学习如何成为更好的产品经理。

-

路线图 – 为提高你的知识和技能提供清晰的路线图。

-

YouTuber – 观看 YouTuber 教授技术的视频教程。

安全

-

CTF – Capture The Flag(夺旗赛)。

-

蜜罐 – 诱捕攻击者尝试入侵组织信息系统的陷阱。

-

网络安全 – 网络应用和服务的安全。

-

开锁 – 不使用钥匙而通过操控锁的组件来解锁的艺术。

-

网络安全蓝队 – 识别信息技术系统安全漏洞的团队。

-

模糊测试 – 一种自动化的软件测试技术,涉及输入伪随机生成的数据。

-

GDPR – 欧盟内所有个人的数据保护和隐私条例。

内容管理系统

-

Refinery CMS – Ruby on Rails 的内容管理系统。

-

Wagtail – 以灵活性和用户体验为重点的 Django CMS。

-

Textpattern – 轻量级 PHP 基础的 CMS。

-

Drupal – 可扩展的 PHP 基础 CMS。

-

Craft CMS – 内容优先的 CMS。

-

Sitecore – .NET 数字营销平台,将 CMS 与管理多个网站的工具结合起来。

-

Silverstripe CMS – PHP MVC 框架,可作为经典或无头 CMS。

硬件

-

电子学 – 面向电子工程师和爱好者。

-

电吉他规格 – 自制电吉他的检查清单。

-

绘图仪 – 计算机控制的绘图机和其他视觉艺术机器人。

-

机器人工具 – 面向专业机器人开发的免费和开源工具。

-

LIDAR – 通过激光光照射目标来测量距离的传感器。

商业

-

OKR 方法论 – 目标设定与沟通最佳实践。

-

领导与管理 – 在科技公司/环境中领导和管理。

-

独立 – 独立开发者业务。

-

交易工具 – Hacker News 上公司使用的工具。

-

清洁技术 – 利用技术应对气候变化。

-

Wardley 图 – 提供高情境感知,帮助改进战略规划和决策。

-

社会企业 – 建立一个主要关注社会影响的组织,该组织至少部分自筹资金。

-

工程团队管理 – 如何从软件开发过渡到工程管理。

-

开发者优先产品 – 针对开发者作为用户的产品。

工作

网络

去中心化系统

-

比特币 – 为软件开发者提供的比特币服务和工具。

-

瑞波 – 开源分布式结算网络。

-

非金融区块链 – 非金融区块链应用。

-

Mastodon – 开源去中心化微博网络。

-

以太坊 – 用于智能合约开发的分布式计算平台。

-

区块链人工智能 – 面向人工智能和机器学习的区块链项目。

-

EOSIO – 支持工业规模应用的去中心化操作系统。

-

Corda – 面向商业的开源区块链平台。

-

Waves – 开源区块链平台和用于 Web 3.0 应用及去中心化解决方案的开发工具包。

-

Substrate – 用于用 Rust 编写可扩展、可升级区块链的框架。

高等教育

-

计算神经科学 – 一门使用计算方法研究神经系统的跨学科科学。

-

数字历史 – 计算机辅助的历史科学研究。

-

科学写作 – 使用 Markdown、reStructuredText 和 Jupyter notebooks 进行无干扰的科学写作。

事件

测试

-

测试 – 软件测试。

-

视觉回归测试 – 确保更改未破坏功能或样式。

-

Selenium – 开源浏览器自动化框架和生态系统。

-

Appium – 应用程序测试自动化工具。

-

TAP – 测试任何协议。

-

JMeter – 负载测试和性能测量工具。

-

k6 – 开源、面向开发者的性能监控和负载测试解决方案。

-

Playwright – 一个 Node.js 库,用于通过单一 API 自动化 Chromium、Firefox 和 WebKit。

-

质量保证路线图 – 如何开始并建立软件测试职业。

杂项

-

JSON – 基于文本的数据交换格式。

-

CSV – 一种文本文件格式,用于存储表格数据,并使用逗号分隔值。

-

Awesome – 递归示意图。

-

回答 – Stack Overflow、Quora 等。

-

Sketch – macOS 的设计应用程序。

-

Gulp – 任务运行器。

-

AMA – 随便问我什么。

-

OpenGL – 跨平台的 2D 和 3D 图形渲染 API。

-

Unicode – Unicode 标准、特性、软件包和资源。

-

公民科学 – 面向社区基础和非机构科学家的资源。

-

MQTT – “物联网”连接协议。

-

Vorpal – Node.js CLI 框架。

-

Vulkan – 低开销的跨平台 3D 图形和计算 API。

-

LaTeX – 排版语言。

-

经济学 – 经济学家的入门工具包。

-

化学信息学 – 应用于化学问题的信息学技术。

-

Colorful – 选择你的下一个配色方案。

-

Steam – 数字分发平台。

-

机器人 – 构建机器人。

-

工程中的同理心 – 构建和推广更具同情心的工程文化。

-

DTrace – 动态追踪框架。

-

用户脚本 – 提升浏览体验。

-

宝可梦 – 宝可梦及宝可梦 GO。

-

ChatOps – 通过聊天管理技术和业务操作。

-

虚假信息 – 程序员信奉的虚假信息。

-

领域驱动设计 – 通过将实施与不断发展的模型连接的复杂需求的软件开发方法。

-

量化自我 – 通过技术进行自我追踪。

-

SaltStack – 基于 Python 的配置管理系统。

-

网页设计 – 针对数字设计师。

-

创意编码 – 编写有表现力的代码而非功能性代码。

-

无登录网页应用 – 无需登录即可使用的网页应用。

-

自由软件 – 自由如同自由。

-

Framer – 原型设计交互式用户界面。

-

Markdown – 标记语言。

-

开发乐趣 – 有趣的开发者项目。

-

医疗保健 – 面向设施、提供者、开发者、政策专家和研究人员的开源医疗软件。

-

Magento 2 – 基于 PHP 的开源电子商务。

-

TikZ – TeX/LaTeX/ConTeXt 图形绘制包。

-

神经科学 – 研究神经系统和大脑。

-

无广告 – 无广告的替代方案。

-

Esolangs – 设计用于实验或作为笑话的编程语言,而非实际使用。

-

普罗米修斯 – 开源监控系统。

-

Homematic – 智能家居设备。

-

账本 – 命令行下的复式记账。

-

网页货币化 – 一种免费的开放网页标准服务,允许你直接在浏览器中发送资金。

-

非版权作品 – 公有领域的作品。

-

加密货币工具与算法 – 使用加密技术调节单位生成和验证交易的数字货币。

-

多样性 – 创建一个更加包容和多样化的技术社区。

-

开源支持者 – 为开源项目提供免费工具和服务的公司。

-

设计原则 – 创造更好、更一致的设计和体验。

-

上座部佛教 – 上座部佛教传统的教义。

-

inspectIT – 开源的 Java 应用性能管理工具。

-

开源维护者 – 成为开源维护者的经验。

-

计算器 – 适用于各种平台的计算器。

-

验证码 – 一种计算机测试,判断用户是否为人类。

-

Jupyter – 创建和分享包含代码、方程、可视化和叙述文本的文档。

-

FIRST 机器人竞赛 – 国际高中机器人锦标赛。

-

人文科技 – 改善社会的开源项目。

-

演讲者 – 编程和设计社区的会议和聚会演讲者。

-

桌面游戏 – 适合所有人的桌面游戏乐趣。

-

软件 Patreon – 资助个人程序员或开源项目的开发。

-

寄生虫 – 寄生虫及宿主-病原体相互作用。

-

食品 – GitHub 上与食品相关的项目。

-

心理健康 – 软件行业中的心理健康意识和自我关怀。

-

比特币支付处理器 – 开始接受比特币。

-

科学计算 – 利用计算机解决复杂的科学问题。

-

农业 – 农业和园艺的开源技术。

-

产品设计 – 从初步概念到生产设计一个产品。

-

Prisma – 将数据库转换为 GraphQL API。

-

软件架构 – 设计和构建软件的学科。

-

连接数据与报告 – 更好地理解谁有权访问电信和互联网基础设施,以及这些访问的条款。

-

技术栈 – 用于构建不同应用和功能的技术栈。

-

细胞数据 – 针对计算生物学家的基于图像的生物学表型分析。

-

IRC – 开源消息传递协议。

-

广告 – 针对网站的广告和程序化媒体。

-

地球 – 寻找解决气候危机的方法。

-

命名 – 计算机科学中的正确命名方式。

-

生物医学信息提取 – 从非结构化生物医学数据和文本中提取信息。

-

网页归档 – 为了未来的世代而努力保存网络。

-

WP-CLI – WordPress 的命令行界面。

-

信用建模 – 将信用申请人分类为风险等级的方法。

-

Ansible – 基于 Python 的开源 IT 配置管理和自动化平台。

-

生物学可视化 – 在网络上交互式地可视化生物数据。

-

二维码 – 一种矩阵条形码,用于存储和分享少量信息。

-

素食主义 – 让植物性生活方式变得简单和可及。

-

翻译 – 将文本的含义从一种语言转移到另一种语言。

相关

-