Hadoop 学习日记(2)

HDFS 概述

HDFS 的产生背景和定义

HDFS 是一个文件系统,用于存储文件,通过目录树来定位文件,其次,它是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色。

HDFS 的使用场景:适合一次写入,多次读出的场景。一个文件经过创建、写入和关闭之后就不需要改变。

HDFS 的优缺点

优点

- 高容错性

数据自动保存多个副本,它通过增加副本的形式,提高容错性

某一个副本丢失后,它可以自动恢复

- 适合处理大数据

数据规模:能够处理数据达到 GB、TB、PB 级别的数据

文件规模:能够处理百万规模以上的文件数量,数量相当大

可以构建在廉价机器上,通过多副本机制,提高可靠性

缺点

-

不适合低延时数据访问

-

无法高效对大量小文件进行存储

小文件大量占用NameNode大量的内存来存储文件目录

小文件存储时间会超过读取时间

- 不支持并发写入、文件随机修改

一个文件只能有一个线程写

仅支持数据 append ,不支持文件的随机修改

HDFS 的组成

HDFS 文件块大小

HDFS 中的文件在物理上是分块存储,块的大小可以通过配置参数 (dfs blocksize) 来规定,默认大小在 2.x 3.x 版本中是 128M,1.x 中是 64M。

为什么块的大小不能设置太小,也不能设置太大。

(1) HDFS 的块设置太小,会增加寻址时间,程序一直在找块的开始位置

(2) 如果块设置的太大,从磁盘传输数据的数据会明显大于定位这个块开始所需要的时间,导致程序在处理这块数据时非常慢。

HDFS 块的大小设置主要取决于磁盘传输速率。

HDFS 的 Shell 相关操作(重点)

基本语法

hadoop fs 具体命令

hadoop dfs 具体命令

两个命令完全相同

查看所有命令

hadoop fs

常用命令

1、准备工作

- 启动Hadoop集群

myhadoop.sh start

-

-help ,输出这个命令的参数

-

创建 /sanguo 文件夹

hadoop fs -mkdir /sanguo

2、上传

- moveFromLocal:从本地剪切粘贴到 HDFS

vim shuguo.txt

添加字符 "shuguo"

hadoop fs -moveFromLocal ./shuguo.txt /sanguo

- copyFromLocal:从本地文件系统拷贝到 HDFS 路径去

vim weiguo.txt

添加字符 "weiguo"

hadoop fs -copyFromLocal ./shuguo.txt /sanguo

- -put:等同于 copyFromLocal,生产环境更习惯使用 put

vim wuguo.txt

添加字符 "wuguo"

hadoop fs -put ./wuguo.txt /sanguo

- -appendToFile:追加一个文件到已经存在的文件末尾

vim liubei.txt

输入内容 "liubei"

hadoop fs -appendToFile liubei.txt /sanguo/shuguo.txt

3、下载

- -copyToLocal:从 HDFS 拷贝到本地

hadoop fs -copyToLocal /sanguo/shuguo.txt ./

- -get:等同于 copyToLocal,生产环境更习惯用 get

hadoop fs -get /sanguo/shuguo.txt ./shuguo2.txt

4、HDFS 直接操作

- -ls:显示目录信息

hadoop fs -ls /sanguo

- -cat:显示文件内容

hadoop fs -cat /sanguo/shuguo.txt

- -chgrp、-chmod、-chown:Linux 文件系统中的用户一样,修改文件所属权限

hadoop fs -chmod 666 /sanguo/shuguo.txt

hadoop fs -chown an:an /sanguo/shugou.txt

- -mkdir:创建路径

hadoop fs -mkdir /jinguo

- -cp:从 HDFS 的一个路径拷贝到 HDFS 的另一个路径

hadoop fs -cp /sanguo/shuguo.txt /jinguo

- -mv:在 HDFS 目录中移动文件

hadoop fs -mv /sanguo/wuguo.txt /jinguo

hadoop fs -mv /sanguo/weiguo.txt /jinguo

- -tail:显示一个文件的末尾 1 kb 的数据

hadoop fs -tail /jinguo/shuguo.txt

- -rm:删除文件或文件夹

hadoop fs -rm /sanguo/shuguo.txt

- -rm -r:递归删除目录及目录里面的内容

hadoop fs -rm -r /sanguo

- -du:统计文件夹大小信息

hadoop fs -du -s -h /jinguo

输出结果为

27 81 /jinguo

27 表示文件大小,81 表示 27*3 个副本,/jinguo 表示查看的目录

hadoop fs -du -h /jinguo

输出结果为

14 42 /jinguo/shuguo.txt

7 21 /jinguo/weiguo.txt

6 18 /jinguo/wuguo.txt

- -setrep:设置 HDFS 中文件的副本数量

hadoop fs -setrep 10 /jinguo/shuguo.txt

这里设置的副本数只是记录在 NameNode 的元数据中,是否真的有这么多副本,还要看 DataNode 的数量。目前只有三台设置,所以最多也就三个副本,只有节点数量增加到10台时,才能有10个副本。

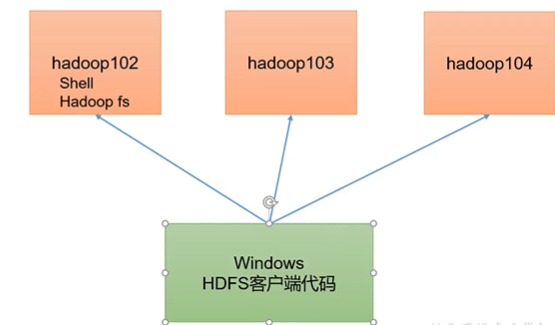

HDFS 的客户端 API

HDFS 的 API 操作

1、找到 Windows 依赖文件夹,拷贝 hadoop-3.1.0 到非中文路径。

2、配置环境变量

HADOOP_HOME .../hadoop-3.1.0

PATH %HADOOP_HOME%\bin

验证 Hadoop 环境变量是否正常,双击 hadoop-3.1.0 下的 winutils.exe,如果报错,说明缺少微软运行环境,安装对应的微软运行库包安装即可。

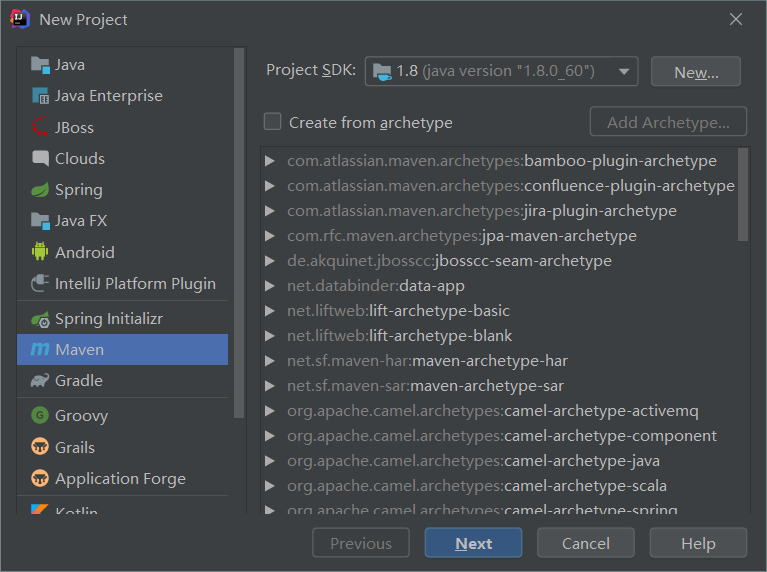

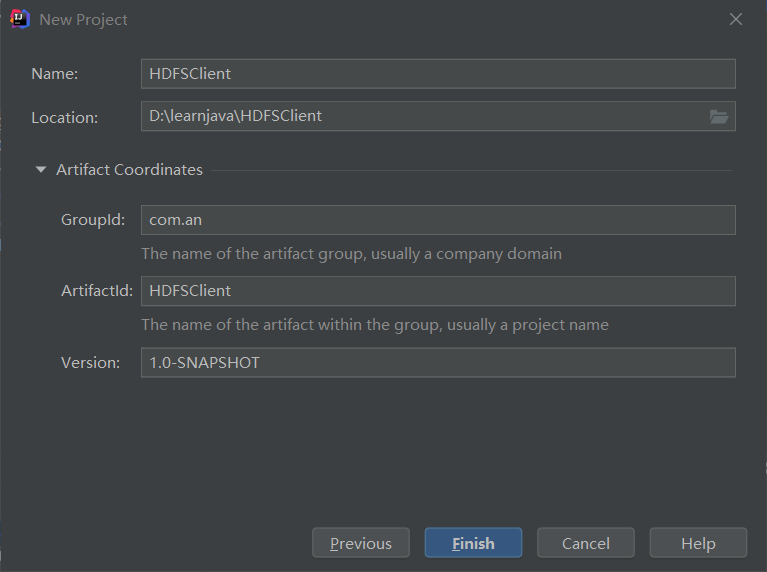

3、开启 IDEA,创建一个 Maven 工程

添加相关依赖

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.1.3</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.12</version>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>1.7.30</version>

</dependency>

</dependencies>

在项目的 src/main/resources 目录下,新建另一个文件,命名为 "log4j.properties",在文件中填入

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

创建包:com.an.hdfs

创建 HdfsClient 类

package com.an.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.junit.After;

import org.junit.Before;

import org.junit.Test;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

import java.util.Arrays;

/**

* @author an

* @create 2021-06-08-10:19

*

* 客户端代码常用套路

* 1、获取一个客户端对象

* 2、执行相关的操作命令

* 3、关闭资源

* HDFS zooKeeper

*

*/

public class HdfsClient {

private FileSystem fs = null;

@Before

public void init() throws IOException, InterruptedException, URISyntaxException {

// 连接到 nn 地址

URI uri = new URI("hdfs://hadoop102:8020");

// 创建一个配置文件

Configuration configuration = new Configuration();

// 用户

String user = "an";

// 获取到了客户端地址

fs = FileSystem.get(uri, configuration,user);

}

@After

public void close() throws IOException {

// 关闭资源

fs.close();

}

// 创建目录

@Test

public void testmkdir() throws URISyntaxException, IOException, InterruptedException {

// 创建一个文件夹

fs.mkdirs(new Path("/xiyou/huaguoshan1"));

}

/**

* 参数优先级

* hdfs-default.xml -> hdfs-site.xml -> 项目 resources 下的 hdfs-site.xml

* -> 代码里的配置

* @throws IOException

*/

// 上传

@Test

public void testPut() throws IOException {

// 参数解读,参数一:表示删除原始数据,参数二:是否运行覆盖,参数三:圆数据路径,参数四:目的路径

fs.copyFromLocalFile(false,false,new Path("D:\\sunwukong.txt"),new Path("/xiyou/huaguoshan"));

}

// 下载

@Test

public void testGet() throws IOException {

/*

参数解读

参数1:源文件是否删除

参数2:源文件路径 HDFS

参数3:目标地址路径 Win

参数4:false,进行校验,true,不进行校验

*/

fs.copyToLocalFile(false,new Path("/xiyou/huaguoshan"),new Path("D:\\"),false);

}

// 删除

@Test

public void testRm() throws IOException {

/*

参数解读

参数1:要删除的路径

参数2:是否递归删除

*/

fs.delete(new Path("/jdk-8u212-linux-x64.tar.gz"),false);

// 删除空目录

fs.delete(new Path("/xiyou/huaguoshan1"),false);

// 删除非空目录

fs.delete(new Path("/jinguo"),true);

}

// 文件的更名和移动

@Test

public void testmv() throws IOException {

/*

参数1:源文件路径

参数2:目标文件路径

*/

// 对文件名称修改

fs.rename(new Path("/wcinput/word.txt"),new Path("/wcinput/ss.txt"));

// 文件的移动和更名

fs.rename(new Path("/wcinput/ss.txt"),new Path("/test.txt"));

// 目录的更名

fs.rename(new Path("/wcinput"),new Path("/wcoutput"));

}

// 获取文件详细信息

@Test

public void fileDetail() throws IOException {

// 获取所有文件信息

RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path("/"), true);

// 遍历文件

while(listFiles.hasNext()) {

LocatedFileStatus fileStatus = listFiles.next();

System.out.println("======="+fileStatus.getPath()+"========");

System.out.println(fileStatus.getPermission());

System.out.println(fileStatus.getOwner());

System.out.println(fileStatus.getGroup());

System.out.println(fileStatus.getLen());

System.out.println(fileStatus.getModificationTime());

System.out.println(fileStatus.getReplication());

System.out.println(fileStatus.getBlockSize());

System.out.println(fileStatus.getPath().getName());

// 获取块信息

System.out.println(Arrays.toString(fileStatus.getBlockLocations()));

}

}

// 文件和文件夹判断

@Test

public void testFile() throws IOException {

FileStatus[] listStatus = fs.listStatus(new Path("/"));

for(FileStatus status : listStatus) {

if(status.isFile()) {

System.out.println("文件:"+status.getPath().getName());

}else {

System.out.println("目录:"+status.getPath().getName());

}

}

}

}

HDFS 的读写流程(重点)

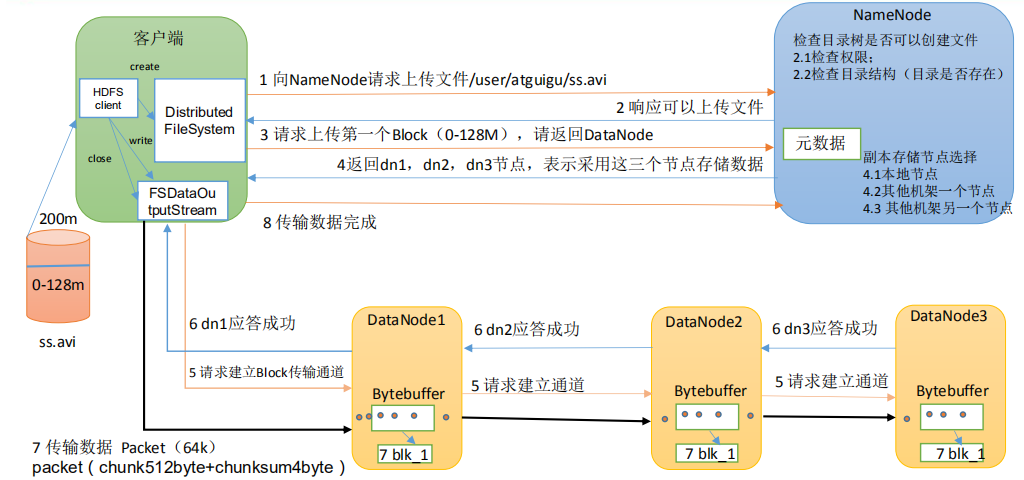

HDFS 写数据流程

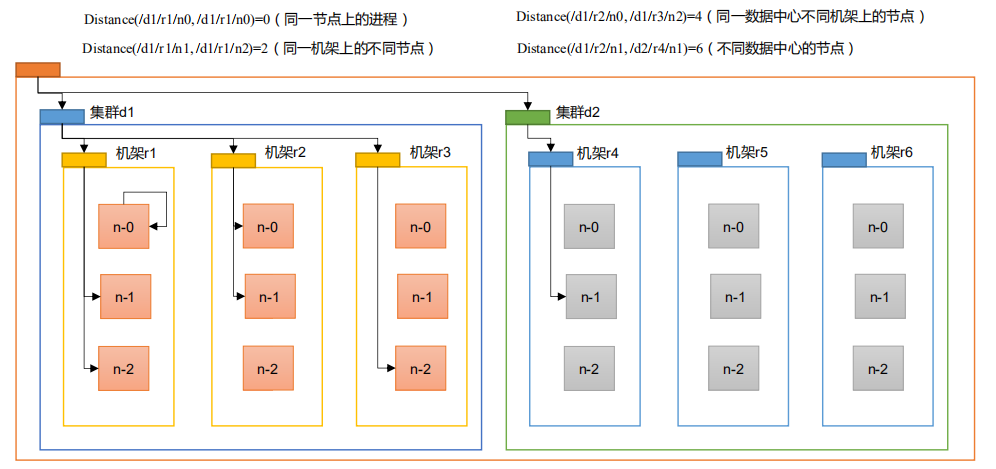

网络拓扑——节点距离计算

在 HDFS 写数据的过程中,NameNode 会选择距离待上传数据最近距离的 DataNode 接收数据。

节点距离:两个节点到达最近的共同祖先的距离总和。

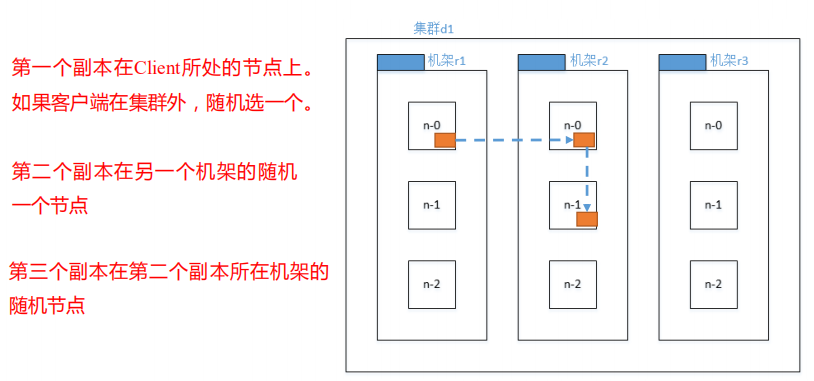

机架感知

即副本节点选择

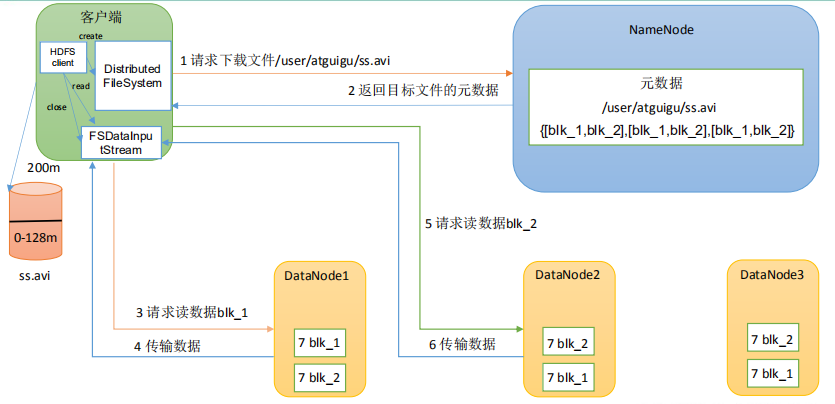

HDFS 读数据的流程

NN 和 2NN

NN 和 2NN 工作机制

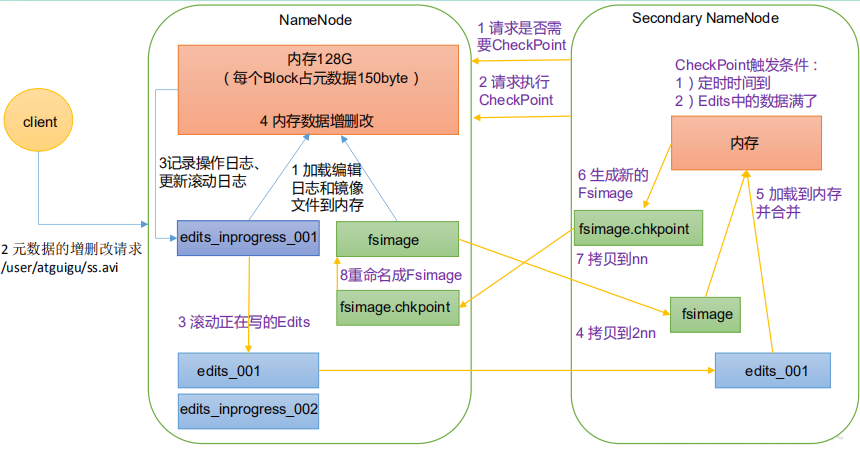

NameNode 中的元数据是存储在哪里的?

首先,做个假设,如果存储在 NameNode 节点的磁盘中,因为经常需要随机访问,还有响应客户请求,必然是效率过低。因此,元数据需要存放在内存中。但是如果只存在内存中,一旦断电,元数据丢失,整个集群就无法工作了。因此产生在磁盘备份元数据的 FsImage。

这样又带来新的问题,当在内存中的元数据更新时,如果同时更新 FsImage,就会导致效率过低,但如果不更新,就会发生一致性问题,一旦 NameNode 节点断电,就会产生数据丢失。因此,引入 Edits 文件(只进行追加操作,而效率很高)。每当元数据有更新或者添加元数据时,修改内存中的元数据并追加到 Edits 中。这样,一旦 NameNode 节点断电,可以通过 FsImage 和 Edits 的合并,合成元数据。

但是,如果长时间添加数据到 Edits 中,会导致该文件数据过大,效率降低,而且一旦断电,恢复数据的时间过长。因此,需要定期进行 FsImage 和 Edits 的合并,如果这个操作由 NameNode 节点完成,又会效率过低。因此,引入一个新节点 SecondaryNameNode,专门用于 FsImage 和 Edits 的合并。

- 第一阶段:NameNode 启动

(1) 第一次启动 NameNode 格式化后,创建 Fsimage 和 Edits 文件。如果不是第一次启动,直接加载编辑日志和镜像文件到内存。

(2) 客户端对元数据进行增删改的请求

(3) NameNode 记录操作日志,更新滚动日志

(4) NameNode 在内存中对元数据进行增、删、改

- 第二阶段:Secondary NameNode 工作

(1) Secondary NameNode 询问 NameNode 是否需要 CheckPoint。直接带回 NameNode 是否检查结果。

(2) Secondary NameNode 请求执行 CheckPoint。

(3) NameNode 滚动正在写的 Edits 日志。

(4) 将滚动前的编辑日志和镜像文件拷贝到 Secondary NameNode。

(5) Secondary NameNode 加载编辑日志和镜像文件到内存,并合并

(6) 生成新的镜像文件 fsimage.chkpoint

(7) 拷贝 fsimage.chkpoint 到 NameNode

(8) NameNode 将 fsimage.chkpoint 重命名为 fsimage

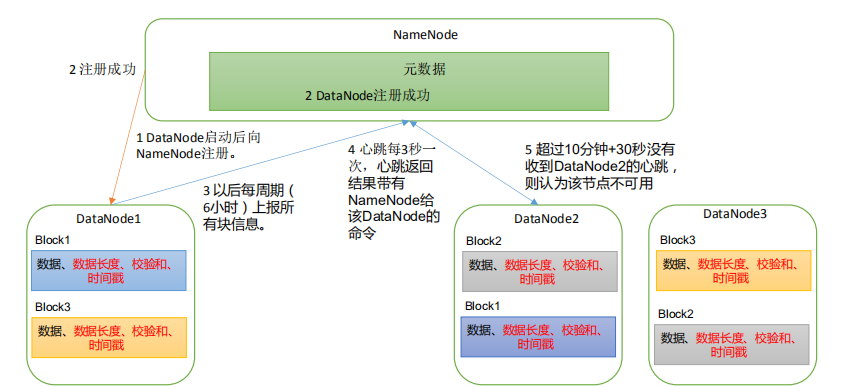

DataNode 相关工作机制

(1) 一个数据块在 DataNode 上以文件形式存储在磁盘上,包括两个文件,一个是数据本身,一个是元数据,包括数据块的长度,块数据的校验和,以及时间戳。

(2) DataNode 启动后向 NameNode 注册,通过后,周期性向 NameNode 上报所有的块的信息

(3) 心跳是每 3 秒一次,心跳返回结果带有 NameNode 给该 DataNode 的命令如复制块数据到另一台机器,或删除某个数据块。如果超过 10 分钟没有收到某个 DataNode 的心跳,则认为该节点不可用

(4) 集群运行中可以安全加入和退出一些机器

浙公网安备 33010602011771号

浙公网安备 33010602011771号