通过提示大语言模型进行个性化推荐LLM-Rec: Personalized Recommendation via Prompting Large Language Models

论文原文地址:https://arxiv.org/abs/2307.15780

本文提出了一种提示LLM并使用其生成的内容增强推荐系统的输入的方法,提高了个性化推荐的效果。

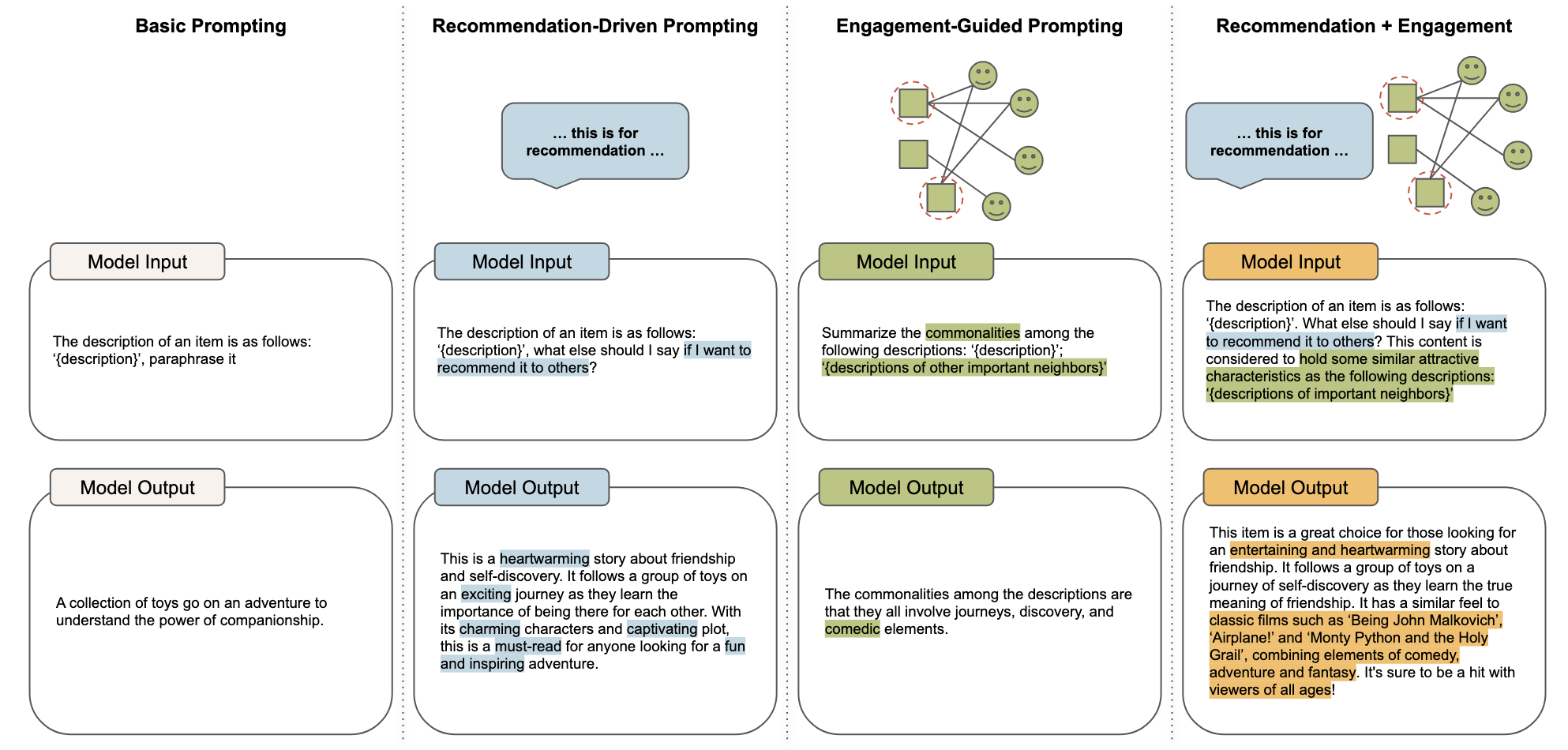

LLM-Rec Prompting

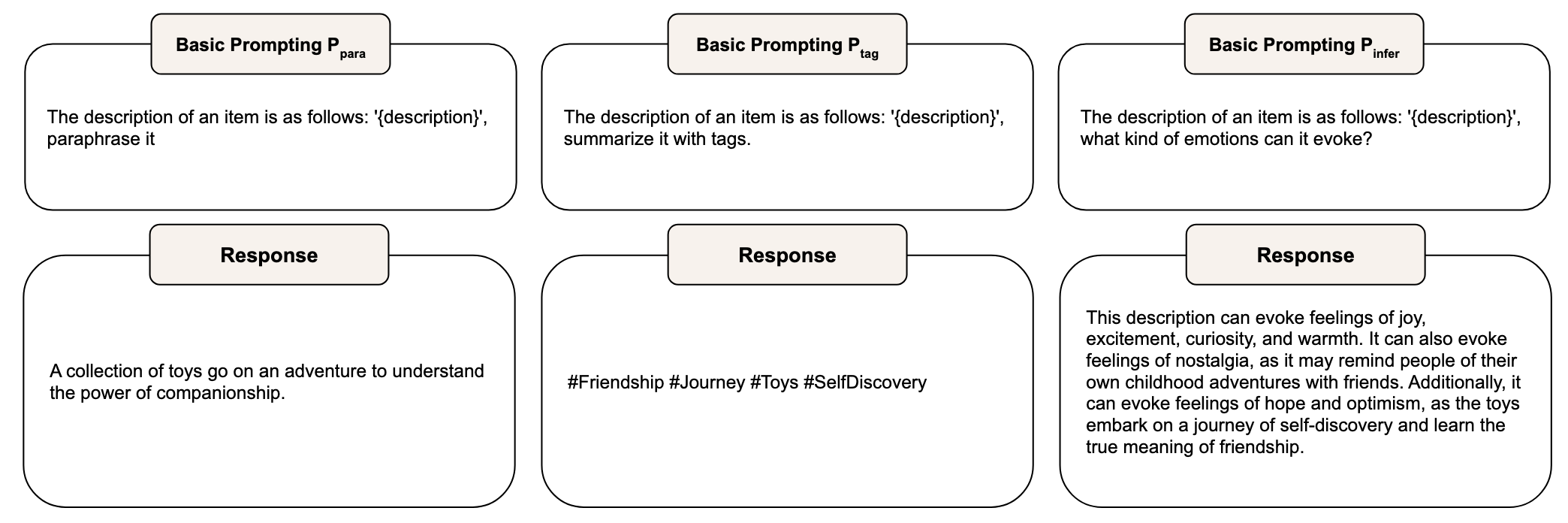

Basic prompting

基础提示,主要有以下三种

- \(P_{para}\):提示LLM对原始内容进行改述,尽量保持原本的意思不变,并且不加入额外的内容。

- \(P_{tag}\):提示LLM用标签总结原始内容,用更简洁的表述捕获关键信息。

- \(P_{infer}\):提示LLM对原始内容的特征进行一些推理,并提供一个比较宽泛的回答。

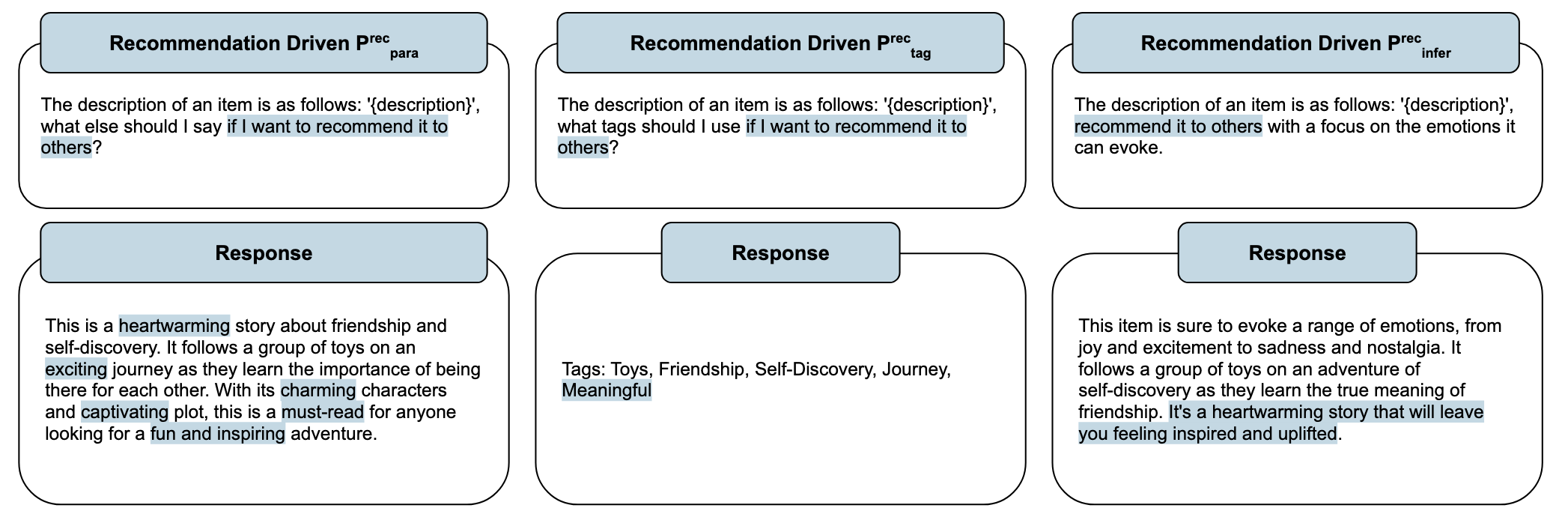

Recommendation-driven prompting

推荐驱动的提示,在基础提示的基础上增加推荐指令,例如“我想把它推荐给他人”这样的语句。这种提示可以使得生成的内容更适合推荐的场景(虽然作者提到了有三种特点,但是我觉得可以用这一句话概括)。

Engagement-guided prompting

参与引导的提示。简单来说,论文中作者根据user与item的交互(如果一个user常与两个item交互,那么这两个item相似度较高),计算出与当前item最相似的T个item,并在输入中,把这T个相似的item的描述也加入。这种方式可以使得LLM生成的内容与当前item更相关,更符合用户的偏好。

Recommendation-driven + engagement-guided prompting

推荐驱动的提示与参与引导的提示的结合。

Experiment

- Benchmarks:用到两个数据集MovieLens-1M和Recipe。

- Item module:

- Response generation:GPT-3(text-davinci-003)

- Text encoder:Sentence-BERT

- Engagement-guided prompting中的重要性度量:见上述。

- User module:大小为128的embedding

- User module:

- ItemPop:流行度推荐

- MLP

- AutoInt

- DCN-V2

- Model training:交叉熵损失

- Evaluation protocols:Precision、Recall、NDCG

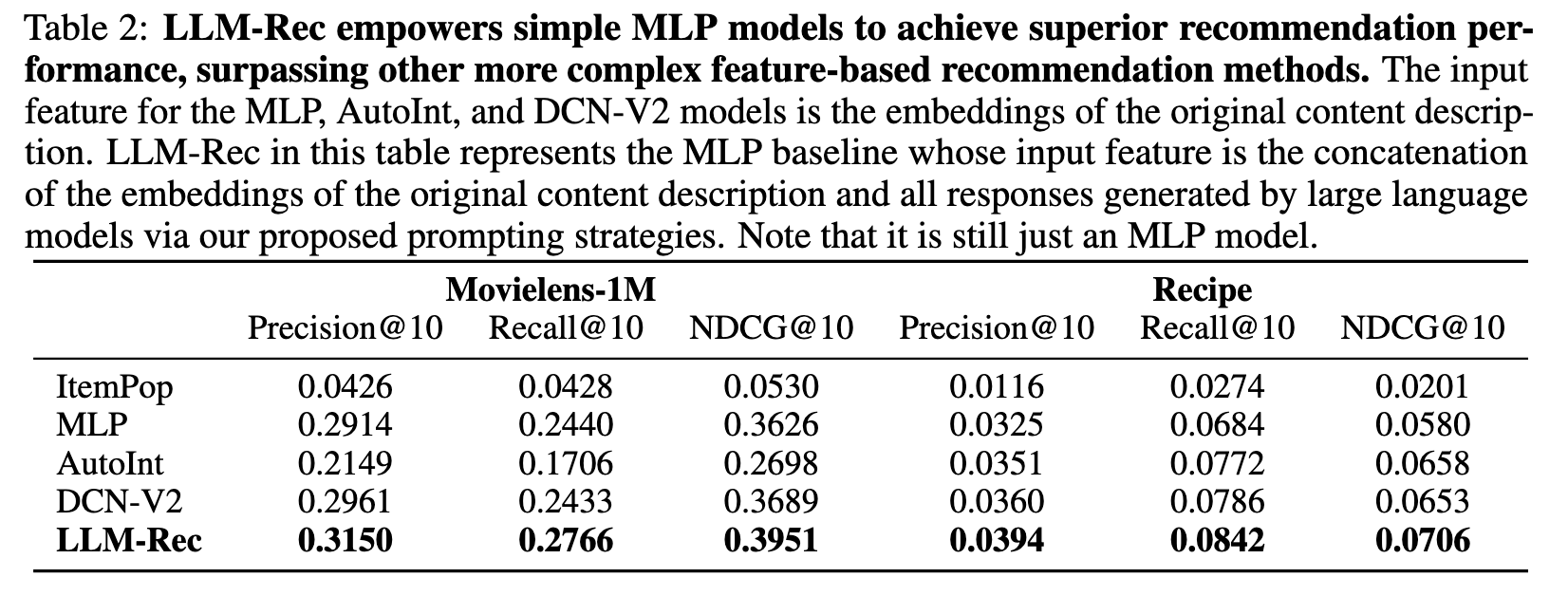

Results

整体的评估框架。

LLM-Rec(使用MLP作为推荐模型,只是输入使用LLM进行了增强)取得了最佳推荐表现,超越了其他更复杂的基于特征的方法。

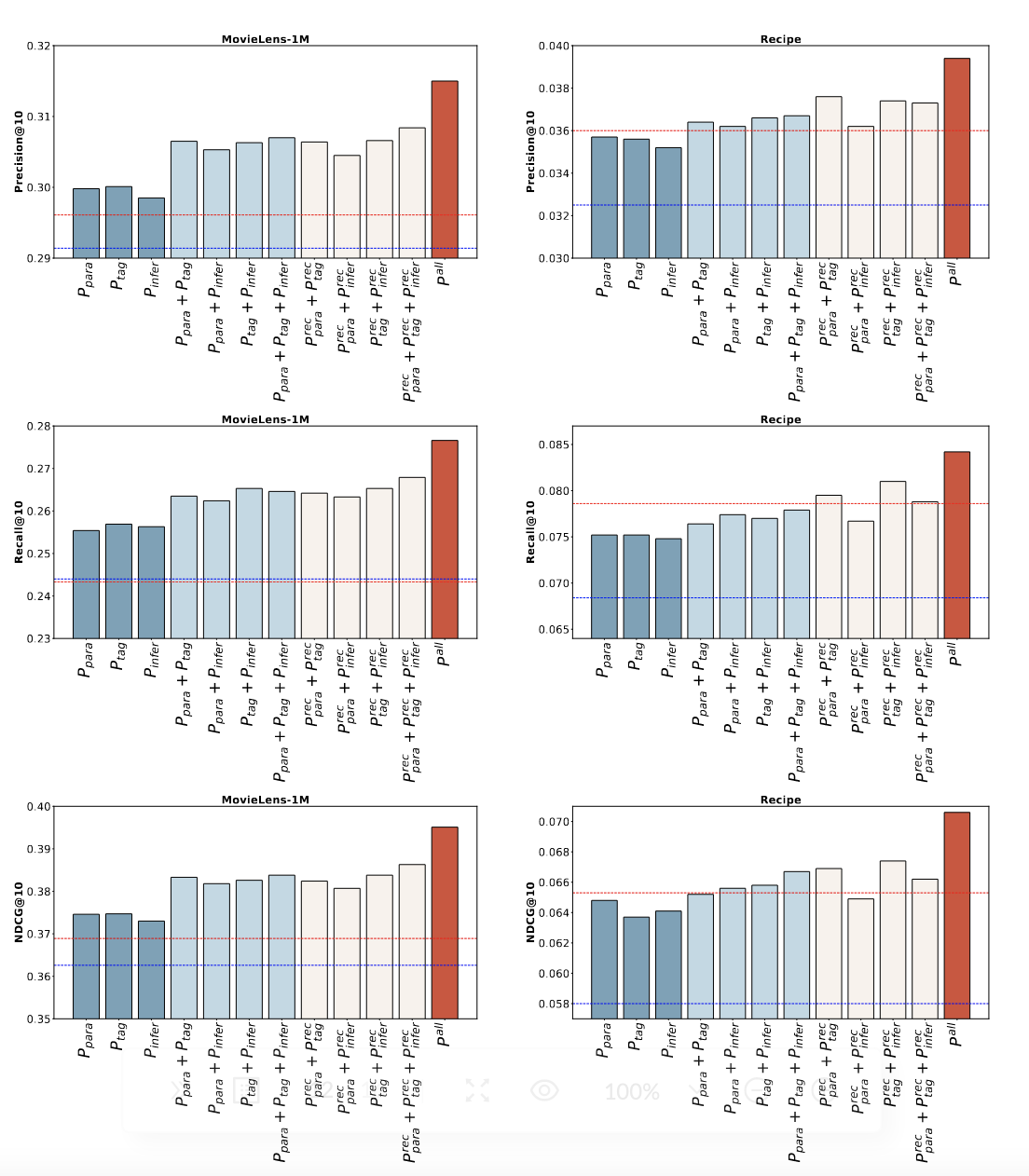

下表展示了每个提示策略的推荐性能,蓝线是只使用原始内容不进行数据增强的情况。

结合重要的关键字,而不是全部生成的内容,可以获得更好的推荐效果。

将生成的所有内容的embedding和原始内容的embedding拼在一起会有更好的推荐效果。

Summary

本文通过提示大模型对输入进行数据增强,提高推荐系统的推荐效果。通过试验结果可以看出,经过LLM增强后的输入对推荐有很大帮助,即使是只使用MLP作为推荐模型,也可以取得超越一些复杂的推荐模型的效果。将各种提示策略(转述、标签、推理)生成的内容进行集成后,会获取更好的效果,这表明生成的内容是互补的。但是,作者在实验中发现,通过推理进行数据增强并没有达到预期的效果,因为通过推理生成的内容已经超出了原始数据的范围,其对推荐可能会产生未知的影响,因此需要进一步研究如何设计出更合适的推理提示以及推理产生的内容对推荐的影响。