ResNet

相较于之前网络的优点:

1. 残差网络更容易优化。当深度增加的时候,残差网络的训练误差比普通网络低。

2. 当深度增加的时候,残差网络比起普通网络更易获得更高的准确率。

梯度消失/梯度爆炸:阻止收敛,难以训练

解决的方法一般有:

- 归一化初始化

- 中间层归一化

退化degradation:

现象:随着网络深度增加,准确率变得饱和然后迅速退化。

分析:这种退化不是由过拟合造成的,如果在合适深度的网络上叠加深度,会造成更高的训练误差。

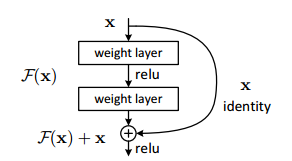

"残差"结构能够解决这种退化问题。

残差网络容易训练的原因如下:

https://blog.csdn.net/legend_hua/article/details/81741992

即随着深度加深,在梯度传导的过程中不会产生梯度消失或者梯度爆炸的情况

-

残差学习:

作者在另一篇论文中分析了几种basicblock在残差网络中产生的影响,论文名如下:

"Identity Mappings in Deep Residual Networks"

捷径shortcut:

A. 零填充捷径

B. 不同维度的结构之间使用投影捷径(1*1卷积),其他映射是恒等捷径

C. 所有结构之间使用投影捷径(1*1卷积)

Ref.

https://blog.csdn.net/wspba/article/details/72789964

http://spytensor.com/index.php/archives/14/?gyvkfy=8fvo03

https://www.cnblogs.com/yinheyi/p/6238968.html

-------------------------------------------------------------逆水行舟,不进则退。