《Unnoticeable Backdoor Attacks on Graph Neural Networks》

Abstract + introduction

GNNs 很容易受到对抗性攻击,并且目前针对图的有效后门攻击仍然是一个有待解决的问题。

图神经网络后门攻击一般步骤:

- 通过将触发器和伪造标签附加到训练图数据中的某些节点来感染图数据

- 在感染的图数据上训练 GNN

- 若想要让 GNN 模型对图中的某个节点/图做出被误导的预测(可以是攻击者想要的预测结果,也可以是错误的预测结果),那么只需要对该节点/图添加触发器(或者对图结构添加触发器)

虽然在图后门攻击方面已经有了一些初步的研究成果,但研究分析表明:它们可能需要大量的攻击预算来实现有效的后门攻击,并且注入的触发器可以很容易地检测和支剪。因此,本文研究了如何在有限攻击预算下进行隐蔽图后门攻击。

所以本文的研究重点在于,降低攻击预算以及提高攻击隐蔽性。

为了充分利用攻击预算,作者建议:

- 在感染阶段针对性选择感染节点来注入触发器和伪造标签。

- 部署自适应的触发器发生器以生成难以察觉的有效触发器子图。

GTA 算法采用的感染节点筛选方法就是随机筛选,而触发器的生成也是跟本篇作者类似的思路:采用了一个可训练的触发器生成器来生成有效的触发器子图。UGBA 与 GTA 的触发器生成器不同的是约束条件,UGBA 采用了余弦相似度约束了模型的优化,而 GTA 则是基于 bi-level optimizer 方法优化,即根据对 backdoored model 的攻击效果作为损失来反向优化触发器生成器,然后注入到 old backdoored model 进行训练优化模型,得到一个 new backdoored model。

作者通过在真实数据集上结合各种防御策略进行的大量实验,证明了 UGBA 有效性。

然后作者通过叙述图对抗性攻击算法的缺点,说明了图后门攻击的必要性

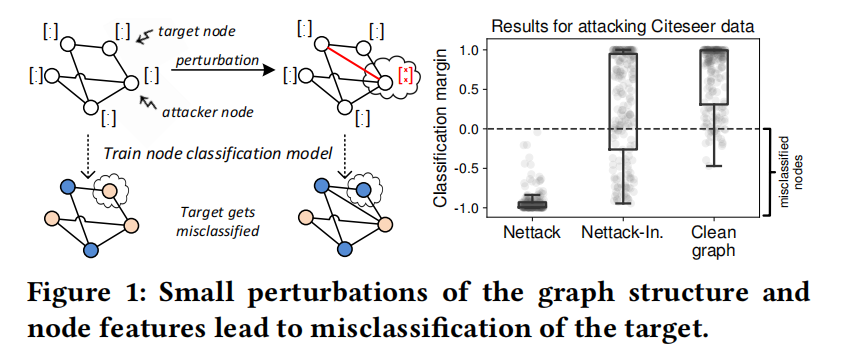

对抗性攻击算法 Nettack 的缺点即:在有限的攻击预算内迭代地修改图结构(可能是修改连边,也可能是修改节点的特征),从而降低模型的分类精度。

注意:这里的 “攻击预算” 不是指实施攻击需要计算的代价,而是限制对数据的修改程度。目的主要是为了隐蔽性。

然而,Nettack 大多数的攻击方式都会采用修改连边的策略,该策略需要计算添加/删除的最优边。这将导致在大规模数据集上产生难以承受的时间和空间复杂性(\(𝑂(N^2)\),其中 \(N\) 是节点个数)。此外,直接修改数据中节点的连边和特征是不切实际的,因为这些数据并不受攻击者的控制。

Nettack 的思路如下图所示:

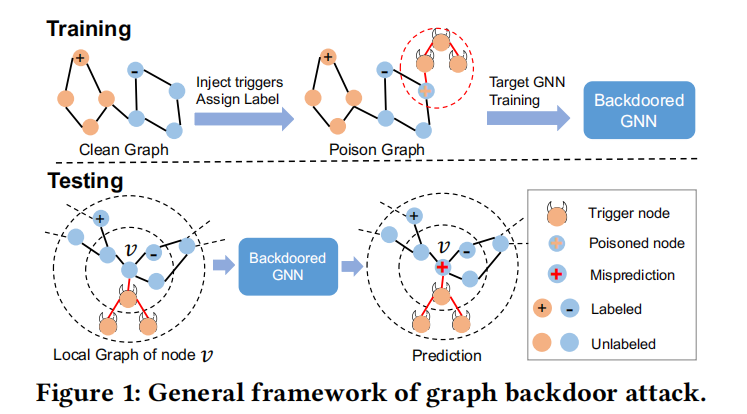

而后门攻击的方式能够解决上述对抗性攻击的缺陷。Fig.1 阐述了后门攻击的策略:

后门攻击跟对抗性攻击的主要区别在于:对抗性攻击并不攻击模型,而是攻击数据,对数据进行微小扰动导致模型作出错误的预测。总的来说,对抗性攻击的精髓在于只需要扰动数据就能够误导模型,但 Nettack 作为图对抗性攻击的开山之作它并没有很好地践行 “不攻击模型” 这个原则,因为它把脏数据交给模型训练了,这样的攻击效果其实是大打折扣的。而后门攻击的核心在于把感染了触发器子图的数据交给模型训练,让训练后的模型把附带了触发器子图的节点或者图预测为攻击者想要的分类。从攻击效果上来说,对抗性攻击更注重破坏模型,而后门攻击更注重操控模型。

后门攻击的优点在于:触发器子图可以是预设,也可以是由触发器生成器生成。首先,对比需要修改图结构的对抗性攻击,后门攻击的计算成本更少,若采用预设的触发器,则后门攻击几乎不需要任何计算成本;若采用触发器生成器,优化触发生成器也只需要对有毒样本进行预测的梯度。其次,一旦成功感染,就可以通过对目标节点附着触发器来轻松控制对目标节点的预测,而对抗性攻击如果要做到 “操控预测” 的效果,则对数据修改的行为进行额外的优化。

最近,Zhang 等人首次研究了一种使用随机生成的子图作为触发器的图后门攻击 SBA。Xi 等人随后又研究了基于触发器生成器的后门攻击 GTA。然而,这些方法在以下两个方面存在攻击隐蔽性问题。

Zaixi Zhang, Jinyuan Jia, Binghui Wang, and Neil Zhenqiang Gong. 2021. Backdoor attacks to graph neural networks. In SACMAT. 15–26.

Zhaohan Xi, Ren Pang, Shouling Ji, and Ting Wang. 2021. Graph backdoor. InUSENIX Security. 1523–1540.

-

3.3.1 中的分析表明:现有的后门攻击方法对于大规模的图数据需要大量的计算成本,也就是说,他们需要对大量的节点附加后门触发器。这很大程度上会导致后门攻击被检测出来。解决方法是:针对性筛选出少数感染节点来达到更好的效果 —— 满足隐蔽性,降低攻击成本。

-

3.3.2 中的分析表明:现有的后门攻击方法生成的触发器可以很容易地识别和销毁。具体来说,社交网络等现实图数据一般都遵循同质性假设,即相似节点可能靠的更近;而在现有的图后门攻击方法中,触发器子图的内部连边以及触发器与目标节点的连边并不能满足同质性假设。因此,只要修剪这些不满足同质性假设节点的连边以及标签就能够有效防止这种后门攻击。解决方法是:对生成的触发器子图使其满足同质性假设 —— 满足隐蔽性。

在本文中,作者基于上面两个核心思想提出了一种新的图后门攻击方法 UGBA,该方法满足了:低成本的攻击预算、隐蔽而有效的触发器。

2 RELATED WORKS

这里我只介绍图神经网络的后门攻击相关工作:

上面已经提到了 Zhang 跟 Xi 等人的两项图后门攻击研究,除此以外,Sheng 等人提出:选择具有高度紧密中心性的节点作为攻击节点;Xu and Picek 提出分配触发器但不改变感染节点的标签来提高隐蔽性。

而 UGBA 与这些方法有本质的不同,因为:

- 我们可以利用自适应的触发器,保持攻击的有效性的同时,绕过基于同质性假设的触发器防御机制

- 我们设计了一种新的基于聚类的感染节点选择算法,以进一步减少所需的攻击预算。

Yu Sheng, Rong Chen, Guanyu Cai, and Li Kuang. 2021. Backdoor attack of

graph neural networks based on subgraph trigger. In International Conference on Collaborative Computing: Networking, Applications and Worksharing. Springer, 276–296.Jing Xu and Stjepan Picek. 2022. Poster: Clean-label Backdoor Attack on Graph

Neural Networks. In CCS. 3491–3493.

3 PRELIMINARY ANALYSIS

在本节将初步介绍图的后门攻击,并展示现有的后门攻击方法存在的隐蔽性问题。

3.1 Notations

\(G=(V,\mathcal{E},X)\) 表示一个属性图,其中 \(V=\{v_1,...,v_N\}\) 是 \(N\) 个节点的集合,\(\mathcal{E}\) 是边的集合,\(X=\{x_1,...,x_N\}\) 是节点属性集合,\(A\) 是图 \(G\) 的邻接矩阵,如果节点 \(v_i\) 和 \(v_j\) 相连,\(A_{ij}=1\);否则 \(A_{ij}=0\)。在本文中,我们关注于 inductive setting 的半监督节点分类任务。具体来说,在 inductive setting 的节点分类中,训练数据为一组带标签节点 \(V_L⊆V\),标签为 \(Y_L=\{y_1,...,y_{N_L}\}\)。测试节点集合 \(V_T\) 不包含在训练图 \(G\) 中,即 \(V_T ∩ V=∅\)。

3.2 Preliminaries of Graph Backdoor Attacks

3.2.1 threat model

在本节将介绍 threat model

Attacker’s Goal:攻击者的目标是误导 GNN 模型,将附加有触发器的目标节点分类为攻击者设定的类别。同时理想状态下,backdoored GNN 并不会对没有附着触发器的节点有任何影响。

Attacker’s Knowledge and Capability:在大多数中毒攻击的设置中,攻击者已知目标模型的训练数据,但并不知道任何模型架构信息。攻击者能够在训练阶段开始之前将触发器和伪造标签附加到感染节点上。而在测试阶段,攻击者可以将触发器附加到测试节点。

3.2.2 General Framework of Graph Backdoor Attacks

后门攻击的关键思想是:将触发器和伪造标签与训练数据中的目标节点关联起来,从而误导目标模型。如 Fig.1 所示,在感染阶段,攻击者将触发器 \(g\) 附着到一组感染节点 \(V_p ⊆ V\),并为 \(V_p\) 分配伪造标签 \(y_t\),得到一个感染数据集。通常感染节点 \(V_p\) 是随机选择的(但 UGBA 会选择特定的节点集作为感染节点)。把感染数据集交给 GNN 训练,让GNN 将附着触发器的感染节点看作是伪造的类别。

在测试阶段,攻击者可以将触发器附着到测试节点上,使测试节点被 backdoored GNN 分类为攻击者设置的目标类别。

3.3 Unnoticeability of Graph Backdoor Attacks

3.3.1 Size of Poisoned Nodes.

在后门攻击中,一组感染节点将被附加触发器和伪造标签,以实现后门攻击。然而,对于大规模的图而言,攻击者可能需要注入大量的触发器和恶意标签才能成功误导模型,这导致了后门攻击易被检测出。

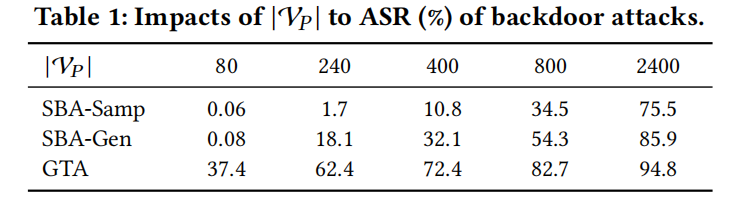

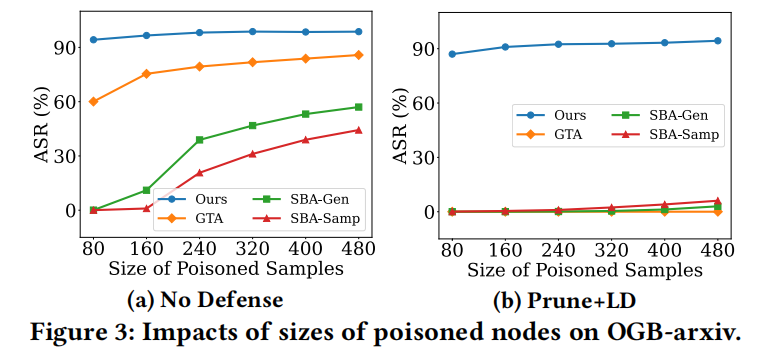

为了验证这一点,作者分析了感染节点个数对于目前三种现有图后门攻击方法成功率的影响:SBA-Gene、SBA-Samp、GTA,并采用尺寸较大的数据集 OGB-arxiv(节点个数 16,9343)。

我们将感染节点的个数分别设置为 \({80, 240, 800, 2400}\);触发器的尺寸被限制为 3 个节点;目标模型采用 GraphSage。攻击成功率(ASR)见 Table.1。

从表中可以看出,三种方法(特别是 SBA-Gen,SBA-Samp)在有限的感染节点预算下都取得了较差的 ASR。只有当感染节点个数设置为 2400(约占 OGB-arxiv 节点总数的 1.4%),攻击才取得了比较好的效果。而若限制 80 个感染节点,SBA-samp 和 SBA-Gen 的 ASR 连 0.1 都不到,GTA 稍微好一些能够达到 37.4 的 ASR,这是因为:

- SBA-Gen SBA-Samp 采用固定的触发器,这对后门攻击来说并不有效

- 虽然 GTA 采用自适应触发器,但跟 SBA-Gen SBA-Samp 一样都存在着同样的问题,即:感染节点的选择是随机的,有限的节点个数预算并没有被充分利用。

3.3.2 Detection of Triggers.

现实世界的图结构(如社交网络)通常具备同质性,即相似的节点往往会相连。而对于现有的后门攻击,触发器子图节点的特征可能与附着的感染节点有很大不同。触发器内部的连边也可能违反同质性。

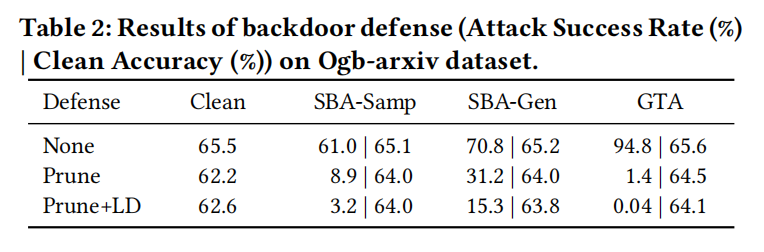

因此,只需要支剪掉这些不满足同质性的连边,并丢弃这些违背同质性假设节点的标签,就可以减少触发器和伪造标签的负面影响。为了验证这一点,我们评估了两种防御后门攻击的策略:

- Prune:对具有低余弦相似度的相连节点进行连边支剪

- Prune + LD:除了支剪外,还丢弃了低余弦相似度节点的标签。

我们固定感染节点个数 \(|V_P|\) 为 2400,在数据集 Ogb-arxiv 上进行实验,结果如 Table.2 所示。其他设置与 Sec 3.3.1. 相同,对于防御策略 Prune 和 Prune+LD,会支剪掉低于 10% 余弦相似度的边。

有关更多其他数据集的结果见 Table.4。Table.2 还报告了在 clean 测试集上的准确性,以展示防御策略对预测性能的影响。所有的结果以 5 次运行的结果取平均。

可以从上面的实验观察到:

- 采用防御策略后,对模型精度的损失并不多,甚至不到 3%。

- 而对于三种后门攻击,采用防御策略后 ASR 都显著地下降。

4 PROBLEM FORMULATION

第三节实验的初步分析验证了现有的后门攻击存在以下两个缺陷:

- 对于大型数据集需要大量攻击预算(即需要非常多的感染节点,否则攻击效果会显著下降)

- 攻击能够很轻易地被支剪防御。

为了解决这两个问题,作者提出了 UGBA,目的是利用有限的感染节点个数,隐蔽地攻击各种 GNNs。具体来说,我们将从以下两个方面建模后门攻击模型。

Selection of Poisoned Nodes \(V_p\): 目前现有的图后门攻击模型中,感染节点是随机挑选的,然而这种方式会浪费掉很多资源在一些无用的感染节点上。例如,攻击者可能会重复感染具备相似模式的节点,而这是没必要的,作者认为:对于一种特定的模式的节点,只需要感染一次或少数几次即可。为了充分利用攻击预算,我们将挑选最具有代表性的感染节点进行感染。

Unnoticeable Constraint on Triggers: 被注入的触发器因为不满足同质性所以能够被很轻易地被防御,因此有必要寻找一种满足节点同质性的触发器(不仅触发器内部的节点需要满足,触发器与感染的节点之间也需要满足,以避免被支剪策略砍掉连边)。作者将这样的触发器通过一个可优化的生成器生成。

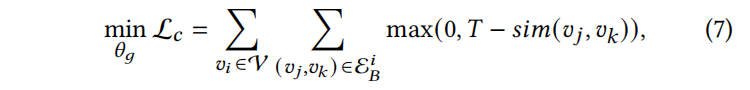

我们设 \({\varepsilon^i}_B\) 表示一个边集,它包含了触发器 \(g_i\) 和节点 \(v_i\) 内部所有的连边,生成自适应触发器的隐蔽性约束能够被表示为:

其中,\(sim\) 表示了节点特征之间的余弦相似度,\(T\) 是余弦相似度的一个相对较高的阈值(比如 10%)。

即,对于附着了触发器的感染节点,整个子图的所有相连节点之间的余弦相似度都大于 10%。

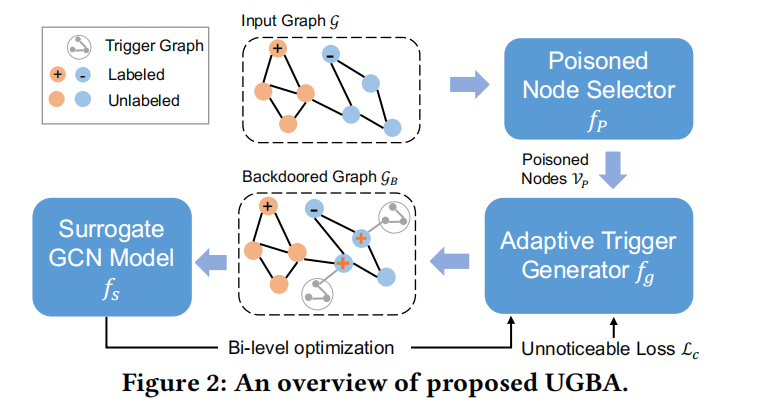

在 GNNs 的节点分类中:

-

预测过程被表示为 \(f_\theta(\mathcal{G}^i_C)\),即:对于干净数据中的节点 \(v_i\) 进行预测。(\(C\) 表示未被感染的标记)

-

而对于附着了触发器的节点 \(v_i\),预测过程则表示为 \(f_\theta(a(\mathcal{G}^i_C, g_i))\),其中 \(𝑎(·)\) 表示了附着触发器 \(g_i\) 到节点 \(v_i\) 的操作

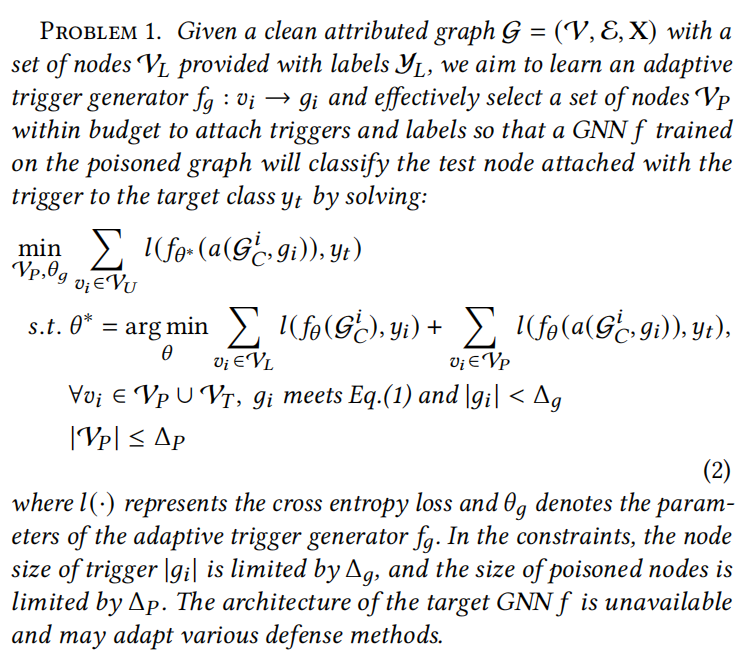

然后,我们通过下面的 Problem1. 对隐蔽的后门攻击进行公式化:

给定一个干净的图,以及带标签节点 \(V_L\) 和相应的标签集 \(Y_L\),我们的目标是学习一个触发器生成器 \(f_g\),它接受一个节点作为参数,然后生成该节点对应的触发器。除此以外,我们还要针对性地筛选感染节点集合 \(V_P\),然后我们把感染数据丢给 GNN \(f\) 进行训练,之后我们会在测试阶段附着触发器到测试节点,让 backdoored GNN 将测试节点分类为我们想要的类别 \(y_t\)。

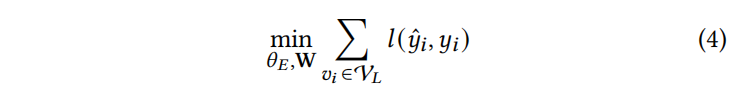

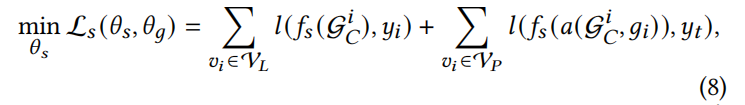

其中 \(𝑙(·)\) 代表了交叉熵损失,\(\theta_g\) 代表了触发器生成器 \(f_g\) 的参数。

在约束条件:

- 感染节点个数不超过 \(\triangle_P\)

- 对于训练集中的感染节点和测试集中的感染节点,触发器 \(g_i\) 都满足了 Eq1. 的同质性约束,并且触发器节点个数小于 \(\triangle_g\)

- GNN 在干净的数据上得到了充分的训练,针对干净数据 \(V_L\) 的预测损失和感染数据 \(V_P\) 上的预测损失 sum 有最小。

约束下,我们得到了感染模型 backdoored GNN \(f_\theta^*\),此时我们会筛选感染节点 \(V_P\),并利用触发器生成器生成触发器 \(g_i\)用感染模型对目标集合\(V_U\) 进行预测,使得感染模型对目标节点 \(V_U\) 的预测损失有最小。那么满足最小损失的触发器以及感染节点即是我们最终的目标。

由于我们关注的是 inductive setting 场景,该场景下测试集 \(V_T\) 不可用于优化模型,只能用于评估模型。为了优化触发器生成器,我们会利用到另一部分的节点 \(V_U\),\(V_U\) 将被设置为 \(V \verb|\| V_L\),即图 \(G\) 中无标签节点的集合,以确保攻击可以对各种类型的目标节点攻击。

5 METHODOLOGY

由于同时优化筛选感染节点和触发器生成器具有挑战性和高计算成本,因此 UGBA 将优化过程分为两个步骤:感染节点选择、触发器生成器学习。那么我们需要解决两个问题:

- 如何选择最具备代表性的的感染节点

- 如何学习触发器生成器,以获得满足隐蔽性约束的触发器,并在后门攻击中保持高成功率

为了解决这些问题,作者提出了 UGBA 的框架,如 Fig.2 所示:

整个优化过程和 GTA 的方式差不多:

- 通过聚类算法挑选出具备代表性的感染节点

- 通过触发器生成器拿到对应的触发器集合

- 附着触发器到图 \(G\) 中拿到脏数据

- 把脏数据丢到模型训练几轮,让模型识别触发器

- 评估后门攻击的损失,以及同质性约束的损失,以这两个损失优化触发器生成器

- 然后重复第 2 步 ~ 第 5 步,训练几轮直到触发器生成器足够好

UGBA 由一个感染节点选择器 \(f_p\),自适应触发器生成器 \(f_g\),GNN 模型 \(f_s\) 组成。具体来说,感染节点选择器将图 \(G\) 作为输入,并应用一种新的度量方案(比如聚类算法)来选择代表性的节点作为中毒节点。

自适应触发器 \(f_g\) 为选中的感染节点提供隐蔽的触发器,以欺骗模型。为了保证触发器生成器能满足各种类型的测试节点的有效性(即泛化能力),作者采用了双向优化的方式。外层循环优化触发器生成器,内层循环优化感染模型。一般是内层每走 20 次 epochs,外层走 1 次 epoch。

5.1 Poisoned Node Selection

直观地说,如果具有代表性特征和局部结构的节点在附着触发器后被预测为伪造标签 \(y_t\),那么其他具备相似特征或局部结构的节点也很可能被成功后门攻击。因此,我们建议在图中选择多样化且具有代表性的节点作为感染节点。

一种方法是直接对节点特征进行聚类。然而该方式没有考虑到图拓扑结构,那么如何考量图的拓扑结构呢?答案是:通过训练一个 GCN 来获取节点经过前向传播后的表征向量,这个向量不仅具备节点跟邻居的特征信息,也具备了跟邻居节点之间的结构属性。

因此我们不直接对节点特征进行聚类,而是对节点经过前向传递后的表征进行聚类,具体表示为下列公式:

而训练 GCN encoder 的损失则能够用下面的公式表示:

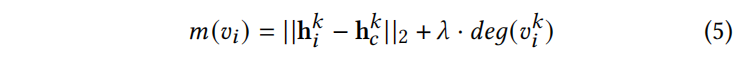

接着,我们通过 K-means 按类别分割表征集合,对于每个节点 \(v_i\) 的代表性得分,我们用其靠近聚类质心表征的欧式距离进行衡量,越靠近聚类质心的节点更具代表性。然而,最靠近质心的节点可能具有较高的节点度。将恶意标签注入到这种节点可能会导致预测性能明显下降,因为负面影响会传播到它的邻居节点,从而导致攻击变得容易被发现。因此,我们考虑加入节点的度进行得分考量,其中 \(\lambda\) 是控制节点度贡献的参数。

接着在每个聚类簇中筛选 \({\triangle P} * {(\frac{K}{size})}\) 个最高得分的节点。

我们的目的是:按每个簇占所有节点的比例来筛选每个簇中得分最高的前 n 个节点。比如所有节点是 200 个,分为 3 个簇,每个簇分别有 80、80、40 个节点,那么每个簇筛选的感染节点个数应该是 80(80/200)=32、80(80/200)=32、80*(40/200)=16。其中 \(\triangle P\) 表示为需要筛选的感染节点数,K表示每个簇中有多少个节点,size表示为总共有多少个节点。

5.2 Adaptive Trigger Generator

一旦确定了感染节点集合 \(V_P\),下一步就是使用 \(f_g\) 生成触发器来感染数据集。为了保证所生成的触发器的隐蔽性,我们提出了一个可微的隐蔽性损失。我们在触发器生成器 \(f_g\) 和模型 \(f_s\) 之间应用了 bi-level optimization,以确保触发器生成器在各种测试样本上泛化能力。其次,我们给出了触发器生成器的优化细节、隐蔽性损失的细节、以及 bi-level optimization with \(f_s\) 的细节。

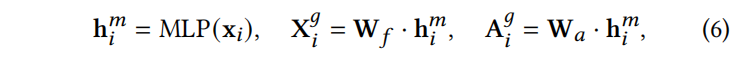

Design of Adaptive Trigger Generator. 为了生成一个自适应触发器,且该触发器满足与感染节点的同质性假设,触发器生成器 \(f_g\) 会利用目标节点的特征作为输入,并采用 MLP 生成一个嵌入 \({h^m}_i\),并利用嵌入同时生成触发器子图的节点特征以及结构。

其中,\(x_i\) 是 \(v_i\) 的节点特征,\(W_f\) and \(W_a\) 分别是对于触发器子图特征以及结构生成的可学习参数。

\({X^g}_i ∈ R^{s×d}\) 是触发器节点的融合特征,其中 s 和 d 分别代表了触发器节点的个数;每个节点的特征维度。

\({A^g}_i ∈ R^{s×s}\) 是触发器的邻接矩阵。

由于现实世界的图通常是离散的,因此我们通过 BNN 在前向传播中生成连续值形式的二值化的邻接矩阵;连续值则用于反向传播。

随着生成的触发器 \(g_i = ({X^g}_i, {A^g}_i)\),我们将其链接到节点 \(v_i ∈ V_P\),并且赋值目标分类 \(y_t\) 以构建一个后门数据集。在测试阶段,将 \(f_g\) 生成的触发器附加到测试节点 \(v ∈ V_T\) 上,引导 backdoored GNN 将其预测为目标类 \(y_t\)。

Differentiable Unnoticeable Loss. 自适应触发器生成器 \(f_g\) 目标是生成一个满足 Eq.1 隐蔽性的触发器。关键的思想是:确保生成的自适应触发器节点内部之间,以及与所连接的感染节点之间,能够满足同质性假设,以避免被防御策略检测到。因此,我们设计了一个可微的隐蔽性损失,以用于优化触发器生成器 \(f_g\)。

设 \({\varepsilon^i}_B\) 为边集,包含了触发器以及感染节点中的连边,隐蔽性损失可以被表示为:

其中 T 表示余弦相似度的最大阈值。隐蔽性损失被应用于所有的节点 \(V\) 以确保生成的触发器能够满足所有类型的节点。

简单来说,上面的公式可以理解为:当两个相连节点的余弦相似度低于阈值,那么低于阈值的差值就会被加到损失上。若高于阈值,那么我们认为此时不存在损失。

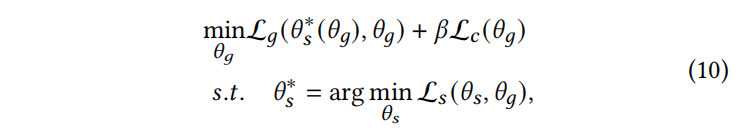

\(Bi-level Optimization.\) 为了保证生成的触发器的有效性,我们通过 bi-level optimization 对自适应触发器生成器进行了优化。可以用公式表示为:

即:保证模型在 clean 数据集上预测正常,也能够让注入触发器的节点成功被预测为伪造标签。其中 \(\theta_s\) 代表代理模型 GCN \(f_s\) 的参数。

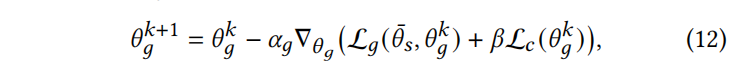

那么结合隐蔽性损失以及模型预测损失,bi-level optimization 能够被表示为:

即,用当前的触发器生成器生成触发器子图注入触发器到数据集,然后走几轮 epochs 降低模型对当前的 clean and dirty 数据集预测的损失,然后加权注入了触发器之后数据集的隐蔽性损失。通过优化损失能够得到一个更好的生成器模型。然后继续生成触发器注入到数据集...重复以上步骤。

5.3 Optimization Algorithm

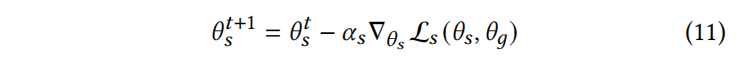

我们提出了一个交替优化方案来以小计算量解决 Eq.10 的计算。

Updating Lower Level Surrogate Model. 若外层每优化一次生成器内层就优化一次 GNN 模型,这种方式在计算上是非常耗时的,因此我们考虑内层优化 GNN 模型 N 次,外层生成器优化一次。

Updating Upper Level Surrogate Model. 在外部迭代中,我们固定住模型的参数不变,用优化后的生成器生成触发器感染护具,然后在内层优化中优化几轮模型,得到相应的模型损失和隐蔽性损失,再进一步优化外部生成器。

6 EXPERIMENTS

在本节中,我们将在各种大型数据集上评估 UGBA 的性能,并回答以下问题:

- RQ1: UGBA 能否对 GNN 进行有效的后门攻击,同时确保隐蔽性?

- RQ2: 感染节点的个数对后门攻击性能的影响?

- RQ3: 自适应约束和感染节点的选择对攻击性能的影响?

6.1 Experimental Settings

6.1.1 dataset

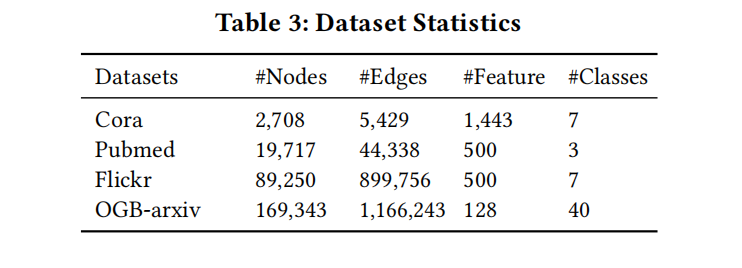

我们在 4 个公共的真实数据集上进行实验,即:Cora、Pubmed、Flickr、OGB-arxiv,这些数据集被广泛用于 inductive setting 的半监督节点分类任务。Cora、Pubmed 是小型的论文引用图;Flickr 是一个大规模的图,每个节点都对应了 Flickr 网站中的一个图像,相连的图像具备相同类型的图像标题。OGB-arixv是一个大规模的论文引用图。详情见 Table.3:

6.1.2 Compared Methods

我们比较了 UGBA 与当下具有代表性的图后门攻击方法,包括 GTA、SBA-Samp、SBA-Gen。我们还比较了再 Pubmed 数据集上 GBAST 和 UGBA 的性能。

由于 UGBA 通过向节点注入触发器来进行攻击,我们还将 UGBA 与两种最先进的大型图结构逃逸攻击(TDGIA 和 AGIA )进行了比较。

为了进行公平的比较,所有攻击方法的超参都基于验证集的性能进行了调整。

Competing with Defense Methods. 我们应用了 Sec3.3.2 中引入的防御策略,以评估后门攻击的隐蔽性。此外还选择了两个具有鲁棒性的 GNN,即 RobustGCN、GNNGuard,以验证 UGBA 也能有效攻击具备鲁棒性的 GNN。

6.1.3 Evaluation Protocol

在本文中,我们在 inductive setting 的分类任务上进行了实验,当攻击者试图感染数据时,他们无法访问测试节点。因此我们从原始数据集中随机抽取 20% 的节点。其中一半被用作 target 节点评估攻击性能;另一半作为干净的测试节点评估感染模型对正常样本的预测精度。其余 80% 节点将作为训练集,其中含标记的节点集、验证集各包含 10% 的节点。最终会利用 target 节点集上的平均成功率(ASR)和干净测试节点上的精度来评估后门攻击。

架构上统一使用两层图卷积。为了证明后门攻击的可移植性,我们对不同的架构实施攻击(GCN、GraphSage、GAT)。分别对每种架构进行 5 次实验,总计 15 次实验,我们会对 15 次 ASR 以及精度取平均。

对于所有的数据集都设置伪造类别为 label 0。对于 Cora、Pubmed、Flickr、OGB-arxiv 4个数据集,分别设置中毒节点的个数为 10、40、80、160。

所有实验中触发器节点数限制为 3 个。(关于改变触发器节点数的实验请参考 App.E)。

UGBA 采用一个 2 层的 MLP 作为自适应触发器生成器。(关于超参数设置的更多细节见 App.B)。

6.2 Attack Results

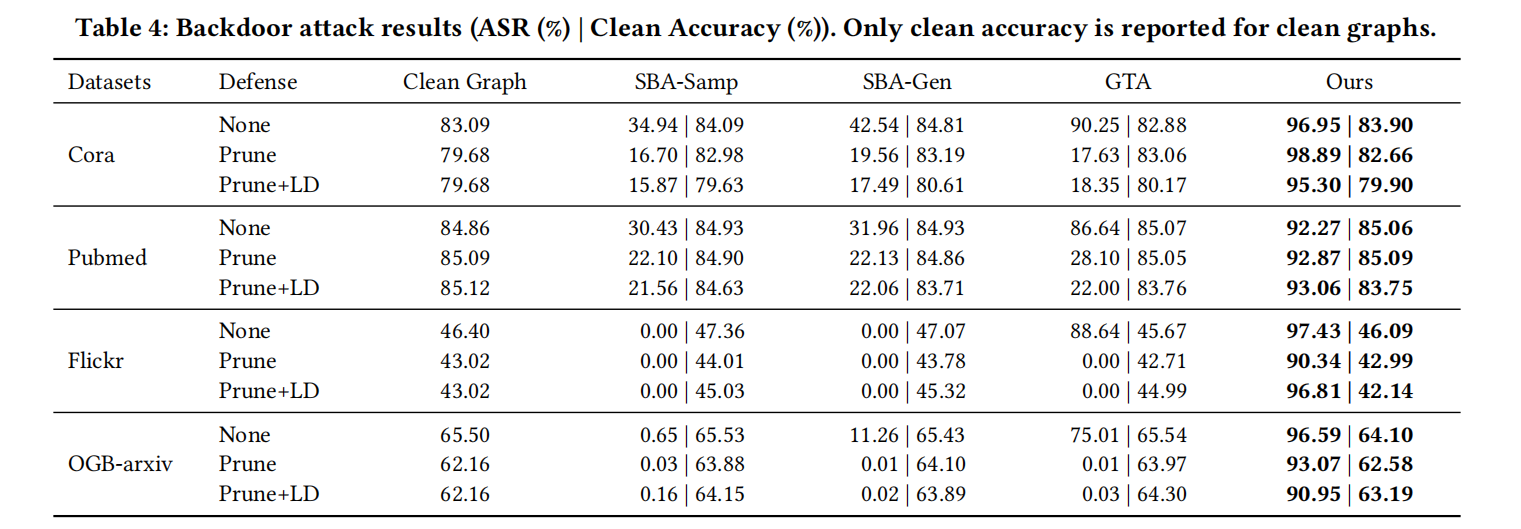

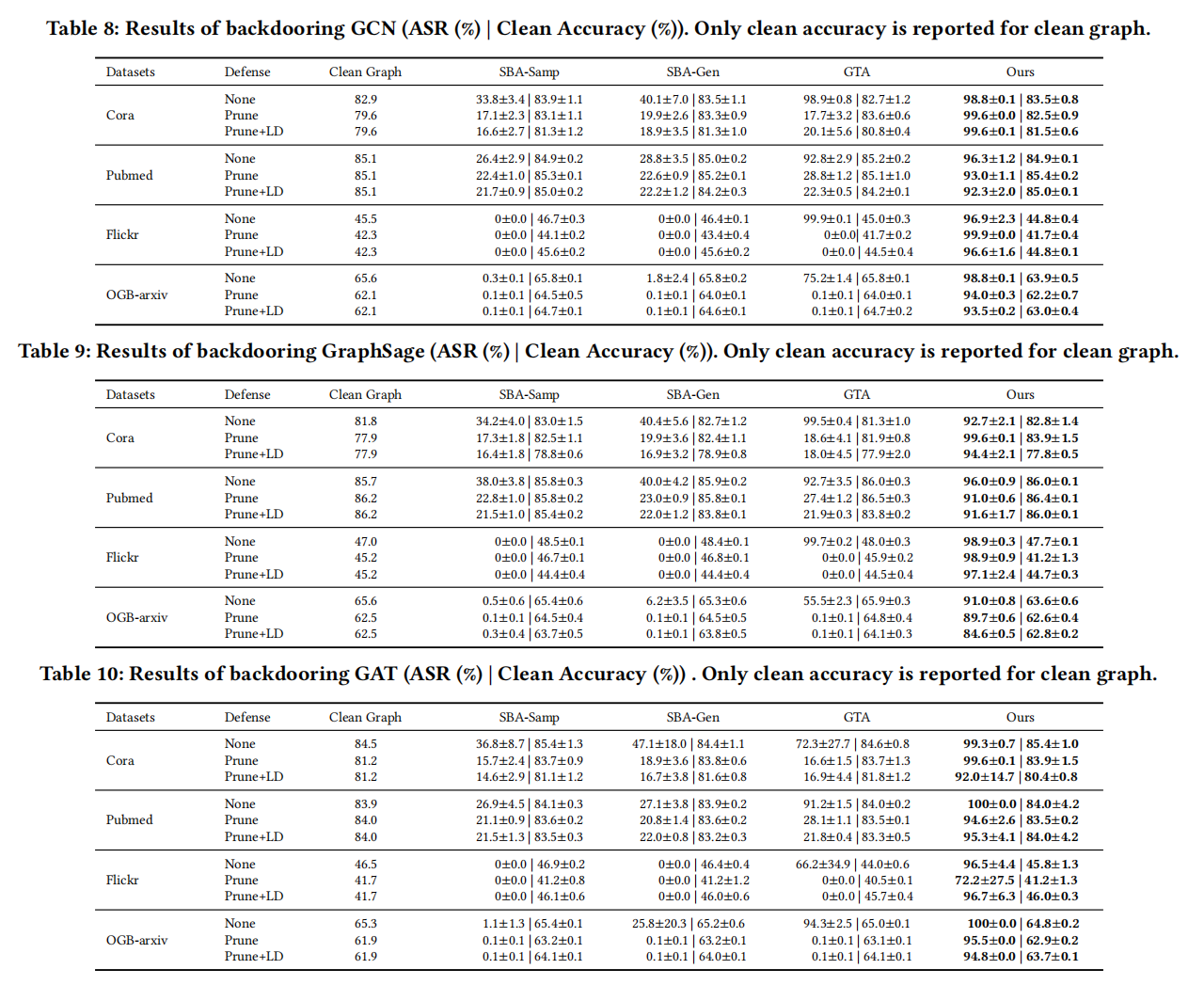

为了回答 RQ1,我们在不同的防御策略下对 UGBA 的攻击性能和隐蔽性进行了比较。

6.2.1 Comparisons with baseline backdoor attacks

我们在 3 种防御策略下对 4 个数据集进行了实验。我们在 Tab.4 中报告了三个 GNN 架构的平均结果。并在 Tab.8 ~ Tab.10 中报告了 3 个架构的具体结果:

从上表可以很明显看出:

- 当没有设置防御策略时,UGBA 优于其他方法,特别是在大规模数据集上。这表明了感染节点选择算法的有效性。

- 当设置防御策略时,其他三个攻击方法效果都较差。相比之下 UGBA 可以达到 90% 以上的 ASR,并保持较高的模型精度。这表明 UGBA 可以为后门攻击生成有效的和隐蔽的触发器。

- 由于 ASR 是三种不同架构的平均结果,UGBA的 高 ASR 得分证明了其在不同类型 GNN 模型中的可转移性。

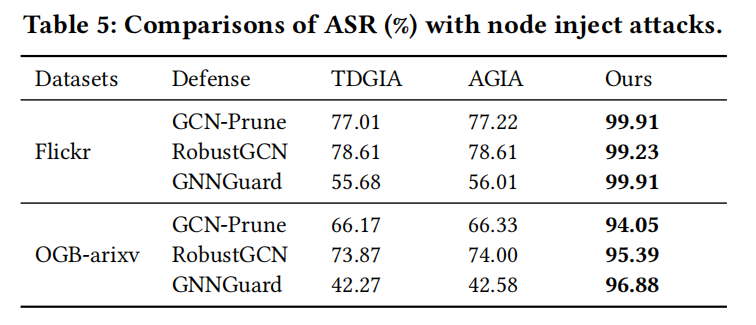

6.2.2 Comparisons with baseline node injection attacks

我们还比较了 UGBA 与两种最先进的节点注入逃避攻击。分别对 Flickr 和 OGB-arxiv 进行了实验。选择了三种防御模型(GCN-Prune、RobustGCN、GNNGuard)来防御攻击。Tab.5 中报告了 5 次运行的平均 ASR。

从这个表中,我们可以观察到:

- UGBA 可以有效地攻击具备鲁棒性的 gnn,这表明 UGBA 也可以绕过约束不明显的一般防御方法。

- 与节点注入攻击相比,UGBA 只需要在注入触发器和标签方面花费非常小的额外成本(例如在 OGB-arxiv 中 169K 个节点中仅有 160 个感染节点)。但是 UGBA 却可以比节点注入攻击效果好大约 30%。这意味着 UGBA 在攻击大型数据集方面具有优越性。

6.3 Impacts of the Sizes of Poisoned Nodes

为了回答 RQ2,我们探究了在不同毒节点个数下 UGBA 的攻击性能。

具体来说,我们将有毒样本的大小改变为 {80、160、240、320、400、480}。其他设置与 Sec6.1.3 中的实验设置相同。超参数的选择过程与 App.B 中描述的相同。Fig.4 显示了在 OGB-arxiv 上实验的结果:

从上图可以看出:

- 在无论是否设置防御策略,所有攻击方法的 ASR 都随着感染节点个数的增加而增加。但 UGBA 始终优于基线,这表明了 UGBA 有效性。特别是当攻击预算越小,UGBA 与基线之间的差距越大,这说明了感染节点的选择对攻击有效性具备显著影响。

- 当防御策略设置时,UGBA 仍然取得了良好的性能,而所有基线方法在所有设置中的 ASR 几乎为 0%。这是因为隐蔽性约束使得 UGBA 可以生成满足节点同质性的触发器节点,这有助于绕过防御策略。

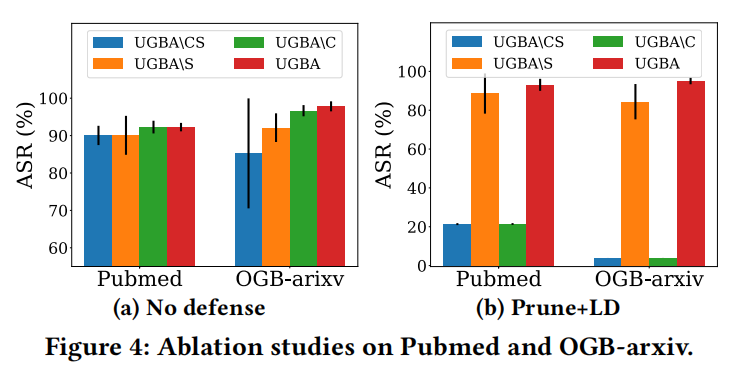

6.4 Ablation Studies

为了回答 RQ3 我们进行了消融研究,以探索不明显的约束和中毒节点选择模块的影响。为了证明隐蔽性约束的有效性,我们在训练生成器时将 \(𝛽\) 设置为 0,并获得一个名为 UGBA\C 的变体。为了证明感染节点筛选算法带来的好处,我们训练了一个变体 UGBA\S,它将随机选择中毒节点。我们同时删掉隐蔽性约束和中毒节点筛选算法来实现一个变体 UGBA\CS。在 Pubmed、OGB-arxiv 上实验的平均结果和标准差如 Fig.4 所示:所有设置都遵循 Sec6.1.3. 且超参数会根据验证集进行调整,以进行公平比较

从 Fig.4 中我们可以观察到:

- 与 UGBA\S 相比,UGBA 在各种防御策略下取得了更好的攻击效果。UGBA 的 ASR 方差显著低于 UGBA\S。这是因为感染节点选择算法始终会选择对后门攻击有用的节点。

- 当设置防御策略时,UGBA 的性能可以大大超过 UGBA\C 和 UGBA\CS。这意味着隐蔽性损失可以引导触发器生成器为各种测试节点提供满足同质性的触发器,这可以有效地绕过防御。

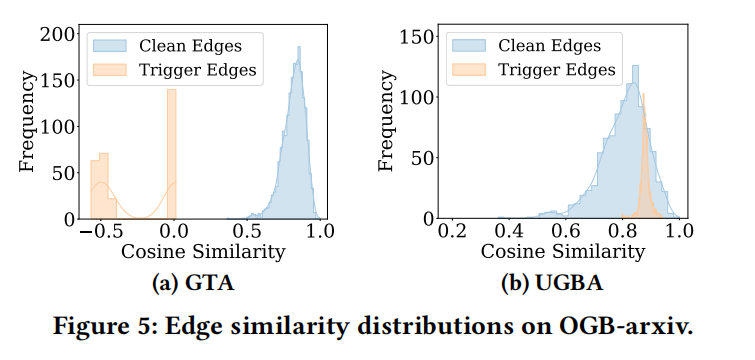

6.5 Similarity Analysis

为了进一步探索触发节点的相似性,我们同时使用 GTA 和 UGBA 在 OGB-arxiv 数据集上进行后门攻击,然后计算触发边(即与触发节点相关的边)和干净边(即未连接到触发节点的边)的边缘相似性。边缘相似度得分的直方图如 Fig.5 所示:

从图中,我们观察到 GTA 产生的触发器子图的相似性很低,相比之下, UGBA 的触发器连边呈现出较高的余弦相似度分数,这验证了我们的方法的隐蔽性。

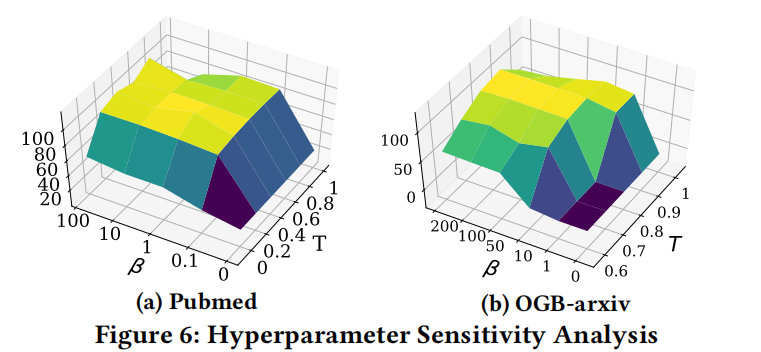

6.6 Parameter Sensitivity Analysis

为了进一步研究了超参 \(\beta\)(感染节点个数)、\(T\) (余弦近似度阈值) 对 UGBA 性能的影响,对于 pubmed 数据集我们将 \(\beta\) 变化设置为 {0、50、100、150、200},T 的变化设置为 {0、0.2、0.4、0.6、0.8、1} 应用于 pubmed;{0.6、0.7、0.8、0.9、1} 应用于 OGB-arxiv。

在 Fig.6 中报告了不同超参下,防御策略对 ASR 的影响:

我们观察到:

- 在 Pubmed 中,相似度阈值 T 需要大于 0.2;而在 OGB-arxiv 中,T 需要大于 0.8。这是因为 OGB-arxiv 中的边比 Pubmed 表现出更高的相似性得分。因此为了避免被检测到攻击,需要更高的相似性阈值。在实际应用中,T 可以根据数据集的平均相似度得分进行设置。

- 当 T 被设置为一个适当的值时,当 $\beta ≤1 $ 时,通常可以得到较高的 ASR,这简化了超参数的调优。

7 CONCLUSION AND FUTURE WORK

本文验证了现有的后门攻击需要大量的攻击预算,并且可以很容易地用支剪策略防御。为了解决这些问题,作者研究了一个在有限攻击预算下进行隐蔽图后门攻击的新方法。具体是采用一种新的感染节点选择算法,选择具有代表性和多样性的节点作为感染节点,以充分利用攻击预算。自触发器生成器通过隐蔽性约束额损失确保生成的触发器的隐蔽性。双向优化进一步保证了生成触发器的有效性。在大尺度数据集上的大量实验表明,我们提出的方法可以有效地后门化各种 GNN 模型,甚至可以绕过防御策略。