本周总结(hadoop安装和数据库小学期)

一:做的事情:安装了hadoop和完成了数据库小学期的作业。鉴于数据库的小学期是完成一个增删改查系统,这之前已经做过很多次了。这里就不再详细说明了,总之就是中规中矩地写完然后再整理成老师的要求。这周在学习上大概花了四天,三天写代码,一天安装软件,解决问题两个小时左右;

二:遇到的问题:安装hadoop的时候运行成功但是界面没出来(通过下载lib/native和添加环境变量解决)

三:下周准备开始了解老师所要求学习的东西(大数据技术)

在此简单介绍一下hadoop:Hadoop是一个由Apache基金会所开发的分布式系统基础架构。用户可以在不了解分布式底层细节的情况下,开发分布式程序。充分利用集群的威力进行高速运算和存储。Hadoop实现了一个分布式文件系统( Distributed File System),其中一个组件是HDFS(Hadoop Distributed File System)。HDFS有高容错性的特点,并且设计用来部署在低廉的(low-cost)硬件上;而且它提供高吞吐量(high throughput)来访问应用程序的数据,适合那些有着超大数据集(large data set)的应用程序。HDFS放宽了(relax)POSIX的要求,可以以流的形式访问(streaming access)文件系统中的数据。Hadoop的框架最核心的设计就是:HDFS和MapReduce。HDFS为海量的数据提供了存储,而MapReduce则为海量的数据提供了计算 。

下面详细说一下hadoop的安装。

没有安装homebrew可以:/bin/zsh -c "$(curl -fsSL https://gitee.com/cunkai/HomebrewCN/raw/master/Homebrew.sh)

先安装,然后完成后输入brew -v查看是否成功

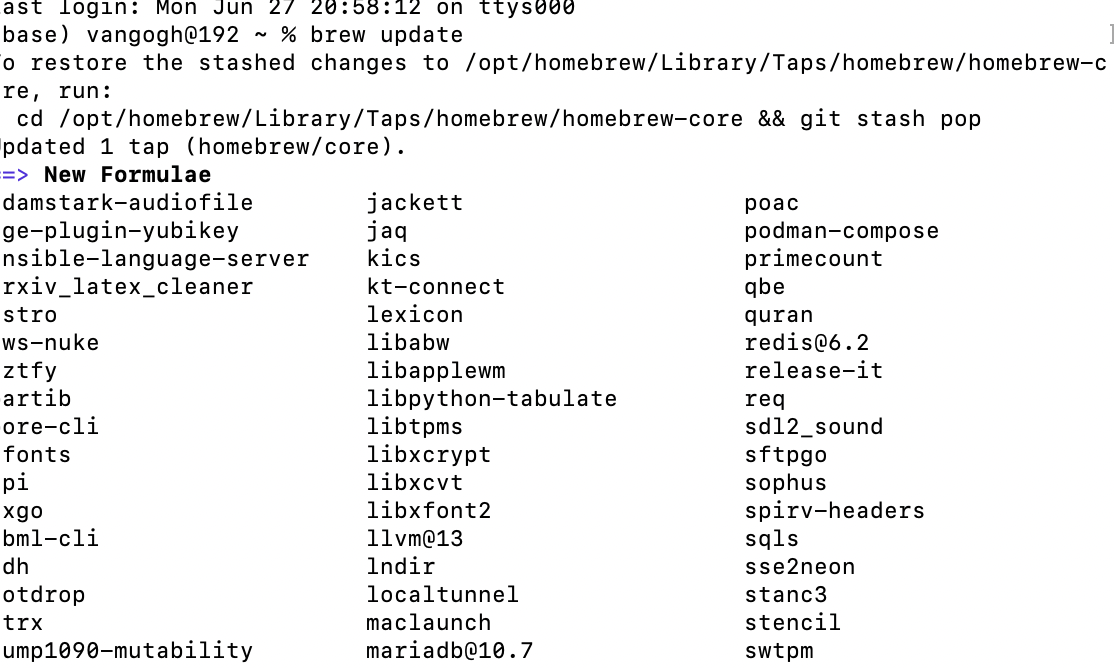

1.在安装了homebrew的前提下,先在终端执行brew update(更新brew)

2.brew install hadoop

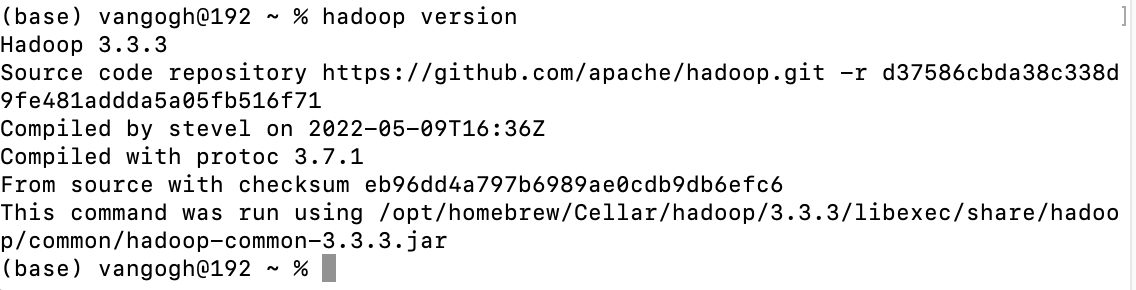

然后安装成功以后,输入hadoop version查看版本

3.vim /opt/homebrew/Cellar/hadoop/3.3.3/libexec/etc/hadoop/core-site.xml

在<configuration></configuration>标签内追加以下代码块

1 2 3 4 5 6 7 8 | <property> <name>hadoop.tmp.dir</name> <value>file:/opt/homebrew/Cellar/hadoop/3.3.3/libexec/tmp</value></property><property> <name>fs.defaultFS</name> <value>hdfs://localhost:8020</value></property> |

4.vim /opt/homebrew/Cellar/hadoop/3.3.3/libexec/etc/hadoop/hdfs-site.xml

在<configuration></configuration>标签内追加代码块

1 2 3 4 5 6 7 8 9 10 11 12 | <property> <name>dfs.replication</name> <value>1</value></property><property> <name>dfs.namenode.name.dir</name> <value>file:/opt/homebrew/Cellar/hadoop/3.3.3/libexec/tmp/dfs/name</value></property><property> <name>dfs.datanode.data.dir</name> <value>file:/opt/homebrew/Cellar/hadoop/3.3.3/libexec/tmp/dfs/data</value></property> |

5.修改环境变量 (vim ~/.bash_profile)

export HADOOP_HOME=/opt/homebrew/Cellar/hadoop/3.3.3/libexec

export HADOOP_COMMON_HOME=$HADOOP_HOME

export PATH=$JAVA_HOME/bin:$PATH:$HADOOP_HOME/bin:/opt/homebrew/Cellar/scala/bin

6.刷新环境变量(source ~/.bash_profile)

7.初始化namenode节点

cd /opt/homebrew/Cellar/hadoop/3.3.3/bin

./hdfs namenode -format

8.启动hadoop

cd /opt/homebrew/Cellar/hadoop/3.3.3/sbin

./start-dfs.sh

9.检验是否启动成功

在浏览器输入http://localhost:9870/dfshealth.html#tab-overview

出现页面即为成功,若出现没连接上localhost,则需要配置ssh免密登录。

10.结束

./stop-all.sh

11.注意事项:(设置ssh免密登录)

当然鉴于我个人比较懒,写的比较简短,而且网上已经有了很好的教程,按着一步步做就行了,下面我将给出参考链接:

1.https://blog.csdn.net/weixin_44864748/article/details/121066700

2.https://blog.csdn.net/Eillfyh/article/details/121504951

当然我想光是安装不够,在正式使用之前还需要查阅教程之类的,才能进行正确的运用。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构

· 字符编码:从基础到乱码解决

· 提示词工程——AI应用必不可少的技术