AdderSR

1. 摘要

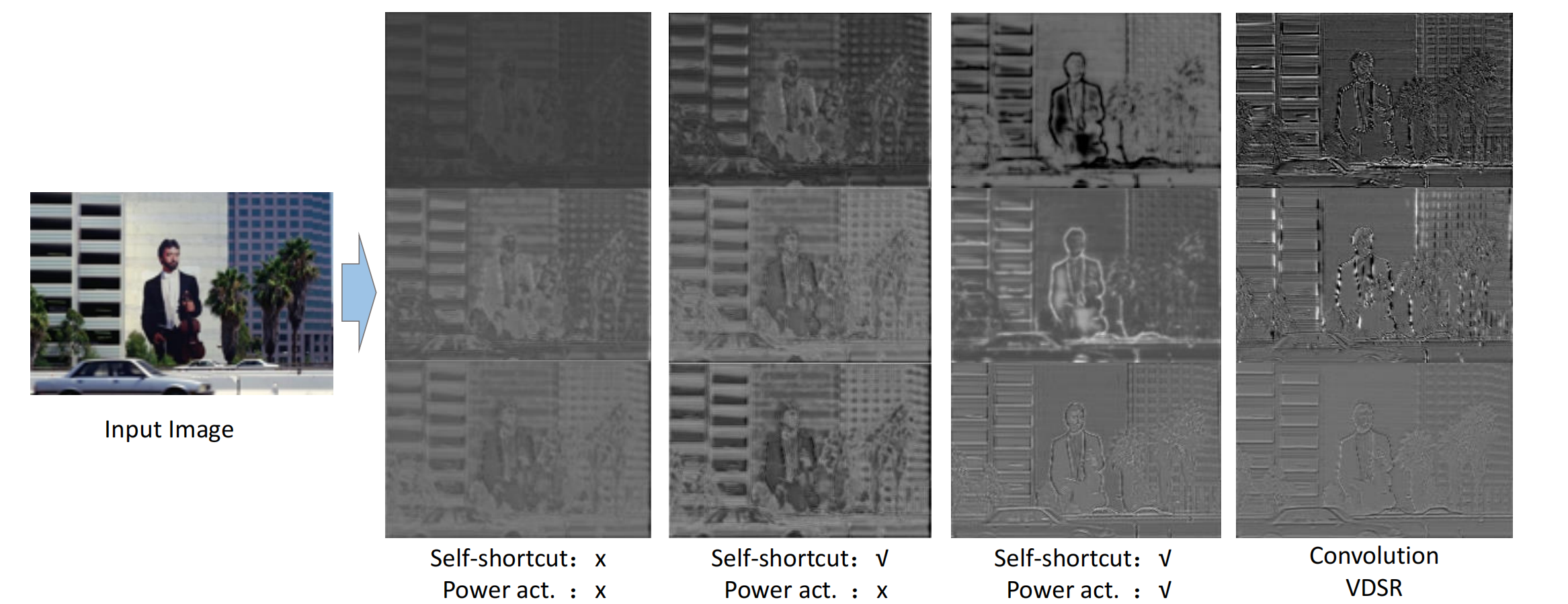

该文利用加法器神经网络(AdderNets)研究了单幅图像的超分辨率问题。与卷积神经网络相比,AdderNets利用加法来计算输出特征,从而避免了传统乘法的大量能耗。然而,由于计算范式的不同,很难将addernet在大规模图像分类上的成功直接继承到图像超分辨率任务中。具体来说,加法器操作不能很容易地学习身份映射,而这是图像处理任务的关键。此外,AdderNets还不能保证高通滤波器的功能。为此,该文深入分析了加法器操作与身份映射和插入快捷方式之间的关系,以提高使用加法器网络的SR模型的性能。然后,我们开发了一个可学习的功率激活来调整特征分布和细化细节。

2. 介绍

单图像超分辨率(SISR)是一种典型的计算机视觉任务,其目的是从低分辨率(LR)图像中重建高分辨率(HR)图像。SISR是在智能手机和移动摄像头等现实世界应用中一项非常流行的图像信号处理任务。由于这些便携式设备的硬件限制,有必要开发计算成本低、视觉质量高的SISR模型。

相比于之前的模型机剪纸等做法,该方法选择替换卷积神经网络为Adder网络,探究在超分辨率上的效果。由于加法的复杂性远低于乘法的复杂性,这项工作激励我们利用AdderNet构建能量有效的SISR模型

3. AdderNet的图像超分辨率

AdderNet显著降低了分类网络的能耗,同时实现了类似的性能。我们的目标是将这一巨大的成功继承到图像超分辨率任务中,它通常具有更高的能耗和计算复杂度。在SISR中,加法器神经网络需要保证两个重要的属性:每个卷积层的输入和输出特征之间的相似性,同时对于高频信息的增强。

3.1 初步和动机

本文首先简要介绍了使用深度学习方法的单图像超分辨率任务,然后讨论了直接使用AdderNets构建高效SR模型的困难。

SISR的目标是从低分辨率图像中重建高分辨率图像。这是一个典型的病定反向问题,因为无限数量的高分辨率图像可以通过降采样生成相同的低分辨率图像。传统SISR任务的目标函数可表述为:

其中\(\pmb I_{\pmb y}\)为观测数据,即低分辨率图像,\(\pmb I_{\pmb X}\)为期望的高分辨率图像,\(R(·)\)表示使用的先验,如平滑和加性噪声,\(λ\)为权衡参数。

在Adder网络任意层中,滤波器参数\(\pmb W\in R^{k\times k\times c_{in}\times c_{out} }\),其中\(k\)为核的大小,\(c_{in}\)和\(c_{out}\)分别为输入通道和输出通道的数量。将输入特征表示为\(\pmb X∈R^{h×w×c_{in}}\),其中\(w\)和\(h\)分别为输入特征的宽度和高度。原始的加法器操作是:

中,\(|·|\)为绝对值函数。\(m,n\)代表特征的空间位置。\(q\)是输出通道的索引。,虽然等式2显示了在图像分类任务上的可比性性能,在等式中定义的\(SISR\)问题1与传统的识别任务有很大的不同。例如,我们需要确保输出结果保持\(\pmb X(i.e \pmb I_{\pmb y})\)中的原始纹理,这是等式2不容易学习的 .因此,我们应该为节能的\(SISR\)模型设计一个新的AdderNet框架。

3.2 使用AdderNet学习身份映射

对于传统的卷积网络,当权值为单位矩阵时,单位映射非常容易学习。然而,在等式中定义的加法器神经网络采用\(l_1-norm\)来测量滤波器和输入数据之间的距离。虽然\(l_1\)距离在图像分类任务上表现得很好,但加法器滤波器不能近似于定理1中所描述的身份映射。叠加更多的加法器层可以缓解这一问题,但它会显著增加模型的大小和复杂性。

定理一:

对于任意低分辨率图像\(\pmb I_{\pmb y}\),以及具有权值参数W的加法器滤波器,不存在满足以下等式的\(W\):

其中,⊕表示在等式中定义的加法器等式 2.

证明:

为了简单起见,这里我们考虑一个全连接的层。假设存在一个过滤器\(W\)满足$\pmb I_{\pmb y}=\pmb I_{\pmb y}\bigoplus\pmb W \(对于任何\)\pmb I_{\pmb y}∈R^{d×d×c}\(,其中\)\pmb W∈R^{d×d×c}\(。然后,对于\)\pmb I_{\pmb y}$中的每个元素,我们都有:

其中,\(m∈\{1,……,d\},n∈\{1,……,d\},q∈\{1,……,c\}\)。然后,我们可以为\(\pmb I_{}\pmb y(m,n,q)\)中的每个元素选择适当的值,这样\(\pmb I_{\pmb y}^{1}(m,n,q)>max_{i,j,k,g}|\pmb W(I,j,k,g)|\),我们有:

让\(\pmb I_{\pmb y}^2(m,n,q)=\pmb I_{\pmb y}^1(m,n,q)+1\),那么我们就有了:

结合使用的等式5和6,我们有\(d^2×c+1=0\),这显然是不可能的。此外,上述证明可以很容易地扩展到\(W\)的滤波器大小往往比输入数据\(\pmb I_{\pmb y}\)小得多的卷积层。为了解决这一问题,我们建议重新细化现有的加法器单元,以调整超分辨率任务。在实际应用中,我们为每个加法器层提出了一个自快捷操作:

其中,\(\pmb W^l\)为第1层加法器滤波器的权值,\(\pmb X^l\)和\(\pmb Y^l\)分别为输入数据和输出数据。等式7的输出包含输入数据\(\pmb X^l\)本身,我们可以利用通过减少\(\pmb W^l\bigoplus \pmb X^l\)的大小来近似的恒等式映射。

3.3 可降低的功率激活函数

通常,自然图像是由不同频率的信息组成的。例如,背景和大面积的草都是低频信息,其中大部分的邻居像素都非常封闭。相比之下,物体和一些建筑的边缘恰好是给定的整个图像的高频信息。在实践中,如果我们将任意图像定义为高频部分和低频部分的组合为\(\pmb I=\pmb I_H+\pmb I_L\),一个用于超分辨率任务和其他图像处理问题的理想高通滤波器\(Φ(·)\)可以定义为:

它只保留了输入图像的高频部分。其中,\(σ(\pmb I_H)\)是高频部分的卷积响应。上述方程可以帮助SISR模型消除冗余输出和噪声,增强高频细节,这也是SISR模型中一个非常重要的组成部分。

同样,对于传统的卷积操作,等式8的功能可以直接实现。例如,一个2×2高通滤波器\(\left[ \begin{matrix} -1 & +1 \\ +1 & -1 \end{matrix} \right] \tag{3}\)可以用于去除图像中的任何平坦区域。然而,对于等式中定义的加法器神经网络不可能实现等式8中描述的功能 。

定理而:

设\(\pmb E∈R^{d×d}\)使用加法器操作作为给定SR模型的输入图像,其中\(\pmb E\)中的每个元素都等于1。W表示任意加法器滤波器的权值。不存在\(\pmb W∈R^{d×d}\)和一个常数\(a∈R\) 满足以下式子:

其中,\(s∈R\),\(⊕\)表示加法器操作,它只包含在等式2中定义的加法。

证明:

假设存在一个满足$(s * \pmb E)\bigoplus \pmb W=a \(的加法器\)\pmb W\(,对于任何\)s∈R\(。我们可以找到一个满足\)s>max_{i,j}|\pmb W(i,j)|$。然后,我们就会有了:

上式显然不成立。根据上述定理,高通滤波器的功能不能被加法器滤波器所取代。因此,加法器神经网络中的超分辨率过程将涉及更多的冗余。为此,我们需要开发一种新的方案,使用加法器神经网络来执行SISR任务,以弥补这一缺陷。

提出了一个可学习的功率激活函数来解决AdderNet的缺陷,并对输出图像进行了细化:

其中Y为输出特征,sgn(·)为符号函数,α>0为用于调整信息和分布的可学习参数。当α>1时,上述激活函数可以增强输出图像的对比度,强调高频信息。当有0个<α<1,等式时11可以平滑输出图像中的所有信号,去除伪影和噪声。此外,上述功能可以很容易地嵌入到任何SISR模型的传统ReLU中。

4. 效果

Reference:

[1]AdderSR: Towards Energy Effificient Image Super-Resolution

浙公网安备 33010602011771号

浙公网安备 33010602011771号