【今日收获】看到关于RL的一些观点

1. MDP的最佳策略是确定性和无记忆的,一错会再错,以前发生的状态也不记得。Memory模块是正解吗?

图源 https://zhuanlan.zhihu.com/p/430221668

2. 毫末 吕迪 对于RL现存问题的看法

每个观点都很insight

强化学习领域目前遇到的瓶颈是什么? - 毫末智行的回答 - 知乎 https://www.zhihu.com/question/449478247/answer/2000015265

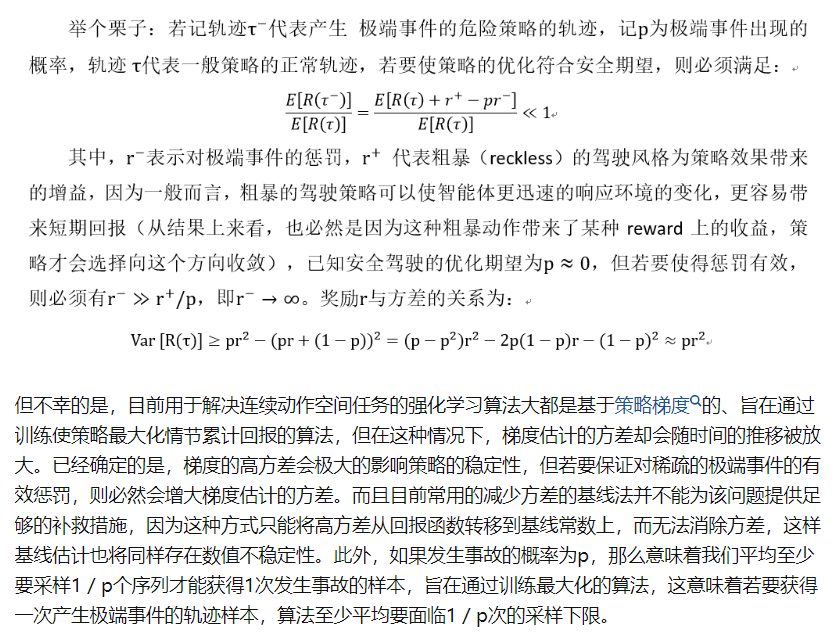

首先是reward设计不合理导致无法兼顾安全性和稳定性,碰撞的极大惩罚在增强安全的同时会导致策略不稳定。

这让人想起什么?

是不是想起在优化算法里外罚函数法的特点,梯度病态

实际上我一直认为reward帮助形成的Q值就是把约束条件做成外罚函数的一种目标函数。

补充,关于外罚函数的缺点:形象理解外罚函数法+内罚函数法 - Cat food的文章 - 知乎 https://zhuanlan.zhihu.com/p/368010901

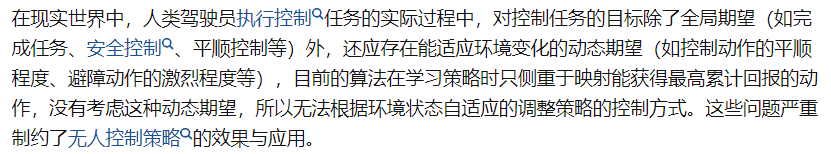

其次是关于模糊的策略映射导致训练confusing,这一段理解不深,以后常读常新吧

最后是多目标需要动态调整。这个我自己目前认为不是最主要的。

3. 偏好强化学习

https://zhuanlan.zhihu.com/p/622056740

还需要再读