使用RAGFlow和Docker部署本地知识库

随着DeepSeek的火热,大模型对与广大开发者越来越触手可及。本文介绍了使用 DeepSeek R1 模型来构建本地知识库。

Ollama 管理本地模型

首先要了解大模型的管理工具 Ollama:

安装 Ollama

点击下载安装 Ollama 客户端;

安装成功后打开,在终端中输入以下命令来检查是否安装成功:

ollama -v

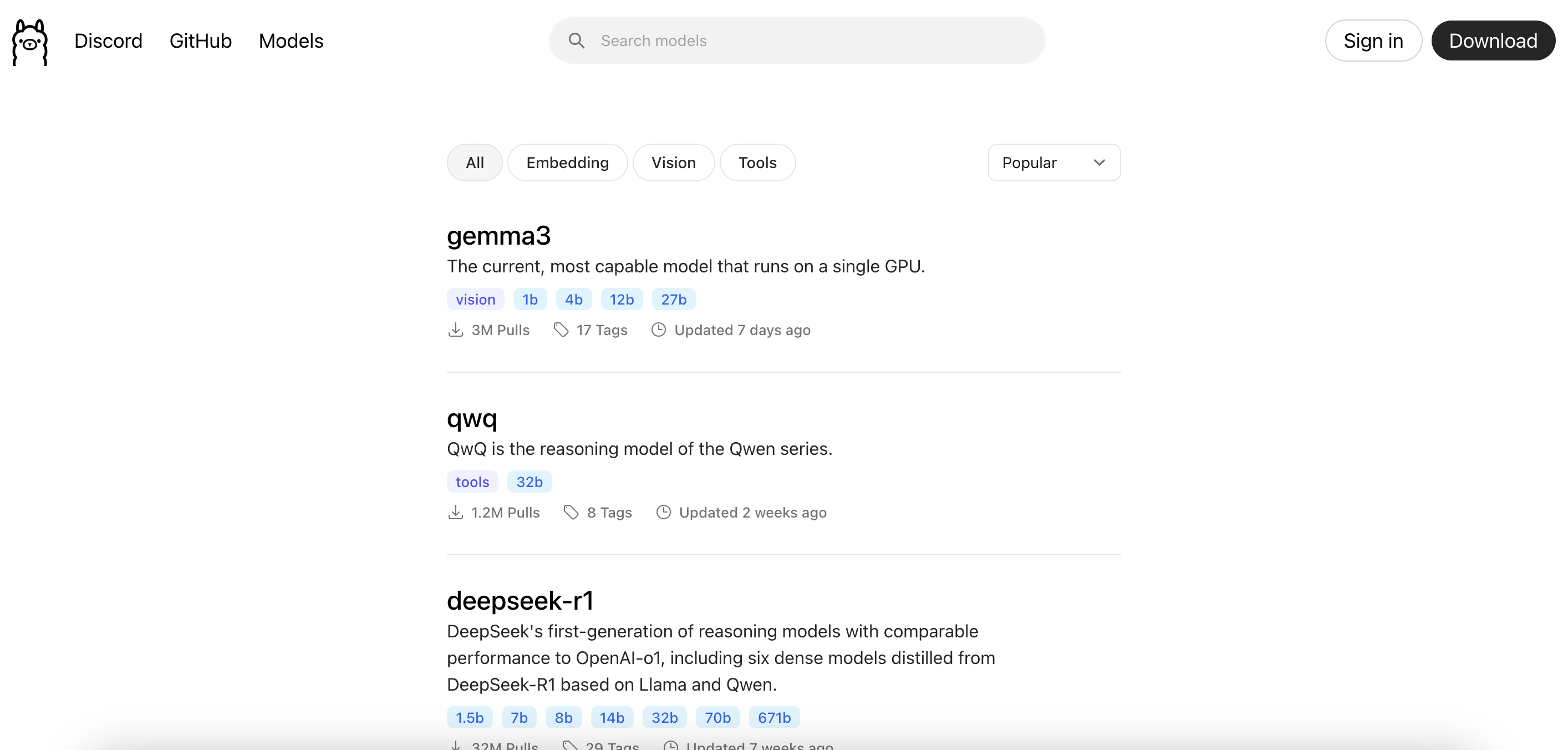

使用 Ollama 安装本地模型

在 Ollama 支持模型:中搜索你需要的大模型

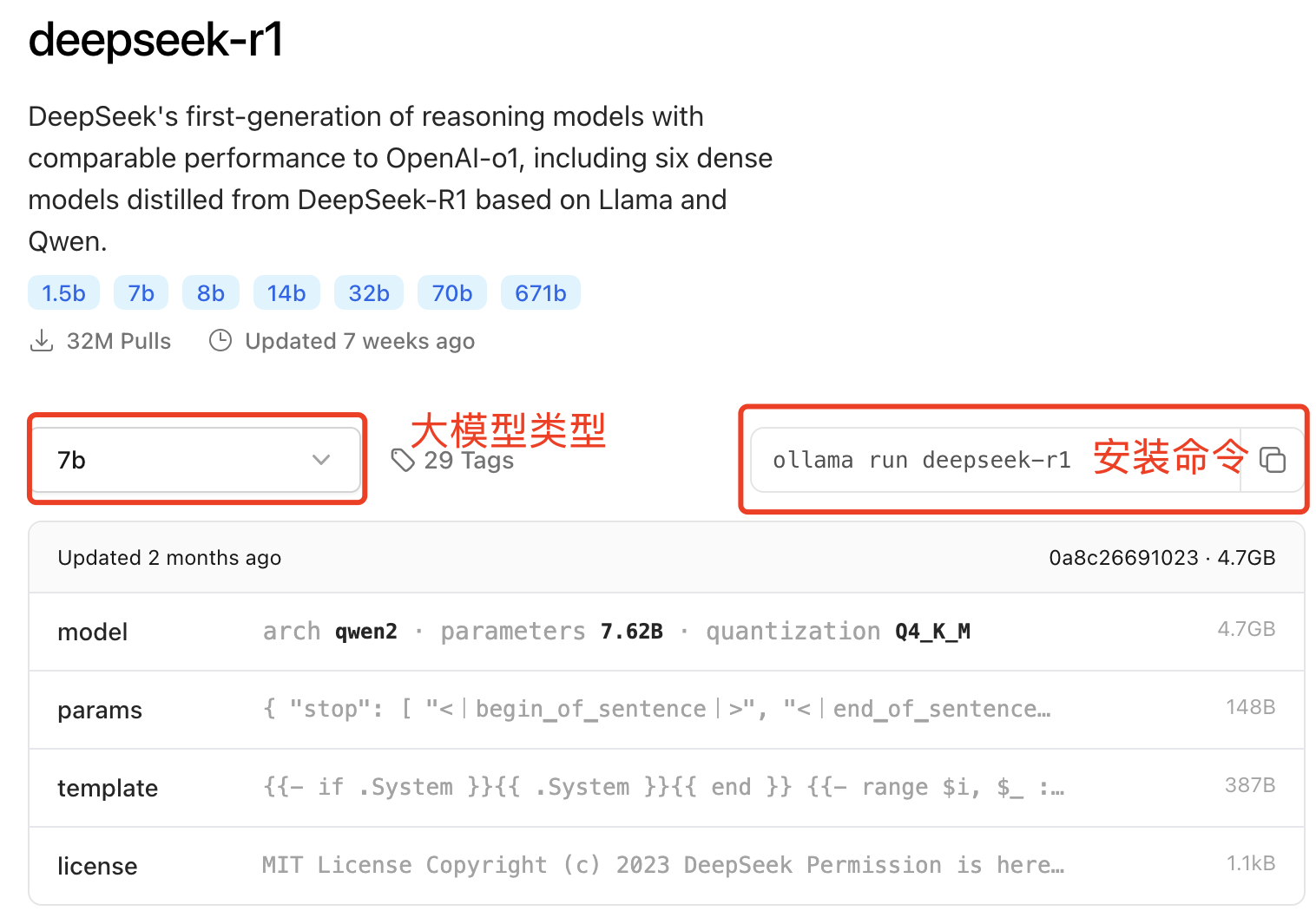

选择你需要的大模型(PS:根据电脑配置情况酌情选择对应参数🐶),执行右侧安装命令 :

ollama run deepseek-r1:7b

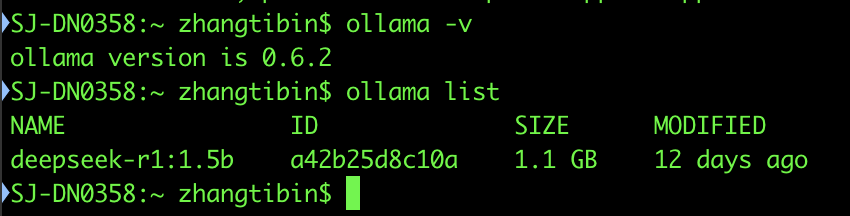

安装成功后查看本地存在的大模型:

ollama list

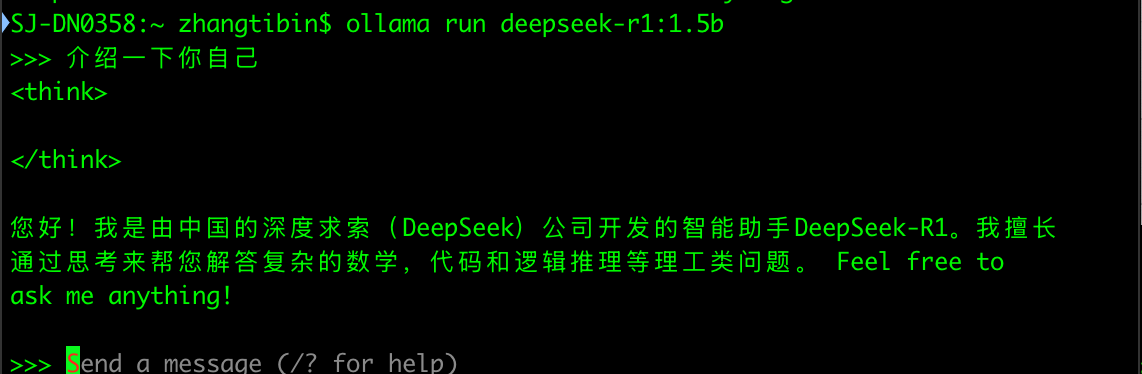

终端运行大模型:

ollama run deepseek-r1:1.5b

到此,本地大模型安装成功。

使用 RAGFlow 构建本地知识库

安装 Docker

下载并安装 Docker 桌面端

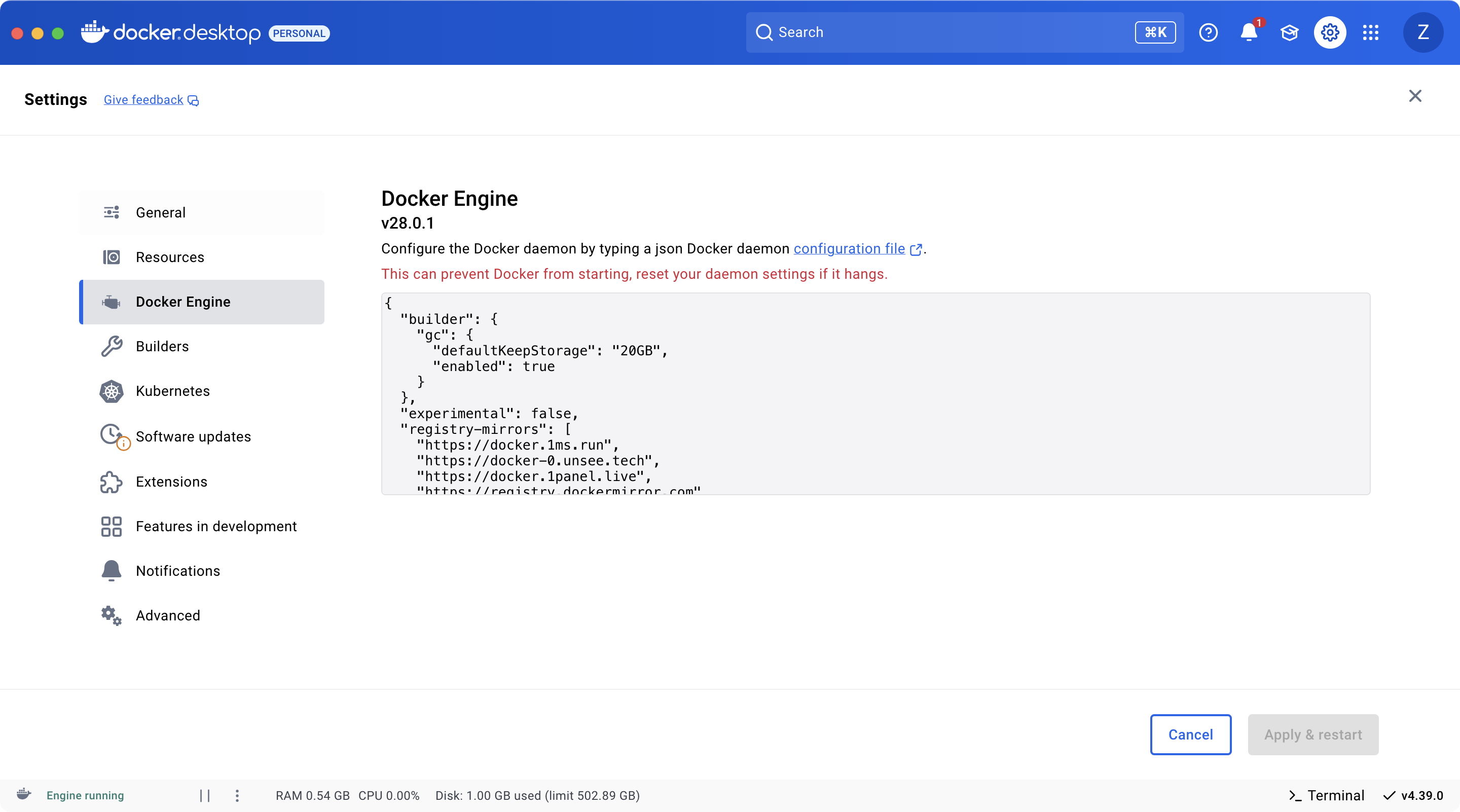

配置 Docker 镜像源:

"registry-mirrors": [

"https://docker.1ms.run",

"https://docker-0.unsee.tech",1

"https://docker.1panel.live",

"https://registry.dockermirror.com",

"https://docker.imgdb.de",

"https://docker.m.daocloud.io",

"https://hub.firefly.store",

"https://hub.rat.dev",

"https://dhub.kubesre.xyz",

"https://cjie.eu.org",2

"https://docker.kejilion.pro",

"https://docker.1panelproxy.com",

"https://docker.hlmirror.com",

"https://hub.fast360.xyz",

"https://dockerpull.cn",

"https://cr.laoyou.ip-ddns.com",

"https://docker.melikeme.cn"

]

配置 RAGFlow

RAGFlow 是一款基于深度文档理解构建的开源 RAG(Retrieval-Augmented Generation)引擎。RAGFlow 可以为各种规模的企业及个人提供一套精简的 RAG 工作流程,结合大语言模型(LLM)针对用户各类不同的复杂格式数据提供可靠的问答以及有理有据的引用。

下载RAGFlow 源码

git clone https://github.com/infiniflow/ragflow.git

要求:

-

CPU >= 4 cores

-

RAM >= 16 GB

-

Disk >= 50 GB

-

Docker >= 24.0.0 & Docker Compose >= v2.26.1

配置RAGFlow环境

打开 .env 文件,根据你的电脑系统修改配置,我的是 MacOS系统

修改以下内容:

1、配置RAGFlow Image: RAGFLOW_IMAGE=infiniflow/ragflow:v0.17.2 2、放开MacOS系统 MACOS=1

| RAGFlow image tag | Image size (GB) | Has embedding models? | Stable? |

|---|---|---|---|

| v0.17.2 | ≈9 | ✔️ | Stable release |

| v0.17.2-slim | ≈2 | ❌ | Stable release |

| nightly | ≈9 | ✔️ | Unstable nightly build |

| nightly-slim | ≈2 | ❌ | Unstable nightly build |

我安装的是内嵌模型的稳定版 ragflow:v0.17.2

进入 docker 文件目录执行

docker compose -f docker-compose.yml up -d

过程比较久 ,耐心等候。。。。

下载成功后,查看服务启动状态

docker logs -f ragflow-server

如果出现以下信息,说明成功启动了

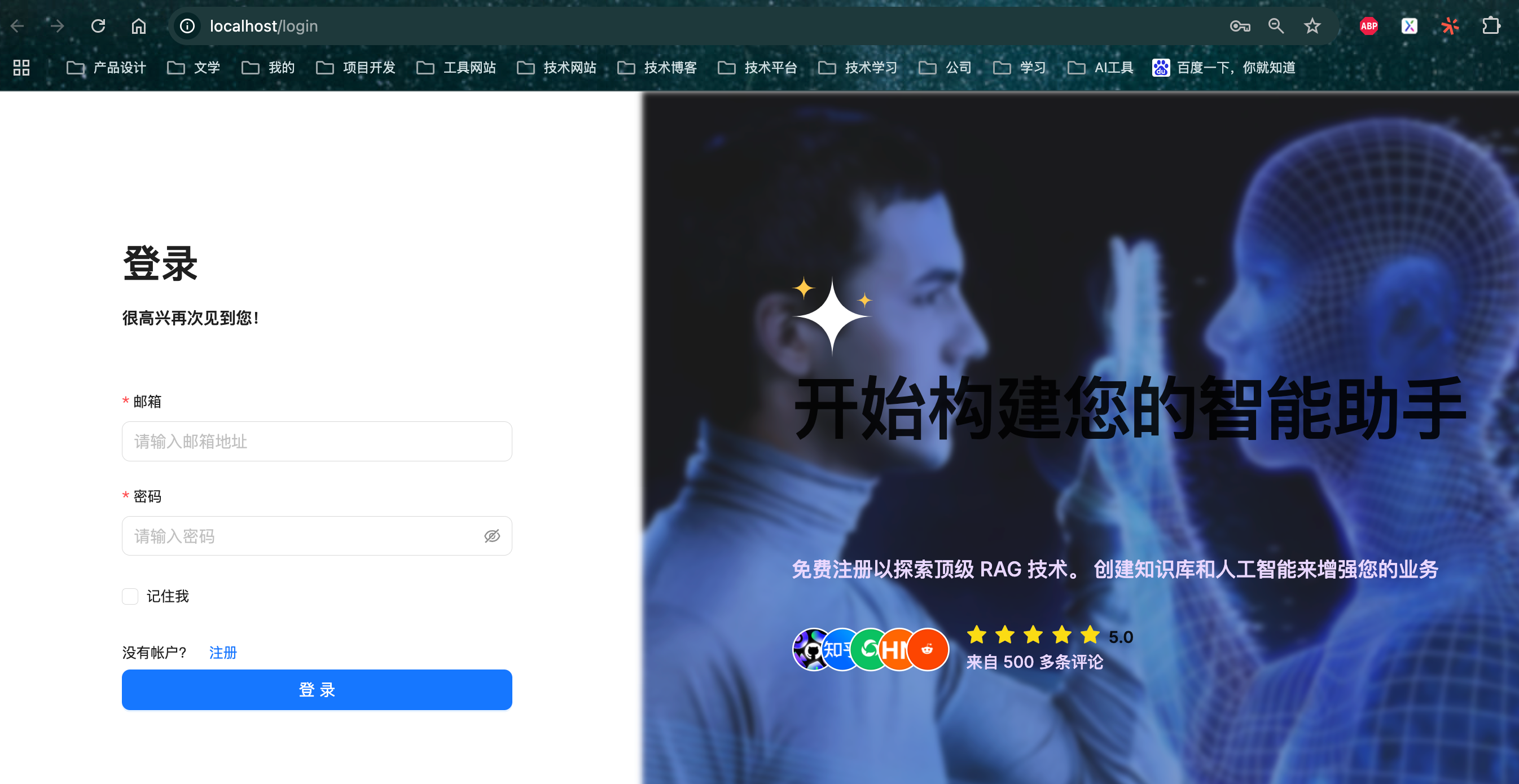

服务起来之后,打开:http://localhost:80 就可以进入了

注册登录进去(第一次注册登录的账号会默认成管理员)

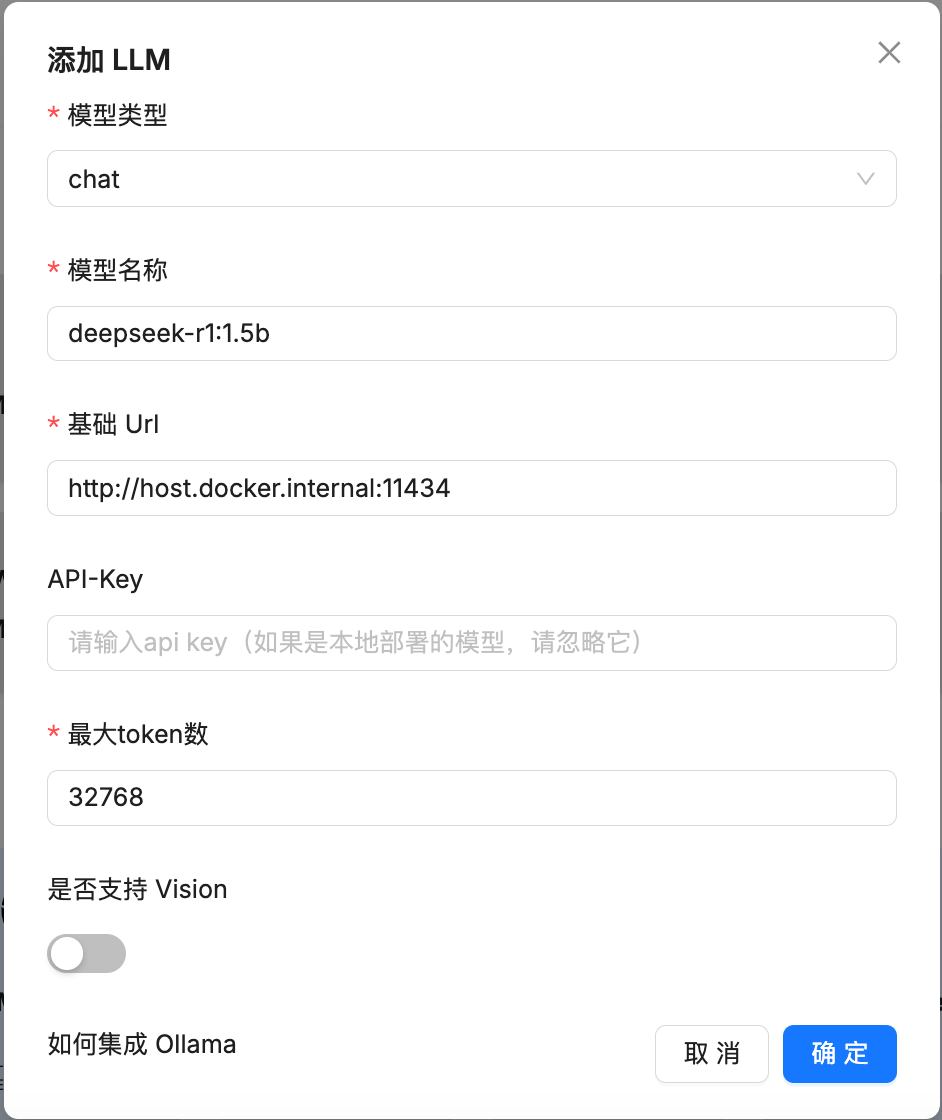

选择 Ollama 添加LLM模型

这里的基础 URL 应该是本地的 IPV4 地址加端口号 11434,但是我试了本地的IP添加不成功,一直失败,经求助大佬,改成现在这个 http://host.docker.internal:11434。这里有清楚原因的可以评论留言,感谢。

系统模型设置:

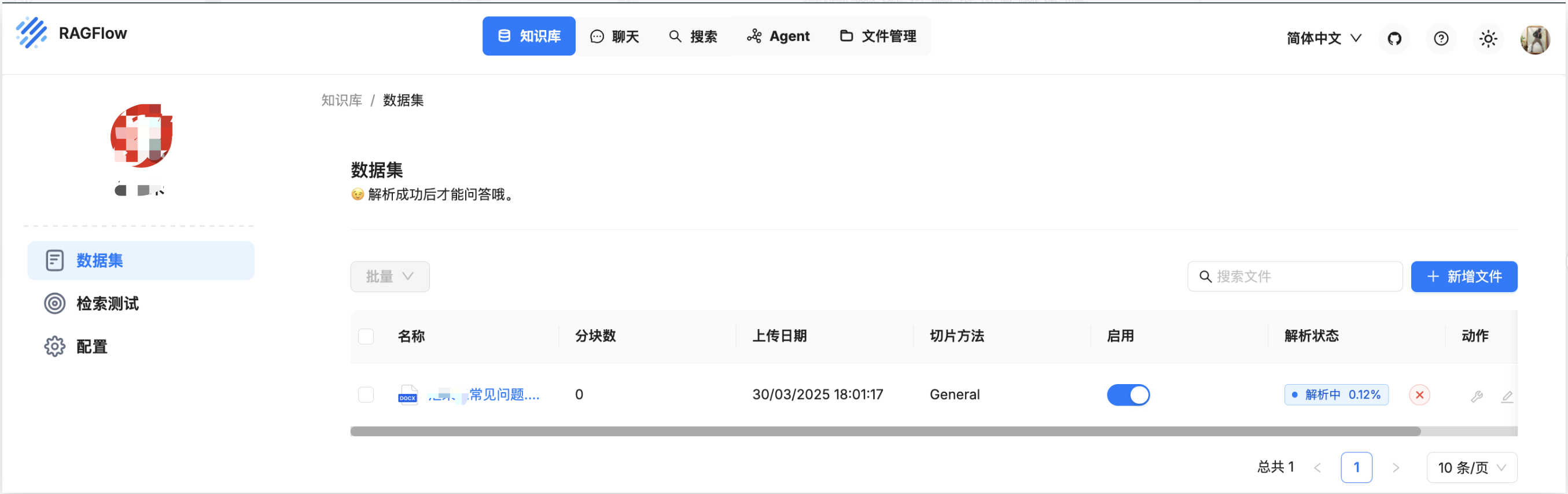

新建本地知识库

上传本地文件解析

开始愉快的聊天吧

另外使用 Dock 配置 RAGFlow 占用电脑空间较大,内存不足者伤不起。

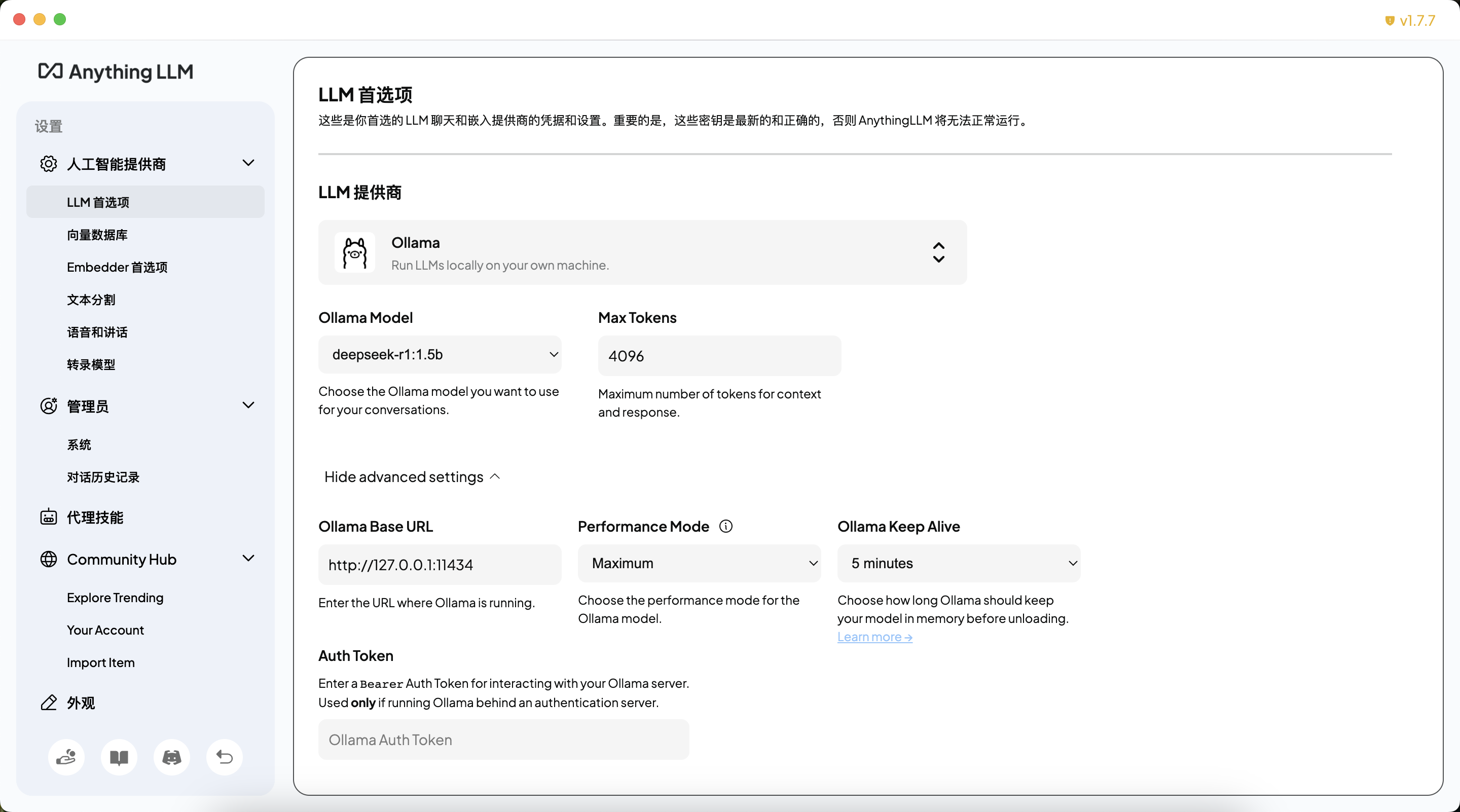

建议使用 AnythingLLM 这个工具来配置本地知识库。工具使用起来非常简单。

配置首选项

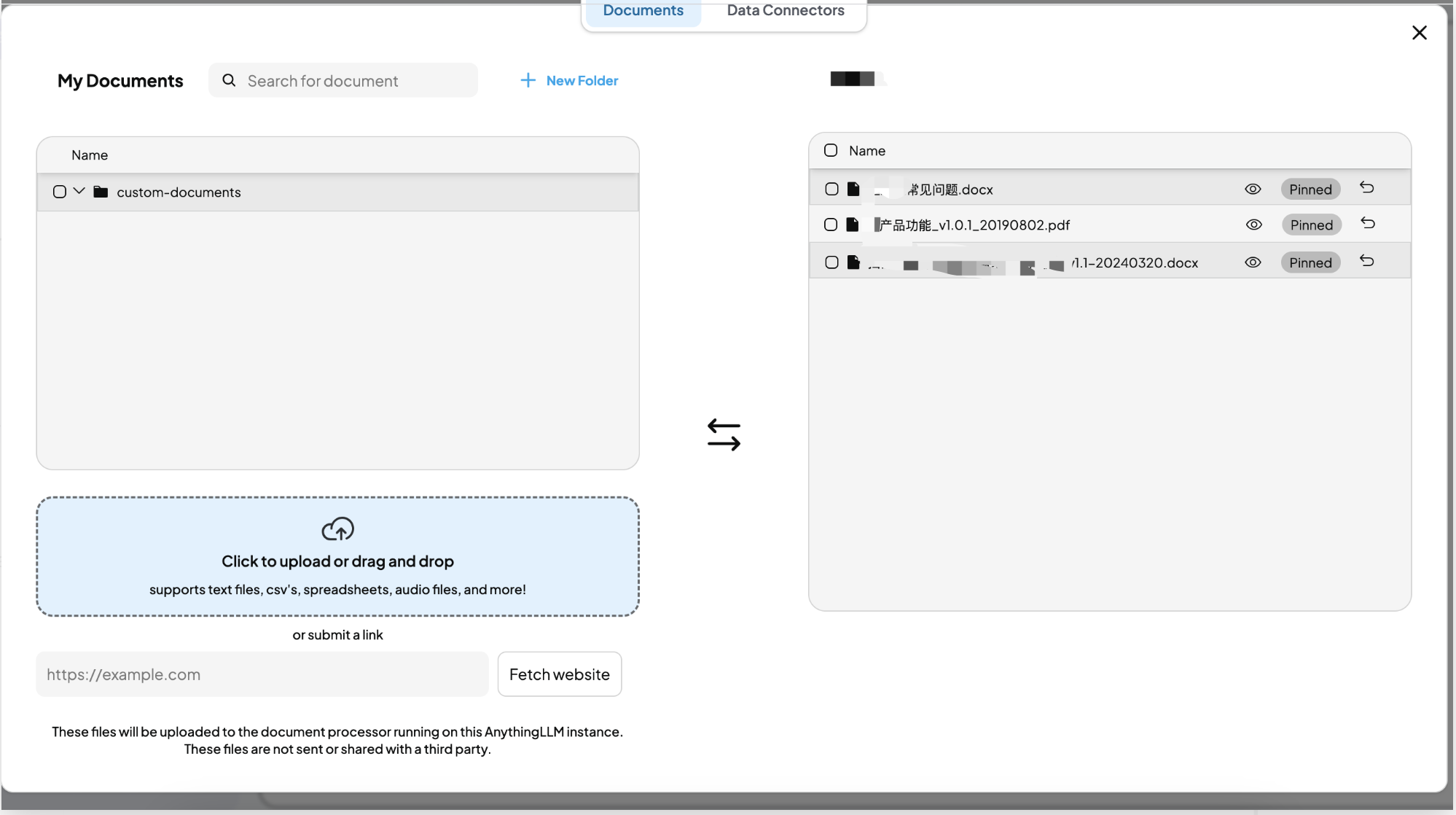

上传本地知识库文件:

浙公网安备 33010602011771号

浙公网安备 33010602011771号