PITS: 学习独立嵌入时间序列Patches《Learning To Embed Time Series Patches Independently》(时间序列、Patch、未掩码片段重构、互补对比学习(最大池化分层对比)、Patch+MLP做预训练任务)

2024年11月5日,不说了,看论文吧.

论文:Learning To Embed Time Series Patches Independently

或者是:Learning to Embed Time Series Patches Independently

GitHub:https://github.com/seunghan96/pits

ICLR 2024的论文。

好熟悉,是SoftCLT的作者.

摘要

作为一种时间序列的自监督表征学习策略,掩码时间序列建模近来备受关注。受计算机视觉中的掩码图像建模的启发,最近的研究首先对时间序列进行片段化和部分掩码,然后训练Transformers,通过预测未掩码片段中的掩码片段来捕捉片段之间的依赖关系。然而,我们认为捕捉这种片段依赖关系可能并不是时间序列表征学习的最佳策略(Why???);相反,学习独立嵌入片段会带来更好的时间序列表征(让我来瞅瞅怎么个事)。具体来说,我们建议使用:1)简单的片段重构任务,即在不查看其他片段的情况下对每个片段进行自编码;2)简单的片段式 MLP,即独立嵌入每个片段。此外,我们还引入了互补对比学习,以分层有效地捕捉相邻的时间序列信息。我们提出的方法改进了时间序列预测,并提高了对时间序列的分析能力。

1 引言

时间序列(TS)数据可应用于一系列下游任务,包括预测、分类和异常检测。深度学习已在时间序列分析中显示出其优越性能,其中学习良好的表征是深度学习成功的关键,而自监督学习已成为有效利用无标记数据的一种有前途的策略。值得注意的是,对比学习(CL)和掩码建模(MM)在 TS 分析以及自然语言处理(Devlin 等人,2018 年;Brown 等人,2020 年)和计算机视觉(Chen 等人,2020 年;Dosovitskiy 等人,2021 年)等其他领域都表现出令人印象深刻的性能。

掩码时间序列建模(MTM)任务部分掩码出 TS,并利用捕捉片段间依赖关系的编码器(如 Transformers)从未掩码的部分预测掩码部分(Zerveas 等人,2021;Nie 等人,2023)。然而,我们认为,学习这种片段间的依赖关系,例如根据掩码部分预测未掩码部分,并利用捕捉片段间依赖关系的架构,可能并非表征学习所必需。(哇,有意思,反直觉的观点)

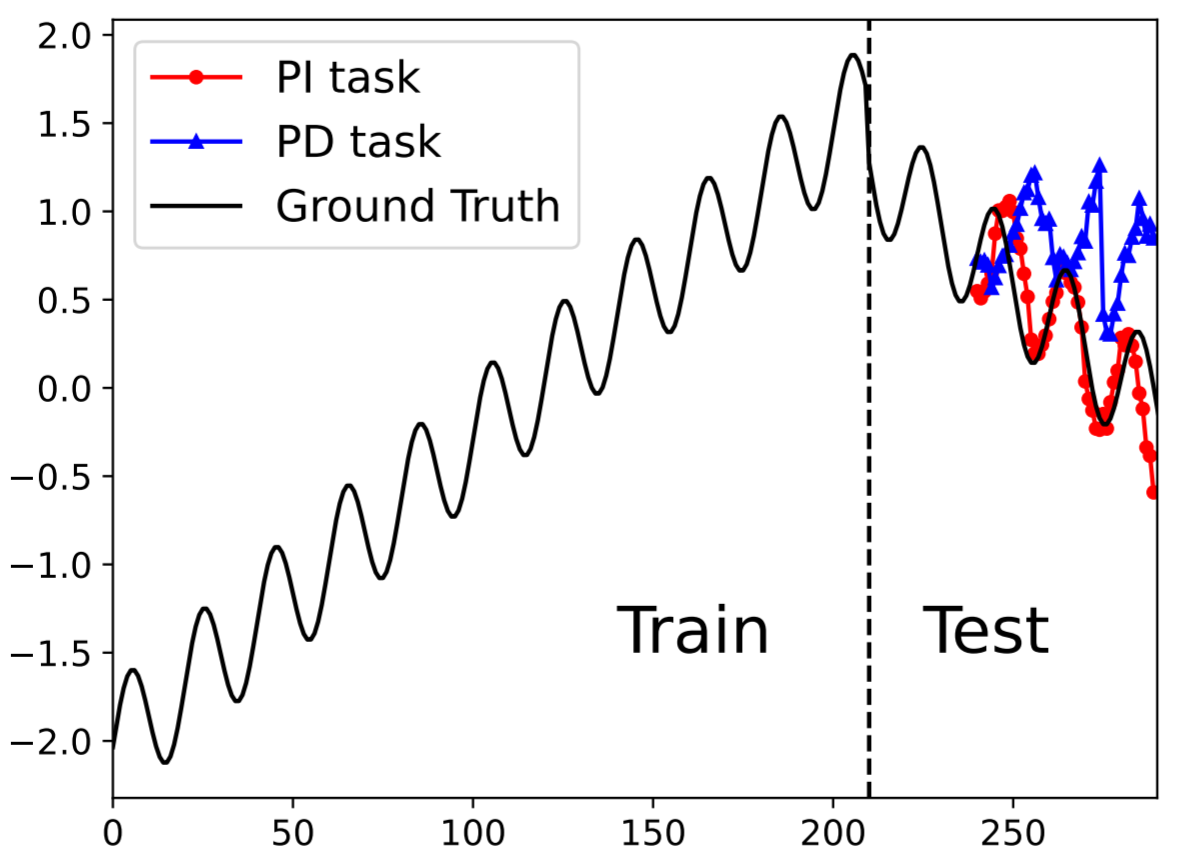

为此,我们引入了片段独立性的概念,即在嵌入 TS 片段时不考虑它们之间的相互作用。这一概念通过两个关键方面来实现: 1)预训练任务;2)模型架构。首先,我们提出了一种片段重建任务,它可以重建未掩码的片段,这与传统的 MM 预测掩码的片段不同。我们将这些任务分别称为独立于片段(PI)任务和依赖于片段(PD)任务,因为前者重建每个片段时不需要其他片段的信息,而后者则需要。图 1 举例说明了 TS 预测。根据 PD 任务(Nie 等人,2023 年)预训练的 Transformer 无法预测分布偏移下的测试数据,而根据 PI 任务预训练的 Transformer 却能稳健地预测分布偏移。其次,我们采用了简单的 PI 架构(如 MLP),比传统的 PD 架构(如 Transformer)表现出更好的效率和性能。(啊啊啊啊啊,分布漂移,我要看看怎么个情况)

图 1:PI 与 PD。

在本文中,我们提出了时间序列的片段独立性(PITS),它利用未掩码片段重构作为 PI 预训练任务,并利用 MLP 作为 PI 架构。在此基础上,我们引入互补 CL 来有效捕捉相邻的时间序列信息,其中 CL 是使用原始样本的两个增强视图来执行的,这些视图以互补的方式进行掩码。

我们对各种任务进行了广泛的实验,结果表明,在标准学习和迁移学习设置下,我们提出的方法在预测和分类任务中的表现都优于最先进的方法(SOTA)。主要贡献总结如下:

- 我们认为,对于 TS 表征学习来说,学习独立嵌入时间序列片段要优于学习它们的依赖性,这在性能和效率方面都是如此。为了实现片段独立性,我们提出了 PITS,其中包含了对 MTM 的两大修改:1)使任务与片段无关,重建未掩码的片段,而不是预测掩码的片段;2)使编码器与片段无关,消除注意力机制,同时保留 MLP 以忽略编码期间片段之间的相关性。(反直觉的一些操作)

- 我们引入互补对比学习来分层高效地捕捉相邻的 TS 信息,其中正对是通过互补随机掩码来实现的。

- 我们对低级预测和高级分类进行了大量实验,证明我们的方法提高了 SOTA 在各种下游任务中的性能。同时,我们发现 PI 任务在管理分布偏移方面优于 PD 任务,而且与 PD 架构相比,PI 架构对片段大小的解释性和鲁棒性更强。

2 相关工作

自监督学习。近年来,自监督学习(self-supervised learning,SSL)在从各个领域的无标记数据中学习强大表征方面获得了广泛关注。SSL 的成功来自于对代理任务的积极研究,这些任务在没有监督的情况下预测数据的某一方面。下标记预测(Brown 等人,2020 年)和掩码标记预测(Devlin 等人,2018 年)常用于自然语言处理,拼图游戏(Noroozi & Favaro,2016 年)和旋转预测(Gidaris & Komodakis,2018 年)常用于计算机视觉。

最近,对比学习(CL)(Hadsell 等人,2006 年)作为一种有效的代理任务出现了。CL 的关键原理是最大化正对之间的相似性,同时最小化负对之间的相似性(Gao 等人,2021 年;Chen 等人,2020 年;Yue 等人,2022 年)。另一种很有前景的技术是掩码建模(MM),它训练模型根据未掩码部分重建掩码片段。例如,在自然语言处理中,模型预测句子中被掩码的单词(Devlin 等人,2018 年),而在计算机视觉中,模型预测图像中被掩码的片段(Baevski 等人,2022 年;He 等人,2022 年;Xie 等人,2022 年),在各自的领域内。

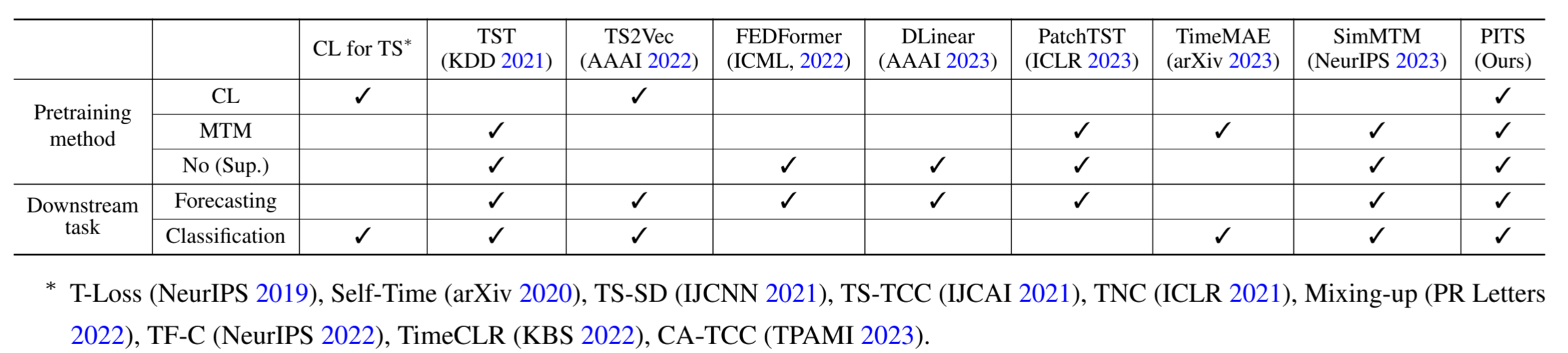

掩码时间序列建模。除了 CL,MM 作为 TS 中 SSL 的代理任务也获得了关注。该任务涉及掩码 TS 的一部分并预测缺失值,被称为掩码时间序列建模(MTM)。CL 在高级分类任务中表现抢眼,而 MM 则在低级预测任务中表现出色(Yue 等人,2022 年;Nie 等人,2023 年)。TST(Zerveas 等人,2021 年)将 MM 范式应用于 TS,旨在重建被掩码的时间戳。PatchTST (Nie 等人,2023 年)侧重于预测被掩码的子序列级片段,以捕捉局部语义信息并减少内存使用。SimMTM (Dong 等人,2023 年)从多个掩码 TS 重建原始 TS。TimeMAE(Cheng 等人,2023 年)使用两个代理任务,即掩码编码词分类和掩码表示回归,训练基于Transformer的编码器。表 1 比较了包括我们在内的 TS 领域的各种方法,包括预训练方法和下游任务两个标准,其中预训练方法中的 No (Sup.) 表示不采用预训练的监督学习方法。

表 1:TS 中 SOTA 方法的比较表。

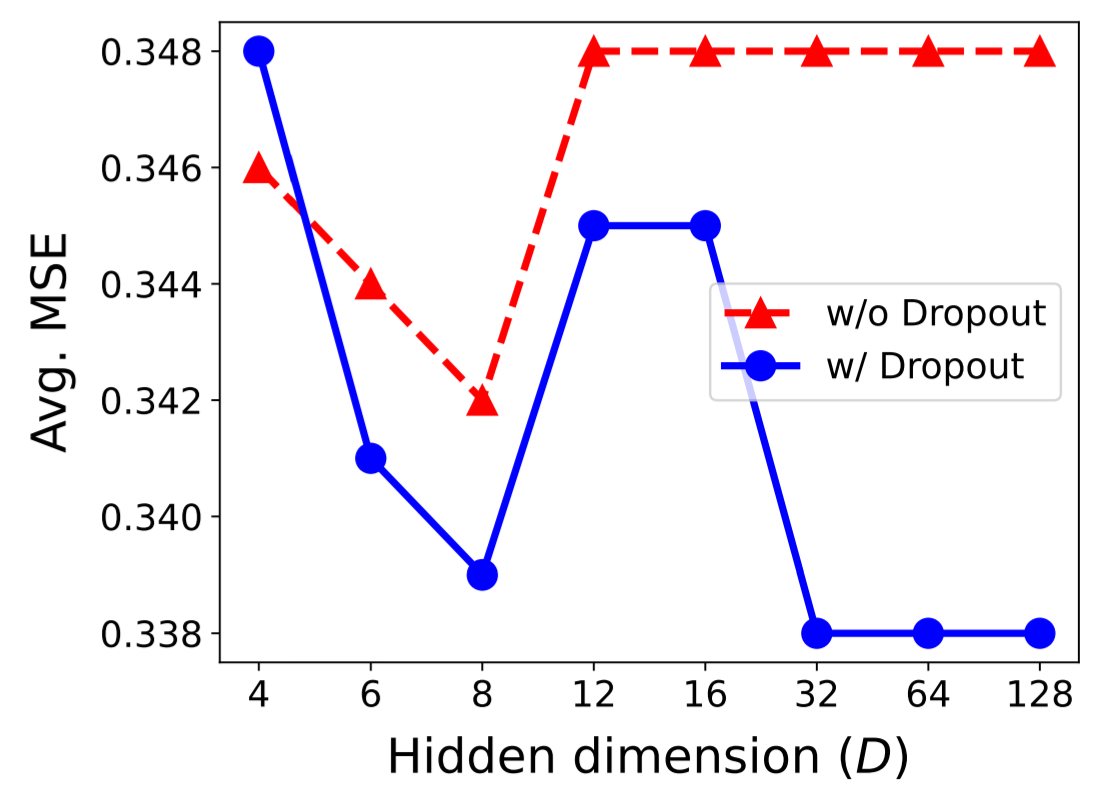

与最近的 MTM 研究不同,我们建议通过自编码来重建未掩码的片段。自编码的一个主要问题是身份映射的琐碎解决方案,即隐藏层的维度应小于输入。为了缓解这一问题,我们在中间全连接(FC)层后引入了dropout,这与堆叠去噪自编码器(Liang & Liu,2015)的情况类似,其中的消融研究可参见图 4。(全连接+dropout来替代堆叠的去噪自编码器)

CL 与 MM 的结合。最近有人致力于将 CL 和 MM 结合起来进行表征学习(Jiang 等人,2023 年;Yi 等人,2023 年;Huang 等人,2022 年;Gong 等人,2023 年;Dong 等人,2023 年)。在这些研究中,SimMTM(Dong 等人,2023 年)以对比损失的形式在目标函数中加入了正则因子,从而解决了 MM 任务。不过,它与我们的工作不同之处在于,它关注的是 TS 之间的 CL,而我们提出的 CL 针对的是单个 TS 中的片段。

互补掩码。SdAE(Chen 等人,2022 年)采用学生分支进行信息重建,教师分支生成掩码标记的潜在表征,利用互补的多重掩码策略来保持分支之间的相关互信息。TSCAE(Ye等人,2023)通过引入师生网络互补掩码,解决了基于MM的预训练模型中上下游不匹配的差距;CFM(Liao等人,2022)引入了可训练的互补掩码策略,用于特征选择。我们提出的互补掩码策略不同之处在于,它不是为蒸馏模型设计的,我们的掩码不是可学习的,而是随机生成的。

用于时间序列预测的线性模型。Transformer (Vaswani 等人,2017 年)是一种流行的序列建模架构,它促使基于 Transformer 的时间序列分析解决方案激增(Wen 等人,2022 年)。Transformer 的主要优势来自多头自注意力机制,擅长在广泛的序列中提取语义关联。然而,Zeng 等人(2023 年)的最新研究表明,简单的线性模型仍能提取基于 Transformer 的方法所捕捉到的此类信息。受这项工作的启发,我们建议使用一种不对时间序列片段之间的交互作用进行编码的简单 MLP 架构。

(没看完,因为有杂事,明天继续.)

(今天11月6日,现在21:53,今天没看,因为没空,上午项目B开会,下午项目B杂活+项目A调代码,刚上传完代码,今天一天又过去了,我不想干项目,我不想干杂活,麻了.)

(我现在就想看看论文,写写代码,把自己的论文做出来,抓紧毕业,而不是每天做一些对我来说毫无意义的项目(从研一就开始干活,对xxx已经PTSD了,只要给我安排活我就开始烦躁).)

(11月7日,继续,争取今天看完(虽然今天有三个会议).)

(现在是11月7日,20:33,看完了,感觉很多结论都和以往的论文有点冲突,感觉值得实验一下,换换数据集跑跑效果,分布漂移明显的数据集和分布漂移不明显的数据集做对比实验.)

(附录也看完了,这个人实验做的是真全啊,厉害.)

3 方法

我们的任务是学习一个TS片段的嵌入函数![]() ,其中

,其中![]() 这里,B、C、N 分别为 TS 数量、单个 TS 中的通道数量、单个 TS 的单通道中的片段数量。输入和输出维度,也就是片段大小和片段嵌入维度,分别记为 P 和 D,即

这里,B、C、N 分别为 TS 数量、单个 TS 中的通道数量、单个 TS 的单通道中的片段数量。输入和输出维度,也就是片段大小和片段嵌入维度,分别记为 P 和 D,即![]() 我们的目标是学习 f θ,提取在各种下游任务中表现出色的表征。

我们的目标是学习 f θ,提取在各种下游任务中表现出色的表征。

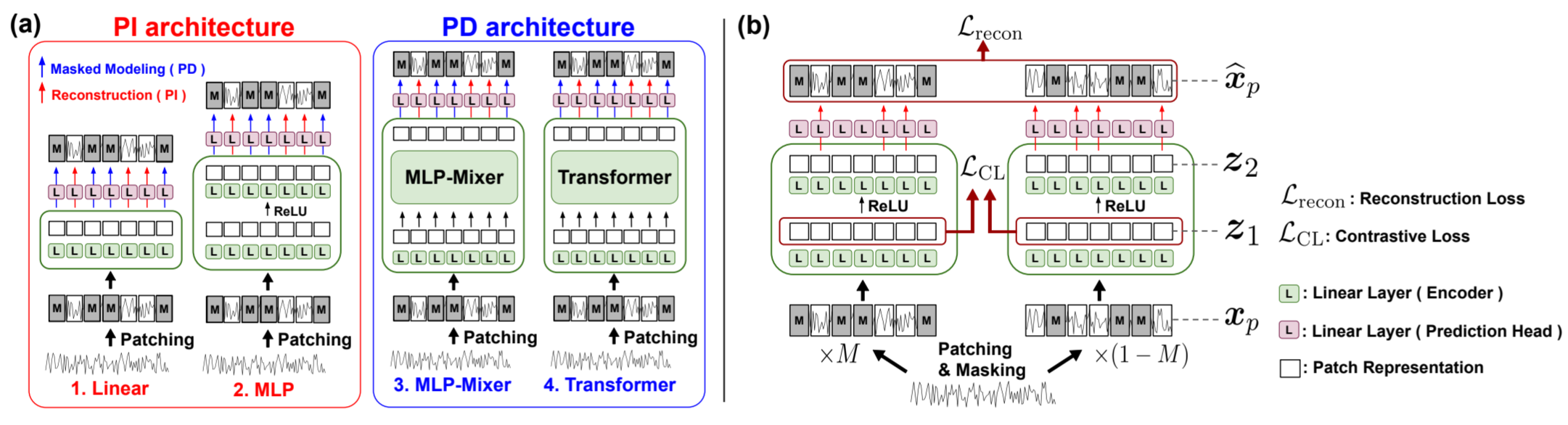

信道独立性和片段独立性。我们的方法采用通道独立架构,即所有通道共享相同的模型权重,并独立嵌入,即 f θ 与 c 无关。与依赖通道的方法相比,这种方法对分布偏移的预测更稳健(Han 等,2023 年)(此话怎讲?)。此外,我们还建议使用 PI 架构,即所有片段共享相同的模型权重并独立嵌入,即 f θ 与 n 无关。我们在图 2(a)中展示了四种不同的 PI/PD 架构,其中我们建议的 PITS 使用 MLP,这是因为其效率和性能较高,分别如表 13 和表 7 所示。

图 2:PITS 的片段独立策略。(a) 展示了 PI 和 PD 的预训练任务和编码器架构。(b) 展示了建议的 PITS,它采用了 PI 架构的 PI 任务。TS 被划分为片段,并使用互补掩码进行增强。来自 MLP 第 1 层和第 2 层的表征分别用于 CL 和重构。

(今天11月9日,周六,今天把这篇博客补了,然后把看论文的一些问题列出来.)

3.1 片段独立的任务:片段重构

传统的 MM 任务(即 PD 任务)是利用未掩码的片段预测已掩码的片段,与此不同,我们提出了片段重构任务(即 PI 任务),如图 2(a)所示,该任务无需查看其他片段即可对每个片段进行自编码。因此,原始的 PD 任务需要捕捉片段依赖关系,而我们提出的任务则不需要。片段化的单变量 TS 可以通过两种不同的方式进行重建 : 1) 由FC 层一次性重建处理片段表征的连接 :![]() 和 2)由FC 层处理每个片段表征进行片段式重建:

和 2)由FC 层处理每个片段表征进行片段式重建: ![]() 其中

其中![]() 。与 Nie 等人(2023 年)的做法类似,我们采用了片段式重建,这种方法在各种实验中都能取得更好的效果。

。与 Nie 等人(2023 年)的做法类似,我们采用了片段式重建,这种方法在各种实验中都能取得更好的效果。

3.2 片段独立的架构:MLP

虽然 MTM 的研究通常使用Transformers来捕捉片段之间的依赖关系,但我们认为学习独立的嵌入片段的效果更好。根据这一想法,我们建议使用简单的 PI 架构,这样编码器就可以只专注于提取片段表征。图 2(a) 显示了 PI/PD 预训练任务和编码器架构的示例。在 PI 架构中,Linear 由单个 FC 层模型组成,MLP 由带有 ReLU 的双层 MLP 组成。对于 PD 架构,MLP-Mixer(Tolstikhin 等人,2021 年;Chen 等人,2023 年)由一个用于时间混合(N -dim)的单 FC 层和一个用于片段混合(D-dim)的双层 MLP 组成,Transformer 由一个自注意层和一个双层 MLP 组成,沿用 Nie 等人(2023 年)的做法。表 13 提供了 MLP 和 Transformer 在参数数量和训练/推理时间方面的效率比较。

3.3 互补对比学习

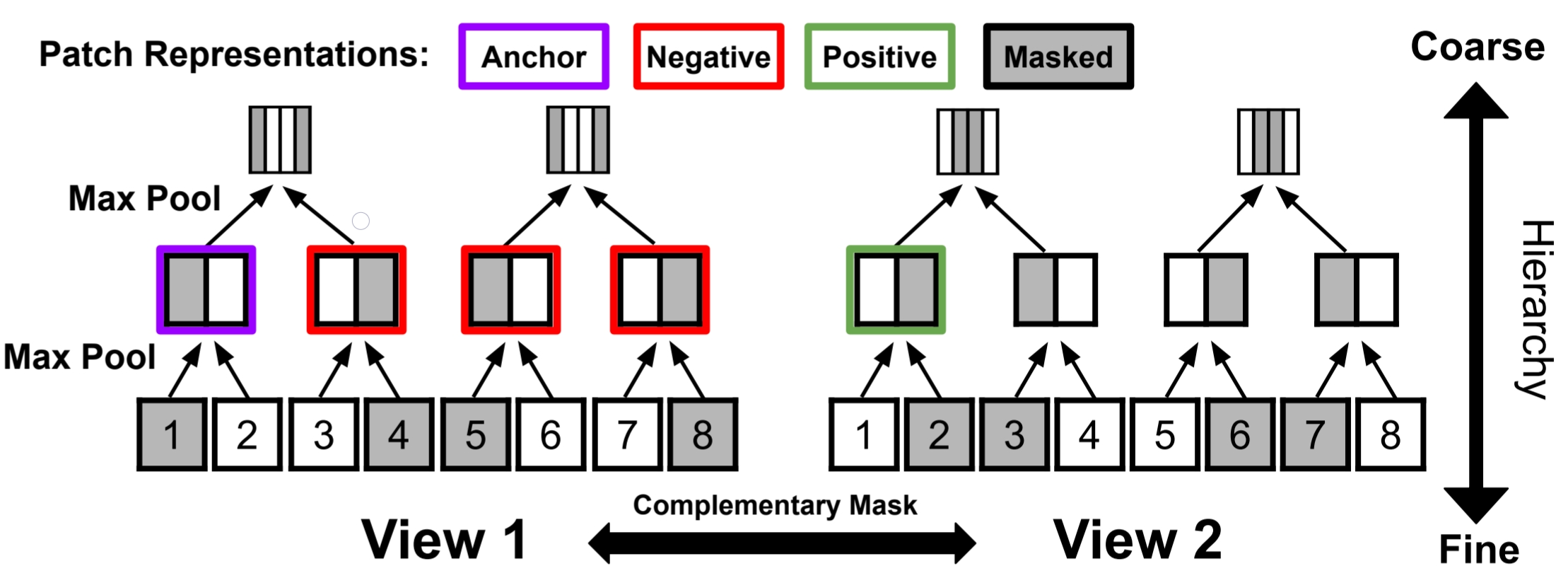

为了进一步提高表征学习的性能,我们提出了互补对比学习,以分层捕捉相邻的 TS 信息。CL 需要两个视图来生成正对,我们通过互补掩码策略来实现:对于长度相同的 TS x 和掩码 m,我们将 m ⊙ x 和 (1 - m) ⊙ x 视为两个视图,其中 ⊙ 是元素相乘,我们使用 50% 的掩码率进行实验。需要注意的是,掩码的目的是为 CL 生成两个视图,它并不影响所提出的 PI 任务,在使用所提出的 PI 架构时也不需要额外的前向传递,这样额外的计算成本可以忽略不计。

图 3 展示了互补 CL 的一个示例,我们通过对沿时间轴的片段表征进行最大池化,分层执行 CL(Yue 等人,2022 年),并计算和汇总在每个层级计算的损失。然后,模型通过与另一视图和其他视图的相似性对比,学会在一个视图中找到缺失的片段信息,这样模型就能分层捕捉相邻的 TS 信息。(没咋看懂这个图呢?下面的1 2 3 4 5 6 7 8是时序的Patch吗?数据块相近的正样本,不相近的负样本?怎么感觉有点奇怪呢?这是把TS2Vec的分层对比加进来了吧)

图 3:互补对比学习。

3.4 目标函数

如图 2(b)所示,根据表 9 中的消融研究,我们在第一层执行 CL,并在第二层顶部通过额外的投影头(projection head)进行重建。为了区分它们,我们将 MLP 中从两层获得的表征分别称为 z 1 和 z 2。

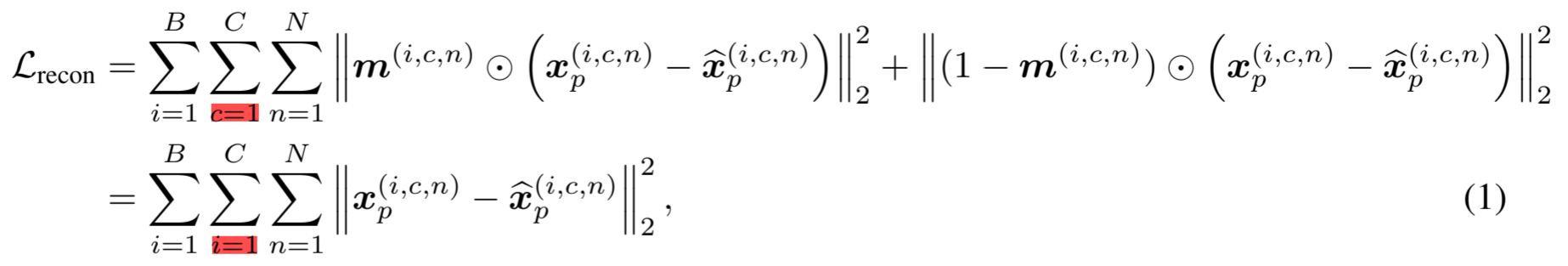

重建损失。如第 3.1 节所述,我们将 z 2 输入片段线性投影头,得到重建结果:![]() 。那么,重建损失可以写成:(红色是我打的标记,公式推导我不会,没推出来这个红色的部分)

。那么,重建损失可以写成:(红色是我打的标记,公式推导我不会,没推出来这个红色的部分)

其中![]() 如果第一个视图

如果第一个视图![]() 被掩码,否则为1。如公式 1 所推导,重建任务不受互补掩码的影响,即重建两个视图的未掩码片段与重建未互补掩码的片段是一样的。

被掩码,否则为1。如公式 1 所推导,重建任务不受互补掩码的影响,即重建两个视图的未掩码片段与重建未互补掩码的片段是一样的。

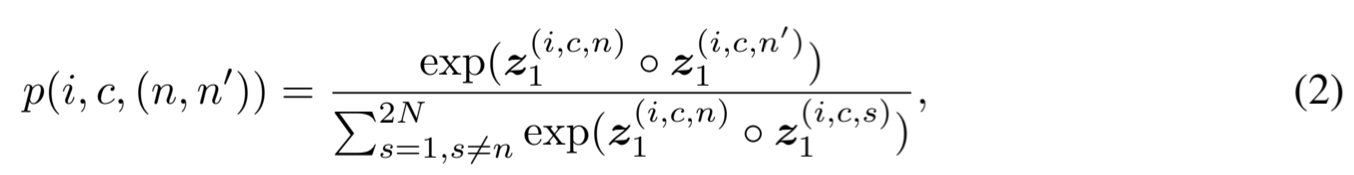

对比损失。受 Lee 等人(2021 年)中对比损失的交叉熵损失类似表述的启发,我们为计算时间对比损失时考虑的所有相似性中的相对相似性建立了一个softmax概率(度量相似性吗?仔细看一下怎么做到的)。为了简洁起见,让![]() 和

和![]() 是片段embedding

是片段embedding![]() 的两个视图。那么,一对片段指数(n,n ′)的softmax概率定义为:

的两个视图。那么,一对片段指数(n,n ′)的softmax概率定义为:

其中,我们使用点积作为相似度量 o。那么,总对比损失可以写成:

其中,我们使用点积作为相似度量 o。那么,总对比损失可以写成:

其中,我们通过最大池化![]() 和维度 n 来计算分层损失,并反复进行以下替换,直到 N = 1:(还是使用的最大池化来得到分层对比Loss)

和维度 n 来计算分层损失,并反复进行以下替换,直到 N = 1:(还是使用的最大池化来得到分层对比Loss)

![]()

PITS 的最终损失是重建损失和分层对比损失之和:

![]()

实例归一化。为了缓解训练数据和测试数据之间的分布偏移问题,我们使用零均值和单位标准差对每个 TS 进行归一化处理(Kim 等人,2021 年)。具体来说,我们在片段之前对每个 TS 进行归一化处理,并将均值和偏差加回到预测输出中。

4 实验

4.1 实验设置

任务和评估指标。我们在两个下游任务(时间序列预测(TSF)和分类(TSC)任务)上演示了所提出的 PITS 的有效性。在评估时,我们主要采用标准 SSL 框架,即在同一数据集上预训练和微调模型,但在某些实验中我们也考虑了域内和跨域迁移学习设置。作为评估指标,我们对 TSF 采用均方误差(MSE)和平均绝对误差(MAE),对 TSC 采用准确度、精确度、召回率和 F 1 分数。

4.2 时间序列预测

数据集和基准方法。在预测任务方面,我们实验了七个数据集,包括四个 ETT 数据集(ETTh1、ETTh2、ETTm1、ETTm2)、天气、交通和电力(Wu 等人,2021 年),预测范围为 H∈{96, 192, 336, 720}。对于基线方法,我们考虑了基于 Transformer 的模型,包括 PatchTST(Nie 等人,2023 年)、SimMTM(Dong 等人,2023 年)、FEDformer(Zhou 等人,2022 年)和 Autoformer(Wu 等人,2021 年),以及线性/MLP 模型,包括 DLinear(Zeng 等人,2023 年)和 TSMixer(Chen 等人,2023 年)。我们还比较了没有自监督预训练的 PITS 和 PatchTST,基本上只比较了 PI 和 PD 架构。我们沿用了 PatchTST、SimMTM 和 TSMixer 的实验设置和基线结果。在所有超参数调整中,我们都使用了单独的验证数据集,按照标准协议将所有数据集按时间顺序分成训练集、验证集和测试集,其中 ETT 数据集的比例为 6:2:2,其他数据集的比例为 7:1:2(Wu 等人,2021 年)。

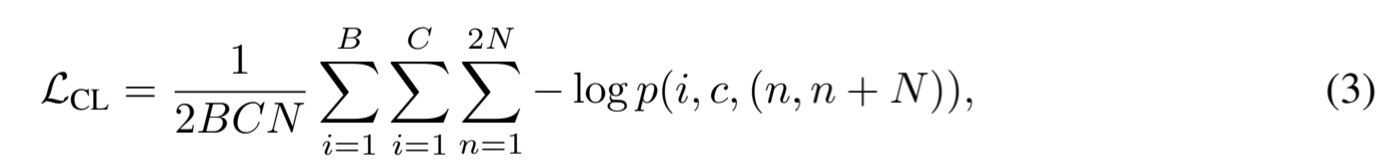

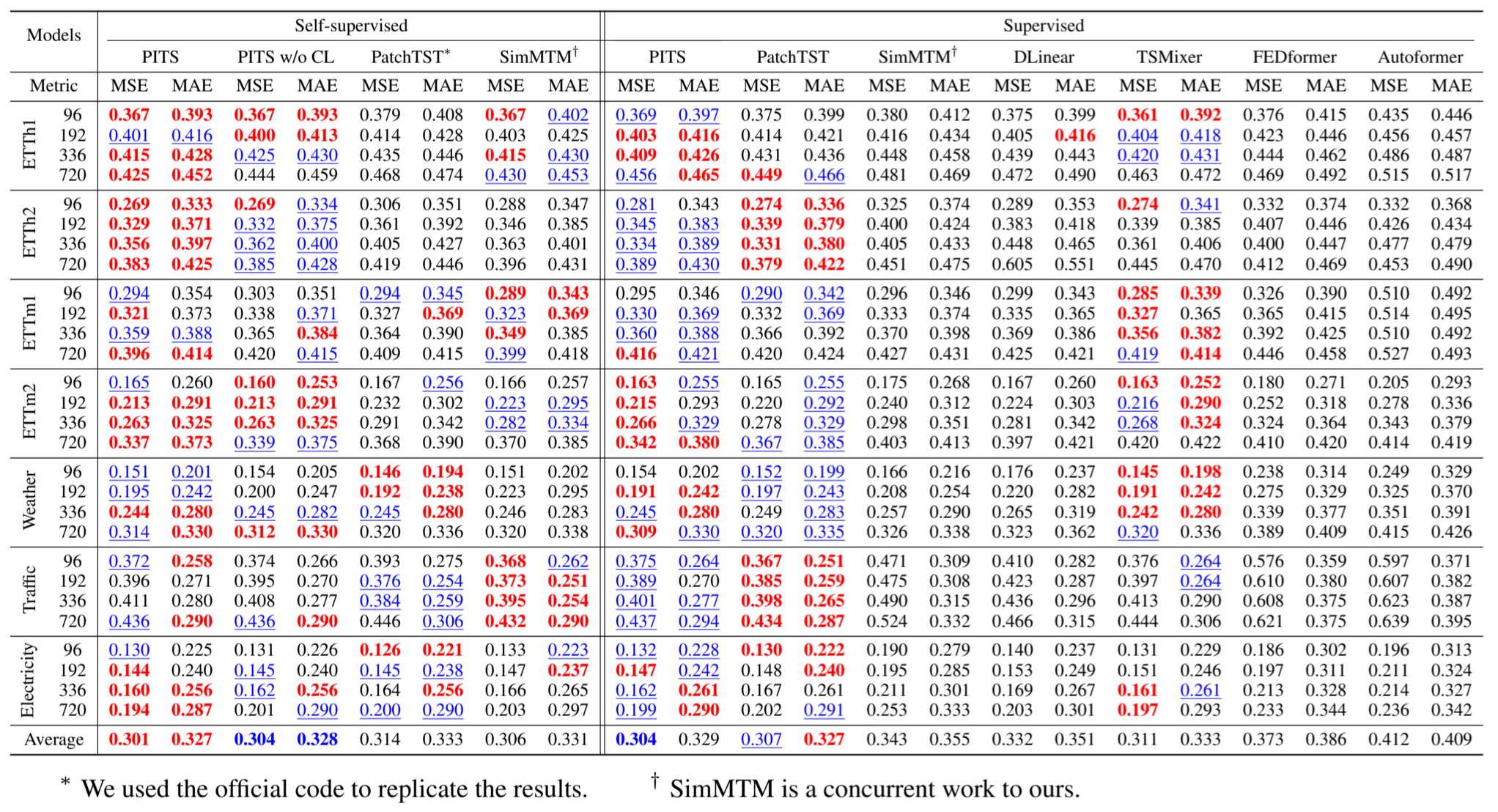

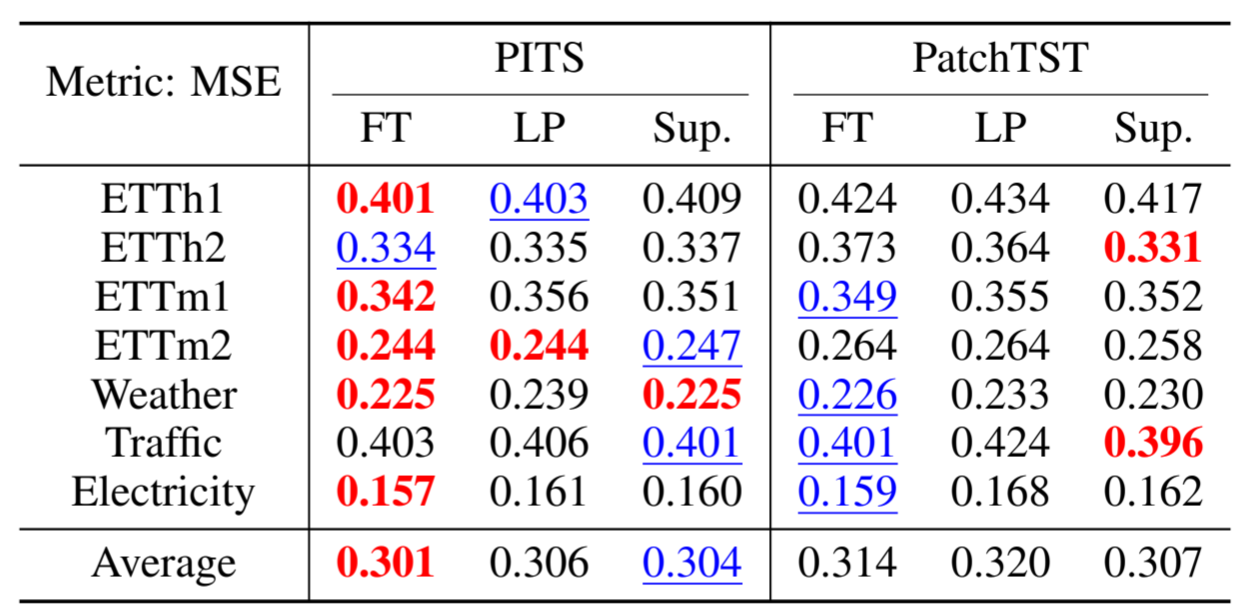

标准设置。表 2 显示了多变量 TSF 任务的综合结果,表明我们提出的 PITS 在两种设置下都能与 PatchTST 竞争,PatchTST 是基于 SOTA Transformer 的方法,而 PITS 的效率比 PatchTST 高得多。SimMTM 是同时进行的一项工作,它在 SSL 中的性能与我们的相似,但在监督学习中的性能明显较差。表 3 比较了 PITS 和 PatchTST 在微调(FT)、线性探测(LP)和无自监督预训练的监督学习(Sup.)三种不同情况下的表现,其中我们列出了四个horizons下的平均 MSE。如表 3 所示,在所有情况下,PITS 的平均 MSE 都优于 PatchTST。

表 2: 多变量TSF 的结果。我们比较了 PatchTST 的监督和自监督版本以及我们的方法。最佳结果以粗体表示,次佳结果以下划线表示。

表 3:PITS 与 PatchTST 的对比。

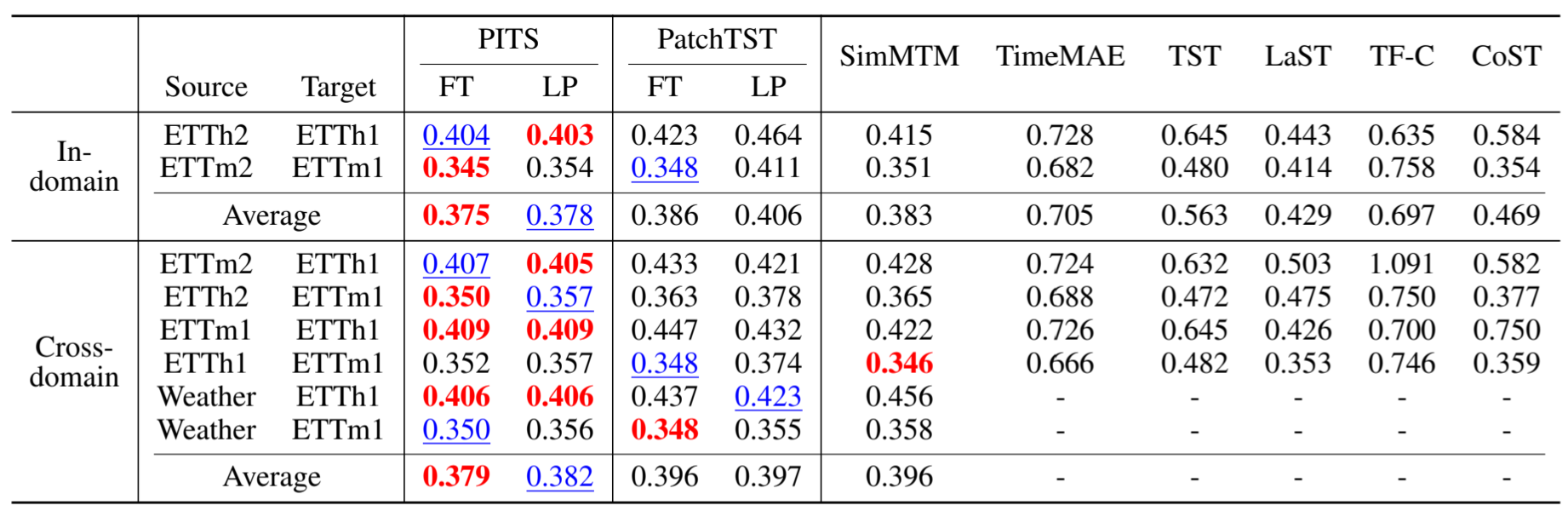

迁移学习。在域内迁移中,我们对源数据集和目标数据集使用相同频率的数据集进行实验;而在跨域迁移中,我们对源数据集和目标数据集使用不同频率的数据集进行实验。表 4 显示了四个horizons的平均 MSE 结果,这表明我们提出的 PITS 在大多数情况下都超过了 SOTA 方法。

表 4:采用迁移学习的 TSF 结果。

4.3 时间序列分类

数据集和基准方法。在分类任务中,我们使用了五个数据集:SleepEEG(Kemp 等人,2000 年)、Epilepsy(Andrzejak 等人,2001 年)、FD-B(Lessmeier 等人,2016 年)、Gesture(Liu 等人,2009 年)和 EMG(Goldberger 等人,2000 年)。对于基线方法,我们采用了 TS-SD(Shi 等人,2021 年)、TS2Vec(Yue 等人,2022 年)、CoST(Woo 等人,2022 年)、LaST(Wang 等人,2022 年)、Mixing-Up(Wickstrøm et al、 2022 年)、TS-TCC(Eldele 等人,2021 年)、TF-C(Zhang 等人,2022 年)、TST(Zerveas 等人,2021 年)、TimeMAE(Cheng 等人,2023 年)和 SimMTM(Dong 等人,2023 年)。

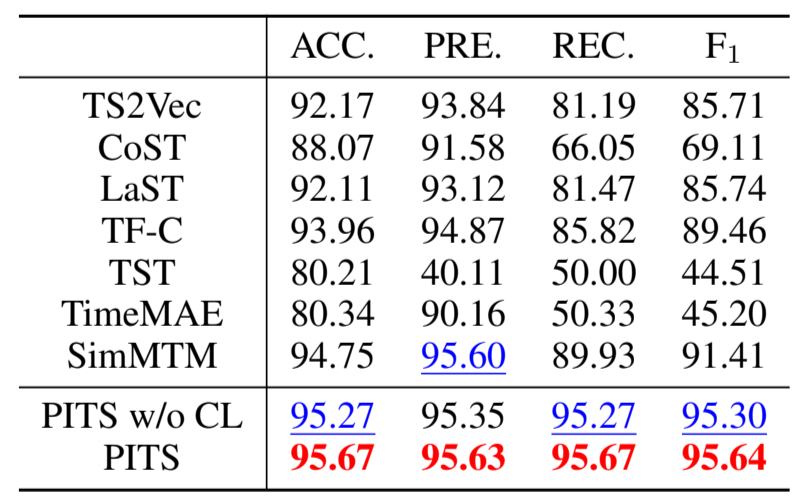

标准设定。表 5 显示,在癫痫数据集上,我们提出的 PITS 在所有指标上都优于所有 SOTA 方法。这与之前关于 CL 在分类任务中优于 MTM 的研究结果形成了鲜明对比(Yue 等人,2022 年):与 TS2Vec 和 TF-C 等 CL 方法相比,之前的 MTM 方法(如 TST 和 TimeMAE)性能相对较低,而我们提出的 PITS 则优于 CL 方法,即使没有补充 CL。

表 5:TSC 的结果。

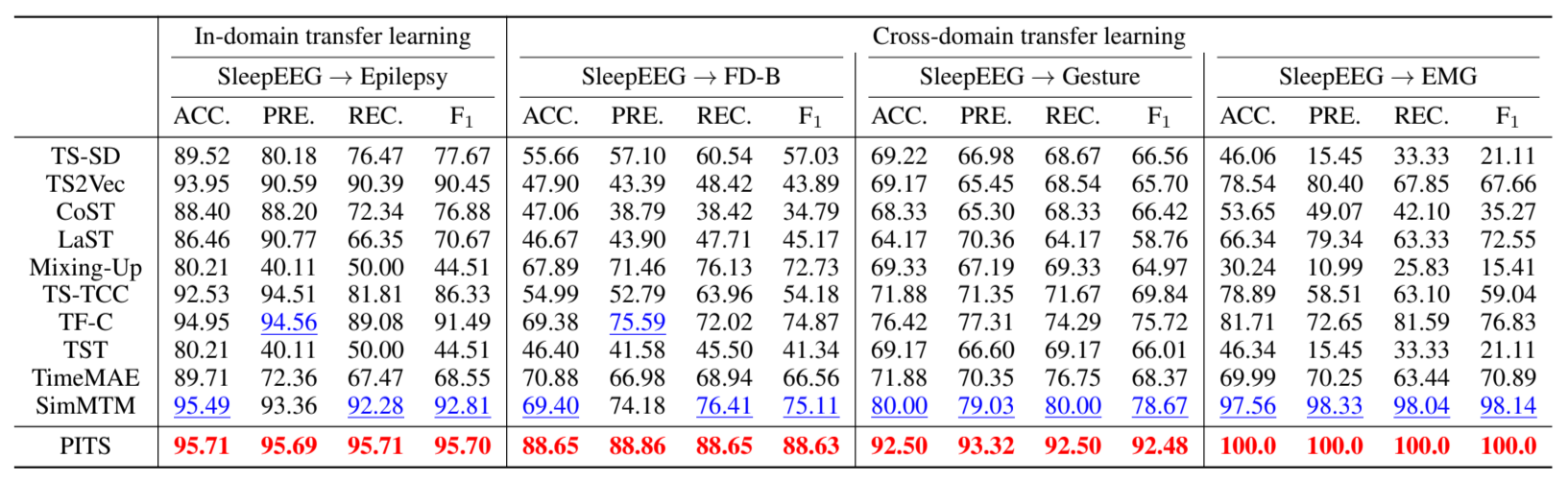

迁移学习。在迁移学习方面,我们使用 SleepEEG 作为源数据集,在域内和跨域迁移设置中进行了实验。域内迁移时,我们使用与源数据集相同领域的目标数据集,这些数据集都具有脑电图数据集的特征;跨域迁移时,我们使用不同领域的目标数据集。表 6 显示,我们的 PITS 在所有情况下都优于 SOTA 方法。特别是在具有挑战性的跨领域迁移学习环境中,性能提升非常明显,这意味着 PITS 在领域转移的实际应用中更加实用。

表 6: 采用迁移学习的 TSC 结果。

4.4 消融研究

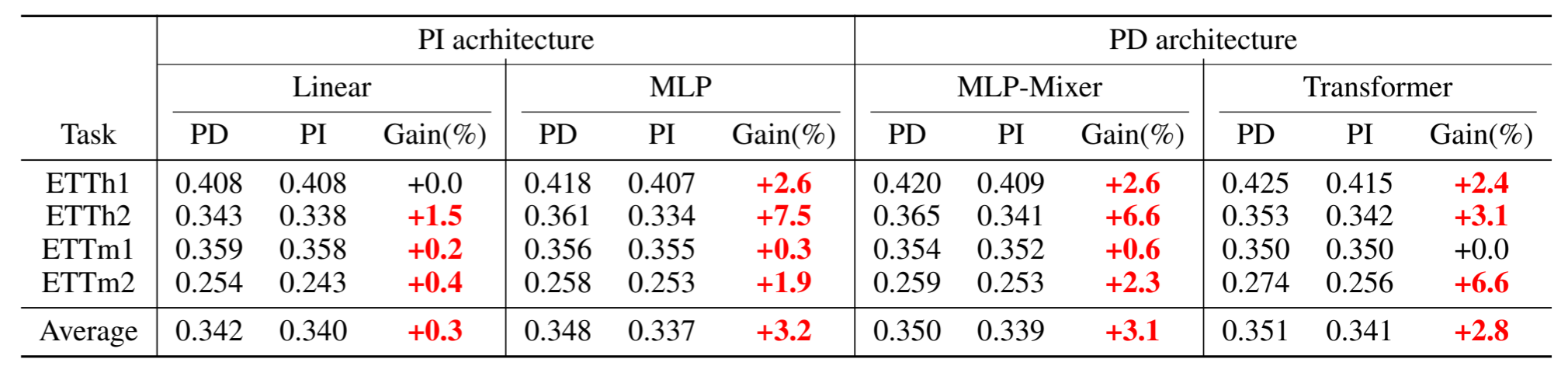

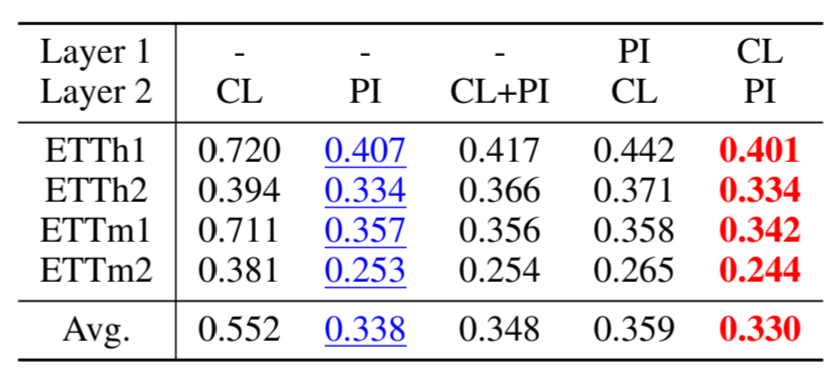

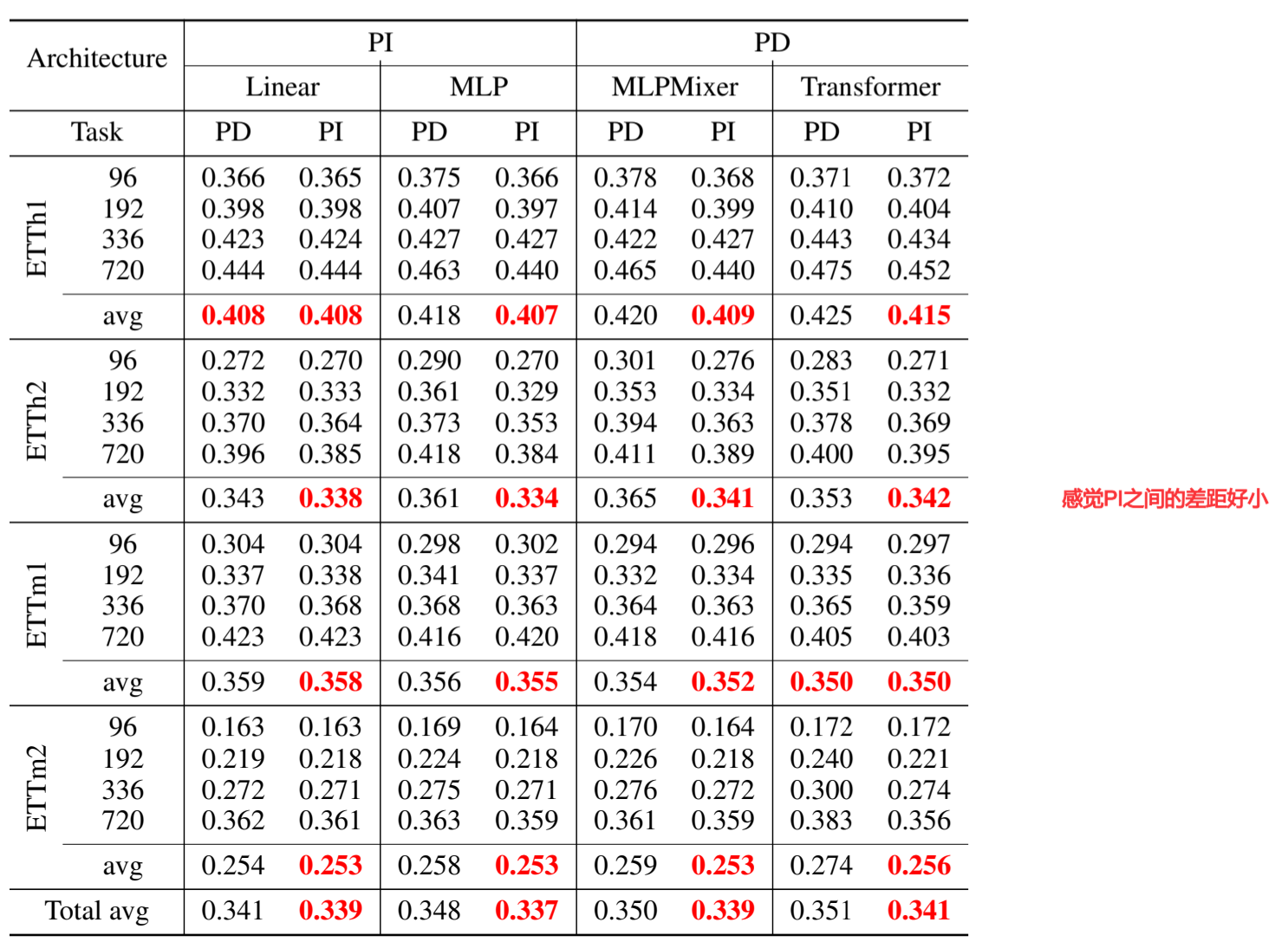

PI/PD 任务/架构的效果。为了评估我们提出的 PI 预训练任务和 PI 编码器架构的效果,我们在表 7 中使用 512 的输入horizon和 12 的片段大小进行了消融研究。回顾一下,PD 任务使用未掩码片段预测掩码片段,而 PI 任务则自编码片段,PD 架构包括使用全连接层(MLP-Mixer)或自注意力模块(Transformer)的片段间交互,而 PI 架构(线性、MLP)则不包括。如表 7 所示,无论选择哪种架构,PI 预训练的 TSF 性能都优于 PD 预训练。此外,与 PD 架构相比,PI 架构的性能更具竞争力,同时 PI 架构更轻便、更高效,如表 13 所示。其中,MLP 在保持效率的同时表现出最佳性能,因此我们在所有实验中都使用 MLP 作为 PITS 的架构。

表 7:PI 策略的有效性。在所有架构中,使用 PI 任务进行的预训练始终优于 PD 任务。结果以四个horizons的平均值报告。

隐藏维度和dropout。PI 任务可能会引起对无效解的关注:当隐藏维度 D 大于输入维度 P 时,身份映射会完美地重建输入。这可以通过引入 “dropout ”来解决,即在线性投影头之前添加一个 “dropout ”层。图 4 显示了 MLP 在不同隐藏维度 D 的情况下,对四个 ETT 数据集的平均 MSE,在没有dropout或dropout率为 0.2 的情况下,共同输入维度为 512。请注意,在本实验中,输入维度(片段大小)为 12,如果 D≥ 12,则会出现无效解。结果证实,要学习高维表征,使用 dropout 是必要的,可带来更好的性能。基于这一结果,我们在整个实验中调整了 D∈{32, 64, 128},而 D 值范围内的性能是一致的。不同dropout率的消融研究见附录 K。

图 4:按 D 和dropout计算的 MSE。

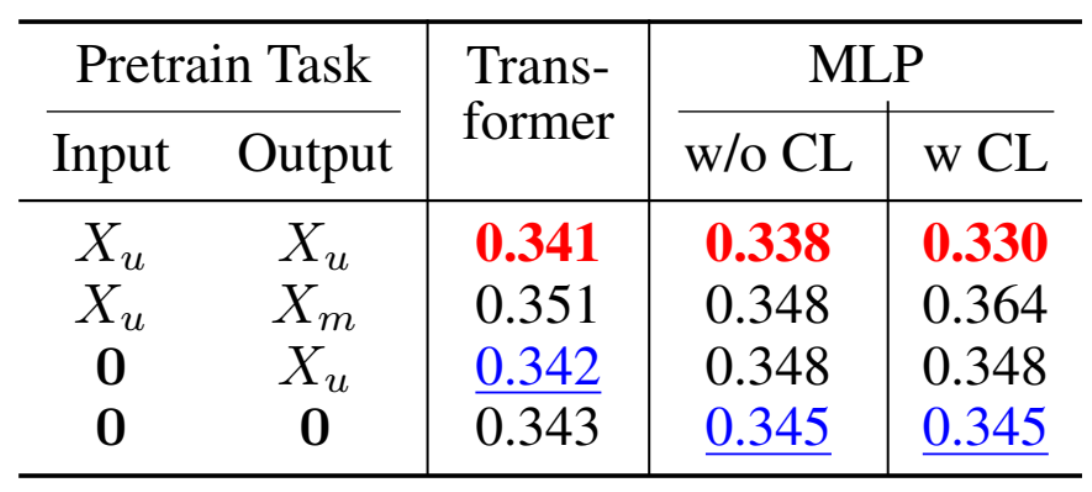

各种预训练任务的性能。除了 1) 重建掩码片段(X m )的 PD 任务和 2) 对未掩码片段(X u )进行自编码的 PI 任务外,我们还采用了另外两个基本任务进行比较: 表 8 显示了四个 ETT 数据集的平均 MSE,这四个数据集的输入范围均为 512,突出显示了使用 PD 任务预训练的模型的表现甚至不如使用 0 作为输入的两个基本任务。这凸显了 PD 任务的无效性和建议的 PI 任务的有效性。

表 8:预培训任务。

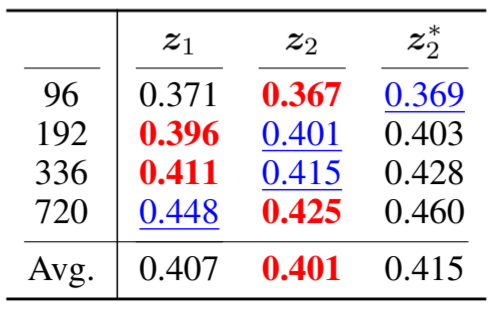

下游任务使用哪种表征法?在 SSL 中,编码器和特定任务投影头的边界往往并不清晰。为了确定为下游任务提取表征的位置,我们使用 MLP 中间层的表征进行了实验:1)第一层的 z 1;2)第二层的 z 2;3)第二层顶部附加投影层的 z ∗2。表 10 显示了 ETTh1 在四个水平面上的 MSE,表明第二层 z 2 的结果最好。

表 10:下游任务的表征方法。

(现在是11月11日的22:00,准备歇了,明天再继续补充博客和看一下代码.)

互补 CL 的位置。为了评估互补 CL 与 PI 重构的效果,我们对代理任务的选择及其在 MLP 编码器中的位置进行了消融研究:对比和/或重构损失在第一层或第二层计算,或者两者都不计算。表 9 显示了四个 ETT 数据集在四个范围内的平均 MSE。我们发现,PI 重构任务至关重要,而在第一层考虑 CL 时效果显著。

表 9:CL 的影响。

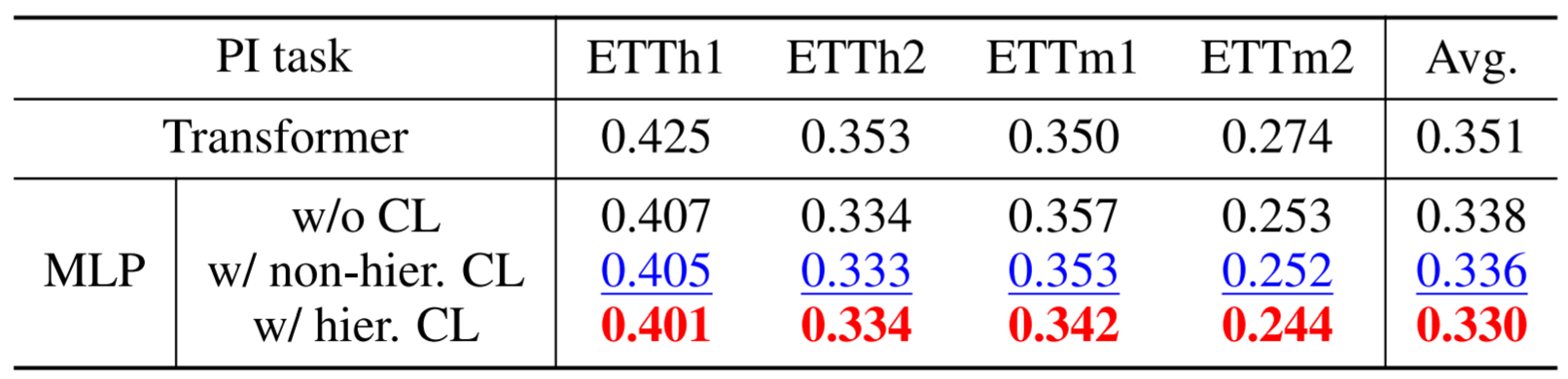

互补 CL 的分层设计。提出的互补 CL 采用分层结构,以捕捉时间序列中的粗粒度和细粒度信息。为了评估这种分层设计的效果,我们考虑了三种不同的方案: 1) 无 CL,2) 非分层 CL,3) 分层 CL。表 11 列出了四个 ETT 数据集在四个时间跨度上的平均 MSE,突出显示了分层设计带来的性能提升。(这说明多尺度还是有效果)

表 11:互补 CL 的分层设计。

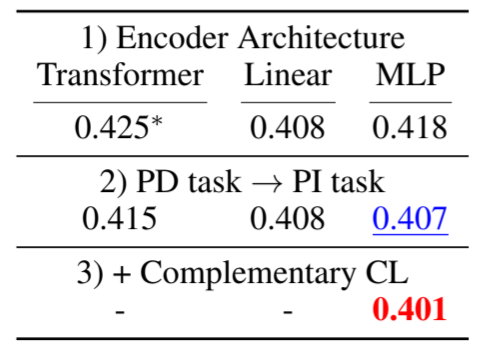

与 PatchTST 的比较。通过改变预训练任务和编码器架构,PITS 可以衍生出 PatchTST。表 12 显示了每种修改对 ETTh1 数据集性能提高的贡献。请注意,我们对 PatchTST 采用了 50%的掩码率,这并不影响其性能(用 ∗ 标记)。

表 12:PatchTST→PITS

5 分析

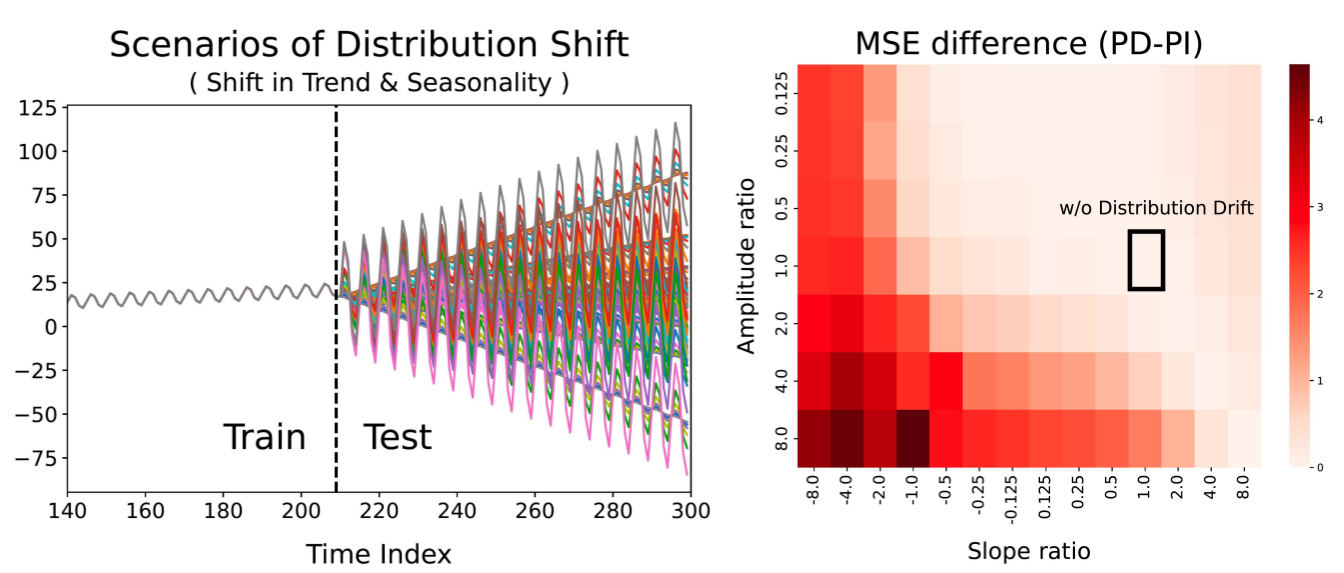

PI 任务比 PD 任务对分布偏移更稳健。为了评估预训练任务对分布偏移的稳健性,我们生成了 98 个表现出不同程度分布偏移的玩具示例,如图 5 左侧面板所示。偏移程度以斜率和振幅的变化为特征。图 5 右侧面板直观显示了用 PD 任务和 PI 任务训练的模型之间的性能差距,其中横轴和纵轴分别对应于训练阶段和测试阶段的斜率和振幅差异。结果表明,用 PI 任务训练的模型对分布偏移表现出更好的鲁棒性,因为在所有机制中 MSE 差值都不是负数,而且随着偏移变得越来越严重,差距也会越来越大,尤其是当斜率翻转或振幅增大时。(为什么可以缓解分布漂移问题?是MLP结构的优势还是Patch的优势,or something?目前个人理解是MLP的效果,因为不学习全局/整体趋势特征,面对整体趋势之外的表现,自然不会受这种全局趋势的影响)

图 5:分布偏移下的 PI 任务与 PD 任务对比。

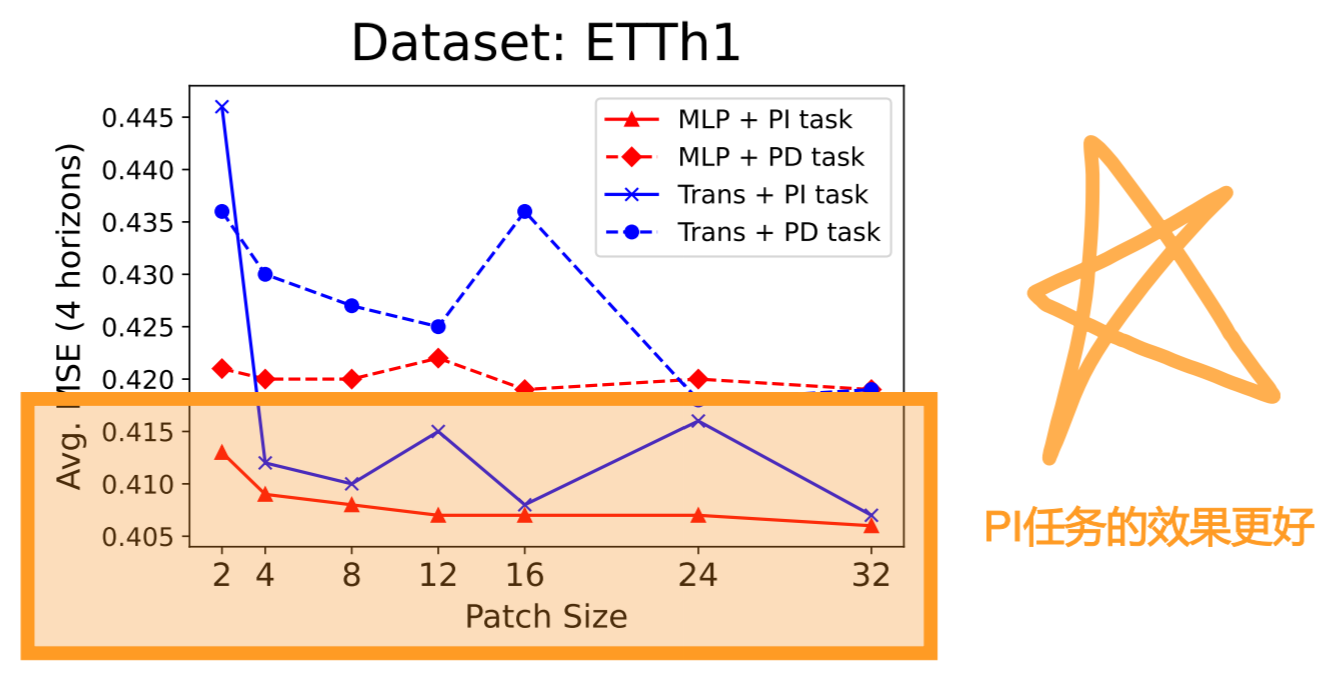

与 Transformer 相比,MLP 对片段大小的鲁棒性更高。为了评估编码器架构对片段大小的稳健性,我们使用不同片段大小的 ETTh1 对 MLP 和 Transformer 进行了比较。图 6 显示了结果,表明 MLP 在 PI 和 PD 任务中的鲁棒性更强,因此在不同片段大小下的预测性能始终更好。

图 6:按片段大小计算的 MSE。

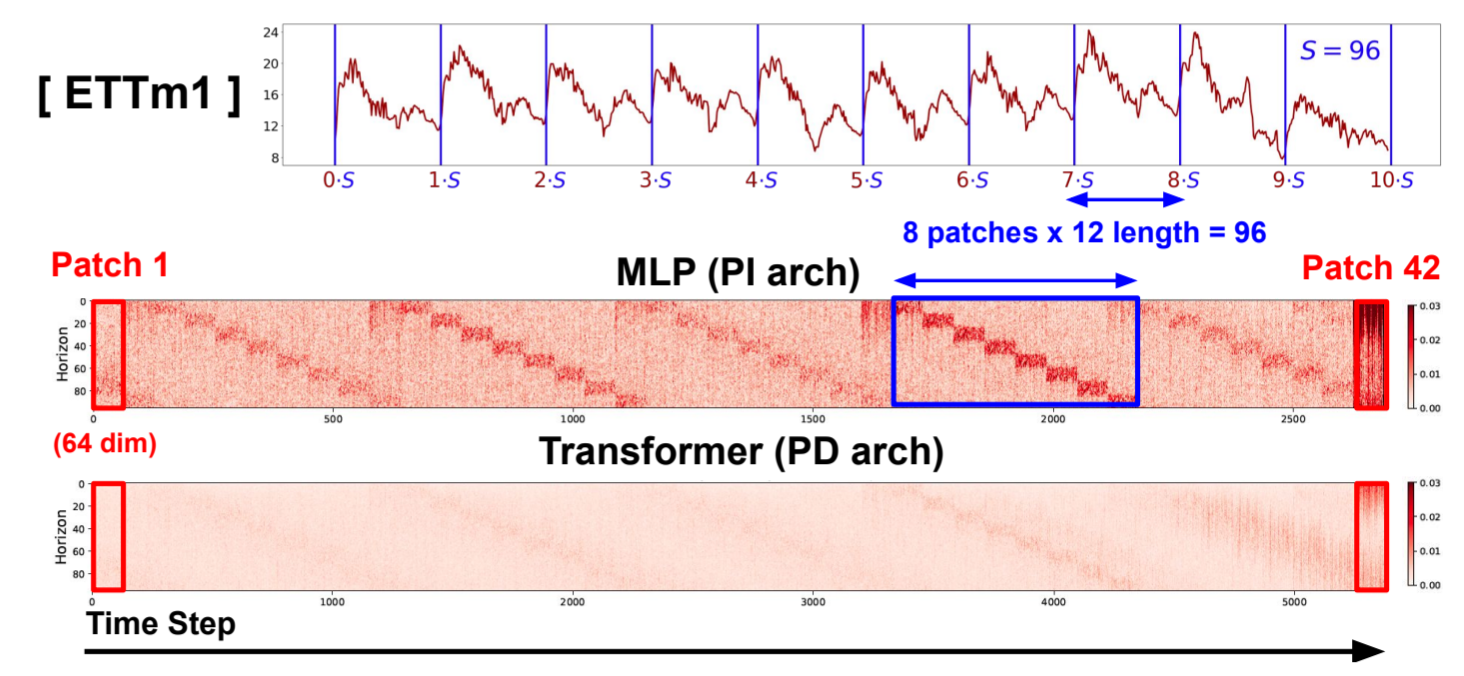

MLP 比 Transformer 更易解释。PI 架构独立处理每个片段,而 PD 架构则共享所有片段的信息,从而导致片段之间的信息泄露。(信息泄露吗?)这使得 MLP 比 Transformer 更具有可解释性,因为通过可视化为下游任务额外引入和学习的线性层的权重矩阵,可以显示每个片段对预测的贡献。图 7 展示了 ETTm1 的季节性和两种架构在 ETTm1 上训练的下游权重矩阵。Transformer 上线性层的权重矩阵大部分是统一的,而 MLP 的权重矩阵则显示出季节性模式,并强调了最近的信息,突出表明 MLP 比 Transformer 更好地捕捉了季节性。(这结论略显武断了老哥)(这不是反直觉的吗?之前一直都是说Transformer可以更好地提取季节趋势等特征吗?为什么MLP在这里效果更好)(为什么MLP比Transformer效果好,有没有一种可能是数据集的问题,数据集用的是比较漂移的,但是好像也说得通,Transformer可能会过拟合或者是会学习到整体的特征,对于分布漂移的数据来说,效果就不会好)

图 7:下游任务权重![]() 。

。

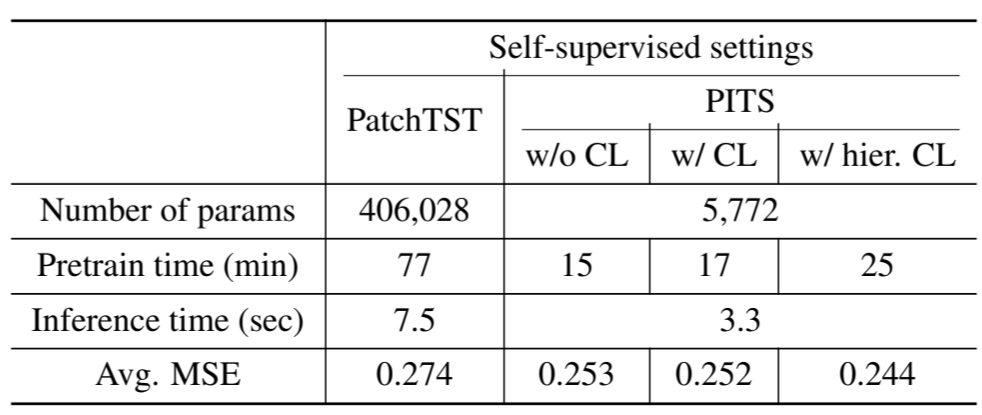

效率分析。为了证明 PI 架构的效率,我们比较了 PatchTST 和 PITS 在 ETTm2 上的参数数量和训练/推理时间。如表 13 所示,PITS 的参数数量明显少于 PatchTST,而且训练和推理速度更快。自监督和监督设置的效率比较见附录 J。

表 13:时间/参数效率。

t-SNE 可视化。为了评估从 PI 和 PD 任务中获得的表征质量,我们利用 t-SNE(Van der Maaten 和 Hinton,2008 年)进行可视化。为进行分析,我们创建了具有 10 类趋势和季节性模式的玩具示例,如图 8 所示。结果表明,从 PI 任务中学到的表征能更好地区分不同类别。

图 8:t-SNE 可视化。

6 结论

本文重新审视了时间序列分析中的掩码建模,重点关注两个关键方面: 1) 预训练任务和 2) 模型结构。与以往主要强调 TS 片段间依赖关系的研究相比,我们从两个方面倡导一种片段独立的方法:1)通过引入片段重构任务;2)采用片段式 MLP。我们的研究结果表明,与 PD 方法相比,所提出的 PI 方法对分布偏移和片段大小具有更强的鲁棒性,因此在预测和分类任务中性能更优,同时效率更高。我们希望我们的工作能通过简单的预训练任务和模型架构,揭示自监督学习在不同领域的有效性,并为未来的时间序列分析工作提供强有力的基线。

再贴一下附录的部分内容:

附录

D 时间序列预测

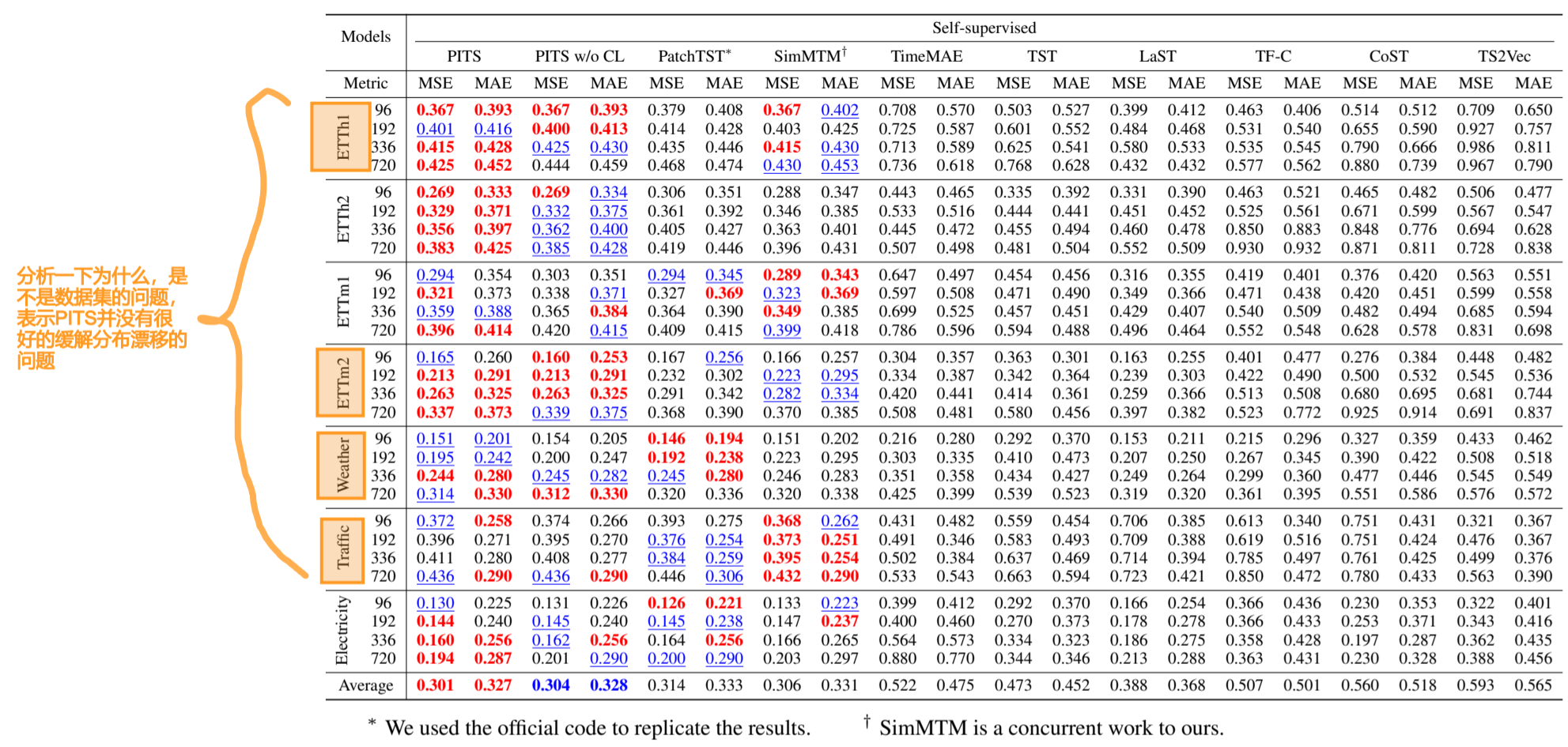

为了证明 PITS 与其他 SOTA 自监督方法相比的有效性,我们将 PITS 与作为 MTM 方法的 PatchTST(Nie 等人,2023 年)、SimMTM(Dong 等人,2023 年)、TimeMAE(Cheng 等人,2023 年)、TST(Zerveas 等人,2021 年),以及作为 CL 方法的 TF-C(Zhang 等人,2022 年)、CoST(Woo 等人,2022 年)、TS2Vec(Yue 等人,2022 年)进行了比较。表 D.1 中的结果显示,在多变量时间序列预测任务中,PITS 的性能优于这些方法。

表 D.1: 采用自监督方法的多变量 TSF 结果。最佳结果以粗体表示,次佳结果以下划线表示。

H PI 策略的有效性

在本实验中,我们从两个方面研究了我们提出的 PI 策略的影响: 1) 预训练任务和 2) 编码器架构。实验结果如表 H.1 所示,包括四个 ETT 数据集,四个不同的预测horizons,共同的输入horizon为 512。这些结果表明,在所有考虑的架构中,PI 任务始终优于传统的 PD 任务。

表 H.1:PI 任务和 PI 架构的有效性。

(现在11月12日11:51,看完了,准备去跑跑代码看看具体情况了.)

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· 什么是nginx的强缓存和协商缓存

· 一文读懂知识蒸馏

· Manus爆火,是硬核还是营销?

2017-11-05 HDU 6038.Function-数学+思维 (2017 Multi-University Training Contest - Team 1 1006)