爬虫试水

昨天晚上在群里听大佬聊了很久的爬虫,今天决定来练波手。

目标:有道翻

爬虫个人见解:

爬虫本质是一个向接口发请求,接受响应,再从响应中获取我们想要的内容。

不管是java还是python,甚至其他语言,只要可以充当一个浏览器客户端

的身份,向服务器发送请求,可以用来做爬虫,而且随着爬虫的流行,反爬

机制也在不断升级,对一些参数的加密,甚至隐藏,这都需要一个比较高的js

水平和调试能力。

1.进入页面,F12,看看我们需要的是哪些接口

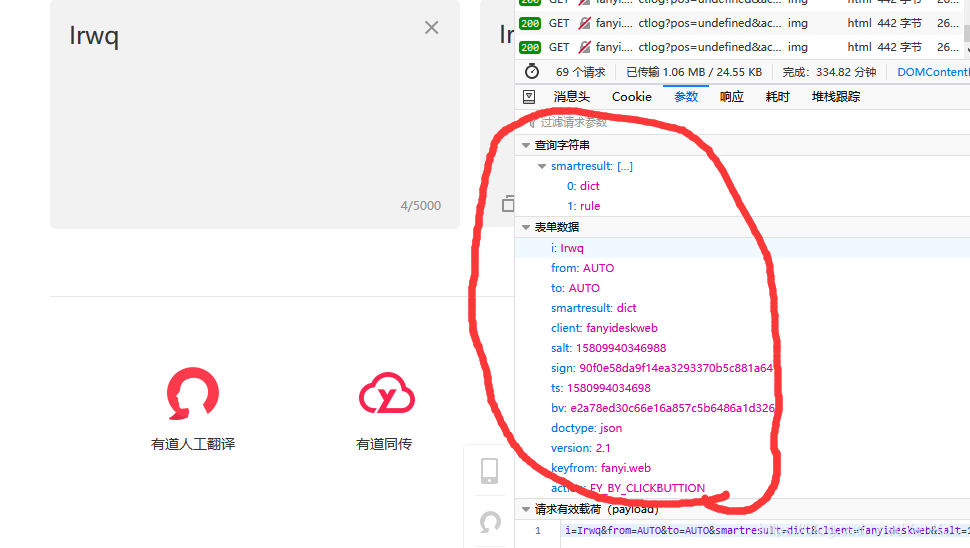

1.1发现了这个接口是我们所需要的,然后我们再继续观察我们所需要的参数,有哪些

1.2每次刷新sign,slat,ts都在变化,说明这些玩意肯定经过特殊的处理,找找js,看看咋回事。

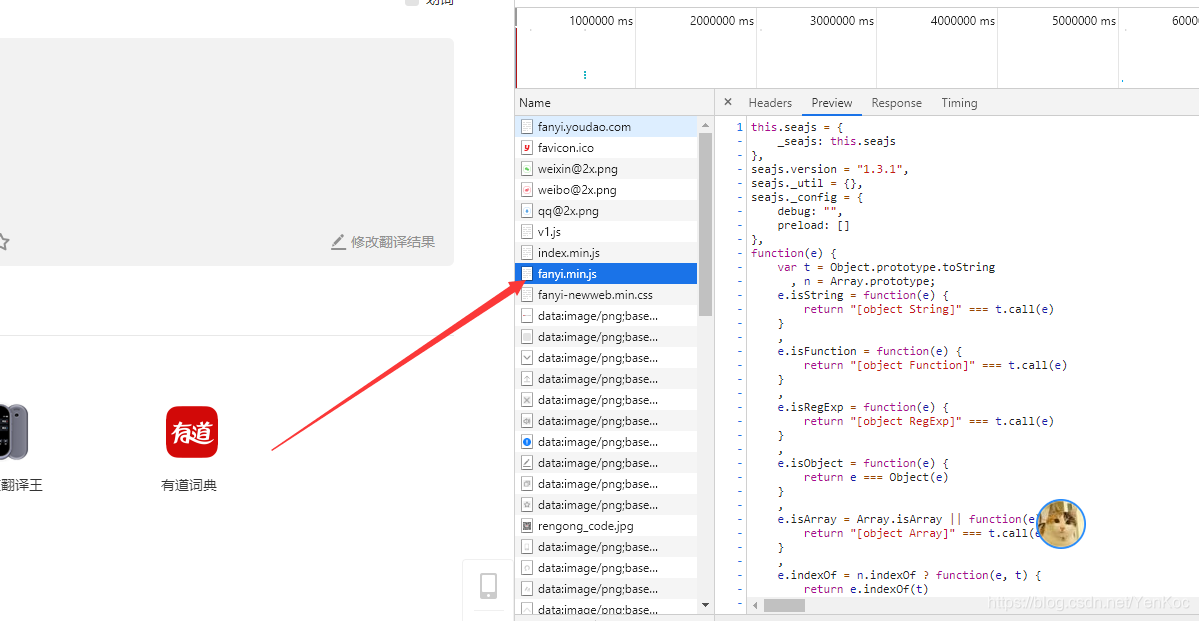

因为是翻译的接口,我优先去看这个fanyi的js,说不定有我们想要的。ctrl+f查找下我们的参数。

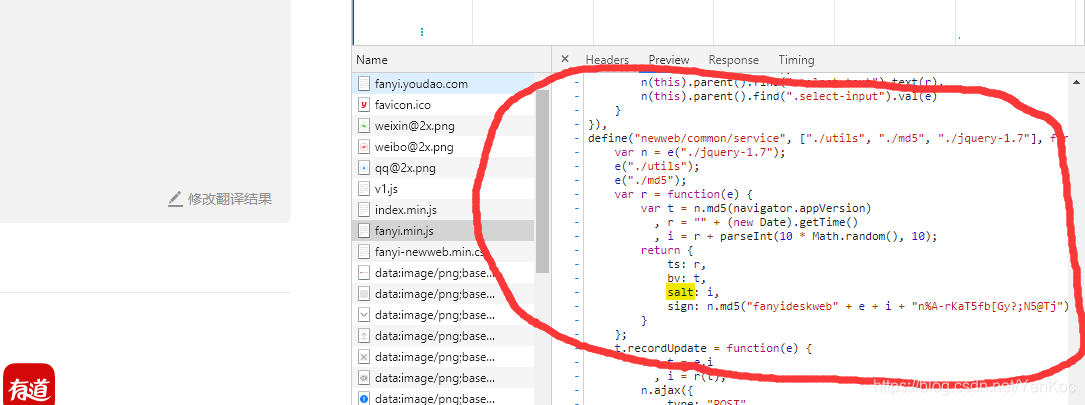

找到了我们所需要的。。。哈哈哈

1.4总结一下我们的参数。

ts:时间戳

bv:md5加密navigator.appVersion这个变量

salt:ts+加上一个100以内的随机数

sign:拼接"fanyide---"和我们输入的字符串和salt+"n...."之后md5加密

上脚本:

import requests

import time

import hashlib

import json

import urllib.parse

def md5encode(str):

hash=hashlib.md5()

hash.update(bytes(str,encoding="utf-8"))

return hash.hexdigest()

def dictres(str1):

navi="Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:72.0) Gecko/20100101 Firefox/72.0"

bv=md5encode(navi) #加密md5

ts=str(round(time.time()*1000)) ##时间戳

salt=ts+"90"

sign=md5encode("fanyideskweb" + str1 + salt + "n%A-rKaT5fb[Gy?;N5@Tj") #将前面的两个参数拼接

dicter={"smartresult": ["dict", "rule"],

"i": str1,

"from": "AUTO",

"to": "AUTO",

"smartresult": "dict",

"client": "fanyideskweb",

"salt": salt,

"sign": sign,

"ts": ts,

"bv": bv,

"doctype": "json", "version": "2.1", "keyfrom": "fanyi.web",

"action": "FY_BY_CLICKBUTTION"

}

return dicter

url="http://fanyi.youdao.com/translate_o?smartresult=dict&"

dicter=dictres("I Love")

dicter=urllib.parse.urlencode(dicter,encoding="utf-8")

headers={

"Host": "fanyi.youdao.com",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:72.0) Gecko/20100101 Firefox/72.0",

"Accept":"application/json, text/javascript, */*; q=0.01",

"Accept-Language": "zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2",

"Accept-Encoding": "gzip, deflate",

"Content-Type":"application/x-www-form-urlencoded; charset=UTF-8",

"X-Requested-With": "XMLHttpRequest",

"Content-Length": "241",

"Origin":"http://fanyi.youdao.com",

"Connection": "keep-alive",

"Referer": "http://fanyi.youdao.com/",

"Cookie": "OUDAO_MOBILE_ACCESS_TYPE=1; OUTFOX_SEARCH_USER_ID=415492750@10.169.0.84; JSESSIONID=aaay_N_BxKsAh94ZLNzax; ___rl__test__cookies=1580994034695; OUTFOX_SEARCH_USER_ID_NCOO=2106452202.0045033"

}

res=requests.post(url,data=dicter,headers=headers)

print(type(res))

finalres=res.json()

print(finalres['translateResult'][0][0]['tgt'])