7.Spark SQL

1.请分析SparkSQL出现的原因,并简述SparkSQL的起源与发展。

SparkSQL的前身是Shark,是用来给MapReduce的技术人员提供快速上手的工具。

Hive是早期唯一运行在Hadoop上的SQL-on-Hadoop工具,但MapReduce计算过程中大量的中间磁盘落地过程消耗了大量的 I/O,降低的运行效率。所以开始出现了部分新的SQL-on-Hadoop工具,例如Drill、Shark。

Shark是Spark生态环境的组件之一,是基于Hive所开发的工具。Shark的出现,使得SQL-on-Hadoop的性能比Hive有了 10-100 倍的提高。Shark对于Hive的太多依赖(如采用Hive的语法解析器、查询优化器等等),制约了Spark的One Stack Rule Them All的既定方针,制约了Spark各个组件的相互集成,所以提出了SparkSQL项目。SparkSQL抛弃原有Shark的代码,汲取了Shark的一些优点。由于摆脱了对Hive的依赖性,SparkSQL无论在数据兼容、性能优化、组件扩展方面都得到了极大的方便

数据兼容方面SparkSQL不但兼容Hive,还可以从RDD、parquet文件、JSON文件中获取数据,未来版本甚至支持获取RDBMS数据以及cassandra 等 NOSQL数据;

其中SparkSQL作为Spark生态的一员继续发展,而不再受限于Hive,只是兼容Hive;而Hive on Spark是一个Hive的发展计划,该计划将 Spark 作为 Hive的底层引擎之一,也就是说,Hive将不再受限于一个引擎,可以采用 Map-Reduce、Tez、Spark等引擎。

2. 简述RDD 和DataFrame的联系与区别?

-

RDD是一种弹性分布式数据集,是一种只读分区数据。它是spark的基础数据结构,具有内存计算能力、数据容错性以及数据不可修改特性。

-

Dataframe也是一种不可修改的分布式数据集合,它可以按列查询数据,类似于关系数据库里面的表结构。可以对数据指定数据模式(schema)。

共同点

-

都是spark平台下的分布式弹性数据集,为处理超大型数据提供便利

-

都有惰性机制,在进行创建、转换,如map方法时,不会立即执行,只有在遇到Action如foreach时,才会开始遍历运算

-

都会根据spark的内存情况自动缓存运算,这样即使数据量很大,也不用担心会内存溢出

-

都有partition的概念

-

有许多共同的函数,如filter,排序等

不同点

RDD

-

RDD一般和spark mlib同时使用

-

RDD不支持sparksql操作

DataFrame

-

与RDD不同,DataFrame每一行的类型固定为Row,只有通过解析才能获取各个字段的值

-

DataFrame与Dataset一般与spark ml同时使用。

-

支持一些特别方便的保存方式,比如保存成csv,可以带上表头

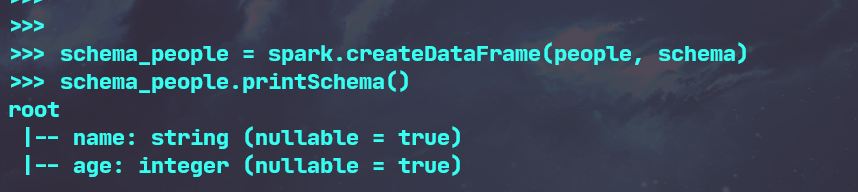

3.DataFrame的创建

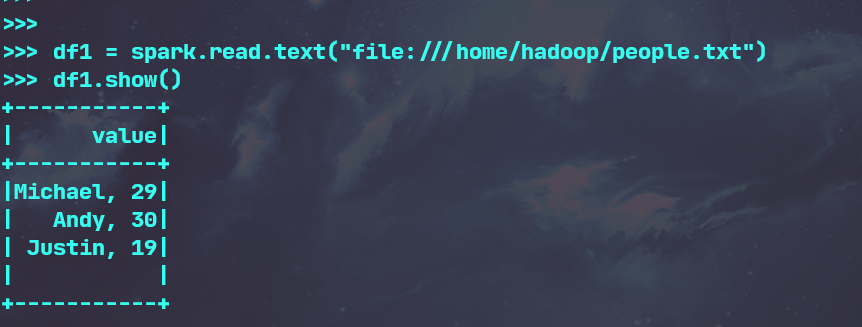

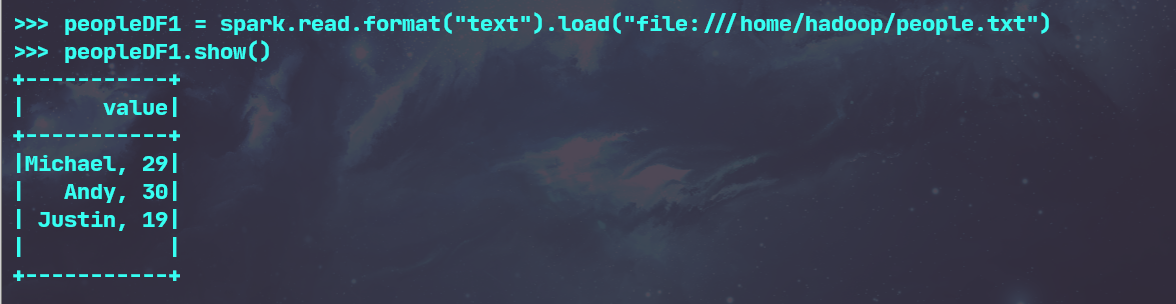

- spark.read.text(url)

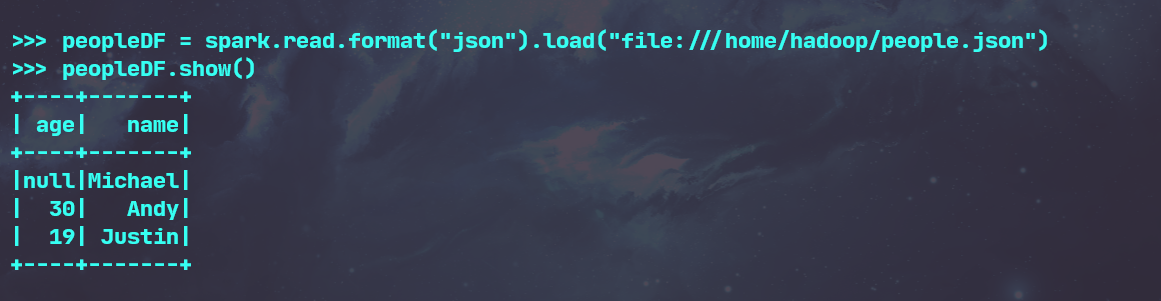

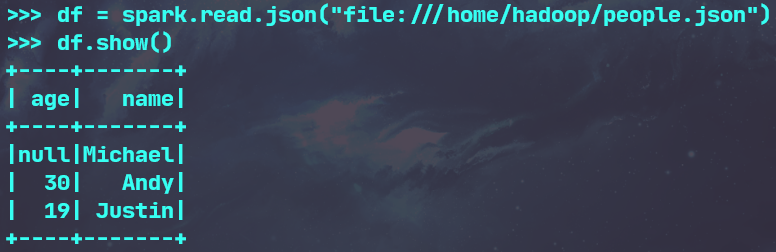

- spark.read.json(url) 注意从不同文件类型生成DataFrame的区别。

- spark.read.format("text").load("people.txt")

- spark.read.format("json").load("people.json")

4. PySpark-DataFrame各种常用操作

- 打印数据 df.show()默认打印前20条数据

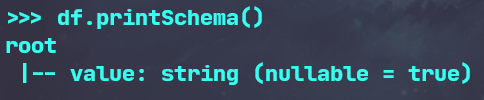

- 打印概要 df.printSchema()

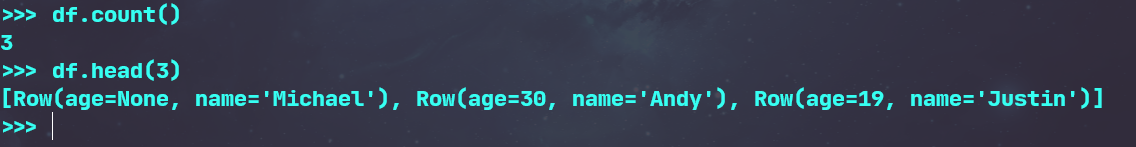

- 查询总行数 df.count()

- df.head(3) #list类型,list中每个元素是Row类

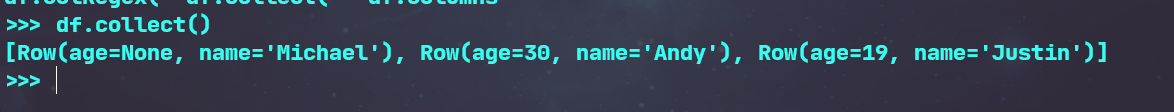

- 输出全部行 df.collect() #list类型,list中每个元素是Row类

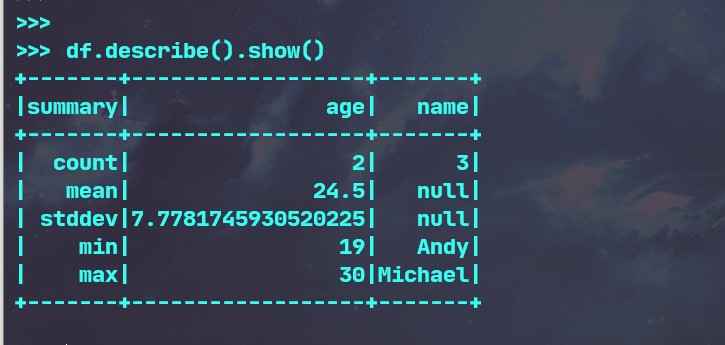

- 查询概况 df.describe().show()

- 取列 df[‘name’], df.name, df[1]

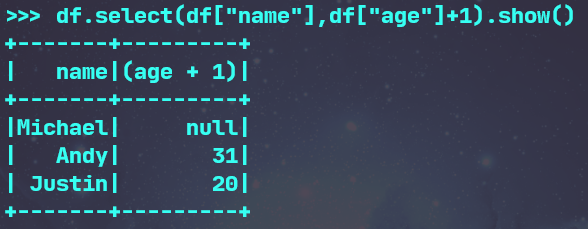

- 选择 df.select() 每个人的年龄+1

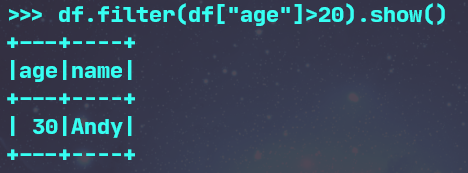

- 筛选 df.filter() 20岁以上的人员信息

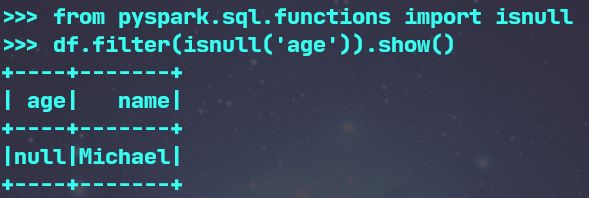

- 筛选年龄为空的人员信息

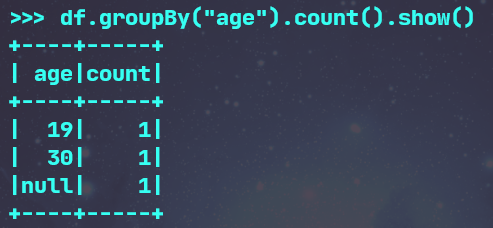

- 分组df.groupBy() 统计每个年龄的人数

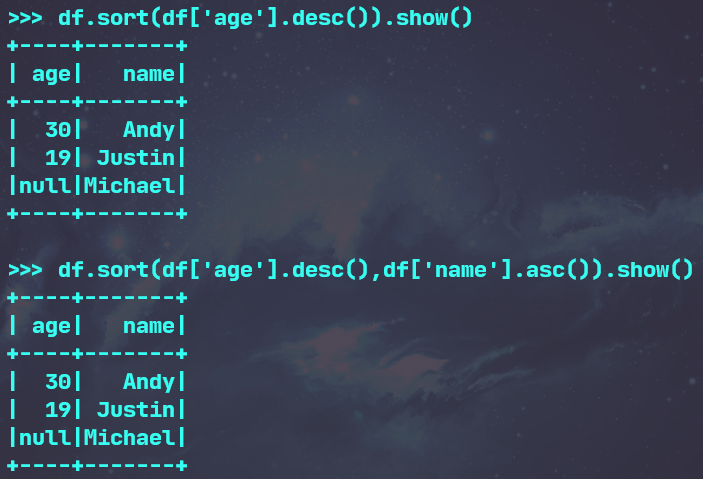

- 排序df.sortBy() 按年龄进行排序

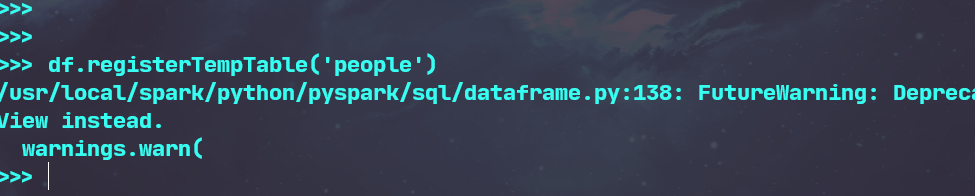

- 创建临时表虚拟表 df.registerTempTable('people')

- spark.sql执行SQL语句 spark.sql('select name from people').show()

5. Pyspark中DataFrame与pandas中DataFrame

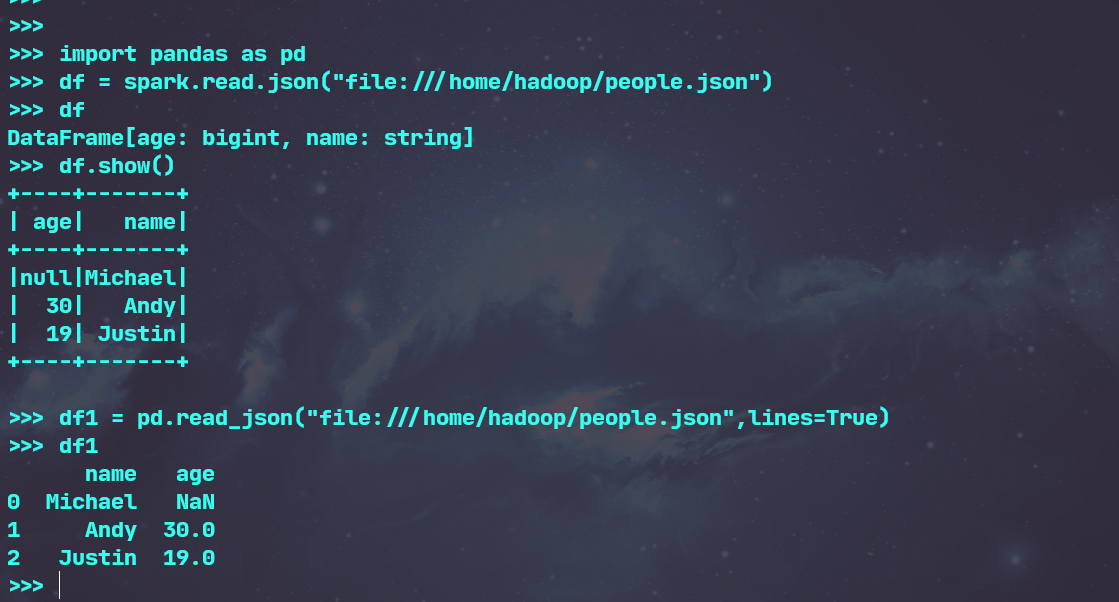

- 分别从文件创建DataFrame

- 比较两者的异同

- pandas中DataFrame创建出来的DataFrame有index索引,而Pyspark中DataFrame创建出来的没有。

- 行列结构不同,pyspark中用的是Pyspark.sql.Row和Pyspark.sql.Column,而pandas中用的是Pandas.Series

- spark中rdd是不可变得,因此dataFrame也是不可变的。而pandas中是可变得

- pandas没有树结构输出,而spark中有

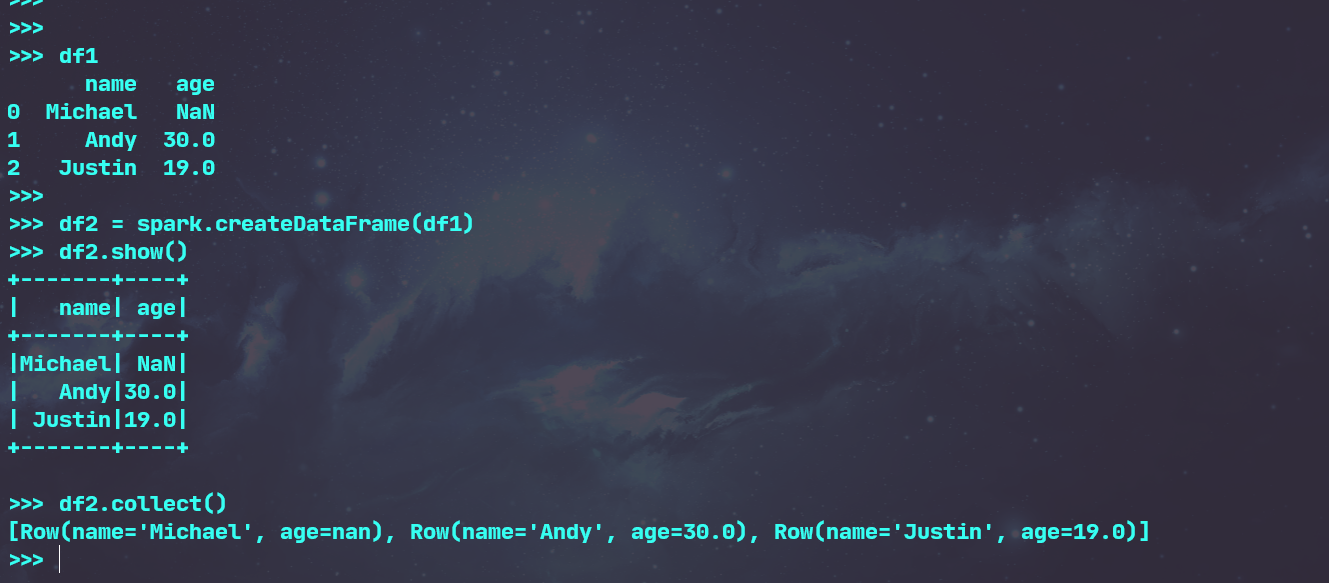

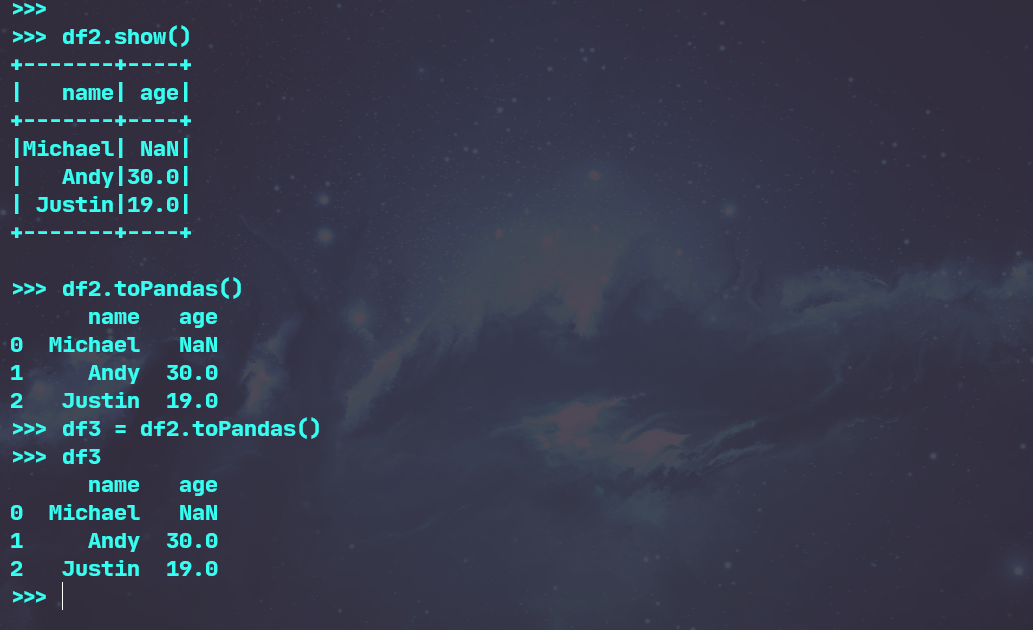

pandas中DataFrame转换为Pyspark中DataFrame

Pyspark中DataFrame转换为pandas中DataFrame

6.RDD与Dataframe

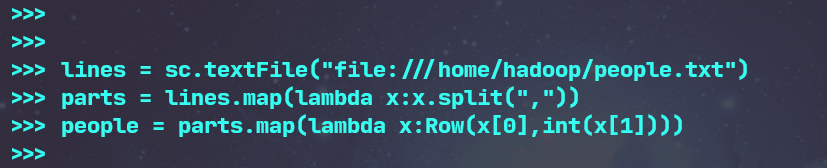

6.1 利用反射机制推断RDD模式

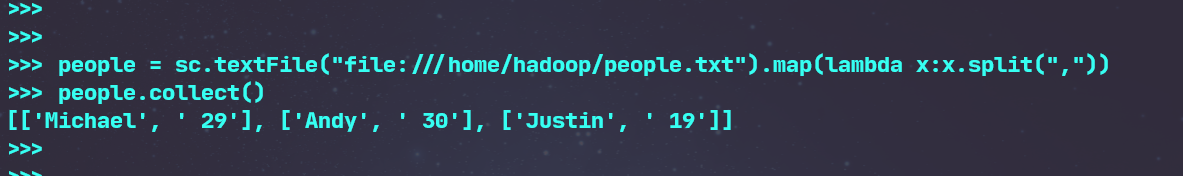

- 创建RDD sc.textFile(url).map(),读文件,分割数据项

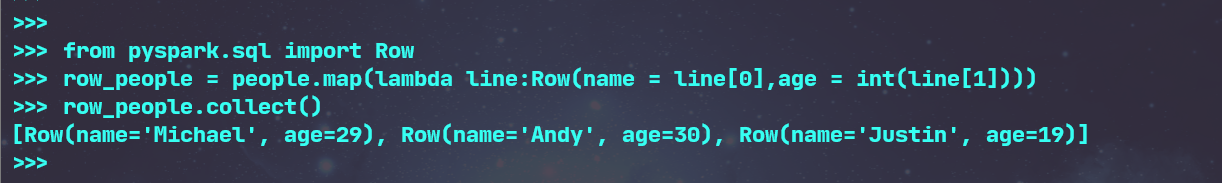

- 每个RDD元素转换成 Row

- 由Row-RDD转换到DataFrame

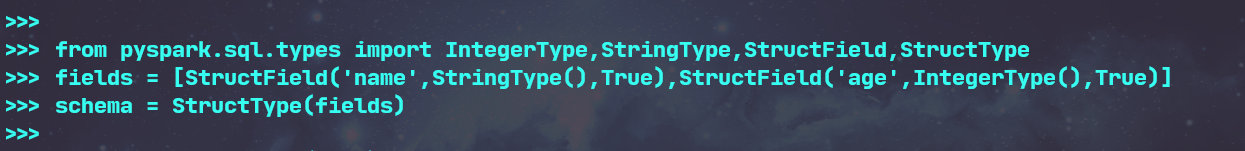

6.2 使用编程方式定义RDD模式

- 下面生成“表头”

- 下面生成“表中的记录”

- 下面把“表头”和“表中的记录”拼装在一起

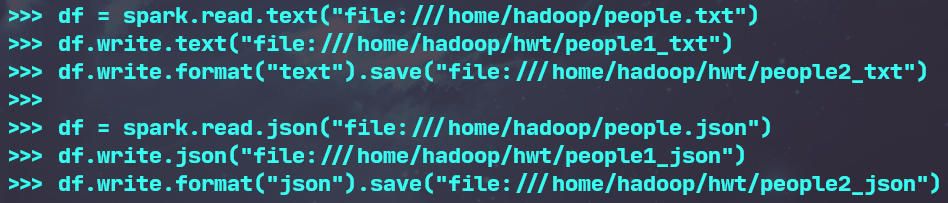

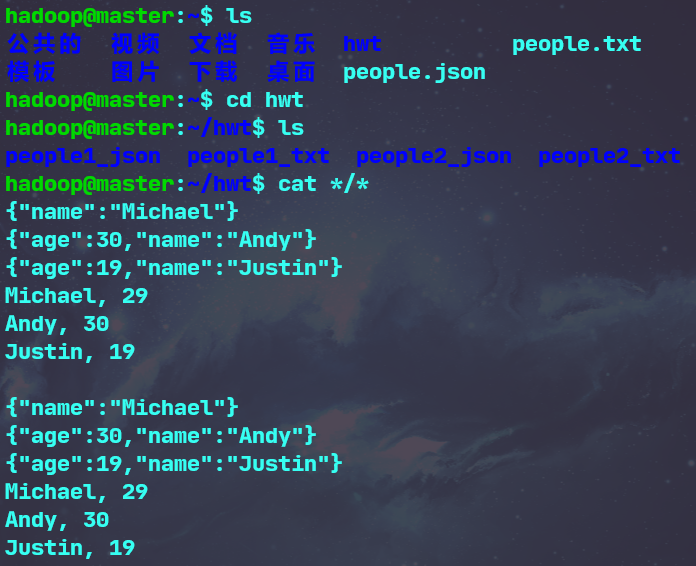

7.DataFrame的保存

- df.write.text(dir)

- df.write.json(dri)

- df.write.format("text").save(dir)

- df.write.format("json").save(dir)

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· Manus爆火,是硬核还是营销?

· 终于写完轮子一部分:tcp代理 了,记录一下

· 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

· 单元测试从入门到精通