sklearn中调用集成学习算法

1、集成学习是指对于同一个基础数据集使用不同的机器学习算法进行训练,最后结合不同的算法给出的意见进行决策,这个方法兼顾了许多算法的"意见",比较全面,因此在机器学习领域也使用地非常广泛。生活中其实也普遍存在集成学习的方法,比如买东西找不同的人进行推荐,病情诊断进行多专家会诊等,考虑各方面的意见进行最终的综合的决策,这样得到的结果可能会更加的全面和准确。另外,sklearn中也提供了集成学习的接口voting classifier。

sklearn中具体调用集成学习方法的具体代码如下:

#使用集成学习的方法进行数据训练和预测

#1-1导入原始基础数据集并且进行数据的预处理

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets

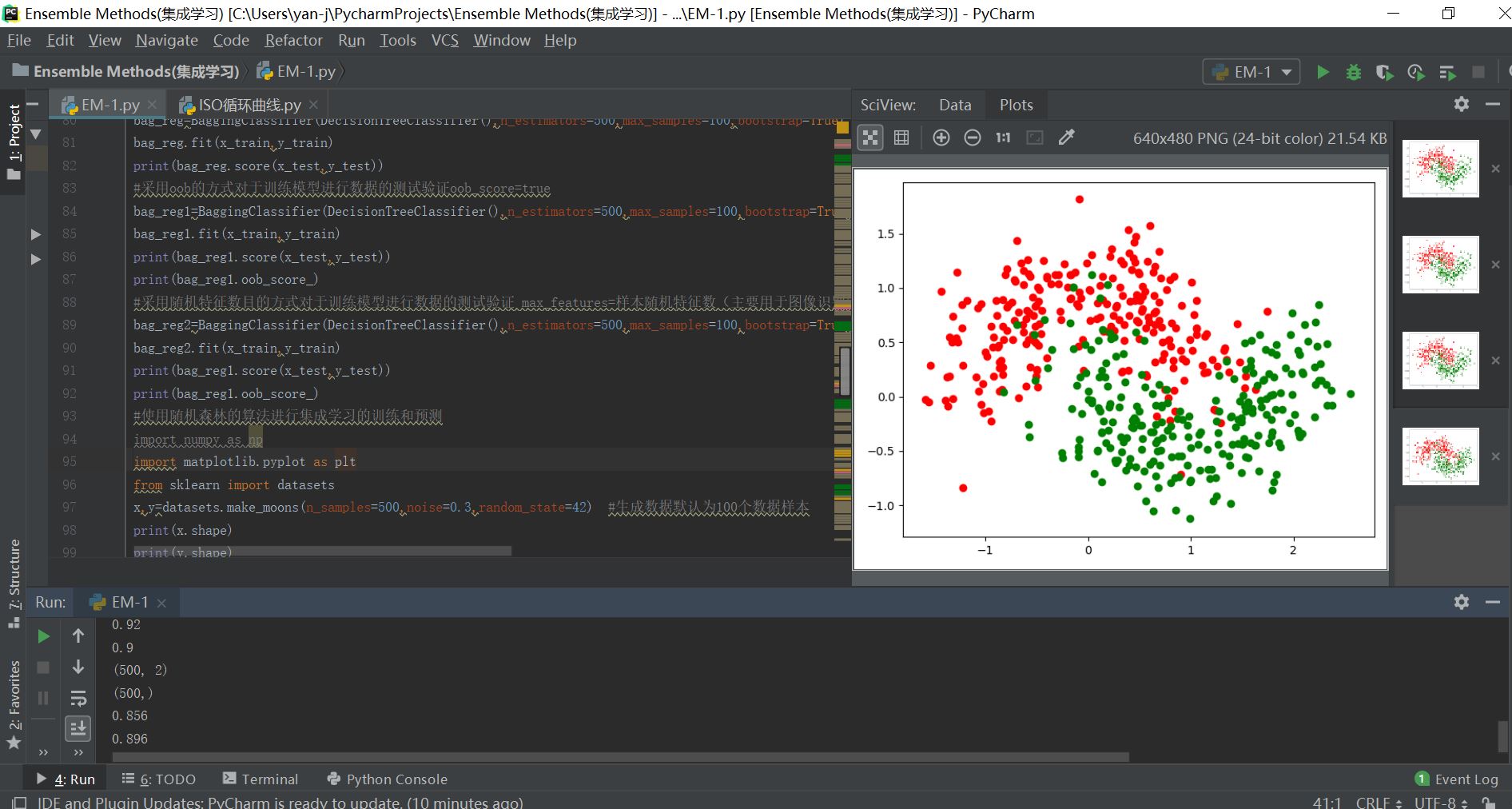

x,y=datasets.make_moons(n_samples=500,noise=0.3,random_state=42) #生成数据默认为100个数据样本

print(x.shape)

print(y.shape)

plt.figure()

plt.scatter(x[y==0,0],x[y==0,1],color="r")

plt.scatter(x[y==1,0],x[y==1,1],color="g")

plt.show()

from sklearn.model_selection import train_test_split

x_train,x_test,y_train,y_test=train_test_split(x,y,random_state=42)

#导入sklearn中的不同机器学习算法

#1逻辑回归算法

from sklearn.linear_model import LogisticRegression

log_reg=LogisticRegression()

log_reg.fit(x_train,y_train)

print(log_reg.score(x_test,y_test))

#2支撑向量机SVM算法

from sklearn.svm import SVC

svc_reg=SVC()

svc_reg.fit(x_train,y_train)

print(svc_reg.score(x_test,y_test))

#KNN算法

from sklearn.neighbors import KNeighborsClassifier

knn_reg=KNeighborsClassifier(n_neighbors=3)

knn_reg.fit(x_train,y_train)

print(knn_reg.score(x_test,y_test))

#决策树算法

from sklearn.tree import DecisionTreeClassifier

tree_reg=DecisionTreeClassifier()

tree_reg.fit(x_train ,y_train)

print(tree_reg.score(x_test,y_test))

y_predict1=log_reg.predict(x_test)

y_predict2=knn_reg.predict(x_test)

y_predict3=svc_reg.predict(x_test)

y_predict4=tree_reg.predict(x_test)

y_predict=np.array(y_predict1+y_predict2+y_predict3+y_predict4>=3,dtype="int") #自己简单采用集成学习的方法来进行相应的预测

from sklearn.metrics import accuracy_score

score=accuracy_score(y_predict,y_test)

print(score)

#使用sklearn中的集成学习接口进行相应的训练和预测—hard voting是投票时少数服从多数的原则(可以先把每个算法调到最好的结果,然后再用集成学习的算法进行预测)

from sklearn.ensemble import VotingClassifier

vote_reg=VotingClassifier(estimators=[

("log_cla",LogisticRegression()),

("svm_cla",SVC()),

("knn",KNeighborsClassifier()),

("tree",DecisionTreeClassifier(random_state=666))

],voting="hard")

vote_reg.fit(x_train,y_train)

print(vote_reg.score(x_test,y_test))

#使用sklearn中的集成学习接口进行相应的训练和预测—soft voting是投票时不同算法不同权重的原则(可以先把每个算法调到最好的结果,然后再用集成学习的算法进行预测)

from sklearn.ensemble import VotingClassifier

vote_reg1=VotingClassifier(estimators=[

("log_cla",LogisticRegression()),

("svm_cla",SVC(probability=True)), #SVC算法本来是计算不了概率的,但是经过一定的改进便可以计算概率,需要使得probability=true

("knn",KNeighborsClassifier()),

("tree",DecisionTreeClassifier(random_state=666))

],voting="soft")

vote_reg1.fit(x_train,y_train)

print(vote_reg1.score(x_test,y_test))

#采用有放回bagging和无放回pasting两种不同的方式来进行集成学习的训练(bootstrap决定有无放回,true代表有放回)

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets

x,y=datasets.make_moons(n_samples=500,noise=0.3,random_state=42) #生成数据默认为100个数据样本

print(x.shape)

print(y.shape)

plt.figure()

plt.scatter(x[y==0,0],x[y==0,1],color="r")

plt.scatter(x[y==1,0],x[y==1,1],color="g")

plt.show()

from sklearn.model_selection import train_test_split

x_train,x_test,y_train,y_test=train_test_split(x,y,random_state=42)

#使用bagging的方式进行集成学习

from sklearn.tree import DecisionTreeClassifier

from sklearn.ensemble import BaggingClassifier

bag_reg=BaggingClassifier(DecisionTreeClassifier(),n_estimators=500,max_samples=100,bootstrap=True)

bag_reg.fit(x_train,y_train)

print(bag_reg.score(x_test,y_test))

#采用oob的方式对于训练模型进行数据的测试验证oob_score=true

bag_reg1=BaggingClassifier(DecisionTreeClassifier(),n_estimators=500,max_samples=100,bootstrap=True,oob_score=True,n_jobs=-1)

bag_reg1.fit(x_train,y_train)

print(bag_reg1.score(x_test,y_test))

print(bag_reg1.oob_score_)

#采用随机特征数目的方式对于训练模型进行数据的测试验证 max_features=样本随机特征数(主要用于图像识别领域数据样本特征比较多的数据集)

bag_reg2=BaggingClassifier(DecisionTreeClassifier(),n_estimators=500,max_samples=100,bootstrap=True,oob_score=True,n_jobs=-1,max_features=1,bootstrap_features=True)

bag_reg2.fit(x_train,y_train)

print(bag_reg1.score(x_test,y_test))

print(bag_reg1.oob_score_)

#使用随机森林的算法进行集成学习的训练和预测

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets

x,y=datasets.make_moons(n_samples=500,noise=0.3,random_state=42) #生成数据默认为100个数据样本

print(x.shape)

print(y.shape)

plt.figure()

plt.scatter(x[y==0,0],x[y==0,1],color="r")

plt.scatter(x[y==1,0],x[y==1,1],color="g")

plt.show()

from sklearn.model_selection import train_test_split

x_train,x_test,y_train,y_test=train_test_split(x,y,random_state=42)

from sklearn.ensemble import RandomForestClassifier

rf1=RandomForestClassifier(n_estimators=500,random_state=666,oob_score=True,n_jobs=-1) #利用随机森林的方法用取不到的数据进行相应的训练

rf1.fit(x,y)

print(rf1.oob_score_)

rf1=RandomForestClassifier(n_estimators=500,random_state=666,max_leaf_nodes=16,oob_score=True,n_jobs=-1)

rf1.fit(x,y)

print(rf1.oob_score_)

#使用极其随机森林的算法进行集成学习的训练和预测(extra tree是指特征随机,并且节点阈值也随机,使得决策树之间差异更大,增加了随机性,降低了过拟合,不过也增加了一定的偏差)

from sklearn.ensemble import ExtraTreesClassifier

et=ExtraTreesClassifier(n_estimators=500,n_jobs=-1,bootstrap=True,oob_score=True)

et.fit(x,y)

print(et.oob_score_)

###利用集成学习解决回归问题

from sklearn.ensemble import RandomForestRegressor

from sklearn.ensemble import ExtraTreesRegressor

from sklearn.ensemble import BaggingRegressor

#回归问题和分类问题是一致的,超参数也是统一的,使用参照以上分类算法,只不过其输出结果是一个数值而非类别

#集成学习的第二种类:Boosting集成多个模型,模型之间是用关系的,它们均在增强整体的效果,主要有Ada Boosting 和Gradient Boosting

#第一种boosting的方式Ada Boosting方式

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets

x,y=datasets.make_moons(n_samples=500,noise=0.3,random_state=666) #生成数据默认为100个数据样本

print(x.shape)

print(y.shape)

plt.figure()

plt.scatter(x[y==0,0],x[y==0,1],color="r")

plt.scatter(x[y==1,0],x[y==1,1],color="g")

plt.show()

from sklearn.model_selection import train_test_split

x_train,x_test,y_train,y_test=train_test_split(x,y,random_state=666)

from sklearn.ensemble import AdaBoostClassifier

from sklearn.tree import DecisionTreeClassifier

ada_boost=AdaBoostClassifier(DecisionTreeClassifier(max_depth=2,min_samples_leaf=10,max_leaf_nodes=20),n_estimators=1000,random_state=666)

ada_boost.fit(x_train,y_train)

print(ada_boost.score(x_test,y_test))

#第二种boosting方式:Gradient Boosting,利用特定的机器学习算法对于数据进行训练和预测,然后将模型误差再进行训练,然后再对误差的误差训练,依次叠加,最终得到的训练结果就是最终的结果

from sklearn.ensemble import GradientBoostingClassifier

gb_boost=GradientBoostingClassifier(max_depth=5,n_estimators=3000)

gb_boost.fit(x_train,y_train)

print(gb_boost.score(x_test,y_test))

#第三种集成学习的思路stacking集成学习的方法:多模型多层次的模型融合集成学习方法

最终的运行结果如下所示: