Hadoop配置

Hadoop的配置

前提是配置好jdk

关闭防火墙

systemctl stop firewalld.service

配置ssh无密码访问

之前的有问题,用了这个就行

sudo apt-get install openssh-server

Generate SSH key & give location to store.

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

append generated key to authorized_keys inside /.ssh

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

modify permissions of authorized_keys.

chmod 0600 ~/.ssh/authorized_keys

verify by ssh into localhost.

ssh localhost

Optional: rm ~/id_rsa.pub

cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

ssh-keygen -t dsa # 会有提示,都按回车就可以

cat id_dsa.pub >> authorized_keys # 加入授权

chmod 600 ./authorized_keys # 修改文件权限,如果不改,无法通过,原因好像是cent os的权限验证比较严格

在root用户下修改/etc/ssh/sshd_config文件(取消以下三个变量的注释)

vim /etc/ssh/sshd_config

RSAAuthentication yes

PubkeyAuthentication yes

AuthorizedKeysFile .ssh/authorized_keys

重启sshd服务

service sshd restart

下载合适版本的Hadoop后,解压到/usr/local

tar -zxvf xxxx

修改Hadoop的环境变量

vim /etc/profile

添加以下内容

export HADOOP_HOME=/usr/local/hadoop-x.x

export PATH=$PATH:$HADOOP_HOME/bin

使配置文件生效

source /etc/profile

修改Hadoop配置文件

cd /usr/local/hadoop-2.9.2/etc/hadoop

| 配置文件 | 修改 |

|---|---|

| hadoop-env.sh | JAVA_HOME |

| hdfs-site.xml | ip |

| yarn-site.xml | ip |

| mapred-site.xml | |

| core-site.xml | ip |

hadoop-env.sh

export JAVA_HOME=/opt/jdk1.8.0_45

core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<!-- 这里填的是你自己的ip,端口默认-->

<value>hdfs://192.168.43.154:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<!-- 这里填的是你自定义的hadoop工作的目录,端口默认-->

<value>/usr/local/hadoop-2.9.2/tmp</value>

</property>

<property>

<name>hadoop.native.lib</name>

<value>false</value>

<description>Should native hadoop libraries, if present, be used.

</description>

</property>

</configuration>

yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.hostname</name>

<!-- 自己的ip端口默认 -->

<value>192.168.43.154</value>

</property>

<!-- reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>20480</value>

</property>

</configuration>

hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.secondary.http.address</name>

<!--这里是你自己的ip,端口默认-->

<value>192.168.43.154:50090</value>

</property>

</configuration>

mapred-site.xml

cp mapred-site.xml.template ./mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

初始化:

bin/hdfs namenode -format

启动:

cd $HADOOP_HOME

./sbin/start-all.sh

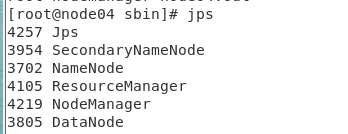

最后结果:

关闭:

./sbin/stop-all.sh

浙公网安备 33010602011771号

浙公网安备 33010602011771号