爬虫 数据处理 pandas数据处理

pandas数据处理

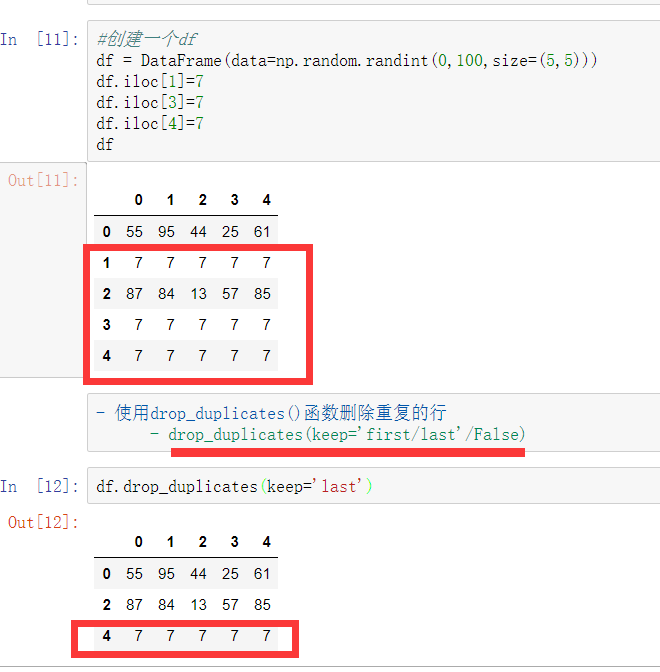

使用duplicated()函数检测重复的行,返回元素为布尔类型的Series对象,每个元素对应一行,如果该行不是第一次出现,则元素为True

- keep参数:指定保留哪一重复的行数据

映射

1) replace()函数:替换元素

DataFrame替换操作

- 单值替换

- 普通替换: 替换所有符合要求的元素:to_replace=15,value='e'

- 按列指定单值替换: to_replace={列标签:替换值} value='value'

- 多值替换

- 列表替换: to_replace=[] value=[]

- 字典替换(推荐) to_replace={to_replace:value,to_replace:value}

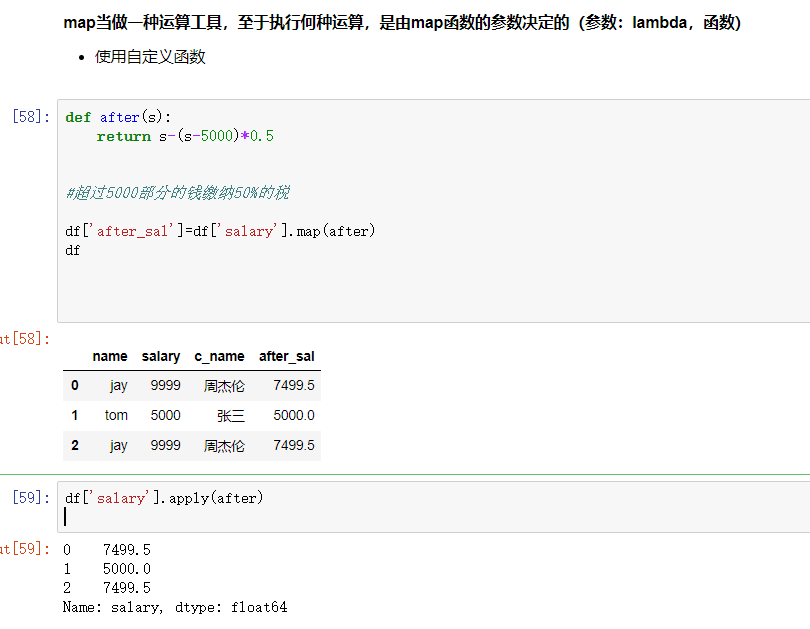

map()函数:新建一列 , map函数并不是df的方法,而是series的方法

- map()可以映射新一列数据

- map()中可以使用lambd表达式

-

map()中可以使用方法,可以是自定义的方法

eg:map({to_replace:value})

- 注意 map()中不能使用sum之类的函数,for循环

注意:并不是任何形式的函数都可以作为map的参数。只有当一个函数具有一个参数且有返回值,那么该函数才可以作为map的参数。

使用聚合操作对数据异常值检测和过滤

使用df.std()函数可以求得DataFrame对象每一列的标准差

数据清洗- 清洗空值

- dropna fillna isnull notnull any all

- 清洗重复值

- drop_duplicates(keep)

- 清洗异常值

- 异常值监测的结果(布尔值),作为清洗的过滤的条件

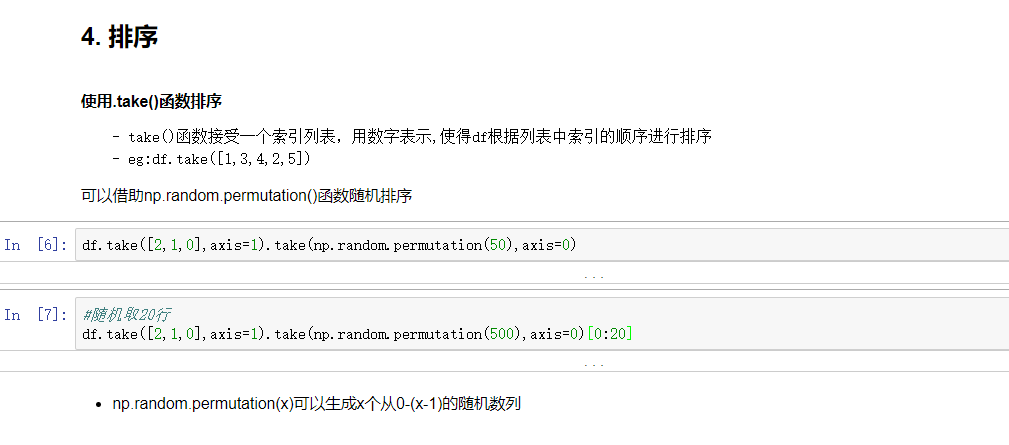

随机抽样

当DataFrame规模足够大时,直接使用np.random.permutation(x)函数,就配合take()函数实现随机抽样

数据分类处理【重点】

数据聚合是数据处理的最后一步,通常是要使每一个数组生成一个单一的数值。

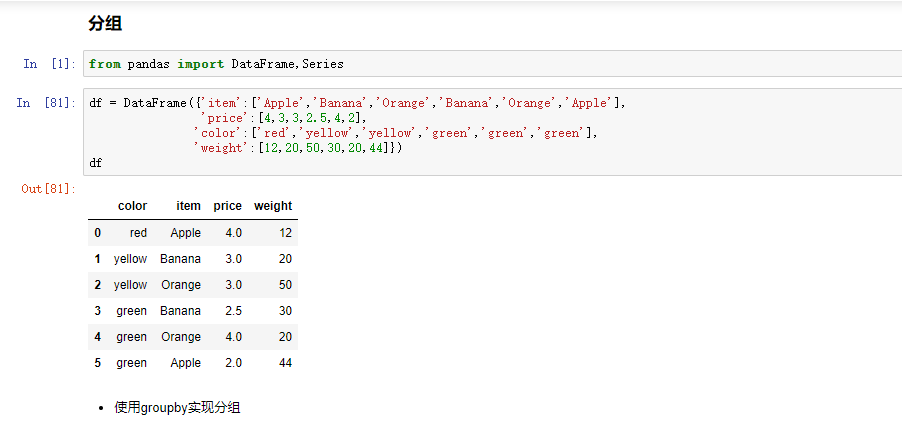

数据分类处理:

- 分组:先把数据分为几组

- 用函数处理:为不同组的数据应用不同的函数以转换数据

- 合并:把不同组得到的结果合并起来

数据分类处理的核心:

- groupby()函数

- groups属性查看分组情况

- eg: df.groupby(by='item').groups

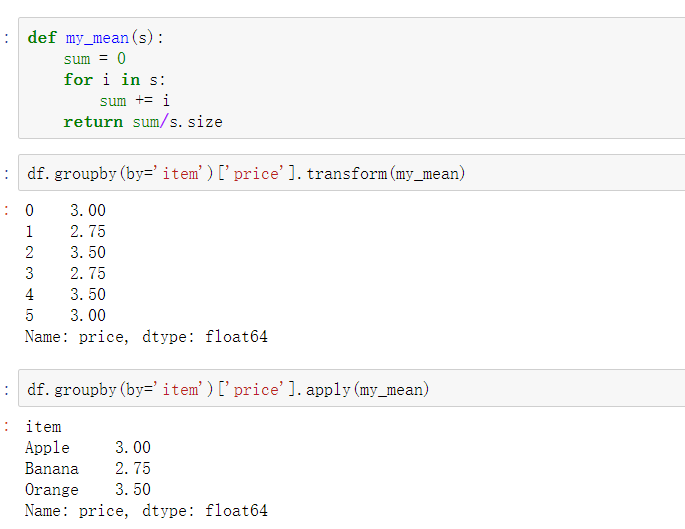

高级数据聚合

使用groupby分组后,也可以使用transform和apply提供自定义函数实现更多的运算

- df.groupby('item')['price'].sum() <==> df.groupby('item')['price'].apply(sum)

- transform和apply都会进行运算,在transform或者apply中传入函数即可

- transform和apply也可以传入一个lambda表达式