贝叶斯推断基础

贝叶斯方法提出了一个概率框架来描述如何将新的观察结果整合到决策过程中。传统的贝叶斯推断的二进制算术结构中,后验概率的计算需要大量的乘、除、加。

先验概率(由历史求因):根据以往经验和分析得到的概率,观测数据前某一不确定量的先验概率分布,通常指模型的参数θ对应的P(θ)

后验概率(知果求因):一个随机事件或者一个不确定事件的后验概率是在考虑和给出相关证据或数据后所得到的条件概率。这个概率需要观测数据才能得到,对一个神经网络建模需要基于给定的数据集才能得到网络参数θ。后验概率表示为P(θ|X)。

似然函数(由因求果):一种关于统计模型参数的函数。给定输出x时,参数θ的似然函数L(θ|x)等于给定参数θ后变量X的概率。L(θ|x)=P(X=x|θ)。

频率派和贝叶斯派的观点争议在于:频率派参数是客观存在的,频率派关心极大似然函数,只要参数求出来了,给定自变量X,Y也就固定了,极大似然估计为θMLE=argmaxθP(X|θ)。

相反地,贝叶斯派认为参数是随机的,当给定输入X后,不能用一个确定的Y表示输出结果,必须用一个概率的方式表示出来。E(Y|X)=∫P(y|x,θ)P(θ|X)dθ。(X,θ,Y分别为输入数据,模型参数,输出)。

如何求后验概率:P(θ|X)=P(X|θ)P(θ)P(X)=P(X|θ)P(θ)∫P(X|θ)P(θ)dθ

实际上很难确定解析解,因此需要引入最大后验概率求法:θMAP=argmaxθP(X|θ)P(θ).

二分类贝叶斯机器(Bayesian Machine)

给定类别V1,V2,有Pr(V1)+pR(V2)=1,Pr(V1),Pr(V2)为后验概率。假设有M个特征证据,E1,E2,⋯,EM。对给定集合的特征,E1,E2,⋯,EM满足条件独立,类别V1的后验概率为:Pr(V1|E1,E2,⋯,EK)=Pr(V1)∏Kj=1Pr(Ej|V1)Pr(V1)∏Kj=1Pr(Ej|V1)+Pr(V2)∏Kj=1Pr(Ej|V2)。

双权重加权比的SC实现

令Pr(Vi)=ωi和Pr(Ej|Vi)=θij,其中i=1,2和j=1,2,⋯,K,类别V1关于两个权重ω1,ω2的加权比的后验概率为:z=ω1θ1ω1θ1+ω2θ2(ω1+ω2=1,θi=∏Kj=1θij),令θ∗1j=θ1jθ1j+θ2j,可以进步表示为z=ω1∏Kj=1θ∗1jω1∏Kj=1θ∗1j+(1−ω1)∏Kj=1(1−θ∗1j)。

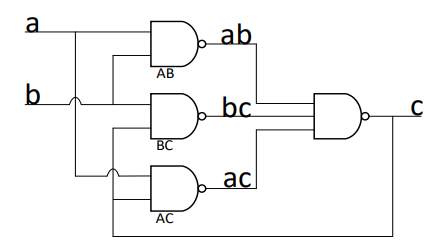

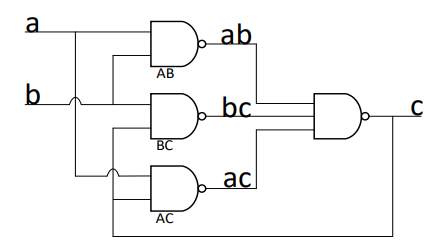

MULLER-C ELEMENT

Celement

Mulle-C Element通常由四个与非门组成,包含两个输入端和一个输出端。

C=(ab|bc|ac)

当a,b输入端均为0时,输出端将变化为0。当两者的输出为1时,输出端为1;其余情况,输出保持不变。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 提示词工程——AI应用必不可少的技术

· 地球OL攻略 —— 某应届生求职总结

· 字符编码:从基础到乱码解决

· SpringCloud带你走进微服务的世界