【论文阅读】Learning Spatial Regularization with Image-level Supervisions for Multi-label Image Classification

转载请注明出处:https://www.cnblogs.com/White-xzx/

原文地址:https://arxiv.org/abs/1702.05891

Caffe-code:https://github.com/zhufengx/SRN_multilabel

如有不准确或错误的地方,欢迎交流~

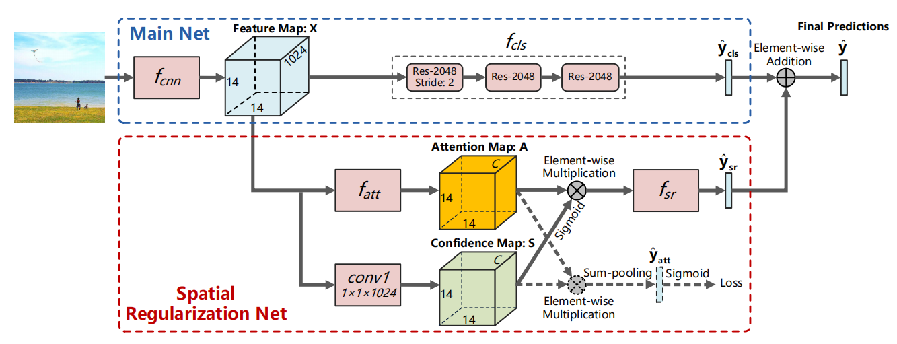

空间正则化网络(Spatial Regularization Network, SRN),学习所有标签间的注意力图(attention maps),并通过可学习卷积挖掘标签间的潜在关系,结合正则化分类结果和 ResNet-101 网络的分类结果,以提高图像分类表现。

【SRN的优势】

(1)挖掘图像多标签之间的语义和空间关联性,较大地提高精度;

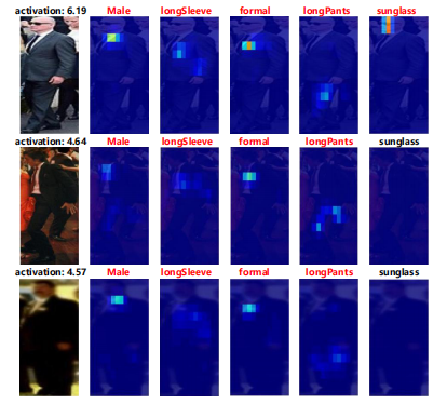

(2)当网络模型对具有空间相关标签的图片训练后,注意力机制自适应地关注图像的相关区域

(3)图像级标注,端到端训练

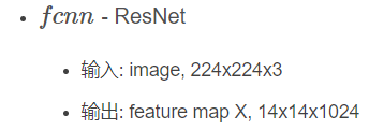

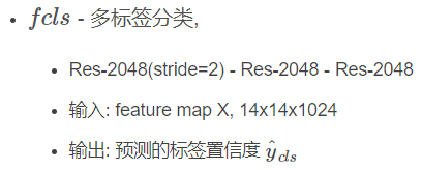

【SRN网络结构】

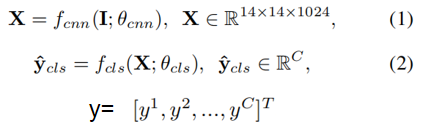

(1)Main Net:ResNet-101,针对各标签分别学习得到独立的分类器。“Res-2048” 表示具有2048输出的 ResNet 网络模块;

(2)SRN 采用ResNet-101的视觉特征作为输入,利用注意力机制学习得到标签间的正则空间关系;

(3)结合主网络和SRN的分类结果得到最终的分类置信度;

【Main Net】

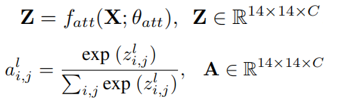

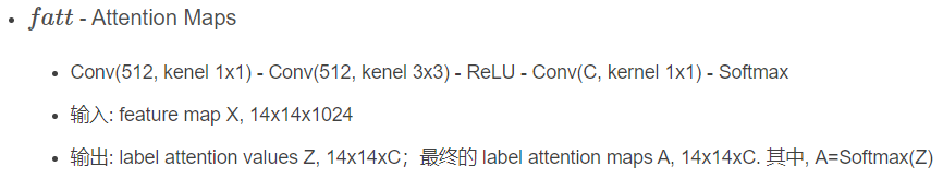

【SRN:注意力机制 fatt(·)】

当图像存在某个标签时,更多的注意力应该放在相关的区域,标签注意力图编码了标签对应的丰富空间信息。l被标记则l相关区域的注意力值应该更高

注意力图能用于产生更鲁棒的空间正则信息,但每个标签的注意力图总是和为1,可能会突出错误位置,造成错误的空间正则信息,论文提出使用加权注意力图U,U解码了标签局部和全局的置信分数(confidence)。

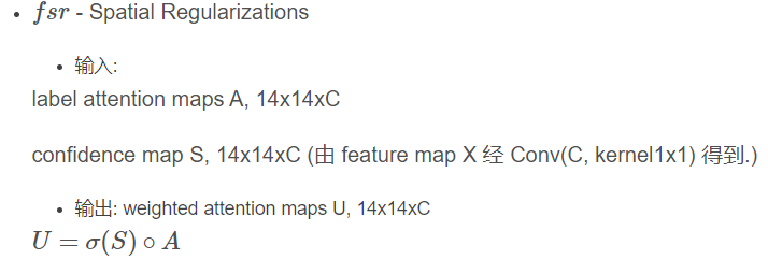

【SRN:fsr(·)结构】

conv2、conv3多通道,512输出,捕捉多标签的语义关系;

conv4单通道,2048输出,4个kernel为一组缠绕1个相同的特征通道,不同kernel捕捉语义关联标签间的不同空间关系。

【Multiple Steps 分步训练】

![]()

分四个阶段: ①只训练主网络, 基于 ResNet,pretrained on ImageNet,fcnn 和 fcls;

②固定 fcnn 和 fcls, 训练 fatt;

③固定 fcnn, fcls和 fatt,训练 fsr;

④联合训练整个网络。

图像增强策略: ①resize为256×256

②裁剪4个角和中心区域,长宽在{256,224,192,168,128}中随机选取

③resize为224×224

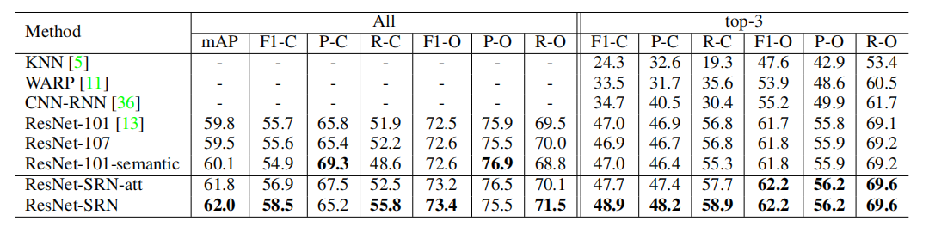

【实验结果】