ChatGPT最新综述!一文带你理清AI生成式内容、挑战与解决方案

随着ChatGPT等大型人工智能(AI)模型的广泛应用,AI生成式内容(AI-Generated Content, AIGC)引起了全球范围内的广泛关注,正引领着内容创作和知识表达的范式转变。AIGC利用生成式AI大模型,根据用户提供的提示,以更快的速度和更低的成本辅助或替代人类创建大规模、高质量、类似人类的内容。尽管AIGC最近取得了重大进展,但仍需解决来自安全、隐私、伦理和法律方面的挑战。西安交大研究团队推出的最新综述《A Survey on ChatGPT: AI-Generated Contents, Challenges, and Solutions》,为我们深入调研了AIGC范式的工作原理、安全和隐私威胁、最新解决方案以及未来挑战。具体而言,首先探讨了AIGC的使能技术、体系架构,并讨论了其工作模式和关键特性。接着,研究了AIGC安全和隐私威胁的分类,并强调了GPT和AIGC技术的伦理和社会影响。此外,回顾了用于可监管AIGC范式的最新AIGC水印技术,包括AIGC模型及其生成的内容。最后,指出了与AIGC相关的相关挑战和未来研究方向。

引用格式:Yuntao Wang and Yanghe Pan and Miao Yan and Zhou Su and Tom H. Luan, "A Survey on ChatGPT: AI-Generated Contents, Challenges, and Solutions", in IEEE Open Journal of the Computer Society, vol. 4, pp. 280-302, 2023, DOI:10.1109/OJCS.2023.3300321.

论文链接:https://arxiv.org/pdf/2305.18339.pdf or https://ieeexplore.ieee.org/document/10221755

1. 引言

人工智能生成式内容(AIGC)是指利用生成式人工智能算法,根据用户输入或需求来协助或替代人类以更快的速度和更低的成本创建丰富、个性化、高质量的内容,包括文本(如诗歌)、图像(如艺术品)、音频(如音乐)、视频(如动漫)、增强型训练样本,以及3D互动内容(如虚拟化身、资产和环境)。作为PGC(Professional Generated Content)和UGC(User Generated Content)等传统内容生成范式的补充,AIGC范式具有广泛的应用前景,可以自动、高效、低成本地生产大量高质量内容,这对于元宇宙和数字孪生等各种新兴应用至关重要。例如,在交互式元宇宙游戏Roblox中,AIGC可以为avatar生成个性化的皮肤和3D游戏场景,使得用户在沉浸式的虚拟空间中游戏、合作和社交。根据Gartner预测,到2025年全球约10%的数据将由生成型人工智能算法生成。

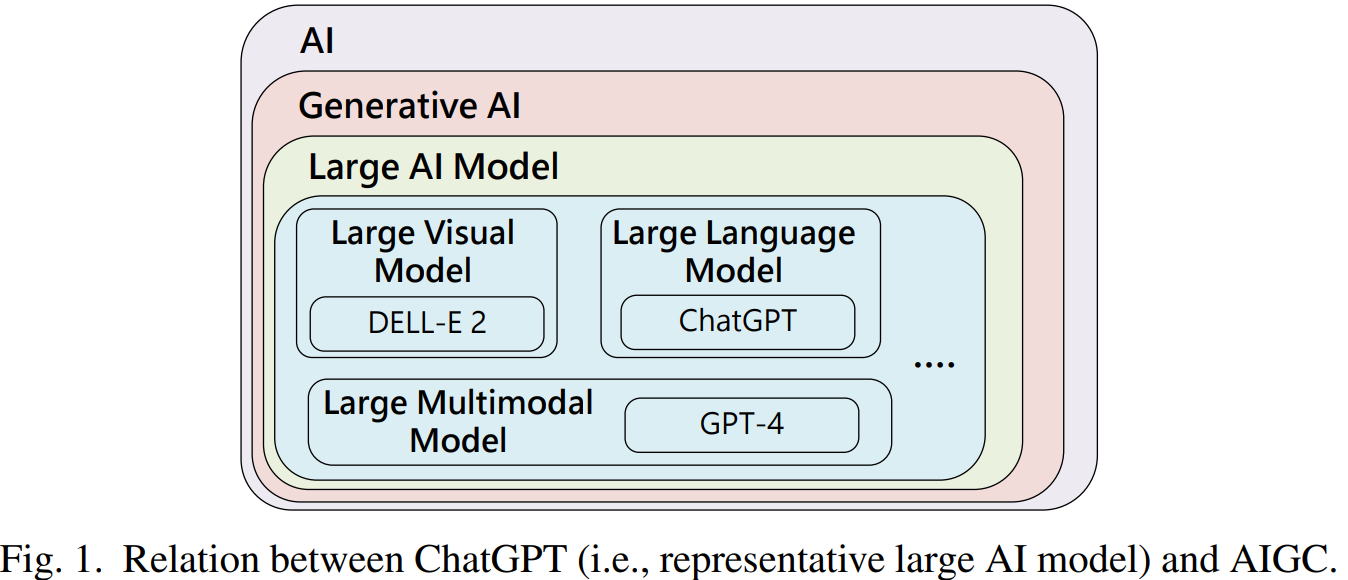

从技术角度看,AIGC通常包括两个阶段:(i)提取和理解用户意图信息;(ii)根据提取的意图生成所需内容。2022年11月,OpenAI发布了ChatGPT,这是一个多功能的语言模型,可以生成代码、编写故事、进行机器翻译、进行语义分析等。截至2023年1月,ChatGPT的日活用户达1300万。ChatGPT是GPT(Generative Pre-training Transformer)的一个变体,它是基于Transformer的大型语言模型(Large Language Model, LLM),可以理解人类语言并创建人类可读的文本(如故事和文章),如图1所示。随着ChatGPT及其后续版本GPT-4等LLM的最新进展,AIGC的能力得到了显著增强,能够以更高的准确性执行多模态任务等更复杂的任务,而这要归功于LLM提供的更好的意图提取能力。在技术进步和日益增长的需求推动下,AIGC引起了全球的关注,并在娱乐、广告、艺术和教育等各个领域展现出巨大的潜力,包括OpenAI、谷歌、微软、NVIDIA和百度在内的科技巨头已宣布进军AIGC并开发了自己的AIGC产品。

在AIGC时代,更大的数据集是“燃料”,更大的基础模型充当“引擎”,而无限的计算能力则起到了“加速器”的作用。ChatGPT是由GPT-3.5模型微调而来,其训练数据集由接近1万亿个词的大约45TB的语料集构成。它集成了自监督学习、强化学习和提示学习等多种人工智能技术。ChatGPT训练所需的计算能力约为每天3640 PetaFLOPs,相当于每秒计算10千万亿次,需要3640天来完成。在大数据、大模型和大计算力的工程化组合下,ChatGPT展示出了强大的涌现能力,可以学习新特征和更高级别的模式,并根据用户的多模态提示自动化创建有价值的内容。除了大规模训练数据和大算能力外,ChatGPT还集成了一系列新技术。例如,ChatGPT使用了思维链提示(CoT-prompting)技术[13],使预训练的LLM能够在少量数据和零样本学习环境下通过逐步推理来解释其推理过程。此外,它还集成了人类反馈增强学习(RLHF)来帮助ChatGPT更好地理解人类偏好,通过训练奖励模型和强化学习对LLM进行微调。此外,在计算机视觉领域,2022年创业公司Stability AI开发的Stable Diffusion和OpenAI开发的DALL-E 2已经取得了巨大的成功,可从复杂和多样化的文本描述中生成高分辨率的图像。

尽管AIGC前景光明,但安全和隐私问题对其广泛应用构成了重大阻碍。在AIGC服务的生命周期中,可能会出现一些安全漏洞、隐私泄露、信任问题和道德问题,这些问题可能源自普遍的数据收集,智能模型/数据盗窃,到大量的网络钓鱼邮件的分发。

- 1)安全漏洞。AIGC服务在其生命周期的每个阶段都面临着安全威胁。例如,在模型训练过程中,攻击者可能使用投毒或对抗性样本来降低模型性能,或发起后门攻击来操纵模型结果;在模型部署后,攻击者可能通过智能模型盗窃攻击窃取AIGC模型或其部分功能。由于大型AIGC模型如ChatGPT采用的策略比通用模型更复杂,可能会出现诸如越狱和提示注入等更多且全新的安全威胁。此外,生成式AI模型仍面临着透明度、鲁棒性和偏差/歧视等方面的技术限制。

- 2)隐私侵犯。 AIGC模型的成功在很大程度上取决于广泛的训练数据集,这些数据集不可避免地包含用户的敏感和私人信息。例如,ChatGPT与用户进行交互时,能够记住与对话相关的条目、用户输入、cookie和日志等。这为AIGC中的数据滥用和犯罪活动带来了新的可能性。根据最近的一项研究[24],对黑盒GPT-2模型,攻击者可以使用提示注入和公共文本特征从AI模型记忆中恢复最多67%的训练文本,包括个人名字、地址和电话号码。2023年3月,由于对隐私合规的担忧,意大利禁止使用ChatGPT[25]。

- 3)信任问题。 AIGC技术的快速发展使得创建和传播虚假信息和假证据,如深度伪造内容和假新闻,变得愈发容易。这导致了诸如AI欺诈、诽谤、身份盗窃和仿冒等新型犯罪活动的出现。例如,ChatGPT可以生成误导性和不道德的回应,恶意用户可利用其撰写无瑕疵文本的能力进行欺诈,复制语音模式进行冒充,以及开发恶意代码进行黑客攻击。这引发了建立可追溯和可监管AIGC服务的巨大需求,以确保生成式AI模型及其所产生的内容的可问责性。

- 4)道德影响。 作为一柄双刃剑,AIGC技术也对人类社会产生了负面影响,并可能被滥用来分发恶意软件、勒索软件和钓鱼邮件。例如,ChatGPT产生即时和令人信服的对话的能力可以使其更容易制作钓鱼邮件,诱骗收件人点击有害链接、下载恶意软件、或者泄露机密信息。此外,AIGC能促进课程作弊、艺术抄袭和学术论文欺诈,使此类不当行为更易实施并更难检测。

本文的贡献具体如下。首先,本文探讨了AIGC范例的工作原理,包括三层通用架构、使能技术、工作模式、关键特征和典型应用,同时讨论了AIGC在内容创作以及知识表示和使用方面所带来的范例转变。其次,本文从安全、隐私、信任和伦理四个视角全面研究了AIGC服务中现有或潜在的安全和隐私威胁,并调研了最先进的防御机制。再次,本文讨论了AIGC中的知识产权保护问题以其监管防护方案,并系统地审查了当前最新水印技术为AIGC模型和生成式内容提供产权保护方案,以及针对AIGC水印技术的安全威胁和相关对策。最后,我们从绿色的AIGC架构、可解释的AIGC模型、分布式和可扩展的AIGC算法、可信和可规管的AIGC服务、以及面向安全设计的AIGC范式等角度讨论了开放研究问题和未来研究方向。

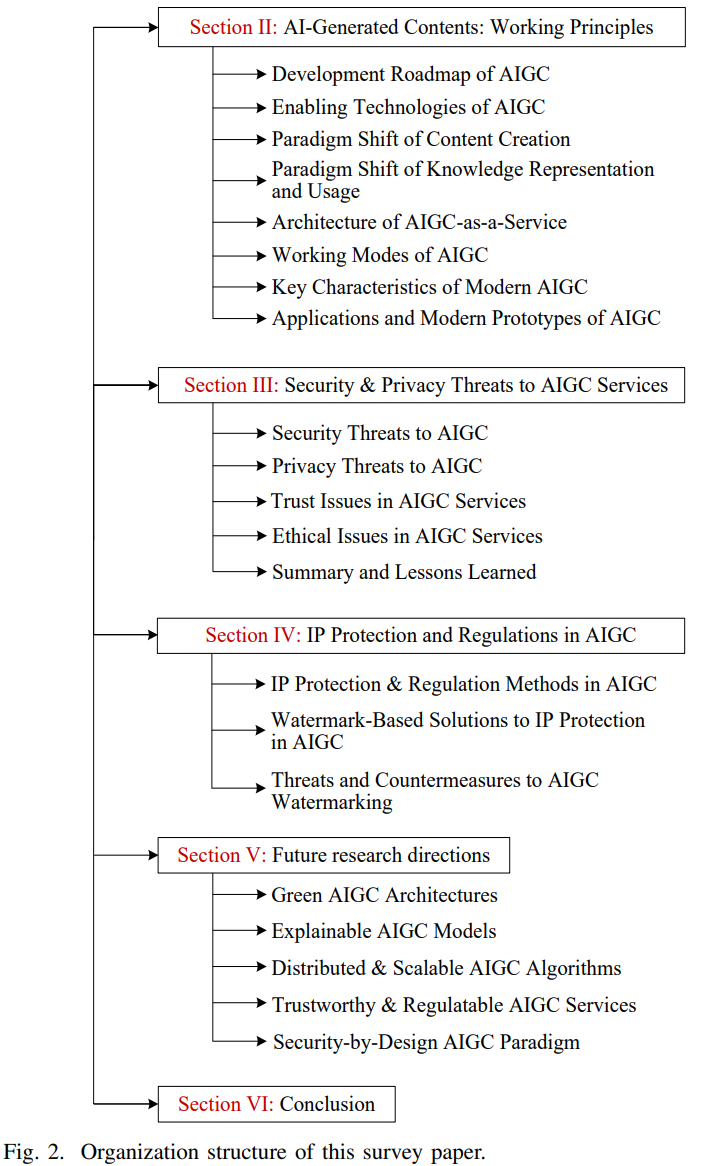

本文章节组织如下。在第二节,我们介绍了AIGC的工作原理。第三节讨论了AIGC中安全和隐私方面的分类和最新对策。第四节介绍了AIGC模型和内容的知识产权保护和监管方案。第五节探讨了未来研究方向。最后,在第六节中得出结论。本文的组织结构如图2所示。

2. AIGC工作原理

本节首先介绍AIGC的发展路线图和使能技术,然后讨论内容生成范式以及知识表示和使用的范式转变,接着,介绍AIGC的通用架构、工作模式、关键特征和典型应用。

2.1. AIGC发展脉络

- 萌芽阶段(20世纪50年代中期之前):1957年,希勒和艾萨克森发明了第一部计算机合成音乐Iliac Suite2。尽管取得了早期的成功,但由于成本高和商业化困难,AIGC在20世纪并没有取得进一步进展。随着深度学习的成功和算力的快速增长,学术和工业界对于AIGC的热情开始重燃。例如,在2007年,第一部由AI创作的小说《在路上》发布。在2012年,微软推出了一个完全自动的基于深度神经网络(DNN)的同声传译系统,用于从汉语到英语的自动语音识别和翻译。

- 发展阶段(2010年中期∼2022年):在此阶段,生成式AI算法出现并迅速发展,为大型模型训练奠定了基础。2014年,Goodfellow等人提出了生成式对抗网络(GAN),用于从现有数据生成图像[35]。2017年,微软的AI机器人小冰创作了世界首本诗集《阳光丧失了玻璃窗》。2017年,Vaswani等人提出了Transformer模型,用于具有并行训练能力的NLP任务。2019年,DeepMind发布了DVD-GAN模型,能够生成连续视频。2021年,OpenAI推出了DALL-E,支持从文本生成图像。

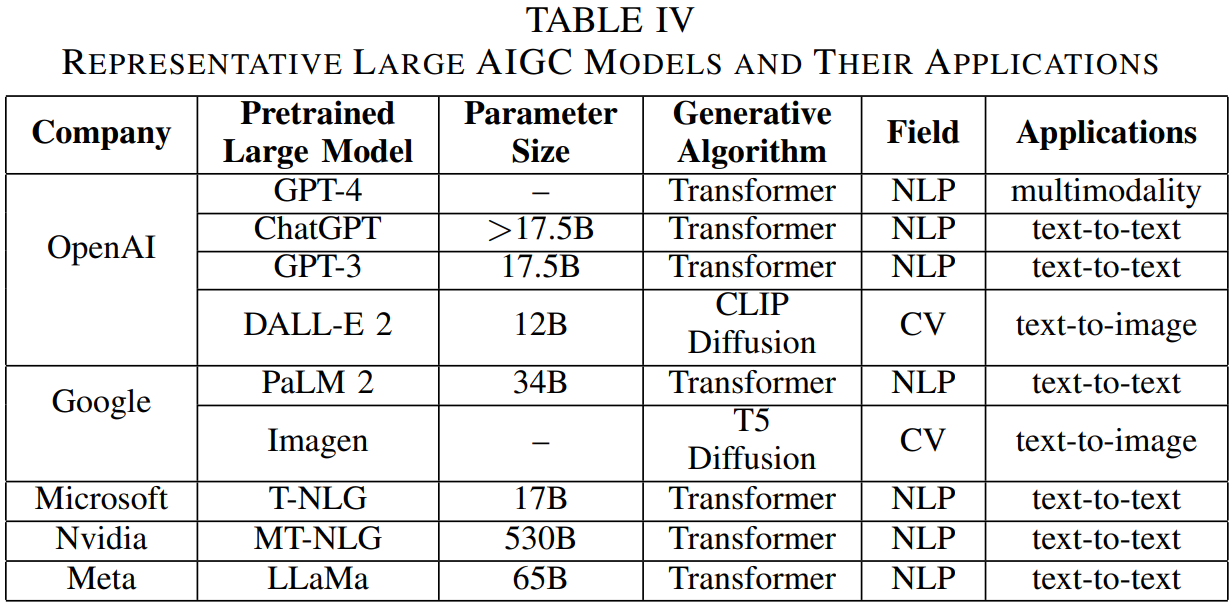

- 蓬勃发展阶段(2022至今):在此阶段,由于预训练AI大模型的出现,AIGC的能力得到了极大的增强,使其可以在大规模应用中得到实际应用。例如,在2022年,OpenAI推出了ChatGPT作为基于生成式预训练变换器(GPT)的通用语言模型,它可以执行各种复杂任务,如生成类似人类的回复和营销文案。2023年多模态版本GPT-4的发布进一步扩展了大型AI模型的能力。其他值得注意的大模型包括PaLM 2(34B)、StableLM(175B)、LLaMa(65B)、ERNIE-ViLG(10B)、Imagen、DALL-E 2等。随着AI大模型技术的不断发展,预计未来几年AIGC技术会被更广泛地应用和出现更多用途。

2.2. AIGC使能技术

生成式AI算法、预训练大模型和多模态技术等多种先进AI技术的融合汇聚,正引领着AIGC范式的蓬勃发展。

- 生成式AI算法:生成式AI算法是一类从大型数据集中学习模式然后产生新内容的AI算法。随着诸如Transformer和Diffusion模型等生成式AI算法的快速进展,AI模型可以学习在训练样本中的图案和数据的基础上生成逼真的图像、视频和文本,且无需人为干预。例如,Transformer模型使用Self-Attention机制根据输入数据的每个部分的重要性分配不同的权重。诸如BERT和ChatGPT等多种预训练模型都是基于Transformer。Diffusion扩散模型定义了一个扩散步骤的马尔科夫链,逐渐向数据添加随机噪声,然后学习逆扩散过程来从噪声中构造必要的数据样本。Stable Diffusion是一个潜在的文本到图像扩散模型,能够从文本描述中产生照片般逼真的图像。

- 预训练AI大模型:AI大模型是指任何具有大量参数的神经网络架构,它能够提供更好的表示学习,并在各种任务上实现更高的准确率。本质上,预训练大模型,如视觉大模型(LVM)和语言大模型(LLM),使得灵活、大规模和高质量的AIGC服务成为可能。例如,ChatGPT可以处理并学习大量的文本数据,以生成连贯而自然的文本输出,如文章、故事,甚至是诗歌。此外,ChatGPT还整合了一系列新技术,如CoT提示和RLHF,以提供更多的交互和个性化的对话。

- 多模态技术:多模态技术通过使预训练AI大模型具有多模态表示能力,从而实现文本、图像、语言和其他模态的高效融合,大大丰富了AI产生或处理的内容的多样性。例如,OpenAI设计的对比语言-图像预训练(CLIP)能够同时执行自然语言处理的理解和计算机视觉分析。CLIP使用互联网上超过40亿条文本-图像训练数据[11]。有了多模态技术的支持,预训练大模型已从早期的单一自然语言处理(NLP)或计算机视觉(CV)模型发展到了多模态和跨模态的AIGC模型。

2.3. 内容创作的范式转变

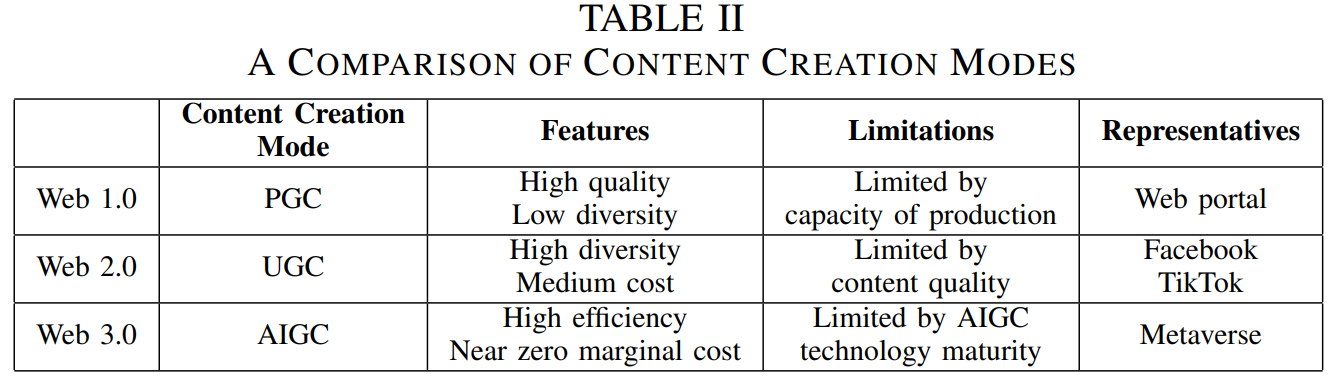

AIGC范式以大规模生产、高质量输出和低单位成本的显着优势,如表II所述,正在革新当前内容生成的格局。借助ChatGPT等预训练大模型和CLIP等多模态技术,AIGC范式已经成为一种强大的产生不同类型的多样化内容的工具,其效率和经济性达到了无所匹敌的水平。

- Web 1.0:互联网的发明带来了信息传播和复制零成本的可能性。在Web 1.0(个人电脑互联网阶段)时代,高质量内容的创作主要属于专业生成内容(PGC)范式[5],其中专业组织或个人是主要的内容生产者。然而,由于内容创作规模受限,该范式限制了用户可用和内容多样性。

- Web 2.0:随着Web 2.0(移动互联网阶段)的出现,用户成为内容创作的主导力量,导致了用户生成内容(UGC)范式的兴起。作为PGC范式的补充,用户在UGC范式下可以在各种平台上自由创造内容并分享[5]。代表性的UGC平台包括Facebook、新浪微博、TikTok等。

- Web 3.0:元宇宙被认为是Web 3.0的未来形态[5],而AIGC是在低成本情况下即时生成大量3D和沉浸式内容(例如个性化元宇宙场景)的关键技术。借助于大计算和大AI模型,AIGC可以自动生成或协助人类在短时间内产生大量高质量内容。传统的PGC和UGC范式在内容生产规模、质量和成本方面存在局限性,而AIGC可以有效地解决这些模式的缺点。

2.4. 知识表示和使用的范式转变

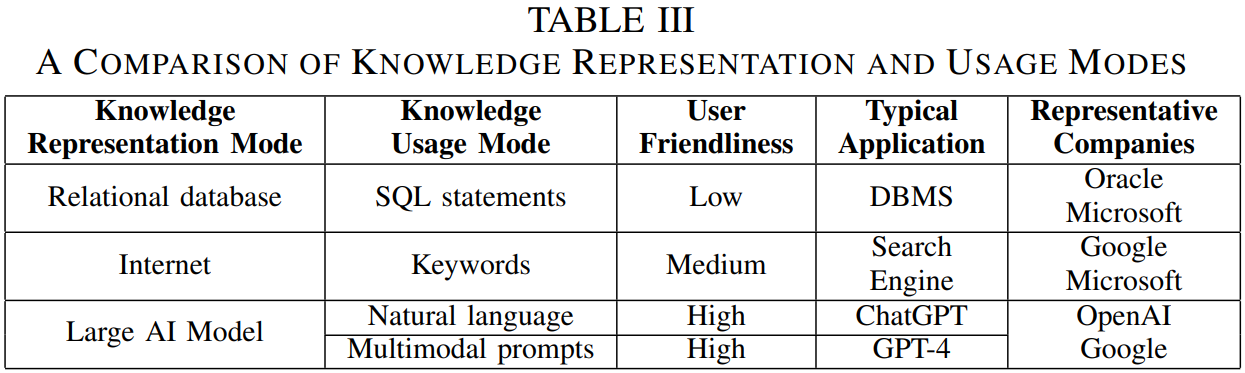

诸如ChatGPT和GPT 4等AI大模型的出现,正在革新当前知识表示和使用的范式。正如表III所述,这一发展预计将对工业界产生持久的影响。

- 阶段I:关系数据库和SQL语句。自个人计算机(PC)发明以来,知识一直以关系数据库的形式存储。为了从这些数据库中访问所需的知识,我们需要学习SQL语句,这可能对没有相关知识的个人来说很困难。代表性公司是Oracle和Microsoft。

- 阶段II:互联网和搜索引擎。自从互联网发明以来,大量的知识以非结构化的形式被存储,包括文本、图像和视频。与关系型数据库需要使用SQL语句来访问数据不同,我们可以使用搜索引擎通过关键字来调用信息。

- 第三阶段:AI大模型和自然语言。目前,ChatGPT和GPT-4模型能够存储来自互联网、用户输入和各类其他来源的人类、机器和AI算法所创造的所有知识。在此阶段,知识不再是显式存储,而是以AI大模型内的参数形式表示。此外,ChatGPT和GPT-4还支持通过自然语言甚至多模态输入同时为大量用户准确检索所需的知识。

2.5. AIGC-as-a-Service架构

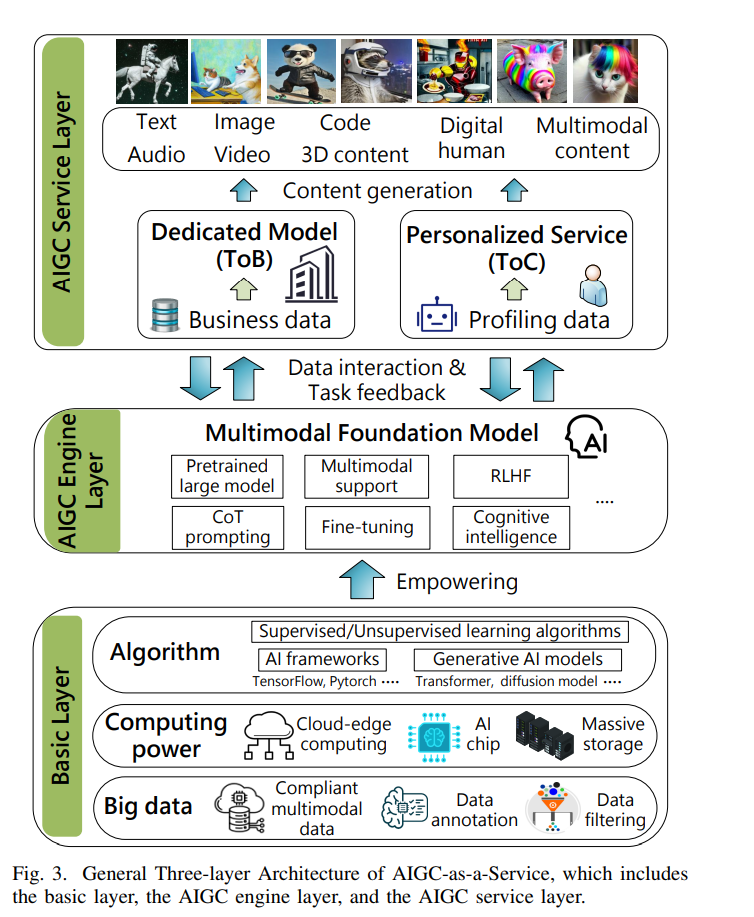

如图3所示,AIGC-as-a-Service(AIGCaaS)的体系架构涉及以下3个层次:(i) 基础层,(ii) AIGC 引擎层,以及 (iii) AIGC 服务层。

- AIGC基础层。随着AI大模型(例如具有1750B参数的GPT 3)的规模不断扩大,亟需更多的算力、更强大的AI算法和海量的训练数据。对于 ChatGPT,大计算能力、大数据以及大模型的组合释放了其强大潜能,使得可以学习用户提供的多模态提示并生成高质量内容方面。AI算法包括AI框架(如TensorFlow、Pytorch 和 Keras)、监督/无监督学习算法和生成式 AI 模型(如Transformer和Diffusion模型)。云服务器具有强大的GPU、TPU 和AI芯片以及海量的存储,可有效地训练基座AIGC 模型。其中涉及的训练数据可以是注释数据或来自互联网的非结构化、多模态数据。

- AIGC引擎层。多模态基座模型(如GPT-4)预先训练了大量的多模态数据,并且可以执行各种任务,而无需进行任务特定的微调。此外,还将诸如CoT提示、RLHF 和多模态技术等各种底层支撑技术集成到训练和优化基座模型中。多模态基座模型作为AIGCaaS的引擎,为上层的AIGC服务带来了不断增强的实时学习能力。此外,因为它可从更多的私有数据(如用户输入和历史对话)以及个人和机构的反馈中进行学习,多模态基座模型可通过与数十亿用户的实时和密集交互逐步进化与优化。

- AIGC服务层。从服务能力的角度,AIGC服务包括文本、音频、图像、视频、代码、3D 内容、数字人和多模态内容的生成。从终端用户的角度,AIGC 服务可以分为 ToB(面向业务)和 ToC(面向消费者)两种类型。虽然基座模型为各种任务提供了一种通用解决方案,但它可能在特定任务上表现不如专用AI模型。

-

- ① 对于ToB情况,一个机构或机构联盟可以通过在包含标注业务数据的较小数据集上对基座模型进行微调,训练出一个专用AI模型来执行特定任务,如医疗诊断或财务分析。例如,一个机构联盟可以通过联邦学习和迁移学习技术使用本地业务数据共同训练一个在基座模型之上的专用AI模型。此外,还可以结合两种方法以获得更好的结果。例如,可以使用一个专用AI模型进行特定任务,并将其输出作为输入提供给基础模型,以生成更全面的响应。

- ② 对于ToC情况,每个用户都可以定制一个网络孪生体(即智能手机或PC中的程序),并使用自然语言与之交流。孪生体有自己的记忆存储用户的偏好,兴趣和历史行为,以及任务特定的专业知识。利用这些知识,孪生体为用户生成个性化的提示,从而提供高效和定制的AIGC服务。此外,它还实现了一个反馈环路,用户可以对AI提供的建议进行评价。孪生体也可以通过构建一个互联的网络并自由分享所学习的知识和技能,来协同完成更复杂的任务。

- 对于ToB和ToC两种情况,以符合伦理和保护隐私的方式处理个人和机构的私有数据都至关重要。此外,在提供AIGC服务时,保护基座模型和专用AI模型的知识产权以及AI生成内容的来源,也是非常重要的。

-

2.6. AIGC工作模式

在未来,AIGC有潜力完全取代简单的和缺乏创造性的人类工作,并加速人机协作时代的到来。AIGC存在两种主要的内容生成模式:协助生成和自主生成。

- AI-Assisted Content Creation(需要人类干预)。在此模式下,AI算法为创造内容的人类提供建议或帮助。然后,人类可以根据AI提出的建议编辑和改进内容,以提高最终产品的质量。然而,这种模式在内容生成上往往比较慢且成本更高。

- Autonomous Content Creation by AI(无需人类干预)。在此模式下,AI完全独立地创建内容,不需要任何人类干预。AI机器人可以自主快速且低成本地创建大量的内容,而产生的内容质量取决于生成的AI模型。

2.7. AIGC关键特性

在此部分,我们将讨论AIGC服务的关键特性:

- 快速、密集和低成本的内容生成。随着AIGC技术的进步,内容生成比以往任何时候都更快速、更高效、更经济。AIGC算法可以比人类更快地筛选信息、发现规律并得出见解,使组织或个人能够以更快的速度生成内容。 AIGC还可以进行密集的内容生成,甚至可以同时创建数十或数千个内容,AIGC算法可以分析大型数据集并生成满足特定标准、主题或目标受众的内容。此外,廉价的内容生成也是AIGC的另一优势,它减少了对人力的需求,使内容生成代理能够24/7不停地工作。

- 多元化和多模态支持。 AIGC中的多模态支持是指AI模型处理和生成来自多种模态或来源(如文本、图像、视频和音频)的信息的能力。因此,它不仅可以从多种模态产生多样化的内容,而且通过实现全面和沉浸式体验,从而改善人机交互(HMI)。例如,具有多模态支持的AIGC模型可以通过有效地组合不同的模态来更好地理解所需创建的场景,并生成关联的多模态内容,为多个元宇宙用户提供沉浸式体验。

2.8. AIGC应用及原型

在此部分,我们将讨论不同类型的AI生成内容以及其应用:

1)文本生成。大型语言模型(LLM)可以比人类作者更快、更有效地生成高质量的文本。这包括博客、新闻、代码、文章、营销副本和产品描述。此外,它使聊天机器人和虚拟助手能够通过AI生成的文本以人类的方式与客户和客户进行沟通。

2)图像生成。大型视觉模型(LVM)可以将草图转化为数字绘制的图像,用于各种目的,包括创造视觉艺术、广告图片、游戏场景、驾驶模拟环境以及增加训练样本。

3)音频生成。AI生成的音频有着广泛的应用,包括语音合成、音乐创作和声音设计。如Amper Music这样的音乐创作AI程序,允许用户使用AI创建原创音乐。

4)视频生成。AI生成的视频可以广泛用于虚拟现实、增强现实、营销、广告、娱乐和教育等各种领域。

5)3D内容生成。AIGC可以通过分析照片和视频等真实世界的数据来创建逼真的3D模型,AI生成的3D模型可以用来创建动画、游戏资产和产品设计。

6)数字人生成。AIGC可以生成具有高度逼真动作和表情的数字人,可用于游戏、虚拟现实和广告等各种领域。

7)跨模态生成。AIGC中的跨模态内容生成指的是使用基础AIGC模型在多种模态之间生成新内容。它包括文本到图像、图像到文本、文本到代码、文本到视频、文本到音频等。

表IV总结了代表性的AIGC原型及其应用。总之,AIGC使我们的生活更加便捷高效,但也带来了新的安全及隐私威胁、伦理影响和潜在的偏见问题,如下一节所示。

3. AIGC安全与隐私威胁

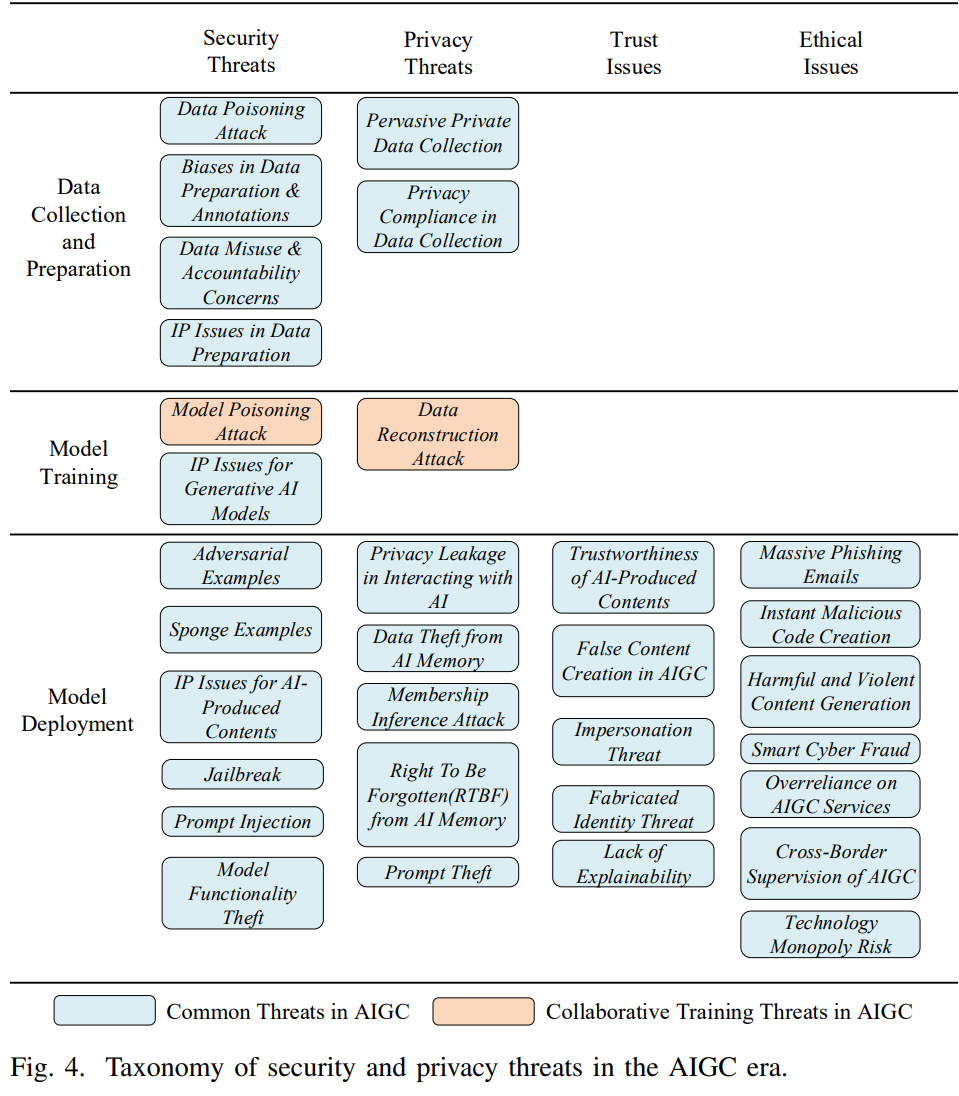

本节讨论了针对AIGC范式下安全和隐私问题的威胁,从以下四个方面进行分类:安全威胁、隐私威胁、信任问题和伦理问题。

3.1. AIGC安全威胁

- 数据中毒攻击。攻击者可能在数据准备过程中将毒化数据插入到目标生成AI模型的训练数据集中,从而导致模型性能降低或后门注入[17]。生成AI模型的性能也可能受到数据污染攻击的影响。例如,通过毒化训练数据集训练的深度生成模型可能会将红色的交通灯理解为绿色,给道路安全带来严重风险[40]。由于广泛的数据收集,AIGC通常在实施数据净化方法以减轻数据中毒效应方面效率低下且成本高昂。此外,攻击者可以利用AIGC技术快速生成大量中毒样本,从而大大降低攻击的总体成本并增加了防御的难度。

- 模型中毒攻击。通过联邦学习等分布式训练范式训练的AIGC模型容易受到模型污染攻击的影响。在模型训练期间,分布式学习的参与者可能向聚合服务器上传恶意更新[41],从而危及AIGC模型的完整性并降低其性能。为了减轻模型污染攻击的影响,聚合服务器需要采用鲁棒性聚合策略(例如FLTrust[42])来确保AIGC模型的性能和安全。

- 对抗样本。对抗样本指的是原始输入数据的扰动或对人类观察者不可感知的输入特征的小变化,其中这些扰动是精心制作出来的,以欺骗AI模型产生错误的输出[43]。生成AI模型也可能受到对抗样本的影响,攻击者可以将制作的扰动注入到模型输入中,以获得有针对性的输出。例如,Kos等人[44]验证了对VAEs和VAE-GANs的对抗样本,可以将原始输入转换为完全不同的输出,将不同的面部图像重构为特定的面部图像。此外,对抗样本还可以通过对抗性训练来帮助模型开发人员提高AIGC模型在抵御恶意攻击方面的鲁棒性。

- 海绵样本 (Sponge Examples)。海绵样本是AIGC中一种新形式的攻击,类似于传统网络中的拒绝服务(DoS)攻击。它们可能会导致模型延迟和能源消耗增加,从而导致在训练AIGC模型(如ChatGPT)的硬件系统中响应时间和资源消耗增加。因此,AIGC模型的可用性会受到影响。Shumailov等人的研究表明,海绵样本可以显著增加Microsoft Azure翻译器的响应时间[45]。

- 数据准备和注释中的偏见。由于训练数据来源的不均匀和标记数据可能存在偏差,生成AI算法可能会学习人类偏见,最终损害AIGC模型在种族、性别、年龄、语言、职业和地理等方面的公平性。此外,当用户与有偏见的AIGC模型进行交互时,可能会感到冒犯或受到伤害。例如,如果用于训练文本生成模型的训练数据主要集中在男性上且缺乏多样性,则人工智能生成的文本可能会展现出支持或排除女性的偏见。这种有偏见的输出可能会加剧性别不平等,并冒犯或伤害女性的利益。AIGC从业者需要在数据准备和注释过程中注意并纠正这些偏见,以确保对生成AI模型的公平、包容和道德使用。

- 数据滥用和问责问题。数据滥用风险在整个AIGC服务中存在,包括个人数据的未经授权收集以及生成有害或非法内容。数据滥用严重侵犯用户的权利和利益,从而降低用户对AIGC服务的信任度和数据贡献的意愿。此外,由于大规模的针对海量用户的数据收集、多样性的用户行为以及难以控制的生成AI模型输出,通常很难在实际的AIGC服务中强制实现数据滥用行为的问责。

- 数据收集中的知识产权问题。一般来说,生成式AI模型需要丰富的训练数据,而训练数据集可能包含通过网络爬虫等方法获取的未授权数据,从而引发潜在的法律风险和知识产权问题。例如,2022年底的Andersen v. Stability AI等案件中,三位艺术家起诉了多个生成型AI平台,因为他们的原创作品被用于训练AI模型而未经许可,这样的作品许可允许用户生成类似于受保护作品风格的衍生作品。因此,确保用于AIGC模型训练的数据是由其数据生产者或所有者授权的至关重要。

- 生成式AI模型的知识产权问题。由于AIGC模型资产的可复制性,授权实体可以压缩或剪枝有价值的AIGC模型并转售以获利,同时其侵权行为难以被检测。例如,在ToC的AIGC服务中,为开发专用AI模型而发布的基座模型(由其所有者进行训练)可能会被第三方授权机构泄露和转售。此外,有价值的AIGC模型可能会被内部和外部对手盗窃或抄袭。因此,这引发了对AIGC模型产权可追溯的巨大需求,以防止模型盗窃,转售和未授权复制来保护知识产权。模型水印[47]-[49]提供了一种具有前景的防御方法,通过嵌入不变的水印作为模型指纹来检测AIGC模型的抄袭和盗窃,并在产权争议时通过验证水印来表明所有权。

- AI生成式内容的知识产权问题。随着大型生成型AI模型的快速发展,也带来了有关AI生成内容的知识产权和AI生成恶意内容的可问责性等崭新的法律挑战。虽然AIGC模型的所有权通常归功于创建它的机构或个人,但生成的内容通常由已存在的数据和新的创意元素混合组成。这种界限的模糊引起了谁持有由AI产生的内容的知识产权的担忧。尽管法院正在进行持续的辩论和诉讼,但在如何解决这一问题方面仍缺乏共识或指导。作为提供法律明确性的首次尝试,欧盟发布的AI法案[50]旨在为生成型AI模型提供法律指导和监管。

- 越狱(Jailbreak)。在部署AIGC模型前,开发人员通常制定严格的规则,以防止生成有害内容或泄漏用户隐私。然而,一个良好设计的prompt可以让攻击者操纵诸如如ChatGPT等大型基座模型以突破安全措施,响应非法或有争议的查询,并获得敏感数据的访问权限。Do Anything Now(DAN)攻击[51]是一种利用“角色扮演”来越狱操纵ChatGPT的破解攻击,使ChatGPT相信它正与具有无限能力且可以立即执行任何命令或任务的另一个AI机器人进行通信。这使DAN攻击者可以未经授权地访问系统并以各种方式操纵ChatGPT的行为,从而对生成型AI模型的道德使用构成重大风险。例如,攻击者可能利用DAN攻击来欺骗ChatGPT透露敏感信息,执行未经授权的命令,甚至接管系统。此外,由于DAN攻击不需要利用软件漏洞来操纵ChatGPT的响应,它更难以防御。

- 提示注入(Prompt Imjection)。提示注入攻击[21]是当涉及到使用基于提示学习的AIGC模型(如LLM)时的一种新的漏洞。当攻击者将恶意或有偏见的提示注入模型的输入(即训练数据集)时,提示注入就会发生,从而生成符合攻击者目标的响应。该攻击可以用于操纵AIGC模型以产生任何所需的输出,或执行未经授权的操作。例如,对手可能注入提示来欺骗ChatGPT提供不支持的医疗建议或宣传极端主义思想,从而使ChatGPT成为传播错误信息或潜在伤害人们健康的平台。

- 模型功能窃取。攻击者可以利用AIGC服务的API来窃取模型结构,模型参数和超参数[52,53]。一旦攻击者获得目标模型的功能,他们就可以利用它获利甚至发起白盒攻击。现有的工作已证明在LLM中进行模型窃取的可行性。例如,Krishna等人[19]成功地对BERT模型进行了模型窃取攻击。虽然可能难以窃取ChatGPT等大型AIGC模型的完整功能,但在某个特定领域内,提取其功能的一部分仍是可能的。例如,攻击者可以准备一个由特定领域中相关问题组成的大型数据集,并从ChatGPT获得响应。然后攻击者使用知识迁移技术,使用问题和响应作为训练集,训练一个小型模型,该窃取的模型可以在特定领域内实现与ChatGPT类似的性能。

3.2. AIGC隐私威胁

- 广泛的私有数据收集。AIGC服务严重依赖于来自各种来源的大规模数据集,包括互联网、第三方数据集和私人用户数据。与传统AI模型相比,在AIGC时代,模型训练期间和模型部署后的广泛的私人数据收集威胁更加严重[54]。为了生成所需的高质量内容,AIGC 模型通常需要用户提供多模式的输入(例如,私人图形和 PDF 文件),这可能是私人和敏感的。此外,Internet上公开的大量个人数据也被用于AIGC模型训练,这也存在隐私风险。

- 与AI交互的隐私泄露。在AIGC服务过程中,用户与AI交互时也存在隐私泄露的问题。通常,在提供ToC的AIGC服务时,AIGC模型(如 ChatGPT)可以从大量用户中收集历史会话和多模式意图进行进一步训练。利用这些信息,OpenAI可以预测用户的偏好并在ChatGPT 交互中生成他们的个人画像,从而可能危及用户的隐私。例如,在 2023年4月,三星的员工使用ChatGPT来协助修复源代码时,他们无意中通过向ChatGPT 输入机密数据(包括新程序的源代码)泄露了公司的商业机密[55]。另一个例子是Apple已限制部分员工使用ChatGPT。此外,ChatGPT的广泛采用已经催生了利用OpenAI的API 的第三方网站或平台的非官方组织或个人。与这些未经验证的实体互动会增加隐私泄露风险,因为它们缺乏可信度并可能会误用用户数据。

- AI Memory中的数据窃取。大型AIGC模型的训练过程通常需要大量数据。例如,GPT-3利用来自各个领域的总共45TB的文本资源[11]。但是,由于AIGC模型的潜在记忆能力,它引发了训练数据中敏感信息(如电子邮件地址、居住地址和电话号码)的严重隐私风险。已有研究已经表明,诸如GPT-2和ChatGPT等LLM具有保留模型内机密训练数据的能力,攻击者可以从输出中利用这些数据,从而可能披露用户的私人信息[20],[24]。例如,在2023年3月,部分ChatGPT用户能够查看其他用户对话中的付款信息,包括姓名、电子邮件地址、付款地址、信用卡号的最后四位数字和信用卡过期日期[22],[23]。特别地,由于搜索引擎的支持,LLM的上层服务例如New Bing在生成内容时可能无意中提取私人数据[20],使数据窃取活动更为普遍。

- 数据重构攻击。在联邦学习范式下为ToB服务训练专用AIGC模型的协作训练过程中,诚实但好奇的聚合服务器可以通过分析每个通信轮上传的原始梯度来潜在重建参与者的本地私有数据集[56]。因此,它会降低个人和机构提供本地数据集地热情。通过利用差分隐私[57]、安全聚合[58]或同态加密[59]技术,可以减轻联邦AIGC模型训练中数据重建攻击的威胁。尽管如此,这些隐私增强方案往往会导致模型性能下降或资源消耗显著增加。实现效用和隐私之间的平衡仍然是一个需要进一步研究的关键问题。

- 成员推理攻击。成员推断攻击旨在确定特定数据样本是否存在于目标模型的训练集中[60]。其成功与AI模型的过度拟合程度密切相关。也就是说,过度拟合程度越高,隐私泄漏的风险就越大。由于诸如ChatGPT等大型AIGC模型在训练集和非训练集之间呈现出性能差异,因此仍存在成员推断攻击的风险。例如,攻击者可以对ChatGPT执行成员推断攻击,以确定特定个体是否是其训练数据集的一部分,具体步骤如下。攻击者可以先向ChatGPT提供一系列输入并收集相应的输出,然后使用监督学习技术训练二元分类器,最后使用这个分类器通过向ChatGPT提供代表该个体的输入来确定该个体是否是ChatGPT训练数据集的一部分。这种攻击有可能揭示其使用模式、偏好甚至身份等个人敏感信息。

- 数据收集中的隐私合规性。 AIGC服务在数据收集中的隐私合规性是另一个重要的隐私问题。考虑到数据收集的广泛规模和多样性以增强AIGC服务,必须遵守数据保护法律和法规,例如GDPR[61]和HIPAA[62]。AI Act还提出了AIGC服务的新规定,概述了开发ChatGPT[63]等基座模型的要求。例如,在2023年3月,意大利数据保护机构宣布暂停ChatGPT并对其涉嫌违反隐私规则进行调查。

- 从AI Memory中遗忘(Right To Be Forgotten, RTBF)。AIGC模型保留或记忆训练数据中的信息的能力,为许可其敏感数据用于模型训练的数据所有者带来了潜在的隐私问题。因此,数据所有者有权撤销其数据授权以保护其数据的保密性。然而,确保数据所有者的RTBF对于AIGC模型来说是具有挑战性的,因为它经常需要重新训练下游模型并导致大量资源消耗。机器遗忘学习(machine unlearning)[64]为AIGC模型提供了一种可行途径,可在减少资源消耗和计算负担的同时从AI内存中删除特定的训练数据。此外,数据切片技术可用于促进数据遗忘,从而确保在AIGC服务中数据所有者的RTBF。

- Prompt窃取。由用户提供的良好构造的多模式提示(prompt)对于在与AIGC模型的交互中产生高质量和期望的内容非常重要。例如,良好的提示可以促进文本到图像服务中艺术图片的生成,其应受到保护以免被盗窃。因此,提示窃取构成了AIGC领域中一大隐私威胁,可以通过两种主要方法进行:(i)网络窃听或恶意软件截取提示输入;以及(ii)模型反演,即从生成的内容中推断提示输出。特别的,GPT-4可能具有反演内容生成过程并推断初始提示的能力,使提示保护成为AIGC服务提供者的重要问题。

3.3. AIGC信任问题

- AIGC生成内容的可信性。尽管AIGC技术最近取得了重大进展,但其生产完全公正、准确和可靠的内容的能力仍然有限。例如,ChatGPT可能会生成貌似正确但毫无意义乃至完全错误的回复,这也被称为幻觉(hallucination),从而降低了用户对AIGC服务的信任。最近,Stack Overflow暂时禁止使用ChatGPT生成答案,原因是其缺乏准确性和可信度[65]。另一个例子是将ChatGPT用于生成有关认知行为疗法(CBT)在治疗与焦虑有关的ChatGPT方面的有效性的系统摘要。不幸的是,ChatGPT生成的摘要夸大了CBT的有效性,包含事实错误和虚假陈述。

- AIGC制造虚假内容。除了产生貌似正确的内容,AIGC模型很可能会被故意使用以制造虚假内容,从而产生更严重的信任问题。例如,利用ChatGPT在社交媒体平台上生成大量虚假新闻,可以使其真实性难以验证。此外,制造这种虚假内容的成本极其低廉,这可能会进一步增加其影响力。正如最近报道的那样,一名中国男子因利用ChatGPT制造关于火车事故的虚假新闻而被逮捕。这篇虚构的新闻在20个博客平台上发表,几个小时内获得了超过15,000次浏览[26]。

- 冒充威胁(Impersonation Threat)。攻击者可以利用社交网络上的照片和视频等公共信息,通过AIGC服务来冒充特定的人并与他人进行互动,从而促进欺诈和身份盗窃等犯罪行为。根据VMware的报告[66],黑客已经能够通过将深度伪造技术与现有攻击方法相结合来逃避安全控制措施,从而非法获利。

- 虚假身份威胁(Fabricated Identity Threat)。除了身份冒充威胁,攻击者可以利用AIGC服务通过生成逼真的图像、视频、音频和文本来创建高度令人信服的虚假身份。这使得用户难以辨别他们是否与目标用户互动还是仅是与聊天机器人互动。虚假身份的存在还可能加剧在线欺诈的风险,导致需要进一步验证接收到的图像和视频的真实性,以确定它们是否由人工智能生成。

- 缺乏可解释性。商业AIGC服务的黑盒模式使人们难以理解AIGC模型的内部过程,例如它们如何解释输入和生成输出内容。因此,这引发了审查AIGC模型关于公平性、透明度和潜在偏见方面的需求。可解释AI(XAI)[67]可用于解释AIGC模型。 OpenAI已开发了一种自动化工具,利用GPT-4在GPT-2中产生神经元行为的自然语言解释[68],作为自我解释的一种尝试。

3.4. AIGC伦理问题

- 大量钓鱼邮件生成。攻击者可以利用诸如ChatGPT等AIGC服务快速生成大量的网络钓鱼邮件,并以极低的成本用于恶意目的[69]。例如,攻击者可能使用ChatGPT向个人发送网络钓鱼邮件,要求他们提交敏感的个人信息,例如银行账户详细信息、密码或社会安全号码。此外,攻击者可以使用ChatGPT通过网络钓鱼邮件将受害者指向下载恶意软件或点击链接以访问恶意网站。即使OpenAI实现了内容审查机制,攻击者仍可能通过诸如越狱提示等各种方法规避OpenAI的审查规则。

- 即时恶意代码生成。AIGC服务既可以帮助用户编程和修复漏洞,也可能促进生成恶意代码等潜在的滥用风险。据报道,即使技术较低的黑客也可以绕过OpenAI现有的限制,利用ChatGPT即时制造出恶意代码[70]。Check Point Research (CPR)报告表示,黑客可利用ChatGPT建立了一个全自动的黑网市场,用于交易非法商品[71]。

- 有害和暴力内容生成。用于开发AIGC模型的训练数据来自现实世界,可能包含有害内容,例如性和暴力素材。因此,人们越来越担心AIGC服务可能会生成此类内容。例如,用于训练扩散模型的LAION数据集已被发现包含引发伦理担忧的有毒内容,包括暴力、色情和种族歧视等。尽管现有的AIGC模型(如Imagen和ChatGPT)已经努力消除有害内容,但筛选后的数据仍可能包含性和暴力内容[72]。可能的解决方案包括使用内容过滤技术或其他形式的内容调节,以防止有害内容的快速传播。

- 智能网络欺诈。AIGC模型还引发了严重的网络欺诈问题。LLM的快速发展使得骗子可以较低的成本在个人电脑上进行部署,使其能够全球范围内全天候地进行大量的复杂欺诈行为[28]。例如,骗子可以通过电话骚扰和录音来提取用户的语音,然后使用所获得的素材来合成声音,并利用伪造的声音进行欺诈。另一个例子是,骗子可以利用ChatGPT生成无瑕疵的谈话,以欺骗用户。随着AIGC模型的不断发展,这些欺诈行为的复杂性不断增加,进一步增加了网络欺诈的风险。

- 对AIGC服务的过度依赖。AIGC服务的发展还引起了对过度依赖的担忧。一方面,人们可能使用AIGC服务来完成任务,而非自主完成。例如,学生可能依赖ChatGPT完成他们的作业和考试,忽略了自主学习和知识获取的责任[73]。另一方面,AIGC模型的NLP功能导致用户对AIGC服务的不合理期望和过度依赖[27]。

- AIGC服务跨境监管。它指来自不同法律管辖区对其辖区内用户访问AIGC系统的监管。例如,如果ChatGPT为特定国家的用户生成不当或有害的内容,则该内容可能受到当地法律法规的约束。在此情况下,跨境监管将涉及不同监管机构和ChatGPT运营商之间的协调,以确保所产生的内容符合当地法律法规。此外,在AIGC服务提供中,大量用户和大型AIGC模型之间的密集互动不可避免地引起人们对跨境用户数据收集和使用的担忧。为了确保对AIGC服务的问责,需要建立相应的跨境监管法律法规,而这通常需要政府、监管机构、行业协会和AIGC平台之间的多方合作。

- 技术垄断风险。它指单一公司或组织利用其市场力量来控制和操纵AIGC的生产和分发的可能性。由于高度专业的AIGC模型通常是建立在预训练的大型模型上,需要巨大的投资以获取训练样本和算力,因此像OpenAI这样的技术巨头有可能利用自己的资源和市场影响力为较小的竞争者设置准入壁垒。此外,因为AIGC行业中的单个公司的支配可能导致对大量用户数据的集中控制,这种垄断还可能对用户的隐私和安全构成风险。作为应对措施,政策制定者需要考虑实施混合监管和反垄断措施,包括促进互操作性标准、与较小的公司合作,以及防止主导行动者收购竞争对手等。

小节:图4展示了AIGC服务的安全性和隐私威胁的分类。可以看出,现有的大多数AI安全和隐私威胁在AIGC领域仍然存在,甚至可能变得更加严重。例如,攻击者可以利用AIGC模型的能力生成大量中毒或对抗性样本,以增加攻击的影响。除此之外,由于AIGC模型可以动态地学习用户输入并从训练数据中记忆可能的敏感信息,从而引发新的隐私威胁,如从AI momory中盗取数据和在与AI交互期间泄露隐私。此外,AIGC的新特征(即快速、密集、低成本和多样化的内容生成)可能引入包括IP问题、越狱和提示注入等新型安全威胁。此外,AIGC服务引发持续的信任问题,特别是涉及接收内容的真实性(例如,接收到的图像和视频是否由AI生成)。此外,虽然AIGC服务可能彻底改变用户的生活,但它们可能引发严重的伦理问题,并更易于实施。因此,在设计AIGC系统之前,识别和解决潜在的安全威胁非常重要。我们需要从技术和监管的角度尽快提出有效和可行的对策。

4. AIGC的IP保护和监管

在本节中,我们首先探讨AIGC中的IP保护和监管方法。然后,我们回顾现有的基于数字水印的可监管的AIGC方案和面向AIGC数字水印的安全威胁和对策。

4.1. AIGC领域的IP保护和监管方法

现有和潜在的AIGC领域中的IP保护和监管方法包括数字水印、加密、硬件、区块链和法律法规,如下:

- 1) 基于数字水印。数字水印在保护知识产权和实现AIGC模型和内容的可问责性方面扮演着重要角色。数字水印本质上可作为数字指纹嵌入到AIGC模型及其生成的内容中,从而验证所有权并防止未经授权的模型使用或侵权行为。 (i) 在模型复制和分配过程中,AIGC模型可能会受到产权侵犯、未经授权的使用和模型伪造等威胁,导致模型所有者的巨大损失。通过将数字水印嵌入到AIGC模型中,所有者可以提供可证明的指纹,以在版权侵犯的情况下验证特定模型的合法所有权。 (ii) 数字水印对于识别并追踪由版权侵犯所导致的AI生成内容的来源也至关重要。它们可用于阻止侵权者在未经允许的情况下使用或分发这些内容。此外,通过嵌入数字水印,更易于追踪由AI生成的虚假信息或有害内容的来源并追究创作者的责任。

- 2) 基于密码技术。在AIGC领域,密码学在保护知识产权方面扮演着重要角色。 (i) 加密技术可用于建立访问控制机制,以确保只有授权实体可以访问受保护的内容。数字版权管理(DRM)是这类方法的一种常见应用。例如,Lotspiech等人利用广播加密技术实现了一种有效的数字内容版权保护系统 [76]。 (ii)将密码技术与数字水印技术相结合是实现知识产权保护的另一种方式。例如,Huang等人建议使用公钥密码来加密水印位置,从而使其更加弹性,避免被恶意个体未经授权修改或攻击 [77]。

- 3) 基于硬件。基于硬件的知识产权保护方法为保护AIGC提供了一种高度安全和高效的手段。例如,可信执行环境(TEE)可在DRM系统中实现安全操作,同时确保机密性和完整性 [78],这可在AIGC知识产权保护方面发挥作用。此外,可信平台模块(TPM)提供了面向嵌入式系统的另一个基于硬件的知识产权保护选项,它可提供安全存储、密码功能和隐私保护等功能 [79]。

- 4) 基于区块链。区块链的不可篡改性和可追溯性使其成为记录和验证知识产权的理想解决方案,提供了一种安全、高效和可信的AIGC知识产权保护的手段 [80]。例如,Kishigami等人开发了一种基于区块链的分布式版权和付款系统,用于数字内容,如音乐、视频和电子书籍,可以有效验证AIGC的授权和所有权 [81]。Lin等人提出了一种新型高级架构设计,将区块链和物联网集成到知识产权保护中,并创建了一个可信、自组织和生态的AIGC知识产权保护系统 [82]。但是,使用区块链会引起涉及数据和模型收集、存储和共享的机密性和隐私方面的担忧。例如,在联盟区块链中,需要可扩展的访问控制来防止未经授权的方访问敏感信息。同时,区块链的可扩展性和性能也在将区块链系统整合到AIGC服务中面临重大挑战。

- 5) 基于法律法规。法律法规在AIGC服务中发挥了重要作用。从硬法律角度看,可以实施具有约束力的法律工具(例如版权法),以规制AIGC模型及其生产的内容的使用。因此,它为AIGC模型和内容的创建者和所有者提供了法律保护,从而防止未经授权的使用或复制他们的作品。从软法律角度看,还可以使用推荐、指南、行为准则、非约束性决议和标准等来规制AIGC模型和内容的使用,提供伦理和道德指导,并促进AIGC模型/内容的创作、使用和分发的最佳实践。但是,规制AIGC模型/内容的挑战在于技术的不断发展导致法律法规难以跟上其发展速度。

小节:上述每种技术都具有独特的优点和局限性,可在组合使用中提供更好的保护,减轻知识产权侵犯的风险。随着AIGC技术的快速发展,开发新型产权保护和监管方法并与现有方法进行全面高效整合至关重要。

4.2. AIGC中基于数字水印的知识产权保护解决方案

AIGC模型中的数字水印是一个两阶段的过程,包括(i)模型训练阶段的数字水印嵌入和(ii)模型发布后的数字水印验证。数字水印嵌入旨在将预先设计的向量或特殊激活模式插入到AI模型中。在完成水印嵌入后,AI模型公开发布并部署服务,当怀疑存在外部模型侵权行为时,模型所有者可以通过验证可疑模型来提取数字水印以证明所有权。

- 1) 传统的集中式AI中的数字水印。现有的大多数基于数字水印的解决方案都是针对集中式AI模型设计的,可以分为基于数据、基于模型和基于特征的数字水印。

- 基于数据的数字水印。在基于数据的方法中,数字水印被插入作为宿主AI模型的指纹,触发一组特定输入(即触发集trigger set)的嵌入阶段。在数字水印验证阶段,验证者将触发集输入到可疑AI模型中,以检测激活模式,而不需要访问可疑AI模型的内部参数(即黑盒模式black-box)。在文献中存在两种主要方法来实现基于数据的数字水印: 后门和对抗样本。

-

- ①后门水印。Adi等人提出通过将后门作为水印插入到宿主模型中来对神经网络进行水印化[74]。一组图像被选择为触发器集并训练具有“错误”标签。利用深度神经网络(DNN)对训练数据的广泛记忆能力,在模型推断过程中预设计的触发器集可以激活宿主模型。实验证明,该方法在面对各种攻击时保持了高准确性和鲁棒性 [75]。作者研究了三种水印生成算法以生成带有有意义内容的图像、带有预先指定的噪声的图像以及具有无关标签的独立训练数据作为触发器集。

- ②对抗样本。Jia等人设计了一种优化算法,用于在干净的图像上生成对抗扰动(即有意义但是隐蔽的噪声),形成触发器集[83]。Qiu等人设计了SemanticAdv来生成语义上有意义的对抗样本,经由基于特征的图像编辑通过特征空间修改[84]。对抗性图像在图像内容方面可以完美欺骗人类视觉和理解,但能使宿主模型输出预设的不正确标签。

-

- 基于模型的数字水印。在基于模型的方法中,通过在模型训练中添加正则化项将预先设计的向量嵌入模型参数parameters(例如,可训练参数或超参数)中来实现水印嵌入。

-

- ①可训练参数。Uchida等人提出了一种一通用的DNN水印技术框架,可以通过在从头开始训练、微调或蒸馏过程中添加正则化项将预先设计的向量(作为水印)嵌入可训练模型参数中[85]。正则化器在模型训练中强制参数和向量之间的距离足够接近。为减少水印嵌入造成的影响,Liu等人提出了一种方法,将特殊内容(例如文本和数字串)加密到矢量中,并将矢量嵌入部分贪心选择的重要参数中[86]。

- ②超参数。Fan等人提出了在宿主模型的超参数(例如,缩放因子和偏差项)中嵌入水印的方法。在标准化层中,超参数被固定为特定值,只有模型所有者知晓,称为passport层[87]。

-

- 基于特征的数字水印。基于特征的水印是通过从数据样本中提取的只有模型所有者知晓的独特的嵌入特征。在水印验证阶段,可以通过特征提取算法验证基于特征的水印。Li等人提出了一种方法,通过将样式转移算法修改的几个图像嵌入到宿主模型中,将外部特征嵌入到宿主模型中[88]。同时,使用经过变换的图像训练了二元元分类器,在模型权重(即宿主模型和使用干净数据训练的良性模型)的梯度上进行了训练,以提取嵌入的外部特征。为了验证水印,检验器随机采样一部分经过变换的图像,通过元分类器检查怀疑的模型。在[89]中,宿主模型是使用通过编码器嵌入特定图像组成的关键样本进行训练的。相应地,还训练了一个鉴别器,用于从关键样本中解码出特定图像,进行水印验证。使用关键样本作为训练数据集时,只有在将关键样本作为输入时,AI模型才能保持所需的性能。

- 基于数据的数字水印。在基于数据的方法中,数字水印被插入作为宿主AI模型的指纹,触发一组特定输入(即触发集trigger set)的嵌入阶段。在数字水印验证阶段,验证者将触发集输入到可疑AI模型中,以检测激活模式,而不需要访问可疑AI模型的内部参数(即黑盒模式black-box)。在文献中存在两种主要方法来实现基于数据的数字水印: 后门和对抗样本。

- 2) 联邦学习中的模型水印。近年来,不断有学者尝试研究联邦学习中的水印技术。Li等人[90]对于DNN模型在联邦学习环境中的IP保护问题进行了正式定义,并提出了一种名为FedIPR的通用框架,同时支持黑盒和白盒验证。它将中心化AI环境中的IP保护方法(即[74],[87])扩展到联邦学习环境中。此外,Tekgul等人研究了客户端-服务器联邦学习环境中的拥有权保护问题,利用聚合器在每轮聚合期间使用触发器集重新训练全局模型来嵌入后门(即基于数据的水印)[91]。

- 3) AIGC中的水印。当前文献主要从两个方面研究AIGC水印技术:(i) AIGC模型的水印和(ii) AI生成内容的水印。

- GAN的水印。研究人员已经探索了各种方法,将水印插入GAN模型中以进行IP保护。Fei等人通过在每个生成的图像中包含一个隐藏签名,将不可察觉的水印添加到GAN模型中[47]。他们通过在生成器的输出端插入一个预训练的CNN水印解码器块并将水印损失纳入损失函数来实现这一点。Ong等人利用正则化项实施了一种综合性的GAN模型IP保护方法[92]。该方法将特定水印可视化到所生成的图像上,有效地防止水印歧义攻击。Yu等人利用图像隐写术将水印预先嵌入到训练数据中[93]。这种技术确保了水印从训练数据传输到GAN的可转移性。因此,嵌入在训练数据中的水印可以从任何生成的图像中解码。

- 潜在扩散模型的水印。Pierre等人通过快速微调图像生成器的潜在解码器并将二进制签名插入生成的图像中,实现了在生成的图像中嵌入不可见水印 [48]。使用预先训练好的水印提取器来恢复生成图像中的隐藏水印,并使用统计测试来确定图像是否由目标模型生成。

- 大型语言模型的水印。Abdelnabi等人成功地将水印嵌入自然语言模型中[49],并引入了对抗性水印变换器(AWT),通过编码器-解码器的协作训练和对抗性训练生成具有给定输入文本和二进制消息的隐式编码的输出文本。值得注意的是,此方案适用于大型语言模型,例如GPT-2。

- AI生成内容的水印。针对人工智能生成的内容,水印方法可以根据检测方法分为静态水印(用于硬IP)和动态水印(用于软IP)[94]。

-

- ①静态水印。当通过人工智能生成内容时,插入静态水印并使其在内容的生命周期内保持不变。它们可以是可见的或不可见的[95]。可见水印通常用于公司或个人希望营销的版权内容。不可见的水印隐藏在内容中。静态水印通过监控内容的未经授权使用或复制来促进跨各种平台的内容分发跟踪。尽管静态水印是永久的且相对容易实现,但由于其静态性质,它们更容易受到水印删除的影响[96]。

- ②动态水印。动态水印是在内容中动态生成的,并可以在生成后修改或删除[94]。它们通常用于每次访问内容时创建一个独特且可识别的版本,以便跟踪内容的使用情况。动态水印可以防止内容的滥用,并促进数字取证,特别是在内容被重复使用或在协作平台上交换的情况下。虽然动态水印更难以删除,但也可能使工作流程复杂化。

-

- AIGC模型和人工智能生成内容的水印。 AIGC模型及其产生的输出的水印可以分为两类。

-

- ①分离方式。 AIGC模型和生成内容的水印是以分离的方式添加的。对于内容水印,它涉及使用传统的多媒体水印技术(例如用于图像[96],音频[97],文本[95]等)对生成的内容水印进行后生成;对于模型水印,可以通过两种方法嵌入:通过将水印合并到模型参数中或利用用于嵌入的触发集。

- ②耦合方式。它指在内容创建时使用水印提取器嵌入水印或在训练数据中添加水印,从而在人工智能生成的内容中实现水印添加过程。例如,水印提取器在AIGC模型的训练过程中同时进行训练。通过将水印提取器的损失与生成模型的损失相结合,可以确保所有生成的内容都包含可提取的水印[98]。从生成的内容中提取水印可以确定内容和模型的所有权。因此,内容和模型的水印以耦合方式嵌入。

-

- 4) AIGC水印的要求。有效的AIGC水印方案应具有足够的鲁棒性,以抵抗模型/数据转换和压缩,足够安全以抵御复杂的攻击,足够可靠以维护内容的质量和AIGC模型的性能,具有可扩展性足够强,可以使用不同的模型和内容,且足够高效以实现实际服务部署。

- 鲁棒性。有效的AIGC水印应具有足够的鲁棒性,以抵抗专门设计用于删除水印或以使水印失效的模型/内容的攻击。水印应能够抵御各种类型的攻击,包括数据篡改,有意删除或常见失真。

- 安全性。安全性是AIGC水印的重要要求。水印不仅应难以删除或破坏,而且还应抵御伪造、伪造、模糊或覆盖。

- 保真性。水印不应影响人工智能模型的质量或性能。嵌入过程不应对模型的准确性和可靠性产生任何重大变化。

- 可扩展性。水印应具有可扩展性,这意味着它应该可行地实现在不同的AIGC模型中,而不会带来显着的困难。还应该能够在不同体积和尺寸的内容上嵌入水印。

- 高效性。水印在计算负担和存储需求方面应该是高效的。嵌入和检测水印的过程不应显着增加AIGC模型所需的处理时间或存储空间。此外,水印过程应易于使用。

小节:现有的人工智能水印方法主要采用三种方法:(i)触发器集合(例如后门和对抗样本);(ii)模型参数(例如可训练参数或超参数);以及(iii)独特特征,作为数字指纹进行所有权验证。当涉及到内容水印方法时,主要分为静态和动态两大类。为了确保在AIGC中综合保护知识产权和监管,通常需要在AIGC模型和人工智能生成的内容上嵌入水印。可以根据应用程序的具体要求和目标使用不同的水印技术,并且使用多种水印组合可能提供更好的保护措施,以防止知识产权侵犯和未经授权的使用。然而,由于训练数据的不断更新,因此有必要重新训练AIGC模型并提高水印效率。因此,有必要开发一种自适应模型水印嵌入机制,在频繁的模型重新训练过程中降低计算成本。此外,由于攻击行为的智能和多样性,需要增强AIGC水印的鲁棒性和安全性。此外,实施快速、高效和低成本的水印嵌入和验证机制以满足大规模AIGC数据生产的不断增长的需求成为挑战。

4.3. AIGC水印的威胁和对策

- 1)水印失真。水印失真是在额外的训练过程之外失真水印验证结果的一种方法。在基于模型的水印中,对手可以通过缩放或重新定位节点来修改参数,从而增加嵌入向量和相应参数之间的距离。

- 置换攻击。置换攻击的目的是置换模型的节点,从而增加嵌入参数和预先设计的向量之间的距离。然而,置换攻击往往会导致模型性能下降,因此一般不适用于实际应用。

- 缩放攻击。缩放攻击的目的是将模型权重乘以某个倍数,同时不影响输出值。在[86]中,刘等人将入射边的权重乘以一个因子,将出射边的权重除以相同的因子值,以保留输出。虽然缩放攻击可以扭曲向量和嵌入参数之间的距离,但提取的符号(即正负符号)基本保持不变,因此可用于水印验证。

- 2)水印消除。水印消除过程涉及创建一个模型副本,通过额外的训练来删除嵌入的水印。攻击者可以试图以各种方式删除水印,例如直接在主机模型上训练(即消除攻击),通过知识蒸馏压缩模型,或者甚至从头创建一个复制原始模型功能的新副本(即模型提取)。

- 去除攻击。该攻击可以通过各种方法发起,包括微调、修剪和重新训练。

-

- ①微调:微调是一种转移学习方法,涉及对其他任务的输出层进行额外的训练,并经常被用作无意攻击以删除嵌入的水印[85]。然而,几乎所有提出的水印方法都能够抵抗微调攻击[87] [83] [88]。

- ②模型剪枝:权重修剪是一种模型压缩技术,也可以通过消除主机模型中冗余节点来删除嵌入的水印,并保持其性能。抵抗修剪攻击是水印方法的基本要求,大多数方法已被证明可以有效抵御此类攻击。

- ③ 重训练。重新训练攻击是微调的一种变种,旨在通过在较小的数据集上重新训练整个模型来去除嵌入的水印[74],因此将计算成本与成功去除水印的可能性进行权衡。

-

- 反向工程。反向工程[99]是一个两阶段的过程,结合了检测隐藏水印和遗忘(unlearning)技术,以去除主机模型的后门。基于数据的水印方法易受反向工程攻击的威胁,如[74]中的水印,是一种具有较弱反向工程鲁棒性的典型后门水印。

- 模型蒸馏。模型蒸馏是一个模型压缩过程,包括训练一个小型模型(称为学生模型)来学习一个更大更复杂模型(被称为教师模型)的知识。从理论上讲,模型蒸馏可以消除所有基于模型的水印,因为学生模型的训练主要基于教师模型生成的软性和硬性标签。因此,教师模型的参数几乎无法转移到学生模型。

- 模型提取。与模型蒸馏类似,模型提取旨在通过黑盒查询来复制远程部署模型的功能[100],[101]。然而,模型提取可能导致更大的模型,在某些情况下甚至可以提取主机模型的精确参数。

- 去除攻击。该攻击可以通过各种方法发起,包括微调、修剪和重新训练。

- 3) 水印歧义攻击。歧义攻击旨在伪造一个额外的水印,对模型的所有权存在疑问,而不必破坏正式的水印。在验证过程中,攻击者只能验证额外的水印,因此声称拥有该模型。范等人[102]证明了正式的基于数据的方法(i.e. [85] [74])不具备对抗模糊攻击的鲁棒性,并提出了一种新颖的护照技术,将水印嵌入超参数。如果相应的护照被修改(即重新嵌入模糊的水印),模型的性能将被显著降低,从而阻止了模型盗窃。

- 4)水印覆盖攻击。一旦攻击者了解了所有者的水印策略,他们可以部署相同的嵌入框架,用新水印覆盖原始水印。刘等人证明了背门方法[74]在攻击者可以访问原始数据集的情况下,不具有对抗水印覆盖的鲁棒性。此外,他们还证明了[86]中提出的水印对水印覆盖具有强鲁棒性,无论攻击者是否可以访问原始训练数据集。

5. 未来研究方向

在本节中,我们从以下几个方面指出了AIGC时代下的未来研究方向。

5.1.绿色的AIGC架构

对于诸如ChatGPT等AIGC大模型,通常需要巨大的算力进行模型训练和服务,从而造成了巨大的能源消耗和环境问题。据报道,ChatGPT同时回答590万用户的一个问题时的能源消耗大约相当于17.5万丹麦人的月用电量[103]。考虑到当前生态友好型技术的发展趋势,设计绿色AIGC架构已成为缓解整个AIGC生命周期中碳排放的迫切需要。其实现依赖于几项关键技术,包括云边协同计算、硬件创新和节能AIGC算法。特别是,云边协同计算[2,4]可以实现可扩展的模型训练和推断,降低能源成本,其中在云上部署的基本模型可以处理复杂的数据和任务,而在分布式边缘设备上部署的专用模型可以处理实时处理。最新的硬件创新可以整合到AIGC架构中以降低能量消耗,比如神经形态芯片[104]可以执行专门的计算任务,同时消耗的能源比传统处理器少。开发节能算法也可以降低AIGC模型所需的计算量,从而减少模型训练和推断的能源需求。此外,可以利用模型压缩技术[105],如剪枝、量化和知识蒸馏,来减少AIGC模型的大小和复杂性,进一步降低能源消耗。在这一领域的开放性研究问题包括最优云边资源共享、自动化和自适应模型压缩、专用人工智能芯片设计,以及能源消耗与性能之间的平衡。

5.2. 可解释的AIGC模型

目前的生成式人工智能模型即AIGC模型通常被认为是黑盒,由于它们缺乏透明度和可解释性,这使得难以理解它们的决策过程。这引发了关于偏见结果、安全威胁和道德考虑的担忧,从而亟需开发可解释的AIGC模型。设计可解释的AIGC模型可采用几种关键技术,包括可解释的人工智能算法、模型可视化技术[106]和人机协同方法[107]。可解释的机器学习算法,如决策树和基于规则的模型,能够捕获输入特征与输出之间的复杂关系,从而为模型的输出提供解释。此外,模型可视化技术[106],例如激活映射、显著性映射和特征可视化,为AIGC模型的决策过程提供了图形化表示,从而便于用户理解模型如何对不同的输入进行分类、聚类或关联。人机协同方法涉及将人类专家纳入AIGC模型的决策过程中,可通过共设计界面和互动反馈机制来实现,以取得更好的结果[107]。这些技术的结合可以提高AIGC模型的透明度和可解释性。然而,在这个领域仍然存在多个开放问题需要探讨。其中最重要的挑战之一是在准确性、可解释性和安全性之间取得平衡。缺乏透明度的黑盒模型在各种数据驱动任务上表现出色,并具有更好的安全性,而可解释的模型通常表现出较低的准确性和更差的安全性。另一个挑战是评估和验证AIGC模型的可解释性,需要一个适当的框架来衡量和比较其解释性能。

5.3. 分布式和可扩展的AIGC算法

随着各行业对AIGC服务和应用的需求不断增加,现有的中心化AIGC范式可能难以应对激增的AIGC模型推理和服务,导致AIGC服务延迟高、可扩展性低。因此,需要一种分布式AIGC范式,通过并行化分布式任务处理,从而减少大规模AIGC任务所需时间,并增加可扩展性。云边协同计算是支持分布式和可扩展AIGC的关键技术之一[2],[4]。它涉及云和边缘设备的协作,将计算能力和处理任务分布在相互连接的设备网络中。在该系统中,基础AIGC模型部署在云上以处理复杂的通用任务,而专用AIGC模型则部署在分布式边缘设备上以处理实时任务处理。专用的AIGC模型可以通过精调来自大型基础AIGC或在联邦边缘中协同训练进行优化,在特定领域(如医疗和交通领域)中表现更优。领域内的用户可以请求部署在边缘设备上的小型专用模型,从而降低延迟、提高性能和降低服务成本。然而,以下研究问题仍待解决。首先,边缘设备可能没有足够的安全资源来保护敏感数据,所以有必要开发有效的隐私和安全协议来保护数据隐私。其次,分配不同处理、存储和通信能力的云/边缘设备之间的资源是具有挑战性的。第三,在实际AIGC服务架构中,异构网络可能导致不同连接到网络的设备的服务质量(QoS)不同,而网络的异构性使得资源管理和优化变得复杂。最后,边缘设备间的兼容性问题可能导致负载平衡、数据传输和任务分配等问题。

5.4. 可信和可监管的AIGC服务

AIGC服务的兴起引发了有关其生成内容的质量、可靠性和可信度的担忧。实际上,AIGC模型有可能生成虚假信息或错误内容,导致误导信息、虚假视频和宣传。此外,评估AI生成的内容的真实性可能会很困难。AIGC服务应符合相关法律法规,以保护公众利益、防止危害和确保问责。可以整合多种技术为确保AIGC服务的可信度和可监管性,包括可解释的人工智能 [67]、审计 [108]、区块链 [80]-[82]、AIGC水印 [74]、[75]和合规框架 [109]。基于审计的方法可以消除AIGC服务中的数据偏见和歧视,同时确保公平 [108]。区块链技术可以通过记录数据传输、访问控制和用户权限等信息在不可变的账本上,增强AIGC服务的信任、透明度和法规合规性 [80]-[82]。然而,区块链技术也会引起数据和模型收集、存储和共享方面的隐私问题,以及实际AIGC服务的可扩展性和性能限制。AIGC水印用作数字指纹,提供了一种识别AIGC模型及其生成内容来源的方式 [74],[75]。AIGC水印可以增强可追溯性、问责制和真实性,同时最小化模型盗窃和信息误传的风险。然而,为了满足大规模AI生产数据的需求,减轻频繁模型重新训练的负担,还需要进一步研究在自适应、快速、高效和经济有效的方式下实现水印嵌入和验证机制。AIGC模型需要频繁重新训练、自适应水印嵌入、安全水印和高效实现,以满足日益增长的数据生产需求。最后,在可监管的AIGC系统中需要结合硬法律和软法律,其中硬法律规管AIGC模型和内容的法律方面,而软法律则促进其创造、使用和分配的伦理实践和标准。

5.5. 设计安全的AIGC服务

为各种应用中对AIGC服务日益增长的需求,开发能够抵御攻击、保护敏感数据和保护用户隐私的安全设计的AIGC系统对减轻潜在威胁至关重要。设计安全的AIGC系统确保安全不是事后措施,而是系统架构设计中一个不可分割的部分。特别是,需要提前考虑到人工智能可能带来的潜在安全风险,并将安全措施嵌入到AIGC系统的设计和开发中。因此,其有助于减轻恶意攻击或系统中意外漏洞对数据隐私和安全可能产生的潜在威胁。对抗性鲁棒程度 [110] 是安全设计的AIGC系统的一个关键方面。它指代AIGC系统抵抗旨在欺骗或操纵系统等攻击的能力。因此,设计安全的AIGC系统可确保AIGC系统即使面临意外或对抗性输入,也仍然保持可靠和值得信任。诸如鲁棒优化 [111]、对抗性训练 [110]和防御蒸馏 [112]等各种技术,都可以提高AIGC系统的对抗性强度。其中的开放性研究问题包括内生安全AIGC算法、新型主动防御、安全编程、严格测试、安全监测和隐私合规性等。

6. 总结

ChatGPT和AI生成式内容技术的快速兴起带来了内容创造方面的重大进展。然而,它也带来了诸如越狱、数据盗窃、深度伪造和有偏见/有害内容等安全威胁。为跟上AIGC时代的进展,本综述从安全威胁与防御的角度对AIGC进行了全面的回顾。本文首先介绍AIGC的工作原理,包括其支撑技术、体系架构、工作模式、关键特征和典型应用。然后,指出了现有和潜在的GPT和AIGC中的安全/隐私威胁、信任、伦理问题。此外,综述了AIGC的最新监管解决方案,以及当前解决方案的挑战和限制。最后,讨论了AIGC框架的绿色、可解释、有效性、可问责和设计安全等方面的未来研究方向。本综述的主要目标是为AIGC提供工作原理、安全/隐私/伦理问题和潜在对策方面的综合洞察,并引领该领域更多的创新举措。

引用格式:Yuntao Wang and Yanghe Pan and Miao Yan and Zhou Su and Tom H. Luan, "A Survey on ChatGPT: AI-Generated Contents, Challenges, and Solutions", in IEEE Open Journal of the Computer Society, vol. 4, pp. 280-302, 2023, DOI:10.1109/OJCS.2023.3300321.

浙公网安备 33010602011771号

浙公网安备 33010602011771号