seq2seq

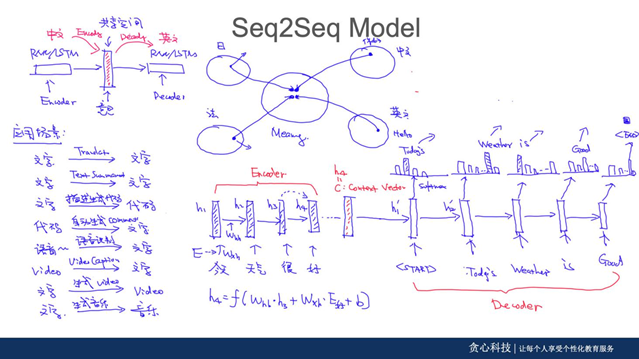

- Seq2seq的思想和应用

Encoder-decoder第一篇:Learning Phrase Representations using RNN Encoder-Decoder for Statis Machine Translation

Seq2seq:sequence to sequence Learning with Neural Networks

知识图谱增加可解释性:seq2seq interpretability knowledge graph

-

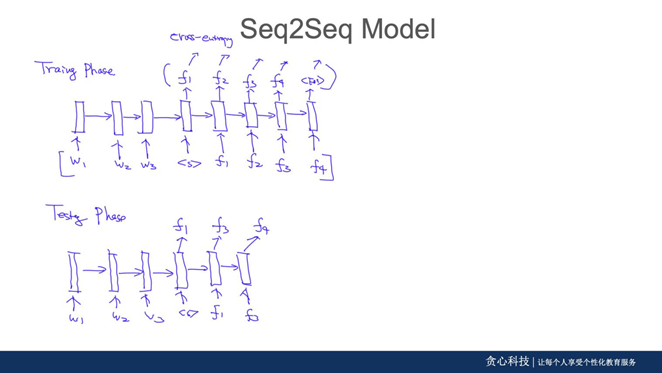

Train(encoder) and test

-

Decoder

在任何的seq2seq模型中,都是串行的,之后的transformer解决了这个问题。

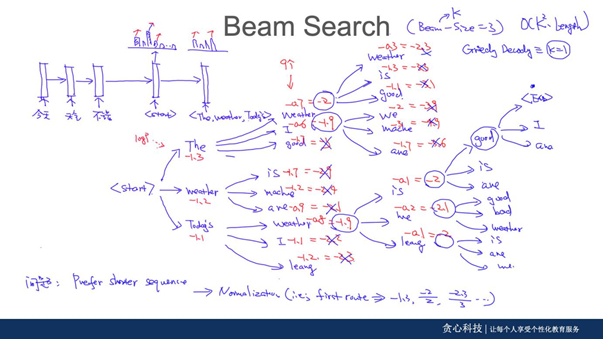

greedy decoder:在seq2seq中,串行*(greedy decoder),局部最优,达不到全局最优

Exhaustic Search:把所有的可能性考虑进来

Beam Search:只考虑最好的top k

Beam search在第二个阶段还进行了筛选,选概率值最大的beam_size

{Beam_size=1} =={greedy search}

1、NLP之Seq2Seq:

原文:https://blog.csdn.net/qq_32241189/article/details/81591456

2、深度学习的seq2seq模型:

原文:https://blog.csdn.net/wangyangzhizhou/article/details/77883152

3、Seq2Seq模型简介

原文:https://www.jianshu.com/p/1c6b1b0cd202

4、三分钟带你对 Softmax 划重点

原文:https://blog.csdn.net/red_stone1/article/details/80687921

https://www.jianshu.com/p/b2b95f945a98

浙公网安备 33010602011771号

浙公网安备 33010602011771号