本地部署 Browser-Use WebUI + 本地部署 DeepSeek 实现浏览器AI自动化

前一版采用的是 Deepseek 官方API,由于最近比较火,可能遇到服务器繁忙导致运行不成功,这一版选择通过 Ollama 本地部署的模型

一、安装部署(已安装 python3.11 或以上版本、playwright)

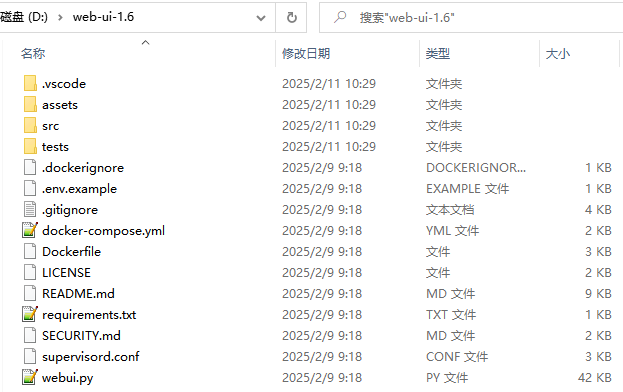

1.下载最新源码包(v1.4及以上版本),解压

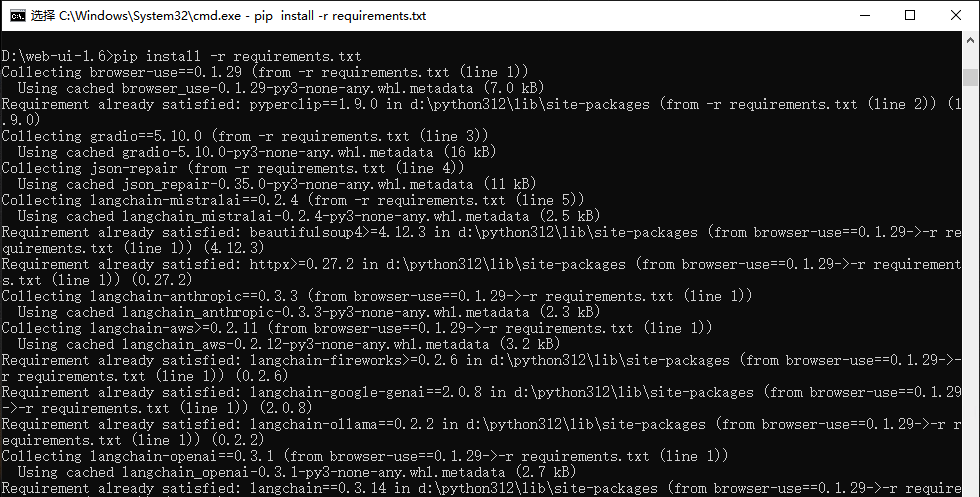

2.在解压的文件夹中打开CMD,安装依赖项

pip install -r requirements.txt

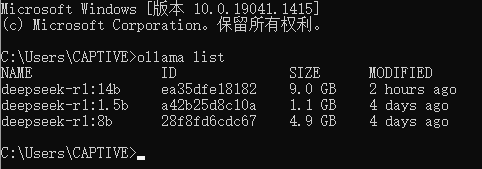

3.安装 Ollama,运行 deepseek-r1

模型大小很重要:更大的模型效果非常好!较小的模型可能无法提供最佳体验,因此建议坚持使用较大的模型,如 deepseek-r1:14b

ollama run deepseek-r1:14b

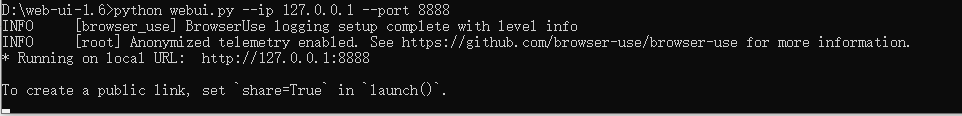

4.启动(启动前关闭所有chorme)

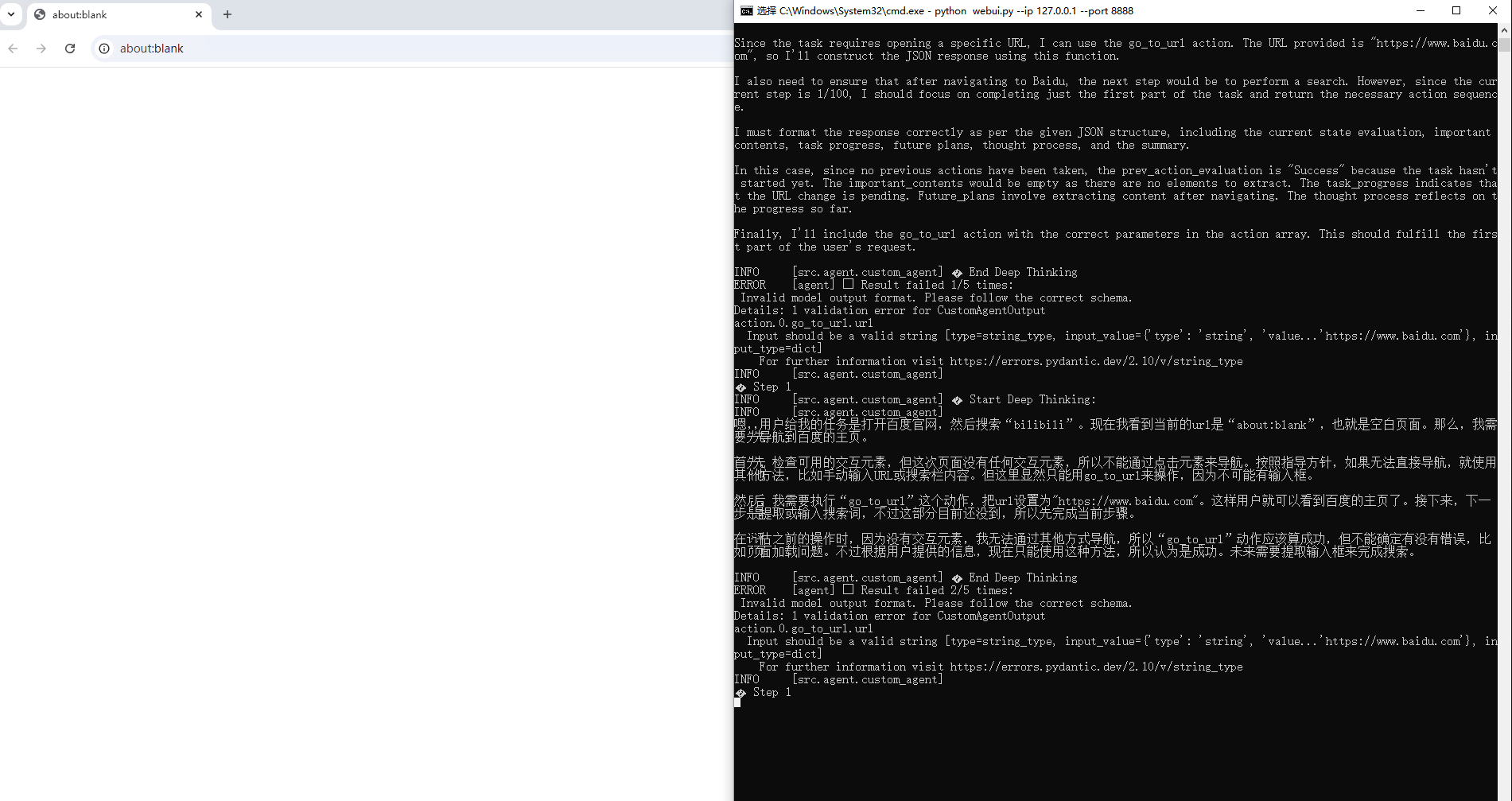

python webui.py --ip 127.0.0.1 --port 8888

5.访问

浏览器打开这个链接:http://127.0.0.1:8888

二、WebUI 配置

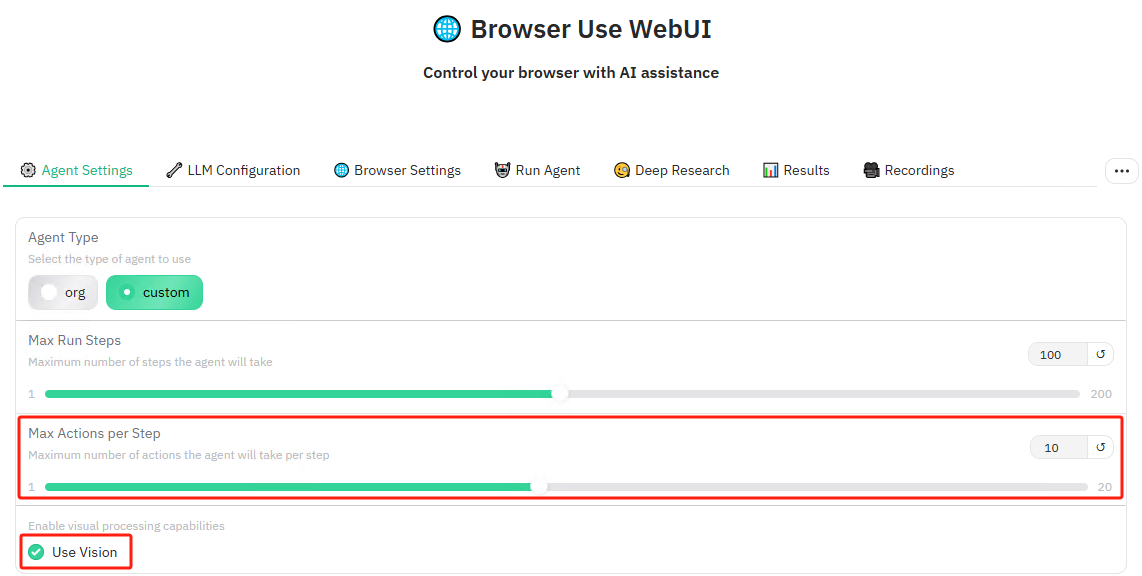

1.Agent Settings

这是一个关键步骤:取消选中“Use Vision”并将“Max Actions per Step”设置为 1

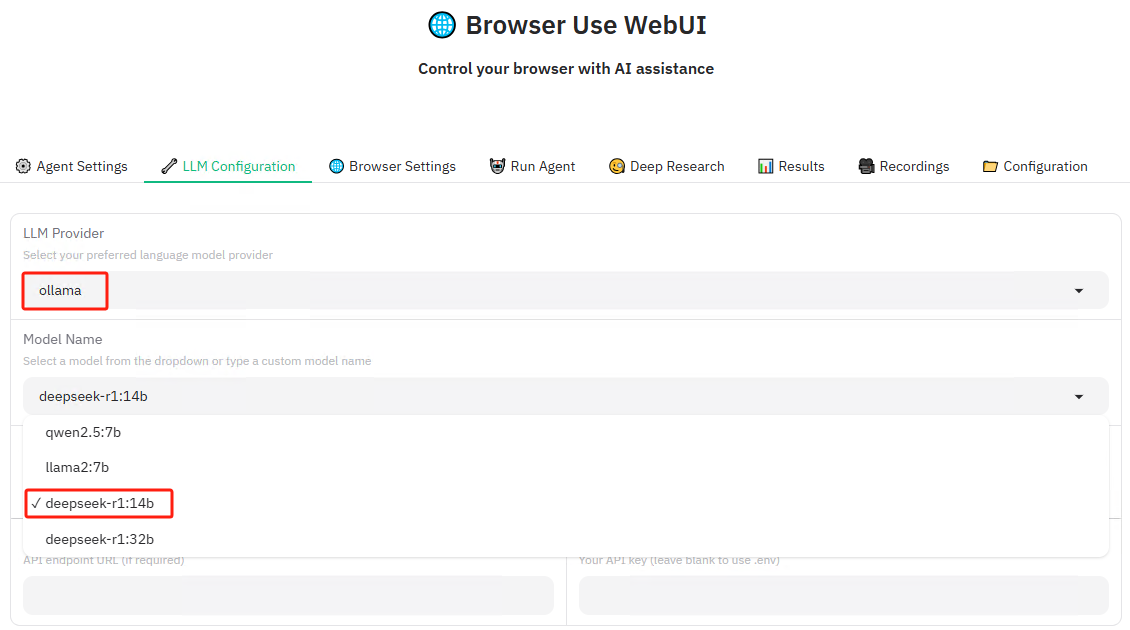

2.LLM Configuration

LLM Provider 选择 ollama ,模型选择 deepseek-r1:14b

注:可手动修改成本地部署的其他模型的 NAME

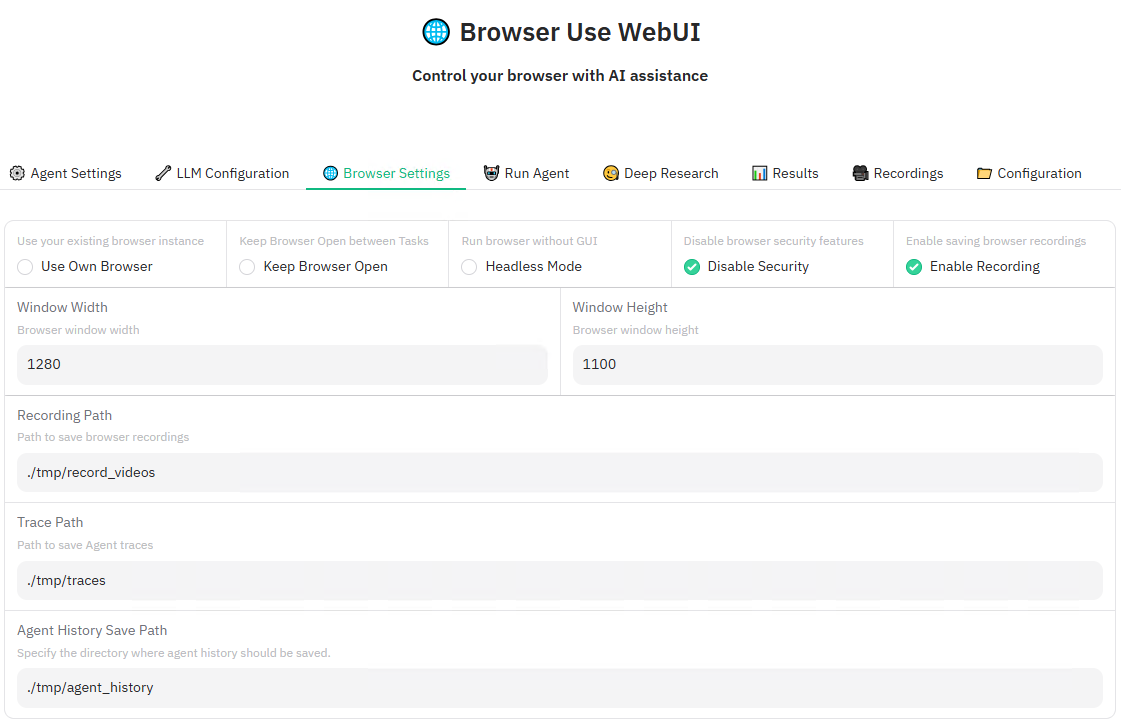

3.Browser Settings

根据需要修改

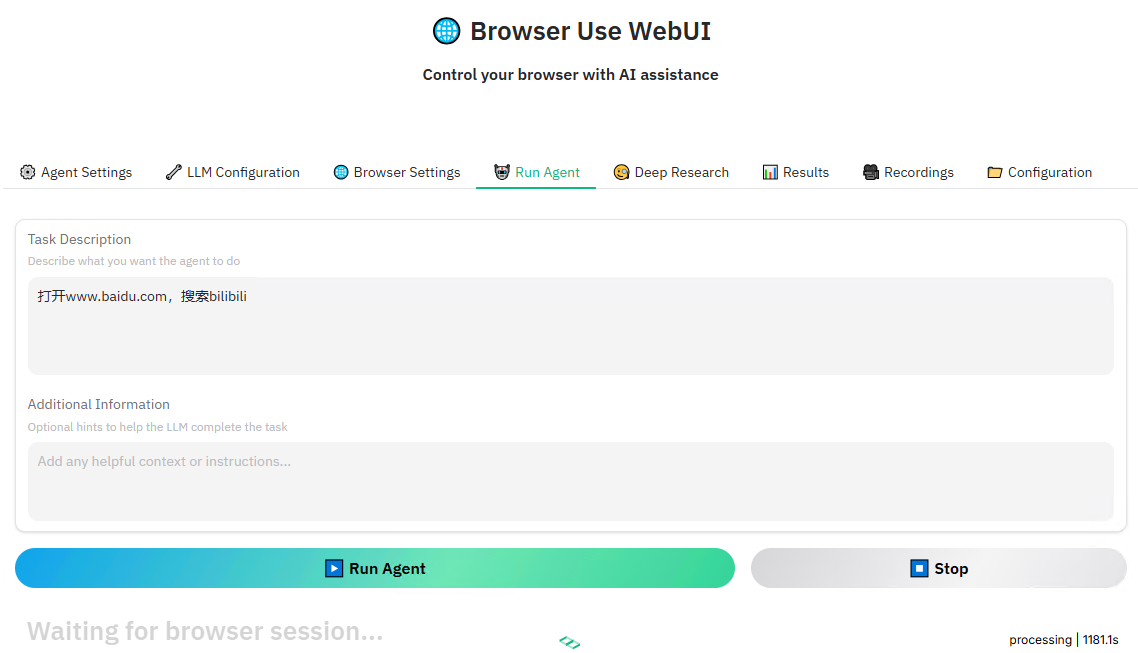

4.Run Agent

录入任务描述,运行

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 拒绝繁忙!免费使用 deepseek-r1:671B 参数满血模型

· 本地搭建DeepSeek和知识库 Dify做智能体Agent(推荐)

· DeepSeek-R1本地部署如何选择适合你的版本?看这里

· DeepSeek本地化部署超简单,比装个office还简单

· 基于deepseek模型知识库,Cherry Studio和AnythingLLM使用效果对比