ChatGLM-6B落地实践——Cpu模式

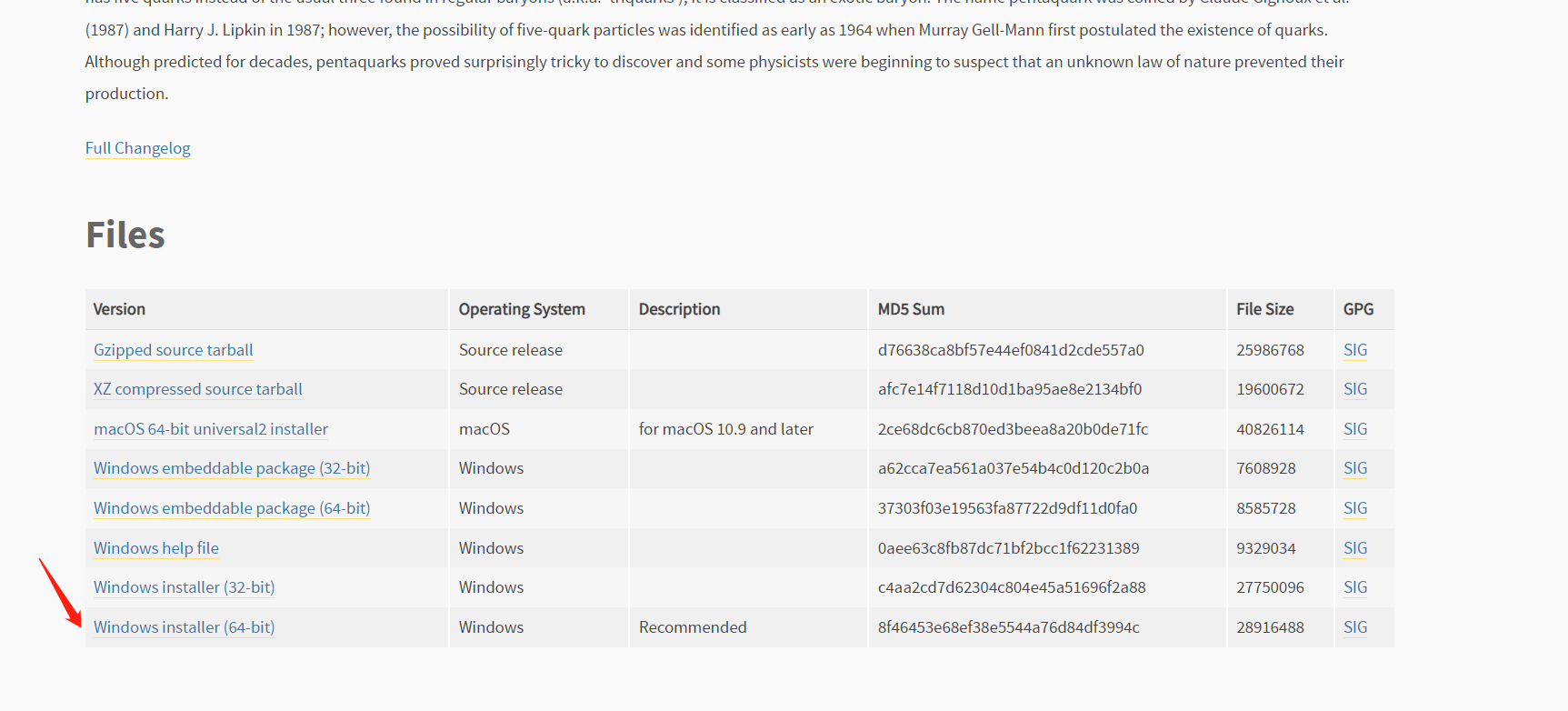

1、安装Python

- 下载地址:https://www.python.org/downloads/release/python-3106

-

- 记得要勾选path

- 安装完成后,命令行里输入

Python -V,如果返回Python 3.10.6那就是成功安装了 - 命令行里输入

python -m pip install --upgrade pip安装升级pip到最新版。

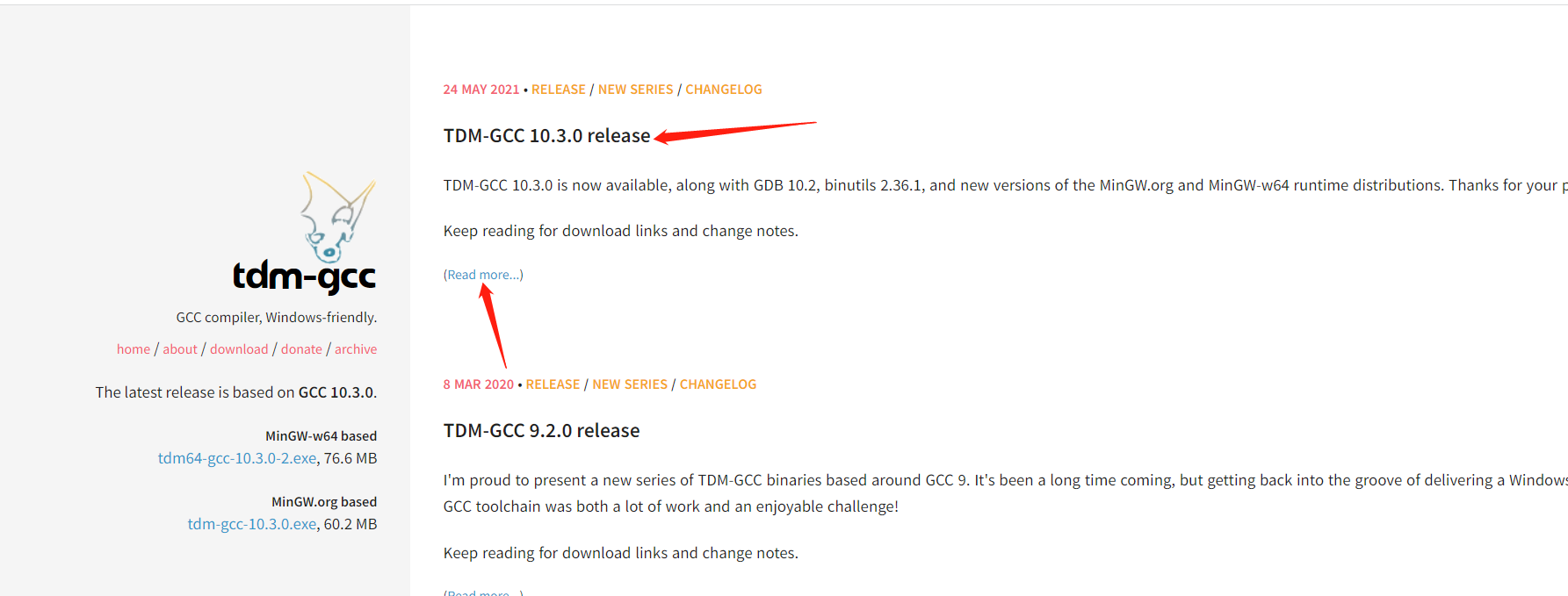

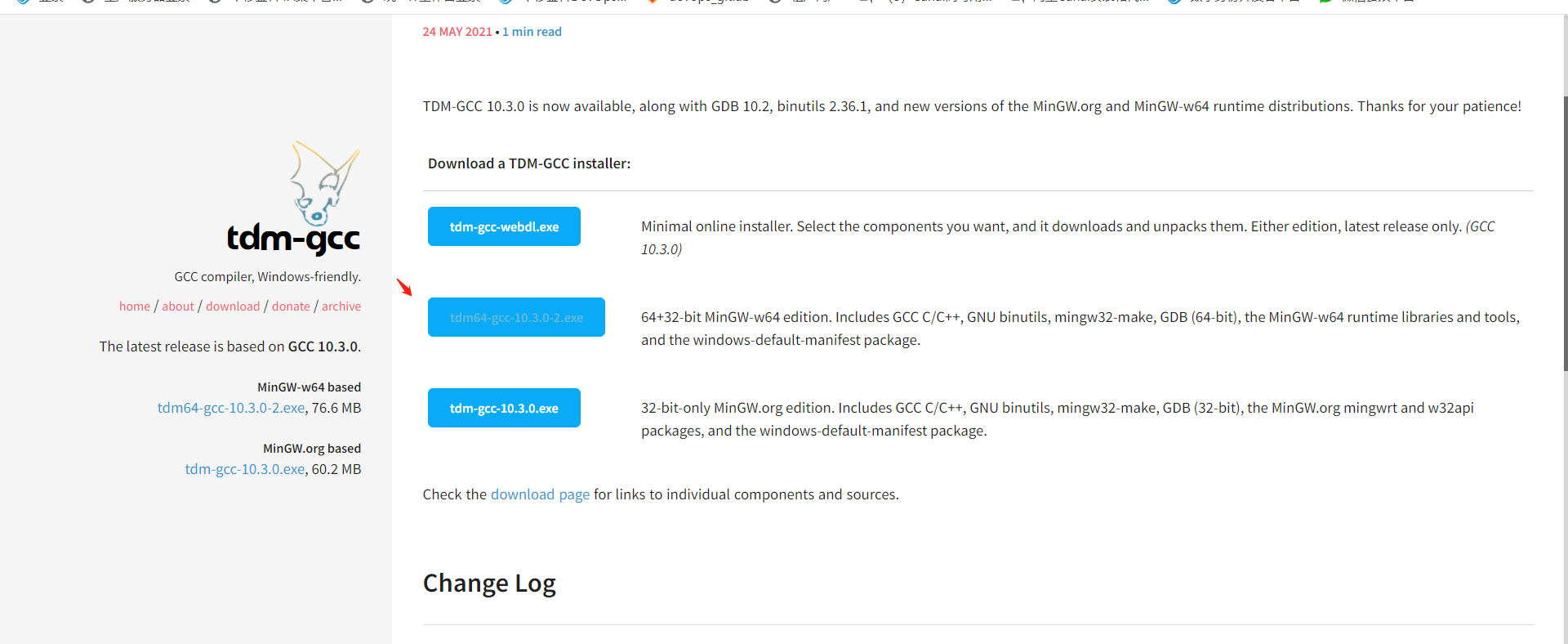

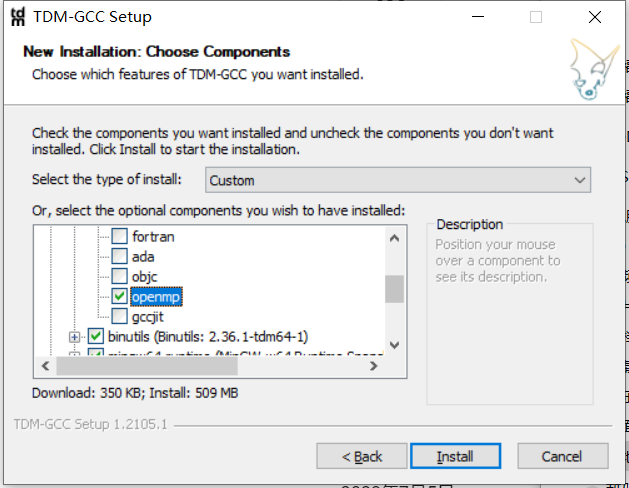

2、安装gcc 与 openmp

如果需要在 cpu 上运行量化后的模型,还需要安装 gcc 与 openmp。多数 Linux 发行版默认已安装。对于 Windows 可在安装TMD-GCC时勾选 openmp。 Windows 测试环境 gcc 版本为 TDM-GCC 10.3.0, Linux 为 gcc 11.3.0。

TMD-GCC下载地址:https://jmeubank.github.io/tdm-gcc/

点击(Read more...) 选择下载

勾选openmp

3、下载ChatGLM-6B与安装依赖

下载源码:git clone https://github.com/THUDM/ChatGLM-6B

cd ChatGLM-6B

使用 pip 安装依赖:pip install -r requirements.txt,其中 transformers 库版本推荐为 4.27.1,但理论上不低于 4.23.1 即可。

4、下载模型

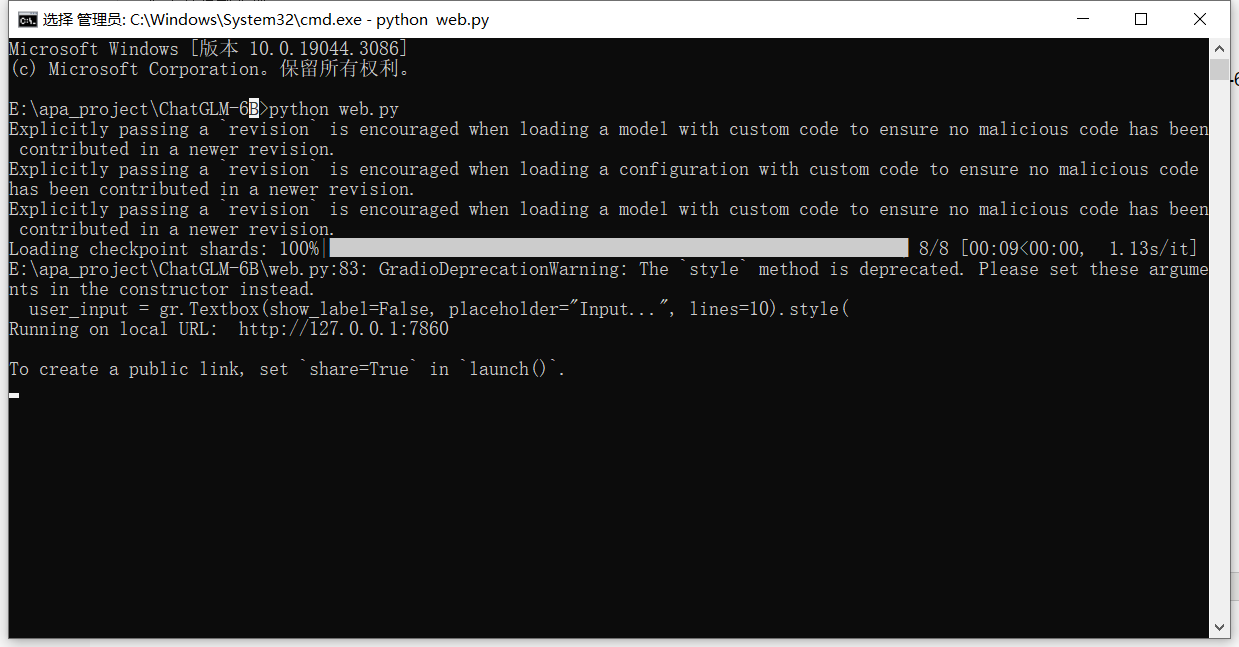

还在刚才 ChatGLM-6B 目录下,在资源管理器,地址栏里敲CMD,敲回车,启动命令提示行窗口,输入以下命令:

git clone https://huggingface.co/THUDM/chatglm-6b

这个下载内容有十几个GB,不要关闭CMD窗口。

如果你从 Hugging Face Hub 上下载 checkpoint 的速度较慢,可以只下载模型实现:

浙公网安备 33010602011771号

浙公网安备 33010602011771号