Canal初步接触

一、简介

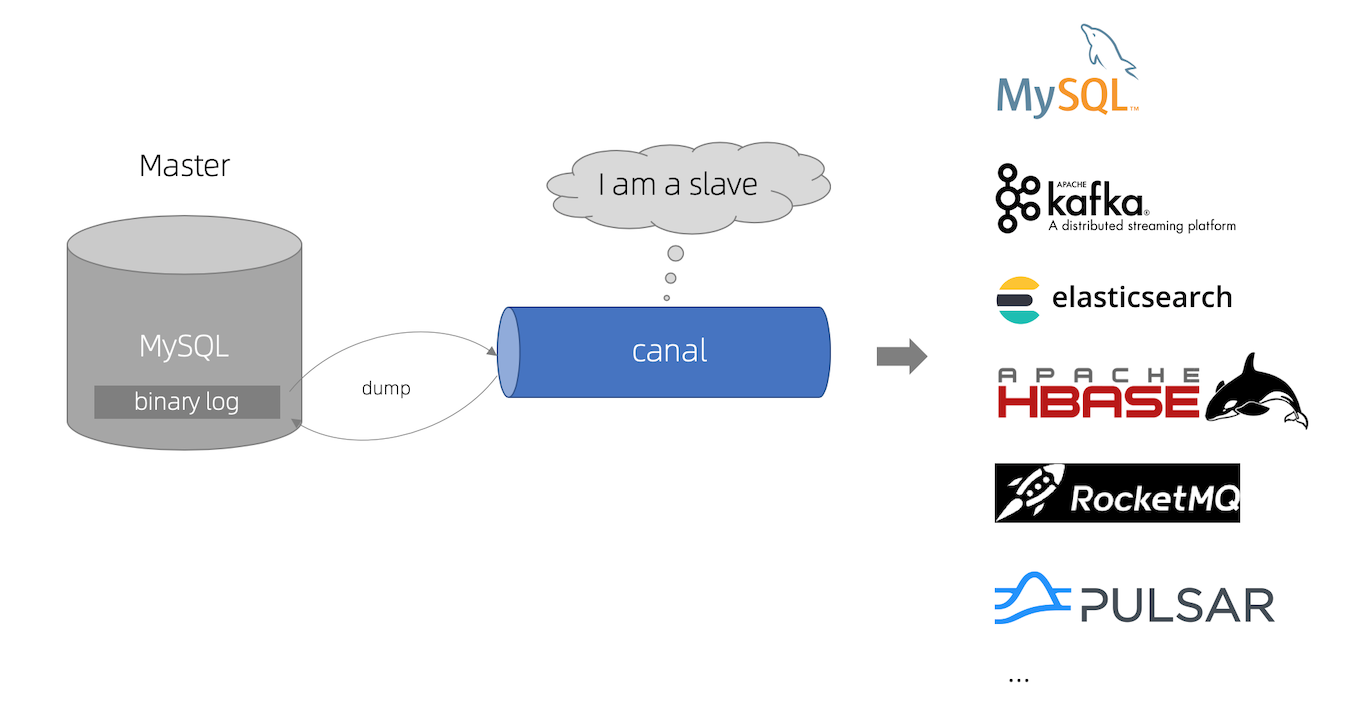

canal [kə'næl],译意为水道/管道/沟渠,主要用途是基于 MySQL 数据库增量日志解析,提供增量数据订阅和消费

早期阿里巴巴因为杭州和美国双机房部署,存在跨机房同步的业务需求,实现方式主要是基于业务 trigger 获取增量变更。从 2010 年开始,业务逐步尝试数据库日志解析获取增量变更进行同步,由此衍生出了大量的数据库增量订阅和消费业务。

基于日志增量订阅和消费的业务包括:

- 数据库镜像

- 数据库实时备份

- 索引构建和实时维护(拆分异构索引、倒排索引等)

- 业务 cache 刷新

- 带业务逻辑的增量数据处理

当前的 canal 支持源端 MySQL 版本包括 5.1.x , 5.5.x , 5.6.x , 5.7.x , 8.0.x

工作原理

MySQL主备复制原理

- MySQL master 将数据变更写入二进制日志( binary log, 其中记录叫做二进制日志事件binary log events,可以通过 show binlog events 进行查看)

- MySQL slave 将 master 的 binary log events 拷贝到它的中继日志(relay log)

- MySQL slave 重放 relay log 中事件,将数据变更反映它自己的数据

canal 工作原理

- canal 模拟 MySQL slave 的交互协议,伪装自己为 MySQL slave ,向 MySQL master 发送dump 协议

- MySQL master 收到 dump 请求,开始推送 binary log 给 slave (即 canal )

- canal 解析 binary log 对象(原始为 byte 流)

二、单机实例

准备

对于自建 MySQL , 需要先开启 Binlog 写入功能,配置 binlog-format 为 ROW 模式,my.cnf 中配置如下:

[mysqld]

log-bin=mysql-bin # 开启 binlog

binlog-format=ROW # 选择 ROW 模式

server_id=1 # 配置 MySQL replaction 需要定义,不要和 canal 的 slaveId 重复

授权 canal 链接 MySQL 账号具有作为 MySQL slave 的权限, 如果已有账户可直接 grant:

CREATE USER canal IDENTIFIED BY 'canal';

GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%';

-- GRANT ALL PRIVILEGES ON *.* TO 'canal'@'%' ;

FLUSH PRIVILEGES;

启动

下载 canal, 访问 release 页面 , 选择需要的包下载, 如以 1.0.17 版本为例:

wget https://github.com/alibaba/canal/releases/download/canal-1.0.17/canal.deployer-1.0.17.tar.gz

解压:

mkdir /tmp/canal

tar zxvf canal.deployer-$version.tar.gz -C /tmp/canal

解压后目录文件:

canal1.1.5

├── bin

│ │── restart.sh # 重启

│ │── startup.sh # 启动canal

│ │── stop.sh # 停止canal

│ └── ...

├── conf

│ │── canal.properties # 配置文件

│ │── example

│ │ ├── h2.mv.db

│ │ ├── instance.properties # 实例配置文件

│ │ └── meta.dat

│ │── logback.xml

│ └── ...

├── lib

├── logs

│ ├── canal

│ │ ├── canal.log

│ │ └── canal_stdout.log

│ └── example

│ ├── meta.log

│ └── example.log

└── plugin

修改配置文件:

vi conf/example/instance.properties

## mysql serverId

canal.instance.mysql.slaveId = 1234

#position info,需要改成自己的数据库信息

canal.instance.master.address=192.168.184.129:3306

canal.instance.master.journal.name=mysql-bin.000005

canal.instance.master.position=988

canal.instance.master.timestamp=1660901056

#canal.instance.standby.address =

#canal.instance.standby.journal.name =

#canal.instance.standby.position =

#canal.instance.standby.timestamp =

#username/password,需要改成自己的数据库信息

canal.instance.dbUsername = canal

canal.instance.dbPassword = canal

canal.instance.connectionCharset = UTF-8

#table regex

canal.instance.filter.regex = .\*\\\\..\*

配置说明

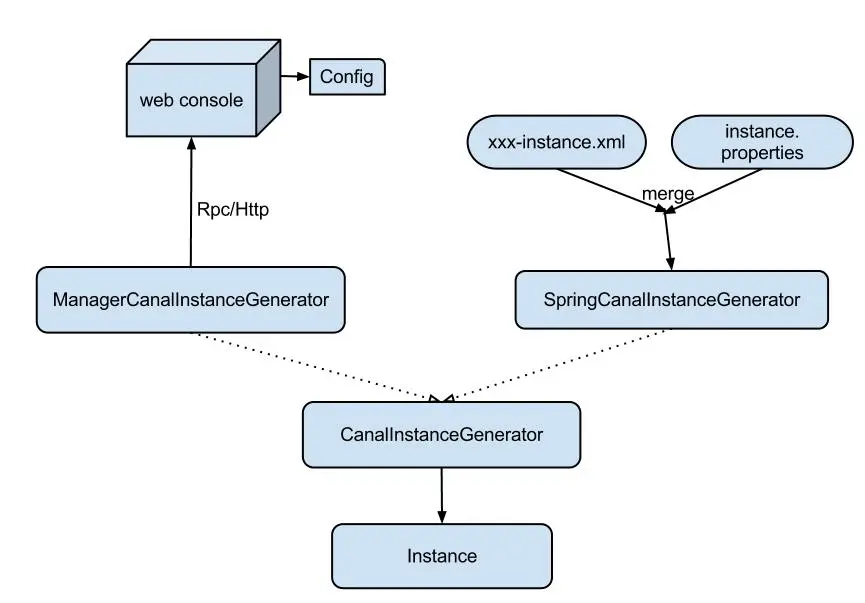

介绍配置之前,先了解下canal的配置加载方式:

ManagerCanalInstanceGenerator:基于manager管理的配置方式,目前alibaba内部配置使用这种方式。可以通过实现CanalConfigClient,连接各自的管理系统,即可完成接入。

SpringCanalInstanceGenerator:基于本地spring xml的配置方式,目前开源版本已经自带该功能所有代码,建议使用

Spring配置

spring配置的原理是将整个配置抽象为两部分:

xxxx-instance.xml (canal组件的配置定义,可以在多个instance配置中共享) xxxx.properties (每个instance通道都有各自一份定义,因为每个msql的ip,帐号,密码等信息不会相同)

通过spring的PropertyPlaceholderConfigurer通过机制将其融合,生成一份instance实例对象,每个instance对应的组件都是相互独立的,互不影响

properties配置文件

properties配置分为两部分:

canal.properties (系统根配置文件) instance.properties (instance级别的配置文件,每个instance一份)

canal.properties介绍:

canal配置主要分为两部分定义:

1. instance列表定义 (列出当前server上有多少个instance,每个instance的加载方式是spring/manager等)

| 参数名字 | 参数说明 | 默认值 |

|---|---|---|

| canal.destinations | 当前server上部署的instance列表 | 无 |

| canal.conf.dir | conf/目录所在的路径 | ../conf |

| canal.auto.scan | 开启instance自动扫描 如果配置为true,canal.conf.dir目录下的instance配置变化会自动触发: a. instance目录新增: 触发instance配置载入,lazy为true时则自动启动 b. instance目录删除:卸载对应instance配置,如已启动则进行关闭 c. instance.properties文件变化:reload instance配置,如已启动自动进行重启操作 |

true |

| canal.auto.scan.interval | instance自动扫描的间隔时间,单位秒 | 5 |

| canal.instance.global.mode | 全局配置加载方式 | spring |

| canal.instance.global.lazy | 全局lazy模式 | false |

| canal.instance.global.manager.address | 全局的manager配置方式的链接信息 | 无 |

| canal.instance.global.spring.xml | 全局的spring配置方式的组件文件 | classpath:spring/file-instance.xml (spring目录相对于canal.conf.dir) |

| canal.instance.example.mode canal.instance.example.lazy canal.instance.example.spring.xml ….. |

instance级别的配置定义,如有配置,会自动覆盖全局配置定义模式 命名规则:canal.instance.{name}.xxx |

无 |

2. common参数定义,比如可以将instance.properties的公用参数,抽取放置到这里,这样每个instance启动的时候就可以共享. 【instance.properties配置定义优先级高于canal.properties】

| 参数名字 | 参数说明 | 默认值 |

|---|---|---|

| canal.id | 每个canal server实例的唯一标识,暂无实际意义 | 1 |

| canal.ip | canal server绑定的本地IP信息,如果不配置,默认选择一个本机IP进行启动服务 | 无 |

| canal.port | canal server提供socket服务的端口 | 11111 |

| canal.zkServers | canal server链接zookeeper集群的链接信息 例子:127.0.0.1:2181,127.0.0.1:2182 |

无 |

| canal.zookeeper.flush.period | canal持久化数据到zookeeper上的更新频率,单位毫秒 | 1000 |

| canal.file.data.dir | canal持久化数据到file上的目录 | ../conf (默认和instance.properties为同一目录,方便运维和备份) |

| canal.file.flush.period | canal持久化数据到file上的更新频率,单位毫秒 | 1000 |

| canal.instance.memory.batch.mode | canal内存store中数据缓存模式 1. ITEMSIZE : 根据buffer.size进行限制,只限制记录的数量 2. MEMSIZE : 根据buffer.size * buffer.memunit的大小,限制缓存记录的大小 |

MEMSIZE |

| canal.instance.memory.buffer.size | canal内存store中可缓存buffer记录数,需要为2的指数 | 16384 |

| canal.instance.memory.buffer.memunit | 内存记录的单位大小,默认1KB,和buffer.size组合决定最终的内存使用大小 | 1024 |

| canal.instance.transactionn.size | 最大事务完整解析的长度支持超过该长度后,一个事务可能会被拆分成多次提交到canal store中,无法保证事务的完整可见性 | 1024 |

| canal.instance.fallbackIntervalInSeconds | canal发生mysql切换时,在新的mysql库上查找binlog时需要往前查找的时间,单位秒 说明:mysql主备库可能存在解析延迟或者时钟不统一,需要回退一段时间,保证数据不丢 |

60 |

| canal.instance.detecting.enable | 是否开启心跳检查 | false |

| canal.instance.detecting.sql | 心跳检查sql | insert into retl.xdual values(1,now()) on duplicate key update x=now() |

| canal.instance.detecting.interval.time | 心跳检查频率,单位秒 | 3 |

| canal.instance.detecting.retry.threshold | 心跳检查失败重试次数 | 3 |

| canal.instance.detecting.heartbeatHaEnable | 心跳检查失败后,是否开启自动mysql自动切换 说明:比如心跳检查失败超过阀值后,如果该配置为true,canal就会自动链到mysql备库获取binlog数据 |

false |

| canal.instance.network.receiveBufferSize | 网络链接参数,SocketOptions.SO_RCVBUF | 16384 |

| canal.instance.network.sendBufferSize | 网络链接参数,SocketOptions.SO_SNDBUF | 16384 |

| canal.instance.network.soTimeout | 网络链接参数,SocketOptions.SO_TIMEOUT | 30 |

| canal.instance.filter.query.dcl | 是否忽略DCL的query语句,比如grant/create user等 | false |

| canal.instance.filter.query.dml | 是否忽略DML的query语句,比如insert/update/delete table.(mysql5.6的ROW模式可以包含statement模式的query记录) | false |

| canal.instance.filter.query.ddl | 是否忽略DDL的query语句,比如create table/alater table/drop table/rename table/create index/drop index. (目前支持的ddl类型主要为table级别的操作,create databases/trigger/procedure暂时划分为dcl类型) | false |

| canal.instance.get.ddl.isolation | ddl语句是否隔离发送,开启隔离可保证每次只返回发送一条ddl数据,不和其他dml语句混合返回.(otter ddl同步使用) | false |

instance.properties介绍:

a. 在canal.properties定义了canal.destinations后,需要在canal.conf.dir对应的目录下建立同名的文件

比如:

这时需要创建example1和example2两个目录,每个目录里各自有一份instance.properties.

ps. canal自带了一份instance.properties demo,可直接复制conf/example目录进行配置修改

cp -R example example1/cp -R example example2/b. 如果canal.properties未定义instance列表,但开启了canal.auto.scan时

server第一次启动时,会自动扫描conf目录下,将文件名做为instance name,启动对应的instance server运行过程中,会根据canal.auto.scan.interval定义的频率,进行扫描

发现目录有新增,启动新的instance 发现目录有删除,关闭老的instance 发现对应目录的instance.properties有变化,重启instance

一个标准的conf目录结果:

| 数名字 | 参数说明 | 默认值 |

|---|---|---|

| canal.instance.mysql.slaveId | mysql集群配置中的serverId概念,需要保证和当前mysql集群中id唯一 | 1234 |

| canal.instance.master.address | mysql主库链接地址 | 127.0.0.1:3306 |

| canal.instance.master.journal.name | mysql主库链接时起始的binlog文件 | 无 |

| canal.instance.master.position | mysql主库链接时起始的binlog偏移量 | 无 |

| canal.instance.master.timestamp | mysql主库链接时起始的binlog的时间戳 | 无 |

| canal.instance.dbUsername | mysql数据库帐号 | canal |

| canal.instance.dbPassword | mysql数据库密码 | canal |

| canal.instance.defaultDatabaseName | mysql链接时默认schema | |

| canal.instance.connectionCharset mysql 数据解析编码 | UTF-8 | |

| canal.instance.filter.regex | mysql 数据解析关注的表,Perl正则表达式.多个正则之间以逗号(,)分隔,转义符需要双斜杠(\\) 常见例子: 1. 所有表:.* or .*\\..* 2. canal schema下所有表: canal\\..* 3. canal下的以canal打头的表:canal\\.canal.* 4. canal schema下的一张表:canal.test1 5. 多个规则组合使用:canal\\..*,mysql.test1,mysql.test2 (逗号分隔) 注意:此过滤条件只针对row模式的数据有效(ps. mixed/statement因为不解析sql,所以无法准确提取tableName进行过滤) |

.*\\..* |

几点说明:

mysql链接时的起始位置

canal.instance.master.journal.name + canal.instance.master.position : 精确指定一个binlog位点,进行启动 canal.instance.master.timestamp : 指定一个时间戳,canal会自动遍历mysql binlog,找到对应时间戳的binlog位点后,进行启动不指定任何信息:默认从当前数据库的位点,进行启动。(show master status)

mysql解析关注表定义

标准的Perl正则,注意转义时需要双斜杠:\\

mysql链接的编码

目前canal版本仅支持一个数据库只有一种编码,如果一个库存在多个编码,需要通过filter.regex配置,将其拆分为多个canal instance,为每个instance指定不同的编码

instance.xml配置文件

目前默认支持的instance.xml有以下几种:

spring/memory-instance.xml spring/file-instance.xml spring/default-instance.xml spring/group-instance.xml

在介绍instance配置之前,先了解一下canal如何维护一份增量订阅&消费的关系信息:

解析位点 (parse模块会记录,上一次解析binlog到了什么位置,对应组件为:CanalLogPositionManager) 消费位点 (canal server在接收了客户端的ack后,就会记录客户端提交的最后位点,对应的组件为:CanalMetaManager)

对应的两个位点组件,目前都有几种实现:

memory (memory-instance.xml中使用) zookeeper mixed file (file-instance.xml中使用,集合了file+memory模式,先写内存,定时刷新数据到本地file上) period (default-instance.xml中使用,集合了zookeeper+memory模式,先写内存,定时刷新数据到zookeeper上)

memory-instance.xml介绍:

所有的组件(parser , sink , store)都选择了内存版模式,记录位点的都选择了memory模式,重启后又会回到初始位点进行解析 特点:速度最快,依赖最少(不需要zookeeper) 场景:一般应用在quickstart,或者是出现问题后,进行数据分析的场景,不应该将其应用于生产环境file-instance.xml介绍:

所有的组件(parser , sink , store)都选择了基于file持久化模式,注意,不支持HA机制. 特点:支持单机持久化 场景:生产环境,无HA需求,简单可用.default-instance.xml介绍:

所有的组件(parser , sink , store)都选择了持久化模式,目前持久化的方式主要是写入zookeeper,保证数据集群共享. 特点:支持HA 场景:生产环境,集群化部署.group-instance.xml介绍:

主要针对需要进行多库合并时,可以将多个物理instance合并为一个逻辑instance,提供客户端访问。 场景:分库业务。 比如产品数据拆分了4个库,每个库会有一个instance,如果不用group,业务上要消费数据时,需要启动4个客户端,分别链接4个instance实例。使用group后,可以在canal server上合并为一个逻辑instance,只需要启动1个客户端,链接这个逻辑instance即可.sh bin/startup.sh

查看server日志:

vi logs/canal/canal.log

查看instance 的日志:

vi logs/example/example.log

关闭:

sh bin/stop.sh

从头创建工程

依赖配置:

<dependency> <groupId>com.alibaba.otter</groupId> <artifactId>canal.client</artifactId> <version>1.1.0</version> </dependency>

ClientSample代码

public static void main(String args[]) { // 创建链接 CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress(AddressUtils.getHostIp(), 11111), "example", "", ""); int batchSize = 1000; int emptyCount = 0; try { connector.connect(); connector.subscribe(".*\\..*"); connector.rollback(); int totalEmptyCount = 120; while (emptyCount < totalEmptyCount) { Message message = connector.getWithoutAck(batchSize); // 获取指定数量的数据 long batchId = message.getId(); int size = message.getEntries().size(); if (batchId == -1 || size == 0) { emptyCount++; System.out.println("empty count : " + emptyCount); try { Thread.sleep(1000); } catch (InterruptedException e) { } } else { emptyCount = 0; // System.out.printf("message[batchId=%s,size=%s] \n", batchId, size); printEntry(message.getEntries()); } connector.ack(batchId); // 提交确认 // connector.rollback(batchId); // 处理失败, 回滚数据 } System.out.println("empty too many times, exit"); } finally { connector.disconnect(); } } private static void printEntry(List<Entry> entrys) { for (Entry entry : entrys) { if (entry.getEntryType() == EntryType.TRANSACTIONBEGIN || entry.getEntryType() == EntryType.TRANSACTIONEND) { continue; } RowChange rowChage = null; try { rowChage = RowChange.parseFrom(entry.getStoreValue()); } catch (Exception e) { throw new RuntimeException("ERROR ## parser of eromanga-event has an error , data:" + entry.toString(), e); } EventType eventType = rowChage.getEventType(); System.out.println(String.format("================> binlog[%s:%s] , name[%s,%s] , eventType : %s", entry.getHeader().getLogfileName(), entry.getHeader().getLogfileOffset(), entry.getHeader().getSchemaName(), entry.getHeader().getTableName(), eventType)); for (RowData rowData : rowChage.getRowDatasList()) { if (eventType == EventType.DELETE) { printColumn(rowData.getBeforeColumnsList()); } else if (eventType == EventType.INSERT) { printColumn(rowData.getAfterColumnsList()); } else { System.out.println("-------> before"); printColumn(rowData.getBeforeColumnsList()); System.out.println("-------> after"); printColumn(rowData.getAfterColumnsList()); } } } } private static void printColumn(List<Column> columns) { for (Column column : columns) { System.out.println(column.getName() + " : " + column.getValue() + " update=" + column.getUpdated()); } }

Simple客户端例子:SimpleCanalClientTest

浙公网安备 33010602011771号

浙公网安备 33010602011771号