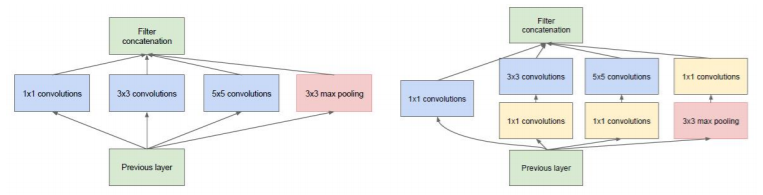

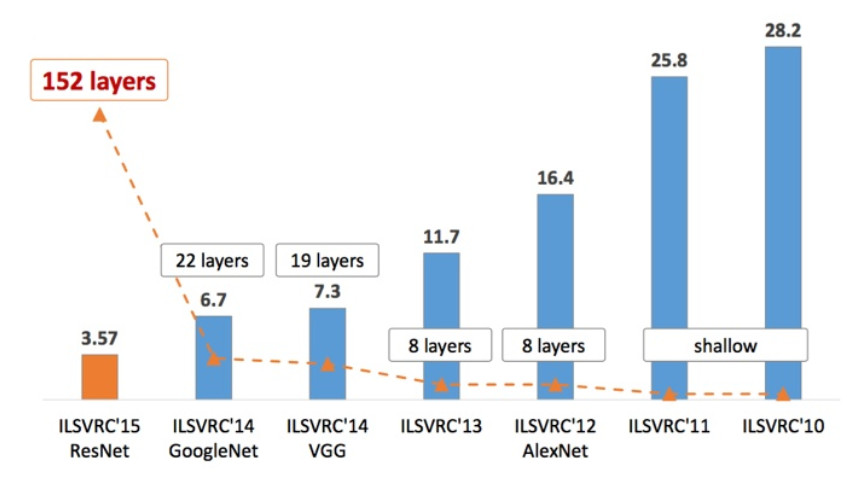

ILSVRC比赛带来的算法

李飞飞和它的团队搜集了ImageNet一个超过15 million的图像数据集,大约有22,000类。这个文件集合对深度卷积网络极大地推进深度学习各领域的发展.

ILSVRC是对ImageNet进行分类,检测,定位的比赛,作为最具影响力的竞赛它的作用功不可没,从中也促使了许多经典工作。

ImageNet的定位结果

| 年 | 网络/队名 | val top-5 | test top-5 | 备注 |

|---|---|---|---|---|

| 2012 | AlexNet | 34.19% | 多伦多大学Hinton和他学生 | |

| 2012 | AlexNet | 33.55% | 用了2011年的数据 | |

| 2013 | OverFeat | 30.0% | 29.87% | 纽约大学Lecun团队 |

| 2014 | GoogleNet | 26.44% | 谷歌 | |

| 2014 | VGG | 26.9% | 25.32% | 牛津大学 |

| 2015 | ResNet | 8.9% | 9.02% | 微软 |

| 2016 | Trimps-Soushen | 7.71% | 公安三所,以Inception, resNet, WRN等为基础 | |

| 2017 | DPN | 6.23% | 新加坡国立大学与奇虎360 |

ImageNet的检测结果

| 网络/队名 | mAP(%) | 备注 | |

|---|---|---|---|

| 2013 | OverFeat | 19.40 | 使用了12年的分类数据预训练 |

| 2013 | UvA | 22.58 | |

| 2013 | OverFeat | 24.3 | 赛后。使用了12年的分类数据预训练 |

| 2014 | GoogleNet | 43.93 | R-CNN |

| 2015 | ResNet | 62.07 | Faster R-CNN |

| 2016 | CUImage | 66.28 | 商汤和港中文,以GBD-Net等为基础 |

| 2017 | BDAT | 73.41 | 南京信息工程大学和帝国理工学院 |

ImageNet的分类结果

| 网络/队名 | val top-1 | val top-5 | test top-5 | 备注 | |

|---|---|---|---|---|---|

| 2012 | AlexNet | 38.1% | 16.4% | 16.42% | 5 CNNs |

| 2012 | AlexNet | 36.7% | 15.4% | 15.32% | 7CNNs。用了2011年的数据 |

| 2013 | OverFeat | 14.18% | 7 fast models | ||

| 2013 | OverFeat | 13.6% | 赛后。7 big models | ||

| 2013 | ZFNet | 13.51% | ZFNet论文上的结果是14.8 | ||

| 2013 | Clarifai | 11.74% | |||

| 2013 | Clarifai | 11.20% | 用了2011年的数据 | ||

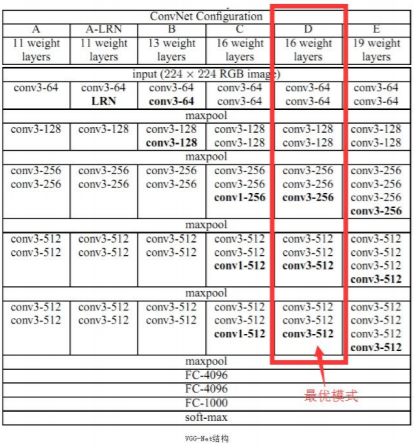

| 2014 | VGG | 7.32% | 7 nets, dense eval | ||

| 2014 | VGG(亚军) | 23.7% | 6.8% | 6.8% | 赛后。2 nets |

| 2014 | GoogleNet v1 | 6.67% | 7 nets, 144 crops | ||

| GoogleNet v2 | 20.1% | 4.9% | 4.82% | 赛后。6 nets, 144 crops | |

| GoogleNet v3 | 17.2% | 3.58% | 赛后。4 nets, 144 crops | ||

| GoogleNet v4 | 16.5% | 3.1% | 3.08% | 赛后。v4+Inception-Res-v2 | |

| 2015 | ResNet | 3.57% | 6 models | ||

| 2016 | Trimps-Soushen | 2.99% | 公安三所 | ||

| 2016 | ResNeXt(亚军) | 3.03% | 加州大学圣地亚哥分校 | ||

| 2017 | SENet | 2.25% | Momenta 与牛津大学 |

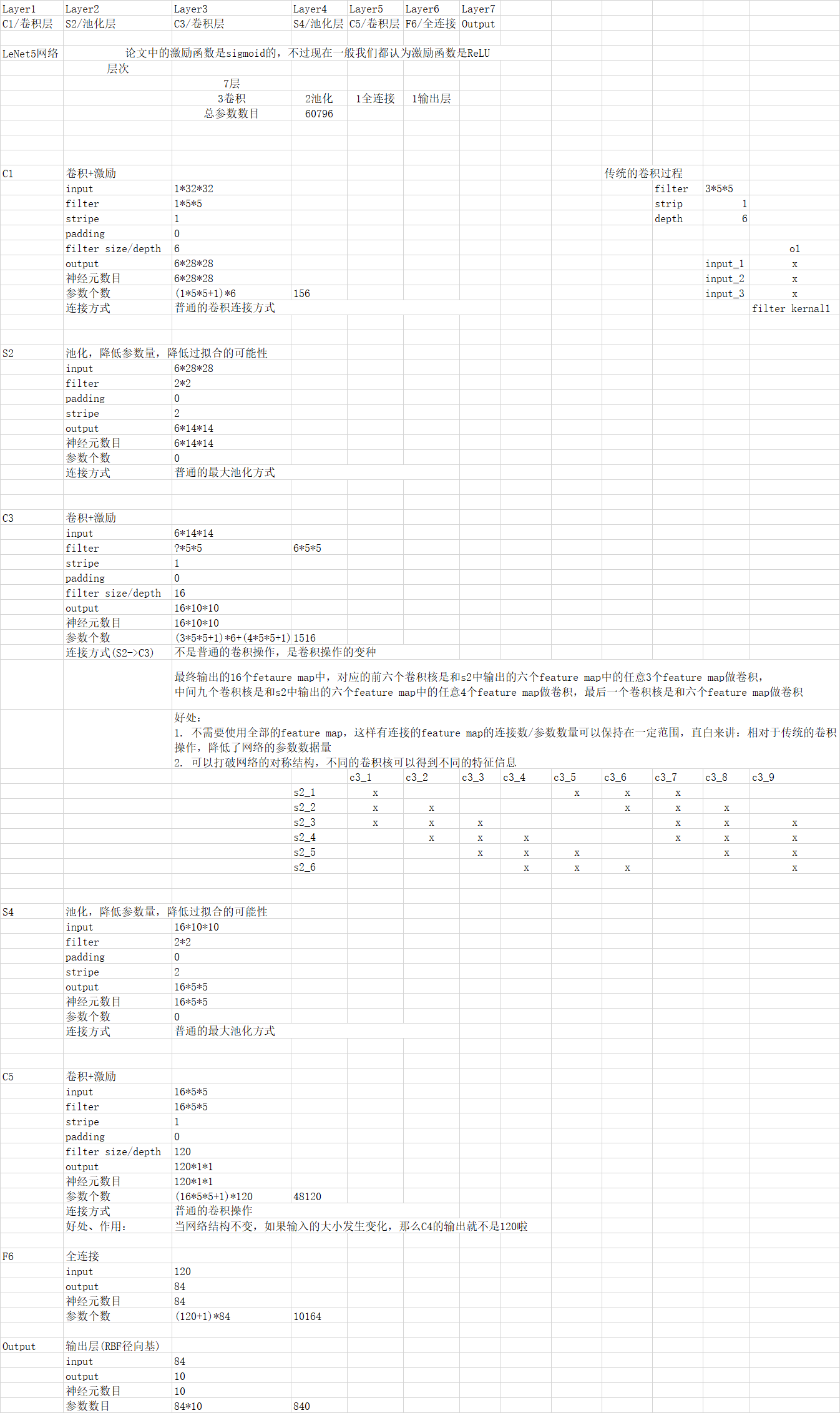

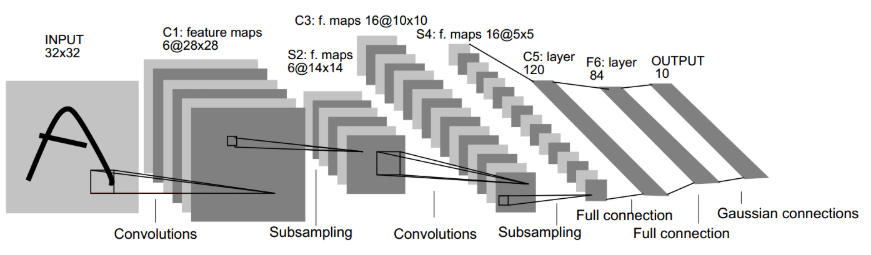

首先诞生的是,1986年:

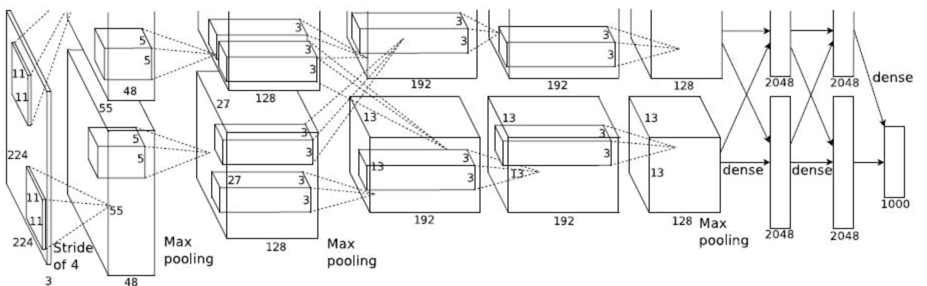

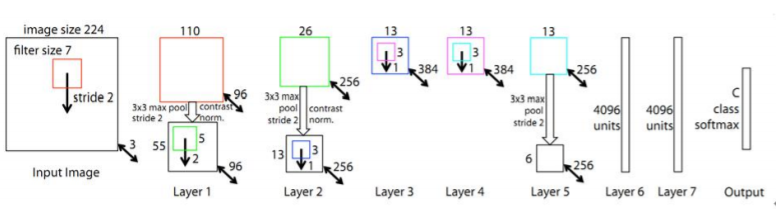

到了2012年:

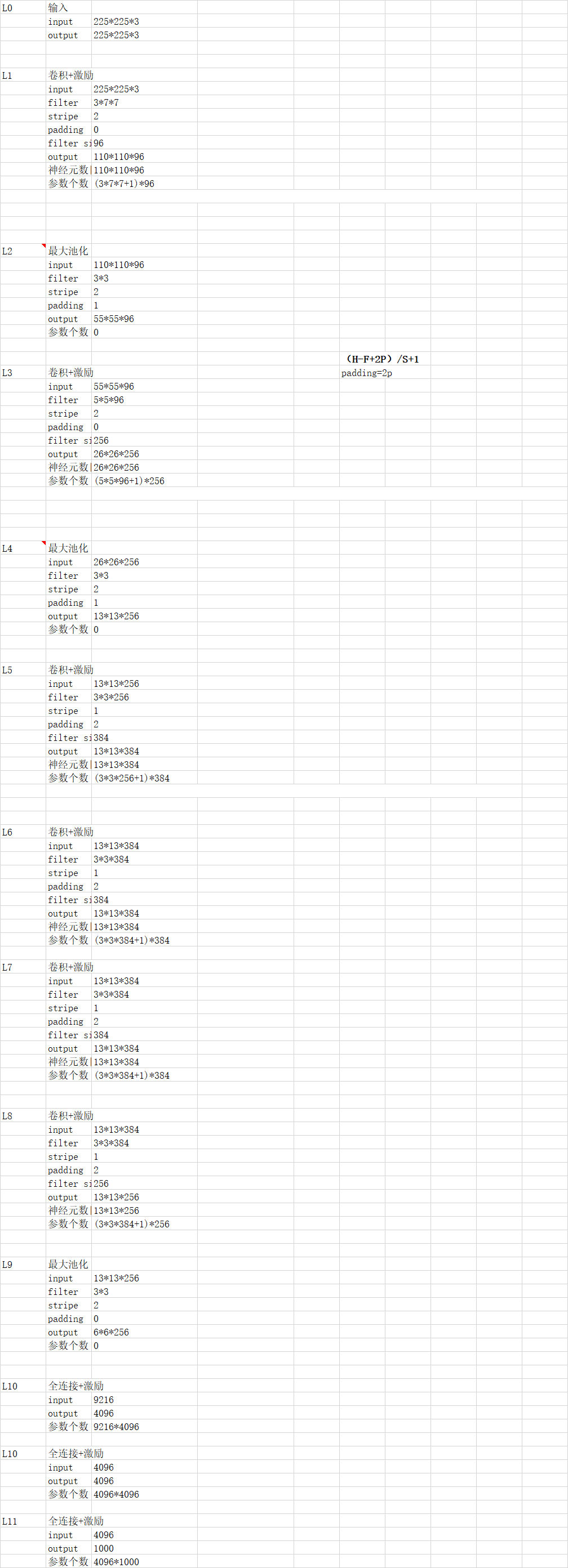

AlexNet结构优化 非线性激活函数:

ReLU 防止过拟合的方法:Dropout,Data augmentation(数据增强)

大数据训练:百万级ImageNet图像数据

GPU实现:在每个GPU中放置一半核(或神经元),还有一个额外的技巧: GPU间的通讯只在某些层进行。

LRN归一化:本质上,这个层也是为了防止激活函数的饱和的。

再到后来该进了alex后出来了ZFNet:

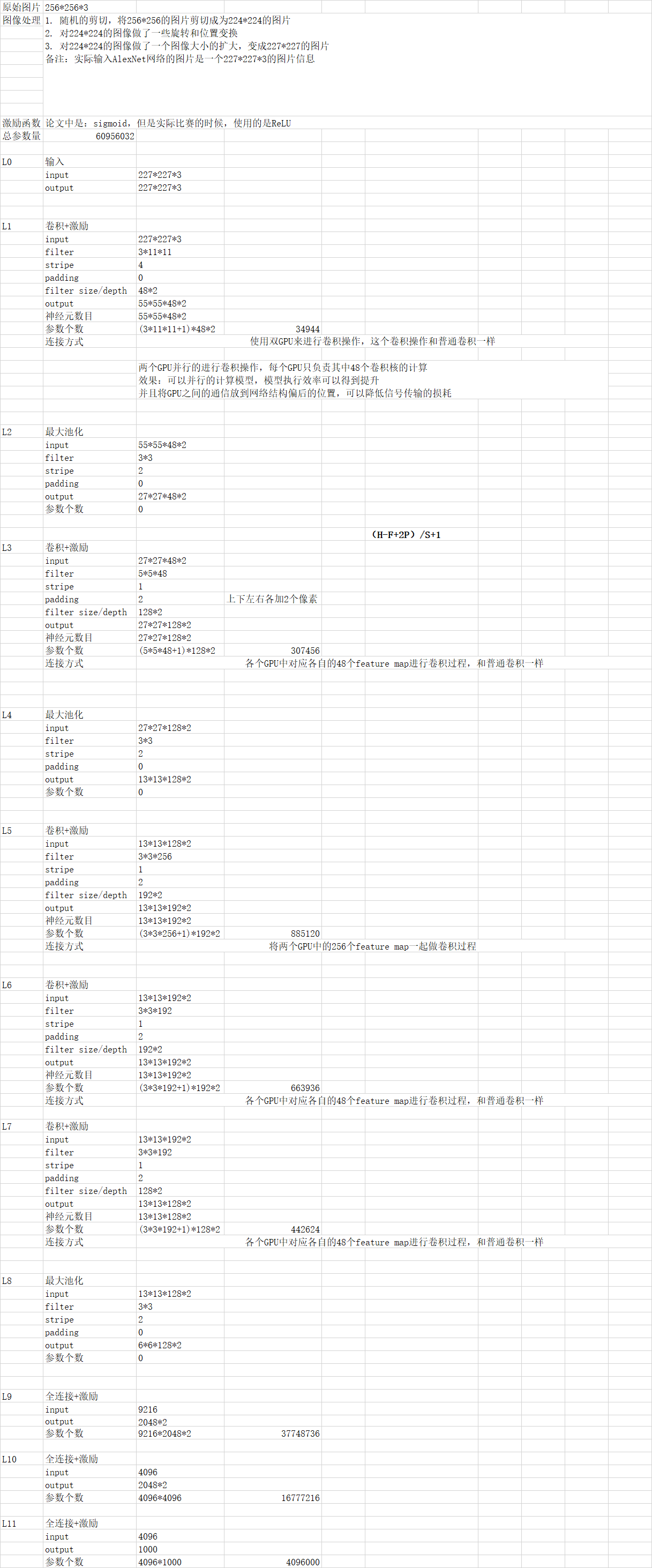

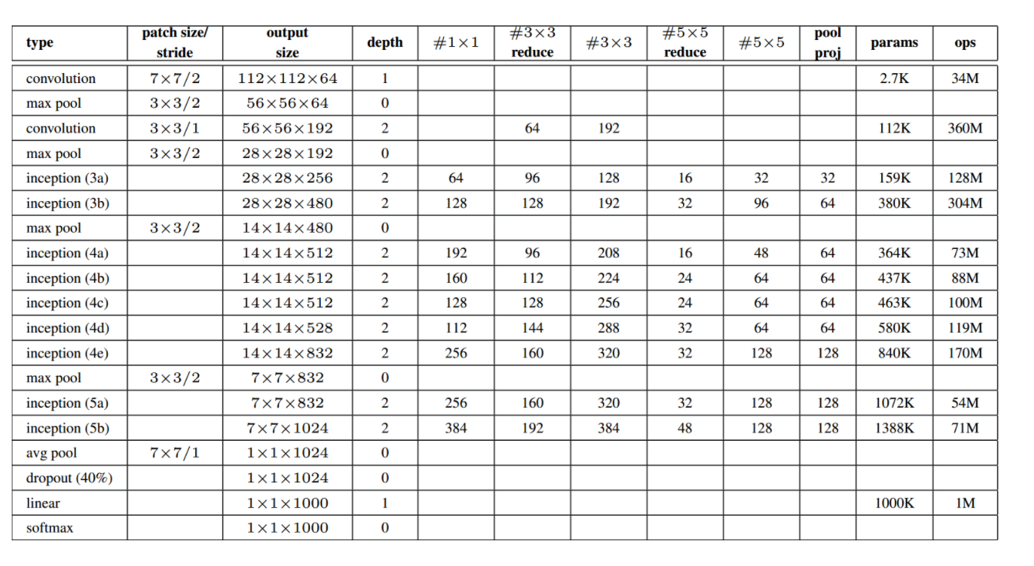

GoogleNet中的特殊结构Interception:

Inception架构的主要思想是找出如何让已有的稠密组件接近与覆盖卷积视觉网络中的最佳局 部稀疏结构。

为了避免patch校准问题,现在的滤波器大小限制在1x1,3x3和5x5,主要是为了方便,不是 必要的。

另外,在pooling层添加一个额外的并行pooling路径用于提高效率。

架构的第二个主要思想:在计算要求增加很多的地方应用维度缩减 和预测。即,在3x3和5x5的卷积前用一个1x1的卷积用于减少计算, 还用于修正线性激活。如下图所示,左边是加入维度缩减之前的, 右边是加入维度缩减之后的。

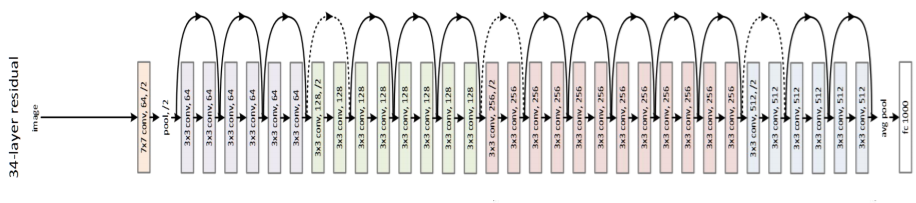

ResNet

ILSVRC2015冠军,比VGG深8倍,超深网络, 最高可以达到152层;引入残差结构,更改 参数w的修改规则;top-5错误率3.6%;参 数更新中使用到RNN的思想。

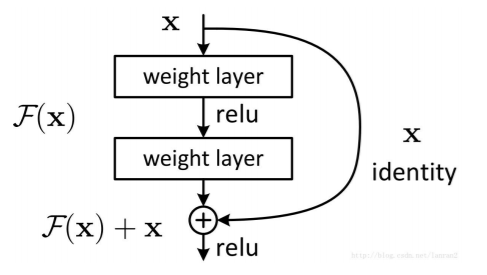

ResNet中特殊的结构:

连接方式叫做“shortcut connection” ,顾名思义, shortcut就是“抄近道”的意思。

浙公网安备 33010602011771号

浙公网安备 33010602011771号