scala打包jar并在Linux下运行

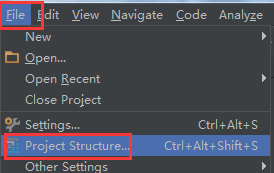

打开

File -> Project Structure

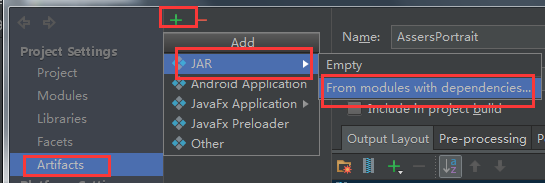

Artifacts -> + -> jar -> From Modules with dependisies...

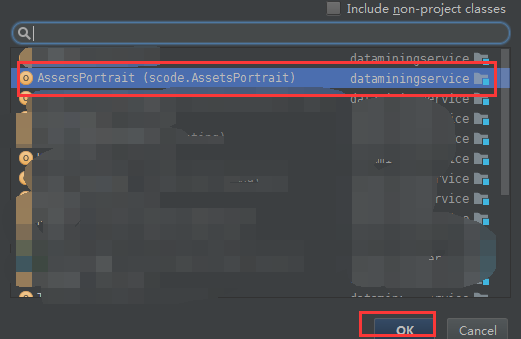

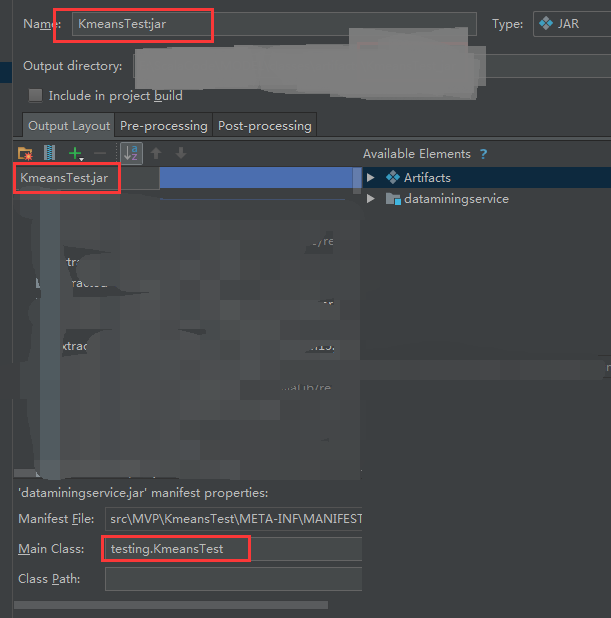

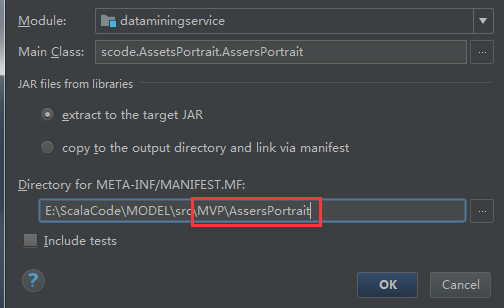

选择需要打包的文件的 Main 函数所在路径文件:

Main Class -> Ok

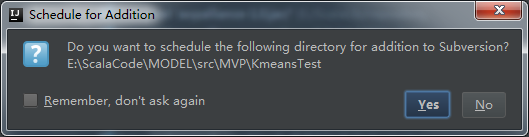

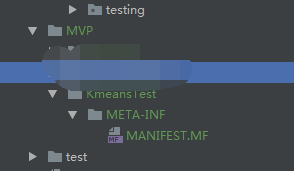

新建一个文件夹用于存放 .MP 文件,而且新建的文件夹一定要在 src 目录下!

然后 yes

更改 jar 包的名字,然后 Apply:

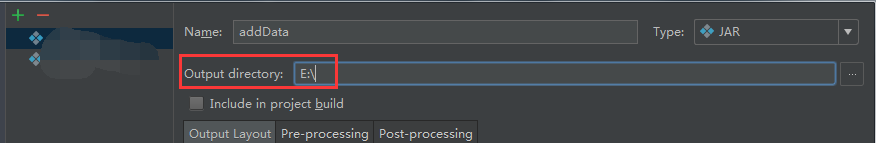

切记这里还有一个位置是存放打包完成后的 jar 存放位置 Output Directory :

可以看到出现了新的文件夹和文件:

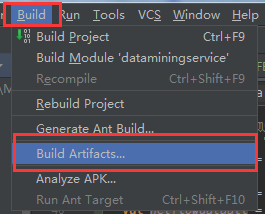

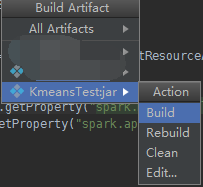

build -> build artifacts

第一次建立选择 build :

下一次修改的时候就直接 rebuild 就可以了

将其传输到 Linux 目录下,运行命令删除不必要的文件:

zip -d 你的jar名字.jar META-INF/*.RSA META-INF/*.DSA META-INF/*.SF

然后输入命令运行:

bash spark-submit --class MF字段 你的jar名字.jar

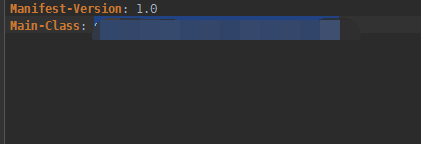

其中 MF字段 为你的 MF 文件中的 Main-Class :

如果出现错误:

请自行添加 bash 的环境变量

或者命令:

/usr/spark/spark-2.0.2-bin-hadoop2.6/bin/spark-submit --class MF字段 /jarPath/name.jar

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】博客园社区专享云产品让利特惠,阿里云新客6.5折上折

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· DeepSeek 解答了困扰我五年的技术问题

· 为什么说在企业级应用开发中,后端往往是效率杀手?

· 用 C# 插值字符串处理器写一个 sscanf

· Java 中堆内存和栈内存上的数据分布和特点

· 开发中对象命名的一点思考

· PPT革命!DeepSeek+Kimi=N小时工作5分钟完成?

· What?废柴, 还在本地部署DeepSeek吗?Are you kidding?

· DeepSeek企业级部署实战指南:从服务器选型到Dify私有化落地

· 程序员转型AI:行业分析

· 重磅发布!DeepSeek 微调秘籍揭秘,一键解锁升级版全家桶,AI 玩家必备神器!