【Python3爬虫】第一个Scrapy项目

Python版本:3.5 IDE:Pycharm

今天跟着网上的教程做了第一个Scrapy项目,遇到了很多问题,花了很多时间终于解决了==

一、Scrapy终端(scrapy shell)

Scrapy终端是一个交互终端,供我们在未启动spider的情况下尝试及调试爬取代码。 其本意是用来测试提取数据的代码,不过我们可以将其作为正常的Python终端,在上面测试任何的Python代码。

在命令行界面输入scrapy shell <url>(这里的网址不需要加引号),例如:

scrapy shell https://www.huya.com/g/lol

接着该终端(使用Scrapy下载器(downloader))获取URL内容并打印可用的对象及快捷命令(注意到以[s] 开头的行):

fetch(request)- 从给定请求获取新响应,并相应地更新所有相关对象。view(response)- 在本地Web浏览器中打开给定的响应,以进行检查。这将向响应正文添加一个<base>标记,以便正确显示外部链接(如图片和样式表)。但请注意,这将在您的计算机中创建一个临时文件,不会自动删除。shelp()- 打印有可用对象和快捷方式列表的帮助

二、建立第一个Scrapy项目

选择一个文件夹,shift+右键然后进入命令行界面,输入以下代码新建一个Scrapy项目:

scrapy startproject HuyaLol

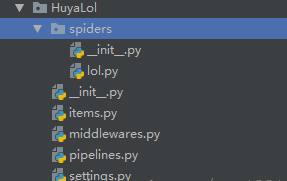

打开Pycharm,然后再打开我们刚建好的HuyaLol项目,在spiders文件夹下新建一个lol.py

然后就可以在lol.py里编写我们的程序了,代码如下:

然后在Pycharm里打开命令行界面,输入scrapy list可以列出当前爬虫项目下所有的爬虫文件,这里只有一个爬虫文件huyalol。

然后在命令行界面输入scrapy crawl huyalol,就可以运行我们的爬虫了,结果如下:

三、遇到的问题及解决办法

(1)利用xpath获取不到数据,反复检查代码之后,发现是引号出了问题

”//*[@id="js-live-list"]/li/a[2]/text()“

这里两端要用单引号,因为中间使用了双引号。

(2)根据教程上把@id="js-live-list"改成@class=“title new-clickstat”后获取不到数据,这个应该注意一下。

(3)在纠正上述问题后还是没有得到数据

解决办法:把settings.py里的ROBOTSTXT_OBEY = True改成ROBOTSTXT_OBEY = False

浙公网安备 33010602011771号

浙公网安备 33010602011771号