Windows下的PyCharm与Ubuntu下的Python的交互

实验环境:

Windows10

Ubuntu18.04

Pycharm2019.1.2(专业版)

Python3.6.5

1、在Windows下与Ubuntu下新建目录,作为两个环节之间的连接桥梁

1.1 在Windows下的D盘新建SparkProgram目录,具体的路径地址如下 D:\SparkProgram

1.2 在Ubuntu下新建SparkProgram目录,具体的路径地址如下/home/hadoop/SparkProgram

# 新建目录 $ sudo mkdir /home/hadoop/SparkProgram # 修改目录的所有者权限 $ sudo -R hadoop:hadoop /home/hadoop/SparkProgram

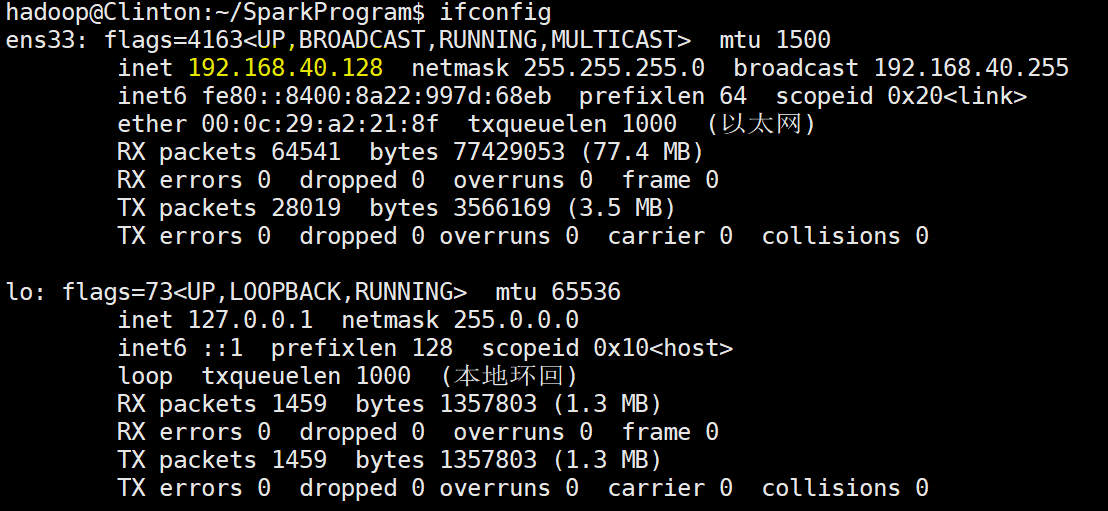

2、查看Ubuntu的网络环境以及python的版本

# 查看网络配置,获取IP地址 $ ifconfig $ whereis python # 查看当前的python安装情况,获得python执行目录

网络环境

Python安装情况

![]()

3、Pycharm的配置

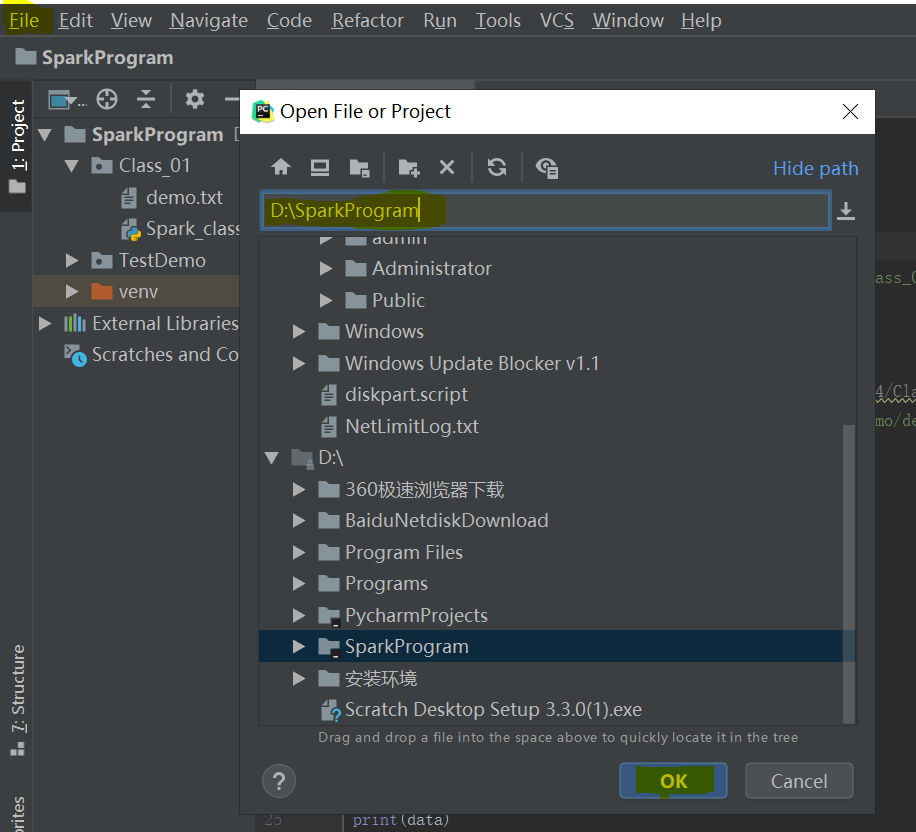

3.1、打开Pycharm,然后依次打开 File > Open ,找到 D:\SparkProgram 目录 并打开,如下

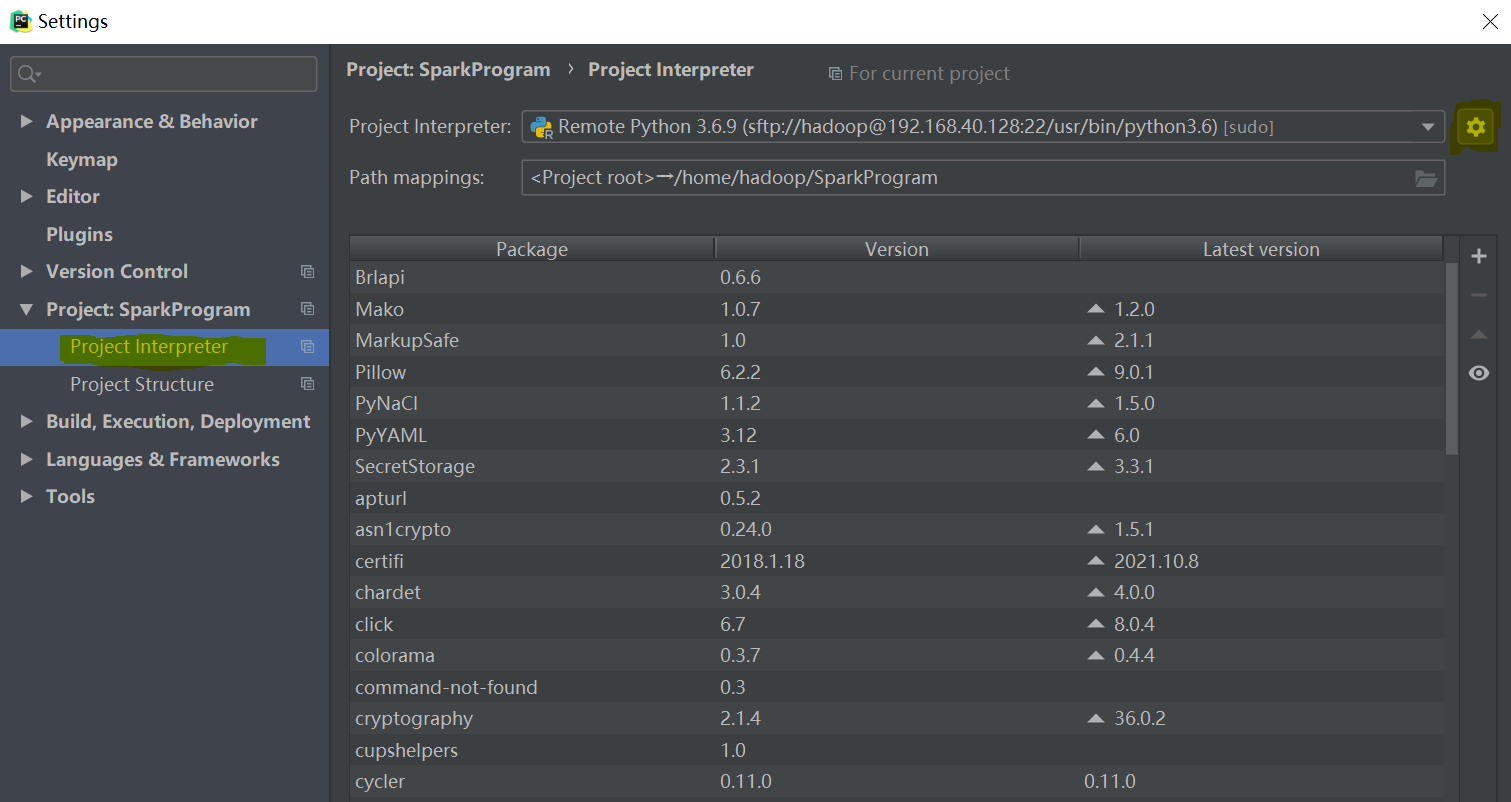

3.2 打开Pycharm,然后依次打开 File > setting ,然后在Project:SparkProgram下找到 Project Interpreter,打开当前界面下的设置(右侧小齿轮图标),并进行添加(Add)操作,如图:

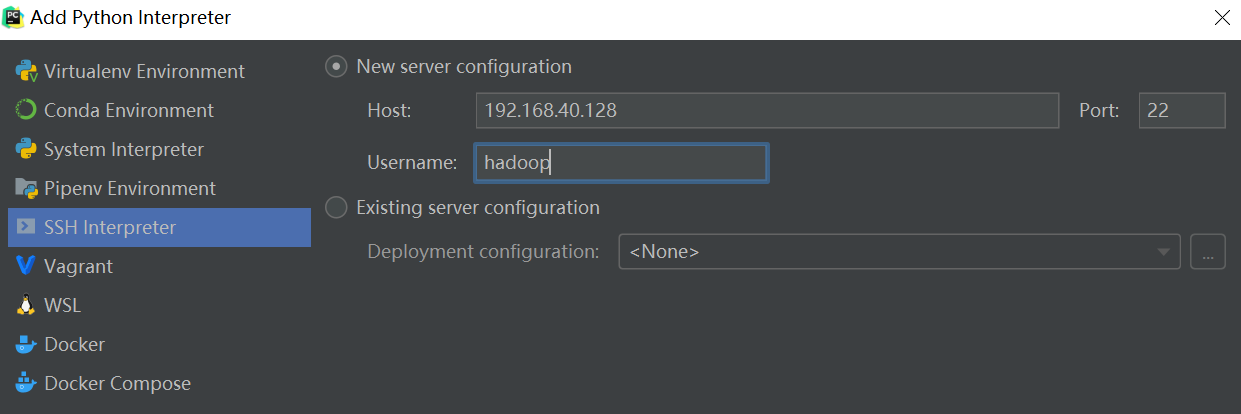

3.3 在新增的设置上,选择 SSH Interpreter 设置 , 通过第二步获取的IP地址以及Ubuntu的用户名进行参数设置,如下图

3.4 配置完成后进入下一步的配置,要求输入Ubuntu的密码,如下图:

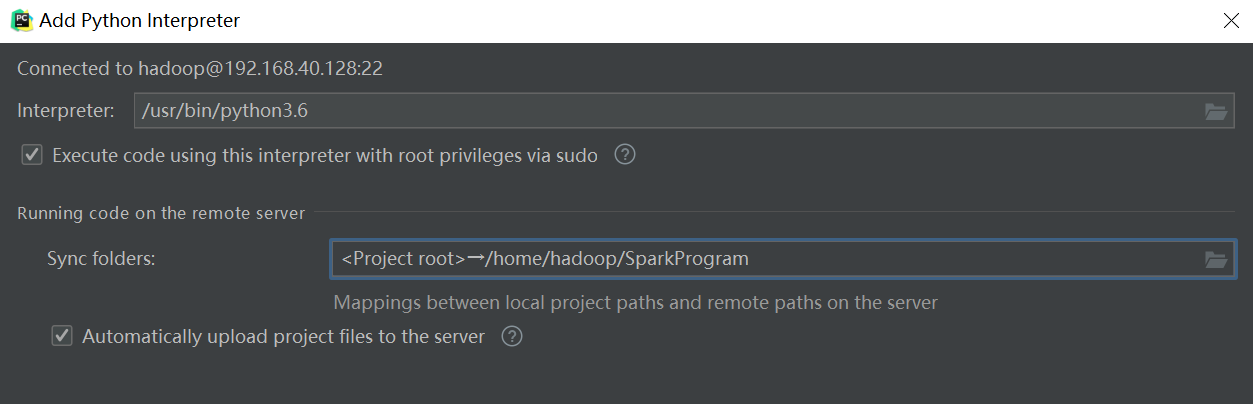

3.5 配置完成后,将进入Python编译器的配置以及映射目录的处理,在这一个过程中,依据第二步获取的python位置,以及第一步创建的映射目录进行处理,这里需要注意,在完成Python编译器的设置后,记得勾选 Execute code using this interpreter with root privileges via sudo 选项,这里关于目录映射的修改可以通过 Sysc foldres 右侧的文件图标进行

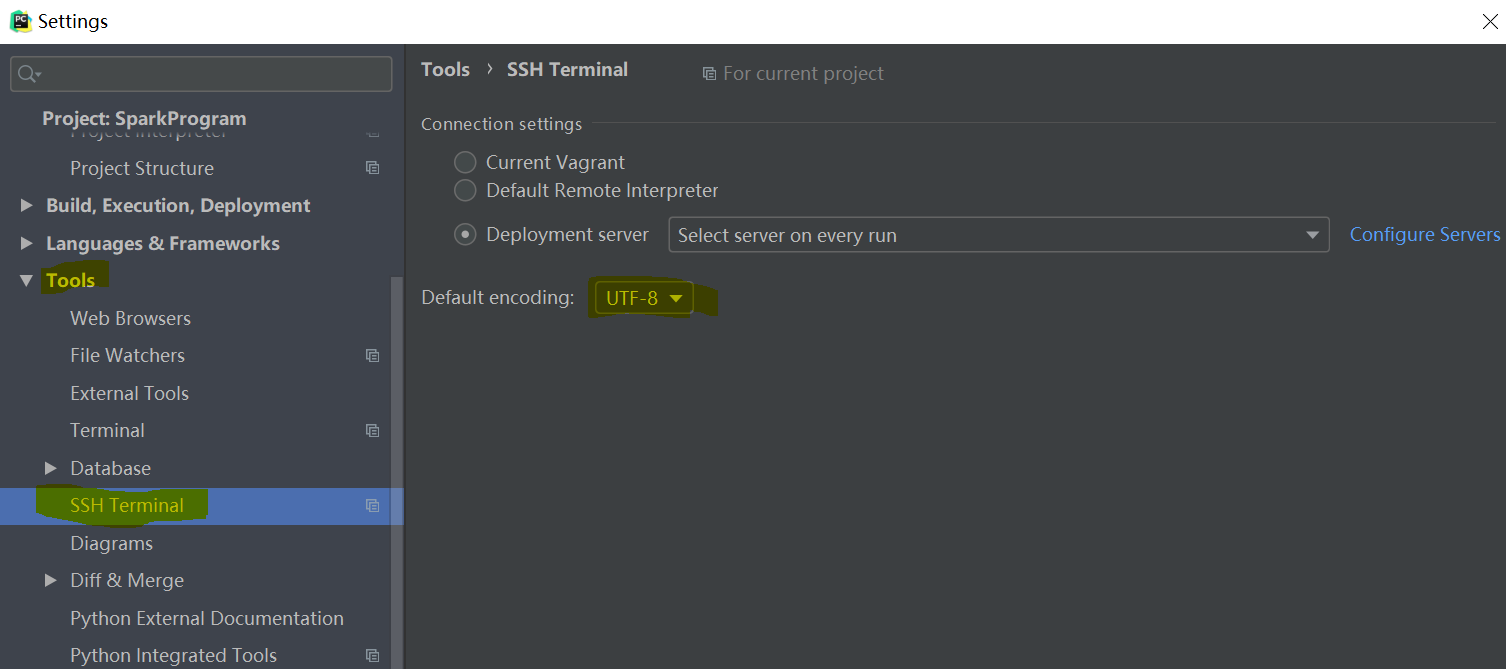

4、 修改 SSH Terminal 下的默认编码,将其设置为 UTF-8

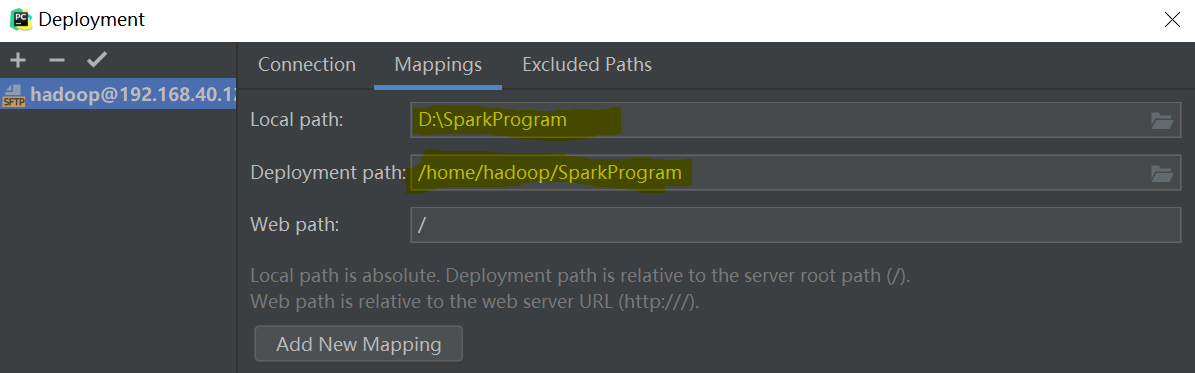

5 在Tools下找到Deployment,打开其中的Configuration,进行mapping的设置 , 这里Local path 指的是 第一步创建的 D:\SparkProgram ; Deployment path 指的是 /home/hadoop/SparkProgram ,如图

6 测试

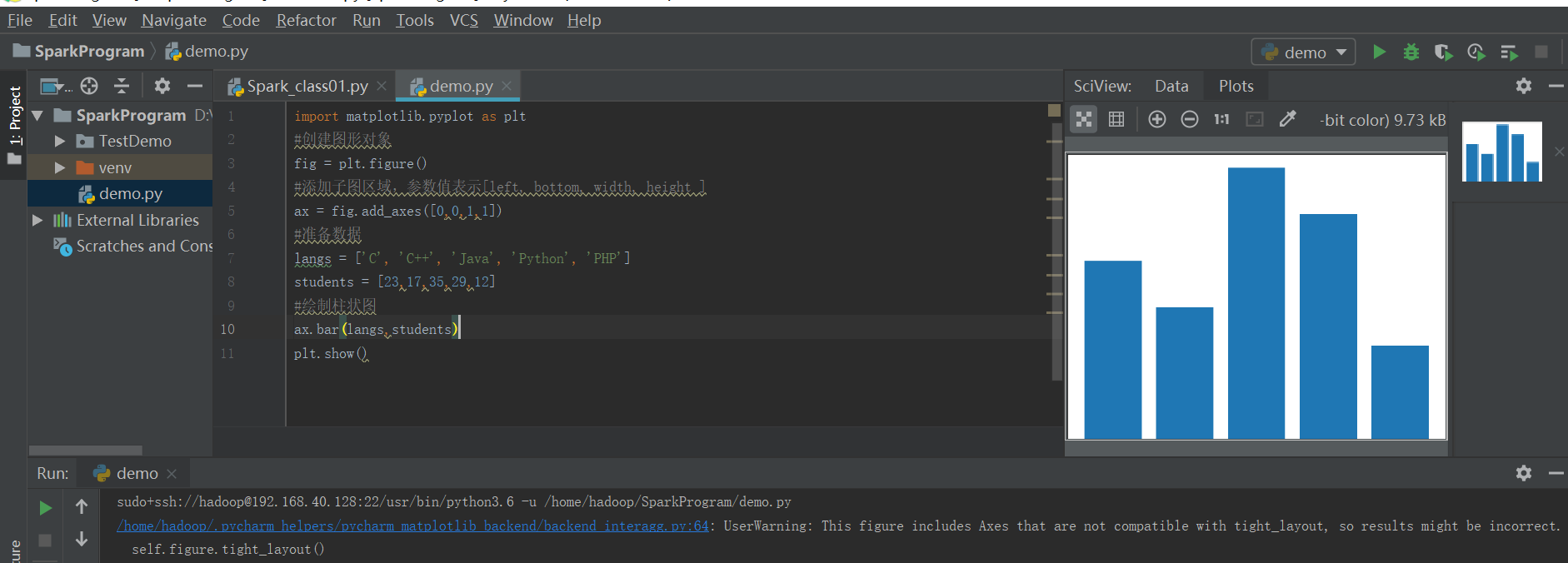

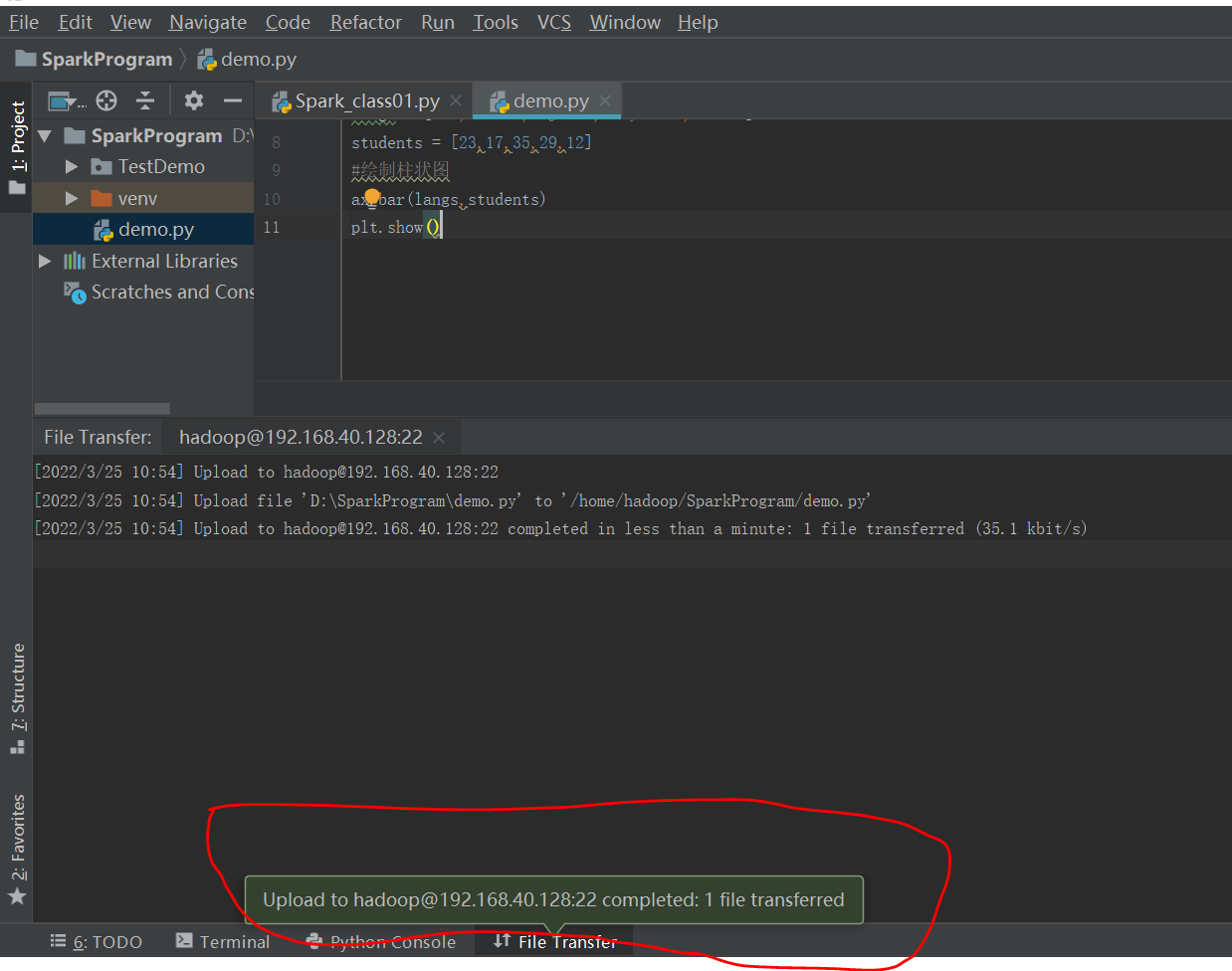

在D:\SparkProgram下,新建一个demo.py 文件,输入如下内容,

import matplotlib.pyplot as plt #创建图形对象 fig = plt.figure() #添加子图区域,参数值表示[left, bottom, width, height ] ax = fig.add_axes([0,0,1,1]) #准备数据 langs = ['C', 'C++', 'Java', 'Python', 'PHP'] students = [23,17,35,29,12] #绘制柱状图 ax.bar(langs,students) plt.show()

选择当前创建的文件按,在Tools下找到Deployment,点击 upload to hadoop@192.168.40.128 ,进行文件上传, 然后去Ubuntu的 /home/hadoop/SparkProgram 目录下,查看当前的内容

上传后

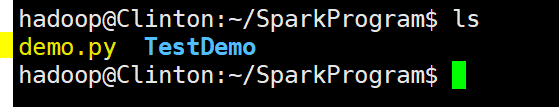

在Ubuntu进行查看

# 切换目录 $ cd /home/hadoop/SparkProgram # 查看内容 $ ls

在PyCharm运行demo.py