06bs4解析

bs4解析

环境的安装:

在cmd中输入:

pip install bs4

pip install lxml

bs4的解析原理:

-

实例化一个BeautifulSoup的对象,并且将即将被解析的页面源码数据加载到该对象中。

-

调用BeautifulSoup对象中的相关属性和方法进行标签定位和数据提取/

如何实例化BeautifulSoup对象呢?

-

BeautifulSoup(fp,'Ixml'):专门用作于解析本地存储的html文档中的数据。

-

BeautifulSoup(page_text, IxmI'):专门用作于将互联网上请求到的页面源码数据进行解析。

定位

标签定位:

- soup.tagName:定位到第一个TagName标签,返回的是单数。

属性定位:

-

soup.find('tagName',attrName='value'),返回的是单数

-

find_all和find用法一致,但是返回值是列表

选择器定位:

- select('选择器'),返回值为列表

- 标签,类,id,层级(>:一个层级,空格:多个层级)

提取数据

取文本:

tag.string:标签中直系的文本内容

tag.text:标签中所有文本内容

取属性

tag['attrName']

测试

放一个test.html来测试一下

<html lang="en">

<head>

<meta charset="UTF-8" />

<title>测试bs4</title>

</head>

<body>

<div>

<p>百里守约</p>

</div>

<div class="song">

<p>李清照</p>

<p>王安石</p>

<p>苏轼</p>

<p>柳宗元</p>

<a href="http://www.song.com/" title="赵匡胤" target="_self">

<span>this is span</span>

宋朝是最强大的王朝,不是军队的强大,而是经济很强大,国民都很有钱</a>

<a href="" class="du">总为浮云能蔽日,长安不见使人愁</a>

<img src="http://www.baidu.com/meinv.jpg" alt="" />

</div>

<div class="tang">

<ul>

<li><a href="http://www.baidu.com" title="qing">清明时节雨纷纷,路上行人欲断魂,借问酒家何处有,牧童遥指杏花村</a></li>

<li><a href="http://www.163.com" title="qin">秦时明月汉时关,万里长征人未还,但使龙城飞将在,不教胡马度阴山</a></li>

<li><a href="http://www.126.com" alt="qi">岐王宅里寻常见,崔九堂前几度闻,正是江南好风景,落花时节又逢君</a></li>

<li><a href="http://www.sina.com" class="du">杜甫</a></li>

<li><a href="http://www.dudu.com" class="du">杜牧</a></li>

<li><b>杜小月</b></li>

<li><i>度蜜月</i></li>

<li><a href="http://www.haha.com" id="feng">凤凰台上凤凰游,凤去台空江自流,吴宫花草埋幽径,晋代衣冠成古丘</a></li>

</ul>

</div>

</body>

</html>

代码练习(一行一行打,看一下区别)

from bs4 import BeautifulSoup

fp = open('./test.html','r',encoding='utf-8')

soup = BeautifulSoup(fp,'lxml') # 即将被解析的页面源码中的数据

soup.p

soup.find('div',class_='song') # 返回的是列表

soup.find_all('div',class_='song') # 返回的是列表

soup.select('.tang')

soup.select('#feng')

soup.select('.tang>ul>li')

soup.select('.tang li')

li_6 = soup.select('.tang>ul>li')[6]

i_tag = li_6.i

i_tag.string

soup.find('div',class_ = 'tang').text

soup.find('a',id = "feng")['href']

实例:爬取三国演义小说内容

网址:http://www.shicimingju.com/book/sanguoyanyi.html

- 章节名称

- 章节内容

完整代码:

import requests

from bs4 import BeautifulSoup

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Safari/537.36 Edg/97.0.1072.55'

}

fp = open('sanguo.txt','w',encoding='utf-8')

# 在首页中解析章节名称,和,每一章节详细页面的url

url = 'http://www.shicimingju.com/book/sanguoyanyi.html'

page_text = requests.get(url=url,headers=headers)

soup = BeautifulSoup(page_text.content,'lxml') # 这里要加上.content,不然会报错

a_list = soup.select('.book-mulu>ul>li>a')

for a in a_list:

detail_url='https://www.shicimingju.com'+a['href']

chap_title = a.string

# 对章节详情页的url发起请求,解析详情页中的章节内容

detail_page_test = requests.get(url=detail_url,headers=headers).text

soup = BeautifulSoup(detail_page_test,'lxml')

chap_content = soup.find('div',class_ = "chapter_content").text

fp.write(chap_title+':'+'\n'+chap_content+'\n')

print(chap_title+'爬取成功!')

fp.close()

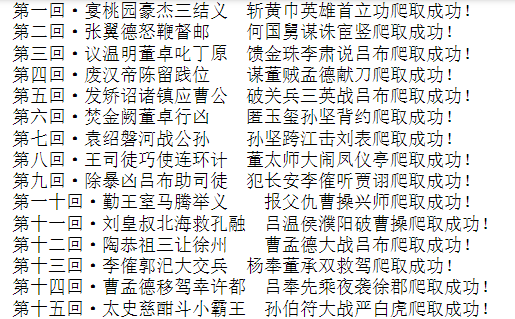

输出结果

还有一个sanguo.txt的文件保存。

很简答的任务啦~

浙公网安备 33010602011771号

浙公网安备 33010602011771号