02http和https

http

概念:clinet和Server进行数据交互的某种形式

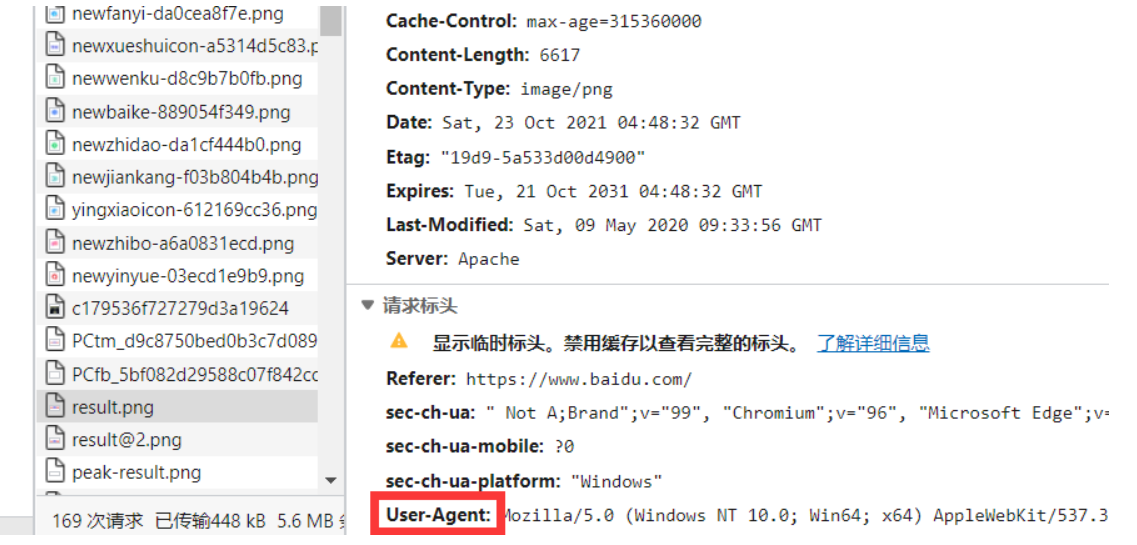

常用的头信息:

-

User-Agent:请求载体的身份标识

-

Connection:close 请求,连接中断,与服务器失去联系,与网站无关

-

content-type:响应

https

概念:安全的http协议(加密)

证书:

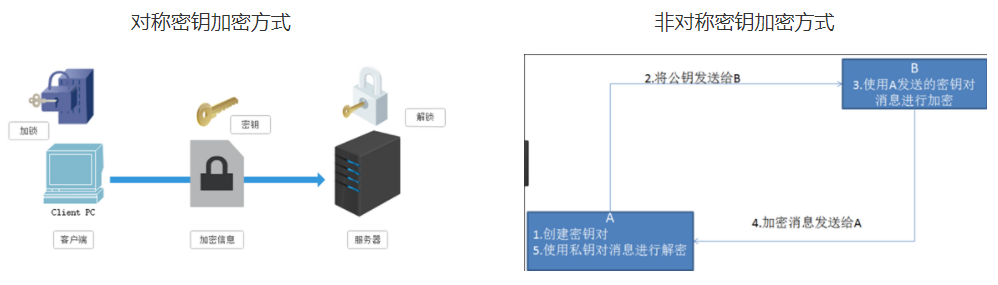

- 对称密钥加密方式

- 非对称密钥加密方式

缺点:如何保证接收端向发送端发出公开秘钥的时候,发送端确保收到的是预先要发送的,而不会被挟持。只要是发送密钥,就有可能有被挟持的风险。非对称加密的方式效率比较低,它处理起来更为复杂,通信过程中使用就有一定的效率问题而影响通信速度

-

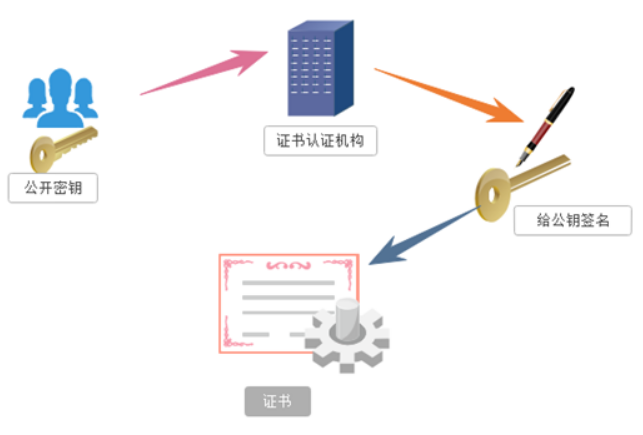

证书密钥加密方式

数字证书认证机构是客户端与服务器都可信赖的第三方机构。证书的具体传播过程如下:

1、服务器的开发者携带公开密钥,向数字证书认证机构提出公开密钥的申请,数字证书认证机构在认清申请者的身份,审核通过以后,会对开发者申请的公开密钥做数字签名,然后分配这个已签名的公开密钥,并将密钥放在证书里面,绑定在一起。

2、服务器将这份数字证书发送给客户端,因为客户端也认可证书机构,客户端可以通过数字证书中的数字签名来验证公钥的真伪,来确保服务器传过来的公开密钥是真实的。一般情况下,证书的数字签名是很难被伪造的,这取决于认证机构的公信力。一旦确认信息无误之后,客户端就会通过公钥对报文进行加密发送,服务器接收到以后用自己的私钥进行解密。

爬虫相关概述

爬虫概念:

- 通过编写程序模拟浏览器上网,然后让其去互联网上爬取/抓取数据的过程

- 模拟:浏览器就是一款纯天然的原始的爬虫工具

爬虫分类:

- 通用爬虫:爬取一整张页面中的数据.抓取系统(爬虫程序)

- 聚焦爬虫:爬取页面中局部的数据,一定是建立在通用爬虫的基础之上

- 增量式爬虫:用来监测网站数据更新的情况,以便爬取到网站最新更新出来的数据

风险分析

合理的的使用

爬虫风险的体现:

- 爬虫干扰了被访问网站的正常运营;

- 一爬虫抓取了受到法律保护的特定类型的数据或信息。

避免风险:

- 严格遵守网站设置的robots协议;

- 在规避反爬虫措施的同时,需要优化自己的代码,避免干扰被访问网站的正常运行;-在使用、传播抓取到的信息时,应审查所抓取的内容,如发现属于用户的个人信息、隐私或者他人的商业秘密的,应及时停止并删除。

反爬机制

反反爬机制

robots.txt协议

文本协议,在文本中指定了可爬和不可爬的数据说明,每个网站都有,如: