论文阅读-2021.11.06

论文阅读-2021.11.06

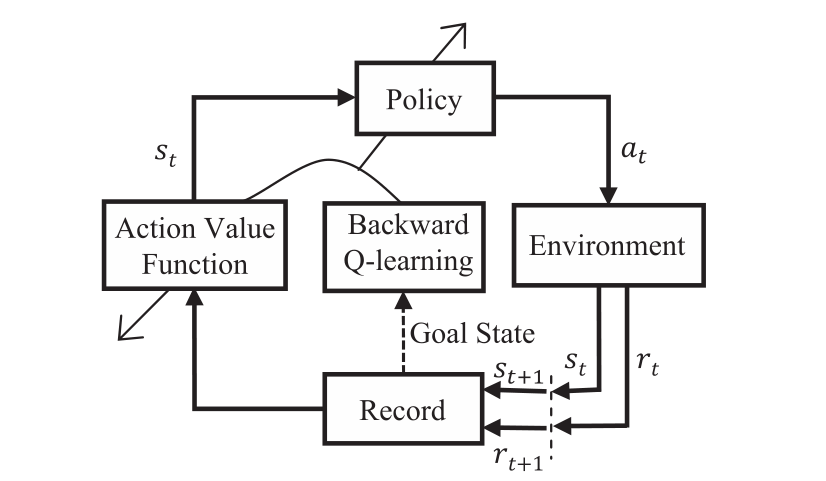

Backward Q-learning: The combination of Sarsa algorithm and Q-learning

自适应Q-learning

算法描述

- 初始化Q表,设置

- 循环(轮次episode):

- 随机状态或初始化状态

- 循环(步step):

- 根据Q表使用策略函数从状态

- 使用动作

- 如果

- 否则:

- 根据Q表使用策略函数从状态

- 达到轮次上限时结束循环

其中,

Backward Q-learning(主要)

算法描述

-

随机初始化所有的

-

对每一轮次:

-

随机选择一个状态或初始化

-

使用策略函数从Q表中选择

-

对每个时间步

-

挑选动作

-

使用策略函数从Q表中选择

-

记录:

-

根据下列公式更新

-

-

-

达到最终状态

-

-

根据下列公式,回溯更新

-

-

初始化

-

用降温准则重新计算温度参数(存疑)

-

-

达到轮次上限,结束循环。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 分享 3 个 .NET 开源的文件压缩处理库,助力快速实现文件压缩解压功能!

· Ollama——大语言模型本地部署的极速利器

· [AI/GPT/综述] AI Agent的设计模式综述