使用生成对抗性网络的照片真实单图像超分辨率(Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network)

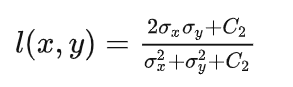

一篇入选CVPR2017会议的文章。该文章将神经网络的推理过程用查找表进行替代,从而减少运算开销。为了实现这一替代,在实现过程中运用了很多巧妙的处理技巧,算法与硬件的配合令人激动。

本文章主要包含:

- 我在学习中对英文原文的摘抄与翻译。

- 作为一个准研究生满怀好奇的碎碎念。

- 一点相关的小笔记。

复现进行中... ...

0. 摘要

尽管使用更快和更深的卷积神经网络在单幅图像超分辨率的精度和速度上取得了突破,但一个中心问题仍然很大程度上没有解决:当我们以大的放大因子进行超分辨时,我们如何恢复更精细的纹理细节?基于优化的超分辨方法的行为主要由目标函数的选择驱动。最近的工作主要集中在最小化均方重建误差。所得到的估计具有高峰值信噪比,但是它们常常缺乏高频细节,并且在它们不能匹配在较高分辨率下期望的保真度的意义上感觉不令人满意。提出了一种用于图像超分辨率(SR)的生成式对抗网络(GAN)SRGAN。据我们所知,它是第一个能够以4倍的尺度放大因子来推断照片级真实感自然图像的框架。为了实现这一点,我们提出了一个感知损失函数,其中包括对抗损失和内容损失。对抗损失将我们的解决方案推向使用鉴别器网络的自然图像流形,该鉴别器网络被训练为区分超分辨率图像和原始照片级真实感图像。此外,我们使用由感知相似性而不是像素空间中的相似性激发的内容丢失。我们的深度残差网络能够在公共基准测试中从大量降采样图像中恢复照片级真实感纹理。一项广泛的平均意见得分(MOS)测试显示,使用SRGAN后,感知质量有了极大的提高。SRGAN获得的MOS评分比任何最先进的方法获得的MOS评分更接近原始高分辨率图像的MOS评分。

已经说明,该模型的优势是能够恢复细致的纹理(高频的细节)。既然使用GAN模型,那么其模型复杂度必然不低。该模型的损失函数主要注重两个方面:图像的真实性与图像的还原度。

1. 引言

从低分辨率(LR)图像估计高分辨率(HR)图像的高挑战性任务被称为超分辨率(SR)。SR受到计算机视觉研究界的广泛关注,并具有广泛的应用[63,71,43]。

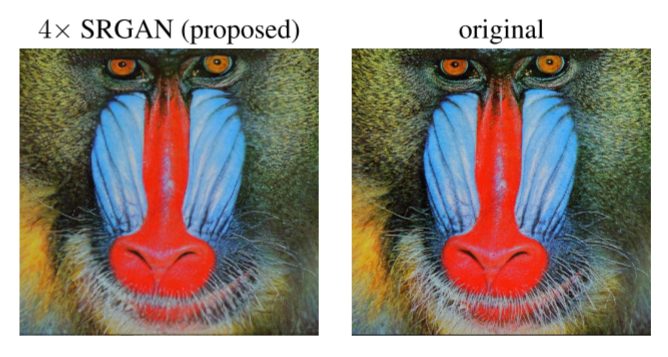

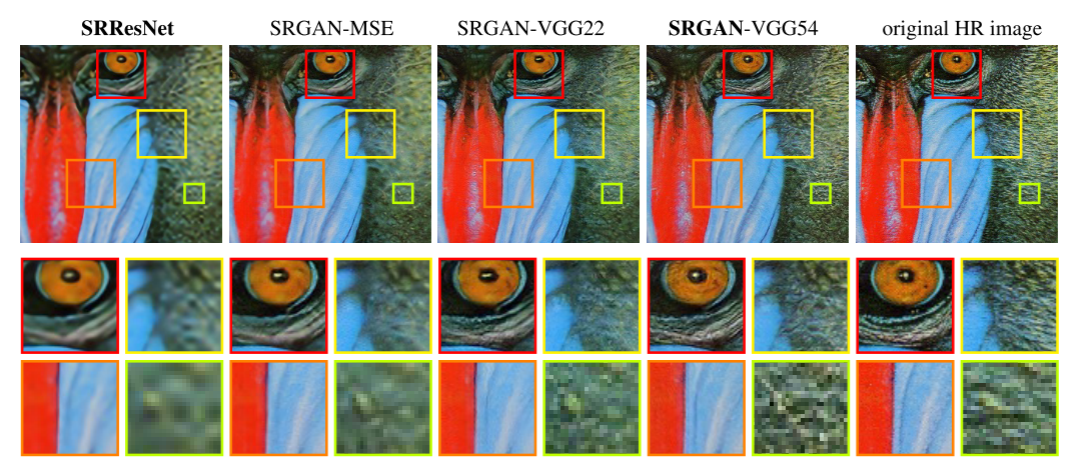

图1:超分辨率图像(左)与原始图像(右)几乎无法区分。[4倍放大]

欠定SR问题的不适定性质对于高放大因子特别显著,对于该高放大因子,重建SR图像中的纹理细节通常不存在。监督SR算法的优化目标通常是恢复的HR图像与地面真实值之间的均方误差(MSE)的最小化。这是方便的,因为最小化MSE也最大化峰值信噪比(PSNR),这是用于评估和比较SR算法的常用度量[61]。然而,MSE(和PSNR)捕捉感知相关差异(例如高纹理细节)的能力非常有限,因为它们是基于像素图像差异定义的[60,58,26]。这在图2中示出,其中最高PSNR不一定反映感知上更好的SR结果。

图2:从左到右:双三次插值、针对MSE优化的深度残差网络、针对对人类感知更敏感的损失优化的深度残差生成对抗网络、原始HR图像。相应的PSNR和SSIM显示在括号中。[4倍放大]

超分辨率和原始图像之间的感知差异意味着恢复的图像不是Ferwerda [16]定义的真实感图像。本文提出了一种超分辨率生成式对抗网络(SRGAN),该网络采用跳连接的深度残差网络(ResNet),以偏离均方误差为唯一优化目标。与之前的工作不同,我们使用VGG网络的高级特征图[49,33,5]结合鉴别器定义了一种新的感知损失,该鉴别器鼓励感知上难以与HR参考图像区分的解决方案。图1所示为采用4×放大因子进行超分辨率处理的照片级真实感图像示例。

1.1. 相关工作

1.1.1. 图像超分辨率

最近关于图像SR的综述文章包括Nasrollahi和Moeslund [43]或Yang等人[61]。在此,我们将重点讨论单幅图像超分辨率(SISR),而不会进一步讨论从多幅图像恢复HR图像的方法[4,15]。

基于预测的方法是解决SISR的首批方法之一。虽然这些滤波方法,例如线性、双三次或Lanczos [14]滤波,可以非常快,但是它们过度简化了SISR问题并且通常产生具有过度平滑纹理的解。已经提出了特别关注边缘保护的方法[1,39]。

如果以PSNR作为目标进行优化,可能存在数值很高,但是感官感受很差的情况。追究原因是因为这些方法通常将纹理引向了平滑而不是精细的方向。因此需要对细致的纹理提供保护。

更强大的方法旨在建立低分辨率和高分辨率图像信息之间的复杂映射,并且通常依赖于训练数据。许多基于样本对的方法依赖于LR训练片,其对应的HR对应物是已知的。Freeman等人[18,17]介绍了早期工作。SR问题的相关方法起源于压缩感测[62,12,69]。在Glasner等人[21]的研究中,作者利用了图像中跨尺度的面片冗余来驱动SR。Huang等人[31]也采用了这种自相似性范例,其中通过进一步允许小的变换和形状变化来扩展自字典。Gu等人[25]提出了一种卷积稀疏编码方法(Revisiting Sparse Convolutional Model for Visual Recognition),该方法通过处理整个图像而不是重叠块来提高一致性。

为了重建真实的纹理细节,同时避免边缘伪影,Tai等人[52]将基于梯度分布先验[50]的边缘定向SR算法与基于学习的细节合成的益处相结合。Zhang等人[70]提出了一种多尺度字典,以捕获不同尺度下相似图像块的冗余。为了超分辨率地标图像,Yue等人[67]从网络检索具有相似内容的相关HR图像,并提出用于对准的结构感知匹配标准。

邻域嵌入方法通过在低维流形中找到相似的LR训练面片并组合其对应的HR面片以进行重建来对LR图像面片进行上采样[54,55]。在Kim和Kwon [35]中,作者强调了邻域方法的过拟合趋势,并使用核岭回归制定了示例对的更一般映射。回归问题也可以用高斯过程回归[27]、树[46]或随机森林[47]来解决。在Dai等人[6]的研究中,学习了大量贴片特异性回归因子,并在测试过程中选择了最合适的回归因子。

最近基于卷积神经网络(CNN)的随机共振算法显示出优异的性能。在Wang等人[59]中,作者基于学习的迭代收缩和阈值算法(LISTA)[23]将稀疏表示先验编码到其前馈网络架构中。Dong等人[9,10]使用双三次插值来放大输入图像,并端到端地训练三层深度全卷积网络以实现最先进的SR性能。随后,证明了使网络能够直接学习上缩放滤波器可以进一步提高准确度和速度方面的性能[11,48,57]。Kim等人[34]利用其深度递归卷积网络(DRCN)提出了一种高性能架构,该架构允许长范围像素相关性,同时保持模型参数数量较少。Johnson等人[33]和Bruna等人[5]的工作与我们的论文特别相关,他们依靠更接近感知相似性的损失函数来恢复视觉上更有说服力的HR图像。

1.1.2. 卷积神经网络的设计

同时,在Krizhevsky等人[37]的工作取得成功之后,许多计算机视觉问题的最新技术水平由专门设计的CNN架构设定。

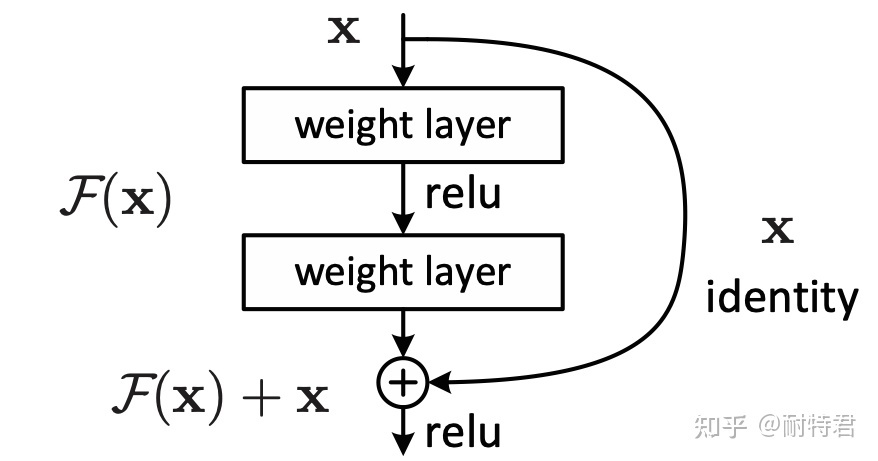

研究表明,较深的网络架构可能难以训练,但有可能大幅提高网络的准确性,因为它们允许对非常高复杂度的映射进行建模[49,51]。为了有效地训练这些更深层次的网络架构,通常使用批量归一化来抵消内部协变量移位。更深层次的网络架构也被证明可以提高SISR的性能,例如Kim等人[34]制定了递归CNN并给出了最新结果。另一个简化深度CNN训练的强大设计选择是最近引入的残差块[29]和跳过连接[30,34]的概念。跳过连接缓解网络模型结构,这些恒等映射对本质的作用是微不足道的,然而,用卷积核来表示恒等映射带来的作用可能并不微不足道。

在SISR的背景下,还表明学习上定标滤波器在准确度和速度方面是有益的[11,48,57]。这是对Dong等人[10]的改进,在Dong等人[10]中,在将图像馈送到CNN之前,采用双三次插值来放大LR观察。

Skip connection的初衷是为了解决gradient vanished的问题。在学习深度神经网络的参数时,通常都是通过gradient descent的方式,即从网络的输出层(output layer)开始由后向输入层(input layer)计算每一层的gradient。由于gradient通常是小于1的数值,当层数很多的时候,gradient就会变得越来越小。最终,出现gradient vanish的问题。当gradient无限接近于0,网络就没有办法更新学习了。为了解决这个问题,于是就有了skip connection这个思路:简言之,在深度网络的中间层额外加入浅层的input,使得gradient的“路径”不再那么长。类似提供一个复合路径,在原来的“长路径”的基础上,现在额外添加一个“捷径”。Skip connection在本质上就是额外提供一个计算gradient的“捷径”。

1.1.3. 损失函数

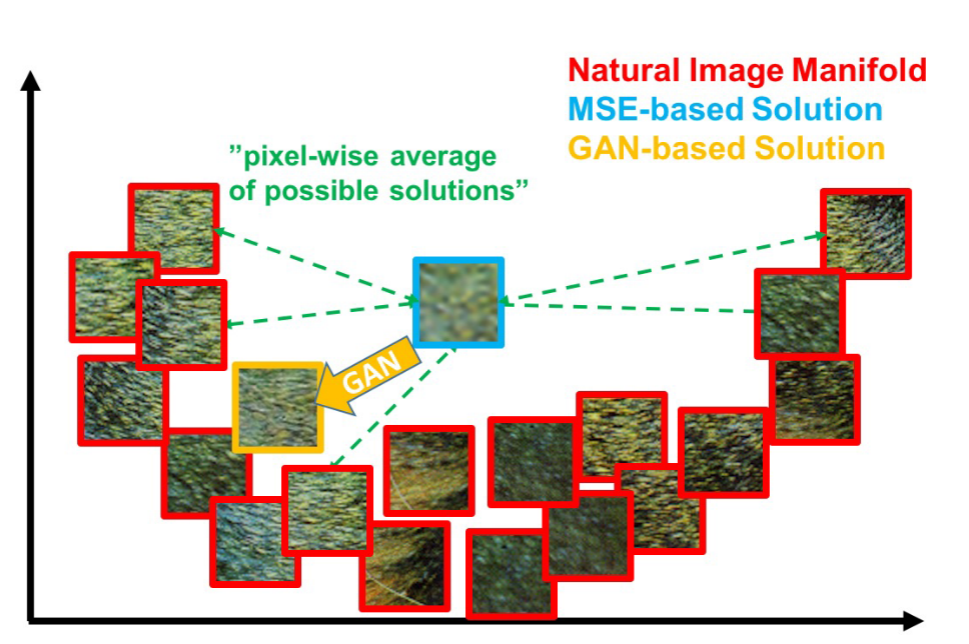

像素损失函数(如MSE)难以处理恢复丢失的高频细节(如纹理)时固有的不确定性:最小化MSE鼓励找到似乎合理的解的逐像素平均值,这些解通常过于平滑,因此感知质量较差[42,33,13,5]。在图2中用相应的PSNR举例说明了不同感知质量的重建。我们在图3中说明了最小化MSE的问题,其中具有高纹理细节的多个潜在解决方案被平均以创建平滑的重建。

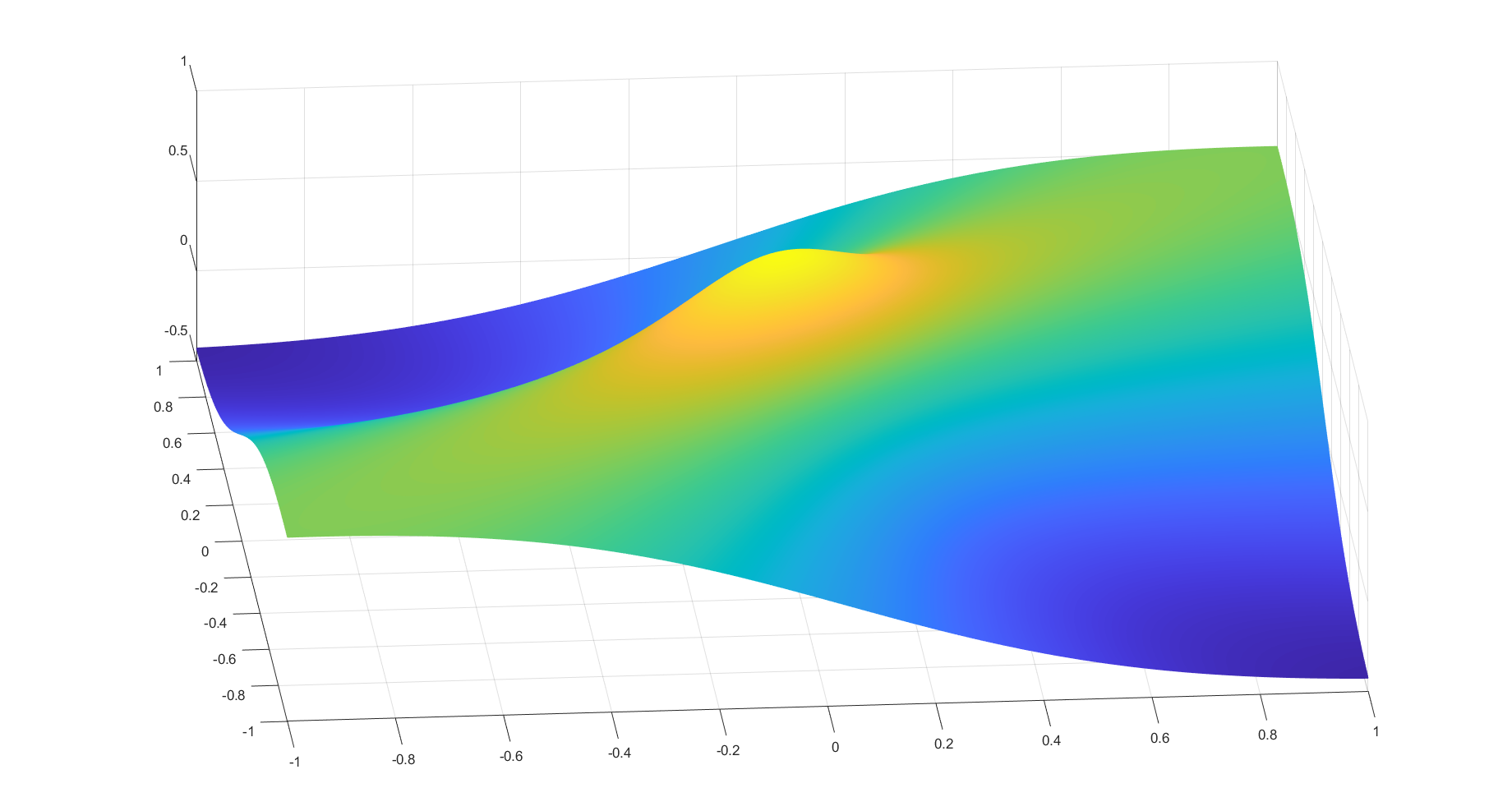

图3:自然图像流形(红色)的面片以及使用MSE(蓝色)和GAN(橙子)获得的超分辨率面片的图示。基于MSE的解由于像素空间中可能解的逐像素平均而显得过于平滑,而GAN将重构驱动向自然图像流形,从而产生感知上更令人信服的解。

在Mathieu等人[42]和丹顿等人[7]的研究中,作者通过将生成对抗网络(GANs)[22]应用于图像生成来解决这一问题。Yu和Porikli [66]通过鉴别器损失来增加像素MSE损失,以训练一个网络,该网络使用较大的放大因子(8×)对面部图像进行超分辨率。拉德福等人[44]也将GAN用于无监督表示学习。使用GAN学习从一个流形到另一个流形的映射的想法由Li和Wand [38]针对风格转移以及Yeh等人[64]针对修复进行了描述。Bruna等人[5]最小化了VGG19 [49]和散射网络特征空间中的平方误差。

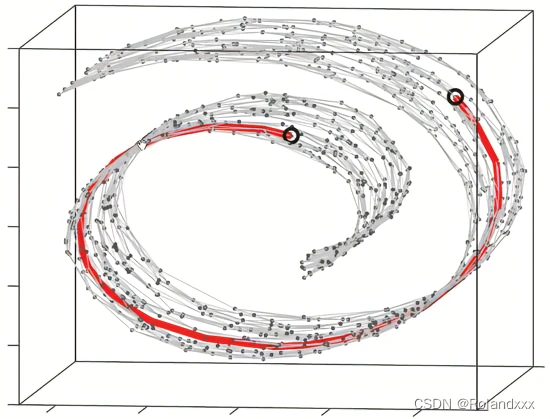

流形(manifold): 流形是几何中的一个概念,它是高维空间中的几何结构,即空间中的点构成的集合。 可以简单的将流形理解成二维空间的曲线,三维空间的曲面在更高维空间的推广。下图是三维空间中的一个流形,这是一个卷曲面,像一个瑞士卷一样,这个图就表示观察到的数据是三维的,但其本质是一个二维流形,因为曲面是2维的。我们可以想象成输入的数据是三维的,但真正表征这个数据的核心特征就是一个二维的,其余的都是维度都是冗余的,所以这里的二维流形也就是表征这个数据的核心特征!所以深度学习的本质就是说某些高维数据,实际是一种低维的流形结构嵌入在高维空间中,这个低维流型结构就是我们提取得到的重要特征。 图上所标注的两个圈圈,在流形(把卷展开)上本距离非常远,但是用三维空间的欧氏距离来计算则它们的距离要近得多。

Dosovitskiy和Brox [13]结合对抗训练使用基于在神经网络的特征空间中计算的欧几里德距离的损失函数。结果表明,提出的损失允许视觉上上级的图像生成,并可用于解决解码非线性特征表示的不适定逆问题。与此类似,约翰逊等人[33]和Bruna等人[5]提出使用从预训练VGG网络中提取的特征,而不是低水平像素误差测量。具体而言,作者根据从VGG19 [49]网络中提取的特征图之间的欧氏距离制定了损失函数。在超分辨率和艺术风格转移方面,获得了更令人信服的结果[19,20]。最近,Li和Wand [38]还研究了在像素或VGG特征空间中比较和混合面片的效果。

数学和物理上的反问题的研究由来已久,法国数学家阿达马早在19世纪就提出了不适定问题的概念:称一个数学物理定解问题的解存在、唯一并且稳定的则称该问题是适定的(WellPosed).如果不满足适定性概念中的上述判据中的一条或几条,称该问题是不适定的。典型的图像处理不适定问题包括:图像去噪(ImageDe-nosing),图像恢复(Image Restorsion),图像放大(Image Zooming),图像修补(ImageInpainting),图像去马赛克(image Demosaicing),图像超分辨(Image super-resolution)等。

1.2. 贡献

GANs为生成具有高感知质量的看似真实的自然图像提供了一个强大的框架。GAN过程鼓励重建向搜索空间中包含照片级真实感图像的概率较高的区域移动,从而更接近自然图像流形,如图3所示。

在本文中,我们描述了第一个非常深的ResNet [29,30]架构,该架构使用GAN的概念来形成照片级真实感SISR的感知损失函数。我们的主要贡献是:

- 我们使用针对MSE优化的16块深度ResNet(SRResNet),通过PSNR和结构相似性(SSIM)测量,为图像SR设置了一个新的最先进的高放大因子(4倍)。

- 我们提出了SRGAN,这是一种基于GAN的网络,针对一种新的感知损失进行了优化。这里,我们用在VGG网络[49]的特征图上计算的损失来替换基于MSE的内容损失,VGG网络[49]的特征图对于像素空间[38]中的变化更加不变。

- 我们通过对来自三个公共基准数据集的图像进行广泛的平均意见得分(MOS)测试,确认SRGAN是最新的技术水平,在很大程度上,用于估计具有高放大因子(4倍)的照片级真实感SR图像。

我们在第2节中描述了网络架构和感知损失。第3节提供了对公共基准数据集的定量评估以及视觉图示。本文最后在第4节进行了讨论,并在第5节作了总结。

2. 方法

在SISR中,目的是从低分辨率输入图像ILR估计高分辨率、超分辨率图像ISR。在这里,ILR是其高分辨率对应物IHR的低分辨率版本。高分辨率图像仅在训练期间可用。在训练中,ILR是通过对IHR应用高斯滤波器,然后使用下采样因子r进行下采样操作来获得的。对于具有C个颜色通道的图像,我们用大小为W × H × C的实值张量来描述ILR,用rW× rH ×C来描述IHR和ISR。

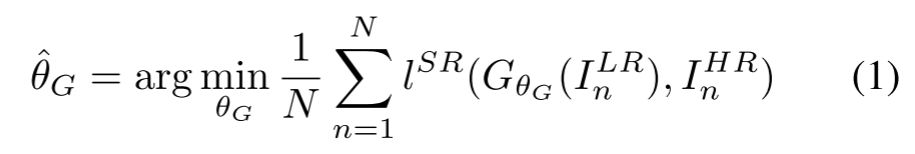

我们的最终目标是训练生成函数G,其针对给定LR输入图像估计其对应的HR对应物。为了实现这一点,我们将生成器网络训练为以θG为参数的前馈CNN GθG。这里θG = {W1:L;b1:L}表示L层深度网络的权重和偏差,通过优化SR特有的损失函数lSR而获得。对于训练图像IHRn,n = 1 , ... , N具有对应的ILRn,n = 1, ... , N,我们求解:

(注:arg min 就是使后面这个式子达到最小值时的变量的取值)

在这项工作中,我们将专门设计感知损失LSR作为几个损失分量的加权组合,这些损失分量对恢复SR图像的不同期望特性进行建模。单个损失函数的详细描述见第2.2节。

2.1. 对抗性网络体系结构

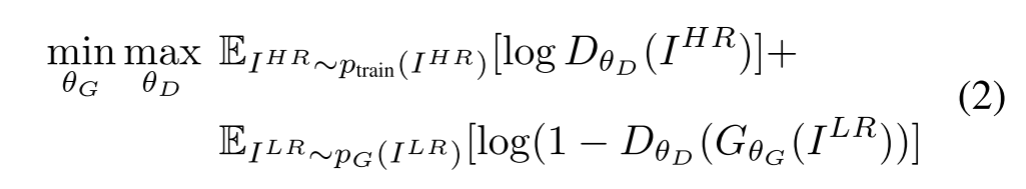

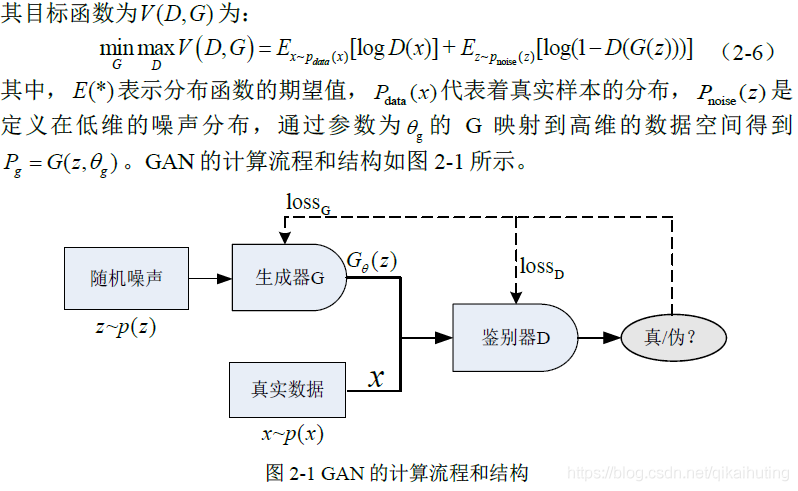

按照Goodfellow等人[22]的方法,我们进一步定义了一个鉴别器网络DθD,我们以交替的方式与GθG沿着优化该鉴别器网络,以解决对抗性的最小值-最大值问题:

该公式背后的一般思想是,它允许训练生成模型G,其目标是欺骗被训练以区分超分辨率图像与真实的图像的可微分鉴别器D。通过这种方法,我们的生成器可以学习创建与真实的图像高度相似并且因此难以通过D分类的解。这鼓励了驻留在自然图像的子空间、流形中的感知上上级的解决方案。这与通过最小化诸如MSE的逐像素误差测量而获得的SR解形成对比。

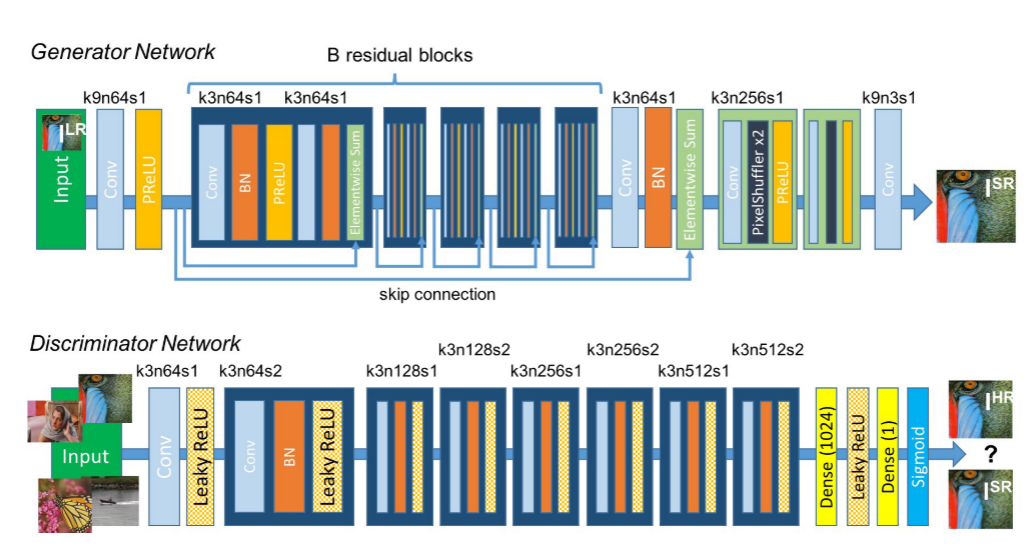

这种方法被鼓励的原因是,我们认为通过判决器,我们更能从几何形态上对原图像与生成图像进行区分,这样也许能够以还原度为代价,给人带来更真实的感受。图4所示的极深生成器网络G的核心是具有相同布局的B残差块。受约翰逊等人[33]的启发,我们采用了Gross和Wilber [24]提出的区块布局。具体来说,我们使用两个带有3×3小内核和64个特征图的卷积层,然后使用批量归一化层[32]和ParametricReLU [28]作为激活函数。我们使用Shi等人[48]提出的两个经过训练的子像素卷积层来提高输入图像的分辨率。

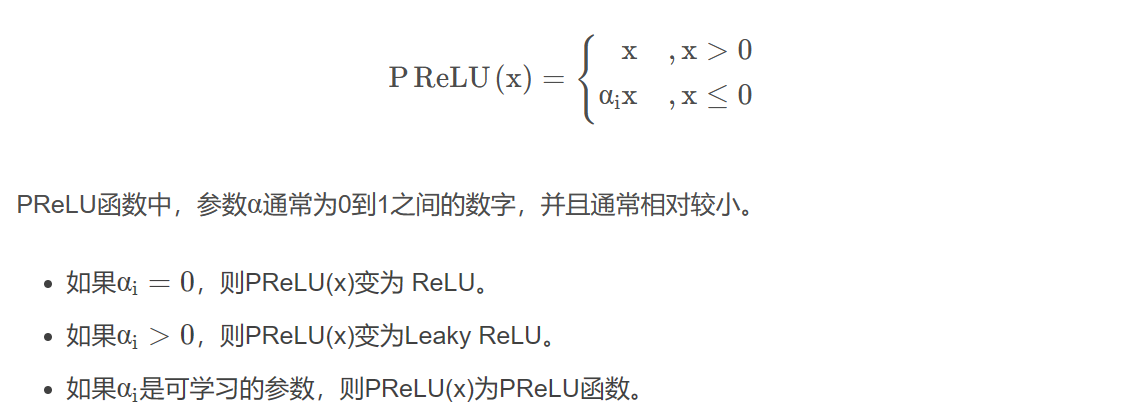

PReLU 也是 ReLU 的改进版本。PReLU函数的特点:在负值域,PReLU的斜率较小,这也可以避免Dead ReLU问题;与ELU相比,PReLU 在负值域是线性运算。尽管斜率很小,但不会趋于0。

为了区分真实的HR图像与生成的SR样本,我们训练了一个鉴别器网络。架构如图4所示。我们遵循拉德福等人[44]总结的架构指南,使用LeakyReLU激活(α = 0.2),避免整个网络的最大池化。训练鉴别器网络以解决等式2中的最大化问题。它包含8个卷积层,3 × 3滤波器内核的数量不断增加,从64个内核增加到512个内核,增加了2倍,与VGG网络相同[49]。每次特征数量加倍时,使用步长卷积来降低图像分辨率。所得到的512个特征图之后是两个密集层和最终S形激活函数,以获得样本分类的概率。

图4:发生器和鉴别器网络的架构,以及每个卷积层对应的内核大小(k)、特征映射数量(n)和跨距(s)。

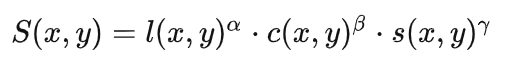

2.2. 知觉损失函数

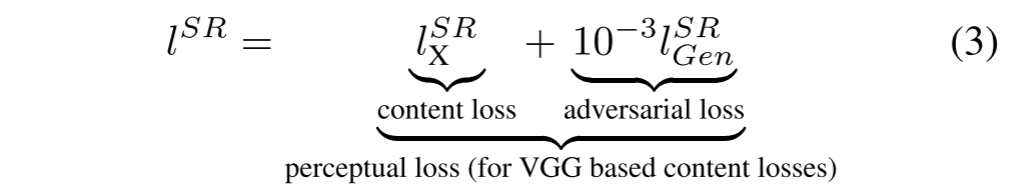

感知损耗函数lSR的定义对于生成器网络的性能至关重要。虽然一般基于MSE [10,48]对最小均方误差进行建模,但我们对约翰逊等人[33]和Bruna等人[5]进行了改进,并设计了一个损失函数,用于评估感知相关特征的解决方案。我们将感知损失公式化为内容损失(lSR X)和对抗损失分量的加权和,如下:

在下文中,我们描述内容损失lSR X和对抗损失lSRGen的可能选择。

损失函数的组成是由内容损失和对抗损失共同组成,但是对抗损失前面由系数10-3,对于这个系数我猜测在下文会有所说明。

2.2.1. 内容物损失

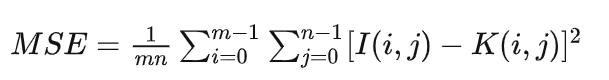

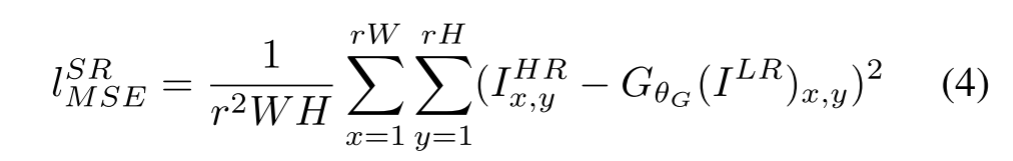

像素级MSE损失计算如下:

这是图像SR最广泛使用的优化目标,许多最先进的方法都依赖于此[10,48]。然而,虽然实现了特别高的PSNR,但MSE优化问题的解决方案通常缺乏高频内容,这导致具有过度平滑纹理的感知上不满意的解决方案(参见图2)。

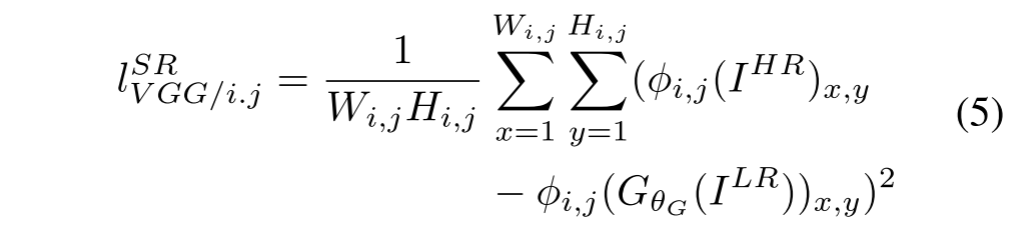

我们基于Gatys等人[19]、Bruna等人[5]和约翰逊等人[33]的想法,并使用更接近感知相似性的损失函数,而不是依赖像素损失。我们根据Simonyan和Zisserman[49]中描述的预训练19层VGG网络的ReLU激活层定义VGG损耗。φi,j表示VGG19网络中第i个最大池层之前的第j个卷积(激活后)获得的特征图,我们认为该特征图是给定的。然后,我们将VGG损失定义为重建图像GθG(ILR)和参考图像IHR的特征表示之间的欧几里德距离:

这里Wi,j和Hi,j描述VGG网络内的各个特征图的维度。

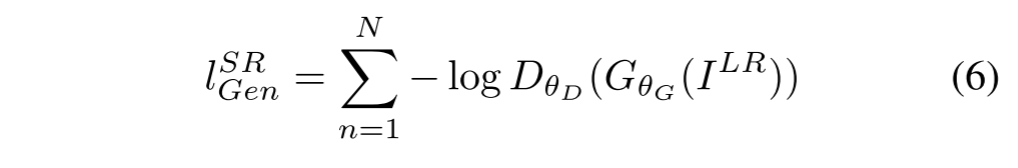

MSE是均方误差,因此该指标更多地具有方差的意味,因此MSE也具有表达预测数据相对于原始数据离散程度的含义。如果MSE越小,那么数据的离散程度也就越小,因此在这种理念的加持之下,导致了MSE作为优化目标缺乏高频信息。除了到目前为止所描述的内容损失之外,我们还将GAN的生成成分添加到感知损失中。这鼓励我们的网络通过试图愚弄鉴别器网络,来偏爱那些驻留在自然图像流形上的解决方案。生成损耗lSR Gen基于所有训练样本上的鉴别器DθD(GθG(ILR))的概率定义为:

3. 实验

3.1. 数据和相似性度量

我们在三个广泛使用的基准数据集Set 5 [3]、Set 14 [69]和BSD 300 [41]的测试集BSD 100上进行了实验。所有实验均在低分辨率和高分辨率图像之间以4×的比例因子进行。这相当于图像像素减少16倍。为了进行公平比较,所有报告的PSNR [dB]和SSIM [58]测量值均使用daala软件包1在中心裁剪图像的y通道上进行计算,从每个边界移除4像素宽的条带。参考方法(包括最近邻法、双三次法、SRCNN [9]和SelfExSR [31])的超分辨率图像来自Huang等人2 [31]的在线补充材料,DRCN的超分辨率图像来自Kim等人3 [34]。使用SRResNet获得的结果(对于损失:lSR MSE和lSR VGG/2.2)和SRGAN变体均可在线获得4。采用配对双侧Wilcoxon符号秩检验进行统计学检验,并在p<0.05时确定显著性。

读者也可能对GitHub5上独立开发的基于GAN的解决方案感兴趣。然而,它只提供了有限的一组面上的实验结果,这是一个更受约束和更容易的任务。

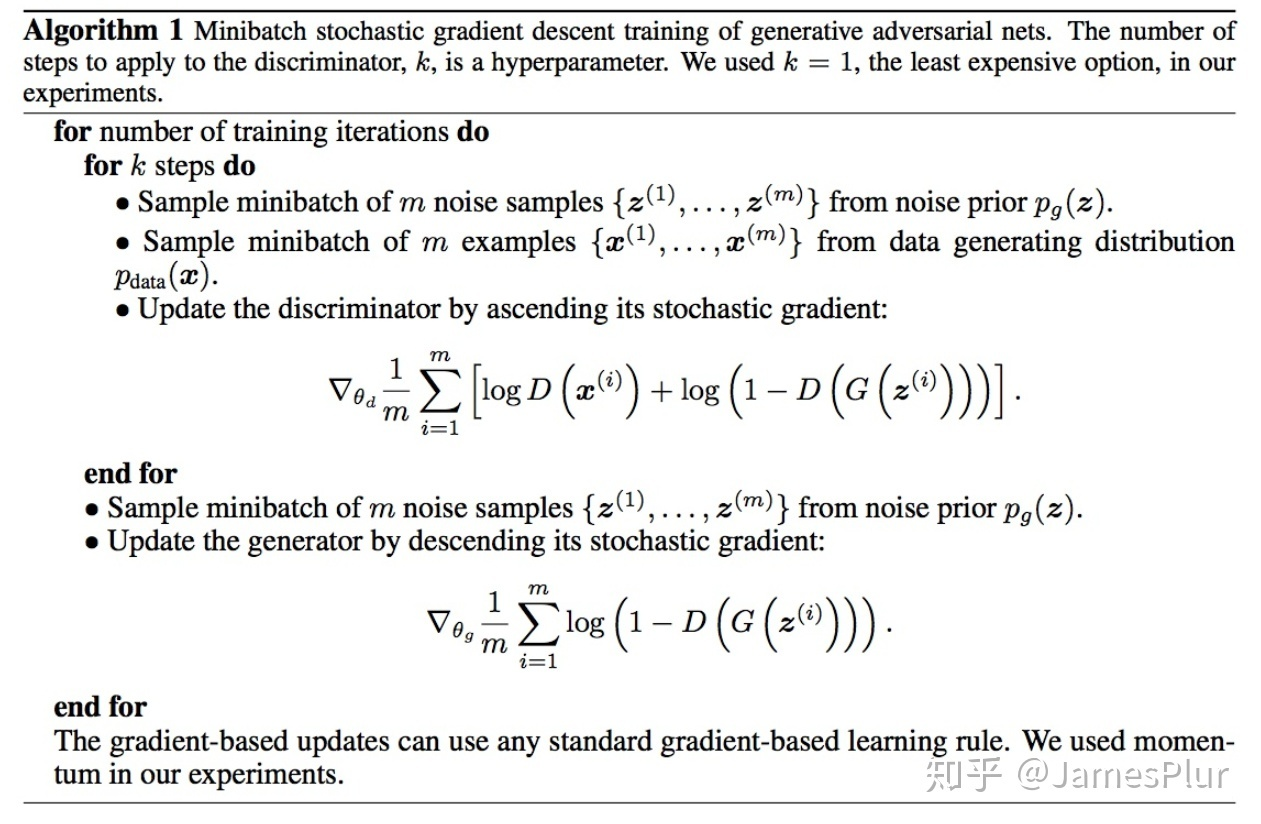

3.2. 训练详情和参数

我们使用来自ImageNet数据库的35万张图像的随机样本在NVIDIA Tesla M40 GPU上训练所有网络[45]。这些图像与测试图像不同。我们通过使用具有下采样因子r = 4的双三次核对HR图像(BGR,C = 3)进行下采样来获得LR图像。对于每个小批,我们裁剪不同训练图像的16个随机96 × 96 HR子图像。注意,我们可以将生成器模型应用于任意大小的图像,因为它是完全卷积的。我们将LR输入图像的范围缩放至[0,1],HR图像的范围缩放至[−1,1]。因此,在强度范围[−1,1]的图像上计算MSE损失。VGG特征图也通过因子1/112.75重新标度,以获得与MSE损失相当的标度的VGG损失。这相当于将公式5乘以约0.006的重标度因子。对于优化,我们使用Adam [36],β1 = 0.9。SRResNet网络以10−4的学习率和106次更新迭代进行训练。在训练实际GAN时,我们使用训练好的基于MSE的SRResNet网络作为生成器的初始化,以避免不期望的局部最优。所有SRGAN变体都以10−4的学习率进行了105次更新迭代,并以10−5的较低学习率进行了另外105次迭代。我们交替更新发生器和鉴别器网络,这相当于Goodfellow等人[22]中使用的k = 1。我们的生成器网络具有16个相同的(B = 16)剩余块。在测试期间,我们关闭批量归一化更新,以获得确定性地仅依赖于输入的输出[32]。我们的实现基于Theano [53]和Lasagne [8]。

简单来说就是没有全连接层的CNN,主要好处是支持不同大小的输入,支持全图end-to-end的训练,可以更好地学习context信息,非常适合于输出是图像的task比如segmentation、edge detection、optical flow等。3.3. 平均意见评分(MOS)检验

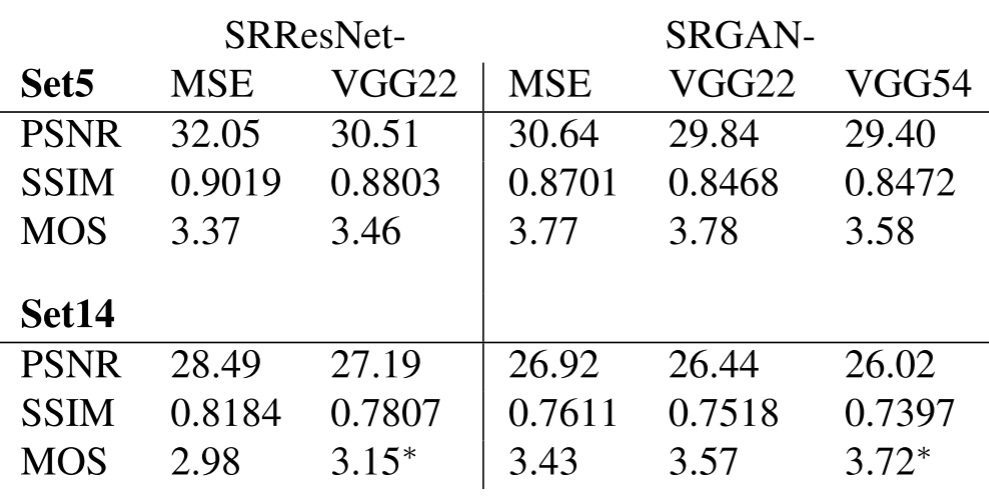

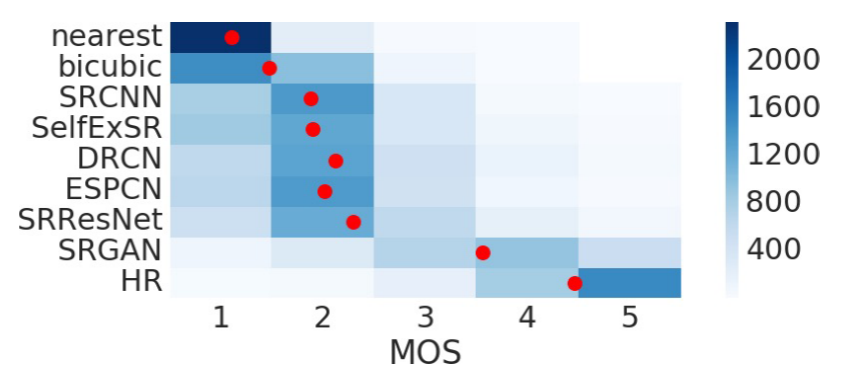

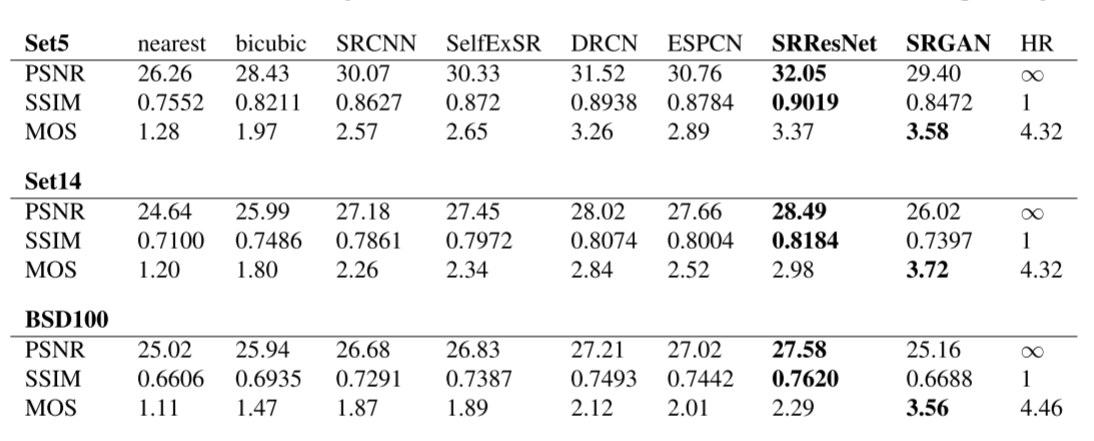

我们已经执行了MOS测试来量化不同方法重建感知上令人信服的图像的能力。具体来说,我们要求26名评分员为超分辨率图像分配一个从1(质量差)到5(质量优)的积分。评分员对第5集、第14集和BSD 100上的每个图像的12个版本进行评分:最近邻(NN)、双三次、SRCNN [9]、自ExSR [31]、DRCN [34]、ESPCN [48]、SRResNet-MSE、SRResNet-VGG 22 ( 未在BSD 100上评级)、SRGAN-MSE*、SRGAN-VGG 22*、SRGANVGG 54和原始HR图像。因此,每名评分者对以随机方式呈现的1128个实例(19张图像的12个版本加上100张图像的9个版本)进行评分。在来自BSD 300训练集的20张图像的NN(评分1)和HR(5)版本上校准评分员。在一项初步研究中,我们通过将一种方法的图像两次添加到一个更大的测试集中,评估了校准程序和26名评定者对BSD 100中10张图像子集的测试-再测试可靠性。我们发现可靠性良好,相同图像的评级之间没有显著差异。评定者非常一致地将NN插值测试图像评定为1,将原始HR图像评定为5(参见图5)。表1、表2和图5总结了所进行MOS测试的实验结果。

3.4.含量损失调查

我们研究了基于GAN的网络中不同内容丢失选择对感知丢失的影响。具体来说,我们研究了lSR = lSR X + 10−3lSR Gen的内容损失lSRX:

表1:SRResNet和敌对网络在Set5和Set14基准数据上的不同损失函数的性能。MOS评分显著高于(p<0.05)该类别中的其他损失 *。[4倍放大]

- SRGAN-MSE:lSR MSE,用于研究以标准MSE作为内容损失的对抗网络。

- SRGAN-VGG22:φ2,2的lSR VGG/2.2,在表示较低级别特征的特征图上定义的损失[68]。

- SRGAN-VGG54:φ 5,4的LSR VGG/5.4,在来自更深网络层的更高级特征的特征图上定义的损失,更有可能集中在图像的内容上[68,65,40]。以下我们将此网络称为SRGAN。

(回顾:φi,j表示VGG19网络中第i个最大池层之前的第j个卷积(激活后)获得的特征图,我们认为该特征图是给定的。)

我们还评估了两个损耗为lSRMSE(SRResNet-MSE)和lSRVGG/2.2(SRResNet-VGG 22)的无对抗组分的生成网络的性能。我们将SRResNet-MSE称为SRResNet。注意,在训练SRResNet-VGG 22时,我们在lSR VGG/2.2 [2,33]中增加了一个额外的总变量损失,权重为2×10−8。定量结果总结见表1,目视示例见图6。即使与对抗损失相结合,MSE也提供具有最高PSNR值的解,然而,与利用对视觉感知更敏感的损失分量所实现的结果相比,该解在感知上相当平滑并且不那么令人信服。这是由基于MSE的内容损失和对抗性损失之间的竞争引起的。我们进一步将我们在少数基于SRGAN MSE的重建中观察到的轻微重建伪影归因于这些竞争目标。我们无法确定SRResNet或SRGAN在Set 5的MOS评分方面的显著最佳损失函数。然而,在MOS方面,SRGAN-VGG 54显著优于Set 14上的其他SRGAN和SRResNet变体。我们观察到一种趋势,即与φ 2,2相比,使用更高级别的VGG特征映射φ 5,4产生更好的纹理细节(参见图6)。补充材料中提供了通过SRGAN over SRResNet改善感知的更多示例。

图5:BSD100上MOS评分的颜色编码分布。对于每种方法,评估了2600份样本(100张图像× 26名评分者)。平均值显示为红色标记,其中区间以值i为中心。[4倍放大]

3.5. 最终网络的性能

我们比较了SRResNet和SRGAN与NN、双三次插值和四种最新方法的性能。定量结果总结在表2中,并确认SRResNet(在PSNR/SSIM方面)在三个基准数据集上设置了新的最新技术水平。请注意,我们使用了一个公开的评估框架(参见第3.1节),因此报告值可能与原始论文中报告的值略有偏差。

我们还在BSD100上获得了SRGAN和所有参考方法的MOS额定值。补充材料中描述了使用SRResNet和SRGAN进行超分辨的图像示例。表2所示的结果证实SRGAN的性能远远优于所有参考方法,并为真实感图像SR树立了一个新的技术水平。表2)在BSD100上具有高度显著性,SRCNN与SelfExSR除外。图5总结了所有收集的MOS评级的分布。

4. 讨论和今后的工作

我们使用MOS测试证实了SRGAN的上级感知性能。我们进一步证明了标准定量测量(如PSNR和SSIM)无法捕获和准确评估与人类视觉系统相关的图像质量[56]。这项工作的重点是超分辨率图像的感知质量,而不是计算效率。与Shi等人[48]相比,所提出的模型未针对实时视频SR进行优化。然而,对网络结构的初步实验表明,较浅的网络有潜力在质量性能略有下降的情况下提供非常有效的替代方案。与Dong等人[10]相反,我们发现更深的网络架构是有益的。我们推测ResNet设计对更深层次网络的性能有实质性影响。我们发现,更深的网络(B > 16)可以进一步提高SRResNet的性能,但代价是更长的训练和测试时间(参见补充材料)。我们进一步发现,由于高频伪像的出现,更深网络的SRGAN变体越来越难以训练。

AN-MSE(左中:c、d)、SRGAN-VGG 2.2(中间:e、f)和SRGAN-VGG 54(右中:g,h)重建结果和对应的参考HR图像(右:(i、j)。[4倍放大]

表2:NN、双三次、SRCNN [9]、SelfExSR [31]、DRCN [34]、ESPCN [48]、SRResNet、SRGAN-VGG 54和原始HR在基准数据上的比较。最高测量值(PSNR[dB]、SSIM、MOS)以粗体显示。[4倍放大]

究竟什么才是人们想要的目标?更符合事实还是更能够欺骗我们的感知系统?这个问题在此时产生了分歧,也许在未来会不谋而合。当针对SR问题的真实感解决方案时,特别重要的是如图6所示的内容损失的选择。在这项工作中,我们发现lSR VGG/5.4产生了感知上最令人信服的结果,我们将其归因于更深的网络层的潜力,以表示远离像素空间的更高抽象[68,65,40]的特征。我们推测,这些更深层的特征图纯粹集中在内容上,而使对抗性损失集中在纹理细节上,这是没有对抗性损失的超分辨率图像与照片级真实感图像之间的主要差异。我们还注意到,理想损失函数取决于应用。例如,产生更精细细节幻觉的方法可能不太适合医疗应用或监视。文本或结构化场景的感知上令人信服的重建[31]是具有挑战性的,也是未来工作的一部分。描述图像空间内容但对于像素空间中的改变更加不变的内容损失函数的开发将进一步改进照片级真实感图像SR结果。

5. 结语

我们已经描述了深度残差网络SRResNet,当使用广泛使用的PSNR度量进行评估时,该深度残差网络SRResNet在公共基准数据集上设置了新的技术状态。我们强调了这种PSNR聚焦图像超分辨率的一些局限性,并引入了SRGAN,它通过训练GAN来增加具有对抗损失的内容损失函数。通过广泛的MOS测试,我们已经证实,SRGAN重建的大尺度放大因子(4倍)比最先进的参考方法获得的重建更具照片真实感。