python网络-多线程(22)

一、什么是线程

线程(英语:thread)是操作系统能够进行运算调度的最小单位。它被包含在进程之中,是进程中的实际运作单位。同一进程中的多条线程将共享该进程中的全部系统资源,一个进程可以有很多线程,每条线程并行执行不同的任务。

二、线程和进程的区别

1、举例:

- 进程,能够完成多任务,比如 在一台电脑上能够同时运行多个QQ

- 线程,能够完成多任务,比如 一个QQ中的多个聊天窗口

2、定义的不同

- 进程是系统进行资源分配和调度的一个独立单位.重点是资源分配和调度

- 线程是进程的一个实体,是CPU调度和分派的基本单位它是比进程更小的能独立运行的基本单位.

3、功能不同

- 一个程序至少有一个进程,一个进程至少有一个线程.

- 线程的划分尺度小于进程(资源比进程少),使得多线程程序的并发性高。

- 进程在执行过程中拥有独立的内存单元,而多个线程共享内存,从而极大地提高了程序的运行效率

- 线程不能够独立执行,必须依存在进程中

4、优缺点

- 线程和进程在使用上各有优缺点:线程执行开销小,但不利于资源的管理和保护;而进程正相反。

三、threading模块

1、单线程执行

#coding=utf-8 import time def sayHi(): print("Hello I am Se7eN_HOU") time.sleep(1) if __name__ == "__main__": for i in range(5): sayHi()

运行结果为:

2、多线程执行

#coding=utf-8 import threading import time def sayHi(): print("Hello I am Se7eN_HOU") time.sleep(1) if __name__ == "__main__": for i in range(5): t = threading.Thread(target = sayHi) t.start()

运行结果为:

说明

- 可以明显看出使用了多线程并发的操作,花费时间要短很多

- 创建好的线程,需要调用

start()方法来启动

3、查看线程数量

#coding=utf-8 import threading from time import sleep,ctime def sing(): for i in range(3): print("正在唱歌...%d"%i) sleep(1) def dance(): for i in range(3): print("正在跳舞...%d"%i) sleep(1) if __name__ == '__main__': print("---开始---") t1 = threading.Thread(target=sing) t2 = threading.Thread(target=dance) t1.start() t2.start() while True: length = len(threading.enumerate()) print("当前运行的线程数为:%d"%length) if length<=1: break sleep(0.5)

运行结果为:

四、Thread子类的封装

通过使用threading模块能完成多任务的程序开发,为了让每个线程的封装性更完美,所以使用threading模块时,往往会定义一个新的子类class,只要继承threading.Thread就可以了,然后重写run方法

#coding=utf-8 import threading import time class MyThread1(threading.Thread): def run(self): for i in range(3): time.sleep(1) msg = "I'm "+self.name+' @ '+str(i) #name属性中保存的是当前线程的名字 print(msg) class MyThread2(threading.Thread): def run(self): for i in range(3): time.sleep(1) msg = "I'm "+self.name+' @ '+str(i) #name属性中保存的是当前线程的名字 print(msg) if __name__ == '__main__': t1 = MyThread1() t2 = MyThread2() t1.start() t2.start()

运行结果为:

说明

- python的threading.Thread类有一个run方法,用于定义线程的功能函数,可以在自己的线程类中覆盖该方法。

- 创建自己的线程实例后,通过Thread类的start方法,可以启动该线程,当该线程获得执行的机会时,就会调用run方法执行线程。

2. 线程的执行顺序

#coding=utf-8 import threading import time class MyThread(threading.Thread): def run(self): for i in range(3): time.sleep(1) msg = "I'm "+self.name+' @ '+str(i) #name属性中保存的是当前线程的名字 print(msg) def test(): for i in range(1,5): t=MyThread() t.start() if __name__ == '__main__': test()

运行结果为:

说明:

从代码和执行结果我们可以看出,多线程程序的执行顺序是不确定的。当执行到sleep语句时,线程将被阻塞(Blocked),到sleep结束后,线程进入就绪(Runnable)状态,等待调度。而线程调度将自行选择一个线程执行。上面的代码中只能保证每个线程都运行完整个run函数,但是线程的启动顺序、run函数中每次循环的执行顺序都不能确定。

总结:

- 每个线程一定会有一个名字,尽管上面的例子中没有指定线程对象的name,但是python会自动为线程指定一个名字。

- 当线程的run()方法结束时该线程完成。

- 无法控制线程调度程序,但可以通过别的方式来影响线程调度的方式。

线程的几种状态

五、多线程-全局变量(共享)、局部变量(不共享)

1、共享全局变量

from threading import Thread import time g_num = 100 def work1(): global g_num for i in range(3): g_num += 1 print("----in work1, g_num is %d---"%g_num) def work2(): global g_num print("----in work2, g_num is %d---"%g_num) print("---线程创建之前,g_num is %d---"%g_num) t1 = Thread(target=work1) t1.start() #延时一会,保证t1线程中的事情做完 time.sleep(1) t2 = Thread(target=work2) t2.start()

运行结果为:

---线程创建之前,g_num is 100--- ----in work1, g_num is 101--- ----in work1, g_num is 102--- ----in work1, g_num is 103--- ----in work2, g_num is 103---

2、列表当做实参传递到线程中

from threading import Thread import time def work1(nums): nums.append(44) print("----in work1---",nums) def work2(nums): #延时一会,保证t1线程中的事情做完 time.sleep(1) print("----in work2---",nums) g_nums = [11,22,33] t1 = Thread(target=work1, args=(g_nums,)) t1.start() t2 = Thread(target=work2, args=(g_nums,)) t2.start()

运行结果为:

----in work1--- [11, 22, 33, 44] ----in work2--- [11, 22, 33, 44]

2、不共享局部变量

import threading from time import sleep def test(sleepTime): num=1 sleep(sleepTime) num+=1 print('---(%s)--num=%d'%(threading.current_thread(), num)) t1 = threading.Thread(target = test,args=(5,)) t2 = threading.Thread(target = test,args=(1,)) t1.start() t2.start()

运行结果为:

---(<Thread(Thread-2, started 12236)>)--num=2 ---(<Thread(Thread-1, started 5644)>)--num=2

总结:

- 在一个进程内的所有线程共享全局变量,能够在不使用其他方式的前提下完成多线程之间的数据共享(这点要比多进程要好)

- 缺点就是,线程是对全局变量随意遂改可能造成多线程之间对全局变量的混乱(即线程非安全)

- 在多线程开发中,全局变量是多个线程都共享的数据,而局部变量等是各自线程的,是非共享的

六、同步

1、线程冲突

假设两个线程t1和t2都要对num=0进行增1运算,t1和t2都各对num修改10次,num的最终的结果应该为20。但是由于是多线程访问,有可能出现下面情况:

在num=0时,t1取得num=0。此时系统把t1调度为”sleeping”状态,把t2转换为”running”状态,t2也获得num=0。然后t2对得到的值进行加1并赋给num,使得num=1。然后系统又把t2调度为”sleeping”,把t1转为”running”。线程t1又把它之前得到的0加1后赋值给num。这样,明明t1和t2都完成了1次加1工作,但结果仍然是num=1。

from threading import Thread import time g_num = 0 def test1(): global g_num for i in range(1000000): g_num += 1 print("---test1---g_num=%d"%g_num) def test2(): global g_num for i in range(1000000): g_num += 1 print("---test2---g_num=%d"%g_num) p1 = Thread(target=test1) p1.start() #time.sleep(3) #取消屏蔽之后 再次运行程序,结果会不一样 p2 = Thread(target=test2) p2.start() print("---g_num=%d---"%g_num) time.sleep(3) print("---g_num=%d---"%g_num)

运行结果为:

---g_num=138526--- ---test1---g_num=1264273 ---test2---g_num=1374945 ---g_num=1374945---

取消屏蔽之后,再次运行结果如下:

---test1---g_num=1000000 ---g_num=1029220--- ---test2---g_num=2000000 ---g_num=2000000---

问题产生的原因就是没有控制多个线程对同一资源的访问,对数据造成破坏,使得线程运行的结果不可预期。这种现象称为“线程不安全”。

2. 什么是同步

- 同步就是协同步调,按预定的先后次序进行运行。如:你说完,我再说。

- "同"字从字面上容易理解为一起动作,其实不是,"同"字应是指协同、协助、互相配合。

- 如进程、线程同步,可理解为进程或线程A和B一块配合,A执行到一定程度时要依靠B的某个结果,于是停下来,示意B运行;B依言执行,再将结果给A;A再继续操作。

3. 解决问题的思路

对于上面提出的那个计算错误的问题,可以通过线程同步来进行解决思路,如下:

- 系统调用t1,然后获取到num的值为0,此时上一把锁,即不允许其他现在操作num

- 对num的值进行+1

- 解锁,此时num的值为1,其他的线程就可以使用num了,而且是num的值不是0而是1

- 同理其他线程在对num进行修改时,都要先上锁,处理完后再解锁,在上锁的整个过程中不允许其他线程访问,就保证了数据的正确性

七、线程互斥锁

一、线程互斥锁介绍

当多个线程几乎同时修改某一个共享数据的时候,需要进行同步控制,线程同步能够保证多个线程安全访问竞争资源,最简单的同步机制是引入互斥锁。

互斥锁为资源引入一个状态:锁定/非锁定

某个线程要更改共享数据时,先将其锁定,此时资源的状态为“锁定”,其他线程不能更改;直到该线程释放资源,将资源的状态变成“非锁定”,其他的线程才能再次锁定该资源。互斥锁保证了每次只有一个线程进行写入操作,从而保证了多线程情况下数据的正确性。

threading模块中定义了Lock类,可以方便的处理锁定:

#创建锁 mutex = threading.Lock() #锁定 mutex.acquire([blocking]) #释放 mutex.release()

其中,锁定方法acquire可以有一个blocking参数。

- 如果设定blocking为True,则当前线程会堵塞,直到获取到这个锁为止(如果没有指定,那么默认为True)

- 如果设定blocking为False,则当前线程不会堵塞

使用互斥锁实现上面的例子的代码如下:

from threading import Thread, Lock import time g_num = 0 def test1(): global g_num for i in range(1000000): #True表示堵塞 即如果这个锁在上锁之前已经被上锁了,那么这个线程会在这里一直等待到解锁为止 #False表示非堵塞,即不管本次调用能够成功上锁,都不会卡在这,而是继续执行下面的代码 mutexFlag = mutex.acquire(True) if mutexFlag:#锁住 g_num += 1 mutex.release()#解锁 print("---test1---g_num=%d"%g_num) def test2(): global g_num for i in range(1000000): mutexFlag = mutex.acquire(True) #True表示堵塞 if mutexFlag:#锁住 g_num += 1 mutex.release()#解锁 print("---test2---g_num=%d"%g_num) #创建一个互斥锁 #这个所默认是未上锁的状态 mutex = Lock() p1 = Thread(target=test1) p1.start() p2 = Thread(target=test2) p2.start() time.sleep(5) print("---g_num=%d---"%g_num)

运行结果为:

---test1---g_num=1942922 ---test2---g_num=2000000 ---g_num=2000000---

2、上锁解锁过程

- 当一个线程调用锁的acquire()方法获得锁时,锁就进入“locked”状态。

- 每次只有一个线程可以获得锁。如果此时另一个线程试图获得这个锁,该线程就会变为“blocked”状态,称为“阻塞”,直到拥有锁的线程调用锁的release()方法释放锁之后,锁进入“unlocked”状态。

- 线程调度程序从处于同步阻塞状态的线程中选择一个来获得锁,并使得该线程进入运行(running)状态。

总结

锁的好处:

- 确保了某段关键代码只能由一个线程从头到尾完整地执行

锁的坏处:

- 阻止了多线程并发执行,包含锁的某段代码实际上只能以单线程模式执行,效率就大大地下降了

- 由于可以存在多个锁,不同的线程持有不同的锁,并试图获取对方持有的锁时,可能会造成死锁

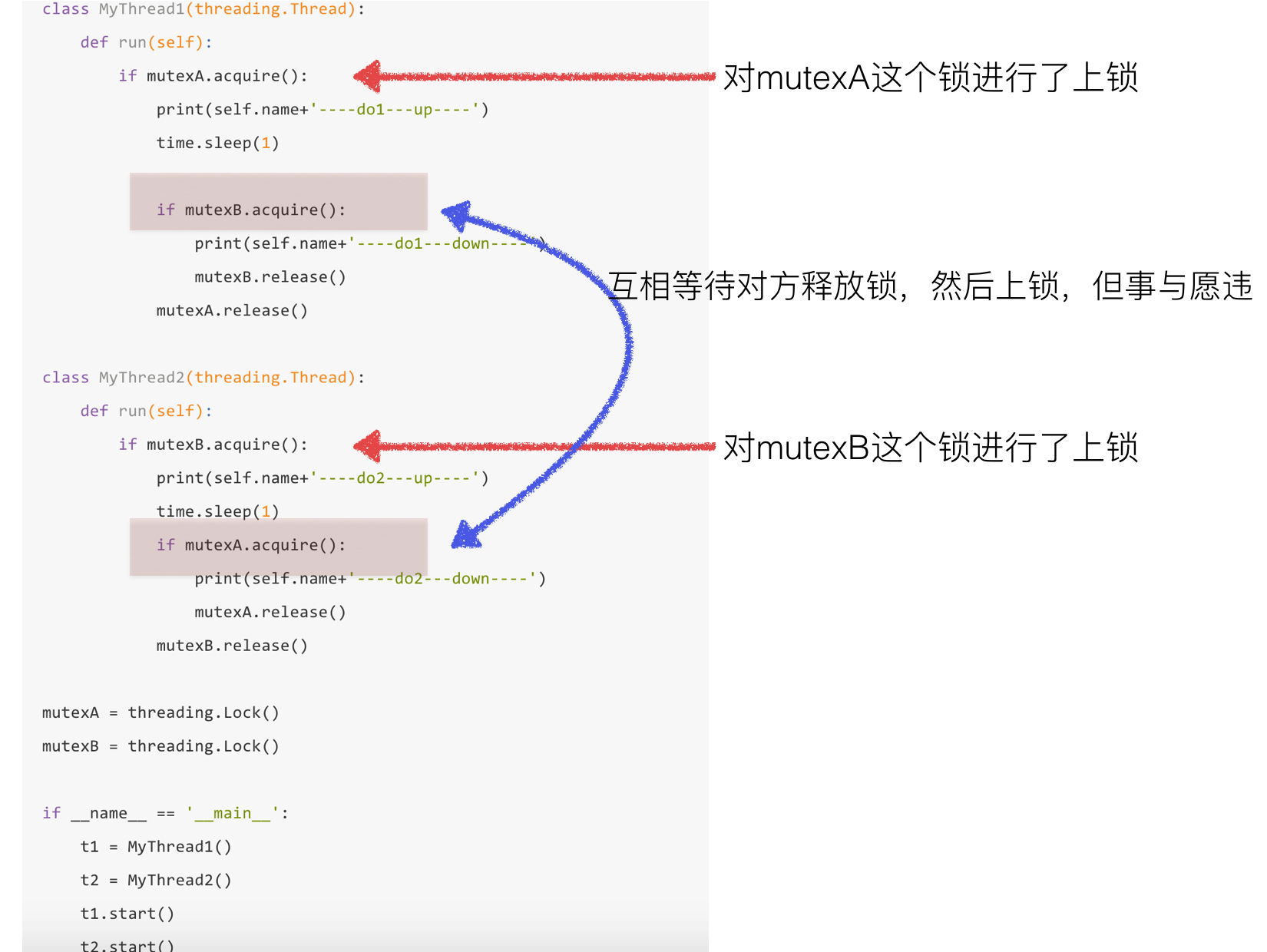

3、死锁

在线程间共享多个资源的时候,如果两个线程分别占有一部分资源并且同时等待对方的资源,就会造成死锁。

尽管死锁很少发生,但一旦发生就会造成应用的停止响应。下面看一个死锁的例子

#coding=utf-8 import threading import time class MyThread1(threading.Thread): def run(self): if mutexA.acquire(): print(self.name+'----do1---up----') time.sleep(1) if mutexB.acquire(): print(self.name+'----do1---down----') mutexB.release() mutexA.release() class MyThread2(threading.Thread): def run(self): if mutexB.acquire(): print(self.name+'----do2---up----') time.sleep(1) if mutexA.acquire(): print(self.name+'----do2---down----') mutexA.release() mutexB.release() mutexA = threading.Lock() mutexB = threading.Lock() if __name__ == '__main__': t1 = MyThread1() t2 = MyThread2() t1.start() t2.start()

运行结果为:

Thread-1----do1---up----

Thread-2----do2---up----

此时已经进入到了死锁状态

4、 避免死锁

- 程序设计时要尽量避免(银行家算法)

- 添加超时时间等

八、同步应用

from threading import Thread,Lock from time import sleep class Task1(Thread): def run(self): while True: if lock1.acquire(): print("------Task 1 -----") sleep(0.5) lock2.release() class Task2(Thread): def run(self): while True: if lock2.acquire(): print("------Task 2 -----") sleep(0.5) lock3.release() class Task3(Thread): def run(self): while True: if lock3.acquire(): print("------Task 3 -----") sleep(0.5) lock1.release() #使用Lock创建出的锁默认没有“锁上” lock1 = Lock() #创建另外一把锁,并且“锁上” lock2 = Lock() lock2.acquire() #创建另外一把锁,并且“锁上” lock3 = Lock() lock3.acquire() t1 = Task1() t2 = Task2() t3 = Task3() t1.start() t2.start() t3.start()

运行结果为:

可以使用互斥锁完成多个任务,有序的进程工作,这就是线程的同步

九、ThreadLocal

在多线程环境下,每个线程都有自己的数据。一个线程使用自己的局部变量比使用全局变量好,因为局部变量只有线程自己能看见,不会影响其他线程,而全局变量的修改必须加锁。

import threading # 创建全局ThreadLocal对象: local_school = threading.local() def process_student(): # 获取当前线程关联的student: std = local_school.student print('Hello, %s (in %s)' % (std, threading.current_thread().name)) def process_thread(name): # 绑定ThreadLocal的student: local_school.student = name process_student() t1 = threading.Thread(target= process_thread, args=("Se7eN",), name='Thread-A') t2 = threading.Thread(target= process_thread, args=("HOU",), name='Thread-B') t1.start() t2.start() t1.join() t2.join()

运行结果为:

Hello, Se7eN (in Thread-A) Hello, HOU (in Thread-B)

说明:

- 全局变量local_school就是一个ThreadLocal对象,每个Thread对它都可以读写student属性,但互不影响。你可以把local_school看成全局变量,但每个属性如local_school.student都是线程的局部变量,可以任意读写而互不干扰,也不用管理锁的问题,ThreadLocal内部会处理。

- ThreadLocal最常用的地方就是为每个线程绑定一个数据库连接,HTTP请求,用户身份信息等,这样一个线程的所有调用到的处理函数都可以非常方便地访问这些资源。

- 一个ThreadLocal变量虽然是全局变量,但每个线程都只能读写自己线程的独立副本,互不干扰。ThreadLocal解决了参数在一个线程中各个函数之间互相传递的问题

十、异步

- 同步调用就是你 喊 你朋友吃饭 ,你朋友在忙 ,你就一直在那等,等你朋友忙完了 ,你们一起去

- 异步调用就是你 喊 你朋友吃饭 ,你朋友说知道了 ,待会忙完去找你 ,你就去做别的了。

def test(): print("---进程池中的进程---pid=%d,ppid=%d--"%(os.getpid(),os.getppid())) for i in range(3): print("----%d---"%i) time.sleep(1) return "hahah" def test2(args): print("---callback func--pid=%d"%os.getpid()) print("---callback func--args=%s"%args) pool = Pool(3) pool.apply_async(func=test,callback=test2) time.sleep(5) print("----主进程-pid=%d----"%os.getpid())

运行结果为:

---进程池中的进程---pid=9401,ppid=9400--

----0---

----1---

----2---

---callback func--pid=9400

---callback func--args=hahah

----主进程-pid=9400----

十一、并行和并发

无论是并行还是并发,在用户看来都是'同时'运行的,不管是进程还是线程,都只是一个任务而已,真是干活的是cpu,cpu来做这些任务,而一个cpu同一时刻只能执行一个任务。

并发是伪并行,即看起来是同时运行。单个cpu+多道技术就可以实现并发,(并行也属于并发),简单的可以理解为快速在多个线程来回切换,感觉好像同时在做多个事情。

只有具备多个cpu才能实现并行,单核下,可以利用多道技术,多个核,每个核也都可以利用多道技术(多道技术是针对单核而言的)。

有四个核,六个任务,这样同一时间有四个任务被执行,假设分别被分配给了cpu1,cpu2,cpu3,cpu4,一旦任务1遇到I/O就被迫中断执行,此时任务5就拿到cpu1的时间片去执行,这就是单核下的多道技术 ,而一旦任务1的I/O结束了,操作系统会重新调用它(需知进程的调度、分配给哪个cpu运行,由操作系统说了算),可能被分配给四个cpu中的任意一个去执行。

多道技术:内存中同时存入多道(多个)程序,cpu从一个进程快速切换到另外一个,使每个进程各自运行几十或几百毫秒,这样,虽然在某一个瞬间,一个cpu只能执行一个任务,但在1秒内,cpu却可以运行多个进程,这就给人产生了并行的错觉,即伪并发,以此来区分多处理器操作系统的真正硬件并行(多个cpu共享同一个物理内存)

- 同步执行:一个进程在执行某个任务时,另外一个进程必须等待其执行完毕,才能继续执行

- 异步执行:一个进程在执行某个任务时,另外一个进程无需等待其执行完毕,就可以继续执行,当有消息返回时,系统会通知后者进行处理,这样可以提高执行效率

举个例子,打电话时就是同步通信,发短息时就是异步通信。

侯哥语录:我曾经是一个职业教育者,现在是一个自由开发者。我希望我的分享可以和更多人一起进步。分享一段我喜欢的话给大家:"我所理解的自由不是想干什么就干什么,而是想不干什么就不干什么。当你还没有能力说不得时候,就努力让自己变得强大,拥有说不得权利。"