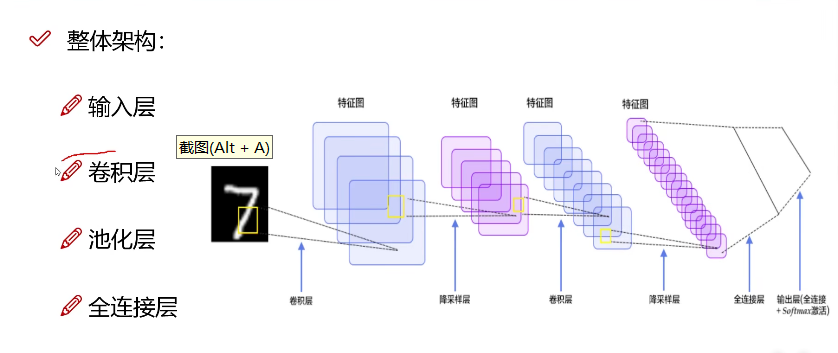

如果一张28*28*1的图像作为输入,那么传统的神经网络输入的是向量,而卷积神经网络输入的是三维矩阵

卷积层

卷积层作用是特征提取,池化层的作用是压缩特征,注意卷积层的卷积策略是不对图像的最外层的像素进行处理

颜色通道的处理策略

3个颜色通道,每个颜色通道分别做计算,再把每个通道卷积结果相加

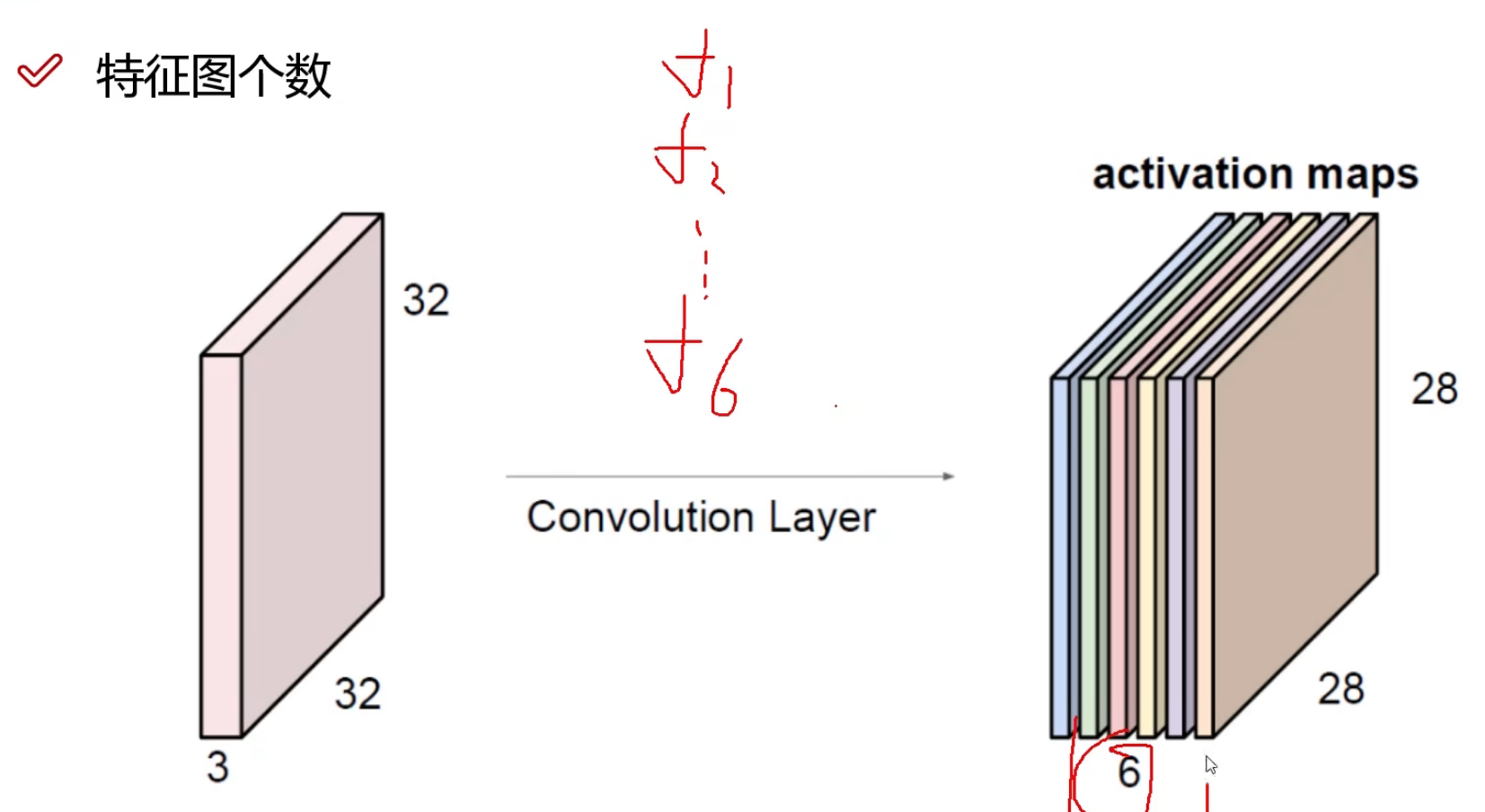

卷积的策略

上图表示一层的卷积,这一层中的卷积核有6个,卷积核的个数代表这一层的深度也就是得到的特征图像的个数,这6个卷积核的尺寸大小相同里面的数值不同,这些数值都是随机初始化的,这6个卷积核分别对这个通道的图像进行卷积,也就是说它们是并联的,并不是一个卷积核对另外一个卷积核的输出结果进行卷积。

卷积的尺寸以及卷积的过程

卷积的过程

卷积的过程如下图所示这里以两个卷积核为例

注意w0代表一个卷积核它的尺寸是3*3*3,其中第一行代表w0这个卷积核对R通道的卷积核,第二行代表w0这个卷积核对G通道的卷积核,第三行代表w0这个卷积核对B通道的卷积核,注意它们的数值不相同。w0,w1处于同一层,如果这一层只有它们两个卷积核那么这一层的深度就是2。

卷积核的尺寸

- 第一层(蓝色)中卷积核的尺寸5*5*3中的3代表输入图像的通道个数,第二层(绿色)中卷积核的尺寸5*5*6中的6代表第一层得到的特征图的个数,以后每一层中的第三个数都代表前一层的特征图的个数。

- 卷积核的尺寸前两个值一般为奇数

卷积的步长

卷积核的中心向右或则向下移动几个像素步长就是几,比如下面的步长为2

步长越小得到的特征图像的尺寸越大,得到的特征更为丰富,计算量越大

一般选用步长为1,卷积核的一维尺寸为3*3

边缘填充

- 上图中原始图像的尺寸应该是5*5*3的,为了方便卷积,也就是要从原始图像中的第一个像素开始卷积,常常将外围填充0。

- 同时由于靠近中心的像素在卷积核的移动过程中能被覆盖多次,而边缘的只会被覆盖一次,导致我们更重视中心的特征,为解决此问题可以进行边缘填充让原本的边界不再是边界

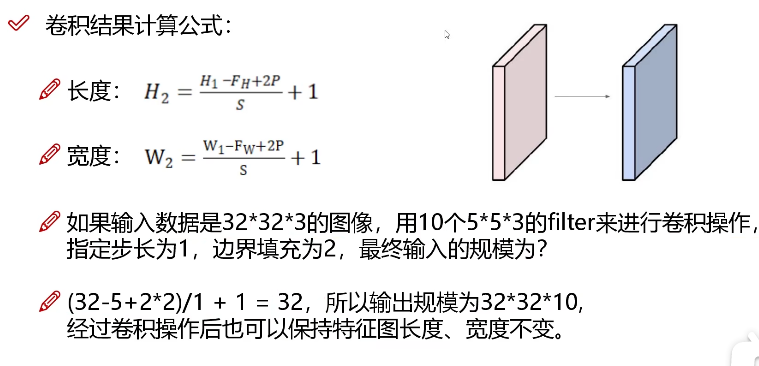

特征图的尺寸

FH,FW为卷积核的前两维尺寸,P为填充的层数,S为步长

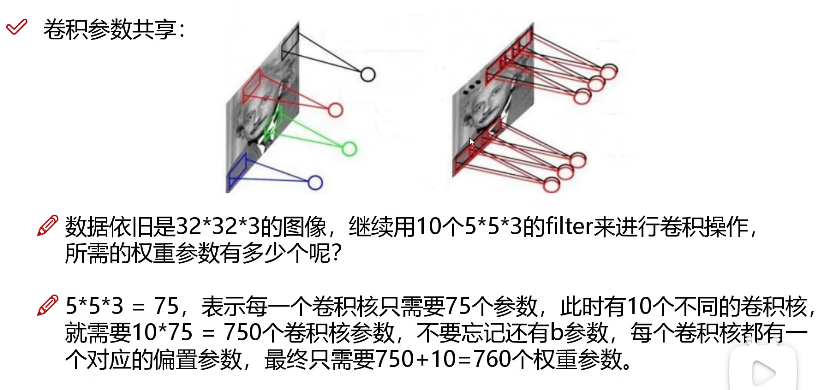

卷积的共享

也就是卷积核在对图像进行卷积的过程中卷积核中的数值始终保持不变,也就是与特征的数量无关,而传统神经网络每个特征都要有一个参数w这就导致了w的数量过于庞大

池化层

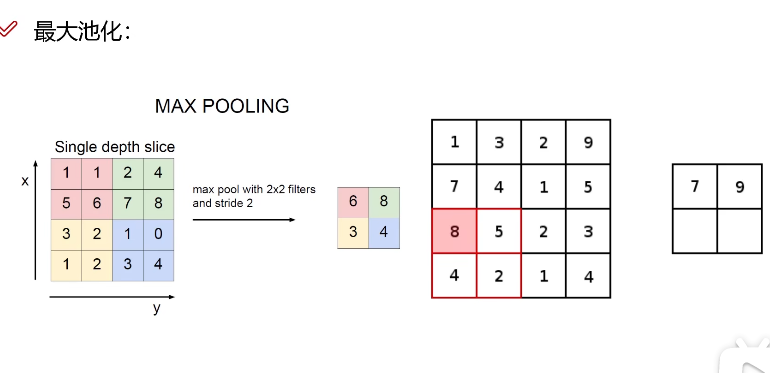

maxpooling(最为常用)

核在特征图中从上到下,从左到右依次滑动(滑动的距离称为步长),窗口内数值最大的我们予以保留,因为不同的卷积核的权重参数是不停改变的特征图中数值较大的像素点代表该特征较为重要。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 从HTTP原因短语缺失研究HTTP/2和HTTP/3的设计差异

· 三行代码完成国际化适配,妙~啊~