会员

周边

新闻

博问

闪存

众包

赞助商

Chat2DB

所有博客

当前博客

我的博客

我的园子

账号设置

会员中心

简洁模式

...

退出登录

注册

登录

RowryCho

好好写代码..

博客园

首页

新随笔

联系

管理

上一页

1

2

3

4

5

6

7

···

16

下一页

2021年10月3日

动手学深度学习 | ResNet为什么能训练出1000层的模型 | 28

摘要: ResNet的梯度计算 最最核心的思想就是乘法变加法。 如果是这种情况,加入g()这一层已经学的很好了,那么梯度就会变小,这样就对f()的梯度也会越来越小(相当于小数字的累乘) 但是如果是残差结构的话,直接使用加法,那么即使g()学的很好,其梯度很小,也不会影响f()的梯度。 正常的深度结构只能是从

阅读全文

posted @ 2021-10-03 08:59 RowryCho

阅读(182)

评论(0)

推荐(0)

2021年10月2日

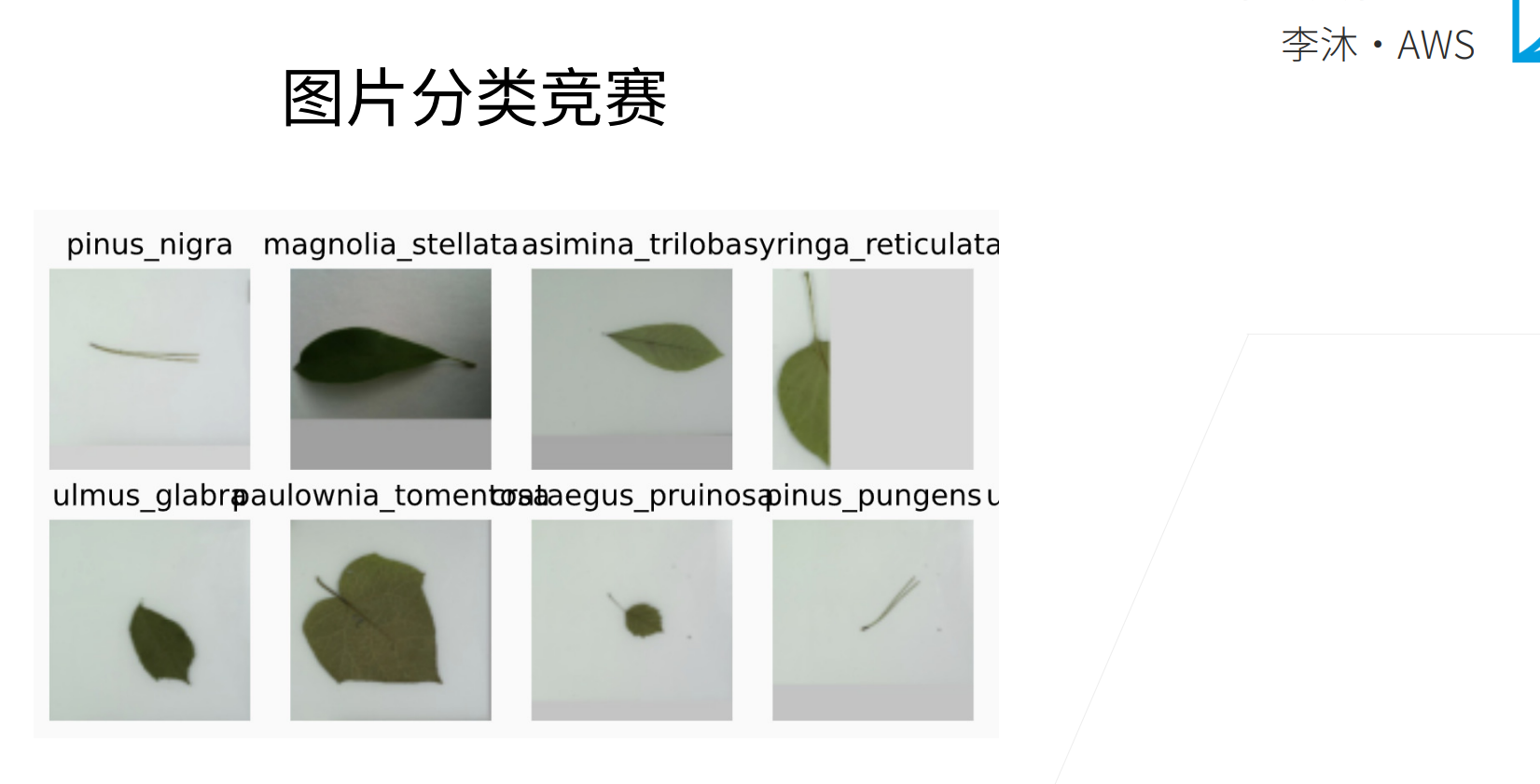

动手学深度学习 | 第二部分完结竞赛:图片分类 | 29

摘要:

阅读全文

posted @ 2021-10-02 17:43 RowryCho

阅读(62)

评论(0)

推荐(0)

动手学深度学习 | 残差网络 ResNet | 27

摘要: ResNet 如果说CNN只要你连接一个网路的话, 那么只要连接ResNet就可以了。ResNet是一个很简单的,也是一个很好用的网络。 模型越复杂精度就越高吗?不是的。可以看下图,五角星是最优解,下面F表示模型的解范围,解范围越大,也就表示模型越复杂,那么可以看到,F3的最优解是比F6的最优解距离

阅读全文

posted @ 2021-10-02 17:34 RowryCho

阅读(230)

评论(0)

推荐(0)

动手学深度学习 | 批量归一化 | 26

摘要: 批量归一化 现在卷积神经网基本都是要使用到BN层的。BN层的思想不新,但是这个特定的层确实是最近几年才出来的,而且大家会发现效果很好。而且当大家要把网络做深的时候,这就是一个不可避免的层了。 梯度在上面的层会大,越往下面梯度会越来越小。 这就导致了一个很大的问题,就是上面的层梯度较大,那么权重更新比

阅读全文

posted @ 2021-10-02 11:21 RowryCho

阅读(148)

评论(0)

推荐(0)

2021年9月30日

动手学深度学习 | 含并行连结的网络GoogLeNet/Inception V3 | 25

摘要: GoogLeNet 虽然现在NiN基本没有被使用,但是GoogLeNet还是被比较多的使用。 这个网路出来的时候也是吓了大家一跳,就是做到了一个几乎快到100层的卷积层,基本可以认为是第一个超过百层的卷积神经网。虽然不是直接有100层深,但确实卷积个数超过了100。 NiN严重影响了GoogLeNe

阅读全文

posted @ 2021-09-30 20:37 RowryCho

阅读(467)

评论(0)

推荐(0)

2021年9月29日

动手学深度学习 | 循环神经网络RNN的实现 | 55

摘要: RNN从零开始实现 简洁实现 QA num_step是做什么用的? 就是那个T,那个时间维度。 比如下面"你好,世界!",输入这个句子有6个字符,那么这里的num_step/T=6。反过来可以认为这是一个6个样本的分类问题,就是每一个词都是要进行下一个词的预测。这是一个多分类问题,T=6,所以要做到

阅读全文

posted @ 2021-09-29 14:24 RowryCho

阅读(330)

评论(0)

推荐(0)

2021年9月28日

动手学深度学习 | 网络中的网络NiN | 24

摘要: NiN NiN Network in Network,网络中的网络,这个网路现在用的不多,几乎很少被用到,但是它里面提出了比较重要的一些概念,在后面很多网络中都会持续的被用到。 MLP其实是不错的,但是缺点就是参数量实在是太大了! 卷积层的参数相对于MLP会少很多,而且$1*1$卷积是可以达到于ML

阅读全文

posted @ 2021-09-28 22:30 RowryCho

阅读(305)

评论(0)

推荐(0)

动手学深度学习 | 循环神经网络RNN | 54

摘要: RNN 来将我们第一个对序列模型的神经网络——循环神经网络 RNN。 x是“你”,然后会去更新隐变量,要去预测“好”字。 接下来观察到了“好”,更新隐变量后要输一个逗号。 $o_t$是来match$x_t$的输入,但是生成$o_t$的时候你是不能看到$x_t$的。也就是当前时刻的输出是为了预测当前时

阅读全文

posted @ 2021-09-28 09:45 RowryCho

阅读(270)

评论(0)

推荐(0)

2021年9月27日

动手学深度学习 | 使用块的网络VGG | 23

摘要: VGG AlexNet最大的问题是什么呢?最大的问题就是长得不规则,虽然说它是一个变大的LeNet,但是感觉很随意,这里加一点,那里加一点。它的结构不够清晰,大家问了很多问题,为什么要这样,为什么要那样,要怎么变深怎么变宽都不知道。 如果想要把网络变得更深更大,那么就要把网络变得更加regular点

阅读全文

posted @ 2021-09-27 17:57 RowryCho

阅读(212)

评论(0)

推荐(0)

动手学深度学习 | 语言模型 | 53

摘要: 语言模型 一只猴子打字,就算是打到宇宙毁灭,他也打不出莎士比亚的文章。 语言模型的核心是估计联合概率$p(x_1,...,x_t)$,序列模型的核心其实也就是预测整个文本序列出现的概率。 我们使用一个最简单的计数模型来进行建模。 一元只有一个变量,也就是自己,那么就可以认为每个变量都是独立的.. 这

阅读全文

posted @ 2021-09-27 15:46 RowryCho

阅读(135)

评论(0)

推荐(0)

上一页

1

2

3

4

5

6

7

···

16

下一页

公告