【大数据】理解爬虫原理

作业要求:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/2851

1. 简单说明爬虫原理

(1)首先选取一部分精心挑选的种子URL;

(2)将这些URL放入待抓取URL队列;

(3)从待抓取URL队列中取出待抓取在URL,解析DNS,并且得到主机的ip,并将URL对应的网页下载下来,存储进已下载网页库中。此外,将这些URL放进已抓取URL队列。

(4)分析已抓取URL队列中的URL,分析其中的其他URL,并且将URL放入待抓取URL队列,从而进入下一个循环。

2. 理解爬虫开发过程

(1)发起请求

使用http库向目标站点发起请求,即发送一个Request

Request包含:请求头、请求体等

Request模块缺陷:不能执行JS 和CSS 代码

(2)获取响应内容

如果服务器能正常响应,则会得到一个Response

Response包含:html,json,图片,视频等

(3)解析内容

解析html数据:正则表达式(RE模块),第三方解析库如Beautifulsoup,pyquery等

解析json数据:json模块

解析二进制数据:以wb的方式写入文件

(4)保存数据

数据库(MySQL,Mongdb、Redis)

文件

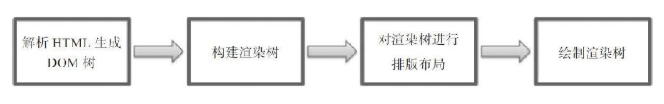

1).简要说明浏览器工作原理;

浏览器内核分成两部分:渲染引擎和js引擎,由于js引擎越来越独立,内核就倾向于只指渲染引擎,负责请求网络页面资源加以解析排版并呈现给用户

默认情况下,渲染引擎可以显示html、xml文档及图片,它也可以借助插件显示其他类型数据,例如使用PDF阅读器插件,可以显示PDF格式

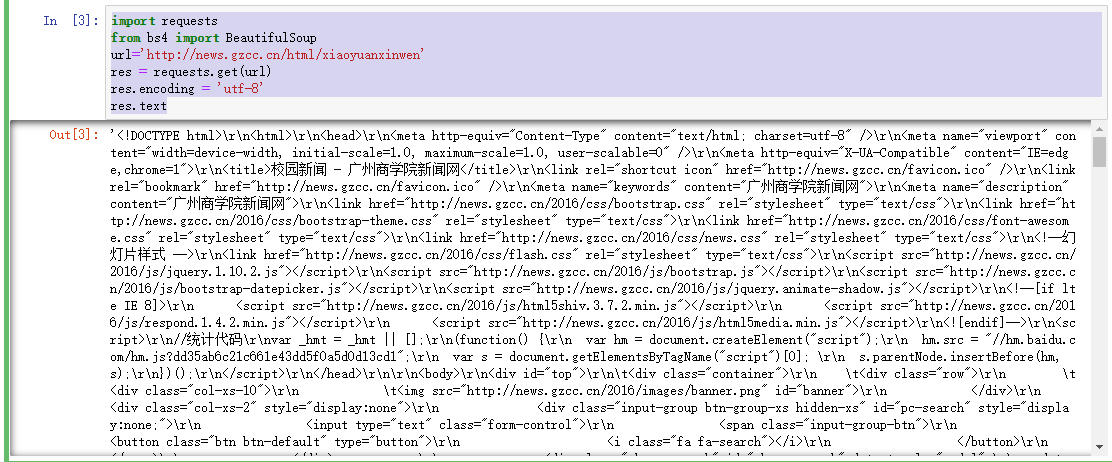

2).使用 requests 库抓取网站数据;

requests.get(url) 获取校园新闻首页html代码

import requests from bs4 import BeautifulSoup url='http://news.gzcc.cn/html/xiaoyuanxinwen' res = requests.get(url) res.encoding = 'utf-8' res.text

3).了解网页

写一个简单的html文件,包含多个标签,类,id

<html> <head> <title>一个 HTML 页面</title> </head> <body> <div class='nav'> <p id='header'>header</p> <p id='body'>body</p> <p id='end'>end</p> </div> <div class='nav'> <p id='header2'>header2</p> <p id='body2'>body2</p> <p id='end2'>end2</p> </div> </body> </html>

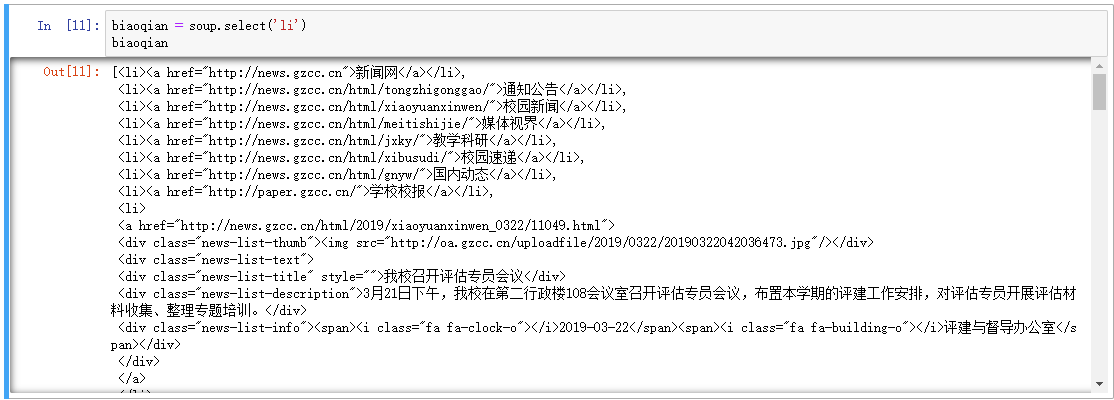

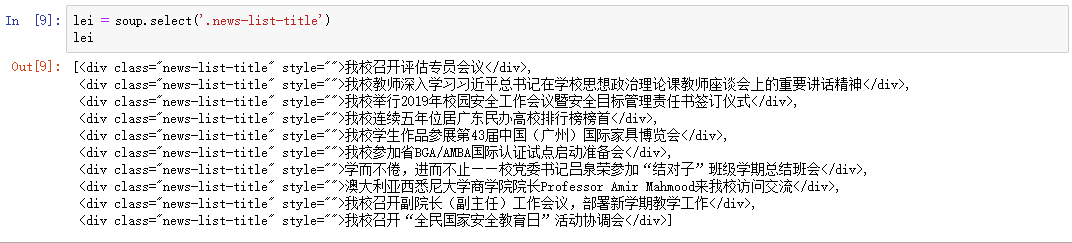

4).使用 Beautiful Soup 解析网页;

通过BeautifulSoup(html_sample,'html.parser')把上述html文件解析成DOM Tree

select(选择器)定位数据

soup = BeautifulSoup(res.text,'html.parser')

找出含有特定标签的html元素

找出含有特定类名的html元素

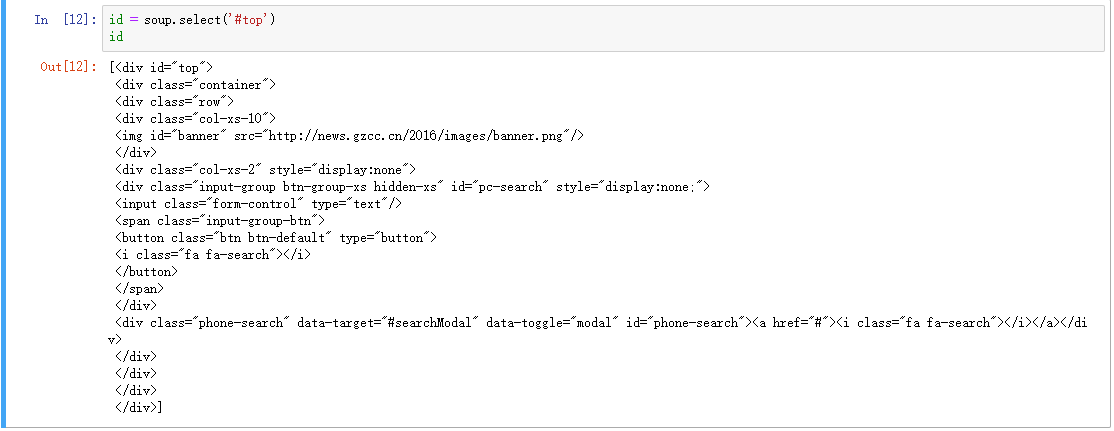

找出含有特定id名的html元素

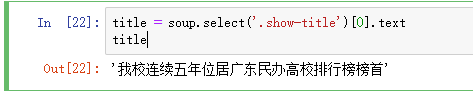

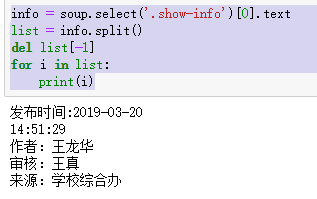

3.提取一篇校园新闻的标题、发布时间、发布单位

url = 'http://news.gzcc.cn/html/2019/xiaoyuanxinwen_0320/11029.html'

- 获取html文本

import requests from bs4 import BeautifulSoup url='http://news.gzcc.cn/html/2019/xiaoyuanxinwen_0320/11029.html' res = requests.get(url) res.encoding = 'utf-8' res.text

- 使用 Beautiful Soup 解析网页

soup = BeautifulSoup(res.text,'html.parser')

- 获取指定信息

title = soup.select('.show-title')[0].text

info = soup.select('.show-info')[0].text list = info.split() del list[-1] for i in list: print(i)

浙公网安备 33010602011771号

浙公网安备 33010602011771号