2019/11/20 Batch Normalization论文学习

学习到的点

-

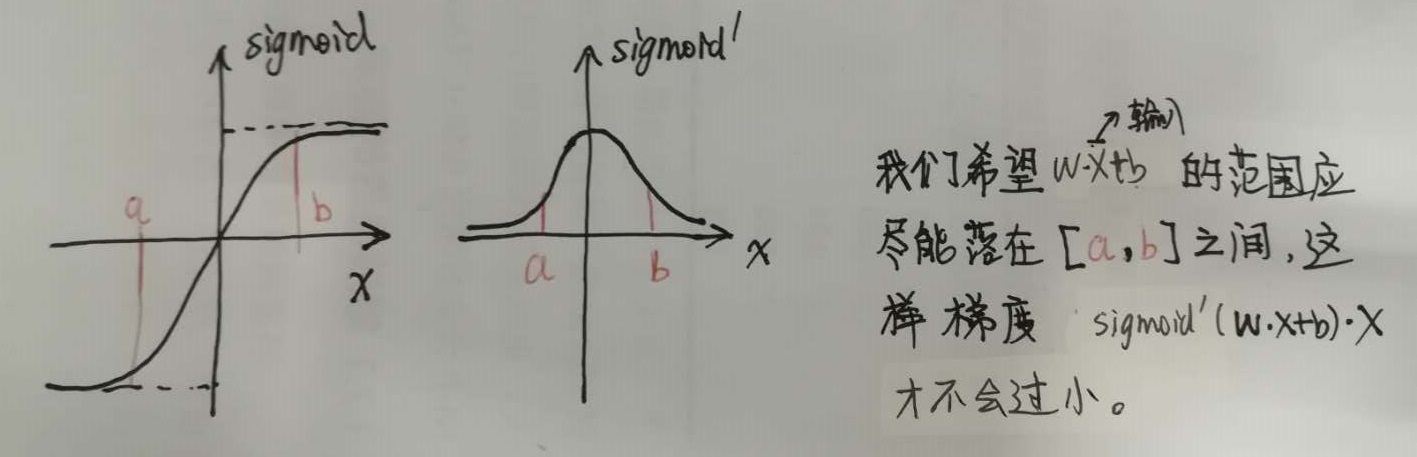

梯度消失原来和饱和线性激活函数有一定关系。设\(sigmoid(W*X+b)\)为一个神经元的函数关系。当更新梯度时,\(W=W-lr*\frac {\partial sigmoid} {\partial W} = W-lr*(W^{'}*X)\),当X很大时候,\(W^{'}|_{X很大}\ =>0\),这样W的更新就会变得非常慢。

-

当选用饱和激活函数时候,一定记得要用BN

-

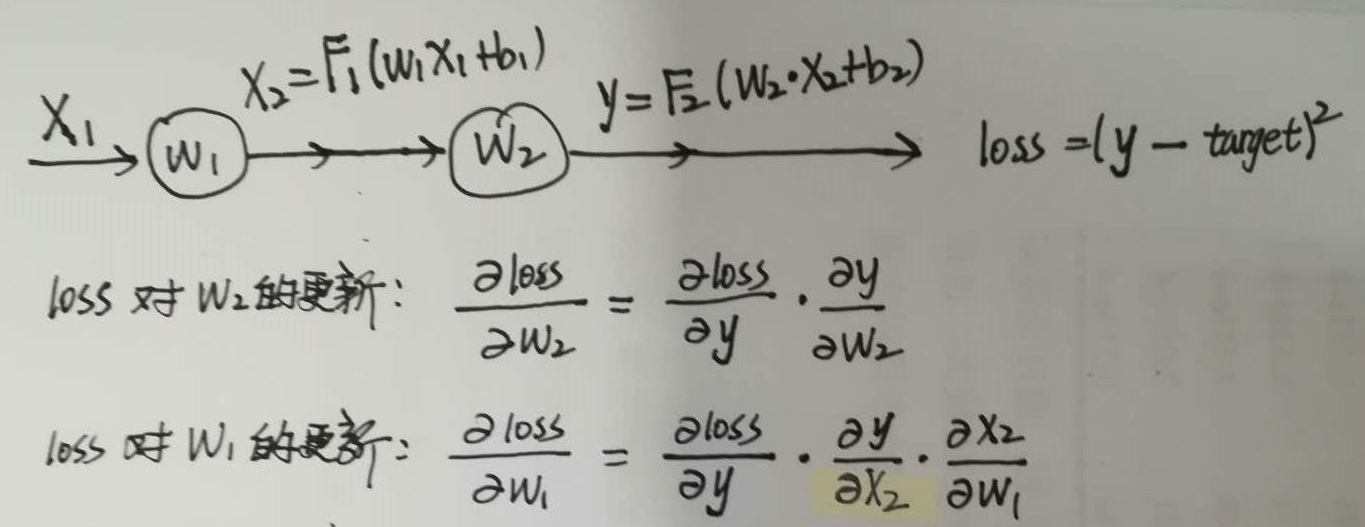

反向传播中,为什么有对中间层输入求导\(\frac {\partial Norm(x,\chi)} {\partial x}\)和\(\frac {\partial Norm(x,\chi)} {\partial \chi}\)?

答:因为中间层输入包含了上一层的参数\(\theta\),链式法则求导。 -

回顾一下反向传播的链式求导规则:

-

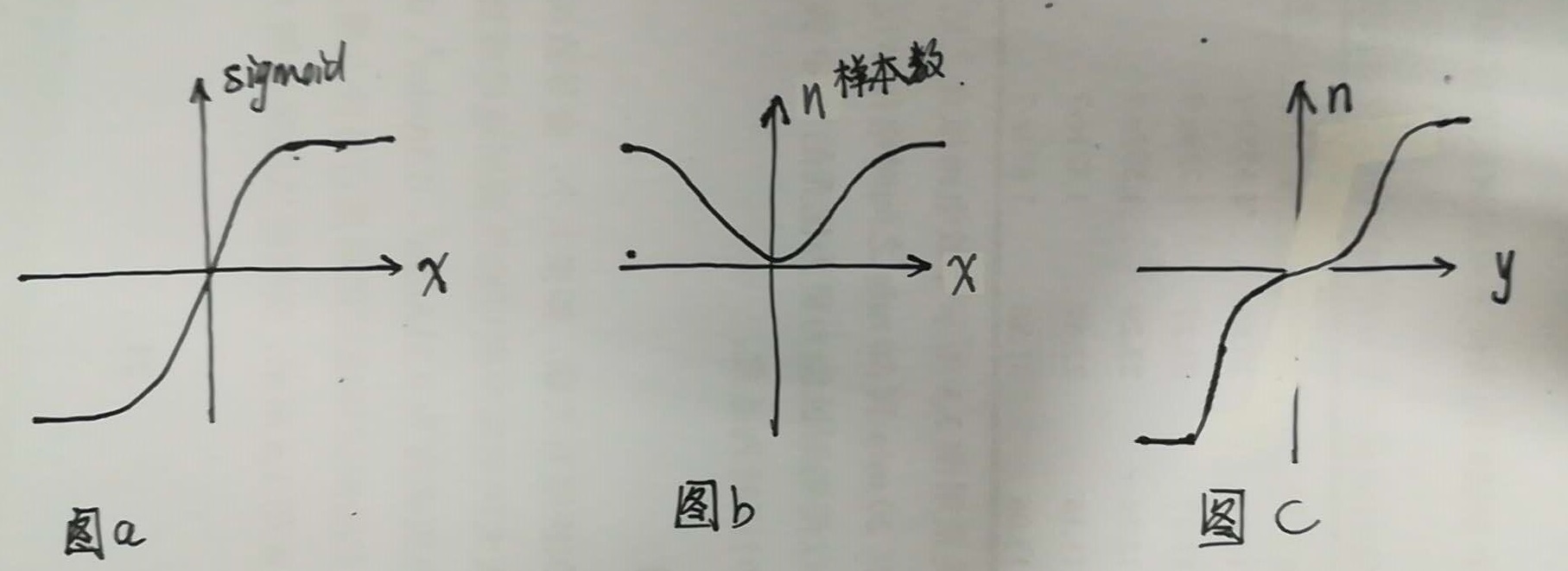

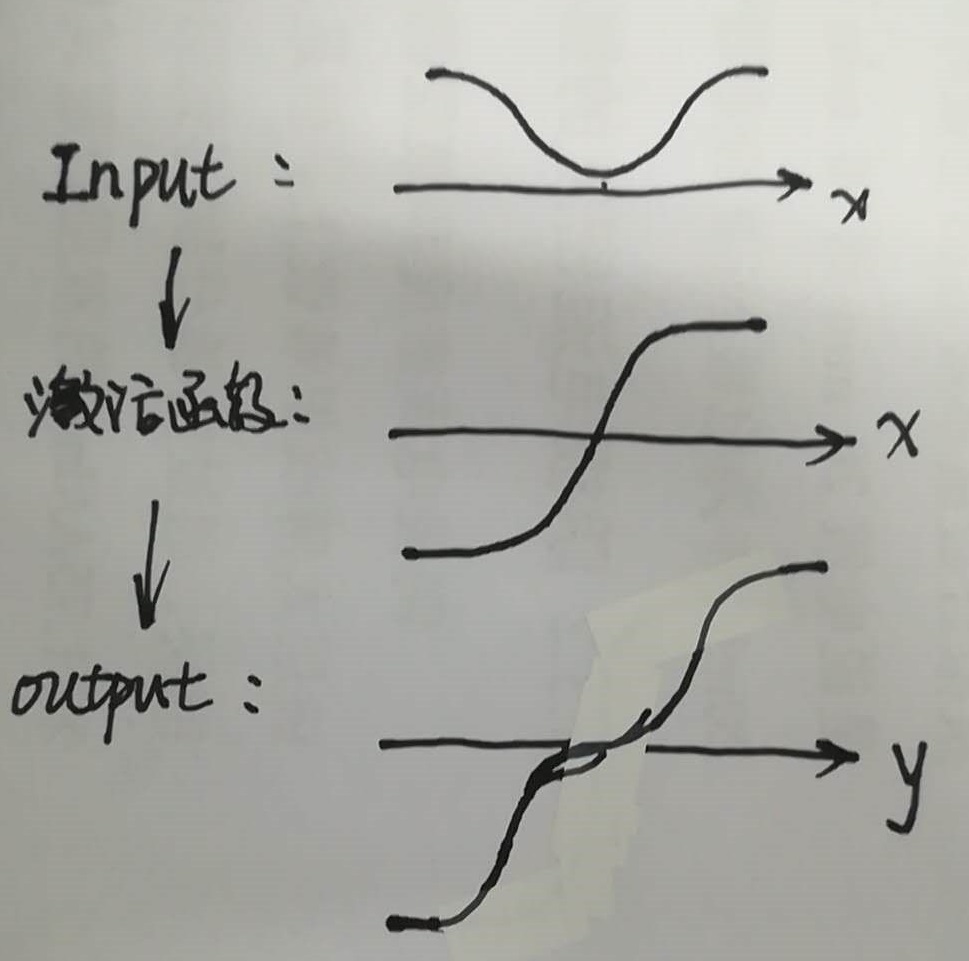

激活函数对输入的分布会产生影响,简单的说,以sigmoid函数为例(图a所示),如果输入样本值的数量分布是如图b所示情况,那么输出的分布将会如图c所示,这样激活函数就改变了之前数据的分布,这种分布的改变如果朝着不好的方向发展会导致网络学不动。