关于爬虫urllib.request模块、urllib.parse模块的基础使用

#构建get参数 data={ "start":(page-1)*number , "limit": number } #将字典转化为 query_string query_string = urllib.parse.urlencode(data) #构建完整的请求url movie_url+=query_string

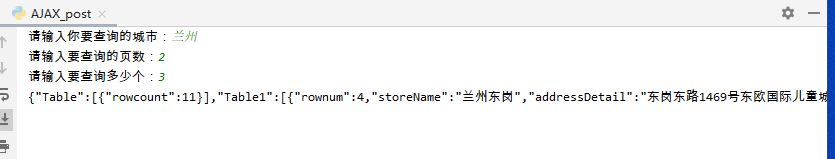

#爬取肯德基餐厅 查询某个地区的餐厅信息 #实则是通过构造post传参 捕获肯德基的查询地址端口 import urllib.request import urllib.parse post_url = "http://www.kfc.com.cn/kfccda/ashx/GetStoreList.ashx?op=keyword" #form_data 生成字典来拼接生成url city= input("请输入你要查询的城市:") page = input("请输入要查询的页数:") size = input("请输入要查询多少个:") #关于post参数 form_data = { 'cname': '', 'pid':'', 'keyword': city, 'pageIndex': page, 'pageSize': size } #构建请求头 headers={ 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:71.0) Gecko/20100101 Firefox/71.0' } #发送请求 request = urllib.request.Request(url=post_url,headers=headers) #post数据需要加这一句编码 form_data =urllib.parse.urlencode(form_data).encode() #获取响应 response = urllib.request.urlopen(request,data=form_data) print(response.read().decode())

作者:求知鱼

-------------------------------------------

个性签名:你有一个苹果,我有一个苹果,我们交换一下,一人还是只有一个苹果;你有一种思想,我有一种思想,我们交换一下,一个人就有两种思想。

如果觉得这篇文章对你有小小的帮助的话,记得在右下角点个“推荐”哦,博主在此感谢!

独学而无友,则孤陋而寡闻,开源、分享、白嫖!