Linux性能优化-认识文件系统

同cpu、内存一样,磁盘和文件系统的管理,也是操作系统最核心的功能

磁盘为系统提供了最基本的持久化存储

文件系统则在磁盘的基础上,提供了一个用来管理文件的树状结构

索引节点和目录项

文件系统,本身是对存储设备上的文件,进行组织管理的机制。组织方式不同,就会形成不同的文件系统。

最重要的一点,在 Linux 中一切皆文件。不仅普通的文件和目录,就连块设备、套接字、管道等,也都要通过统一的文件系统来管理。

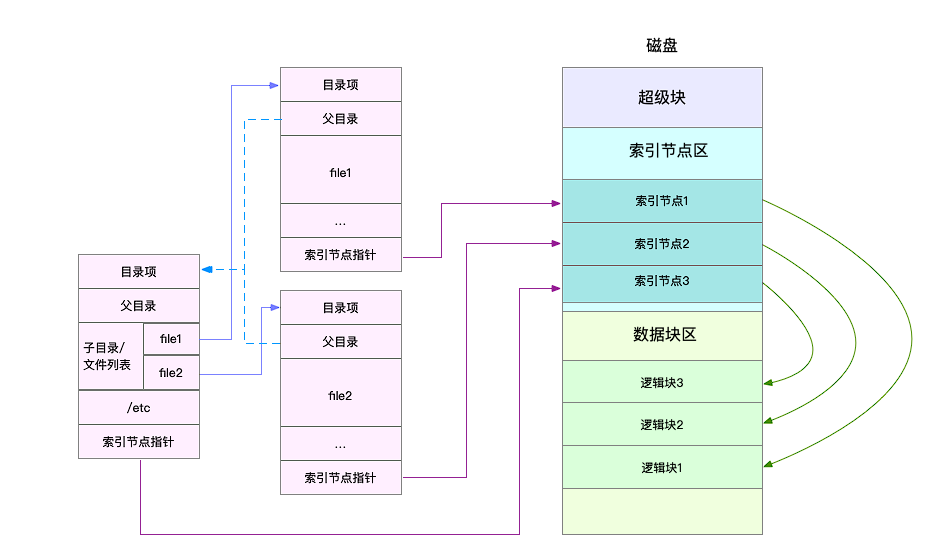

为了方便管理,Linux 文件系统为每个文件都分配两个数据结构,索引节点(index node)和目录项(directory entry)。它们主要用来记录文件的元信息和目录结构。

- 索引节点,简称为 inode,用来记录文件的元数据,比如 inode 编号、文件大小、访问权限、修改日期、数据的位置等。索引节点和文件一一对应,它跟文件内容一样,都会被持久化存储到磁盘中。所以记住,索引节点同样占用磁盘空间。

- 目录项,简称为 dentry,用来记录文件的名字、索引节点指针以及与其他目录项的关联关系。多个关联的目录项,就构成了文件系统的目录结构。不过,不同于索引节点,目录项是由内核维护的一个内存数据结构,所以通常也被叫做目录项缓存。

换句话说,索引节点是每个文件的唯一标志,而目录项维护的正是文件系统的树状结构。目录项和索引节点的关系是多对一,你可以简单理解为,一个文件可以有多个别名。

举个例子,通过硬链接为文件创建的别名,就会对应不同的目录项,不过这些目录项本质上还是链接同一个文件,所以,它们的索引节点相同。

索引节点和目录项纪录了文件的元数据,以及文件间的目录关系,那么具体来说,文件数据到底是怎么存储的呢?是不是直接写到磁盘中就好了呢?

实际上,磁盘读写的最小单位是扇区,然而扇区只有 512B 大小,如果每次都读写这么小的单位,效率一定很低。所以,文件系统又把连续的扇区组成了逻辑块,然后每次都以逻辑块为最小单元,来管理数据。常见的逻辑块大小为 4KB,也就是由连续的 8 个扇区组成。

目录项、索引节点以及文件数据的关系:

有两点需要注意

第一,目录项本身就是一个内存缓存,而索引节点则是存储在磁盘中的数据。为了协调慢速磁盘与快速 CPU 的性能差异,文件内容会缓存到页缓存 Cache 中。这些索引节点自然也会缓存到内存中,加速文件的访问。

第二,磁盘在执行文件系统格式化时,会被分成三个存储区域,超级块、索引节点区和数据块区。

超级块,存储整个文件系统的状态。

索引节点区,用来存储索引节点。

数据块区,则用来存储文件数据。虚拟文件系统

文件系统I/O

把文件系统挂载到挂载点后,你就能通过挂载点,再去访问它管理的文件了。VFS 提供了一组标准的文件访问接口。这些接口以系统调用的方式,提供给应用程序使用。

文件读写方式的各种差异,导致 I/O 的分类多种多样。最常见的有,缓冲与非缓冲 I/O、直接与非直接 I/O、阻塞与非阻塞 I/O、同步与异步 I/O 等。

第一种,根据是否利用标准库缓存,可以把文件 I/O 分为缓冲 I/O 与非缓冲 I/O。

- 缓冲 I/O,是指利用标准库缓存来加速文件的访问,而标准库内部再通过系统调度访问文件。

- 非缓冲 I/O,是指直接通过系统调用来访问文件,不再经过标准库缓存。

第二,根据是否利用操作系统的页缓存,可以把文件 I/O 分为直接 I/O 与非直接 I/O。

- 直接 I/O,是指跳过操作系统的页缓存,直接跟文件系统交互来访问文件。

- 非直接 I/O 正好相反,文件读写时,先要经过系统的页缓存,然后再由内核或额外的系统调用,真正写入磁盘。

第三,根据应用程序是否阻塞自身运行,可以把文件 I/O 分为阻塞 I/O 和非阻塞 I/O:

- 所谓阻塞 I/O,是指应用程序执行 I/O 操作后,如果没有获得响应,就会阻塞当前线程,自然就不能执行其他任务。

- 所谓非阻塞 I/O,是指应用程序执行 I/O 操作后,不会阻塞当前的线程,可以继续执行其他的任务,随后再通过轮询或者事件通知的形式,获取调用的结果。

第四,根据是否等待响应结果,可以把文件 I/O 分为同步和异步 I/O:

- 所谓同步 I/O,是指应用程序执行 I/O 操作后,要一直等到整个 I/O 完成后,才能获得 I/O 响应。

- 所谓异步 I/O,是指应用程序执行 I/O 操作后,不用等待完成和完成后的响应,而是继续执行就可以。等到这次 I/O 完成后,响应会用事件通知的方式,告诉应用程序。

有时候,碰到了空间不足的问题,可是用 df 查看磁盘空间后,却发现剩余空间还有很多。这是怎么回事呢?

除了文件数据,索引节点也占用磁盘空间。你可以给 df 命令加上 -i 参数,查看索引节点的使用情况,如下所示:

$ df -i /dev/sda1

Filesystem Inodes IUsed IFree IUse% Mounted on

/dev/sda1 3870720 157460 3713260 5% /

索引节点的容量,(也就是 Inode 个数)是在格式化磁盘时设定好的,一般由格式化工具自动生成。当你发现索引节点空间不足,但磁盘空间充足时,很可能就是过多小文件导致的。所以,一般来说,删除这些小文件,或者把它们移动到索引节点充足的其他磁盘中,就可以解决这个问题。

缓存

free 输出的 Cache,是页缓存和可回收 Slab 缓存的和,你可以从 /proc/meminfo ,直接得到它们的大小:

$ cat /proc/meminfo | grep -E "SReclaimable|Cached"

Cached: 748316 kB

SwapCached: 0 kB

SReclaimable: 179508 kB

文件系统中的目录项和索引节点缓存,又该如何观察呢?实际上,内核使用 Slab 机制,管理目录项和索引节点的缓存。/proc/meminfo 只给出了 Slab 的整体大小,具体到每一种 Slab 缓存,还要查看 /proc/slabinfo 这个文件。比如,运行下面的命令,所有目录项和各种文件系统索引节点的缓存情况:

$ cat /proc/slabinfo | grep -E '^#|dentry|inode'

# name <active_objs> <num_objs> <objsize> <objperslab> <pagesperslab> : tunables <limit> <batchcount> <sharedfactor> : slabdata <active_slabs> <num_slabs> <sharedavail>

xfs_inode 0 0 960 17 4 : tunables 0 0 0 : slabdata 0 0 0

...

ext4_inode_cache 32104 34590 1088 15 4 : tunables 0 0 0 : slabdata 2306 2306 0hugetlbfs_inode_cache 13 13 624 13 2 : tunables 0 0 0 : slabdata 1 1 0

sock_inode_cache 1190 1242 704 23 4 : tunables 0 0 0 : slabdata 54 54 0

shmem_inode_cache 1622 2139 712 23 4 : tunables 0 0 0 : slabdata 93 93 0

proc_inode_cache 3560 4080 680 12 2 : tunables 0 0 0 : slabdata 340 340 0

inode_cache 25172 25818 608 13 2 : tunables 0 0 0 : slabdata 1986 1986 0

dentry 76050 121296 192 21 1 : tunables 0 0 0 : slabdata 5776 5776 0

这个界面中,dentry 行表示目录项缓存,inode_cache 行,表示 VFS 索引节点缓存,其余的则是各种文件系统的索引节点缓存。

更常使用 slabtop ,来找到占用内存最多的缓存类型。比如,下面就是我运行 slabtop 得到的结果:

# 按下c按照缓存大小排序,按下a按照活跃对象数排序

$ slabtop

Active / Total Objects (% used) : 277970 / 358914 (77.4%)

Active / Total Slabs (% used) : 12414 / 12414 (100.0%)

Active / Total Caches (% used) : 83 / 135 (61.5%)

Active / Total Size (% used) : 57816.88K / 73307.70K (78.9%)

Minimum / Average / Maximum Object : 0.01K / 0.20K / 22.88K

OBJS ACTIVE USE OBJ SIZE SLABS OBJ/SLAB CACHE SIZE NAME

69804 23094 0% 0.19K 3324 21 13296K dentry

16380 15854 0% 0.59K 1260 13 10080K inode_cache

58260 55397 0% 0.13K 1942 30 7768K kernfs_node_cache

485 413 0% 5.69K 97 5 3104K task_struct

1472 1397 0% 2.00K 92 16 2944K kmalloc-2048

思考题

在实际工作中,我们经常会根据文件名字,查找它所在路径,比如:$ find / -name file-name,这个命令,会不会导致系统的缓存升高呢?如果有影响,又会导致哪种类型的缓存升高呢?

这个命令,会不会导致系统的缓存升高呢?

--> 会的

如果有影响,又会导致哪种类型的缓存升高呢?

--> /xfs_inode/ proc_inode_cache/dentry/inode_cache

实验步骤:

1. 清空缓存:echo 3 > /proc/sys/vm/drop_caches ; sync

2. 执行find : find / -name test

3. 发现更新top4 项是:

OBJS ACTIVE USE OBJ SIZE SLABS OBJ/SLAB CACHE SIZE NAME

37400 37400 100% 0.94K 2200 17 35200K xfs_inode

36588 36113 98% 0.64K 3049 12 24392K proc_inode_cache

104979 104979 100% 0.19K 4999 21 19996K dentry

18057 18057 100% 0.58K 1389 13 11112K inode_cache

find / -name 这个命令是全盘扫描(既包括内存文件系统又包含本地的xfs【我的环境没有mount 网络文件系统】),所以 inode cache & dentry & proc inode cache 会升高。

另外,执行过了一次后再次执行find 就机会没有变化了,执行速度也快了很多,也就是下次的find大部分是依赖cache的结果。

浙公网安备 33010602011771号

浙公网安备 33010602011771号