Deep Learning 学习笔记(6):神经网络( Neural Network )

神经元:

在神经网络的模型中,神经元可以表示如下

神经元的左边是其输入,包括变量x1、x2、x3与常数项1,

右边是神经元的输出

神经元的输出函数被称为激活函数(activation function),输出值被称为激活值(activation value)。

激活函数有很多种,其中最简单的莫过于sigmoid函数。

除非特别声明,否则博客里提及的激活函数均为sigmoid

神经网络:

多个神经元首尾相连连接成神经网络(Neural Network),可以表示如下:

尽管生物体中神经云之间的连接会更加复杂,

在常用的模型中,神经元的连接要遵循一定规则,

简单地来说就是要分层:上一层神经元的输出作为下一层的输入,

两层之间单向传递,没有反馈

同层之间的神经元没有交流。

下面我们来描述一下这个模型 :

神经网络  来表示网络的层数,

来表示网络的层数,

其中最左边的叫做出入层,最右边的称为输出层,中间的层被称为隐藏层

隐藏层的借点成为隐藏节点。隐藏层的数量为网络的“深度”

我们将第  层记为

层记为  ,于是

,于是  是输入层,输出层是

是输入层,输出层是  。

。

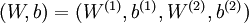

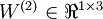

本例神经网络有参数  ,

,

其中 ,  (下面的式子中用到)是第

(下面的式子中用到)是第  层第

层第  单元与第

单元与第  层第

层第  单元之间的联接参数(权重,注意标号顺序),

单元之间的联接参数(权重,注意标号顺序),

是第

是第  层第

层第  单元的偏置项。

单元的偏置项。

因此在本例中,  ,

,  。

。

注意,即偏置单元没有输入

表示第

表示第  层的节点数,偏置单元不计在内

层的节点数,偏置单元不计在内

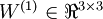

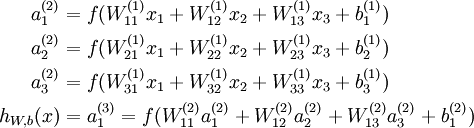

神经网络的计算:

用  表示第

表示第  层第

层第  单元的激活值(输出值),当

单元的激活值(输出值),当  时,

时,

表示第

表示第  层第

层第  单元输入加权和(包括偏置单元)

单元输入加权和(包括偏置单元)

于是, 可以按如下方法计算

可以按如下方法计算

计算过程可以用向量运算简化

这种由输入求输出,从左向右计算的算法,叫做前向传播算法

于是乎这种神经网络也叫做前馈神经网络

(完)

浙公网安备 33010602011771号

浙公网安备 33010602011771号