windos上安装hadoop并将文件上传至HDFS的操作

1. 下载并安装hadoop

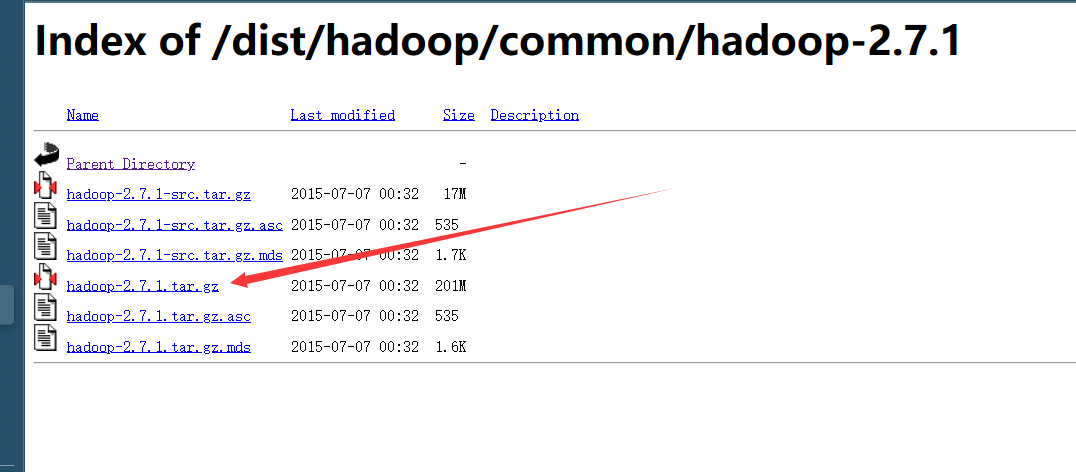

下载解压 hadoop: https://archive.apache.org/dist/hadoop/common/hadoop-2.7.1/

百度网盘: 安装包和配置文件链接:(https://pan.baidu.com/s/1SyORDDF5hxmm5-dZPuHNhA?pwd=1234)

注意:

我使用的是2.7.1版本,官网的Hadoop不支持Windows系统,需要修改一些配置方便在Windows上运行,hadooponwindows-master.zip 解压后

复制解压开的bin文件和etc文件到hadoop-2.7.1文件中,并替换原有的bin和etc文件。同时记住hadoop安装路径

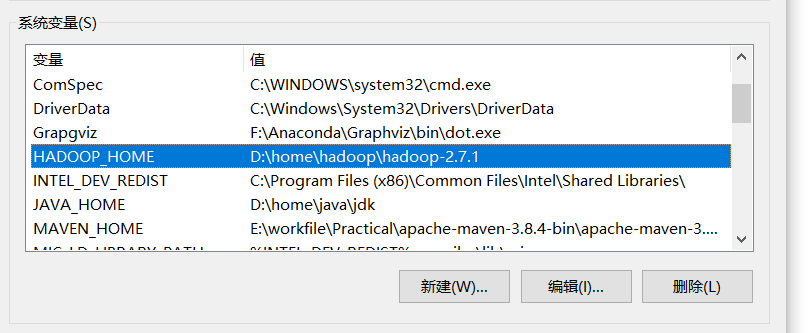

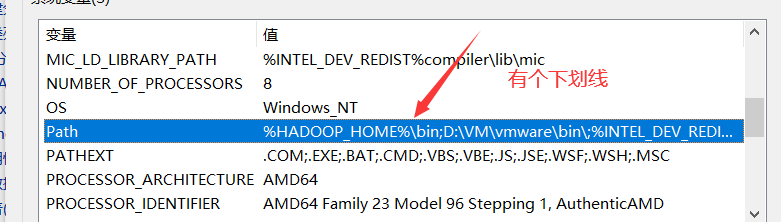

配置环境变量(别敲错啦)

2. 修改配置文件

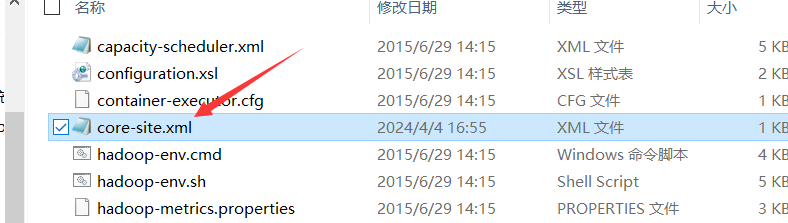

下面操作都在这路径下进行:(下载目录\etc\hadoop)

2.1 core-site.xml文件 (下面也一样)

添加如下代码:

替换后有代码最开始为:

<configuration>

</configuration>

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

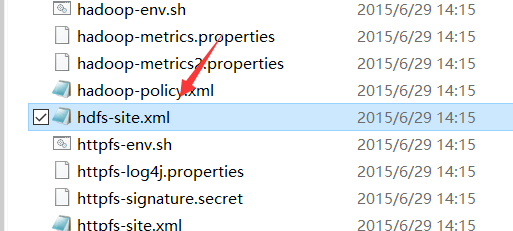

2.2 hdfs-site.xml文件

别着急,添加之前先来创建文件夹

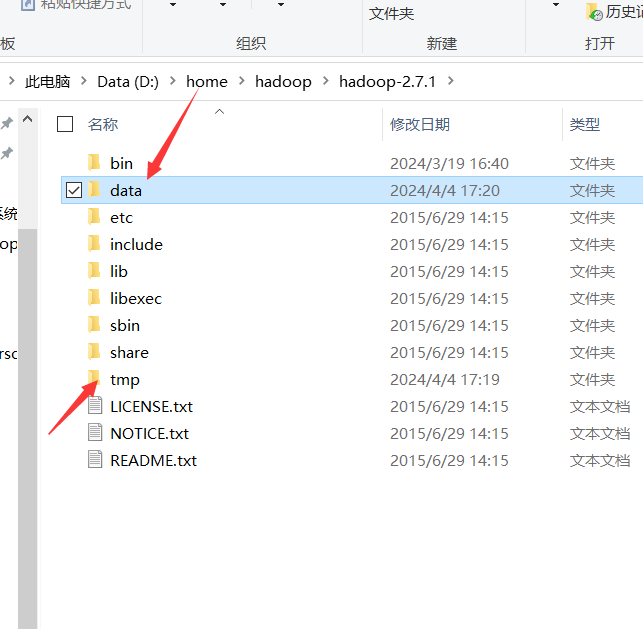

下载目录下

添加tmp文件夹

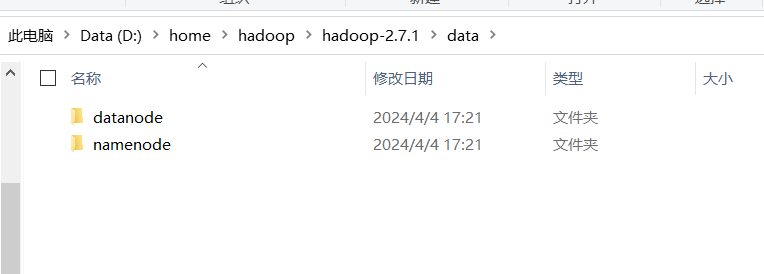

添加data里面创建namenode,datanode子文件夹

现在可以添加了:注意下划线

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/D:/home/hadoop/hadoop-2.7.1/data/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/D:/home/hadoop/hadoop-2.7.1/data/datanode</value>

</property>

</configuration>

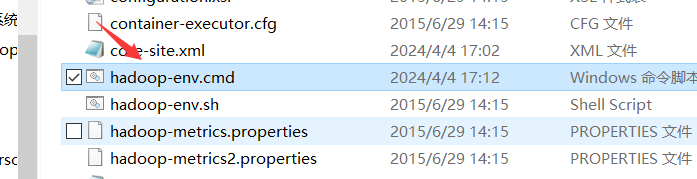

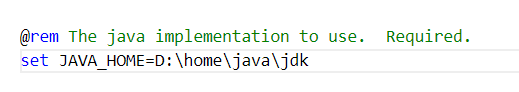

2.3 hadoop-env.cmd文件

set JAVA_HOME=%JAVA_HOME% 把%JAVA_HOME%替换成JDK的绝对路径

2.4 拷贝hadoop.dll

从D:\home\hadoop\hadoop-2.7.1\bin下拷贝hadoop.dll到 C:\Windows\System32 ,不然在window平台使用MapReduce测试时报错

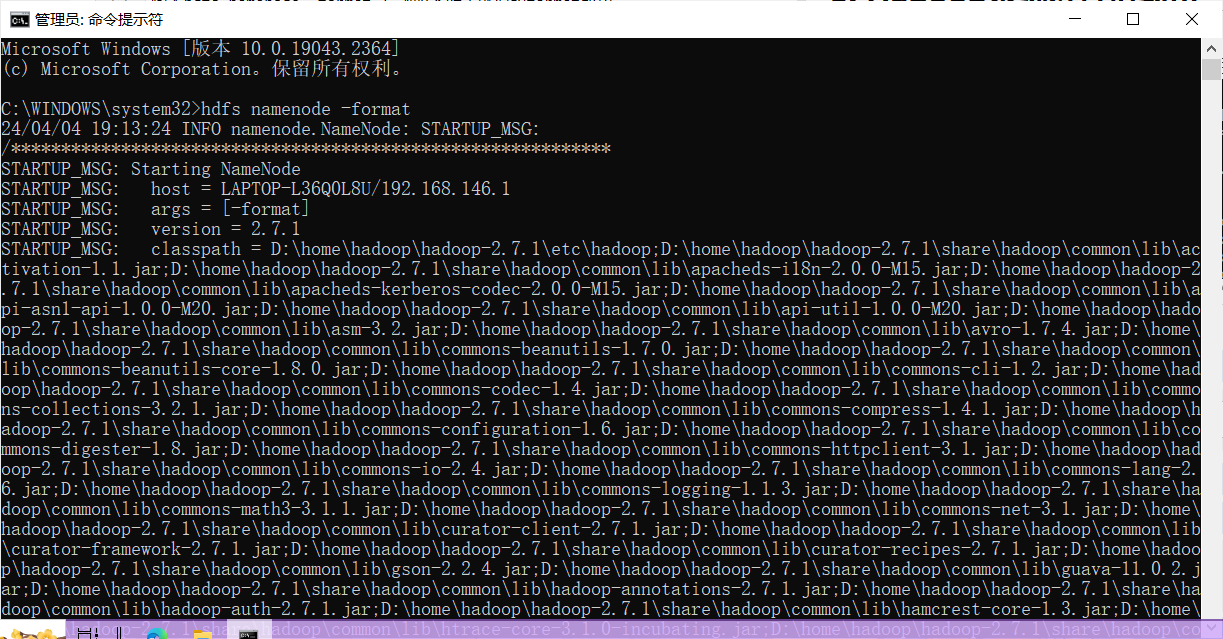

3. Hadoop系统进行格式化

以管理员身份打开命令提示符

输入hdfs namenode -format,看到如下所示就说明format成功

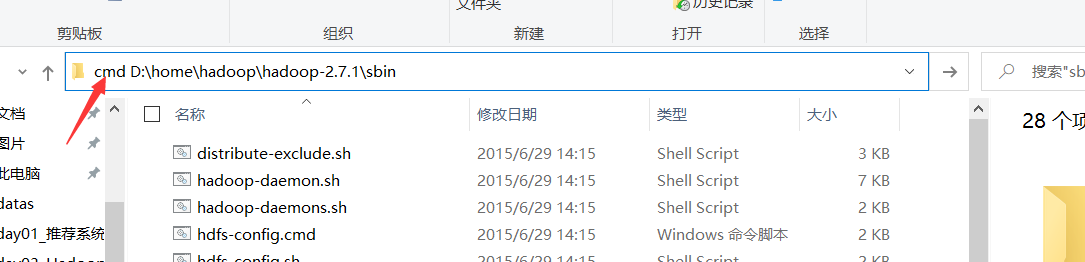

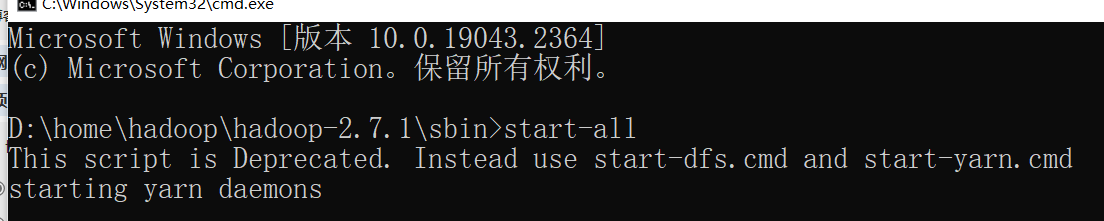

4.启动集群

快捷cmd

输入:start-all,启动hadoop集群

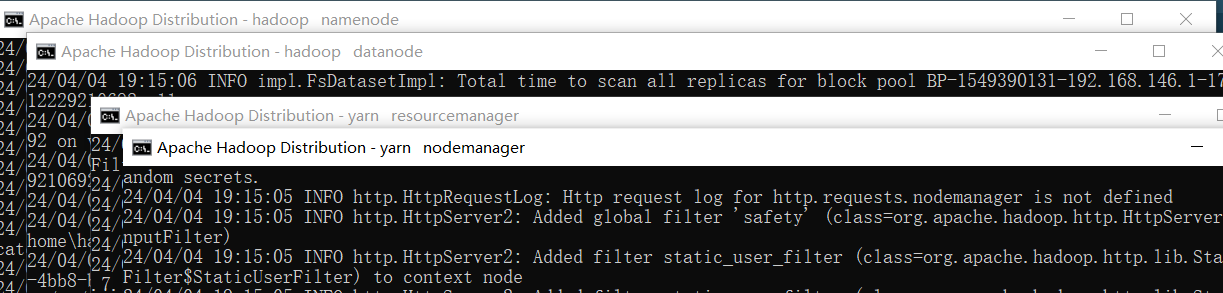

出现四个弹窗表示启动hadoop集群成功(千万别关掉了)

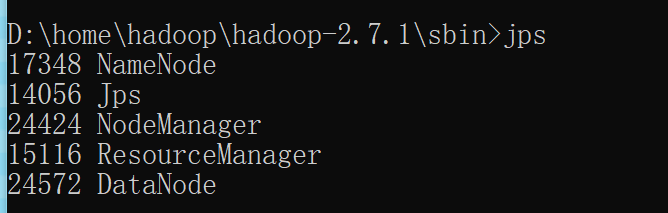

输入jps - 可以查看运行的所有节点

要是没有启动namenode和datanode

重新格式化Hadoop文件系统

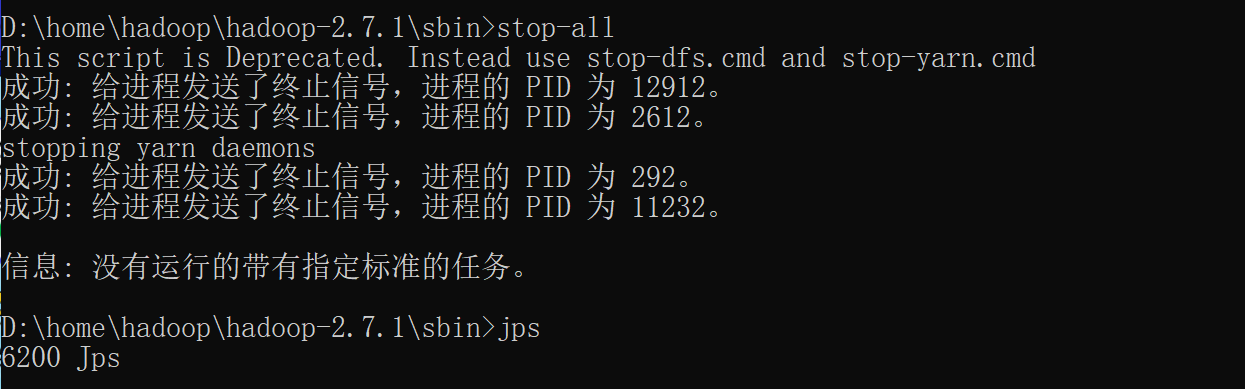

- 停止Hadoop所有进程

stop-all.sh - 删除HADOOP_HOME目录下的logs和tmp目录(关键步骤),安全起见把新建namenode、datanode也看看有多的文件就删除。

- 重新格式化文件系统

hdfs namenode -format - 启动Hadoop进程

start-all

我也遇到节点没有完全启动,查看启动的日志大概指导是路径问题,后面才发现配置文件没有替换(替换后就要重新配置文件)、配置namenode和datanode的时候在路径前面一定要有'/'。最终所有节点启动成功。亲测有效。

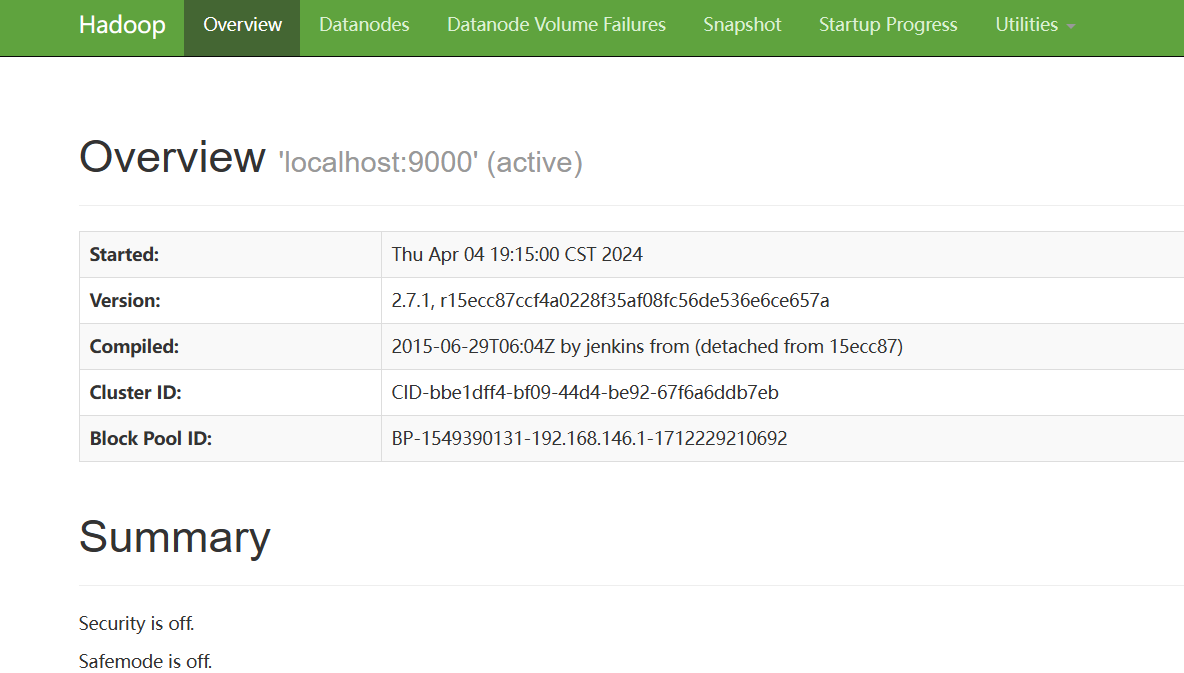

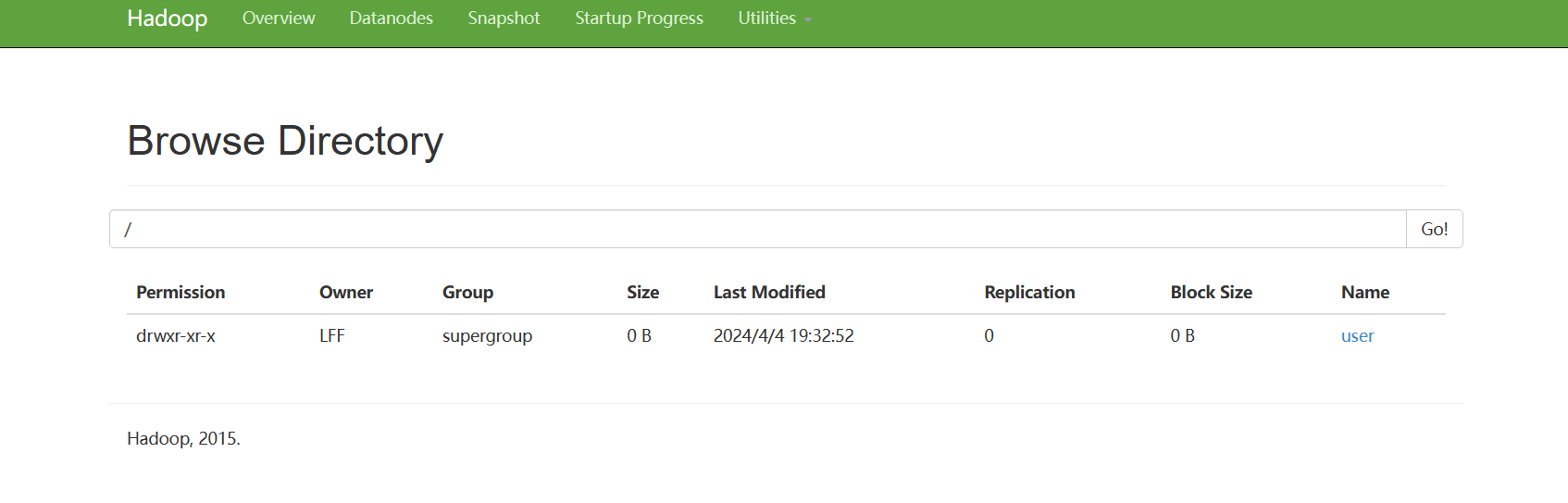

访问 http://localhost:50070,访问hadoop的web界面

在WEB管理页面中,点击顶部右侧的菜单选项“Utilities”,在弹出的子菜单中点击“Browse the file system”,会出现HDFS文件系统操作页面,在这个页面中可以创建、查看、删除目录和文件

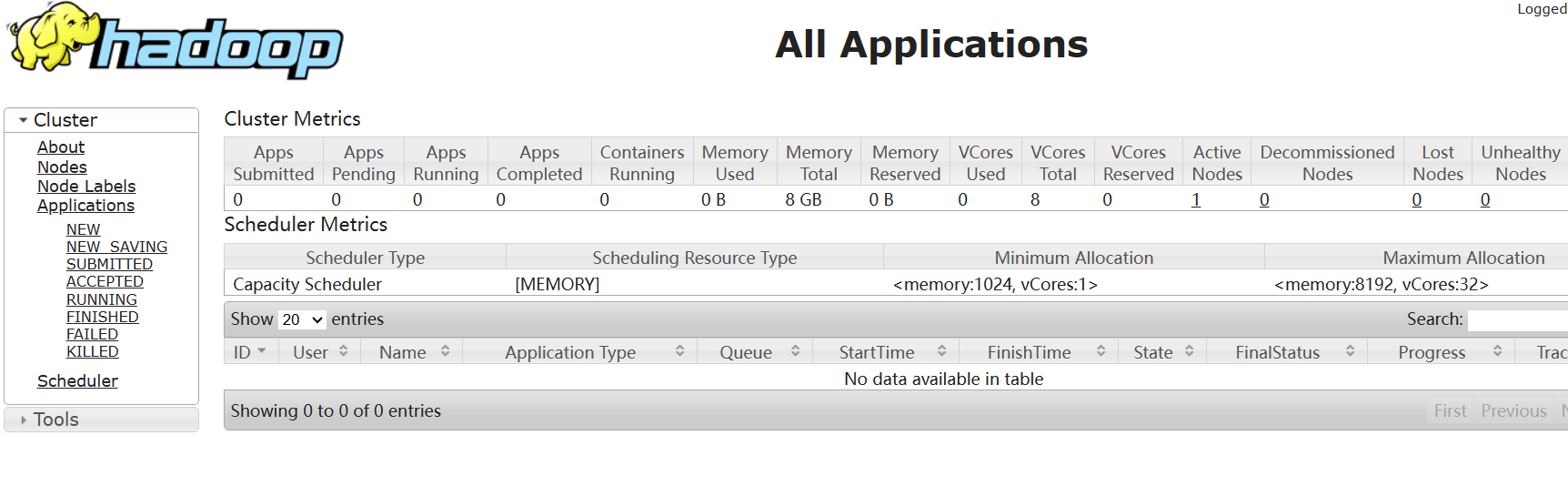

访问 http://localhost:8088,访问yarn的web界面,有就表明已经成功

5.关闭集群

注意:要想接着操作下面的内容你就不要关闭集群

停止运行的所有节点的命令stop-all

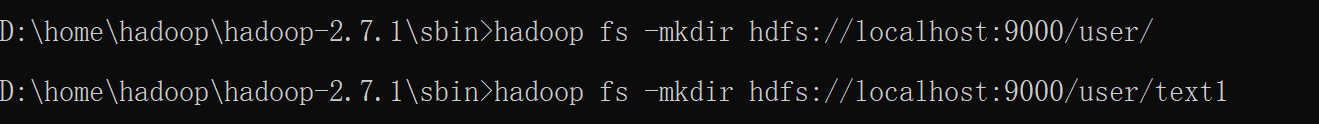

6.上传测试

hadoop fs -mkdir hdfs://localhost:9000/user/

hadoop fs -mkdir hdfs://localhost:9000/user/text1

菜单选项"Utilities",在弹出的子菜单中点击“Browse the file system”

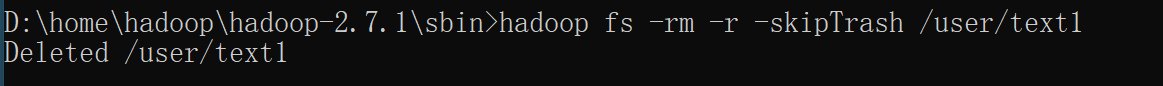

删除文件夹

hadoop fs -rm -r -skipTrash /user/text1

hdfs dfs -rm -r /user //此种方式user目录也会删掉

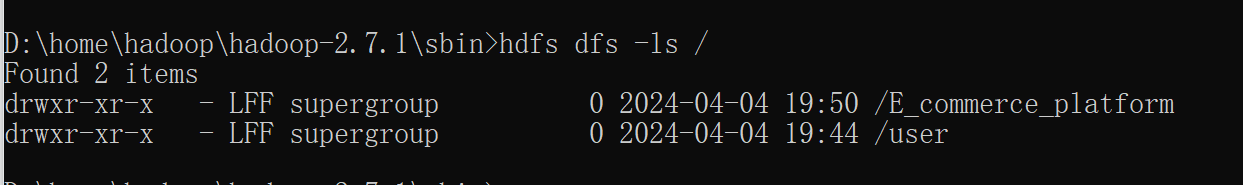

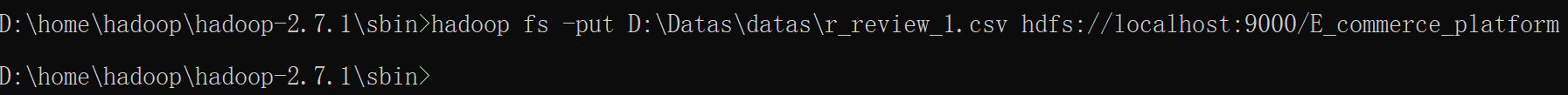

上传文件

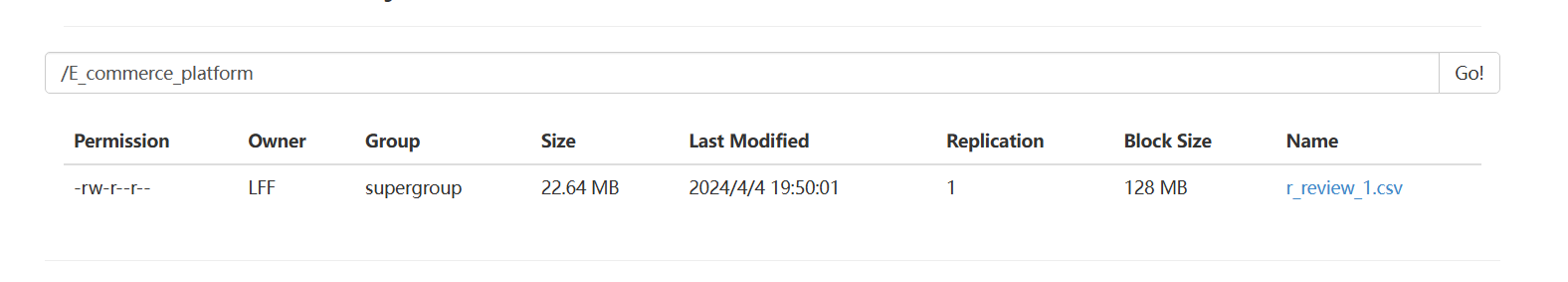

hadoop fs -put D:\Datas\datas\r_review_1.csv hdfs://localhost:9000/E_commerce_platform

浏览目录

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 三行代码完成国际化适配,妙~啊~

· .NET Core 中如何实现缓存的预热?