核函数方法

现在考虑一个信号的二分类问题,设样本为\(\boldsymbol{x}_n,n=1,...,N\),这些样本隶属于两个类别\(y=1\)或\(y=-1\),现在依据上述已有的样本以及每个样本的标签,我们要对一个新的样本\(\boldsymbol{x}\)进行判别,它是属于\(y=1\)还是\(y=-1\)的类别,一个很直观的思路是利用已有样本和其标签去拟合得到样本属性和类别之间的函数关系式,设两者之间的函数关系式为\(y=f(\boldsymbol{x})\),以均方误差作为判定标准,得到如下优化问题

\[\begin{equation}

\begin{aligned}

\underset{f(\boldsymbol{x})}{{\rm min}}\sum_{n=1}^N [y_n-f(\boldsymbol{x}_n)]^2=\underset{\boldsymbol{w}}{{\rm min}}\sum_{n=1}^N [y_n-\boldsymbol{w}^{\rm T}\boldsymbol{x}_n]^2

\end{aligned}

\end{equation}\tag{1}

\]

其中(1)第二个等式是将模型\(f(\boldsymbol{x})\)限制为线性模型。显然,上面的处理思路是直观且可行的,但是上述这种适用于连续结果的信号拟合思路,用在二分类问题中总是会显得有点大材小用。因此我们考虑能否结合问题的特殊性,找到更简单的处理思路。

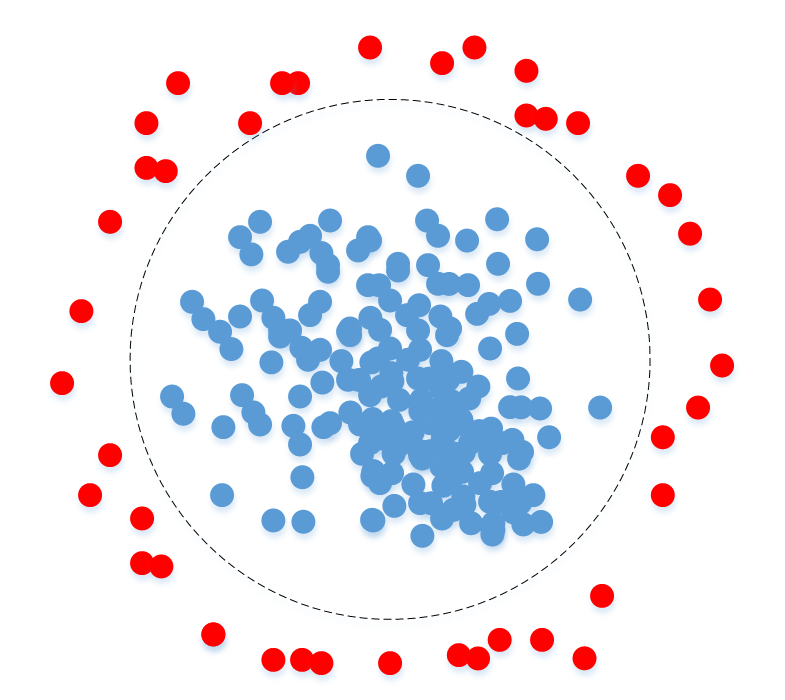

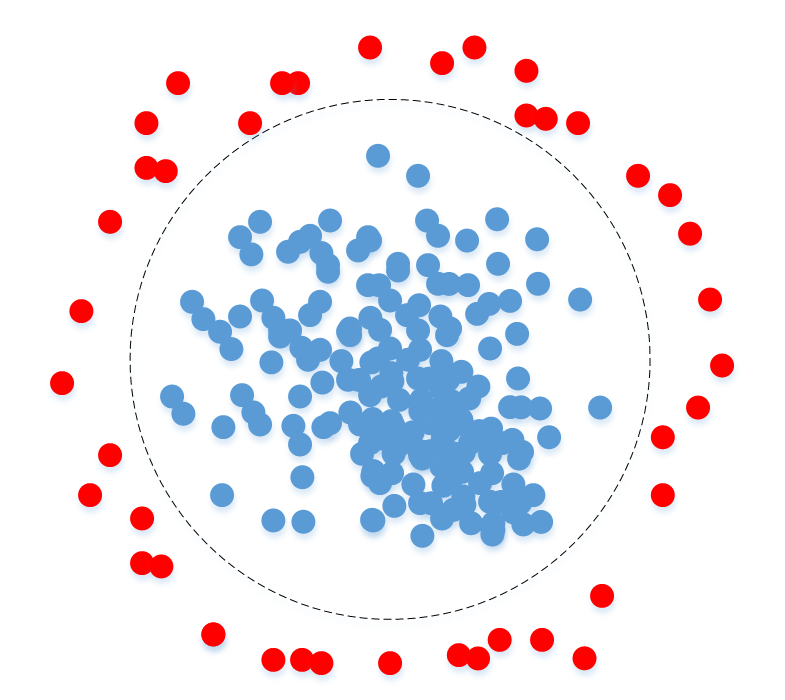

以下首先以线性可分的情况来进行研究,如下图所示有两类点,可以通过一个一条之间将两类点很好地进行区分。现在,假设有一个新的点,要获知它的类别,可以尝试以下思路:

图1 线性可分二分类问题示意图

图1 线性可分二分类问题示意图

首先在已有的两类样本中分别找一个点作为两类样本的代表点(这边以两类样本点的重心点作为各自样本的代表点),则这两个代表点可以分别表示为\(\boldsymbol{x}_+=\frac{1}{m_+}\sum_{y_n=1}\boldsymbol{x}_n\),\(\boldsymbol{x}_-=\frac{1}{m_-}\sum_{y_n=-1}\boldsymbol{x}_n\),其中\(m_+,m_-\)分别表示两类样本的样本数,则可以得到这两个代表点的向量\(\vec{x_+ x_-}=\boldsymbol{x}_+-\boldsymbol{x}_-\),两者的中点可以表示为\(\boldsymbol{x}_m=\frac{1}{2}(\boldsymbol{x}_+ + \boldsymbol{x}_-)\),从上面的示意图可以看出,可以利用待分类点\(\boldsymbol{x}\)与\(\boldsymbol{x}_m\)组成的向量与向量\(\vec{x_+ x_-}\)之间夹角的夹角来判定\(\boldsymbol{x}\)的类别,也就是两个向量的内积(甚至只需要内积的符号即可),所以其判定准则可以表示为:

\[\begin{equation}

\begin{aligned}

f(\boldsymbol{x})&=<\boldsymbol{x}_+ - \boldsymbol{x}_-,\boldsymbol{x}-\boldsymbol{x}_m>=<\boldsymbol{x}_+ - \boldsymbol{x}_-,\boldsymbol{x}>-<\boldsymbol{x}_+ - \boldsymbol{x}_-,\boldsymbol{x}_m>\\

&=\frac{1}{m_+}\sum_{y_n=1}\boldsymbol{x}_n^{\rm T}\boldsymbol{x}-\frac{1}{m_-}\sum_{y_n=-1}\boldsymbol{x}_n^{\rm T}\boldsymbol{x}-b=\sum_{n=1}^N\alpha_k\boldsymbol{x}_n^{\rm T}\boldsymbol{x}-b

\end{aligned}

\end{equation}\tag{2}

\]

显然,(2)对应的判别函数是一个超平面(当样本维数为2时,对应的是一条直线)。

上面仅仅是一个示意性的推导过程,在实际情况下其实并不是很合理,因为我们其实更希望的是两个类别的边界上的样本点的距离越远越好,而不是中间样本点的距离。显然按照这个思路,我们需要求点到超平面的距离,可设超平面方程为\(\boldsymbol{w}^{\rm T}\boldsymbol{x}+b=0\),现在要求平面外一点\(\boldsymbol{x}\)与该平面的距离,设\(\boldsymbol{x}_0\)为该点在平面上的投影,则显然\(\boldsymbol{x}\)与其投影点的连线应该平行于平面的法向量,所以这两个向量的内积就等于两个向量各自模的乘积,即

\[<\boldsymbol{w},\boldsymbol{x}-\boldsymbol{x}_0>=||\boldsymbol{w}||||\boldsymbol{x}-\boldsymbol{x}_0||\tag{3}

\]

其中\(||\boldsymbol{x}-\boldsymbol{x}_0||\)即为我们要求的点到平面的距离,所以

\[\begin{equation}

\begin{aligned}

||\boldsymbol{x}-\boldsymbol{x}_0||&=\frac{|<\boldsymbol{w},\boldsymbol{x}-\boldsymbol{x}_0>|}{||\boldsymbol{w}||}=\frac{|<\boldsymbol{w},\boldsymbol{x}>-<\boldsymbol{w},\boldsymbol{x}_0>|}{||\boldsymbol{w}||}\\

&=\frac{|\boldsymbol{w}^{\rm T}\boldsymbol{x}-\boldsymbol{w}^{\rm T}\boldsymbol{x}_0|}{||\boldsymbol{w}||}=\frac{|\boldsymbol{w}^{\rm T}\boldsymbol{x}+b|}{||\boldsymbol{w}||}

\end{aligned}

\end{equation}\tag{4}

\]

现在我们的判定准则是希望两类样本中与超平面距离最近的点之间的距离最远,以下对这一问题进行建模处理,现在的问题可以按如下进行表示

\[\begin{equation}

\begin{aligned}

\underset{\boldsymbol{w}}{{\rm max}}\frac{|\boldsymbol{w}^{\rm T}\boldsymbol{x}+b|}{||\boldsymbol{w}||}

\end{aligned}

\end{equation}\tag{5}

\]

上面的式子并不是很好求解,为此,我们考虑通过对超平面参数的调整(如对b的调整,相当于将超平面左右移动)使得

\[\begin{equation}

\begin{aligned}

\boldsymbol{w}^{\rm T}\boldsymbol{x}_n+b \leq -1, y_n=-1\\

\boldsymbol{w}^{\rm T}\boldsymbol{x}_n+b \geq 1, y_n=1\\

\end{aligned}

\end{equation}\tag{6}

\]

所以此时(5)的优化问题可以转化为

\[\begin{equation}

\begin{aligned}

\underset{\boldsymbol{w}}{{\rm max}}\frac{2}{||\boldsymbol{w}||},\quad {\rm s.t.}\quad y_n(\boldsymbol{w}^{\rm T}\boldsymbol{x}_n+b)\geq 1 \quad \rightarrow\\

\underset{\boldsymbol{w}}{{\rm min}}\frac{1}{2}||\boldsymbol{w}||^2,\quad {\rm s.t.}\quad 1-y_n(\boldsymbol{w}^{\rm T}\boldsymbol{x}_n+b) \leq 0

\end{aligned}

\end{equation}\tag{7}

\]

用拉格朗日方法来计算上面的优化问题有

\[L(\boldsymbol{w},\boldsymbol{\alpha},b)=\frac{1}{2}||\boldsymbol{w}||^2+\sum_{n=1}^N \alpha_n(1-y_n(\boldsymbol{w}^{\rm T}\boldsymbol{x}_n+b))\tag{8}

\]

对各个变量求梯度有

\[\begin{equation}

\begin{aligned}

&\Delta_{\boldsymbol{w}}L=\boldsymbol{w}-\sum_{n=1}^N \alpha_n y_n \boldsymbol{x}_n=0,\rightarrow \quad \boldsymbol{w}=\sum_{n=1}^N \alpha_n y_n \boldsymbol{x}_n\\

&\Delta_{\alpha_k}L=1-y_n(\boldsymbol{w}^{\rm T}\boldsymbol{x}_n+b)=0,\rightarrow \quad y_n(\boldsymbol{w}^{\rm T}\boldsymbol{x}_n+b)=1\\

&\Delta_{b}L=-\sum_{n=1}^N \alpha_n y_n=0

\end{aligned}

\end{equation}\tag{9}

\]

在(9)中需要得到\(\alpha_n\)才能求得\(\boldsymbol{w}\),此时可以将\(\boldsymbol{w}\)的表达式带入代入目标函数中,我们得到:

\[\frac{1}{2}||\boldsymbol{w}||^2=\frac{1}{2}\sum_{i=1}^N \sum_{j=1}^N\alpha_i \alpha_j y_i y_j \boldsymbol{x}_i^{\rm T} \boldsymbol{x}_j\tag{10}

\]

上面是一个二次优化的问题,结合(9)中\(\alpha\)需要满足的约束条件,我们最终可以求得\(\boldsymbol{w}=\sum_{n=1}^N \alpha_n y_n \boldsymbol{x}_n\)。所以最终判决标准可以表示为

\[f(\boldsymbol{x}_n)={\rm sgn}(\sum_{n=1}^N \alpha_n y_n \boldsymbol{x}_n^{\rm T}\boldsymbol{x}_n+b)\tag{11}

\]

上面整个推导过程其实就是支持向量机的内容。

从上面的推导结果我们可以得出一个结论:当样本是线性可分时,它的分类判决标准中的核心操作是对样本的内积。这一结论将有助于启迪后续核函数的思想。

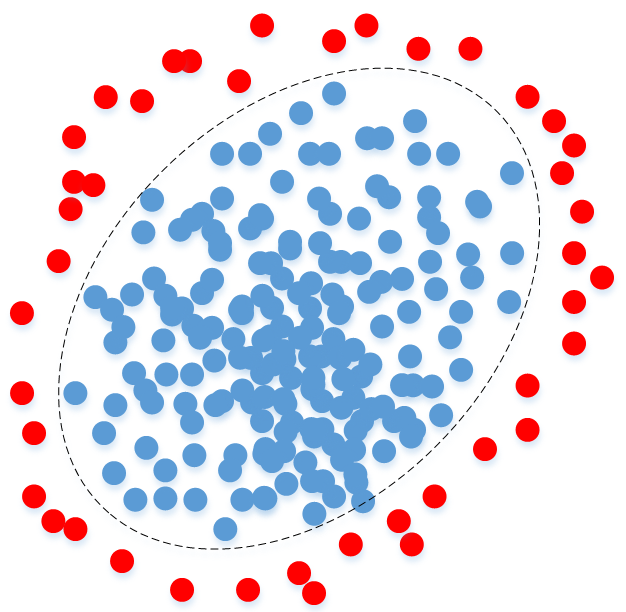

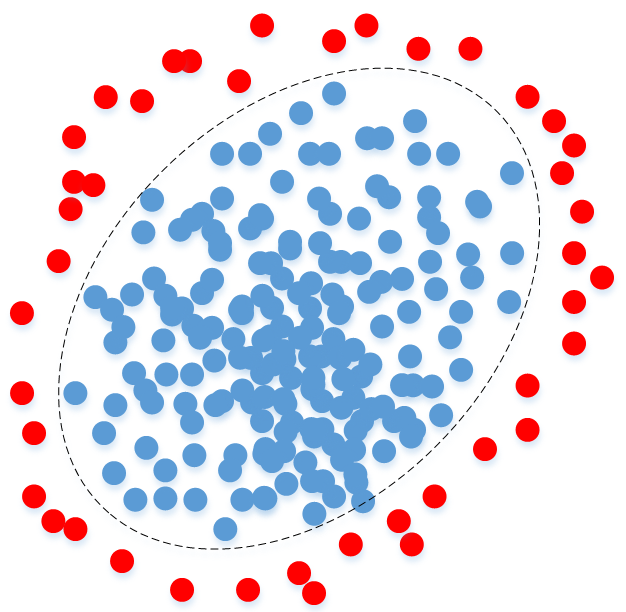

上面研究的均是线性可分的情况,这种情况未免太过理想,在实际应用中,不同类别的样本往往是线性不可分的,比如下图所示的情况

图2 线性不可分二分类问题示意图

图2 线性不可分二分类问题示意图

对图2所示情况,用一条直线显然不足以将两类样本分开,此时就是线性不可分的情况。对于图2第一幅来说,其判决边界是一个圆,所以其判决准则可以写成\(x_1^2+x_2^2 \gtrless r^2\)的形式。对于图2第二副图来说,其判决边界是一个椭圆,所以其判决准则可以写成\((ax_1+bx_2)^2+cx_2^2=a^2 x_1^2+2ab x_1 x_2+(b+c)x_2^2\gtrless r^2\)的形式。显然,线性不可分的情况太过复杂,我们很希望能将其转化成一个线性可分的情况,所以我们尝试对上面的判决准则做一个变量代换,即:\(y_1=a^2 x_1^2,y_2=2abx_1x_2,y_3=(b+c)x_2^2\),这样判决准则就变成了\(y_1+y_2+y_3 \gtrless r^2\),显然在原来二维空间中线性不可分的问题,在三维空间中变得线性可分了。而根据上面推导出来的线性可分的判决条件,我们其实不必要去关注维度提升之后,样本在高纬度空间中的具体形式,而只需要知道维度提升之后样本在新的高维空间中的内积就行了,这个思想其实就是核函数的思想,而样本的内积操作就是核函数思想中最核心的东西。

据此,由上面的分析可知,当样本线性可分时,其分类的判定准则表示为

\[f(\boldsymbol{x}_n)={\rm sgn}(\sum_{n=1}^N \alpha_n y_n \boldsymbol{x}_n^{\rm T}\boldsymbol{x}_n+b)\tag{12}

\]

当样本线性不可分时,我们对样本进行生维处理,在高维空间中,样本表现为\(\Phi(\boldsymbol{x}_n)\),则在高维空间中,样本变成了线性可分,此时判决准则相应地就变成了

\[f(\Phi(\boldsymbol{x}_n))={\rm sgn}(\sum_{n=1}^N \alpha_n y_n \Phi(\boldsymbol{x}_n)^{\rm T}\Phi(\boldsymbol{x}_n)+b)\tag{13}

\]

我们不关心\(\Phi(\boldsymbol{x}_n)\)的具体形式,我们关心的是\(\Phi(\boldsymbol{x}_n)^{\rm T}\Phi(\boldsymbol{x}_n)\),因此核函数方法的核心就变成了设计核函数\(K(\boldsymbol{x}_n)=\Phi(\boldsymbol{x}_n)^{\rm T}\Phi(\boldsymbol{x}_n)\)。而目前已经有一些常用的核函数可以利用了。因此核函数思想赋予了我们"上帝视角",让我们从高维空间中拨开重重迷雾看到了事情的本质(内积)。