Contextual-based Image Inpainting: Infer, Match, and Translate

Contextual-based Image Inpainting: Infer, Match, and Translate

Pytorch

引言

- 设计了一个基于深度学习的修复系统,可以在图片缺失区域推断出较高质量的内容和纹理。

- 提出了一个新颖的鲁棒的训练方法,并提出了特征操作的问题以及如何避免训练时的欠拟合。

- 模型可以在图像任务上得到较好的结果,并且论文的算法同样可以扩展到其他图像编辑任务上,比如风格迁移。

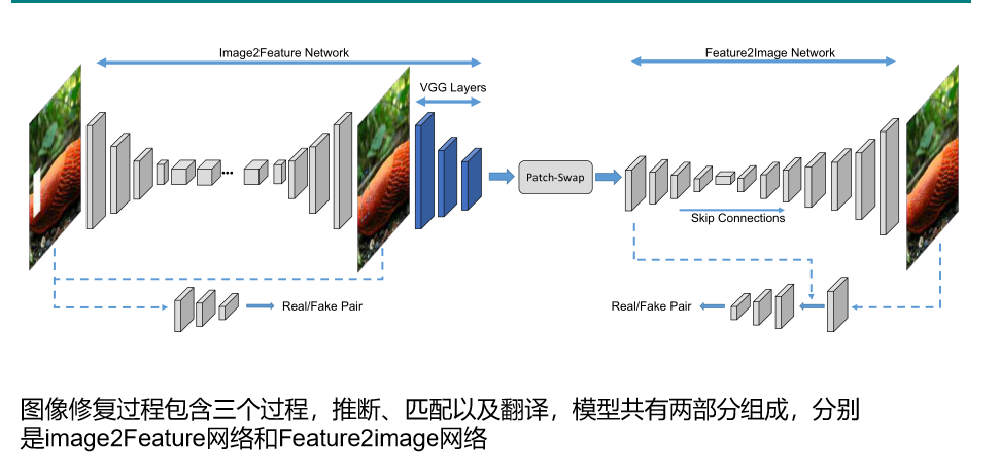

网络架构

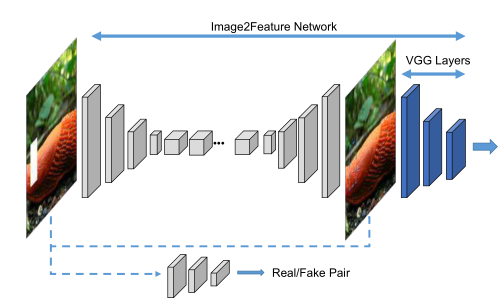

image2Feature

推断过程基于FCN的网络和预训练好的vgg19网络的前三层组成,利用Image2Feature 得到初步修复结果。同时引入了PatchGAN的判别器。 输入256*256*3,经过FCN和VGG网络得到64*64*256

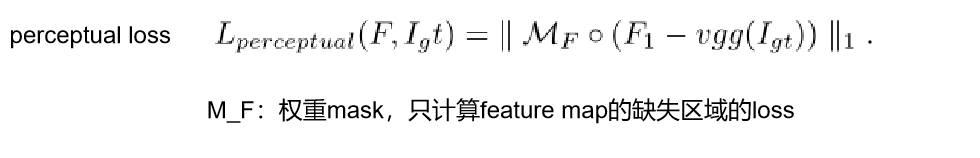

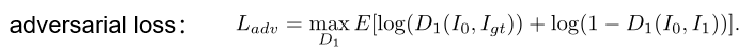

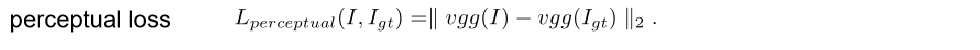

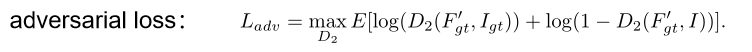

损失函数

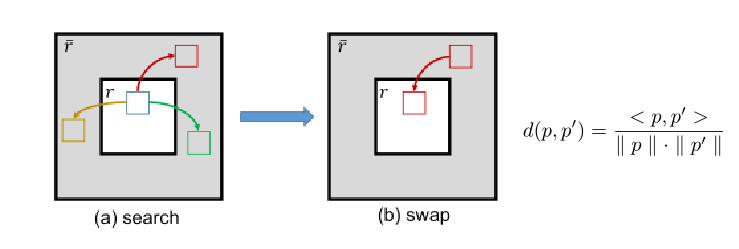

Patch-swap

patch大小为3*3,将已知区域堆叠成3*3的卷积核,与缺失区域cross-correlation

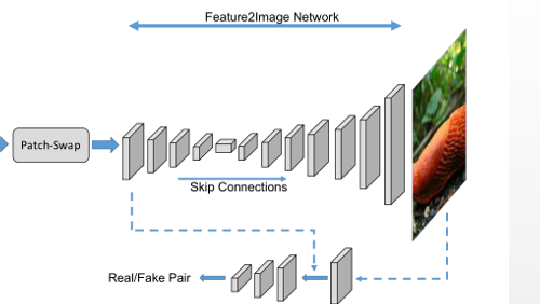

Feature2Image

基于U-NET结构,输入的是patch-swap操作之后的64*64*256大小特征图。输出最终的3*256*256的结果。同样引入patchGAN。

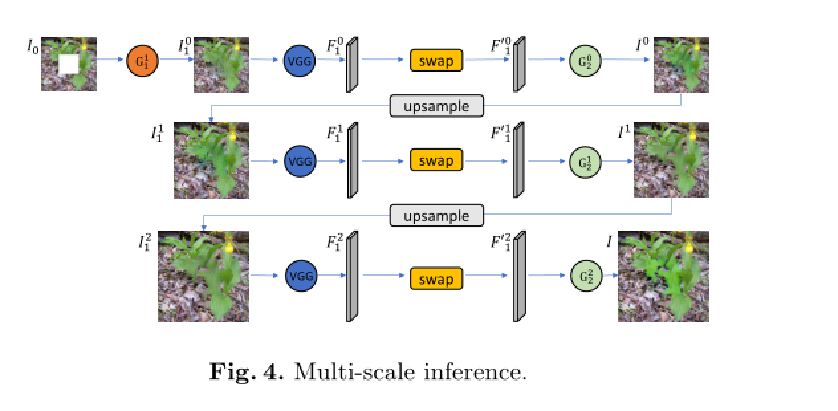

多尺度框架

可以将修复的结果I经过上采样以后,再次通过匹配以及 翻译两个阶段即可以得到更大尺寸的修复结果。

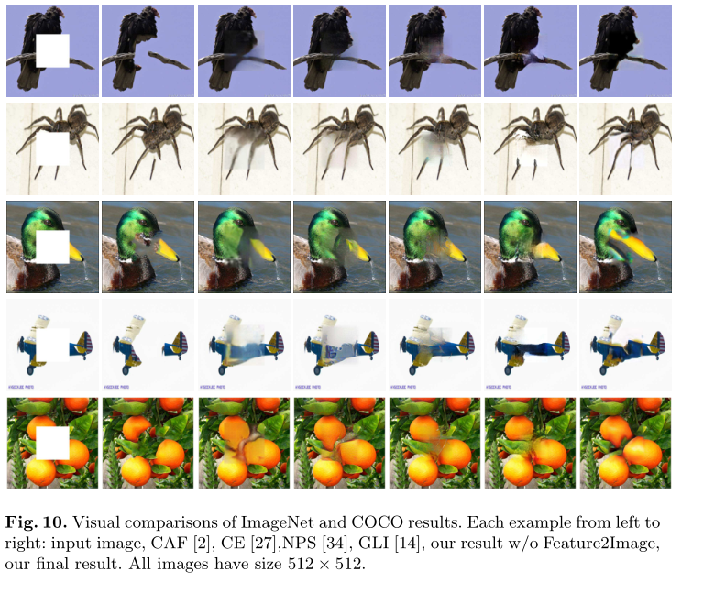

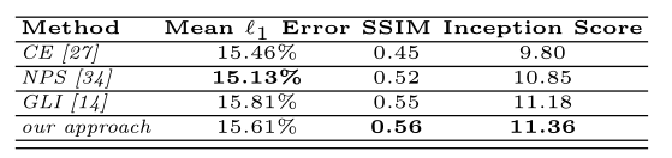

实验

浙公网安备 33010602011771号

浙公网安备 33010602011771号