gstreamer 中文教程

基础教程1:Hello World!

目标

没有什么比在屏幕上打印“Hello World”更能获得对软件库的第一印象了!

但是由于我们正在处理多媒体框架,所以我们将改为播放视频。

不要被下面的代码量吓到:只有 4 行是真正的工作。其余的是清理代码,在 C 中,这总是有点冗长。

事不宜迟,为您的第一个 GStreamer 应用程序做好准备……

Hello world

将此代码复制到名为的文本文件中(或在您的 GStreamer 安装中找到它)。basic-tutorial-1.c

基础教程1.c

#include <gst/gst.h>

#ifdef __APPLE__

#include <TargetConditionals.h>

#endif

int

tutorial_main (int argc, char *argv[])

{

GstElement *pipeline;

GstBus *bus;

GstMessage *msg;

/* Initialize GStreamer */

gst_init (&argc, &argv);

/* Build the pipeline */

pipeline =

gst_parse_launch

("playbin uri=https://gstreamer.freedesktop.org/data/media/sintel_trailer-480p.webm",

NULL);

/* Start playing */

gst_element_set_state (pipeline, GST_STATE_PLAYING);

/* Wait until error or EOS */

bus = gst_element_get_bus (pipeline);

msg =

gst_bus_timed_pop_filtered (bus, GST_CLOCK_TIME_NONE,

GST_MESSAGE_ERROR | GST_MESSAGE_EOS);

/* See next tutorial for proper error message handling/parsing */

if (GST_MESSAGE_TYPE (msg) == GST_MESSAGE_ERROR) {

g_error ("An error occurred! Re-run with the GST_DEBUG=*:WARN environment "

"variable set for more details.");

}

/* Free resources */

gst_message_unref (msg);

gst_object_unref (bus);

gst_element_set_state (pipeline, GST_STATE_NULL);

gst_object_unref (pipeline);

return 0;

}

int

main (int argc, char *argv[])

{

#if defined(__APPLE__) && TARGET_OS_MAC && !TARGET_OS_IPHONE

return gst_macos_main (tutorial_main, argc, argv, NULL);

#else

return tutorial_main (argc, argv);

#endif

}

按照在 Linux 上安装、在 Mac OS X 上安装或在 Windows 上安装中的描述编译它。如果遇到编译错误,请仔细检查这些部分中给出的说明。

如果一切正常,启动可执行文件!您应该会看到一个弹出窗口,其中包含直接从 Internet 播放的视频以及音频。恭喜!

需要帮忙?

如果您需要帮助来编译此代码,请参阅针对您的平台构建教程部分:Linux、Mac OS X或 Windows,或在 Linux 上使用此特定命令:

gcc basic-tutorial-1.c -o basic-tutorial-1pkg-config --cflags --libs gstreamer-1.0``如果您需要帮助来运行此代码,请参阅适用于您的平台的运行教程部分: Linux、Mac OS X或 Windows。

所需的库:

gstreamer-1.0

本教程将打开一个窗口并显示一个带有音频的电影。媒体是从 Internet 获取的,因此窗口可能需要几秒钟才会出现,具体取决于您的连接速度。此外,没有延迟管理(缓冲),因此在连接速度较慢时,电影可能会在几秒钟后停止。查看基础教程 12:Streaming如何解决此问题。

演练

让我们回顾一下这些代码行,看看它们做了什么:

GstElement *pipeline;

GstBus *bus;

这必须始终是您的第一个 GStreamer 命令。除其他事项外, gst_init ():

- 初始化所有内部结构

- 检查可用的插件

- 执行任何适用于 GStreamer 的命令行选项

如果您始终将命令行参数传递 argc给argvgst_init ( ),您的应用程序将自动受益于 GStreamer 标准命令行选项(更多信息请参见基础教程 10:GStreamer 工具)

/* Initialize GStreamer */

gst_init (&argc, &argv);

/* Build the pipeline */

这一行是本教程的核心,举例说明了两个关键点:gst_parse_launch () 和playbin。

gst_parse_launch

GStreamer 是一个旨在处理多媒体流的框架。媒体从“源”元素(生产者)向下传播到“汇”元素(消费者),通过一系列执行各种任务的中间元素。所有互连元素的集合称为“管道”。

在 GStreamer 中,您通常通过手动组装各个元素来构建管道,但是,当管道足够简单并且您不需要任何高级功能时,您可以采用快捷方式:gst_parse_launch ( )。

此函数采用管道的文本表示并将其转换为实际管道,这非常方便。事实上,这个功能非常方便,有一个完全围绕它构建的工具,您会非常熟悉(请参阅基本教程 10:GStreamer 工具以了解 gst-launch-1.0和 gst-launch-1.0语法)。

游戏箱

那么,我们要求gst_parse_launch () 为我们构建什么样的管道呢?这里进入第二个关键点:我们正在构建一个由称为playbin的单个元素组成的管道。

playbin是一个特殊的element,作为source和sink,是一个完整的pipeline。在内部,它创建并连接所有必要的元素来播放您的媒体,因此您不必担心。

它不允许手动管道所具有的控制粒度,但是,它仍然允许足够的自定义以满足广泛的应用程序。包括本教程。

在本例中,我们只向playbin传递一个参数,即我们要播放的媒体的 URI。尝试将其更改为其他内容!不管是anhttp://还是file://URI,playbin都会透明的实例化合适的GStreamer源!

如果您输入错误的 URI,或者文件不存在,或者您缺少插件,GStreamer 提供了几种通知机制,但我们在这个例子中唯一做的就是出错退出,所以不要期待太多反馈。

gst_parse_launch

("playbin uri=https://gstreamer.freedesktop.org/data/media/sintel_trailer-480p.webm",

这行突出了另一个有趣的概念:状态。每个 GStreamer 元素都有一个相关联的状态,您可以或多或少地将其视为常规 DVD 播放器中的播放/暂停按钮。就目前而言,除非您将管道设置为状态,否则播放不会开始就足够了PLAYING。

在这一行中,gst_element_set_state () 正在设置pipeline(我们唯一的元素,记住)状态PLAYING,从而启动播放。

/* Start playing */

gst_element_set_state (pipeline, GST_STATE_PLAYING);

/* Wait until error or EOS */

这些行将等待直到发生错误或找到流的末尾。gst_element_get_bus () 检索管道的总线, gst_bus_timed_pop_filtered () 将阻塞,直到您通过该总线接收到 ERROR 或EOS(End-Of-Stream)。不要太担心这条线,GStreamer 总线在基础教程 2:GStreamer 概念中有解释。

就是这样!从这一点开始,GStreamer 会处理一切。当媒体到达终点(EOS)或遇到错误(尝试关闭视频窗口,或拔掉网线)时,执行将结束。始终可以通过在控制台中按 control-C 来停止应用程序。

清理

但是,在终止应用程序之前,我们需要做一些事情来正确地整理自己。

msg =

gst_bus_timed_pop_filtered (bus, GST_CLOCK_TIME_NONE,

GST_MESSAGE_ERROR | GST_MESSAGE_EOS);

/* See next tutorial for proper error message handling/parsing */

if (GST_MESSAGE_TYPE (msg) == GST_MESSAGE_ERROR) {

始终阅读您使用的函数的文档,以了解您是否应该释放它们在使用后返回的对象。

在这种情况下,gst_bus_timed_pop_filtered () 返回一条消息,需要使用gst_message_unref ()释放该消息(有关消息的更多信息,请参见 基础教程 2:GStreamer 概念)。

gst_element_get_bus () 添加了对必须使用gst_object_unref ()释放的总线的引用。将管道设置为 NULL 状态将确保它释放它已分配的所有资源(更多关于 基础教程 3:动态管道中的状态)。最后,取消引用管道将破坏它及其所有内容。

结论

您的第一个 GStreamer 教程到此结束。我们希望它的简洁性可以作为该框架强大功能的一个例子!

让我们回顾一下。今天我们学习了:

- 如何使用gst_init () 初始化 GStreamer。

- 如何使用gst_parse_launch ()从文本描述快速构建管道 。

- 如何使用playbin创建自动播放管道。

- 如何使用 gst_element_set_state () 通知 GStreamer 开始播放。

- 如何高枕无忧,GStreamer 搞定一切,使用gst_element_get_bus () 和gst_bus_timed_pop_filtered ()。

下一篇教程将继续介绍更多基本的 GStreamer 元素,并向您展示如何手动构建管道。

很高兴有你在这里,很快再见!

基础教程2:GStreamer概念

目标

上一教程展示了如何自动构建管道。现在我们将通过实例化每个元素并将它们全部链接在一起来手动构建管道。在这个过程中,我们将学习:

- 什么是 GStreamer 元素以及如何创建它。

- 如何将元素相互连接。

- 如何自定义元素的行为。

- 如何观察总线的错误情况并从 GStreamer 消息中提取信息。

Hello world

将此代码复制到名为的文本文件中(或在您的 GStreamer 安装中找到它)。basic-tutorial-2.c

基础教程2.c

#include <gst/gst.h>

#ifdef __APPLE__

#include <TargetConditionals.h>

#endif

int

tutorial_main (int argc, char *argv[])

{

GstElement *pipeline, *source, *sink;

GstBus *bus;

GstMessage *msg;

GstStateChangeReturn ret;

/* Initialize GStreamer */

gst_init (&argc, &argv);

/* Create the elements */

source = gst_element_factory_make ("videotestsrc", "source");

sink = gst_element_factory_make ("autovideosink", "sink");

/* Create the empty pipeline */

pipeline = gst_pipeline_new ("test-pipeline");

if (!pipeline || !source || !sink) {

g_printerr ("Not all elements could be created.\n");

return -1;

}

/* Build the pipeline */

gst_bin_add_many (GST_BIN (pipeline), source, sink, NULL);

if (gst_element_link (source, sink) != TRUE) {

g_printerr ("Elements could not be linked.\n");

gst_object_unref (pipeline);

return -1;

}

/* Modify the source's properties */

g_object_set (source, "pattern", 0, NULL);

/* Start playing */

ret = gst_element_set_state (pipeline, GST_STATE_PLAYING);

if (ret == GST_STATE_CHANGE_FAILURE) {

g_printerr ("Unable to set the pipeline to the playing state.\n");

gst_object_unref (pipeline);

return -1;

}

/* Wait until error or EOS */

bus = gst_element_get_bus (pipeline);

msg =

gst_bus_timed_pop_filtered (bus, GST_CLOCK_TIME_NONE,

GST_MESSAGE_ERROR | GST_MESSAGE_EOS);

/* Parse message */

if (msg != NULL) {

GError *err;

gchar *debug_info;

switch (GST_MESSAGE_TYPE (msg)) {

case GST_MESSAGE_ERROR:

gst_message_parse_error (msg, &err, &debug_info);

g_printerr ("Error received from element %s: %s\n",

GST_OBJECT_NAME (msg->src), err->message);

g_printerr ("Debugging information: %s\n",

debug_info ? debug_info : "none");

g_clear_error (&err);

g_free (debug_info);

break;

case GST_MESSAGE_EOS:

g_print ("End-Of-Stream reached.\n");

break;

default:

/* We should not reach here because we only asked for ERRORs and EOS */

g_printerr ("Unexpected message received.\n");

break;

}

gst_message_unref (msg);

}

/* Free resources */

gst_object_unref (bus);

gst_element_set_state (pipeline, GST_STATE_NULL);

gst_object_unref (pipeline);

return 0;

}

int

main (int argc, char *argv[])

{

#if defined(__APPLE__) && TARGET_OS_MAC && !TARGET_OS_IPHONE

return gst_macos_main (tutorial_main, argc, argv, NULL);

#else

return tutorial_main (argc, argv);

#endif

}

需要帮忙?

如果您需要帮助来编译此代码,请参阅针对您的平台构建教程 部分:Linux、Mac OS X或Windows,或在 Linux 上使用此特定命令:

gcc basic-tutorial-2.c -o basic-tutorial-2pkg-config --cflags --libs gstreamer-1.0``如果您需要帮助来运行此代码,请参阅适用于您的平台的运行教程部分: Linux、Mac OS X [ 2 ] 或Windows。

本教程打开一个窗口并显示一个测试模式,没有音频

所需的库:

gstreamer-1.0

演练

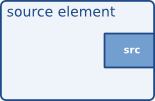

这些元素是 GStreamer 的基本构造块。它们处理数据,因为数据从源元素(数据生产者)向下游流向接收器元素(数据消费者),并通过过滤器元素。

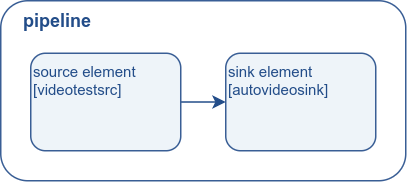

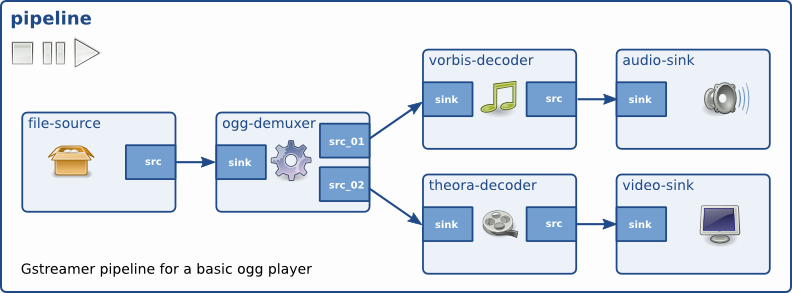

图 1。示例流水线

元素创建

我们将跳过 GStreamer 初始化,因为它与之前的教程相同:

/* Initialize GStreamer */

gst_init (&argc, &argv);

如这段代码所示,可以使用gst_element_factory_make ()创建新元素。第一个参数是要创建的元素类型(基础教程 14:Handy elements展示了几种常见类型,基础教程 10:GStreamer 工具展示了如何获取所有可用类型的列表)。第二个参数是我们要给这个特定实例的名称。如果您没有保留指针(以及更有意义的调试输出),命名您的元素对于以后检索它们很有用。但是,如果您为名称传递NULL ,GStreamer 将为您提供一个唯一的名称。

对于本教程,我们创建了两个元素:一个videotestsrc和一个autovideosink。没有过滤元件。因此,管道将如下所示:

图 2。本教程中构建的管道

videotestsrc是一个源元素(它产生数据),它创建一个测试视频模式。此元素对于调试目的(和教程)很有用,并且通常不会在实际应用程序中找到。

autovideosink是一个接收器元素(它消耗数据),它在窗口上显示它接收到的图像。根据操作系统的不同,存在多种具有不同功能的视频接收器。 autovideosink会自动选择并实例化最好的一个,因此您不必担心细节,并且您的代码更加独立于平台。

管道创建

/* Create the elements */

source = gst_element_factory_make ("videotestsrc", "source");

GStreamer 中的所有元素通常必须包含在管道中才能使用,因为它负责一些时钟和消息传递功能。我们使用gst_pipeline_new ()创建管道。

g_printerr ("Not all elements could be created.\n");

return -1;

}

/* Build the pipeline */

gst_bin_add_many (GST_BIN (pipeline), source, sink, NULL);

if (gst_element_link (source, sink) != TRUE) {

管道是一种特殊类型的bin,它是用于包含其他元素的元素。因此,所有适用于箱的方法也适用于管道。

在我们的例子中,我们调用gst_bin_add_many () 将元素添加到管道中(注意演员表)。此函数接受要添加的元素列表,以NULL结尾。可以使用gst_bin_add ()添加单个元素。

但是,这些元素尚未相互关联。为此,我们需要使用gst_element_link ()。它的第一个参数是源,第二个是目标。顺序很重要,因为必须在数据流之后建立链接(即从源元素到接收器元素)。请记住,只有位于同一容器中的元素才能链接在一起,因此请记住在尝试链接它们之前将它们添加到管道中!

特性

GStreamer 元素都是一种特殊的GObject ,它是提供属性设施的实体。

大多数 GStreamer 元素都具有可自定义的属性:可以修改以更改元素行为(可写属性)或查询以了解元素的内部状态(可读属性)的命名属性。

使用g_object_get ()读取属性并使用g_object_set ()写入属性。

g_object_set () 接受以 NULL结尾的属性名、属性值对列表,因此可以一次更改多个属性。

这就是属性处理方法具有g_前缀的原因。

回到上面例子中的内容,

gst_object_unref (pipeline);

return -1;

上面的代码行更改了videotestsrc的“pattern”属性,该属性控制元素输出的测试视频的类型。尝试不同的值!

可以使用基础教程 10:GStreamer 工具中描述的 gst-inspect-1.0 工具找到元素公开的所有属性的名称和可能的值,或者在该元素的文档中找到(这里是 videotestsrc 的情况)。

错误检查

此时,我们已经构建和设置了整个管道,本教程的其余部分与上一个非常相似,但我们将添加更多错误检查:

/* Modify the source's properties */

g_object_set (source, "pattern", 0, NULL);

/* Start playing */

ret = gst_element_set_state (pipeline, GST_STATE_PLAYING);

if (ret == GST_STATE_CHANGE_FAILURE) {

我们调用gst_element_set_state (),但是这次我们检查它的返回值是否有错误。更改状态是一个微妙的过程,基础教程 3:动态管道中提供了更多详细信息。

gst_object_unref (pipeline);

return -1;

}

/* Wait until error or EOS */

bus = gst_element_get_bus (pipeline);

msg =

gst_bus_timed_pop_filtered (bus, GST_CLOCK_TIME_NONE,

GST_MESSAGE_ERROR | GST_MESSAGE_EOS);

/* Parse message */

if (msg != NULL) {

GError *err;

gchar *debug_info;

switch (GST_MESSAGE_TYPE (msg)) {

case GST_MESSAGE_ERROR:

gst_message_parse_error (msg, &err, &debug_info);

g_printerr ("Error received from element %s: %s\n",

GST_OBJECT_NAME (msg->src), err->message);

g_printerr ("Debugging information: %s\n",

debug_info ? debug_info : "none");

g_clear_error (&err);

g_free (debug_info);

break;

case GST_MESSAGE_EOS:

g_print ("End-Of-Stream reached.\n");

break;

default:

/* We should not reach here because we only asked for ERRORs and EOS */

g_printerr ("Unexpected message received.\n");

gst_bus_timed_pop_filtered () 等待执行结束并返回我们之前忽略的GstMessage 。当 GStreamer 遇到错误条件或EOS时,我们要求gst_bus_timed_pop_filtered () 返回,因此我们需要检查发生了什么,并在屏幕上打印一条消息(您的应用程序可能需要执行更复杂的操作)。

GstMessage是一个非常通用的结构,几乎可以传递任何类型的信息。幸运的是,GStreamer 为每一种消息提供了一系列的解析函数。

在这种情况下,一旦我们知道消息包含错误(通过使用 GST_MESSAGE_TYPE () 宏),我们就可以使用 gst_message_parse_error () 返回一个 GLib GError错误结构和一个对调试有用的字符串。检查代码以了解这些是如何使用和随后释放的。

GStreamer 总线

在这一点上,值得更正式地介绍一下 GStreamer 总线。它是负责将元素生成的GstMessage按顺序传递给应用程序并传递给应用程序线程的对象。最后一点很重要,因为实际的媒体流是在应用程序之外的另一个线程中完成的。

可以使用gst_bus_timed_pop_filtered () 及其同级从总线同步提取消息 ,或者使用信号异步提取消息(在下一教程中显示)。您的应用程序应始终关注总线,以便收到有关错误和其他播放相关问题的通知。

其余代码是清理序列,与基础教程 1:Hello world!.

锻炼

如果您想练习一下,请尝试以下练习:在此管道的源和接收器之间添加一个视频过滤器元素。使用 vertigotv以获得不错的效果。您需要创建它,将它添加到管道,并将它与其他元素链接起来。

根据您的平台和可用的插件,您可能会遇到“协商”错误,因为接收器不了解过滤器正在生成什么(更多关于协商的信息,请参见基础教程 6:媒体格式和 Pad 功能)。在这种情况下,尝试在过滤器之后添加一个名为videoconvert的元素(即构建一个包含 4 个元素的管道。有关 videoconvert的更多信息,请参见基础教程 14:Handy elements)。

结论

本教程显示:

- 如何使用gst_element_factory_make ()创建元素

- 如何使用gst_pipeline_new ()创建空管道

- 如何使用gst_bin_add_many ()向管道添加元素

- 如何使用gst_element_link ()将元素相互链接

关于 GStreamer 基本概念的两篇教程中的第一篇到此结束。接下来是第二个。

请记住,在本页的附件中,您应该找到教程的完整源代码以及构建它所需的任何附件文件。

很高兴有你在这里,很快再见!

基础教程3:动态管道

目标

本教程展示了使用 GStreamer 所需的其余基本概念,它允许在信息可用时“即时”构建管道,而不是在应用程序开始时定义单一管道。

完成本教程后,您将具备开始回放教程所需的知识 。这里审查的要点是:

- 如何在链接元素时获得更好的控制。

- 如何收到有趣事件的通知,以便您及时做出反应。

- 元素可以处于的各种状态。

介绍

正如您即将看到的,本教程中的管道在设置为播放状态之前并未完全构建。还行吧。如果我们不采取进一步的行动,数据将到达管道的末端,管道将产生一条错误消息并停止。但我们将采取进一步行动......

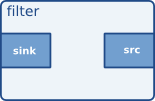

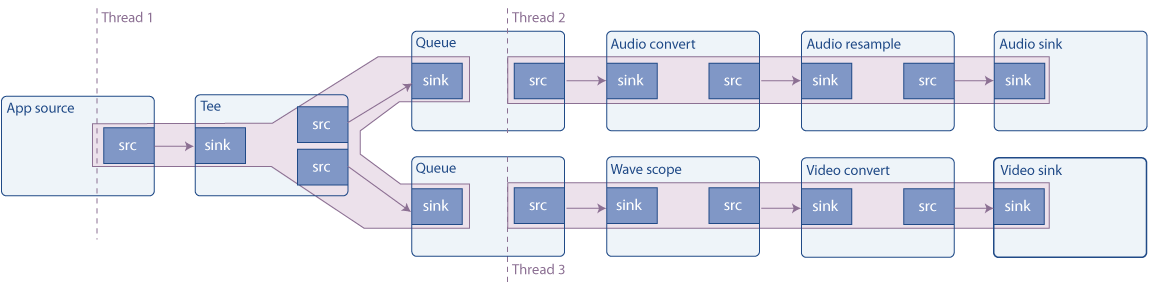

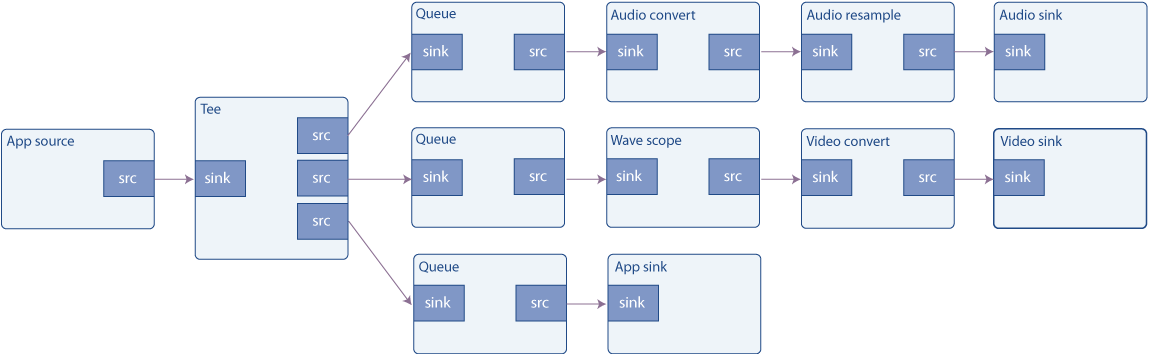

在此示例中,我们打开一个多路复用(或多路复用)文件,即音频和视频一起存储在一个容器文件中。负责打开此类容器的元素称为 demuxers,容器格式的一些示例包括 Matroska (MKV)、Quick Time(QT、MOV)、Ogg 或高级系统格式(ASF、WMV、WMA)。

如果一个容器嵌入了多个流(例如,一个视频和两个音轨),分路器会将它们分开并通过不同的输出端口公开它们。这样就可以在管道中创建不同的分支,处理不同类型的数据。

GStreamer 元素相互通信的端口称为 pads ( GstPad)。存在接收器垫,数据通过它进入元素,还有源垫,数据通过它退出元素。很自然地,source 元素仅包含 source pad,sink 元素仅包含 sink pad,而 filter 元素包含两者。

图 1。GStreamer 元素及其垫。

一个解复用器包含一个接收器垫,多路复用数据通过它到达,以及多个源垫,一个用于在容器中找到的每个流:

图 2。具有两个源焊盘的解复用器。

为了完整起见,这里有一个简化的管道,其中包含一个多路分解器和两个分支,一个用于音频,一个用于视频。这不是 将在此示例中构建的管道:

图 3。具有两个分支的示例管道。

处理多路分解器的主要复杂性在于,它们在收到一些数据并有机会查看容器以查看内部内容之前无法生成任何信息。也就是说,多路分解器开始时没有其他元素可以链接到的源垫,因此管道必须在它们处终止。

解决方案是构建从源向下到分路器的管道,并将其设置为运行(播放)。当分路器收到足够的信息来了解容器中流的数量和种类时,它将开始创建源垫。这是我们完成管道构建并将其附加到新添加的多路分解器垫的正确时间。

为简单起见,在本例中,我们将只链接到音频板而忽略视频。

Hello world

将此代码复制到名为的文本文件中basic-tutorial-3.c(或在您的 GStreamer 安装中找到它)。

基础教程-3.c

#include <gst/gst.h>

/* Structure to contain all our information, so we can pass it to callbacks */

typedef struct _CustomData {

GstElement *pipeline;

GstElement *source;

GstElement *convert;

GstElement *resample;

GstElement *sink;

} CustomData;

/* Handler for the pad-added signal */

static void pad_added_handler (GstElement *src, GstPad *pad, CustomData *data);

int main(int argc, char *argv[]) {

CustomData data;

GstBus *bus;

GstMessage *msg;

GstStateChangeReturn ret;

gboolean terminate = FALSE;

/* Initialize GStreamer */

gst_init (&argc, &argv);

/* Create the elements */

data.source = gst_element_factory_make ("uridecodebin", "source");

data.convert = gst_element_factory_make ("audioconvert", "convert");

data.resample = gst_element_factory_make ("audioresample", "resample");

data.sink = gst_element_factory_make ("autoaudiosink", "sink");

/* Create the empty pipeline */

data.pipeline = gst_pipeline_new ("test-pipeline");

if (!data.pipeline || !data.source || !data.convert || !data.resample || !data.sink) {

g_printerr ("Not all elements could be created.\n");

return -1;

}

/* Build the pipeline. Note that we are NOT linking the source at this

* point. We will do it later. */

gst_bin_add_many (GST_BIN (data.pipeline), data.source, data.convert, data.resample, data.sink, NULL);

if (!gst_element_link_many (data.convert, data.resample, data.sink, NULL)) {

g_printerr ("Elements could not be linked.\n");

gst_object_unref (data.pipeline);

return -1;

}

/* Set the URI to play */

g_object_set (data.source, "uri", "https://gstreamer.freedesktop.org/data/media/sintel_trailer-480p.webm", NULL);

/* Connect to the pad-added signal */

g_signal_connect (data.source, "pad-added", G_CALLBACK (pad_added_handler), &data);

/* Start playing */

ret = gst_element_set_state (data.pipeline, GST_STATE_PLAYING);

if (ret == GST_STATE_CHANGE_FAILURE) {

g_printerr ("Unable to set the pipeline to the playing state.\n");

gst_object_unref (data.pipeline);

return -1;

}

/* Listen to the bus */

bus = gst_element_get_bus (data.pipeline);

do {

msg = gst_bus_timed_pop_filtered (bus, GST_CLOCK_TIME_NONE,

GST_MESSAGE_STATE_CHANGED | GST_MESSAGE_ERROR | GST_MESSAGE_EOS);

/* Parse message */

if (msg != NULL) {

GError *err;

gchar *debug_info;

switch (GST_MESSAGE_TYPE (msg)) {

case GST_MESSAGE_ERROR:

gst_message_parse_error (msg, &err, &debug_info);

g_printerr ("Error received from element %s: %s\n", GST_OBJECT_NAME (msg->src), err->message);

g_printerr ("Debugging information: %s\n", debug_info ? debug_info : "none");

g_clear_error (&err);

g_free (debug_info);

terminate = TRUE;

break;

case GST_MESSAGE_EOS:

g_print ("End-Of-Stream reached.\n");

terminate = TRUE;

break;

case GST_MESSAGE_STATE_CHANGED:

/* We are only interested in state-changed messages from the pipeline */

if (GST_MESSAGE_SRC (msg) == GST_OBJECT (data.pipeline)) {

GstState old_state, new_state, pending_state;

gst_message_parse_state_changed (msg, &old_state, &new_state, &pending_state);

g_print ("Pipeline state changed from %s to %s:\n",

gst_element_state_get_name (old_state), gst_element_state_get_name (new_state));

}

break;

default:

/* We should not reach here */

g_printerr ("Unexpected message received.\n");

break;

}

gst_message_unref (msg);

}

} while (!terminate);

/* Free resources */

gst_object_unref (bus);

gst_element_set_state (data.pipeline, GST_STATE_NULL);

gst_object_unref (data.pipeline);

return 0;

}

/* This function will be called by the pad-added signal */

static void pad_added_handler (GstElement *src, GstPad *new_pad, CustomData *data) {

GstPad *sink_pad = gst_element_get_static_pad (data->convert, "sink");

GstPadLinkReturn ret;

GstCaps *new_pad_caps = NULL;

GstStructure *new_pad_struct = NULL;

const gchar *new_pad_type = NULL;

g_print ("Received new pad '%s' from '%s':\n", GST_PAD_NAME (new_pad), GST_ELEMENT_NAME (src));

/* If our converter is already linked, we have nothing to do here */

if (gst_pad_is_linked (sink_pad)) {

g_print ("We are already linked. Ignoring.\n");

goto exit;

}

/* Check the new pad's type */

new_pad_caps = gst_pad_get_current_caps (new_pad);

new_pad_struct = gst_caps_get_structure (new_pad_caps, 0);

new_pad_type = gst_structure_get_name (new_pad_struct);

if (!g_str_has_prefix (new_pad_type, "audio/x-raw")) {

g_print ("It has type '%s' which is not raw audio. Ignoring.\n", new_pad_type);

goto exit;

}

/* Attempt the link */

ret = gst_pad_link (new_pad, sink_pad);

if (GST_PAD_LINK_FAILED (ret)) {

g_print ("Type is '%s' but link failed.\n", new_pad_type);

} else {

g_print ("Link succeeded (type '%s').\n", new_pad_type);

}

exit:

/* Unreference the new pad's caps, if we got them */

if (new_pad_caps != NULL)

gst_caps_unref (new_pad_caps);

/* Unreference the sink pad */

gst_object_unref (sink_pad);

}

需要帮忙?

如果您需要帮助来编译此代码,请参阅针对您的平台构建教程 部分:Linux、Mac OS X或Windows,或在 Linux 上使用此特定命令:

gcc basic-tutorial-3.c -o basic-tutorial-3pkg-config --cflags --libs gstreamer-1.0``如果您需要帮助来运行此代码,请参阅适用于您的平台的运行教程部分: Linux、Mac OS X或Windows。

本教程仅播放音频。媒体是从 Internet 获取的,因此可能需要几秒钟才能启动,具体取决于您的连接速度。

所需的库:

gstreamer-1.0

演练

/* Structure to contain all our information, so we can pass it to callbacks */

typedef struct _CustomData {

GstElement *pipeline;

GstElement *source;

GstElement *convert;

GstElement *resample;

GstElement *sink;

} CustomData;

到目前为止,我们已将所需的所有信息(GstElement基本上是指向 s 的指针)保存为局部变量。由于本教程(以及大多数实际应用程序)涉及回调,我们将把所有数据分组到一个结构中以便于处理。

/* Handler for the pad-added signal */

static void pad_added_handler (GstElement *src, GstPad *pad, CustomData *data);

这是前向引用,稍后使用。

/* Create the elements */

data.source = gst_element_factory_make ("uridecodebin", "source");

data.convert = gst_element_factory_make ("audioconvert", "convert");

data.resample = gst_element_factory_make ("audioresample", "resample");

data.sink = gst_element_factory_make ("autoaudiosink", "sink");

我们像往常一样创建元素。uridecodebin将在内部实例化所有必要的元素(源、多路分解器和解码器)以将 URI 转换为原始音频和/或视频流。它完成了一半的工作playbin。由于它包含多路分解器,它的源板最初不可用,我们需要动态链接到它们。

audioconvert用于在不同的音频格式之间进行转换,确保此示例适用于任何平台,因为音频解码器生成的格式可能与音频接收器期望的格式不同。

audioresample对于在不同的音频采样率之间进行转换很有用,同样确保此示例可以在任何平台上运行,因为音频解码器产生的音频采样率可能不是音频接收器支持的采样率。

对于音频,这autoaudiosink相当于autovideosink在上一个教程中看到的。它会将音频流渲染到声卡。

if (!gst_element_link_many (data.convert, data.resample, data.sink, NULL)) {

g_printerr ("Elements could not be linked.\n");

gst_object_unref (data.pipeline);

return -1;

}

这里我们链接元素转换器、重采样和接收器,但我们不将它们与源链接,因为此时它不包含源焊盘。我们只是让这个分支(converter + sink)保持未链接状态,直到稍后。

/* Set the URI to play */

g_object_set (data.source, "uri", "https://gstreamer.freedesktop.org/data/media/sintel_trailer-480p.webm", NULL);

我们将文件的 URI 设置为通过属性播放,就像我们在上一个教程中所做的那样。

信号

/* Connect to the pad-added signal */

g_signal_connect (data.source, "pad-added", G_CALLBACK (pad_added_handler), &data);

GSignals是 GStreamer 中的关键点。当发生有趣的事情时,它们允许您收到通知(通过回调的方式)。信号由名称标识,每个GObject信号都有自己的信号。

在这一行中,我们附加到源(一个元素)的“pad-added”信号uridecodebin。为此,我们使用g_signal_connect()并提供要使用的回调函数 ( pad_added_handler) 和数据指针。GStreamer 对这个数据指针不做任何事情,它只是将它转发给回调,以便我们可以与其共享信息。在这种情况下,我们将指针传递给CustomData我们专门为此目的构建的结构。

a 生成的信号GstElement可以在其文档中找到,也可以使用基础教程 10:GStreamer 工具gst-inspect-1.0中描述的工具。

我们现在准备好了!只需将管道设置为PLAYINGstate 并开始侦听总线以获取有趣的消息(如ERROR或EOS),就像在之前的教程中一样。

回调

当我们的源元素最终有足够的信息开始生成数据时,它将创建源焊盘,并触发“焊盘添加”信号。此时我们的回调将被调用:

static void pad_added_handler (GstElement *src, GstPad *new_pad, CustomData *data) {

src是GstElement触发信号的。在这个例子中,它只能是uridecodebin,因为它是我们附加的唯一信号。信号处理程序的第一个参数始终是触发它的对象。

new_pad是GstPad刚刚添加到src元素的 。这通常是我们要链接到的打击垫。

data是我们附加到信号时提供的指针。在这个例子中,我们用它来传递CustomData指针。

GstPad *sink_pad = gst_element_get_static_pad (data->convert, "sink");

我们从中CustomData提取转换器元素,然后使用 检索它的接收器垫gst_element_get_static_pad ()。这是我们要链接的打击垫new_pad。在之前的教程中,我们将元素与元素进行了链接,并让 GStreamer 选择合适的焊盘。现在我们要直接连接焊盘。

/* If our converter is already linked, we have nothing to do here */

if (gst_pad_is_linked (sink_pad)) {

g_print ("We are already linked. Ignoring.\n");

goto exit;

}

uridecodebin可以创建它认为合适的任意数量的 pad,并且对于每个 pad,都会调用此回调。一旦我们已经链接,这些代码行将阻止我们尝试链接到新的 pad。

/* Check the new pad's type */

new_pad_caps = gst_pad_get_current_caps (new_pad, NULL);

new_pad_struct = gst_caps_get_structure (new_pad_caps, 0);

new_pad_type = gst_structure_get_name (new_pad_struct);

if (!g_str_has_prefix (new_pad_type, "audio/x-raw")) {

g_print ("It has type '%s' which is not raw audio. Ignoring.\n", new_pad_type);

goto exit;

}

现在我们将检查这个新 pad 将要输出的数据类型,因为我们只对产生音频的 pad 感兴趣。我们之前已经创建了一段处理音频的管道(audioconvert与 audioresample和 链接autoaudiosink),例如,我们将无法将其链接到制作视频的 pad。

gst_pad_get_current_caps()检索包装在结构中的垫的当前功能(即它当前输出的数据类型)GstCaps 。可以使用查询垫可以支持的所有可能的上限 gst_pad_query_caps()。一个 pad 可以提供许多功能,因此GstCaps 可以包含许多GstStructure,每个代表不同的功能。pad 上的当前上限将始终具有单个GstStructure并代表单一媒体格式,或者如果没有当前上限,则将NULL返回。

因为,在这种情况下,我们知道我们想要的垫子只有一个功能(音频),所以我们用 检索第GstStructure一个 gst_caps_get_structure()。

最后,gst_structure_get_name()我们恢复结构的名称,其中包含格式的主要描述(实际上是媒体类型)。

如果名称不是audio/x-raw,则这不是解码音频垫,我们对此不感兴趣。

否则,尝试链接:

/* Attempt the link */

ret = gst_pad_link (new_pad, sink_pad);

if (GST_PAD_LINK_FAILED (ret)) {

g_print ("Type is '%s' but link failed.\n", new_pad_type);

} else {

g_print ("Link succeeded (type '%s').\n", new_pad_type);

}

gst_pad_link()试图链接两个垫。与 的情况一样gst_element_link(),必须指定从源到接收器的链接,并且两个焊盘必须由驻留在同一容器(或管道)中的元素拥有。

我们完成了!当出现正确类型的 pad 时,它将链接到音频处理管道的其余部分,并继续执行直到出现 ERROR 或 EOS。但是,我们将通过介绍 State 的概念从本教程中挤出更多内容。

GStreamer 状态

当我们说播放不会开始直到您将管道带到状态时,我们已经讨论了一些状态PLAYING。我们将在这里介绍其余状态及其含义。GStreamer中有4种状态:

| 状态 | 描述 |

|---|---|

NULL |

元素的 NULL 状态或初始状态。 |

READY |

该元素已准备好进入暂停状态。 |

PAUSED |

该元素已暂停,它已准备好接受和处理数据。然而,接收器元素只接受一个缓冲区然后阻塞。 |

PLAYING |

元素正在播放,时钟在运行,数据在流动。 |

只能在相邻的之间移动,也就是说,不能从NULL 到PLAYING,必须经过中间READY和PAUSED 状态。但是,如果您将管道设置为PLAYING,GStreamer 将为您进行中间转换。

case GST_MESSAGE_STATE_CHANGED:

/* We are only interested in state-changed messages from the pipeline */

if (GST_MESSAGE_SRC (msg) == GST_OBJECT (data.pipeline)) {

GstState old_state, new_state, pending_state;

gst_message_parse_state_changed (msg, &old_state, &new_state, &pending_state);

g_print ("Pipeline state changed from %s to %s:\n",

gst_element_state_get_name (old_state), gst_element_state_get_name (new_state));

}

break;

我们添加了这段代码,用于侦听有关状态更改的总线消息并将它们打印在屏幕上以帮助您了解转换。每个元素都将有关其当前状态的消息放在总线上,因此我们将它们过滤掉并仅监听来自管道的消息。

大多数应用程序只需要担心开始PLAYING播放,然后执行暂停,然后在程序退出时PAUSED返回以释放所有资源。NULL

锻炼

传统上,动态 pad 链接一直是许多程序员的难题。通过实例化一个(可能前面有autovideosink一个)证明你已经掌握了它,并在正确的垫出现时将它链接到多路分解器。videoconvert提示:您已经在屏幕上打印了视频板的类型。

您现在应该看到(和听到)与基础教程 1 中相同的电影:Hello world!. 在您使用的那个教程中playbin,这是一个方便的元素,它会自动为您处理所有的解复用和 pad 链接。大多数播放教程都致力于playbin.

结论

在本教程中,您学习了:

- 如何通知事件使用

GSignals - 如何

GstPad直接连接 s 而不是它们的父元素。 - GStreamer 元素的各种状态。

您还组合了这些项目以构建一个动态管道,该管道未在程序启动时定义,但在有关媒体的信息可用时创建。

您现在可以继续基础教程,并在基础教程 4:时间管理中了解如何执行查找和与时间相关的查询,或者转到回放教程,并获得有关playbin元素的更多见解。

请记住,在本页的附件中,您应该找到教程的完整源代码以及构建它所需的任何附件文件。很高兴有你在这里,很快再见!

基础教程4:时间管理

目标

本教程展示了如何使用 GStreamer 与时间相关的工具。尤其:

- 如何在管道中查询流位置或持续时间等信息。

- 如何在流中寻找(跳转)到不同的位置(时间)。

介绍

GstQuery是一种允许向元素或垫询问一条信息的机制。在此示例中,我们询问管道是否允许搜索(某些来源,如直播,不允许搜索)。如果允许,那么一旦电影播放了 10 秒,我们就会使用搜索跳到不同的位置。

在之前的教程中,一旦我们设置并运行了管道,我们的主要功能就只是坐着等待接收一个ERROR或一个EOS 通过总线。在这里,我们修改此函数以定期唤醒并查询管道的流位置,以便我们可以将其打印在屏幕上。这类似于媒体播放器会定期更新用户界面。

最后,流的持续时间会在它发生变化时被查询和更新。

求实例

将此代码复制到名为的文本文件中basic-tutorial-4.c(或在您的 GStreamer 安装中找到它)。

基础教程-4.c

#include <gst/gst.h>

/* Structure to contain all our information, so we can pass it around */

typedef struct _CustomData {

GstElement *playbin; /* Our one and only element */

gboolean playing; /* Are we in the PLAYING state? */

gboolean terminate; /* Should we terminate execution? */

gboolean seek_enabled; /* Is seeking enabled for this media? */

gboolean seek_done; /* Have we performed the seek already? */

gint64 duration; /* How long does this media last, in nanoseconds */

} CustomData;

/* Forward definition of the message processing function */

static void handle_message (CustomData *data, GstMessage *msg);

int main(int argc, char *argv[]) {

CustomData data;

GstBus *bus;

GstMessage *msg;

GstStateChangeReturn ret;

data.playing = FALSE;

data.terminate = FALSE;

data.seek_enabled = FALSE;

data.seek_done = FALSE;

data.duration = GST_CLOCK_TIME_NONE;

/* Initialize GStreamer */

gst_init (&argc, &argv);

/* Create the elements */

data.playbin = gst_element_factory_make ("playbin", "playbin");

if (!data.playbin) {

g_printerr ("Not all elements could be created.\n");

return -1;

}

/* Set the URI to play */

g_object_set (data.playbin, "uri", "https://gstreamer.freedesktop.org/data/media/sintel_trailer-480p.webm", NULL);

/* Start playing */

ret = gst_element_set_state (data.playbin, GST_STATE_PLAYING);

if (ret == GST_STATE_CHANGE_FAILURE) {

g_printerr ("Unable to set the pipeline to the playing state.\n");

gst_object_unref (data.playbin);

return -1;

}

/* Listen to the bus */

bus = gst_element_get_bus (data.playbin);

do {

msg = gst_bus_timed_pop_filtered (bus, 100 * GST_MSECOND,

GST_MESSAGE_STATE_CHANGED | GST_MESSAGE_ERROR | GST_MESSAGE_EOS | GST_MESSAGE_DURATION);

/* Parse message */

if (msg != NULL) {

handle_message (&data, msg);

} else {

/* We got no message, this means the timeout expired */

if (data.playing) {

gint64 current = -1;

/* Query the current position of the stream */

if (!gst_element_query_position (data.playbin, GST_FORMAT_TIME, ¤t)) {

g_printerr ("Could not query current position.\n");

}

/* If we didn't know it yet, query the stream duration */

if (!GST_CLOCK_TIME_IS_VALID (data.duration)) {

if (!gst_element_query_duration (data.playbin, GST_FORMAT_TIME, &data.duration)) {

g_printerr ("Could not query current duration.\n");

}

}

/* Print current position and total duration */

g_print ("Position %" GST_TIME_FORMAT " / %" GST_TIME_FORMAT "\r",

GST_TIME_ARGS (current), GST_TIME_ARGS (data.duration));

/* If seeking is enabled, we have not done it yet, and the time is right, seek */

if (data.seek_enabled && !data.seek_done && current > 10 * GST_SECOND) {

g_print ("\nReached 10s, performing seek...\n");

gst_element_seek_simple (data.playbin, GST_FORMAT_TIME,

GST_SEEK_FLAG_FLUSH | GST_SEEK_FLAG_KEY_UNIT, 30 * GST_SECOND);

data.seek_done = TRUE;

}

}

}

} while (!data.terminate);

/* Free resources */

gst_object_unref (bus);

gst_element_set_state (data.playbin, GST_STATE_NULL);

gst_object_unref (data.playbin);

return 0;

}

static void handle_message (CustomData *data, GstMessage *msg) {

GError *err;

gchar *debug_info;

switch (GST_MESSAGE_TYPE (msg)) {

case GST_MESSAGE_ERROR:

gst_message_parse_error (msg, &err, &debug_info);

g_printerr ("Error received from element %s: %s\n", GST_OBJECT_NAME (msg->src), err->message);

g_printerr ("Debugging information: %s\n", debug_info ? debug_info : "none");

g_clear_error (&err);

g_free (debug_info);

data->terminate = TRUE;

break;

case GST_MESSAGE_EOS:

g_print ("\nEnd-Of-Stream reached.\n");

data->terminate = TRUE;

break;

case GST_MESSAGE_DURATION:

/* The duration has changed, mark the current one as invalid */

data->duration = GST_CLOCK_TIME_NONE;

break;

case GST_MESSAGE_STATE_CHANGED: {

GstState old_state, new_state, pending_state;

gst_message_parse_state_changed (msg, &old_state, &new_state, &pending_state);

if (GST_MESSAGE_SRC (msg) == GST_OBJECT (data->playbin)) {

g_print ("Pipeline state changed from %s to %s:\n",

gst_element_state_get_name (old_state), gst_element_state_get_name (new_state));

/* Remember whether we are in the PLAYING state or not */

data->playing = (new_state == GST_STATE_PLAYING);

if (data->playing) {

/* We just moved to PLAYING. Check if seeking is possible */

GstQuery *query;

gint64 start, end;

query = gst_query_new_seeking (GST_FORMAT_TIME);

if (gst_element_query (data->playbin, query)) {

gst_query_parse_seeking (query, NULL, &data->seek_enabled, &start, &end);

if (data->seek_enabled) {

g_print ("Seeking is ENABLED from %" GST_TIME_FORMAT " to %" GST_TIME_FORMAT "\n",

GST_TIME_ARGS (start), GST_TIME_ARGS (end));

} else {

g_print ("Seeking is DISABLED for this stream.\n");

}

}

else {

g_printerr ("Seeking query failed.");

}

gst_query_unref (query);

}

}

} break;

default:

/* We should not reach here */

g_printerr ("Unexpected message received.\n");

break;

}

gst_message_unref (msg);

}

需要帮忙?

如果您需要帮助来编译此代码,请参阅针对您的平台构建教程 部分:Linux、Mac OS X或Windows,或在 Linux 上使用此特定命令:

gcc basic-tutorial-4.c -o basic-tutorial-4pkg-config --cflags --libs gstreamer-1.0``如果您需要帮助来运行此代码,请参阅适用于您的平台的运行教程部分: Linux、Mac OS X或Windows。

本教程将打开一个窗口并显示一个带有音频的电影。媒体是从 Internet 获取的,因此窗口可能需要几秒钟才会出现,具体取决于您的连接速度。进入电影 10 秒后,它会跳到一个新位置

所需的库:

gstreamer-1.0

演练

/* Structure to contain all our information, so we can pass it around */

typedef struct _CustomData {

GstElement *playbin; /* Our one and only element */

gboolean playing; /* Are we in the PLAYING state? */

gboolean terminate; /* Should we terminate execution? */

gboolean seek_enabled; /* Is seeking enabled for this media? */

gboolean seek_done; /* Have we performed the seek already? */

gint64 duration; /* How long does this media last, in nanoseconds */

} CustomData;

/* Forward definition of the message processing function */

static void handle_message (CustomData *data, GstMessage *msg);

我们首先定义一个结构来包含我们所有的信息,这样我们就可以将它传递给其他函数。特别是,在这个例子中,我们将消息处理代码移到它自己的函数中, handle_message因为它变得有点太大了。

然后我们构建一个由单个元素 a 组成的管道 playbin,我们已经在基础教程 1:Hello world!. 然而, playbin本身就是一个管道,在这种情况下它是管道中唯一的元素,所以我们直接使用元素playbin。我们将跳过细节:通过 URI 属性提供剪辑的 URI playbin,并将管道设置为播放状态。

msg = gst_bus_timed_pop_filtered (bus, 100 * GST_MSECOND,

GST_MESSAGE_STATE_CHANGED | GST_MESSAGE_ERROR | GST_MESSAGE_EOS | GST_MESSAGE_DURATION);

以前我们没有为 提供超时 gst_bus_timed_pop_filtered(),这意味着它在收到消息之前不会返回。现在我们使用 100 毫秒的超时,因此,如果在十分之一秒内没有收到消息,该函数将返回 NULL。我们将使用此逻辑来更新我们的“UI”。

请注意,所需的超时必须指定为 a GstClockTime,因此以纳秒为单位。表示不同时间单位的数字应该乘以GST_SECONDor之类的宏GST_MSECOND。这也使您的代码更具可读性。

如果我们收到一条消息,我们将在handle_message函数中处理它(下一小节),否则:

用户界面刷新

/* We got no message, this means the timeout expired */

if (data.playing) {

如果管道处于PLAYING状态,则该刷新屏幕了。如果我们不在状态中,我们不想做任何事情PLAYING,因为大多数查询都会失败。

我们每秒大约到达这里 10 次,这对于我们的 UI 来说已经足够好了。我们将在屏幕上打印当前媒体位置,我们可以通过查询管道来了解这一点。这涉及将在下一小节中显示的几个步骤,但是,由于位置和持续时间是足够常见的查询,因此GstElement提供更简单的现成替代方案:

/* Query the current position of the stream */

if (!gst_element_query_position (data.pipeline, GST_FORMAT_TIME, ¤t)) {

g_printerr ("Could not query current position.\n");

}

gst_element_query_position()隐藏了对查询对象的管理,直接给我们提供结果。

/* If we didn't know it yet, query the stream duration */

if (!GST_CLOCK_TIME_IS_VALID (data.duration)) {

if (!gst_element_query_duration (data.pipeline, GST_FORMAT_TIME, &data.duration)) {

g_printerr ("Could not query current duration.\n");

}

}

现在是了解流长度的好时机,使用另一个GstElement辅助函数:gst_element_query_duration()

/* Print current position and total duration */

g_print ("Position %" GST_TIME_FORMAT " / %" GST_TIME_FORMAT "\r",

GST_TIME_ARGS (current), GST_TIME_ARGS (data.duration));

请注意使用GST_TIME_FORMAT和GST_TIME_ARGS宏来提供 GStreamer 时间的用户友好表示。

/* If seeking is enabled, we have not done it yet, and the time is right, seek */

if (data.seek_enabled && !data.seek_done && current > 10 * GST_SECOND) {

g_print ("\nReached 10s, performing seek...\n");

gst_element_seek_simple (data.pipeline, GST_FORMAT_TIME,

GST_SEEK_FLAG_FLUSH | GST_SEEK_FLAG_KEY_UNIT, 30 * GST_SECOND);

data.seek_done = TRUE;

}

gst_element_seek_simple()现在我们通过调用管道“简单地”执行查找。很多求道的奥妙都藏在这个方法里,真是好东西!

让我们回顾一下参数:

GST_FORMAT_TIME表示我们正在以时间单位指定目的地。其他搜索格式使用不同的单位。

那么来吧GstSeekFlags,让我们回顾一下最常见的:

GST_SEEK_FLAG_FLUSH:这会在进行查找之前丢弃当前管道中的所有数据。在重新填充管道并且新数据开始显示时可能会暂停一下,但会大大提高应用程序的“响应能力”。如果未提供此标志,“陈旧”数据可能会显示一段时间,直到新位置出现在管道的末端。

GST_SEEK_FLAG_KEY_UNIT:对于大多数编码视频流,寻找任意位置是不可能的,但只能寻找称为关键帧的特定帧。使用此标志时,搜索实际上将移动到最近的关键帧并立即开始生成数据。如果不使用此标志,管道将在内部移动到最近的关键帧(它没有其他选择),但在到达请求的位置之前不会显示数据。最后一种选择更准确,但可能需要更长的时间。

GST_SEEK_FLAG_ACCURATE:一些媒体剪辑没有提供足够的索引信息,这意味着寻找任意位置非常耗时。在这些情况下,GStreamer 通常会估计要寻找的位置,并且通常工作得很好。如果这个精度对你的情况来说不够好(你看到搜索没有达到你要求的确切时间),那么提供这个标志。请注意,计算搜索位置可能需要更长的时间(在某些文件上很长)。

最后,我们提供要寻求的位置。由于我们要求GST_FORMAT_TIME,该值必须以纳秒为单位,因此为简单起见,我们以秒为单位表示时间,然后乘以GST_SECOND。

消息泵

该handle_message函数处理通过管道总线接收到的所有消息。ERROR和EOS处理与之前的教程相同,所以我们跳到有趣的部分:

case GST_MESSAGE_DURATION:

/* The duration has changed, mark the current one as invalid */

data->duration = GST_CLOCK_TIME_NONE;

break;

每当流的持续时间发生变化时,此消息就会发布在总线上。这里我们简单地将当前持续时间标记为无效,以便稍后重新查询。

case GST_MESSAGE_STATE_CHANGED: {

GstState old_state, new_state, pending_state;

gst_message_parse_state_changed (msg, &old_state, &new_state, &pending_state);

if (GST_MESSAGE_SRC (msg) == GST_OBJECT (data->pipeline)) {

g_print ("Pipeline state changed from %s to %s:\n",

gst_element_state_get_name (old_state), gst_element_state_get_name (new_state));

/* Remember whether we are in the PLAYING state or not */

data->playing = (new_state == GST_STATE_PLAYING);

Seeks 和 time queries 通常只有在 PAUSEDorPLAYING状态下才能得到有效的回复,因为所有元素都有机会接收信息并配置自己。在这里,我们使用playing 变量来跟踪管道是否处于PLAYING状态。此外,如果我们刚刚进入该PLAYING状态,我们将进行第一个查询。我们询问管道是否允许在此流上进行搜索:

if (data->playing) {

/* We just moved to PLAYING. Check if seeking is possible */

GstQuery *query;

gint64 start, end;

query = gst_query_new_seeking (GST_FORMAT_TIME);

if (gst_element_query (data->pipeline, query)) {

gst_query_parse_seeking (query, NULL, &data->seek_enabled, &start, &end);

if (data->seek_enabled) {

g_print ("Seeking is ENABLED from %" GST_TIME_FORMAT " to %" GST_TIME_FORMAT "\n",

GST_TIME_ARGS (start), GST_TIME_ARGS (end));

} else {

g_print ("Seeking is DISABLED for this stream.\n");

}

}

else {

g_printerr ("Seeking query failed.");

}

gst_query_unref (query);

}

gst_query_new_seeking()创建一个具有格式的“寻求”类型的新查询对象GST_FORMAT_TIME。这表明我们有兴趣通过指定我们想要移动到的新时间来寻找。我们也可以请求GST_FORMAT_BYTES,然后寻找源文件中的特定字节位置,但这通常不太有用。

然后将此查询对象传递给管道 gst_element_query()。结果存储在同一个查询中,可以使用 轻松检索gst_query_parse_seeking()。它提取一个布尔值,指示是否允许查找,以及查找可能的范围。

完成后不要忘记取消引用查询对象。

就是这样!有了这些知识,就可以构建一个媒体播放器,它会根据当前流位置定期更新滑块,并允许通过移动滑块进行搜索!

结论

本教程展示了:

- 如何查询管道信息使用

GstQuery - 如何使用

gst_element_query_position()和获取位置和持续时间等公共信息gst_element_query_duration() - 如何使用流中的任意位置

gst_element_seek_simple() - 在哪些状态下可以执行所有这些操作。

下一个教程将展示如何将 GStreamer 与图形用户界面工具包集成。

请记住,在本页的附件中,您应该找到教程的完整源代码以及构建它所需的任何附件文件。

很高兴有你在这里,很快再见!

基础教程5:GUI工具包集成

目标

本教程展示了如何将 GStreamer 集成到图形用户界面 (GUI) 工具包中,例如GTK+。基本上,GStreamer 负责媒体播放,而 GUI 工具包处理用户交互。最有趣的部分是两个库必须交互的部分:指示 GStreamer 将视频输出到 GTK+ 窗口并将用户操作转发到 GStreamer。

特别是,您将学习:

- 如何告诉 GStreamer 将视频输出到特定窗口(而不是创建自己的窗口)。

- 如何使用来自 GStreamer 的信息不断刷新 GUI。

- 如何从 GStreamer 的多线程更新 GUI,这是大多数 GUI 工具包禁止的操作。

- 一种仅订阅您感兴趣的消息的机制,而不是收到所有消息的通知。

介绍

我们将使用 GTK+工具包构建一个媒体播放器,但这些概念适用于其他工具包,例如Qt 。对GTK+有最低限度的了解将有助于理解本教程。

要点是告诉 GStreamer 将视频输出到我们选择的窗口。具体机制取决于操作系统(或者更确切地说,取决于窗口系统),但 GStreamer 为平台独立性提供了一个抽象层。这种独立性来自GstVideoOverlay接口,它允许应用程序告诉视频接收器应该接收渲染的窗口的处理程序。

GObject 接口

接口(GStreamer 使用的

GObject接口)是元素可以实现的一组函数。如果是,则称它支持该特定接口。例如,视频接收器通常创建自己的窗口来显示视频,但是,如果它们也能够渲染到外部窗口,则它们可以选择实现接口GstVideoOverlay并提供指定此外部窗口的函数。从应用程序开发人员的角度来看,如果支持某个接口,您就可以使用它而不必管是哪种元素在实现它。而且,如果你在使用playbin,它会自动暴露一些它内部元素支持的接口:你可以直接在上面使用你的接口函数,playbin而不知道是谁在实现它们!

另一个问题是 GUI 工具包通常只允许通过主(或应用程序)线程操作图形“小部件”,而 GStreamer 通常会产生多个线程来处理不同的任务。从回调中调用GTK+函数通常会失败,因为回调在调用线程中执行,不需要是主线程。这个问题可以通过在回调中在 GStreamer 总线上发布一条消息来解决:消息将由主线程接收,然后主线程将做出相应的反应。

最后,到目前为止,我们已经注册了一个handle_message函数,每次消息出现在总线上时都会调用该函数,这迫使我们解析每条消息以查看它是否对我们感兴趣。在本教程中,使用了一种不同的方法来为每种消息注册回调,因此总体上解析和代码更少。

GTK+ 中的媒体播放器

让我们基于 playbin 编写一个非常简单的媒体播放器,这次,使用 GUI!

将此代码复制到名为的文本文件中basic-tutorial-5.c(或在您的 GStreamer 安装中找到它)。

基础教程-5.c

#include <string.h>

#include <gtk/gtk.h>

#include <gst/gst.h>

#include <gst/video/videooverlay.h>

#include <gdk/gdk.h>

#if defined (GDK_WINDOWING_X11)

#include <gdk/gdkx.h>

#elif defined (GDK_WINDOWING_WIN32)

#include <gdk/gdkwin32.h>

#elif defined (GDK_WINDOWING_QUARTZ)

#include <gdk/gdkquartz.h>

#endif

/* Structure to contain all our information, so we can pass it around */

typedef struct _CustomData {

GstElement *playbin; /* Our one and only pipeline */

GtkWidget *slider; /* Slider widget to keep track of current position */

GtkWidget *streams_list; /* Text widget to display info about the streams */

gulong slider_update_signal_id; /* Signal ID for the slider update signal */

GstState state; /* Current state of the pipeline */

gint64 duration; /* Duration of the clip, in nanoseconds */

} CustomData;

/* This function is called when the GUI toolkit creates the physical window that will hold the video.

* At this point we can retrieve its handler (which has a different meaning depending on the windowing system)

* and pass it to GStreamer through the VideoOverlay interface. */

static void realize_cb (GtkWidget *widget, CustomData *data) {

GdkWindow *window = gtk_widget_get_window (widget);

guintptr window_handle;

if (!gdk_window_ensure_native (window))

g_error ("Couldn't create native window needed for GstVideoOverlay!");

/* Retrieve window handler from GDK */

#if defined (GDK_WINDOWING_WIN32)

window_handle = (guintptr)GDK_WINDOW_HWND (window);

#elif defined (GDK_WINDOWING_QUARTZ)

window_handle = gdk_quartz_window_get_nsview (window);

#elif defined (GDK_WINDOWING_X11)

window_handle = GDK_WINDOW_XID (window);

#endif

/* Pass it to playbin, which implements VideoOverlay and will forward it to the video sink */

gst_video_overlay_set_window_handle (GST_VIDEO_OVERLAY (data->playbin), window_handle);

}

/* This function is called when the PLAY button is clicked */

static void play_cb (GtkButton *button, CustomData *data) {

gst_element_set_state (data->playbin, GST_STATE_PLAYING);

}

/* This function is called when the PAUSE button is clicked */

static void pause_cb (GtkButton *button, CustomData *data) {

gst_element_set_state (data->playbin, GST_STATE_PAUSED);

}

/* This function is called when the STOP button is clicked */

static void stop_cb (GtkButton *button, CustomData *data) {

gst_element_set_state (data->playbin, GST_STATE_READY);

}

/* This function is called when the main window is closed */

static void delete_event_cb (GtkWidget *widget, GdkEvent *event, CustomData *data) {

stop_cb (NULL, data);

gtk_main_quit ();

}

/* This function is called everytime the video window needs to be redrawn (due to damage/exposure,

* rescaling, etc). GStreamer takes care of this in the PAUSED and PLAYING states, otherwise,

* we simply draw a black rectangle to avoid garbage showing up. */

static gboolean draw_cb (GtkWidget *widget, cairo_t *cr, CustomData *data) {

if (data->state < GST_STATE_PAUSED) {

GtkAllocation allocation;

/* Cairo is a 2D graphics library which we use here to clean the video window.

* It is used by GStreamer for other reasons, so it will always be available to us. */

gtk_widget_get_allocation (widget, &allocation);

cairo_set_source_rgb (cr, 0, 0, 0);

cairo_rectangle (cr, 0, 0, allocation.width, allocation.height);

cairo_fill (cr);

}

return FALSE;

}

/* This function is called when the slider changes its position. We perform a seek to the

* new position here. */

static void slider_cb (GtkRange *range, CustomData *data) {

gdouble value = gtk_range_get_value (GTK_RANGE (data->slider));

gst_element_seek_simple (data->playbin, GST_FORMAT_TIME, GST_SEEK_FLAG_FLUSH | GST_SEEK_FLAG_KEY_UNIT,

(gint64)(value * GST_SECOND));

}

/* This creates all the GTK+ widgets that compose our application, and registers the callbacks */

static void create_ui (CustomData *data) {

GtkWidget *main_window; /* The uppermost window, containing all other windows */

GtkWidget *video_window; /* The drawing area where the video will be shown */

GtkWidget *main_box; /* VBox to hold main_hbox and the controls */

GtkWidget *main_hbox; /* HBox to hold the video_window and the stream info text widget */

GtkWidget *controls; /* HBox to hold the buttons and the slider */

GtkWidget *play_button, *pause_button, *stop_button; /* Buttons */

main_window = gtk_window_new (GTK_WINDOW_TOPLEVEL);

g_signal_connect (G_OBJECT (main_window), "delete-event", G_CALLBACK (delete_event_cb), data);

video_window = gtk_drawing_area_new ();

gtk_widget_set_double_buffered (video_window, FALSE);

g_signal_connect (video_window, "realize", G_CALLBACK (realize_cb), data);

g_signal_connect (video_window, "draw", G_CALLBACK (draw_cb), data);

play_button = gtk_button_new_from_icon_name ("media-playback-start", GTK_ICON_SIZE_SMALL_TOOLBAR);

g_signal_connect (G_OBJECT (play_button), "clicked", G_CALLBACK (play_cb), data);

pause_button = gtk_button_new_from_icon_name ("media-playback-pause", GTK_ICON_SIZE_SMALL_TOOLBAR);

g_signal_connect (G_OBJECT (pause_button), "clicked", G_CALLBACK (pause_cb), data);

stop_button = gtk_button_new_from_icon_name ("media-playback-stop", GTK_ICON_SIZE_SMALL_TOOLBAR);

g_signal_connect (G_OBJECT (stop_button), "clicked", G_CALLBACK (stop_cb), data);

data->slider = gtk_scale_new_with_range (GTK_ORIENTATION_HORIZONTAL, 0, 100, 1);

gtk_scale_set_draw_value (GTK_SCALE (data->slider), 0);

data->slider_update_signal_id = g_signal_connect (G_OBJECT (data->slider), "value-changed", G_CALLBACK (slider_cb), data);

data->streams_list = gtk_text_view_new ();

gtk_text_view_set_editable (GTK_TEXT_VIEW (data->streams_list), FALSE);

controls = gtk_box_new (GTK_ORIENTATION_HORIZONTAL, 0);

gtk_box_pack_start (GTK_BOX (controls), play_button, FALSE, FALSE, 2);

gtk_box_pack_start (GTK_BOX (controls), pause_button, FALSE, FALSE, 2);

gtk_box_pack_start (GTK_BOX (controls), stop_button, FALSE, FALSE, 2);

gtk_box_pack_start (GTK_BOX (controls), data->slider, TRUE, TRUE, 2);

main_hbox = gtk_box_new (GTK_ORIENTATION_HORIZONTAL, 0);

gtk_box_pack_start (GTK_BOX (main_hbox), video_window, TRUE, TRUE, 0);

gtk_box_pack_start (GTK_BOX (main_hbox), data->streams_list, FALSE, FALSE, 2);

main_box = gtk_box_new (GTK_ORIENTATION_VERTICAL, 0);

gtk_box_pack_start (GTK_BOX (main_box), main_hbox, TRUE, TRUE, 0);

gtk_box_pack_start (GTK_BOX (main_box), controls, FALSE, FALSE, 0);

gtk_container_add (GTK_CONTAINER (main_window), main_box);

gtk_window_set_default_size (GTK_WINDOW (main_window), 640, 480);

gtk_widget_show_all (main_window);

}

/* This function is called periodically to refresh the GUI */

static gboolean refresh_ui (CustomData *data) {

gint64 current = -1;

/* We do not want to update anything unless we are in the PAUSED or PLAYING states */

if (data->state < GST_STATE_PAUSED)

return TRUE;

/* If we didn't know it yet, query the stream duration */

if (!GST_CLOCK_TIME_IS_VALID (data->duration)) {

if (!gst_element_query_duration (data->playbin, GST_FORMAT_TIME, &data->duration)) {

g_printerr ("Could not query current duration.\n");

} else {

/* Set the range of the slider to the clip duration, in SECONDS */

gtk_range_set_range (GTK_RANGE (data->slider), 0, (gdouble)data->duration / GST_SECOND);

}

}

if (gst_element_query_position (data->playbin, GST_FORMAT_TIME, ¤t)) {

/* Block the "value-changed" signal, so the slider_cb function is not called

* (which would trigger a seek the user has not requested) */

g_signal_handler_block (data->slider, data->slider_update_signal_id);

/* Set the position of the slider to the current pipeline position, in SECONDS */

gtk_range_set_value (GTK_RANGE (data->slider), (gdouble)current / GST_SECOND);

/* Re-enable the signal */

g_signal_handler_unblock (data->slider, data->slider_update_signal_id);

}

return TRUE;

}

/* This function is called when new metadata is discovered in the stream */

static void tags_cb (GstElement *playbin, gint stream, CustomData *data) {

/* We are possibly in a GStreamer working thread, so we notify the main

* thread of this event through a message in the bus */

gst_element_post_message (playbin,

gst_message_new_application (GST_OBJECT (playbin),

gst_structure_new_empty ("tags-changed")));

}

/* This function is called when an error message is posted on the bus */

static void error_cb (GstBus *bus, GstMessage *msg, CustomData *data) {

GError *err;

gchar *debug_info;

/* Print error details on the screen */

gst_message_parse_error (msg, &err, &debug_info);

g_printerr ("Error received from element %s: %s\n", GST_OBJECT_NAME (msg->src), err->message);

g_printerr ("Debugging information: %s\n", debug_info ? debug_info : "none");

g_clear_error (&err);

g_free (debug_info);

/* Set the pipeline to READY (which stops playback) */

gst_element_set_state (data->playbin, GST_STATE_READY);

}

/* This function is called when an End-Of-Stream message is posted on the bus.

* We just set the pipeline to READY (which stops playback) */

static void eos_cb (GstBus *bus, GstMessage *msg, CustomData *data) {

g_print ("End-Of-Stream reached.\n");

gst_element_set_state (data->playbin, GST_STATE_READY);

}

/* This function is called when the pipeline changes states. We use it to

* keep track of the current state. */

static void state_changed_cb (GstBus *bus, GstMessage *msg, CustomData *data) {

GstState old_state, new_state, pending_state;

gst_message_parse_state_changed (msg, &old_state, &new_state, &pending_state);

if (GST_MESSAGE_SRC (msg) == GST_OBJECT (data->playbin)) {

data->state = new_state;

g_print ("State set to %s\n", gst_element_state_get_name (new_state));

if (old_state == GST_STATE_READY && new_state == GST_STATE_PAUSED) {

/* For extra responsiveness, we refresh the GUI as soon as we reach the PAUSED state */

refresh_ui (data);

}

}

}

/* Extract metadata from all the streams and write it to the text widget in the GUI */

static void analyze_streams (CustomData *data) {

gint i;

GstTagList *tags;

gchar *str, *total_str;

guint rate;

gint n_video, n_audio, n_text;

GtkTextBuffer *text;

/* Clean current contents of the widget */

text = gtk_text_view_get_buffer (GTK_TEXT_VIEW (data->streams_list));

gtk_text_buffer_set_text (text, "", -1);

/* Read some properties */

g_object_get (data->playbin, "n-video", &n_video, NULL);

g_object_get (data->playbin, "n-audio", &n_audio, NULL);

g_object_get (data->playbin, "n-text", &n_text, NULL);

for (i = 0; i < n_video; i++) {

tags = NULL;

/* Retrieve the stream's video tags */

g_signal_emit_by_name (data->playbin, "get-video-tags", i, &tags);

if (tags) {

total_str = g_strdup_printf ("video stream %d:\n", i);

gtk_text_buffer_insert_at_cursor (text, total_str, -1);

g_free (total_str);

gst_tag_list_get_string (tags, GST_TAG_VIDEO_CODEC, &str);

total_str = g_strdup_printf (" codec: %s\n", str ? str : "unknown");

gtk_text_buffer_insert_at_cursor (text, total_str, -1);

g_free (total_str);

g_free (str);

gst_tag_list_free (tags);

}

}

for (i = 0; i < n_audio; i++) {

tags = NULL;

/* Retrieve the stream's audio tags */

g_signal_emit_by_name (data->playbin, "get-audio-tags", i, &tags);

if (tags) {

total_str = g_strdup_printf ("\naudio stream %d:\n", i);

gtk_text_buffer_insert_at_cursor (text, total_str, -1);

g_free (total_str);

if (gst_tag_list_get_string (tags, GST_TAG_AUDIO_CODEC, &str)) {

total_str = g_strdup_printf (" codec: %s\n", str);

gtk_text_buffer_insert_at_cursor (text, total_str, -1);

g_free (total_str);

g_free (str);

}

if (gst_tag_list_get_string (tags, GST_TAG_LANGUAGE_CODE, &str)) {

total_str = g_strdup_printf (" language: %s\n", str);

gtk_text_buffer_insert_at_cursor (text, total_str, -1);

g_free (total_str);

g_free (str);

}

if (gst_tag_list_get_uint (tags, GST_TAG_BITRATE, &rate)) {

total_str = g_strdup_printf (" bitrate: %d\n", rate);

gtk_text_buffer_insert_at_cursor (text, total_str, -1);

g_free (total_str);

}

gst_tag_list_free (tags);

}

}

for (i = 0; i < n_text; i++) {

tags = NULL;

/* Retrieve the stream's subtitle tags */

g_signal_emit_by_name (data->playbin, "get-text-tags", i, &tags);

if (tags) {

total_str = g_strdup_printf ("\nsubtitle stream %d:\n", i);

gtk_text_buffer_insert_at_cursor (text, total_str, -1);

g_free (total_str);

if (gst_tag_list_get_string (tags, GST_TAG_LANGUAGE_CODE, &str)) {

total_str = g_strdup_printf (" language: %s\n", str);

gtk_text_buffer_insert_at_cursor (text, total_str, -1);

g_free (total_str);

g_free (str);

}

gst_tag_list_free (tags);

}

}

}

/* This function is called when an "application" message is posted on the bus.

* Here we retrieve the message posted by the tags_cb callback */

static void application_cb (GstBus *bus, GstMessage *msg, CustomData *data) {

if (g_strcmp0 (gst_structure_get_name (gst_message_get_structure (msg)), "tags-changed") == 0) {

/* If the message is the "tags-changed" (only one we are currently issuing), update

* the stream info GUI */

analyze_streams (data);

}

}

int main(int argc, char *argv[]) {

CustomData data;

GstStateChangeReturn ret;

GstBus *bus;

/* Initialize GTK */

gtk_init (&argc, &argv);

/* Initialize GStreamer */

gst_init (&argc, &argv);

/* Initialize our data structure */

memset (&data, 0, sizeof (data));

data.duration = GST_CLOCK_TIME_NONE;

/* Create the elements */

data.playbin = gst_element_factory_make ("playbin", "playbin");

if (!data.playbin) {

g_printerr ("Not all elements could be created.\n");

return -1;

}

/* Set the URI to play */

g_object_set (data.playbin, "uri", "https://gstreamer.freedesktop.org/data/media/sintel_trailer-480p.webm", NULL);

/* Connect to interesting signals in playbin */

g_signal_connect (G_OBJECT (data.playbin), "video-tags-changed", (GCallback) tags_cb, &data);

g_signal_connect (G_OBJECT (data.playbin), "audio-tags-changed", (GCallback) tags_cb, &data);

g_signal_connect (G_OBJECT (data.playbin), "text-tags-changed", (GCallback) tags_cb, &data);

/* Create the GUI */

create_ui (&data);

/* Instruct the bus to emit signals for each received message, and connect to the interesting signals */

bus = gst_element_get_bus (data.playbin);

gst_bus_add_signal_watch (bus);

g_signal_connect (G_OBJECT (bus), "message::error", (GCallback)error_cb, &data);

g_signal_connect (G_OBJECT (bus), "message::eos", (GCallback)eos_cb, &data);

g_signal_connect (G_OBJECT (bus), "message::state-changed", (GCallback)state_changed_cb, &data);

g_signal_connect (G_OBJECT (bus), "message::application", (GCallback)application_cb, &data);

gst_object_unref (bus);

/* Start playing */

ret = gst_element_set_state (data.playbin, GST_STATE_PLAYING);

if (ret == GST_STATE_CHANGE_FAILURE) {

g_printerr ("Unable to set the pipeline to the playing state.\n");

gst_object_unref (data.playbin);

return -1;

}

/* Register a function that GLib will call every second */

g_timeout_add_seconds (1, (GSourceFunc)refresh_ui, &data);

/* Start the GTK main loop. We will not regain control until gtk_main_quit is called. */

gtk_main ();

/* Free resources */

gst_element_set_state (data.playbin, GST_STATE_NULL);

gst_object_unref (data.playbin);

return 0;

}

需要帮忙?

如果您需要帮助来编译此代码,请参阅针对您的平台构建教程 部分:Linux、Mac OS X或Windows,或在 Linux 上使用此特定命令:

gcc basic-tutorial-5.c -o basic-tutorial-5pkg-config --cflags --libs gstreamer-video-1.0 gtk+-3.0 gstreamer-1.0``如果您需要帮助来运行此代码,请参阅适用于您的平台的运行教程部分: Linux、Mac OS X或Windows。

本教程打开一个 GTK+ 窗口并显示一个带有音频的电影。媒体是从 Internet 获取的,因此窗口可能需要几秒钟才会出现,具体取决于您的连接速度。窗口有一些 GTK+ 按钮来暂停、停止和播放电影,还有一个滑块来显示流的当前位置,可以拖动它来改变它。此外,有关流的信息显示在窗口右边缘的一列中。

请记住,没有延迟管理(缓冲),因此在连接速度较慢时,电影可能会在几秒钟后停止。查看基础教程 12:Streaming如何解决此问题。

所需的库:

gstreamer-video-1.0 gtk+-3.0 gstreamer-1.0

演练

关于本教程的结构,我们将不再使用前向函数定义:函数将在使用前定义。此外,为了解释清楚起见,代码片段的呈现顺序并不总是与程序顺序相匹配。使用行号在完整代码中定位片段。

#include <gdk/gdk.h>

#if defined (GDK_WINDOWING_X11)

#include <gdk/gdkx.h>

#elif defined (GDK_WINDOWING_WIN32)

#include <gdk/gdkwin32.h>

#elif defined (GDK_WINDOWING_QUARTZ)

#include <gdk/gdkquartzwindow.h>

#endif

值得注意的第一件事是我们不再完全独立于平台。我们需要为我们将要使用的窗口系统包含适当的 GDK 头文件。幸运的是,支持的窗口系统并不多,所以这三行通常就足够了:Linux 的 X11、Windows 的 Win32 和 Mac OSX 的 Quartz。

本教程主要由回调函数组成,这些回调函数将从 GStreamer 或 GTK+ 调用,所以让我们回顾一下main注册所有这些回调的函数。

int main(int argc, char *argv[]) {

CustomData data;

GstStateChangeReturn ret;

GstBus *bus;

/* Initialize GTK */

gtk_init (&argc, &argv);

/* Initialize GStreamer */

gst_init (&argc, &argv);

/* Initialize our data structure */

memset (&data, 0, sizeof (data));

data.duration = GST_CLOCK_TIME_NONE;

/* Create the elements */

data.playbin = gst_element_factory_make ("playbin", "playbin");

if (!data.playbin) {

g_printerr ("Not all elements could be created.\n");

return -1;

}

/* Set the URI to play */

g_object_set (data.playbin, "uri", "https://gstreamer.freedesktop.org/data/media/sintel_trailer-480p.webm", NULL);

标准 GStreamer 初始化和 playbin 管道创建,以及 GTK+ 初始化。没有多少新意。

/* Connect to interesting signals in playbin */

g_signal_connect (G_OBJECT (data.playbin), "video-tags-changed", (GCallback) tags_cb, &data);

g_signal_connect (G_OBJECT (data.playbin), "audio-tags-changed", (GCallback) tags_cb, &data);

g_signal_connect (G_OBJECT (data.playbin), "text-tags-changed", (GCallback) tags_cb, &data);

我们有兴趣在流中出现新标签(元数据)时收到通知。为简单起见,我们将处理来自同一个回调的各种标签(视频、音频和文本)tags_cb。

/* Create the GUI */

create_ui (&data);

所有 GTK+ 小部件的创建和信号注册都发生在这个函数中。它只包含与 GTK 相关的函数调用,因此我们将跳过它的定义。它注册的信号传达用户命令,如下面查看回调时所示。

/* Instruct the bus to emit signals for each received message, and connect to the interesting signals */

bus = gst_element_get_bus (data.playbin);

gst_bus_add_signal_watch (bus);

g_signal_connect (G_OBJECT (bus), "message::error", (GCallback)error_cb, &data);

g_signal_connect (G_OBJECT (bus), "message::eos", (GCallback)eos_cb, &data);

g_signal_connect (G_OBJECT (bus), "message::state-changed", (GCallback)state_changed_cb, &data);

g_signal_connect (G_OBJECT (bus), "message::application", (GCallback)application_cb, &data);

gst_object_unref (bus);

在Playback tutorial 1: Playbin usage中,gst_bus_add_watch()用于注册一个函数,该函数接收发布到 GStreamer 总线的每条消息。我们可以通过使用信号来实现更精细的粒度,这允许我们只注册我们感兴趣的消息。通过调用,gst_bus_add_signal_watch()我们指示总线在每次收到消息时发出信号。此信号的名称message::detail是detail触发信号发射的消息。例如,当总线收到 EOS 消息时,它会发出一个名为 的信号message::eos。

This tutorial is using the Signals's details to register only to the messages we care about. If we had registered to the message signal, we would be notified of every single message, just like gst_bus_add_watch() would do.

Keep in mind that, in order for the bus watches to work (be it a gst_bus_add_watch() or a gst_bus_add_signal_watch()), there must be GLib Main Loop running. In this case, it is hidden inside the GTK+ main loop.

/* Register a function that GLib will call every second */

g_timeout_add_seconds (1, (GSourceFunc)refresh_ui, &data);

Before transferring control to GTK+, we use g_timeout_add_seconds () to register yet another callback, this time with a timeout, so it gets called every second. We are going to use it to refresh the GUI from the refresh_ui function.

After this, we are done with the setup and can start the GTK+ main loop. We will regain control from our callbacks when interesting things happen. Let's review the callbacks. Each callback has a different signature, depending on who will call it. You can look up the signature (the meaning of the parameters and the return value) in the documentation of the signal.

/* This function is called when the GUI toolkit creates the physical window that will hold the video.

* At this point we can retrieve its handler (which has a different meaning depending on the windowing system)

* and pass it to GStreamer through the VideoOverlay interface. */

static void realize_cb (GtkWidget *widget, CustomData *data) {

GdkWindow *window = gtk_widget_get_window (widget);

guintptr window_handle;

if (!gdk_window_ensure_native (window))

g_error ("Couldn't create native window needed for GstVideoOverlay!");

/* Retrieve window handler from GDK */

#if defined (GDK_WINDOWING_WIN32)

window_handle = (guintptr)GDK_WINDOW_HWND (window);

#elif defined (GDK_WINDOWING_QUARTZ)

window_handle = gdk_quartz_window_get_nsview (window);

#elif defined (GDK_WINDOWING_X11)

window_handle = GDK_WINDOW_XID (window);

#endif

/* Pass it to playbin, which implements VideoOverlay and will forward it to the video sink */

gst_video_overlay_set_window_handle (GST_VIDEO_OVERLAY (data->playbin), window_handle);

}

The code comments talks by itself. At this point in the life cycle of the application, we know the handle (be it an X11's XID, a Window's HWND or a Quartz's NSView) of the window where GStreamer should render the video. We simply retrieve it from the windowing system and pass it to playbin through the GstVideoOverlay interface using gst_video_overlay_set_window_handle(). playbin will locate the video sink and pass the handler to it, so it does not create its own window and uses this one.

Not much more to see here; playbin and the GstVideoOverlay really simplify this process a lot!

/* This function is called when the PLAY button is clicked */

static void play_cb (GtkButton *button, CustomData *data) {

gst_element_set_state (data->playbin, GST_STATE_PLAYING);

}

/* This function is called when the PAUSE button is clicked */

static void pause_cb (GtkButton *button, CustomData *data) {

gst_element_set_state (data->playbin, GST_STATE_PAUSED);

}

/* This function is called when the STOP button is clicked */

static void stop_cb (GtkButton *button, CustomData *data) {

gst_element_set_state (data->playbin, GST_STATE_READY);

}

These three little callbacks are associated with the PLAY, PAUSE and STOP buttons in the GUI. They simply set the pipeline to the corresponding state. Note that in the STOP state we set the pipeline to READY. We could have brought the pipeline all the way down to the NULL state, but, the transition would then be a little slower, since some resources (like the audio device) would need to be released and re-acquired.

/* This function is called when the main window is closed */

static void delete_event_cb (GtkWidget *widget, GdkEvent *event, CustomData *data) {

stop_cb (NULL, data);

gtk_main_quit ();

}

gtk_main_quit() will eventually make the call to to gtk_main_run() in main to terminate, which, in this case, finishes the program. Here, we call it when the main window is closed, after stopping the pipeline (just for the sake of tidiness).

/* This function is called everytime the video window needs to be redrawn (due to damage/exposure,

* rescaling, etc). GStreamer takes care of this in the PAUSED and PLAYING states, otherwise,

* we simply draw a black rectangle to avoid garbage showing up. */

static gboolean draw_cb (GtkWidget *widget, cairo_t *cr, CustomData *data) {

if (data->state < GST_STATE_PAUSED) {

GtkAllocation allocation;

/* Cairo is a 2D graphics library which we use here to clean the video window.

* It is used by GStreamer for other reasons, so it will always be available to us. */

gtk_widget_get_allocation (widget, &allocation);

cairo_set_source_rgb (cr, 0, 0, 0);

cairo_rectangle (cr, 0, 0, allocation.width, allocation.height);

cairo_fill (cr);

}

return FALSE;

}

When there is data flow (in the PAUSED and PLAYING states) the video sink takes care of refreshing the content of the video window. In the other cases, however, it will not, so we have to do it. In this example, we just fill the window with a black rectangle.

/* This function is called when the slider changes its position. We perform a seek to the

* new position here. */

static void slider_cb (GtkRange *range, CustomData *data) {

gdouble value = gtk_range_get_value (GTK_RANGE (data->slider));

gst_element_seek_simple (data->playbin, GST_FORMAT_TIME, GST_SEEK_FLAG_FLUSH | GST_SEEK_FLAG_KEY_UNIT,

(gint64)(value * GST_SECOND));

}

This is an example of how a complex GUI element like a seeker bar (or slider that allows seeking) can be very easily implemented thanks to GStreamer and GTK+ collaborating. If the slider has been dragged to a new position, tell GStreamer to seek to that position with gst_element_seek_simple() (as seen in Basic tutorial 4: Time management). The slider has been setup so its value represents seconds.

It is worth mentioning that some performance (and responsiveness) can be gained by doing some throttling, this is, not responding to every single user request to seek. Since the seek operation is bound to take some time, it is often nicer to wait half a second (for example) after a seek before allowing another one. Otherwise, the application might look unresponsive if the user drags the slider frantically, which would not allow any seek to complete before a new one is queued.

/* This function is called periodically to refresh the GUI */

static gboolean refresh_ui (CustomData *data) {

gint64 current = -1;

/* We do not want to update anything unless we are in the PAUSED or PLAYING states */

if (data->state < GST_STATE_PAUSED)

return TRUE;

This function will move the slider to reflect the current position of the media. First off, if we are not in the PLAYING state, we have nothing to do here (plus, position and duration queries will normally fail).

/* If we didn't know it yet, query the stream duration */

if (!GST_CLOCK_TIME_IS_VALID (data->duration)) {

if (!gst_element_query_duration (data->playbin, GST_FORMAT_TIME, &data->duration)) {

g_printerr ("Could not query current duration.\n");

} else {

/* Set the range of the slider to the clip duration, in SECONDS */

gtk_range_set_range (GTK_RANGE (data->slider), 0, (gdouble)data->duration / GST_SECOND);

}

}

We recover the duration of the clip if we didn't know it, so we can set the range for the slider.

if (gst_element_query_position (data->playbin, GST_FORMAT_TIME, ¤t)) {

/* Block the "value-changed" signal, so the slider_cb function is not called

* (which would trigger a seek the user has not requested) */

g_signal_handler_block (data->slider, data->slider_update_signal_id);

/* Set the position of the slider to the current pipeline position, in SECONDS */

gtk_range_set_value (GTK_RANGE (data->slider), (gdouble)current / GST_SECOND);

/* Re-enable the signal */

g_signal_handler_unblock (data->slider, data->slider_update_signal_id);

}

return TRUE;

We query the current pipeline position, and set the position of the slider accordingly. This would trigger the emission of the value-changed signal, which we use to know when the user is dragging the slider. Since we do not want seeks happening unless the user requested them, we disable the value-changed signal emission during this operation with g_signal_handler_block() and g_signal_handler_unblock().

Returning TRUE from this function will keep it called in the future. If we return FALSE, the timer will be removed.

/* This function is called when new metadata is discovered in the stream */

static void tags_cb (GstElement *playbin, gint stream, CustomData *data) {

/* We are possibly in a GStreamer working thread, so we notify the main

* thread of this event through a message in the bus */

gst_element_post_message (playbin,

gst_message_new_application (GST_OBJECT (playbin),

gst_structure_new_empty ("tags-changed")));

}

This is one of the key points of this tutorial. This function will be called when new tags are found in the media, from a streaming thread, this is, from a thread other than the application (or main) thread. What we want to do here is to update a GTK+ widget to reflect this new information, but GTK+ does not allow operating from threads other than the main one.

The solution is to make playbin post a message on the bus and return to the calling thread. When appropriate, the main thread will pick up this message and update GTK.

gst_element_post_message()使 GStreamer 元素将给定消息发布到总线。gst_message_new_application()创建该类型的新消息APPLICATION。GStreamer 消息有不同的类型,这种特定类型是为应用程序保留的:它将通过总线不受 GStreamer 的影响。类型列表可以在GstMessageType文档中找到。

消息可以通过其嵌入的 传递附加信息 GstStructure,这是一个非常灵活的数据容器。在这里,我们创建了一个新结构gst_structure_new(),并将其命名为tags-changed,以避免在我们想要发送其他应用程序消息时发生混淆。

稍后,一旦进入主线程,总线将收到此消息并发出信号message::application,我们已将其关联到函数 application_cb:

/* This function is called when an "application" message is posted on the bus.

* Here we retrieve the message posted by the tags_cb callback */

static void application_cb (GstBus *bus, GstMessage *msg, CustomData *data) {

if (g_strcmp0 (gst_structure_get_name (gst_message_get_structure (msg)), "tags-changed") == 0) {

/* If the message is the "tags-changed" (only one we are currently issuing), update

* the stream info GUI */

analyze_streams (data);

}

}

一旦我确定它是tags-changed消息,我们就调用该 analyze_streams函数,该函数也在播放教程 1:Playbin 用法中使用,并且在那里更详细。它基本上从流中恢复标签并将它们写入 GUI 中的文本小部件中。

error_cb,和真的不值得解释,因为它们与之前所有教程中的eos_cb功能state_changed_cb相同,但现在来自它们自己的功能。

就是这样!本教程中的代码量可能看起来令人生畏,但所需的概念却很少而且很简单。如果您遵循了前面的教程并且对 GTK 有一点了解,那么您可能已经了解了这个,现在可以享受您自己的媒体播放器了!

锻炼

如果此媒体播放器对您来说不够好,请尝试将显示有关流的信息的文本小部件更改为适当的列表视图(或树视图)。然后,当用户选择不同的流时,让 GStreamer 切换流!要切换流,您需要阅读播放教程 1:Playbin 使用。

结论

本教程展示了:

- 如何使用 将视频输出到特定窗口句柄

gst_video_overlay_set_window_handle()。 - 如何通过注册超时回调来定期刷新 GUI

g_timeout_add_seconds ()。 - 如何通过总线以应用程序消息的方式向主线程传递信息

gst_element_post_message()。 - 如何通过使总线发出信号并

gst_bus_add_signal_watch()使用信号详细信息区分所有消息类型来仅通知感兴趣的消息。

这允许您使用适当的图形用户界面构建一个比较完整的媒体播放器。

以下基本教程继续关注其他个别 GStreamer 主题

很高兴有你在这里,很快再见!

基础教程 6:媒体格式和 Pad Capabilities

目标

Pad Capabilities 是 GStreamer 的基本元素,尽管大多数时候它们是不可见的,因为框架会自动处理它们。这个有点理论的教程显示:

- 什么是打击垫功能。

- 如何找回它们。

- 何时取回它们。

- 为什么你需要了解它们。

介绍

垫

如前所述,Pad 允许信息进入和离开元素。然后,Pad的 Capabilities(或简称Caps )指定了什么样的信息可以通过 Pad。例如,“分辨率为 320x200 像素和每秒 30 帧的 RGB 视频”,或“每个样本音频 16 位,每秒 44100 个样本的 5.1 通道”,甚至压缩格式,如 mp3 或 h264。

Pad 可以支持多种功能(例如,视频接收器可以支持不同类型的 RGB 或 YUV 格式的视频)并且功能可以指定为范围(例如,音频接收器可以支持每秒 1 到 48000 个样本的采样率) . 然而,从 Pad 到 Pad 的实际信息必须只有一种明确指定的类型。通过称为协商的过程,两个链接的 Pad 就共同类型达成一致,因此 Pad 的 Capabilities 变得固定 (它们只有一种类型并且不包含范围)。下面的示例代码的演练应该使所有这些都清楚。

为了将两个元素链接在一起,它们必须共享一个共同的能力子集(否则它们不可能相互理解)。这是Capabilities的主要目标。

作为应用程序开发人员,您通常会通过将元素链接在一起来构建管道(如果您使用 all-in-all 元素,则程度较小playbin)。在这种情况下,您需要知道元素的Pad Caps(正如人们熟悉的那样),或者至少知道当 GStreamer 拒绝链接两个具有协商错误的元素时它们是什么。

垫模板

Pad 是从Pad Templates创建的,它指示 Pad 可能拥有的所有可能功能。模板对于创建多个相似的 Pad 很有用,也允许提前拒绝元素之间的连接:如果它们的 Pad Templates 的 Capabilities 没有公共子集(它们的交集为空),则无需进一步协商。

Pad Templates 可以被视为协商过程的第一步。随着过程的发展,实际的 Pad 被实例化并且它们的 Capabilities 被改进直到它们被修复(或协商失败)。

功能示例

SINK template: 'sink'

Availability: Always

Capabilities:

audio/x-raw

format: S16LE

rate: [ 1, 2147483647 ]

channels: [ 1, 2 ]

audio/x-raw

format: U8

rate: [ 1, 2147483647 ]

channels: [ 1, 2 ]

这个 pad 是一个水槽,在元素上总是可用的(我们现在不会谈论可用性)。它支持两种媒体,都是整数格式 ( ) 的原始音频audio/x-raw:有符号的 16 位小端和无符号的 8 位。方括号表示一个范围:例如,通道数从 1 到 2 不等。

SRC template: 'src'

Availability: Always

Capabilities:

video/x-raw

width: [ 1, 2147483647 ]

height: [ 1, 2147483647 ]

framerate: [ 0/1, 2147483647/1 ]

format: { I420, NV12, NV21, YV12, YUY2, Y42B, Y444, YUV9, YVU9, Y41B, Y800, Y8, GREY, Y16 , UYVY, YVYU, IYU1, v308, AYUV, A420 }

video/x-raw表示此源板输出原始视频。它支持广泛的尺寸和帧率,以及一组 YUV 格式(花括号表示列表)。所有这些格式都表示图像平面的不同打包和子采样。

最后的评论

您可以使用基础教程 10:GStreamer 工具gst-inspect-1.0中描述的工具来了解任何 GStreamer 元素的 Caps。

请记住,某些元素会查询底层硬件以获取支持的格式并相应地提供它们的 Pad Caps(它们通常在进入 READY 状态或更高状态时执行此操作)。因此,显示的上限可能因平台而异,甚至因一次执行而异(尽管这种情况很少见)。

本教程实例化两个元素(这次,通过它们的工厂),显示它们的 Pad 模板,链接它们并设置要播放的管道。在每次状态更改时,都会显示接收器元素的 Pad 的 Capabilities,因此您可以观察协商如何进行,直到 Pad Caps 固定为止。

一个简单的 Pad 功能示例

将此代码复制到名为的文本文件中basic-tutorial-6.c(或在您的 GStreamer 安装中找到它)。

basic-tutorial-6.c

#include <gst/gst.h>

/* Functions below print the Capabilities in a human-friendly format */

static gboolean print_field (GQuark field, const GValue * value, gpointer pfx) {

gchar *str = gst_value_serialize (value);

g_print ("%s %15s: %s\n", (gchar *) pfx, g_quark_to_string (field), str);

g_free (str);

return TRUE;

}

static void print_caps (const GstCaps * caps, const gchar * pfx) {

guint i;

g_return_if_fail (caps != NULL);

if (gst_caps_is_any (caps)) {

g_print ("%sANY\n", pfx);

return;

}

if (gst_caps_is_empty (caps)) {

g_print ("%sEMPTY\n", pfx);

return;

}

for (i = 0; i < gst_caps_get_size (caps); i++) {

GstStructure *structure = gst_caps_get_structure (caps, i);

g_print ("%s%s\n", pfx, gst_structure_get_name (structure));

gst_structure_foreach (structure, print_field, (gpointer) pfx);

}

}

/* Prints information about a Pad Template, including its Capabilities */

static void print_pad_templates_information (GstElementFactory * factory) {

const GList *pads;

GstStaticPadTemplate *padtemplate;

g_print ("Pad Templates for %s:\n", gst_element_factory_get_longname (factory));

if (!gst_element_factory_get_num_pad_templates (factory)) {

g_print (" none\n");

return;

}

pads = gst_element_factory_get_static_pad_templates (factory);

while (pads) {

padtemplate = pads->data;

pads = g_list_next (pads);

if (padtemplate->direction == GST_PAD_SRC)

g_print (" SRC template: '%s'\n", padtemplate->name_template);

else if (padtemplate->direction == GST_PAD_SINK)

g_print (" SINK template: '%s'\n", padtemplate->name_template);

else

g_print (" UNKNOWN!!! template: '%s'\n", padtemplate->name_template);

if (padtemplate->presence == GST_PAD_ALWAYS)

g_print (" Availability: Always\n");

else if (padtemplate->presence == GST_PAD_SOMETIMES)

g_print (" Availability: Sometimes\n");

else if (padtemplate->presence == GST_PAD_REQUEST)

g_print (" Availability: On request\n");

else

g_print (" Availability: UNKNOWN!!!\n");

if (padtemplate->static_caps.string) {

GstCaps *caps;

g_print (" Capabilities:\n");

caps = gst_static_caps_get (&padtemplate->static_caps);

print_caps (caps, " ");

gst_caps_unref (caps);

}

g_print ("\n");

}

}

/* Shows the CURRENT capabilities of the requested pad in the given element */

static void print_pad_capabilities (GstElement *element, gchar *pad_name) {

GstPad *pad = NULL;

GstCaps *caps = NULL;

/* Retrieve pad */

pad = gst_element_get_static_pad (element, pad_name);

if (!pad) {

g_printerr ("Could not retrieve pad '%s'\n", pad_name);

return;

}

/* Retrieve negotiated caps (or acceptable caps if negotiation is not finished yet) */

caps = gst_pad_get_current_caps (pad);

if (!caps)

caps = gst_pad_query_caps (pad, NULL);

/* Print and free */

g_print ("Caps for the %s pad:\n", pad_name);

print_caps (caps, " ");

gst_caps_unref (caps);

gst_object_unref (pad);

}

int main(int argc, char *argv[]) {

GstElement *pipeline, *source, *sink;

GstElementFactory *source_factory, *sink_factory;

GstBus *bus;

GstMessage *msg;

GstStateChangeReturn ret;

gboolean terminate = FALSE;

/* Initialize GStreamer */

gst_init (&argc, &argv);

/* Create the element factories */

source_factory = gst_element_factory_find ("audiotestsrc");

sink_factory = gst_element_factory_find ("autoaudiosink");

if (!source_factory || !sink_factory) {

g_printerr ("Not all element factories could be created.\n");

return -1;

}

/* Print information about the pad templates of these factories */

print_pad_templates_information (source_factory);

print_pad_templates_information (sink_factory);

/* Ask the factories to instantiate actual elements */

source = gst_element_factory_create (source_factory, "source");

sink = gst_element_factory_create (sink_factory, "sink");

/* Create the empty pipeline */

pipeline = gst_pipeline_new ("test-pipeline");

if (!pipeline || !source || !sink) {

g_printerr ("Not all elements could be created.\n");

return -1;

}

/* Build the pipeline */

gst_bin_add_many (GST_BIN (pipeline), source, sink, NULL);

if (gst_element_link (source, sink) != TRUE) {

g_printerr ("Elements could not be linked.\n");

gst_object_unref (pipeline);

return -1;

}

/* Print initial negotiated caps (in NULL state) */