kubernetes的暴露pod对外访问的方式

1,背景

我们在使用k8s部署服务后,有一些服务需要对外暴露

例如:我们的API服务、或者一些监控服务

2,5种方式

2.1,hostNetwork

有点类似于docker网络中的host网络模式,直接使用宿主机的网络,所以只能使用宿主机的ip和容器的端口访问

apiVersion: v1

kind: Pod

metadata:

name: influxdb

spec:

hostNetwork: true

containers:

- name: influxdb

image: influxdb

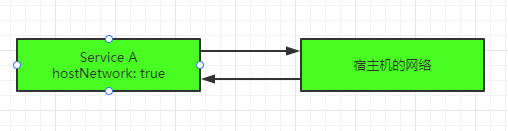

使用"hostNetwork: true"配置网络,pod中运行的应用程序可以直接看到宿主主机的网络接口,宿主机(节点主机)所在的局域网上所有网络接口都可以访问到该应用程序及端口。

通俗的讲就是:Service A 的网络与宿主机一致

优点:网络直接与宿主机(节点主机)一致

缺点:只能通过宿主机的ip进行访问!如果k8s重启或者其他的一些原因导致服务部署的节点发生变化,那么访问ip也要随着宿主机的切换变化

2.2,hostPort

指定特定的端口来访问,但是ip是根据启动的节点ip而定

containerPort容器内部的端口,hostPort映射到宿主机的端口

apiVersion: v1

kind: Pod

metadata:

name: influxdb

spec:

containers:

- name: influxdb

image: influxdb

ports:

- containerPort: 8086

hostPort: 8086

这样做有个缺点,因为Pod重新调度的时候该Pod被调度到的宿主机可能会变动,这样就变化了,用户必须自己维护一个Pod与所在宿主机的对应关系。

2.3,NodePort

相当于直接使用集群ip(无论启动在哪一个节点都可以访问),然后设置一个端口

kind: Service

apiVersion: v1

metadata:

name: influxdb

spec:

type: NodePort

ports:

- port: 8086

nodePort: 30000

selector:

name: influxdb

NodePort在kubenretes里是一个广泛应用的服务暴露方式。Kubernetes中的service默认情况下都是使用的ClusterIP这种类型,这样的service会产生一个ClusterIP,这个IP只能在集群内部访问,要想让外部能够直接访问service,需要将service type修改为 nodePort

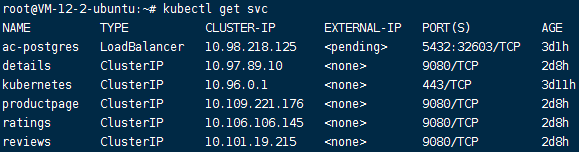

2.4,LoadBalancer

LoadBalancer 只能在service上定义

kind: Service

apiVersion: v1

metadata:

name: influxdb

spec:

type: LoadBalancer

ports:

- port: 8086

selector:

name: influxdb

例如postgres就可以通过外网ip+端口直接访问

2.5,Ingress

Ingress是自kubernetes1.1版本后引入的资源类型(istio使用的就是这种)。必须要部署Ingress controller才能创建Ingress资源,Ingress controller是以一种插件的形式提供。Ingress controller 是部署在Kubernetes之上的Docker容器。它的Docker镜像包含一个像nginx或HAProxy的负载均衡器和一个控制器守护进程。控制器守护程序从Kubernetes接收所需的Ingress配置。它会生成一个nginx或HAProxy配置文件,并重新启动负载平衡器进程以使更改生效。换句话说,Ingress controller是由Kubernetes管理的负载均衡器。

Kubernetes Ingress提供了负载平衡器的典型特性:HTTP路由,粘性会话,SSL终止,SSL直通,TCP和UDP负载平衡等。目前并不是所有的Ingress controller都实现了这些功能,需要查看具体的Ingress controller文档。

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: influxdb

spec:

rules:

- host: influxdb.kube.example.com

http:

paths:

- backend:

serviceName: influxdb

servicePort: 8086

外部访问URL http://influxdb.kube.example.com/ping 访问该服务,入口就是80端口,然后Ingress controller直接将流量转发给后端Pod,不需再经过kube-proxy的转发,比LoadBalancer方式更高效。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 全程不用写代码,我用AI程序员写了一个飞机大战

· DeepSeek 开源周回顾「GitHub 热点速览」

· 记一次.NET内存居高不下排查解决与启示

· 物流快递公司核心技术能力-地址解析分单基础技术分享

· .NET 10首个预览版发布:重大改进与新特性概览!