kafka2.10集群搭建(一)

一.kafka集群搭建

1.上传解压

2.配置文件的配置

1.修改 server.properties文件

broker.id=11 #192.168.199.11 #21 一般使用ip后三位 listeners=PLAINTEXT://192.168.199.11:9092 #34 log.dirs=/home/pengbo.zhao/data/kafka #63 zookeeper.connect=192.168.199.11:2181,192.168.199.12:2181,192.168.199.13:2181/kafka #119

//注意:这里后面连接的url后面加了"/kafka",详见kafka server.properties 配置文件详解

broker.id=12 #192.168.199.12 #21 一般使用ip后三位

listeners=PLAINTEXT://192.168.199.12:9092 #34

log.dirs=/home/pengbo.zhao/data/kafka #63

zookeeper.connect=192.168.199.11:2181,192.168.199.12:2181,192.168.199.13:2181/kafka #119

broker.id=13 #192.168.199.13 #21 一般使用ip后三位

listeners=PLAINTEXT://192.168.199.13:9092 #34

log.dirs=/home/pengbo.zhao/data/kafka #63

zookeeper.connect=192.168.199.11:2181,192.168.199.12:2181,192.168.199.13:2181/kafka #119

//注意:这里后面连接的url后面加了"/kafka",详见kafka server.properties 配置文件详解

3.启动、停止

bin/kafka-server-start.sh -daemon config/server.properties #采用后台启动的方式启动三台kafka

bin/kafka-server-stop.sh config/server.properties

4.创建topic

bin/kafka-topics.sh --create --topic test1 --partitions 1 --replication-factor 3 --zookeeper 192.168.199.11:2181/kafka

//注意:在zk集群模式下,连接1个节点就可以将数据同步了

查看分布:

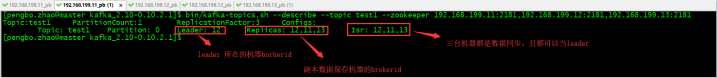

bin/kafka-topics.sh --describe --topic test1 --zookeeper 192.168.199.11:2181/kafka

5.验证topic

通过console的方式连接控制台,创建生产者

bin/kafka-console-producer.sh --topic test1 --broker-list 192.168.199.11:9092,192.168.199.12:9092,192.168.199.13:9092

创建消费者:

bin/kafka-console-consumer.sh --topic test1 --bootstrap-server 192.168.199.11:9092,192.168.199.12:9092,192.168.199.13:9092

在producer端任意输入数据,在consumer端可以接收到发送的数据

由于本人是自己学习总结出来的,有不足之处,请各位看官批评指出,我将及时改正,以提高知识总结的正确性和严谨性,为大家学习提供方便!!!

如若转载,请注明出处!!!