创建Spark-Core项目

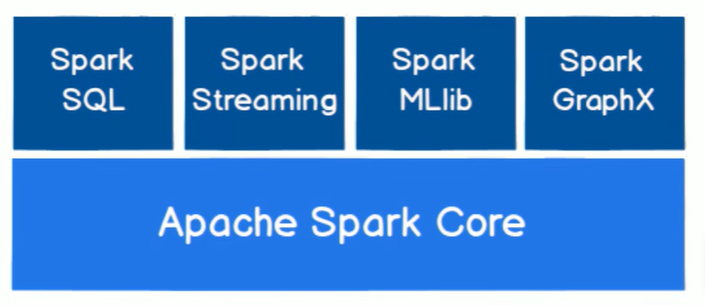

SparkCore 是整个Spark 框架的核心,其他都是在此基础上扩展API

-

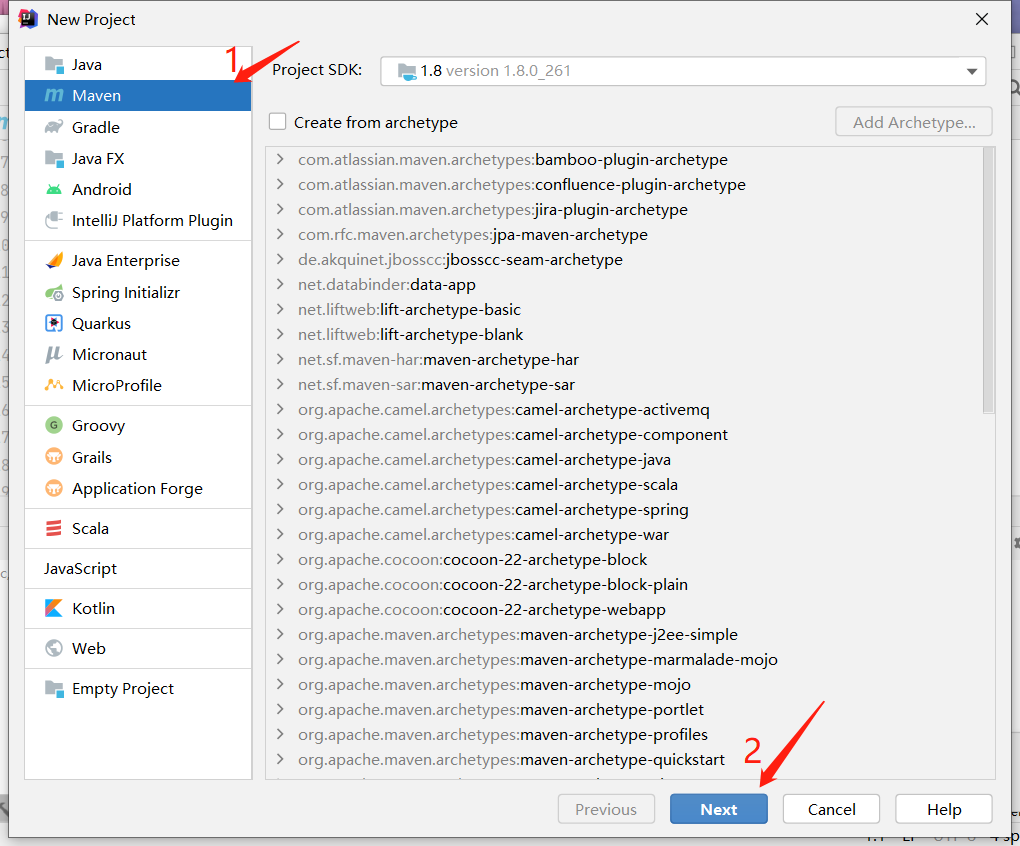

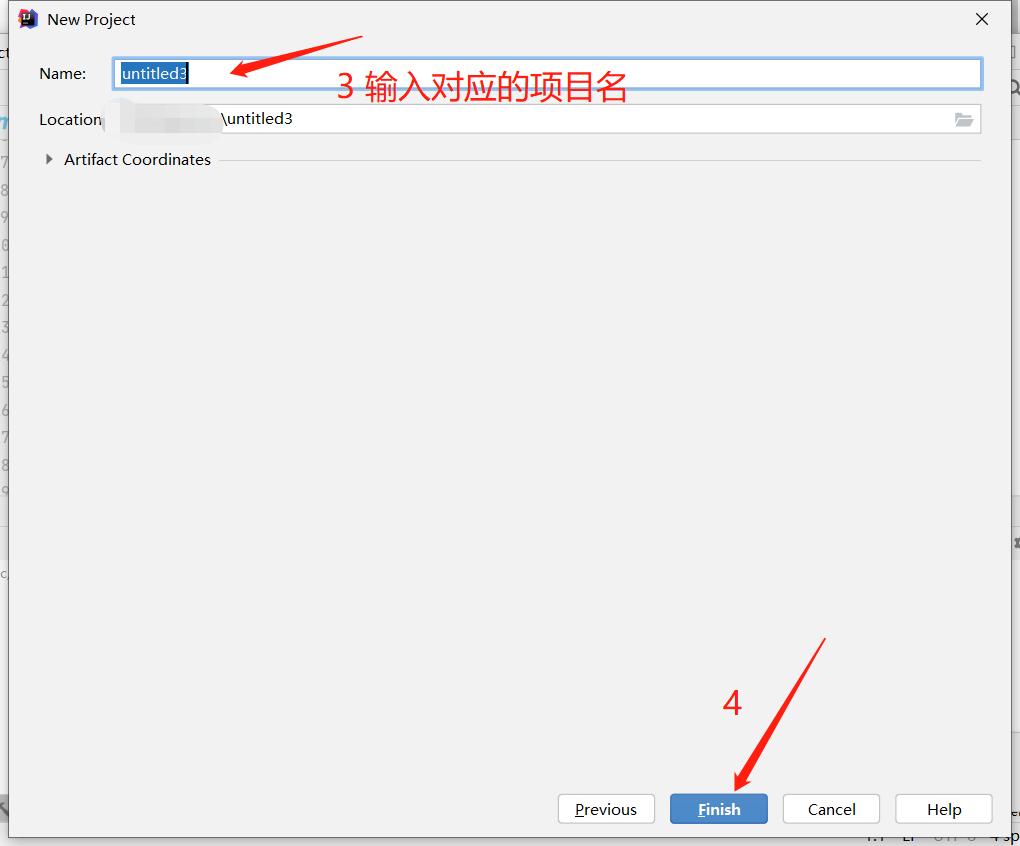

第一步,打开IDEA,新建Maven项目

-

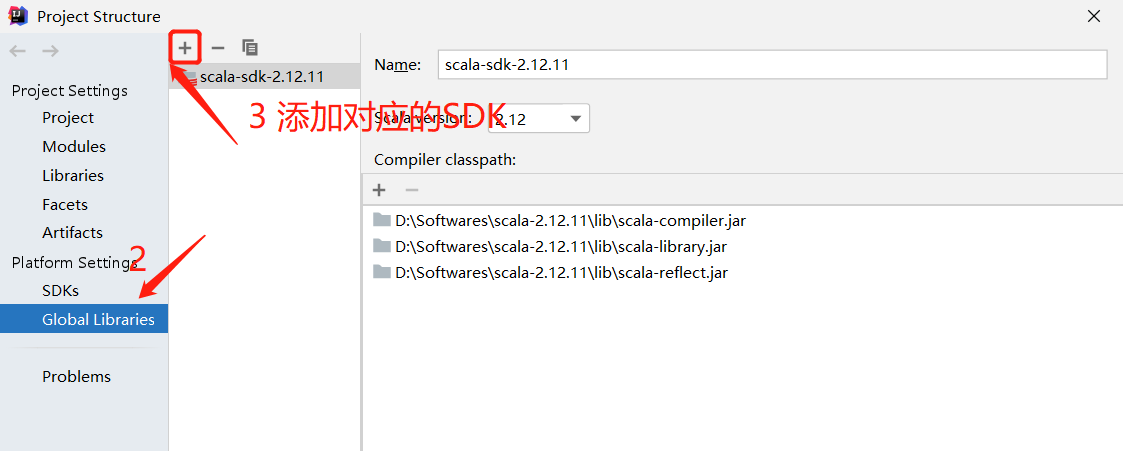

第二步,增加 Scala 插件(前提:一配置好scala环境)

注意版本,Spark3.0 版本最好用 Scala2.12 版本(文本末尾有scala 环境安装包)

-

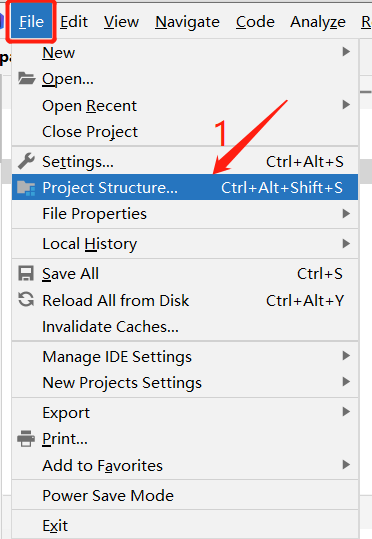

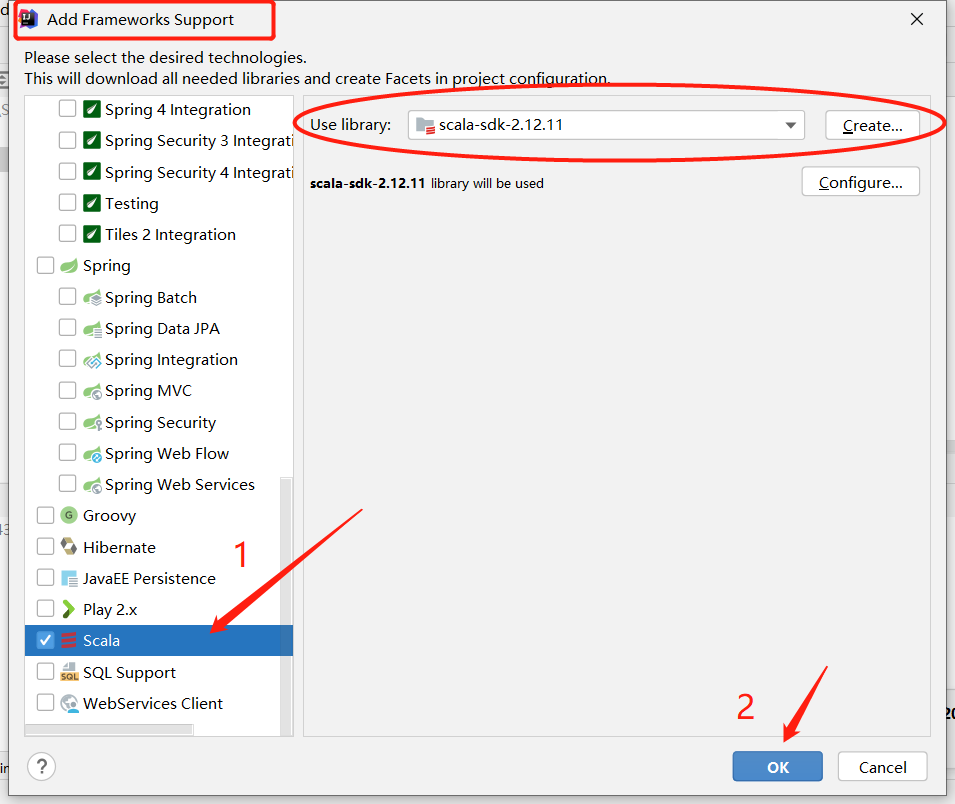

第三步,添加框架支持

右键项目名。选择

-

第四步,添加依赖

<dependencies>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.0.0</version>

</dependency>

</dependencies>

至此项目环境配置完成

scala2.12 的环境包

链接:https://pan.baidu.com/s/1xYEAdLgHf8EZF1wn4WUSUg

提取码:wahh

浙公网安备 33010602011771号

浙公网安备 33010602011771号