Python:关于subprocess.stdout.read()导致程序死锁的问题

subprocess.stdout.read()导致程序死锁的问题解决

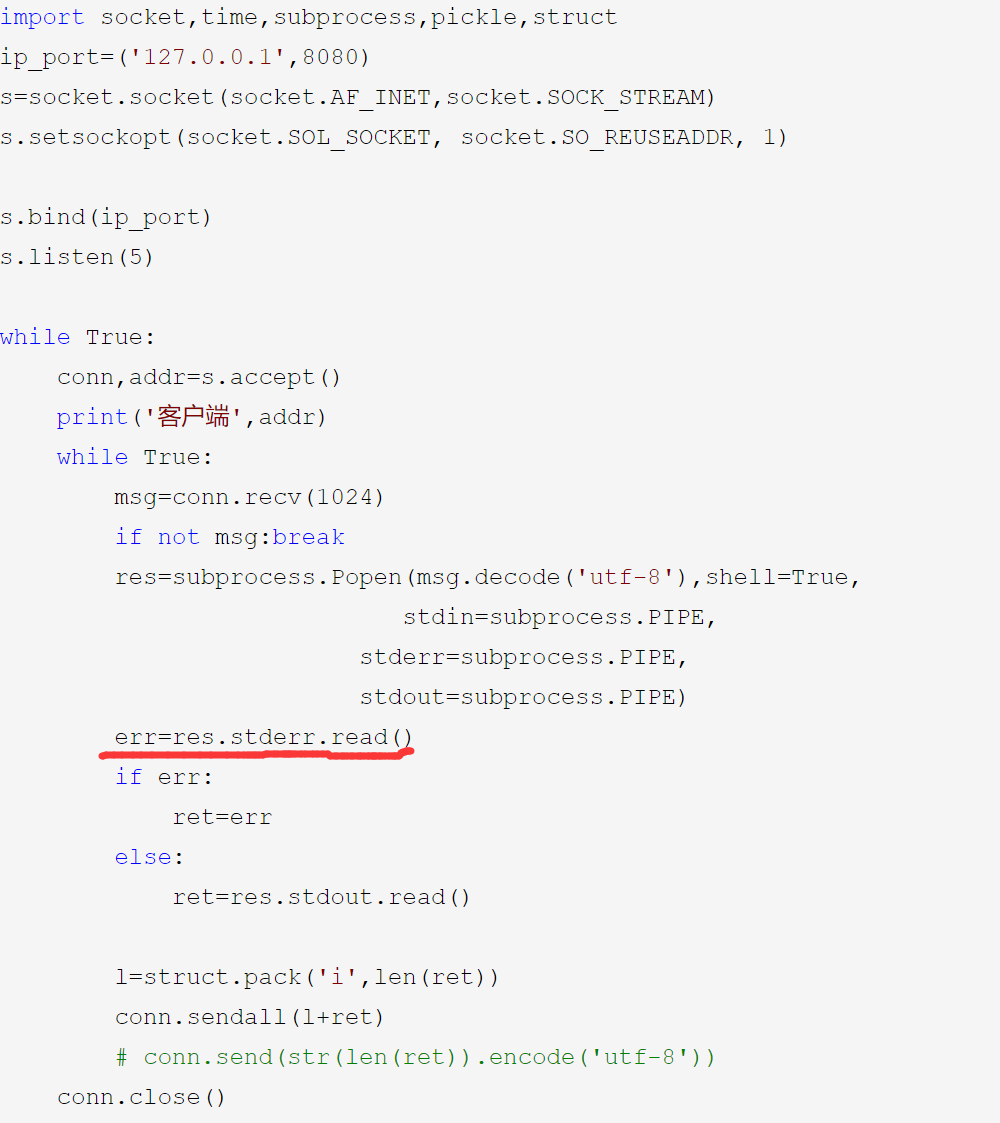

今天有位老哥联系我说,在我的python之路系列中,解决粘包问题那一章的代码有BUG

这里当运行命令过于庞大的时候,会导致程序直接卡死在这里,我自己试试了下,确实有这个问题。

但是到底是为什么呢,前前后后想了好久,没找到答案,后来google了半天以及翻了下官方文档

终于找到了问题所在!!!划重点

如果设置了stdout或stderr,subprocess就会调用os.pipe创建一个管道用于其和子进程之间的通信,而上面的问题正好是cmd输出的数据把pipe塞满,无法继续往pipe里写入数据导致程序hang住,而我们没有去读出pipe数据,而是死等子进程完成,导致死锁。

具体大小的话windows只有4kb,而linux有64kb(辣鸡windows)

那么如何解决呢

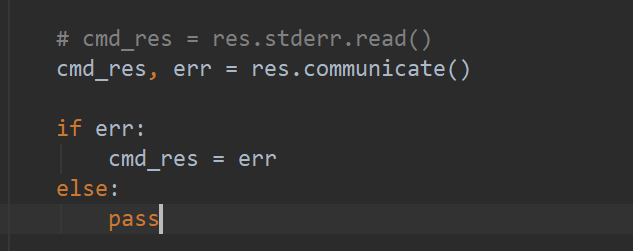

解决办法一:

使用communicate及时读出pipe中内容,避免堵死,但在输出量非常大的情况下会影响性能:

这也是官方文档里推荐的做法,但是不能乱用,因为会影响性能.

解决办法二:

使用文件代替PIPE,但是这样子的话传给客户端的就只能是文件了。

fdout = open(len(procs)+".out", 'w')

fderr = open(len(procs)+".err", 'w')

总结:

两种方法需要自己根据情况进行取舍,都有各自的优势和劣势。